Vertex AI の料金

料金は米ドル(USD)で表しています。米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

Vertex AI と従来の AI Platform の料金比較

Vertex AI の料金体系は、以下の点を除き、従来の AI Platform や AutoML プロダクトとの違いはありません。

- 以前の AI Platform Prediction や AutoML Tables Prediction では、より低コストで低性能なマシンタイプがサポートされていましたが、Vertex AI Inference や AutoML Tabular ではサポートされていません。

- 従来の AI Platform Prediction では、ゼロへのスケーリングがサポートされていましたが、Vertex AI Inference ではサポートされていません。

さらに、Vertex AI では以下のようなコスト最適化の方法を提供しています。

- TensorFlow ランタイムの最適化。

- モデルの共同ホスティングをサポート。

- トレーニングおよび予測の最低利用期間はなし。ただし、使用時間 30 秒ごとに課金。

Vertex AI における生成 AI の料金

Vertex AI における生成 AI の料金情報については、Vertex AI における生成 AI の料金をご覧ください。

AutoML モデルの料金

Vertex AI AutoML モデルでは、次の 3 つのアクティビティに対して課金されます。

- モデルのトレーニング

- エンドポイントへのモデルのデプロイ

- モデルを使用した予測

Vertex AI は、Vertex AutoML モデルに事前定義されたマシン構成を使用し、これらのアクティビティの 1 時間あたりの料金は、リソース使用量を反映しています。

モデルのトレーニングに必要な時間は、トレーニング対象データのサイズや複雑さによって異なります。オンライン予測またはオンライン説明を提供するには、まずモデルをデプロイする必要があります。

予測を行わない場合でも、エンドポイントにデプロイされたモデルごとに料金が発生します。追加料金の発生を防ぐには、モデルのデプロイ解除を行う必要があります。デプロイされていないモデルまたはデプロイに失敗したモデルは、課金されません。

料金は、使用したコンピューティング時間数に基づく従量制です。ユーザーがキャンセルした場合を除き、なんらかの理由でトレーニングが失敗した場合、そのトレーニング時間に対しては課金されません。ユーザーによるキャンセルの場合は、トレーニング時間に対し、課金が発生します。

料金情報を確認するには、以下のモデルタイプを選択してください。

画像データ

画像データ

オペレーション | 料金(分類)(米ドル) | 料金(オブジェクト検出)(USD) |

|---|---|---|

トレーニング | $3.465 / 1 hour | $3.465 / 1 hour |

トレーニング(Edge オンデバイス モデル) | $18.00 / 1 hour | $18.00 / 1 hour |

デプロイとオンライン予測 | $1.375 / 1 hour | $2.002 / 1 hour |

バッチ予測 | $2.222 / 1 hour | $2.222 / 1 hour |

表形式データ

表形式データ

オペレーション | 分類と回帰の 1 ノード時間あたりの料金 | 予測の料金 |

|---|---|---|

トレーニング | $21.252 / 1 hour | |

推論 | カスタム トレーニング モデルの推論と同じ料金。 Vertex AI は、40 台の n1-highmem-8 マシンを使用してバッチ推論を実行します。 |

Vertex Explainable AI の推論にかかる料金

Vertex Explainable AI に関連するコンピューティングは、推論と同じレートで課金されます。ただし、説明の処理は通常の推論よりも時間を要するため、自動スケーリングで Vertex Explainable AI を多用すると、開始されるノードが増加し、推論の料金が増加する可能性があります。

Vertex AI Forecast

AutoML

AutoML

ステージ | 料金 |

|---|---|

予測 | 0 count to 1,000,000 count $0.20 / 1,000 count, per 1 month / account 1,000,000 count to 50,000,000 count $0.10 / 1,000 count, per 1 month / account 50,000,000 count and above $0.02 / 1,000 count, per 1 month / account |

トレーニング | $21.252 / 1 hour |

Explainable AI | シャープレイ値を用いた説明可能性。Vertex AI 推論と説明の料金ページを参照。 |

* 予測データポイントとは、予測期間の 1 つの時点を指します。たとえば、日次の粒度であれば、7 日間の予測期間は時系列ごとに 7 つのデータポイントになります。

- 最大 5 つの予測分位数を追加料金なしで含めることができます。

- 各ティアごとに消費されるデータポイントの数は、月ごとに更新されます。

ARIMA+

ARIMA+

ステージ | 料金 |

|---|---|

予測 | $5.00 / 1,000 count |

トレーニング | 1 TB あたり$250.00 x 候補モデルの数 x バックテスト ウィンドウの数* |

Explainable AI | 時系列分解による説明可能性は追加料金なし。シャープレイ値を用いた説明可能性はサポートなし。 |

詳細は、BigQuery ML 料金ページをご覧ください。各トレーニングおよび予測ジョブは、Vertex AI の料金に記載されているように、1 マネージド パイプライン実行のコストが発生します。

* バックテスト ウィンドウは、テストセットの各期間に対して作成されます。使用する AUTO_ARIMA_MAX_ORDER が、候補モデルの数を決定します。この値は、複数の時系列を持つモデルの場合、6 から 42 の範囲で設定されます。

カスタム トレーニング済みモデル

トレーニング

トレーニング

以下のテーブルは、さまざまなトレーニング構成の 1 時間あたりのおおよその料金を示しています。選択したマシンタイプのカスタム構成を選択できます。料金を計算するには、使用する仮想マシンの費用を合算してください。

Compute Engine マシンタイプにアクセラレータを接続する場合、アクセラレータの費用は含まれません。この費用を計算するには、以下のアクセラレータの表に示す料金に、使用する各タイプのアクセラレータのマシン時間を掛けます。

マシンタイプ

マシンタイプ

Vertex AI カスタム トレーニングで Spot VM を使用できます。 Spot VM の料金は、Compute Engine Spot VM の料金に基づいて請求されます。インフラストラクチャの使用料とは別に、以下の表に記載のとおり、Vertex AI カスタム トレーニングの管理手数料が発生します。

Vertex AI カスタム トレーニングで Compute Engine の予約を使用できます。Compute Engine の予約を使用すると、適用される確約利用割引(CUD)を含む Compute Engine の料金に従って課金されます。インフラストラクチャの使用料とは別に、以下の表に記載のとおり、Vertex AI カスタム トレーニングの管理手数料が発生します。

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Delhi (asia-south2)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Stockholm (europe-north2)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Alabama (us-east7)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

- Phoenix (us-west8)

マシンタイプ | 料金(米ドル) |

|---|---|

g4-standard-48 | $5.1749195 / 1 hour |

g4-standard-96 | $10.349839 / 1 hour |

g4-standard-384 | $20.699678 / 1 hour |

g4-standard-384 | $41.399356 / 1 hour |

n1-standard-4 | $0.21849885 / 1 hour |

n1-standard-8 | $0.4369977 / 1 hour |

n1-standard-16 | $0.8739954 / 1 hour |

n1-standard-32 | $1.7479908 / 1 hour |

n1-standard-64 | $3.4959816 / 1 hour |

n1-standard-96 | $5.2439724 / 1 hour |

n1-highmem-2 | $0.13604845 / 1 hour |

n1-highmem-4 | $0.2720969 / 1 hour |

n1-highmem-8 | $0.5441938 / 1 hour |

n1-highmem-16 | $1.0883876 / 1 hour |

n1-highmem-32 | $2.1767752 / 1 hour |

n1-highmem-64 | $4.3535504 / 1 hour |

n1-highmem-96 | $6.5303256 / 1 hour |

n1-highcpu-16 | $0.65180712 / 1 hour |

n1-highcpu-32 | $1.30361424 / 1 hour |

n1-highcpu-64 | $2.60722848 / 1 hour |

n1-highcpu-96 | $3.91084272 / 1 hour |

a2-highgpu-1g* | $4.425248914 / 1 hour |

a2-highgpu-2g* | $8.850497829 / 1 hour |

a2-highgpu-4g* | $17.700995658 / 1 hour |

a2-highgpu-8g* | $35.401991315 / 1 hour |

a2-megagpu-16g* | $65.707278915 / 1 hour |

a3-highgpu-8g* | $101.007352832 / 1 hour |

a3-megagpu-8g* | $106.046424032 / 1 hour |

a3-ultragpu-8g* | $99.773930496 / 1 hour |

a4-highgpu-8g* | $148.212 / 1 hour |

e2-standard-4 | $0.154126276 / 1 hour |

e2-standard-8 | $0.308252552 / 1 hour |

e2-standard-16 | $0.616505104 / 1 hour |

e2-standard-32 | $1.233010208 / 1 hour |

e2-highmem-2 | $0.103959618 / 1 hour |

e2-highmem-4 | $0.207919236 / 1 hour |

e2-highmem-8 | $0.415838472 / 1 hour |

e2-highmem-16 | $0.831676944 / 1 hour |

e2-highcpu-16 | $0.455126224 / 1 hour |

e2-highcpu-32 | $0.910252448 / 1 hour |

n2-standard-4 | $0.2233714 / 1 hour |

n2-standard-8 | $0.4467428 / 1 hour |

n2-standard-16 | $0.8934856 / 1 hour |

n2-standard-32 | $1.7869712 / 1 hour |

n2-standard-48 | $2.6804568 / 1 hour |

n2-standard-64 | $3.5739424 / 1 hour |

n2-standard-80 | $4.467428 / 1 hour |

n2-highmem-2 | $0.1506661 / 1 hour |

n2-highmem-4 | $0.3013322 / 1 hour |

Cloud TPU | 料金はアクセラレータのタイプによって決まります。「アクセラレータ」をご覧ください。 |

n2-highmem-8 | $0.6026644 / 1 hour |

n2-highmem-16 | $1.2053288 / 1 hour |

n2-highmem-32 | $2.4106576 / 1 hour |

n2-highmem-48 | $3.6159864 / 1 hour |

n2-highmem-64 | $4.8213152 / 1 hour |

n2-highmem-80 | $6.026644 / 1 hour |

n2-highcpu-16 | $0.6596032 / 1 hour |

n2-highcpu-32 | $1.3192064 / 1 hour |

n2-highcpu-48 | $1.9788096 / 1 hour |

n2-highcpu-64 | $2.6384128 / 1 hour |

n2-highcpu-80 | $3.298016 / 1 hour |

c2-standard-4 | $0.2401292 / 1 hour |

c2-standard-8 | $0.4802584 / 1 hour |

c2-standard-16 | $0.9605168 / 1 hour |

c2-standard-30 | $1.800969 / 1 hour |

c2-standard-60 | $3.601938 / 1 hour |

m1-ultramem-40 | $7.237065 / 1 hour |

m1-ultramem-80 | $14.47413 / 1 hour |

m1-ultramem-160 | $28.94826 / 1 hour |

m1-megamem-96 | $12.249984 / 1 hour |

*この金額には GPU の料金が含まれています。このインスタンス タイプでは、常に固定数の GPU アクセラレータが必要となるためです。

米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

アクセラレータ

アクセラレータ

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Delhi (asia-south2)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Berlin (europe-west10)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

- Phoenix (us-west8)

マシンタイプ | 料金(米ドル) | Vertex 管理手数料 |

|---|---|---|

NVIDIA_TESLA_A100 | $2.933908 / 1 hour | $0.4400862 / 1 hour |

NVIDIA_TESLA_A100_80GB | $3.92808 / 1 hour | $0.589212 / 1 hour |

NVIDIA_H100_80GB | $9.79655057 / 1 hour | $1.4694826 / 1 hour |

NVIDIA_H200_141GB | $10.708501 / 1 hour | 使用不可 |

NVIDIA_H100_MEGA_80GB | $11.8959171 / 1 hour | 使用不可 |

NVIDIA_TESLA_L4 | $0.644046276 / 1 hour | 使用不可 |

NVIDIA_TESLA_P4 | $0.69 / 1 hour | 使用不可 |

NVIDIA_TESLA_P100 | $1.679 / 1 hour | 使用不可 |

NVIDIA_TESLA_T4 | $0.4025 / 1 hour | 使用不可 |

NVIDIA_TESLA_V100 | $2.852 / 1 hour | 使用不可 |

TPU_V2 Single(8 コア) | $5.175 / 1 hour | 使用不可 |

TPU_V2 Pod(32 コア)* | $27.60 / 1 hour | 使用不可 |

TPU_V3 Single(8 コア) | $9.20 / 1 hour | 使用不可 |

TPU_V3 Pod(32 コア)* | $36.80 / 1 hour | 使用不可 |

tpu7x-standard-4t(1 チップ) | $13.80 / 1 hour | 使用不可 |

米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

* Cloud TPU Pod を使用したトレーニングの料金は、Pod のコア数に基づいています。Pod のコア数は常に 32 の倍数です。32 以上のコアを持つ Pod でのトレーニングの料金は、32 コアの Pod の料金にコア数を 32 で割った数値を掛けます。たとえば、128 コアの Pod の場合、料金は(32 コアの Pod の料金)×(128/32)となります。特定のリージョンで利用可能な Cloud TPU Pod を確認するには、Cloud TPU ドキュメントにあるシステム アーキテクチャをご覧ください。

ディスク

ディスク

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Delhi (asia-south2)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

pd-standard | $0.000063014 / 1 gibibyte hour |

pd-ssd | $0.000267808 / 1 gibibyte hour |

米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

- すべてのご利用は Vertex AI の割り当てポリシーの対象となります。

- Vertex AI のライフサイクル中は、データやプログラム ファイルを Google Cloud Storage のバケットに保存する必要があります。詳しくは、Cloud Storage の使用方法をご覧ください。

ジョブにリソースがプロビジョニングされた時点で、ジョブが完了するまで、モデルのトレーニングに対する料金が発生します。

警告: トレーニング ジョブは、Vertex AI 割り当てポリシーによる制限の対象となります。最初のトレーニング ジョブに強力な処理クラスタを選択すると、割り当てを超過する可能性が高くなります。

事前定義された構成のスケール階層(AI Platform Training)

モデルをトレーニングする際に、使用する処理クラスタのタイプを調整できます。最も簡単な方法は、「スケールティア」という事前に定義された構成の中から 1 つを選択することです。詳細については、スケールティアをご覧ください。

カスタム構成用のマシンタイプ

Vertex AI を使用する場合、または AI Platform Training のスケールティアとして CUSTOM を選択した場合は、クラスタのマスター、ワーカー、パラメータ サーバーとして使用する仮想マシンの数やタイプを調整できます。詳しくは、Vertex AI のマシンタイプと AI Platform Training のマシンタイプをご覧ください。

カスタム処理クラスタを使用したトレーニングの料金は、指定した全マシンの合計になります。個々のマシンのアクティブな処理時間ではなく、ジョブの合計時間に対して課金されます。

Gen AI Evaluation Service

モデルベースの指標の場合、料金は、基盤となる自動評価モデルに関連する予測費用に対してのみ適用されます。料金は、評価データセットで提供する入力トークンと自動評価ツールの出力に基づいて請求されます。

Gen AI Evaluation Service の一般提供(GA)が開始されました。料金改定は 2025 年 4 月 14 日に適用されました。

メートル法 | 料金 |

|---|---|

ポイントワイズ | デフォルトの自動評価モデル Gemini 2.0 Flash |

ペアワイズ | デフォルトの自動評価モデル Gemini 2.0 Flash |

コンピューティングベースの指標については、入力の場合は 1,000 文字あたり $0.00003、出力の場合は 1,000 文字あたり $0.00009 が課金されます。こうした指標は、SKU では Automatic Metric と呼ばれます。

指標名 | タイプ |

|---|---|

完全一致 | コンピューティングベース |

Bleu | コンピューティングベース |

ROUGE | コンピューティングベース |

ツール呼び出しが有効 | コンピューティングベース |

ツール名一致 | コンピューティングベース |

ツール パラメータキーの一致 | コンピューティングベース |

ツールのパラメータの KV の一致 | コンピューティングベース |

料金は米ドル(USD)で表しています。米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

従来のモデルベースの指標については、入力の場合は 1,000 文字あたり $0.005、出力の場合は 1,000 文字あたり $0.015 が課金されます。

指標名 | タイプ |

|---|---|

一貫性 | ポイントワイズ |

流暢さ | ポイントワイズ |

フルフィルメント | ポイントワイズ |

安全性 | ポイントワイズ |

根拠性 | ポイントワイズ |

要約の品質 | ポイントワイズ |

要約の有用性 | ポイントワイズ |

要約の冗長性 | ポイントワイズ |

質問応答の品質 | ポイントワイズ |

質問応答の関連性 | ポイントワイズ |

質問応答の有用性 | ポイントワイズ |

質問応答の正確性 | ポイントワイズ |

ペアワイズ要約の品質 | ペアワイズ |

ペアワイズの質問応答の品質 | ペアワイズ |

料金は米ドル(USD)で表しています。米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

Vertex AI Agent Engine

Vertex AI Agent Engine は、開発者が本番環境でエージェントをスケーリングするためのサービスです。サービスは組み合わせて使用することも、個別に利用することもできます。使用したプロダクトに対してのみ請求されます。現在は、Agent Engine ランタイムの料金を支払う。

2026 年 2 月 11 日より、コード実行、セッション、メモリバンクの課金が開始されます。

ランタイム

料金は、Agent Engine ランタイムにデプロイされたエージェントが使用するコンピューティング(vCPU 時間)とメモリ(GiB 時間)のリソースに基づいています。請求は、使用時間の秒単位で切り上げられます。エージェントのアイドル時間は課金対象外です。

無料枠

ランタイムを使い始めるお客様向けに、毎月の無料枠をご用意しています。

- vCPU - 毎月最初の 180,000 vCPU 秒(50 時間)は無料

- RAM - 毎月最初の 360,000 GiB 秒(100 時間)は無料

使用状況に基づく料金

1 か月の使用量が無料枠を超えると、以下の料金で課金が開始されます。

リソース | 料金(米ドル) |

|---|---|

vCPU | 0 hour to 50 hour $0.00 (Free) / 3,600 second, per 1 month / project 50 hour and above $0.0864 / 3,600 second, per 1 month / project |

RAM | 0 gibibyte hour to 100 gibibyte hour $0.00 (Free) / 3,600 gibibyte second, per 1 month / project 100 gibibyte hour and above $0.009 / 3,600 gibibyte second, per 1 month / project |

コードの実行

ランタイムと同様に、サンドボックスの実行に必要なコンピューティングとメモリに対して料金が発生します。請求は、使用時間の秒単位で切り上げられます。アイドル時間は課金対象外。

- コンピューティング: vCPU 時間あたり $0.0864

- メモリ: $0.0090/GiB 時間

セッション

セッション サービスに保存されたイベントの数に基づいて料金が課金されます。コンテンツを含む保存されたセッション イベントに対して課金されます。これには、最初のユーザー リクエスト、モデルのレスポンス、関数呼び出し、関数のレスポンスが含まれます。セッション サービスに保存されるシステム制御イベント(チェックポイントなど)については、課金されません。

- 保存されたイベント 1,000 件あたり $0.25

メモリバンク

保存および返されたメモリの数に基づいて料金を支払います。

- 保存されたメモリ: 保存されたメモリ 1,000 個あたり月額$0.25(+ メモリ生成の LLM 費用、別途支払い)

- メモリの取得: 1,000 個のメモリが返されるごとに $0.50。毎月最初に返される 1,000 個のメモリは無料

料金シナリオ

料金シナリオ

Agent Engine サービスの使用にかかる費用を理解していただくために、軽量エージェントと標準エージェントという 2 つの仮想エージェントをご用意しました。どちらのシナリオでも、次の前提を立てています。

- 無料枠: これらの計算では、ランタイムとメモリバンクの無料枠は、以前のテストで 1 か月以内にすでに使用されていると仮定しています。

- セッションあたりのランタイム リクエスト: 「フルセッション」または会話は 10 件のランタイム リクエストで構成されます。

- セッション: 各ランタイム リクエストで平均 3 つのセッション イベントが生成されます。

- メモリバンク:

- ストレージ: 各セッションの終了時に、1 つのメモリが抽出されて保存されます。

- 検索: ランタイム リクエストごとに平均 1 つのメモリが返されると想定しています。

- Code Execution は、すべてのランタイム リクエストの 30% で呼び出されます。

- 請求月: すべての月単位の計算は、30 日の月に基づいています。

追加情報:

- サービスのモジュール性: 以下のシナリオでは、Agent Engine サービスを組み合わせて使用した場合の費用を示していますが、サービスを個別に利用することもできます。たとえば、Agent Engine ランタイムを使用せずに、Agent Engine セッションと Memory Bank サービスを使用できます。

- モデルの追加費用: エージェントは、推論と計画のために LLM を必要とします。エージェントが使用する LLM トークンは別途課金され、以下のシナリオには含まれません。

- 追加のツール費用: エージェントがアクションを実行するにはツールが必要です。エージェントが使用するツール(API 呼び出し、ストレージなど)は別途課金され、以下のシナリオには含まれません。

架空のシナリオ

架空のシナリオ

シナリオ 1: 軽量な内部エージェント

このシナリオは、エージェントが少量の断続的なトラフィックを処理する状況を表しています。

- ユースケースの例: 小規模企業の IT ヘルプデスク ボット、メールの下書きを作成する個人の生産性向上エージェント、ドキュメントから回答を提供する Slack ボット。

- ランタイムとコード実行に必要なコンピューティングとメモリ: 1 vCPU / 1 GiB RAM。

- トラフィック: 1 秒あたり 0.16 クエリ(1 分あたり 10 クエリ)、合計で 1 か月あたり 432,000 リクエスト。

- 平均リクエスト時間: 3 秒

サービス | 計算 | 1 か月の費用 |

|---|---|---|

ランタイム | (432,000 リクエスト × 3 秒/リクエスト ÷ 3,600 秒/時間)= 360 時間 vCPU: (360 時間 × 1 vCPU × $0.0864/時間)= $31.10 RAM:(360 時間 × 1 GiB × $0.0090/時間)= $3.24 | $34.34 |

コードの実行 | (360 ランタイム時間 × 30% 使用)= 108 時間 vCPU: (108 時間 × 1 vCPU × $0.0864/時間)= $9.33 RAM: (108 時間 × 1 GiB × $0.0090/時間)= $0.97 | $10.30 |

セッション | 432,000 リクエスト × 3 イベント ÷ 1,000 × $0.25 | $324 |

Memory Bank | 保存: (432,000 リクエスト ÷ 10 リクエスト/セッション × 1 メモリ/セッション ÷ 1,000)× $0.25 = $10.80 検索: (432,000 リクエスト × 1 戻りメモリ ÷ 1,000)× $0.50 = $216.00 | $226.80 |

月額費用の合計(推定) | $595.44 |

シナリオ 2: 標準エージェント

このシナリオは、ビジネス アプリケーションに統合された本番環境エージェントが、安定したユーザー トラフィックを処理する様子を表しています。

- ユースケースの例: e コマースサイトのカスタマー サービス エージェント、B2B ウェブサイトのリード評価ボット、営業チーム向けの社内データ分析エージェントなど。

- コンピューティング: 2 vCPU / 5 GiB RAM

- トラフィック: 1 秒あたり 10 クエリ(1 分あたり 600 クエリ)、合計で 1 か月あたり 25,920,000 リクエスト

- 平均リクエスト時間: 5 秒

サービス | 計算 | 1 か月の費用 |

|---|---|---|

ランタイム | (25,920,000 リクエスト × 5 秒/リクエスト ÷ 3,600 秒/時間)= 36,000 時間 vCPU:(36,000 時間 × 2 vCPU × $0.0864/時間)= $6,220.80 RAM:(36,000 時間 × 5 GiB × $0.0090/時間)= $1,620.00 | $7,840.80 |

コードの実行 | (36,000 ランタイム時間 × 30% の使用率)= 10,800 時間 vCPU: (10,800 時間 × 2 vCPU × $0.0864/時間)= $1,866.24 RAM:(10,800 時間 × 5 GiB × $0.0090/時間)= $486 | $2,352.24 |

セッション | 25,920,000 リクエスト * 3 イベント ÷ 1,000 × $0.25 | $19,440 |

メモリバンク | 保存:(25,920,000 リクエスト ÷ 10 リクエスト/セッション × 1 メモリ/セッション ÷ 1,000)× $0.25 = $648.00 検索: (25,920,000 リクエスト × 1 戻りメモリ ÷ 1,000)× $0.50 = $12,960.00 | $13,608 |

月額費用の合計(推定) | $43,241.04 |

Vertex AI での Ray

トレーニング

トレーニング

以下のテーブルは、さまざまなトレーニング構成の 1 時間あたりのおおよその料金を示しています。選択したマシンタイプのカスタム構成を選択できます。料金を計算するには、使用する仮想マシンの費用を合算してください。

Compute Engine マシンタイプにアクセラレータを接続する場合、アクセラレータの費用は含まれません。この費用を計算するには、以下のアクセラレータの表に示す料金に、使用する各タイプのアクセラレータのマシン時間を掛けます。

マシンタイプ

マシンタイプ

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

- Phoenix (us-west8)

マシンタイプ | 料金(米ドル) |

|---|---|

n1-standard-4 | $0.2279988 / 1 hour |

n1-standard-8 | $0.4559976 / 1 hour |

n1-standard-16 | $0.9119952 / 1 hour |

n1-standard-32 | $1.8239904 / 1 hour |

n1-standard-64 | $3.6479808 / 1 hour |

n1-standard-96 | $5.4719712 / 1 hour |

n1-highmem-2 | $0.1419636 / 1 hour |

n1-highmem-4 | $0.2839272 / 1 hour |

n1-highmem-8 | $0.5678544 / 1 hour |

n1-highmem-16 | $1.1357088 / 1 hour |

n1-highmem-32 | $2.2714176 / 1 hour |

n1-highmem-64 | $4.5428352 / 1 hour |

n1-highmem-96 | $6.8142528 / 1 hour |

n1-highcpu-16 | $0.68014656 / 1 hour |

n1-highcpu-32 | $1.36029312 / 1 hour |

n1-highcpu-64 | $2.72058624 / 1 hour |

n1-highcpu-96 | $4.08087936 / 1 hour |

a2-highgpu-1g* | $4.408062 / 1 hour |

a2-highgpu-2g* | $8.816124 / 1 hour |

a2-highgpu-4g* | $17.632248 / 1 hour |

a2-highgpu-8g* | $35.264496 / 1 hour |

a2-highgpu-16g* | $70.528992 / 1 hour |

a3-highgpu-8g* | $105.39898088 / 1 hour |

a3-megagpu-8g* | $110.65714224 / 1 hour |

a4-highgpu-8g* | $148.212 / 1 hour |

e2-standard-4 | $0.16082748 / 1 hour |

e2-standard-4 | $0.32165496 / 1 hour |

e2-standard-16 | $0.64330992 / 1 hour |

e2-standard-32 | $1.28661984 / 1 hour |

e2-highmem-2 | $0.10847966 / 1 hour |

e2-highmem-4 | $0.21695932 / 1 hour |

e2-highmem-8 | $0.43391864 / 1 hour |

e2-highmem-16 | $0.86783728 / 1 hour |

e2-highcpu-16 | $0.4749144 / 1 hour |

e2-highcpu-32 | $0.9498288 / 1 hour |

n2-standard-4 | $0.2330832 / 1 hour |

n2-standard-8 | $0.4661664 / 1 hour |

n2-standard-16 | $0.9323328 / 1 hour |

n2-standard-32 | $1.8646656 / 1 hour |

n2-standard-48 | $2.7969984 / 1 hour |

n2-standard-64 | $3.7293312 / 1 hour |

n2-standard-80 | $4.661664 / 1 hour |

n2-highmem-2 | $0.1572168 / 1 hour |

n2-highmem-4 | $0.3144336 / 1 hour |

n2-highmem-8 | $0.6288672 / 1 hour |

n2-highmem-16 | $1.2577344 / 1 hour |

n2-highmem-32 | $2.5154688 / 1 hour |

n2-highmem-48 | $3.7732032 / 1 hour |

n2-highmem-64 | $5.0309376 / 1 hour |

n2-highmem-80 | $6.288672 / 1 hour |

n2-highcpu-16 | $0.6882816 / 1 hour |

n2-highcpu-32 | $1.3765632 / 1 hour |

n2-highcpu-48 | $2.0648448 / 1 hour |

n2-highcpu-64 | $2.7531264 / 1 hour |

n2-highcpu-80 | $3.441408 / 1 hour |

c2-standard-4 | $0.2505696 / 1 hour |

c2-standard-8 | $0.5011392 / 1 hour |

c2-standard-16 | $1.0022784 / 1 hour |

c2-standard-30 | $1.879272 / 1 hour |

c2-standard-60 | $3.758544 / 1 hour |

m1-ultramem-40 | $7.55172 / 1 hour |

m1-ultramem-80 | $15.10344 / 1 hour |

m1-ultramem-160 | $30.20688 / 1 hour |

m1-megamem-96 | $12.782592 / 1 hour |

Cloud TPU | 料金はアクセラレータのタイプによって決まります。「アクセラレータ」をご覧ください。 |

米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

アクセラレータ

アクセラレータ

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

GPU のタイプ | 料金(米ドル) |

|---|---|

NVIDIA_TESLA_A100 | $3.5206896 / 1 hour |

NVIDIA_TESLA_A100_80GB | $4.517292 / 1 hour |

NVIDIA_H100_80GB | $11.75586073 / 1 hour |

NVIDIA_TESLA_P4 | $0.72 / 1 hour |

NVIDIA_TESLA_P100 | $1.752 / 1 hour |

NVIDIA_TESLA_T4 | $0.42 / 1 hour |

NVIDIA_TESLA_V100 | $2.976 / 1 hour |

TPU_V2 Single(8 コア) | $5.40 / 1 hour |

TPU_V2 Pod(32 コア)* | $28.80 / 1 hour |

TPU_V3 Single(8 コア) | $9.60 / 1 hour |

TPU_V3 Pod(32 コア)* | $38.40 / 1 hour |

米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

* Cloud TPU Pod を使用したトレーニングの料金は、Pod のコア数に基づいています。Pod のコア数は常に 32 の倍数です。32 以上のコアを持つ Pod でのトレーニングの料金は、32 コアの Pod の料金にコア数を 32 で割った数値を掛けます。たとえば、128 コアの Pod の場合、料金は(32 コアの Pod の料金)×(128/32)となります。特定のリージョンで利用可能な Cloud TPU Pod を確認するには、Cloud TPU ドキュメントにあるシステム アーキテクチャをご覧ください。

ディスク

ディスク

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

ディスクタイプ | 料金(米ドル) |

|---|---|

pd-standard | $0.000065753 / 1 gibibyte hour |

pd-ssd | $0.000279452 / 1 gibibyte hour |

米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

- すべてのご利用は Vertex AI の割り当てポリシーの対象となります。

- Vertex AI のライフサイクル中は、データやプログラム ファイルを Google Cloud Storage のバケットに保存する必要があります。詳しくは、Cloud Storage の使用方法をご覧ください。

ジョブにリソースがプロビジョニングされた時点で、ジョブが完了するまで、モデルのトレーニングに対する料金が発生します。

警告: トレーニング ジョブは、Vertex AI 割り当てポリシーによる制限の対象となります。最初のトレーニング ジョブに強力な処理クラスタを選択すると、割り当てを超過する可能性が高くなります。

予測と説明

以下のテーブルは、ノード時間あたりのバッチ予測、オンライン予測、およびオンライン説明の料金を示しています。ノード時間とは、仮想マシンが予測ジョブを実行している時間、または予測または説明リクエストを処理するためにアクティブな状態(1 つ以上のモデルがデプロイされたエンドポイント)で待機している時間を表します。

Vertex AI Inference で Spot VM を使用できます。 Spot VM の料金は、Compute Engine Spot VM の料金に基づいて請求されます。インフラストラクチャの使用料とは別に、以下の表に記載のとおり、Vertex AI 推論の管理手数料が発生します。

Vertex AI 推論で Compute Engine の予約を使用できます。Compute Engine の予約を使用すると、適用される確約利用割引(CUD)を含む Compute Engine の料金に従って課金されます。インフラストラクチャの使用料とは別に、以下の表に記載のとおり、Vertex AI 推論の管理手数料が発生します。

E2 シリーズ

E2 シリーズ

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

e2-standard-2 | $0.0770564 / 1 hour |

e2-standard-4 | $0.1541128 / 1 hour |

e2-standard-8 | $0.3082256 / 1 hour |

e2-standard-16 | $0.6164512 / 1 hour |

e2-standard-32 | $1.2329024 / 1 hour |

e2-highmem-2 | $0.1039476 / 1 hour |

e2-highmem-4 | $0.2078952 / 1 hour |

e2-highmem-8 | $0.4157904 / 1 hour |

e2-highmem-16 | $0.8315808 / 1 hour |

e2-highcpu-2 | $0.056888 / 1 hour |

e2-highcpu-4 | $0.113776 / 1 hour |

e2-highcpu-8 | $0.227552 / 1 hour |

e2-highcpu-16 | $0.455104 / 1 hour |

e2-highcpu-32 | $0.910208 / 1 hour |

N1 シリーズ

N1 シリーズ

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Milan (europe-west8)

- Paris (europe-west9)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

n1-standard-2 | $0.1095 / 1 hour |

n1-standard-4 | $0.219 / 1 hour |

n1-standard-8 | $0.438 / 1 hour |

n1-standard-16 | $0.876 / 1 hour |

n1-standard-32 | $1.752 / 1 hour |

n1-highmem-2 | $0.137 / 1 hour |

n1-highmem-4 | $0.274 / 1 hour |

n1-highmem-8 | $0.548 / 1 hour |

n1-highmem-16 | $1.096 / 1 hour |

n1-highcpu-2 | $0.081 / 1 hour |

n1-highcpu-4 | $0.162 / 1 hour |

n1-highcpu-8 | $0.324 / 1 hour |

n1-highcpu-16 | $0.648 / 1 hour |

n1-highcpu-32 | $1.296 / 1 hour |

N2 シリーズ

N2 シリーズ

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

n2-standard-2 | $0.1116854 / 1 hour |

n2-standard-4 | $0.2233708 / 1 hour |

n2-standard-8 | $0.4467416 / 1 hour |

n2-standard-16 | $0.8934832 / 1 hour |

n2-standard-32 | $1.7869664 / 1 hour |

n2-highmem-2 | $0.1506654 / 1 hour |

n2-highmem-4 | $0.3013308 / 1 hour |

n2-highmem-8 | $0.6026616 / 1 hour |

n2-highmem-16 | $1.2053232 / 1 hour |

n2-highcpu-2 | $0.0824504 / 1 hour |

n2-highcpu-4 | $0.1649008 / 1 hour |

n2-highcpu-8 | $0.3298016 / 1 hour |

n2-highcpu-16 | $0.6596032 / 1 hour |

n2-highcpu-32 | $1.3192064 / 1 hour |

N2D シリーズ

N2D シリーズ

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

n2d-standard-2 | $0.0971658 / 1 hour |

n2d-standard-4 | $0.1943316 / 1 hour |

n2d-standard-8 | $0.3886632 / 1 hour |

n2d-standard-16 | $0.7773264 / 1 hour |

n2d-standard-32 | $1.5546528 / 1 hour |

n2d-highmem-2 | $0.131077 / 1 hour |

n2d-highmem-4 | $0.262154 / 1 hour |

n2d-highmem-8 | $0.524308 / 1 hour |

n2d-highmem-16 | $1.048616 / 1 hour |

n2d-highcpu-2 | $0.0717324 / 1 hour |

n2d-highcpu-4 | $0.1434648 / 1 hour |

n2d-highcpu-8 | $0.2869296 / 1 hour |

n2d-highcpu-16 | $0.5738592 / 1 hour |

n2d-highcpu-32 | $1.1477184 / 1 hour |

C2 シリーズ

C2 シリーズ

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

c2-standard-4 | $0.240028 / 1 hour |

c2-standard-8 | $0.480056 / 1 hour |

c2-standard-16 | $0.960112 / 1 hour |

c2-standard-30 | $1.80021 / 1 hour |

c2-standard-60 | $3.60042 / 1 hour |

C2D シリーズ

C2D シリーズ

- Taiwan (asia-east1)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

c2d-standard-2 | $0.1044172 / 1 hour |

c2d-standard-4 | $0.2088344 / 1 hour |

c2d-standard-8 | $0.4176688 / 1 hour |

c2d-standard-16 | $0.8353376 / 1 hour |

c2d-standard-32 | $1.6706752 / 1 hour |

c2d-standard-56 | $2.9236816 / 1 hour |

c2d-standard-112 | $5.8473632 / 1 hour |

c2d-highmem-2 | $0.1408396 / 1 hour |

c2d-highmem-4 | $0.2816792 / 1 hour |

c2d-highmem-8 | $0.5633584 / 1 hour |

c2d-highmem-16 | $1.1267168 / 1 hour |

c2d-highmem-32 | $2.2534336 / 1 hour |

c2d-highmem-56 | $3.9435088 / 1 hour |

c2d-highmem-112 | $7.8870176 / 1 hour |

c2d-highcpu-2 | $0.086206 / 1 hour |

c2d-highcpu-4 | $0.172412 / 1 hour |

c2d-highcpu-8 | $0.344824 / 1 hour |

c2d-highcpu-16 | $0.689648 / 1 hour |

c2d-highcpu-32 | $1.379296 / 1 hour |

c2d-highcpu-56 | $2.413768 / 1 hour |

c2d-highcpu-112 | $4.827536 / 1 hour |

C3 シリーズ

C3 シリーズ

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

マシンタイプ | 料金(米ドル) |

|---|---|

c3-highcpu-4 | $0.19824 / 1 hour |

c3-highcpu-8 | $0.39648 / 1 hour |

c3-highcpu-22 | $1.09032 / 1 hour |

c3-highcpu-44 | $2.18064 / 1 hour |

c3-highcpu-88 | $4.36128 / 1 hour |

c3-highcpu-176 | $8.72256 / 1 hour |

A2 シリーズ

A2 シリーズ

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Singapore (asia-southeast1)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Oregon (us-west1)

- Salt Lake City (us-west3)

マシンタイプ | 料金(米ドル) |

|---|---|

a2-highgpu-1g | $4.2244949 / 1 hour |

a2-highgpu-2g | $8.4489898 / 1 hour |

a2-highgpu-4g | $16.8979796 / 1 hour |

a2-highgpu-8g | $33.7959592 / 1 hour |

a2-megagpu-16g | $64.1020592 / 1 hour |

a2-ultragpu-1g | $5.7818474 / 1 hour |

a2-ultragpu-2g | $11.5636948 / 1 hour |

a2-ultragpu-4g | $23.1273896 / 1 hour |

a2-ultragpu-8g | $46.2547792 / 1 hour |

予約または Spot 容量から消費する場合、課金は 2 つの SKU(ラベル「vertex-ai-online-prediction」の GCE SKU と Vertex AI 管理手数料 SKU)に分散されます。これにより、Vertex AI で確約利用割引(CUD)を使用できます。

A3 シリーズ

A3 シリーズ

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Delhi (asia-south2)

- Singapore (asia-southeast1)

- Sydney (australia-southeast1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Toronto (northamerica-northeast2)

- Iowa (us-central1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

a3-ultragpu-8g | $96.015616 / 1 hour |

a3-megagpu-8g | $106.65474 / 1 hour |

予約または Spot 容量から消費する場合、課金は 2 つの SKU(ラベル「vertex-ai-online-prediction」の GCE SKU と Vertex AI 管理手数料 SKU)に分散されます。これにより、Vertex AI で確約利用割引(CUD)を使用できます。

A4 シリーズ

A4 シリーズ

- Singapore (asia-southeast1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Los Angeles (us-west2)

マシンタイプ | 料金(米ドル) |

|---|---|

a4-highgpu-8g | $148.212 / 1 hour |

予約または Spot 容量から消費する場合、課金は 2 つの SKU(ラベル「vertex-ai-online-prediction」の GCE SKU と Vertex AI 管理手数料 SKU)に分散されます。これにより、Vertex AI で確約利用割引(CUD)を使用できます。

A4X シリーズ

A4X シリーズ

- Netherlands (europe-west4)

- Iowa (us-central1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

マシンタイプ | 料金(米ドル) |

|---|---|

a4x-highgpu-4g | $74.75 / 1 hour |

予約または Spot 容量から消費する場合、課金は 2 つの SKU(ラベル「vertex-ai-online-prediction」の GCE SKU と Vertex AI 管理手数料 SKU)に分散されます。これにより、Vertex AI で確約利用割引(CUD)を使用できます。

a4x-highgpu-4g には 18 個以上の VM が必要です。

G2 シリーズ

G2 シリーズ

- Taiwan (asia-east1)

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Dammam (me-central2)

- Toronto (northamerica-northeast2)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

g2-standard-4 | $0.81293 / 1 hour |

g2-standard-8 | $0.98181 / 1 hour |

g2-standard-12 | $1.15069 / 1 hour |

g2-standard-16 | $1.31957 / 1 hour |

g2-standard-24 | $2.30138 / 1 hour |

g2-standard-32 | $1.99509 / 1 hour |

g2-standard-48 | $4.60276 / 1 hour |

g2-standard-96 | $9.20552 / 1 hour |

予約または Spot 容量から消費する場合、課金は 2 つの SKU(ラベル「vertex-ai-online-prediction」の GCE SKU と Vertex AI 管理手数料 SKU)に分散されます。これにより、Vertex AI で確約利用割引(CUD)を使用できます。

G4 シリーズ

G4 シリーズ

- Taiwan (asia-east1)

- Delhi (asia-south2)

- Singapore (asia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- Netherlands (europe-west4)

- Milan (europe-west8)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Alabama (us-east7)

- Oregon (us-west1)

- Salt Lake City (us-west3)

マシンタイプ | 料金(米ドル) |

|---|---|

g4-standard-48 | $5.1749195 / 1 hour |

g4-standard-384 | $10.349839 / 1 hour |

g4-standard-384 | $20.699678 / 1 hour |

g4-standard-384 | $41.399356 / 1 hour |

TPU v5e の料金

TPU v5e の料金

- Singapore (asia-southeast1)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Oregon (us-west1)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

ct5lp-hightpu-1t | $1.38 / 1 hour |

ct5lp-hightpu-4t | $5.52 / 1 hour |

ct5lp-hightpu-8t | $5.52 / 1 hour |

TPU v6e の料金

TPU v6e の料金

- Tokyo (asia-northeast1)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- London (europe-west2)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

マシンタイプ | 料金(米ドル) |

|---|---|

ct6e-standard-1t | $3.105 / 1 hour |

ct6e-standard-4t | $12.42 / 1 hour |

ct6e-standard-8t | $24.84 / 1 hour |

各 マシンタイプ は、Google Cloud の請求書に以下の SKU として請求されます。

- vCPU 料金: vCPU 時間で測定

- RAM 料金: GB 時間で測定

- GPU 料金: マシンに組み込まれているか、オプションで設定されている場合、GPU 時間で測定

マシンタイプの料金は、そのマシンタイプを使用するモデル バージョンの各予測ノードの 1 時間あたりの総コストを概算するために使用されます。

たとえば、マシンタイプが n1-highcpu-32 の場合、32 個の vCPU と 32 GB の RAM が含まれます。したがって、1 時間あたりの料金は、32 vCPU 時間 + 32 GB 時間となります。

E2 シリーズ

E2 シリーズ

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

項目 | 料金(米ドル) |

|---|---|

vCPU | $0.0250826 / 1 hour |

RAM | $0.0033614 / 1 gibibyte hour |

N1 シリーズ

N1 シリーズ

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

項目 | 料金(米ドル) |

|---|---|

vCPU | $0.036 / 1 hour |

RAM | $0.005 / 1 gibibyte hour |

N2 シリーズ

N2 シリーズ

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

項目 | 料金(米ドル) |

|---|---|

vCPU | $0.0363527 / 1 hour |

RAM | $0.0048725 / 1 gibibyte hour |

N2D シリーズ

N2D シリーズ

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

項目 | 料金(米ドル) |

|---|---|

vCPU | $0.0316273 / 1 hour |

RAM | $0.0042389 / 1 gibibyte hour |

C2 シリーズ

C2 シリーズ

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

項目 | 料金(米ドル) |

|---|---|

vCPU | $0.039077 / 1 hour |

RAM | $0.0052325 / 1 gibibyte hour |

C2D シリーズ

C2D シリーズ

- Taiwan (asia-east1)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Las Vegas (us-west4)

項目 | 料金(米ドル) |

|---|---|

vCPU | $0.0339974 / 1 hour |

RAM | $0.0045528 / 1 gibibyte hour |

C3 シリーズ

C3 シリーズ

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- Netherlands (europe-west4)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

項目 | 料金(米ドル) |

|---|---|

vCPU | $0.03908 / 1 hour |

RAM | $0.00524 / 1 gibibyte hour |

A2 シリーズ

A2 シリーズ

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Singapore (asia-southeast1)

- Netherlands (europe-west4)

- Tel Aviv (me-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Oregon (us-west1)

- Salt Lake City (us-west3)

項目 | 料金(米ドル) |

|---|---|

vCPU | $0.0363527 / 1 hour |

RAM | $0.0048725 / 1 gibibyte hour |

GPU(A100 40 GB) | $3.3741 / 1 hour |

GPU(A100 80 GB) | $4.51729 / 1 hour |

A3 シリーズ

A3 シリーズ

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Delhi (asia-south2)

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Toronto (northamerica-northeast2)

- Iowa (us-central1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Las Vegas (us-west4)

項目 | 料金(米ドル) |

|---|---|

vCPU | $0.0293227 / 1 hour |

RAM | $0.0025534 / 1 gibibyte hour |

GPU(H100 80 GB) | $11.2660332 / 1 hour |

GPU(H200) | $10.708501 / 1 hour |

G2 シリーズ

G2 シリーズ

- Taiwan (asia-east1)

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Dammam (me-central2)

- Toronto (northamerica-northeast2)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Las Vegas (us-west4)

項目 | 料金(米ドル) |

|---|---|

vCPU | $0.02874 / 1 hour |

RAM | $0.00337 / 1 gibibyte hour |

GPU(L4) | $0.64405 / 1 hour |

マシンタイプによっては、予測用に GPU アクセラレータを追加できます。GPU には、前の表で説明したものとは別の追加料金がかかります。各オプション GPU の料金については、料金表をご覧ください。

アクセラレータ - 1 時間あたりの料金

アクセラレータ - 1 時間あたりの料金

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

GPU のタイプ | 料金(米ドル) |

|---|---|

NVIDIA_TESLA_P4 | $0.69 / 1 hour |

NVIDIA_TESLA_P100 | $1.679 / 1 hour |

NVIDIA_TESLA_T4 | $0.402 / 1 hour |

NVIDIA_TESLA_V100 | $2.852 / 1 hour |

料金は GPU 単位です。予測ノードごとに複数の GPU を使用する場合(または、複数のノードを使用するようにバージョンをスケールする場合)は、それに応じて費用もスケールします。

AI Platform Prediction では、モデルに基づく予測を提供する際に複数の仮想マシン(「ノード」)を実行します。デフォルトでは、Vertex AI により、実行するノードの数が常に自動的にスケールされます。オンライン予測の場合、ノードの数は需要の増減に応じてスケールされます。各ノードで複数の予測リクエストにレスポンスできます。バッチ予測の場合、ノードの数はジョブの実行にかかる合計時間を短縮するようにスケールされます。予測ノードのスケール方法はカスタマイズできます。

各ノードでモデルを実行した時間に対して料金が発生します。以下が課金対象の時間となります。

- ノードによるバッチ予測ジョブの処理時間

- ノードによるオンライン予測リクエストの処理時間

- ノードがオンライン予測の準備状態になっている時間

1 つのノードを 1 時間実行したときの料金が 1 ノード時間です。予測ジョブの料金の表にはノード時間あたりの料金が記載されています。この料金は各リージョンで異なり、オンライン予測とバッチ予測の間でも異なります。

ノード時間は小数単位で増やすことができます。たとえば、1 つのノードを 30 分間実行すると 0.5 ノード時間となります。

Compute Engine(N1)マシンタイプの料金計算

- ノードの実行時間は、30 秒単位で課金されます。つまり 30 秒ごとに、ノードがその時点で使用している vCPU、RAM、GPU リソースの 30 秒分の料金がプロジェクトに対して課金されます。

予測ノードの自動スケーリングの詳細

オンライン予測 | バッチ予測 |

|---|---|

スケーリングでは、個々のリクエストのレイテンシを低減することが優先されます。このサービスでは、リクエストへの対応後、数分間にわたってモデルがアイドル状態に維持されます。 | スケーリングでは、ジョブの合計経過時間を短縮することが優先されます。 |

スケーリングは毎月の合計料金に影響します。リクエストの数や頻度が増えるほど、使用されるノード数も多くなります。 | スケールすると、新しいノードの立ち上げに関連するオーバーヘッドが若干発生しますが、ジョブの料金にはほとんど影響しません。 |

トラフィック量に応じてサービスにスケールさせること(自動スケーリング)も、レイテンシを回避するために継続実行ノード数を設定すること(手動スケーリング)もできます。

| バッチ予測に使用するノードの最大数を設定し、モデルのデプロイ時に実行を続けるノード数を設定することで、スケーリングに影響を与えることができます。 |

バッチ予測ジョブは、ジョブの完了後に課金されます

バッチ予測ジョブは、ジョブの実行中に料金が加算されていくのではなく、ジョブの完了後に課金されます。構成済みの Cloud Billing 予算アラートも、ジョブの実行中にトリガーされません。大規模なジョブを開始する前には、少量の入力データでコスト ベンチマーク ジョブをいくつか実行することを検討してください。

予測ジョブの計算の例

南北アメリカ リージョンのある不動産会社が、営業対象地域の住宅価格の週次予測ジョブを実行しているとします。ある月、4 週間分の予測ジョブをそれぞれ 3920、4277、3849、3961 のバッチで実行しました。ジョブは 1 つのノードに制限され、各インスタンスの処理には平均で 0.72 秒かかりました。

まず、各ジョブの実行時間を計算します。

- 計算

どのジョブも実行時間が 10 分を超えているため、処理時間 1 分ごとに課金されます。

- 計算

1 か月の総額は $0.26 になります。

この例では、ジョブが単一ノードで実行され、入力インスタンスごとに一定の時間がかかったと想定しています。実際の使用では、必ず複数のノードを考慮に入れ、各ノードの実際の実行時間を計算に使用してください。

Vertex Explainable AI の料金

Vertex Explainable AI の料金

特徴ベースの説明

特徴ベースの説明では、予測料金への追加料金は発生しません。ただし、説明の処理は通常の予測よりも時間を要するため、自動スケーリングで Vertex Explainable AI を多用すると、開始されるノードが増加し、予測の料金が増加する可能性があります。

例ベースの説明

例ベースの説明の料金は、以下の要素で構成されています。

- モデルをアップロードするか、モデルのデータセットを更新すると、課金が発生します。

- 例の潜在空間表現を生成するために使用されるバッチ予測ジョブごとの 1 ノード時間は、予測と同じレートで課金されます。

- インデックスを作成または更新するための費用は、ベクトル検索のインデックスの料金と同じで、例の数 × 次元数 × 1 フロートあたり 4 バイト × 1 GB あたり $3.00 で計算されます。たとえば、100 万の例と 1,000 次元の潜在空間がある場合、費用は $12(1,000,000 x 1,000 x 4 x 3.00 ÷ 1,000,000,000)となります。

- エンドポイントにデプロイする際には、エンドポイント内の各ノードごとに 1 ノード時間あたりの料金が課金されます。エンドポイントに関連するすべてのコンピューティングは、予測と同じレートで課金されます。しかし、例に基づく説明ではベクトル検索インデックスを利用するための追加のコンピューティング リソースが必要であり、その結果、より多くのノードが起動され、予測料金が増加することになります。

Vertex AI Neural Architecture Search

次のテーブルは、Neural Architecture Search を利用できる各リージョンの料金をまとめたものです。

価格

価格

次のテーブルに、さまざまな構成の 1 時間あたりの料金を示します。

事前定義されたスケール階層を選択することも、特定のマシンタイプからなるカスタム構成を選択することもできます。カスタム構成を選択する場合は、使用する仮想マシンの費用を合算してください。

アクセラレータを有効にした従来のマシンタイプの料金には、アクセラレータの費用が含まれます。Compute Engine マシンタイプにアクセラレータを接続する場合、アクセラレータの費用は含まれません。この費用を計算するには、以下のアクセラレータのテーブルに記載の料金に、使用する各アクセラレータの数を掛けます。

マシンタイプ

マシンタイプ

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

n1-standard-4 | $0.2849985 / 1 hour |

n1-standard-8 | $0.569997 / 1 hour |

n1-standard-16 | $1.139994 / 1 hour |

n1-standard-32 | $2.279988 / 1 hour |

n1-standard-64 | $4.559976 / 1 hour |

n1-standard-96 | $6.839964 / 1 hour |

n1-highmem-2 | $0.1774545 / 1 hour |

n1-highmem-4 | $0.1774545 / 1 hour |

n1-highmem-8 | $0.709818 / 1 hour |

n1-highmem-16 | $1.419636 / 1 hour |

n1-highmem-32 | $2.839272 / 1 hour |

n1-highmem-64 | $5.678544 / 1 hour |

n1-highmem-96 | $8.517816 / 1 hour |

n1-highcpu-16 | $0.8501832 / 1 hour |

n1-highcpu-32 | $1.7003664 / 1 hour |

n1-highcpu-64 | $3.4007328 / 1 hour |

n1-highcpu-96 | $5.1010992 / 1 hour |

a2-highgpu-1g | $5.641070651 / 1 hour |

a2-highgpu-2g | $11.282141301 / 1 hour |

a2-highgpu-4g | $22.564282603 / 1 hour |

a2-highgpu-8g | $45.128565205 / 1 hour |

a2-highgpu-16g | $90.257130411 / 1 hour |

e2-standard-4 | $0.20103426 / 1 hour |

e2-standard-8 | $0.40206852 / 1 hour |

e2-standard-16 | $0.80413704 / 1 hour |

e2-standard-32 | $1.60827408 / 1 hour |

e2-highmem-2 | $0.13559949 / 1 hour |

e2-highmem-4 | $0.27119898 / 1 hour |

e2-highmem-8 | $0.54239796 / 1 hour |

e2-highmem-16 | $1.08479592 / 1 hour |

e2-highcpu-16 | $0.59364288 / 1 hour |

e2-highcpu-32 | $1.18728576 / 1 hour |

n2-standard-4 | $0.291354 / 1 hour |

n2-standard-8 | $0.582708 / 1 hour |

n2-standard-16 | $1.165416 / 1 hour |

n2-standard-32 | $2.330832 / 1 hour |

n2-standard-48 | $3.496248 / 1 hour |

n2-standard-64 | $4.661664 / 1 hour |

n2-standard-80 | $5.82708 / 1 hour |

n2-highmem-2 | $0.196521 / 1 hour |

n2-highmem-4 | $0.393042 / 1 hour |

n2-highmem-8 | $0.786084 / 1 hour |

n2-highmem-16 | $1.572168 / 1 hour |

n2-highmem-32 | $3.144336 / 1 hour |

n2-highmem-48 | $4.716504 / 1 hour |

n2-highmem-64 | $6.288672 / 1 hour |

n2-highmem-80 | $7.86084 / 1 hour |

n2-highcpu-16 | $0.860352 / 1 hour |

n2-highcpu-32 | $1.720704 / 1 hour |

n2-highcpu-64 | $3.441408 / 1 hour |

n2-highcpu-80 | $4.30176 / 1 hour |

c2-standard-4 | $0.313212 / 1 hour |

c2-standard-8 | $0.626424 / 1 hour |

c2-standard-16 | $1.252848 / 1 hour |

c2-standard-30 | $2.34909 / 1 hour |

c2-standard-60 | $4.69818 / 1 hour |

米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

a2-highgpu インスタンスの料金には、追加された NVIDIA_TESLA_A100 アクセラレータの料金が含まれています。

アクセラレータ

アクセラレータ

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

GPU のタイプ | 料金(米ドル) |

|---|---|

NVIDIA_TESLA_A100 | $4.400862 / 1 hour |

NVIDIA_TESLA_P4 | $0.90 / 1 hour |

NVIDIA_TESLA_P100 | $2.19 / 1 hour |

NVIDIA_TESLA_T4 | $0.525 / 1 hour |

NVIDIA_TESLA_V100 | $3.72 / 1 hour |

米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

ディスク

ディスク

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

ディスクタイプ | 料金(米ドル) |

|---|---|

pd-standard | $0.000082192 / 1 gibibyte hour |

pd-ssd | $0.000349315 / 1 gibibyte hour |

米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

注:

- すべてのご利用は Neural Architecture Search の割り当てポリシーの対象となります。

- Neural Architecture Search のライフサイクル中は、データやプログラム ファイルを Cloud Storage バケットに保存する必要があります。詳しくは、Cloud Storage の使用方法をご覧ください。

- ボリューム ベースの割引については、セールスチームにお問い合わせください。

- 各 VM のディスクサイズを 100 GB 以上に構成した場合のみ、ディスク料金が発生します。各 VM の最初の 100 GB(デフォルトのディスクサイズ)は無料です。たとえば、各 VM に 105 GB のディスクを構成するように設定した場合、VM ごとに 5 GB のディスク料金が請求されます。

Cloud Storage の利用が必須になる場合

Cloud Storage の利用が必須になる場合

このドキュメントに記載されている費用のほかに、Neural Architecture Search のライフサイクル中にはデータやプログラム ファイルを Cloud Storage バケットに保存する必要があります。このストレージは、Cloud Storage 料金ポリシーの対象になります。

次の場合は Cloud Storage の利用が必須となります。

- トレーニング アプリケーション パッケージをステージする。

- トレーニングの入力データを保存する。

注: BigQuery など別の Google Cloud サービスで入力データを保存することもできますが、その場合、利用するサービスの料金が適用されます。

- ジョブの出力を保存する。Neural Architecture Search の場合、こうした出力を長期間保存する必要はありません。オペレーションが完了したら、すぐにファイルを削除できます。

リソースを管理するための無料のオペレーション

リソースを管理するための無料のオペレーション

Neural Architecture Search が提供するリソース管理オペレーションは、無料で利用できます。ただし、Neural Architecture Search 割り当てポリシーにより、オペレーションの一部が制限されます。

リソース | 無料のオペレーション |

|---|---|

ジョブ | get、list、cancel |

オペレーション | get、list、cancel、delete |

Vertex AI Pipelines

Vertex AI Pipelines では、パイプライン実行ごとに $0.03 の実行料金が課金されます。プレビュー リリース中は、実行料金が請求されません。また、パイプライン コンポーネントによって消費される Compute Engine リソースなど、Vertex AI Pipelines で使用する Google Cloud リソースの料金も発生します(Vertex AI Training と同じ料金が発生します)。また、パイプラインによって呼び出されるサービス(Dataflow など)の費用はお客様の負担となります。

Vertex AI Feature Store

Vertex AI Feature Store は、2023 年 11 月より一般提供(GA)されています。以前のバージョンのプロダクトについては、Vertex AI Feature Store(従来版)をご覧ください。

新しい Vertex AI Feature Store

新しい Vertex AI Feature Store

新しい Vertex AI Feature Store では、次の 2 種類のオペレーションの機能がサポートされています。

- オフライン オペレーション: オフライン ストア(BigQuery)のデータを転送、保存、取得、変換するオペレーション

- オンライン オペレーション: オンライン ストアにデータを転送するオペレーションと、オンライン ストア内のデータに対するオペレーション

オフライン オペレーションの料金

オフライン オペレーションには BigQuery が使用されるため、オフライン ストアへの取り込み、オフライン ストアに対するクエリ、オフライン ストレージなどの機能については、BigQuery の料金をご覧ください。

オンライン オペレーションの料金

オンライン オペレーションでは、オンライン ストアへのデータ転送(データの提供またはデータの保存)を行う GA 機能に対して Vertex AI Feature Store の料金が発生します。ノード時間は、仮想マシンがオペレーションを完了するのに費やした時間を表し、分単位で課金されます。

- Johannesburg (africa-south1)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Warsaw (europe-central2)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Milan (europe-west8)

- Doha (me-central1)

- Dammam (me-central2)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

オペレーション | 料金(米ドル) |

|---|---|

データ処理ノード データ処理(オンライン データベースへの取り込みなど) 保存、モニタリングなど) | $0.08 / 1 hour |

最適化オンライン サービング ノード 低レイテンシのサービングとエンベディングのサービング 各ノードには 200 GB のストレージが含まれる | $0.30 / 1 hour |

Bigtable オンライン サービング ノード Cloud Bigtable でのサービング | $0.94 / 1 hour |

Bigtable オンライン サービング ストレージ Cloud Bigtable でのサービング用のストレージ | $0.000342466 / 1 gibibyte hour |

最適化されたオンライン サービングと Bigtable オンライン サービングは異なるアーキテクチャを使用するため、これらのノードは同等ではありません。

米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

オンライン オペレーションのワークロードの見積もり

ワークロードを見積もる際は、以下のガイドラインを考慮してください。ワークロードに必要なノード数は、サービング方法によって異なる場合があります。

- データ処理:

- 取り込み - 分析関数を使用しない場合、1 つのノードで 1 時間あたり最低約 100 MiB のデータを Bigtable オンライン ストアまたは最適化されたオンライン ストアに取り込むことができます。

- Bigtable オンライン サービング: 各ノードは、約 15,000 QPS と最大 5 TB のストレージをサポートできます。

- 最適化されたオンライン サービング: パフォーマンスは、ワークロードに応じて費用を最小限に抑えるように自動的に構成されるマシンタイプとレプリカに基づきます。各ノードは、高可用性と自動スケーリングのために、最小 2 個、最大 6 個のレプリカを持つことができます。レプリカの数に応じて課金されます。詳しくは、月ごとのシナリオの例をご覧ください。

- エンベディング関連以外のワークロードの場合、各ノードは、約 500 QPS と最大 200 GB のストレージをサポートできます。

- エンべディング関連のワークロードの場合、各ノードは、約 500 QPS と最大 4 GB のストレージ(512 次元のデータ)をサポートできます。

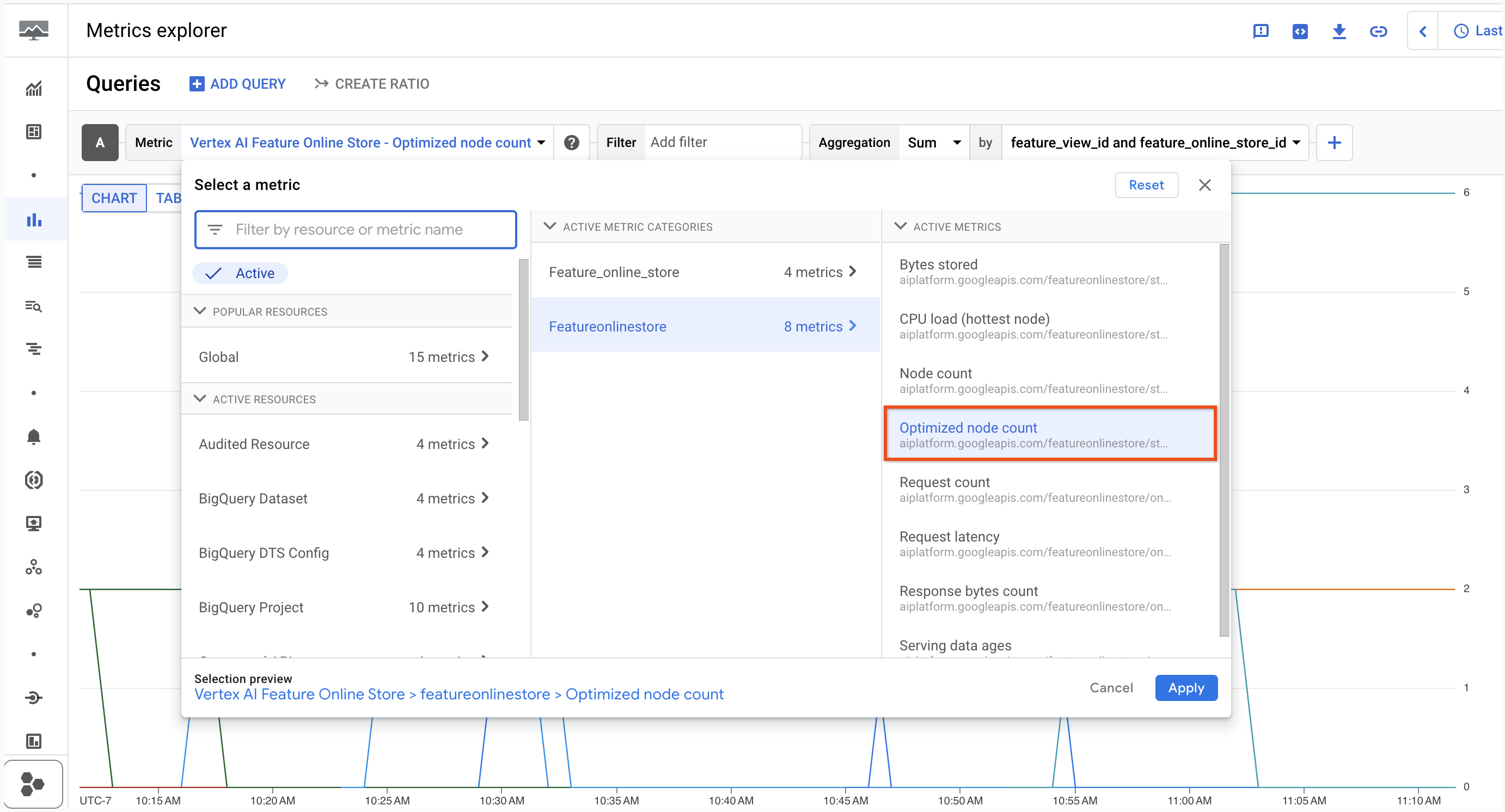

ノード数(レプリカを含む)は、Metrics Explorer で確認できます。

月次シナリオの例(us-central1 を想定)

データ ストリームのワークロード - 2.5 TB のデータ(1 日あたり 1 GB 更新)と 1,200 QPS の Bigtable オンライン サービング

運用 | 月間使用量 | 1 か月の費用 |

|---|---|---|

データ処理ノード | (1 GB/日)×(30 日/月)×(1,000 MB/GB)×(1 ノード時間 / 100 MB)= 300 ノード時間 | 300 ノード時間 ×(1 ノード時間あたり $0.08)= $24 |

最適化オンライン サービング ノード | なし | なし |

Bigtable オンライン サービング ノード | (1 ノード)×(24 時間/日)×(30 日/月)= 720 ノード時間 | 720 ノード時間 ×(1 ノード時間あたり $0.94)= $677 |

Bigtable オンライン サービング ストレージ | (2.5 TB/月)×(1,000 GB/TB)= 2,500 GB/月 | 2,500 GB/月 ×(GB/月 $0.25)= $625 |

合計 | $1,326 |

高 QPS ワークロード - 10 GB の非エンベディング データ(1 日あたり 5 GB 更新)と 2,000 QPS の最適化されたオンライン サービング

運用 | 月間使用量 | 1 か月の費用 |

|---|---|---|

データ処理ノード | (5 GB/日)×(30 日/月)×(1,000 MB/GB)×(1 ノード時間 / 100 MB)= 1,500 ノード時間 | 1,500 ノード時間 ×(1 ノード時間あたり $0.08)= $120 |

最適化オンライン サービング ノード | Roundup(10 GB * (1 ノード / 200 GB)) = 1 * max(2 デフォルト レプリカ, 2,000 QPS * (1 レプリカ / 500 QPS)) = 4 合計ノード * (24 時間/日) * (30 日/月) =2,880 ノード時間 | 2,880 ノード時間 ×(1 ノード時間あたり $0.30)= $864 |

Bigtable オンライン サービング ノード | なし | なし |

Bigtable オンライン サービング ストレージ | なし | なし |

合計 | $984 |

エンベディング サービングのワークロード - 20 GB のエンベディング データ(1 日あたり 2 GB 更新)と 800 QPS の最適化されたオンライン サービング

運用 | 月間使用量 | 1 か月の費用 |

|---|---|---|

データ処理ノード | (2 GB/日)×(30 日/月)×(1,000 MB/GB)×(1 ノード時間 / 100 MB)= 600 ノード時間 | 600 ノード時間 ×(1 ノード時間あたり $0.08)= $48 |

最適化オンライン サービング ノード | Roundup(20GB* (1 ノード / 4GB) = 5 * max(2 デフォルト レプリカ, 800 QPS * (1 レプリカ / 500 QPS)) = 10 合計ノード * (24 時間/日) * (30 日/月) = 7200 ノード時間 | 7,200 ノード時間 ×(1 ノード時間あたり $0.30)= $2,160 |

Bigtable オンライン サービング ノード | なし | なし |

Bigtable オンライン サービング ストレージ | なし | なし |

合計 | $2,208 |

Vertex AI Feature Store(従来版)

Vertex AI Feature Store(従来版)

Vertex AI Feature Store(従来版)の料金は、オンラインおよびオフライン ストレージの特徴データ量と、オンライン サービスの可用性に基づきます。1 時間あたりのノードは、仮想マシンが特徴データの提供に費やした時間、または特徴データ リクエスト処理の待機に費やした時間を表します。

オペレーション | 料金(米ドル) |

|---|---|

オンライン ストレージ | $0.25/GB/月 |

オフライン ストレージ | $0.023/GB/月 |

オンライン サービング | 1 ノード 1 時間あたり $0.94 |

バッチ エクスポート | $0.005/GB |

ストリーミング取り込み | 取り込み 1 GB あたり $0.10 |

米ドル以外の通貨でお支払いの場合は、Cloud Platform SKU に記載されている該当通貨の料金が適用されます。

特徴量のモニタリングを有効にすると、上記の料金に加え、以下の料金が課金されます。

- 分析されたすべてのデータに対して 1 GB あたり $3.50。スナップショット分析を有効にすると、Vertex AI Feature Store(従来版)で取得されたデータのスナップショットが含まれます。特徴分析のインポートを有効にした場合、取り込まれたデータのバッチが含まれます。

- 特徴値モニタリングで使用される、その他の Vertex AI Feature Store(従来版)オペレーションの追加料金には、以下が含まれます。

- スナップショット分析の機能は、構成したモニタリング間隔に基づいて特徴値のスナップショットを定期的に取得します。

- スナップショットのエクスポートにかかる料金は、通常のバッチ エクスポートの操作と同じです。

スナップショットの分析例

データ サイエンティストが Vertex AI Feature Store(従来版)の特徴値モニタリングを有効にし、日次のスナップショット分析のモニタリングをオンにします。エンティティ タイプのモニタリングのためにパイプラインが日次で実行されます。パイプラインで Vertex AI Feature Store(従来版)内の 2 GB のデータをスキャンし、0.1 GB のデータを含むスナップショットをエクスポートします。1 日の分析にかかる合計料金は次のとおりです。

(0.1 GB × $3.50)+(2 GB × $0.005)= $0.36

取り込みの分析例

データ サイエンティストが Vertex AI Feature Store(従来版)の特徴値モニタリングを有効にし、取り込みオペレーションのモニタリングをオンにします。取り込みオペレーションで Vertex AI Feature Store(従来版)に 1 GB のデータをインポートします。特徴値モニタリングの合計料金は次のとおりです。

(1 GB × $3.50)= $3.50

Vertex ML Metadata

メタデータ ストレージはバイナリ ギガバイト(GiB)単位で測定されます。1 GiB は 1,073,741,824 バイトです。この測定単位はギビバイトとも呼ばれます。

Vertex ML Metadata では、メタデータ ストレージに対して 1 ギビバイト(GiB)あたり月額 $10 が課金されます。料金は、メガバイト(MB)を単位として計算されます。たとえば、10 MB のメタデータを保存する場合、そのデータに対して月額 $0.10 が課金されます。

料金は、Vertex ML Metadata がサポートされているすべてのリージョンで共通です。

Vertex AI TensorBoard

Vertex AI TensorBoard を使用するには、プロジェクトの IAM 管理者に「Vertex AI TensorBoard ウェブアプリ ユーザー」のロールの割り当てをリクエストしてください。また、Vertex AI の管理者ロールにもアクセス権があります。

2023 年 8 月より、Vertex AI TensorBoard では、ログと指標のデータ保存の料金がユーザーごとの月額ライセンス $300/月から $10 GiB/月に変更されました。つまり、これまでの定額料金がなくなり、実際に使用したストレージ容量のみに料金が発生します。ストレージの管理方法については、Vertex AI TensorBoard: 過去の TensorBoard テストの削除のチュートリアルをご覧ください。

Vertex AI Vizier

Vertex AI Vizier は、Vertex AI 内のブラックボックス最適化サービスです。Vertex AI Vizier の料金モデルは、次の要素で構成されています。

- RANDOM_SEARCH と GRID_SEARCH を使用するトライアルは、無料でご利用いただけます。検索アルゴリズムの詳細

- Vertex AI Vizier は、毎月 100 回まで無料で試用できます(RANDOM_SEARCH と GRID_SEARCH を使用するトライアルは、この合計数にカウントされません)。

- Vertex AI Vizier のトライアルが 100 回を超えると、それ以降の同月のトライアルには、1 回あたり $1 が課金されます(RANDOM_SEARCH または GRID_SEARCH を使用するトライアルは無料です)。

ベクトル検索

ベクトル検索の近似最近傍探索サービスの料金は、次の要素で構成されます。

- デプロイされたインデックスをホストするために使用される各 VM の 1 ノード時間あたりの料金。

- 新しいインデックスの作成、既存のインデックスの更新、インデックスのストリーミング アップデートの使用にかかる費用。

インデックスの作成と更新時に処理されるデータは、バイナリ ギガバイト(GiB)単位で測定されます。1 GiB は、1,073,741,824 バイトです。この測定単位はギビバイトとも呼ばれます。

ベクトル検索では、すべてのリージョンにおいて、処理されたデータ 1 GiB あたり $3.00 が課金されます。また、ストリーミング アップデートに対しては、取り込まれたデータ 1 GiB あたり $0.45 が課金されます。

以下の各表は、ベクトル検索が利用可能な各リージョンにおけるインデックス サービス料金をまとめたものです。料金はリージョンごとのマシンタイプに対応し、1 ノード時間ごとに課金されます。

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Melbourne (australia-southeast2)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Paris (europe-west9)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

e2-standard-2 | $0.0938084 / 1 hour |

e2-standard-16 | $0.7504672 / 1 hour |

e2-highmem-16 | $1.012368 / 1 hour |

n2d-standard-32 | $1.8926208 / 1 hour |

n1-standard-16 | $1.0639944 / 1 hour |

n1-standard-32 | $2.1279888 / 1 hour |

ベクトル検索の料金の例

ベクトル検索の料金の例

ベクトル検索の料金は、データサイズ、実行する秒間クエリ数(QPS)、使用するノード数によって決まります。推定利用料金を算出するには、データサイズの合計を計算する必要があります。データサイズは、埋め込み/ベクトルの数 x 次元数 x 1 次元あたり 4 バイトです。データサイズが決まれば、利用料金と作成料金を計算できます。利用料金と作成料金の合計が、毎月の合計料金となります。

- 利用料金: レプリカ数 / シャード数 x シャード数(~データサイズ / シャードサイズ)x 1 時間あたりのコスト x 730 時間

- 作成料金: データサイズ(GiB)x $3/GiB x 更新回数/月

ストリーミング アップデート: ベクトル検索では、ヒューリスティック ベースの指標を使用して圧縮をトリガーするタイミングを決定します。最も古いものが 5 日以上前の未圧縮データである場合、圧縮は常にトリガーされます。ストリーミング アップデートの費用に加えて、バッチ アップデートと同じ頻度でインデックスを再構築する費用も課金されます。

エンベディング数 / ベクター | 次元数 | 秒間クエリ数(QPS) | マシンタイプ | ノード | 推定月額利用料金(米ドル) |

|---|---|---|---|---|---|

200 万回 | 128 | 100 | e2-standard-2 | 1 | $68 |

2,000 万 | 256 | 1,000 | e2-standard-16 | 1 | $547 |

2,000 万 | 256 | 3,000 | e2-standard-16 | 3 | $1,642 |

1 億 | 256 | 500 | e2-highmem-16 | 2 | $1,477 |

10 億 | 100 | 500 | e2-highmem-16 | 8 | $5,910 |

すべての例は、us-central1 のマシンタイプに基づいています。発生する料金は、リコールレートとレイテンシの要件によって異なります。推定月額利用料金は、コンソールで使用されるノード数に直接関係しています。コストに影響する構成パラメータの詳細については、リコールとレイテンシに影響する構成パラメータをご覧ください。

秒間クエリ数(QPS)が多い場合、これらのクエリをバッチ処理することで、総コストを最大 30%~ 40% 削減できます。

ストレージ最適化ベクトル検索ティア

ストレージ最適化ベクトル検索ティア

個々の VM と個別の圧縮ジョブを管理して料金を支払う代わりに、2 つの SKU があります。

- 容量ユニット(CU): これはサービングの主な測定単位です。CU は、コンピューティングとアクティブ SSD ストレージをまとめた単位で、それぞれ最大 1 TiB まで、レプリカごとに 1 時間あたり 2.30 ドルで課金されます。この単一の料金には、サービス提供の費用と継続的なインデックス管理の費用が含まれます。インデックスのサイズが大きくなると、サービスは自動的にスケーリングされ、追加の CU が追加されます。

- 書き込みユニット: データの追加には、1 GiB あたり $0.45 の料金がかかります。料金は、バッチとストリーミングの両方のインデックス更新に適用されます。

単位 | 料金 |

|---|---|

ストレージ最適化容量ユニット | $2.30 / 1 hour |

書き込みユニット | $0.45 / 1 gibibyte |

Vertex AI Model Registry

Vertex AI Model Registry は、モデルとモデルのバージョンを追跡し、一覧表示する中央リポジトリです。Vertex AI にモデルをインポートすると、Vertex AI Model Registry に表示されます。モデルを Model Registry に配置しても費用は発生しません。料金が発生するのは、モデルをエンドポイントにデプロイするとき、またはモデルに対してバッチ予測を行うときだけです。この料金は、デプロイするモデルのタイプによって決まります。

Vertex AI Model Registry からカスタムモデルをデプロイする場合の料金の詳細については、カスタム トレーニング モデルをご覧ください。AutoML モデルをデプロイする場合の料金については、AutoML モデルの料金をご覧ください。

Vertex AI Model Monitoring

Vertex AI を使用すると、モデルを本番環境にデプロイした後も、モデルの継続的な有効性をモニタリングできます。詳細については、Vertex AI Model Monitoring の概要をご覧ください。

Vertex AI Model Monitoring を使用すると、次の料金が発生します。

- 分析されるすべてのデータに対して 1 GB あたり $3.50。BigQuery テーブルに記録されたトレーニング データや予測データも含む。

- アトリビューション モニタリングが有効になっている場合、BigQuery ストレージや Batch Explain など、Model Monitoring で使用する他の Google Cloud プロダクトに対する料金。

Vertex AI Model Monitoring は、us-central1、europe-west4、asia-east1、asia-southeast1 の各リージョンでサポートされています。料金はすべてのリージョンで同じです。

データサイズは、TfRecord 形式に変換された後に測定されます。

Vertex AI Model Monitoring ジョブを設定すると、トレーニング データセットに 1 回限りの料金が発生します。

予測データセットは、オンライン予測サービスから収集されたログで構成されています。予測リクエストはさまざまな時間枠で到着するため、時間枠ごとにデータが収集され、各予測時間枠で分析されたデータの合計が料金の計算に使用されます。

例: データ サイエンティストは、モデルに属する予測トラフィックに対して、モデル モニタリングを実行します。

- モデルは、BigQuery データセットからトレーニングされます。TfRecord に変換後のデータサイズは 1.5 GB です。

- 午後 1 時から午後 2 時の間に記録された予測データは 0.1 GB、午後 3 時から午後 4 時の間に記録された予測データは 0.2 GB です。

- モデルのモニタリング ジョブを設定するための合計料金は次のとおりです。

- (1.5 GB × $3.50)+((0.1 GB + 0.2 GB)× $3.50)= $6.30

Vertex AI Workbench

料金情報を確認するには、インスタンス、マネージド ノートブック、またはユーザー管理のノートブックを選択してください。

インスタンス

インスタンス

以下の表は、さまざまな VM 構成の 1 時間あたりのおおよその料金を示しています。選択したマシンタイプのカスタム構成を選択できます。料金を計算するには、使用する仮想マシンの費用を合算してください。

Compute Engine マシンタイプにアクセラレータを接続する場合、アクセラレータの費用は含まれません。この費用を計算するには、以下のアクセラレータの表に示す料金に、使用する各タイプのアクセラレータのマシン時間を掛けます。

CPU

CPU

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Warsaw (europe-central2)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Toronto (northamerica-northeast2)

- Sao Paulo (southamerica-east1)

- Santiago (southamerica-west1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Salt Lake City (us-west3)

- Las Vegas (us-west4)

マシンタイプ | vCPU あたりの料金(USD) |

|---|---|

N1 | $0.0379332 / 1 hour |

N2 | $0.0379332 / 1 hour |

E2 | $0.026173908 / 1 hour |

A2 | $0.0379332 / 1 hour |

メモリ

メモリ

- Johannesburg (africa-south1)

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Warsaw (europe-central2)

- Finland (europe-north1)

- Madrid (europe-southwest1)

- Belgium (europe-west1)

- Turin (europe-west12)

- London (europe-west2)

- Frankfurt (europe-west3)

- Netherlands (europe-west4)

- Zurich (europe-west6)

- Milan (europe-west8)

- Doha (me-central1)

- Dammam (me-central2)

- Tel Aviv (me-west1)

- Montreal (northamerica-northeast1)

- Sao Paulo (southamerica-east1)

- Iowa (us-central1)

- South Carolina (us-east1)

- Northern Virginia (us-east4)

- Columbus (us-east5)

- Dallas (us-south1)

- Oregon (us-west1)

- Los Angeles (us-west2)

- Las Vegas (us-west4)

マシンタイプ | 料金(米ドル) |

|---|---|

N1 | $0.0050844 / 1 gibibyte hour |

N2 | $0.0050844 / 1 gibibyte hour |

E2 | $0.003508236 / 1 gibibyte hour |

A2 | $0.0050844 / 1 gibibyte hour |

アクセラレータ

アクセラレータ

- Taiwan (asia-east1)

- Hong Kong (asia-east2)

- Tokyo (asia-northeast1)

- Osaka (asia-northeast2)

- Seoul (asia-northeast3)

- Mumbai (asia-south1)

- Singapore (asia-southeast1)

- Jakarta (asia-southeast2)

- Sydney (australia-southeast1)

- Finland (europe-north1)

- Belgium (europe-west1)