Questa guida mostra come eseguire il deployment e configurare manualmente un cluster Red Hat Enterprise Linux (RHEL) ad alta disponibilità (HA) per un sistema SAP HANA scalabile su Google Cloud che utilizza un bilanciatore del carico di rete passthrough interno per gestire l'indirizzo IP virtuale (VIP).

Questa guida include i passaggi per:

- Configurazione di un bilanciatore del carico di rete passthrough interno per reindirizzare il traffico in caso di guasto

- Configurazione di un cluster Pacemaker su RHEL per gestire i sistemi SAP e altre risorse durante un failover

Questa guida include anche i passaggi per la configurazione della replica del sistema SAP HANA, ma consulta la documentazione di SAP per le istruzioni definitive.

Per eseguire il deployment di un sistema SAP HANA senza un cluster ad alta disponibilità Linux o un host di node di standby, consulta la guida al deployment di SAP HANA.

Questa guida è rivolta agli utenti SAP HANA esperti che hanno familiarità con le configurazioni ad alta disponibilità di Linux per SAP HANA.

Il sistema di cui questa guida descrive l'implementazione

Seguendo questa guida, eseguirai il deployment di un sistema SAP HANA HA multi-nodo configurato per la ridondanza completa della zona con un'istanza aggiuntiva che agisce come maggioritario, noto anche come nodo di pareggio, che garantisce il mantenimento del quorum del cluster in caso di perdita di una zona.

Il deployment finale è costituito dalle seguenti risorse:

- Un sito principale e uno secondario in cui ogni istanza ha una controparte zonale.

- Due siti configurati per la replica sincrona.

- Una singola istanza di calcolo che agisce come maker di maggioranza.

- Un gestore delle risorse di cluster ad alta disponibilità Pacemaker con un meccanismo di isolamento.

- Uno o più dischi permanenti per i volumi di dati e log di SAP HANA collegati a ogni istanza SAP HANA.

Questa guida ti consente di utilizzare i modelli Terraform forniti da Google Cloud per eseguire il deployment delle macchine virtuali (VM) Compute Engine e delle istanze SAP HANA, in modo da garantire che le VM e i sistemi SAP HANA di base soddisfino i requisiti di supportabilità di SAP e siano conformi alle best practice attuali.

In questa guida, SAP HANA Studio viene utilizzato per testare la replica del sistema SAP HANA. Se preferisci, puoi utilizzare SAP HANA Cockpit. Per informazioni sull'installazione di SAP HANA Studio, consulta:

- Installazione di SAP HANA Studio su una VM Windows Compute Engine

- Guida all'installazione e all'aggiornamento di SAP HANA Studio

Prerequisiti

Prima di creare il cluster SAP HANA ad alta disponibilità, assicurati che siano soddisfatti i seguenti prerequisiti:

- Hai letto la guida alla pianificazione di SAP HANA e la guida alla pianificazione dell'alta disponibilità di SAP HANA.

- Tu o la tua organizzazione avete un Google Cloud account e avete creato un progetto per il deployment di SAP HANA. Per informazioni sulla creazione diGoogle Cloud account e progetti, consulta Configurare l'Account Google nella Guida all'implementazione di SAP HANA.

- Se vuoi che il tuo carico di lavoro SAP venga eseguito in conformità con la residenza dei dati, controllo dell'accesso, il personale di assistenza o i requisiti normativi, devi creare la cartella Assured Workloads richiesta. Per ulteriori informazioni, consulta Controlli di conformità e sovranità per SAP su Google Cloud.

I media di installazione di SAP HANA sono archiviati in un bucket Cloud Storage disponibile nel progetto e nella regione di deployment. Per informazioni su come caricare i media di installazione di SAP HANA in un bucket Cloud Storage, consulta Downloading SAP HANA (Download di SAP HANA) nella Guida al deployment di SAP HANA.

Se OS Login è abilitato nei metadati del progetto, devi disattivarlo temporaneamente fino al completamento del deployment. Ai fini del deployment, questa procedura configura le chiavi SSH nei metadati dell'istanza. Quando l'accesso al sistema operativo è abilitato, le configurazioni delle chiavi SSH basate su metadati vengono disabilitate e questo deployment non va a buon fine. Al termine del deployment, puoi riattivare l'accesso al sistema operativo.

Per ulteriori informazioni, vedi:

Se utilizzi il DNS interno della VPC, il valore della variabile

vmDnsSettingnei metadati del progetto deve essereGlobalOnlyoZonalPreferredper abilitare la risoluzione dei nomi dei nodi nelle varie zone. L'impostazione predefinita divmDnsSettingèZonalOnly. Per ulteriori informazioni, consulta:Disponi di una soluzione NFS, come la soluzione Filestore gestita, per condividere i volumi SAP HANA

/hana/sharede/hanabackuptra gli host nel sistema SAP HANA scalabile orizzontalmente. Per eseguire il deployment dei server NFS Filestore, consulta Creare istanze.- Tieni presente che i siti principali e secondari devono avere accesso ai propri percorsi NFS dedicati per evitare di sovrascrivere i dati. Per utilizzare una singola istanza Filestore, devi configurare il deployment in modo che utilizzi sottodirectory distinte come percorso di montaggio.

Creare una rete

Per motivi di sicurezza, crea una nuova rete. Puoi controllare chi ha accesso aggiungendo regole firewall o utilizzando un altro metodo di controllo dell'accesso.

Se il progetto ha una rete VPC predefinita, non utilizzarla. Crea invece una tua rete VPC in modo che le uniche regole firewall in vigore siano quelle che crei esplicitamente.

Durante il deployment, le istanze Compute Engine in genere richiedono l'accesso a internet per scaricare l'agente per SAP di Google Cloud. Se utilizzi una delle immagini Linux certificate da SAP disponibili su Google Cloud, l'istanza di calcolo richiede anche l'accesso a internet per registrare la licenza e accedere ai repository del fornitore del sistema operativo. Una configurazione con un gateway NAT e con tag di rete VM supporta questo accesso, anche se le istanze di calcolo di destinazione non hanno IP esterni.

Per creare una rete VPC per il tuo progetto, completa i seguenti passaggi:

-

Crea una rete in modalità personalizzata. Per saperne di più, consulta Creare una rete in modalità personalizzata.

-

Crea una subnet e specifica la regione e l'intervallo IP. Per ulteriori informazioni, consulta la sezione Aggiunta di subnet.

Configurazione di un gateway NAT

Se devi creare una o più VM senza indirizzi IP pubblici, devi utilizzare la Network Address Translation (NAT) per consentire alle VM di accedere a internet. Utilizza Cloud NAT, un Google Cloud servizio gestito software-defined distribuito che consente alle VM di inviare pacchetti in uscita a internet e di ricevere eventuali pacchetti di risposta in entrata stabiliti corrispondenti. In alternativa, puoi configurare una VM separata come gateway NAT.

Per creare un'istanza Cloud NAT per il tuo progetto, consulta Utilizzo di Cloud NAT.

Dopo aver configurato Cloud NAT per il progetto, le istanze VM possono accedere in sicurezza a internet senza un indirizzo IP pubblico.

aggiungi regole firewall

Per impostazione predefinita, una regola del firewall implicita blocca le connessioni in entrata dall'esterno della tua rete Virtual Private Cloud (VPC). Per consentire le connessioni in entrata, configura una regola firewall per la tua VM. Dopo aver stabilito una connessione in entrata con una VM, il traffico è consentito in entrambe le direzioni tramite la connessione.

Puoi anche creare una regola firewall per consentire l'accesso esterno a porte specifiche o per limitare l'accesso tra le VM sulla stessa rete. Se viene utilizzato il tipo di rete VPC default, vengono applicate anche alcune regole predefinite aggiuntive, come la regola default-allow-internal, che consente la connettività tra le VM sulla stessa rete su tutte le porte.

A seconda dei criteri IT applicabili al tuo ambiente, potresti dover isolare o limitare in altro modo la connettività all'host del database, cosa che puoi fare creando regole firewall.

A seconda dello scenario, puoi creare regole firewall per consentire l'accesso per:

- Le porte SAP predefinite elencate in TCP/IP di tutti i prodotti SAP.

- Connessioni dal tuo computer o dall'ambiente di rete aziendale all'istanza VM Compute Engine. Se hai dubbi su quale indirizzo IP utilizzare, rivolgiti all'amministratore di rete della tua azienda.

Per creare le regole firewall per il progetto, consulta la sezione Creare regole firewall.

Deployment delle VM e di SAP HANA

In questa guida viene utilizzato un file di configurazione Terraform fornito da Google Cloud per eseguire il deployment di quanto segue:

- Due sistemi SAP HANA corrispondenti, ciascuno con due o più istanze VM.

- Una singola istanza di creatore della maggioranza, nota anche come nodo di pareggio, che garantisce il mantenimento del quorum del cluster in caso di perdita di una zona.

I sistemi SAP HANA utilizzano la replica asincrona del sistema in modo che uno dei sistemi SAP HANA funzioni come sistema principale attivo e l'altro come sistema secondario in standby. Esegui il deployment di entrambi i sistemi SAP HANA all'interno della stessa regione, idealmente in zone diverse.

Se hai bisogno di un sistema scalabile orizzontalmente con host di riserva per il failover automatico dell'host SAP HANA, consulta la guida al deployment di Terraform: sistema SAP HANA scalabile orizzontalmente con failover automatico dell'host.

Definisci le opzioni di configurazione per il cluster SAP HANA ad alta disponibilità in un file di configurazione Terraform.

Le istruzioni riportate di seguito utilizzano Cloud Shell, ma sono applicabili in generale a un terminale locale con Terraform installato e configurato con il provider Google.

Verifica che le quote attuali per risorse come i dischi permanenti e le CPU siano sufficienti per i sistemi SAP HANA che stai per installare. Se le quote non sono sufficienti, il deployment non va a buon fine.

Per i requisiti delle quote SAP HANA, consulta Considerazioni su prezzi e quote per SAP HANA.

Apri Cloud Shell o il terminale locale.

Scarica il file di configurazione

manual_sap_hana_scaleout_ha.tfnella tua directory di lavoro eseguendo il seguente comando in Cloud Shell o nel terminale:$wget https://storage.googleapis.com/cloudsapdeploy/terraform/latest/terraform/sap_hana_ha/terraform/manual_sap_hana_scaleout_ha.tfApri il file

manual_sap_hana_scaleout_ha.tfnell'editor di codice Cloud Shell o, se utilizzi il terminale, apri il file in un editor di testo di tua scelta.Per aprire l'editor di codice di Cloud Shell, fai clic sull'icona a forma di matita nell'angolo in alto a destra della finestra del terminale di Cloud Shell.

Nel file

manual_sap_hana_scaleout_ha.tf, aggiorna i valori degli argomenti sia persap_hana_primaryche persap_hana_secondarysostituendo i contenuti tra virgolette doppie con i valori per la tua installazione. Gli argomenti sono descritti nella tabella seguente.Argomento Tipo di dati Descrizione sourceStringa Specifica la posizione e la versione del modulo Terraform da utilizzare durante il deployment.

Il file di configurazione

manual_sap_hana_scaleout_ha.tfinclude due istanze dell'argomentosource: una attiva e una inclusa come commento. L'argomentosourceattivo per impostazione predefinita specificalatestcome versione del modulo. La seconda istanza dell'argomentosource, che per impostazione predefinita è disattivata da un carattere#iniziale, specifica un timestamp che identifica una versione del modulo.Se vuoi che tutti i tuoi deployment utilizzino la stessa versione del modulo, rimuovi il carattere

#iniziale dall'argomentosourceche specifica il timestamp della versione e aggiungilo all'argomentosourceche specificalatest.project_idStringa Specifica l'ID del Google Cloud progetto in cui stai eseguendo il deployment di questo sistema. Ad esempio, my-project-x.machine_typeStringa Specifica il tipo di macchina virtuale (VM) Compute Engine su cui devi eseguire il sistema SAP. Se hai bisogno di un tipo di VM personalizzata, specifica un tipo di VM predefinito con un numero di vCPU più vicino a quello di cui hai bisogno, pur essendo più grande. Al termine del deployment, modifica il numero di vCPU e la quantità di memoria. Ad esempio,

n1-highmem-32.networkStringa Specifica il nome della rete in cui devi creare il bilanciatore del carico che gestisce il VIP. Se utilizzi una rete VPC condivisa, devi aggiungere l'ID del progetto host come directory principale del nome della rete. Ad esempio,

HOST_PROJECT_ID/NETWORK_NAME.subnetworkStringa Specifica il nome della sottorete creata in un passaggio precedente. Se effettui il deployment in una VPC condivisa, specifica questo valore come SHARED_VPC_PROJECT_ID/SUBNETWORK. Ad esempiomyproject/network1.linux_imageStringa Specifica il nome dell'immagine del sistema operativo Linux su cui vuoi eseguire il deployment del sistema SAP. Ad esempio, rhel-9-2-sap-haosles-15-sp5-sap. Per l'elenco delle immagini del sistema operativo disponibili, consulta la pagina Immagini nella console Google Cloud .linux_image_projectStringa Specifica il Google Cloud progetto contenente l'immagine che hai specificato per l'argomento linux_image. Può trattarsi del tuo progetto o di un Google Cloud progetto di immagini. Per un'immagine Compute Engine, specificarhel-sap-cloudosuse-sap-cloud. Per trovare il progetto immagine per il tuo sistema operativo, consulta Dettagli del sistema operativo.primary_instance_nameStringa Specifica un nome per l'istanza VM del sistema SAP HANA principale. Il nome può contenere lettere minuscole, numeri o trattini. primary_zoneStringa Specifica una zona in cui è dipiegato il sistema SAP HANA principale. Le zone primaria e secondaria devono trovarsi nella stessa regione. Ad esempio, us-east1-c.secondary_instance_nameStringa Specifica un nome per l'istanza VM del sistema SAP HANA secondario. Il nome può contenere lettere minuscole, numeri o trattini. secondary_zoneStringa Specifica una zona in cui è dipiegato il sistema SAP HANA secondario. Le zone principali e secondarie devono trovarsi nella stessa regione. Ad esempio, us-east1-b.sap_hana_deployment_bucketStringa Per installare automaticamente SAP HANA sulle VM di cui è stato eseguito il deployment, specifica il percorso del bucket Cloud Storage contenente i file di installazione di SAP HANA. Non includere gs://nel percorso; includi solo il nome del bucket e i nomi di eventuali cartelle. Ad esempio,my-bucket-name/my-folder.Il bucket Cloud Storage deve esistere nel progetto Google Cloud specificato per l'argomento

project_id.sap_hana_scaleout_nodesNumero intero Specifica il numero di host worker necessari nel sistema di scalabilità. Per eseguire il deployment di un sistema scalabile, è necessario almeno un host worker. Terraform crea gli host worker oltre all'istanza SAP HANA principale. Ad esempio, se specifichi

3, nel sistema di scalabilità vengono dispieghe quattro istanze SAP HANA.sap_hana_sidStringa Per installare automaticamente SAP HANA sulle VM di cui è stato eseguito il deployment, specifica l'ID sistema SAP HANA. L'ID deve essere composto da tre caratteri alfanumerici e deve iniziare con una lettera. Tutte le lettere devono essere in maiuscolo. Ad esempio, ED1.sap_hana_instance_numberNumero intero Facoltativo. Specifica il numero di istanza, da 0 a 99, del sistema SAP HANA. Il valore predefinito è 0.sap_hana_sidadm_passwordStringa Per installare automaticamente SAP HANA sulle VM di cui è stato eseguito il deployment, specifica una password SIDadmtemporanea da utilizzare per gli script di installazione durante il deployment. La password deve contenere almeno 8 caratteri e includere almeno una lettera maiuscola, una lettera minuscola e un numero.Anziché specificare la password in testo normale, ti consigliamo di utilizzare un secret. Per saperne di più, consulta Gestione delle password.

sap_hana_sidadm_password_secretStringa Facoltativo. Se utilizzi Secret Manager per archiviare la password SIDadm, specifica il nome del segreto corrispondente a questa password.In Secret Manager, assicurati che il valore della chiave, ovvero la password, contenga almeno 8 caratteri e includa almeno una lettera maiuscola, una lettera minuscola e un numero.

Per saperne di più, consulta Gestione delle password.

sap_hana_system_passwordStringa Per installare automaticamente SAP HANA sulle VM di cui è stato eseguito il deployment, specifica una password temporanea del superutente del database da utilizzare per gli script di installazione durante il deployment. La password deve contenere almeno 8 caratteri e includere almeno una lettera maiuscola, una lettera minuscola e un numero. Anziché specificare la password in testo normale, ti consigliamo di utilizzare un secret. Per saperne di più, consulta Gestione delle password.

sap_hana_system_password_secretStringa Facoltativo. Se utilizzi Secret Manager per archiviare la password del superutente del database, specifica il nome del segreto corrispondente a questa password. In Secret Manager, assicurati che il valore della chiave, ovvero la password, contenga almeno 8 caratteri e includa almeno una lettera maiuscola, una lettera minuscola e un numero.

Per saperne di più, consulta Gestione delle password.

sap_hana_double_volume_sizeBooleano Facoltativo. Per raddoppiare le dimensioni del volume HANA, specifica true. Questo argomento è utile quando vuoi eseguire il deployment di più istanze SAP HANA o di un'istanza SAP HANA di ripristino di emergenza sulla stessa VM. Per impostazione predefinita, le dimensioni del volume vengono calcolate automaticamente in base alle dimensioni minime richieste per la VM, soddisfacendo al contempo i requisiti di certificazione e assistenza SAP. Il valore predefinito èfalse.sap_hana_backup_sizeNumero intero Facoltativo. Specifica le dimensioni del volume /hanabackupin GB. Se non specifichi questo argomento o lo imposti su0, lo script di installazione esegue laProvisioning dell'istanza Compute Engine con un volume di backup HANA pari al doppio della memoria totale.sap_hana_sidadm_uidNumero intero Facoltativo. Specifica un valore per sostituire il valore predefinito dell'SID_LCID utente amministratore. Il valore predefinito è 900. Puoi impostare un valore diverso per garantire la coerenza all'interno del tuo panorama SAP.sap_hana_sapsys_gidNumero intero Facoltativo. Sostituisce l'ID gruppo predefinito per sapsys. Il valore predefinito è79.sap_vipStringa Facoltativo. Specifica l'indirizzo IP che utilizzerai per il VIP. L' indirizzo IP deve rientrare nell'intervallo di indirizzi IP assegnati alla subnet. Il file di configurazione Terraform riserva questo indirizzo IP per te.

Dalla versione

1.3.730053050del modulosap_hana_ha, l'argomentosap_vipè facoltativo. Se non lo specifichi, Terraform assegna automaticamente un indirizzo IP disponibile dalla subnet specificata per l'argomentosubnetwork.primary_instance_group_nameStringa Facoltativo. Specifica il nome del gruppo di istanze non gestite per il nodo principale. Il nome predefinito è ig-PRIMARY_INSTANCE_NAME.secondary_instance_group_nameStringa Facoltativo. Specifica il nome del gruppo di istanze non gestite per il nodo secondario. Il nome predefinito è ig-SECONDARY_INSTANCE_NAME.loadbalancer_nameStringa Facoltativo. Specifica il nome del bilanciatore del carico di rete passthrough interno. Il nome predefinito è lb-SAP_HANA_SID-ilb.network_tagsStringa Facoltativo. Specifica uno o più tag di rete separati da virgola da associare alle istanze VM per finalità di firewall o routing. Se specifichi

public_ip = falsee non specifichi un tag di rete, assicurati di fornire un altro mezzo di accesso a internet.nic_typeStringa Facoltativo. Specifica l'interfaccia di rete da utilizzare con l'istanza VM. Puoi specificare il valore GVNICoVIRTIO_NET. Per utilizzare una scheda di rete virtuale Google (gVNIC), devi specificare un'immagine del sistema operativo che supporti gVNIC come valore per l'argomentolinux_image. Per l'elenco delle immagini del sistema operativo, consulta Dettagli del sistema operativo.Se non specifichi un valore per questo argomento, l'interfaccia di rete viene selezionata automaticamente in base al tipo di macchina specificato per l'argomento

Questo argomento è disponibile nella versione del modulomachine_type.sap_hana202302060649o successive.disk_typeStringa Facoltativo. Specifica il tipo predefinito di volume del Persistent Disk o Hyperdisk da eseguire per i dati SAP e i volumi dei log nel deployment. Per informazioni sul deployment predefinito del disco eseguito dalle configurazioni Terraform fornite da Google Cloud, consulta Deployment del disco da parte di Terraform. Di seguito sono riportati i valori validi per questo argomento:

pd-ssd,pd-balanced,hyperdisk-extreme,hyperdisk-balanced, epd-extreme. Nei deployment di SAP HANA con scalabilità verticale, viene disegnato anche un disco permanente bilanciato separato per la directory/hana/shared.Puoi eseguire l'override di questo tipo di disco predefinito, della dimensione del disco predefinita e delle IOPS predefinite utilizzando alcuni argomenti avanzati. Per ulteriori informazioni, vai alla tua directory di lavoro, quindi esegui il comando

terraform inite consulta il file/.terraform/modules/manual_sap_hana_scaleout_ha/variables.tf. Prima di utilizzare questi argomenti in produzione, assicurati di testarli in un ambiente non di produzione.Se vuoi utilizzare SAP HANA Native Storage Extension (NSE), devi eseguire il provisioning di dischi più grandi utilizzando gli argomenti avanzati.

use_single_shared_data_log_diskBooleano Facoltativo. Il valore predefinito è false, che indica a Terraform di eseguire il deployment di un disco permanente o Hyperdisk separato per ciascuno dei seguenti volumi SAP:/hana/data,/hana/log,/hana/sharede/usr/sap. Per montare questi volumi SAP sullo stesso disco permanente o Hyperdisk, specificatrue.include_backup_diskBooleano Facoltativo. Questo argomento è applicabile ai deployment di SAP HANA scalabili verticalmente. Il valore predefinito è true, che indica a Terraform di eseguire il deployment di un disco separato per ospitare la directory/hanabackup.Il tipo di disco è determinato dall'argomento

backup_disk_type. Le dimensioni di questo disco sono determinate dall'argomentosap_hana_backup_size.Se imposti il valore di

include_backup_disksufalse, non viene disegnato alcun disco per la directory/hanabackup.public_ipBooleano Facoltativo. Determina se un indirizzo IP pubblico viene aggiunto o meno all'istanza VM. Il valore predefinito è true.service_accountStringa Facoltativo. Specifica l'indirizzo email di un account di servizio gestito dall'utente da utilizzare dalle VM host e dai programmi in esecuzione sulle VM host. Ad esempio svc-acct-name@project-id..Se specifichi questo argomento senza un valore o lo ometti, lo script di installazione utilizza l'account di servizio predefinito di Compute Engine. Per ulteriori informazioni, consulta Gestione di identità e accessi per i programmi SAP su Google Cloud.

sap_deployment_debugBooleano Facoltativo. Solo quando lassistenza clienti Google Cloud ti chiede di attivare il debug per il tuo deployment, specifica true, in modo che il deployment generi log dettagliati. Il valore predefinito èfalse.primary_reservation_nameStringa Facoltativo. Per utilizzare una prenotazione VM Compute Engine specifica per il provisioning dell'istanza VM che ospita l'istanza SAP HANA principale del tuo cluster HA, specifica il nome della prenotazione. Per impostazione predefinita, lo script di installazione seleziona qualsiasi prenotazione Compute Engine disponibile in base alle seguenti condizioni. Affinché una prenotazione sia utilizzabile, indipendentemente dal fatto che tu specifichi un nome o che lo script di installazione la selezioni automaticamente, la prenotazione deve essere impostata con quanto segue:

-

L'opzione

specificReservationRequiredè impostata sutrueo, nella Google Cloud console, è selezionata l'opzione Seleziona una prenotazione specifica. -

Alcuni tipi di macchine Compute Engine supportano piattaforme CPU non coperte dalla certificazione SAP del tipo di macchina. Se la prenotazione di destinazione riguarda uno dei seguenti tipi di macchine, deve specificare le piattaforme CPU minime come indicato:

n1-highmem-32: Intel Broadwelln1-highmem-64: Intel Broadwelln1-highmem-96: Intel Skylakem1-megamem-96: Intel Skylake

Le piattaforme CPU minime per tutti gli altri tipi di macchine certificate da SAP per l'utilizzo su Google Cloud sono conformi al requisito minimo della CPU SAP.

secondary_reservation_nameStringa Facoltativo. Per utilizzare una prenotazione VM Compute Engine specifica per il provisioning dell'istanza VM che ospita l'istanza SAP HANA secondaria del tuo cluster HA, specifica il nome della prenotazione. Per impostazione predefinita, lo script di installazione seleziona qualsiasi prenotazione Compute Engine disponibile in base alle seguenti condizioni. Affinché una prenotazione sia utilizzabile, indipendentemente dal fatto che tu specifichi un nome o che lo script di installazione la selezioni automaticamente, la prenotazione deve essere impostata con quanto segue:

-

L'opzione

specificReservationRequiredè impostata sutrueo, nella Google Cloud console, è selezionata l'opzione Seleziona una prenotazione specifica. -

Alcuni tipi di macchine Compute Engine supportano piattaforme CPU non coperte dalla certificazione SAP del tipo di macchina. Se la prenotazione di destinazione riguarda uno dei seguenti tipi di macchine, deve specificare le piattaforme CPU minime come indicato:

n1-highmem-32: Intel Broadwelln1-highmem-64: Intel Broadwelln1-highmem-96: Intel Skylakem1-megamem-96: Intel Skylake

Le piattaforme CPU minime per tutti gli altri tipi di macchine certificate da SAP per l'utilizzo su Google Cloud sono conformi al requisito minimo della CPU SAP.

primary_static_ipStringa Facoltativo. Specifica un indirizzo IP statico valido per l'istanza VM principale nel cluster ad alta disponibilità. Se non ne specifichi uno, verrà generato automaticamente un indirizzo IP per l'istanza VM. Ad esempio, 128.10.10.10.Questo argomento è disponibile nella versione

sap_hana_hadel modulo202306120959o successive.secondary_static_ipStringa Facoltativo. Specifica un indirizzo IP statico valido per l'istanza VM secondaria nel cluster ad alta disponibilità. Se non ne specifichi uno, verrà generato automaticamente un indirizzo IP per l'istanza VM. Ad esempio, 128.11.11.11.Questo argomento è disponibile nella versione

sap_hana_hadel modulo202306120959o successive.primary_worker_static_ipsElenco(Stringa) Facoltativo. Specifica un array di indirizzi IP statici validi per le istanze worker nell'istanza principale del sistema SAP HANA HA scalabile. Se non specifichi un valore per questo argomento, viene generato automaticamente un indirizzo IP per ogni istanza VM worker. Ad esempio, [ "1.0.0.1", "2.3.3.4" ].Gli indirizzi IP statici vengono assegnati nell'ordine di creazione delle istanze. Per esempio, se scegli di eseguire il deployment di 3 istanze di worker, ma specifichi solo 2 indirizzi IP per l'argomento

primary_worker_static_ips, questi indirizzi IP vengono assegnati alle prime due istanze VM di cui viene eseguito il deployment dalla configurazione Terraform. Per la terza istanza VM worker, l'indirizzo IP viene generato automaticamente.Questo argomento è disponibile nella versione

sap_hana_hadel modulo202307270727o successive.secondary_worker_static_ipsElenco(Stringa) Facoltativo. Specifica un array di indirizzi IP statici validi per le istanze worker nell'istanza secondaria del sistema HA scalabile SAP HANA. Se non specifichi un valore per questo argomento, viene generato automaticamente un indirizzo IP per ogni istanza VM worker. Ad esempio, [ "1.0.0.2", "2.3.3.5" ].Gli indirizzi IP statici vengono assegnati nell'ordine di creazione delle istanze. Per esempio, se scegli di eseguire il deployment di 3 istanze di worker, ma specifichi solo 2 indirizzi IP per l'argomento

secondary_worker_static_ips, questi indirizzi IP vengono assegnati alle prime due istanze VM di cui viene eseguito il deployment dalla configurazione Terraform. Per la terza istanza VM worker, l'indirizzo IP viene generato automaticamente.Questo argomento è disponibile nella versione

sap_hana_hadel modulo202307270727o successive.Gli esempi seguenti mostrano file di configurazione completi che definiscono un cluster ad alta disponibilità per un sistema SAP HANA scalabile orizzontalmente. Il cluster utilizza un bilanciatore del carico di rete passthrough interno per gestire l'IP virtuale.

Terraform esegue il deployment delle Google Cloud risorse definite nel file di configurazione, dopodiché gli script prendono il controllo per configurare il sistema operativo e installare SAP HANA.

-

L'opzione

Nello stesso file

manual_sap_hana_scaleout_ha.tf, aggiorna i valori degli argomenti permajority_maker. Gli argomenti sono descritti nella tabella seguente.Argomento Tipo di dati Descrizione projectStringa Specifica l'ID del Google Cloud progetto in cui stai eseguendo il deployment di questo sistema. majority_maker_instance_nameStringa Specifica un nome per l'istanza VM di Compute Engine che funge da originatore della maggioranza.

Questo argomento è disponibile nella versione

sap_hana_hadel modulo202307270727o successive.majority_maker_instance_typeStringa Specifica il tipo di macchina virtuale (VM) Compute Engine da utilizzare per l'istanza di creator di maggioranza. Ad esempio, n1-highmem-32.Se vuoi utilizzare un tipo di VM personalizzata, specifica un tipo di VM predefinito con un numero di vCPU più vicino a quello di cui hai bisogno, pur essendo più grande. Al termine del deployment, modifica il numero di vCPU e la quantità di memoria.

Questo argomento è disponibile nella versione

sap_hana_hadel modulo202307270727o successive.majority_maker_zoneStringa Specifica una zona in cui è dipiegato l'istanza VM del creatore di maggioranza. Questa zona deve trovarsi nella stessa regione delle zone principale e secondaria. Ad esempio, us-east1-d.Google Cloud consiglia di eseguire il deployment dell'istanza VM del creatore della maggioranza in una zona diversa da quella dei sistemi SAP HANA principali e secondari.

Questo argomento è disponibile nella versione

sap_hana_hadel modulo202307270727o successive.majority_maker_linux_imageStringa Utilizzando gli stessi valori del passaggio precedente, specifica il percorso completo dell'immagine come "linux_image_project/linux_image". Ad esempio"rhel-sap-cloud/rhel-9-0-sap-v20230708".subnetworkStringa Specifica il nome della sottorete creata in un passaggio precedente. Se effettui il deployment in una VPC condivisa, specifica questo valore come SHARED_VPC_PROJECT_ID/SUBNETWORK. Ad esempiomyproject/network1.service_accountStringa Facoltativo. Specifica l'indirizzo email di un account di servizio gestito dall'utente da utilizzare dalle VM host e dai programmi in esecuzione sulle VM host. Ad esempio svc-acct-name@project-id..Se specifichi questo argomento senza un valore o lo ometti, lo script di installazione utilizza l'account di servizio predefinito di Compute Engine. Per ulteriori informazioni, consulta Gestione di identità e accessi per i programmi SAP su Google Cloud.

metadata_startup_scriptStringa Non modificare questo argomento. Per impostazione predefinita, il creatore della maggioranza scarica lo script di avvio più recente per preparare l'istanza al clustering di Pacemaker. Per chiarezza, i commenti nella configurazione di esempio seguente sono omessi.

module "sap_hana_primary" {

source = "https://storage.googleapis.com/cloudsapdeploy/terraform/latest/terraform/sap_hana/sap_hana_module.zip"

project_id = "example-project-123456"

zone = "us-west1-a"

machine_type = "n1-highmem-32"

subnetwork = "default"

linux_image = "rhel-9-0-sap-v20230711"

linux_image_project = "rhel-sap-cloud"

instance_name = "hana-ha-1"

sap_hana_sid = "HA1"

sap_hana_deployment_bucket = "my-hana-bucket"

sap_hana_sidadm_password_secret = "hana_sid_adm_pwd"

sap_hana_system_password_secret = "hana_sys_pwd"

sap_hana_scaleout_nodes = 1

sap_hana_shared_nfs = "10.10.10.1:/hana_scaleout/hana_a/shared"

sap_hana_backup_nfs = "10.10.10.1:/hana_scaleout/hana_a/backup"

}

module "sap_hana_secondary" {

source = "https://storage.googleapis.com/cloudsapdeploy/terraform/latest/terraform/sap_hana/sap_hana_module.zip"

project_id = "example-project-123456"

zone = "us-west1-b"

machine_type = "n1-highmem-32"

subnetwork = "default"

linux_image = "rhel-9-0-sap-v20230711"

linux_image_project = "rhel-sap-cloud"

instance_name = "hana-ha-2"

sap_hana_sid = "HA1"

sap_hana_deployment_bucket = "my-hana-bucket"

sap_hana_sidadm_password_secret = "hana_sid_adm_pwd"

sap_hana_system_password_secret = "hana_sys_pwd"

sap_hana_scaleout_nodes = 1

sap_hana_shared_nfs = "10.10.10.2:/hana_scaleout/hana_b/shared"

sap_hana_backup_nfs = "10.10.10.2:/hana_scaleout/hana_b/backup"

}

resource "google_compute_instance" "majority_maker" {

project = "example-project-123456"

# majority_maker_instance_name

name = "majority-maker"

# majority_maker_instance_type

machine_type = "n1-standard-8"

# majority_maker_zone

zone = "us-west1-c"

boot_disk {

initialize_params {

# majority_maker_linux_image

image = "rhel-sap-cloud/rhel-9-0-sap-v20230711"

}

}

network_interface {

# network or subnetwork

network = "default"

}

service_account {

# service_account (Optional)

# email = svc-acct-name@project-id..

scopes = ["cloud-platform"]

}

# Do not edit

metadata_startup_script = "curl -s https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_majoritymaker/startup.sh | bash -s https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_majoritymaker/startup.sh"

}

Inizializza la directory di lavoro corrente e scarica i file del plug-in e del modulo del provider Terraform per Google Cloud:

terraform init

Il comando

terraform initprepara la directory di lavoro per altri comandi Terraform.Per forzare l'aggiornamento del plug-in del provider e dei file di configurazione nella directory di lavoro, specifica il flag

--upgrade. Se il flag--upgradeviene omesso e non apporti modifiche alla directory di lavoro, Terraform utilizza le copie memorizzate nella cache locale, anche selatestè specificato nell'URLsource.terraform init --upgrade

Se vuoi, crea il piano di esecuzione Terraform:

terraform plan

Il comando

terraform planmostra le modifiche richieste dalla configurazione attuale. Se salti questo passaggio, il comandoterraform applycrea automaticamente un nuovo piano e ti chiede di approvarlo.Applica il piano di esecuzione:

terraform apply

Quando ti viene chiesto di approvare le azioni, inserisci

yes.Il comando

terraform applyconfigura l' Google Cloud infrastruttura e poi passa il controllo a uno script che configura il cluster ad alta disponibilità e installa SAP HANA in base agli argomenti definiti nel file di configurazione Terraform.Mentre Terraform ha il controllo, i messaggi di stato vengono scritti in Cloud Shell. Dopo l'attivazione degli script, i messaggi di stato vengono scritti in Logging e sono visualizzabili nella Google Cloud console, come descritto in Controllare i log.

Verifica del deployment del sistema HANA HA

Controlla i log

Nella Google Cloud console, apri Cloud Logging per monitorare l'avanzamento dell'installazione e verificare la presenza di errori.

Filtra i log:

Esplora log

Nella pagina Esplora log, vai al riquadro Query.

Dal menu a discesa Risorsa, seleziona Globale e poi fai clic su Aggiungi.

Se non vedi l'opzione Globale, nell'editor di query inserisci la seguente query:

resource.type="global" "Deployment"Fai clic su Esegui query.

Visualizzatore log legacy

- Nella pagina Visualizzatore log legacy, seleziona Globale come risorsa di logging nel menu del selettore di base.

Analizza i log filtrati:

- Se viene visualizzato

"--- Finished", significa che l'elaborazione del deployment è completata e puoi procedere al passaggio successivo. Se viene visualizzato un errore relativo alla quota:

Nella pagina IAM e amministrazione Quote, aumenta le quote che non soddisfano i requisiti di SAP HANA elencati nella guida alla pianificazione di SAP HANA.

Apri Cloud Shell.

Vai alla tua directory di lavoro ed elimina il deployment per ripulire le VM e i dischi permanenti dall'installazione non riuscita:

terraform destroy

Quando ti viene chiesto di approvare l'azione, inserisci

yes.Esegui di nuovo il deployment.

- Se viene visualizzato

Controlla la configurazione della VM e dell'installazione di SAP HANA

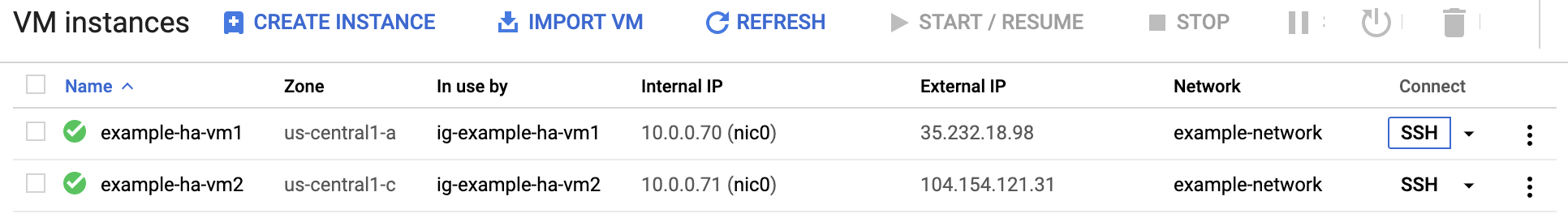

Dopo aver eseguito il deployment del sistema SAP HANA senza errori, connettiti a ogni VM utilizzando SSH. Nella pagina Istanze VM di Compute Engine, puoi fare clic sul pulsante SSH per ogni istanza VM oppure utilizzare il metodo SSH che preferisci.

Passa all'utente root.

sudo su -

Al prompt dei comandi, inserisci

df -h. Assicurati di visualizzare un output che includa le directory/hana, ad esempio/hana/data.[root@example-ha-vm1 ~]# df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 0 126G 0% /dev tmpfs 126G 54M 126G 1% /dev/shm tmpfs 126G 25M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda2 30G 5.4G 25G 18% / /dev/sda1 200M 6.9M 193M 4% /boot/efi /dev/mapper/vg_hana-shared 251G 52G 200G 21% /hana/shared /dev/mapper/vg_hana-sap 32G 477M 32G 2% /usr/sap /dev/mapper/vg_hana-data 426G 9.8G 417G 3% /hana/data /dev/mapper/vg_hana-log 125G 7.0G 118G 6% /hana/log /dev/mapper/vg_hanabackup-backup 512G 9.3G 503G 2% /hanabackup tmpfs 26G 0 26G 0% /run/user/900 tmpfs 26G 0 26G 0% /run/user/899 tmpfs 26G 0 26G 0% /run/user/1003

Ripulisci e riprova a eseguire il deployment

Se uno dei passaggi di verifica del deployment nelle sezioni precedenti indica che l'installazione non è andata a buon fine, devi annullare il deployment e riprovare completando i seguenti passaggi:

Risolvi eventuali errori per assicurarti che il deployment non fallisca di nuovo per lo stesso motivo. Per informazioni su come controllare i log o risolvere gli errori relativi alla quota, consulta Controllare i log.

Apri Cloud Shell o, se hai installato Google Cloud CLI sulla tua workstation locale, apri un terminale.

Vai alla directory contenente il file di configurazione Terraform utilizzato per questo deployment.

Elimina tutte le risorse che fanno parte del deployment eseguendo il seguente comando:

terraform destroy

Quando ti viene chiesto di approvare l'azione, inserisci

yes.Riprova il deployment come indicato in precedenza in questa guida.

Convalida l'installazione dell'agente per SAP di Google Cloud

Dopo aver eseguito il deployment di tutte le istanze e installato il sistema SAP, verifica che Agent per SAP diGoogle Cloudfunzioni correttamente.

Verifica che l'agente per SAP di Google Cloudsia in esecuzione

Per verificare che l'agente sia in esecuzione:

Stabilisci una connessione SSH con la tua istanza Compute Engine.

Esegui questo comando:

systemctl status google-cloud-sap-agent

Se l'agente funziona correttamente, l'output contiene

active (running). Ad esempio:google-cloud-sap-agent.service - Google Cloud Agent for SAP Loaded: loaded (/usr/lib/systemd/system/google-cloud-sap-agent.service; enabled; vendor preset: disabled) Active: active (running) since Fri 2022-12-02 07:21:42 UTC; 4 days ago Main PID: 1337673 (google-cloud-sa) Tasks: 9 (limit: 100427) Memory: 22.4 M (max: 1.0G limit: 1.0G) CGroup: /system.slice/google-cloud-sap-agent.service └─1337673 /usr/bin/google-cloud-sap-agent

Se l'agente non è in esecuzione, riavvialo.

Verificare che l'agente host SAP riceva le metriche

Per verificare che le metriche dell'infrastruttura vengano raccolte dall'agente diGoogle Cloudper SAP e inviate correttamente all'agente host SAP, segui questi passaggi:

- Nel sistema SAP, inserisci la transazione

ST06. Nel riquadro di panoramica, controlla la disponibilità e i contenuti dei seguenti campi per la configurazione end-to-end corretta dell'infrastruttura di monitoraggio di SAP e Google:

- Fornitore di servizi cloud:

Google Cloud Platform - Accesso al monitoraggio avanzato:

TRUE - Dettagli sul monitoraggio migliorati:

ACTIVE

- Fornitore di servizi cloud:

Configurare il monitoraggio per SAP HANA

Se vuoi, puoi monitorare le tue istanze SAP HANA utilizzando Agente per SAP diGoogle Cloud. Dalla versione 2.0, puoi configurare l'agente per raccogliere le metriche di monitoraggio di SAP HANA e inviarle a Cloud Monitoring. Cloud Monitoring ti consente di creare dashboard per visualizzare queste metriche, configurare avvisi in base alle soglie delle metriche e altro ancora.

Per ulteriori informazioni sulla raccolta delle metriche di monitoraggio di SAP HANA utilizzando Agente per SAP diGoogle Cloud, consulta la raccolta delle metriche di monitoraggio di SAP HANA.

(Facoltativo) Crea un elenco di istanze per l'automazione basata su script

Per automatizzare parzialmente alcune delle attività ripetitive durante la configurazione del sistema SAP HANA e del cluster Pacemaker, puoi utilizzare gli script bash. In questa guida, questi script bash vengono utilizzati per velocizzare la configurazione del sistema SAP HANA e del cluster Pacemaker. Questi script richiedono un elenco di tutte le istanze VM di cui è stato eseguito il deployment e delle relative zone.

Per attivare questa automazione, crea un file denominato nodes.txt e includi i dettagli di tutte le istanze VM di cui è stato eseguito il deployment nel seguente formato: nome della zona, spazio vuoto e nome dell'istanza VM. In questa guida viene utilizzato il seguente file di esempio:

# cat nodes.txt us-west1-a hana-ha-vm-1 us-west1-a hana-ha-vm-1w1 us-west1-a hana-ha-vm-1w2 us-west1-b hana-majoritymaker us-west1-c hana-ha-vm-2 us-west1-c hana-ha-vm-2w1 us-west1-c hana-ha-vm-2w2

Configurare l'accesso SSH senza password

Per configurare il cluster Pacemaker e sincronizzare le chiavi del secure store SAP HANA (SSFS), è necessario l'accesso SSH senza password tra tutti i nodi, inclusa l'istanza del creator di maggioranza. Per l'accesso SSH senza password, devi aggiungere le chiavi pubbliche SSH ai metadati delle istanze di tutte le istanze di cui è stato eseguito il deployment.

Il formato dei metadati è USERNAME: PUBLIC-KEY-VALUE.

Per saperne di più sull'aggiunta di chiavi SSH alle VM, consulta Aggiungere chiavi SSH alle VM che utilizzano chiavi SSH basate su metadati.

Procedura manuale

Per ogni istanza nei sistemi principali e secondari, nonché per l'istanza del creatore di maggioranza, raccoglie la chiave pubblica per l'utente

root.gcloud compute ssh --quiet --zone ZONE_ID INSTANCE_NAME -- sudo cat /root/.ssh/id_rsa.pub

Anteponi la chiave alla stringa

root:e scrivi la chiave come nuova riga nel file denominatopublic-ssh-keys.txt, ad esempio:root:ssh-rsa AAAAB3NzaC1JfuYnOI1vutCs= root@INSTANCE_NAME

Dopo aver raccolto tutte le chiavi pubbliche SSH, caricale come metadati in tutte le istanze:

gcloud compute instances add-metadata --metadata-from-file ssh-keys=public-ssh-keys.txt --zone ZONE_ID INSTANCE_NAME

Passaggi automatici

In alternativa, per automatizzare la procedura di configurazione dell'accesso SSH senza password per tutte le istanze elencate in nodes.txt, svolgi i seguenti passaggi dalla console Google Cloud :

Crea un elenco di chiavi pubbliche di tutte le istanze di cui è stato eseguito il deployment:

while read -u10 ZONE HOST ; do echo "Collecting public-key from $HOST"; { echo 'root:'; gcloud compute ssh --quiet --zone $ZONE $HOST --tunnel-through-iap -- sudo cat /root/.ssh/id_rsa.pub; } | tr -ds '\n' " " >> public-ssh-keys.txt; done 10< nodes.txtAssegna le chiavi pubbliche SSH come voci di metadati a tutte le istanze:

while read -u10 ZONE HOST ; do echo "Adding public keys to $HOST"; gcloud compute instances add-metadata --metadata-from-file ssh-keys=public-ssh-keys.txt --zone $ZONE $HOST; done 10< nodes.txt

Disattivare l'avvio automatico di SAP HANA

Procedura manuale

Per ogni istanza SAP HANA nel cluster, assicurati che l'avvio automatico di SAP HANA sia disattivato. Per i failover, Pacemaker gestisce l'avvio e l'arresto delle istanze SAP HANA in un cluster.

Su ogni host, come SID_LCadm, interrompi SAP HANA:

>HDB stopSu ogni host, apri il profilo SAP HANA utilizzando un editor, ad esempio vi:

vi /usr/sap/SID/SYS/profile/SID_HDBINST_NUM_HOST_NAME

Imposta la proprietà

Autostartsu0:Autostart=0

Salva il profilo.

Su ogni host, avvia SAP HANA come SID_LCadm:

>HDB start

Passaggi automatici

In alternativa, per disattivare l'avvio automatico di SAP HANA per tutte le istanze elencate in

nodes.txt,

esegui il seguente script dalla Google Cloud console:

while read -u10 ZONE HOST ; do gcloud compute ssh --verbosity=none --zone $ZONE $HOST -- "echo Setting Autostart=0 on \$HOSTNAME; sudo sed -i 's/Autostart=1/Autostart=0/g' /usr/sap/SID/SYS/profile/SID_HDBINST_NUM_\$HOSTNAME"; done 10< nodes.txt

Attivare il riavvio rapido di SAP HANA

Google Cloud Consiglia vivamente di attivare il riavvio rapido di SAP HANA per ogni istanza di SAP HANA, in particolare per le istanze più grandi. Il riavvio rapido di SAP HANA riduce il tempo di riavvio nel caso in cui SAP HANA si arresti, ma il sistema operativo rimanga in esecuzione.

Come configurato dagli script di automazione forniti,

le impostazioni del sistema operativo e del kernel supportano già il riavvio rapido di SAP HANA. Google Cloud

Devi definire il file system tmpfs e configurare SAP HANA.

Per definire il file system tmpfs e configurare SAP HANA, puoi seguire i passaggi manuali o utilizzare lo script di automazione fornito daGoogle Cloud per attivare il riavvio rapido di SAP HANA. Per ulteriori informazioni, consulta:

- Passaggi manuali: attivare il riavvio rapido di SAP HANA

- Passaggi automatici: attiva Fast Restart di SAP HANA

Per istruzioni autorevoli complete su SAP HANA Fast Restart, consulta la documentazione dell'opzione SAP HANA Fast Restart.

Procedura manuale

Configura il file system tmpfs

Dopo aver eseguito il deployment delle VM host e dei sistemi SAP HANA di base,

devi creare e montare le directory per i nodi NUMA nel file system tmpfs.

Mostra la topologia NUMA della VM

Prima di poter mappare il file system tmpfs richiesto, devi sapere quanti nodi NUMA sono presenti nella tua VM. Per visualizzare i nodi NUMA disponibili su una VM Compute Engine, inserisci il seguente comando:

lscpu | grep NUMA

Ad esempio, un tipo di VM m2-ultramem-208 ha quattro nodi NUMA,

numerati da 0 a 3, come mostrato nell'esempio seguente:

NUMA node(s): 4 NUMA node0 CPU(s): 0-25,104-129 NUMA node1 CPU(s): 26-51,130-155 NUMA node2 CPU(s): 52-77,156-181 NUMA node3 CPU(s): 78-103,182-207

Crea le directory dei nodi NUMA

Crea una directory per ogni nodo NUMA nella VM e imposta le autorizzazioni.

Ad esempio, per quattro nodi NUMA numerati da 0 a 3:

mkdir -pv /hana/tmpfs{0..3}/SID

chown -R SID_LCadm:sapsys /hana/tmpfs*/SID

chmod 777 -R /hana/tmpfs*/SIDMonta le directory dei nodi NUMA su tmpfs

Monta le directory del file system tmpfs e specifica

una preferenza per il nodo NUMA per ciascuna con mpol=prefer:

SID specifica il SID con lettere maiuscole.

mount tmpfsSID0 -t tmpfs -o mpol=prefer:0 /hana/tmpfs0/SID mount tmpfsSID1 -t tmpfs -o mpol=prefer:1 /hana/tmpfs1/SID mount tmpfsSID2 -t tmpfs -o mpol=prefer:2 /hana/tmpfs2/SID mount tmpfsSID3 -t tmpfs -o mpol=prefer:3 /hana/tmpfs3/SID

Aggiorna /etc/fstab

Per assicurarti che i punti di montaggio siano disponibili dopo il riavvio del sistema operativo, aggiungi voci alla tabella del file system, /etc/fstab:

tmpfsSID0 /hana/tmpfs0/SID tmpfs rw,nofail,relatime,mpol=prefer:0 tmpfsSID1 /hana/tmpfs1/SID tmpfs rw,nofail,relatime,mpol=prefer:1 tmpfsSID1 /hana/tmpfs2/SID tmpfs rw,nofail,relatime,mpol=prefer:2 tmpfsSID1 /hana/tmpfs3/SID tmpfs rw,nofail,relatime,mpol=prefer:3

(Facoltativo) Imposta limiti all'utilizzo della memoria

Il file system tmpfs può aumentare e diminuire dinamicamente.

Per limitare la memoria utilizzata dal file system tmpfs, puoi impostare un limite di dimensioni per un volume del nodo NUMA con l'opzione size.

Ad esempio:

mount tmpfsSID0 -t tmpfs -o mpol=prefer:0,size=250G /hana/tmpfs0/SID

Puoi anche limitare l'utilizzo complessivo della memoria tmpfs per tutti i nodi NUMA per

una determinata istanza SAP HANA e un determinato nodo del server impostando il

parametro persistent_memory_global_allocation_limit nella sezione [memorymanager]

del file global.ini.

Configurazione di SAP HANA per il riavvio rapido

Per configurare SAP HANA per il riavvio rapido, aggiorna il file global.ini

e specifica le tabelle da archiviare nella memoria persistente.

Aggiorna la sezione [persistence] nel file global.ini

Configura la sezione [persistence] nel file global.ini di SAP HANA

per fare riferimento alle località tmpfs. Separa ogni località tmpfs con un punto e virgola:

[persistence] basepath_datavolumes = /hana/data basepath_logvolumes = /hana/log basepath_persistent_memory_volumes = /hana/tmpfs0/SID;/hana/tmpfs1/SID;/hana/tmpfs2/SID;/hana/tmpfs3/SID

L'esempio precedente specifica quattro volumi di memoria per quattro nodi NUMA,

che corrispondono a m2-ultramem-208. Se esegui la tua esecuzione su m2-ultramem-416, devi configurare otto volumi di memoria (0-7).

Riavvia SAP HANA dopo aver modificato il file global.ini.

Ora SAP HANA può utilizzare la posizione tmpfs come spazio di memoria permanente.

Specifica le tabelle da archiviare nella memoria persistente

Specifica tabelle o partizioni di colonne specifiche da archiviare nella memoria persistente.

Ad esempio, per attivare la memoria persistente per una tabella esistente, esegui la query SQL:

ALTER TABLE exampletable persistent memory ON immediate CASCADE

Per modificare il valore predefinito per le nuove tabelle, aggiungi il parametro

table_default nel file indexserver.ini. Ad esempio:

[persistent_memory] table_default = ON

Per ulteriori informazioni su come controllare le colonne, le tabelle e le visualizzazioni di monitoraggio che forniscono informazioni dettagliate, consulta Memoria persistente SAP HANA.

Passaggi automatici

Lo script di automazione fornito Google Cloud per attivare il riavvio rapido di SAP HANA apporta modifiche alle directory /hana/tmpfs*, al file /etc/fstab e alla configurazione di SAP HANA. Quando esegui lo script, potresti dover eseguire passaggi aggiuntivi a seconda che si tratti del deployment iniziale del sistema SAP HANA o se stai ridimensionando la macchina a una dimensione NUMA diversa.

Per il deployment iniziale del sistema SAP HANA o per il ridimensionamento della macchina al fine di aumentare il numero di nodi NUMA, assicurati che SAP HANA sia in esecuzione durante l'esecuzione dello script di automazione fornito per attivare il riavvio rapido di SAP HANA. Google Cloud

Quando redimensioni la macchina per ridurre il numero di nodi NUMA, assicurati che SAP HANA sia interrotta durante l'esecuzione dello script di automazione che consente di attivare il riavvio rapido di SAP HANA. Google Cloud Dopo l'esecuzione dello script, devi aggiornare manualmente la configurazione di SAP HANA per completare la configurazione del riavvio rapido di SAP HANA. Per ulteriori informazioni, consulta la configurazione di SAP HANA per il riavvio rapido.

Per attivare il riavvio rapido di SAP HANA, segui questi passaggi:

Stabilisci una connessione SSH con la VM host.

Passa al root:

sudo su -

Scarica lo script

sap_lib_hdbfr.sh:wget https://storage.googleapis.com/cloudsapdeploy/terraform/latest/terraform/lib/sap_lib_hdbfr.sh

Rendi eseguibile il file:

chmod +x sap_lib_hdbfr.sh

Verifica che lo script non contenga errori:

vi sap_lib_hdbfr.sh ./sap_lib_hdbfr.sh -help

Se il comando restituisce un errore, contatta l'assistenza clienti Google Cloud. Per ulteriori informazioni su come contattare l'assistenza clienti, consulta Ricevere assistenza per SAP su Google Cloud.

Esegui lo script dopo aver sostituito l'ID sistema (SID) e la password di SAP HANA per l'utente SYSTEM del database SAP HANA. Per fornire la password in modo sicuro, ti consigliamo di utilizzare un secret in Secret Manager.

Esegui lo script utilizzando il nome di un secret in Secret Manager. Questo segreto deve esistere nel Google Cloud progetto che contiene l'istanza VM host.

sudo ./sap_lib_hdbfr.sh -h 'SID' -s SECRET_NAME

Sostituisci quanto segue:

SID: specifica l'SID con lettere maiuscole. Ad esempio,AHA.SECRET_NAME: specifica il nome del segreto corrispondente alla password per l'utente SYSTEM del database SAP HANA. Questo segreto deve esistere nel Google Cloud progetto che contiene l'istanza VM host.

In alternativa, puoi eseguire lo script utilizzando una password in testo normale. Dopo aver attivato il riavvio rapido di SAP HANA, assicurati di cambiare la password. L'utilizzo di una password in testo normale non è consigliato perché la password verrà registrata nella cronologia della riga di comando della VM.

sudo ./sap_lib_hdbfr.sh -h 'SID' -p 'PASSWORD'

Sostituisci quanto segue:

SID: specifica l'SID con lettere maiuscole. Ad esempio,AHA.PASSWORD: specifica la password per l'utente SYSTEM del database SAP HANA.

Se l'esecuzione iniziale è andata a buon fine, dovresti visualizzare un output simile al seguente:

INFO - Script is running in standalone mode

ls: cannot access '/hana/tmpfs*': No such file or directory

INFO - Setting up HANA Fast Restart for system 'TST/00'.

INFO - Number of NUMA nodes is 2

INFO - Number of directories /hana/tmpfs* is 0

INFO - HANA version 2.57

INFO - No directories /hana/tmpfs* exist. Assuming initial setup.

INFO - Creating 2 directories /hana/tmpfs* and mounting them

INFO - Adding /hana/tmpfs* entries to /etc/fstab. Copy is in /etc/fstab.20220625_030839

INFO - Updating the HANA configuration.

INFO - Running command: select * from dummy

DUMMY

"X"

1 row selected (overall time 4124 usec; server time 130 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('global.ini', 'SYSTEM') SET ('persistence', 'basepath_persistent_memory_volumes') = '/hana/tmpfs0/TST;/hana/tmpfs1/TST;'

0 rows affected (overall time 3570 usec; server time 2239 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('global.ini', 'SYSTEM') SET ('persistent_memory', 'table_unload_action') = 'retain';

0 rows affected (overall time 4308 usec; server time 2441 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('indexserver.ini', 'SYSTEM') SET ('persistent_memory', 'table_default') = 'ON';

0 rows affected (overall time 3422 usec; server time 2152 usec)

Passaggi automatici

Per automatizzare questa procedura, utilizza nodes.txt e i seguenti script dalla Google Cloud console:

Genera un file

hosts.txtcon un elenco di indirizzi IP e nomi host:while read -u10 ZONE HOST ; do gcloud compute instances list --filter="name=( 'NAME' $HOST )" --format="csv[separator=' ',no-heading](networkInterfaces[0].networkIP,name)" >> hosts.txt; done 10< nodes.txt

Verifica che il file

hosts.txtsia simile all'esempio seguente:10.138.0.1 rhel-hana-primary 10.138.0.2 rhel-hana-primaryw1 10.138.0.3 rhel-hana-secondary 10.138.0.4 rhel-hana-secondaryw1 10.138.0.5 rhel-sap-mm

Su tutti gli host del cluster, incluso il maggioritario, aggiorna il file

/etc/hostsin modo da includere i nomi host e gli indirizzi IP interni di tutte le istanze del cluster Pacemaker.while read -u10 ZONE HOST ; do gcloud compute ssh --tunnel-through-iap --quiet $HOST --zone $ZONE -- "sudo tee -a /etc/hosts" < hosts.txt; done 10< nodes.txt

Esegui il backup dei database

Crea i backup dei database per avviare la registrazione del database per la replica del sistema SAP HANA e creare un punto di recupero.

Se hai più database tenant in una configurazione MDC, esegui il backup di ciascun database tenant.

Il modello Deployment Manager utilizza /hanabackup/data/SID come directory di backup predefinita.

Per creare i backup dei nuovi database SAP HANA:

Nell'host principale, passa a

SID_LCadm. A seconda dell'immagine del sistema operativo, il comando potrebbe essere diverso.sudo -i -u SID_LCadm

Crea backup del database:

Per un sistema SAP HANA con un singolo contenitore del database:

>hdbsql -t -u system -p SYSTEM_PASSWORD -i INST_NUM \ "backup data using file ('full')"L'esempio seguente mostra una risposta corretta da un nuovo sistema SAP HANA:

0 rows affected (overall time 18.416058 sec; server time 18.414209 sec)

Per un sistema di contenitori multidatabase (MDC) SAP HANA, crea un backup del database di sistema e di tutti i database dei tenant:

>hdbsql -t -d SYSTEMDB -u system -p SYSTEM_PASSWORD -i INST_NUM \ "backup data using file ('full')">hdbsql -t -d SID -u system -p SYSTEM_PASSWORD -i INST_NUM \ "backup data using file ('full')"

L'esempio seguente mostra una risposta corretta da un nuovo sistema SAP HANA:

0 rows affected (overall time 16.590498 sec; server time 16.588806 sec)

Verifica che la modalità di logging sia impostata su normale:

>hdbsql -u system -p SYSTEM_PASSWORD -i INST_NUM \ "select value from "SYS"."M_INIFILE_CONTENTS" where key='log_mode'"Dovresti vedere:

VALUE "normal"

Attiva la replica del sistema SAP HANA

Nell'ambito dell'attivazione della replica del sistema SAP HANA, devi copiare i dati e i file chiave per gli archivi sicuri SAP HANA sul file system (SSFS) dall'hosting primario all'hosting secondario. Il metodo utilizzato da questa procedura per copiare i file è solo uno dei possibili metodi che puoi utilizzare.

Nell'host principale come

SID_LCadm, attiva la replica del sistema:>hdbnsutil -sr_enable --name=PRIMARY_HOST_NAMESul computer host secondario:

Come

SID_LCadm, interrompi SAP HANA:>sapcontrol -nr INST_NUM -function StopSystemCome utente root, archivia i dati e i file di chiavi SSFS esistenti:

#cd /usr/sap/SID/SYS/global/security/rsecssfs/#mv data/SSFS_SID.DAT data/SSFS_SID.DAT-ARC#mv key/SSFS_SID.KEY key/SSFS_SID.KEY-ARCCopia il file di dati dall'host principale:

#scp -o StrictHostKeyChecking=no \ PRIMARY_HOST_NAME:/usr/sap/SID/SYS/global/security/rsecssfs/data/SSFS_SID.DAT \ /usr/sap/SID/SYS/global/security/rsecssfs/data/SSFS_SID.DATCopia il file della chiave dall'host principale:

#scp -o StrictHostKeyChecking=no \ PRIMARY_HOST_NAME:/usr/sap/SID/SYS/global/security/rsecssfs/key/SSFS_SID.KEY \ /usr/sap/SID/SYS/global/security/rsecssfs/key/SSFS_SID.KEYAggiorna la proprietà dei file:

#chown SID_LCadm:sapsys /usr/sap/SID/SYS/global/security/rsecssfs/data/SSFS_SID.DAT#chown SID_LCadm:sapsys /usr/sap/SID/SYS/global/security/rsecssfs/key/SSFS_SID.KEYAggiorna le autorizzazioni per i file:

#chmod 644 /usr/sap/SID/SYS/global/security/rsecssfs/data/SSFS_SID.DAT#chmod 640 /usr/sap/SID/SYS/global/security/rsecssfs/key/SSFS_SID.KEYCome SID_LCadm, registra il sistema SAP HANA secondario con la replica del sistema SAP HANA:

>hdbnsutil -sr_register --remoteHost=PRIMARY_HOST_NAME --remoteInstance=INST_NUM \ --replicationMode=syncmem --operationMode=logreplay --name=SECONDARY_HOST_NAMECome SID_LCadm, avvia SAP HANA:

>sapcontrol -nr INST_NUM -function StartSystem

Convalida della replica del sistema

Nell'host principale come SID_LCadm, verifica che la replica del sistema SAP HANA sia attiva eseguendo il seguente script Python:

$ python $DIR_INSTANCE/exe/python_support/systemReplicationStatus.pySe la replica è configurata correttamente, tra gli altri indicatori, vengono visualizzati i seguenti valori per i servizi xsengine, nameserver e indexserver:

- Il valore

Secondary Active StatusèYES - Il valore

Replication StatusèACTIVE

Inoltre, overall system replication status mostra ACTIVE.

Attivare i hook del provider SAP HANA HA/RE

Red Hat consiglia di attivare i hook del provider SAP HANA HA/RE, che consentono a SAP HANA di inviare notifiche per determinati eventi e migliorano il rilevamento degli errori. Gli hook del provider SAP HANA HA/RE richiedono SAP HANA 2.0 SPS 03 o una versione successiva.

Sia sul sito principale che su quello secondario, completa i seguenti passaggi:

Come

SID_LCadm, interrompi SAP HANA:>sapcontrol -nr 00 -function StopSystem

Come utente root o

SID_LCadm, apri il fileglobal.iniper la modifica:>vi /hana/shared/SID/global/hdb/custom/config/global.iniAggiungi le seguenti definizioni al file

global.ini:[ha_dr_provider_SAPHanaSR] provider = SAPHanaSR path = /usr/share/SAPHanaSR-ScaleOut/ execution_order = 1 [ha_dr_provider_chksrv] provider = ChkSrv path = /usr/share/SAPHanaSR-ScaleOut/ execution_order = 2 action_on_lost = stop [trace] ha_dr_saphanasr = info ha_dr_chksrv = info

Come utente root, crea un file di configurazione personalizzato nella directory

/etc/sudoers.deseguendo il seguente comando. Questo nuovo file di configurazione consente all'utenteSID_LCadmdi accedere agli attributi del nodo del cluster quando viene chiamato il metodo di hooksrConnectionChanged().>visudo -f /etc/sudoers.d/20-saphanaNel file

Sostituisci/etc/sudoers.d/20-saphana, aggiungi il seguente testo:SID_LCcon l'ID cliente in lettere minuscole.Cmnd_Alias SOK = /usr/sbin/crm_attribute -n hana_SID_LC_glob_srHook -v SOK -t crm_config -s SAPHanaSR Cmnd_Alias SFAIL = /usr/sbin/crm_attribute -n hana_SID_LC_glob_srHook -v SFAIL -t crm_config -s SAPHanaSR SID_LCadm ALL=(ALL) NOPASSWD: SOK, SFAIL Defaults!SOK, SFAIL !requiretty

Nel file

/etc/sudoers, assicurati che sia incluso il seguente testo:#includedir /etc/sudoers.d

Tieni presente che

#in questo testo fa parte della sintassi e non indica che la riga è un commento.Come

SID_LCadm, avvia SAP HANA:>sapcontrol -nr 00 -function StartSystemNell'host principale come

SID_LCadm, testa lo stato riportato dallo script di hook:>cdtrace>awk '/ha_dr_SAPHanaSR.*crm_attribute/ { printf "%s %s %s %s\n",$2,$3,$5,$16 }' nameserver_*

Configurare il supporto del failover di Cloud Load Balancing

Il servizio bilanciatore del carico di rete passthrough interno con supporto del failover instrada il traffico all'host attivo in un cluster SAP HANA in base a un servizio di controllo di integrità.

Prenota un indirizzo IP per l'IP virtuale

L'indirizzo IP virtuale (VIP), a volte indicato come indirizzo IP mobile, segue il sistema SAP HANA attivo. Il bilanciatore del carico indirizza il traffico inviato all'indirizzo VIP alla VM che attualmente ospita il sistema SAP HANA attivo.

Apri Cloud Shell:

Prenota un indirizzo IP per l'IP virtuale. Si tratta dell'indirizzo IP utilizzato dalle applicazioni per accedere a SAP HANA. Se ometti il flag

--addresses, viene scelto per te un indirizzo IP nella subnet specificata:$gcloud compute addresses create VIP_NAME \ --region CLUSTER_REGION --subnet CLUSTER_SUBNET \ --addresses VIP_ADDRESSPer ulteriori informazioni sulla prenotazione di un indirizzo IP statico, consulta Prenotazione di un indirizzo IP interno statico.

Conferma la prenotazione dell'indirizzo IP:

$gcloud compute addresses describe VIP_NAME \ --region CLUSTER_REGIONDovresti vedere un output simile al seguente esempio:

address: 10.0.0.19 addressType: INTERNAL creationTimestamp: '2020-05-20T14:19:03.109-07:00' description: '' id: '8961491304398200872' kind: compute#address name: vip-for-hana-ha networkTier: PREMIUM purpose: GCE_ENDPOINT region: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1 selfLink: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1/addresses/vip-for-hana-ha status: RESERVED subnetwork: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1/subnetworks/example-subnet-us-central1

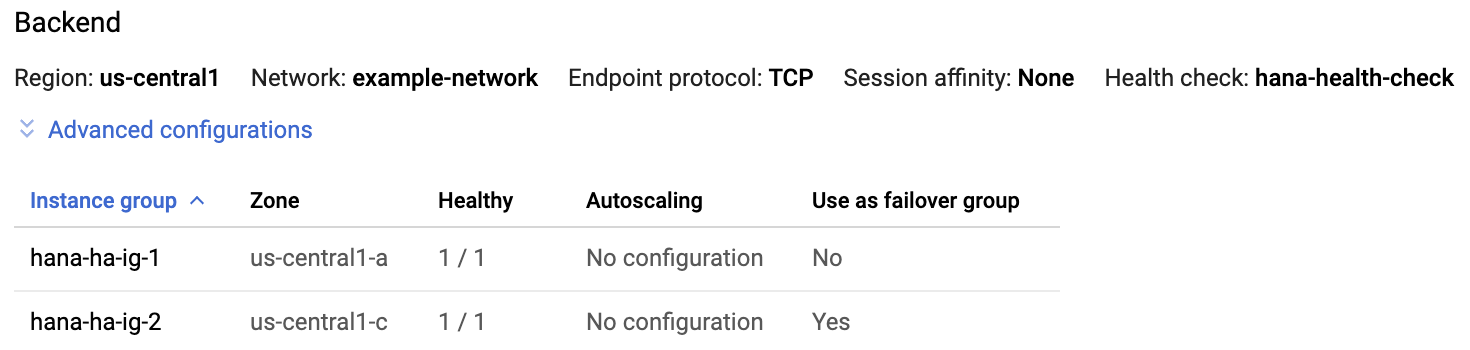

Crea gruppi di istanze per le VM host

In Cloud Shell, crea due gruppi di istanze non gestite e assegna la VM host principale a uno e la VM host secondaria all'altro:

$gcloud compute instance-groups unmanaged create PRIMARY_IG_NAME \ --zone=PRIMARY_ZONE$gcloud compute instance-groups unmanaged add-instances PRIMARY_IG_NAME \ --zone=PRIMARY_ZONE \ --instances=PRIMARY_HOST_NAME$gcloud compute instance-groups unmanaged create SECONDARY_IG_NAME \ --zone=SECONDARY_ZONE$gcloud compute instance-groups unmanaged add-instances SECONDARY_IG_NAME \ --zone=SECONDARY_ZONE \ --instances=SECONDARY_HOST_NAMEConferma la creazione dei gruppi di istanze:

$gcloud compute instance-groups unmanaged listDovresti vedere un output simile al seguente esempio:

NAME ZONE NETWORK NETWORK_PROJECT MANAGED INSTANCES hana-ha-ig-1 us-central1-a example-network example-project-123456 No 1 hana-ha-ig-2 us-central1-c example-network example-project-123456 No 1

Crea un controllo di integrità Compute Engine

In Cloud Shell, crea il controllo di integrità. Per la porta utilizzata dal controllo di integrità, scegli una porta nell'intervallo privato 49152-65535 per evitare conflitti con altri servizi. I valori di intervallo di controllo e timeout sono leggermente più lunghi di quelli predefiniti per aumentare la tolleranza al failover durante gli eventi di migrazione live di Compute Engine. Se necessario, puoi modificare i valori:

$gcloud compute health-checks create tcp HEALTH_CHECK_NAME --port=HEALTHCHECK_PORT_NUM \ --proxy-header=NONE --check-interval=10 --timeout=10 --unhealthy-threshold=2 \ --healthy-threshold=2Conferma la creazione del controllo di integrità:

$gcloud compute health-checks describe HEALTH_CHECK_NAMEDovresti vedere un output simile al seguente esempio:

checkIntervalSec: 10 creationTimestamp: '2020-05-20T21:03:06.924-07:00' healthyThreshold: 2 id: '4963070308818371477' kind: compute#healthCheck name: hana-health-check selfLink: https://www.googleapis.com/compute/v1/projects/example-project-123456/global/healthChecks/hana-health-check tcpHealthCheck: port: 60000 portSpecification: USE_FIXED_PORT proxyHeader: NONE timeoutSec: 10 type: TCP unhealthyThreshold: 2

Crea una regola firewall per i controlli di integrità

Definisci una regola firewall per una porta nell'intervallo privato che consenta l'accesso alle VM host dagli intervalli IP utilizzati dai controlli di salute di Compute Engine, 35.191.0.0/16 e 130.211.0.0/22. Per saperne di più, consulta Creare regole firewall per i controlli di integrità.

Se non ne hai già uno, aggiungi un tag di rete alle VM host. Questo tag di rete viene utilizzato dalla regola firewall per i controlli di integrità.

$gcloud compute instances add-tags PRIMARY_HOST_NAME \ --tags NETWORK_TAGS \ --zone PRIMARY_ZONE$gcloud compute instances add-tags SECONDARY_HOST_NAME \ --tags NETWORK_TAGS \ --zone SECONDARY_ZONESe non ne hai già una, crea una regola firewall per consentire i controlli di integrità:

$gcloud compute firewall-rules create RULE_NAME \ --network NETWORK_NAME \ --action ALLOW \ --direction INGRESS \ --source-ranges 35.191.0.0/16,130.211.0.0/22 \ --target-tags NETWORK_TAGS \ --rules tcp:HLTH_CHK_PORT_NUMAd esempio:

gcloud compute firewall-rules create fw-allow-health-checks \ --network example-network \ --action ALLOW \ --direction INGRESS \ --source-ranges 35.191.0.0/16,130.211.0.0/22 \ --target-tags cluster-ntwk-tag \ --rules tcp:60000

Configura il bilanciatore del carico e il gruppo di failover

Crea il servizio di backend del bilanciatore del carico:

$gcloud compute backend-services create BACKEND_SERVICE_NAME \ --load-balancing-scheme internal \ --health-checks HEALTH_CHECK_NAME \ --no-connection-drain-on-failover \ --drop-traffic-if-unhealthy \ --failover-ratio 1.0 \ --region CLUSTER_REGION \ --global-health-checksAggiungi il gruppo di istanze principale al servizio di backend:

$gcloud compute backend-services add-backend BACKEND_SERVICE_NAME \ --instance-group PRIMARY_IG_NAME \ --instance-group-zone PRIMARY_ZONE \ --region CLUSTER_REGIONAggiungi il gruppo di istanze di failover secondario al servizio di backend:

$gcloud compute backend-services add-backend BACKEND_SERVICE_NAME \ --instance-group SECONDARY_IG_NAME \ --instance-group-zone SECONDARY_ZONE \ --failover \ --region CLUSTER_REGIONCreare una regola di forwarding. Per l'indirizzo IP, specifica l'indirizzo IP che hai riservato per il VIP. Se devi accedere al sistema SAP HANA dall'esterno della regione specificata di seguito, includi il flag

--allow-global-accessnella definizione:$gcloud compute forwarding-rules create RULE_NAME \ --load-balancing-scheme internal \ --address VIP_ADDRESS \ --subnet CLUSTER_SUBNET \ --region CLUSTER_REGION \ --backend-service BACKEND_SERVICE_NAME \ --ports ALLPer saperne di più sull'accesso tra regioni al sistema SAP HANA di alta disponibilità, consulta Bilanciamento del carico TCP/UDP interno.

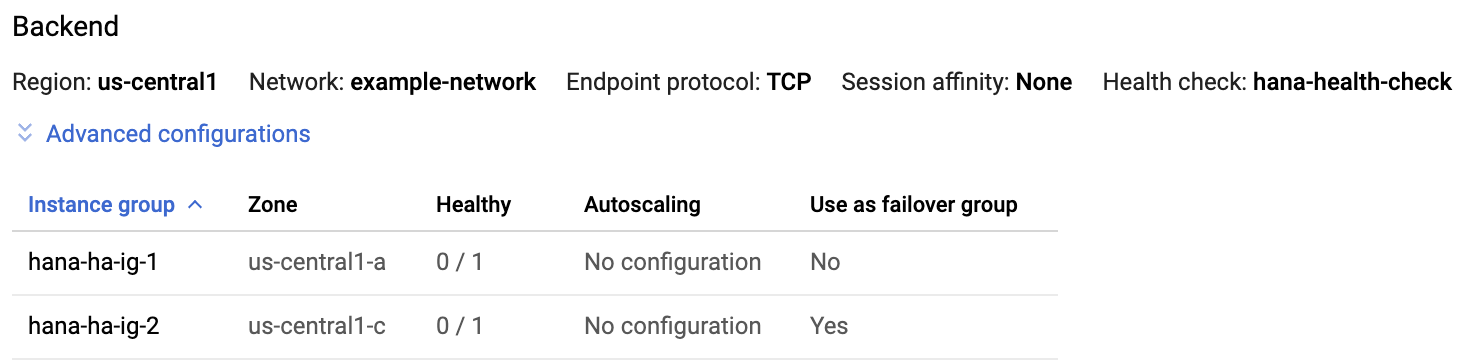

Testa la configurazione del bilanciatore del carico

Anche se i gruppi di istanza di backend non verranno registrati come integri fino a più tardi, puoi testare la configurazione del bilanciatore del carico impostando un listener per rispondere ai controlli di integrità. Dopo aver configurato un ascoltatore, se il bilanciatore del carico è configurato correttamente, lo stato dei gruppi di istanza di backend diventa Stabile.

Le sezioni seguenti presentano diversi metodi che puoi utilizzare per testare la configurazione.

Test del bilanciatore del carico con l'utilità socat

Puoi utilizzare l'utilità socat per ascoltare temporaneamente sulla porta di controllo di integrità.

Installa l'

socatutility sia sulle VM host master principali che su quelle secondarie:$sudo yum install -y socatAvvia un processo

socatper ascoltare per 60 secondi sulla porta di controllo di integrità:$sudo timeout 60s socat - TCP-LISTEN:HLTH_CHK_PORT_NUM,forkIn Cloud Shell, dopo aver atteso qualche secondo affinché il controllo di integrità rilevi il listener, controlla lo stato dei gruppi di istanza di backend:

$gcloud compute backend-services get-health BACKEND_SERVICE_NAME \ --region CLUSTER_REGIONDovresti vedere un output simile al seguente:

--- backend: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-a/instanceGroups/hana-ha-ig-1 status: healthStatus: ‐ healthState: HEALTHY instance: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-a/instances/hana-ha-vm-1 ipAddress: 10.0.0.35 port: 80 kind: compute#backendServiceGroupHealth --- backend: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instanceGroups/hana-ha-ig-2 status: healthStatus: ‐ healthState: HEALTHY instance: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instances/hana-ha-vm-2 ipAddress: 10.0.0.34 port: 80 kind: compute#backendServiceGroupHealth

Test del bilanciatore del carico utilizzando la porta 22

Se la porta 22 è aperta per le connessioni SSH sulle VM host, puoi modificare temporaneamente il controllo di integrità in modo che utilizzi la porta 22, che ha un listener in grado di rispondere al controllo di integrità.

Per utilizzare temporaneamente la porta 22:

Fai clic sul controllo di integrità nella console:

Fai clic su Modifica.

Nel campo Porta, imposta il numero di porta su 22.

Fai clic su Salva e attendi un paio di minuti.

In Cloud Shell, controlla lo stato dei gruppi di istanza di backend:

$gcloud compute backend-services get-health BACKEND_SERVICE_NAME \ --region CLUSTER_REGIONDovresti vedere un output simile al seguente:

--- backend: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-a/instanceGroups/hana-ha-ig-1 status: healthStatus: ‐ healthState: HEALTHY instance: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-a/instances/hana-ha-vm-1 ipAddress: 10.0.0.35 port: 80 kind: compute#backendServiceGroupHealth --- backend: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instanceGroups/hana-ha-ig-2 status: healthStatus: ‐ healthState: HEALTHY instance: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instances/hana-ha-vm-2 ipAddress: 10.0.0.34 port: 80 kind: compute#backendServiceGroupHealth

Al termine, ripristina il numero di porta del controllo di integrità.

Configurare Pacemaker

La procedura seguente configura l'implementazione Red Hat di un cluster Pacemaker su VM Compute Engine per SAP HANA.

La procedura si basa sulla documentazione di Red Hat per la configurazione di cluster ad alta disponibilità, tra cui (è richiesto un abbonamento a Red Hat):

- Installazione e configurazione di un cluster ad alta disponibilità Red Hat Enterprise Linux 7.6 (e versioni successive) su Google Cloud

- Replicazione automatica del sistema SAP HANA in scale-out in un cluster pacemaker

Procedura manuale

Completa i seguenti passaggi su tutti gli host. Nell'immagine RHEL per SAP fornita da Google, alcuni pacchetti sono già installati, ma sono necessarie alcune modifiche aggiuntive.

Come utente root, rimuovi l'agente di risorse SAP HANA Scale-Up preinstallato nell'immagine:

#yum -y remove resource-agents-sap-hanaInstalla Pacemaker e gli agenti delle risorse mancanti:

#yum -y install pcs pacemaker fence-agents-gce resource-agents-gcp resource-agents-sap-hana-scaleoutUpdate packages to latest version:

#yum update -yImposta la password per l'utente

hacluster, creato nell'ambito dei pacchetti:#passwd haclusterSpecifica una password per

haclusterquando richiesto.Nelle immagini RHEL for SAP fornite da Google Cloud, il servizio firewall del sistema operativo è attivo per impostazione predefinita. Configura il servizio firewall per consentire il traffico ad alta disponibilità:

#firewall-cmd --permanent --add-service=high-availability#firewall-cmd --reloadAvvia il servizio pcs e configuralo in modo che venga avviato all'avvio:

#systemctl start pcsd.service#systemctl enable pcsd.serviceControlla lo stato del servizio pcs:

#systemctl status pcsd.serviceDovresti vedere un output simile al seguente:

● pcsd.service - PCS GUI and remote configuration interface Loaded: loaded (/usr/lib/systemd/system/pcsd.service; enabled; vendor preset: disabled) Active: active (running) since Sat 2020-06-13 21:17:05 UTC; 25s ago Docs: man:pcsd(8) man:pcs(8) Main PID: 31627 (pcsd) CGroup: /system.slice/pcsd.service └─31627 /usr/bin/ruby /usr/lib/pcsd/pcsd Jun 13 21:17:03 hana-ha-1 systemd[1]: Starting PCS GUI and remote configuration interface... Jun 13 21:17:05 hana-ha-1 systemd[1]: Started PCS GUI and remote configuration interface.

Passaggi automatici

Per automatizzare questa procedura, puoi utilizzare nodes.txt e lo script seguente dalla Google Cloud Console.

Al prompt, inserisci una password da utilizzare per l'utente hacluster creato durante l'installazione degli agenti di risorse Pacemaker.

echo "Set password for hacluster user:"; read -r HA_PASSWD; while read -u10 HOST ; do gcloud compute ssh --tunnel-through-iap --quiet --zone $HOST -- "sudo yum -y remove resource-agents-sap-hana; sudo yum -y install pcs pacemaker fence-agents-gce resource-agents-sap-hana-scaleout resource-agents-gcp; sudo yum update -y; sudo firewall-cmd --permanent --add-service=high-availability; sudo firewall-cmd --reload; sudo systemctl start pcsd.service; sudo systemctl enable pcsd.service; yes $HA_PASSWD | sudo passwd hacluster"; done 10< nodes.txt

Aggiorna il file /etc/hosts

Su tutti gli host del cluster, incluso il maggioritario, aggiorna il file /etc/hosts in modo da includere i nomi host e gli indirizzi IP interni di tutte le istanze del cluster Pacemaker.

L'output del file /etc/hosts dovrebbe essere simile all'esempio riportato di seguito:

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6 10.138.0.1 rhel-hana-primary.us-west1-a.c.project-name.internal rhel-hana-primary # Added by Google 169.254.169.254 metadata.google.internal # Added by Google 10.138.0.1 rhel-hana-primary 10.138.0.2 rhel-hana-primaryw1 10.138.0.3 rhel-hana-secondary 10.138.0.4 rhel-hana-secondaryw1 10.138.0.5 rhel-sap-mm

Per ulteriori informazioni di Red Hat sulla configurazione del file /etc/hosts sui nodi del cluster RHEL, consulta https://access.redhat.com/solutions/81123

Crea il cluster

Con accesso come utente root sull'host master principale, autorizzi l'utente

hacluster. È importante includere in questo comando tutti gli host del cluster, che devono far parte del cluster.RHEL 8.0 e versioni successive

pcs host auth primary-master-name primary-worker-name(s) secondary-master-name secondary-worker-name(s) majority-maker-name

RHEL 7.6 e versioni successive

pcs cluster auth primary-master-name primary-worker-name(s) secondary-master-name secondary-worker-name(s) majority-maker-name

Quando richiesto, inserisci il nome utente

haclustere la password impostata per l'utentehaclusternella sezione precedente.Imposta il cluster in modalità di manutenzione.

pcs property set maintenance-mode=true

Genera e sincronizza la configurazione di corosync.

RHEL 8.0 e versioni successive

pcs cluster setup scale_out_hsr primary-master-name primary-worker-name(s) secondary-master-name secondary-worker-name(s) majority-maker-name

RHEL 7.6 e versioni successive

pcs cluster setup --start --name hanascaleoutsr primary-master-name primary-worker-name(s) secondary-master-name secondary-worker-name(s) majority-maker-name

Modifica le impostazioni predefinite di corosync.conf

Apri il file

/etc/corosync/corosync.confutilizzando un editor a tua scelta.Rimuovi il parametro