Google Kubernetes Engine (GKE)

Kubernetes, evoluto: la base per i creatori di piattaforme

Imposta i container su Autopilot ed esegui in sicurezza workload aziendali su larga scala, con una competenza minima o nulla di Kubernetes.

Ottieni un cluster di zona o Autopilot gratuito al mese. Inoltre, i nuovi clienti ricevono 300$ di crediti gratuiti per provare GKE.

Funzionalità

Gestione semplificata dei cluster e maggiore efficienza delle risorse

GKE Autopilot è una modalità operativa in cui Google gestisce l'infrastruttura dei nodi, la scalabilità, la sicurezza e le funzionalità preconfigurate. Grazie al dimensionamento corretto automatico della capacità e alla tariffazione per pod, puoi evitare il sovra-provisioning, il pagamento eccessivo e la sottoutilizzazione. Con la piattaforma di calcolo ottimizzata per container di Autopilot, puoi ottenere un calcolo scalabile in verticale e in orizzontale quasi in tempo reale che fornisce la capacità necessaria, quando necessario, al miglior prezzo e con le migliori prestazioni.

Piattaforma pronta per la produzione per i workload di AI agentica e i modelli di AI generativa

Con il supporto per cluster fino a 65.000 nodi, l'integrazione con AI Hypercomputer e il supporto per GPU e TPU, GKE semplifica l'esecuzione di ML, HPC e altri workload che traggono vantaggio da acceleratori hardware specializzati.

Le funzionalità di inferenza di GKE con tecniche di scalabilità e bilanciamento del carico con supporto dell'AI generativa aiutano a ridurre i costi di gestione di oltre il 30%, la latenza di coda del 60% e ad aumentare il throughput fino al 40% rispetto ad altre offerte Kubernetes open source e gestite.

La sicurezza prima di tutto

GKE offre sicurezza su larga scala con best practice integrate, infrastruttura conforme e avvisi in tempo reale, in modo da poter mitigare rapidamente e velocemente le minacce alla sicurezza e i problemi di conformità in una vista unificata.

Supportata da un team di sicurezza Google di oltre 750 esperti, la security posture integrata di GKE include applicazione di patch e protezione hard, isolamento e segmentazione, nodi Confidential GKE Node, gestione di identità e accessi e integrazioni con Cloud Logging e Cloud Monitoring.

Inoltre, con GKE Sandbox, puoi aggiungere un secondo livello di difesa tra i workload containerizzati su GKE per una maggiore sicurezza dei workload.

Gestione multi-team e multi-cluster

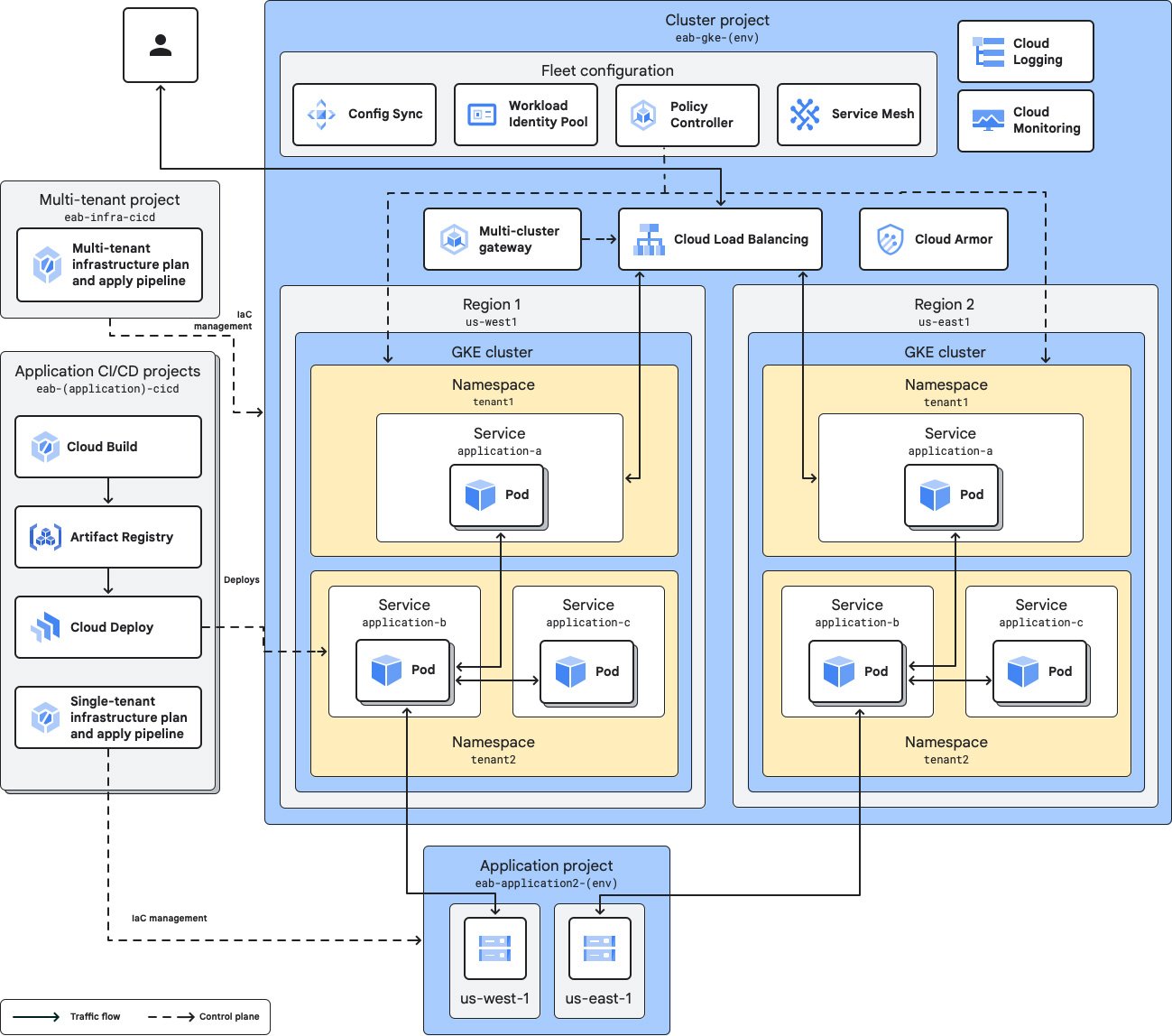

Parchi risorse e team possono essere utilizzati per organizzare cluster e workload e assegnare facilmente risorse a più team per migliorare la velocità e delegare la proprietà. Gli ambiti dei team consentono di definire sottoinsiemi di risorse del parco risorse in base al team, con ogni ambito associato a uno o più cluster membro del parco risorse.

Puoi scegliere più cluster per separare i servizi tra ambienti, livelli, impostazioni internazionali, team o provider di infrastrutture. I parchi risorse cercano di semplificare il più possibile la gestione di più cluster.

Portabilità dei workload con supporto multi-cloud

GKE esegue Kubernetes certificato e adotta standard aperti per consentire ai clienti di eseguire le proprie applicazioni, senza modifiche, sugli investimenti hardware on-premise esistenti o nel cloud pubblico.

I cluster collegati GKE ti consentono di registrare o collegare qualsiasi cluster Kubernetes conforme che hai creato all'ambiente di gestione GKE. Il collegamento di un cluster ti offre la gestione e il controllo GKE, oltre all'accesso a funzionalità aggiuntive come Config Sync, Cloud Service Mesh e parchi risorse.

Come funziona

All'interno di ogni cluster GKE, GKE gestisce il ciclo di vita del piano di controllo Kubernetes dalla creazione all'eliminazione del cluster. Con Autopilot abilitato, GKE può anche gestire i tuoi nodi, inclusi provisioning, scalabilità e pianificazione automatizzati. In alternativa, puoi scegliere di avere più controllo e gestire i nodi in autonomia.

All'interno di ogni cluster GKE, GKE gestisce il ciclo di vita del piano di controllo Kubernetes dalla creazione all'eliminazione del cluster. Con Autopilot abilitato, GKE può anche gestire i tuoi nodi, inclusi provisioning, scalabilità e pianificazione automatizzati. In alternativa, puoi scegliere di avere più controllo e gestire i nodi in autonomia.

Utilizzi comuni

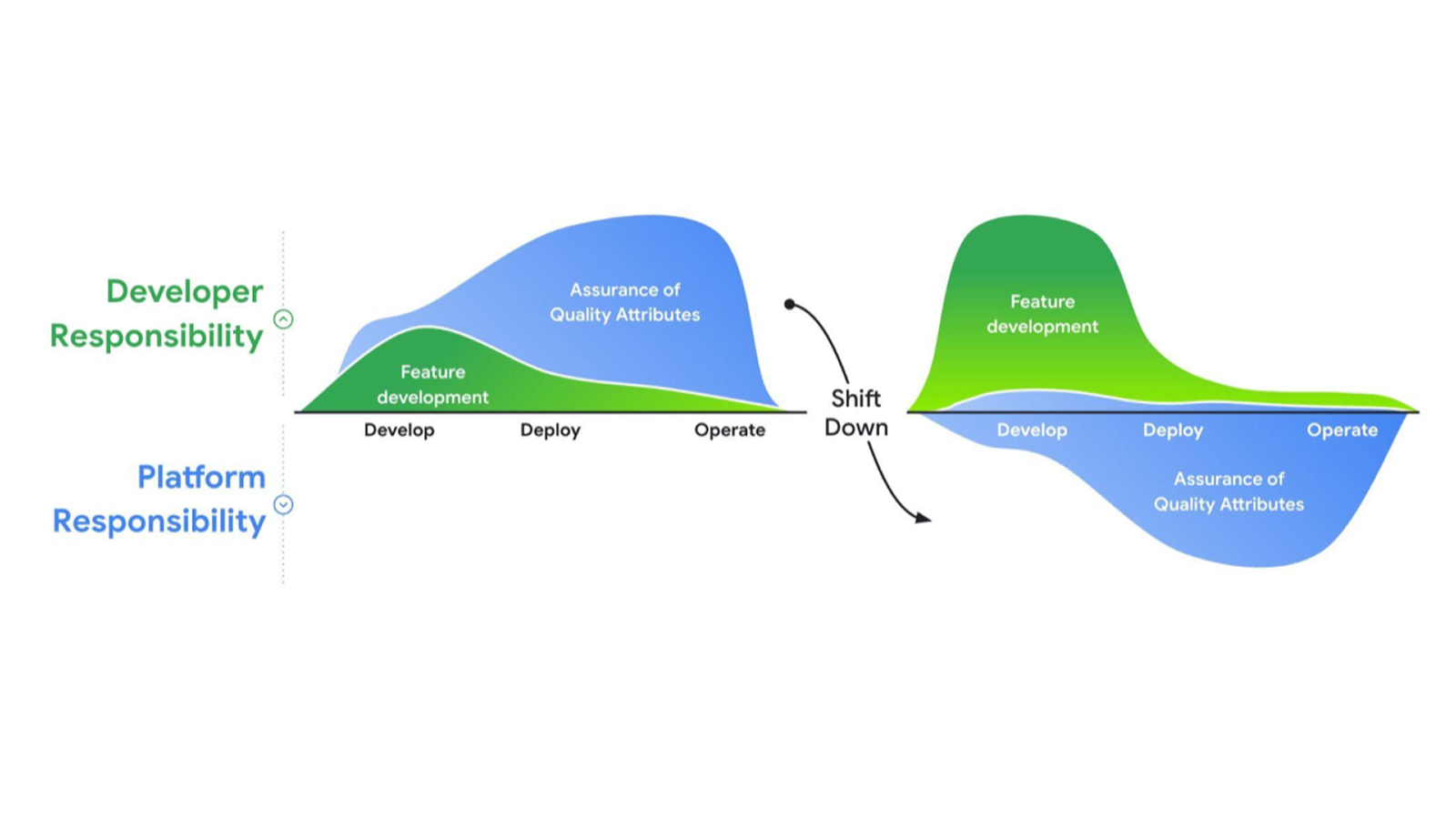

Crea piattaforme per tutti i tuoi workload

Crea una piattaforma per sviluppatori aziendali per una distribuzione rapida e affidabile delle app

Crea una piattaforma per sviluppatori aziendali per una distribuzione rapida e affidabile delle app

Google Cloud offre una suite completa di servizi gestiti e runtime che fungono da elementi costitutivi per la tua piattaforma, in modo che tu possa trovare la giusta combinazione di servizi per i tuoi casi d'uso. La profonda integrazione di GKE con l'ecosistema Google Cloud, la scalabilità senza pari e la security posture integrata lo rendono una base ideale per la tua piattaforma.

Che cos'è il platform engineering?

Tutorial, guide rapide e lab

Crea una piattaforma per sviluppatori aziendali per una distribuzione rapida e affidabile delle app

Crea una piattaforma per sviluppatori aziendali per una distribuzione rapida e affidabile delle app

Google Cloud offre una suite completa di servizi gestiti e runtime che fungono da elementi costitutivi per la tua piattaforma, in modo che tu possa trovare la giusta combinazione di servizi per i tuoi casi d'uso. La profonda integrazione di GKE con l'ecosistema Google Cloud, la scalabilità senza pari e la security posture integrata lo rendono una base ideale per la tua piattaforma.

Risorse per l'apprendimento

Che cos'è il platform engineering?

Addestra, distribuisci e scala i modelli di AI generativa

Esegui il deployment dell'inferenza di AI generativa con GKE

Esegui il deployment dell'inferenza di AI generativa con GKE

GKE non solo fornisce una piattaforma per l'AI, ma semplifica e automatizza anche le operazioni Kubernetes con l'AI. Con il supporto per un massimo di 65.000 nodi e l'integrazione con AI Hypercomputer, puoi addestrare e scalare i tuoi modelli di AI generativa più grandi su GKE.

Inoltre, le funzionalità di inferenza di GKE con supporto dell'AI generativa offrono costi di gestione inferiori fino al 30%, latenza di coda inferiore del 60% e throughput superiore del 40% rispetto a OSS K8s.

Tutorial, guide rapide e lab

Esegui il deployment dell'inferenza di AI generativa con GKE

Esegui il deployment dell'inferenza di AI generativa con GKE

GKE non solo fornisce una piattaforma per l'AI, ma semplifica e automatizza anche le operazioni Kubernetes con l'AI. Con il supporto per un massimo di 65.000 nodi e l'integrazione con AI Hypercomputer, puoi addestrare e scalare i tuoi modelli di AI generativa più grandi su GKE.

Inoltre, le funzionalità di inferenza di GKE con supporto dell'AI generativa offrono costi di gestione inferiori fino al 30%, latenza di coda inferiore del 60% e throughput superiore del 40% rispetto a OSS K8s.

Orchestrazione multi-agente

Esegui il deployment e orchestra applicazioni multi-agente

Esegui il deployment e orchestra applicazioni multi-agente

L'AI agentica è incentrata sull'orchestrazione e sull'esecuzione di agenti che utilizzano gli LLM come "cervello" per eseguire azioni attraverso strumenti.

GKE è la piattaforma aperta definitiva per supportare gli agenti e orchestrare il tuo computing in modo da poter adottare la prossima generazione di workload di AI agentica.

Tutorial, guide rapide e lab

Esegui il deployment e orchestra applicazioni multi-agente

Esegui il deployment e orchestra applicazioni multi-agente

L'AI agentica è incentrata sull'orchestrazione e sull'esecuzione di agenti che utilizzano gli LLM come "cervello" per eseguire azioni attraverso strumenti.

GKE è la piattaforma aperta definitiva per supportare gli agenti e orchestrare il tuo computing in modo da poter adottare la prossima generazione di workload di AI agentica.

Prezzi

| Come funzionano i prezzi di GKE | Dopo aver utilizzato i crediti gratuiti, il costo totale si basa sulla modalità operativa dei cluster, sulle tariffe di gestione dei cluster e sulle tariffe applicabili per il trasferimento dei dati in entrata. | |

|---|---|---|

| Servizio | Descrizione | Prezzo ($) |

Livello gratuito | Il livello gratuito di GKE offre 74,40 $ in crediti mensili per account di fatturazione, che vengono applicati a cluster Autopilot e di zona. | Nessun costo |

Tariffa di gestione dei cluster | Include gestione del ciclo di vita dei cluster completamente automatizzata, scalabilità automatica di pod e cluster, visibilità dei costi, ottimizzazione automatica dei costi dell'infrastruttura e funzionalità di gestione multi-cluster, senza costi aggiuntivi. | 0,10 $ per cluster all'ora |

Computing | Quando utilizzi Autopilot, paghi solo per la CPU, la memoria e le risorse di computing di cui viene eseguito il provisioning per i tuoi pod. Per i pool di nodi e le classi di computing che non utilizzano Autopilot, ti vengono addebitati i costi per le istanze Compute Engine sottostanti dei nodi fino a quando i nodi non vengono eliminati. | Consulta i prezzi di Compute Engine |

Scopri di più sui prezzi di GKE. Visualizza tutti i dettagli sui prezzi

Come funzionano i prezzi di GKE

Dopo aver utilizzato i crediti gratuiti, il costo totale si basa sulla modalità operativa dei cluster, sulle tariffe di gestione dei cluster e sulle tariffe applicabili per il trasferimento dei dati in entrata.

Il livello gratuito di GKE offre 74,40 $ in crediti mensili per account di fatturazione, che vengono applicati a cluster Autopilot e di zona.

Nessun costo

Tariffa di gestione dei cluster

Include gestione del ciclo di vita dei cluster completamente automatizzata, scalabilità automatica di pod e cluster, visibilità dei costi, ottimizzazione automatica dei costi dell'infrastruttura e funzionalità di gestione multi-cluster, senza costi aggiuntivi.

0,10 $

per cluster all'ora

Quando utilizzi Autopilot, paghi solo per la CPU, la memoria e le risorse di computing di cui viene eseguito il provisioning per i tuoi pod.

Per i pool di nodi e le classi di computing che non utilizzano Autopilot, ti vengono addebitati i costi per le istanze Compute Engine sottostanti dei nodi fino a quando i nodi non vengono eliminati.

Consulta i prezzi di Compute Engine

Scopri di più sui prezzi di GKE. Visualizza tutti i dettagli sui prezzi

Business case

Impara dai clienti di GKE

10 anni e non li dimostra: perché Signify ha scelto GKE

Con GKE come base, la piattaforma Philips Hue ha scalato la sua infrastruttura per supportare un aumento del 1.150% delle transazioni e dei comandi nell'ultimo decennio.

Sblocca l'innovazione dell'AI su GKE

Il fornitore di pubblicità basato sull'AI Moloco ottiene tempi di addestramento dei modelli 10 volte più rapidi con le TPU su GKE.

Con le TPU su GKE, HubX riduce la latenza fino al 66%, migliorando l'esperienza utente e aumentando i tassi di conversione.

LiveX AI ottiene un TCO inferiore di oltre il 50%, un time-to-market più rapido del 25% e un costo operativo inferiore del 66% con GKE Autopilot.