Dataproc

Apache Spark e Hadoop gestiti con Google Dataproc

Esegui i tuoi workload Spark e open source più impegnativi in modo più semplice con un servizio gestito, più intelligente con Gemini e più veloce con Lightning Engine.

Apache Spark è un marchio di Apache Software Foundation.

Funzionalità

Prestazioni leader del settore

Accelera i tuoi job Spark più impegnativi con Lightning Engine. Il nostro motore di nuova generazione offre prestazioni oltre 4, 3 volte più veloci con ottimizzazione gestita, riducendo il TCO e la necessità di ottimizzazione manuale. Ora disponibile in anteprima per Dataproc.

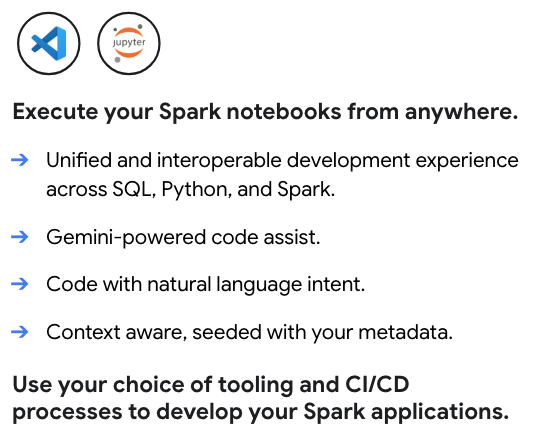

Sviluppo e operazioni basati sull'AI

Accelera l'intero workflow con Gemini. Ricevi assistenza basata sull'AI per scrivere ed eseguire il debug del codice PySpark e utilizza Gemini Cloud Assist per ottenere un'analisi automatizzata della causa principale per i job non riusciti o a esecuzione lenta, riducendo drasticamente i tempi di risoluzione dei problemi\

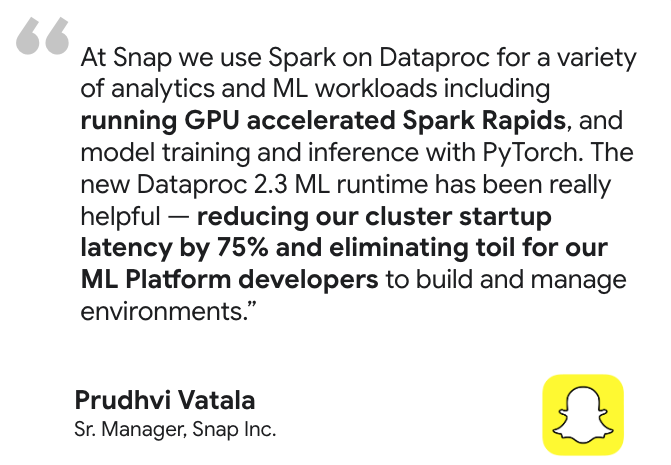

Predisposizione per ML e AI aziendali

Crea e metti in funzione l'intero ciclo di vita del machine learning. Accelera l'addestramento e l'inferenza dei modelli con il supporto GPU, basato su NVIDIA RAPIDS™ e runtime ML preconfigurati. Quindi, integrati con l'ecosistema AI di Google Cloud più ampio per orchestrare MLOps end-to-end con Vertex AI Pipelines.

Potenti integrazioni lakehouse

Connettiti in modo nativo a un'architettura lakehouse aperta. Elabora i dati direttamente da BigQuery, orchestra MLOps con Vertex AI Pipelines e unifica la governance sui tuoi dati aperti con BigLake e Dataplex Universal Catalog.

Controllo e personalizzazione senza pari

Personalizza ogni cluster Dataproc in base alle tue esigenze specifiche. Sviluppa in Python, Scala o Java, scegli tra un'ampia gamma di tipi di macchine, utilizza azioni di inizializzazione per installare software personalizzato e porta le tue immagini container per la massima portabilità.

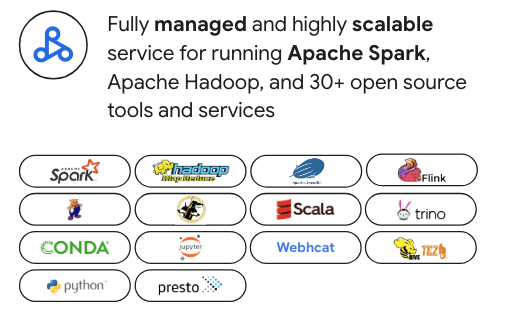

Creato per lo stack di dati open source moderno

Nessun vincolo al fornitore. Sebbene Dataproc sia ottimizzato per Apache Spark, supporta oltre 30 strumenti open source come Apache Hadoop, Flink, Trino e Presto. Si integra perfettamente con gli orchestratori più diffusi come Airflow e può essere esteso con Kubernetes e Docker per la massima flessibilità.

Sicurezza di livello aziendale

Integrazione perfetta con la tua security posture. Sfrutta IAM per autorizzazioni granulari, Controlli di servizio VPC per la sicurezza di rete e Kerberos per un'autenticazione efficace sul tuo cluster Spark.

Utilizzi comuni

Migrazione nel cloud

Esegui facilmente il lift-and-shift dei workload Apache Hadoop e Spark on-premise. È anche il percorso ideale per passare da un "Spark fai da te" autogestito a un servizio completamente gestito. Il supporto di Dataproc per un'ampia gamma di versioni di Spark, tra cui la versione legacy 2.x, semplifica la migrazione riducendo la necessità di un refactoring immediato del codice. Ciò ti consente di sfruttare le competenze open source esistenti del tuo team per un percorso più rapido verso il cloud.

Risorse per l'apprendimento

Migrazione nel cloud

Esegui facilmente il lift-and-shift dei workload Apache Hadoop e Spark on-premise. È anche il percorso ideale per passare da un "Spark fai da te" autogestito a un servizio completamente gestito. Il supporto di Dataproc per un'ampia gamma di versioni di Spark, tra cui la versione legacy 2.x, semplifica la migrazione riducendo la necessità di un refactoring immediato del codice. Ciò ti consente di sfruttare le competenze open source esistenti del tuo team per un percorso più rapido verso il cloud.

Modernizzazione del lakehouse

Utilizza Dataproc come motore di elaborazione open source potente per il tuo data lakehouse moderno. Elabora i dati in formati aperti come Apache Iceberg direttamente dal tuo data lake, eliminando i silo di dati e lo spostamento costoso dei dati. Integra senza problemi BigQuery e Dataplex Universal Catalog per una piattaforma di analisi e governance veramente unificata e multi-motore.

Risorse per l'apprendimento

Modernizzazione del lakehouse

Utilizza Dataproc come motore di elaborazione open source potente per il tuo data lakehouse moderno. Elabora i dati in formati aperti come Apache Iceberg direttamente dal tuo data lake, eliminando i silo di dati e lo spostamento costoso dei dati. Integra senza problemi BigQuery e Dataplex Universal Catalog per una piattaforma di analisi e governance veramente unificata e multi-motore.

Data engineering

Crea e orchestra pipeline ETL Spark complesse e di lunga durata con affidabilità e scalabilità di livello enterprise. Sfrutta funzionalità potenti come la scalabilità automatica per ottimizzare i costi e le prestazioni e utilizza i modelli di workflow per automatizzare e gestire i tuoi job più critici a livello di produzione dall'inizio alla fine.

Risorse per l'apprendimento

Data engineering

Crea e orchestra pipeline ETL Spark complesse e di lunga durata con affidabilità e scalabilità di livello enterprise. Sfrutta funzionalità potenti come la scalabilità automatica per ottimizzare i costi e le prestazioni e utilizza i modelli di workflow per automatizzare e gestire i tuoi job più critici a livello di produzione dall'inizio alla fine.

Data science su larga scala

Fornisci ai team di data science ambienti di cluster Spark potenti e personalizzabili per l'addestramento di modelli su larga scala e l'inferenza in batch. Con ML Runtime preconfigurati e supporto GPU, puoi accelerare l'intero ciclo di vita ML e integrarti con Vertex AI per creare e rendere operative pipeline MLOps end-to-end.

Risorse per l'apprendimento

Data science su larga scala

Fornisci ai team di data science ambienti di cluster Spark potenti e personalizzabili per l'addestramento di modelli su larga scala e l'inferenza in batch. Con ML Runtime preconfigurati e supporto GPU, puoi accelerare l'intero ciclo di vita ML e integrarti con Vertex AI per creare e rendere operative pipeline MLOps end-to-end.

Motori di analisi OSS flessibili

Vai oltre Spark e Hadoop senza aggiungere overhead operativo. Esegui il deployment di cluster dedicati con Trino per SQL interattivo, Flink per l'elaborazione avanzata dei flussi o altri motori open source specializzati. Dataproc fornisce un control plane unificato per gestire questo ecosistema diversificato con la semplicità di un servizio gestito.

Risorse per l'apprendimento

Motori di analisi OSS flessibili

Vai oltre Spark e Hadoop senza aggiungere overhead operativo. Esegui il deployment di cluster dedicati con Trino per SQL interattivo, Flink per l'elaborazione avanzata dei flussi o altri motori open source specializzati. Dataproc fornisce un control plane unificato per gestire questo ecosistema diversificato con la semplicità di un servizio gestito.

Prezzi

| Cluster gestiti Dataproc | Dataproc offre prezzi con pagamento a consumo. Ottimizza i costi con la scalabilità automatica e le VM preemptible. |

|---|---|

Componenti chiave |

|

Esempio | Un cluster con 6 nodi (1 principale + 5 worker) di 4 CPU ciascuno in esecuzione per 2 ore costerebbe 0,48 $. Costo di Dataproc = numero di vCPU * ore * prezzo Dataproc = 24 * 2 * 0,01 $ = 0,48 $ |

Cluster gestiti Dataproc

Dataproc offre prezzi con pagamento a consumo. Ottimizza i costi con la scalabilità automatica e le VM preemptible.

Componenti chiave

- Istanze Compute Engine (vCPU, memoria)

- Costo del servizio Dataproc (per vCPU all'ora)

- Dischi permanenti

Esempio

Un cluster con 6 nodi (1 principale + 5 worker) di 4 CPU ciascuno in esecuzione per 2 ore costerebbe 0,48 $. Costo di Dataproc = numero di vCPU * ore * prezzo Dataproc = 24 * 2 * 0,01 $ = 0,48 $

Business case

Crea il tuo business case per Google Dataproc

I vantaggi economici di Google Cloud Dataproc e Serverless Spark rispetto a soluzioni alternative

Scopri come Dataproc offre risparmi significativi in termini di TCO e valore aziendale rispetto alle soluzioni on-prem e ad altre soluzioni cloud.

Contenuti correlati

Nel report:

Scopri come Dataproc e Serverless per Apache Spark possono offrire un risparmio sui costi dal 18% al 60% rispetto ad altre alternative Spark basate su cloud.

Scopri come Google Cloud Serverless per Apache Spark può offrire un rapporto prezzo-prestazioni migliore del 21-55% rispetto ad altre offerte Spark serverless.

Scopri come Dataproc e Google Cloud Serverless per Apache Spark semplificano i deployment Spark e contribuiscono a ridurre la complessità operativa.

Domande frequenti

Quando devo scegliere Dataproc rispetto a Google Cloud Serverless per Apache Spark?

Scegli Dataproc quando hai bisogno di un controllo granulare sull'ambiente del cluster, stai migrando workload Hadoop/Spark esistenti o hai bisogno di un cluster persistente con un set diversificato di strumenti open source. Per una ripartizione dettagliata delle differenze nei modelli di gestione, nei workload ideali e nelle strutture di costo.

Posso usare più servizi, e non solamente Spark e Hadoop?

Sì. Dataproc è una piattaforma unificata per lo stack di dati open source moderno. Supporta oltre 30 componenti, consentendoti di eseguire cluster dedicati per strumenti come Flink per l'elaborazione di flussi o Trino per SQL interattivo, il tutto in un unico servizio gestito.

Quanto controllo ho sull'ambiente del cluster?

Hai un alto grado di controllo. Dataproc consente di personalizzare i tipi di macchina, le dimensioni del disco e le configurazioni di rete. Puoi anche utilizzare le azioni di inizializzazione per installare software personalizzato, portare le tue immagini container e sfruttare le VM spot per ottimizzare i costi.