Questa guida mostra come utilizzare Sensitive Data Protection per ispezionare una tabella BigQuery e inviare i risultati dell'ispezione a Data Catalog.

Puoi eseguire anche la profilazione dei dati, che è diversa da un'operazione di ispezione. Puoi anche inviare profili di dati a Dataplex. Per saperne di più, vedi Taggare le tabelle in Dataplex in base agli insight dei profili di dati.

Data Catalog è un servizio scalabile di gestione dei metadati che consente di scoprire, gestire e comprendere rapidamente tutti i dati in Google Cloud.

La protezione dei dati sensibili è integrata con Data Catalog. Quando utilizzi un'azione di Sensitive Data Protection per ispezionare le tabelle BigQuery per individuare dati sensibili, i risultati possono essere inviati direttamente a Data Catalog sotto forma di modello di tag.

Completando i passaggi descritti in questa guida, sarai in grado di:

- Abilita Data Catalog e Sensitive Data Protection.

- Configura Sensitive Data Protection per ispezionare una tabella BigQuery.

- Configura un'ispezione di Sensitive Data Protection per inviare i risultati dell'ispezione a Data Catalog.

Per ulteriori informazioni su Data Catalog, consulta la documentazione di Data Catalog.

Se vuoi inviare a Dataplex i risultati delle operazioni di profilazione dei dati (non i job di ispezione), consulta la documentazione per la profilazione di un'organizzazione, una cartella o un progetto.

Costi

In questo documento utilizzi i seguenti componenti fatturabili di Google Cloud:

- Sensitive Data Protection

- BigQuery

Per generare una stima dei costi basata sull'utilizzo previsto,

utilizza il Calcolatore prezzi.

Prima di iniziare

Prima di poter inviare i risultati dell'ispezione di Sensitive Data Protection a Data Catalog, segui questi passaggi:

- Passaggio 1: imposta la fatturazione.

- Passaggio 2: crea un nuovo progetto e compila una nuova tabella BigQuery. (Facoltativo)

- Passaggio 3: attiva Data Catalog.

- Passaggio 4: attiva Sensitive Data Protection.

Le seguenti sottosezioni trattano ogni passaggio in dettaglio.

Passaggio 1: imposta la fatturazione

Devi prima configurare un account di fatturazione, se non ne hai già uno.

Scopri come attivare la fatturazione

(Facoltativo) Passaggio 2: crea un nuovo progetto e compila una nuova tabella BigQuery

Se stai configurando questa funzionalità per il lavoro in produzione o hai già una tabella BigQuery che vuoi ispezionare, apri il progetto Google Cloud che contiene la tabella e vai al passaggio 3.

Se stai provando questa funzionalità e vuoi esaminare i dati dei test, crea un nuovo progetto. Per completare questo passaggio, devi disporre del ruolo Creatore progetto IAM. Scopri di più sui ruoli IAM.

- Vai alla pagina Nuovo progetto nella console Google Cloud.

- Nell'elenco a discesa Account di fatturazione, seleziona l'account di fatturazione a cui deve essere fatturato il progetto.

- Nell'elenco a discesa Organizzazione, seleziona l'organizzazione in cui vuoi creare il progetto.

- Nell'elenco a discesa Posizione, seleziona l'organizzazione o la cartella in cui vuoi creare il progetto.

- Fai clic su Crea per creare il progetto.

Quindi, scarica e memorizza i dati di esempio:

- Vai al repository dei tutorial di Cloud Functions su GitHub.

- Seleziona uno dei file CSV con dati di esempio e scarica il file.

- Quindi, vai a BigQuery nella console Google Cloud.

- Seleziona il progetto.

- Fai clic su Crea set di dati.

- Fai clic su Crea tabella.

- Fai clic su Carica e seleziona il file da caricare.

- Assegna un nome alla tabella, poi fai clic su Crea tabella.

Passaggio 3: attiva Data Catalog

Successivamente, abilita Data Catalog per il progetto che contiene la tabella BigQuery che vuoi ispezionare utilizzando Sensitive Data Protection.

Per abilitare Data Catalog utilizzando la console Google Cloud:

- Registra la tua applicazione per Data Catalog.

- Nella pagina di registrazione, dall'elenco a discesa Crea un progetto, seleziona il progetto che vuoi utilizzare con Data Catalog.

- Dopo aver selezionato il progetto, fai clic su Continua.

Data Catalog è ora abilitato per il tuo progetto.

Passaggio 4: attiva Sensitive Data Protection

Abilita Sensitive Data Protection per lo stesso progetto per cui hai abilitato Data Catalog.

Per attivare la protezione dei dati sensibili utilizzando la console Google Cloud:

- Registra la tua richiesta di partecipazione al programma Sensitive Data Protection.

Registra la tua applicazione per la protezione dei dati sensibili

- Nella pagina di registrazione, dall'elenco a discesa Crea un progetto, seleziona lo stesso progetto che hai scelto nel passaggio precedente.

- Dopo aver selezionato il progetto, fai clic su Continua.

La protezione dei dati sensibili è ora abilitata per il tuo progetto.

Configura ed esegui un job di ispezione di Sensitive Data Protection

Puoi configurare ed eseguire un job di ispezione di Sensitive Data Protection utilizzando la console Google Cloud o l'API DLP.

I modelli di tag di Data Catalog sono archiviati nello stesso progetto e nella stessa regione della tabella BigQuery. Se stai esaminando una tabella di un altro progetto, devi concedere il ruolo Proprietario TagTemplate Data Catalog (roles/datacatalog.tagTemplateOwner) all'agente di servizio Sensitive Data Protection nel progetto in cui si trova la tabella BigQuery.

Console Google Cloud

Per configurare un job di ispezione di una tabella BigQuery utilizzando Sensitive Data Protection:

Nella sezione Sensitive Data Protection della console Google Cloud, vai alla pagina Crea job o trigger di job.

Inserisci le informazioni del job di Sensitive Data Protection e fai clic su Continua per completare ogni passaggio:

In Passaggio 1: scegli i dati di input, assegna un nome al job inserendo un valore nel campo Nome. In Località, scegli BigQuery dal menu Tipo di archiviazione, quindi inserisci le informazioni per la tabella da ispezionare. La sezione Campionamento è preconfigurata per eseguire un'ispezione di esempio sui dati. Puoi modificare i campi Limita righe per e Numero massimo di righe per risparmiare risorse se disponi di una grande quantità di dati. Per maggiori dettagli, consulta Scegliere i dati di input.

(Facoltativo) Nel Passaggio 2: configura il rilevamento, configurerai i tipi di dati da cercare, chiamati "infoTypes". Ai fini di questa procedura dettagliata, mantieni selezionati gli infoType predefiniti. Per maggiori dettagli, consulta Configurare il rilevamento.

Per il Passaggio 3: aggiungi azioni, attiva Salva in Data Catalog.

(Facoltativo) Per il Passaggio 4: pianificazione, ai fini di questa procedura dettagliata, lascia il menu impostato su Nessuno in modo che l'ispezione venga eseguita una sola volta. Per scoprire di più sulla pianificazione dei job di ispezione ripetuti, consulta Pianificazione.

Fai clic su Crea. Il job viene eseguito immediatamente.

DLP API

In questa sezione configurerai ed esegui un job di ispezione di Sensitive Data Protection.

Il job di ispezione che configuri qui indica a Sensitive Data Protection di ispezionare i dati BigQuery di esempio descritti nel Passaggio 2 sopra o i tuoi dati BigQuery. Nella configurazione del job specificata indichi anche Sensitive Data Protection di salvare i risultati dell'ispezione in Data Catalog.

Passaggio 1: prendi nota dell'identificatore del progetto

Vai alla console Google Cloud.

Fai clic su Seleziona.

Nell'elenco a discesa Seleziona da, scegli l'organizzazione per cui hai abilitato Data Catalog.

In ID, copia l'ID del progetto che contiene i dati da esaminare. Questo è il progetto descritto nel passaggio Impostazione dei repository di archiviazione in precedenza in questa pagina.

In Nome, fai clic sul progetto per selezionarlo.

Passaggio 2: apri Explorer API e configura il job

Vai a Explorer API nella pagina di riferimento per il metodo

dlpJobs.create. Per fare in modo che queste istruzioni restino disponibili, fai clic con il tasto destro del mouse sul seguente link e aprilo in una nuova scheda o finestra:Nella casella parent, inserisci quanto segue, dove project-id è l'ID progetto che hai annotato in precedenza nel passaggio precedente:

projects/project-id

Ora copia il seguente JSON. Seleziona i contenuti del campo Corpo della richiesta in Explorer API, quindi incolla il codice JSON per sostituire i contenuti. Assicurati di sostituire i segnaposto

project-id,bigquery-dataset-nameebigquery-table-namecon l'ID progetto effettivo e i nomi delle tabelle e dei set di dati BigQuery, in modo corretto.{ "inspectJob": { "storageConfig": { "bigQueryOptions": { "tableReference": { "projectId": "project-id", "datasetId": "bigquery-dataset-name", "tableId": "bigquery-table-name" } } }, "inspectConfig": { "infoTypes": [ { "name": "EMAIL_ADDRESS" }, { "name": "PERSON_NAME" }, { "name": "US_SOCIAL_SECURITY_NUMBER" }, { "name": "PHONE_NUMBER" } ], "includeQuote": true, "minLikelihood": "UNLIKELY", "limits": { "maxFindingsPerRequest": 100 } }, "actions": [ { "publishFindingsToCloudDataCatalog": {} } ] } }

Per scoprire di più sulle opzioni di ispezione disponibili, consulta Ispezione dello spazio di archiviazione e dei database per l'individuazione di dati sensibili. Per un elenco completo dei tipi di informazioni che Sensitive Data Protection può esaminare, consulta la documentazione di riferimento sugli InfoType.

Passaggio 3: esegui la richiesta per avviare il job di ispezione

Dopo aver configurato il job seguendo i passaggi precedenti, fai clic su Esegui per inviare la richiesta. Se la richiesta ha esito positivo, viene visualizzata una risposta con un codice di operazione riuscita e un oggetto JSON che indica lo stato del job di Sensitive Data Protection appena creato.

La risposta alla richiesta di ispezione include l'ID job del job di ispezione

come chiave "name" e lo stato attuale del job di ispezione come

chiave "state". Poiché hai appena inviato la richiesta, lo stato del job in quel momento è "PENDING".

Controlla lo stato del job di ispezione di Sensitive Data Protection

Dopo l'invio della richiesta di ispezione, il job di ispezione inizia immediatamente.

Console Google Cloud

Per controllare lo stato del job di ispezione:

Nella console Google Cloud, apri Sensitive Data Protection.

Fai clic sulla scheda Job e trigger di job, quindi fai clic su Tutti i job.

Il job che hai appena eseguito probabilmente sarà in cima all'elenco. Controlla la colonna Stato per assicurarti che lo stato sia Completato.

Puoi fare clic sull'ID job del job per visualizzare i risultati. Ogni rilevatore infoType elencato nella pagina Dettagli job è seguito dal numero di corrispondenze trovate nei contenuti.

DLP API

Per controllare lo stato del job di ispezione:

Vai a Explorer API nella pagina di riferimento per il metodo

dlpJobs.getfacendo clic sul seguente pulsante:Nella casella nome, digita il nome del job dalla risposta JSON alla richiesta di ispezione nel seguente formato:

projects/project-id/dlpJobs/job-id

i-1234567890123456789.Per inviare la richiesta, fai clic su Esegui.

Se la chiave "state" dell'oggetto JSON di risposta indica che il job è "DONE",

il job di ispezione è stato completato.

Per visualizzare il resto del codice JSON della risposta, scorri la pagina verso il basso. In "result" > "infoTypeStats", ogni tipo di informazione elencato deve avere un valore "count" corrispondente. In caso contrario, assicurati di aver inserito correttamente il JSON e che il percorso o la posizione dei dati sia corretta.

Al termine del job di ispezione, puoi passare alla sezione successiva di questa guida per visualizzare i risultati dell'ispezione in Security Command Center.

Visualizza i risultati dell'ispezione di Sensitive Data Protection in Data Catalog

Poiché hai chiesto a Sensitive Data Protection di inviare i risultati del job di ispezione a Data Catalog, ora puoi visualizzare i tag e il modello di tag creati automaticamente nell'interfaccia utente di Data Catalog:

- Vai alla pagina Data Catalog nella console Google Cloud.

- Cerca la tabella che hai controllato.

- Fai clic sui risultati corrispondenti alla tabella per visualizzare i relativi metadati.

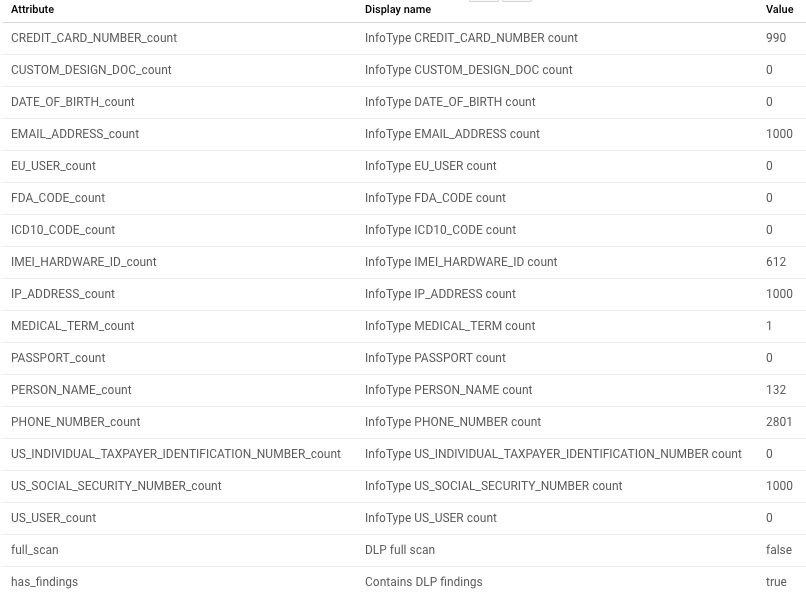

Il seguente screenshot mostra la visualizzazione dei metadati di Data Catalog di una tabella di esempio:

Riepilogo dell'ispezione

I risultati di Sensitive Data Protection sono inclusi in modulo di riepilogo per la tabella ispezionata. Questo riepilogo include i conteggi totali degli infoType e i dati di riepilogo sul job di ispezione che include le date e l'ID risorsa del job.

Sono elencati tutti i infoTypes che sono stati ispezionati. Quelli con risultati mostrano un

conteggio maggiore di zero.

Eseguire la pulizia

Per evitare che al tuo account Google Cloud vengano addebitati costi relativi alle risorse utilizzate in questo argomento, esegui una delle seguenti operazioni, a seconda che tu abbia utilizzato dati di esempio o tuoi:

- Dati di esempio: elimina il progetto che hai creato.

- I tuoi dati: elimina il job di protezione dei dati sensibili che hai creato.

Elimina il progetto

Il modo più semplice per eliminare la fatturazione è eliminare il progetto creato seguendo le istruzioni fornite in questo argomento.

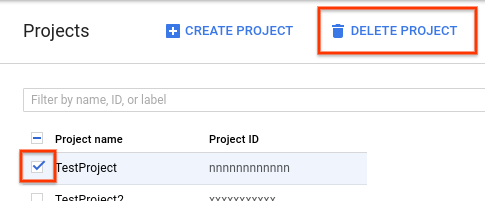

Per eliminare il progetto:

- Nella console Google Cloud, vai alla pagina Progetti.

-

Nell'elenco dei progetti, seleziona quello da eliminare e fai clic su Elimina progetto.

- Nella finestra di dialogo, digita l'ID del progetto e fai clic su Chiudi per eliminare il progetto.

Quando elimini il progetto utilizzando questo metodo, vengono eliminati anche il job di Sensitive Data Protection e il bucket Cloud Storage che hai creato. Non è necessario seguire le istruzioni riportate nelle sezioni seguenti.

Eliminazione del job di Sensitive Data Protection o del trigger di job

Se hai ispezionato i tuoi dati, elimina il job di ispezione o il trigger del job appena creato.

Console Google Cloud

Nella console Google Cloud, apri Sensitive Data Protection.

Fai clic sulla scheda Job e trigger di job, quindi fai clic sulla scheda Trigger di job.

Nella colonna Azioni relativa al trigger di job da eliminare, fai clic sul menu Altre azioni (visualizzato come tre puntini disposti in verticale) , quindi fai clic su Elimina.

Se vuoi, puoi anche eliminare i dettagli del job che hai eseguito. Fai clic sulla scheda Tutti i job, quindi nella colonna Azioni per il job da eliminare, fai clic sul menu Altre azioni (visualizzato come tre puntini disposti verticalmente) , quindi su Elimina.

DLP API

Vai a Explorer API nella pagina di riferimento per il metodo

dlpJobs.deletefacendo clic sul seguente pulsante:Nella casella nome, digita il nome del job dalla risposta JSON alla richiesta di ispezione, che ha il seguente formato:

projects/project-id/dlpJobs/job-id

i-1234567890123456789.

Se hai creato job di ispezione aggiuntivi o se vuoi assicurarti di aver eliminato correttamente il job, puoi elencare tutti i job esistenti:

Vai a Explorer API nella pagina di riferimento per il metodo

dlpJobs.listfacendo clic sul seguente pulsante:Nella casella parent, digita l'identificatore del progetto nel formato seguente, dove project-id è l'identificatore del progetto:

projects/project-id

Fai clic su Execute (Esegui).

Se non ci sono job elencati nella risposta, hai eliminato tutti i job. Se i job sono elencati nella risposta, ripeti la procedura di eliminazione riportata sopra per tali job.

Passaggi successivi

- Scopri di più sull'azione

publishFindingsToCloudDataCatalogin Sensitive Data Protection. - Scopri di più sulla creazione di tag personalizzati o tag a livello di colonna in Data Catalog in base ai risultati di Sensitive Data Protection.

- Scopri di più sull'ispezione dei repository di archiviazione per dati sensibili utilizzando Sensitive Data Protection.

- Scopri come utilizzare Data Catalog.