이 가이드에서는 SAP NetWeaver 시스템용 성능 최적화 SUSE Linux Enterprise Server(SLES) 고가용성(HA) 클러스터를 배포하고 구성하는 방법을 보여줍니다.

이 가이드에는 다음을 수행하는 단계가 포함되어 있습니다.- 장애가 발생할 경우 트래픽을 다시 라우팅하도록 내부 패스 스루 네트워크 부하 분산기 구성

- 장애 조치 중에 SAP 시스템과 기타 리소스를 관리하도록 SLES에서 Pacemaker 클러스터 구성 간단한 마운트 구성은 SAP용 SLES 15 이상에도 제공됩니다.

이 가이드에는 HA용 SAP NetWeaver 시스템을 구성하는 단계도 포함되어 있지만 정확한 지침은 SAP 문서를 참조하세요.

고가용성에 국한되지 않는 SAP NetWeaver용 Compute Engine VM 배포에 대한 자세한 내용은 사용하는 운영체제에 해당하는 SAP NetWeaver 배포 가이드를 참조하세요.

Red Hat Enterprise Linux(RHEL)에서 SAP HANA용 HA 클러스터를 구성하려면 RHEL에서 SAP NetWeaver용 HA 클러스터 수동 구성 가이드를 참조하세요.

이 가이드는 SAP NetWeaver용 Linux 고가용성 구성에 익숙한 SAP NetWeaver 고급 사용자를 대상으로 합니다.

이 가이드에서 배포하는 시스템

이 가이드를 수행하여 SAP NetWeaver 인스턴스 두 개를 배포하고 SLES에서 HA 클러스터를 설정합니다. 각 SAP NetWeaver 인스턴스를 동일한 리전 내 서로 다른 영역에 있는 Compute Engine VM에 배포합니다. 기본 데이터베이스의 고가용성 설치는 이 가이드에서 다루지 않습니다.

배포된 클러스터에는 다음 기능과 특징이 포함됩니다.

- 호스트 VM 두 개(활성 ASCS 인스턴스용 하나 및 ENSA2 Enqueue Replicator 또는 ENSA1 Enqueue Replication Server(ENSA1)의 활성 인스턴스 하나). ENSA2 인스턴스와 ENSA1 인스턴스 모두 ERS라고 합니다.

- Pacemaker 고가용성 클러스터 리소스 관리자

- STONITH 펜싱 메커니즘

- 실패한 인스턴스를 새 보조 인스턴스로 자동 다시 시작

Terraform을 사용하여 SAP NetWeaver HA 시스템 배포를 자동화하려면 Terraform: SLES 기반 SAP NetWeaver용 HA 클러스터 구성 가이드를 참조하세요.

기본 요건

SAP NetWeaver 고가용성 클러스터를 만들기 전에 다음 기본 요건을 충족하는지 확인하세요.

- SAP NetWeaver 계획 가이드 및 Google Cloud의 SAP NetWeaver용 고가용성 계획 가이드를 읽었습니다.

- 사용자 또는 사용자의 조직에 Google Cloud 계정이 있어야 하고 SAP NetWeaver 배포를 위한 프로젝트를 만들어야 합니다.Google Cloud 계정 및 프로젝트를 만드는 방법에 대한 자세한 내용은 Linux용 SAP NetWeaver 배포 가이드의 프로젝트 만들기를 참고하세요.

- 데이터 상주, 액세스 제어, 지원 담당자 또는 규제 요건에 따라 SAP 워크로드를 실행해야 하는 경우 필요한 Assured Workloads 폴더를 만들어야 합니다. 자세한 내용은 Google Cloud 기반 SAP의 규정 준수 및 주권 제어 Google Cloud를 참고하세요.

VPC 내부 DNS를 사용하는 경우 전체 영역에서 노드 이름을 확인하려면 프로젝트 메타데이터의

vmDnsSetting변수 값이GlobalOnly또는ZonalPreferred여야 합니다.vmDnsSetting의 기본 설정은ZonalOnly입니다. 자세한 내용은 다음을 참고하세요.Filestore Enterprise와 같은 NFS 공유 파일 스토리지 솔루션을 사용하여 파일 공유를 설정했습니다.

프로젝트 메타데이터에 OS 로그인이 사용 설정되면 배포가 완료될 때까지 OS 로그인을 일시적으로 중지해야 합니다. 이 절차는 배포 목적으로 인스턴스 메타데이터에 SSH 키를 구성합니다. OS 로그인이 사용 설정되면 메타데이터 기반 SSH 키 구성이 사용 중지되고 이 배포가 실패합니다. 배포가 완료되면 OS 로그인을 다시 사용 설정할 수 있습니다.

자세한 내용은 다음을 참고하세요.

SUSE의 관련 정보

환경에 필요한 경우를 제외하고 이 가이드의 정보는 SUSE의 다음 관련 가이드와 일치합니다. Google Cloud

- SAP NetWeaver Enqueue Replication 1 고가용성 클러스터 - SAP NetWeaver 7.40 및 7.50용 설정 가이드 | SAP 애플리케이션용 SUSE Linux Enterprise Server 12

- SAP NetWeaver Enqueue Replication 1 고가용성 클러스터 - SAP NetWeaver 7.40 및 7.50용 설정 가이드 | SAP 애플리케이션용 SUSE Linux Enterprise Server 15

- SAP S/4 HANA - Enqueue Replication 2 고가용성 클러스터 - 설정 가이드 | SAP 애플리케이션용 SUSE Linux Enterprise Server 12

- SAP S/4 HANA - Enqueue Replication 2 고가용성 클러스터 - 설정 가이드 | SAP 애플리케이션용 SUSE Linux Enterprise Server 15

네트워크 만들기

보안 문제로 새 네트워크를 만들어야 합니다. 방화벽 규칙을 추가하거나 다른 액세스 제어 방법을 사용하여 액세스 권한이 있는 사용자를 제어할 수 있습니다.

프로젝트에 기본 VPC 네트워크가 있더라도 사용하지 마세요. 명시적으로 직접 만든 방화벽 규칙만 적용되도록 VPC 네트워크를 직접 만드시기 바랍니다.

배포 중에 Compute Engine 인스턴스는 일반적으로 SAP용 Google Cloud에이전트를 다운로드하기 위해 인터넷에 액세스할 수 있어야 합니다. Google Cloud에서 제공하는 SAP 인증 Linux 이미지 중 하나를 사용하는 경우 컴퓨팅 인스턴스도 라이선스를 등록하고 OS 공급업체 저장소에 액세스하기 위해 인터넷에 액세스할 수 있어야 합니다. NAT 게이트웨이 및 VM 네트워크 태그가 있는 구성은 대상 컴퓨팅 인스턴스에 외부 IP가 없더라도 이러한 액세스를 지원합니다.

네트워킹을 설정하는 방법은 다음과 같습니다.

콘솔

- Google Cloud 콘솔에서 VPC 네트워크 페이지로 이동합니다.

- VPC 네트워크 만들기를 클릭합니다.

- 네트워크의 이름을 입력합니다.

이름은 이름 지정 규칙을 준수해야 합니다. VPC 네트워크는 Compute Engine 이름 지정 규칙을 사용합니다.

- 서브넷 생성 모드에서 커스텀을 선택합니다.

- 새 서브넷 섹션에서 서브넷에 다음 구성 매개변수를 지정합니다.

- 서브넷 이름을 입력합니다.

- 리전에서 서브넷을 만들 Compute Engine 리전을 선택합니다.

- IP 스택 유형에서 IPv4(단일 스택)를 선택한 다음 CIDR 형식의 IP 주소 범위(예:

10.1.0.0/24)를 입력합니다.이 범위는 서브넷의 기본 IPv4 범위입니다. 서브네트워크를 한 개 넘게 추가하려는 경우 네트워크의 각 서브네트워크에 서로 겹치지 않는 CIDR IP 범위를 할당하세요. 각 서브네트워크 및 내부 IP 범위는 단일 리전에 매핑됩니다.

- 완료를 클릭합니다.

- 서브넷을 추가하려면 서브넷 추가를 클릭하고 이전 단계를 반복합니다. 네트워크를 만든 후에 네트워크에 서브넷을 더 추가할 수 있습니다.

- 만들기를 클릭합니다.

gcloud

- Cloud Shell로 이동합니다.

- 커스텀 서브네트워크 모드에서 새 네트워크를 만들려면 다음을 실행합니다.

gcloud compute networks create NETWORK_NAME --subnet-mode custom

NETWORK_NAME을 새 네트워크 이름으로 바꿉니다. 이름은 이름 지정 규칙을 준수해야 합니다. VPC 네트워크는 Compute Engine 이름 지정 규칙을 사용합니다.각 Compute Engine 리전에 서브넷을 자동으로 만드는 기본 자동 모드를 사용하지 않으려면

--subnet-mode custom을 지정합니다. 자세한 내용은 서브넷 생성 모드를 참조하세요. - 서브네트워크를 만들고 리전 및 IP 범위를 지정합니다.

gcloud compute networks subnets create SUBNETWORK_NAME \ --network NETWORK_NAME --region REGION --range RANGE다음을 바꿉니다.

SUBNETWORK_NAME: 새 서브네트워크의 이름입니다.NETWORK_NAME: 이전 단계에서 만든 네트워크의 이름입니다.REGION: 서브네트워크가 위치할 리전입니다.RANGE: CIDR 형식으로 지정된 IP 주소 범위(예:10.1.0.0/24)입니다.서브네트워크를 한 개 넘게 추가하려는 경우 네트워크의 각 서브네트워크에 서로 겹치지 않는 CIDR IP 범위를 할당하세요. 각 서브네트워크 및 내부 IP 범위는 단일 리전에 매핑됩니다.

- 필요한 경우 이전 단계를 반복하고 서브네트워크를 추가합니다.

NAT 게이트웨이 설정

공개 IP 주소가 없는 VM을 하나 이상 만들어야 하는 경우 네트워크 주소 변환 (NAT)을 사용하여 VM이 인터넷에 액세스하도록 설정해야 합니다. VM이 인터넷에 아웃바운드 패킷을 보내고 그에 따라 설정된 인바운드 응답 패킷을 받을 수 있도록 하는 Google Cloud 분산 소프트웨어 정의 관리형 서비스인 Cloud NAT를 사용하세요. 또는 별도의 VM을 NAT 게이트웨이로 설정할 수 있습니다.

프로젝트에 Cloud NAT 인스턴스를 만들려면 Cloud NAT 사용을 참조하세요.

프로젝트에 Cloud NAT를 구성하면 VM 인스턴스가 공개 IP 주소 없이 인터넷에 안전하게 액세스할 수 있습니다.

방화벽 규칙 추가

기본적으로 Google Cloud 네트워크 외부에서 들어오는 연결은 차단됩니다. 새로 추가되는 연결을 허용하려면 VM에 대해 방화벽 규칙을 설정합니다. 방화벽 규칙은 VM에 새로 추가되는 연결만 규제합니다. VM과 연결이 설정되면 이 연결을 통해 트래픽이 양방향으로 허용됩니다

지정된 포트에 액세스를 허용하거나 동일한 서브네트워크에 있는 VM 간의 액세스를 허용하는 방화벽 규칙을 만들 수 있습니다.

다음에 액세스를 허용하는 방화벽 규칙을 만들 수 있습니다.

- 모든 SAP 제품의 TCP/IP 포트에 설명된 대로 SAP NetWeaver에서 사용하는 기본 포트

- 사용자 컴퓨터 또는 기업 네트워크 환경에서 Compute Engine VM 인스턴스에 연결. 사용할 IP 주소를 잘 모를 때는 회사의 네트워크 관리자에게 문의하세요.

- 3계층, 수평 확장 또는 고가용성 구성에서 VM 간 통신 예를 들어 3계층 시스템을 배포하는 경우 SAP NetWeaver용 VM과 데이터베이스 서버용 VM 각각 1개씩, 2개 이상의 VM이 서브네트워크에 포함됩니다. 두 VM 간 통신을 사용 설정하려면 서브네트워크에서 시작된 트래픽을 허용하는 방화벽 규칙을 만들어야 합니다.

- Cloud Load Balancing 상태 확인 자세한 내용은 상태 확인에 사용할 방화벽 규칙 만들기를 참조하세요.

방화벽 규칙을 만들려면 다음 안내를 따르세요.

Google Cloud 콘솔에서 VPC 네트워크 방화벽 페이지로 이동합니다.

페이지 상단에서 방화벽 규칙 만들기를 클릭합니다.

- 네트워크 필드에서 VM이 위치하는 네트워크를 선택합니다.

- 대상 필드에서 네트워크의 모든 인스턴스를 선택합니다.

- 소스 필터 필드에서 다음 중 하나를 선택합니다.

- 특정 IP 주소에서 들어오는 트래픽을 허용하려면 IP 범위를 선택합니다. 소스 IP 범위 필드에 IP 주소 범위를 지정합니다.

- 특정 서브네트워크에서 들어오는 트래픽을 허용하려면 서브넷을 선택합니다. 다음 서브넷 필드에 서브네트워크 이름을 지정합니다. 이 옵션을 사용하면 3계층 또는 수평 확장 구성의 VM 간에 액세스를 허용할 수 있습니다.

- 프로토콜 및 포트 섹션에서 지정된 프로토콜 및 포트를 선택하고

tcp:PORT_NUMBER;를 지정합니다.

만들기를 클릭하여 방화벽 규칙을 만듭니다.

SAP NetWeaver용 VM 배포

HA 클러스터 구성을 시작하기 전에 HA 클러스터에서 기본 노드와 보조 노드 역할을 할 VM 인스턴스를 정의하고 배포합니다.

VM을 정의하고 배포하려면 Linux에서 SAP NetWeaver용 VM 자동 배포에서 SAP NetWeaver 시스템용 VM을 배포하는 데 사용하는 템플릿과 동일한 Cloud Deployment Manager 템플릿을 사용합니다.

하지만 VM을 하나가 아니라 두 개 배포하려면 첫 번째 VM의 정의를 복사하고 붙여넣어 두 번째 VM의 정의를 구성 파일에 추가해야 합니다. 두 번째 정의를 만든 후에는 두 번째 정의에서 리소스와 인스턴스 이름을 변경해야 합니다. 영역 오류를 방지하기 위해 같은 리전에 다른 영역을 지정합니다. 두 정의의 다른 모든 속성 값은 동일하게 유지됩니다.

VM이 성공적으로 배포되면 SAP NetWeaver를 설치하고 HA 클러스터를 정의하고 구성합니다.

다음 안내에서는 Cloud Shell을 사용하지만 일반적으로 Google Cloud CLI에 적용할 수 있습니다.

Cloud Shell을 엽니다.

YAML 구성 파일 템플릿

template.yaml을 작업 디렉터리에 다운로드합니다.wget https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_nw/template.yaml

필요한 경우

template.yaml파일의 이름을 바꿔 정의하는 구성을 식별합니다. 예를 들면nw-ha-sles15sp3.yaml입니다.Cloud Shell 터미널 창 오른쪽 상단에 있는 연필(edit) 아이콘을 클릭하여 Cloud Shell 코드 편집기에서 YAML 구성 파일을 엽니다.

YAML 구성 파일 템플릿에서 첫 번째 VM 인스턴스를 정의합니다. 다음 표 뒤의 다음 단계에서 두 번째 VM 인스턴스를 정의합니다.

대괄호로 묶인 콘텐츠를 설치에 해당하는 값으로 바꿔 속성 값을 지정합니다. 속성은 다음 표에 설명되어 있습니다. 완료된 구성 파일의 예시는 전체 YAML 구성 파일의 예시를 참조하세요.

속성 데이터 유형 설명 name문자열 다음 속성 집합이 정의하는 배포 리소스를 식별하는 임의 이름입니다. type문자열 배포 중에 사용할 Deployment Manager 템플릿의 위치, 유형, 버전을 지정합니다.

YAML 파일에는 두 가지의

type사양이 포함되어 있으며 그 중 하나는 주석 처리되어 있습니다. 기본적으로 활성화되는type사양은 템플릿 버전을latest으로 지정합니다. 주석 처리된type사양은 타임스탬프가 있는 특정 템플릿 버전을 지정합니다.모든 배포에서 동일한 템플릿 버전을 사용하려면 타임스탬프가 포함된

type사양을 사용하세요.instanceName문자열 정의하려는 VM 인스턴스의 이름입니다. 기본 VM 정의와 보조 VM 정의에 서로 다른 이름을 지정합니다. 동일한 고가용성 클러스터에 속하는 인스턴스를 식별하는 이름을 사용하는 것이 좋습니다. 인스턴스 이름은 13자 이하여야 하고 소문자, 숫자 또는 하이픈으로 지정해야 합니다. 프로젝트 내에서 고유한 이름을 사용합니다.

instanceType문자열 필요한 Compute Engine VM의 유형입니다. 기본 VM과 보조 VM에 동일한 인스턴스 유형을 지정합니다. 커스텀 VM 유형이 필요하면 작은 사전 정의된 VM 유형을 지정하고, 배포가 완료된 후 필요에 따라 VM을 맞춤설정합니다.

zone문자열 정의하는 VM 인스턴스를 배포할 Google Cloud 영역입니다. 동일한 리전에서 기본 VM 정의와 보조 VM 정의에 서로 다른 영역을 지정합니다. 영역은 서브넷에 선택한 리전과 동일한 리전에 있어야 합니다. subnetwork문자열 이전 단계에서 만든 서브네트워크 이름입니다. 공유 VPC에 배포하는 경우 이 값을 SHAREDVPC_PROJECT/SUBNETWORK로 지정합니다. 예를 들면myproject/network1입니다.linuxImage문자열 SAP NetWeaver와 함께 사용할 Linux 운영체제 이미지 또는 이미지 계열의 이름입니다. 이미지 계열을 지정하려면 계열 이름에 프리픽스 family/를 추가합니다. 예를 들면family/sles-15-sp3-sap와 같습니다. 사용 가능한 이미지 계열 목록은 Google Cloud 콘솔의 이미지 페이지를 참고하세요.linuxImageProject문자열 사용하려는 이미지가 포함된 Google Cloud 프로젝트입니다. 이 프로젝트는 자체 프로젝트이거나 Google Cloud 이미지 프로젝트 suse-sap-cloud일 수 있습니다. Google Cloud 이미지 프로젝트 목록은 Compute Engine 문서의 이미지 페이지를 참고하세요.usrsapSize정수 /usr/sap디스크의 크기입니다. 최소 크기는 8GB입니다.swapSize정수 스왑 볼륨 크기입니다. 최소 크기는 1GB입니다. networkTag문자열 선택사항. 방화벽 또는 라우팅 목적으로 VM 인스턴스를 나타내는 쉼표로 구분된 네트워크 태그(한 개 이상)입니다.

고가용성 구성의 경우, 클러스터 노드 간의 통신을 허용하는 방화벽 규칙에 사용할 네트워크 태그와 클러스터 노드에 액세스할 수 있도록 Cloud Load Balancing 상태 확인을 허용하는 방화벽 규칙에 사용할 네트워크 태그를 지정합니다.

publicIP: No를 지정하고 네트워크 태그를 지정하지 않으면 다른 인터넷 액세스 방법을 제공해야 합니다.serviceAccount문자열 선택사항. 배포된 VM에 사용할 커스텀 서비스 계정을 지정합니다. 서비스 계정에는 배포 중에 SAP용 VM을 구성하는 데 필요한 권한이 포함되어야 합니다.

serviceAccount를 지정하지 않으면 기본 Compute Engine 서비스 계정이 사용됩니다.전체 서비스 계정 주소를 지정합니다. 예:

sap-ha-example@example-project-123456.publicIP불리언 선택사항. 공개 IP 주소를 VM 인스턴스에 추가할지 여부를 결정합니다. 기본값은 Yes입니다.sap_deployment_debug불리언 선택사항. 이 값이 Yes로 설정된 경우 배포 시 상세 배포 로그가 생성됩니다. Google 지원 엔지니어가 디버깅을 사용 설정하도록 요청하지 않는 한 이 설정을 사용하지 마세요.YAML 구성 파일에서 첫 번째 VM의 정의를 복사하고 첫 번째 정의 뒤에 복사본을 붙여넣어 두 번째 VM의 정의를 만듭니다. 예시를 보려면 전체 YAML 구성 파일 예시를 참조하세요.

두 번째 VM의 정의에서 첫 번째 정의에서 지정한 값과 다른 값을 다음 속성에 지정합니다.

nameinstanceNamezone

VM 인스턴스를 만듭니다.

gcloud deployment-manager deployments create DEPLOYMENT_NAME --config TEMPLATE_NAME.yaml

각 항목의 의미는 다음과 같습니다.

DEPLOYMENT_NAME은 배포 이름을 나타냅니다.TEMPLATE_NAME은 YAML 구성 파일의 이름을 나타냅니다.

위의 명령어는 Deployment Manager를 호출하여 YAML 구성 파일의 사양에 따라 VM을 배포합니다.

배포 처리는 두 단계로 구성됩니다. 첫 번째 단계에서는 Deployment Manager가 상태를 콘솔에 씁니다. 두 번째 단계에서는 배포 스크립트가 상태를 Cloud Logging에 씁니다.

완전한 YAML 구성 파일 예시

다음은 최신 버전의 Deployment Manager 템플릿을 사용하여 SAP NetWeaver용 HA 구성에 2개의 VM 인스턴스를 배포하는 완성된 YAML 구성 파일을 보여주는 예시입니다. 이 예시에서는 템플릿을 처음 다운로드할 때 템플릿에 포함된 주석을 생략합니다.

이 파일에는 배포할 두 리소스(sap_nw_node_1 및 sap_nw_node_2)의 정의가 포함되어 있습니다. 각 리소스 정의에는 VM의 정의가 포함됩니다.

sap_nw_node_2 리소스 정의는 첫 번째 정의를 복사하여 붙여넣은 후 name, instanceName, zone 속성 값을 수정하여 만들었습니다. 두 리소스 정의의 다른 모든 속성 값은 동일합니다.

networkTag 및 serviceAccount 속성은 구성 파일 템플릿의 고급 옵션 섹션에 있습니다.

resources:

- name: sap_nw_node_1

type: https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_nw/sap_nw.py

properties:

instanceName: nw-ha-vm-1

instanceType: n2-standard-4

zone: us-central1-b

subnetwork: example-sub-network-sap

linuxImage: family/sles-15-sp3-sap

linuxImageProject: suse-sap-cloud

usrsapSize: 15

swapSize: 24

networkTag: cluster-ntwk-tag,allow-health-check

serviceAccount: limited-roles@example-project-123456.

- name: sap_nw_node_2

type: https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_nw/sap_nw.py

properties:

instanceName: nw-ha-vm-2

instanceType: n2-standard-4

zone: us-central1-c

subnetwork: example-sub-network-sap

linuxImage: family/sles-15-sp3-sap

linuxImageProject: suse-sap-cloud

usrsapSize: 15

swapSize: 24

networkTag: cluster-ntwk-tag,allow-health-check

serviceAccount: limited-roles@example-project-123456.호스트 VM에 대한 액세스를 허용하는 방화벽 규칙 만들기

방화벽 규칙을 아직 만들지 않았으면 다음 소스에서 각 호스트 VM에 액세스를 허용하는 방화벽 규칙을 만듭니다.

- 구성을 위해 로컬 워크스테이션, 배스천 호스트 또는 점프 서버에서

- 클러스터 노드 간의 액세스를 위해 HA 클러스터의 다른 호스트 VM에서

- 이후 단계인 상태 확인을 위한 방화벽 규칙 만들기에 설명된 대로 Cloud Load Balancing에서 사용되는 상태 확인입니다.

VPC 방화벽 규칙을 만들 때 호스트 VM을 규칙 대상으로 지정하도록 template.yaml 구성 파일에서 정의한 네트워크 태그를 지정합니다.

배포를 확인하려면 배스천 호스트 또는 로컬 워크스테이션의 SSH 연결을 포트 22에서 허용하는 규칙을 정의합니다.

클러스터 노드 간의 액세스를 위해 동일한 서브네트워크에 있는 다른 VM에서의 모든 연결 유형을 모든 포트에서 허용하는 방화벽 규칙을 추가합니다.

다음 섹션으로 이동하기 전에 배포 확인 및 클러스터 내 통신용 방화벽 규칙을 만들었는지 확인합니다. 자세한 내용은 방화벽 규칙 추가를 참조하세요.

VM 배포 확인

SAP NetWeaver를 설치하거나 HA 클러스터 구성을 시작하기 전에 로그 및 OS 스토리지 매핑을 확인하여 VM이 올바르게 배포되었는지 확인합니다.

로그 확인

Google Cloud 콘솔에서 Cloud Logging을 열어 설치 진행 상태를 모니터링하고 오류를 확인합니다.

로그를 필터링합니다.

로그 탐색기

로그 탐색기 페이지에서 쿼리 창으로 이동합니다.

리소스 드롭다운 메뉴에서 전역을 선택한 후 추가를 클릭합니다.

전역 옵션이 표시되지 않으면 쿼리 편집기에 다음 쿼리를 입력합니다.

resource.type="global" "Deployment"쿼리 실행을 클릭합니다.

기존 로그 뷰어

- 기존 로그 뷰어 페이지의 기본 선택기 메뉴에서 전역을 로깅 리소스로 선택합니다.

필터링된 로그를 분석합니다.

"--- Finished"가 표시되면 배포 처리가 완료된 것이므로 다음 단계를 진행할 수 있습니다.할당량 오류가 표시되면 다음을 수행합니다.

IAM 및 관리자 할당량 페이지에서 SAP NetWeaver 계획 가이드에 나와 있는 SAP NetWeaver 요구사항을 충족하지 않는 할당량을 늘립니다.

Deployment Manager 배포 페이지에서 배포를 삭제하여 설치를 실패한 VM과 영구 디스크를 삭제합니다.

배포를 다시 실행합니다.

VM 구성 확인

VM 인스턴스가 배포된 후

ssh를 사용하여 VM에 연결합니다.- 아직 방화벽 규칙을 만들지 않았다면 포트

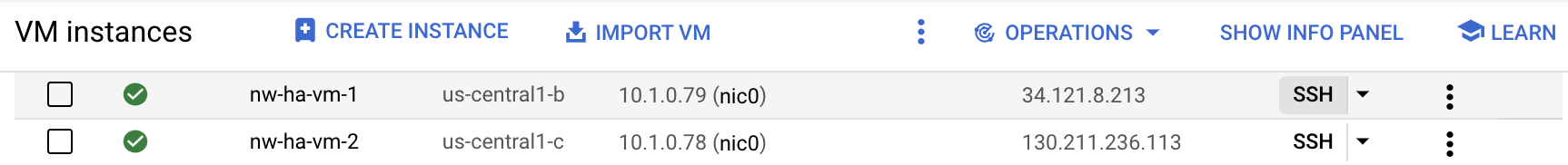

22를 통해 SSH 연결을 허용하는 방화벽 규칙을 만듭니다. VM 인스턴스 페이지로 이동합니다.

각 VM 인스턴스의 항목에서 SSH 버튼을 클릭하여 각 VM 인스턴스에 연결하거나 선호하는 SSH 메서드를 사용할 수 있습니다.

- 아직 방화벽 규칙을 만들지 않았다면 포트

파일 시스템을 표시합니다.

~>df -h다음과 유사한 출력이 표시되는지 확인합니다.

Filesystem Size Used Avail Use% Mounted on devtmpfs 32G 8.0K 32G 1% /dev tmpfs 48G 0 48G 0% /dev/shm tmpfs 32G 402M 32G 2% /run tmpfs 32G 0 32G 0% /sys/fs/cgroup /dev/sda3 30G 3.4G 27G 12% / /dev/sda2 20M 3.7M 17M 19% /boot/efi /dev/mapper/vg_usrsap-vol 15G 48M 15G 1% /usr/sap tmpfs 6.3G 0 6.3G 0% /run/user/1002 tmpfs 6.3G 0 6.3G 0% /run/user/0

스왑 공간이 만들어졌는지 확인합니다.

~>cat /proc/meminfo | grep Swap다음 예시와 비슷한 결과가 표시됩니다.

SwapCached: 0 kB SwapTotal: 25161724 kB SwapFree: 25161724 kB

검증 단계에서 설치에 실패한 단계를 하나라도 발견한 경우 다음을 수행합니다.

- 오류를 수정합니다.

- 배포 페이지에서 배포를 삭제하여 설치에 실패한 VM과 영구 디스크를 삭제합니다.

- 배포를 다시 실행합니다.

Google Cloud CLI 업데이트

Deployment Manager 템플릿은 배포 중에 VM에 Google Cloud CLI를 설치했습니다. 최신 업데이트를 모두 포함하도록 gcloud CLI를 업데이트합니다.

기본 VM에 SSH를 통해 연결합니다.

gcloud CLI 업데이트

~>sudo gcloud components update안내를 따릅니다.

보조 VM에서 이 단계를 반복합니다.

VM 간의 부하 분산기 백엔드 통신 사용 설정

VM이 성공적으로 배포되었는지 확인한 후 HA 클러스터의 노드 역할을 할 VM 간의 백엔드 통신을 사용 설정합니다.

Google Cloud에서 제공하는 모든 Linux 공개 이미지의 Linux 게스트 환경에 포함된 google-guest-agent 구성을 수정하여 VM 간의 백엔드 통신을 사용 설정합니다.

부하 분산기 백엔드 통신을 사용 설정하려면 클러스터에 포함된 각 VM에서 다음 단계를 수행합니다.

에이전트를 중지합니다.

sudo service google-guest-agent stop

수정할

/etc/default/instance_configs.cfg파일을 열거나 만듭니다. 예를 들면 다음과 같습니다.sudo vi /etc/default/instance_configs.cfg

/etc/default/instance_configs.cfg파일에서 다음과 같은 구성 속성을 지정합니다. 섹션이 없는 경우 섹션을 만듭니다. 특히target_instance_ips및ip_forwarding속성 모두false로 설정되어 있는지 확인합니다.[IpForwarding] ethernet_proto_id = 66 ip_aliases = true target_instance_ips = false [NetworkInterfaces] dhclient_script = /sbin/google-dhclient-script dhcp_command = ip_forwarding = false setup = true

게스트 에이전트 서비스를 시작합니다.

sudo service google-guest-agent start

부하 분산기 상태 확인 구성에는 상태 확인에 사용되는 리스닝 포트와 인터페이스에 대한 가상 IP 할당이 모두 필요합니다. 자세한 내용은 부하 분산기 구성 테스트를 참조하세요.

기본 VM 및 보조 VM에서 SSH 키 구성

HA 클러스터의 호스트 간에 파일을 복사할 수 있도록 이 섹션의 단계에서는 두 호스트 간에 루트 SSH 연결을 만듭니다.

Google Cloud에서 제공하는 Deployment Manager 템플릿에서 자동으로 키를 생성하지만 필요한 경우 사용자가 생성하는 키로 대체할 수 있습니다.

조직에 내부 네트워크 통신에 적용되는 가이드라인이 있을 수 있습니다. 필요한 경우 배포가 완료된 후 VM에서 메타데이터를 삭제하고 authorized_keys 디렉터리에서 키를 삭제할 수 있습니다.

직접 SSH 연결 설정이 조직의 가이드라인을 준수하지 않으면 다음과 같은 다른 방법을 사용하여 파일을 전송할 수 있습니다.

- Cloud Shell 파일 업로드와 파일 다운로드 메뉴 옵션을 사용하여 로컬 워크스테이션을 통해 작은 파일을 전송합니다. Cloud Shell로 파일 관리를 참조하세요.

- Cloud Storage 버킷을 사용하여 파일을 교환합니다. 업로드 및 다운로드를 참조하세요.

- Filestore 또는 Google Cloud NetApp 볼륨과 같은 파일 스토리지 솔루션을 사용하여 공유 폴더를 만듭니다. 파일 공유 솔루션을 참조하세요.

기본 인스턴스와 보조 인스턴스 간의 SSH 연결을 사용 설정하려면 다음 단계를 수행합니다. 이 단계에서는 SAP용 Deployment Manager 템플릿에서 생성된 SSH 키를 사용한다고 가정합니다.

기본 호스트 VM에서 다음을 수행합니다.

SSH를 통해 VM에 연결합니다.

루트로 전환합니다.

$sudo su -SSH 키가 있는지 확인합니다.

#ls -l /root/.ssh/다음 예시와 같이 id_rsa 키 파일이 표시됩니다.

-rw-r--r-- 1 root root 569 May 4 23:07 authorized_keys -rw------- 1 root root 2459 May 4 23:07 id_rsa -rw-r--r-- 1 root root 569 May 4 23:07 id_rsa.pub

보조 VM의 SSH 키 정보로 기본 VM의 메타데이터를 업데이트합니다.

#gcloud compute instances add-metadata SECONDARY_VM_NAME \ --metadata "ssh-keys=$(whoami):$(cat ~/.ssh/id_rsa.pub)" \ --zone SECONDARY_VM_ZONE기본 시스템에서 보조 시스템으로 SSH 연결을 열어 SSH 키가 올바르게 설정되었는지 확인합니다.

#ssh SECONDARY_VM_NAME

보조 호스트 VM에서 다음을 수행합니다.

VM에 SSH를 통해 연결합니다.

루트로 전환합니다.

$sudo su -SSH 키가 있는지 확인합니다.

#ls -l /root/.ssh/다음 예시와 같이 id_rsa 키 파일이 표시됩니다.

-rw-r--r-- 1 root root 569 May 4 23:07 authorized_keys -rw------- 1 root root 2459 May 4 23:07 id_rsa -rw-r--r-- 1 root root 569 May 4 23:07 id_rsa.pub

기본 VM의 SSH 키 정보로 보조 VM의 메타데이터를 업데이트합니다.

#gcloud compute instances add-metadata PRIMARY_VM_NAME \ --metadata "ssh-keys=$(whoami):$(cat ~/.ssh/id_rsa.pub)" \ --zone PRIMARY_VM_ZONE#cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys보조 시스템에서 기본 시스템으로 SSH 연결을 열어 SSH 키가 올바르게 설정되었는지 확인합니다.

#ssh PRIMARY_VM_NAME

공유 파일 스토리지 설정 및 공유 디렉터리 구성

HA 클러스터의 두 노드가 액세스할 수 있는 고가용성 공유 파일 스토리지를 제공하는 NFS 파일 공유 솔루션을 설정해야 합니다. 그런 다음 두 노드에 공유 파일 스토리지에 매핑되는 디렉터리를 만듭니다. 클러스터 소프트웨어는 올바른 디렉터리에만 적절한 디렉터리가 마운트되도록 합니다.

파일 공유 솔루션 설정은 이 가이드에서 다루지 않습니다. 파일 공유 시스템 설정에 대한 안내는 선택한 솔루션의 공급업체에서 제공하는 안내를 참조하세요. 파일 공유 솔루션에 Filestore를 사용하는 경우 엔터프라이즈 등급의 Filestore를 사용하는 것이 좋습니다. Filestore 인스턴스를 만드는 방법을 알아보려면 인스턴스 만들기를 참조하세요.

Google Cloud에서 사용할 수 있는 파일 공유 솔루션에 대한 자세한 내용은 Google Cloud의 HA SAP 시스템용 공유 스토리지 옵션을 참고하세요.

공유 디렉터리를 구성하려면 다음 안내를 따르세요.

가용성이 높은 NFS 공유 파일 스토리지 솔루션을 아직 설정하지 않았으면 지금 설정합니다.

초기 구성을 위해 두 서버 모두에 NFS 공유 스토리지를 마운트합니다.

~>sudo mkdir /mnt/nfs~>sudo mount -t nfs NFS_PATH /mnt/nfsNFS_PATH를 NFS 파일 공유 솔루션 경로로 바꿉니다. 예를 들면10.49.153.26:/nfs_share_nw_ha입니다.두 서버 중 하나에서

sapmnt디렉터리, 중앙 전송 디렉터리, 인스턴스별 디렉터리를 만듭니다. 자바 스택을 사용하는 경우 다음 명령어 및 다른 예시 명령어를 사용하기 전에 'ASCS'를 'SCS'로 바꿉니다.~>sudo mkdir /mnt/nfs/sapmntSID~>sudo mkdir /mnt/nfs/usrsap{trans,SIDASCSASCS_INSTANCE_NUMBER,SIDERSERS_INSTANCE_NUMBER}간단한 마운트 설정을 사용하는 경우 다음 명령어를 대신 실행합니다.

~>sudo mkdir /mnt/nfs/sapmntSID~>sudo mkdir /mnt/nfs/usrsap{trans,SID}다음을 바꿉니다.

SID: SAP 시스템 ID(SID)입니다. 모든 문자에 대문자를 사용합니다. 예를 들면AHA입니다.ASCS_INSTANCE_NUMBER: ASCS 시스템의 인스턴스 번호입니다. 예를 들면00입니다.ERS_INSTANCE_NUMBER: ERS 시스템의 인스턴스 번호입니다. 예를 들면10입니다.

두 서버 모두에서 필요한 마운트 지점을 만듭니다.

~>sudo mkdir -p /sapmnt/SID~>sudo mkdir -p /usr/sap/trans~>sudo mkdir -p /usr/sap/SID/ASCSASCS_INSTANCE_NUMBER~>sudo mkdir -p /usr/sap/SID/ERSERS_INSTANCE_NUMBER간단한 마운트 설정을 사용하는 경우 다음 명령어를 대신 실행합니다.

~>sudo mkdir -p /sapmnt/SID~>sudo mkdir -p /usr/sap/trans~>sudo mkdir -p /usr/sap/SID파일 디렉터리에 처음 액세스할 때 공통 공유 파일 디렉터리를 마운트하도록

autofs를 구성합니다.ASCSASCS_INSTANCE_NUMBER및ERSERS_INSTANCE_NUMBER디렉터리 마운트는 이후 단계에서 구성하는 클러스터 소프트웨어에 의해 관리됩니다.명령어에서 NFS 옵션을 파일 공유 솔루션에 맞게 조정합니다.

두 서버 모두에서

autofs를 구성합니다.~>echo "/- /etc/auto.sap" | sudo tee -a /etc/auto.master~>NFS_OPTS="-rw,relatime,vers=3,hard,proto=tcp,timeo=600,retrans=2,mountvers=3,mountport=2050,mountproto=tcp"~>echo "/sapmnt/SID ${NFS_OPTS} NFS_PATH/sapmntSID" | sudo tee -a /etc/auto.sap~>echo "/usr/sap/trans ${NFS_OPTS} NFS_PATH/usrsaptrans" | sudo tee -a /etc/auto.sapautofs에 관한 자세한 내용은 autofs - 작동 방식을 참고하세요.간단한 마운트 설정을 사용하는 경우 다음 명령어를 대신 실행합니다.

~>echo "/- /etc/auto.sap" | sudo tee -a /etc/auto.master~>NFS_OPTS="-rw,relatime,vers=3,hard,proto=tcp,timeo=600,retrans=2,mountvers=3,mountport=2050,mountproto=tcp"~>echo "/sapmnt/SID ${NFS_OPTS}/sapmnt" | sudo tee -a /etc/auto.sap~>echo "/usr/sap/trans ${NFS_OPTS}/usrsaptrans" | sudo tee -a /etc/auto.sap~>echo "/usr/sap/SID ${NFS_OPTS}/usrsapSID" | sudo tee -a /etc/auto.sap두 서버 모두에서

autofs서비스를 시작합니다.~>sudo systemctl enable autofs~>sudo systemctl restart autofs~>sudo automount -vcd명령어를 사용하여 각 디렉터리에 액세스하여 공유 디렉터리를 마운트하도록autofs를 트리거합니다. 예를 들면 다음과 같습니다.~>cd /sapmnt/SID~>cd /usr/sap/trans간단한 마운트 설정을 사용하는 경우 다음 명령어를 대신 실행합니다.

~>cd /sapmnt/SID~>cd /usr/sap/trans~>cd /usr/sap/SID모든 디렉터리에 액세스한 후에

df -Th명령어를 실행하여 디렉터리가 마운트되었는지 확인합니다.~>df -Th | grep FILE_SHARE_NAMEFILE_SHARE_NAME을 NFS 파일 공유 솔루션 이름으로 바꿉니다. 예를 들면nfs_share_nw_ha입니다.다음 예와 비슷한 마운트 지점 및 디렉터리가 표시됩니다.

10.49.153.26:/nfs_share_nw_ha nfs 1007G 76M 956G 1% /mnt/nfs 10.49.153.26:/nfs_share_nw_ha/usrsaptrans nfs 1007G 76M 956G 1% /usr/sap/trans 10.49.153.26:/nfs_share_nw_ha/sapmntAHA nfs 1007G 76M 956G 1% /sapmnt/AHA

간단한 마운트 설정을 사용하는 경우 다음 예와 유사한 마운트 지점과 디렉터리가 표시됩니다.

10.49.153.26:/nfs_share_nw_ha nfs 1007G 76M 956G 1% /mnt/nfs 10.49.153.26:/nfs_share_nw_ha/usrsaptrans nfs 1007G 76M 956G 1% /usr/sap/trans 10.49.153.26:/nfs_share_nw_ha/sapmntAHA nfs 1007G 76M 956G 1% /sapmnt/AHA 10.49.153.26:/nfs_share_nw_ha/usrsapAHA nfs 1007G 76M 956G 1% /usr/sap/AHA

Cloud Load Balancing 장애 조치 지원 구성

장애 조치를 지원하는 내부 패스 스루 네트워크 부하 분산기는 ASCS 및 ERS 트래픽을 SAP NetWeaver 클러스터의 각 활성 인스턴스로 라우팅합니다. 내부 패스 스루 네트워크 부하 분산기는 가상 IP(VIP) 주소, 백엔드 서비스, 인스턴스 그룹, 상태 점검을 사용하여 트래픽을 적절하게 라우팅합니다.

가상 IP의 IP 주소 예약

SAP NetWeaver 고가용성 클러스터의 경우 유동 IP 주소라고도 하는 VIP 두 개를 만듭니다. 한 VIP는 활성 SAP Central Services(SCS) 인스턴스를 따르고 다른 VIP는 Enqueue Replication Server(ERS) 인스턴스를 따릅니다. 부하 분산기는 각 VIP로 전송된 트래픽을 현재 VIP의 ASCS 또는 ERS 구성요소의 활성 인스턴스를 호스팅하는 VM으로 라우팅합니다.

Cloud Shell을 엽니다.

ASCS의 VIP와 ERS의 VIP에 IP 주소를 예약합니다. ASCS의 경우 IP 주소는 애플리케이션이 SAP NetWeaver에 액세스하는 데 사용하는 IP 주소입니다. ERS의 경우 IP 주소는 Enqueue Server 복제에 사용되는 IP 주소입니다.

--addresses플래그를 생략하면 지정된 서브넷의 IP 주소가 자동으로 선택됩니다.~gcloud compute addresses create ASCS_VIP_NAME \ --region CLUSTER_REGION --subnet CLUSTER_SUBNET \ --addresses ASCS_VIP_ADDRESS~gcloud compute addresses create ERS_VIP_NAME \ --region CLUSTER_REGION --subnet CLUSTER_SUBNET \ --addresses ERS_VIP_ADDRESS다음을 바꿉니다.

ASCS_VIP_NAME: ASCS 인스턴스의 가상 IP 주소 이름을 지정합니다. 예:ascs-aha-vipCLUSTER_REGION: 클러스터가 있는 Google Cloud 리전을 지정합니다. 예를 들면us-central1입니다.CLUSTER_SUBNET: 클러스터에서 사용 중인 서브네트워크를 지정합니다. 예:example-sub-network-sapASCS_VIP_ADDRESS: (선택사항) CIDR 표기법으로 ASCS 가상 IP의 IP 주소를 지정합니다. 예:10.1.0.2ERS_VIP_NAME: ERS 인스턴스의 가상 IP 주소 이름을 지정합니다. 예:ers-aha-vipERS_VIP_ADDRESS: (선택사항) CIDR 표기법으로 ERS 가상 IP의 IP 주소를 지정합니다. 예:10.1.0.4

고정 IP를 예약하는 방법에 대한 자세한 내용은 고정 내부 IP 주소 예약을 참조하세요.

IP 주소 예약을 확인합니다.

~gcloud compute addresses describe VIP_NAME \ --region CLUSTER_REGION다음과 비슷한 출력이 표시됩니다.

address: 10.1.0.2 addressType: INTERNAL creationTimestamp: '2022-04-04T15:04:25.872-07:00' description: '' id: '555067171183973766' kind: compute#address name: ascs-aha-vip networkTier: PREMIUM purpose: GCE_ENDPOINT region: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1 selfLink: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1/addresses/ascs-aha-vip status: RESERVED subnetwork: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1/subnetworks/example-sub-network-sap

/etc/hosts에서 VIP 주소의 호스트 이름 정의

각 VIP 주소의 호스트 이름을 정의한 다음 VM과 VIP 모두의 IP 주소 및 호스트 이름을 각 VM의 /etc/hosts 파일에 추가합니다.

VIP 호스트 이름은 DNS 서비스에 추가하지 않으면 VM 외부에서 알 수 없습니다. 로컬 /etc/hosts 파일에 이러한 항목을 추가하면 DNS 서비스가 중단되지 않도록 클러스터를 보호할 수 있습니다.

/etc/hosts 파일의 업데이트는 다음 예시와 유사해야 합니다.

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6 10.1.0.113 nw-ha-vm-2.us-central1-c.c.example-project-123456.internal nw-ha-vm-2 10.1.0.2 ascs-aha-vip 10.1.0.4 ers-aha-vip 10.1.0.114 nw-ha-vm-1.us-central1-b.c.example-project-123456.internal nw-ha-vm-1 # Added by Google 169.254.169.254 metadata.google.internal # Added by Google

Cloud Load Balancing 상태 확인 만들기

상태 점검 두 개를 만듭니다. 하나는 활성 ASCS 인스턴스용이고 하나는 활성 ERS용입니다.

Cloud Shell에서 상태 확인을 만듭니다. 다른 서비스와 충돌하지 않도록 비공개 범위 49152~65535에서 ASCS 및 ERS 인스턴스의 포트 번호를 지정합니다. Compute Engine 라이브 마이그레이션 이벤트 중에 장애 조치 내결함성을 늘리기 위해 다음 명령어의 확인 간격 및 제한 시간 값은 기본값보다 약간 더 깁니다. 필요한 경우 이러한 값을 조정할 수 있습니다.

~gcloud compute health-checks create tcp ASCS_HEALTH_CHECK_NAME \ --port=ASCS_HEALTHCHECK_PORT_NUM --proxy-header=NONE --check-interval=10 --timeout=10 \ --unhealthy-threshold=2 --healthy-threshold=2~gcloud compute health-checks create tcp ERS_HEALTH_CHECK_NAME \ --port=ERS_HEALTHCHECK_PORT_NUM --proxy-header=NONE --check-interval=10 --timeout=10 \ --unhealthy-threshold=2 --healthy-threshold=2

각 상태 확인의 생성을 확인합니다.

~gcloud compute health-checks describe HEALTH_CHECK_NAME다음과 비슷한 출력이 표시됩니다.

checkIntervalSec: 10 creationTimestamp: '2021-05-12T15:12:21.892-07:00' healthyThreshold: 2 id: '1981070199800065066' kind: compute#healthCheck name: ascs-aha-health-check-name selfLink: https://www.googleapis.com/compute/v1/projects/example-project-123456/global/healthChecks/scs-aha-health-check-name tcpHealthCheck: port: 60000 portSpecification: USE_FIXED_PORT proxyHeader: NONE timeoutSec: 10 type: TCP unhealthyThreshold: 2

상태 확인에 사용할 방화벽 규칙 만들기

아직 이렇게 하지 않았다면 Cloud Load Balancing 상태 확인(35.191.0.0/16 및 130.211.0.0/22)에 사용되는 IP 범위에서 호스트 VM에 액세스할 수 있는 비공개 범위의 포트에 사용할 방화벽 규칙을 정의합니다. 부하 분산기의 방화벽 규칙에 대한 자세한 내용은 상태 확인을 위한 방화벽 규칙 만들기를 참조하세요.

아직 없으면 호스트 VM에 네트워크 태그를 추가합니다. 이 네트워크 태그는 방화벽 규칙에서 상태 확인을 위해 사용됩니다.

~gcloud compute instances add-tags PRIMARY_VM_NAME \ --zone=PRIMARY_ZONE \ --tags NETWORK_TAGS~gcloud compute instances add-tags SECONDARY_VM_NAME \ --zone=SECONDARY_ZONE \ --tags NETWORK_TAGS

네트워크 태그를 사용하여 상태 확인을 허용하는 방화벽 규칙을 만듭니다.

~gcloud compute firewall-rules create RULE_NAME \ --network=NETWORK_NAME \ --action=ALLOW \ --direction=INGRESS \ --source-ranges=35.191.0.0/16,130.211.0.0/22 \ --target-tags=NETWORK_TAGS \ --rules=tcp:ASCS_HEALTHCHECK_PORT_NUM,tcp:ERS_HEALTHCHECK_PORT_NUM예를 들면 다음과 같습니다.

gcloud compute firewall-rules create nw-ha-cluster-health-checks \ --network=example-network \ --action=ALLOW \ --direction=INGRESS \ --source-ranges=35.191.0.0/16,130.211.0.0/22 \ --target-tags=allow-health-check \ --rules=tcp:60000,tcp:60010

Compute Engine 인스턴스 그룹 만들기

클러스터 노드 VM이 포함된 각 영역에 인스턴스 그룹을 만들고 해당 영역의 VM을 인스턴스 그룹에 추가해야 합니다.

Cloud Shell에서 기본 인스턴스 그룹을 만들고 기본 VM을 추가합니다.

~gcloud compute instance-groups unmanaged create PRIMARY_IG_NAME \ --zone=PRIMARY_ZONE~gcloud compute instance-groups unmanaged add-instances PRIMARY_IG_NAME \ --zone=PRIMARY_ZONE \ --instances=PRIMARY_VM_NAME

Cloud Shell에서 보조 인스턴스 그룹을 만들고 보조 VM을 추가합니다.

~gcloud compute instance-groups unmanaged create SECONDARY_IG_NAME \ --zone=SECONDARY_ZONE~gcloud compute instance-groups unmanaged add-instances SECONDARY_IG_NAME \ --zone=SECONDARY_ZONE \ --instances=SECONDARY_VM_NAME

인스턴스 그룹 생성을 확인합니다.

~gcloud compute instance-groups unmanaged list다음과 비슷한 출력이 표시됩니다.

NAME ZONE NETWORK NETWORK_PROJECT MANAGED INSTANCES sap-aha-primary-instance-group us-central1-b example-network-sap example-project-123456 No 1 sap-aha-secondary-instance-group us-central1-c example-network-sap example-project-123456 No 1

백엔드 서비스 구성

백엔드 서비스 두 개를 만듭니다. 하나는 ASCS용이고 하나는 ERS용입니다. 각 백엔드 서비스에 두 인스턴스 그룹을 추가하여 각 백엔드 서비스의 다른 인스턴스 그룹을 장애 조치 인스턴스 그룹으로 지정합니다. 마지막으로 VIP에서 백엔드 서비스로의 전달 규칙을 만듭니다.

Cloud Shell에서 ASCS의 백엔드 서비스 및 장애 조치 그룹을 만듭니다.

ASCS의 백엔드 서비스를 만듭니다.

~gcloud compute backend-services create ASCS_BACKEND_SERVICE_NAME \ --load-balancing-scheme internal \ --health-checks ASCS_HEALTH_CHECK_NAME \ --no-connection-drain-on-failover \ --drop-traffic-if-unhealthy \ --failover-ratio 1.0 \ --region CLUSTER_REGION \ --global-health-checks기본 인스턴스 그룹을 ASCS 백엔드 서비스에 추가합니다.

~gcloud compute backend-services add-backend ASCS_BACKEND_SERVICE_NAME \ --instance-group PRIMARY_IG_NAME \ --instance-group-zone PRIMARY_ZONE \ --region CLUSTER_REGION보조 인스턴스 그룹을 ASCS 백엔드 서비스의 장애 조치 인스턴스 그룹으로 추가합니다.

~gcloud compute backend-services add-backend ASCS_BACKEND_SERVICE_NAME \ --instance-group SECONDARY_IG_NAME \ --instance-group-zone SECONDARY_ZONE \ --failover \ --region CLUSTER_REGION

Cloud Shell에서 ERS의 백엔드 서비스 및 장애 조치 그룹을 만듭니다.

ERS의 백엔드 서비스를 만듭니다.

~gcloud compute backend-services create ERS_BACKEND_SERVICE_NAME \ --load-balancing-scheme internal \ --health-checks ERS_HEALTH_CHECK_NAME \ --no-connection-drain-on-failover \ --drop-traffic-if-unhealthy \ --failover-ratio 1.0 \ --region CLUSTER_REGION \ --global-health-checks보조 인스턴스 그룹을 ERS 백엔드 서비스에 추가합니다.

~gcloud compute backend-services add-backend ERS_BACKEND_SERVICE_NAME \ --instance-group SECONDARY_IG_NAME \ --instance-group-zone SECONDARY_ZONE \ --region CLUSTER_REGION기본 인스턴스 그룹을 ERS 백엔드 서비스의 장애 조치 인스턴스 그룹으로 추가합니다.

~gcloud compute backend-services add-backend ERS_BACKEND_SERVICE_NAME \ --instance-group PRIMARY_IG_NAME \ --instance-group-zone PRIMARY_ZONE \ --failover \ --region CLUSTER_REGION

필요한 경우 백엔드 서비스에 예상대로 인스턴스 그룹이 포함되어 있는지 확인합니다.

~gcloud compute backend-services describe BACKEND_SERVICE_NAME \ --region=CLUSTER_REGIONASCS 백엔드 서비스의 경우 다음 예시와 비슷한 출력이 표시됩니다. ERS의 경우

failover: true가 기본 인스턴스 그룹에 표시됩니다.backends: - balancingMode: CONNECTION group: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-b/instanceGroups/sap-aha-primary-instance-group - balancingMode: CONNECTION failover: true group: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instanceGroups/sap-aha-secondary-instance-group connectionDraining: drainingTimeoutSec: 0 creationTimestamp: '2022-04-06T10:58:37.744-07:00' description: '' failoverPolicy: disableConnectionDrainOnFailover: true dropTrafficIfUnhealthy: true failoverRatio: 1.0 fingerprint: s4qMEAyhrV0= healthChecks: - https://www.googleapis.com/compute/v1/projects/example-project-123456/global/healthChecks/ascs-aha-health-check-name id: '6695034709671438882' kind: compute#backendService loadBalancingScheme: INTERNAL name: ascs-aha-backend-service-name protocol: TCP region: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1 selfLink: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1/backendServices/ascs-aha-backend-service-name sessionAffinity: NONE timeoutSec: 30

Cloud Shell에서 ASCS 및 ERS 백엔드 서비스에 대한 전달 규칙을 만듭니다.

ASCS VIP에서 ASCS 백엔드 서비스로의 전달 규칙을 만듭니다.

~gcloud compute forwarding-rules create ASCS_FORWARDING_RULE_NAME \ --load-balancing-scheme internal \ --address ASCS_VIP_ADDRESS \ --subnet CLUSTER_SUBNET \ --region CLUSTER_REGION \ --backend-service ASCS_BACKEND_SERVICE_NAME \ --ports ALLERS VIP에서 ERS 백엔드 서비스로의 전달 규칙을 만듭니다.

~gcloud compute forwarding-rules create ERS_FORWARDING_RULE_NAME \ --load-balancing-scheme internal \ --address ERS_VIP_ADDRESS \ --subnet CLUSTER_SUBNET \ --region CLUSTER_REGION \ --backend-service ERS_BACKEND_SERVICE_NAME \ --ports ALL

부하 분산기 구성 테스트

백엔드 인스턴스 그룹이 나중까지 정상으로 등록되지 않더라도 상태 확인에 응답하도록 리스너를 설정하여 부하 분산기 구성을 테스트할 수 있습니다. 리스너를 설정한 후 부하 분산기가 올바르게 구성되면 백엔드 인스턴스 그룹 상태가 정상으로 변경됩니다.

다음 섹션에서는 구성을 테스트하는 데 사용할 수 있는 다양한 방법을 보여줍니다.

socat 유틸리티로 부하 분산기 테스트

socat 유틸리티를 사용하여 상태 확인 포트에서 일시적으로 리슨할 수 있습니다. 나중에 클러스터 리소스를 구성할 때 socat 유틸리티를 사용하므로 이 유틸리티를 설치해야 합니다.

두 호스트 VM에서 루트로

socat유틸리티를 설치합니다.#zypper install socat기본 VM에서 VIP를 eth0 네트워크 카드에 임시로 할당합니다.

ip addr add VIP_ADDRESS dev eth0

기본 VM에서

socat프로세스를 시작하여 ASCS 상태 점검 포트에서 60초 동안 리슨합니다.#timeout 60s socat - TCP-LISTEN:ASCS_HEALTHCHECK_PORT_NUM,forkCloud Shell에서 상태 점검이 리스너를 감지할 때까지 몇 초 정도 기다린 후 ASCS 백엔드 인스턴스 그룹 상태를 확인합니다.

~gcloud compute backend-services get-health ASCS_BACKEND_SERVICE_NAME \ --region CLUSTER_REGION다음 ASCS 예시와 비슷한 출력이 표시됩니다.

backend: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-b/instanceGroups/sap-aha-primary-instance-group status: healthStatus: - forwardingRule: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1/forwardingRules/scs-aha-forwarding-rule forwardingRuleIp: 10.1.0.90 healthState: HEALTHY instance: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-b/instances/nw-ha-vm-1 ipAddress: 10.1.0.89 port: 80 kind: compute#backendServiceGroupHealth --- backend: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instanceGroups/sap-aha-secondary-instance-group status: healthStatus: - forwardingRule: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1/forwardingRules/scs-aha-forwarding-rule forwardingRuleIp: 10.1.0.90 healthState: UNHEALTHY instance: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instances/nw-ha-vm-2 ipAddress: 10.1.0.88 port: 80 kind: compute#backendServiceGroupHealtheth0 인터페이스에서 VIP를 삭제합니다.

ip addr del VIP_ADDRESS dev eth0

ASCS 변수 값을 ERS 값으로 바꿔 ERS에 대한 단계를 반복합니다.

포트 22를 사용하여 부하 분산기 테스트

호스트 VM에서 SSH 연결용으로 포트 22가 열려 있으면 상태 점검기에 응답할 수 있는 리스너가 있는 포트 22를 사용하도록 상태 점검기를 임시로 수정할 수 있습니다.

포트 22를 일시적으로 사용하려면 다음 단계를 수행합니다.

Google Cloud 콘솔에서 Compute Engine 상태 점검 페이지로 이동합니다.

상태 점검 이름을 클릭합니다.

수정을 클릭합니다.

포트 필드에서 포트 번호를 22로 변경합니다.

저장을 클릭하고 1~2분 정도 기다립니다.

Cloud Shell에서 상태 확인이 리스너를 감지할 때까지 몇 초 정도 기다린 후 백엔드 인스턴스 그룹 상태를 확인합니다.

~gcloud compute backend-services get-health BACKEND_SERVICE_NAME \ --region CLUSTER_REGION다음과 비슷한 출력이 표시됩니다.

backend: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-b/instanceGroups/sap-aha-primary-instance-group status: healthStatus: - forwardingRule: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1/forwardingRules/scs-aha-forwarding-rule forwardingRuleIp: 10.1.0.85 healthState: HEALTHY instance: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-b/instances/nw-ha-vm-1 ipAddress: 10.1.0.79 port: 80 kind: compute#backendServiceGroupHealth --- backend: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instanceGroups/sap-aha-secondary-instance-group status: healthStatus: - forwardingRule: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1/forwardingRules/scs-aha-forwarding-rule forwardingRuleIp: 10.1.0.85 healthState: HEALTHY instance: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instances/nw-ha-vm-2 ipAddress: 10.1.0.78 port: 80 kind: compute#backendServiceGroupHealth확인을 완료하면 상태 확인 포트 번호를 원래 포트 번호로 다시 변경합니다.

Pacemaker 설정

다음 절차에서는 SAP NetWeaver용 Compute Engine VM에서 Pacemaker 클러스터의 SUSE 구현을 구성합니다.

SLES에서 고가용성 클러스터를 구성하는 방법에 대한 자세한 내용은 사용하는 SLES 버전의 SUSE Linux Enterprise 고가용성 확장 문서를 참조하세요.

필수 클러스터 패키지 설치

기본 호스트와 보조 호스트 모두에서 루트로 다음 필수 클러스터 패키지를 다운로드합니다.

ha_sles패턴:#zypper install -t pattern ha_slessap-suse-cluster-connector패키지:#zypper install -y sap-suse-cluster-connector간단한 마운트 설정을 사용하는 경우 다음 명령어를 추가로 실행합니다.

#zypper install -y sapstartsrv-resource-agents아직 설치하지 않았다면

socat유틸리티가 다음을 수행합니다.#zypper install -y socat

최신 고가용성 에이전트가 로드되었는지 확인합니다.

#zypper se -t patch SUSE-SLE-HA

기본 VM에서 클러스터 초기화, 구성, 시작

ha-cluster-init SUSE 스크립트를 사용하여 클러스터를 초기화합니다. 그런 다음 Corosync 구성 파일을 수정하고 보조 노드와 동기화해야 합니다. 클러스터를 시작한 후 crm 명령어를 사용하여 추가 클러스터 속성 및 기본값을 설정합니다.

Corosync 구성 파일 만들기

기본 호스트에 Corosync 구성 파일을 만듭니다.

원하는 텍스트 편집기를 사용하여 다음 파일을 만듭니다.

/etc/corosync/corosync.conf

기본 호스트의

corosync.conf파일에서 다음 구성을 추가하고 기울임꼴의 변수 텍스트를 실제 값으로 바꿉니다.totem { version: 2 secauth: off crypto_hash: sha1 crypto_cipher: aes256 cluster_name: hacluster clear_node_high_bit: yes token: 20000 token_retransmits_before_loss_const: 10 join: 60 max_messages: 20 transport: udpu interface { ringnumber: 0 Bindnetaddr: STATIC_IP_OF_THIS_HOST mcastport: 5405 ttl: 1 } } logging { fileline: off to_stderr: no to_logfile: no logfile: /var/log/cluster/corosync.log to_syslog: yes debug: off timestamp: on logger_subsys { subsys: QUORUM debug: off } } nodelist { node { ring0_addr: THIS_HOST_NAME nodeid: 1 } node { ring0_addr: OTHER_HOST_NAME nodeid: 2 } } quorum { provider: corosync_votequorum expected_votes: 2 two_node: 1 }

다음을 바꿉니다.

STATIC_IP_OF_THIS_HOST: Google Cloud 콘솔의 네트워크 인터페이스 또는gcloud compute instances describe VM_NAME에 표시된 대로이 VM의 고정 기본 내부 IP 주소를 지정합니다.THIS_HOST_NAME: 이 VM의 호스트 이름을 지정합니다.OTHER_HOST_NAME: 클러스터의 다른 VM의 호스트 이름을 지정합니다.

기본 호스트에 사용한 것과 동일한 단계를 반복하여 보조 호스트에 Corosync 구성 파일을 만듭니다.

Bindnetaddr속성에 HDB의 고정 IP와nodelist에서 호스트 이름 순서를 제외하면 구성 파일 속성 값이 각 호스트에서 동일합니다.

클러스터 초기화

클러스터를 초기화하려면 다음 안내를 따르세요.

hacluster사용자의 비밀번호를 변경합니다.#passwd hacluster기본 호스트에서 클러스터를 루트로 초기화합니다.

다음 명령어는 클러스터 이름을 지정하고 구성 파일

corosync.conf를 만들고, 구성하고, 클러스터 노드 간의 동기화를 설정합니다.#crm cluster init --name CLUSTER_NAME --yes ssh#crm cluster init --name CLUSTER_NAME --yes --interface eth0 csync2#crm cluster init --name CLUSTER_NAME --yes --interface eth0 corosync기본 호스트에서 Pacemaker를 시작합니다.

#systemctl enable pacemaker#systemctl start pacemaker

추가 클러스터 속성 설정

일반 클러스터 속성을 설정합니다.

#crm configure property stonith-timeout="300s"#crm configure property stonith-enabled="true"#crm configure rsc_defaults resource-stickiness="1"#crm configure rsc_defaults migration-threshold="3"#crm configure op_defaults timeout="600"개별 클러스터 리소스를 정의할 때

resource-stickiness및migration-threshold에 설정한 값이 여기에 설정한 기본값을 재정의합니다.crm config show를 입력하면 리소스 기본값과 정의된 모든 리소스의 값을 확인할 수 있습니다.

보조 VM을 클러스터에 조인

기본 VM의 열린 터미널에서 SSH를 통해 보조 VM에 클러스터를 조인하고 시작합니다.

hacluster사용자의 비밀번호를 변경합니다.#passwd hacluster기본 VM에서 SSH를 통해 보조 VM에서 다음

crm cluster join스크립트 옵션을 실행합니다. 이 안내에 설명된 대로 HA 클러스터를 구성한 경우 워치독 기기에 대한 경고를 무시할 수 있습니다.--yes ssh옵션을 실행하여 클러스터 노드 간에ssh를 설정합니다.#ssh SECONDARY_VM_NAME 'crm cluster join --cluster-node PRIMARY_VM_NAME --yes ssh'--interface eth0 csync2옵션을 실행합니다.#ssh SECONDARY_VM_NAME 'crm cluster join --cluster-node PRIMARY_VM_NAME --yes --interface eth0 csync2'ssh_merge옵션을 실행합니다.#ssh SECONDARY_VM_NAME 'crm cluster join --cluster-node PRIMARY_VM_NAME --yes ssh_merge'cluster옵션을 실행합니다.#ssh SECONDARY_VM_NAME 'crm cluster join --cluster-node PRIMARY_VM_NAME --yes cluster'

보조 호스트에서 Pacemaker를 시작합니다.

Pacemaker를 사용 설정합니다.

#ssh SECONDARY_VM_NAME systemctl enable pacemakerPacemaker를 시작합니다.

#ssh SECONDARY_VM_NAME systemctl start pacemaker

두 호스트 중 하나에서 루트로 클러스터에 두 노드가 표시되는지 확인합니다.

#crm_mon -s다음과 비슷한 출력이 표시됩니다.

CLUSTER OK: 2 nodes online, 0 resource instances configured

인프라의 클러스터 리소스 구성

고가용성 클러스터에서 Pacemaker가 관리하는 리소스를 정의합니다. 다음 클러스터 구성요소의 리소스를 정의해야 합니다.

- 분할 브레인 시나리오를 방지하는 펜싱 기기

- 공유 파일 시스템의 ASCS 및 ERS 디렉터리

- 상태 확인

- VIP

- ASCS 및 ERS 구성요소

SAP NetWeaver를 먼저 설치해야 하므로 ASCS 및 ERS 구성요소의 리소스를 나머지 리소스보다 늦게 정의합니다.

유지보수 모드 사용 설정

두 호스트 중 하나에서 루트로 클러스터를 유지보수 모드로 전환합니다.

#crm configure property maintenance-mode="true"유지보수 모드를 확인합니다.

#crm status출력에는 다음 예시와 같이 리소스 관리가 사용 중지되었음을 나타내야 합니다.

Cluster Summary: * Stack: corosync * Current DC: nw-ha-vm-1 (version 2.0.4+20200616.2deceaa3a-3.3.1-2.0.4+20200616.2deceaa3a) - partition with quorum * Last updated: Fri May 14 15:26:08 2021 * Last change: Thu May 13 19:02:33 2021 by root via cibadmin on nw-ha-vm-1 * 2 nodes configured * 0 resource instances configured *** Resource management is DISABLED *** The cluster will not attempt to start, stop or recover services Node List: * Online: [ nw-ha-vm-1 nw-ha-vm-2 ] Full List of Resources: * No resources

펜싱 설정

각 호스트 VM의 fence_gce 에이전트로 클러스터 리소스를 정의하여 펜싱을 설정합니다.

펜싱 작업 후 올바른 이벤트 시퀀스를 보장하려면 VM이 펜싱된 후 Corosync의 다시 시작을 지연하도록 운영체제를 구성합니다. 지연을 고려하여 재부팅 시 Pacemaker 제한 시간을 조정합니다.

펜싱 기기 리소스 만들기

클러스터의 각 VM의 경우 VM을 다시 시작할 수 있는 펜싱 기기의 클러스터 리소스를 만듭니다. VM에 대한 펜싱 기기는 다른 VM에서 실행되어야 하므로 다시 시작할 수 있는 VM을 제외한 모든 VM에서 실행되도록 클러스터 리소스의 위치를 구성합니다.

기본 호스트에서 루트로 기본 VM에 대한 펜싱 기기의 클러스터 리소스를 만듭니다.

#crm configure primitive FENCING_RESOURCE_PRIMARY_VM stonith:fence_gce \ op monitor interval="300s" timeout="120s" \ op start interval="0" timeout="60s" \ params port="PRIMARY_VM_NAME" zone="PRIMARY_ZONE" \ project="CLUSTER_PROJECT_ID" \ pcmk_reboot_timeout=300 pcmk_monitor_retries=4 pcmk_delay_max=30보조 VM에서만 활성화되도록 기본 VM에 대한 펜싱 기기의 위치를 구성합니다.

#crm configure location FENCING_LOCATION_NAME_PRIMARY_VM \ FENCING_RESOURCE_PRIMARY_VM -inf: "PRIMARY_VM_NAME"새로 만든 구성을 확인합니다.

#crm config show related:FENCING_RESOURCE_PRIMARY_VM다음과 비슷한 출력이 표시됩니다.

primitive FENCING_RESOURCE_PRIMARY_VM stonith:fence_gce \ op monitor interval=300s timeout=120s \ op start interval=0 timeout=60s \ params PRIMARY_VM_NAME zone=PRIMARY_ZONE project=CLUSTER_PROJECT_ID pcmk_reboot_timeout=300 pcmk_monitor_retries=4 pcmk_delay_max=30 location FENCING_RESOURCE_PRIMARY_VM FENCING_RESOURCE_PRIMARY_VM -inf: PRIMARY_VM_NAME기본 호스트에서 루트로 보조 VM에 대한 펜싱 기기의 클러스터 리소스를 만듭니다.

#crm configure primitive FENCING_RESOURCE_SECONDARY_VM stonith:fence_gce \ op monitor interval="300s" timeout="120s" \ op start interval="0" timeout="60s" \ params port="SECONDARY_VM_NAME" zone="SECONDARY_VM_ZONE" \ project="CLUSTER_PROJECT_ID" \ pcmk_reboot_timeout=300 pcmk_monitor_retries=4기본 VM에서만 활성화되도록 보조 VM에 대한 펜싱 기기의 위치를 구성합니다.

#crm configure location FENCING_LOCATION_NAME_SECONDARY_VM \ FENCING_RESOURCE_SECONDARY_VM -inf: "SECONDARY_VM_NAME"새로 만든 구성을 확인합니다.

#crm config show related:FENCING_RESOURCE_SECONDARY_VM다음과 비슷한 출력이 표시됩니다.

primitive FENCING_RESOURCE_SECONDARY_VM stonith:fence_gce \ op monitor interval=300s timeout=120s \ op start interval=0 timeout=60s \ params SECONDARY_VM_NAME zone=SECONDARY_ZONE project=CLUSTER_PROJECT_ID pcmk_reboot_timeout=300 pcmk_monitor_retries=4 location FENCING_RESOURCE_SECONDARY_VM FENCING_RESOURCE_SECONDARY_VM -inf: SECONDARY_VM_NAME

Corosync 재시작 지연 설정

두 호스트 모두에서 루트로

systemd삽입 파일을 만들어 Corosync 시작을 지연하여 펜싱된 VM이 재부팅된 후 올바른 이벤트 시퀀스를 확인합니다.systemctl edit corosync.service

파일에 다음 행을 추가합니다.

[Service] ExecStartPre=/bin/sleep 60

파일을 저장하고 편집기를 종료합니다.

systemd 관리자 구성을 새로고침합니다.

systemctl daemon-reload

삽입 파일이 생성되었는지 확인합니다.

service corosync status

다음 예시와 같이 삽입 파일의 줄이 표시됩니다.

● corosync.service - Corosync Cluster Engine Loaded: loaded (/usr/lib/systemd/system/corosync.service; disabled; vendor preset: disabled) Drop-In: /etc/systemd/system/corosync.service.d └─override.conf Active: active (running) since Tue 2021-07-20 23:45:52 UTC; 2 days ago

파일 시스템 리소스 만들기

간단한 마운트 설정을 사용하는 경우 간단한 마운트 설정은 클러스터에서 관리하는 인스턴스별 파일 시스템 리소스를 사용하지 않으므로 이 섹션을 건너뛸 수 있습니다.

이제 공유 파일 시스템 디렉터리를 만들었으므로 클러스터 리소스를 정의할 수 있습니다.

인스턴스별 디렉터리의 파일 시스템 리소스를 구성합니다.

#crm configure primitive ASCS_FILE_SYSTEM_RESOURCE Filesystem \ device="NFS_PATH/usrsapSIDASCSASCS_INSTANCE_NUMBER" \ directory="/usr/sap/SID/ASCSASCS_INSTANCE_NUMBER" fstype="nfs" \ op start timeout=60s interval=0 \ op stop timeout=60s interval=0 \ op monitor interval=20s timeout=40s다음을 바꿉니다.

ASCS_FILE_SYSTEM_RESOURCE: ASCS 파일 시스템의 클러스터 리소스 이름을 지정합니다.NFS_PATH: ASCS의 NFS 파일 시스템 경로를 지정합니다.SID: 시스템 ID(SID)를 지정합니다. 모든 문자에 대문자를 사용합니다.ASCS_INSTANCE_NUMBER: ASCS 인스턴스 번호를 지정합니다.

#crm configure primitive ERS_FILE_SYSTEM_RESOURCE Filesystem \ device="NFS_PATH/usrsapSIDERSERS_INSTANCE_NUMBER" \ directory="/usr/sap/SID/ERSERS_INSTANCE_NUMBER" fstype="nfs" \ op start timeout=60s interval=0 \ op stop timeout=60s interval=0 \ op monitor interval=20s timeout=40s다음을 바꿉니다.

ERS_FILE_SYSTEM_RESOURCE: ERS 파일 시스템의 클러스터 리소스 이름을 지정합니다.NFS_PATH: ERS의 NFS 파일 시스템 경로를 지정합니다.SID: 시스템 ID(SID)를 지정합니다. 모든 문자에 대문자를 사용합니다.ERS_INSTANCE_NUMBER: ASCS 인스턴스 번호를 지정합니다.

새로 만든 구성을 확인합니다.

#crm configure show ASCS_FILE_SYSTEM_RESOURCE ERS_FILE_SYSTEM_RESOURCE다음과 비슷한 출력이 표시됩니다.

primitive ASCS_FILE_SYSTEM_RESOURCE Filesystem \ params device="NFS_PATH/usrsapSIDASCSASCS_INSTANCE_NUMBER" directory="/usr/sap/SID/ASCSASCS_INSTANCE_NUMBER" fstype=nfs \ op start timeout=60s interval=0 \ op stop timeout=60s interval=0 \ op monitor interval=20s timeout=40s primitive ERS_FILE_SYSTEM_RESOURCE Filesystem \ params device="NFS_PATH/usrsapSIDERSERS_INSTANCE_NUMBER" directory="/usr/sap/SID/ERSERS_INSTANCE_NUMBER" fstype=nfs \ op start timeout=60s interval=0 \ op stop timeout=60s interval=0 \ op monitor interval=20s timeout=40s

상태 확인 리소스 만들기

ASCS 및 ERS 상태 점검을 위한 클러스터 리소스를 구성합니다.

#crm configure primitive ASCS_HEALTH_CHECK_RESOURCE anything \ params binfile="/usr/bin/socat" \ cmdline_options="-U TCP-LISTEN:ASCS_HEALTHCHECK_PORT_NUM,backlog=10,fork,reuseaddr /dev/null" \ op monitor timeout=20s interval=10s \ op_params depth=0#crm configure primitive ERS_HEALTH_CHECK_RESOURCE anything \ params binfile="/usr/bin/socat" \ cmdline_options="-U TCP-LISTEN:ERS_HEALTHCHECK_PORT_NUM,backlog=10,fork,reuseaddr /dev/null" \ op monitor timeout=20s interval=10s \ op_params depth=0새로 만든 구성을 확인합니다.

#crm configure show ERS_HEALTH_CHECK_RESOURCE ASCS_HEALTH_CHECK_RESOURCE다음과 비슷한 출력이 표시됩니다.

primitive ERS_HEALTH_CHECK_RESOURCE anything \ params binfile="/usr/bin/socat" cmdline_options="-U TCP-LISTEN:ASCS_HEALTHCHECK_PORT_NUM,backlog=10,fork,reuseaddr /dev/null" \ op monitor timeout=20s interval=10s \ op_params depth=0 primitive ASCS_HEALTH_CHECK_RESOURCE anything \ params binfile="/usr/bin/socat" cmdline_options="-U TCP-LISTEN:ERS_HEALTHCHECK_PORT_NUM,backlog=10,fork,reuseaddr /dev/null" \ op monitor timeout=20s interval=10s \ op_params depth=0

VIP 리소스 만들기

VIP 주소의 클러스터 리소스를 정의합니다.

숫자 VIP 주소를 조회해야 하는 경우 다음을 사용하세요.

gcloud compute addresses describe ASCS_VIP_NAME

--region=CLUSTER_REGION --format="value(address)"gcloud compute addresses describe ERS_VIP_NAME

--region=CLUSTER_REGION --format="value(address)"

ASCS 및 ERS VIP용 클러스터 리소스를 만듭니다.

#crm configure primitive ASCS_VIP_RESOURCE IPaddr2 \ params ip=ASCS_VIP_ADDRESS cidr_netmask=32 nic="eth0" \ op monitor interval=3600s timeout=60s#crm configure primitive ERS_VIP_RESOURCE IPaddr2 \ params ip=ERS_VIP_ADDRESS cidr_netmask=32 nic="eth0" \ op monitor interval=3600s timeout=60s새로 만든 구성을 확인합니다.

#crm configure show ASCS_VIP_RESOURCE ERS_VIP_RESOURCE다음과 비슷한 출력이 표시됩니다.

primitive ASCS_VIP_RESOURCE IPaddr2 \ params ip=ASCS_VIP_ADDRESS cidr_netmask=32 nic=eth0 \ op monitor interval=3600s timeout=60s primitive ERS_VIP_RESOURCE IPaddr2 \ params ip=ERS_VIP_RESOURCE cidr_netmask=32 nic=eth0 \ op monitor interval=3600s timeout=60s

정의된 리소스 보기

지금까지 정의한 모든 리소스를 보려면 다음 명령어를 입력합니다.

#crm status다음과 비슷한 출력이 표시됩니다.

Stack: corosync Current DC: nw-ha-vm-1 (version 1.1.24+20201209.8f22be2ae-3.12.1-1.1.24+20201209.8f22be2ae) - partition with quorum Last updated: Wed May 26 19:10:10 2021 Last change: Tue May 25 23:48:35 2021 by root via cibadmin on nw-ha-vm-1 2 nodes configured 8 resource instances configured *** Resource management is DISABLED *** The cluster will not attempt to start, stop or recover services Online: [ nw-ha-vm-1 nw-ha-vm-2 ] Full list of resources: fencing-rsc-nw-aha-vm-1 (stonith:fence_gce): Stopped (unmanaged) fencing-rsc-nw-aha-vm-2 (stonith:fence_gce): Stopped (unmanaged) filesystem-rsc-nw-aha-ascs (ocf::heartbeat:Filesystem): Stopped (unmanaged) filesystem-rsc-nw-aha-ers (ocf::heartbeat:Filesystem): Stopped (unmanaged) health-check-rsc-nw-ha-ascs (ocf::heartbeat:anything): Stopped (unmanaged) health-check-rsc-nw-ha-ers (ocf::heartbeat:anything): Stopped (unmanaged) vip-rsc-nw-aha-ascs (ocf::heartbeat:IPaddr2): Stopped (unmanaged) vip-rsc-nw-aha-ers (ocf::heartbeat:IPaddr2): Stopped (unmanaged)간단한 마운트 설정을 사용하는 경우 다음 예와 유사한 출력이 표시됩니다.

Stack: corosync Current DC: nw-ha-vm-1 (version 1.1.24+20201209.8f22be2ae-3.12.1-1.1.24+20201209.8f22be2ae) - partition with quorum Last updated: Wed Sep 26 19:10:10 2024 Last change: Tue Sep 25 23:48:35 2024 by root via cibadmin on nw-ha-vm-1 2 nodes configured 8 resource instances configured *** Resource management is DISABLED *** The cluster will not attempt to start, stop or recover services Online: [ nw-ha-vm-1 nw-ha-vm-2 ] Full list of resources: fencing-rsc-nw-aha-vm-1 (stonith:fence_gce): Stopped (unmanaged) fencing-rsc-nw-aha-vm-2 (stonith:fence_gce): Stopped (unmanaged) health-check-rsc-nw-ha-ascs (ocf::heartbeat:anything): Stopped (unmanaged) health-check-rsc-nw-ha-ers (ocf::heartbeat:anything): Stopped (unmanaged) vip-rsc-nw-aha-ascs (ocf::heartbeat:IPaddr2): Stopped (unmanaged) vip-rsc-nw-aha-ers (ocf::heartbeat:IPaddr2): Stopped (unmanaged)

ASCS 및 ERS 설치

다음 섹션에서는 Google Cloud에 SAP NetWeaver를 설치하는 데 필요한 요구사항과 권장사항만 설명합니다.

자세한 설치 안내는 SAP NetWeaver 문서를 참조하세요.

설치 준비

클러스터 전체에서 일관성을 유지하고 설치를 단순화하려면 SAP NetWeaver ASCS 및 ERS 구성요소를 설치하기 전에 사용자, 그룹, 권한을 정의하고 보조 서버를 대기 모드로 전환해야 합니다.

클러스터의 유지보수 모드를 해제합니다.

#crm configure property maintenance-mode="false"두 서버 모두에서 루트로 환경에 적합한 사용자 및 그룹 ID를 지정하여 다음 명령어를 입력합니다.

#groupadd -g GID_SAPINST sapinst#groupadd -g GID_SAPSYS sapsys#useradd -u UID_SIDADM SID_LCadm -g sapsys#usermod -a -G sapinst SID_LCadm#useradd -u UID_SAPADM sapadm -g sapinst#chown SID_LCadm:sapsys /usr/sap/SID/SYS#chown SID_LCadm:sapsys /sapmnt/SID -R#chown SID_LCadm:sapsys /usr/sap/trans -R#chown SID_LCadm:sapsys /usr/sap/SID/SYS -R#chown SID_LCadm:sapsys /usr/sap/SID -R간단한 마운트 설정을 사용하는 경우에는 대신 두 서버 모두에서 다음 명령어를 루트로 실행합니다. 환경에 적합한 사용자와 그룹 ID를 지정합니다.

#groupadd -g GID_SAPINST sapinst#groupadd -g GID_SAPSYS sapsys#useradd -u UID_SIDADM SID_LCadm -g sapsys#usermod -a -G sapinst SID_LCadm#useradd -u UID_SAPADM sapadm -g sapinst#chown SID_LCadm:sapsys /usr/sap/SID#chown SID_LCadm:sapsys /sapmnt/SID -R#chown SID_LCadm:sapsys /usr/sap/trans -R#chown SID_LCadm:sapsys /usr/sap/SID -R#chown SID_LCadm:sapsys /usr/sap/SID/SYS다음을 바꿉니다.

GID_SAPINST: SAP 프로비저닝 도구의 Linux 그룹 ID를 지정합니다.GID_SAPSYS: SAPSYS 사용자의 Linux 그룹 ID를 지정합니다.UID_SIDADM: SAP 시스템 관리자(SID)의 Linux 사용자 ID를 지정합니다.SID_LC: 시스템 ID(SID)를 지정합니다. 모든 문자에 소문자를 사용합니다.UID_SAPADM: SAP 호스트 에이전트의 사용자 ID를 지정합니다.SID: 시스템 ID(SID)를 지정합니다. 모든 문자에 대문자를 사용합니다.

예를 들어 다음은 실제 GID 및 UID 번호 지정 스키마를 보여줍니다.

Group sapinst 1001 Group sapsys 1002 Group dbhshm 1003 User en2adm 2001 User sapadm 2002 User dbhadm 2003

ASCS 구성요소 설치

보조 서버에서 다음 명령어를 입력하여 보조 서버를 대기 모드로 전환합니다.

#crm_standby -v on -N ${HOSTNAME};보조 서버를 대기 모드로 설정하면 모든 클러스터 리소스가 기본 서버에 통합되어 설치가 간소화됩니다.

보조 서버가 대기 모드인지 확인합니다.

#crm status출력은 다음 예시와 비슷합니다.

Stack: corosync Current DC: nw-ha-vm-1 (version 1.1.24+20201209.8f22be2ae-3.12.1-1.1.24+20201209.8f22be2ae) - partition with quorum Last updated: Thu May 27 17:45:16 2021 Last change: Thu May 27 17:45:09 2021 by root via crm_attribute on nw-ha-vm-2 2 nodes configured 8 resource instances configured Node nw-ha-vm-2: standby Online: [ nw-ha-vm-1 ] Full list of resources: fencing-rsc-nw-aha-vm-1 (stonith:fence_gce): Stopped fencing-rsc-nw-aha-vm-2 (stonith:fence_gce): Started nw-ha-vm-1 filesystem-rsc-nw-aha-scs (ocf::heartbeat:Filesystem): Started nw-ha-vm-1 filesystem-rsc-nw-aha-ers (ocf::heartbeat:Filesystem): Started nw-ha-vm-1 health-check-rsc-nw-ha-scs (ocf::heartbeat:anything): Started nw-ha-vm-1 health-check-rsc-nw-ha-ers (ocf::heartbeat:anything): Started nw-ha-vm-1 vip-rsc-nw-aha-scs (ocf::heartbeat:IPaddr2): Started nw-ha-vm-1 vip-rsc-nw-aha-ers (ocf::heartbeat:IPaddr2): Started nw-ha-vm-1간단한 마운트 설정을 사용하는 경우 출력은 다음과 유사합니다.

Stack: corosync Current DC: nw-ha-vm-1 (version 1.1.24+20201209.8f22be2ae-3.12.1-1.1.24+20201209.8f22be2ae) - partition with quorum Last updated: Wed Sep 26 19:30:10 2024 Last change: Tue Sep 25 23:58:35 2024 by root via crm_attribute on nw-ha-vm-2 2 nodes configured 8 resource instances configured Node nw-ha-vm-2: standby Online: [ nw-ha-vm-1 ] Full list of resources: fencing-rsc-nw-aha-vm-1 (stonith:fence_gce): Stopped fencing-rsc-nw-aha-vm-2 (stonith:fence_gce): Started nw-ha-vm-1 health-check-rsc-nw-ha-scs (ocf::heartbeat:anything): Started nw-ha-vm-1 health-check-rsc-nw-ha-ers (ocf::heartbeat:anything): Started nw-ha-vm-1 vip-rsc-nw-aha-scs (ocf::heartbeat:IPaddr2): Started nw-ha-vm-1 vip-rsc-nw-aha-ers (ocf::heartbeat:IPaddr2): Started nw-ha-vm-1기본 서버에서 루트 사용자 권한으로 SAP Software Provisioning Manager(SWPM)를 실행하여 디렉터리를

/tmp와 같은 임시 설치 디렉터리로 변경하고 ASCS 인스턴스를 설치합니다.SWPM의 웹 인터페이스에 액세스하려면

root사용자의 비밀번호가 필요합니다. IT 정책으로 인해 SAP 관리자가 루트 비밀번호에 액세스할 수 없는 경우SAPINST_REMOTE_ACCESS_USER를 사용할 수 있습니다.SWPM을 시작할 때

SAPINST_USE_HOSTNAME매개변수를 사용하여/etc/hosts파일에서 ASCS VIP 주소에 정의한 가상 호스트 이름을 지정합니다.예를 들면 다음과 같습니다.

cd /tmp; /mnt/nfs/install/SWPM/sapinst SAPINST_USE_HOSTNAME=vh-aha-scs

마지막 SWPM 확인 페이지에서 가상 호스트 이름이 올바른지 확인합니다.

구성이 완료되면 보조 VM을 대기 모드에서 해제합니다.

#crm_standby -v off -N ${HOSTNAME}; # On SECONDARY

ERS 구성요소 설치

기본 서버에서 루트 또는

SID_LCadm으로 ASCS 서비스를 중지합니다.#su - SID_LCadm -c "sapcontrol -nr ASCS_INSTANCE_NUMBER -function Stop"#su - SID_LCadm -c "sapcontrol -nr ASCS_INSTANCE_NUMBER -function StopService"기본 서버에서 다음 명령어를 입력하여 기본 서버를 대기 모드로 전환합니다.

#crm_standby -v on -N ${HOSTNAME};기본 서버를 대기 모드로 설정하면 모든 클러스터 리소스가 보조 서버에 통합되어 설치가 간소화됩니다.

기본 서버가 대기 모드인지 확인합니다.

#crm status보조 서버에서 루트 사용자 권한으로 SAP Software Provisioning Manager(SWPM)를 실행하여 디렉터리를

/tmp와 같은 임시 설치 디렉터리로 변경하고 ERS 인스턴스를 설치합니다.ASCS 구성요소를 설치할 때 사용한 동일한 사용자 및 비밀번호를 사용하여 SWPM에 액세스합니다.

SWPM을 시작할 때

SAPINST_USE_HOSTNAME매개변수를 사용하여/etc/hosts파일에서 ERS VIP 주소에 정의한 가상 호스트 이름을 지정합니다.예를 들면 다음과 같습니다.

cd /tmp; /mnt/nfs/install/SWPM/sapinst SAPINST_USE_HOSTNAME=vh-aha-ers

마지막 SWPM 확인 페이지에서 가상 호스트 이름이 올바른지 확인합니다.

기본 VM을 대기 모드에서 해제하여 두 VM 모두 활성화되도록 합니다.

#crm_standby -v off -N ${HOSTNAME};

SAP 서비스 구성

서비스가 올바르게 구성되었는지 확인하고 ASCS 및 ERS 프로필에서 설정을 확인한 다음 SID_LCadm 사용자를 haclient 사용자 그룹에 추가해야 합니다.

SAP 서비스 항목 확인

두 서버 모두에서

/usr/sap/sapservices파일에 ASCS 및 ERS 서비스, 둘 다의 항목이 포함되어 있는지 확인합니다. 이렇게 하려면systemV또는systemd통합을 사용하면 됩니다.sapstartsrv명령어를pf=PROFILE_OF_THE_SAP_INSTANCE및-reg옵션과 함께 사용하여 누락된 항목을 추가할 수 있습니다.이러한 통합에 대한 자세한 내용은 다음 SAP Note를 참조하세요.

systemV다음은

systemV통합을 사용할 때/usr/sap/sapservices파일에 ASCS 및 ERS 서비스의 항목이 어떻게 입력되는지 보여주는 예시입니다.#LD_LIBRARY_PATH=/usr/sap/hostctrl/exe:$LD_LIBRARY_PATH; export LD_LIBRARY_PATH /usr/sap/hostctrl/exe/sapstartsrv \ pf=/usr/sap/SID/SYS/profile/SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME \ -D -u SID_LCadm /usr/sap/hostctrl/exe/sapstartsrv \ pf=/usr/sap/SID/SYS/profile/SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME \ -D -u SID_LCadmsystemd/usr/sap/sapservices파일에 ASCS 및 ERS 서비스 항목이 포함되어 있는지 확인합니다. 다음은systemd통합을 사용할 때 이러한 항목이/usr/sap/sapservices파일에 표시되는 방법의 예시입니다.systemctl --no-ask-password start SAPSID_ASCS_INSTANCE_NUMBER # sapstartsrv pf=/usr/sap/SID/SYS/profile/SID_ASCSASCS_INSTANCE_NUMBER_SID_LCascs systemctl --no-ask-password start SAPSID_ERS_INSTANCE_NUMBER # sapstartsrv pf=/usr/sap/SID/SYS/profile/SID_ERSERS_INSTANCE_NUMBER_SID_LCers

ASCS 및 ERS 인스턴스에서

systemd통합을 사용 중지합니다.#systemctl disable SAPSID_ASCS_INSTANCE_NUMBER.service#systemctl stop SAPSID_ASCS_INSTANCE_NUMBER.service#systemctl disable SAPSID_ERS_INSTANCE_NUMBER.service#systemctl stop SAPSID_ERS_INSTANCE_NUMBER.servicesystemd통합이 사용 중지되었는지 확인합니다.#systemctl list-unit-files | grep sap다음 예시와 비슷한 출력이 표시되면

systemd통합이 사용 중지된 것입니다.saphostagent및saptune과 같은 일부 서비스는 사용 설정되고 일부 서비스는 사용 중지됩니다.SAPSID_ASCS_INSTANCE_NUMBER.service disabled SAPSID_ERS_INSTANCE_NUMBER.service disabled saphostagent.service enabled sapinit.service generated saprouter.service disabled saptune.service enabled

자세한 내용은 SUSE 문서 ASCS 및 ERS SAP 인스턴스의

systemd서비스 사용 중지를 참조하세요.

SAP 서비스 중지

보조 서버에서 ERS 서비스를 중지합니다.

#su - SID_LCadm -c "sapcontrol -nr ERS_INSTANCE_NUMBER -function Stop"#su - SID_LCadm -c "sapcontrol -nr ERS_INSTANCE_NUMBER -function StopService"각 서버에서 모든 서비스가 중지되었는지 확인합니다.

#su - SID_LCadm -c "sapcontrol -nr ASCS_INSTANCE_NUMBER -function GetSystemInstanceList"#su - SID_LCadm -c "sapcontrol -nr ERS_INSTANCE_NUMBER -function GetSystemInstanceList"다음과 비슷한 출력이 표시됩니다.

GetSystemInstanceList FAIL: NIECONN_REFUSED (Connection refused), NiRawConnect failed in plugin_fopen()

sapping 및 sappong을 사용 설정합니다.

간단한 마운트 설정을 사용하지 않는 경우 이 섹션을 건너뜁니다.

클러스터의 시작 및 중지 절차는 Pacemaker에서 관리하므로 시스템 부팅 중에 sapstartsrv가 자동으로 시작되지 않도록 해야 합니다. 시스템 부팅 중에 sapping이 sapinit보다 먼저 실행되어 sapservices 파일을 숨깁니다. sapinit이 완료되면 sappong은 sapservices 파일을 숨김 해제합니다.

이 흐름을 활성화하려면 다음 명령어를 사용하여 systemd 서비스 sapping 및 sappong을 사용 설정해야 합니다.

#systemctl enable sapping sappong#systemctl status sapping sappong

ASCS 및 ERS 프로필 수정

두 서버 중 하나에서 다음 명령어 중 하나를 사용하여 프로필 디렉터리로 전환합니다.

#cd /usr/sap/SID/SYS/profile#cd /sapmnt/SID/profile필요한 경우 프로필 디렉터리에 파일을 나열하여 ASCS 및 ERS 프로필의 파일 이름을 찾거나 다음 형식을 사용합니다.

SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME

SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME

프로필 ASCS 및 ERS 인스턴스 프로필에 다음 줄을 추가하여

sap-suse-cluster-connector패키지를 사용 설정합니다.#----------------------------------------------------------------------- # SUSE HA library #----------------------------------------------------------------------- service/halib = $(DIR_CT_RUN)/saphascriptco.so service/halib_cluster_connector = /usr/bin/sap_suse_cluster_connectorENSA1을 사용하는 경우 ASCS 프로필에서 다음을 설정하여 연결 유지 함수를 사용 설정합니다.

enque/encni/set_so_keepalive = true

자세한 내용은 SAP Note 1410736 - TCP/IP: settings keepalive interval(연결 유지 간격 설정)을 참조하세요.

필요한 경우 ASCS 및 ERS 프로필을 수정하여 Enqueue Server와 Enqueue Replication Server의 시작 동작을 변경합니다.

ENSA1

ASCS 프로필의 'SAP Enqueue Server 시작' 섹션에서

Restart_Program_NN이라고 표시되면 다음 예시와 같이 'Restart'를 'Start'로 변경합니다.Start_Program_01 = local $(_EN) pf=$(_PF)

ERS 프로필의 'Enqueue Replication Server 시작' 섹션에서

Restart_Program_NN이라고 표시되면 다음 예시와 같이 'Restart'를 'Start'로 변경합니다.Start_Program_00 = local $(_ER) pf=$(_PFL) NR=$(SCSID)

ENSA2

ASCS 프로필의 'SAP Enqueue Server 시작' 섹션에서

Restart_Program_NN이라고 표시되면 다음 예시와 같이 'Restart'를 'Start'로 변경합니다.Start_Program_01 = local $(_ENQ) pf=$(_PF)

ERS 프로필의 'Enqueue Replicator 시작' 섹션에서

Restart_Program_NN이라고 표시되면 다음 예시와 같이 'Restart'를 'Start'로 변경합니다.Start_Program_00 = local $(_ENQR) pf=$(_PF) ...

sidadm 사용자를 haclient 사용자 그룹에 추가합니다.

sap-suse-cluster-connector를 설치하면 설치 시 haclient 사용자 그룹이 생성됩니다. SID_LCadm 사용자가 클러스터에서 작업할 수 있도록 사용 설정하려면 해당 사용자를 haclient 사용자 그룹에 추가합니다.

두 서버 모두에서

SID_LCadm사용자를haclient사용자 그룹에 추가합니다.#usermod -aG haclient SID_LCadm

ASCS 및 ERS용 클러스터 리소스 구성

두 서버 중 하나에서 루트로 클러스터를 유지보수 모드로 설정합니다.

#crm configure property maintenance-mode="true"클러스터가 유지보수 모드인지 확인합니다.

#crm status클러스터가 유지보수 모드이면 상태에 다음 줄이 포함됩니다.

*** Resource management is DISABLED *** The cluster will not attempt to start, stop or recover services

간단한 마운트 설정을 사용하는 경우 ASCS 및 ERS 서비스의

sapstartsrv클러스터 리소스를 만듭니다. 간단한 마운트 설정을 사용하지 않는 경우 이 단계를 건너뜁니다.ASCS의 경우 다음 콘텐츠로

sapstartsrv_scs.txt라는 구성 파일을 만듭니다.primitive rsc_SAPStartSrv_SID_ASCSINSTANCENUMBER ocf:suse:SAPStartSrv \ params InstanceName=SID_ASCSINSTANCE_NUMBER_ASCS_VIRTUAL_HOSTNAME

ASCS에 대한 구성을 로드하려면 다음 명령어를 실행합니다.

#crm configure load update sapstartsrv_scs.txtERS의 경우 다음 콘텐츠로

sapstartsrv_ers.txt라는 구성 파일을 만듭니다.primitive rsc_SAPStartSrv_SID_ERSINSTANCENUMBER ocf:suse:SAPStartSrv \ params InstanceName=SID_ERSINSTANCE_NUMBER_ERS_VIRTUAL_HOSTNAME

ERS에 대한 구성을 로드하려면 다음 명령어를 실행합니다.

#crm configure load update sapstartsrv_ers.txt

ASCS 및 ERS 서비스용 클러스터 리소스를 만듭니다.

ENSA1

ASCS 인스턴스의 클러스터 리소스를 만듭니다.

InstanceName값은 ASCS를 설치할 때 SWPM이 생성한 인스턴스 프로필의 이름입니다.#crm configure primitive ASCS_INSTANCE_RESOURCE SAPInstance \ operations \$id=ASCS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME \ START_PROFILE="/PATH_TO_PROFILE/SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME" \ AUTOMATIC_RECOVER=false \ meta resource-stickiness=5000 failure-timeout=60 \ migration-threshold=1 priority=10간단한 마운트 설정을 사용하는 경우 다음 명령어를 대신 실행합니다.

#crm configure primitive ASCS_INSTANCE_RESOURCE SAPInstance \ operations \$id=ASCS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME \ START_PROFILE="/PATH_TO_PROFILE/SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME" \ AUTOMATIC_RECOVER=false MINIMAL_PROBE=true \ meta resource-stickiness=5000 failure-timeout=60 \ migration-threshold=1 priority=10ERS 인스턴스의 클러스터 리소스를 만듭니다.

InstanceName값은 ERS를 설치할 때 SWPM이 생성한 인스턴스 프로필의 이름입니다.IS_ERS=true매개변수는 Pacemaker로 하여금 ERS가 활성화된 노드에서runsersSID플래그를1로 설정하도록 지시합니다.#crm configure primitive ERS_INSTANCE_RESOURCE SAPInstance \ operations \$id=ERS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME \ START_PROFILE="/PATH_TO_PROFILE/SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME" \ AUTOMATIC_RECOVER=false IS_ERS=true \ meta priority=1000간단한 마운트 설정을 사용하는 경우 다음 명령어를 대신 실행합니다.

#crm configure primitive ERS_INSTANCE_RESOURCE SAPInstance \ operations \$id=ERS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME \ START_PROFILE="/PATH_TO_PROFILE/SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME" \ AUTOMATIC_RECOVER=false MINIMAL_PROBE=true IS_ERS=true \ meta priority=1000새로 만든 구성을 확인합니다.

#crm configure show ASCS_INSTANCE_RESOURCE ERS_INSTANCE_RESOURCE출력은 다음 예시와 비슷합니다.

primitive ASCS_INSTANCE_RESOURCE SAPInstance \ operations $id=ASCS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME START_PROFILE="/PATH_TO_PROFILE/SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME" AUTOMATIC_RECOVER=false \ meta resource-stickiness=5000 failure-timeout=60 migration-threshold=1 priority=10 primitive ERS_INSTANCE_RESOURCE SAPInstance \ operations $id=ERS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME START_PROFILE="/PATH_TO_PROFILE/SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME" AUTOMATIC_RECOVER=false IS_ERS=true \ meta priority=1000

간단한 마운트 설정을 사용하는 경우 출력은 다음 예시와 유사합니다.

primitive ASCS_INSTANCE_RESOURCE SAPInstance \ operations $id=ASCS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME START_PROFILE="/PATH_TO_PROFILE/SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME" AUTOMATIC_RECOVER=false MINIMAL_PROBE=true \ meta resource-stickiness=5000 failure-timeout=60 migration-threshold=1 priority=10 primitive ERS_INSTANCE_RESOURCE SAPInstance \ operations $id=ERS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME START_PROFILE="/PATH_TO_PROFILE/SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME" AUTOMATIC_RECOVER=false MINIMAL_PROBE=true IS_ERS=true \ meta priority=1000

ENSA2

ASCS 인스턴스의 클러스터 리소스를 만듭니다.

InstanceName값은 ASCS를 설치할 때 SWPM이 생성한 인스턴스 프로필의 이름입니다.#crm configure primitive ASCS_INSTANCE_RESOURCE SAPInstance \ operations \$id=ASCS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME \ START_PROFILE="/PATH_TO_PROFILE/SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME" \ AUTOMATIC_RECOVER=false \ meta resource-stickiness=5000 failure-timeout=60간단한 마운트 설정을 사용하는 경우 다음 명령어를 대신 실행합니다.

#crm configure primitive ASCS_INSTANCE_RESOURCE SAPInstance \ operations \$id=ASCS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME \ START_PROFILE="/PATH_TO_PROFILE/SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME" \ AUTOMATIC_RECOVER=false MINIMAL_PROBE=true \ meta resource-stickiness=5000 failure-timeout=60ERS 인스턴스의 클러스터 리소스를 만듭니다.

InstanceName값은 ERS를 설치할 때 SWPM이 생성한 인스턴스 프로필의 이름입니다.#crm configure primitive ERS_INSTANCE_RESOURCE SAPInstance \ operations \$id=ERS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME \ START_PROFILE="/PATH_TO_PROFILE/SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME" \ AUTOMATIC_RECOVER=false IS_ERS=true간단한 마운트 설정을 사용하는 경우 다음 명령어를 대신 실행합니다.

#crm configure primitive ERS_INSTANCE_RESOURCE SAPInstance \ operations \$id=ERS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME \ START_PROFILE="/PATH_TO_PROFILE/SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME" \ AUTOMATIC_RECOVER=false IS_ERS=true MINIMAL_PROBE=true \ meta priority=1000새로 만든 구성을 확인합니다.

#crm configure show ASCS_INSTANCE_RESOURCE ERS_INSTANCE_RESOURCE출력은 다음 예시와 비슷합니다.

primitive ASCS_INSTANCE_RESOURCE SAPInstance \ operations $id=ASCS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME START_PROFILE="/PATH_TO_PROFILE/SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME" AUTOMATIC_RECOVER=false \ meta resource-stickiness=5000 failure-timeout=60 primitive ERS_INSTANCE_RESOURCE SAPInstance \ operations $id=ERS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME START_PROFILE="/PATH_TO_PROFILE/SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME" AUTOMATIC_RECOVER=false IS_ERS=true \

간단한 마운트 설정을 사용하는 경우 출력은 다음과 유사합니다.

primitive ASCS_INSTANCE_RESOURCE SAPInstance \ operations $id=ASCS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME START_PROFILE="/PATH_TO_PROFILE/SID_ASCSASCS_INSTANCE_NUMBER_ASCS_VIRTUAL_HOST_NAME" AUTOMATIC_RECOVER=false MINIMAL_PROBE=true \ meta resource-stickiness=5000 failure-timeout=60 \ migration-threshold=1 priority=10 primitive ERS_INSTANCE_RESOURCE SAPInstance \ operations $id=ERS_INSTANCE_RSC_OPERATIONS_NAME \ op monitor interval=11 timeout=60 on-fail=restart \ params InstanceName=SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME START_PROFILE="/PATH_TO_PROFILE/SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME" AUTOMATIC_RECOVER=false MINIMAL_PROBE=true IS_ERS=true \ meta priority=1000

리소스 그룹 및 위치 제약조건 구성

ASCS 및 ERS 리소스를 그룹화합니다.

crm resource status명령어를 입력하여 이전에 정의한 모든 리소스의 이름을 표시할 수 있습니다.#crm configure group ASCS_RESOURCE_GROUP ASCS_FILE_SYSTEM_RESOURCE \ ASCS_HEALTH_CHECK_RESOURCE ASCS_VIP_RESOURCE \ ASCS_INSTANCE_RESOURCE \ meta resource-stickiness=3000#crm configure group ASCS_RESOURCE_GROUP ASCS_SAPSTARTSRV_RESOURCE \ ASCS_HEALTH_CHECK_RESOURCE ASCS_VIP_RESOURCE \ ASCS_INSTANCE_RESOURCE \ meta resource-stickiness=3000ASCS_RESOURCE_GROUP: ASCS 클러스터 리소스에 고유한 그룹 이름을 지정합니다.SID_LC_ASCSINSTANCE_NUMBER_group와 같은 규칙을 사용하여 고유성을 보장할 수 있습니다. 예를 들면nw1_ASCS00_group입니다.ASCS_FILE_SYSTEM_RESOURCE: 앞에서 ASCS 파일 시스템에 정의한 클러스터 리소스의 이름을 지정합니다. 이 자리표시자 변수는 간단한 마운트 설정을 사용하는 경우 적용할 수 없습니다.ASCS_SAPSTARTSRV_RESOURCE: 이전에 ASCSsapstartsrv에 정의한 클러스터 리소스 이름을 지정합니다. 이 자리표시자 변수는 간단한 마운트 설정을 사용하는 경우에만 적용됩니다.ASCS_HEALTH_CHECK_RESOURCE: 이전에 ASCS 상태 점검에 정의한 클러스터 리소스의 이름을 지정합니다.ASCS_VIP_RESOURCE: 이전에 ASCS VIP에 정의한 클러스터 리소스 이름을 지정합니다.ASCS_INSTANCE_RESOURCE: 이전에 ASCS 인스턴스에 정의한 클러스터 리소스 이름을 지정합니다.

#crm configure group ERS_RESOURCE_GROUP ERS_FILE_SYSTEM_RESOURCE \ ERS_HEALTH_CHECK_RESOURCE ERS_VIP_RESOURCE \ ERS_INSTANCE_RESOURCE#crm configure group ERS_RESOURCE_GROUP ERS_SAPSTARTSRV_RESOURCE \ ERS_HEALTH_CHECK_RESOURCE ERS_VIP_RESOURCE \ ERS_INSTANCE_RESOURCEERS_RESOURCE_GROUP: ERS 클러스터 리소스에 고유한 그룹 이름을 지정합니다. 'SID_ERSinstance number_group'과 같은 규칙을 사용하여 고유성을 보장할 수 있습니다. 예:nw1_ERS10_groupERS_SAPSTARTSRV_RESOURCE: 이전에 ERSsapstartsrv에 정의한 클러스터 리소스 이름을 지정합니다. 이 자리표시자 변수는 간단한 마운트 설정을 사용하는 경우에만 적용됩니다.ERS_FILE_SYSTEM_RESOURCE: 이전에 ERS 파일 시스템에 정의한 클러스터 리소스 이름을 지정합니다. 이 자리표시자 변수는 간단한 마운트 설정을 사용하는 경우 적용할 수 없습니다.ERS_HEALTH_CHECK_RESOURCE: 이전에 ERS 상태 점검을 위해 정의한 클러스터 리소스의 이름을 지정합니다.ERS_VIP_RESOURCE: 이전에 ERS VIP에 정의한 클러스터 리소스 이름을 지정합니다.ERS_INSTANCE_RESOURCE: 이전에 ERS 인스턴스에 정의한 클러스터 리소스 이름을 지정합니다.

새로 만든 구성을 확인합니다.

#crm configure show type:group출력은 다음 예시와 비슷합니다.

group ERS_RESOURCE_GROUP ERS_FILE_SYSTEM_RESOURCE ERS_HEALTH_CHECK_RESOURCE ERS_VIP_RESOURCE ERS_INSTANCE_RESOURCE group ASCS_RESOURCE_GROUP ASCS_FILE_SYSTEM_RESOURCE ASCS_HEALTH_CHECK_RESOURCE ASCS_VIP_RESOURCE ASCS_INSTANCE_RESOURCE \ meta resource-stickiness=3000간단한 마운트 설정을 사용하는 경우 출력은 다음 예시와 유사합니다.

group ERS_RESOURCE_GROUP ERS_SAPSTARTSRV_RESOURCE ERS_HEALTH_CHECK_RESOURCE ERS_VIP_RESOURCE ERS_INSTANCE_RESOURCE group ASCS_RESOURCE_GROUP ASCS_SAPSTARTSRV_RESOURCE ASCS_HEALTH_CHECK_RESOURCE ASCS_VIP_RESOURCE ASCS_INSTANCE_RESOURCE

코로케이션 제약조건을 만듭니다.

ENSA1

ASCS 리소스가 ERS 리소스와 동일한 서버에서 실행되지 않도록 코로케이션 제약조건을 만듭니다.

#crm configure colocation PREVENT_SCS_ERS_COLOC -5000: ERS_RESOURCE_GROUP ASCS_RESOURCE_GROUPrunsersSID플래그가1과 동일하다고 판단하여 ERS가 실행 중인 서버로 장애 조치하도록 ASCS를 구성합니다.#crm configure location LOC_SCS_SID_FAILOVER_TO_ERS ASCS_INSTANCE_RESOURCE \ rule 2000: runs_ers_SID eq 1장애 조치가 완료된 후 ERS가 다른 서버로 이동하기 전에 ASCS가 시작되도록 구성합니다.

#crm configure order ORD_SAP_SID_FIRST_START_ASCS \ Optional: ASCS_INSTANCE_RESOURCE:start \ ERS_INSTANCE_RESOURCE:stop symmetrical=false새로 만든 구성을 확인합니다.

#crm configure show type:colocation type:location type:order다음과 비슷한 출력이 표시됩니다.

order ORD_SAP_SID_FIRST_START_ASCS Optional: ASCS_INSTANCE_RESOURCE:start ERS_INSTANCE_RESOURCE:stop symmetrical=false colocation PREVENT_SCS_ERS_COLOC -5000: ERS_RESOURCE_GROUP ASCS_RESOURCE_GROUP location LOC_SCS_SID_FAILOVER_TO_ERS ASCS_INSTANCE_RESOURCE \ rule 2000: runs_ers_SID eq 1

ENSA2

ASCS 리소스가 ERS 리소스와 동일한 서버에서 실행되지 않도록 코로케이션 제약조건을 만듭니다.

#crm configure colocation PREVENT_SCS_ERS_COLOC -5000: ERS_RESOURCE_GROUP ASCS_RESOURCE_GROUP장애 조치가 완료된 후 ERS가 다른 서버로 이동하기 전에 ASCS가 시작되도록 구성합니다.

#crm configure order ORD_SAP_SID_FIRST_START_ASCS \ Optional: ASCS_INSTANCE_RESOURCE:start \ ERS_INSTANCE_RESOURCE:stop symmetrical=false새로 만든 구성을 확인합니다.

#crm configure show type:colocation type:order다음과 비슷한 출력이 표시됩니다.

colocation PREVENT_SCS_ERS_COLOC -5000: ERS_RESOURCE_GROUP ASCS_RESOURCE_GROUP order ORD_SAP_SID_FIRST_START_ASCS Optional: ASCS_INSTANCE_RESOURCE:start ERS_INSTANCE_RESOURCE:stop symmetrical=false

유지보수 모드를 사용 중지합니다.

#crm configure property maintenance-mode="false"

클러스터 검증 및 테스트

이 섹션에서는 다음 테스트를 실행하는 방법을 보여줍니다.

- 구성 오류 검사

- ASCS 및 ERS 리소스가 장애 조치 중에 서버를 올바르게 전환하는지 확인

- 잠금이 유지되었는지 확인

- 라이브 마이그레이션으로 장애 조치가 트리거되지 않도록 Compute Engine 유지보수 이벤트 시뮬레이션

클러스터 구성 확인

두 서버 중 하나에서 루트로 리소스가 실행 중인 노드를 확인합니다.

#crm status다음 예시에서는 ASCS 리소스가

nw-ha-vm-1서버에서 실행되고 ERS 리소스가nw-ha-vm-2서버에서 실행됩니다.Cluster Summary: * Stack: corosync * Current DC: nw-ha-vm-2 (version 2.0.4+20200616.2deceaa3a-3.3.1-2.0.4+20200616.2deceaa3a) - partition with quorum * Last updated: Thu May 20 16:58:46 2021 * Last change: Thu May 20 16:57:31 2021 by ahaadm via crm_resource on nw-ha-vm-2 * 2 nodes configured * 10 resource instances configured Node List: * Online: [ nw-ha-vm-1 nw-ha-vm-2 ] Active Resources: * fencing-rsc-nw-aha-vm-1 (stonith:fence_gce): Started nw-ha-vm-2 * fencing-rsc-nw-aha-vm-2 (stonith:fence_gce): Started nw-ha-vm-1 * Resource Group: ascs-aha-rsc-group-name: * filesystem-rsc-nw-aha-ascs (ocf::heartbeat:Filesystem): Started nw-ha-vm-1 * health-check-rsc-nw-ha-ascs (ocf::heartbeat:anything): Started nw-ha-vm-1 * vip-rsc-nw-aha-ascs (ocf::heartbeat:IPaddr2): Started nw-ha-vm-1 * ascs-aha-instance-rsc-name (ocf::heartbeat:SAPInstance): Started nw-ha-vm-1 * Resource Group: ers-aha-rsc-group-name: * filesystem-rsc-nw-aha-ers (ocf::heartbeat:Filesystem): Started nw-ha-vm-2 * health-check-rsc-nw-ha-ers (ocf::heartbeat:anything): Started nw-ha-vm-2 * vip-rsc-nw-aha-ers (ocf::heartbeat:IPaddr2): Started nw-ha-vm-2 * ers-aha-instance-rsc-name (ocf::heartbeat:SAPInstance): Started nw-ha-vm-2간단한 마운트 설정을 사용하는 경우 출력은 다음 예시와 유사합니다.

Cluster Summary: * Stack: corosync * Current DC: nw-ha-vm-2 (version 2.0.4+20200616.2deceaa3a-3.3.1-2.0.4+20200616.2deceaa3a) - partition with quorum * Last updated: Thu Sep 20 19:44:26 2024 * Last change: Thu Sep 20 19:53:41 2024 by ahaadm via crm_resource on nw-ha-vm-2 * 2 nodes configured * 10 resource instances configured Node List: * Online: [ nw-ha-vm-1 nw-ha-vm-2 ] Active Resources: * fencing-rsc-nw-aha-vm-1 (stonith:fence_gce): Started nw-ha-vm-2 * fencing-rsc-nw-aha-vm-2 (stonith:fence_gce): Started nw-ha-vm-1 * Resource Group: ascs-aha-rsc-group-name: * SAPStartSrv-rsc-nw-aha-ascs (ocf::heartbeat:SAPStartSrv): Started nw-ha-vm-1 * health-check-rsc-nw-ha-ascs (ocf::heartbeat:anything): Started nw-ha-vm-1 * vip-rsc-nw-aha-ascs (ocf::heartbeat:IPaddr2): Started nw-ha-vm-1 * ascs-aha-instance-rsc-name (ocf::heartbeat:SAPInstance): Started nw-ha-vm-1 * Resource Group: ers-aha-rsc-group-name: * SAPStartSrv-rsc-nw-aha-ers (ocf::heartbeat:SAPStartSrv): Started nw-ha-vm-2 * health-check-rsc-nw-ha-ers (ocf::heartbeat:anything): Started nw-ha-vm-2 * vip-rsc-nw-aha-ers (ocf::heartbeat:IPaddr2): Started nw-ha-vm-2 * ers-aha-instance-rsc-name (ocf::heartbeat:SAPInstance): Started nw-ha-vm-2SID_LCadm사용자로 전환합니다.#su - SID_LCadm클러스터 구성을 확인합니다.

INSTANCE_NUMBER의 경우 명령어를 입력하는 서버에서 활성화된 ASCS 또는 ERS 인스턴스의 인스턴스 번호를 지정합니다.>sapcontrol -nr INSTANCE_NUMBER -function HAGetFailoverConfigHAActive는 다음 예시와 같이TRUE여야 합니다.20.05.2021 01:33:25 HAGetFailoverConfig OK HAActive: TRUE HAProductVersion: SUSE Linux Enterprise Server for SAP Applications 15 SP2 HASAPInterfaceVersion: SUSE Linux Enterprise Server for SAP Applications 15 SP2 (sap_suse_cluster_connector 3.1.2) HADocumentation: https://www.suse.com/products/sles-for-sap/resource-library/sap-best-practices/ HAActiveNode: nw-ha-vm-1 HANodes: nw-ha-vm-1, nw-ha-vm-2

SID_LCadm으로 구성에서 오류가 있는지 확인합니다.>sapcontrol -nr INSTANCE_NUMBER -function HACheckConfig다음과 비슷한 출력이 표시됩니다.

20.05.2021 01:37:19 HACheckConfig OK state, category, description, comment SUCCESS, SAP CONFIGURATION, Redundant ABAP instance configuration, 0 ABAP instances detected SUCCESS, SAP CONFIGURATION, Redundant Java instance configuration, 0 Java instances detected SUCCESS, SAP CONFIGURATION, Enqueue separation, All Enqueue server separated from application server SUCCESS, SAP CONFIGURATION, MessageServer separation, All MessageServer separated from application server SUCCESS, SAP STATE, SCS instance running, SCS instance status ok SUCCESS, SAP CONFIGURATION, SAPInstance RA sufficient version (vh-ascs-aha_AHA_00), SAPInstance includes is-ers patch SUCCESS, SAP CONFIGURATION, Enqueue replication (vh-ascs-aha_AHA_00), Enqueue replication enabled SUCCESS, SAP STATE, Enqueue replication state (vh-ascs-aha_AHA_00), Enqueue replication active

ASCS가 활성화된 서버에서

SID_LCadm으로 장애 조치를 시뮬레이션합니다.>sapcontrol -nr ASCS_INSTANCE_NUMBER -function HAFailoverToNode ""루트로,

crm_mon을 사용하여 장애 조치를 수행하면 ASCS가 다른 서버로 이동하고 ERS가 해당 서버에서 중지된 후 ASCS가 실행 중이던 서버로 ERS가 이동하는 것이 표시됩니다.

장애 조치 시뮬레이션

기본 호스트에서 장애를 시뮬레이션하여 클러스터를 테스트할 수 있습니다. 사용할 시스템을 출시하기 전에 테스트 시스템을 사용하거나 프로덕션 시스템에서 테스트를 실행합니다.

다음과 같은 다양한 방법으로 장애를 시뮬레이션할 수 있습니다.

ip link set eth0 downecho c > /proc/sysrq-trigger

이 안내에서는 장애 조치와 펜싱의 유효성을 모두 확인하므로 ip link set eth0 down을 사용하여 네트워크 인터페이스를 오프라인으로 전환합니다.

시스템을 백업합니다.

활성 SCS 인스턴스가 있는 호스트의 루트로 네트워크 인터페이스를 오프라인으로 전환합니다.

#ip link set eth0 downSSH를 사용하여 두 호스트 중 하나에 다시 연결하고 루트 사용자로 변경합니다.

crm status를 입력하여 보조 호스트를 포함했던 VM에서 지금 기본 호스트가 활성 상태임을 확인합니다. 다음 예시와 같이 클러스터에 자동으로 다시 시작이 사용 설정되어 있으므로 중지된 호스트가 다시 시작되고 보조 호스트 역할을 할당합니다.Cluster Summary: * Stack: corosync * Current DC: nw-ha-vm-2 (version 2.0.4+20200616.2deceaa3a-3.3.1-2.0.4+20200616.2deceaa3a) - partition with quorum * Last updated: Fri May 21 22:31:32 2021 * Last change: Thu May 20 20:36:36 2021 by ahaadm via crm_resource on nw-ha-vm-1 * 2 nodes configured * 10 resource instances configured Node List: * Online: [ nw-ha-vm-1 nw-ha-vm-2 ] Full List of Resources: * fencing-rsc-nw-aha-vm-1 (stonith:fence_gce): Started nw-ha-vm-2 * fencing-rsc-nw-aha-vm-2 (stonith:fence_gce): Started nw-ha-vm-1 * Resource Group: scs-aha-rsc-group-name: * filesystem-rsc-nw-aha-scs (ocf::heartbeat:Filesystem): Started nw-ha-vm-2 * health-check-rsc-nw-ha-scs (ocf::heartbeat:anything): Started nw-ha-vm-2 * vip-rsc-nw-aha-scs (ocf::heartbeat:IPaddr2): Started nw-ha-vm-2 * scs-aha-instance-rsc-name (ocf::heartbeat:SAPInstance): Started nw-ha-vm-2 * Resource Group: ers-aha-rsc-group-name: * filesystem-rsc-nw-aha-ers (ocf::heartbeat:Filesystem): Started nw-ha-vm-1 * health-check-rsc-nw-ha-ers (ocf::heartbeat:anything): Started nw-ha-vm-1 * vip-rsc-nw-aha-ers (ocf::heartbeat:IPaddr2): Started nw-ha-vm-1 * ers-aha-instance-rsc-name (ocf::heartbeat:SAPInstance): Started nw-ha-vm-1

간단한 마운트 설정을 사용하는 경우 다음과 유사한 출력이 표시됩니다.

Cluster Summary: * Stack: corosync * Current DC: nw-ha-vm-2 (version 2.0.4+20200616.2deceaa3a-3.3.1-2.0.4+20200616.2deceaa3a) - partition with quorum * Last updated: Wed Sep 26 19:10:10 2024 * Last change: Tue Sep 25 23:48:35 2024 by ahaadm via crm_resource on nw-ha-vm-1 * 2 nodes configured * 10 resource instances configured Node List: * Online: [ nw-ha-vm-1 nw-ha-vm-2 ] Full List of Resources: * fencing-rsc-nw-aha-vm-1 (stonith:fence_gce): Started nw-ha-vm-2 * fencing-rsc-nw-aha-vm-2 (stonith:fence_gce): Started nw-ha-vm-1 * Resource Group: scs-aha-rsc-group-name: * SAPStartSrv-rsc-nw-aha-scs (ocf::heartbeat:SAPStartSrv): Started nw-ha-vm-2 * health-check-rsc-nw-ha-scs (ocf::heartbeat:anything): Started nw-ha-vm-2 * vip-rsc-nw-aha-scs (ocf::heartbeat:IPaddr2): Started nw-ha-vm-2 * scs-aha-instance-rsc-name (ocf::heartbeat:SAPInstance): Started nw-ha-vm-2 * Resource Group: ers-aha-rsc-group-name: * SAPStartSrv-rsc-nw-aha-ers (ocf::heartbeat:SAPStartSrv): Started nw-ha-vm-1 * health-check-rsc-nw-ha-ers (ocf::heartbeat:anything): Started nw-ha-vm-1 * vip-rsc-nw-aha-ers (ocf::heartbeat:IPaddr2): Started nw-ha-vm-1 * ers-aha-instance-rsc-name (ocf::heartbeat:SAPInstance): Started nw-ha-vm-1

잠금 항목이 유지되는지 확인

잠금 항목이 장애 조치 중에 보존되는지 확인하려면 먼저 Enqueue Server 버전의 탭을 선택하고 절차에 따라 잠금 항목을 생성하고 장애 조치를 시뮬레이션하고 ASCS가 다시 활성화된 후에도 잠금 항목이 유지되는지 확인합니다.

ENSA1

ERS가 활성화된 서버에서

SID_LCadm으로enqt프로그램을 사용하여 잠금 항목을 생성합니다.>enqt pf=/PATH_TO_PROFILE/SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME 11 NUMBER_OF_LOCKSASCS가 활성화된 서버에서

SID_LCadm으로 잠금 항목이 등록되었는지 확인합니다.>sapcontrol -nr ASCS_INSTANCE_NUMBER -function EnqGetStatistic | grep locks_now10개의 잠금을 설정한 경우 다음 예시와 비슷한 출력이 표시됩니다.

locks_now: 10

ERS가 활성화된 서버에서

SID_LCadm으로enqt프로그램의 모니터링 함수OpCode=20을 시작합니다.>enqt pf=/PATH_TO_PROFILE/SID_ERSERS_INSTANCE_NUMBER_ERS_VIRTUAL_HOST_NAME 20 1 1 9999예를 들면 다음과 같습니다.

>enqt pf=/sapmnt/AHA/profile/AHA_ERS10_vh-ers-aha 20 1 1 9999ASCS가 활성화된 경우 서버를 재부팅합니다.

모니터링 서버에서 Pacemaker가 ERS 중지하여 다른 서버로 이동할 때 다음과 같은 출력이 표시됩니다.

Number of selected entries: 10 Number of selected entries: 10 Number of selected entries: 10 Number of selected entries: 10 Number of selected entries: 10

enqt모니터링이 중지되면Ctrl + c를 입력하여 모니터링 종료합니다.원하는 경우 두 서버 중 하나에서 루트로 클러스터 장애 조치를 모니터링합니다.

#crm_mon잠금이 유지되었음을 확인한 후