이 계획 가이드에서는 SAP 및 Google Cloud 관리자에게 SAP LT Replication Server와 함께 SAP용 BigQuery 커넥터의 버전 2.9 (최신)를 사용하여 SAP 데이터를 BigQuery로 복제하는 작업을 계획할 때 필요한 정보를 제공합니다.

이 가이드에는 다음 주제가 포함되어 있습니다.

BigQuery의 SAP 데이터 모델링을 위한 솔루션 가속기에 대한 자세한 내용은 Google Cloud Cortex Framework를 참고하세요.

소프트웨어 요구사항

이 섹션에서는 SAP용 BigQuery 커넥터의 소프트웨어 요구사항을 설명합니다.

SAP용 BigQuery 커넥터를 Google Cloud, 온프레미스 또는 AWS, Azure 등의 퍼블릭 클라우드의 SAP LT Replication Server에 설치할 수 있습니다.

SAP 소프트웨어 버전 요구사항

SAP LT Replication Server와 SAP 소스 시스템의 필수 버전은 SAP LT Replication Server를 독립형 아키텍처의 자체 서버 또는 임베디드 아키텍처의 소스 ABAP 애플리케이션 시스템에 설치하는지 여부에 따라 달라집니다.

SAP 소프트웨어 요구사항은 데이터 소스로 사용하는 SAP 시스템(SAP S/4HANA 또는 SAP ECC)에 따라서도 달라집니다.

Google Cloud 에서 SAP용 BigQuery 커넥터를 지원하는 SAP 소프트웨어 버전을 확인하려면 SAP 소스 시스템에 해당하는 탭을 선택합니다.

S/4HANA

| 설치 아키텍처 | 시스템 | 지원되는 버전 | 사용자 인터페이스(UI) 부가기능 |

|---|---|---|---|

| 독립형 | 소스 시스템 |

|

SAP에서 권장하는 대로 UI 부가기능이 SAP NetWeaver 버전과 호환되는 최신 버전인지 확인합니다. /UI2/CL_JSON: PL12 이상. UI 부가기능의 최소 필수 버전에 대한 자세한 내용은 SAP Note 22798102 - /UI2/CL_JSON 수정 - PL12의 '지원 패키지' 섹션을 참고하세요. SAP NetWeaver와의 UI 부가기능 호환성에 대한 자세한 내용은 다음을 참고하세요. |

| SAP LT Replication Server 시스템 |

|

||

| 임베디드 | 소스 시스템 |

|

ECC

| 설치 아키텍처 | 시스템 | 지원되는 버전 | 사용자 인터페이스(UI) 부가기능 |

|---|---|---|---|

| 독립형 | 소스 시스템 |

|

SAP에서 권장하는 대로 UI 부가기능이 SAP NetWeaver 버전과 호환되는 최신 버전인지 확인합니다. /UI2/CL_JSON: PL12 이상. UI 부가기능의 최소 필수 버전에 대한 자세한 내용은 SAP Note 22798102 - /UI2/CL_JSON 수정 - PL12의 '지원 패키지' 섹션을 참고하세요. SAP NetWeaver와의 UI 부가기능 호환성에 대한 자세한 내용은 다음을 참고하세요. |

| SAP LT Replication Server 시스템 |

|

||

| 임베디드 | 소스 시스템 |

|

운영체제 요구사항

SAP용 BigQuery 커넥터는 SAP LT Replication Server에서 지원되는 모든 운영체제를 지원합니다.

SAP LT Replication Server가 지원하는 운영체제에 대한 상세 설명은 SAP 제품 지원 여부 표를 참조하세요.

Cloud Billing 계정 요구사항

SAP용 BigQuery 커넥터는 무료로 제공되지만 설치 패키지를 받으려면 Cloud Billing 계정이 필요합니다.

확장성

델타가 수백만 개 있는 수십억 개의 데이터 레코드와 같은 대용량 볼륨의 경우 SAP용 BigQuery 커넥터에서 SAP LT Replication Server 확장 및 파티션 나누기 함수를 사용하여 대규모 데이터 추출을 병렬 처리합니다. 자세한 내용은 SAP 도움말 포털에서 사용하는 버전의 SAP LT Replication Server에 대한 크기 조정 가이드를 참조하세요.

Google Cloud 측에서는 복제 경로에 따라 SAP용 BigQuery 커넥터가 다양한 Google Cloud 서비스를 사용하여 데이터 로드를 확장합니다.

- Pub/Sub를 통한 CDC 복제의 경우 SAP용 BigQuery 커넥터는 Pub/Sub API와 Storage Write API를 사용합니다.

- 스트리밍 데이터 복제의 경우 SAP용 BigQuery 커넥터는 BigQuery 스트리밍 API를 사용합니다.

지원되는 복제 소스

SAP용 BigQuery 커넥터는 SAP LT Replication Server에서 지원되는 일반적으로 사용되는 대부분의 애플리케이션 및 데이터베이스 소스 시스템을 지원합니다.

지원되는 SAP 애플리케이션 소스

SAP LT Replication Server에서 지원하는 SAP 애플리케이션 소스의 데이터를 복제할 수 있습니다. SAP용 BigQuery 커넥터는 기존 애플리케이션뿐 아니라 유지보수 중인 주요 엔터프라이즈 애플리케이션 버전을 데이터 소스로 지원합니다. 지원되는 SAP 애플리케이션 중 일부를 소개하자면 다음과 같습니다.

- SAP Business Suite 7

- S/4HANA

- SAP NetWeaver에서 실행되는 SAP 애플리케이션

SAP Business Warehouse의 데이터를 복제할 때는 SAP LT Replication Server를 사용하지 않는 것이 좋습니다. SAP에서 제공하는 자세한 내용은 SAP Note 2525755를 참고하세요.

S/4HANA Cloud, SAP Ariba, SAP SuccessFactors와 같은 SAP Cloud 애플리케이션은 지원되지 않습니다.

지원되는 데이터 소스

투명 테이블이나 클러스터 테이블만 복제할 수 있습니다.

SAP용 BigQuery 커넥터에서는 복제 SAP Core Data Services(CDS) 뷰를 지원하지 않습니다.

정보 설계 도구에서 BigQuery는 SAP BusinessObjects 비즈니스 인텔리전스 4.3부터 데이터 소스로 지원됩니다. SAP BusinessObjects Web Intelligence 및 SAP Crystal Reports for Enterprise와 같은 SAP BusinessObjects 보고 도구에서 BigQuery에 저장된 데이터를 쿼리할 수 있습니다.

호환성에 대한 자세한 내용은 SAP Note 2750723 - SAP BI 플랫폼 제품에서 Google BigQuery 지원을 확인하세요.

보안

SAP LT Replication Server에서 BigQuery로의 데이터 복제를 위한 보안을 구현할 때는 SAP LT Replication Server, SAP LT Replication Server 호스트 운영체제,Google Cloud에서 보안 제어를 구현해야 합니다.

SAP용 BigQuery 커넥터와 BigQuery 간의 통신을 위해 SAP용 BigQuery 커넥터에서는 엔드 투 엔드 HTTPS 통신 및 SSL을 사용합니다.

SAP 보안

SAP LT Replication Server에서 SAP용 BigQuery 커넥터를 구성하고 작업할 수 있는 사용자를 제어하려면 표준 SAP 역할 기반 승인을 사용합니다.

SAP용 BigQuery 커넥터는 전송 설치 과정에서 승인 객체 ZGOOG_MTID를 제공합니다.

SAP용 BigQuery 커넥터를 사용하는 데이터 복제 작업을 구성하고 실행하려면 SAP용 BigQuery 커넥터에 대한 SAP 역할 및 승인 만들기에 설명된 대로 SAP LT Replication Server 내에서 관리 액세스 권한이 있는 역할을 정의하면 됩니다.

예를 들어 모든 SAP 승인이 포함된 ZGOOGLE_BIGQUERY_ADMIN이라는 역할과 SAP용 BigQuery 커넥터를 사용해 BigQuery에 대한 데이터 복제를 구성 및 운영하는 데 필요한 ZGOOG_MTID 승인을 정의할 수 있습니다.

역할 및 승인에 대한 SAP의 추가 정보는 SAP 도움말 포털에서 SAP LT Replication Server 버전에 대한 보안 가이드를 참조하세요.

Google Cloud 보안

SAP용 BigQuery 커넥터에서 Google Cloud 보안을 구현하려면 다음 보안 제어를 사용하면 됩니다.

- Identity and Access Management(IAM) 권한, 역할, 서비스 계정, 키

- 데이터 세트 또는 테이블 수준에서 설정된 BigQuery 제어

- BigQuery와 같은 API 기반 서비스를 위한 Virtual Private Cloud(VPC) 서비스 제어

- VPC 네트워크에서 BigQuery와 같은 서비스의 비공개 소비를 허용하는 Private Service Connect 엔드포인트

Google Cloud ID 및 액세스 관리

SAP용 BigQuery 커넥터 인증 및 승인을 위해서는Google Cloud 프로젝트에서 BigQuery 데이터 세트가 포함된 IAM 서비스 계정이 필요합니다.

Google Cloud 리소스와 상호작용하도록 승인하려면 BigQuery 및 Pub/Sub 서비스와 상호작용할 수 있는 권한이 포함된 역할을 서비스 계정에 부여합니다.

데이터 스트리밍 복제 (삽입 전용)의 경우 SAP용 BigQuery 커넥터가 BigQuery에 액세스하는 데 필요한 권한은 다음 IAM 역할에 포함되어 있습니다.

변경 데이터 캡처 (CDC) 복제의 경우 SAP용 BigQuery 커넥터가 Pub/Sub 및 BigQuery에 액세스하는 데 필요한 권한은 다음 IAM 역할에 포함되어 있습니다.

SAP LT Replication Server가 Compute Engine VM에서 실행되는 경우 호스트 VM의 서비스 계정에 서비스 계정 토큰 생성자 역할도 부여해야 합니다.

SAP LT Replication Server가 온프레미스 또는 다른 클라우드 플랫폼에서 실행되는 경우에는 서비스 계정을 만드는 것 외에도 SAP용 BigQuery 커넥터에 대해 서비스 계정 키를 만들어야 합니다. SAP 관리자가 SAP LT Replication Server 호스트에 키를 설치합니다. SAP용 BigQuery 커넥터가 Pub/Sub 또는 BigQuery에 연결될 때 SAP LT Replication Server는 서비스 계정 키를 사용해서Google Cloud에 인증을 수행합니다.

SAP LT Replication Server가 Google Cloud에서 실행되는 경우에는 서비스 계정 키가 필요하지 않습니다.

IAM, 서비스 계정, 역할, 권한에 대한 상세 설명은 다음을 참조하세요.

BigQuery 데이터 세트 및 테이블 액세스 제어

IAM 제어 외에도 BigQuery를 사용하여 액세스를 제어할 수 있습니다. SAP용 BigQuery 커넥터의 경우 데이터 세트 및 테이블에 액세스 제어를 설정할 수 있습니다.

자세한 내용은 다음을 참고하세요.

VPC 서비스 제어

Google Cloud에서는 BigQuery와의 API 기반 상호작용에 VPC 방화벽 규칙이 적용되지 않습니다. 대신 Virtual Private Cloud (VPC) 서비스 제어를 사용하여 트래픽을 제한할 수 있습니다.

SAP 워크로드가 Google Cloud에서 실행되는 경우 서비스 경계를 정의하여 VPC 서비스 제어를 구현할 수 있습니다. 자세한 내용은 서비스 경계를 참고하세요.

SAP 워크로드가 Google Cloud에서 실행되지 않는 경우 온프레미스 호스트의 비공개 Google 액세스 설정 과정에서 VPC 서비스 제어를 구현할 수 있습니다.

BigQuery의 네트워크 보안에 대한 상세 설명은 네트워크 보안을 참조하세요.

Private Service Connect 엔드포인트

BigQuery와 같은 Google 관리형 서비스의 비공개 소비를 허용하는 엔드포인트를 VPC 네트워크에 설정하려면 Private Service Connect를 사용하면 됩니다.

Private Service Connect를 사용하면 VPC CIDR 범위의 내부 IP 주소를 사용하여 Google API 및 서비스에 액세스하는 비공개 엔드포인트를 만들 수 있습니다. Private Service Connect를 사용하여 BigQuery 스트리밍 API의 맞춤 비공개 DNS 이름을 만들 수도 있습니다. 자세한 내용은 Private Service Connect를 참조하세요.

Google Cloud외부 호스트에서 실행되는 SAP용 BigQuery 커넥터의 경우 Private Service Connect가 지원되지 않습니다.

Google Cloud 보안에 관한 자세한 정보

보안 계정, 역할, 권한에 대한 상세 설명은 다음을 참조하세요.

네트워킹

BigQuery로 복제할 때 사용할 네트워크 경로를 계획할 때는 다음 사항을 고려하세요.

- 대역폭

- 지연 시간과 지연 시간이 SAP LT Replication Server 호스트의 리소스 소비에 미치는 영향

- 데이터 볼륨과 데이터 볼륨이 기존 네트워크 부하에 미치는 영향

- SAP 워크로드가 Google Cloud에서 실행되지 않는 경우에 사용할 연결 유형(Cloud Interconnect 또는 Cloud VPN)

Google Cloud에 연결

SAP 시스템이 Google Cloud 에서 실행되지 않고 SAP 시스템과 Google Cloud가 아직 연결되지 않은 경우 연결을 설정하고 Google Cloud API에 대한 비공개 액세스를 구성해야 합니다.

Cloud Interconnect 또는 Cloud VPN을 사용하여 Google Cloud 에 연결을 설정할 수 있습니다.

Cloud Interconnect는 일반적으로 Cloud VPN보다 높은 대역폭, 낮은 지연 시간, 낮은 네트워크 경합을 제공합니다. 성능에 민감한 대량 복제 작업의 경우 Google Cloud SAP용 BigQuery 커넥터에 대해 Cloud Interconnect를 사용하는 것이 좋습니다.

Cloud VPN을 사용하면 복제 데이터가 공개 인터넷을 통해 이동하므로 네트워크 경합이 발생할 가능성이 낮고 일반적으로 지연 시간이 증가합니다.

선택한 연결 옵션에 관계없이 연결에서 지원할 것으로 예상되는 모든 트래픽을 검토해야 합니다. 연결의 대역폭과 네트워크 속도가 복제 작업과 기타 워크로드를 부작용 없이 지원하기에 충분한지 확인합니다.

느린 연결 속도로 인해 리소스 작업이 완료되는 데 걸리는 시간이 늘어나면서 복제에 필요한 리소스가 장기간 연결된 상태로 유지되어 SAP 소스 서버와 SAP LT Replication Server 호스트 모두에서 리소스 소비가 증가할 수 있습니다.

연결 옵션에 대한 자세한 내용은 다음을 참고하세요.

프록시 서버를 사용하여 HTTP 요청을 Google Cloud에 보내려면 트랜잭션 SM59에 정의된 RFC 대상을 사용하는 것이 좋습니다.

RFC 대상

SAP용 BigQuery 커넥터의 전송 파일에는 SM59 트랜잭션에 있는 다음 샘플 RFC 대상이 포함됩니다. 이러한 RFC 대상은 외부 서버(유형 G)에 대한 HTTP 연결이며 해당 서비스의 공개 API 엔드포인트에 연결됩니다.

| 샘플 RFC 대상 이름 | 대상 호스트(API 엔드포인트) | 참고 |

|---|---|---|

GOOG_BIGQUERY |

https://bigquery.googleapis.com |

이 RFC 대상은 BigQuery API를 타겟팅합니다. |

GOOG_PUBSUB |

https://pubsub.googleapis.com |

이 RFC 대상은 Pub/Sub API를 타겟팅합니다. |

GOOG_IAMCREDENTIALS |

https://iamcredentials.googleapis.com |

이 RFC 대상은 IAM API를 타겟팅합니다. |

GOOG_OAUTH2_TOKEN |

https://googleapis.com/oauth2 |

이 RFC 대상은 OAuth 2.0 기반 인증을 위해 Google Cloud 엔드포인트를 타겟팅합니다. 이것은 JSON 웹 토큰 (JWT)을 사용하여 Google Cloud 에 인증하려는 경우에만 Google Cloud 외부에서 실행되는 SAP 워크로드에 사용합니다. |

RFC 대상을 사용하여 Google Cloud 에 연결하면 다음과 같은 이점이 있습니다.

SAP 환경에서 프록시 서버를 사용하고 동일한 프록시 서버를 사용하여 Google Cloud에 HTTP 요청을 보내려면 RFC 대상에서 프록시 서버를 구성하면 됩니다.

Private Service Connect 엔드포인트를 통해 Google Cloud API 및 서비스에 액세스하려면Google Cloud 프로젝트에서 해당 엔드포인트를 만든 다음 RFC 대상에 엔드포인트를 지정할 수 있습니다.

HTTP 압축을 사용할 수 있습니다. 이때Google Cloud 는 리전 간 복제를 권장하며, 여기서 SAP 소스 시스템과 BigQuery 데이터 세트는 서로 다른 Compute Engine 리전에 배치됩니다.

RFC 대상을 사용하여 Google Cloud API 또는 서비스에 연결하려면 RFC 대상을 /GOOG/CLIENT_KEY 테이블에 매핑하는 항목을 /GOOG/SERVIC_MAP 테이블에 만들어야 합니다. 구성 단계는 시나리오에 대한 SAP용 BigQuery 커넥터 설치 및 구성 가이드를 참조하세요.

HTTP 압축

RFC 대상을 사용하여 SAP용 BigQuery 커넥터와 Google Cloud API 간의 연결을 설정하는 경우 압축 옵션을 사용하여 HTTP 요청 본문을 압축할 수 있습니다. HTTP 압축은 HTTP 1.1을 사용하도록 RFC 대상을 구성할 때만 사용할 수 있습니다.

프로덕션 환경에서 HTTP 압축을 사용 설정하기 전에 HTTP 압축에 영향을 주는 프로필 매개변수를 테스트 환경에서 분석합니다. SAP에서 제공하는 자세한 내용은 SAP Note 1037677 - HTTP 압축은 특정 문서만 압축을 참조하세요.

대역폭

SAP LT Replication Server와Google Cloud 간의 네트워크 연결에 필요한 속도로 데이터 볼륨을 지원할 수 있는 충분한 대역폭이 있는지 확인합니다.

네트워크 연결 속도가 느리면 데이터 복제 지연 시간이 늘어나 소스 SAP 시스템에서 복제에 사용되는 리소스가 증가합니다.

생산적인 설치를 위해 Google Cloud Cloud Interconnect 연결을 권장합니다. Cloud VPN도 사용할 수 있습니다.

지연 시간

네트워크 연결의 지연 시간을 줄이려면 SAP LT Replication Server 시스템 및 SAP 소스 시스템과 최대한 가까운 위치에 대상 BigQuery 데이터 세트를 만드세요. 소스 SAP 시스템이 Google Cloud에서 실행되는 경우 소스 SAP 시스템과 동일한 Google Cloud 리전에 BigQuery 데이터 세트를 만드는 게 좋습니다.

프로덕션 환경으로 설치를 마이그레이션하기 전에 지연 시간을 테스트하세요.

네트워크 성능에 대한 상세 설명은 네트워크 연결 성능을 참조하세요.

네트워크 액세스 제어

SAP LT Replication Server와 Google Cloud간의 연결 양측에서 네트워크 액세스 제어를 구현할 수 있습니다.

Google Cloud 네트워크 액세스 제어

SAP용 BigQuery 커넥터는 Google CloudVPC 방화벽 규칙이 적용되지 않는 API 엔드포인트를 통해 BigQuery와 통신합니다.

대신 VPC 서비스 제어를 사용하여 트래픽을 제한하세요.

BigQuery의 네트워크 보안에 대한 상세 설명은 네트워크 보안을 참조하세요.

SAP LT Replication Server 호스트 네트워크 액세스 제어

SAP LT Replication Server 호스트에서 방화벽 또는 프록시가 서버에서 BigQuery 및 Pub/Sub API 엔드포인트로 이그레스 트래픽을 허용하도록 유의해야 합니다. 특히 SAP LT Replication Server가 다음 Google Cloud API에 액세스할 수 있는지 확인합니다.

https://bigquery.googleapis.comhttps://pubsub.googleapis.comhttps://iamcredentials.googleapis.com

Private Service Connect 엔드포인트를 사용하여 BigQuery 및 Pub/Sub API에 액세스하려면 /GOOG/SERVIC_MAP 테이블에서 Private Service Connect 엔드포인트를 구성해야 합니다.

성능 계획

SAP LT Replication Server와 BigQuery 간의 초기 로드 및 복제 작업 성능은 복제 경로의 여러 지점에서 다양한 요인의 영향을 받습니다.

그러나 SAP LT Replication Server와 BigQuery 데이터 세트 간의 거리 또는 Google Cloud연결 대역폭과 같은 특정한 기본 요소가 대부분의 다른 요소보다 성능에 더 큰 영향을 미칩니다.

일반 성능 권장사항

최고의 성능을 위해 다음 권장사항을 SAP LT Replication Server 구성에 적용하세요.

- SAP 소스 시스템 및 SAP LT Replication Server를 포함하는 SAP 워크로드를 Google Cloud에서 실행합니다.

- SAP 워크로드가 Google Cloud에 있는 경우 SAP 워크로드와 동일한 리전에 BigQuery 데이터 세트를 만듭니다.

- Google Cloud에서 SAP 워크로드를 실행할 수 없는 경우 다음 안내를 따르세요.

- SAP 워크로드와 가장 가까운 Google Cloud리전에 BigQuery 데이터 세트를 만듭니다.

- Cloud Interconnect를 사용하여 Google Cloud 에 연결합니다.

- 리소스 경합을 막기 위해 SAP 소스 시스템과 SAP LT Replication Server에 별도의 전용 호스트를 사용합니다.

- SAP 도움말 포털에서 SAP LT Replication Server 버전에 대한 크기 조정 가이드에 따라 SAP LT Replication Server 시스템을 워크로드에 맞는 최적의 크기로 조정합니다.

- 다음과 같은 SAP LT Replication Server 복제 설정을 사용합니다.

- 병렬 작업

- 읽기 유형 1(가능한 경우) 자세한 내용은 성능 및 LTRS 고급 복제 설정을 참조하세요.

- 다음을 사용한 SAP용 BigQuery 커넥터 구성

- 기본 레코드 압축

- 기본 청크 크기

- 필드를 BigQuery 테이블에 매핑할 때 가능하다면 커스텀 이름을 사용하지 마세요.

자세한 내용은 다음을 참고하세요.

성능에 영향을 줄 수 있는 추가 특성

구성 및 데이터의 여러 특성이 성능에 영향을 줄 수 있습니다. 이러한 특성 중 일부는 수정이 불가능합니다. 이러한 특성은 다음과 같습니다.

- 소스 서버:

- CPU 수

- 메모리 양

- SAP HANA, SAP ASE, IBM Db2 등 사용되는 데이터베이스

- 소스 테이블의 열 수

- 각 레코드에 보존된 데이터 양

- 필드 이름 길이와 같은 테이블 메타데이터

- 대화상자 작업 프로세스 수

- SAP LT Replication Server:

- CPU 수

- 메모리 양

- 호스트가 실행 중일 수 있는 다른 워크로드

- SAP 대화상자 및 백그라운드 작업 프로세스

- SAP LT Replication Server 설치 아키텍처의 유형. 자세한 내용은 SAP LT Replication Server의 독립형(권장) 또는 임베디드 설치를 참조하세요.

- SAP LT Replication Server 시스템에서 실행 중인 백그라운드 작업 수

LTRC트랜잭션의 관리 탭에서 대량 전송에 할당된 백그라운드 작업 수- 읽기 유형 및 부분 크기를 포함한

LTRS트랜잭션 성능 설정

- BigQuery 복제 구성(

/GOOG/SLT_SETTINGS트랜잭션):- 대상 필드에 커스텀 이름이 지정되었는지 여부 (대상 BigQuery 필드 이름을 처리하면 성능에 약간의 영향을 미칠 수 있습니다.)

- 레코드 압축 사용 설정 여부

- 전송된 HTTP 요청의 총 개수에 영향을 줄 수 있는 청크 크기

SAP LT Replication Server 성능 고려사항

다음 섹션에서는 SAP LT Replication Server 구성과 관련된 성능 옵션에 대해 설명합니다.

성능 및 SAP LT Replication Server 설치 아키텍처

SAP LT Replication Server가 자체 전용 서버에 설치되는 독립형 아키텍처는 일반적으로 SAP LT Replication Server가 소스 시스템과 동일한 서버에 설치되는 임베디드 아키텍처보다 우수한 성능을 제공합니다.

임베디드 아키텍처에서는 SAP LT Replication Server가 SAP 소스 시스템과 서버 리소스를 공유해야 합니다.

독립형 아키텍처에서도 호스트의 CPU와 메모리는 물론 서버에서 실행 중인 다른 워크로드가 SAP LT Replication Server 인스턴스의 성능에 영향을 줄 수 있습니다.

성능 및 LTRS 고급 복제 설정

초기 로드 및 복제 성능은 고급 복제 설정에서 LTRS 트랜잭션의 소스 테이블에 지정한 설정의 영향을 받습니다.

특히 대용량 초기 로드 또는 복제 최적화를 위한 성능 조정에 대한 안내는 SAP 도움말 포털에서 SAP LT Replication Server 성능 최적화 가이드를 참조하세요.

Google Cloud 에서는 트랜잭션 LTRS의 고급 복제 설정 > 일반 성능 섹션에서 다음 사양을 사용하는 것이 좋습니다.

일반적인 테이블 유형의 초기 로드에서는 1 범위 계산을 읽기 유형으로 지정합니다. 1 범위 계산을 사용하기에 너무 큰 테이블의 경우 읽기 유형 5를 지정합니다.

복제의 경우 활성 설정에서 다음 안내를 따르세요.

- 가장 빠른 복제를 원하는 경우 자동 범위를 지정합니다.

- 보다 안정적인 복제를 원한다면 범위 없음을 지정합니다.

다음 표는 몇 가지 일반적인 시나리오의 설정을 보여줍니다.

| 테이블 유형 | 권장 읽기 유형 |

|---|---|

| 투명성(소형~중간) | 읽기 유형 1 - 범위 계산 |

| 투명(대형) | 읽기 유형 1이 적합하지 않은 경우에만 읽기 유형 5 - 범위 계산 |

| 클러스터 테이블 | 읽기 유형 4 - 발신자 큐 |

네트워크 연결 성능

SAP LT Replication Server 시스템과 Google Cloud 간 연결의 대역폭과 지연 시간이 BigQuery에 대한 전체적인 복제 성능에 영향을 줄 수 있습니다.

BigQuery에서 복제 확인을 수신하는 데 시간이 많이 걸릴수록 SAP LT Replication Server와 소스 시스템에서 호스트 리소스를 더 오랫동안 보존하기 때문에 복제 속도뿐 아니라 SAP LT Replication Server와 소스 시스템에서 소비되는 리소스 양에도 영향을 미칩니다.

SAP 워크로드가 온프레미스 또는 다른 클라우드 제공업체에서 실행되는 경우 공개 인터넷에서 트래픽과 경합할 필요 없이 높은 대역폭과 짧은 지연 시간을 제공하는 Cloud Interconnect 연결을 사용하는 것이Google Cloud 좋습니다.

Cloud VPN을 사용하여 Google Cloud 및 BigQuery에 연결할 수 있지만 VPN 연결에서는 복제가 일반 인터넷 트래픽과 경합해야 합니다.

SAP 워크로드가 Google Cloud에서 실행되는 경우 Google Cloud는 SAP LT Replication Server와 BigQuery 데이터 세트를 같은 리전에 배치하는 것이 좋습니다. SAP LT Replication Server와 BigQuery가 서로 다른 리전에 있으면 일반적으로 지연 시간이 길어지고 성능이 저하됩니다. 리전 선택에 대한 자세한 내용은 리전 및 영역 선택을 참고하세요.

데이터 전송

보통은 전체 HTTP 요청 수와 관련 처리 오버헤드를 줄이기 위해 각 HTTP 요청에 최대한 많은 데이터를 전송하려고 합니다.

하지만 특정 테이블의 레코드 크기 또는 Pub/Sub 또는 BigQuery의 할당량 또는 기타 한도 도달로 인해 전송되는 데이터의 양을 줄여야 하는 경우도 있습니다.

다음 방법으로 각 요청에 전송되는 데이터 양을 제어할 수 있습니다.

- SAP LT Replication Server가 SAP용 BigQuery 커넥터로 전송하는 데이터 양(부분 크기)을 조정합니다.

- SAP용 BigQuery 커넥터가 BigQuery로 보내는 데이터 양(청크 크기)을 조정합니다.

- BigQuery 프로젝트의 스트리밍 삽입 할당량을 조정합니다.

SAP LT Replication Server에서 전송되는 데이터 양 조정

SAP LT Replication Server는 레코드를 소스 시스템에서 SAP용 BigQuery 커넥터로 부분으로 전송합니다. 완료될 때까지 각 부분은 서버 리소스를 소비하는 별도의 로드 또는 복제 작업으로 처리됩니다.

일반적으로 SAP LT Replication Server의 부분 크기를 늘릴 때는 SAP LT Replication Server 프로세스의 수를 줄여 관련 오버헤드를 낮춥니다.

부분 크기 및 청크 크기

SAP LT Replication Server의 부분 크기는 바이트 또는 바이트 및 레코드의 곱으로 설정됩니다. SAP용 BigQuery 커넥터의 청크 크기는 포함 가능한 레코드 수에 따라 조정됩니다. 청크의 바이트 크기는 레코드의 필드 수와 각 레코드에 보존되는 데이터 양을 비롯한 여러 요소에 따라 달라집니다.

SAP LT Replication Server 부분 크기가 SAP용 BigQuery 커넥터 청크 크기보다 큰 경우, SAP용 BigQuery 커넥터는 해당 부분의 모든 레코드가 전송될 때까지 각 부분의 여러 청크를 전송합니다.

부분 크기가 청크 크기보다 작으면 SAP용 BigQuery 커넥터에서 부분당 하나의 청크만 전송합니다. SAP용 BigQuery 커넥터에 설정된 청크 크기에 관계없이 각 청크에는 각 부분에서 전송된 레코드 수만 포함됩니다.

SAP용 BigQuery 커넥터가 각 HTTP 요청에서 바이트 수에 대한 Pub/Sub 또는 BigQuery 한도를 초과하지 않는 최대한 큰 청크를 만들 수 있도록 SAP LT Replication Server에서 부분 크기를 설정하는 것이 이상적입니다.

청크 크기 지정에 대한 상세 설명은 SAP용 BigQuery 커넥터의 청크 크기를 참조하세요.

SAP LT Replication Server의 부분 크기

SAP LT Replication Server가 사용하는 기본 부분 크기를 변경하려면 LTRS 트랜잭션을 실행하고 성능 옵션의 고급 복제 설정에서 패키지 크기 필드의 값을 조정합니다.

자세한 내용은 SAP 도움말 포털에서 SAP LT Replication Server 성능 최적화 가이드를 참조하세요.

SAP용 BigQuery 커넥터의 청크 크기

SAP용 BigQuery 커넥터는 BigQuery에 데이터를 레코드 청크로 전송합니다.

Pub/Sub를 통한 CDC 복제의 경우 SAP용 BigQuery 커넥터에 기본 청크 크기(레코드 1,000개)를 사용하는 것이 좋습니다. Pub/Sub에서 허용하는 최대 레코드 수입니다.

스트리밍 데이터 복제의 경우 SAP용 BigQuery 커넥터에 기본 청크 크기(레코드 10,000개)를 사용하는 것이 좋습니다. 하지만 소스 테이블의 레코드에 매우 적은 수의 필드가 포함되어 있거나 필드에 매우 작은 크기의 데이터 값이 포함되어 있으면 BigQuery가 허용하는 최대 청크 크기(레코드 50,000개)까지 더 큰 청크 크기를 사용할 수 있습니다.

지정된 청크의 레코드 수가 HTTP 요청의 바이트 크기에 대한 허용된 한도를 초과하는 바이트 크기로 확인되면 quotaExceeded 오류 또는 invalid 오류가 발생합니다.

소스 테이블의 레코드에 많은 필드가 포함되거나 필드에 많은 데이터가 포함된 경우에 이러한 문제가 발생할 수 있습니다.

청크 크기와 관련된 오류가 발생하면 해당 테이블의 대량 전송 구성에 지정된 청크 크기를 줄여보세요. 또는 청크 크기를 자동으로 조정하도록 해당 테이블의 동적 청크 크기를 사용 설정할 수 있습니다. 자세한 내용은 동적 청크 크기 조정을 참조하세요.

동적 청크 크기를 사용 설정하지 않았으면 MSEG, ACDOCA, MATDOC와 같이 레코드당 필드 수가 많은 대규모 레코드를 포함할 수 있는 SAP 소스 테이블의 경우, 청크 크기를 더 낮게 지정해야 할 수 있습니다.

/GOOG/SLT_SETTINGS 트랜잭션을 실행하여 청크 크기를 지정할 수 있습니다. 청크 크기는 테이블 속성 화면의 청크 크기 필드에 지정됩니다.

청크 크기 지정에 대한 상세 설명은 다음을 참조하세요.

- Pub/Sub을 통한 CDC 복제의 경우 테이블 만들기 및 기타 일반 속성 지정을 참고하세요.

- 스트리밍 데이터 복제의 경우 테이블 만들기 및 기타 일반 속성 지정을 참고하세요.

BigQuery 오류 메시지에 대한 상세 설명은 오류 메시지를 참조하세요.

부분 전송과 관련된 처리 오버헤드

전송되는 각 부분은 다음 작업을 트리거하며, 그로 인해 처리 오버헤드 또는 리소스 소비가 발생합니다.

- 소스 시스템의 로깅 테이블에 있는 변경된 레코드 모음이 SAP LT Replication Server에 단일 부분으로 전송됩니다. 아직은 변경된 레코드가 로깅 테이블에서 삭제되지 않습니다.

- SAP LT Replication Server가 Google Cloud에 새 액세스 토큰을 요청합니다.

- SAP용 BigQuery 커넥터가 Google Cloud에 HTTP 요청을 보내 대상 테이블의 구조를 확인합니다.

- SAP용 BigQuery 커넥터는 단일 부분에서 수신한 모든 레코드를 전송하는 데 필요한 만큼 많은 청크에서 Google Cloud로 레코드를 전송합니다. 각 청크는 별도의 HTTP 요청으로 전송됩니다.

- Google Cloud 는 수신된 각 청크를 처리합니다.

- 청크마다 HTTP

OK상태 코드가 SAP LT Replication Server에 반환됩니다. - Google Cloud 가 모든 레코드를 수신한 후 SAP LT Replication Server가 로깅 테이블에서 전송된 레코드를 삭제하여 최종적으로 소스 시스템의 리소스를 확보합니다.

부분 및 성능을 위한 SAP LT Replication Server 구성에 대한 상세 설명은 SAP 도움말 포털에서 SAP LT Replication Server 성능 최적화 가이드를 참조하세요.

BigQuery 할당량

프로젝트에 적용되는 BigQuery 스트리밍 API 할당량은 일정 시간 동안 및 단일 HTTP 요청에서 BigQuery로 스트리밍할 수 있는 데이터 양을 제한합니다.

예를 들어 BigQuery는 다음과 같이 측정항목에 대해 한도를 설정합니다.

- 전송할 수 있는 프로젝트별 초당 바이트 수

- 단일 HTTP 요청으로 전송할 수 있는 최대 레코드 또는 행 수

- 전송할 수 있는 HTTP 요청의 최대 크기

스트리밍 삽입의 경우 BigQuery는 HTTP 요청 크기를 10MB로 수정하고 단일 HTTP 요청으로 전송할 수 있는 레코드 수를 50,000개로 수정합니다.

대부분의 경우 할당량을 변경할 수 있지만 한도는 변경할 수 없습니다.

Google Cloud 콘솔의 할당량 페이지에서 프로젝트에 적용되는 할당량을 확인하고 수정할 수 있습니다.

스트리밍 삽입과 관련된 BigQuery 할당량 및 한도에 대한 상세 설명은 다음을 참조하세요.

Pub/Sub 할당량

프로젝트에 적용되는 Pub/Sub API 할당량은 일정 시간 동안 및 단일 HTTP 요청에서 BigQuery로 스트리밍할 수 있는 데이터 양을 제한합니다.

예를 들어 Pub/Sub는 다음과 같이 측정항목에 대해 한도를 설정합니다.

- 전송할 수 있는 프로젝트별 초당 바이트 수

- 단일 HTTP 요청으로 전송할 수 있는 최대 레코드 또는 행 수

- 전송할 수 있는 HTTP 요청의 최대 크기

CDC 데이터의 경우 Pub/Sub는 HTTP 요청 크기를 10MB로 수정하고 단일 HTTP 요청으로 전송할 수 있는 레코드 수를 1,000개로 수정합니다.

대부분의 경우 할당량을 변경할 수 있지만 한도는 변경할 수 없습니다.

Google Cloud 콘솔의 할당량 페이지에서 프로젝트에 적용되는 할당량을 확인하고 수정할 수 있습니다.

Pub/Sub 할당량 및 리소스 한도에 대한 자세한 내용은 다음을 참고하세요.

레코드 압축

Pub/Sub를 통한 CDC 복제의 경우 레코드 압축 기능이 지원되지 않습니다.

스트리밍 데이터 복제의 경우 기본적으로 SAP용 BigQuery 커넥터는 BigQuery로 전송하는 레코드를 압축하여 복제 성능을 향상시켜 줍니다. SAP용 BigQuery 커넥터 버전 2.8부터 레코드 압축 옵션은 테이블 수준과 필드 수준에서 사용할 수 있습니다.

테이블 수준에서 레코드 압축이 사용 설정되면(기본 설정) SAP용 BigQuery 커넥터가 소스 레코드에 비어 있는 모든 필드를 BigQuery로 전송되는 레코드에서 생략합니다. 레코드가 BigQuery에 삽입되면 전송 데이터에서 생략된 필드가 BigQuery의 대상 테이블에서 null로 초기화됩니다.

하지만 테이블 수준에서 레코드 압축을 계속 사용하면서 일부 빈 필드를 초기 값으로 BigQuery에 복제해야 하는 경우 해당 필드의 레코드 압축 설정을 변경하면 됩니다. 즉, 지정된 필드의 빈 값이 전송된 데이터에서 생략되지 않으며 소스 테이블에서 초기화된 값이 무엇이든 유지됩니다.

테이블 수준 및 필드 수준에서 사용할 수 있는 압축되지 않은 플래그 전송 설정을 사용하여 레코드 압축 동작을 제어할 수 있습니다. 다음 표에는 레코드 압축 동작이 요약되어 있습니다.

| 테이블 수준에서 압축되지 않은 플래그 전송 | 필드 수준에서 압축되지 않은 플래그 전송 | 레코드 압축 동작 |

|---|---|---|

| 예 | 아니요 | 모든 필드는 압축되지 않은 상태로 전송됩니다. |

| 예 | 예 | 모든 필드는 압축되지 않은 상태로 전송됩니다. |

| 아니요 | 예 | 필드 수준에서 선택된 필드만 압축되지 않은 상태로 전송됩니다. |

| 아니요 | 아니요 | 모든 필드가 압축된 상태로 전송됩니다. |

압축되지 않은 데이터가 복제를 위해 전송되면 날짜 필드 및 타임스탬프 필드를 제외하고 빈 필드는 소스 테이블에서 초기화된 값을 유지합니다. 날짜 및 타임스탬프 필드의 초기화된 값에는 다음 값이 수신됩니다.

- 날짜 필드 초기화 값:

DATE 1970-01-01 - 타임스탬프 필드 초기화 값:

TIMESTAMP 1970-01-01 00:00:00 UTC

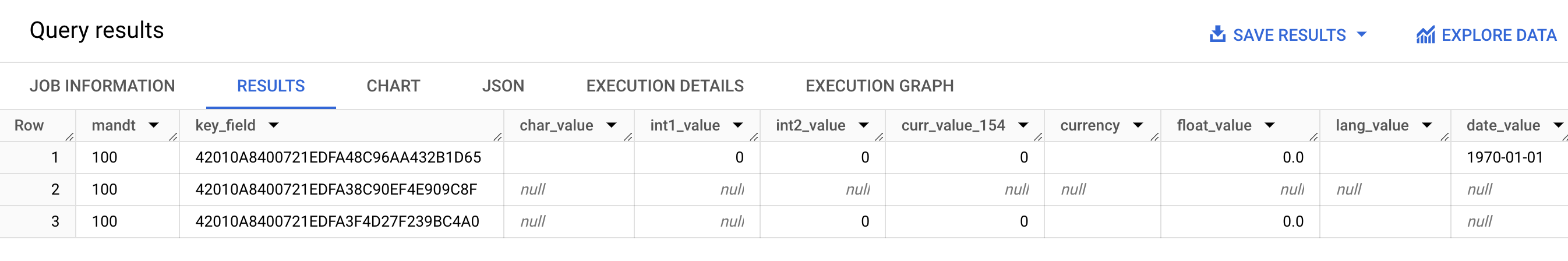

다음 스크린샷은 레코드 압축 동작의 예를 보여줍니다.

- 행 1: 모든 필드가 압축 해제됩니다. 압축되지 않은 플래그 전송이 테이블 수준에서 선택됩니다.

- 행 2: 모든 필드가 압축됩니다. 압축되지 않은 플래그 전송은 테이블 수준에서 지워집니다.

- 3번째 행:

int2_value,curr_value_154,currency,float_value,lang_value필드가 압축 해제됩니다. 이러한 필드의 경우 압축되지 않은 플래그 전송이 필드 수준에서 선택됩니다.

성능 향상을 위해 테이블 수준에서 압축되지 않은 플래그 전송을 선택하여 레코드 압축을 사용 중지하지 마세요. 복제 성능에 부정적인 영향을 미칠 수 있습니다. 특정 필드에 대해서만 압축되지 않은 데이터를 전송해야 하는 경우 필드 수준에서 해당 특정 필드에 대해 압축되지 않은 플래그 전송을 선택합니다. 레코드 압축이 SAP LT Replication Server에서 BigQuery로 전송되는 데이터에 미치는 영향에 대한 자세한 내용은 SAP용 BigQuery 커넥터 압축 기능 이해를 참고하세요.

BigQuery 복제 구성

SAP용 BigQuery 커넥터로 복제를 구성할 때는 Google Cloud에서 제공하는 커스텀 트랜잭션을 포함한 여러 가지 SAP 트랜잭션을 사용합니다.

SM30- Google Cloud에 연결하기 위한 속성을 정의합니다. 이 속성은 커스텀 구성 테이블/GOOG/CLIENT_KEY에 레코드로 저장됩니다. 선택적으로 RFC 대상을 사용해서Google Cloud API 및 서비스에 연결할 때는 일부 연결 속성이 커스텀 구성 테이블/GOOG/SERVIC_MAP에 저장됩니다.LTRC- 여러 속성 중에서도 SAP용 BigQuery 커넥터 복제 애플리케이션과 대량 전송 ID를 정의합니다.SM59- BigQuery 및 IAM과 같은 Google CloudAPI 및 서비스에 연결을 사용 설정하는 RFC 대상을 정의합니다./GOOG/SLT_SETTINGS- 대상 BigQuery 데이터 세트, 테이블, 필드의 속성을 정의합니다. SAP LT Replication Server에/GOOG/SLT_SETTINGS를 입력할 때는 트랜잭션 이름에서 처음 슬래시를 이스케이프 처리하기 위해/n을 추가해야 합니다.

언어 지원

SAP용 BigQuery 커넥터는 복제 구성(영어)만 지원합니다. SAP 트랜잭션 및 Google Cloud에서 제공하는 커스텀 트랜잭션을 사용하여 복제를 구성할 때는 SAP 로그온 화면에서 로그온 언어로 영어를 사용합니다.

그러나 SAP용 BigQuery 커넥터는 SAP SLT가 지원하는 모든 언어로 SAP LT Replication Server에서 실행되는 백그라운드 작업 실행을 지원합니다.

SAP용 BigQuery 커넥터로 작업할 때 발생할 수 있는 오류 메시지는 백그라운드 작업 실행 언어와 상관없이 영어로 생성됩니다.

대상 테이블 속성

/GOOG/SLT_SETTINGS 트랜잭션을 실행하여 SAP LT Replication Server에서 복제를 구성하면서 SAP용 BigQuery 커넥터가 BigQuery에서 대상 테이블을 만들 때 적용되는 설정을 지정할 수 있습니다.

예를 들어 대상 BigQuery 테이블에 대해 다음 속성을 지정할 수 있습니다.

- 표 이름

- 필드의 기본 이름 지정 옵션

- 레코드 변경사항을 캡처하고 레코드 카운트 쿼리를 사용 설정하기 위한 추가 필드

- 테이블 파티션 나누기

필드의 기본 이름 지정 옵션

소스 필드 이름 또는 소스 필드의 라벨 및 설명으로 대상 BigQuery 테이블의 필드 이름을 생성하도록 SAP용 BigQuery 커넥터를 구성할 수 있습니다. 일반적으로 라벨 및 설명은 필드의 콘텐츠에 대한 유용한 정보를 제공합니다.

기본적으로 SAP용 BigQuery 커넥터에는 소스 필드의 이름이 사용됩니다.

/GOOG/SLT_SETTINGS 트랜잭션의 대량 전송 구성에서 테이블 만들기 속성을 지정할 때 커스텀 이름 플래그를 지정하여 기본값을 변경할 수 있습니다. 이 사양은 /GOOG/BQ_MASTR 구성 테이블에 저장됩니다.

이름을 만들 때 SAP용 BigQuery 커넥터에서 BigQuery 이름 지정 규칙에 따라 이름을 수정합니다.

테이블이 생성되기 전 /GOOG/SLT_SETTINGS 트랜잭션의 필드 매핑 화면에서 필드 이름을 수정할 수 있습니다.

커스텀 이름 플래그가 지정된 경우 대상 테이블을 만들 때 SAP용 BigQuery 커넥터에서 사용할 이름이 필드 매핑 화면의 외부 필드 이름 열 값에 표시됩니다.

SAP용 BigQuery 커넥터는 각 소스 필드의 중간 필드 라벨을 사용하여 외부 필드 이름 열의 이름을 만듭니다. 소스 필드 정의에 중간 필드 라벨이 지정되지 않았으면 필드의 짧은 설명이 사용됩니다. 짧은 설명도 지정되지 않았으면 가장 짧게 지정된 라벨이 사용됩니다. 아무것도 지정되지 않았으면 소스 필드의 이름이 사용됩니다.

대상 필드 이름 맞춤설정에 대한 상세 설명은 대상 필드 이름 맞춤설정을 참조하세요.

레코드 변경사항 캡처 및 레코드 카운트 사용 설정

복제를 트리거한 소스 테이블의 변경 유형을 캡처하고 SAP LT Replication Server와 비교하여 BigQuery 테이블에서 레코드 수를 쿼리하거나 소스 테이블에서 레코드 수를 쿼리하려면 복제를 구성할 때 /GOOG/SLT_SETTINGS 트랜잭션의 추가 필드 플래그 옵션을 지정합니다.

추가 필드 플래그 옵션을 지정하면 대상 BigQuery 테이블의 스키마에 다음 열이 추가됩니다.

| 필드 이름 | 데이터 유형 | 설명 |

|---|---|---|

operation_flag

|

STRING

|

BigQuery에 레코드 로드 또는 복제를 트리거한 소스 테이블의 변경 유형을 식별합니다.

복제 모드로 삽입된 레코드를 카운트하려면

초기 로드 모드로 삽입된 레코드를 카운트하려면 |

is_deleted

|

BOOLEAN

|

true는 소스 레코드가 소스 테이블에서 삭제되었음을 나타냅니다.

BigQuery 테이블에서 소스 테이블에서 삭제되지 않은 레코드만 카운트하려면 |

recordstamp

|

TIMESTAMP

|

SAP LT Replication Server가 레코드를 BigQuery로 전송한 시간입니다. BigQuery 테이블에서 고유 레코드 수를 카운트하려면 각 레코드의 최근에 삽입된 인스턴스만 쿼리합니다. 예시 쿼리는 BigQuery 테이블에서 총 레코드 수 쿼리를 참조하세요. |

추가 필드 플래그 옵션의 현재 설정은 /GOOG/BQ_MASTR 구성 테이블에 저장됩니다.

추가 필드 플래그를 지정하는 방법에 대한 자세한 내용은 다음을 참조하세요.

- Pub/Sub을 통한 CDC 복제의 경우 테이블 만들기 및 기타 일반 속성 지정을 참고하세요.

- 스트리밍 데이터 복제의 경우 테이블 만들기 및 기타 일반 속성 지정을 참고하세요.

테이블 파티션 나누기

소스 테이블의 타임스탬프 필드(시간 단위 열로 파티션을 나눈 테이블 생성) 또는 레코드가 BigQuery에 삽입된 시간(수집 시간으로 파티션을 나눈 테이블 생성)을 기준으로 파티션을 나눈 BigQuery 테이블을 만들 수 있습니다.

복제 속성을 구성할 때 /GOOG/BQ_TABLE의 파티션 유형 필드에 파티션 유형을 지정하여 파티션 나누기를 사용 설정할 수 있습니다.

지정할 수 있는 파티션 유형에 따라 시간, 일, 월 또는 연도를 기준으로 파티션 나누기의 세부사항이 조정됩니다.

시간 단위 열 파티션 나누기를 위해 소스 테이블의 타임스탬프를 사용하려면 파티션 필드 필드에 소스 필드 이름을 지정합니다.

수집 시간으로 파티션 나누기를 위해 BigQuery 삽입 시간을 사용하려면 파티션 필드를 비워 두면 됩니다. SAP용 BigQuery 커넥터가 대상 테이블에 삽입 시간을 저장할 필드를 만듭니다.

대상 필드 속성

기본적으로 SAP용 BigQuery 커넥터에서는 SAP 소스 테이블의 필드 이름 및 데이터 유형이 대상 BigQuery의 필드 이름 및 데이터 유형으로 사용됩니다.

원하는 경우 대상 테이블을 만들기 전에 필드 이름을 맞춤설정하거나 BigQuery 데이터 유형을 변경할 수 있습니다.

대상 필드 이름 맞춤설정

테이블을 만들기 전에 대상 필드 이름을 맞춤설정할 수 있습니다.

필요한 경우 SAP용 BigQuery 커넥터가 BigQuery 이름 지정 규칙을 준수하기 위해 사용자가 지정한 커스텀 이름을 수정합니다.

복제를 구성할 때 /GOOG/SLT_SETTINGS 트랜잭션의 필드 매핑 화면에서 필드 이름을 볼 수 있습니다. SAP용 BigQuery 커넥터에서 설정은 /GOOG/BQ_FIELD 구성 테이블에 저장됩니다.

테이블을 만들기 전에 필드 매핑 화면의 임시 필드 이름 열에서 생성된 이름을 수정하여 커스텀 필드 이름을 지정할 수 있습니다. 값을 삭제하고 임시 필드 이름 필드를 비워 두면 SAP용 BigQuery 커넥터가 소스 필드의 이름을 해당 대상 필드의 이름으로 사용합니다.

임시 필드 이름을 수정한 후 저장을 클릭하면 SAP용 BigQuery 커넥터가 값을 검증하고 필요에 따라 BigQuery 이름 지정 규칙을 적용한 후 변경사항을 저장합니다. Enter 키를 누르면 저장하지 않고 값을 확인할 수 있습니다.

대상 필드의 기본 이름 지정 방법 설정에 대한 상세 설명은 필드 기본 이름 지정 옵션을 참조하세요.

스프레드시트 또는 텍스트 파일을 사용하여 BigQuery 필드 맵 수정

대상 BigQuery 테이블을 만들기 전에, BigQuery 데이터 엔지니어 또는 관리자가 SAP LT Replication Server에 액세스하지 않고도 값을 수정할 수 있도록 대상 필드의 기본 데이터 유형, 이름, 설명을 스프레드시트 또는 텍스트 파일에 저장할 수 있습니다.

값을 수정한 후에는 파일과 내용을 쉼표로 구분된 값(CSV) 형식으로 변환해야 합니다. 그런 다음 커스텀 트랜잭션 /GOOG/SLT_SETTINGS를 사용하여 CSV 파일을 업로드하면 대량 전송 설정에 업데이트를 적용할 수 있습니다.

CSV 파일을 사용하여 BigQuery 필드 맵을 수정하는 프로세스에는 다음 단계가 포함됩니다.

- 기본 필드 매핑의 스프레드시트 또는 텍스트 파일을 만듭니다.

- 값을 수정합니다.

- 스프레드시트 또는 텍스트 파일을 CSV 형식으로 변환합니다.

- CSV 파일을 업로드합니다.

각 단계에 대한 자세한 안내는 CSV 파일에서 BigQuery 필드 맵 수정을 참조하세요.

필드에 대한 BigQuery 이름 지정 규칙

BigQuery 이름 지정 규칙에서는 소문자, 숫자, 밑줄만 사용합니다.

SAP용 BigQuery 커넥터가 대상 필드 이름에 사용할 입력 값에 BigQuery 이름 지정 규칙을 적용합니다.

예를 들어 커스텀 필드 이름으로 FIELD-@#!*123을 입력하면 SAP용 BigQuery 커넥터가 field_123으로 이름을 변경합니다.

필드의 BigQuery 이름 지정 규칙에 대한 상세 설명은 열 이름을 참조하세요.

데이터 유형 매핑

기본적으로 SAP용 BigQuery 커넥터는 소스 SAP 필드의 SAP 유형 종류 또는 SAP 데이터 유형에 따라 대상 BigQuery 필드에 데이터 유형을 할당합니다.

Pub/Sub을 통한 CDC 복제의 경우 데이터 유형 매핑에 중간 단계가 포함됩니다.

SAP용 BigQuery 커넥터에서 Pub/Sub로: SAP용 BigQuery 커넥터가 Pub/Sub 주제로 데이터를 전송하면 SAP 데이터 유형이 먼저 Pub/Sub Avro 데이터 유형으로 변환됩니다.

Pub/Sub에서 BigQuery로: Pub/Sub Avro 형식 데이터는 BigQuery 구독을 사용하여 BigQuery로 스트리밍됩니다. 이 시점에서 Pub/Sub은 최종 BigQuery 데이터 유형을 할당합니다.

원활한 데이터 흐름과 정확한 해석을 위해서는 Pub/Sub Avro 데이터 유형과 최종 BigQuery 데이터 유형이 호환되어야 합니다. Pub/Sub 주제와 BigQuery 테이블 간의 스키마 호환성에 대한 자세한 내용은 스키마 호환성을 참고하세요.

복제를 구성할 때 /GOOG/SLT_SETTINGS 트랜잭션의 필드 매핑 화면에서 데이터 유형을 볼 수 있습니다. SAP용 BigQuery 커넥터에서 설정은 /GOOG/BQ_FIELD 구성 테이블에 저장됩니다.

테이블을 만들기 전에 기본 데이터 유형 사양을 다른 BigQuery 데이터 유형 및 Pub/Sub Avro 데이터 유형으로 변경할 수 있습니다.

특별 처리가 필요한 데이터 유형

대상 BigQuery 테이블에 정확하게 표시되려면 특별한 처리가 필요한 SAP 데이터 유형이 여러 개 있습니다.

이러한 데이터 유형 중 일부는 사용자가 직접 처리해야 합니다. 다른 작업은 SAP용 BigQuery 커넥터에서 자동으로 처리됩니다.

부울

부울의 경우 SAP는 CHAR 데이터 유형을 사용합니다. 기본적으로 SAP용 BigQuery 커넥터에서 대상 BigQuery 테이블의 STRING 데이터 유형에 매핑합니다.

따라서 부울의 경우 /GOOG/SLT_SETTINGS 트랜잭션을 사용하여 복제를 구성할 때 필드 매핑 화면에서 부울 필드의 기본 데이터 유형 할당을 STRING에서 BOOLEAN로 변경해야 합니다.

타임스탬프

타임스탬프의 경우 SAP는 P(묶음 십진수) 또는 DEC(십진수) 데이터 유형을 사용합니다. 기본적으로 SAP용 BigQuery 커넥터에서 대상 BigQuery 테이블의 NUMERIC에 매핑합니다.

따라서 타임스탬프의 경우 /GOOG/SLT_SETTINGS 트랜잭션을 사용하여 복제를 구성할 때 필드 매핑 화면에서 타임스탬프 필드의 기본 데이터 유형 할당을 NUMERIC에서 TIMESTAMP 또는 TIMESTAMP (LONG)으로 변경해야 합니다.

X SAP 유형 종류

X SAP 유형 종류는 16진수이며 RAW, RAWSTRING 또는 LRAW SAP 데이터 유형으로 표현됩니다. 기본적으로 SAP용 BigQuery 커넥터는 이러한 데이터 유형을 소스 BigQuery 테이블의 STRING에 매핑합니다.

BYTES에 매핑할 X SAP 유형 종류가 있는 소스 필드가 필요하면 /GOOG/SLT_SETTINGS 트랜잭션의 필드 매핑 화면에서 해당 필드의 기본 데이터 유형 할당을 변경해야 합니다.

X SAP 유형 종류는 SAP에서 정수를 나타내는 데 사용되기도 합니다.

이 경우 SAP용 BigQuery 커넥터는 소스 필드의 데이터 유형이 정수용 SAP 데이터 유형인 INT1, INT2, INT4, INT8인지 확인하고 대상 BigQuery 테이블에서 INTEGER 데이터 유형을 할당합니다.

y SAP 유형 종류

y SAP 유형 종류는 바이트 문자열이며 RAW, RAWSTRING 또는 LRAW SAP 데이터 유형으로 표현됩니다. 기본적으로 SAP용 BigQuery 커넥터는 이러한 데이터 유형을 소스 BigQuery 테이블의 STRING에 매핑합니다.

BYTES에 매핑할 y SAP 유형 종류가 있는 소스 필드가 필요하면 /GOOG/SLT_SETTINGS 트랜잭션의 필드 매핑 화면에서 해당 필드의 기본 데이터 유형 할당을 변경해야 합니다.

LRAW SAP 데이터 유형

SAP용 BigQuery 커넥터는 BigQuery에 LRAW 데이터 유형을 Base64 인코딩된 문자열로 저장합니다.

Pub/Sub를 통해 CDC 복제를 사용하는 경우 커넥터는 LRAW 필드를 UTF-8 인코딩으로 변환한 후 Pub/Sub로 전송합니다. 이 변환에도 불구하고 커넥터는 여전히 BigQuery에 데이터를 Base64로 저장합니다.

LRAW 필드 값의 커넥터 UTF-8 변환은 이전 길이 열이 나타내는 초기 바이트만 고려합니다. 이는 SAP 표준을 따르며, 여기서 앞의 길이 필드 (INT2 또는 INT4 유형)는 LRAW 콘텐츠의 유효한 길이를 정의합니다.

기본 데이터 유형 매핑

다음 표는 SAP용 BigQuery 커넥터의 기본 데이터 유형 변환을 보여줍니다.

| SAP 유형 종류 | SAP 데이터 유형 | BigQuery 데이터 유형 | Pub/Sub Avro 데이터 유형 | 참고 |

|---|---|---|---|---|

b(1바이트 정수)s(2바이트 정수)I(4바이트 정수)8(8바이트 정수)

|

INT1INT2INT4INT8

|

INTEGER |

INT |

|

F(부동 소수점 수)

|

FLTP

|

FLOAT |

FLOAT |

|

P(묶음)

|

CURRDECQUAN

|

NUMERIC |

DOUBLE |

기본적으로 P SAP 유형 종류는 BigQuery 데이터 유형 NUMERIC에 매핑되고 외부 형식의 숫자로 변환됩니다. |

a(10진수 부동 소수점 수, 16자리)

|

DECFLOAT16 |

NUMERIC |

DOUBLE |

|

e(10진수 부동 소수점 수, 16자리)

|

DECFLOAT34 |

NUMERIC |

DOUBLE |

|

N(숫자) |

NUMC |

STRING |

STRING |

|

X(16진수)y(바이트 문자열)

|

RAWRAWSTRINGLRAW

|

STRING |

STRING |

SAP 유형 종류가 X이지만 데이터 유형 이름이 'INT*' 패턴(INT1 ,INT2 ,INT4)을 다루는 경우 소스 데이터 요소가 새 데이터 요소 TYPINT8 및 TYPEKIND '8'로 대체되며 BigQuery 데이터 유형 INTEGER에 매핑됩니다. |

C(문자)g(문자열)?(csequence)&(clike)

|

CHARSTRING |

STRING |

STRING |

|

D(날짜) |

DATS |

DATE |

STRING |

|

T(시간) |

TIMS |

TIME |

STRING |

라이선스

SAP용 BigQuery 커넥터는 서비스별 약관(https://cloud.google.com/terms/service-terms)을 포함한 Google Cloud 플랫폼 사용에 적용되는 계약에 따라 '소프트웨어'로 제공됩니다. 상기 약관을 전제로 Google의 명시적인 서면 승인 없이 SAP용 BigQuery 커넥터를 수정하거나 배포할 수 없습니다.

SAP용 BigQuery 커넥터 소프트웨어는 무료로 제공됩니다. Google Cloud Platform 사용에 적용되는 계약에 따라 BigQuery, Pub/Sub, Pub/Sub API, Storage Write API, BigQuery 스트리밍 API와 같은 다른 '소프트웨어' 및 '서비스'를 사용하면 비용이 발생할 수 있습니다. Google Cloud

SAP용 BigQuery 커넥터에는 SAP LT Replication Server를 포함하되 이에 국한되지 않는 SAP 소프트웨어에 대한 라이선스가 포함되지 않습니다. SAP 소프트웨어에 대한 적절한 라이선스를 별도로 조달해야 합니다.

지원 수명 주기

Google Cloud 최신 주 버전의 SAP용 BigQuery 커넥터를 지원 및 유지보수하며, 이전 주 버전에 대해서도 Google Cloud 기반 SAP 출시 노트 페이지 Google Cloud에서 지원 중단 알림을 게시한 후 최소 12개월 동안 지원 및 유지보수를 제공합니다.

다음 단계

SAP용 BigQuery 커넥터를 설치하는 방법에 대한 자세한 내용은 SAP용 BigQuery 커넥터 설치를 참고하세요.