Ce guide explique comment utiliser Cloud Deployment Manager pour déployer un système SAP HANA à évolutivité horizontale qui inclut la solution de reprise après sinistre par basculement automatique des hôtes SAP HANA. Avec Deployment Manager, vous pouvez déployer un système qui répond aux exigences de compatibilité SAP, et respecte les bonnes pratiques de SAP et de Compute Engine.

Le système SAP HANA obtenu comprend 1 hôte maître, 15 hôtes de calcul au maximum et jusqu'à 3 hôtes de secours, qui sont tous situés dans une même zone Compute Engine.

Le système comprend également le gestionnaire d'espace de stockageGoogle Cloud pour les nœuds de secours SAP HANA (gestionnaire d'espace de stockage pour SAP HANA), qui gère le transfert d'appareils de stockage sur le nœud de secours lors d'un basculement.

Le gestionnaire d'espace de stockage pour SAP HANA est installé dans le volume SAP HANA /shared.

Pour en savoir plus sur le gestionnaire d'espace de stockage pour SAP HANA et les autorisations IAM requises, consultez la section Gestionnaire d'espace de stockage pour SAP HANA.

Si vous devez déployer SAP HANA dans un cluster Linux haute disponibilité, utilisez l'un des guides suivants :

- Deployment Manager : guide de configuration d'un cluster à haute disponibilité SAP HANA

- Guide de configuration d'un cluster à haute disponibilité pour SAP HANA sur RHEL

- Guide de configuration d'un cluster à haute disponibilité pour SAP HANA sur SLESLINK

Ce guide est destiné aux utilisateurs avancés de SAP HANA qui sont familiarisés avec les configurations à évolutivité horizontale SAP incluant des hôtes de secours pour la haute disponibilité, ainsi que des systèmes de fichiers réseau.

Prérequis

Avant de créer le système à évolutivité horizontale et haute disponibilité SAP HANA, assurez-vous que les prérequis suivants sont respectés :

- Vous avez lu le guide de planification SAP HANA et le guide de planification de la haute disponibilité pour SAP HANA.

- Vous ou votre organisation disposez d'un compte Google Cloud et vous avez créé un projet pour le déploiement de SAP HANA. Pour en savoir plus sur la création de comptes et de projetsGoogle Cloud , consultez la section Configurer votre compte Google dans le guide de déploiement de SAP HANA.

- Si vous souhaitez que votre charge de travail SAP s'exécute conformément aux exigences liées à la résidence des données, au contrôle des accès, au personnel d'assistance ou à la réglementation, vous devez créer le dossier Assured Workloads requis. Pour en savoir plus, consultez la page Contrôles de conformité et de souveraineté pour SAP sur Google Cloud.

- Le support d'installation de SAP HANA se trouve dans un bucket Cloud Storage disponible dans votre projet et votre région de déploiement. Pour en savoir plus sur l'importation de support d'installation SAP HANA dans un bucket Cloud Storage, consultez la section Créer un bucket Cloud Storage dans le guide de déploiement de SAP HANA.

- Vous disposez d'une solution NFS, telle que la solution Filestore, pour partager les volumes SAP HANA

/hana/sharedet/hanabackupentre les hôtes du système à évolutivité horizontale SAP HANA. Vous devez spécifier les points de montage des serveurs NFS dans le fichier de configuration de Deployment Manager pour pouvoir déployer le système. Pour déployer des serveurs Filestore NFS, consultez la page Créer des d'instances. La communication doit être autorisée entre toutes les VM du sous-réseau SAP HANA qui hébergent un nœud SAP HANA à évolutivité horizontale.

Si OS Login est activé dans les métadonnées de votre projet, vous devrez le désactiver temporairement jusqu'à la fin du déploiement. Pour le déploiement, cette procédure configure les clés SSH dans les métadonnées d'instance. Lorsque OS Login est activé, les configurations de clé SSH basées sur les métadonnées sont désactivées et le déploiement échoue. Une fois le déploiement terminé, vous pouvez réactiver OS Login.

Pour en savoir plus, consultez les pages suivantes :

Créer un réseau

Pour des raisons de sécurité, vous devez créer un réseau. Vous pourrez contrôler les accès en ajoutant des règles de pare-feu ou en utilisant une autre méthode.

Si votre projet dispose d'un réseau VPC par défaut, ne l'utilisez pas. À la place, créez votre propre réseau VPC afin que les seules règles de pare-feu appliquées soient celles que vous créez explicitement.

Lors du déploiement, les instances Compute Engine nécessitent généralement un accès à Internet pour télécharger l'agent Google Cloudpour SAP. Si vous utilisez l'une des images Linux certifiées SAP disponibles dans Google Cloud, l'instance de calcul nécessite également l'accès à Internet pour enregistrer la licence et accéder aux dépôts des fournisseurs d'OS. Une configuration comprenant une passerelle NAT et des tags réseau de VM permet aux instances de calcul cibles d'accéder à Internet même si elles ne possèdent pas d'adresses IP externes.

Pour configurer la mise en réseau, procédez comme suit :

Console

- Dans la console Google Cloud , accédez à la page Réseaux VPC.

- Cliquez sur Créer un réseau VPC.

- Saisissez un Nom pour le réseau.

Le nom doit respecter la convention d'attribution de noms. Les réseaux VPC utilisent la convention d'attribution de noms de Compute Engine.

- Dans le champ Mode de création du sous-réseau, sélectionnez Custom.

- Dans la section Nouveau sous-réseau, spécifiez les paramètres de configuration de sous-réseau suivants :

- Saisissez un nom pour le sous-réseau.

- Dans le champ Région, sélectionnez la région Compute Engine dans laquelle vous souhaitez créer le sous-réseau.

- Pour Type de pile IP, sélectionnez IPv4 (pile unique), puis saisissez une plage d'adresses IP au format CIDR, telle que

10.1.0.0/24.Il s'agit de la plage IPv4 principale du sous-réseau. Si vous envisagez d'ajouter plusieurs sous-réseaux, attribuez à chacun d'eux des plages d'adresses IP CIDR qui ne se chevauchent pas dans le réseau. Notez que chaque sous-réseau et ses plages d'adresses IP internes sont mappés sur une seule région.

- Cliquez sur OK.

- Pour ajouter d'autres sous-réseaux, cliquez sur Ajouter un sous-réseau et répétez les étapes ci-dessus. Vous pouvez ajouter d'autres sous-réseaux au réseau après sa création.

- Cliquez sur Créer.

gcloud

- Accédez à Cloud Shell.

- Pour créer un réseau en mode de sous-réseau personnalisé, exécutez la commande suivante :

gcloud compute networks create NETWORK_NAME --subnet-mode custom

Remplacez

NETWORK_NAMEpar le nom du nouveau réseau. Le nom doit respecter la convention d'attribution de noms. Les réseaux VPC utilisent la convention de dénomination de Compute Engine.Spécifiez

--subnet-mode custompour éviter d'utiliser le mode automatique par défaut, qui crée automatiquement un sous-réseau dans chaque région Compute Engine. Pour en savoir plus, consultez la section Mode de création du sous-réseau. - Créez un sous-réseau, et spécifiez la région et la plage d'adresses IP :

gcloud compute networks subnets create SUBNETWORK_NAME \ --network NETWORK_NAME --region REGION --range RANGERemplacez les éléments suivants :

SUBNETWORK_NAME: nom du nouveau sous-réseauNETWORK_NAME: nom du réseau que vous avez créé à l'étape précédenteREGION: région dans laquelle vous souhaitez créer le sous-réseauRANGE: plage d'adresses IP spécifiée au format CIDR (par exemple,10.1.0.0/24)Si vous envisagez d'ajouter plusieurs sous-réseaux, attribuez à chacun d'eux des plages d'adresses IP CIDR qui ne se chevauchent pas. Notez que chaque sous-réseau et ses plages d'adresses IP internes sont mappés sur une seule région.

- Si vous le souhaitez, répétez l'étape précédente et ajoutez des sous-réseaux.

Configurer une passerelle NAT

Si vous devez créer une ou plusieurs VM sans adresse IP publique, vous devez utiliser la traduction d'adresse réseau (NAT) pour permettre aux VM d'accéder à Internet. Utilisez Cloud NAT, un service Google Cloud géré distribué et défini par logiciel qui permet aux VM d'envoyer des paquets sortants vers Internet et de recevoir tous les paquets de réponses entrants établis correspondants. Vous pouvez également configurer une VM distincte en tant que passerelle NAT.

Pour créer une instance Cloud NAT pour votre projet, consultez la page Utiliser Cloud NAT.

Une fois que vous avez configuré Cloud NAT pour votre projet, vos instances de VM peuvent accéder en toute sécurité à Internet sans adresse IP publique.

Ajouter des règles de pare-feu

Par défaut, une règle de pare-feu implicite bloque les connexions entrantes provenant de l'extérieur de votre réseau VPC (Virtual Private Cloud, cloud privé virtuel). Pour autoriser les connexions entrantes, configurez une règle de pare-feu pour votre VM. Une fois qu'une connexion entrante est établie avec une VM, le trafic est autorisé dans les deux sens via cette connexion.

Vous pouvez également créer une règle de pare-feu pour autoriser l'accès externe à des ports spécifiés ou pour limiter l'accès entre plusieurs VM d'un même réseau. Si le type de réseau VPC default est utilisé, d'autres règles par défaut s'appliquent également, telles que la règle default-allow-internal, qui permet la connectivité entre les VM d'un même réseau sur tous les ports.

En fonction de la stratégie informatique applicable à votre environnement, vous devrez peut-être isoler votre hôte de base de données, ou en restreindre la connectivité, en créant des règles de pare-feu.

Selon votre scénario, vous pouvez créer des règles de pare-feu afin d'autoriser l'accès pour ce qui suit :

- Ports SAP par défaut répertoriés dans le tableau listant les ports TCP/IP de tous les produits SAP.

- Connexions à partir de votre ordinateur ou de votre environnement de réseau d'entreprise à votre instance de VM Compute Engine. Si vous ne savez pas quelle adresse IP utiliser, contactez l'administrateur réseau de votre entreprise.

- Communication entre VM sur le sous-réseau SAP HANA, y compris la communication entre les nœuds d'un système à évolutivité horizontale SAP HANA ou la communication entre le serveur de base de données et les serveurs d'applications dans une architecture à trois niveaux. Pour activer la communication entre VM, vous pouvez créer une règle de pare-feu autorisant le trafic provenant du sous-réseau.

Pour créer une règle de pare-feu, procédez comme suit :

Console

Dans la console Google Cloud , accédez à la page Pare-feu du réseau VPC.

En haut de la page, cliquez sur Créer une règle de pare-feu.

- Dans le champ Réseau, sélectionnez le réseau sur lequel se trouve votre VM.

- Dans le champ Cibles, spécifiez les ressources Google Cloudauxquelles cette règle s'applique. Par exemple, spécifiez Toutes les instances du réseau. Pour limiter la règle à des instances spécifiques sur Google Cloud, saisissez des tags dans le champ Tags cibles spécifiés.

- Dans le champ Filtre source, sélectionnez l'une des options suivantes :

- Plages IP pour autoriser le trafic entrant provenant d'adresses IP spécifiques. Indiquez la plage d'adresses IP dans le champ Plages d'adresses IP sources.

- Sous-réseaux pour autoriser le trafic entrant depuis un sous-réseau particulier. Spécifiez le nom du sous-réseau dans le champ Sous-réseaux qui s'affiche. Utilisez cette option pour autoriser l'accès entre plusieurs VM dans une configuration à trois niveaux ou évolutive.

- Dans la section Protocoles et ports, sélectionnez Protocoles et ports spécifiés, puis saisissez

tcp:PORT_NUMBER.

Cliquez sur Créer pour créer la règle de pare-feu.

gcloud

Créez une règle de pare-feu à l'aide de la commande suivante :

$ gcloud compute firewall-rules create FIREWALL_NAME

--direction=INGRESS --priority=1000 \

--network=NETWORK_NAME --action=ALLOW --rules=PROTOCOL:PORT \

--source-ranges IP_RANGE --target-tags=NETWORK_TAGSCréer un système SAP HANA à évolutivité horizontale avec des hôtes de secours

Dans la procédure ci-dessous, vous allez effectuer les opérations suivantes :

- Créer le système SAP HANA en appelant Deployment Manager et en complétant un modèle de fichier de configuration

- Vérifier le déploiement

- Tester un ou plusieurs hôtes de secours en simulant une défaillance d'un hôte

Certaines des étapes des instructions suivantes utilisent Cloud Shell pour saisir les commandes gcloud. Si la dernière version de Google Cloud CLI est installée, vous pouvez saisir les commandes gcloud à partir d'un terminal local.

Définir et créer le système SAP HANA

Dans la procédure ci-dessous, vous allez télécharger et compléter un modèle de fichier de configuration Deployment Manager. Ensuite, vous appellerez Deployment Manager pour déployer les VM, les disques persistants et les instances SAP HANA.

Vérifiez que vos quotas actuels pour les ressources de projet, telles que les disques persistants et les processeurs, sont suffisants pour le système SAP HANA que vous êtes sur le point d'installer. Si les quotas sont insuffisants, le déploiement échoue. Pour connaître les exigences de quota de SAP HANA, consultez la section Remarques relatives aux tarifs et aux quotas applicables à SAP HANA.

Ouvrez Cloud Shell.

Téléchargez le modèle de fichier de configuration

template.yamlpour le système à évolutivité horizontale et à haute disponibilité SAP HANA dans votre répertoire de travail :wget https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_hana_scaleout/template.yaml

Renommez éventuellement le fichier

template.yamlpour identifier la configuration qu'il définit. Par exemple, vous pouvez utiliser un nom de fichier tel quehana2sp3rev30-scaleout.yaml.Ouvrez le fichier

template.yamldans l'éditeur de code Cloud Shell.Pour ce faire, cliquez sur l'icône en forme de crayon située dans l'angle supérieur droit de la fenêtre du terminal Cloud Shell.

Dans le fichier

template.yaml, mettez à jour les valeurs de propriété suivantes en remplaçant les crochets et leur contenu par les valeurs de votre installation. Par exemple, vous pouvez remplacer "[ZONE]" par "us-central1-f".Property Type de données Description type Chaîne Spécifie l'emplacement, le type et la version du modèle Deployment Manager à utiliser lors du déploiement.

Le fichier YAML comprend deux spécifications

type, dont l'une est laissée en commentaire. La spécificationtypequi est active par défaut spécifie la version du modèle en tant quelatest. La spécificationtypequi est laissée en commentaire spécifie une version de modèle spécifique avec un horodatage.Si tous vos déploiements doivent utiliser la même version de modèle, utilisez la spécification

typequi inclut l'horodatage.instanceNameChaîne Nom de l'instance de VM de l'hôte maître SAP HANA. Le nom ne doit contenir que des lettres minuscules, des chiffres ou des traits d'union. Les instances de VM des hôtes de calcul et de secours utilisent le même nom, auquel sont ajoutés la lettre "w" et le numéro d'hôte. instanceTypeChaîne Type de machine virtuelle Compute Engine nécessaire à l'exécution de SAP HANA. Si vous avez besoin d'un type de VM personnalisé, spécifiez un type de VM prédéfini doté d'un nombre de processeurs virtuels le plus proche possible de la quantité dont vous avez besoin tout en étant légèrement supérieur. Une fois le déploiement terminé, modifiez le nombre de processeurs virtuels et la quantité de mémoire. zoneChaîne Zone dans laquelle vous déployez vos systèmes SAP HANA à exécuter. Elle doit être située dans la région que vous avez sélectionnée pour votre sous-réseau. subnetworkChaîne Nom du sous-réseau que vous avez créé précédemment. Si vous procédez au déploiement sur un VPC partagé, spécifiez cette valeur en tant que [SHAREDVPC_PROJECT]/[SUBNETWORK]. Exemple :myproject/network1linuxImageChaîne Nom de la famille d'images ou de l'image du système d'exploitation Linux que vous utilisez avec SAP HANA. Pour spécifier une famille d'images, ajoutez le préfixe family/au nom de la famille. Par exemple,family/rhel-8-1-sap-haoufamily/sles-15-sp2-sap. Pour spécifier une image spécifique, indiquez uniquement le nom de l'image. Pour obtenir la liste des familles d'images disponibles, consultez la page Images dans la console Google Cloud .linuxImageProjectChaîne Le projet Google Cloud qui contient l'image que vous allez utiliser. Il peut s'agir de votre propre projet ou d'un projet d'image Google Cloud . Pour une image Compute Engine, spécifiez rhel-sap-cloudoususe-sap-cloud. Pour trouver le projet d'image correspondant à votre système d'exploitation, consultez la page Détails des systèmes d'exploitation.sap_hana_deployment_bucketChaîne Nom du bucket Cloud Storage de votre projet contenant les fichiers d'installation de SAP HANA que vous avez importés précédemment. sap_hana_sidChaîne ID du système SAP HANA. L'ID doit comporter trois caractères alphanumériques et commencer par une lettre. Les lettres doivent être saisies en majuscules. sap_hana_instance_numberEntier Numéro d'instance (0 à 99) du système SAP HANA. La valeur par défaut est 0. sap_hana_sidadm_passwordChaîne Un mot de passe temporaire à utiliser par l'administrateur du système d'exploitation lors du déploiement. Les mots de passe doivent comporter huit caractères ou plus, et inclure au moins une lettre majuscule, une lettre minuscule et un chiffre. sap_hana_system_passwordChaîne Mot de passe temporaire à utiliser par le super-utilisateur de la base de données lors du déploiement. Les mots de passe doivent comporter huit caractères ou plus, et inclure au moins une lettre majuscule, une lettre minuscule et un chiffre. sap_hana_worker_nodesEntier Nombre d'hôtes de calcul SAP HANA supplémentaires dont vous avez besoin. Vous pouvez spécifier 1 à 15 hôtes de calcul. La valeur par défaut est 1. sap_hana_standby_nodesEntier Nombre d'hôtes de secours SAP HANA supplémentaires dont vous avez besoin. Vous pouvez spécifier 1 à 3 hôtes de secours. La valeur par défaut est 1. sap_hana_shared_nfsChaîne Point de montage NFS du volume /hana/shared. Exemple :10.151.91.122:/hana_shared_nfssap_hana_backup_nfsChaîne Point de montage NFS du volume /hanabackup. Exemple :10.216.41.122:/hana_backup_nfsnetworkTagChaîne Facultatif. Un ou plusieurs tags réseau séparés par une virgule représentant votre instance de VM à des fins de routage ou de pare-feu. Si vous spécifiez publicIP: Noet ne spécifiez pas de tag réseau, veillez à fournir un autre moyen d'accès à Internet.nic_typeString Facultatif, mais recommandé si disponible pour la machine cible et la version de l'OS. Spécifie l'interface réseau à utiliser avec l'instance de VM. Vous pouvez spécifier la valeur GVNICouVIRTIO_NET. Pour utiliser une carte d'interface réseau virtuelle Google (gVNIC), vous devez spécifier une image de l'OS compatible avec gVNIC comme valeur de la propriétélinuxImage. Pour obtenir la liste des images de l'OS, consultez la section Détails des systèmes d'exploitation.Si vous ne spécifiez pas de valeur pour cette propriété, l'interface réseau est automatiquement sélectionnée en fonction du type de machine que vous spécifiez pour la propriété

Cet argument est disponible dans les versionsinstanceType.202302060649du modèle Deployment Manager ou ultérieures.publicIPBooléen Facultatif. Détermine si une adresse IP publique est ajoutée à votre instance de VM. La valeur par défaut est Yes.sap_hana_double_volume_sizeEntier Facultatif. Double la taille du volume HANA. Utile si vous souhaitez déployer plusieurs instances SAP HANA ou une instance SAP HANA de reprise après sinistre sur la même VM. Par défaut, la taille du volume est calculée automatiquement pour correspondre à la taille minimale requise pour votre empreinte mémoire, tout en respectant les exigences de certification et de compatibilité SAP. sap_hana_sidadm_uidEntier Facultatif. Remplace la valeur par défaut de l'ID utilisateur SID_LCadm. La valeur par défaut est 900. Vous pouvez la remplacer par une autre valeur pour garantir la cohérence dans votre environnement SAP.sap_hana_sapsys_gidEntier Facultatif. Remplace l'ID de groupe par défaut défini pour sapsys. La valeur par défaut est 79. sap_deployment_debugBooléen Facultatif. Si cette valeur est définie sur Yes, le déploiement génère des journaux de déploiement détaillés. Vous ne devez activer ce paramètre que si un ingénieur de l'assistance Google vous demande d'activer le débogage.post_deployment_scriptBooléen Facultatif. URL ou emplacement de stockage d'un script à exécuter une fois le déploiement terminé. Le script doit être hébergé sur un serveur Web ou dans un bucket Cloud Storage. La valeur doit commencer par http:// https:// ou gs://. Notez que ce script sera exécuté sur toutes les VM créées par le modèle. Vous devez cocher la case située en haut de votre script si vous ne souhaitez exécuter ce dernier que sur l'instance maître. L'exemple ci-dessous montre un fichier de configuration terminé permettant de déployer un système SAP HANA à évolutivité horizontale avec trois hôtes de calcul et un hôte de secours dans la zone us-central1-f. Chaque hôte est installé sur une VM n2-highmem-32 qui exécute un système d'exploitation Linux fourni par une image publique Compute Engine. Les volumes NFS sont fournis par Filestore. Les mots de passe temporaires ne sont utilisés que lors du traitement de la configuration et du déploiement. Le compte de service personnalisé qui est spécifié devient le compte de service des VM déployées.

resources: - name: sap_hana_ha_scaleout type: https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_hana_scaleout/sap_hana_scaleout.py # # By default, this configuration file uses the latest release of the deployment # scripts for SAP on Google Cloud. To fix your deployments to a specific release # of the scripts, comment out the type property above and uncomment the type property below. # # type: https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/YYYYMMDDHHMM/dm-templates/sap_hana_scaleout/sap_hana_scaleout.py # properties: instanceName: hana-scaleout-w-failover instanceType: n2-highmem-32 zone: us-central1-f subnetwork: example-sub-network-sap linuxImage: family/sles-15-sp2-sap linuxImageProject: suse-sap-cloud sap_hana_deployment_bucket: hana2-sp5-rev53 sap_hana_sid: HF0 sap_hana_instance_number: 00 sap_hana_sidadm_password: TempPa55word sap_hana_system_password: TempPa55word sap_hana_worker_nodes: 3 sap_hana_standby_nodes: 1 sap_hana_shared_nfs: 10.74.146.58:/hana_shr sap_hana_backup_nfs: 10.188.249.170:/hana_bup serviceAccount: sap-deploy-example@example-project-123456.Créez les instances :

gcloud deployment-manager deployments create [DEPLOYMENT_NAME] --config [TEMPLATE_NAME].yamlLa commande ci-dessus appelle Deployment Manager, qui configure l'infrastructure Google Cloud , puis appelle un autre script qui configure le système d'exploitation et installe SAP HANA.

Lorsque Deployment Manager exerce un contrôle, les messages d'état sont écrits dans Cloud Shell. Une fois les scripts appelés, les messages d'état sont écrits dans Logging et peuvent être consultés dans la console Google Cloud , comme décrit dans la section Vérifier les journaux Logging.

La durée d'exécution peut varier, mais l'ensemble du processus prend généralement moins de 30 minutes.

Valider le déploiement

Pour vérifier le déploiement, vérifiez les journaux de déploiement dans Cloud Logging, vérifiez les disques et services sur les VM des hôtes principaux et de calcul, affichez le système dans SAP HANA Studio et testez la reprise par un hôte de secours.

Vérifier les journaux

Dans la console Google Cloud , ouvrez Cloud Logging pour surveiller la progression de l'installation et rechercher les erreurs.

Filtrez les journaux :

Explorateur de journaux

Sur la page Explorateur de journaux, accédez au volet Requête.

Dans le menu déroulant Ressource, sélectionnez Global, puis cliquez sur Ajouter.

Si l'option Global n'apparaît pas, saisissez la requête suivante dans l'éditeur de requête :

resource.type="global" "Deployment"Cliquez sur Exécuter la requête.

Ancienne visionneuse de journaux

- Sur la page Ancienne visionneuse de journaux, dans le menu de sélection de base, sélectionnez Global comme ressource de journalisation.

Analysez les journaux filtrés :

- Si

"--- Finished"s'affiche, le traitement du déploiement est terminé, et vous pouvez passer à l'étape suivante. Si vous rencontrez une erreur de quota :

Sur la page Quotas de IAM & Admin, augmentez les quotas qui ne répondent pas aux exigences de SAP HANA décrites dans le guide de planification SAP HANA.

Sur la page Déploiements de Deployment Manager, supprimez le déploiement pour nettoyer les VM et les disques persistants de l'installation ayant échoué.

Réexécutez le déploiement.

- Si

Se connecter aux VM pour contrôler les disques et les services SAP HANA

Une fois le déploiement terminé, assurez-vous que les disques et les services SAP HANA sont correctement déployés. Pour ce faire, contrôlez les disques et les services de l'hôte maître et d'un hôte de calcul.

Sur la page "Instances de VM" Compute Engine, connectez-vous à la VM de l'hôte maître et à la VM d'un hôte de calcul en cliquant sur le bouton "SSH" qui se trouve sur la ligne de chacune des deux instances de VM.

Accéder à la page "Instances de VM"

Veillez à bien vous connecter à l'hôte de calcul, et non à un hôte de secours. Les hôtes de secours utilisent la même convention de dénomination que les hôtes de calcul, mais le suffixe d'hôte de calcul le plus élevé avant la première reprise est ajouté à leur nom. Par exemple, si vous utilisez trois hôtes de calcul et un hôte de secours, avant la première reprise, le suffixe de l'hôte de secours est "w4".

Dans chaque fenêtre de terminal, connectez-vous en tant qu'utilisateur racine.

sudo su -

Dans chaque fenêtre de terminal, affichez le système de fichiers du disque.

df -h

Sur l'hôte maître, un résultat semblable au suivant doit s'afficher :

hana-scaleout-w-failover:~ # df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 8.0K 126G 1% /dev tmpfs 189G 0 189G 0% /dev/shm tmpfs 126G 18M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda3 45G 5.6G 40G 13% / /dev/sda2 20M 2.9M 18M 15% /boot/efi 10.135.35.138:/hana_shr 1007G 50G 906G 6% /hana/shared tmpfs 26G 0 26G 0% /run/user/473 10.197.239.138:/hana_bup 1007G 0 956G 0% /hanabackup tmpfs 26G 0 26G 0% /run/user/900 /dev/mapper/vg_hana-data 709G 7.7G 702G 2% /hana/data/HF0/mnt00001 /dev/mapper/vg_hana-log 125G 5.3G 120G 5% /hana/log/HF0/mnt00001 tmpfs 26G 0 26G 0% /run/user/1003

Sur un hôte de calcul, vous constatez que les répertoires

/hana/dataet/hana/logont des points de montage différents.hana-scaleout-w-failoverw2:~ # df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 8.0K 126G 1% /dev tmpfs 189G 0 189G 0% /dev/shm tmpfs 126G 9.2M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda3 45G 5.6G 40G 13% / /dev/sda2 20M 2.9M 18M 15% /boot/efi tmpfs 26G 0 26G 0% /run/user/0 10.135.35.138:/hana_shr 1007G 50G 906G 6% /hana/shared 10.197.239.138:/hana_bup 1007G 0 956G 0% /hanabackup /dev/mapper/vg_hana-data 709G 821M 708G 1% /hana/data/HF0/mnt00003 /dev/mapper/vg_hana-log 125G 2.2G 123G 2% /hana/log/HF0/mnt00003 tmpfs 26G 0 26G 0% /run/user/1003

Sur un hôte de secours, les répertoires de données et de journaux ne sont pas montés tant qu'il ne prend pas le relais d'un hôte défaillant.

hana-scaleout-w-failoverw4:~ # df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 8.0K 126G 1% /dev tmpfs 189G 0 189G 0% /dev/shm tmpfs 126G 18M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda3 45G 5.6G 40G 13% / /dev/sda2 20M 2.9M 18M 15% /boot/efi tmpfs 26G 0 26G 0% /run/user/0 10.135.35.138:/hana_shr 1007G 50G 906G 6% /hana/shared 10.197.239.138:/hana_bup 1007G 0 956G 0% /hanabackup tmpfs 26G 0 26G 0% /run/user/1003

Dans chaque fenêtre de terminal, connectez-vous en tant qu'utilisateur du système d'exploitation SAP HANA.

su - SID_LCadm

Remplacez

SID_LCpar la valeur [SID] que vous avez spécifiée dans le modèle de fichier de configuration. Utilisez des minuscules pour toutes les lettres.Dans chaque fenêtre de terminal, assurez-vous que les services SAP HANA, tels que

hdbnameserver,hdbindexserveret d'autres, s'exécutent sur l'instance.HDB info

Sur l'hôte maître, la sortie qui s'affiche doit être semblable à la sortie dans l'exemple tronqué suivant :

hf0adm@hana-scaleout-w-failover:/usr/sap/HF0/HDB00> HDB info USER PID PPID %CPU VSZ RSS COMMAND hf0adm 5936 5935 0.7 18540 6776 -sh hf0adm 6011 5936 0.0 14128 3856 \_ /bin/sh /usr/sap/HF0/HDB00/HDB info hf0adm 6043 6011 0.0 34956 3568 \_ ps fx -U hf0adm -o user:8,pid:8,ppid:8,pcpu:5,vsz:10 hf0adm 17950 1 0.0 23052 3168 sapstart pf=/hana/shared/HF0/profile/HF0_HDB00_hana-scaleout hf0adm 17957 17950 0.0 457332 70956 \_ /usr/sap/HF0/HDB00/hana-scaleout-w-failover/trace/hdb.sa hf0adm 17975 17957 1.8 9176656 3432456 \_ hdbnameserver hf0adm 18334 17957 0.4 4672036 229204 \_ hdbcompileserver hf0adm 18337 17957 0.4 4941180 257348 \_ hdbpreprocessor hf0adm 18385 17957 4.5 9854464 4955636 \_ hdbindexserver -port 30003 hf0adm 18388 17957 1.2 7658520 1424708 \_ hdbxsengine -port 30007 hf0adm 18865 17957 0.4 6640732 526104 \_ hdbwebdispatcher hf0adm 14230 1 0.0 568176 32100 /usr/sap/HF0/HDB00/exe/sapstartsrv pf=/hana/shared/HF0/profi hf0adm 10920 1 0.0 710684 51560 hdbrsutil --start --port 30003 --volume 3 --volumesuffix mn hf0adm 10575 1 0.0 710680 51104 hdbrsutil --start --port 30001 --volume 1 --volumesuffix mn hf0adm 10217 1 0.0 72140 7752 /usr/lib/systemd/systemd --user hf0adm 10218 10217 0.0 117084 2624 \_ (sd-pam)

Sur un hôte de calcul, la sortie qui s'affiche doit être semblable à la sortie dans l'exemple tronqué suivant :

hf0adm@hana-scaleout-w-failoverw2:/usr/sap/HF0/HDB00> HDB info USER PID PPID %CPU VSZ RSS COMMAND hf0adm 22136 22135 0.3 18540 6804 -sh hf0adm 22197 22136 0.0 14128 3892 \_ /bin/sh /usr/sap/HF0/HDB00/HDB info hf0adm 22228 22197 100 34956 3528 \_ ps fx -U hf0adm -o user:8,pid:8,ppid:8,pcpu:5,vsz:10 hf0adm 9138 1 0.0 23052 3064 sapstart pf=/hana/shared/HF0/profile/HF0_HDB00_hana-scaleout hf0adm 9145 9138 0.0 457360 70900 \_ /usr/sap/HF0/HDB00/hana-scaleout-w-failoverw2/trace/hdb. hf0adm 9163 9145 0.7 7326228 755772 \_ hdbnameserver hf0adm 9336 9145 0.5 4670756 226972 \_ hdbcompileserver hf0adm 9339 9145 0.6 4942460 259724 \_ hdbpreprocessor hf0adm 9385 9145 2.0 7977460 1666792 \_ hdbindexserver -port 30003 hf0adm 9584 9145 0.5 6642012 528840 \_ hdbwebdispatcher hf0adm 8226 1 0.0 516532 52676 hdbrsutil --start --port 30003 --volume 5 --volumesuffix mn hf0adm 7756 1 0.0 567520 31316 /hana/shared/HF0/HDB00/exe/sapstartsrv pf=/hana/shared/HF0/p

Sur un hôte de secours, la sortie qui s'affiche doit être semblable à la sortie dans l'exemple tronqué suivant :

hana-scaleout-w-failoverw4:~ # su - hf0adm hf0adm@hana-scaleout-w-failoverw4:/usr/sap/HF0/HDB00> HDB info USER PID PPID %CPU VSZ RSS COMMAND hf0adm 19926 19925 0.2 18540 6748 -sh hf0adm 19987 19926 0.0 14128 3864 \_ /bin/sh /usr/sap/HF0/HDB00/HDB info hf0adm 20019 19987 0.0 34956 3640 \_ ps fx -U hf0adm -o user:8,pid:8,ppid:8,pcpu:5,vsz:10 hf0adm 8120 1 0.0 23052 3232 sapstart pf=/hana/shared/HF0/profile/HF0_HDB00_hana-scaleout hf0adm 8127 8120 0.0 457348 71348 \_ /usr/sap/HF0/HDB00/hana-scaleout-w-failoverw4/trace/hdb. hf0adm 8145 8127 0.6 7328784 708284 \_ hdbnameserver hf0adm 8280 8127 0.4 4666916 223892 \_ hdbcompileserver hf0adm 8283 8127 0.4 4939904 256740 \_ hdbpreprocessor hf0adm 8328 8127 0.4 6644572 534044 \_ hdbwebdispatcher hf0adm 7374 1 0.0 633568 31520 /hana/shared/HF0/HDB00/exe/sapstartsrv pf=/hana/shared/HF0/p

Si vous utilisez RHEL pour SAP 9.0 ou une version ultérieure, assurez-vous que les packages

chkconfigetcompat-openssl11sont installés sur votre instance de VM.Pour en savoir plus, consultez la note SAP 3108316 – Red Hat Enterprise Linux 9.x : installation et configuration.

Connecter SAP HANA Studio

Connectez-vous à l'hôte maître SAP HANA à partir de SAP HANA Studio.

Vous pouvez vous connecter à partir d'une instance de SAP HANA Studio située en dehors de Google Cloud ou d'une instance sur Google Cloud. Vous devrez peut-être activer l'accès réseau entre les VM cibles et SAP HANA Studio.

Pour utiliser SAP HANA Studio sur Google Cloud et activer l'accès au système SAP HANA, consultez la section Installer SAP HANA Studio sur une VM Windows Compute Engine.

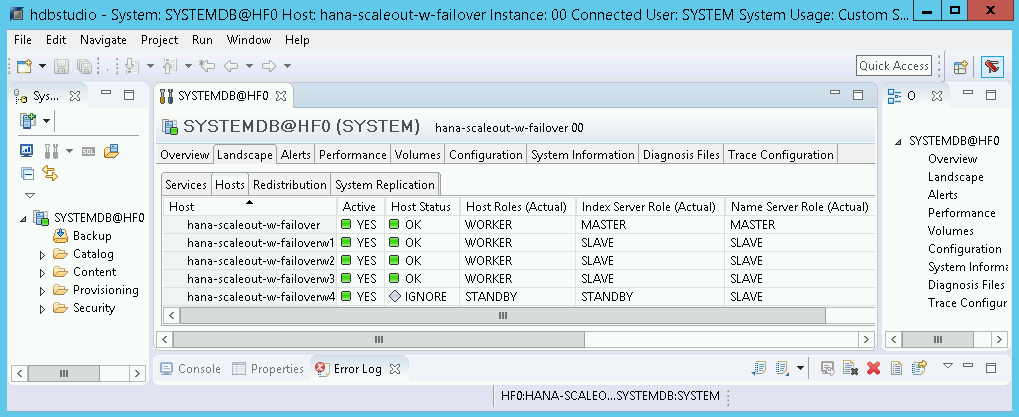

Dans SAP HANA Studio, cliquez sur l'onglet Landscape (Environnement) dans le panneau d'administration système par défaut. Un écran semblable à l'exemple suivant doit s'afficher :

Si l'une des étapes de validation indique que l'installation a échoué, procédez comme suit :

- Corrigez l'erreur.

- Sur la page Déploiements, supprimez le déploiement.

- Réexécutez le déploiement.

Effectuer un test de basculement

Après avoir vérifié que le système SAP HANA a bien été déployé, testez la fonction de basculement.

Les instructions suivantes déclenchent un basculement en vous connectant en tant qu'utilisateur du système d'exploitation SAP HANA et en saisissant la commande HDB stop. La commande HDB stop lance un arrêt progressif de SAP HANA et dissocie les disques de l'hôte, ce qui permet un basculement relativement rapide.

Pour effectuer un test de basculement, procédez comme suit :

Connectez-vous à la VM d'un hôte de calcul à l'aide de SSH. Vous pouvez vous connecter à partir de la page "Instances de VM" Compute Engine en cliquant sur le bouton "SSH" de chaque instance de VM. Vous avez également la possibilité d'utiliser la méthode SSH de votre choix.

Connectez-vous en tant qu'utilisateur du système d'exploitation SAP HANA. Dans l'exemple suivant, remplacez

SID_LCpar le SID que vous avez défini pour votre système.su - SID_LCadm

Simulez une défaillance en arrêtant SAP HANA :

HDB stop

La commande

HDB stopprovoque l'arrêt de SAP HANA, ce qui déclenche un basculement. Pendant le basculement, les disques sont dissociés de l'hôte défaillant et réassociés à l'hôte de secours. L'hôte défaillant est redémarré et devient un hôte de secours.Attendez que l'opération de reprise se termine, puis reconnectez-vous via SSH à l'hôte ayant pris le relais de l'hôte défaillant.

Connectez-vous en tant qu'utilisateur racine.

sudo su -

Affichez le système de fichiers du disque des VM de l'hôte maître et des hôtes de calcul.

df -h

Des résultats semblables aux lignes suivantes devraient s'afficher : Les répertoires

/hana/dataet/hana/logde l'hôte défaillant sont désormais montés sur l'hôte qui a pris le relais.hana-scaleout-w-failoverw4:~ # df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 8.0K 126G 1% /dev tmpfs 189G 0 189G 0% /dev/shm tmpfs 126G 9.2M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda3 45G 5.6G 40G 13% / /dev/sda2 20M 2.9M 18M 15% /boot/efi tmpfs 26G 0 26G 0% /run/user/0 10.74.146.58:/hana_shr 1007G 50G 906G 6% /hana/shared 10.188.249.170:/hana_bup 1007G 0 956G 0% /hanabackup /dev/mapper/vg_hana-data 709G 821M 708G 1% /hana/data/HF0/mnt00003 /dev/mapper/vg_hana-log 125G 2.2G 123G 2% /hana/log/HF0/mnt00003 tmpfs 26G 0 26G 0% /run/user/1003

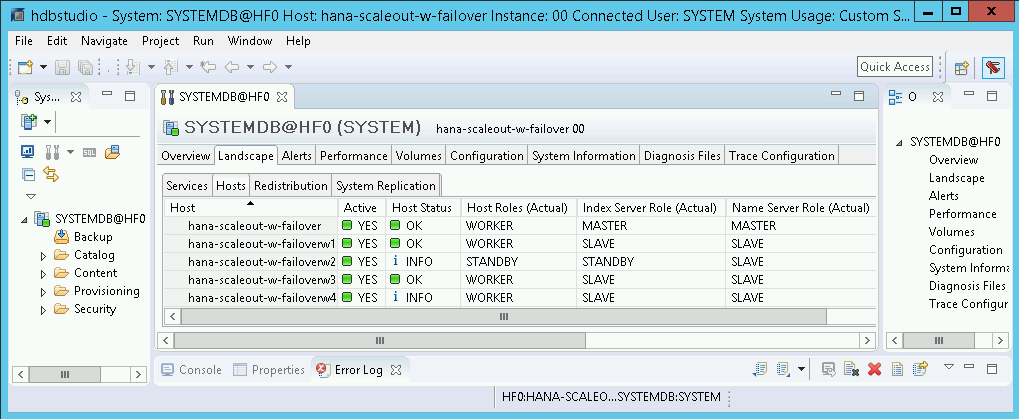

Dans SAP HANA Studio, ouvrez la vue Landscape (Environnement) du système SAP HANA, puis vérifiez les points suivants pour vous assurer que le basculement a bien été effectué :

- L'état des hôtes impliqués dans le basculement doit être

INFO. - Dans la colonne Index Server Role (Actual) (Rôle du serveur d'index (actuel)), l'hôte défaillant doit désormais s'afficher en tant que nouvel hôte de secours.

- L'état des hôtes impliqués dans le basculement doit être

Vérifier l'installation de l'agent Google Cloudpour SAP

Après avoir déployé une VM et installé le système SAP, vérifiez que l'agentGoogle Cloudpour SAP fonctionne correctement.

Vérifier que l'agent pour SAP de Google Cloudest en cours d'exécution

Pour vérifier que l'agent est en cours d'exécution, procédez comme suit :

Établissez une connexion SSH avec votre instance Compute Engine.

Exécutez la commande suivante :

systemctl status google-cloud-sap-agent

Si l'agent fonctionne correctement, la sortie contient

active (running). Exemple :google-cloud-sap-agent.service - Google Cloud Agent for SAP Loaded: loaded (/usr/lib/systemd/system/google-cloud-sap-agent.service; enabled; vendor preset: disabled) Active: active (running) since Fri 2022-12-02 07:21:42 UTC; 4 days ago Main PID: 1337673 (google-cloud-sa) Tasks: 9 (limit: 100427) Memory: 22.4 M (max: 1.0G limit: 1.0G) CGroup: /system.slice/google-cloud-sap-agent.service └─1337673 /usr/bin/google-cloud-sap-agent

Si l'agent n'est pas en cours d'exécution, redémarrez-le.

Vérifier que l'agent hôte SAP reçoit les métriques

Pour vérifier que les métriques d'infrastructure sont collectées par l'agentGoogle Cloudpour SAP et envoyées correctement à l'agent hôte SAP, procédez comme suit:

- Dans votre système SAP, saisissez la transaction

ST06. Dans le volet de synthèse, vérifiez la disponibilité et le contenu des champs suivants pour vous assurer de la configuration de façon correcte et complète de l'infrastructure de surveillance SAP et Google :

- Fournisseur cloud :

Google Cloud Platform - Accès à la surveillance améliorée :

TRUE - Détails de la surveillance améliorée :

ACTIVE

- Fournisseur cloud :

Configurer la surveillance pour SAP HANA

Vous pouvez éventuellement surveiller vos instances SAP HANA à l'aide de l'agentGoogle Cloudpour SAP. À partir de la version 2.0, vous pouvez configurer l'agent de sorte qu'il collecte les métriques de surveillance SAP HANA et les envoie à Cloud Monitoring. Cloud Monitoring vous permet de créer des tableaux de bord pour visualiser ces métriques, de configurer des alertes en fonction de seuils de métriques, etc.

Pour en savoir plus sur la collecte des métriques de surveillance SAP HANA à l'aide de l'agentGoogle Cloudpour SAP, consultez Collecte des métriques de surveillance SAP HANA.

Activer le redémarrage rapide de SAP HANA

Google Cloud Nous vous recommandons vivement d'activer le redémarrage rapide SAP HANA pour chaque instance de SAP HANA, en particulier pour les instances de grande capacité. Le redémarrage rapide de SAP HANA réduit le temps de redémarrage en cas d'arrêt de SAP HANA, mais le système d'exploitation reste en cours d'exécution.

Comme configuré par les scripts d'automatisation fournis par Google Cloud , les paramètres du système d'exploitation et du noyau sont déjà compatibles avec le redémarrage rapide de SAP HANA.

Vous devez définir le système de fichiers tmpfs et configurer SAP HANA.

Pour définir le système de fichiers tmpfs et configurer SAP HANA, vous pouvez suivre les étapes manuelles ou utiliser le script d'automatisation fourni parGoogle Cloud pour activer le redémarrage rapide de SAP HANA. Pour en savoir plus, consultez les pages suivantes :

- Étapes manuelles : Activer le redémarrage rapide de SAP HANA

- Étapes automatisées : Activer le redémarrage rapide de SAP HANA

Pour obtenir des instructions faisant autorité sur la fonction de redémarrage rapide SAP HANA, consultez la documentation sur les options de redémarrage rapide de SAP HANA.

Étapes manuelles

Configurer le système de fichiers tmpfs

Une fois les VM hôtes et les systèmes SAP HANA de base déployés, vous devez créer et installer des répertoires pour les nœuds NUMA du système de fichiers tmpfs.

Afficher la topologie NUMA de votre VM

Pour pouvoir mapper le système de fichiers tmpfs requis, vous devez connaître la quantité de nœuds NUMA dont dispose votre VM. Pour afficher les nœuds NUMA disponibles sur une VM Compute Engine, saisissez la commande suivante :

lscpu | grep NUMA

Par exemple, un type de VM m2-ultramem-208 comporte quatre nœuds NUMA, numérotés de 0 à 3, comme illustré dans l'exemple suivant :

NUMA node(s): 4 NUMA node0 CPU(s): 0-25,104-129 NUMA node1 CPU(s): 26-51,130-155 NUMA node2 CPU(s): 52-77,156-181 NUMA node3 CPU(s): 78-103,182-207

Créer les répertoires de nœuds NUMA

Créez un répertoire pour chaque nœud NUMA de votre VM et définissez les autorisations.

Par exemple, pour quatre nœuds NUMA numérotés de 0 à 3 :

mkdir -pv /hana/tmpfs{0..3}/SID

chown -R SID_LCadm:sapsys /hana/tmpfs*/SID

chmod 777 -R /hana/tmpfs*/SIDInstaller les répertoires de nœuds NUMA dans tmpfs

Montez les répertoires du système de fichiers tmpfs et spécifiez une préférence de nœud NUMA pour chacun avec mpol=prefer :

SID : spécifiez le SID en majuscules.

mount tmpfsSID0 -t tmpfs -o mpol=prefer:0 /hana/tmpfs0/SID mount tmpfsSID1 -t tmpfs -o mpol=prefer:1 /hana/tmpfs1/SID mount tmpfsSID2 -t tmpfs -o mpol=prefer:2 /hana/tmpfs2/SID mount tmpfsSID3 -t tmpfs -o mpol=prefer:3 /hana/tmpfs3/SID

Mettre à jour /etc/fstab

Pour vous assurer que les points d'installation sont disponibles après un redémarrage du système d'exploitation, ajoutez des entrées dans la table du système de fichiers, /etc/fstab :

tmpfsSID0 /hana/tmpfs0/SID tmpfs rw,nofail,relatime,mpol=prefer:0 tmpfsSID1 /hana/tmpfs1/SID tmpfs rw,nofail,relatime,mpol=prefer:1 tmpfsSID1 /hana/tmpfs2/SID tmpfs rw,nofail,relatime,mpol=prefer:2 tmpfsSID1 /hana/tmpfs3/SID tmpfs rw,nofail,relatime,mpol=prefer:3

Facultatif : définir des limites à l'utilisation de la mémoire

Le système de fichiers tmpfs peut augmenter ou diminuer de manière dynamique.

Pour limiter la mémoire utilisée par le système de fichiers tmpfs, vous pouvez définir une limite de taille pour un volume de nœuds NUMA en utilisant l'option size.

Exemple :

mount tmpfsSID0 -t tmpfs -o mpol=prefer:0,size=250G /hana/tmpfs0/SID

Vous pouvez également limiter l'utilisation globale de la mémoire tmpfs pour tous les nœuds NUMA d'une instance SAP HANA donnée et d'un nœud de serveur donné en définissant le paramètre persistent_memory_global_allocation_limit dans la section [memorymanager] du fichier global.ini.

Configuration de SAP HANA pour le redémarrage rapide

Pour configurer SAP HANA pour le redémarrage rapide, mettez à jour le fichier global.ini et spécifiez les tables à stocker dans la mémoire persistante.

Mettre à jour la section [persistence] du fichier global.ini

Configurez la section [persistence] du fichier SAP HANA global.ini de manière à référencer les emplacements tmpfs. Séparez chaque emplacement tmpfs par un point-virgule :

[persistence] basepath_datavolumes = /hana/data basepath_logvolumes = /hana/log basepath_persistent_memory_volumes = /hana/tmpfs0/SID;/hana/tmpfs1/SID;/hana/tmpfs2/SID;/hana/tmpfs3/SID

L'exemple précédent spécifie quatre volumes de mémoire pour quatre nœuds NUMA, ce qui correspond à m2-ultramem-208. Si vous l'exécutez sur m2-ultramem-416, vous devez configurer huit volumes de mémoire (de 0 à 7).

Redémarrez SAP HANA après avoir modifié le fichier global.ini.

SAP HANA peut désormais utiliser l'emplacement tmpfs comme espace de mémoire persistant.

Spécifier les tables à stocker en mémoire persistante

Spécifiez des tables ou partitions de colonne spécifiques à stocker en mémoire persistante.

Par exemple, pour activer la mémoire persistante pour une table existante, exécutez la requête SQL :

ALTER TABLE exampletable persistent memory ON immediate CASCADE

Pour modifier la valeur par défaut des nouvelles tables, ajoutez le paramètre table_default dans le fichier indexserver.ini. Exemple :

[persistent_memory] table_default = ON

Pour en savoir plus sur le contrôle des colonnes et des tables ainsi que sur les vues de surveillance qui fournissent des informations détaillées, consultez la page Mémoire persistante SAP HANA.

Étapes automatisées

Le script d'automatisation fourni par Google Cloud pour activer le redémarrage rapide de SAP HANA apporte des modifications aux répertoires /hana/tmpfs*, au fichier /etc/fstab et à la configuration de SAP HANA. Google Cloud Lorsque vous exécuterez le script, vous devrez peut-être effectuer des étapes supplémentaires selon qu'il s'agit du déploiement initial de votre système SAP HANA ou que vous redimensionnez votre machine sur une autre taille NUMA.

Pour le déploiement initial de votre système SAP HANA ou le redimensionnement de la machine pour augmenter le nombre de nœuds NUMA, assurez-vous que SAP HANA est en cours d'exécution pendant l'exécution du script d'automatisation fourni par Google Cloudpour activer le redémarrage rapide de SAP HANA.

Lorsque vous redimensionnez votre machine pour réduire le nombre de nœuds NUMA, assurez-vous que SAP HANA est arrêté pendant l'exécution du script d'automatisation fourni par Google Cloud pour activer le redémarrage rapide de SAP HANA. Une fois le script exécuté, vous devez mettre à jour manuellement la configuration SAP HANA pour terminer la configuration du redémarrage rapide de SAP HANA. Pour en savoir plus, consultez la section Configuration de SAP HANA pour le redémarrage rapide.

Pour activer le redémarrage rapide de SAP HANA, procédez comme suit :

Établissez une connexion SSH avec votre VM hôte.

Passez en mode root :

sudo su -

Téléchargez le script

sap_lib_hdbfr.sh:wget https://storage.googleapis.com/cloudsapdeploy/terraform/latest/terraform/lib/sap_lib_hdbfr.sh

Rendez le fichier exécutable :

chmod +x sap_lib_hdbfr.sh

Vérifiez que le script ne comporte aucune erreur :

vi sap_lib_hdbfr.sh ./sap_lib_hdbfr.sh -help

Si la commande renvoie une erreur, contactez le Cloud Customer Care. Pour savoir comment contacter le service client, consultez la page Obtenir de l'aide pour SAP sur Google Cloud.

Exécutez le script après avoir remplacé l'ID système (SID) et le mot de passe SAP HANA de l'utilisateur système de la base de données SAP HANA. Pour fournir le mot de passe en toute sécurité, nous vous recommandons d'utiliser un secret dans Secret Manager.

Exécutez le script en utilisant le nom d'un secret dans Secret Manager. Ce secret doit exister dans le projet Google Cloud qui contient votre instance de VM hôte.

sudo ./sap_lib_hdbfr.sh -h 'SID' -s SECRET_NAME

Remplacez les éléments suivants :

SID: spécifiez le SID en majuscules. Par exemple,AHA.SECRET_NAME: spécifiez le nom du secret correspondant au mot de passe de l'utilisateur système de la base de données SAP HANA. Ce secret doit exister dans le projet Google Cloud qui contient votre instance de VM hôte.

Vous pouvez également exécuter le script en utilisant un mot de passe en texte brut. Une fois le redémarrage rapide de SAP HANA activé, veillez à modifier votre mot de passe. L'utilisation d'un mot de passe en texte brut n'est pas recommandée, car celui-ci serait enregistré dans l'historique de ligne de commande de votre VM.

sudo ./sap_lib_hdbfr.sh -h 'SID' -p 'PASSWORD'

Remplacez les éléments suivants :

SID: spécifiez le SID en majuscules. Par exemple,AHA.PASSWORD: spécifiez le mot de passe de l'utilisateur système de la base de données SAP HANA.

Dans le cas d'une exécution initiale réussie, vous devez obtenir une sortie semblable à celle-ci :

INFO - Script is running in standalone mode

ls: cannot access '/hana/tmpfs*': No such file or directory

INFO - Setting up HANA Fast Restart for system 'TST/00'.

INFO - Number of NUMA nodes is 2

INFO - Number of directories /hana/tmpfs* is 0

INFO - HANA version 2.57

INFO - No directories /hana/tmpfs* exist. Assuming initial setup.

INFO - Creating 2 directories /hana/tmpfs* and mounting them

INFO - Adding /hana/tmpfs* entries to /etc/fstab. Copy is in /etc/fstab.20220625_030839

INFO - Updating the HANA configuration.

INFO - Running command: select * from dummy

DUMMY

"X"

1 row selected (overall time 4124 usec; server time 130 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('global.ini', 'SYSTEM') SET ('persistence', 'basepath_persistent_memory_volumes') = '/hana/tmpfs0/TST;/hana/tmpfs1/TST;'

0 rows affected (overall time 3570 usec; server time 2239 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('global.ini', 'SYSTEM') SET ('persistent_memory', 'table_unload_action') = 'retain';

0 rows affected (overall time 4308 usec; server time 2441 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('indexserver.ini', 'SYSTEM') SET ('persistent_memory', 'table_default') = 'ON';

0 rows affected (overall time 3422 usec; server time 2152 usec)

Se connecter à SAP HANA

Étant donné qu'aucune adresse IP externe n'est utilisée pour SAP HANA dans ces instructions, vous ne pouvez vous connecter aux instances SAP HANA que via l'instance bastion à l'aide de SSH ou via le serveur Windows à l'aide de SAP HANA Studio.

Pour vous connecter à SAP HANA via l'instance bastion, connectez-vous à l'hôte bastion, puis aux instances SAP HANA à l'aide du client SSH de votre choix.

Pour vous connecter à la base de données SAP HANA via SAP HANA Studio, utilisez un client Bureau à distance pour vous connecter à l'instance Windows Server. Une fois la connexion établie, installez SAP HANA Studio manuellement, puis accédez à votre base de données SAP HANA.

Effectuer des tâches post-déploiement

Avant d'utiliser votre instance SAP HANA, nous vous recommandons d'effectuer les étapes de post-déploiement ci-dessous. Pour en savoir plus, consultez le guide d'installation et de mise à jour de SAP HANA.

Modifiez les mots de passe temporaires de l'administrateur système et du super-utilisateur de la base de données SAP HANA.

Mettez à jour le logiciel SAP HANA avec les derniers correctifs.

Installez des composants supplémentaires tels que les bibliothèques Application Function Library (AFL) ou Smart Data Access (SDA).

Si vous mettez à niveau un système SAP HANA existant, chargez les données à partir du système existant à l'aide de procédures de sauvegarde et de restauration standards ou en utilisant la réplication du système SAP HANA.

Configurez et sauvegardez votre nouvelle base de données SAP HANA. Pour en savoir plus, consultez le Guide d'utilisation de SAP HANA.

Étape suivante

- Pour en savoir plus sur l'administration et la surveillance des VM, consultez le Guide d'utilisation de SAP HANA.