SAP용 BigQuery 툴킷을 사용하면 ABAP을 사용하여 SAP 환경 내에서 BigQuery 리소스에 프로그래매틱 방식으로 액세스할 수 있습니다. 다음과 같은 일반 작업에 대한 상용구 코드를 작성하지 않고도 SAP에서 BigQuery 리소스에 액세스할 수 있습니다.

- 테이블 정의 동기화: SAP 및 BigQuery 테이블을 동기화된 상태로 유지합니다.

- 데이터 유형 매핑: SAP와 BigQuery 간의 데이터 유형을 매핑합니다.

- 데이터 청크화: 대규모 데이터 세트를 효율적으로 전송합니다.

- 오류 처리: 데이터 복제 중에 발생할 수 있는 오류를 관리합니다.

SAP Landscape Transformation Replication Server가 필요한 SAP용 BigQuery 커넥터와 달리 ABAP가 지원되는 모든 SAP ERP 시스템 내에서 SAP용 BigQuery 툴킷을 사용할 수 있습니다.

SAP용 BigQuery 툴킷은 ABAP SDK for Google Cloud의 온프레미스 또는 클라우드 버전의 하위 패키지로 제공됩니다. 툴킷을 사용하려면 SAP 환경에 SDK를 설치해야 합니다. 설치 단계에 관한 자세한 내용은 ABAP SDK for Google Cloud의 온프레미스 또는 모든 클라우드 버전 설치 및 구성을 참고하세요.

SAP용 BigQuery 툴킷은 ABAP SDK for Google Cloud의 온프레미스 또는 클라우드 버전에서만 사용할 수 있습니다.

SAP에서 BigQuery로의 데이터 복제

SAP용 BigQuery 툴킷의 BigQuery Data Transfer 모듈을 사용하면 분석 및 보고를 위해 SAP에서 BigQuery로 데이터를 복제할 수 있습니다.

다음 다이어그램은 BigQuery Data Transfer 모듈의 데이터 전송 구성 및 데이터 복제 흐름을 보여줍니다.

데이터 전송 구성

이전 섹션의 다이어그램에 표시된 대로 SAP에서 BigQuery로의 데이터 복제를 설정하려면 관리자가 다음 구성을 실행해야 합니다.

- Google Cloud에서 클라우드 관리자는 BigQuery를 구성하고 필요한 IAM 권한을 부여합니다.

- SAP 시스템에서 SAP 시스템 관리자는 Google Cloud와의 통신을 허용하도록 ABAP SDK for Google Cloud를 구성합니다.

- SAP 시스템에서 SAP 시스템 관리자는 데이터 전송 설정 및 BigQuery 리소스 세부정보를 관리하도록 BigQuery Data Transfer 모듈을 구성합니다. 이러한 구성은 다음 표에 저장됩니다.

/GOOG/BQTR_MASTER/GOOG/BQTR_TABLE/GOOG/BQTR_FIELD/GOOG/BQTR_PARAMS

ABAP 코드가 실행되면 BigQuery 데이터 로드 클래스가 이러한 테이블에서 구성을 읽어 데이터 복제 프로세스를 안내합니다.

데이터 복제 흐름

이전 섹션의 다이어그램에 표시된 대로 SAP 시스템에서 BigQuery로 데이터를 복제하기 위해 ABAP 개발자는 다음 작업을 실행하는 맞춤 ABAP 코드를 작성합니다.

- 표준 또는 맞춤 SAP 테이블에서 데이터를 읽습니다.

BigQuery 데이터 로드 클래스

/GOOG/CL_BQTR_DATA_LOAD를 사용하여 선택한 데이터를 BigQuery에 복제합니다. 이 클래스는 다음을 충족해야 합니다.- BigQuery Data Transfer 구성 테이블에 저장된 구성을 사용합니다.

/GOOG/CL_BIGQUERY_V2클래스를 사용하여 테이블 정의 동기화 및 데이터 복제를 실행합니다.

후속 비즈니스 로직을 구현합니다.

오류 및 예외를 처리합니다.

데이터 복제에 지원되는 소스

SAP용 BigQuery 툴킷의 BigQuery Data Transfer 모듈을 사용하여 테이블, 사전 뷰, CDS 뷰, CDS 엔티티와 같은 ABAP 사전 객체 또는 플랫 구조 유형의 데이터 객체에서 BigQuery로 데이터를 프로그래매틱 방식으로 로드할 수 있습니다.

다음과 같은 방법으로 SAP용 BigQuery 툴킷을 사용하여 데이터 복제를 수행할 수 있습니다.

- 비즈니스 부가기능 (BAdI), 사용자 종료, 루틴과 같은 SAP 개선 프레임워크 내의 플러그인 예를 들어 툴킷을 비즈니스 웨어하우스 (BW) 루틴에 연결하여 BW 데이터 전송 프로세스 (DTP)에서 처리되는 데이터를 전송할 수 있습니다.

- 맞춤 ABAP 프로그램에서 데이터를 일괄 로드하는 데 사용됩니다.

성능 계획

SAP용 BigQuery 툴킷은 BigQuery API에 동기식 호출을 수행하여 BigQuery로의 데이터 전송의 최종 단계를 제공합니다.

맞춤 ABAP 애플리케이션 내에서 SAP용 BigQuery 툴킷을 사용하면 SAP 워크로드 내에서와 BigQuery Data Transfer 구성을 통해 데이터 복제 성능을 최적화할 수 있습니다.

SAP 워크로드 및 맞춤 애플리케이션의 성능 조정 옵션

SAP 워크로드와 맞춤 애플리케이션의 성능을 최적화하려면 다음 옵션을 고려하세요.

- SAP 워크로드(데이터가 BigQuery로 복제되는 소스 시스템)를 Google Cloud에서 실행합니다.

- SAP 워크로드가 Google Cloud에 있는 경우 SAP 워크로드와 동일한 리전에 BigQuery 데이터 세트를 만듭니다.

- Google Cloud에서 SAP 워크로드를 실행할 수 없는 경우 다음 단계를 따르세요.

- SAP 워크로드와 가장 가까운 Google Cloud 리전에 BigQuery 데이터 세트를 만듭니다.

- Cloud Interconnect를 사용하여 Google Cloud 에 연결합니다.

- 워크로드에 맞게 SAP 서버 시스템을 최적으로 조정합니다.

- 병렬 처리를 구현하여 여러 병렬 스레드에서 BigQuery Data Transfer 모듈을 호출하여 처리량을 늘립니다.

SAP용 BigQuery Toolkit은 BigQuery로의 데이터 전송의 최종 단계를 제공하므로 성능은 특정 환경 내의 다양한 요인에 영향을 받습니다. 이러한 요인에는 다음이 포함될 수 있습니다.

네트워크 인프라: 대역폭 제한, 지연 시간, 전반적인 네트워크 안정성은 복제 속도와 효율성에 큰 영향을 미칩니다.

소스 시스템: 하드웨어, 구성, 현재 부하를 비롯한 소스 데이터베이스의 성능은 복제 성능에 영향을 줄 수 있습니다.

데이터 볼륨 및 변경률: 복제되는 데이터 양과 변경 빈도는 복제에 필요한 시간과 리소스에 영향을 미칩니다.

기타 구성요소: 방화벽, 보안 정책, 부하 분산기, 기타 인프라 요소는 모두 데이터 복제의 전반적인 성능에 영향을 미칠 수 있습니다.

자체 환경에서 SAP용 BigQuery 툴킷의 성능을 테스트해야 합니다. 최적의 결과를 얻으려면 환경의 모든 관련 구성요소를 고려하고 최적화하세요.

BigQuery Data Transfer 구성을 통해 사용할 수 있는 성능 조정 옵션

BigQuery Data Transfer 구성은 복제 성능을 제어하는 다음과 같은 옵션을 제공합니다.

데이터 전송 청크 크기

SAP용 BigQuery 툴킷은 BigQuery에 데이터를 레코드 청크로 전송합니다. SAP용 BigQuery 툴킷에 기본 청크 크기(레코드 10,000개)를 사용하는 것이 좋습니다. 소스 테이블의 레코드에 매우 적은 수의 필드가 포함되어 있거나 필드에 매우 작은 크기의 데이터 값이 포함되어 있으면 SAP용 BigQuery 툴킷이 허용하는 최대 청크 크기(레코드 50,000개)까지 더 큰 청크 크기를 사용할 수 있습니다.

지정된 청크의 레코드 수가 HTTP 요청의 바이트 크기에 대한 BigQuery 한도를 초과하는 바이트 크기로 확인되면 quotaExceeded 오류 또는 invalid 오류가 발생합니다. 소스 테이블의 레코드에 많은 필드가 포함되거나 필드에 많은 데이터가 포함된 경우에 이러한 문제가 발생할 수 있습니다.

청크 크기와 관련된 오류가 발생하면 해당 테이블의 대량 전송 구성에 지정된 청크 크기를 줄여보세요. 또는 청크 크기를 자동으로 조정하도록 해당 테이블의 동적 청크 크기를 사용 설정할 수 있습니다. 자세한 내용은 동적 청크 크기 조정을 참조하세요.

동적 청크 크기를 사용 설정하지 않았으면 MSEG, ACDOCA, MATDOC와 같이 레코드당 필드 수가 많은 대규모 레코드를 포함할 수 있는 SAP 소스 테이블의 경우, 단위 크기를 2,000개 미만으로 지정해야 할 수 있습니다.

/GOOG/BQTR_SETTINGS 트랜잭션을 실행하여 청크 크기를 지정할 수 있습니다. 청크 크기는 테이블 속성 화면의 청크 크기 필드에 지정됩니다.

레코드 압축

기본적으로 SAP용 BigQuery 툴킷은 BigQuery로 전송하는 레코드를 압축하여 복제 성능을 향상시켜 줍니다.

테이블 수준에서 레코드 압축이 사용 설정된 경우(기본 설정) SAP용 BigQuery 툴킷은 소스 레코드에 비어 있는 모든 필드를 BigQuery로 전송되는 레코드에서 생략합니다. 레코드가 BigQuery에 삽입되면 전송 데이터에서 생략된 필드가 BigQuery의 대상 테이블에서 null로 초기화됩니다.

하지만 테이블 수준에서 레코드 압축을 계속 사용하면서 일부 빈 필드를 초기 값으로 BigQuery에 복제해야 하는 경우 해당 필드의 레코드 압축 설정을 변경하면 됩니다. 따라서 지정된 필드의 빈 값은 전송된 데이터에서 생략되지 않으며 소스 테이블에서 초기화된 값이 무엇이든 유지됩니다.

대량 전송 구성에서 테이블 수준 및 필드 수준에서 사용할 수 있는 압축되지 않은 플래그 전송 설정을 사용하여 레코드 압축 동작을 제어할 수 있습니다. 다음 표에는 압축되지 않은 플래그 전송 설정에 따른 레코드 압축 동작이 요약되어 있습니다.

| 테이블 수준에서 압축되지 않은 플래그 전송 | 필드 수준에서 압축되지 않은 플래그 전송 | 레코드 압축 동작 |

|---|---|---|

| 예 | 아니요 | 모든 필드는 압축되지 않은 상태로 전송됩니다. |

| 예 | 예 | 모든 필드는 압축되지 않은 상태로 전송됩니다. |

| 아니요 | 예 | 필드 수준에서 선택된 필드만 압축되지 않은 상태로 전송됩니다. |

| 아니요 | 아니요 | 모든 필드가 압축된 상태로 전송됩니다. |

압축되지 않은 데이터 복제를 전송하면 날짜 필드 및 타임스탬프 필드를 제외하고 소스 테이블에서 초기화된 값이 무엇이든 빈 필드에 보존됩니다. 날짜 및 타임스탬프 필드의 초기화된 값에는 다음 값이 수신됩니다.

- 날짜 필드 초기화 값:

DATE 1970-01-01 - 타임스탬프 필드 초기화 값:

TIMESTAMP 1970-01-01 00:00:00 UTC

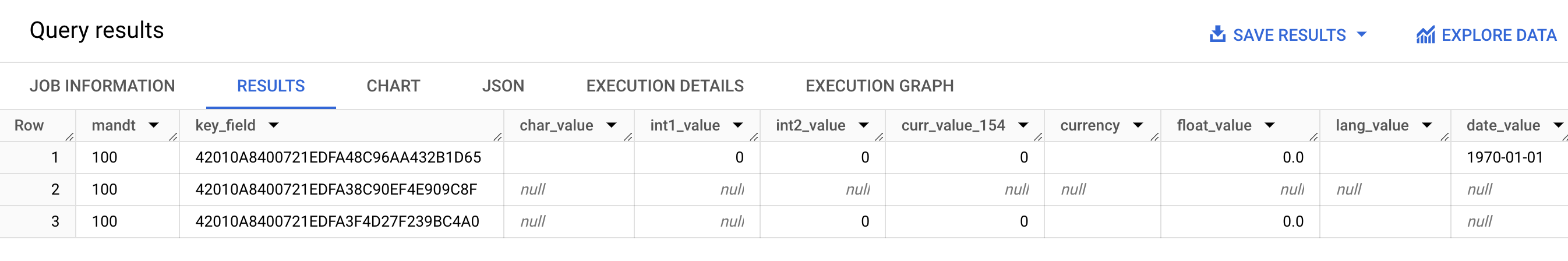

다음 스크린샷은 레코드 압축 동작의 예를 보여줍니다.

위 이미지는 다음을 보여줍니다.

- 행 1: 모든 필드가 압축 해제됩니다. 압축되지 않은 플래그 전송이 테이블 수준에서 선택됩니다.

- 행 2: 모든 필드가 압축됩니다. 압축되지 않은 플래그 전송은 테이블 수준에서 지워집니다.

- 3번째 행:

int2_value,curr_value_154,currency,float_value,lang_value필드가 압축 해제됩니다. 이러한 필드의 경우 압축되지 않은 플래그 전송이 필드 수준에서 선택됩니다.

성능 향상을 위해 테이블 수준에서 압축되지 않은 플래그 전송을 선택하여 레코드 압축을 사용 중지하지 않는 것이 좋습니다. 복제 성능에 부정적인 영향을 미칠 수 있습니다. 특정 필드에 대해서만 압축되지 않은 데이터를 전송해야 하는 경우 필드 수준에서 해당 특정 필드에 대해 압축되지 않은 플래그 전송을 선택합니다.

대상 테이블 속성

SAP용 BigQuery Toolkit의 BigQuery Data Transfer 모듈에서 복제를 구성할 때 SAP용 BigQuery Toolkit이 BigQuery에서 대상 테이블을 만들 때 적용되는 설정을 지정할 수 있습니다.

예를 들어 대상 BigQuery 테이블에 대해 다음 속성을 지정할 수 있습니다.

- 표 이름

- 필드의 기본 이름 지정 옵션

- 레코드 변경사항을 캡처하고 레코드 카운트 쿼리를 사용 설정하기 위한 추가 필드

- 테이블 파티션 나누기

필드의 기본 이름 지정 옵션

소스 필드 이름 또는 소스 필드의 라벨 및 설명으로 대상 BigQuery 테이블의 필드 이름을 생성하도록 SAP용 BigQuery 툴킷을 구성할 수 있습니다. 일반적으로 라벨 및 설명은 필드의 콘텐츠에 대한 유용한 정보를 제공합니다.

기본적으로 SAP용 BigQuery 툴킷에는 소스 필드의 이름이 사용됩니다.

/GOOG/BQTR_SETTINGS 트랜잭션의 대량 전송 구성에서 테이블 만들기 속성을 지정할 때 커스텀 이름 플래그를 지정하여 기본값을 변경할 수 있습니다. 이 사양은 /GOOG/BQTR_MASTR 구성 테이블에 저장됩니다.

이름을 만들 때 SAP용 BigQuery 툴킷에서 BigQuery 이름 지정 규칙에 따라 이름을 수정합니다.

SAP용 BigQuery 툴킷이 BigQuery에서 테이블을 만들기 전에 /GOOG/BQTR_SETTINGS 트랜잭션의 필드 매핑 화면에서 필드 이름을 수정할 수 있습니다.

커스텀 이름 플래그가 지정된 경우 대상 테이블을 만들 때 SAP용 BigQuery 툴킷에서 사용할 이름이 필드 매핑 화면의 외부 필드 이름 열 값에 표시됩니다.

SAP용 BigQuery 툴킷은 각 소스 필드의 중간 필드 라벨을 사용하여 외부 필드 이름 열의 이름을 만듭니다. 소스 필드 정의에 중간 필드 라벨이 지정되지 않았으면 필드의 짧은 설명이 사용됩니다. 짧은 설명도 지정되지 않았으면 가장 짧게 지정된 라벨이 사용됩니다. 아무것도 지정되지 않았으면 소스 필드의 이름이 사용됩니다.

대상 필드 이름 맞춤설정에 대한 상세 설명은 대상 필드 이름 맞춤설정을 참조하세요.

레코드 변경사항 캡처 및 레코드 카운트 사용 설정

복제를 트리거한 소스 테이블의 변경 유형을 캡처하고 소스 테이블의 레코드 수와 비교하기 위해 BigQuery 테이블의 레코드 수를 쿼리하려면 복제를 구성할 때 /GOOG/BQTR_SETTINGS 트랜잭션에서 추가 필드 플래그 옵션을 지정합니다.

추가 필드 플래그 옵션을 지정하면 대상 BigQuery 테이블의 스키마에 다음 열이 추가됩니다.

| 필드 이름 | 데이터 유형 | 설명 |

|---|---|---|

operation_flag

|

STRING

|

BigQuery에 레코드 로드 또는 복제를 트리거한 소스 테이블의 변경 유형을 식별합니다.

복제 모드로 삽입된 레코드를 카운트하려면

초기 로드 모드로 삽입된 레코드를 카운트하려면 |

is_deleted

|

BOOLEAN

|

true는 소스 레코드가 소스 테이블에서 삭제되었음을 나타냅니다.

BigQuery 테이블에서 소스 테이블에서 삭제되지 않은 레코드만 카운트하려면 |

recordstamp

|

TIMESTAMP

|

SAP용 BigQuery Toolkit이 레코드를 BigQuery로 전송한 시간입니다. BigQuery 테이블에서 고유 레코드 수를 카운트하려면 각 레코드의 최근에 삽입된 인스턴스만 쿼리합니다. 예시 쿼리는 BigQuery 테이블에서 총 레코드 수 쿼리를 참조하세요. |

추가 필드 플래그 옵션의 현재 설정은 /GOOG/BQTR_MASTR 구성 테이블에 저장됩니다.

추가 필드 플래그를 지정하는 방법에 대한 자세한 내용은 테이블 만들기 및 기타 일반 속성 지정을 참고하세요.

테이블 파티션 나누기

다음 방법 중 하나로 BigQuery 테이블을 만들 수 있습니다.

- 소스 테이블의 타임스탬프 필드(시간 단위 열로 파티션을 나눈 테이블 생성)를 기준으로 파티션을 나눈 테이블

- 레코드가 BigQuery에 삽입된 시간을 기준으로 파티션을 나눈 테이블(수집 시간으로 파티션을 나눈 테이블 생성)

복제 속성을 구성할 때 /GOOG/BQTR_TABLE의 파티션 유형 필드에 파티션 유형을 지정하여 파티션 나누기를 사용 설정할 수 있습니다.

지정할 수 있는 파티션 유형에 따라 시간, 일, 월 또는 연도를 기준으로 파티션 나누기의 세부사항이 조정됩니다.

시간 단위 열 파티션 나누기를 위해 소스 테이블의 타임스탬프를 사용하려면 파티션 필드 필드에 소스 필드 이름을 지정합니다.

수집 시간으로 파티션 나누기를 위해 BigQuery 삽입 시간을 사용하려면 파티션 필드를 비워 두면 됩니다. SAP용 BigQuery 툴킷은 대상 테이블에 삽입 시간을 저장할 필드를 만듭니다.

대상 필드 속성

기본적으로 SAP용 BigQuery 툴킷에서는 SAP 소스 테이블의 필드 이름 및 데이터 유형이 대상 BigQuery의 필드 이름 및 데이터 유형으로 사용됩니다.

원하는 경우 대상 테이블을 만들기 전에 필드 이름을 맞춤설정하거나 BigQuery 데이터 유형을 변경할 수 있습니다.

대상 필드 이름 맞춤설정

테이블을 만들기 전에 대상 필드 이름을 맞춤설정할 수 있습니다.

필요한 경우 SAP용 BigQuery 툴킷이 BigQuery 이름 지정 규칙을 준수하기 위해 사용자가 지정한 커스텀 이름을 수정합니다.

복제를 구성할 때 /GOOG/BQTR_SETTINGS 트랜잭션의 필드 매핑 화면에서 필드 이름을 볼 수 있습니다. SAP용 BigQuery 툴킷에서 설정은 /GOOG/BQTR_FIELD 구성 테이블에 저장됩니다.

BigQuery에서 테이블을 만들기 전에 필드 매핑 화면의 임시 필드 이름 열에서 생성된 이름을 수정하여 커스텀 필드 이름을 지정할 수 있습니다. 값을 삭제하고 임시 필드 이름 필드를 비워 두면 SAP용 BigQuery 툴킷이 소스 필드의 이름을 해당 대상 필드의 이름으로 사용합니다.

임시 필드 이름 열을 수정한 후 저장을 클릭하면 SAP용 BigQuery 툴킷이 값을 검증하고 필요에 따라 BigQuery 이름 지정 규칙을 적용한 후 변경사항을 저장합니다. 키보드에서 Enter 키를 누르면 저장하지 않고 값을 확인할 수 있습니다.

대상 필드의 기본 이름 지정 방법 설정에 대한 자세한 내용은 필드 기본 이름 지정 옵션을 참고하세요.

스프레드시트 또는 텍스트 파일을 사용하여 BigQuery 필드 맵 수정

원하는 경우 대상 BigQuery 테이블을 만들기 전에 대상 필드의 기본 데이터 유형, 이름, 설명을 스프레드시트 또는 텍스트 파일에 저장할 수 있습니다. 이 방법을 사용하면 BigQuery 데이터 엔지니어 또는 관리자가 SAP 서버에 액세스할 수 없더라도 값을 수정할 수 있습니다.

값을 수정한 후에는 파일과 내용을 쉼표로 구분된 값(CSV) 형식으로 변환해야 합니다. 그런 다음 커스텀 트랜잭션 /GOOG/BQTR_SETTINGS를 사용하여 CSV 파일을 업로드하면 대량 전송 설정에 업데이트를 적용할 수 있습니다.

CSV 파일을 사용하여 BigQuery 필드 맵을 수정하려면 다음 단계를 따르세요.

- 기본 필드 매핑이 포함된 스프레드시트 또는 텍스트 파일을 만듭니다.

- 스프레드시트 또는 텍스트 파일의 값을 수정합니다.

- 스프레드시트 또는 텍스트 파일을 CSV 형식으로 변환합니다.

- BigQuery 데이터 전송: 설정 유지보수 화면에서 CSV 파일을 업로드합니다.

이 프로세스에 대한 자세한 내용은 CSV 파일에서 BigQuery 필드 맵 수정을 참고하세요.

필드에 대한 BigQuery 이름 지정 규칙

BigQuery 이름 지정 규칙에서는 소문자, 숫자, 밑줄만 사용합니다.

SAP용 BigQuery 툴킷이 대상 필드 이름에 사용할 입력 값에 BigQuery 이름 지정 규칙을 적용합니다.

예를 들어 커스텀 필드 이름으로 FIELD-@#!*123을 입력하면 SAP용 BigQuery 툴킷이 field_123으로 이름을 변경합니다.

필드의 BigQuery 이름 지정 규칙에 대한 상세 설명은 열 이름을 참조하세요.

데이터 유형 매핑

기본적으로 SAP용 BigQuery 툴킷은 소스 SAP 필드의 SAP 유형 종류 또는 SAP 데이터 유형에 따라 대상 BigQuery 필드에 데이터 유형을 할당합니다.

복제를 구성할 때 /GOOG/BQTR_SETTINGS 트랜잭션의 필드 매핑 화면에서 데이터 유형을 볼 수 있습니다. SAP용 BigQuery 툴킷에서 설정은 /GOOG/BQTR_FIELD 구성 테이블에 저장됩니다.

SAP용 BigQuery 툴킷에서 BigQuery에 테이블을 만들기 전에 필드 매핑 화면의 외부 데이터 요소 열에서 기본 데이터 유형 사양을 다른 BigQuery 데이터 유형으로 변경할 수 있습니다.

특별 처리가 필요한 데이터 유형

정확성과 대상 BigQuery 테이블과의 호환성을 보장하려면 복제 프로세스 중에 여러 SAP 데이터 유형에 특별한 처리나 변환이 필요합니다.

SAP용 BigQuery 툴킷은 이러한 변환 중 일부를 자동으로 처리하지만 다른 변환에는 사용자의 주의와 수동 구성이 필요합니다.

다음 데이터 유형의 변환은 수동으로 처리해야 합니다.

부울

부울의 경우 SAP는 CHAR 데이터 유형을 사용합니다. 기본적으로 SAP용 BigQuery 툴킷은 이 데이터 유형을 대상 BigQuery 테이블의 STRING 데이터 유형에 매핑합니다.

따라서 /GOOG/BQTR_SETTINGS 트랜잭션을 사용하여 부울의 복제를 구성할 때 필드 매핑 화면에서 부울 필드의 기본 데이터 유형 할당을 STRING에서 BOOLEAN로 변경해야 합니다.

타임스탬프

타임스탬프의 경우 SAP는 P (묶음 십진수) 또는 DEC(십진수) 데이터 유형을 사용합니다. 기본적으로 SAP용 BigQuery 툴킷은 이러한 데이터 유형을 대상 BigQuery 테이블의 NUMERIC에 매핑합니다.

따라서 타임스탬프의 경우 /GOOG/BQTR_SETTINGS 트랜잭션을 사용하여 복제를 구성할 때 필드 매핑 화면에서 타임스탬프 필드의 기본 데이터 유형 할당을 NUMERIC에서 TIMESTAMP 또는 TIMESTAMP (LONG)으로 변경해야 합니다.

X SAP 유형 종류

X SAP 유형 종류는 16진수이며 RAW, RAWSTRING 또는 LRAW SAP 데이터 유형으로 표현됩니다. 기본적으로 SAP용 BigQuery 툴킷은 이러한 데이터 유형을 소스 BigQuery 테이블의 STRING에 매핑합니다.

BYTES에 매핑할 X SAP 유형 종류가 있는 소스 필드가 필요하면 /GOOG/BQTR_SETTINGS 트랜잭션의 필드 매핑 화면에서 해당 필드의 기본 데이터 유형 할당을 변경해야 합니다.

X SAP 유형 종류는 SAP에서 정수를 나타내는 데 사용되기도 합니다.

이 경우 SAP용 BigQuery 툴킷은 소스 필드의 데이터 유형이 정수용 SAP 데이터 유형인 INT1, INT2, INT4, INT8인지 확인하고 대상 BigQuery 테이블에서 INTEGER 데이터 유형을 할당합니다.

y SAP 유형 종류

y SAP 유형 종류는 바이트 문자열이며 RAW, RAWSTRING 또는 LRAW SAP 데이터 유형으로 표현됩니다. 기본적으로 SAP용 BigQuery 툴킷은 이러한 데이터 유형을 소스 BigQuery 테이블의 STRING에 매핑합니다.

BYTES에 매핑할 y SAP 유형 종류가 있는 소스 필드가 필요하면 /GOOG/BQTR_SETTINGS 트랜잭션의 필드 매핑 화면에서 해당 필드의 기본 데이터 유형 할당을 변경해야 합니다.

기본 데이터 유형 매핑

다음 표는 SAP용 BigQuery 툴킷의 기본 데이터 유형 변환을 보여줍니다.

| SAP 유형 종류 | SAP 데이터 유형 | BigQuery 데이터 유형 | 참고 |

|---|---|---|---|

b(1바이트 정수)s(2바이트 정수)I(4바이트 정수)8(8바이트 정수)

|

INT1INT2INT4INT8

|

INTEGER |

|

F(부동 소수점 수)

|

FLTP

|

FLOAT |

|

P(묶음)

|

CURRDECQUAN

|

NUMERIC |

기본적으로 P SAP 유형 종류는 BigQuery 데이터 유형 NUMERIC에 매핑되고 외부 형식의 숫자로 변환됩니다. |

a(10진수 부동 소수점 수, 16자리)

|

DECFLOAT16 |

NUMERIC |

|

e(10진수 부동 소수점 수, 16자리)

|

DECFLOAT34 |

NUMERIC |

|

N(숫자) |

NUMC |

STRING |

|

X(16진수)y(바이트 문자열)

|

RAWRAWSTRINGLRAW

|

STRING |

SAP 유형 종류가 X이지만 데이터 유형 이름이 'INT*' 패턴(INT1 ,INT2 ,INT4)을 다루는 경우 소스 데이터 요소가 새 데이터 요소 TYPINT8 및 TYPEKIND '8'로 대체되며 BigQuery 데이터 유형 INTEGER에 매핑됩니다. |

C(문자)g(문자열)?(csequence)&(clike)

|

CHARSTRING |

STRING |

|

D(날짜) |

DATS |

DATE |

|

T(시간) |

TIMS |

TIME |

커뮤니티 리소스

Embedded BW를 사용하는 SAP S/4HANA 시스템 내에서 BigQuery Toolkit 기반 애플리케이션의 구현을 가속화하려면 GitHub에서 제공되는 오픈소스 생성 도구를 사용하면 됩니다.

지원 받기

Google Cloud SAP용 BigQuery 툴킷의 설치, 구성, 운영, 유지관리와 관련된 문제 및 질문에 대한 지원을 제공합니다.

운영 데이터 프로비저닝 (ODP), 데이터 이전 서버 (DMIS), 핵심 데이터 서비스 (CDS), 인터넷 통신 관리자 (ICM) 또는 서드 파티 소프트웨어와 같은 SAP 관리 구성요소에서 발생하는 문제의 경우 Google Cloud Customer Care에서 근본 원인을 파악하기 위해 최선을 다합니다. 이 문제를 해결하려면 해당 공급업체 또는 지원 제공업체에 문의하세요.

SAP용 BigQuery 툴킷 문제를 해결하려면 SAP용 BigQuery 툴킷 문제 해결을 참고하세요.

ABAP SDK for Google Cloud 문제를 해결하는 데 도움이 필요한 경우 다음을 수행하세요.

Cloud 포럼에서 커뮤니티에 질문하고 ABAP SDK for Google Cloud에 대해 논의합니다.

사용 가능한 모든 진단 정보를 수집하여 Cloud Customer Care에 문의합니다. Cloud Customer Care 문의 정보는 Google Cloud기반 SAP 지원 받기를 참조하세요.