이 주제에서는 GKE의 Apigee Hybrid 및 온프렘에 배포된 Anthos GKE의 멀티 리전 배포를 설명합니다.

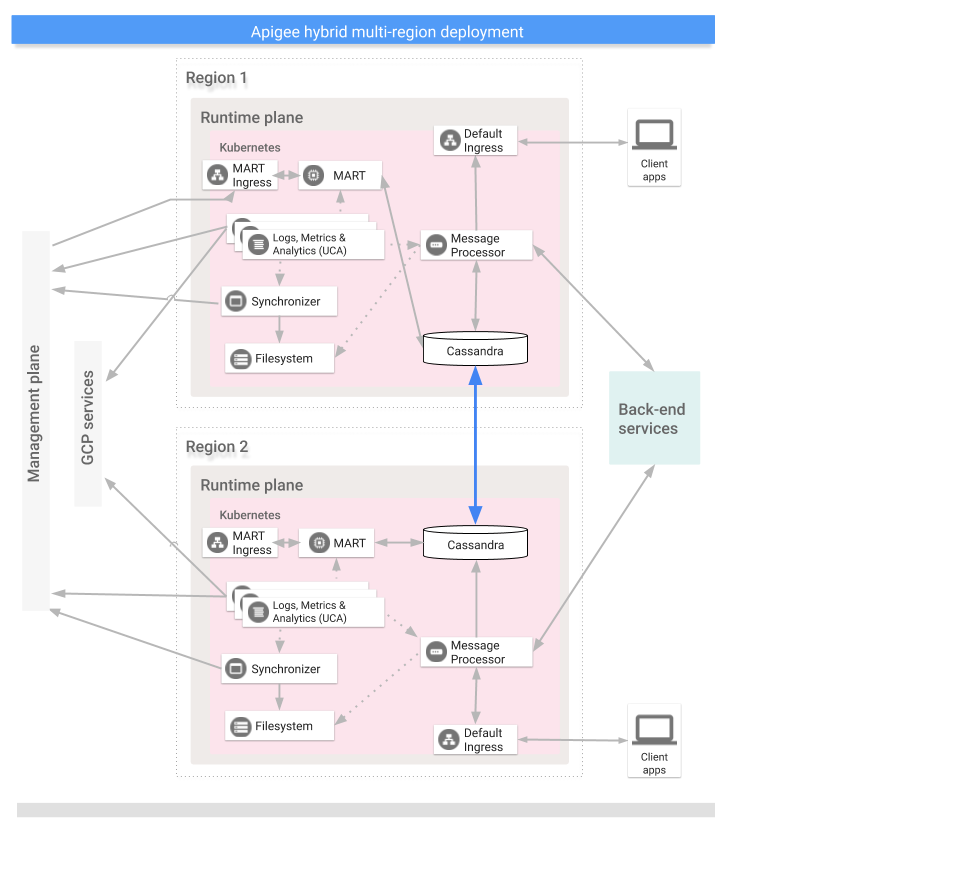

멀티 리전 배포를 위한 토폴로지는 다음과 같습니다.

- 활성-활성: 애플리케이션이 여러 지리적 위치에 배포되고 배포에 대한 지연 시간이 짧은 API 응답이 필요한 경우. 클라이언트와 가장 가까운 여러 지리적 위치에 하이브리드를 배포할 수 있는 옵션이 있습니다. 예를 들면 미국 서부 해안, 미국 동부 해안, 유럽, APAC이 있습니다.

- 활성-수동: 기본 리전과 장애 조치 또는 재해 복구 리전이 있는 경우.

다음 이미지와 같이 멀티 리전 하이브리드 배포의 리전은 Cassandra를 통해 통신합니다.

MART 연결 부하 분산

각 리전별 클러스터에는 자체 MART IP 및 호스트 이름이 있어야 합니다. 그러나 관리 영역을 그중 하나에만 연결해야 합니다. Cassandra는 모든 클러스터에 정보를 전달합니다. MART의 고가용성을 위한 최선의 방법은 개별 MART IP 주소를 부하 분산하여 부하 분산된 MART URL과 통신하도록 조직을 구성하는 것입니다.

기본 요건

여러 지역에 하이브리드를 구성하기 전에 다음 기본 요건을 만족해야 합니다.

- 다양한 CIDR 블록으로 복수의 리전에 Kubernetes 클러스터 설정

- 리전 간 통신 설정

- 모든 리전의 Kubernetes 클러스터 간에 Cassandra 포트 7000과 7001을 엽니다(7000은 문제 해결 중에 백업 옵션으로 사용할 수 있음). 포트 구성도 참조하세요.

자세한 내용은 Kubernetes 문서를 참조하세요.

멀티 리전 시드 호스트 구성

이 섹션에서는 기존 Cassandra 클러스터를 새 리전으로 확장하는 방법을 설명합니다. 이 설정을 사용하면 새 리전에서 클러스터를 부트스트랩하고 기존 데이터 센터에 연결할 수 있습니다. 이 구성이 없으면 멀티 리전 Kubernetes 클러스터가 서로를 알지 못합니다.

다음

kubectl명령어를 실행하여 현재 리전의 Cassandra의 시드 호스트 주소를 식별합니다.시드 호스트 주소를 사용하면 새 리전 인스턴스가 첫 번째 시작할 때 원래의 클러스터를 찾아 클러스터의 토폴로지를 학습할 수 있습니다. 시드 호스트 주소는 클러스터의 연락 지점으로 지정됩니다.

kubectl get pods -o wide -n apigee NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE apigee-cassandra-0 1/1 Running 0 5d 10.0.0.11 gke-k8s-dc-2-default-pool-a2206492-p55d apigee-cassandra-1 1/1 Running 0 5d 10.0.2.4 gke-k8s-dc-2-default-pool-e9daaab3-tjmz apigee-cassandra-2 1/1 Running 0 5d 10.0.3.5 gke-k8s-dc-2-default-pool-e589awq3-kjch

- 이전 명령어에서 반환된 IP 중 멀티 리전 시드 호스트가 될 IP를 결정합니다.

이 단계의 구성은 GKE 또는 GKE On-Prem에 있는지에 따라 다릅니다.

GKE만 해당: 데이터 센터 2에서 런타임 영역 구성요소 관리에

cassandra.multiRegionSeedHost및cassandra.datacenter를 구성합니다. 여기서multiRegionSeedHost는 이전 명령어로 반환한 IP 중 하나입니다.cassandra: multiRegionSeedHost: seed_host_IP datacenter: data_center_name rack: rack_name

예를 들면 다음과 같습니다.

cassandra: multiRegionSeedHost: 10.0.0.11 datacenter: "dc-2" rack: "ra-1"

GKE On-Prem만 해당: 데이터 센터 2에서 재정의 파일에

cassandra.multiRegionSeedHost를 구성합니다. 여기서multiRegionSeedHost는 이전 명령어로 반환한 IP 중 하나입니다.cassandra: hostNetwork: true dnsPolicy: ClusterFirstWithHostNet multiRegionSeedHost: seed_host_IP

예를 들면 다음과 같습니다.

cassandra: hostNetwork: true dnsPolicy: ClusterFirstWithHostNet multiRegionSeedHost: 10.0.0.11

- 새 데이터 센터/리전에서 하이브리드를 설치하기 전에 첫 번째 리전에서 설정한 것과 동일하게 TLS 인증서 및 사용자 인증 정보를

overrides.yaml에 설정합니다.

새 리전 설정

시드 호스트를 구성한 후에 새 리전을 설정할 수 있습니다.

새 리전을 설정 절차:

- 기존 클러스터에서 새 클러스터로 인증서를 복사합니다. 새 CA 루트는 Cassandra 및 mTLS용 기타 하이브리드 구성요소에서 사용됩니다. 따라서 클러스터 간에 일관된 인증서가 있어야 합니다.

- 컨텍스트를 원래 네임스페이스로 설정합니다.

kubectl config use-context original-cluster-name

- 현재 네임스페이스 구성을 파일로 내보냅니다.

$ kubectl get namespace

-o yaml > apigee-namespace.yaml apigee-ca보안 비밀을 파일로 내보냅니다.kubectl -n cert-manager get secret apigee-ca -o yaml > apigee-ca.yaml

- 컨텍스트를 새 리전의 클러스터 이름으로 설정합니다.

kubectl config use-context new-cluster-name

- 네임스페이스 구성을 새 클러스터로 가져옵니다. 새 리전에서 다른 네임스페이스를 사용하는 경우 파일의 '네임스페이스'를 업데이트해야 합니다.

kubectl apply -f apigee-namespace.yaml

보안 비밀을 새 클러스터로 가져옵니다.

kubectl -n cert-manager apply -f apigee-ca.yaml

- 컨텍스트를 원래 네임스페이스로 설정합니다.

- 새 리전에 하이브리드를 설치합니다. 이전 섹션에 설명된 대로

overrides-DC_name.yaml파일에 첫 번째 리전에서 구성된 동일한 TLS 인증서가 포함되어 있는지 확인합니다.다음 두 명령어를 실행하여 새 리전에 하이브리드를 설치합니다.

apigeectl init -f overrides/overrides-DC_name.yaml

apigeectl apply -f overrides/overrides-DC_name.yaml

모든 apigee 키스페이스를 확장합니다.

다음 단계는 Cassandra 데이터를 새 데이터 센터로 확장합니다.

- Cassandra pod에서 셸을 엽니다.

kubectl run -i --tty --restart=Never --rm --image google/apigee-hybrid-cassandra-client:1.0.0 cqlsh

- Cassandra 서버에 연결합니다.

cqlsh apigee-cassandra-0.apigee-cassandra.apigee.svc.cluster.local -u ddl_user --ssl Password: Connected to apigeecluster at apigee-cassandra-0.apigee-cassandra.apigee.svc.cluster.local:9042. [cqlsh 5.0.1 | Cassandra 3.11.3 | CQL spec 3.4.4 | Native protocol v4] Use HELP for help.

- 사용 가능한 키스페이스를 가져옵니다.

SELECT * from system_schema.keyspaces ; keyspace_name | durable_writes | replication ----------------------------+----------------+-------------------------------------------------------------------------------------------------------- rtc_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} system_auth | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} system_schema | True | {'class': 'org.apache.cassandra.locator.LocalStrategy'} cache_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} kms_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} kvm_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} system_distributed | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} system | True | {'class': 'org.apache.cassandra.locator.LocalStrategy'} perses | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} quota_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3'} system_traces | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} (10 rows) - apigee 키스페이스를 업데이트/확장합니다.

ALTER KEYSPACE cache_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE kms_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE kvm_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE perses WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE quota_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3};ALTER KEYSPACE rtc_hybrid_test_7_hybrid WITH replication = {'class': 'NetworkTopologyStrategy', 'dc-1':3, 'dc-2':3}; - 키스페이스 확장을 검증합니다.

SELECT * from system_schema.keyspaces ; keyspace_name | durable_writes | replication ----------------------------+----------------+-------------------------------------------------------------------------------------------------------- system_auth | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} system_schema | True | {'class': 'org.apache.cassandra.locator.LocalStrategy'} cache_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} kms_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} kvm_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} system_distributed | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} system | True | {'class': 'org.apache.cassandra.locator.LocalStrategy'} perses | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} quota_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} rtc_hybrid_test_7_hybrid | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '3', 'dc-2': '3'} system_traces | True | {'class': 'org.apache.cassandra.locator.NetworkTopologyStrategy', 'dc-1': '1', 'dc-2': '1'} (10 rows) ddl@cqlsh>

- Cassandra pod에서 셸을 엽니다.

- 새 데이터 센터의 모든 pod에서

nodetool rebuild를 순차적으로 실행합니다. 데이터 크기에 따라 몇 분에서 몇 시간 정도 걸릴 수 있습니다.kubectl exec apigee-cassandra-0 -n apigee -- nodetool rebuild -- dc-1

- 로그에서 재빌드 프로세스를 확인합니다. 또한

nodetool status명령어를 사용하여 데이터 크기를 확인합니다.kubectl logs apigee-cassandra-0 -f -n apigee

다음 예시는 로그 항목의 예시를 보여줍니다.

INFO 01:42:24 rebuild from dc: dc-1, (All keyspaces), (All tokens) INFO 01:42:24 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Executing streaming plan for Rebuild INFO 01:42:24 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Starting streaming to /10.12.1.45 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889, ID#0] Beginning stream session with /10.12.1.45 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Starting streaming to /10.12.4.36 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889 ID#0] Prepare completed. Receiving 1 files(0.432KiB), sending 0 files(0.000KiB) INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Session with /10.12.1.45 is complete INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889, ID#0] Beginning stream session with /10.12.4.36 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Starting streaming to /10.12.5.22 INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889 ID#0] Prepare completed. Receiving 1 files(0.693KiB), sending 0 files(0.000KiB) INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Session with /10.12.4.36 is complete INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889, ID#0] Beginning stream session with /10.12.5.22 INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889 ID#0] Prepare completed. Receiving 3 files(0.720KiB), sending 0 files(0.000KiB) INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Session with /10.12.5.22 is complete INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] All sessions completed

- 시드 호스트를 업데이트합니다.

overrides-DC_name.yaml에서multiRegionSeedHost: 10.0.0.11을 삭제하고 다시 적용합니다.apigeectl apply -f overrides/overrides-DC_name.yaml

Cassandra 클러스터 상태 확인

다음 명령어는 두 데이터 센터에서 클러스터 설정이 성공했는지 확인하는 데 유용합니다. 이 명령어는 두 리전의 nodetool 상태를 확인합니다.

kubectl exec apigee-cassandra-0 -n apigee -- nodetool status Datacenter: us-central1 ======================= Status=Up/Down |/ State=Normal/Leaving/Joining/Moving -- Address Load Tokens Owns (effective) Host ID Rack UN 10.12.1.45 112.09 KiB 256 100.0% 3c98c816-3f4d-48f0-9717-03d0c998637f ra-1 UN 10.12.4.36 95.27 KiB 256 100.0% 0a36383d-1d9e-41e2-924c-7b62be12d6cc ra-1 UN 10.12.5.22 88.7 KiB 256 100.0% 3561f4fa-af3d-4ea4-93b2-79ac7e938201 ra-1 Datacenter: us-west1 ==================== Status=Up/Down |/ State=Normal/Leaving/Joining/Moving -- Address Load Tokens Owns (effective) Host ID Rack UN 10.0.4.33 78.69 KiB 256 0.0% a200217d-260b-45cd-b83c-182b27ff4c99 ra-1 UN 10.0.0.21 78.68 KiB 256 0.0% 9f3364b9-a7a1-409c-9356-b7d1d312e52b ra-1 UN 10.0.1.26 15.46 KiB 256 0.0% 1666df0f-702e-4c5b-8b6e-086d0f2e47fa ra-1