Le BigQuery Toolkit pour SAP vous permet d'accéder de manière programmatique aux ressources BigQuery dans votre environnement SAP à l'aide d'ABAP. Vous pouvez accéder aux ressources BigQuery depuis SAP sans avoir à écrire de code passe-partout pour les opérations courantes, telles que les suivantes :

- Synchronisation de la définition des tables : synchronisez vos tables SAP et BigQuery.

- Mappage des types de données : mappez les types de données entre SAP et BigQuery.

- Segmentation des données : permet de transférer efficacement de grands ensembles de données.

- Gestion des erreurs : gérez les erreurs potentielles lors de la réplication des données.

Contrairement à BigQuery Connector pour SAP, qui nécessite un SAP Landscape Transformation Replication Server, vous pouvez utiliser le BigQuery Toolkit pour SAP dans n'importe quel système SAP ERP où ABAP est compatible.

BigQuery Toolkit pour SAP est fourni en tant que sous-package de l'édition sur site ou de toute édition cloud du SDK ABAP pour Google Cloud. Pour utiliser le kit d'outils, vous devez installer le SDK dans votre environnement SAP. Pour en savoir plus sur la procédure d'installation, consultez Installer et configurer l'édition sur site ou n'importe quelle édition cloud du SDK ABAP pour Google Cloud.

La boîte à outils BigQuery pour SAP n'est disponible qu'avec l'édition sur site ou toute édition cloud du SDK ABAP pour Google Cloud.

Réplication des données de SAP vers BigQuery

Le module de transfert de données BigQuery du BigQuery Toolkit pour SAP vous permet de répliquer des données depuis SAP vers BigQuery à des fins d'analyse et de création de rapports.

Le schéma suivant montre les configurations de transfert de données et le flux de réplication des données dans le module de transfert de données BigQuery :

Configurations de transfert de données

Comme illustré dans le schéma de la section précédente, pour établir la réplication des données de SAP vers BigQuery, les administrateurs effectuent les configurations suivantes :

- Dans Google Cloud, l'administrateur cloud configure BigQuery et accorde les autorisations IAM nécessaires.

- Dans le système SAP, l'administrateur du système SAP configure le SDK ABAP pour Google Cloud afin d'autoriser la communication avec Google Cloud.

- Dans le système SAP, l'administrateur du système SAP configure le module de transfert de données BigQuery pour gérer les paramètres de transfert de données et les détails des ressources BigQuery. Ces configurations sont stockées dans les tables suivantes :

/GOOG/BQTR_MASTER/GOOG/BQTR_TABLE/GOOG/BQTR_FIELD/GOOG/BQTR_PARAMS

Lorsque le code ABAP s'exécute, la classe de chargement des données BigQuery lit les configurations de ces tables pour guider le processus de réplication des données.

Flux de réplication des données

Comme indiqué dans le diagramme de la section précédente, pour répliquer les données des systèmes SAP vers BigQuery, les développeurs ABAP écrivent du code ABAP personnalisé qui effectue les opérations suivantes :

- Lecture des données à partir de tables SAP standards ou personnalisées.

Utilise la classe de chargement de données BigQuery

/GOOG/CL_BQTR_DATA_LOADpour répliquer les données sélectionnées dans BigQuery. Ce cours :- Utilise la configuration stockée dans les tables de configuration du service de transfert de données BigQuery.

- Utilise la classe

/GOOG/CL_BIGQUERY_V2pour effectuer la synchronisation de la définition de table et la réplication des données.

Implémente la logique métier de suivi.

Gère les erreurs et les exceptions.

Sources compatibles pour la réplication des données

Vous pouvez utiliser le module de transfert de données BigQuery du BigQuery Toolkit for SAP pour charger de manière programmatique des données à partir d'objets de dictionnaire ABAP tels que des tables, des vues de dictionnaire, des vues CDS, des entités CDS ou à partir de n'importe quel objet de données de type structure plate dans BigQuery.

Vous pouvez utiliser le BigQuery Toolkit pour SAP pour répliquer des données de différentes manières :

- En tant que plug-in dans les frameworks d'amélioration SAP, tels que les Business Add-Ins (BAdI), les exits utilisateur et les routines. Par exemple, la boîte à outils peut être branchée sur des routines Business Warehouse (BW) pour envoyer les données traitées par le processus de transfert de données (DTP) BW.

- Pour charger des données par lot à partir d'un programme ABAP personnalisé.

Planification des performances

Le BigQuery Toolkit pour SAP constitue la dernière étape de la transmission des données à BigQuery en effectuant des appels synchrones à l'API BigQuery.

Lorsque vous utilisez le BigQuery Toolkit pour SAP dans votre application ABAP personnalisée, vous pouvez optimiser les performances de la réplication de données à la fois dans votre charge de travail SAP et dans les configurations du service de transfert de données BigQuery.

Options d'optimisation des performances avec votre charge de travail SAP et votre application personnalisée

Pour optimiser les performances de votre charge de travail SAP et de vos applications personnalisées, envisagez les options suivantes :

- Exécutez votre charge de travail SAP, le système source à partir duquel les données sont répliquées dans BigQuery, sur Google Cloud.

- Si votre charge de travail SAP se trouve sur Google Cloud, créez votre ensemble de données BigQuery dans la même région que votre charge de travail SAP.

- Si vous ne pouvez pas exécuter votre charge de travail SAP sur Google Cloud, procédez comme suit :

- Créez votre ensemble de données BigQuery dans une région Google Cloudla plus proche de votre charge de travail SAP.

- Connectez-vous à Google Cloud à l'aide de Cloud Interconnect.

- Dimensionnez de manière optimale votre système de serveur SAP pour votre charge de travail.

- Implémentez le traitement parallèle pour appeler le module de transfert de données BigQuery dans plusieurs threads parallèles afin d'augmenter le débit.

Étant donné que BigQuery Toolkit for SAP constitue la dernière étape de la transmission des données à BigQuery, ses performances sont influencées par divers facteurs propres à votre environnement. Ces facteurs peuvent inclure les suivants :

Infrastructure réseau : les limites de bande passante, la latence et la stabilité globale du réseau jouent un rôle important dans la vitesse et l'efficacité de la réplication.

Systèmes sources : les performances de vos bases de données sources, y compris leur matériel, leur configuration et leur charge actuelle, peuvent avoir un impact sur les performances de la réplication.

Volume de données et taux de modification : la quantité de données répliquées et la fréquence des modifications ont une incidence sur le temps et les ressources nécessaires à la réplication.

Autres composants : les pare-feu, les règles de sécurité, les équilibreurs de charge et d'autres éléments d'infrastructure peuvent tous contribuer aux performances globales de la réplication des données.

Il vous incombe de tester les performances de BigQuery Toolkit pour SAP dans votre propre environnement. Pour obtenir des résultats optimaux, réfléchissez à tous les composants pertinents de votre environnement et optimisez-les.

Options d'optimisation des performances disponibles dans les configurations du service de transfert de données BigQuery

Les configurations du service de transfert de données BigQuery offrent les options suivantes pour contrôler les performances de la réplication :

Taille des blocs de transfert de données

BigQuery Toolkit pour SAP envoie les données à BigQuery sous forme de fragments d'enregistrements. Nous vous recommandons d'utiliser la taille de fragment par défaut avec BigQuery Toolkit pour SAP, soit 10 000 enregistrements. Si les enregistrements d'une table source contiennent très peu de champs ou si les champs contiennent des valeurs de données de très petite taille, vous pouvez utiliser une taille de fragment plus grande jusqu'à la taille de fragment maximale autorisée par BigQuery Toolkit pour SAP, à savoir 50 000 enregistrements.

Si le nombre d'enregistrements dans un fragment donné atteint une taille d'octet dépassant la limite BigQuery sur la taille en octets pour les requêtes HTTP, vous pouvez recevoir une erreur quotaExceeded ou une erreur invalid. Cela peut se produire si les enregistrements d'une table source contiennent beaucoup de champs ou si les champs contiennent beaucoup de données.

Si vous obtenez une erreur liée à la taille des fragments, essayez de réduire la taille de fragment spécifiée dans la configuration de transfert de masse de cette table. Vous pouvez également activer la taille dynamique des fragments pour cette table afin d'ajuster automatiquement la taille des fragments. Pour en savoir plus, consultez la section Taille dynamique des fragments.

Si vous n'avez pas activé la taille dynamique des fragments, les tables sources SAP telles que MSEG, ACDOCA et MATDOC, peuvent comporter des enregistrements volumineux avec de nombreux champs par enregistrement. Vous devrez peut-être spécifier une taille de fragment inférieure à 2 000.

Vous pouvez spécifier une taille de fragment en exécutant la transaction /GOOG/BQTR_SETTINGS. La taille des fragments est spécifiée dans le champ Taille du segment de l'écran Attributs de la table.

Compression d'enregistrement

Par défaut, BigQuery Toolkit pour SAP améliore les performances de réplication en compressant les enregistrements qu'il envoie à BigQuery.

Lorsque la compression des enregistrements est activée au niveau de la table (paramètre par défaut), BigQuery Toolkit pour SAP omet tous les champs vides de l'enregistrement source lors de l'envoi des enregistrements à BigQuery. Lorsque l'enregistrement est inséré dans BigQuery, les champs qui ont été omis des données envoyées sont initialisés avec null dans la table cible de BigQuery.

Toutefois, si vous devez répliquer certains champs vides avec leurs valeurs initiales dans BigQuery tout en continuant à utiliser la compression des enregistrements au niveau de la table, vous pouvez modifier le paramètre de compression des enregistrements pour ces champs spécifiques. Par conséquent, les valeurs vides des champs spécifiés ne sont pas omises des données envoyées et conservent la valeur avec laquelle elles sont initialisées dans la table source.

Dans votre configuration de transfert de masse, vous pouvez contrôler le comportement de compression des enregistrements à l'aide du paramètre Envoyer un indicateur non compressé disponible au niveau de la table et du champ. Le tableau suivant récapitule le comportement de la compression des enregistrements en fonction du paramètre Envoyer un indicateur non compressé :

| Indicateur "Envoyer non compressé" au niveau de la table | Indicateur "Envoyer non compressé" au niveau du champ | Comportement de la compression des enregistrements |

|---|---|---|

| Oui | Non | Tous les champs sont envoyés sans compression. |

| Oui | Oui | Tous les champs sont envoyés sans compression. |

| Non | Oui | Seuls les champs sélectionnés au niveau du champ sont envoyés sans compression. |

| Non | Non | Tous les champs sont envoyés sous forme compressée. |

Lorsque vous envoyez la réplication de données non compressées, à l'exception des champs de date et d'horodatage, les champs vides conservent la valeur avec laquelle ils ont été initialisés dans la table source. La valeur initialisée pour les champs de date et d'horodatage reçoit les valeurs suivantes :

- Valeur d'initialisation de champ de date :

DATE 1970-01-01 - Valeur d'initialisation de champ d'horodatage :

TIMESTAMP 1970-01-01 00:00:00 UTC

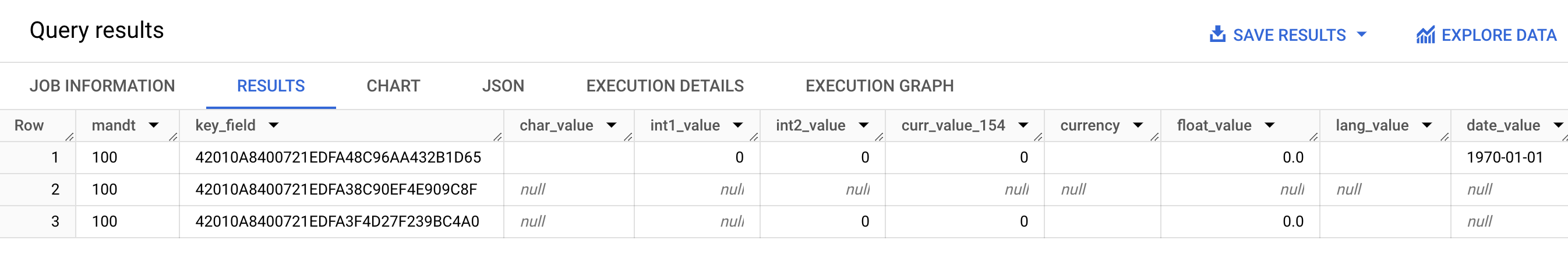

La capture d'écran suivante montre un exemple du comportement de compression des enregistrements :

L'image précédente montre les éléments suivants :

- Ligne 1 : tous les champs sont non compressés. L'option Envoyer un indicateur non compressé est sélectionnée au niveau de la table.

- Ligne 2 : tous les champs sont compressés. L'indicateur d'envoi non compressé est désactivé au niveau de la table.

- Ligne 3 : les champs suivants ne sont pas compressés :

int2_value,curr_value_154,currency,float_valueetlang_value. Pour ces champs, l'option Envoyer un indicateur non compressé est sélectionnée au niveau du champ.

Pour de meilleures performances, nous vous recommandons de ne pas désactiver la compression des enregistrements en sélectionnant Envoyer un indicateur non compressé au niveau du tableau. Cela peut avoir un impact négatif sur les performances de la réplication. Si vous devez envoyer des données non compressées uniquement pour des champs spécifiques, sélectionnez Envoyer un indicateur non compressé pour ces champs spécifiques au niveau du champ.

Propriétés de la table cible

Lorsque vous configurez la réplication dans le module de transfert de données BigQuery de BigQuery Toolkit pour SAP, vous pouvez spécifier les paramètres qui s'appliquent lorsque BigQuery Toolkit pour SAP crée la table cible dans BigQuery.

Par exemple, vous pouvez spécifier les propriétés suivantes pour une table BigQuery cible :

- Nom du tableau

- Options de dénomination par défaut des champs

- Champs supplémentaires pour capturer les modifications d'enregistrements et activer les requêtes de comptage des enregistrements

- Partitionnement de table

Options de nommage par défaut des champs

Vous pouvez configurer BigQuery Toolkit pour SAP afin de créer les noms des champs de la table BigQuery cible à partir des noms des champs sources, ou à partir des libellés et des descriptions des champs sources. Les libellés et les descriptions sont généralement plus informatifs sur le contenu du champ.

Par défaut, BigQuery Toolkit pour SAP utilise les noms des champs sources.

Vous pouvez modifier la valeur par défaut en spécifiant l'option Noms personnalisés lorsque vous spécifiez des attributs de création de table dans la configuration de transfert de masse de la transaction /GOOG/BQTR_SETTINGS. La spécification est stockée dans la table de configuration /GOOG/BQTR_MASTR.

Lors de la création des noms, BigQuery Toolkit pour SAP les modifie pour respecter la convention de dénomination BigQuery.

Avant que BigQuery Toolkit pour SAP ne crée une table dans BigQuery, vous pouvez modifier les noms de champ dans l'écran de mappage de champ de la transaction /GOOG/BQTR_SETTINGS.

Lorsque l'indicateur Noms personnalisés est spécifié, les noms que BigQuery Toolkit pour SAP utilisera lors de la création de la table cible s'affichent dans la colonne Nom du champ externe de l'écran de mappage de champ.

BigQuery Toolkit pour SAP crée les noms dans la colonne Nom du champ externe à partir du libellé de champ medium de chaque champ source. Si un libellé de champ "medium" n'est pas spécifié dans la définition du champ source, la description courte du champ est utilisée. Si la description courte n'est pas non plus spécifiée, le libellé le plus court est utilisé. Si aucun de ces éléments n'est spécifié, le nom du champ source est utilisé.

Pour en savoir plus sur la personnalisation des noms de champs cibles, consultez la section Personnaliser les noms de champs cibles.

Capturer les modifications des enregistrements et activer le comptage des enregistrements

Pour capturer le type de modification dans la table source qui a déclenché la réplication et pour pouvoir interroger le nombre d'enregistrements dans la table BigQuery afin de le comparer à celui de la table source, spécifiez l'option Option pour les champs supplémentaires dans la transaction /GOOG/BQTR_SETTINGS lorsque vous configurez la réplication.

Lorsque vous spécifiez l'option Option pour les champs supplémentaires, les colonnes suivantes sont ajoutées au schéma de la table BigQuery cible :

| Nom du champ | Type de données | Description |

|---|---|---|

operation_flag

|

STRING

|

Identifie le type de modification dans la table source qui a déclenché le chargement ou la réplication de l'enregistrement dans BigQuery.

Pour compter les enregistrements insérés en mode de réplication, interrogez les enregistrements dont la valeur est

Pour compter les enregistrements insérés en mode de chargement initial, interrogez les enregistrements dont la valeur est |

is_deleted

|

BOOLEAN

|

Si la valeur est true, cela indique que l'enregistrement source a été supprimé de la table source.

Pour ne comptabiliser que les enregistrements d'une table BigQuery qui n'ont pas été supprimés de la table source, utilisez le champ |

recordstamp

|

TIMESTAMP

|

Heure à laquelle BigQuery Toolkit pour SAP a envoyé l'enregistrement à BigQuery. Pour compter les enregistrements uniques dans une table BigQuery, interrogez uniquement la dernière instance insérée de chaque enregistrement. Pour obtenir un exemple de requête, consultez la section Interroger le nombre total d'enregistrements dans une table BigQuery. |

Le paramètre actuel de l'option Option pour les champs supplémentaires est stocké dans la table de configuration /GOOG/BQTR_MASTR.

Pour en savoir plus sur la spécification de l'option pour les champs supplémentaires, consultez Spécifier la création de table et d'autres attributs généraux.

Partitionnement de table

Vous pouvez créer des tables BigQuery de l'une des manières suivantes :

- Tables partitionnées par un champ d'horodatage dans la table source, ce qui crée une table partitionnée par colonne d'unité de temps.

- Tables partitionnées par l'heure/la date auxquelles les enregistrements sont insérés dans BigQuery, ce qui crée une table partitionnée par date/heure d'ingestion.

Pour activer le partitionnement, spécifiez un type de partition dans le champ Type de partition du fichier /GOOG/BQTR_TABLE lorsque vous configurez les propriétés de réplication.

Les types de partition que vous pouvez spécifier ajustent la précision du partitionnement à l'échelle de l'heure, du jour, du mois ou de l'année.

Pour utiliser un horodatage de la table source pour le partitionnement de la colonne d'unité de temps, spécifiez le nom du champ source dans le champ Champ de partitionnement.

Pour utiliser un temps d'insertion BigQuery pour le partitionnement par date/heure d'ingestion, vous pouvez laisser le champ de partition vide. BigQuery Toolkit pour SAP crée un champ dans la table cible pour stocker la date/heure d'insertion.

Propriétés du champ cible

Par défaut, BigQuery Toolkit pour SAP utilise les noms de champs et les types de données de la table source SAP comme noms de champs et types de données dans la cible BigQuery.

Vous pouvez éventuellement personnaliser les noms des champs ou modifier le type de données BigQuery avant de créer la table cible.

Personnaliser les noms des champs cibles

Avant de créer une table, vous pouvez personnaliser les noms des champs cibles.

Si nécessaire, BigQuery Toolkit pour SAP modifie les noms personnalisés que vous spécifiez afin de respecter la convention de dénomination BigQuery.

Lorsque vous configurez la réplication, vous pouvez afficher les noms des champs sur l'écran de mappage des champs de la transaction /GOOG/BQTR_SETTINGS. BigQuery Toolkit pour SAP stocke vos paramètres dans la table de configuration /GOOG/BQTR_FIELD.

Avant de créer une table dans BigQuery, vous pouvez spécifier un nom de champ personnalisé en modifiant le nom généré dans la colonne Nom de champ temporaire de l'écran de mappage de champ. Si vous supprimez une valeur et laissez le champ Nom de champ temporaire vide, BigQuery Toolkit pour SAP utilise le nom du champ source comme nom pour ce champ cible.

Une fois le nom de champ temporaire modifié, lorsque vous cliquez sur Enregistrer, BigQuery Toolkit pour SAP valide la valeur, applique les conventions de nommage BigQuery nécessaires et enregistre les modifications. Vous pouvez valider une valeur sans l'enregistrer en appuyant sur Entrée sur votre clavier.

Pour en savoir plus sur la définition de la méthode de nommage par défaut pour les champs cibles, consultez Options de nommage par défaut pour les champs.

Utiliser une feuille de calcul ou un fichier texte pour modifier le mappage des champs BigQuery

Vous pouvez éventuellement enregistrer les types de données, les noms et les descriptions par défaut des champs cibles dans une feuille de calcul ou un fichier texte avant de créer une table BigQuery cible. Cette approche permet aux ingénieurs de données ou aux administrateurs BigQuery de modifier les valeurs même s'ils n'ont pas accès à votre serveur SAP.

Une fois les valeurs modifiées, vous devez convertir le fichier et son contenu au format CSV (valeurs séparées par une virgule). Vous pouvez ensuite appliquer les mises à jour aux paramètres de transfert de masse en important le fichier CSV avec la transaction personnalisée /GOOG/BQTR_SETTINGS.

Pour modifier le mappage de champs BigQuery à l'aide d'un fichier CSV :

- Créez une feuille de calcul ou un fichier texte contenant les mappages de champs par défaut.

- Modifiez les valeurs dans la feuille de calcul ou le fichier texte.

- Convertissez le fichier texte ou la feuille de calcul au format CSV.

- Dans l'écran Service de transfert de données BigQuery : maintenance des paramètres, importez le fichier CSV.

Pour en savoir plus sur ce processus, consultez Modifier le mappage de champs BigQuery dans un fichier CSV.

Convention de dénomination BigQuery pour les champs

La convention de dénomination BigQuery n'utilise que des lettres minuscules, des chiffres et des traits de soulignement.

BigQuery Toolkit pour SAP applique les conventions de dénomination de BigQuery à toute valeur d'entrée à utiliser pour le nom d'un champ cible.

Par exemple, si vous saisissez FIELD-@#!*123 en tant que nom de champ personnalisé, BigQuery Toolkit pour SAP remplace le nom par field_123.

Pour en savoir plus sur la convention de dénomination BigQuery pour les champs, consultez la section Noms de colonnes.

Mappage des types de données

Par défaut, BigQuery Toolkit pour SAP attribue des types de données aux champs BigQuery cibles en fonction du genre de type SAP ou du type de données SAP du champ SAP source.

Lorsque vous configurez la réplication, vous pouvez afficher les types de données sur l'écran de mappage des champs de la transaction /GOOG/BQTR_SETTINGS. BigQuery Toolkit pour SAP stocke vos paramètres dans la table de configuration /GOOG/BQTR_FIELD.

Avant que BigQuery Toolkit pour SAP ne crée une table dans BigQuery, vous pouvez remplacer la spécification de type de données par défaut par un autre type de données BigQuery dans la colonne Élément de données externe de l'écran de mappage des champs.

Types de données nécessitant un traitement spécial

Pour garantir l'exactitude et la compatibilité avec les tables BigQuery cibles, plusieurs types de données SAP nécessitent un traitement ou une conversion spéciaux lors du processus de réplication.

Bien que le BigQuery Toolkit pour SAP gère automatiquement certaines de ces conversions pour vous, d'autres nécessitent votre attention et une configuration manuelle.

Vous devez gérer manuellement les conversions pour les types de données suivants :

Valeurs booléennes

Pour les valeurs booléennes, SAP utilise le type de données CHAR. Par défaut, BigQuery Toolkit pour SAP mappe ce type de données sur le type de données STRING dans la table BigQuery cible.

Par conséquent, lorsque vous configurez la réplication pour les valeurs booléennes à l'aide de la transaction /GOOG/BQTR_SETTINGS, vous devez redéfinir l'attribution de type de données par défaut des champs de valeurs booléennes de STRING à BOOLEAN dans l'écran de mappage des champs.

Horodatages

Pour les codes temporels, SAP utilise les types de données P (décimaux compressés) ou DEC (décimaux). Par défaut, BigQuery Toolkit pour SAP mappe ces types de données sur NUMERIC dans la table BigQuery cible.

Par conséquent, pour les horodatages, lorsque vous configurez la réplication à l'aide de la transaction /GOOG/BQTR_SETTINGS, vous devez redéfinir l'attribution de type de données par défaut pour les champs d'horodatage de NUMERIC à TIMESTAMP ou TIMESTAMP (LONG) dans l'écran de mappage des champs.

Genre de type SAP X

Le genre de type SAP X est hexadécimal et est représenté par les types de données SAP RAW, RAWSTRING ou LRAW. Par défaut, BigQuery Toolkit pour SAP mappe ces types de données sur STRING dans la table BigQuery source.

Si vous avez besoin d'un champ source avec le genre de type SAP X pour effectuer le mappage sur BYTES à la place, vous devez modifier l'attribution de type de données par défaut pour le champ sur l'écran de mappage des champs de la transaction /GOOG/BQTR_SETTINGS.

Le genre de type SAP X est aussi parfois utilisé dans SAP pour représenter les entiers.

Dans ce cas, BigQuery Toolkit pour SAP vérifie le type de données du champ source pour l'un des types de données SAP afin de rechercher des entiers, INT1, INT2, INT4 et INT8 et attribue le type de données INTEGER dans la table BigQuery cible.

Genre de type SAP y

Le genre de type SAP y est une chaîne d'octets et est représenté par les types de données SAP RAW, RAWSTRING ou LRAW. Par défaut, BigQuery Toolkit pour SAP mappe ces types de données sur STRING dans la table BigQuery source.

Si vous avez besoin d'un champ source avec le genre de type SAP y pour effectuer le mappage sur BYTES à la place, vous devez modifier l'attribution de type de données par défaut pour le champ sur l'écran de mappage des champs de la transaction /GOOG/BQTR_SETTINGS.

Mappage par défaut des types de données

Le tableau suivant indique la conversion de type de données de BigQuery Toolkit pour SAP :

| Genre de type SAP | Type de données SAP | Type de données BigQuery | Remarques |

|---|---|---|---|

b (entier de 1 octet)s (entier de 2 octets)I (entier de 4 octets)8 (entier de 8 octets)

|

INT1INT2INT4INT8

|

INTEGER |

|

F (nombre à virgule flottante)

|

FLTP

|

FLOAT |

|

P (emballé)

|

CURRDECQUAN

|

NUMERIC |

Par défaut, le genre de type SAP P est mappé sur le type de données BigQuery NUMERIC et converti en un nombre au format externe. |

a (nombre flottant décimal, 16 emplacements)

|

DECFLOAT16 |

NUMERIC |

|

e (nombre flottant décimal, 16 emplacements)

|

DECFLOAT34 |

NUMERIC |

|

N (numérique) |

NUMC |

STRING |

|

X (hexadécimal)y (chaîne d'octets)

|

RAWRAWSTRINGLRAW

|

STRING |

Si le genre de type SAP est X, mais que le nom de type de données couvre le modèle 'INT*' (INT1, INT2, INT4), un élément de données source est remplacé par un nouvel élément de données TYPINT8 avec TYPEKIND '8', qui est mappé sur le type de données BigQuery INTEGER. |

C (caractère)g (chaîne de caractères)? (csequence)& (clike)

|

CHARSTRING |

STRING |

|

D (date) |

DATS |

DATE |

|

T (time) |

TIMS |

TIME |

Ressources de la communauté

Pour accélérer l'implémentation des applications basées sur BigQuery Toolkit dans les systèmes SAP S/4HANA qui utilisent Embedded BW, vous pouvez utiliser les outils de génération Open Source disponibles sur GitHub.

Obtenir de l'aide

Google Cloud propose une assistance pour les problèmes et les questions liés à l'installation, à la configuration, au fonctionnement et à la maintenance de BigQuery Toolkit pour SAP.

Pour les problèmes provenant de composants gérés par SAP tels que l'Operational Data Provisioning (ODP), le Data Migration Server (DMIS), les Core Data Services (CDS), l'Internet Communication Manager (ICM) ou des logiciels tiers, l' Google Cloud Customer Care s'efforce d'identifier la cause première. Pour résoudre ces problèmes, contactez le fournisseur ou le prestataire d'assistance concerné.

Pour résoudre les problèmes liés à BigQuery Toolkit pour SAP, consultez Résoudre les problèmes liés à BigQuery Toolkit pour SAP.

Procédez comme suit si vous avez besoin d'aide pour résoudre les problèmes liés au SDK ABAP pour Google Cloud :

Consultez le guide de dépannage du SDK ABAP pour Google Cloud.

Posez vos questions concernant le SDK ABAP pour Google Cloud et discutez de celui-ci avec la communauté sur les forums Cloud.

Recueillez toutes les informations de diagnostic disponibles et contactez Cloud Customer Care. Pour savoir comment contacter le service client, consultez Obtenir de l'aide pour SAP sur Google Cloud.