Questa pagina si applica ad Apigee e Apigee hybrid.

Visualizza la documentazione di

Apigee Edge.

![]()

Apigee Analytics raccoglie e analizza un ampio spettro di dati che fluiscono attraverso le tue API e fornisce strumenti di visualizzazione, tra cui dashboard interattive, report personalizzati e altri strumenti che identificano le tendenze nelle prestazioni dei proxy API.

Ora puoi accedere a questi contenuti avanzati esportando i dati di analisi da Apigee Analytics nel tuo repository di dati, ad esempio Google Cloud Storage o Google BigQuery. Puoi quindi sfruttare le potenti funzionalità di query e machine learning offerte da Google BigQuery e TensorFlow per eseguire la tua analisi dei dati. Puoi anche combinare i dati di analisi esportati con altri dati, come i log web, per ottenere nuove informazioni su utenti, API e applicazioni.

Quali formati di dati di esportazione sono supportati?

Esporta i dati di analisi in uno dei seguenti formati:

Valori separati da virgola (CSV)

Il delimitatore predefinito è una virgola (,). I caratteri delimitatori supportati includono virgola (,), barra verticale (|) e tabulazione (\t). Configura il valore utilizzando la proprietà

csvDelimiter, come descritto in Riferimento alle proprietà della richiesta di esportazione .JSON (delimitato da nuova riga)

Consente di utilizzare il carattere di nuova riga come delimitatore.

I dati esportati includono tutte le dimensioni e le metriche di Analytics integrate in Apigee e tutti i dati di analisi personalizzati che aggiungi. Per una descrizione dei dati esportati, consulta Riferimento per metriche, dimensioni e filtri di Analytics.

Puoi esportare i dati di analisi nei seguenti repository di dati:

Passaggi per esportare i dati di analisi

I seguenti passaggi riassumono la procedura utilizzata per esportare i dati di analisi:

- Configura il repository di dati (Cloud Storage o BigQuery) per l'esportazione dei dati. Devi assicurarti che il repository di dati sia configurato correttamente e che il account di servizio dell'agente di servizio Apigee utilizzato per scrivere i dati nel repository di dati disponga delle autorizzazioni corrette.

- Crea un datastore che definisca le proprietà del repository di dati (Cloud Storage o BigQuery) in cui esportare i dati.

- Esporta i dati di analisi. L'esportazione dei dati viene eseguita in modo asincrono in background.

- Visualizza lo stato della richiesta di esportazione per determinare quando verrà completata.

- Al termine dell'esportazione, accedi ai dati esportati nel tuo repository di dati.

Le sezioni seguenti descrivono questi passaggi in modo più dettagliato.

Configurazione del repository di dati

Configura Cloud Storage o BigQuery per consentire l'accesso tramite l'esportazione dei dati di analisi.

Configurazione di Google Cloud Storage

Prima di poter esportare i dati in Google Cloud Storage, devi:

Crea un bucket Google Cloud Storage.

Assicurati che l'API BigQuery sia attivata nel tuo progetto Google Cloud Platform. Apigee utilizza l'API BigQuery per sfruttare le funzionalità di esportazione di BigQuery durante l'esportazione in Cloud Storage.

Per istruzioni, vedi Abilitazione delle API.

Assicurati che al service account Agente di servizio Apigee con indirizzo email

service-project-number@gcp-sa-apigee.iam.gserviceaccount.comsiano assegnati i seguenti ruoli:- BigQuery Job User

- Amministratore Storage

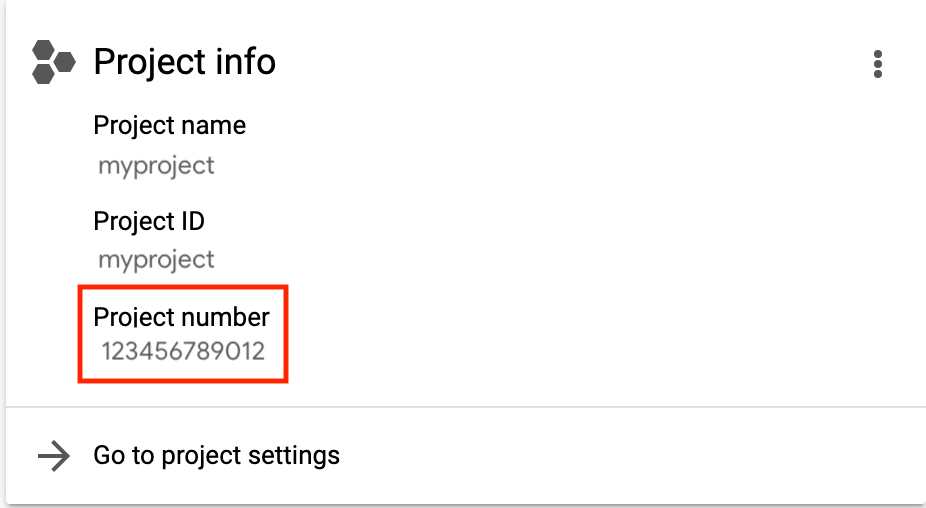

Il project-number è elencato nella home page del progetto, come mostrato di seguito.

Consulta l'articolo relativo a concessione, modifica e revoca dell'accesso alle risorse.

In alternativa, se vuoi modificare un ruolo esistente o crearne uno personalizzato, aggiungi le seguenti autorizzazioni al ruolo:

bigquery.jobs.createstorage.objects.createstorage.objects.deletestorage.objects.list

Configurazione di Google BigQuery

Prima di poter esportare i dati in Google BigQuery:

- Assicurati di aver attivato BigQuery nel tuo progetto Google Cloud Platform.

- Assicurati che l'API BigQuery sia attivata nel tuo progetto Google Cloud Platform. Per istruzioni, vedi Abilitazione delle API.

Assicurati che al service account Agente di servizio Apigee con indirizzo email

service-project-number@gcp-sa-apigee.iam.gserviceaccount.comsiano assegnati i seguenti ruoli:- BigQuery Job User

- BigQuery Data Editor

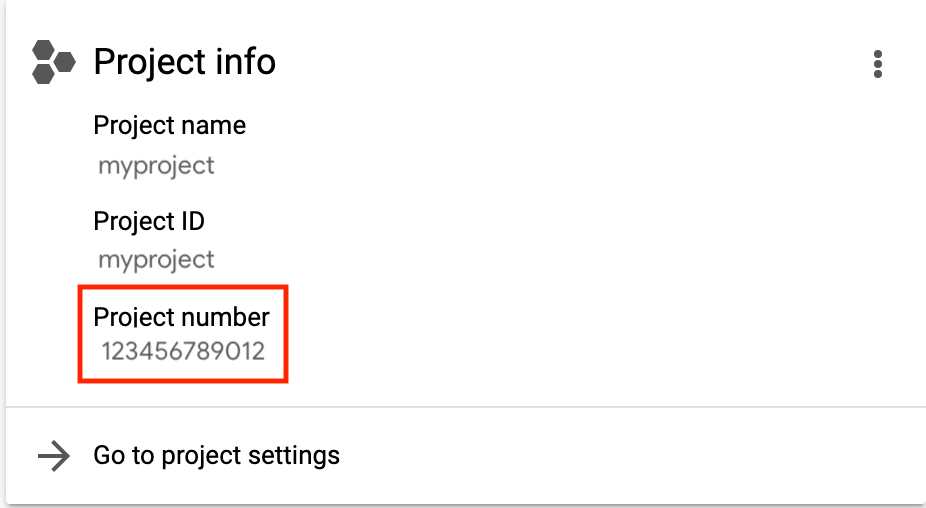

Il project-number è elencato nella home page del progetto, come mostrato di seguito.

Consulta l'articolo relativo a concessione, modifica e revoca dell'accesso alle risorse.

Se vuoi modificare un ruolo esistente o crearne uno personalizzato, aggiungi le seguenti autorizzazioni al ruolo:

bigquery.datasets.createbigquery.datasets.getbigquery.jobs.createbigquery.tables.createbigquery.tables.getbigquery.tables.updateData

Crea un set di dati BigQuery.

Esportazione dei dati in BigQuery per una singola regione negli Stati Uniti o nell'UE

Poiché i dati di analisi per gli Stati Uniti o l'UE vengono archiviati nella multi-regione degli Stati Uniti o dell'UE, non puoi esportarli direttamente in una singola regione degli Stati Uniti o dell'UE in BigQuery. Come soluzione alternativa, puoi prima esportare i dati in Google Cloud Storage e poi trasferirli in BigQuery nel seguente modo:

- Crea un bucket Cloud Storage e imposta Location sulla singola regione negli Stati Uniti o nell'UE che vuoi associare ai tuoi dati in BigQuery.

- Crea un datastore Cloud Storage, utilizzando il bucket di archiviazione creato nel passaggio precedente.

- Esporta i dati in Cloud Storage. Per un esempio, consulta Esempio 1: esporta i dati in Cloud Storage di seguito.

- Carica i dati in BigQuery, come descritto nelle sezioni seguenti:

Gestione dei datastore

Il datastore definisce la connessione al repository dei dati di esportazione (Cloud Storage, BigQuery).

Le sezioni seguenti descrivono come creare e gestire i datastore. Prima di creare un datastore, ti consigliamo di testare la configurazione del repository di dati.

Test della configurazione del repository di dati

Quando crei il repository di dati, Apigee non verifica né convalida che la configurazione sia valida. Ciò significa che puoi creare il datastore (nel passaggio successivo) e non rilevare errori fino a quando non esegui la prima esportazione dei dati.

Poiché l'esecuzione di una procedura di esportazione dei dati può richiedere molto tempo, puoi rilevare gli errori prima testando la configurazione del repository di dati per assicurarti che sia valida e correggendo eventuali errori prima di creare il datastore.

Per testare la configurazione del repository di dati, invia una richiesta POST all'API /organizations/{org}/analytics/datastores:test. Trasmetti le seguenti informazioni nel corpo della richiesta:

- Nome visualizzato

- Tipo di datastore

- Dettagli della configurazione in base al tipo di datastore, come descritto in Riferimento alle proprietà delle richieste Datastore.

Ad esempio, il seguente test verifica una configurazione del repository di dati Cloud Storage:

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores:test" \

-X POST \

-H "Content-type:application/json" \

-H "Authorization: Bearer $TOKEN" \

-d \

'{

"displayName": "My Cloud Storage datastore",

"targetType": "gcs",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

}'

Di seguito è riportato un esempio di risposta in caso di esito positivo del test:

{

"state": "completed",

}

Di seguito è riportato un esempio di risposta in caso di esito negativo del test:

{

"state": "failed",

"error": "<error message>"

}

In questo caso, risolvi i problemi sollevati nel messaggio di errore e testa di nuovo la configurazione del repository di dati. Dopo un test riuscito, crea il datastore come descritto nella sezione successiva.

Creazione di un datastore

Per creare un datastore, invia una richiesta POST all'API

/organizations/{org}/analytics/datastores. Trasmetti le seguenti informazioni nel corpo della richiesta:

- Nome visualizzato

- Tipo di datastore

- Dettagli della configurazione in base al tipo di datastore, come descritto in Riferimento alle proprietà delle richieste Datastore.

Di seguito sono riportati esempi per ogni tipo di datastore.

Di seguito è riportato un esempio della risposta per un repository di dati Cloud Storage:

{

"self": "/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b",

"displayName": "My Cloud Storage datastore",

"org": "myorg",

"targetType": "gcs",

"createTime": "1535411583949",

"lastUpdateTime": "1535411634291",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

}

Utilizza l'URL restituito nella proprietà self per visualizzare i dettagli del datastore, come descritto in Visualizzare i dettagli di un datastore.

Per saperne di più, consulta l'API datastore store.

Esempio 1: crea un datastore Cloud Storage

La seguente richiesta crea un datastore Cloud Storage:

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores" \

-X POST \

-H "Content-type:application/json" \

-H "Authorization: Bearer $TOKEN" \

-d \

'{

"displayName": "My Cloud Storage datastore",

"targetType": "gcs",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

}'

Dove $TOKEN è impostato sul tuo token di accesso OAuth 2.0, come descritto in

Ottenere un token di accesso OAuth 2.0. Per informazioni sulle opzioni curl utilizzate in questo esempio, consulta la sezione

Utilizzare curl. Per una descrizione delle variabili di ambiente che puoi utilizzare, consulta

Impostazione

delle variabili di ambiente per le richieste API Apigee.

Esempio 2: crea un datastore BigQuery

La seguente richiesta crea un datastore BigQuery:

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores" \

-X POST \

-H "Content-type:application/json" \

-H "Authorization: Bearer $TOKEN" \

-d \

'{

"displayName": "My BigQuery datastore",

"targetType": "bigquery",

"datastoreConfig": {

"projectId": "my-project",

"datasetName": "mybigquery",

"tablePrefix": "bqprefix"

}

}'

Dove $TOKEN è impostato sul tuo token di accesso OAuth 2.0, come descritto in

Ottenere un token di accesso OAuth 2.0. Per informazioni sulle opzioni curl utilizzate in questo esempio, consulta la sezione

Utilizzare curl. Per una descrizione delle variabili di ambiente che puoi utilizzare, consulta

Impostazione

delle variabili di ambiente per le richieste API Apigee.

Visualizzazione di tutti i datastore

Per visualizzare tutti i datastore della tua organizzazione, invia una richiesta GET all'API /organizations/{org}/analytics/datastores.

Ad esempio:

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores" \ -X GET \ -H "Authorization: Bearer $TOKEN"

Dove $TOKEN è impostato sul tuo token di accesso OAuth 2.0, come descritto in

Ottenere un token di accesso OAuth 2.0. Per informazioni sulle opzioni curl utilizzate in questo esempio, consulta la sezione

Utilizzare curl. Per una descrizione delle variabili di ambiente che puoi utilizzare, consulta

Impostazione

delle variabili di ambiente per le richieste API Apigee.

Di seguito è riportato un esempio di risposta:

{

"datastores": [

{

"self": "/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b",

"displayName": "My Cloud Storage datastore",

"org": "myorg",

"targetType": "gcs",

"createTime": "1535411583949",

"lastUpdateTime": "1535411634291",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

},

{

"self": "/organizations/myorg/analytics/datastores/g8c3f0mk-1f78-8837-9c67-k222b60ce30b",

"displayName": "My BigQuery datastore",

"org": "myorg",

"targetType": "bigquery",

"createTime": "1535411583949",

"lastUpdateTime": "1535411634291",

"datastoreConfig": {

"projectId": "my-project",

"datasetName": "mybigquery",

"tablePrefix": "bqprefix"

}

}

]

}

Per saperne di più, consulta l'API List data stores.

Visualizzazione dei dettagli di un datastore

Per visualizzare i dettagli di un datastore, invia una richiesta GET all'API

/organizations/{org}/analytics/datastores/{datastore}.

Ad esempio:

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b" \ -X GET \ -H "Authorization: Bearer $TOKEN"

Dove $TOKEN è impostato sul tuo token di accesso OAuth 2.0, come descritto in

Ottenere un token di accesso OAuth 2.0. Per informazioni sulle opzioni curl utilizzate in questo esempio, consulta la sezione

Utilizzare curl. Per una descrizione delle variabili di ambiente che puoi utilizzare, consulta

Impostazione

delle variabili di ambiente per le richieste API Apigee.

Di seguito è riportato un esempio di risposta per un datastore Cloud Storage:

{

"self": "/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b",

"displayName": "My Cloud Storage datastore",

"org": "myorg",

"targetType": "gcs",

"createTime": "1535411583949",

"lastUpdateTime": "1535411634291",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

}

Per saperne di più, consulta Get datastore API.

Modificare un datastore

Per modificare un datastore, invia una richiesta PUT all'API

/organizations/{org}/analytics/datastores/{datastore}. Trasmetti tutte o un sottoinsieme delle seguenti informazioni nel corpo della richiesta:

- Nome visualizzato del datastore

- Dettagli della configurazione in base al tipo di datastore, come descritto in Riferimento alle proprietà delle richieste Datastore.

Ad esempio, per aggiornare un datastore Cloud Storage:

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b" \

-X PUT \

-H "Content-type:application/json" \

-H "Authorization: Bearer $TOKEN" \

-d \

'{

"displayName": "My Cloud Storage datastore",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

}'

Dove $TOKEN è impostato sul tuo token di accesso OAuth 2.0, come descritto in

Ottenere un token di accesso OAuth 2.0. Per informazioni sulle opzioni curl utilizzate in questo esempio, consulta la sezione

Utilizzare curl. Per una descrizione delle variabili di ambiente che puoi utilizzare, consulta

Impostazione

delle variabili di ambiente per le richieste API Apigee.

Di seguito è riportato un esempio di risposta per un datastore Cloud Storage:

{

"self": "/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b",

"displayName": "My Cloud Storage datastore",

"org": "myorg",

"targetType": "gcs",

"createTime": "1535411583949",

"lastUpdateTime": "1535411634291",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

}

Per saperne di più, consulta l'API datastore store.

Eliminazione di un datastore

Per eliminare un datastore, invia una richiesta DELETE all'API /organizations/{org}/analytics/datastores/{datastore}.

Ad esempio:

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b" \ -X DELETE \ -H "Authorization: Bearer $TOKEN"

Dove $TOKEN è impostato sul tuo token di accesso OAuth 2.0, come descritto in

Ottenere un token di accesso OAuth 2.0. Per informazioni sulle opzioni curl utilizzate in questo esempio, consulta la sezione

Utilizzare curl. Per una descrizione delle variabili di ambiente che puoi utilizzare, consulta

Impostazione

delle variabili di ambiente per le richieste API Apigee.

Di seguito è riportato un esempio di risposta:

{}Per saperne di più, consulta l'API datastore store.

Esportazione dei dati di analisi

Per esportare i dati di Analytics, invia una richiesta POST all'API /organizations/{org}/environments/{env}/analytics/exports. Trasmetti le seguenti informazioni nel corpo della richiesta:

- Nome e descrizione della richiesta di esportazione

- Intervallo di date dei dati esportati (il valore può coprire un solo giorno)

- Formato dei dati esportati

- Nome datastore

Di seguito sono riportati alcuni esempi di richieste di esportazione. Per una descrizione completa delle proprietà del corpo della richiesta, consulta Riferimento alle proprietà della richiesta di esportazione.

La risposta alla richiesta POST è nel formato:

{

"self": "/organizations/myorg/environments/test/analytics/exports/a7c2f0dd-1b53-4917-9c42-a211b60ce35b",

"created": "2017-09-28T12:39:35Z",

"state": "enqueued"

}

Tieni presente che la proprietà state nella risposta è impostata su enqueued. La richiesta POST funziona in modo asincrono. Ciò significa che continua a essere eseguito in background dopo che la richiesta restituisce una risposta. I valori possibili per state includono: enqueued, running, completed, failed.

Utilizza l'URL restituito nella proprietà self per visualizzare lo stato della richiesta di esportazione dei dati, come descritto in Visualizzare lo stato di una richiesta di esportazione di Analytics. Al termine della richiesta, il valore della proprietà state nella risposta viene impostato su completed. Puoi quindi accedere ai dati di analisi nel tuo datastore.

Per saperne di più, consulta l'API Create data export.

Esempio 1: esporta i dati in Cloud Storage

L'esempio seguente esporta un insieme completo di dati non elaborati delle ultime 24 ore dall'ambiente test nell'organizzazione myorg. I contenuti vengono esportati in Cloud Storage in formato JSON:

curl "https://apigee.googleapis.com/v1/organizations/myorg/environments/test/analytics/exports" \

-X POST \

-H "Content-type:application/json" \

-H "Authorization: Bearer $TOKEN" \

-d \

'{

"name": "Export raw results to Cloud Storage",

"description": "Export raw results to Cloud Storage for last 24 hours",

"dateRange": {

"start": "2020-06-08",

"end": "2020-06-09"

},

"outputFormat": "json",

"datastoreName": "My Cloud Storage data repository"

}'

Dove $TOKEN è impostato sul tuo token di accesso OAuth 2.0, come descritto in

Ottenere un token di accesso OAuth 2.0. Per informazioni sulle opzioni curl utilizzate in questo esempio, consulta la sezione

Utilizzare curl. Per una descrizione delle variabili di ambiente che puoi utilizzare, consulta

Impostazione

delle variabili di ambiente per le richieste API Apigee.

Utilizza l'URI specificato dalla proprietà self per monitorare lo stato del job come descritto in Visualizzazione dello stato di una richiesta di esportazione di Analytics.

Esempio 2: esportare i dati in BigQuery

L'esempio seguente esporta un file CSV delimitato da virgole in BigQuery:

curl "https://apigee.googleapis.com/v1/organizations/myorg/environments/test/analytics/exports" \

-X POST \

-H "Content-type:application/json" \

-H "Authorization: Bearer $TOKEN" \

-d \

'{

"name": "Export query results to BigQuery",

"description": "One-time export to BigQuery",

"dateRange": {

"start": "2018-06-08",

"end": "2018-06-09"

},

"outputFormat": "csv",

"csvDelimiter": ",",

"datastoreName": "My BigQuery data repository"

}'

Dove $TOKEN è impostato sul tuo token di accesso OAuth 2.0, come descritto in

Ottenere un token di accesso OAuth 2.0. Per informazioni sulle opzioni curl utilizzate in questo esempio, consulta la sezione

Utilizzare curl. Per una descrizione delle variabili di ambiente che puoi utilizzare, consulta

Impostazione

delle variabili di ambiente per le richieste API Apigee.

Nota:il file CSV esportato crea una tabella BigQuery con il seguente prefisso:

<PREFIX>_<EXPORT_DATE>_api_<UUID>_from_<FROM_DATE>_to_<TO_DATE>

Utilizza l'URI specificato dalla proprietà self per monitorare lo stato del job come descritto in Visualizzare lo stato di una richiesta di esportazione di Analytics.

Informazioni sulle quote dell'API Export

Per evitare un utilizzo eccessivo di costose chiamate API di esportazione dei dati,

Apigee applica una quota di 15 chiamate al giorno per organizzazione alle chiamate all'API organizations/{org}/environments/{env}/analytics/exports.

Se superi la quota di chiamate, l'API restituisce una risposta HTTP 429.

Visualizzare lo stato di tutte le richieste di esportazione di Analytics

Per visualizzare lo stato di tutte le richieste di esportazione di Analytics, invia una richiesta GET a

/organizations/{org}/environments/{env}/analytics/exports.

Ad esempio, la seguente richiesta restituisce lo stato di tutte le richieste di esportazione di Analytics per l'ambiente test nell'organizzazione myorg:

curl "https://apigee.googleapis.com/v1/organizations/myorg/environments/test/analytics/exports" \ -X GET \ -H "Authorization: Bearer $TOKEN"

Dove $TOKEN è impostato sul tuo token di accesso OAuth 2.0, come descritto in

Ottenere un token di accesso OAuth 2.0. Per informazioni sulle opzioni curl utilizzate in questo esempio, consulta la sezione

Utilizzare curl. Per una descrizione delle variabili di ambiente che puoi utilizzare, consulta

Impostazione

delle variabili di ambiente per le richieste API Apigee.

Di seguito è riportato un esempio della risposta che elenca due richieste di esportazione, una in coda (creata e in coda) e una completata:

[

{

"self":

"/v1/organizations/myorg/environments/test/analytics/exports/e8b8db22-fe03-4364-aaf2-6d4f110444ba",

"name": "Export results To Cloud Storage",

"description": "One-time export to Cloud Storage",

"userId": "my@email.com",

"datastoreName": "My datastore",

"executionTime": "36 seconds",

"created": "2018-09-28T12:39:35Z",

"updated": "2018-09-28T12:39:42Z",

"state": "enqueued"

},

{

"self":

"/v1/organizations/myorg/environments/test/analytics/exports/9870987089fe03-4364-aaf2-6d4f110444ba"

"name": "Export raw results to BigQuery",

"description": "One-time export to BigQuery",

...

}

]

Per saperne di più, consulta API List data exports.

Visualizzare lo stato di una richiesta di esportazione di Analytics

Per visualizzare lo stato di una richiesta di esportazione di Analytics specifica, invia una richiesta GET a

/organizations/{org}/environments/{env}/analytics/exports/{exportId},

dove {exportId} è l'ID associato alla richiesta di esportazione di Analytics.

Ad esempio, la seguente richiesta restituisce lo stato della richiesta di esportazione di Analytics con l'ID 4d6d94ad-a33b-4572-8dba-8677c9c4bd98.

curl "https://apigee.googleapis.com/v1/organizations/myorg/environments/test/analytics/exports/4d6d94ad-a33b-4572-8dba-8677c9c4bd98" \ -X GET \ -H "Authorization: Bearer $TOKEN"

Di seguito è riportato un esempio di risposta:

{

"self":

"/v1/organizations/myorg/environments/test/analytics/exports/4d6d94ad-a33b-4572-8dba-8677c9c4bd98",

"name": "Export results to Cloud Storage",

"description": "One-time export to Cloud Storage",

"userId": "my@email.com",

"datastoreName": "My datastore",

"executionTime": "36 seconds",

"created": "2018-09-28T12:39:35Z",

"updated": "2018-09-28T12:39:42Z",

"state": "enqueued"

}

Per saperne di più, consulta Recuperare l'API di esportazione dei dati.

Se l'esportazione di Analytics non restituisce dati di Analytics, executionTime è impostato su "0 secondi".

Riferimento per le proprietà delle richieste Datastore

La seguente tabella descrive le proprietà che puoi passare nel corpo della richiesta in formato JSON durante la creazione di un datastore in base al tipo di datastore.

Per Google Cloud Storage:

| Proprietà | Descrizione | Obbligatorio? |

|---|---|---|

| ID progetto | ID progetto Google Cloud.

Per creare un progetto Google Cloud Platform, consulta Creazione e gestione dei progetti nella documentazione di Google Cloud Platform. |

Sì |

| Nome bucket | Nome del bucket in Cloud Storage in cui vuoi esportare i dati di analisi.

Nota:il bucket deve esistere prima di eseguire un'esportazione dei dati. Per creare un bucket Cloud Storage, consulta Creare bucket nella documentazione di Google Cloud Platform. |

Sì |

| Percorso | Directory in cui archiviare i dati di analisi nel bucket Cloud Storage. | Sì |

Per BigQuery:

| Proprietà | Descrizione | Obbligatorio? |

|---|---|---|

| ID progetto | ID progetto Google Cloud.

Per creare un progetto Google Cloud Platform, consulta Creazione e gestione dei progetti nella documentazione di Google Cloud Platform. |

Sì |

| Nome set di dati | Nome del set di dati BigQuery in cui vuoi esportare i dati di analisi. Assicurati che il set di dati sia creato prima di richiedere l'esportazione dei dati.

Per creare un set di dati BigQuery, consulta Creazione e utilizzo di set di dati nella documentazione di Google Cloud Platform. |

Sì |

| Prefisso tabella | Il prefisso dei nomi delle tabelle create per i dati di analisi nel set di dati BigQuery. | Sì |

Riferimento alla proprietà della richiesta di esportazione

La seguente tabella descrive le proprietà che puoi trasmettere nel corpo della richiesta in formato JSON durante l'esportazione dei dati di analisi.

| Proprietà | Descrizione | Obbligatorio? |

|---|---|---|

description

|

Descrizione della richiesta di esportazione. | No |

name

|

Nome della richiesta di esportazione. | Sì |

dateRange

|

Specifica la data

"dateRange": {

"start": "2018-07-29",

"end": "2018-07-30"

}Il valore Nota:per assicurarti che tutti i dati vengano acquisiti dal giorno precedente, potresti dover ritardare l'ora di inizio della richiesta di esportazione (ad esempio, 00:05:00 UTC). |

Sì |

outputFormat

|

Specifica json o csv.

|

Sì |

csvDelimiter

|

Delimitatore utilizzato nel file di output CSV, se |

No |

datastoreName

|

Il nome del datastore contenente la definizione del datastore. | Sì |

Ad esempio:

{

"name": "Export raw results to Cloud Storage",

"description": "Export raw results to Cloud Storage for last 24 hours",

"datastoreName": "My Cloud Storage datastore"

}