Petunjuk ini menunjukkan cara mengekspor data dari aplikasi SAP atau database dasarnya ke BigQuery menggunakan SAP Data Services (DS).

Database tersebut dapat berupa SAP HANA atau database lain yang didukung oleh SAP.

Contoh dalam panduan ini mengekspor tabel database SQL Anywhere, tetapi Anda dapat menggunakannya untuk menyiapkan ekspor jenis objek lainnya dari aplikasi SAP dan lapisan database ke BigQuery.

Anda dapat menggunakan ekspor data untuk mencadangkan data SAP atau untuk menggabungkan data dari sistem SAP dengan data konsumen dari sistem lain di BigQuery. Di sana, Anda dapat memperoleh insight dari machine learning dan untuk analisis data berskala petabyte.

Petunjuk ini ditujukan bagi administrator sistem SAP yang memiliki pengalaman dasar dalam konfigurasi SAP Basis, SAP DS, dan Google Cloud.

Arsitektur

SAP Data Services mengambil data dari aplikasi SAP atau database dasarnya, mengubah data agar kompatibel dengan format BigQuery, dan memulai tugas pemuatan yang memindahkan data ke BigQuery. Setelah tugas pemuatan selesai, data akan tersedia di BigQuery untuk dianalisis.

Ekspor adalah snapshot data dalam sistem sumber pada saat ekspor. Anda mengontrol kapan SAP Data Services memulai ekspor. Semua data yang ada dalam tabel BigQuery target akan ditimpa oleh data yang diekspor. Setelah ekspor selesai, data di BigQuery tidak akan disinkronkan dengan data di sistem sumber.

Dalam skenario ini, sistem sumber SAP dan SAP Data Services dapat dijalankan dengan baik di dalam maupun di luar Google Cloud.

Komponen solusi inti

Komponen berikut diperlukan untuk mengekspor data dari aplikasi SAP atau dari database ke BigQuery dengan menggunakan SAP Data Services:

| Komponen | Versi yang diperlukan | Catatan |

|---|---|---|

| Stack server aplikasi SAP | Semua Sistem SAP berbasis ABAP yang dimulai dengan R/3 4.6C | Dalam panduan ini, server aplikasi dan server database secara kolektif disebut sebagai sistem sumber, meskipun jika keduanya dijalankan di mesin yang berbeda. Menentukan pengguna RFC dengan otorisasi yang sesuai Opsional: menentukan ruang tabel terpisah untuk tabel logging |

| Sistem database (DB) | Setiap versi DB yang tercantum sebagai didukung dalam Matriks Ketersediaan Produk (PAM) SAP, tunduk pada batasan stack SAP NetWeaver yang tercantum dalam PAM. | |

| SAP Data Services | SAP Data Services 4.2 SP1 atau yang lebih tinggi | |

| BigQuery | T/A |

Biaya

BigQuery adalah komponen Google Cloud yang dapat ditagih.

Gunakan Kalkulator Harga untuk membuat perkiraan biaya berdasarkan penggunaan yang Anda proyeksikan.

Prasyarat

Petunjuk ini mengasumsikan bahwa sistem aplikasi SAP, server database, dan SAP Data Services sudah diinstal dan dikonfigurasi untuk operasi normal.

Periksa di SAP untuk memastikan bahwa konfigurasi yang Anda rencanakan sesuai dengan persyaratan pemberian lisensi SAP. Persyaratan tersebut mungkin berbeda, bergantung pada apakah Anda mengekspor data dari sistem aplikasi SAP atau dari database dasar.

Menyiapkan project Google Cloud di Google Cloud

Sebelum dapat menggunakan BigQuery, Anda memerlukan project Google Cloud.

Membuat project Google Cloud

Buka konsol Google Cloud lalu mendaftarlah dengan menelusuri wizard penyiapan.

Di samping logo Google Cloud di sudut kiri atas, klik dropdown lalu pilih NEW PROJECT.

Beri nama project Anda, lalu klik Create.

Setelah project dibuat (notifikasi ditampilkan di kanan atas), muat ulang halaman.

Mengaktifkan API

Aktifkan BigQuery API:

Membuat akun layanan

Akun layanan (khususnya file kuncinya) digunakan untuk mengautentikasi SAP DS ke BigQuery. Gunakan file kunci tersebut nanti saat Anda membuat datastore target.

Di konsol Google Cloud , buka halaman Service accounts.

Pilih project Google Cloud Anda.

Klik Create Service Account.

Masukkan Service account name.

Klik Create and Continue.

Pada daftar Select a role, pilih BigQuery > BigQuery Data Editor.

Klik Add Another Role.

Pada daftar Select a role, pilih BigQuery > BigQuery Job User.

Klik Continue.

Berikan akses ke akun layanan kepada pengguna lain sebagaimana mestinya.

Klik Done.

Pada halaman Service accounts di konsol Google Cloud, klik alamat email akun layanan yang baru saja Anda buat.

Di bawah nama akun layanan, klik tab Keys.

Klik menu drop-down Add Key, lalu pilih Create new key.

Pastikan jenis kunci JSON telah ditentukan.

Klik Create.

Simpan file kunci yang didownload secara otomatis ke lokasi yang aman.

Mengonfigurasi ekspor dari sistem SAP ke BigQuery

Mengonfigurasi solusi ini mencakup langkah-langkah tingkat tinggi berikut:

- Mengonfigurasi SAP Data Services

- Membuat aliran data antara SAP Data Services dan BigQuery

Konfigurasi SAP Data Services

Membuat project layanan data

- Buka aplikasi SAP Data Services Designer.

- Buka Project > New > Project.

- Tentukan nama di kolom Project name.

- Klik Create. Project Anda akan muncul di Project Explorer di sebelah kiri.

Membuat datastore sumber

Anda dapat menggunakan sistem aplikasi SAP atau database dasarnya sebagai datastore sumber untuk SAP Data Services. Jenis objek data yang dapat Anda ekspor akan berbeda-beda, bergantung pada apakah Anda menggunakan sistem aplikasi SAP atau database sebagai datastore Anda.

Jika menggunakan sistem aplikasi SAP sebagai datastore, Anda dapat mengekspor objek berikut:

- Tabel

- Dilihat

- Hierarki

- ODP

- BAPI (Fungsi)

- IDocs

Jika menggunakan database dasar sebagai koneksi datastore, Anda dapat mengekspor objek seperti berikut:

- Tabel

- Dilihat

- Prosedur tersimpan

- Objek data lainnya

Konfigurasi datastore untuk sistem aplikasi dan database SAP dijelaskan di bagian berikut. Terlepas dari jenis koneksi datastore atau objek data, prosedur untuk mengimpor dan menggunakan objek dalam aliran data SAP Data Services hampir sama.

Konfigurasi untuk koneksi lapisan aplikasi SAP

Langkah-langkah ini akan membuat koneksi ke aplikasi SAP dan menambahkan objek data ke node datastore yang berlaku di library objek Designer.

- Buka aplikasi SAP Data Services Designer.

- Buka project SAP Data Services Anda di Project Explorer.

- Buka Project > New > Datastore.

- Isi Datastore Name. Misalnya, ECC_DS.

- Di kolom Datastore type, pilih SAP Applications.

- Di kolom Application server name, masukkan nama instance server aplikasi SAP.

- Tentukan kredensial akses server aplikasi SAP.

- Klik OK.

Konfigurasi untuk koneksi lapisan database SAP

SAP HANA

Langkah-langkah ini akan membuat koneksi ke database SAP HANA dan menambahkan tabel data ke node datastore yang berlaku di library objek Designer.

- Buka aplikasi SAP Data Services Designer.

- Buka project SAP Data Services Anda di Project Explorer.

- Buka Project > New > Datastore.

- Isi Datastore Name, misalnya, HANA_DS.

- Di kolom Datastore type, pilih opsi Database.

- Di kolom Database type, pilih opsi SAP HANA.

- Di kolom Database version, pilih versi database Anda.

- Isi nama Database server, Port Number, dan kredensial akses.

- Klik OK.

Database lain yang didukung

Langkah-langkah ini akan membuat koneksi ke SQL Anywhere dan menambahkan tabel data ke node datastore yang berlaku di library objek Designer.

Langkah-langkah untuk pembuatan koneksi ke database lain yang didukung hampir sama.

- Buka aplikasi SAP Data Services Designer.

- Buka project SAP Data Services Anda di Project Explorer.

- Buka Project > New > Datastore.

- Isi Name, misalnya, SQL_ANYWHERE_DS.

- Di kolom Datastore type, pilih opsi Database.

- Di kolom Database type, pilih opsi SQL Anywhere.

- Di kolom Database version, pilih versi database Anda.

- Isi Database server name, Database name, dan kredensial akses.

- Klik OK.

Datastore baru akan muncul di tab Datastore di library objek lokal Designer.

Membuat datastore target

Langkah-langkah ini akan membuat datastore BigQuery yang menggunakan akun layanan yang telah Anda buat sebelumnya di bagian Membuat akun layanan. Dengan akun layanan, SAP Data Services dapat mengakses BigQuery dengan aman.

Untuk informasi selengkapnya, lihat Mendapatkan email akun layanan Google dan Mendapatkan file kunci pribadi akun layanan Google dalam dokumentasi SAP Data Services.

- Buka aplikasi SAP Data Services Designer.

- Buka project SAP Data Services Anda di Project Explorer.

- Buka Project > New > Datastore.

- Isi kolom Name. Misalnya, BQ_DS.

- Di kolom Datastore type, pilih Google BigQuery.

- Opsi Web Service URL akan muncul. Software ini secara otomatis menyelesaikan opsi dengan URL layanan web BigQuery default.

- Pilih Advanced.

- Selesaikan opsi Advanced berdasarkan Deskripsi opsi Datastore untuk BigQuery dalam dokumentasi SAP Data Services.

- Klik Oke.

Datastore baru akan muncul di tab Datastore di library objek lokal Designer.

Menyiapkan aliran data antara SAP Data Services dan BigQuery

Untuk menyiapkan aliran data, Anda harus membuat tugas batch, membuat aliran data loader BigQuery, serta mengimpor tabel sumber dan BigQuery ke SAP Data Services sebagai metadata eksternal.

Membuat tugas batch

- Buka aplikasi SAP Data Services Designer.

- Buka project SAP Data Services Anda di Project Explorer.

- Buka Project > New > Batch Job.

- Isi kolom Name. Misalnya, JOB_SQL_ANYWHERE_BQ.

- Klik OK.

Membuat logika aliran data

Mengimpor tabel sumber

Langkah-langkah ini mengimpor tabel database dari datastore sumber dan menyediakannya di SAP Data Services.

- Buka aplikasi SAP Data Services Designer.

- Luaskan datastore sumber di Project Explorer.

- Pilih opsi External Metadata di bagian atas panel kanan. Daftar node dengan tabel yang tersedia dan/atau objek lain akan muncul.

- Pilih tabel yang akan diimpor dari daftar.

- Klik kanan dan pilih opsi Import.

- Tabel yang diimpor kini tersedia di library objek di bagian node datastore sumber.

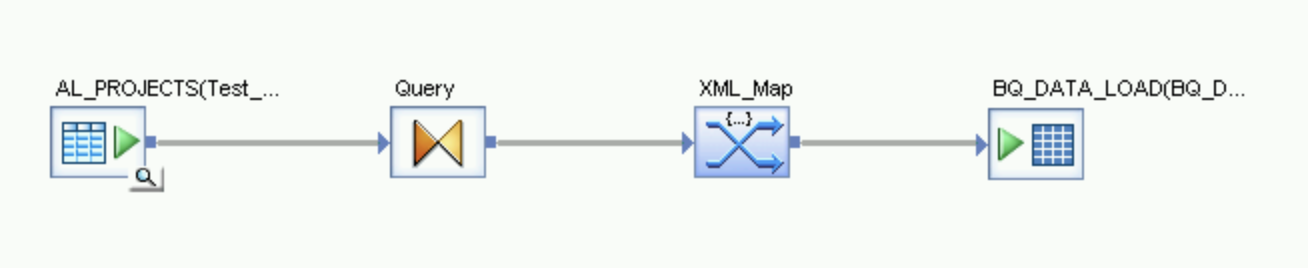

Membuat aliran data

- Pilih tugas batch di Project Explorer.

- Klik kanan di ruang kerja kosong di panel kanan dan pilih opsi Add New > Dataflow.

- Klik kanan ikon dataflow, lalu pilih Rename.

- Ubah nama menjadi DF_SQL_ANYWHERE_BQ.

Buka ruang kerja dataflow dengan mengklik dua kali ikon dataflow.

Mengimpor dan menghubungkan aliran data dengan objek datastore sumber

- Luaskan datastore sumber di Project Explorer.

- Dari datastore, tarik lalu lepas tabel sumber ke ruang kerja aliran data (pilih opsi Make Source saat Anda menarik tabel ke ruang kerja). Dalam petunjuk ini, datastore diberi nama SQL_ANYWHERE_DS. Nama datastore Anda mungkin berbeda.

- Tarik Query transform dari node Platform di tab Transforms pada library objek ke aliran data.

- Hubungkan tabel sumber di ruang kerja ke Query transform.

- Klik dua kali di Query transform.

Pilih semua kolom tabel pada bagian Schema In di sebelah kiri, lalu tarik ke Schema Out di sebelah kanan.

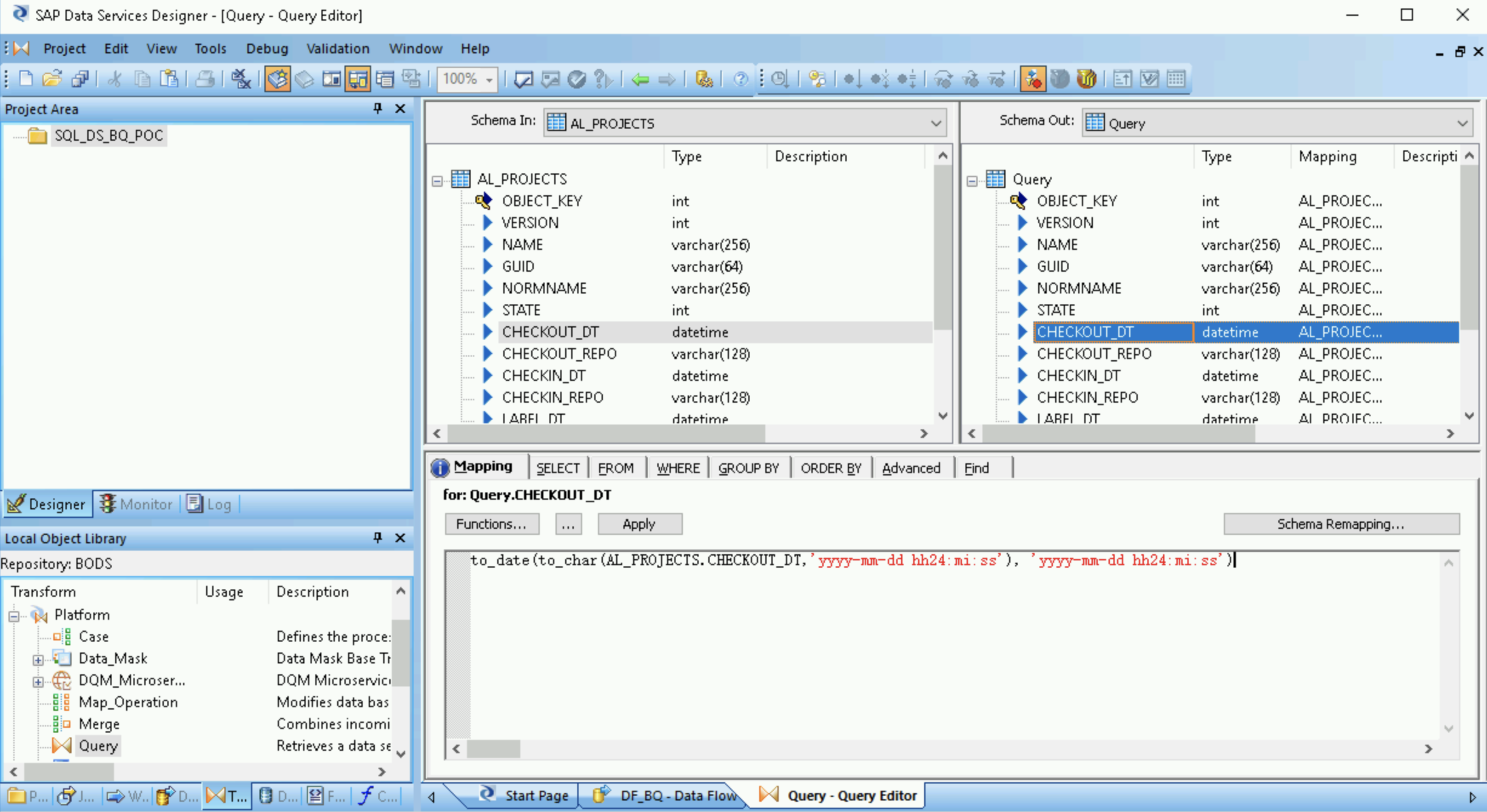

- Pilih kolom datetime dalam daftar Schema Out di sebelah kanan.

- Pilih tab Mapping di bawah daftar skema.

Ganti nama kolom dengan fungsi berikut:

to_date(to_char(FIELDNAME,'yyyy-mm-dd hh24:mi:ss'), 'yyyy-mm-dd hh24:mi:ss')

FIELDNAME adalah nama kolom yang Anda pilih.

Klik ikon Kembali di toolbar aplikasi untuk kembali ke Dataflow Editor.

Dari node Platform di tab Transforms pada library objek, tarik transformasi XML_Map ke dalam aliran data.

Pilih mode Batch dalam dialog.

Hubungkan transformasi Query ke transformasi XML_Map.

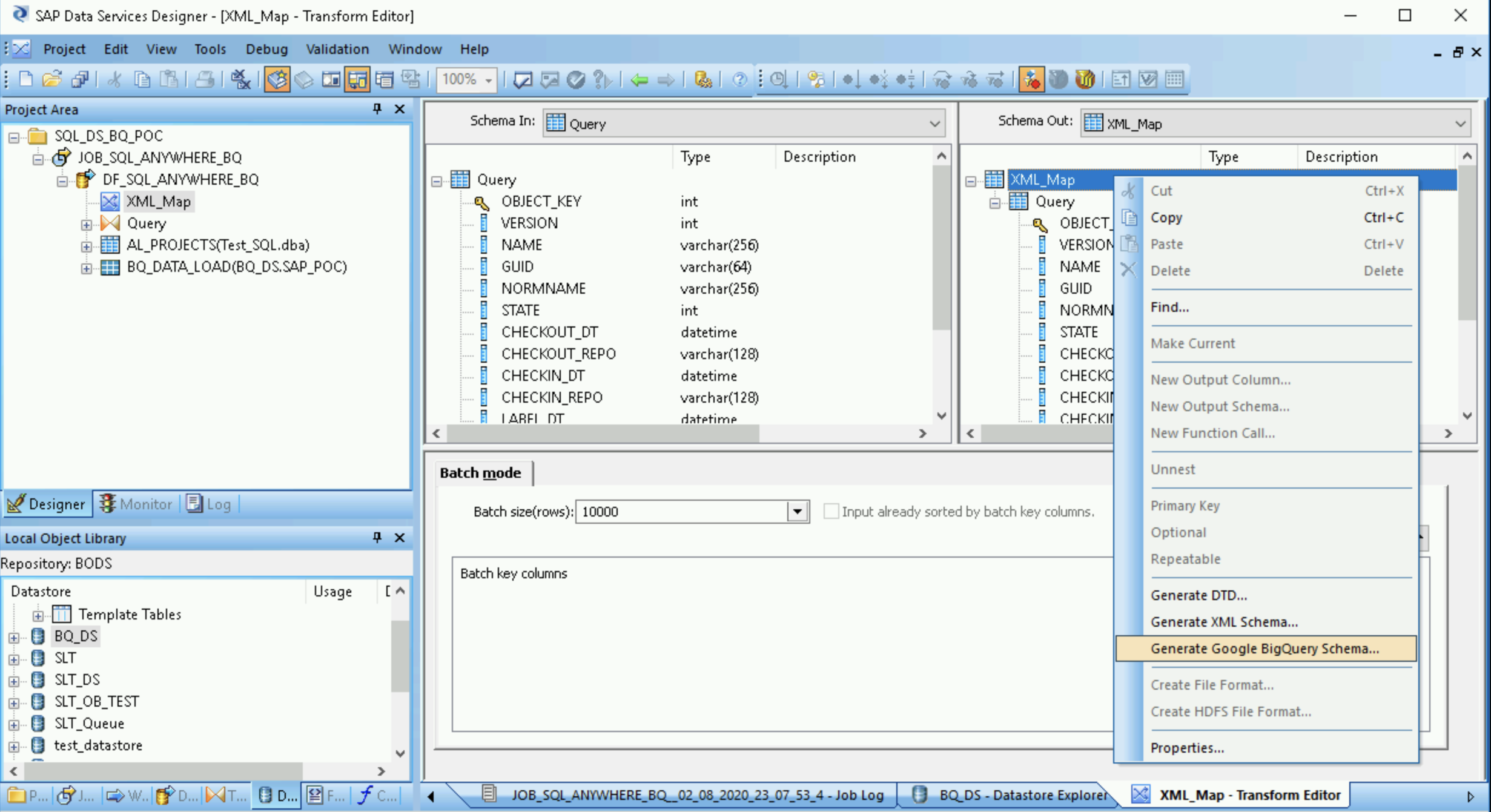

Membuat file skema

Langkah-langkah ini akan membuat file skema yang mencerminkan struktur tabel sumber. Kemudian, Anda akan menggunakan file skema untuk membuat tabel BigQuery.

Skema ini memastikan bahwa aliran data loader BigQuery berhasil mengisi tabel BigQuery yang baru.

- Buka XML Map transform, lalu selesaikan bagian skema input dan output berdasarkan data yang Anda sertakan dalam tabel BigQuery.

- Klik kanan node XML_Map di kolom Schema Out, lalu pilih Generate Google BigQuery Schema dari menu dropdown.

- Masukkan nama dan lokasi untuk skema tersebut.

- Klik Save.

SAP Data Services menghasilkan file skema dengan ekstensi file .json.

Membuat tabel BigQuery

Anda perlu membuat tabel dalam set data BigQuery diGoogle Cloud untuk pemuatan data. Untuk membuat tabel, gunakan skema yang dibuat di SAP Data Services.

Tabel ini didasarkan pada skema yang Anda buat pada langkah sebelumnya.

- Akses project Google Cloud Anda di konsol Google Cloud .

- Pilih BigQuery.

- Klik set data yang berlaku.

- Klik Create table.

- Masukkan Nama tabel. Misalnya,

BQ_DATA_LOAD. - Di bagian Schema, alihkan setelan untuk mengaktifkan mode Edit as text.

- Tetapkan skema tabel baru di BigQuery dengan menyalin dan menempelkan konten file skema yang Anda buat di halaman Membuat file skema.

- Klik Create table.

Mengimpor tabel BigQuery

Langkah-langkah ini mengimpor tabel BigQuery yang Anda buat di langkah sebelumnya dan menyediakannya di SAP Data Services.

- Di library objek SAP Data Services Designer, klik kanan datastore BigQuery dan pilih opsi Refresh Object Library. Tindakan ini akan memperbarui daftar tabel sumber data yang dapat Anda gunakan dalam aliran data.

- Buka datastore BigQuery.

- Di bagian atas panel kanan, pilih External Metadata. Tabel BigQuery yang Anda buat akan muncul.

- Klik kanan nama tabel BigQuery yang berlaku, lalu pilih Import.

- Proses impor tabel yang dipilih ke SAP Data Services dimulai. Tabel tersebut sekarang tersedia di library objek pada node datastore target.

Mengimpor dan menghubungkan aliran data dengan objek datastore target

- Dari datastore di library objek, tarik tabel BigQuery yang diimpor ke aliran data. Nama datastore dalam petunjuk ini adalah

BQ_DS. Nama datastore Anda mungkin berbeda. Hubungkan transformasi XML_Map ke tabel BigQuery yang diimpor.

Buka transformasi XML_Map, lalu selesaikan bagian skema input dan output berdasarkan data yang Anda sertakan dalam tabel BigQuery.

Klik dua kali tabel BigQuery di ruang kerja untuk membukanya dan menyelesaikan opsi di tab Target seperti yang ditunjukkan dalam tabel berikut:

Opsi Deskripsi Buat Port Tentukan No, yang merupakan default.

Menetapkan Yes akan membuat file sumber atau target menjadi port aliran data tersemat.Mode Tetapkan Truncate untuk pemuatan awal, yang akan menggantikan semua data yang sudah ada dalam tabel BigQuery dengan data yang dimuat oleh SAP Data Services. Truncate adalah setelan default-nya. Jumlah loader Tentukan bilangan bulat positif guna menetapkan jumlah loader (thread) yang akan digunakan untuk pemrosesan. Defaultnya adalah 4.

Setiap loader memulai satu tugas pemuatan yang dapat dilanjutkan di BigQuery. Anda dapat menetapkan berapa pun jumlah loader.

Untuk membantu menentukan jumlah loader yang tepat, lihat dokumentasi SAP, termasuk:

Data gagal maksimum per loader Tentukan 0 atau bilangan bulat positif untuk menetapkan jumlah maksimum data yang bisa gagal per tugas pemuatan sebelum BigQuery berhenti memuat kumpulan data. Nilai defaultnya adalah nol (0). Klik ikon Validasi di toolbar bagian atas.

Klik ikon Kembali di toolbar aplikasi untuk kembali ke Dataflow Editor.

Memuat data ke BigQuery

Langkah-langkah ini memulai tugas replikasi dan menjalankan aliran data di SAP Data Services untuk memuat data dari sistem sumber ke BigQuery.

Saat Anda menjalankan pemuatan, semua data dalam set data sumber direplikasi ke tabel BigQuery target yang terhubung ke aliran data pemuatan. Setiap data dalam tabel target akan ditimpa.

- Di SAP Data Services Designer, buka Project Explorer.

- Klik kanan pada nama tugas replikasi dan pilih Execute.

- Klik OK.

- Proses pemuatan dimulai dan pesan debug mulai muncul di log SAP Data Services. Data dimuat ke tabel yang Anda buat di BigQuery untuk pemuatan awal. Nama tabel pemuatan dalam petunjuk ini adalah

BQ_DATA_LOAD. Nama tabel Anda mungkin berbeda. - Untuk melihat apakah pemuatan sudah selesai, buka konsol Google Cloud dan buka set data BigQuery yang berisi tabel. Jika data masih dimuat, "Loading" akan muncul di samping nama tabel.

Setelah dimuat, data siap untuk diproses di BigQuery.

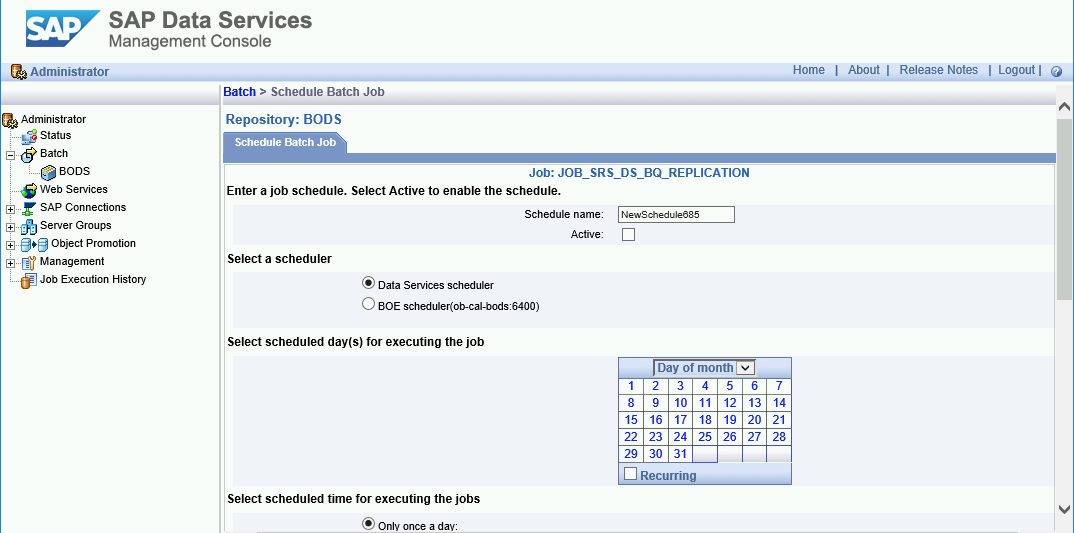

Menjadwalkan pemuatan

Anda dapat menjadwalkan tugas pemuatan untuk dijalankan secara berkala menggunakan SAP Data Services Management Console.

- Buka aplikasi SAP Data Services Management Console.

- Klik Administrator.

- Luaskan node Batch di hierarki menu di sebelah kiri.

- Klik nama repositori SAP Data Services.

- Klik tab Batch Job Configuration.

- Klik Add Schedule.

- Isi nama Schedule.

- Centang Active.

- Di bagian Select schedule time for running the jobs, tentukan frekuensi untuk eksekusi pemuatan delta.

- Penting: Google Cloud membatasi jumlah tugas pemuatan BigQuery yang dapat Anda jalankan dalam sehari. Pastikan jadwal Anda tidak melebihi batas, yang tidak dapat dinaikkan. Untuk mengetahui informasi lebih lanjut mengenai batas tugas pemuatan BigQuery, lihat Kuota & batas dalam dokumentasi BigQuery.

Klik Apply.

Langkah berikutnya

Membuat kueri dan menganalisis data yang direplikasi di BigQuery. Untuk informasi selengkapnya tentang pembuatan kueri, lihat:

- Ringkasan proses pembuatan kueri data BigQuery dalam dokumentasi BigQuery.

Untuk mengetahui beberapa ide tentang cara menyiapkan solusi untuk mereplikasi data secara hampir real-time dari aplikasi SAP ke BigQuery dengan menggunakan SAP Landscape Transformation Replication Server dan SAP Data Services, lihat:

Untuk arsitektur referensi, diagram, dan praktik terbaik lainnya, jelajahi Pusat Arsitektur Cloud.