ファイル ストレージはネットワーク接続ストレージ(NAS)とも呼ばれ、アプリケーションにファイルレベルのアクセスを提供し、複数のマシン間で共有できる情報の読み取りや更新を可能にします。オンプレミス ファイル ストレージ ソリューションの中にはスケールアップ アーキテクチャを持つものがあり、これは一定量のコンピューティング リソースにストレージを追加するだけです。ファイル ストレージ ソリューションの中にはスケールアウト アーキテクチャを持つものもあり、これは既存のファイル システムに対して、必要に応じて段階的に容量とコンピューティング(パフォーマンス)を追加できます。どちらのストレージ アーキテクチャの場合でも、1 つまたは複数の仮想マシン(VM)によりストレージにアクセスできます。

ファイル システムの中にはネイティブ POSIX クライアントを使用するものもありますが、多くのストレージ システムでは、クライアント マシンがファイル システムをマウントして、あたかもローカルでホストされているかのようにファイルにアクセスすることを可能にするプロトコルが使用されています。ファイル共有をエクスポートするための最も一般的なプロトコルは、Linux (と一部のケースで Windows)ではネットワーク ファイル システム(NFS)、Windows ではサーバー メッセージ ブロック(SMB)です。

このドキュメントでは、ファイル共有の次のオプションについて説明します。

- Compute Engine Persistent Disk とローカル SSD

- マネージド ソリューション:

- Google Cloud Marketplace のパートナー ソリューション:

すべての Google Cloud サービスのパフォーマンスと予測可能性の基盤となる要素はネットワーク スタックであり、Google は長年にわたってこれを進化させてきました。Google は Jupiter ファブリックを使用して、お客様のワークロードに影響を与えることなく進化し続ける堅牢かつスケーラブルで安定したネットワーキング スタックを構築しました。Google は社内のネットワーク能力の向上と強化に努めており、それによるパフォーマンス向上は、お客様のファイル共有ソリューションにメリットをもたらします。

投資対効果を最大限に高める Google Cloud の特長の 1 つは、カスタム VM タイプを指定できることです。ファイラーのサイズを選択する際、メモリと CPU の適切な組み合わせを選択して、オーバーサブスクライブを起こすことなくファイラーを最適なパフォーマンスで動作させることができます。

また、ファイル サーバーのストレージ デバイスに必要なストレージ帯域幅、IOPS、ネットワーク帯域幅が確実に提供されるように、適切な Compute Engine 永続ディスクの容量と vCPU 数を選択することが重要です。VM に対して、vCPU ごとに 2 Gbps のネットワーク スループット(最大値)が提供されます。永続ディスクの調整については、永続ディスクとローカル SSD のパフォーマンスの最適化をご覧ください。

Cloud Storage は、ペタバイト規模のデータを高レベルの冗長性と低コストで保管するのに適しています。ただし、Cloud Storage のパフォーマンス プロファイルと API は、ここで説明するファイル サーバーのものとは異なります。

ファイルサーバー ソリューションの概要

次の表は、ファイル サーバーのソリューションと機能をまとめたものです。

| 解決策 | 最適なデータセット | スループット | マネージド サポート | プロトコルのエクスポート |

|---|---|---|---|---|

| Filestore Basic | 1 TiB~64 TiB | 最大 1.2 GiB/秒 | Google のフルマネージド サービス | NFSv3 |

| Filestore Zonal | 1 TiB~100 TiB | 最大 26 GiB/秒 | Google のフルマネージド サービス | NFSv3 |

| Filestore Regional | 1 TiB~100 TiB | 最大 26 GiB/秒 | Google のフルマネージド サービス | NFSv3 |

| Google Cloud NetApp Volumes | 1 GiB~100 TiB | MB 規模/秒~4.5 GiB/秒 | Google のフルマネージド サービス | NFSv3、NFSv4.1、SMB2、SMB3 |

| NetApp Cloud Volumes ONTAP | 1 GiB~1 PiB | 可変 | お客様が管理 | NFSv3、NFSv4.1、SMB2、SMB3、iSCSI |

| Nasuni | 数十 TB~1 PB 超 | 最大 1.2 Gbps | Nasuni と顧客が管理 | NFSv3、NFSv4、NFSv4.1、NFSv4.2、SMB2、SMB3 |

| 読み取り専用 Persistent Disk | 64 TB 未満 | 240~1,200 Mbps | × | 直接接続 |

Persistent Disk とローカル SSD

所有するデータが単一の VM からのアクセスで十分な規模の場合、または時間が経過してもデータが変化しない場合は、Compute Engine Persistent Disk を使用し、ファイル サーバーを一切使用しないという選択肢もあります。永続ディスクを使用する場合、Ext4 や XFS などのファイル システムでディスクをフォーマットし、読み書きモードまたは読み取り専用モードでボリュームをアタッチできます。つまり、ボリュームをインスタンスにアタッチして必要なデータを読み込んだ後に、そのボリュームを読み取り専用ディスクとして数百の VM に同時に接続できます。読み取り専用の永続ディスクの使用は、すべてのユースケースで適切とは限りませんが、ファイル サーバーを使用する場合に比べて複雑性が大きく軽減される可能性があります。

永続ディスクは安定したパフォーマンスを提供します。インスタンスにアタッチした同じサイズのすべてのディスク(SSD 永続ディスクの場合は同じ数の vCPU)は、同じパフォーマンス特性を持ちます。本番環境で使用する前に永続ディスクをプリウォームまたはテストする必要はありません。

ボリュームのプロビジョニング後に考慮すべき I/O コストが存在しないため、永続ディスクのコストを見積もるのは簡単です。永続ディスクは、必要に応じてサイズ変更することもできます。これにより、低コストで低容量のボリュームから始めることができます。容量をスケーリングするために追加のインスタンスやディスクを作成する必要はありません。

ストレージの合計容量が主な要件となる場合は、低コストの標準永続ディスクを使用できます。耐久性を維持しながら最高のパフォーマンスを実現するためには、SSD 永続ディスクを使用できます。

データが一時的で、1 ミリ秒未満のレイテンシと高い IOPS(1 秒あたりの入出力オペレーション数)が要求される場合は、最大 9 TB のローカル SSD を利用して優れたパフォーマンスを実現できます。ローカル SSD では、インスタンスの割り当て済みネットワーク帯域幅を使い切ることなく、Gbps 規模の帯域幅と数百万規模の IOPS が提供されます。ただし、ローカル SSD を使用すると、可用性、耐久性、柔軟性に関してある程度のトレードオフがあります。

Compute Engine インスタンスに使用できるさまざまなディスクタイプの比較については、ブロック ストレージのドキュメントをご覧ください。

ファイル ストレージ ソリューションを選択する際の考慮事項

ファイル ストレージ ソリューションの選択では、管理機能、費用、パフォーマンス、スケーラビリティに関するトレードオフを見極める必要があります。明確に定義されたワークロードであれば判断は簡単ですが、そのようなケースはまれです。ワークロードが時間とともに増加する場合や激しく変動する場合は、コストの節約より柔軟性と弾力性を優先して、拡張可能なソリューションを採用するほうが賢明です。一方、ワークロードが一時的で明確に定義できる場合は、解体と再構築が可能な専用のファイル ストレージ アーキテクチャを作成して、必要なストレージに即座に対応することが可能です。

最初に決定すべき事項の 1 つは、マネージド ストレージ サービス、プロダクト サポートが含まれるソリューション、サポートのないソリューションのうちどれに投資するかです。

- マネージド ファイル ストレージ サービスは、Google またはパートナーがすべての運用を行うため、運用が最も簡単です。これらのサービスは、他の大半の Google Cloud サービスと同様に、可用性に関するサービスレベル契約(SLA)を提供することもあります。

- マネージド方式ではないもののサポートされているソリューションでは、柔軟性が高くなります。問題が発生したときはパートナーに解決を依頼できますが、ストレージ ソリューションの日常的な運用はユーザーの責任になります。

- サポートのないソリューションでは、すべての問題の解決がユーザーに任されるため、デプロイと保守に多大な労力がかかります。これらのソリューションについては、このドキュメントでは説明しません。

次に、ソリューションの耐久性と可用性の要件を決定します。ほとんどのファイル ソリューションはゾーン ソリューションであり、ゾーンに障害が発生した場合にデフォルトでは保護されません。そのため、ゾーン障害に対する障害復旧(DR)ソリューションが必要かどうかを検討することが重要です。アプリケーションの耐久性と可用性に関する要件を理解することも重要です。たとえば、デプロイに際してのローカル SSD または永続ディスクの選択は、ファイル ソリューション ソフトウェアの構成と同様に、これらの要件に大きく影響します。高い耐久性と可用性を達成し、ゾーンまたはリージョンの障害に対する保護も行うには、どのソリューションでも慎重な計画が必要になります。

最後に、データにアクセスする必要がある場所(ゾーン、リージョン、オンプレミス データセンター)について検討します。オンプレミスからのアクセスとクラウド内からのアクセスを混在させることのできるソリューションは限られているため、データにアクセスするコンピューティング ファームの場所によってファイラー ソリューションの選択も影響を受けます。

マネージド ファイル ストレージ ソリューション

このセクションでは、Google が管理するファイル ストレージ ソリューションについて説明します。

Filestore Basic

Filestore は、Google のフルマネージド NAS ソリューションです。

Filestore Basic インスタンスは、ファイル共有、ソフトウェア開発、GKE ワークロードに適しています。データの保存には HDD または SSD を選択できます。SSD の方がパフォーマンスに優れています。どちらのオプションでも容量が段階的にスケールアップされ、バックアップを使用してデータを保護できます。

Filestore Zonal

Filestore Zonal は、Google Cloud 上やハイブリッド クラウド全体でエンタープライズ ストレージとデータ マネジメントを簡素化します。Filestore Zonal では、グローバル データに対し、費用対効果に優れた高パフォーマンスの並列アクセスが可能です。それとともに、動的にスケーリング可能な分散ファイル システムにより厳格な整合性が確保されます。Filestore Zonal を使用すると、リファクタリングを行わずに既存の NFS アプリケーションと NAS ワークフローをクラウドで実行できます。さらに、エンタープライズ データサービス(スナップショットやバックアップなど)の利点も活用できます。Filestore の CSI ドライバにより、コンテナ化されたワークロードでシームレスなデータの永続性、ポータビリティ、共有が可能になります。

Filestore Zonal インスタンスはオンデマンドでスケーリングできます。これにより、必要に応じてファイル システムのインフラストラクチャを作成および拡張でき、ストレージのパフォーマンスと容量が動的ワークフローの要件に常に沿うようにできます。Filestore Zonal クラスタが拡張されると、それに比例してメタデータと I/O パフォーマンスの両方が直線的にスケーリングされます。こうしてスケーリングされることで、ハイ パフォーマンス コンピューティング、分析、クロスサイトのデータ集約、DevOps など、幅広い種類のデータ集約型ワークフローの強化と迅速化が可能になります。そのため、Filestore Zonal は、ライフ サイエンス(ゲノム配列決定など)、金融サービス、メディア、エンターテイメントといったデータ中心型の業界で使用するのに最適です。

Filestore Regional

Filestore Regional は、重要なファイルベースのアプリケーションを Google Cloud にデプロイできるフルマネージドかつクラウドネイティブな NFS ソリューションで、SLA によって 99.99% のリージョン可用性を保証します。99.99% のリージョン可用性 SLA を提供する Filestore Regional は、高い可用性が要求されるアプリケーション向けに設計されています。簡単な操作(またはいくつかの gcloud コマンドや API 呼び出しを実行する)だけで、リージョン内の 3 つのゾーンに同期的に複製される NFS 共有をプロビジョニングできます。リージョン内のいずれかのゾーンが利用できなくなった場合でも、Filestore Regional は透過的にデータをアプリケーションに提供し続け、お客様側での操作を必要としません。

また、重要なデータをさらに保護するため、Filestore はファイル システムのスナップショットを定期的に作成して保持できます。Filestore を使用すると、事前に作成されたリカバリ ポイントから、個々のファイルまたはファイル システム全体を 10 分以内で復元できます。

SAP のような重要なアプリケーションでは、データベース階層とアプリケーション階層の両方で高い可用性が要求されます。この要件を満たすために、お客様は組み込みデータベースの高可用性を利用して、SAP データベース階層を複数のゾーンの Google Cloud Hyperdisk Extreme にデプロイできます。同様に、多数の VM 間での実行可能ファイルの共有が必要となる NetWeaver アプリケーション階層を Filestore Regional にデプロイできます。この場合、NetWeaver データがリージョン内の複数のゾーンにレプリケートされます。この結果、高可用性を備えた 3 層構造のミッション クリティカルなアプリケーション アーキテクチャが完成します。

IT 組織が Google Kubernetes Engine(GKE)のコンテナにステートフル アプリケーションをデプロイする事例も増加しています。そのため、多くの場合、これらのアプリケーションをサポートするために使用するインフラストラクチャを再検討する必要が生じます。ブロック ストレージ(Persistent Disk)、ファイル ストレージ(Filestore Basic、Zonal、または Regional)、オブジェクト ストレージ(Cloud Storage)を使用できます。GKE 用 Filestore マルチシェアと Filestore CSI ドライバを組み合わせると、複数の GKE Pod を必要とする組織は共有ファイル アクセスを使用して、ミッション クリティカルなワークロードの可用性を向上させることができます。

NetApp Volumes

NetApp Volumes は、共有ファイル ストレージを Google Cloud コンピューティング インスタンスに迅速にマウントできるフルマネージド Google サービスです。NetApp Volumes は、SMB、NFS、マルチプロトコル アクセスをサポートしています。NetApp Volumes は、アプリケーションに低いレイテンシで高いパフォーマンスを提供するだけでなく、堅牢なデータ保護機能(スナップショット、コピー、クロスリージョン レプリケーション、バックアップ)も備えています。このサービスは、シーケンシャルなワークロードとランダムなワークロードの両方を必要とするアプリケーションに適していて、数百または数千の Compute Engine インスタンスにスケーリングできます。100 GiB から 100 TiB の範囲のボリュームを数秒でプロビジョニングし、堅牢なデータ保護機能で保護できます。NetApp Volumes には、オンデマンドで変更できる 3 つのサービスレベル(スタンダード、プレミアム、エクストリーム)があるため、可用性に影響を及ぼすことなく、ワークロードに適したパフォーマンスを実現できます。NetApp Volumes を利用できる Google Cloud のロケーションについては、NetApp Volumes のロケーションをご覧ください。

Cloud Marketplace のパートナー ソリューション

Cloud Marketplace では、次のパートナーが提供するソリューションを利用できます。

NetApp Cloud Volumes ONTAP

NetApp Cloud Volumes ONTAP(NetApp CVO)は、お客様が管理するクラウドベースのソリューションで、NetApp の主要なデータ マネジメント オペレーティング システムである ONTAP の全機能セットを Google Cloud にもたらします。NetApp CVO は VPC 内にデプロイされ、課金とサポートは Google が行います。ONTAP ソフトウェアは、Compute Engine VM 上で実行され、永続ディスクと Cloud Storage バケットを組み合わせて(階層化が有効になっている場合)NAS データを保存します。組み込みファイラーはシン プロビジョニングを利用して NAS ボリュームに対応するので、お客様は使用した分のストレージに対してのみ請求されます。データが増えると、集約容量プールに永続ディスクが追加されます。

NetApp CVO では、基盤となるインフラストラクチャは抽象化され、クラウド環境またはオンプレミス環境の他のすべての ONTAP ボリュームとの共通の集約プールから切り分けるように、仮想データ ボリュームを作成できます。作成されたデータ ボリュームは、すべてのバージョンの NFS、SMB、マルチプロトコル NFS/SMB、iSCSI をサポートします。電子設計自動化(EDA)、メディア、エンターテイメントなど多くの業界で使用される、ウェブ コンテンツとリッチメディア コンテンツを含む幅広いファイルベースのワークロードをサポートします。

NetApp CVO は、スペース節約的な特定の時点のスナップショットを瞬時に作成し、Cloud Storage へのブロックレベルの永久増分バックアップを組み込み、クロスリージョンの非同期レプリケーションにより障害復旧に備えています。Compute Engine インスタンスと永続ディスクのタイプを選択できるので、ワークロードに必要なパフォーマンスを実現できます。NetApp CVO は、高パフォーマンス構成による運用時にも、重複除去、コンパクション、圧縮などによりストレージが効率化されます。また、使用頻度の低いデータは Cloud Storage バケットに自動的に階層化されるので、ペタバイト規模のデータを保存しながらも、全体的なストレージ費用を大幅に削減できます。

DDN EXAScaler Cloud

DDN の EXAScaler Cloud プラットフォームは、業界トップクラスの高性能なデータ処理向けの並列共有ファイル ソリューションであり、AI、HPC、分析のワークロードのサポートに必要な大量のデータを管理できます。ライフ サイエンス、エネルギー、自律走行車、金融サービスなどのデータを大量に使用するお客様は、クラウドでの AI や分析に EXAScaler Cloud を活用して、Google Cloud リソースから得られる利益を最大化し、クラウド バースト機能と長期的なデータの保持機能によりアジャイルなワークフローを作成できます。

EXAScaler Cloud の理想的な用途には、ディープ ラーニング アプリケーションと推論 AI アプリケーション、クラウド バースト機能を提供するハイブリッド クラウド アーキテクチャによるオンデマンドのハイ パフォーマンス処理、オンプレミスの EXAScaler デプロイの長期アセットを保持するためのリポジトリなどがあります。クラウドベースの EXAScaler は簡単にデプロイでき、上位 100 のスーパーコンピュータの 3 分の 2 以上を支える DDN の並列ファイル システムを利用しています。

EXAScaler Cloud は、データ集約型のクラウド ワークロードを最適化するように設計されています。I/O 競合を低減し、多数のクライアント向けの共有ストレージに対する耐障害性に優れたアクセスを提供することで、インサイトを得るまでの時間を短縮します。EXAScaler Cloud は、ネットワークやコンピューティング インスタンス自体を含めてアプリケーションからストレージ デバイスまでの環境全体を、高いパフォーマンスの実現に向けて最適化します。

柔軟な構成の場合、EXAScaler Cloud は、高パフォーマンスのスクラッチ ワークロード、IOPS またはスループット指向の高い永続性を有するアプリケーション、長期の永続的データに有用です。クラウド上でオンプレミス アーキテクチャを模倣することにより、お客様はワークロードをシームレスに移行し、ワークロードの移動によるエンドユーザーのアプリケーションの中断を最小限に抑えることができます。

DDN EXAScaler Cloud は、スケーラブルなワークロードを処理し、世界中の最大規模のデータ環境をサポートすることで得た専門知識に裏付けられています。プレミアム サポートの各オプションでは、オンプレミスでもクラウドでも同様のエキスパートによるサポートを受けられます。

詳しくは以下をご覧ください。

- Google Cloud 向け DDN のウェブページ

- HPC ワークロードの並列ファイル システム

- アーキテクチャ: DDN EXAScaler を使用した Google Cloud 内の Lustre ファイル システム

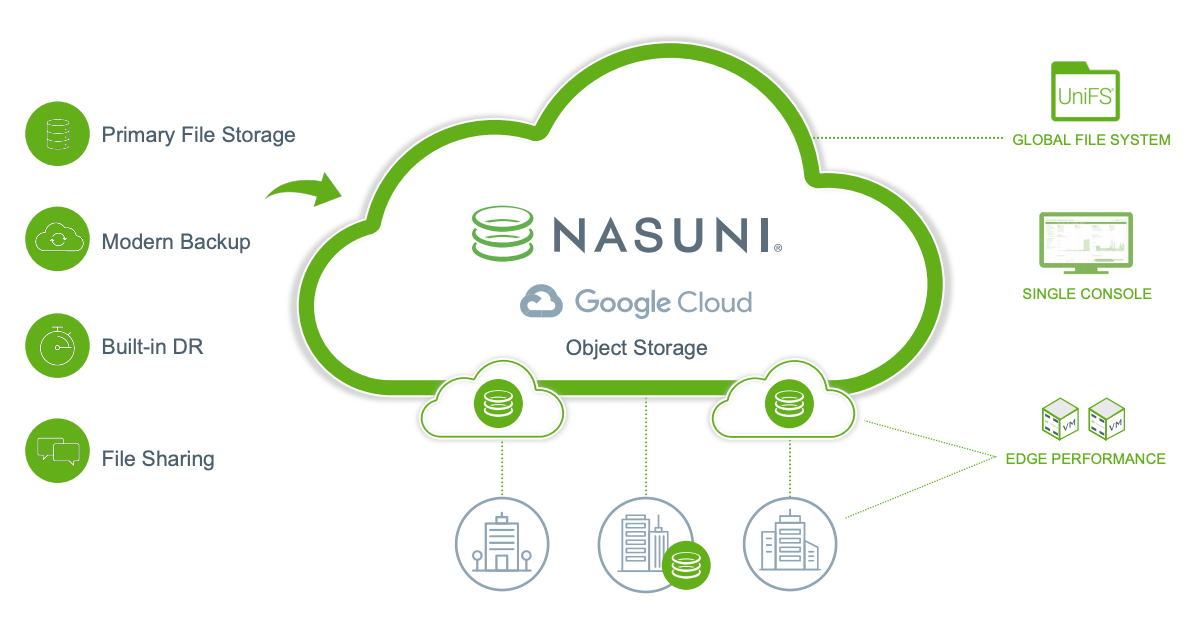

Nasuni Cloud File Storage

Nasuni は、エンタープライズ ファイル サーバーおよび NAS デバイス、関連するすべてのインフラストラクチャ(バックアップ ハードウェアと DR ハードウェアを含む)を、よりシンプルで低コストのクラウド代替プロダクトに置き換えます。Nasuni は Google Cloud のオブジェクト ストレージを使用して、より効率的な Software as a Service(SaaS)ストレージ ソリューションを提供します。このソリューションは、統制されていない急速なファイルデータの増大に対応するためにスケーリングできます。Nasuni は、すべての従業員がどこからでも、部門、プロジェクト、組織のファイル共有とアプリケーション ワークフローに対応できるように設計されています。

Nasuni は 3 つのパッケージがあり、あらゆる規模の企業や組織に合わせた料金を用意しているため、必要に応じて拡大や拡張が可能です。

Nasuni には次のような利点があります。

クラウドベースのプライマリ ファイル ストレージを最大 70% 削減。Nasuni のアーキテクチャは、組み込みのオブジェクトのライフサイクル管理ポリシーを活用します。このポリシーにより、Cloud Storage クラス(Standard、Nearline、Coldline、Archive など)を使用する完全な柔軟性が与えられます。Nasuni でプライマリ ストレージに即時アクセスのアーカイブ クラスを使用することで、最大 70% ものコスト削減を実現できます。

クラウドでの部門と組織のファイル共有。Nasuni のクラウドベースのアーキテクチャは、Google Cloud リージョン全体で単一のグローバル名前空間を使用できます。ファイル数、ファイルサイズ、スナップショット数に制限はなく、標準的な NAS(SMB)ドライブ マッピング プロトコルを介してパソコンから直接 Google Cloud にファイルを保存できます。

組み込み式のバックアップと障害復旧。Nasuni の「一度の設定で手間要らず」なオペレーションは、グローバル ファイル ストレージの管理を簡単にします。Backup and DR が含まれ、単一の管理コンソールで場所や時間を問わずに環境を監視して制御できます。

古いファイル サーバーの置き換え。Nasuni を使用すると、Microsoft Windows ファイル サーバーや他の既存のファイル ストレージ システムを Google Cloud に簡単に移行でき、これらの環境にかかる費用が抑えられ、管理の複雑さが減ります。

詳しくは以下をご覧ください。

- Nasuni の概要(動画)

- Nasuni と Google Cloud のパートナーシップ ウェブページ

- Nasuni Enterprise File Storage for Google Cloud ソリューションの概要(PDF)

- Cloud Marketplace の Nasuni Cloud File Storage

- Nasuni と Google Cloud のブログ

Sycomp Storage Fueled by IBM Spectrum Scale

Google Cloud Marketplace の Sycomp Storage Fueled by IBM Spectrum Scale を使用すると、ハイ パフォーマンス コンピューティング(HPC)、AI、ML、ビッグデータのワークロードを Google Cloud で実行できます。Sycomp Storage を使用すると、何千もの VM から同時にデータにアクセスし、ストレージ階層を自動的に管理して費用を削減しながら、アプリケーションをオンプレミスまたは Google Cloud で実行できます。Sycomp Storage Fueled by IBM Spectrum Scale は Cloud Marketplace で入手可能で、迅速にデプロイでき、NFS と IBM Spectrum Scale クライアントを介したデータへのアクセスをサポートします。

IBM Spectrum Scale は、大量(PB 規模)のデータを安全に管理できる並列ファイル システムです。IBM Spectrum Scale 並列ファイル システムは、POSIX 遵守の共有ファイル システムを必要とする HPC、AI、ML、ビッグデータなどのアプリケーションに適しています。調整可能なストレージ容量とパフォーマンスのスケーリングにより、Sycomp Storage は小規模から大規模の HPC、AI、ML のワークロードをサポートできます。

Google Cloud にクラスタをデプロイしたら、その使用方法を決定します。クラウドのみで使用するか、既存のオンプレミス IBM Spectrum Scale クラスタに接続してハイブリッド モードで使用するかを選択します。

詳しくは以下をご覧ください。

- IBM Spectrum Scale が Google Cloud で利用可能に

- Sycomp Storage Fueled by IBM Spectrum Scale on Google Cloud

- Cloud Marketplace の Sycomp Storage Fueled by IBM Spectrum Scale

寄稿者

著者: Sean Derrington | グループ アウトバウンド プロダクト マネージャー、ストレージ

その他の関係者:

- Dean Hildebrand | CTO オフィス テクニカル ディレクター

- クロス プロダクト ソリューション デベロッパー Kumar Dhanagopal