Este artigo faz parte de uma série sobre a recuperação de desastres (DR) no Google Cloud. Nesta parte, abordamos o processo para arquitetar cargas de trabalho usando Google Cloud e a criação de elementos básicos resistentes a falhas na infraestrutura em nuvem.

A série contém estas partes:

- Guia de planejamento de recuperação de desastres

- Elementos básicos da recuperação de desastres

- Cenários de recuperação de desastres para dados

- Cenários de recuperação de desastres para aplicativos

- Como arquitetar a recuperação de desastres para cargas de trabalho com restrição de localidade

- Casos de uso da recuperação de desastres: aplicativos de análise de dados com restrição de localidade

- Como arquitetar a recuperação de desastres para interrupções de infraestrutura em nuvem (este documento)

Introdução

À medida que as cargas de trabalho são movidas para a nuvem pública, elas precisam traduzir o conhecimento da construção de sistemas resilientes locais para a infraestrutura de hiperescala de provedores de nuvem como o Google Cloud. Neste artigo, você conhecerá os conceitos padrão do setor sobre recuperação de desastres, como o objetivo de tempo de recuperação (RTO, na sigla em inglês) e o objetivo de ponto de recuperação (RPO, na sigla em inglês) da infraestrutura Google Cloud.

Neste documento, seguimos um dos princípios fundamentais do Google para alcançar uma disponibilidade de serviço extremamente alta: planejamento para a falha. Embora oGoogle Cloud ofereça serviços extremamente confiáveis, os desastres acontecem (desastres naturais, cortes de fibra e falhas imprevisíveis de infraestrutura) e causam interrupções. Com o planejamento para interrupções, os clientes doGoogle Cloud criam aplicativos com desempenho previsível durante esses eventos inevitáveis, usando os produtos do Google Cloud com mecanismos de DR "integrados".

A recuperação de desastres é um tema amplo que abrange muito mais do que apenas falhas de infraestrutura, como bugs de software ou corrupção de dados, e você terá um plano completo. No entanto, neste artigo, nos concentramos em uma parte de um plano de DR geral: como projetar aplicativos resilientes a interrupções de infraestrutura em nuvem. Especificamente, neste artigo abordamos:

- A infraestrutura do Google Cloud , como os eventos de desastre se manifestam como interrupções doGoogle Cloud e como o Google Cloud é arquitetado para minimizar a frequência e o escopo das interrupções.

- um guia de planejamento de arquitetura que oferece um framework para categorizar e projetar aplicativos com base nos resultados de confiabilidade pretendidos;

- uma lista detalhada de produtos Google Cloud que oferecem recursos de DR integrados que você talvez queira usar no aplicativo.

Para mais detalhes sobre o planejamento geral de DR e o uso do Google Cloud como um componente na sua estratégia de DR local, consulte o guia de planejamento de recuperação de desastres. Além disso, mesmo que a alta disponibilidade seja um conceito estreitamente relacionado à recuperação de desastres, ela não é abordada neste artigo. Para mais detalhes sobre a arquitetura de alta disponibilidade, consulte o Well-Architected Framework.

Observação sobre a terminologia: neste artigo, nos referimos à disponibilidade ao discutirmos a capacidade de um produto ser acessado e usado de maneira significativa ao longo do tempo, enquanto a confiabilidade se refere a um conjunto de atributos, incluindo disponibilidade, mas também itens como durabilidade e exatidão.

Como o Google Cloud foi projetado para resiliência

Data centers do Google

Os data centers tradicionais dependem da maximização da disponibilidade de componentes individuais. Na nuvem, o escalonamento permite que operadores como o Google distribuam serviços em muitos componentes com tecnologias de virtualização e, portanto, excedem a confiabilidade tradicional dos componentes. Isso significa afastar a ideia de arquitetura de confiabilidade para longe dos muitos detalhes que antes preocupavam você. Em vez de se preocupar com os vários modos de falha dos componentes (como resfriamento e entrega de energia), é possível planejar no que diz respeito aos produtos do Google Cloud e as métricas de confiabilidade estabelecidas deles. Essas métricas refletem o risco de interrupção agregada de toda a infraestrutura. Isso permite que você se concentre muito mais no design, na implantação e nas operações de aplicativos, em vez de gerenciamento de infraestrutura.

O Google projeta a infraestrutura para atender às metas de disponibilidade agressivas, com base na nossa extensa experiência na criação e execução de data centers modernos. O Google é líder mundial no design de data centers. De energia a resfriamento e redes, cada tecnologia de data center tem redundâncias e mitigações próprias, incluindo planos de FMEA. Os data centers do Google são criados de forma a equilibrar esses riscos diferentes e oferecer aos clientes um nível esperado consistente de disponibilidade para os produtos Google Cloud . O Google usa a própria experiência para modelar a disponibilidade da arquitetura geral do sistema físico e lógico. Isso garante que o design do data center atenda às expectativas. Os engenheiros do Google fazem grandes esforços do ponto de vista operacional para ajudar a garantir que essas expectativas sejam atendidas. A disponibilidade real medida normalmente excede nossas metas de design com bastante margem.

Ao refinar todos esses riscos e mitigações dos data centers em produtos voltados para o usuário,o Google Cloud livra você dessas responsabilidades operacionais e relacionadas ao projeto. Em vez disso, você se concentra na confiabilidade projetada nas regiões e zonas doGoogle Cloud .

Regiões e zonas

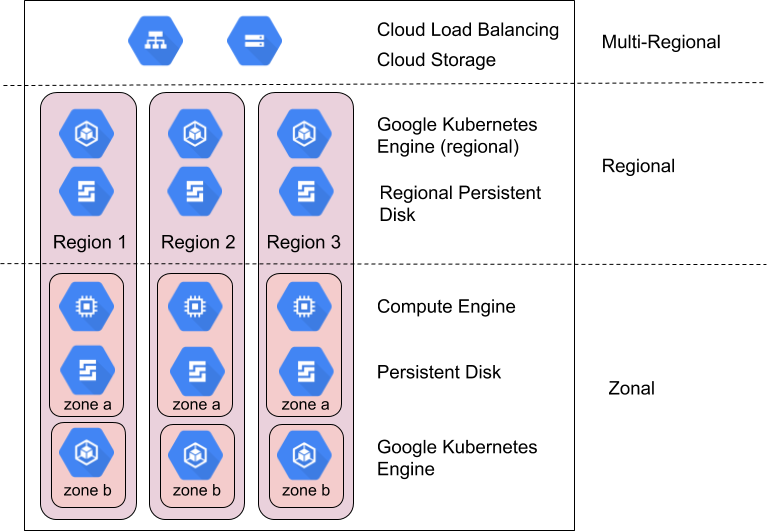

Regiões são áreas geográficas independentes que consistem em zonas. Zonas e regiões são abstrações lógicas de recursos físicos subjacentes. Para mais informações sobre considerações específicas de cada região, consulte Geografia e regiões.

Os produtos doGoogle Cloud são divididos em recursos zonais, regionais ou multirregionais.

Os recursos zonais estão hospedados em uma única zona. Uma interrupção de serviço nessa zona pode afetar todos os recursos nela. Por exemplo, uma instância do Compute Engine é executada em uma zona única especificada. Se uma falha de hardware interrompe o serviço nessa zona, essa instância do Compute Engine fica indisponível durante a interrupção.

Os recursos regionais são implantados de maneira redundante em várias zonas em uma região. Isso proporciona mais confiabilidade em relação aos recursos de zona.

Os recursos multirregionais são distribuídos nas regiões e entre elas. Em geral, os recursos multirregionais têm maior confiabilidade do que os regionais. No entanto, nesse nível, os produtos precisam otimizar a disponibilidade, o desempenho e a eficiência dos recursos. Como resultado, é importante entender as vantagens e desvantagens de cada produto multirregional que você decide usar. Elas são documentadas com base em produtos específicos mais adiante neste documento.

Como aproveitar as zonas e regiões para aumentar a confiabilidade

Os SREs do Google gerenciam e escalonam produtos de usuários globais altamente confiáveis, como o Gmail e a Pesquisa, usando uma variedade de técnicas e tecnologias que aproveitam a infraestrutura de computação no mundo todo. Isso inclui redirecionar o tráfego para fora dos locais indisponíveis usando o balanceamento de carga global, executar várias réplicas em muitos locais ao redor do planeta e replicar dados entre os locais. Esses mesmos recursos estão disponíveis para Google Cloud em produtos como o Cloud Load Balancing, o Google Kubernetes Engine (GKE) e o Spanner.

Google Cloud geralmente projeta produtos para oferecer os seguintes níveis de disponibilidade para zonas e regiões:

| Recurso | Exemplos | Meta de design de disponibilidade | Inatividade implícita |

|---|---|---|---|

| Zonal | Disco permanente, Compute Engine | 99,9% | 8,75 horas/ano |

| Regional | Cloud Storage regional, disco permanente replicado, GKE regional | 99,99% | 52 minutos/ano |

Compare as metas de design de disponibilidade do Google Cloud com seu nível de inatividade aceitável para identificar os recursos adequados do Google Cloud . Mesmo que os designs tradicionais se concentrem na melhoria da disponibilidade no nível do componente para melhorar a disponibilidade do aplicativo resultante, os modelos na nuvem se concentram na composição dos componentes para atingir essa meta. Muitos produtos no Google Cloud usam essa técnica. Por exemplo, o Spanner oferece um banco de dados multirregional que compõe várias regiões para fornecer disponibilidade de 99,999%.

A composição é importante porque, sem ela, a disponibilidade do aplicativo não pode exceder a dos produtos Google Cloud que você usa. Na verdade, a menos que seu aplicativo nunca falhe, ele terá uma disponibilidade menor que os produtosGoogle Cloud subjacentes. No restante desta seção, você geralmente verá como é possível usar uma composição de produtos regionais e zonais para alcançar maior disponibilidade de aplicativos do que uma única zona ou região proporcionaria. Na próxima seção, você verá um guia prático sobre como aplicar esses princípios aos aplicativos.

Como planejar os escopos de interrupção de zona

As falhas de infraestrutura geralmente causam interrupções de serviço em uma única zona. Em uma região, as zonas foram projetadas para minimizar o risco de falhas correlacionadas com outras zonas. Uma interrupção de serviço em uma zona geralmente não afeta o serviço de outra zona na mesma região. Uma interrupção no escopo de uma zona não significa necessariamente que a zona inteira está indisponível. Ela apenas define o limite do incidente. É possível que uma interrupção de zona não tenha efeito tangível sobre recursos específicos nessa zona.

É uma ocorrência rara, mas também é essencial observar que várias zonas ainda sofrem uma interrupção correlacionada em algum momento de uma única região. Quando duas ou mais zonas sofrem uma interrupção, a estratégia de escopo de interrupção regional abaixo é aplicada.

Os recursos regionais foram desenvolvidos para ser resistentes a interrupções de zona, entregando o serviço com base em uma composição de várias zonas. Se uma das zonas que fazem o backup de um recurso regional for interrompida, o recurso ficará automaticamente disponível em outra zona. Verifique com atenção a descrição da capacidade do produto no apêndice para mais detalhes.

OGoogle Cloud oferece apenas alguns recursos por zona, como máquinas virtuais (VMs) do Compute Engine e um Persistent Disk. Se você planeja usar recursos zonais, precisará executar sua própria composição de recursos projetando, criando e testando o failover e a recuperação entre recursos zonais localizados em várias zonas. Algumas estratégias incluem:

- rotear seu tráfego rapidamente para máquinas virtuais em outra zona usando o Cloud Load Balancing quando uma verificação de integridade determinar que uma zona está enfrentando problemas;

- usar modelos de instância do Compute Engine e/ou grupos de instâncias gerenciadas para executar e escalonar instâncias de VM idênticas em várias zonas;

- usar um disco permanente regional para replicar dados de maneira síncrona em outra zona de uma região. Para mais detalhes, veja Opções de alta disponibilidade usando DPs regionais.

Como planejar os escopos de interrupção regionais

Uma interrupção regional é uma interrupção do serviço que afeta mais de uma zona em uma única região. Essas tarefas são maiores, interrupções com menos frequência e podem ser causadas por desastres naturais ou falhas de infraestrutura em larga escala.

Para um produto regional projetado para fornecer 99,99% de disponibilidade, uma interrupção ainda pode ser convertida a quase uma hora de inatividade para um produto específico a cada ano. Portanto, os aplicativos essenciais podem precisar ter um plano de DR de várias regiões em vigor se essa duração de interrupção for inaceitável.

Os recursos multirregional são projetados para serem resistentes a interrupções da região, fornecendo serviços de várias regiões. Conforme descrito acima, produtos multirregionais oferecem o equilíbrio entre latência, consistência e custo. A compensação mais comum é entre a replicação de dados síncrona e assíncrona. A replicação assíncrona oferece menor latência ao custo do risco de perda de dados durante uma interrupção. Por isso, é importante verificar a descrição da capacidade do produto no apêndice para mais detalhes.

Se você quiser usar regional e permanecer resilientes às interrupções regionais, é preciso executar a própria composição de recursos projetando, criando e testando o failover e recuperação entre recursos regionais localizados em várias regiões. Além das estratégias por zona acima, que também podem ser aplicadas em várias regiões, considere:

- Os recursos regionais precisam replicar os dados para uma região secundária, para uma opção de Multi-Regional Storage, como o Cloud Storage, ou uma opção de nuvem híbrida, como o GKE Enterprise.

- Depois de realizar uma mitigação de interrupção regional, teste-a regularmente. Há poucas coisas piores do que imaginar que você está resistente a uma interrupção de região única e descobrir que esse não é o caso no momento.

Abordagem de resiliência e disponibilidade doGoogle Cloud

Google Cloud supera regularmente as metas de design de disponibilidade, mas não presuma que esse desempenho é a disponibilidade mínima para a qual é possível projetar. Em vez disso, selecione dependências do Google Cloud com destinos projetados para a confiabilidade pretendida do seu aplicativo. Assim, o tempo de inatividade do aplicativo mais o tempo de inatividade do Google Cloud fornecerá o resultado que você procura.

Um sistema bem projetado pode responder à pergunta: "O que acontece quando uma zona ou região tem uma interrupção de 1, 5, 10 ou 30 minutos?" Isso precisa ser considerado em muitas camadas, incluindo:

- O que meus clientes enfrentarão durante uma interrupção?

- Como detectarei uma interrupção?

- O que acontece com meu aplicativo durante uma interrupção?

- O que acontece com meus dados durante uma interrupção?

- O que acontece com meus outros aplicativos devido a uma interrupção (devido a dependências cruzadas)?

- O que preciso fazer para recuperar um problema depois que uma interrupção é resolvida? Quem faz isso?

- Quem preciso enviar notificações sobre uma interrupção e em que período?

Guia passo a passo para projetar a recuperação de desastres para aplicativos em Google Cloud

Nas seções anteriores, abordamos como o Google desenvolve a infraestrutura em nuvem, assim como algumas abordagens para lidar com interrupções zonais e regionais.

Nesta seção, você aprende a desenvolver um framework para aplicar o princípio da composição aos seus aplicativos com base nos resultados de confiabilidade pretendidos.

Os aplicativos do cliente em Google Cloud que visam objetivos de recuperação de desastres, como RTO e RPO, precisam ser projetados para que as operações críticas para os negócios, sujeitas a RTO/RPO, tenham dependências apenas em componentes do plano de dados responsáveis pelo processamento contínuo de operações para o serviço. Em outras palavras, essas operações críticas para o cliente não podem depender das operações do plano de gerenciamento, que gerenciam o estado da configuração e a configuração de push para o plano de controle e o plano de dados.

Por exemplo,os clientes do Google Cloud que pretendem alcançar o RTO para operações essenciais para os negócios não devem depender de uma API de criação de VMs ou da atualização de uma permissão do IAM.

Etapa 1: coletar os requisitos atuais

A primeira etapa é definir os requisitos de disponibilidade para seus aplicativos. Neste momento, a maioria das empresas já tem algum nível de orientação de design, que pode ser desenvolvido internamente ou derivado de regulamentos ou outros requisitos legais. Essa orientação de design geralmente é codificada em duas métricas principais: objetivo de tempo de recuperação (RTO, na sigla em inglês) e objetivo de ponto de recuperação (RPO, na sigla em inglês). Em termos de negócios, o RTO se traduz como "Em quanto tempo depois de um desastre estarei pronto para começar a trabalhar". O RPO se traduz como "Quantos dados posso perder no caso de um desastre".

Antes, as empresas definiram os requisitos de RTO e de RPO para uma ampla variedade de eventos de desastre, de falhas de componentes a terremotos. Isso fazia sentido no mundo local, onde os planejadores precisavam mapear os requisitos de RTO/RPO por todo o software e a pilha de hardware. Na nuvem, você não precisa mais definir seus requisitos com esses detalhes, porque o provedor cuida disso. Em vez disso, é possível definir os requisitos de RTO e RPO em termos de escopo de perda (zonas ou regiões inteiras) sem ser específico sobre os motivos subjacentes. Para Google Cloud isso simplifica a coleta de requisitos em três cenários: uma interrupção de zona, uma interrupção regional ou a interrupção improvável de várias regiões.

Reconhecendo que nem todos os aplicativos têm a mesma criticalidade, a maioria dos clientes categoriza os aplicativos em níveis de gravidade nos quais um requisito de RTO/RPO específico pode ser aplicado. Quando reunidos, o RTO/RPO e a criticidade do aplicativo simplificam o processo de arquitetar um determinado aplicativo respondendo:

- O aplicativo precisa ser executado em várias zonas na mesma região ou em várias zonas em várias regiões?

- O aplicativo do Google Cloud pode depender de quais produtos?

Este é um exemplo de saída do exercício de coleta de requisitos:

RTO e RPO da Importância do aplicativo para exemplo de organização:

| Importância do aplicativo | % de Apps | Aplicativos de exemplo | Interrupção de zona | Interrupção da região |

|---|---|---|---|---|

| Nível 1

(mais importante) |

5% | Geralmente aplicativos globais ou externos voltados para o cliente, como pagamentos em tempo real e vitrines de comércio eletrônico. | RTO Zero

RPO Zero |

RTO Zero

RPO Zero |

| Nível 2 | 35% | Normalmente, aplicativos regionais ou aplicativos internos importantes, como CRM ou ERP. | RTO de 15 min

RPO de 15 minutos |

RTO de 1 hora

RPO de 1 hora |

| Nível 3

(menos importante) |

60% | Normalmente os aplicativos para equipes ou departamentos, como back-office, reservas, viagens internas, contabilidade e RH. | RTO de 1 hora

RPO de 1 hora |

RTO 12h

RPO de 12 horas |

Etapa 2: mapeamento de recursos para produtos disponíveis

A segunda etapa é entender os recursos de resiliência dos produtos do Google Cloud que os aplicativos vão usar. A maioria das empresas revisa as informações de produtos relevantes e adiciona orientações sobre como modificar as arquiteturas para acomodar lacunas entre os recursos do produto e os requisitos de resiliência. Nesta seção, abordamos algumas áreas comuns e recomendações sobre limitações de dados e aplicativos neste espaço.

Como mencionado anteriormente, os produtos ativados para DR do Google atendem a dois tipos de escopos de interrupção: regional e zonal. Interrupções parciais precisam ser planejadas da mesma forma que uma interrupção total quando se trata de DR. Isso fornece uma matriz inicial de alto nível de quais produtos são adequados para cada cenário por padrão:

Google Cloud Recursos gerais do produto

(consulte o Apêndice para saber mais sobre recursos específicos do produto)

| Todos os produtos Google Cloud | Produtos regionais do Google Cloud com replicação automática entre zonas | Produtos multirregionais ou globais Google Cloud com replicação automática em todas as regiões | |

|---|---|---|---|

| Falha de um componente dentro de uma zona | Coberto* | Coberto | Coberto |

| Interrupção de zona | Não coberto | Coberto | Coberto |

| Interrupção da região | Não coberto | Não coberto | Coberto |

* Todos os produtos do Google Cloud Google Cloud são resilientes a falhas de componentes, exceto nos casos específicos indicados na documentação do produto. Normalmente, são cenários em que o produto oferece acesso direto ou mapeamento estático a uma parte do hardware de especialização, como memória ou discos de estado sólido (SSD).

Como o RPO limita as opções de produtos

Na maioria das implantações na nuvem, a integridade dos dados é o aspecto com arquitetura mais significativa a ser considerado para um serviço. Pelo menos alguns aplicativos têm um requisito de RPO de zero, o que significa que não haverá perda de dados no caso de uma interrupção. Isso normalmente exige que os dados sejam replicados de maneira síncrona para outra zona ou região. A replicação síncrona tem vantagens e desvantagens relacionadas ao custo e à latência. Portanto, mesmo que muitos produtos do Google Cloud forneçam replicação síncrona em todas as zonas, apenas algumas oferecem regiões diferentes. Isso significa que não é incomum que diferentes tipos de dados dentro de um aplicativo tenham valores de RPO distintos.

Para dados com um RPO maior que zero, os aplicativos podem aproveitar a replicação assíncrona. A replicação assíncrona é aceitável quando dados perdidos podem ser recriados facilmente ou podem ser recuperados em uma fonte dourada de dados, se necessário. Também pode ser uma escolha sensata quando uma pequena quantidade de perda de dados é aceitável no contexto de durações esperadas de interrupção regional e por zona. Também é importante ressaltar que, durante uma interrupção temporária, os dados gravados no local afetado, mas que ainda não foram replicados para outro local, geralmente ficam disponíveis após a resolução. Isso significa que o risco de perda permanente é menor que o risco de perder o acesso a dados durante uma interrupção.

Principais ações: estabeleça se você realmente precisa de RPO zero e, em caso positivo, se é possível fazer isso para um subconjunto de dados. Isso aumenta drasticamente o intervalo de serviços ativados para DR disponíveis com você. No Google Cloud, conseguir o RPO zero significa usar produtos predominantemente regionais para seu aplicativo, que, por padrão, são resilientes a interrupções escalonadas por zona, mas não por região.

Como a RTO limita as opções de produtos

Um dos principais benefícios da computação em nuvem é a capacidade de implantar a infraestrutura sob demanda. No entanto, isso não é o mesmo que a implantação instantânea. O valor de RTO do seu aplicativo precisa acomodar o RTO combinado dos produtos do Google Cloud que seu aplicativo usa e todas as ações que seus engenheiros ou SREs precisam executar para reiniciar as VMs ou os componentes do aplicativo. Uma RTO medida em minutos significa projetar um aplicativo que se recupera automaticamente de um desastre sem intervenção humana ou com etapas mínimas, como o envio de um botão para failover. Historicamente, o custo e a complexidade desse tipo de sistema têm sido muito altos, mas os produtos do Google Cloud como balanceadores de carga e grupos de instâncias tornam esse design muito mais acessível e simples. Portanto, considere o failover e a recuperação automatizados para a maioria dos aplicativos. Esteja ciente de que projetar um sistema para esse tipo de failover quente entre regiões é complicado e caro. Apenas uma pequena fração de serviços críticos garante esse recurso.

A maioria dos aplicativos terá uma RTO entre uma hora e um dia, o que permite um failover morno em um cenário de desastre, com alguns componentes do aplicativo sendo executados o tempo todo em um modo de espera, como bancos de dados, enquanto outros são escalonados no caso de um desastre real, como servidores da Web. Para esses aplicativos, considere a automação para os eventos de escalonamento horizontal. Serviços com um RTO ao longo de um dia são os mais críticos e geralmente podem ser recuperados do backup ou recriados do zero.

Principais ações: defina se você precisa de um RTO de (quase) zero para failover regional e, em caso afirmativo, se pode fazer isso para um subconjunto de serviços. Isso muda o custo de execução e manutenção do serviço.

Etapa 3: desenvolver suas próprias arquiteturas e guias de referência

A etapa final recomendada é criar os próprios padrões de arquitetura específicos da empresa para ajudar as equipes a padronizar a abordagem de recuperação de desastres. A maioria dos clientes do Google Cloud produz um guia para as equipes de desenvolvimento correspondentes às expectativas individuais de resiliência de negócios com as duas principais categorias de cenários de interrupção no Google Cloud. Dessa forma, as equipes podem categorizar facilmente quais produtos ativados para DR são adequados para cada nível de crítica.

Criar diretrizes de produtos

Voltando à tabela de exemplo do RTO/RPO acima, você tem um guia hipotético que lista quais produtos seriam permitidos por padrão para cada nível de crítica. Observe que quando determinados produtos são identificados como não adequados por padrão, sempre é possível adicionar seus próprios mecanismos de replicação e failover para ativar a sincronização entre zonas ou regiões, mas este exercício é diferente do escopo deste artigo. As tabelas também incluem links para mais informações sobre cada produto para ajudar você a entender os recursos em relação ao gerenciamento de interrupções de zona ou região.

Padrões de arquitetura de amostra para uma organização de exemplo - Resiliência de interrupção da zona

| Google Cloud Produto | O produto atende aos requisitos de interrupção de zona para a organização de exemplo com a configuração correta? | ||

|---|---|---|---|

| Nível 1 | Nível 2 | Nível 3 | |

| Compute Engine | Não | Não | Não |

| Dataflow | Não | Não | Não |

| BigQuery | Não | Não | Sim |

| GKE | Sim | Sim | Sim |

| Cloud Storage | Sim | Sim | Sim |

| Cloud SQL | Não | Sim | Sim |

| Spanner | Sim | Sim | Sim |

| Cloud Load Balancing | Sim | Sim | Sim |

Esta tabela é um exemplo baseado apenas nas camadas hipotéticas mostradas acima.

Padrões de arquitetura de amostra para uma organização de exemplo - Resiliência de interrupção de região

| Google Cloud Produto | O produto atende aos requisitos de interrupção de região para a organização de exemplo (com configuração de produto apropriada) | ||

|---|---|---|---|

| Nível 1 | Nível 2 | Nível 3 | |

| Compute Engine | Sim | Sim | Sim |

| Dataflow | Não | Não | Não |

| BigQuery | Não | Não | Sim |

| GKE | Sim | Sim | Sim |

| Cloud Storage | Não | Não | Não |

| Cloud SQL | Não | Sim | Sim |

| Spanner | Sim | Sim | Sim |

| Cloud Load Balancing | Sim | Sim | Sim |

Esta tabela é um exemplo baseado apenas nas camadas hipotéticas mostradas acima.

Para mostrar como esses produtos serão usados, as seções a seguir abordam algumas arquiteturas de referência para cada um dos níveis de criticidade do aplicativo. Essas descrições de nível superior deliberadamente representam as principais decisões de arquitetura e não representam um design de solução completo.

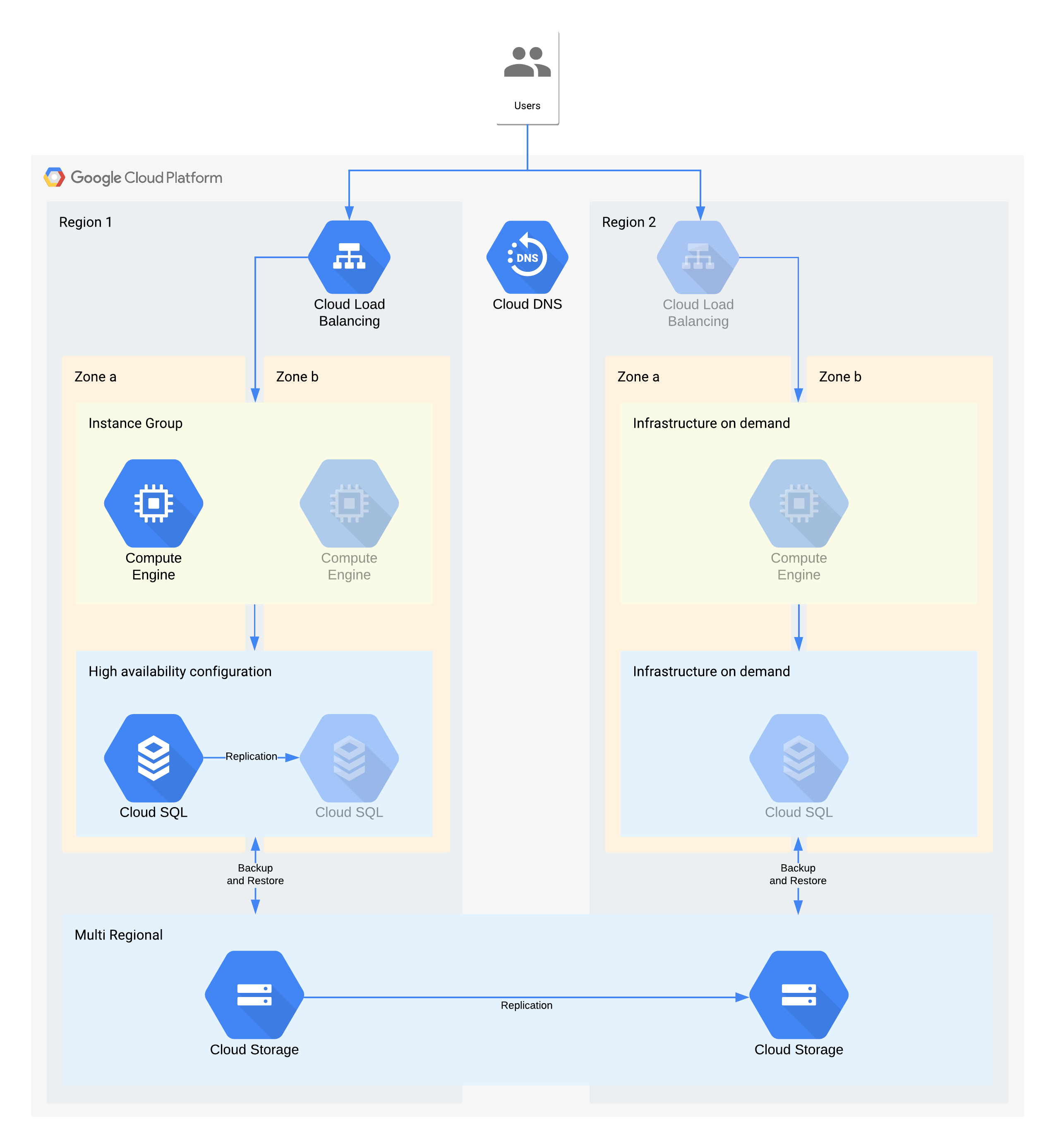

Exemplo de arquitetura de nível 3

| Importância do aplicativo | Interrupção de zona | Interrupção da região |

|---|---|---|

| Camada 3 (menos importante) |

RTO 12 horas RPO 24 horas |

RTO 28 dias RPO 24 horas |

Os ícones esmaecidos indicam a infraestrutura que será ativada para recuperação.

Nesta arquitetura, descrevemos um aplicativo cliente/servidor tradicional: os usuários internos se conectam a um aplicativo em execução em uma instância de computação, apoiada por um banco de dados para armazenamento permanente.

É importante observar que essa arquitetura aceita valores melhores de RTO e RPO do que o necessário. No entanto, você também precisa eliminar etapas manuais extras quando elas são caras ou pouco confiáveis. Por exemplo, recuperar um banco de dados de um backup noturno poderia ser compatível com o RPO de 24 horas, mas isso geralmente precisa de um especialista, como um administrador de banco de dados que pode não estar disponível, especialmente se vários serviços fossem afetados ao mesmo tempo. Com a infraestrutura sob demanda do Google Cloud, é possível criar essa capacidade sem comprometer significativamente os custos. Assim, essa arquitetura usa a HA do Cloud SQL em vez de um backup/restauração manual para interrupções zonais.

Principais decisões arquitetônicas para interrupção da zona - RTO de 12h e RPO de 24h:

- Um balanceador de carga interno é usado para fornecer um ponto de acesso escalonável para os usuários, o que permite o failover automático para outra zona. Mesmo que o RTO seja de 12 horas, alterações manuais em endereços IP ou até mesmo atualizações de DNS podem demorar mais que o esperado.

- Um grupo gerenciado de instâncias por região é configurado com várias zonas, mas poucos recursos. Isso otimiza os custos, mas ainda permite que as máquinas virtuais sejam escalonadas rapidamente na zona de backup.

- Uma configuração de alta disponibilidade do Cloud SQL oferece failover automático a outra zona. Os bancos de dados são significativamente mais difíceis de recriar e restaurar em comparação com as máquinas virtuais do Compute Engine.

Principais decisões arquitetônicas para interrupção da região: RTO de 28 dias e RPO de 24 horas:

- Um balanceador de carga seria construído na região 2 apenas em caso de interrupção regional. O Cloud DNS é usado para fornecer um recurso de failover regional orquestrado, mas manual, uma vez que a infraestrutura na região 2 só seria disponibilizada no caso de uma interrupção da região.

- Um novo grupo gerenciado de instâncias seria construído somente no caso de interrupção da região. Isso otimiza os custos e é improvável que sejam invocados de acordo com o curto período da maioria das interrupções regionais. Para simplificar, o diagrama não mostra as ferramentas associadas necessárias para reimplantar ou a cópia das imagens do Compute Engine necessárias.

- Uma nova instância do Cloud SQL é recriada e os dados são restaurados de um backup. Novamente, o risco de uma interrupção prolongada em uma região é extremamente baixo, então essa é outra troca de otimização de custos.

- O Cloud Storage multirregional é usado para armazenar esses backups. Isso proporciona resiliência automática de zona e região no RTO e RPO.

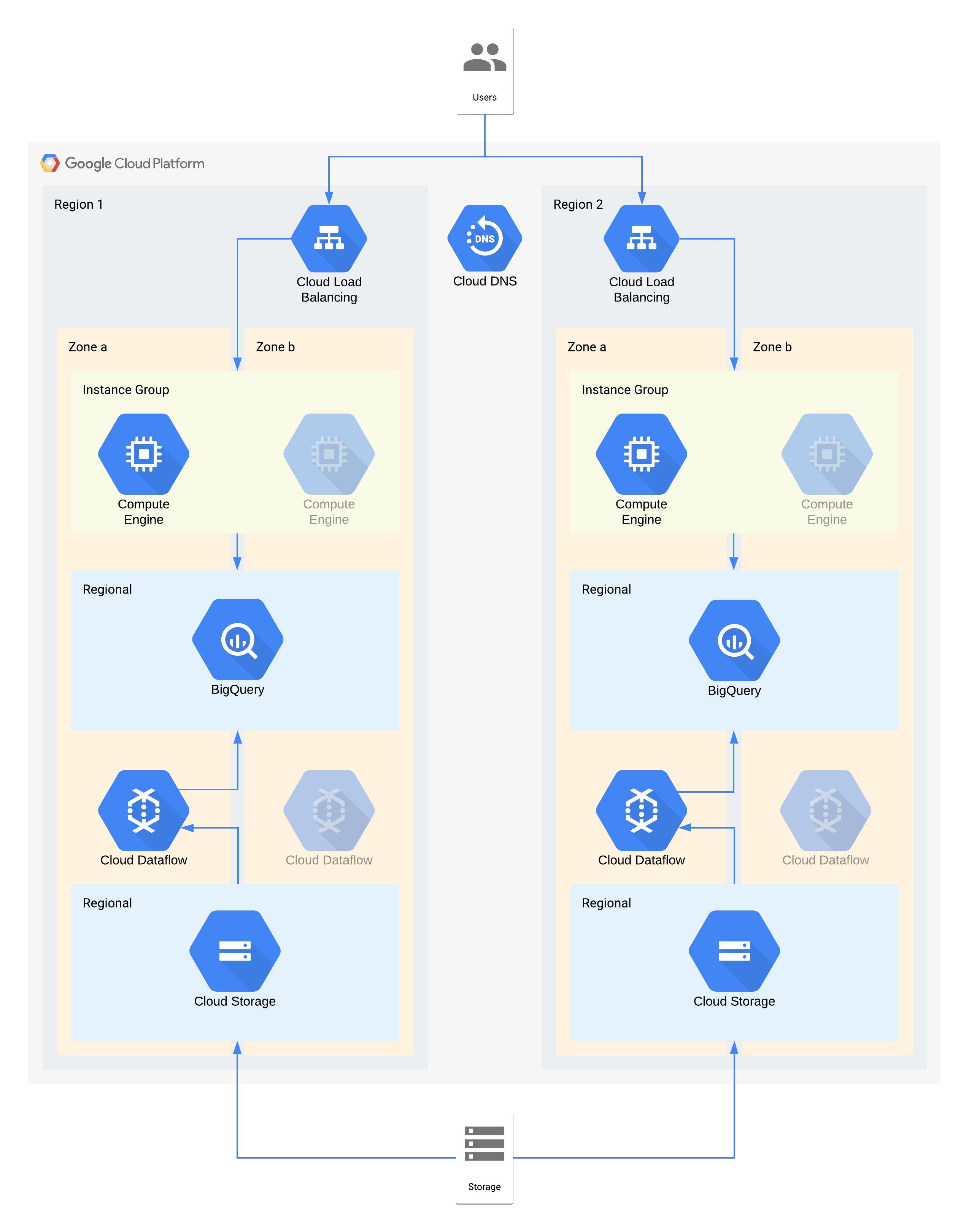

Exemplo de arquitetura de nível 2

| Importância do aplicativo | Interrupção de zona | Interrupção da região |

|---|---|---|

| Nível 2 | RTO 4 horas RPO zero |

RTO 24 horas RPO 4 horas |

Nesta arquitetura, descrevemos um armazenamento de dados com usuários internos que se conectam a uma camada de visualização da instância do Compute e uma camada de ingestão e transformação de dados que preenche o armazenamento de dados de back-end.

Alguns componentes individuais dessa arquitetura não são diretamente compatíveis com o RPO necessário para a respectiva camada. No entanto, por serem usados em conjunto, o serviço geral atende ao RPO. Nesse caso, como o Dataflow é um produto zonal, siga as recomendações para design de alta disponibilidade a fim de evitar a perda de dados durante uma interrupção. No entanto, a camada do Cloud Storage é a fonte dourada desses dados e é compatível com um RPO de zero. Como resultado, é possível ingerir novamente todos os dados perdidos no BigQuery usando a zona b em caso de uma interrupção na zona a.

Principais decisões arquitetônicas para interrupção da zona - RTO de 4h e RPO de zero:

- Um balanceador de carga é usado para fornecer um ponto de acesso escalonável para os usuários, o que permite o failover automático para outra zona. Mesmo que o RTO seja de quatro horas, as alterações manuais em endereços IP ou até mesmo as atualizações de DNS podem levar mais tempo do que o esperado.

- Um grupo gerenciado de instâncias regional para a camada de computação de visualização de dados é configurado com várias zonas, mas recursos mínimos. Isso otimiza os custos, mas ainda permite que as máquinas virtuais sejam escalonadas rapidamente.

- O Cloud Storage regional é usado como uma camada de preparação para a ingestão inicial de dados, proporcionando resiliência automática de zonas.

- O Dataflow é usado para extrair dados do Cloud Storage e transformá-los antes de carregá-los no BigQuery. No caso de uma interrupção da zona, esse é um processo sem estado que pode ser reiniciado em outra zona.

- O BigQuery disponibiliza o back-end do data warehouse para o front-end de visualização de dados. No caso de uma interrupção da zona, os dados perdidos serão reprocessados no Cloud Storage.

Principais decisões arquitetônicas para interrupção da região: RTO de 24h e RPO de 4h :

- Um balanceador de carga em cada região é usado para fornecer um ponto de acesso escalonável para os usuários. O Cloud DNS é usado para fornecer um recurso de failover regional orquestrado, mas manual, uma vez que a infraestrutura na região 2 só seria disponibilizada no caso de uma interrupção da região.

- Um grupo gerenciado de instâncias regional para a camada de computação de visualização de dados é configurado com várias zonas, mas recursos mínimos. Isso não será acessível até que o balanceador de carga seja reconfigurado, mas não requer intervenção manual caso contrário.

- O Cloud Storage regional é usado como uma camada de preparação para a ingestão inicial de dados. Ele está sendo carregado ao mesmo tempo nas duas regiões para atender aos requisitos do RPO.

- O Dataflow é usado para extrair dados do Cloud Storage e transformá-los antes de carregá-los no BigQuery. No caso de uma interrupção da região, isso preencheria o BigQuery com os dados mais recentes do Cloud Storage.

- O BigQuery fornece o back-end do data warehouse. Em operações normais, isso seria atualizado de maneira intermitente. No caso de interrupção da região, os dados mais recentes serão reprocessados pelo Dataflow do Cloud Storage.

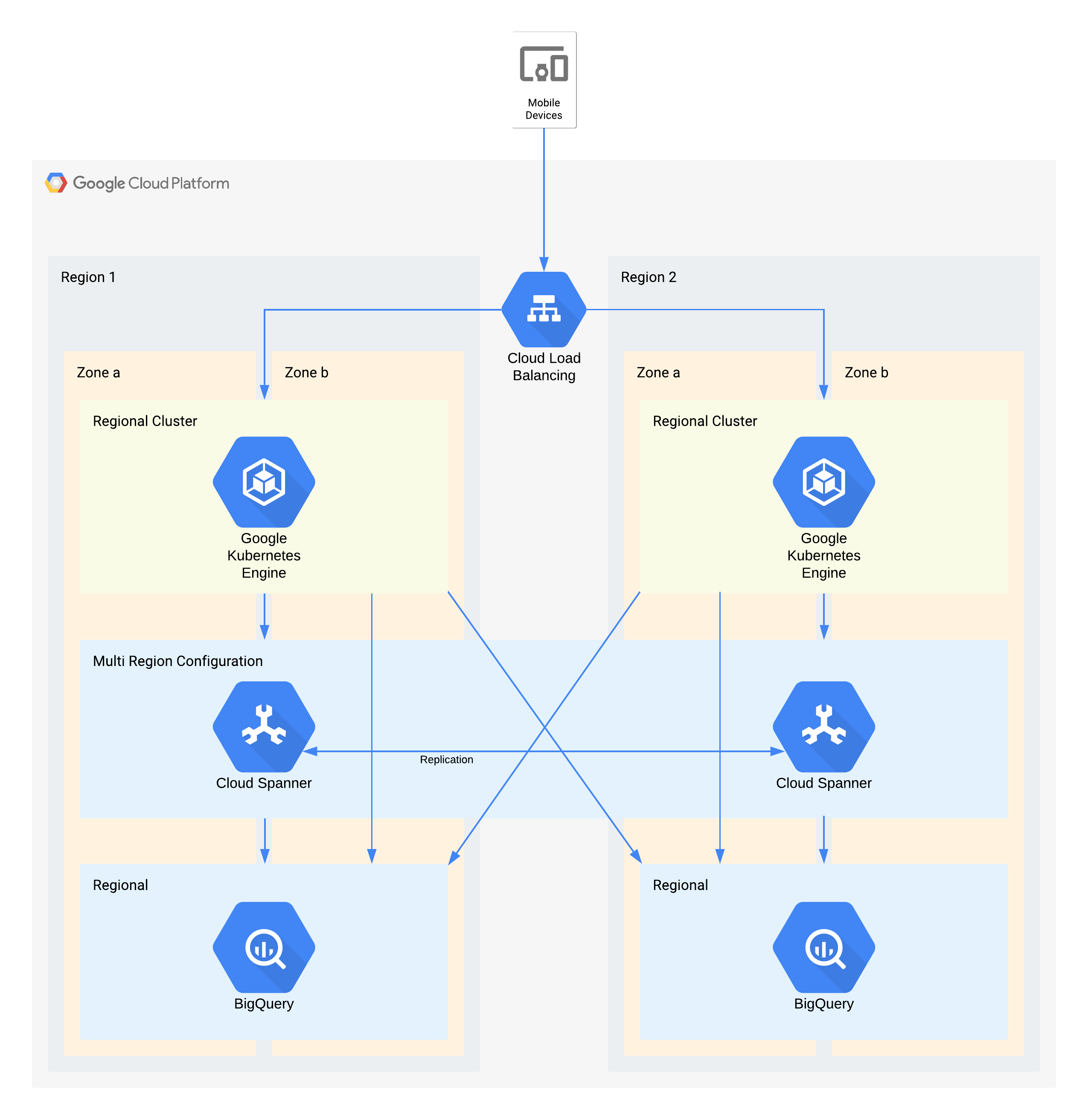

Exemplo de arquitetura de nível 1

| Importância do aplicativo | Interrupção de zona | Interrupção da região |

|---|---|---|

| Camada 1 (mais importante) |

RTO zero RPO zero |

RTO 4 horas RPO 1 hora |

Nesta arquitetura, descrevemos uma infraestrutura de back-end de aplicativo para dispositivos móveis com usuários externos que se conectam a um conjunto de microsserviços em execução no GKE. O Spanner fornece a camada de armazenamento de dados de back-end para dados em tempo real, e os dados históricos são transmitidos para um data lake do BigQuery em cada região.

Novamente, alguns componentes individuais dessa arquitetura não são diretamente compatíveis com o RPO necessário para o nível. No entanto, por serem usados juntos, o serviço geral atende ao RPO. Nesse caso, o BigQuery é usado para consultas analíticas. As regiões são alimentadas simultaneamente pelo Spanner.

Principais decisões de arquitetura para interrupção da zona, RTO de zero e RPO de zero:

- Um balanceador de carga é usado para fornecer um ponto de acesso escalonável para os usuários, o que permite o failover automático para outra zona.

- Um cluster regional do GKE é usado na camada do aplicativo configurada com várias zonas. Isso realiza o RTO de zero em cada região.

- O Spanner multirregional é usado como uma camada de persistência de dados, fornecendo resiliência de dados de zona automática e consistência de transação.

- O BigQuery oferece o recurso de análise para o aplicativo. Cada região recebe dados do Spanner e é acessada de maneira independente pelo aplicativo.

Principais decisões de arquitetura para interrupção da região: RTO de quatro horas e RPO de uma hora:

- Um balanceador de carga é usado para fornecer um ponto de acesso escalonável para os usuários, o que permite o failover automático para outra região.

- Um cluster regional do GKE é usado na camada do aplicativo configurada com várias zonas. No caso de interrupção da região, o cluster na região alternativa é escalonado automaticamente para assumir a carga extra de processamento.

- O Spanner multirregional é usado como uma camada de persistência de dados, fornecendo resiliência de dados de região automática e consistência de transação. Esse é o componente principal para atingir o RPO entre regiões de uma hora.

- O BigQuery oferece o recurso de análise para o aplicativo. Cada região recebe dados do Spanner e é acessada de maneira independente pelo aplicativo. Essa arquitetura compensa o componente do BigQuery, permitindo que ela atenda aos requisitos gerais do aplicativo.

Apêndice: referência ao produto

Nesta seção, descrevemos os recursos de arquitetura e DR dos produtos do Google Cloud mais usados nos aplicativos dos clientes e que podem ser facilmente usados para atender aos requisitos de DR.

Temas comuns

Muitos produtos do Google Cloud oferecem configurações regionais ou multirregionais. Os produtos regionais são resilientes a falhas de zona, e os produtos multirregionais e globais são resilientes a interrupções regionais. Em geral, isso significa que, durante uma falha, seu aplicativo sofre o mínimo de interrupções. O Google alcança esses resultados com algumas abordagens arquitetônicas comuns que espelham a orientação arquitetônica acima.

Implantação redundante: os back-ends e armazenamento de dados do aplicativo são implantados em várias zonas em uma região e em várias regiões em um local multirregional. Para mais informações sobre considerações específicas de cada região, consulte Geografia e regiões.

Replicação de dados: os produtos usam replicação síncrona ou assíncrona nos locais redundantes.

A replicação síncrona significa que, quando seu aplicativo faz uma chamada de API para criar ou modificar dados armazenados pelo produto, ele recebe uma resposta bem-sucedida somente depois que o produto grava os dados em vários locais. A replicação síncrona garante que você não perca o acesso a nenhum dos seus dados durante uma interrupção da infraestrutura do Google Cloud , porque todos os dados estão disponíveis em um dos locais de back-end disponíveis.

Mesmo que essa técnica ofereça proteção máxima de dados, ela pode ter desvantagens em termos de latência e desempenho. Produtos de várias regiões que usam a replicação síncrona têm uma desvantagem muito maior: geralmente na ordem de dezenas ou centenas de milissegundos de latência extra.

Assíncrona replicação significa que, quando seu aplicativo faz uma chamada de API para criar ou modificar dados armazenados pelo produto, ele recebe uma resposta bem-sucedida depois que o produto grava os dados em um único local. Com a solicitação de gravação, o produto replica os dados para outros locais.

Essa técnica fornece menor latência e maior capacidade na API do que a replicação síncrona, mas à custa da proteção de dados. Se o local em que você gravou dados sofrer uma interrupção antes que a replicação seja concluída, você perderá o acesso a esses dados até que a interrupção seja resolvida.

Como lidar com interrupções com balanceamento de carga: Google Cloud usa o balanceamento de carga do software para encaminhar solicitações para os back-ends de aplicativos apropriados. Em comparação a outras abordagens, como o balanceamento de carga DNS, essa abordagem reduz o tempo de resposta do sistema para uma interrupção. Quando ocorre uma interrupção de localização do Google Cloud , o balanceador de carga detecta rapidamente que o back-end implantado nesse local ficou "não íntegro" e direciona todas as solicitações para um back-end em um local alternativo. Isso permite que o produto continue atendendo às solicitações do aplicativo durante uma interrupção de local. Quando a interrupção do local é resolvida, o balanceador de carga detecta a disponibilidade dos back-ends de produtos nesse local e retoma o envio do tráfego para esse local.

Access Context Manager

Com o Access Context Manager, as empresas podem configurar níveis de acesso que são mapeados para uma política definida nos atributos da solicitação. As políticas são espelhadas por região.

No caso de uma interrupção zonal, as solicitações para zonas indisponíveis são exibidas de maneira automática e transparente de outras zonas disponíveis na região.

No caso de interrupção regional, os cálculos de política da região afetada ficarão indisponíveis até que a região fique disponível novamente.

Transparência no acesso

A transparência no acesso permite que os administradores da organização Google Cloud definam um controle de acesso minucioso e baseado em atributos para projetos e recursos no Google Cloud. Ocasionalmente, o Google precisa acessar os dados dos clientes para fins administrativos. Quando acessamos os dados dos clientes, a transparência no acesso fornece registros de acesso para os clientes afetados do Google Cloud. Esses registros de transparência no acesso ajudam a garantir o compromisso do Google com a segurança e a transparência dos dados no tratamento de dados.

A Transparência no acesso é resiliente contra interrupções zonais e regionais. Se uma interrupção zonal ou regional ocorrer, a transparência no acesso continuará processando os registros de acesso administrativo em outra zona ou região.

AlloyDB para PostgreSQL

O AlloyDB para PostgreSQL é um serviço de banco de dados totalmente gerenciado e compatível com o PostgreSQL. Ele oferece alta disponibilidade em uma região por meio dos nós redundantes da instância primária que estão em duas zonas diferentes da região. A instância primária mantém a disponibilidade regional acionando um failover automático para a zona de espera quando a zona ativa encontra um problema. O armazenamento regional garante a durabilidade dos dados em caso de perda de uma única zona.

Como outro método de recuperação de desastres, o AlloyDB para PostgreSQL usa a replicação entre regiões a fim de fornecer recursos de recuperação de desastres replicando de maneira assíncrona os dados do cluster primário em clusters secundários que estão em regiões separadas do Google Cloud .

Interrupção zonal: durante a operação normal, apenas um dos dois nós de uma instância primária de alta disponibilidade está ativo e atende a todas as gravações de dados. Esse nó ativo armazena os dados na camada de armazenamento regional separada do cluster.

O AlloyDB para PostgreSQL detecta automaticamente falhas no nível da zona e aciona um failover para restaurar a disponibilidade do banco de dados. Durante o failover, o AlloyDB para PostgreSQL inicia o banco de dados no nó de espera, que já está provisionado em uma zona diferente. Novas conexões de banco de dados são encaminhadas automaticamente para essa zona.

Do ponto de vista de um aplicativo cliente, uma interrupção de zona se assemelha a uma interrupção temporária da conectividade de rede. Após a conclusão do failover, um cliente pode se reconectar à instância no mesmo endereço usando as mesmas credenciais, sem perda de dados.

Interrupção regional: a replicação entre regiões usa a replicação assíncrona, que permite que a instância primária confirme as transações antes de elas serem confirmadas em réplicas. A diferença de tempo entre o momento em que uma transação é confirmada na instância primária e o momento em que ela é confirmada na réplica é conhecida como atraso de replicação. A diferença de tempo entre o momento em que a instância primária gera o registro prévio de escrita (WAL) e o momento em que o WAL acessa a réplica é chamada de atraso de liberação. Os atrasos de replicação e de liberação dependem da configuração da instância do banco de dados e da carga de trabalho gerada pelo usuário.

No caso de uma interrupção regional, é possível promover clusters secundários em uma região diferente para se tornarem clusters primários graváveis e autônomos. Esse cluster promovido não replica mais os dados do cluster primário original ao qual foi associado anteriormente. Devido ao atraso de liberação, algumas perdas de dados podem ocorrer porque pode haver transações no cluster primário original que não foram propagadas para o cluster secundário.

O RPO de replicação entre regiões é afetado pela utilização da CPU do cluster primário e pela distância física entre a região do cluster primário e a região do cluster secundário. Para otimizar o RPO, recomendamos testar a carga de trabalho com uma configuração que inclua uma réplica a fim de estabelecer um limite seguro de transações por segundo (TPS), que é o TPS sustentado mais alto que não acumula atraso de liberação. Se a carga de trabalho exceder o limite seguro de TPS, o atraso de liberação se acumulará, o que poderá afetar o RPO. Para limitar o atraso de rede, escolha pares de regiões no mesmo continente.

Para mais informações sobre como monitorar o atraso de rede e outras métricas do AlloyDB para PostgreSQL, consulte Monitorar instâncias.

IA antilavagem de dinheiro

A IA antilavagem de dinheiro (AML AI) fornece uma API para ajudar instituições financeiras globais a detectar lavagem de dinheiro com mais eficiência. A IA antilavagem de dinheiro é uma oferta regional, o que significa que os clientes podem escolher a região, mas não as zonas que a compõem. A carga dos dados e do tráfego é balanceada automaticamente entre as zonas de uma região. As operações (por exemplo, para criar um pipeline ou executar uma previsão) são automaticamente escalonadas em segundo plano e têm a carga balanceada entre zonas, conforme necessário.

Interrupção zonal: a AML AI armazena dados para os recursos regionalmente e eles são replicados de maneira síncrona. Quando uma operação de longa duração termina com sucesso, é possível contar com os recursos, independentemente de falhas zonais. O processamento também é replicado entre as zonas, mas essa replicação tem como objetivo o balanceamento de carga e não a alta disponibilidade. Portanto, uma falha zonal durante uma operação pode resultar em uma falha na operação. Se isso acontecer, realize a operação novamente para resolver o problema. Durante uma interrupção de zona, os tempos de processamento podem ser afetados.

Interrupção regional: os clientes escolhem a região do Google Cloud em que querem criar os recursos da AML AI. Os dados jamais são replicados entre regiões. O tráfego do cliente nunca é roteado para uma região diferente pela AML AI. Em caso de falha regional, a AML AI volta a ficar disponível assim que a falha é resolvida.

Chaves de API

As chaves de API fornecem um gerenciamento de recursos de chave de API escalonável para um projeto. As chaves de API são um serviço global, o que significa que elas são visíveis e podem ser acessadas de qualquer local do Google Cloud . Os dados e metadados são armazenados de maneira redundante em várias zonas e regiões.

As chaves de API são resilientes a falhas temporárias zonais e regionais. No caso de interrupção zonal ou interrupção regional, as chaves de API continuam a atender solicitações de outra zona na mesma região ou em uma região diferente.

Para mais informações sobre chaves de API, consulte Visão geral da API de chaves de API.

Apigee

A Apigee fornece uma plataforma segura, escalonável e confiável para desenvolvimento e gerenciamento de APIs. A Apigee oferece implantações de região única e multirregional.

Interrupção zonal: os dados de ambiente de execução do cliente são replicados em várias zonas de disponibilidade. Portanto, uma interrupção de zona única não afeta a Apigee.

Interrupção regional: para instâncias da Apigee de região única, se uma região ficar inativa, as instâncias da Apigee não estarão disponíveis nessa região e não poderão ser restauradas em regiões diferentes. Para instâncias multirregionais da Apigee, os dados são replicados de maneira assíncrona em todas as regiões. Portanto, a falha de uma região não reduz completamente o tráfego. No entanto, talvez não seja possível acessar dados não comprometidos na região com falha. É possível desviar o tráfego de regiões não íntegras. Para alcançar o failover automático de tráfego, configure o roteamento de rede usando grupos de instâncias gerenciadas (MIGs, na sigla em inglês).

AutoML Translation

O AutoML Translation é um serviço de tradução automática que permite importar seus próprios dados (pares de frases) para treinar modelos personalizados para suas necessidades específicas do domínio.

Interrupção zonal: o AutoML Translation tem servidores de computação ativos em várias zonas e regiões. Também é compatível com a replicação síncrona de dados entre zonas nas regiões. Esses recursos ajudam o Translation AutoML a atingir um failover instantâneo sem perda de dados para falhas zonais e sem exigir entrada ou ajuste de clientes.

Interrupção regional: no caso de falha regional, o AutoML Translation não está disponível.

AutoML Vision

O AutoML Vision faz parte da Vertex AI. Ele oferece um framework unificado para criar conjuntos de dados, importar dados, treinar modelos e disponibilizar modelos para previsão on-line e em lote.

O AutoML Vision é uma oferta regional. Os clientes podem escolher de qual região querem iniciar um job, mas não podem escolher as zonas específicas dentro dessa região. O serviço faz o balanceamento automático de carga das cargas de trabalho em diferentes zonas na região.

Interrupção por zona: o AutoML Vision armazena metadados dos jobs regionalmente e grava de maneira síncrona nas zonas da região. Os jobs são iniciados em uma zona específica, conforme selecionado pelo Cloud Load Balancing.

Jobs de treinamento do AutoML Vision: uma interrupção zonal faz com que todos os jobs em execução falhem e as atualizações de status do job falhem. Se um job falhar, tente de novo imediatamente. O novo job é roteado para uma zona disponível.

Jobs de previsão em lote do AutoML Vision: a previsão em lote é criada com base na previsão em lote da Vertex AI. Quando ocorre uma interrupção zonal, o serviço tenta executar o job automaticamente, roteando-o para as zonas disponíveis. Se várias tentativas falharem, o status do job será atualizado para com falha. As solicitações subsequentes do usuário para executar o job são roteadas para uma zona disponível.

Falha temporária regional:os clientes escolhem a região Google Cloud em que querem executar os jobs. Os dados jamais são replicados entre regiões. Em uma falha regional, o serviço AutoML Vision fica indisponível nessa região. Ela é disponibilizada novamente quando a falha temporária é resolvida. Para executar os jobs, recomendamos que os clientes usem várias regiões. Em caso de interrupção regional, encaminhe os jobs para uma região disponível diferente.

Lote

O Batch é um serviço totalmente gerenciado para enfileirar, programar e executar jobs em lote no Google Cloud. As configurações em lote são definidas no nível da região. Os clientes precisam escolher uma região para enviar os jobs em lote, e não uma zona em uma região. Quando um job é enviado, o Batch grava dados de clientes de maneira síncrona em várias zonas. No entanto, os clientes podem especificar as zonas em que as VMs em lote executam jobs.

Falha zonal: quando uma única zona falha, as tarefas em execução nela também falham. Se as tarefas tiverem configurações de repetição, o Batch fará o failover automaticamente para outras zonas ativas na mesma região. O failover automático está sujeito à disponibilidade de recursos em zonas ativas na mesma região. Os jobs que exigem recursos zonais (como VMs, GPUs ou discos permanentes zonais) que estão disponíveis apenas na zona com falha são enfileirados até que a zona com falha se recupere ou até que os tempos limite dos jobs em fila sejam atingidos. Quando possível, recomendamos que os clientes permitam que o Batch escolha recursos zonais para executar os jobs deles. Isso ajuda a garantir que os jobs sejam resilientes a uma interrupção de zona.

Falha regional: em caso de falha regional, o plano de controle de serviço está indisponível na região. O serviço não replica dados ou solicitações de redirecionamento entre regiões. Recomendamos que os clientes usem várias regiões para executar os jobs e redirecionar jobs para uma região diferente se uma região falhar.

Proteção de dados e contra ameaças do Chrome Enterprise Premium

A proteção de dados e contra ameaças do Chrome Enterprise Premium faz parte da solução Chrome Enterprise Premium. Ele amplia o Chrome com uma variedade de recursos de segurança, incluindo proteção contra malware e phishing, Prevenção contra perda de dados (DLP, na sigla em inglês), regras de filtragem de URL e relatórios de segurança.

Os administradores do Chrome Enterprise Premium podem optar por armazenar o conteúdo principal do cliente que viola as políticas de DLP ou malware em eventos de registro de regras do Google Workspace e/ou no Cloud Storage para investigações futuras. Os eventos de registro de regras do Google Workspace são alimentados por um banco de dados multirregional do Spanner. O Chrome Enterprise Premium pode levar até várias horas para detectar violações da política. Durante esse período, todos os dados não processados estão sujeitos à perda de dados devido a uma interrupção zonal ou regional. Quando uma violação é detectada, o conteúdo que viola suas políticas é gravado nos eventos de registro de regras do Google Workspace e/ou no Cloud Storage.

Interrupção por zona e regional: como a proteção de dados e contra ameaças do Chrome Enterprise Premium é multizonal e multirregional, ele pode sobreviver a uma perda completa e não planejada de uma zona ou região sem perda de disponibilidade. Ele oferece esse nível de confiabilidade ao redirecionar o tráfego para o serviço em outras zonas ou regiões ativas. No entanto, como a detecção de violações de DLP e malware pode levar várias horas para que a proteção de dados e ameaças do Chrome Enterprise Premium detecte violações de DLP e malware, todos os dados não processados em uma zona ou região específica estão sujeitos à perda por uma interrupção zonal ou regional.

BigQuery

O BigQuery é um armazenamento de dados sem servidor, altamente escalonável e econômico projetado para a agilidade dos negócios. O BigQuery é compatível com os seguintes tipos de localização para conjuntos de dados do usuário:

- uma região: uma localização geográfica específica, como Iowa (

us-central1) ou Montreal (northamerica-northeast1); - uma multirregião: uma área geográfica grande que contém dois ou mais lugares

geográficos, como os Estados Unidos (

US) ou a Europa (EU).

Em ambos os casos, os dados são armazenados de modo redundante em duas zonas de uma única região no local selecionado. Os dados gravados no BigQuery são gravados nas zonas principal e secundária de maneira síncrona. Isso protege contra a indisponibilidade de uma única zona na região, mas não contra uma falha temporária regional.

Autorização binária

A autorização binária é um produto de segurança da cadeia de suprimentos de software do GKE e do Cloud Run.

Todas as políticas de autorização binária são replicadas em várias zonas em cada região. A replicação ajuda as operações de leitura da política de autorização binária a se recuperarem de falhas de outras regiões. A replicação também torna as operações de leitura tolerantes a falhas zonais em cada região.

As operações de aplicação obrigatória da autorização binária são resilientes contra interrupções do serviço zonais, mas não são resilientes contra interrupções do serviço regionais. As operações de aplicação são executadas na mesma região do cluster do GKE ou do job do Cloud Run que está fazendo a solicitação. Portanto, em caso de uma falha regional, não há nada em execução para fazer solicitações de aplicação da autorização binária.

Gerenciador de certificados

O Gerenciador de certificados permite adquirir e gerenciar certificados Transport Layer Security (TLS) para uso com diferentes tipos de Cloud Load Balancing.

No caso de uma interrupção zonal, o Gerenciador de certificados regional e global é resiliente a falhas zonais, porque os jobs e bancos de dados são redundantes em várias zonas dentro de uma região. No caso de interrupção regional, o Gerenciador de certificados global é resiliente a falhas regionais porque os jobs e bancos de dados são redundantes em várias regiões. O Gerenciador de certificados regionais é um produto regional. Portanto, ele não aguenta uma falha regional.

Sistema de detecção de intrusões do Cloud

O Sistema de detecção de intrusões do Cloud (Cloud IDS) é um serviço zonal que fornece endpoints de IDS com escopo zonal, que processam o tráfego de VMs em uma zona específica. Por isso, não é tolerante a interrupções dos serviços zonais ou regionais.

Interrupção do serviço zonal: o Cloud IDS está vinculado a instâncias de VM. Se um cliente planeja mitigar interrupções dos serviços zonais implantando VMs em várias zonas (manualmente ou por grupos gerenciados de instâncias regionais), ele também precisa implantar endpoints do Cloud IDS nessas zonas.

Interrupção do serviço regional: o Cloud IDS é um produto regional. Ele não oferece nenhuma funcionalidade entre regiões. Uma falha regional eliminará toda a funcionalidade do Cloud IDS em todas as zonas nessa região.

Google Security Operations SIEM

O Google Security Operations SIEM do Google, que faz parte do Google Security Operations, é um serviço totalmente gerenciado que ajuda as equipes de segurança a detectar, investigar e responder a ameaças.

O Google Security Operations SIEM do Google tem ofertas regionais e multirregionais.

Em ofertas regionais, a carga dos dados e do tráfego é balanceada automaticamente nas zonas na região escolhida, e os dados são armazenados de modo redundante nas zonas de disponibilidade na região.

Multirregiões são georredundantes. Essa redundância oferece um conjunto mais amplo de proteções do que o armazenamento regional. Isso também ajuda a garantir que o serviço continue a funcionar mesmo que uma região inteira seja perdida.

A maioria dos caminhos de ingestão de dados replicam os dados dos clientes de forma síncrona em vários locais. Quando os dados são replicados de forma assíncrona, há uma janela de tempo (objetivo do ponto de recuperação, ou RPO) em que os dados ainda não replicados em vários locais. Isso ocorre na ingestão com feeds em implantações multirregionais. Após o RPO, os dados são disponibilizados em várias regiões.

Falha temporária por zona:

Implantações regionais: as solicitações são atendidas por qualquer zona dentro da região. Os dados são replicados de forma síncrona em várias zonas. No caso de uma interrupção do serviço completa na zona, as zonas restantes continuam a fornecer o tráfego e a processar os dados. Provisionamento redundante e escalonamento automático para o Google Security Operations SIEM ajuda a garantir que o serviço permaneça operacional nas zonas restantes durante essas mudanças de carga.

Implantações multirregionais: falhas temporárias zonais são equivalentes a interrupções regionais.

Falha temporária regional:

Implantações regionais: o Google Security Operations SIEM armazena todos os dados do cliente em uma única região, e o tráfego nunca é roteado entre regiões. Em caso de interrupção regional, o Google Security Operations SIEM ficará indisponível na região até que a interrupção do serviço seja resolvida.

Implantações multirregionais (sem feeds): as solicitações são veiculadas de qualquer região da implantação multirregional. Os dados são replicados de forma síncrona entre várias regiões. Em caso de interrupção do serviço em toda a região, as regiões restantes continuam a veicular o tráfego e a processar os dados. O provisionamento redundante e o escalonamento automático para o Google Security Operations SIEM ajudam a garantir que o serviço permaneça operacional nas regiões restantes durante essas mudanças de carga.

Implantações multirregionais (com feeds): as solicitações são atendidas de qualquer região. da implantação multirregional. Os dados são replicados de forma assíncrona entre várias regiões com o RPO fornecido. No caso de uma interrupção do serviço em toda a região, os dados armazenados depois que o RPO fica disponível nas regiões restantes. Os dados na janela de RPO podem não ser replicados.

Inventário de recursos do Cloud

O Inventário de recursos do Cloud é um serviço global de alto desempenho, resiliente e que mantém um repositório de metadados de recursos e políticas do Google Cloud . O Cloud Asset Inventory fornece ferramentas de pesquisa e análise que ajudam a rastrear recursos implantados em organizações, pastas e projetos.

No caso de interrupção da zona, o Inventário de recursos do Cloud continua a atender às solicitações de outra zona na mesma região ou em uma região diferente.

No caso de uma falha temporária regional, o Inventário de recursos do Cloud continua a atender solicitações de outras regiões.

Bigtable

O Bigtable é um serviço de banco de dados NoSQL de alto desempenho e totalmente gerenciado para grandes cargas de trabalho de análise e operacionais.

Visão geral da replicação do Bigtable

O Bigtable oferece um recurso de replicação flexível e totalmente configurável, que pode ser usado para aumentar a disponibilidade e a durabilidade dos dados, copiando-os para clusters em várias regiões. ou várias zonas na mesma região. O Bigtable também pode fornecer failover automático para suas solicitações quando você usa a replicação.

Ao usar configurações multirregionais ou multirregionais com roteamento de vários clusters, no caso de uma interrupção zonal ou regional, o Bigtable encaminha automaticamente o tráfego e atende às solicitações de o cluster disponível mais próximo. Como a replicação do Bigtable é assíncrona e consistente eventual, mudanças muito recentes nos dados no local da falha podem estarão indisponíveis se ainda não tiverem sido replicadas para outros locais.

Considerações sobre desempenho

Quando as demandas de recursos da CPU excedem a capacidade do nó disponível, o Bigtable sempre prioriza a veiculação de solicitações recebidas antes do tráfego de replicação.

Para mais informações sobre como usar a replicação do Bigtable com sua carga de trabalho, consulte a Visão geral da replicação do Cloud Bigtable e exemplos de configurações de replicação.

Os nós do Bigtable são usados para atender às solicitações recebidas e para executar a replicação de dados de outros clusters. Além de manter a contagem suficiente de nós por cluster, também é preciso garantir que seus aplicativos usem o design de esquema adequado para evitar pontos de acesso, o que pode causar uso excessivo ou desequilibrado de CPU e maior latência de replicação.

Para mais informações sobre como projetar o esquema do aplicativo para maximizar o desempenho e a eficiência do Bigtable, consulte Práticas recomendadas de design do esquema.

Monitoramento

O Bigtable oferece várias maneiras de monitorar visualmente a latência de replicação das instâncias e clusters usando os gráficos para replicação disponíveis no Google Cloud console.

Também é possível monitorar programaticamente as métricas de replicação do Bigtable usando a API Cloud Monitoring.

Certificate Authority Service

Com o Certificate Authority Service (CA Service), os clientes podem simplificar, automatizar e personalizar a implantação, o gerenciamento e a segurança de autoridades de certificação (CA, na sigla em inglês) privadas e emitir certificados de maneira resiliente em grande escala.

Interrupção zonal: o serviço de CA é resiliente a falhas zonais, porque o plano de controle é redundante em várias zonas em uma região. Se houver uma interrupção zonal, o serviço de CA continuará a atender solicitações de outra zona na mesma região sem interrupção. Como os dados são replicados de forma síncrona, não há perda ou dados corrompidos.

Interrupção regional: o serviço de CA é um produto regional, por isso não pode suportar uma falha regional. Se você precisar de resiliência a falhas regionais, crie CAs emissoras em duas regiões diferentes. Crie a CA emissora principal na região em que você precisa de certificados. Crie uma CA substituta em uma região diferente. Use o substituto quando a região da CA subordinada primária tiver uma interrupção. Se necessário, as duas CAs podem encadear a mesma CA raiz.

Cloud Billing

Com a API Cloud Billing, os desenvolvedores podem gerenciar o faturamento dos projetos doGoogle Cloud de maneira programática. A API Cloud Billing foi projetada como um sistema global com atualizações gravadas de forma síncrona em várias zonas e regiões.

Falha zonal ou regional: a API Cloud Billing faz o failover automaticamente para outra zona ou região. As solicitações individuais podem falhar, mas uma política de repetição permite que as tentativas subsequentes sejam bem-sucedidas.

Cloud Build

O Cloud Build é um serviço que executa seus builds no Google Cloud.

O Cloud Build é composto por instâncias isoladas por região que replicam dados de maneira síncrona em várias zonas da região. Recomendamos que você use regiões específicas do Google Cloud em vez da região global. Verifique se os recursos usados pelo build (incluindo buckets de registros, repositórios do Artifact Registry e outros) estão alinhados à região. em que seu build é executado.

No caso de uma falha temporária zonal, as operações do plano de controle não são afetadas. No entanto, a execução de versões na zona com falha será atrasada ou perdida permanentemente. As versões recém-acionadas serão distribuídas automaticamente para as zonas em funcionamento restantes.

No caso de uma falha regional, o plano de controle fica off-line e, no momento, a execução de versões é atrasada ou perdida permanentemente. Gatilhos, pools de workers e dados de versões nunca são replicados entre regiões. Recomendamos que você prepare gatilhos e pools de workers em várias regiões para facilitar a mitigação de uma falha temporária.

Cloud CDN

O Cloud CDN distribui e armazena em cache o conteúdo em muitos locais na rede do Google para reduzir a latência de exibição para os clientes. O conteúdo em cache é exibido da melhor maneira possível. Quando uma solicitação não pode ser exibida pelo cache do Cloud CDN, ela é encaminhada para servidores de origem, como VMs de back-end ou buckets do Cloud Storage, onde o conteúdo original é armazenado.

Quando uma zona ou região falha, os caches nos locais afetados ficam indisponíveis. As solicitações de entrada são encaminhadas para os locais e caches de borda disponíveis do Google. Se esses caches alternativos não puderem exibir a solicitação, eles a encaminharão para um servidor de origem disponível. Desde que o servidor possa exibir a solicitação com dados atualizados, não haverá perda de conteúdo. O aumento da taxa de ausências no cache fará com que os servidores de origem tenham mais tráfego do que o normal conforme os caches são preenchidos. As solicitações subsequentes serão exibidas a partir dos caches não afetados pela interrupção da zona ou da região.

Para mais informações sobre o Cloud CDN e o comportamento do cache, consulte a documentação do Cloud CDN.

Cloud Composer

O Cloud Composer é um serviço gerenciado de orquestração de fluxos de trabalho que permite criar, programar, monitorar e gerenciar fluxos de trabalho que abrangem nuvens e data centers no local. Os ambientes do Cloud Composer são criados no projeto de código aberto do Apache Airflow.

A disponibilidade da API Cloud Composer não é afetada pela indisponibilidade zonal. Durante uma falha temporária zonal, você mantém acesso à API Cloud Composer, incluindo a capacidade de criar novos ambientes do Cloud Composer.

Um ambiente do Cloud Composer tem um cluster do GKE como parte da própria arquitetura. Durante uma falha temporária zonal, os fluxos de trabalho no cluster podem ser interrompidos:

- No Cloud Composer 1, o cluster do ambiente é um recurso zonal, portanto, uma interrupção zonal pode tornar o cluster indisponível. Os fluxos de trabalho que estão em execução no momento da falha podem ser interrompidos antes da conclusão.

- No Cloud Composer 2, o cluster do ambiente é um recurso regional. No entanto, os fluxos de trabalho executados em nós de zonas afetadas por uma falha zonal podem ser interrompidos antes da conclusão.

Nas duas versões do Cloud Composer, uma interrupção zonal pode interromper a execução de fluxos de trabalho parcialmente executados, incluindo as ações externas configuradas por você. Dependendo do fluxo de trabalho, isso pode causar inconsistências externamente, por exemplo, se o fluxo de trabalho parar no meio de uma execução de várias etapas para modificar armazenamentos de dados externos. Portanto, considere o processo de recuperação ao projetar seu fluxo de trabalho do Airflow, incluindo como detectar estados de fluxo de trabalho parcialmente executados e reparar qualquer mudança parcial de dados.

No Cloud Composer 1, durante uma interrupção zonal, é possível optar por iniciar um novo ambiente do Cloud Composer em outra zona. Como o Airflow mantém o estado dos fluxos de trabalho no banco de dados de metadados, a transferência dessas informações para um novo ambiente do Cloud Composer pode realizar outras etapas e preparação.

No Cloud Composer 2, é possível resolver interrupções zonais configurando a recuperação de desastres com snapshots do ambiente com antecedência. Durante uma interrupção zonal, é possível mudar para outro ambiente transferindo o estado dos fluxos de trabalho com um snapshot do ambiente. Somente o Cloud Composer 2 é compatível com a recuperação de desastres com snapshots do ambiente.

Cloud Data Fusion

O Cloud Data Fusion é um serviço totalmente gerenciado de integração de dados corporativos. Ele pode ser usado para gerar e gerenciar pipelines de dados. Ele tem três edições.

Falhas zonais afetam instâncias da edição Developer.

Falhas regionais afetam instâncias da edição Basic e Enterprise.

Para controlar o acesso a recursos, projete e execute pipelines em ambientes separados. Essa separação permite projetar um pipeline uma vez e executá-lo em vários ambientes. É possível recuperar os pipelines nos dois ambientes. Para mais informações, consulte Fazer backup e restaurar dados da instância.

As recomendações a seguir se aplicam a falhas regionais e zonais.

Falhas no ambiente de design do pipeline

No ambiente de design, salve os rascunhos de pipelines em caso de falha. Dependendo dos requisitos específicos de RTO e RPO, é possível usar os rascunhos salvos para restaurar o pipeline em uma instância diferente do Cloud Data Fusion durante uma falha.

Falhas no ambiente de execução do pipeline

No ambiente de execução, inicie o pipeline internamente com gatilhos ou programações do Cloud Data Fusion ou externamente com ferramentas de orquestração, como o Cloud Composer. Para recuperar as configurações de ambiente de execução dos pipelines, faça backup dos pipelines e configurações, como plug-ins e programações. Em uma falha, use o backup para replicar uma instância em uma região ou zona não afetada.

Outra maneira de se preparar para falhas é ter várias instâncias nas regiões com a mesma configuração e conjunto de pipelines. Se você usar a orquestração externa, os pipelines em execução poderão ter o balanceamento de carga automático entre as instâncias. Tome cuidado para garantir que não haja recursos, como fontes de dados ou ferramentas de orquestração, vinculados a uma única região e usados por todas as instâncias, porque isso pode se tornar um ponto central de interrupção em uma falha. Por exemplo, é possível ter várias instâncias em diferentes regiões e usar o Cloud Load Balancing e o Cloud DNS para direcionar as solicitações de execução do pipeline para uma instância que não é afetada por uma falha. Confira as arquiteturas de exemplo nível um e nível três.

Falhas em outros serviços de dados Google Cloud no pipeline

A instância pode usar outros serviços do Google Cloud como fontes de dados ou ambientes de execução de pipeline, como Dataproc, Cloud Storage ou BigQuery. Google Cloud Esses serviços podem estar em diferentes regiões. Quando a execução inter-regional é necessária, uma falha em qualquer uma das regiões leva a uma interrupção. Nesse cenário, siga as etapas padrão de recuperação de desastres, tendo em mente que a configuração entre regiões com serviços essenciais em regiões diferentes é menos resiliente.

Cloud Deploy

O Cloud Deploy oferece entrega contínua de cargas de trabalho em serviços de ambiente de execução, como o GKE e o Cloud Run. O serviço é composto por instâncias regionais que replicam dados de maneira síncrona nas zonas da região.

Interrupção zonal: as operações do plano de controle não são afetadas. No entanto, os builds do Cloud Build (por exemplo, operações de renderização ou implantação) em execução quando uma zona falha são atrasadas ou perdidas permanentemente. Durante uma interrupção, o recurso do Cloud Deploy que acionou o build (uma versão ou lançamento) exibe um status de falha que indica que a operação subjacente falhou. É possível recriar o recurso para iniciar um novo build nas zonas de funcionamento restantes. Por exemplo, crie uma nova implantação reimplantando a versão em um destino.

Interrupção regional: as operações do plano de controle ficarão indisponíveis, bem como os dados do Cloud Deploy, até que a região seja restaurada. Para facilitar a restauração do serviço em caso de uma interrupção regional, recomendamos que você armazene o pipeline de entrega e as definições de meta no controle de origem. É possível usar esses arquivos de configuração para recriar os pipelines do Cloud Deploy em uma região em funcionamento. Durante uma interrupção, os dados sobre versões existentes são perdidos. Crie uma nova versão para continuar implantando softwares nos seus destinos.

Cloud DNS

O Cloud DNS é um serviço de Sistema de Nome de Domínio (DNS, na sigla em inglês) global, resiliente e de alto desempenho. Com ele, você publica nomes de domínio no DNS global com economia.

No caso de interrupção zonal, o Cloud DNS continua atendendo solicitações de outra zona na mesma região ou em uma região diferente sem interrupção. As atualizações nos registros do Cloud DNS são replicadas de maneira síncrona nas zonas da região em que são recebidas. Portanto, não há perda de dados.

No caso de interrupção regional, o Cloud DNS continua atendendo às solicitações de outras regiões. É possível que atualizações muito recentes nos registros do Cloud DNS não estejam disponíveis porque as atualizações são processadas primeiro em uma única região antes de serem replicadas de maneira assíncrona em outras regiões.

API Cloud Healthcare

A API Cloud Healthcare, um serviço para armazenar e gerenciar dados de saúde, foi criada para fornecer alta disponibilidade e oferece proteção contra falhas zonais e regionais, dependendo de uma configuração escolhida.

Configuração regional: na configuração padrão, a API Cloud Healthcare oferece proteção contra falhas zonais. O serviço é implantado em três zonas em uma região, e os dados também triplicam nas diferentes zonas da região. Em caso de falha zonal, afetando a camada de serviço ou a camada de dados, as zonas restantes assumem o controle sem interrupção. Com a configuração regional, se uma região inteira em que o serviço estiver localizado passar por uma falha temporária, ele ficará indisponível até que a região fique on-line novamente. No caso inesperado de uma destruição física de uma região inteira, os dados armazenados nela serão perdidos.

Configuração multirregional: na configuração multirregional, a API Cloud Healthcare é implantada em três zonas pertencentes a três regiões diferentes. Os dados também são replicados em três regiões. Isso protege contra a perda de serviço em caso de uma interrupção em toda a região, já que as regiões restantes serão assumidas automaticamente. Os dados estruturados, como o FHIR, são replicados de maneira síncrona em várias regiões. Portanto, estão protegidos contra a perda de dados em caso de uma interrupção em toda a região. Os dados armazenados em buckets do Cloud Storage, como DICOM e Ditado ou objetos HL7v2/FHIR, são replicados de maneira assíncrona em várias regiões.

Cloud Identity

Os serviços do Cloud Identity são distribuídos em várias regiões e usam balanceamento de carga dinâmico. O Cloud Identity não permite que os usuários selecionem um escopo de recurso. Se uma zona ou região específica sofrer uma interrupção, o tráfego será distribuído automaticamente para outras zonas ou regiões.

Os dados permanentes são espelhados em várias regiões com replicação síncrona na maioria dos casos. Por motivos de desempenho, alguns sistemas, como caches ou alterações que afetam um grande número de entidades, são replicados de maneira assíncrona nas regiões. Se a região principal em que os dados mais atuais estiverem armazenados sofrer uma interrupção, o Cloud Identity exibirá dados desatualizados de outro local até que a região principal fique disponível.

Cloud Interconnect

O Cloud Interconnect oferece aos clientes o acesso RFC 1918 às redes do Google Cloud a partir dos data centers locais por cabos físicos conectados à borda de peering do Google.

O Cloud Interconnect oferece aos clientes um SLA de 99,9% se provisionarem conexões para dois domínios de disponibilidade de borda (EAD, na sigla em inglês) em uma área metropolitana. Um SLA de 99,99% estará disponível se o cliente provisionar conexões em dois EADs em duas áreas metropolitanas para duas regiões com roteamento global. Para mais informações, consulte Visão geral da topologia para aplicativos não críticos e Visão geral da topologia para aplicativos no nível de produção.

O Cloud Interconnect é independente da zona de computação e fornece alta disponibilidade na forma de EADs. No caso de uma falha no EAD, a sessão do BGP para esse EAD falha e o tráfego falha para o outro EAD.

No caso de uma falha regional, as sessões do BGP para essa região interrompem o tráfego e fazem o failover para os recursos na região de trabalho. Isso se aplica quando o roteamento global está ativado.

Cloud Key Management Service

O Cloud Key Management Service (Cloud KMS) fornece gerenciamento de recursos de chave criptográfica escalonável e altamente durável. O Cloud KMS armazena todos os dados e metadados nos bancos de dados do Spanner que oferecem alta durabilidade de dados e disponibilidade com replicação síncrona.

Os recursos do Cloud KMS podem ser criados em uma única região, várias regiões ou globalmente.