Panduan ini menunjukkan cara men-deploy dan mengonfigurasi cluster ketersediaan tinggi (HA) SUSE Linux Enterprise Server (SLES) yang dioptimalkan performanya untuk sistem peningkatan skala SAP HANA di Google Cloud.

Panduan ini mencakup langkah-langkah untuk:

- Mengonfigurasi Load Balancer Jaringan passthrough internal untuk mengalihkan traffic jika terjadi kegagalan

- Mengonfigurasi cluster Pacemaker di SLES untuk mengelola sistem SAP dan resource lainnya selama failover

Panduan ini juga mencakup langkah-langkah untuk mengonfigurasi replikasi sistem SAP HANA, tetapi baca dokumentasi SAP untuk petunjuk pastinya.

Untuk men-deploy sistem SAP HANA tanpa cluster ketersediaan tinggi Linux atau host node standby, gunakan Panduan deployment SAP HANA.

Guna mengonfigurasi cluster HA untuk SAP HANA di Red Hat Enterprise Linux (RHEL), lihat Panduan konfigurasi cluster HA untuk peningkatan skala SAP HANA di RHEL.

Panduan ini ditujukan bagi pengguna SAP HANA tingkat lanjut yang memahami konfigurasi ketersediaan tinggi Linux untuk SAP HANA.

Sistem yang di-deploy oleh panduan ini

Dengan mengikuti panduan ini, Anda akan men-deploy dua instance SAP HANA dan menyiapkan cluster HA di SLES. Anda men-deploy setiap instance SAP HANA pada VM Compute Engine di zona berbeda dalam region yang sama. Penginstalan SAP NetWeaver dengan ketersediaan tinggi tidak tercakup dalam panduan ini.

Cluster yang di-deploy mencakup fungsi dan fitur berikut:

- Dua VM host, masing-masing dengan instance SAP HANA

- Replikasi sistem SAP HANA sinkron.

- Pengelola resource cluster ketersediaan tinggi Pacemaker.

- Mekanisme pagar STONITH.

- Mulai ulang otomatis instance yang gagal sebagai instance sekunder baru.

Panduan ini menyarankan penggunaan template Cloud Deployment Manager yang disediakan oleh Google Cloud untuk men-deploy virtual machine (VM) Compute Engine dan instance SAP HANA, yang memastikan bahwa VM dan sistem SAP HANA dasar memenuhi persyaratan dukungan SAP dan sesuai dengan praktik terbaik saat ini.

SAP HANA Studio digunakan dalam panduan ini untuk menguji replikasi sistem SAP HANA. Anda dapat menggunakan SAP HANA Cockpit sebagai gantinya, jika ingin. Untuk informasi tentang cara menginstal SAP HANA Studio, lihat:

- Menginstal SAP HANA Studio di VM Windows Compute Engine

- Panduan Penginstalan dan Update SAP HANA Studio

Prasyarat

Sebelum membuat cluster ketersediaan tinggi SAP HANA, pastikan prasyarat berikut terpenuhi:

- Anda telah membaca panduan perencanaan SAP HANA dan panduan perencanaan ketersediaan tinggi SAP HANA.

- Anda atau organisasi Anda memiliki akun Google Cloud dan telah membuat project untuk deployment SAP HANA. Untuk informasi tentang cara membuat akun dan projectGoogle Cloud , lihat Menyiapkan akun Google di Panduan Deployment SAP HANA.

- Jika ingin menjalankan workload SAP dengan mematuhi persyaratan residensi data, kontrol akses, staf dukungan, atau peraturan, Anda harus membuat folder Assured Workloads yang diperlukan. Untuk mengetahui informasi selengkapnya, lihat Kepatuhan dan sovereign controls untuk SAP di Google Cloud.

Media penginstalan SAP HANA disimpan di bucket Cloud Storage yang tersedia di project dan region deployment Anda. Untuk informasi tentang cara mengupload media penginstalan SAP HANA ke bucket Cloud Storage, lihat Mendownload SAP HANA di Panduan Deployment SAP HANA.

Jika login OS diaktifkan di metadata project, Anda harus menonaktifkan login OS untuk sementara sampai deployment selesai. Untuk tujuan deployment, prosedur ini mengonfigurasi kunci SSH dalam metadata instance. Jika login OS diaktifkan, konfigurasi kunci SSH berbasis metadata akan dinonaktifkan, dan deployment ini akan gagal. Setelah deployment selesai, Anda dapat kembali mengaktifkan login OS.

Untuk informasi selengkapnya, lihat:

Jika Anda menggunakan DNS internal VPC, nilai variabel

vmDnsSettingdalam metadata project Anda harusGlobalOnlyatauZonalPreferreduntuk mengaktifkan resolusi nama node di seluruh zona. Setelan defaultvmDnsSettingadalahZonalOnly. Untuk informasi selengkapnya, lihat:

Membuat jaringan

Untuk tujuan keamanan, buat jaringan baru. Anda dapat mengontrol siapa saja yang memiliki akses dengan menambahkan aturan firewall atau dengan menggunakan metode kontrol akses lainnya.

Jika project Anda memiliki jaringan VPC default, jangan gunakan jaringan tersebut. Sebagai gantinya, buat jaringan VPC Anda sendiri sehingga satu-satunya aturan firewall yang berlaku adalah yang Anda buat secara eksplisit.

Selama deployment, instance Compute Engine biasanya memerlukan akses ke internet untuk mendownload Agen Google Clouduntuk SAP. Jika Anda menggunakan salah satu image Linux bersertifikasi SAP yang tersedia dari Google Cloud, instance komputasi juga memerlukan akses ke internet untuk mendaftarkan lisensi dan mengakses repositori vendor OS. Konfigurasi dengan gateway NAT dan dengan tag jaringan VM mendukung akses ini, meskipun instance komputasi target tidak memiliki IP eksternal.

Untuk menyiapkan jaringan:

Konsol

- Di Google Cloud konsol, buka halaman jaringan VPC.

- Klik Create VPC network.

- Masukkan Name untuk jaringan.

Nama harus mematuhi konvensi penamaan. Jaringan VPC menggunakan konvensi penamaan Compute Engine.

- Untuk Subnet creation mode, pilih Custom.

- Di bagian New subnet, tentukan parameter konfigurasi berikut untuk subnet:

- Masukkan Name untuk subnet.

- Untuk Region, pilih Region Compute Engine tempat Anda ingin membuat subnet.

- Untuk IP stack type, pilih IPv4 (single-stack), lalu masukkan rentang alamat IP dalam format CIDR, seperti

10.1.0.0/24.Ini adalah rentang IPv4 utama untuk subnet. Jika Anda berencana untuk menambahkan lebih dari satu subnet, tetapkan rentang IP CIDR yang tidak tumpang-tindih untuk setiap subnetwork di dalam jaringan. Perhatikan bahwa setiap subnetwork dan rentang IP internalnya dipetakan ke satu region.

- Klik Done.

- Untuk menambahkan lebih banyak subnet, klik Add subnet dan ulangi langkah-langkah sebelumnya. Anda dapat menambahkan lebih banyak subnet ke jaringan setelah jaringan dibuat.

- Klik Buat.

gcloud

- Buka Cloud Shell.

- Untuk membuat jaringan baru dalam mode subnetwork kustom, jalankan:

gcloud compute networks create NETWORK_NAME --subnet-mode custom

Ganti

NETWORK_NAMEdengan nama jaringan baru. Nama harus mematuhi konvensi penamaan. Jaringan VPC menggunakan konvensi penamaan Compute Engine.Tentukan

--subnet-mode customuntuk menghindari penggunaan mode otomatis default, yang secara otomatis membuat subnet di setiap region Compute Engine. Untuk mengetahui informasi selengkapnya, lihat Mode pembuatan subnet. - Buat subnetwork, lalu tentukan region dan rentang IP:

gcloud compute networks subnets create SUBNETWORK_NAME \ --network NETWORK_NAME --region REGION --range RANGEGanti kode berikut:

SUBNETWORK_NAME: nama subnetwork baruNETWORK_NAME: nama jaringan yang Anda buat di langkah sebelumnyaREGION: region tempat Anda ingin subnetwork tersebut beradaRANGE: rentang alamat IP, ditentukan dalam format CIDR, seperti10.1.0.0/24Jika Anda berencana untuk menambahkan lebih dari satu subnetwork, tetapkan rentang IP CIDR yang tidak tumpang-tindih untuk setiap subnetwork di dalam jaringan. Perhatikan bahwa setiap subnetwork dan rentang IP internalnya dipetakan ke satu region.

- Jika ingin, ulangi langkah sebelumnya dan tambahkan subnetwork tambahan.

Menyiapkan gateway NAT

Jika perlu membuat satu atau beberapa VM tanpa alamat IP publik, Anda harus menggunakan penafsiran alamat jaringan (NAT) agar VM dapat mengakses internet. Gunakan Cloud NAT, layanan terkelola yang terdistribusi dan diatur oleh software Google Cloud . Layanan ini memungkinkan VM mengirim paket keluar ke internet dan menerima semua paket respons masuk yang ditetapkan. Atau, Anda dapat menyiapkan VM terpisah sebagai gateway NAT.

Untuk membuat instance Cloud NAT bagi project Anda, lihat Menggunakan Cloud NAT.

Setelah mengonfigurasi Cloud NAT untuk project, instance VM Anda dapat mengakses internet dengan aman tanpa alamat IP publik.

Menambahkan aturan firewall

Secara default, aturan firewall tersirat memblokir koneksi masuk dari luar jaringan Virtual Private Cloud (VPC) Anda. Untuk mengizinkan koneksi masuk, siapkan aturan firewall untuk VM Anda. Setelah koneksi masuk dibuat dengan VM, traffic diizinkan di kedua arah melalui koneksi tersebut.

Anda juga dapat membuat aturan firewall untuk mengizinkan akses eksternal ke port tertentu, atau untuk membatasi akses antar-VM di jaringan yang sama. Jika jenis jaringan VPC default digunakan, beberapa aturan default tambahan juga berlaku, seperti aturan default-allow-internal, yang memungkinkan konektivitas antar-VM di jaringan yang sama di semua port.

Bergantung pada kebijakan IT yang berlaku untuk lingkungan Anda, Anda mungkin perlu mengisolasi atau membatasi konektivitas ke host database Anda, yang dapat Anda lakukan dengan membuat aturan firewall.

Bergantung pada skenario, Anda dapat membuat aturan firewall guna mengizinkan akses untuk:

- Port SAP default yang tercantum dalam TCP/IP dari Semua Produk SAP.

- Koneksi dari komputer atau lingkungan jaringan perusahaan Anda ke instance VM Compute Engine. Jika tidak yakin dengan alamat IP yang harus digunakan, hubungi administrator jaringan perusahaan Anda.

- Komunikasi antar-VM di subnetwork SAP HANA, termasuk komunikasi antar-node dalam sistem penyebaran skala SAP HANA atau komunikasi antara server database dan server aplikasi dalam arsitektur 3 tingkat. Anda dapat mengaktifkan komunikasi antar-VM dengan membuat aturan firewall untuk mengizinkan traffic yang berasal dari dalam subnetwork.

Untuk membuat aturan firewall:

Konsol

Di Google Cloud konsol, buka halaman Firewall jaringan VPC.

Di bagian atas halaman, klik Create firewall rule.

- Di kolom Network, pilih jaringan tempat VM Anda berada.

- Di kolom Targets, tentukan resource di Google Cloud tempat aturan ini diterapkan. Misalnya, tentukan All instances in the network. Atau, untuk membatasi aturan pada instance tertentu di Google Cloud, masukkan tag di Specified target tags.

- Di kolom Source filter, pilih salah satu opsi berikut:

- IP ranges untuk mengizinkan traffic masuk dari alamat IP tertentu. Tentukan rentang alamat IP di kolom Source IP ranges.

- Subnets untuk mengizinkan traffic masuk dari subnetwork tertentu. Tentukan nama subnetwork di kolom Subnets berikut. Anda dapat menggunakan opsi ini untuk mengizinkan akses antar-VM dalam konfigurasi 3 tingkat atau penyebaran skala.

- Di bagian Protocols and ports, pilih Specified protocols and ports, lalu masukkan

tcp:PORT_NUMBER.

Klik Create untuk membuat aturan firewall.

gcloud

Buat aturan firewall menggunakan perintah berikut:

$ gcloud compute firewall-rules create FIREWALL_NAME

--direction=INGRESS --priority=1000 \

--network=NETWORK_NAME --action=ALLOW --rules=PROTOCOL:PORT \

--source-ranges IP_RANGE --target-tags=NETWORK_TAGSMen-deploy VM dan SAP HANA

Sebelum mulai mengonfigurasi cluster HA, Anda perlu menentukan dan men-deploy instance VM dan sistem SAP HANA yang berfungsi sebagai node utama dan sekunder di cluster HA.

Untuk menentukan dan men-deploy sistem, gunakan template Cloud Deployment Manager, sama seperti yang Anda gunakan untuk men-deploy sistem SAP HANA dalam Panduan deployment SAP HANA.

Namun, untuk men-deploy dua sistem, bukan satu, Anda perlu menambahkan definisi untuk sistem kedua ke file konfigurasi dengan menyalin dan menempel definisi sistem pertama. Setelah membuat definisi kedua, Anda perlu mengubah nama resource dan instance dalam definisi kedua. Untuk melindungi dari kegagalan zona, tentukan zona berbeda di region yang sama. Semua nilai properti lainnya dalam kedua definisi tetap sama.

Setelah sistem SAP HANA berhasil di-deploy, Anda dapat menentukan dan mengonfigurasi cluster HA.

Petunjuk berikut menggunakan Cloud Shell, tetapi secara umum berlaku untuk Google Cloud CLI.

Pastikan kuota resource saat ini, seperti persistent disk dan CPU, cukup untuk sistem SAP HANA yang akan diinstal. Jika kuota Anda tidak mencukupi, deployment akan gagal. Untuk mengetahui persyaratan kuota SAP HANA, lihat Pertimbangan harga dan kuota untuk SAP HANA.

Buka Cloud Shell atau, jika Anda menginstal gcloud CLI di workstation lokal, buka terminal.

Download template file konfigurasi

template.yamluntuk cluster ketersediaan tinggi SAP HANA ke direktori kerja Anda dengan memasukkan perintah berikut di Cloud Shell atau gcloud CLI:wget https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_hana/template.yaml

Jika ingin, ganti nama file

template.yamluntuk mengidentifikasi konfigurasi yang ditentukannya.Buka file

template.yamldi editor kode Cloud Shell atau, jika Anda menggunakan gcloud CLI, editor teks pilihan Anda.Untuk membuka editor kode Cloud Shell, klik ikon pensil di sudut kanan atas jendela terminal Cloud Shell.

Dalam file

template.yaml, selesaikan definisi sistem SAP HANA utama. Tentukan nilai properti dengan mengganti tanda kurung dan isinya dengan nilai untuk penginstalan Anda. Propertinya dijelaskan dalam tabel berikut.Untuk membuat instance VM tanpa menginstal SAP HANA, hapus atau jadikan sebagai komentar pada semua baris yang dimulai dengan

sap_hana_.Properti Jenis data Deskripsi jenis String Menentukan lokasi, jenis, dan versi template Deployment Manager yang akan digunakan selama deployment.

File YAML berisi dua spesifikasi

type, yang salah satunya diberi komentar. Spesifikasitypeyang aktif secara default menentukan versi template sebagailatest. Spesifikasitypeyang dijadikan sebagai komentar menentukan versi template tertentu dengan stempel waktu.Jika Anda memerlukan semua deployment untuk menggunakan versi template yang sama, gunakan spesifikasi

typeyang menyertakan stempel waktu.instanceNameString Nama instance VM yang saat ini ditentukan. Tentukan nama yang berbeda dalam definisi VM utama dan sekunder. Nama harus ditentukan dalam huruf kecil, angka, atau tanda hubung. instanceTypeString Jenis virtual machine Compute Engine yang diperlukan untuk menjalankan SAP HANA. Jika Anda memerlukan jenis VM kustom, tentukan jenis VM yang telah ditetapkan dengan jumlah vCPU yang paling mendekati, namun lebih besar dari jumlah yang Anda butuhkan. Setelah deployment selesai, ubah jumlah vCPU dan jumlah memori. zoneString Zona Google Cloud tempat men-deploy instance VM yang Anda tentukan. Tentukan zona berbeda di region yang sama untuk definisi HANA utama dan sekunder. Zona harus berada di region yang sama dengan yang Anda pilih untuk subnet Anda. subnetworkString Nama subnetwork yang Anda buat di langkah sebelumnya. Jika Anda men-deploy ke VPC bersama, tentukan nilai ini sebagai [SHAREDVPC_PROJECT]/[SUBNETWORK]. Contoh,myproject/network1.linuxImageString Nama image sistem operasi atau kelompok image sistem operasi Linux yang Anda gunakan dengan SAP HANA. Untuk menentukan keluarga image, tambahkan awalan family/ke nama keluarga. Contoh,family/sles-15-sp1-sap. Untuk menetapkan image tertentu, tentukan nama image saja. Untuk daftar image dan kelompok image yang tersedia, lihat halaman Images di konsol Google Cloud .linuxImageProjectString Project Google Cloud yang berisi image yang akan Anda gunakan. Project ini dapat berupa project Anda sendiri atau project image Google Cloud , seperti suse-sap-cloud. Untuk mengetahui informasi selengkapnya tentang Google Cloud project image, lihat halaman Images dalam dokumentasi Compute Engine.sap_hana_deployment_bucketString Nama bucket penyimpanan Google Cloud dalam project Anda yang berisi file penginstalan dan revisi SAP HANA yang Anda upload pada langkah sebelumnya. Semua file revisi upgrade dalam bucket diterapkan ke SAP HANA selama proses deployment. sap_hana_sidString ID sistem (SID) SAP HANA. ID harus terdiri dari tiga karakter alfanumerik dan diawali dengan huruf. Semua huruf harus huruf besar. sap_hana_instance_numberBilangan Bulat Nomor instance, 0 hingga 99, dari sistem SAP HANA. Defaultnya adalah 0. sap_hana_sidadm_passwordString Sandi untuk administrator sistem operasi (OS). Sandi minimal terdiri dari delapan karakter dan berisi minimal satu huruf besar, satu huruf kecil, dan satu angka. sap_hana_system_passwordString Sandi untuk superuser database. Sandi minimal terdiri dari 8 karakter dan mengandung minimal satu huruf besar, satu huruf kecil, dan satu angka. sap_hana_sidadm_uidBilangan Bulat Nilai default untuk ID pengguna SID_LCadmadalah900untuk menghindari grup buatan pengguna bentrok dengan SAP HANA. Anda dapat mengubahnya ke nilai yang berbeda jika diperlukan.sap_hana_sapsys_gidBilangan Bulat ID grup default untuk sapsys adalah 79. Dengan menentukan nilai di atas, Anda dapat mengganti nilai ini sesuai persyaratan Anda.sap_hana_scaleout_nodesBilangan Bulat Tentukan: 0. Instruksi ini hanya untuk sistem SAP HANA peningkatan skala.networkTagString Tag jaringan yang mewakili instance VM untuk tujuan firewall atau pemilihan rute. Jika Anda menentukan publicIP: Nodan tidak menetapkan tag jaringan, pastikan untuk menyediakan cara lain untuk mengakses internet.nic_typeString Opsional, tetapi direkomendasikan jika tersedia untuk mesin dan versi OS target. Menentukan antarmuka jaringan yang akan digunakan dengan instance VM. Anda dapat menentukan nilai GVNICatauVIRTIO_NET. Untuk menggunakan Google Virtual NIC (gVNIC), Anda harus menentukan image OS yang mendukung gVNIC sebagai nilai untuk propertilinuxImage. Untuk mengetahui daftar OS image, lihat Detail sistem operasi.Jika Anda tidak menentukan nilai untuk properti ini, antarmuka jaringan akan secara otomatis dipilih berdasarkan jenis mesin yang Anda tentukan untuk properti

Argumen ini tersedia di template Deployment Manager versiinstanceType.202302060649atau yang lebih baru.publicIPBoolean Opsional. Menentukan apakah alamat IP publik ditambahkan ke instance VM Anda atau tidak. Nilai defaultnya adalah Yes.serviceAccountString Opsional. Menentukan akun layanan yang akan digunakan oleh VM host dan oleh program yang berjalan di VM host. Masukkan alamat email akun layanan. Misalnya, svc-acct-name@project-id.. Secara default, akun layanan default Compute Engine digunakan. Untuk mengetahui informasi selengkapnya, lihat Identity and access management untuk program SAP di Google Cloud. Buat definisi sistem SAP HANA sekunder dengan menyalin definisi sistem SAP HANA utama dan menempelkan salinannya setelah definisi sistem SAP HANA utama. Lihat contoh dengan mengikuti langkah-langkah berikut.

Dalam definisi sistem SAP HANA sekunder, tentukan nilai yang berbeda untuk properti berikut dibandingkan dengan yang Anda tetapkan dalam definisi sistem SAP HANA utama:

nameinstanceNamezone

Buat instance:

gcloud deployment-manager deployments create DEPLOYMENT_NAME --config TEMPLATE_NAME.yaml

Perintah di atas memanggil Deployment Manager, yang men-deploy VM, mendownload software SAP HANA dari bucket penyimpanan Anda, dan menginstal SAP HANA, semuanya sesuai dengan spesifikasi di file

template.yamlAnda.Pemrosesan deployment terdiri dari dua tahap. Pada tahap pertama, Deployment Manager menulis statusnya ke konsol. Pada tahap kedua, skrip deployment menulis statusnya ke Cloud Logging.

Contoh file konfigurasi template.yaml lengkap

Contoh berikut menunjukkan file konfigurasi template.yaml lengkap yang men-deploy dua instance VM dengan instalasi sistem SAP HANA.

File ini berisi definisi dua resource untuk di-deploy:

sap_hana_primary dan sap_hana_secondary. Setiap definisi resource

berisi definisi untuk VM dan instance SAP HANA.

Definisi resource sap_hana_secondary dibuat dengan menyalin dan menempelkan

definisi pertama, lalu mengubah nilai properti name,

instanceName, dan zone. Semua nilai properti lainnya dalam

dua definisi resource sama.

Properti networkTag, serviceAccount, sap_hana_sidadm_uid, dan sap_hana_sapsys_gid berasal dari bagian Opsi Lanjutan di template file konfigurasi. Properti sap_hana_sidadm_uid dan

sap_hana_sapsys_gid disertakan untuk menampilkan nilai defaultnya, yang digunakan

karena properti tersebut dijadikan komentar.

resources:

- name: sap_hana_primary

type: https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_hana/sap_hana.py

#

# By default, this configuration file uses the latest release of the deployment

# scripts for SAP on Google Cloud. To fix your deployments to a specific release

# of the scripts, comment out the type property above and uncomment the type property below.

#

# type: https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/yyyymmddhhmm/dm-templates/sap_hana/sap_hana.py

#

properties:

instanceName: hana-ha-vm-1

instanceType: n2-highmem-32

zone: us-central1-a

subnetwork: example-subnet-us-central1

linuxImage: family/sles-15-sp1-sap

linuxImageProject: suse-sap-cloud

sap_hana_deployment_bucket: hana2-sp4-rev46

sap_hana_sid: HA1

sap_hana_instance_number: 22

sap_hana_sidadm_password: Tempa55word

sap_hana_system_password: Tempa55word

sap_hana_scaleout_nodes: 0

networkTag: cluster-ntwk-tag

serviceAccount: limited-roles@example-project-123456.

# sap_hana_sidadm_uid: 900

# sap_hana_sapsys_gid: 79

- name: sap_hana_secondary

type: https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_hana/sap_hana.py

#

# By default, this configuration file uses the latest release of the deployment

# scripts for SAP on Google Cloud. To fix your deployments to a specific release

# of the scripts, comment out the type property above and uncomment the type property below.

#

# type: https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/yyyymmddhhmm/dm-templates/sap_hana/sap_hana.py

#

properties:

instanceName: hana-ha-vm-2

instanceType: n2-highmem-32

zone: us-central1-c

subnetwork: example-subnet-us-central1

linuxImage: family/sles-15-sp1-sap

linuxImageProject: suse-sap-cloud

sap_hana_deployment_bucket: hana2-sp4-rev46

sap_hana_sid: HA1

sap_hana_instance_number: 22

sap_hana_sidadm_password: Google123

sap_hana_system_password: Google123

sap_hana_scaleout_nodes: 0

networkTag: cluster-ntwk-tag

serviceAccount: limited-roles@example-project-123456.

# sap_hana_sidadm_uid: 900

# sap_hana_sapsys_gid: 79

Membuat aturan firewall yang mengizinkan akses ke VM host

Jika Anda belum melakukannya, buat aturan firewall yang mengizinkan akses ke setiap VM host dari sumber berikut:

- Untuk tujuan konfigurasi, workstation lokal, host bastion, atau server jump

- Untuk tujuan konfigurasi, workstation lokal, host bastion, atau server jump

Saat membuat aturan firewall VPC, tentukan tag jaringan yang Anda tetapkan di file konfigurasi template.yaml untuk menetapkan VM host sebagai target untuk aturan tersebut.

Untuk memverifikasi deployment, tentukan aturan untuk mengizinkan koneksi SSH pada port 22 dari bastion host atau workstation lokal.

Untuk akses antara node cluster, tambahkan aturan firewall yang mengizinkan semua jenis koneksi pada port mana pun dari VM lain di subnetwork yang sama.

Pastikan aturan firewall untuk memverifikasi deployment dan komunikasi intra-cluster telah dibuat sebelum melanjutkan ke bagian berikutnya. Untuk mengetahui petunjuknya, lihat Menambahkan aturan firewall.

Memverifikasi deployment VM dan SAP HANA

Untuk memverifikasi deployment, periksa log deployment di Cloud Logging dan periksa disk serta layanan di VM host utama dan sekunder.

Di konsol Google Cloud , buka Cloud Logging untuk memantau progres penginstalan dan memeriksa error.

Filter log:

Logs Explorer

Di halaman Logs Explorer, buka panel Query.

Dari menu drop-down Resource, pilih Global, lalu klik Add.

Jika Anda tidak melihat opsi Global, di editor kueri, masukkan kueri berikut:

resource.type="global" "Deployment"Klik Jalankan kueri.

Logs Viewer Lama

- Di halaman Legacy Logs Viewer, dari menu pemilih dasar, pilih Global sebagai resource logging Anda.

Analisis log yang difilter:

- Jika

"--- Finished"ditampilkan, berarti pemrosesan deployment selesai dan Anda dapat melanjutkan ke langkah berikutnya. Jika Anda melihat error kuota:

Di halaman Quotas IAM & Admin, tingkatkan kuota yang tidak memenuhi persyaratan SAP HANA yang tercantum dalam Panduan perencanaan SAP HANA.

Di halaman Deployment Manager Deployments, hapus deployment untuk membersihkan VM dan persistent disk dari penginstalan yang gagal.

Jalankan kembali deployment Anda.

- Jika

Periksa konfigurasi VM dan SAP HANA

Setelah sistem SAP HANA di-deploy tanpa error, hubungkan ke setiap VM menggunakan SSH. Dari halaman instance VM Compute Engine, Anda dapat mengklik tombol SSH untuk setiap instance VM, atau menggunakan metode SSH yang Anda inginkan.

Ubah ke pengguna root.

$sudo su -Di command prompt, masukkan

df -h. Di setiap VM, pastikan Anda melihat direktori/hana, seperti/hana/data.Filesystem Size Used Avail Use% Mounted on /dev/sda2 30G 4.0G 26G 14% / devtmpfs 126G 0 126G 0% /dev tmpfs 126G 0 126G 0% /dev/shm tmpfs 126G 17M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda1 200M 9.7M 191M 5% /boot/efi /dev/mapper/vg_hana-shared 251G 49G 203G 20% /hana/shared /dev/mapper/vg_hana-sap 32G 240M 32G 1% /usr/sap /dev/mapper/vg_hana-data 426G 7.0G 419G 2% /hana/data /dev/mapper/vg_hana-log 125G 4.2G 121G 4% /hana/log /dev/mapper/vg_hanabackup-backup 512G 33M 512G 1% /hanabackup tmpfs 26G 0 26G 0% /run/user/900 tmpfs 26G 0 26G 0% /run/user/899 tmpfs 26G 0 26G 0% /run/user/1000

Ubah ke pengguna admin SAP dengan mengganti

SID_LCdalam perintah berikut dengan ID sistem yang Anda tentukan dalam template file konfigurasi. Gunakan huruf kecil untuk setiap huruf.#su - SID_LCadmPastikan layanan SAP HANA, seperti

hdbnameserver,hdbindexserver, dan lainnya, berjalan pada instance dengan memasukkan perintah berikut:>HDB infoJika Anda menggunakan RHEL untuk SAP 9.0 atau yang lebih baru, pastikan paket

chkconfigdancompat-openssl11diinstal pada instance VM Anda.Untuk mengetahui informasi selengkapnya dari SAP, lihat Catatan SAP 3108316 - Red Hat Enterprise Linux 9.x: Penginstalan dan Konfigurasi .

Memvalidasi penginstalan Agen Google Clouduntuk SAP

Setelah Anda men-deploy VM dan menginstal sistem SAP, pastikan bahwa AgenGoogle Clouduntuk SAP berfungsi dengan benar.

Memastikan bahwa Agen Google Clouduntuk SAP sedang berjalan

Untuk memastikan bahwa agen sedang berjalan, ikuti langkah-langkah berikut:

Buat koneksi SSH dengan instance Compute Engine Anda.

Jalankan perintah berikut:

systemctl status google-cloud-sap-agent

Jika agen berfungsi dengan baik, output akan berisi

active (running). Contoh:google-cloud-sap-agent.service - Google Cloud Agent for SAP Loaded: loaded (/usr/lib/systemd/system/google-cloud-sap-agent.service; enabled; vendor preset: disabled) Active: active (running) since Fri 2022-12-02 07:21:42 UTC; 4 days ago Main PID: 1337673 (google-cloud-sa) Tasks: 9 (limit: 100427) Memory: 22.4 M (max: 1.0G limit: 1.0G) CGroup: /system.slice/google-cloud-sap-agent.service └─1337673 /usr/bin/google-cloud-sap-agent

Jika agen tidak berjalan, mulai ulang agen.

Memverifikasi bahwa Agen Host SAP menerima metrik

Untuk memverifikasi bahwa metrik infrastruktur dikumpulkan oleh Agent for SAPGoogle Clouddan dikirim dengan benar ke Agen Host SAP, ikuti langkah-langkah berikut:

- Di sistem SAP, masukkan transaksi

ST06. Di panel ringkasan, periksa ketersediaan dan konten kolom berikut untuk penyiapan infrastruktur pemantauan SAP dan Google yang menyeluruh dan benar:

- Penyedia Cloud:

Google Cloud Platform - Akses Pemantauan yang Ditingkatkan:

TRUE - Detail Enhanced Monitoring:

ACTIVE

- Penyedia Cloud:

Menyiapkan pemantauan untuk SAP HANA

Secara opsional, Anda dapat memantau instance SAP HANA menggunakan AgenGoogle Clouduntuk SAP. Mulai versi 2.0, Anda dapat mengonfigurasi agen untuk mengumpulkan metrik pemantauan SAP HANA dan mengirimkannya ke Cloud Monitoring. Dengan Cloud Monitoring, Anda dapat membuat dasbor untuk memvisualisasikan metrik ini, menyiapkan pemberitahuan berdasarkan batas metrik, dan lainnya.

Untuk mengetahui informasi selengkapnya tentang pengumpulan metrik pemantauan SAP HANA menggunakan AgenGoogle Clouduntuk SAP, lihat Pengumpulan metrik pemantauan SAP HANA.

Menonaktifkan mulai otomatis SAP HANA

Untuk setiap instance SAP HANA dalam cluster, pastikan mulai otomatis SAP HANA dinonaktifkan. Untuk failover, Pacemaker mengelola proses mulai dan berhenti instance SAP HANA dalam cluster.

Pada setiap host sebagai SID_LCadm, hentikan SAP HANA:

>HDB stopPada setiap host, buka profil SAP HANA dengan menggunakan editor, seperti vi:

vi /usr/sap/SID/SYS/profile/SID_HDBINST_NUM_HOST_NAME

Tetapkan properti

Autostartke0.Autostart=0

Simpan profil.

Pada setiap host sebagai SID_LCadm, mulai SAP HANA:

>HDB start

Mengaktifkan Mulai Ulang Cepat SAP HANA

Google Cloud sangat merekomendasikan pengaktifan Mulai Ulang Cepat SAP HANA untuk setiap instance SAP HANA, terutama untuk instance yang lebih besar. Mulai Ulang Cepat SAP HANA mengurangi waktu mulai ulang jika SAP HANA dihentikan, tetapi sistem operasi tetap berjalan.

Seperti yang dikonfigurasi oleh skrip otomatisasi yang disediakan Google Cloud ,

setelan sistem operasi dan kernel sudah mendukung Mulai Ulang Cepat SAP HANA.

Anda perlu menentukan sistem file tmpfs dan mengonfigurasi SAP HANA.

Untuk menentukan sistem file tmpfs dan mengonfigurasi SAP HANA, Anda dapat mengikuti

langkah-langkah manual atau menggunakan skrip otomatisasi yang

Google Cloud sediakan untuk mengaktifkan Mulai Ulang Cepat SAP HANA. Untuk mengetahui informasi selengkapnya, lihat:

- Langkah manual: Mengaktifkan Mulai Ulang Cepat SAP HANA

- Langkah otomatis: Mengaktifkan Mulai Ulang Cepat SAP HANA

Untuk mengetahui petunjuk otoritatif lengkap terkait Mulai Ulang Cepat SAP HANA, lihat dokumentasi Opsi Mulai Ulang Cepat SAP HANA.

Langkah manual

Mengonfigurasi sistem file tmpfs

Setelah VM host dan sistem SAP HANA dasar berhasil di-deploy, Anda harus membuat dan memasang direktori untuk node NUMA di sistem file tmpfs.

Menampilkan topologi NUMA VM Anda

Sebelum dapat memetakan sistem file tmpfs yang diperlukan, Anda perlu mengetahui jumlah node NUMA yang dimiliki VM Anda. Untuk menampilkan node NUMA yang tersedia di VM Compute Engine, masukkan perintah berikut:

lscpu | grep NUMA

Misalnya, jenis VM m2-ultramem-208 memiliki empat node NUMA bernomor 0-3, seperti yang ditunjukkan pada contoh berikut:

NUMA node(s): 4 NUMA node0 CPU(s): 0-25,104-129 NUMA node1 CPU(s): 26-51,130-155 NUMA node2 CPU(s): 52-77,156-181 NUMA node3 CPU(s): 78-103,182-207

Membuat direktori node NUMA

Buat direktori untuk setiap node NUMA di VM Anda dan tetapkan izinnya.

Misalnya, untuk empat node NUMA yang bernomor 0-3:

mkdir -pv /hana/tmpfs{0..3}/SID

chown -R SID_LCadm:sapsys /hana/tmpfs*/SID

chmod 777 -R /hana/tmpfs*/SIDInstal direktori node NUMA ke tmpfs

Instal direktori sistem file tmpfs dan tentukan preferensi node NUMA untuk setiap direktori dengan mpol=prefer:

SID menentukan SID dengan huruf besar.

mount tmpfsSID0 -t tmpfs -o mpol=prefer:0 /hana/tmpfs0/SID mount tmpfsSID1 -t tmpfs -o mpol=prefer:1 /hana/tmpfs1/SID mount tmpfsSID2 -t tmpfs -o mpol=prefer:2 /hana/tmpfs2/SID mount tmpfsSID3 -t tmpfs -o mpol=prefer:3 /hana/tmpfs3/SID

Update /etc/fstab

Untuk memastikan direktori pemasangan tersedia setelah sistem operasi dimulai ulang, tambahkan entri ke tabel sistem file, /etc/fstab:

tmpfsSID0 /hana/tmpfs0/SID tmpfs rw,nofail,relatime,mpol=prefer:0 tmpfsSID1 /hana/tmpfs1/SID tmpfs rw,nofail,relatime,mpol=prefer:1 tmpfsSID1 /hana/tmpfs2/SID tmpfs rw,nofail,relatime,mpol=prefer:2 tmpfsSID1 /hana/tmpfs3/SID tmpfs rw,nofail,relatime,mpol=prefer:3

Opsional: menetapkan batas penggunaan memori

Sistem file tmpfs dapat bertambah dan mengecil secara dinamis.

Untuk membatasi memori yang digunakan oleh sistem file tmpfs, Anda dapat menetapkan batas ukuran untuk volume node NUMA dengan opsi size.

Contoh:

mount tmpfsSID0 -t tmpfs -o mpol=prefer:0,size=250G /hana/tmpfs0/SID

Anda juga dapat membatasi penggunaan memori tmpfs secara keseluruhan untuk semua node NUMA untuk instance SAP HANA tertentu dan node server tertentu, dengan menetapkan parameter persistent_memory_global_allocation_limit di bagian [memorymanager] dari file global.ini.

Mengonfigurasi SAP HANA untuk Mulai Ulang Cepat

Guna mengonfigurasi SAP HANA untuk Fast Restart, update file global.ini dan tentukan tabel yang akan disimpan dalam memori persisten.

Perbarui bagian [persistence] dalam file global.ini

Konfigurasi bagian [persistence] di file global.ini SAP HANA untuk mereferensikan lokasi tmpfs. Pisahkan setiap lokasi tmpfs dengan titik koma:

[persistence] basepath_datavolumes = /hana/data basepath_logvolumes = /hana/log basepath_persistent_memory_volumes = /hana/tmpfs0/SID;/hana/tmpfs1/SID;/hana/tmpfs2/SID;/hana/tmpfs3/SID

Contoh sebelumnya menentukan empat volume memori untuk empat node NUMA, yang sesuai dengan m2-ultramem-208. Jika menjalankan m2-ultramem-416, Anda perlu mengonfigurasi delapan volume memori (0..7).

Mulai ulang SAP HANA setelah mengubah file global.ini.

SAP HANA kini dapat menggunakan lokasi tmpfs sebagai ruang memori persisten.

SAP HANA kini dapat menggunakan lokasi sebagai ruang memori persisten.

Menentukan tabel atau partisi kolom tertentu yang akan disimpan di memori persisten.

Misalnya, untuk mengaktifkan memori persisten pada tabel yang sudah ada, jalankan kueri SQL:

ALTER TABLE exampletable persistent memory ON immediate CASCADE

Guna mengubah default untuk tabel baru, tambahkan parameter table_default dalam file indexserver.ini. Contoh:

[persistent_memory] table_default = ON

Untuk informasi selengkapnya tentang cara mengontrol kolom, tabel, dan tampilan pemantauan mana yang memberikan informasi mendetail, lihat Memori Persisten SAP HANA.

Langkah otomatis

Skrip otomatisasi yang disediakan Google Cloud untuk mengaktifkan

Mulai Ulang Cepat SAP HANA

akan membuat perubahan pada direktori /hana/tmpfs*, file /etc/fstab, dan

konfigurasi SAP HANA. Saat menjalankan skrip, Anda mungkin perlu melakukan langkah tambahan, bergantung pada apakah ini adalah deployment awal sistem SAP HANA atau Anda mengubah ukuran mesin ke ukuran NUMA yang berbeda.

Untuk deployment awal sistem SAP HANA atau mengubah ukuran mesin guna meningkatkan jumlah node NUMA, pastikan SAP HANA berjalan selama eksekusi skrip otomatisasi yang disediakan Google Clouduntuk mengaktifkan Mulai Ulang Cepat SAP HANA.

Jika Anda mengubah ukuran mesin untuk mengurangi jumlah node NUMA, pastikan SAP HANA dihentikan selama eksekusi skrip otomatisasi yang disediakan Google Cloud untuk mengaktifkan Mulai Ulang Cepat SAP HANA. Setelah skrip dijalankan, Anda harus memperbarui konfigurasi SAP HANA secara manual untuk menyelesaikan penyiapan Mulai Ulang Cepat SAP HANA. Untuk mengetahui informasi selengkapnya, lihat Konfigurasi SAP HANA untuk Mulai Ulang Cepat.

Untuk mengaktifkan Mulai Ulang Cepat SAP HANA, ikuti langkah-langkah berikut:

Buat koneksi SSH dengan VM host Anda.

Beralih ke root:

sudo su -

Download skrip

sap_lib_hdbfr.sh:wget https://storage.googleapis.com/cloudsapdeploy/terraform/latest/terraform/lib/sap_lib_hdbfr.sh

Setel agar file dapat dieksekusi:

chmod +x sap_lib_hdbfr.sh

Pastikan bahwa skrip tidak memiliki error:

vi sap_lib_hdbfr.sh ./sap_lib_hdbfr.sh -help

Jika perintah menampilkan error, hubungi Cloud Customer Care. Untuk mengetahui informasi selengkapnya tentang cara menghubungi Layanan Pelanggan, lihat Mendapatkan dukungan untuk SAP di Google Cloud.

Jalankan skrip setelah mengganti ID sistem (SID) dan sandi SAP HANA untuk pengguna SISTEM dari database SAP HANA. Untuk memberikan sandi dengan aman, sebaiknya gunakan secret di Secret Manager.

Jalankan skrip menggunakan nama secret di Secret Manager. Secret ini harus ada di project Google Cloud yang berisi instance VM host Anda.

sudo ./sap_lib_hdbfr.sh -h 'SID' -s SECRET_NAME

Ganti kode berikut:

SID: menentukan SID dengan huruf besar. Contoh,AHA.SECRET_NAME: menentukan nama secret yang sesuai dengan sandi untuk pengguna SISTEM dari database SAP HANA. Secret ini harus ada di project Google Cloud yang berisi instance VM host Anda.

Atau, Anda dapat menjalankan skrip menggunakan sandi teks biasa. Setelah Mulai Ulang Cepat SAP HANA diaktifkan, pastikan untuk mengubah sandi Anda. Sebaiknya jangan gunakan sandi teks biasa karena sandi Anda akan dicatat dalam histori command line VM Anda.

sudo ./sap_lib_hdbfr.sh -h 'SID' -p 'PASSWORD'

Ganti kode berikut:

SID: menentukan SID dengan huruf besar. Contoh,AHA.PASSWORD: menentukan sandi untuk pengguna SISTEM dari database SAP HANA.

Agar operasi awal berhasil, Anda akan melihat output yang mirip dengan output berikut ini:

INFO - Script is running in standalone mode

ls: cannot access '/hana/tmpfs*': No such file or directory

INFO - Setting up HANA Fast Restart for system 'TST/00'.

INFO - Number of NUMA nodes is 2

INFO - Number of directories /hana/tmpfs* is 0

INFO - HANA version 2.57

INFO - No directories /hana/tmpfs* exist. Assuming initial setup.

INFO - Creating 2 directories /hana/tmpfs* and mounting them

INFO - Adding /hana/tmpfs* entries to /etc/fstab. Copy is in /etc/fstab.20220625_030839

INFO - Updating the HANA configuration.

INFO - Running command: select * from dummy

DUMMY

"X"

1 row selected (overall time 4124 usec; server time 130 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('global.ini', 'SYSTEM') SET ('persistence', 'basepath_persistent_memory_volumes') = '/hana/tmpfs0/TST;/hana/tmpfs1/TST;'

0 rows affected (overall time 3570 usec; server time 2239 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('global.ini', 'SYSTEM') SET ('persistent_memory', 'table_unload_action') = 'retain';

0 rows affected (overall time 4308 usec; server time 2441 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('indexserver.ini', 'SYSTEM') SET ('persistent_memory', 'table_default') = 'ON';

0 rows affected (overall time 3422 usec; server time 2152 usec)

Mengonfigurasi kunci SSH pada VM utama dan sekunder

Kunci penyimpanan aman (SSFS) SAP HANA perlu disinkronkan dengan host di cluster HA. Untuk menyederhanakan sinkronisasi, dan mengizinkan file seperti cadangan disalin antar-host di cluster dengan ketersediaan tinggi (HA), Anda dapat membuat koneksi SSH root di antara dua host tersebut.

Organisasi Anda kemungkinan memiliki pedoman yang mengatur komunikasi jaringan

internal. Jika perlu, setelah deployment selesai, Anda dapat menghapus metadata dari VM dan kunci dari direktori authorized_keys.

Jika penyiapan koneksi SSH langsung tidak mematuhi pedoman organisasi, Anda dapat menyinkronkan kunci SSFS dan mentransfer file dengan menggunakan metode lain, seperti:

- Transfer file yang lebih kecil melalui workstation lokal menggunakan opsi menu Upload file dan Download file Cloud Shell. Lihat Mengelola file dengan Cloud Shell.

- Bertukar file menggunakan bucket Google Cloud Storage. Lihat bagian Menangani objek di dokumentasi Cloud Storage.

- Gunakan agen Backint Cloud Storage untuk SAP HANA guna mencadangkan dan memulihkan database HANA. Lihat agen Backint Cloud Storage untuk SAP HANA.

- Gunakan solusi penyimpanan file seperti Filestore atau Google Cloud NetApp Volumes untuk membuat folder bersama. Untuk informasi selengkapnya, lihat Opsi server file.

Untuk mengaktifkan koneksi SSH antara instance utama dan sekunder, ikuti langkah-langkah berikut.

Di VM host utama:

Gunakan SSH untuk terhubung ke VM

Beralih ke root:

$sudo su -Sebagai root, buat kunci SSH.

#ssh-keygenPerbarui metadata VM utama dengan informasi tentang kunci SSH untuk VM sekunder.

#gcloud compute instances add-metadata secondary-host-name \ --metadata "ssh-keys=$(whoami):$(cat ~/.ssh/id_rsa.pub)" --zone secondary-zoneBerikan otorisasi pada VM utama ke dirinya sendiri

#cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

Di VM host sekunder:

Gunakan SSH untuk terhubung ke VM

Beralih ke root:

$sudo su -Sebagai root, buat kunci SSH.

#ssh-keygenUpdate metadata VM sekunder dengan informasi tentang kunci SSH untuk VM utama.

#gcloud compute instances add-metadata primary-host-name \ --metadata "ssh-keys=$(whoami):$(cat ~/.ssh/id_rsa.pub)" --zone primary-zoneBerikan otorisasi pada VM sekunder ke dirinya sendiri

#cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keysPastikan kunci SSH disiapkan dengan benar dengan membuka koneksi SSH dari sistem sekunder ke sistem utama.

#ssh primary-host-name

Pada VM host utama sebagai root, konfirmasi koneksi dengan membuka koneksi SSH ke VM host sekunder:

#ssh secondary-host-name

Membuat pengguna database SAP HANA untuk memantau status cluster

Pada host utama, sebagai

SID_LCadm, login ke terminal interaktif database SAP HANA:>hdbsql -u system -p "system-password" -i inst_numDi terminal interaktif, buat pengguna database

slehasync:=>CREATE USER slehasync PASSWORD "hdb-user-password";=>GRANT CATALOG READ TO slehasync;=>GRANT MONITOR ADMIN TO slehasync;=>ALTER USER slehasync DISABLE PASSWORD LIFETIME;Sebagai

SID_LCadm, tentukan kunci penggunaSLEHALOCdi penyimpanan pengguna yang aman SAP HANA (hdbuserstore):>PATH="$PATH:/usr/sap/SID/HDBinst_num/exe">hdbuserstore SET SLEHALOC localhost:3inst_num15 slehasync hdb-user-password

Mencadangkan database

Buat cadangan database Anda guna memulai logging database untuk replikasi sistem SAP HANA dan membuat titik pemulihan.

Jika Anda memiliki beberapa database tenant di konfigurasi MDC, cadangkan setiap database tenant.

Template Deployment Manager menggunakan /hanabackup/data/SID sebagai direktori pencadangan default.

Untuk membuat cadangan database SAP HANA baru:

Di host utama, alihkan ke

SID_LCadm. Bergantung pada image OS Anda, perintahnya mungkin berbeda.sudo -i -u SID_LCadm

Buat cadangan database:

Untuk sistem container-database tunggal SAP HANA:

>hdbsql -t -u system -p SYSTEM_PASSWORD -i INST_NUM \ "backup data using file ('full')"Contoh berikut menunjukkan respons yang berhasil dari sistem SAP HANA baru:

0 rows affected (overall time 18.416058 sec; server time 18.414209 sec)

Untuk sistem multi-database-container (MDC) SAP HANA, buat cadangan database sistem serta database tenant:

>hdbsql -t -d SYSTEMDB -u system -p SYSTEM_PASSWORD -i INST_NUM \ "backup data using file ('full')">hdbsql -t -d SID -u system -p SYSTEM_PASSWORD -i INST_NUM \ "backup data using file ('full')"

Contoh berikut menunjukkan respons yang berhasil dari sistem SAP HANA baru:

0 rows affected (overall time 16.590498 sec; server time 16.588806 sec)

Pastikan mode logging disetel ke normal:

>hdbsql -u system -p SYSTEM_PASSWORD -i INST_NUM \ "select value from "SYS"."M_INIFILE_CONTENTS" where key='log_mode'"Anda akan melihat:

VALUE "normal"

Mengaktifkan replikasi sistem SAP HANA

Sebagai bagian dari pengaktifan replikasi sistem SAP HANA, Anda perlu menyalin data dan file kunci untuk penyimpanan aman SAP HANA di sistem file (SSFS) dari host utama ke host sekunder. Metode yang digunakan prosedur ini untuk menyalin file hanyalah salah satu metode yang dapat Anda gunakan.

Pada host utama sesuai

SID_LCadm, aktifkan replikasi sistem:>hdbnsutil -sr_enable --name=PRIMARY_HOST_NAMEPada host sekunder:

Sebagai

SID_LCadm, hentikan SAP HANA:>HDB stopSebagai root, arsipkan file kunci dan data SSFS yang ada:

#cd /usr/sap/SID/SYS/global/security/rsecssfs/#mv data/SSFS_SID.DAT data/SSFS_SID.DAT-ARC#mv key/SSFS_SID.KEY key/SSFS_SID.KEY-ARCSalin file data dari host utama:

#scp -o StrictHostKeyChecking=no \ PRIMARY_HOST_NAME:/usr/sap/SID/SYS/global/security/rsecssfs/data/SSFS_SID.DAT \ /usr/sap/SID/SYS/global/security/rsecssfs/data/SSFS_SID.DATSalin file kunci dari host utama:

#scp -o StrictHostKeyChecking=no \ PRIMARY_HOST_NAME:/usr/sap/SID/SYS/global/security/rsecssfs/key/SSFS_SID.KEY \ /usr/sap/SID/SYS/global/security/rsecssfs/key/SSFS_SID.KEYPerbarui kepemilikan file:

#chown SID_LCadm:sapsys /usr/sap/SID/SYS/global/security/rsecssfs/data/SSFS_SID.DAT#chown SID_LCadm:sapsys /usr/sap/SID/SYS/global/security/rsecssfs/key/SSFS_SID.KEYPerbarui izin untuk file:

#chmod 644 /usr/sap/SID/SYS/global/security/rsecssfs/data/SSFS_SID.DAT#chmod 640 /usr/sap/SID/SYS/global/security/rsecssfs/key/SSFS_SID.KEYSebagai SID_LCadm, daftarkan sistem SAP HANA sekunder dengan replikasi sistem SAP HANA:

>hdbnsutil -sr_register --remoteHost=PRIMARY_HOST_NAME --remoteInstance=INST_NUM \ --replicationMode=syncmem --operationMode=logreplay --name=SECONDARY_HOST_NAMESebagai SID_LCadm, mulai SAP HANA:

>HDB start

Memvalidasi replikasi sistem

Pada host utama sebagai SID_LCadm, konfirmasi bahwa replikasi sistem SAP

HANA aktif dengan menjalankan skrip python berikut:

$ python $DIR_INSTANCE/exe/python_support/systemReplicationStatus.pyJika replikasi disiapkan dengan benar, di antara indikator lainnya, nilai berikut

akan ditampilkan untuk layanan xsengine, nameserver, dan indexserver:

Secondary Active StatusadalahYES.Replication StatusadalahACTIVE.

Selain itu, overall system replication status menampilkan ACTIVE.

Menginstal paket HA yang diperlukan

Untuk SLES untuk SAP 15 SP6 atau yang lebih baru, sebaiknya gunakan paket SAPHanaSR-angi. Untuk SLES untuk SAP 15 SP5 atau yang lebih lama, Anda dapat menggunakan paket SAPHanaSR.

Untuk menginstal paket

SAPHanaSR, jalankan perintah berikut sebagai pengguna root:zypper install SAPHanaSR

Untuk menginstal paket

SAPHanaSR-angi, jalankan perintah berikut sebagai pengguna root:Jika paket

SAPHanaSRatauSAPHanaSR-docsudah diinstal, hapus paket tersebut:zypper remove SAPHanaSR SAPHanaSR-doc

Menginstal paket

SAPHanaSR-angizypper install SAPHanaSR-angi

Mengaktifkan hook penyedia HA/DR SAP HANA

SUSE merekomendasikan

agar Anda mengaktifkan hook penyedia HA/DR SAP HANA, yang memungkinkan

SAP HANA mengirimkan notifikasi untuk peristiwa tertentu dan meningkatkan deteksi

kegagalan.

Hook penyedia SAP HANA HA/DR

memerlukan SAP HANA 2.0 SPS 03 atau versi yang lebih baru untuk hook SAPHanaSR, dan SAP

HANA 2.0 SPS 05 atau versi yang lebih baru untuk hook SAPHanaSR-angi.

Di situs utama dan sekunder, selesaikan langkah-langkah berikut:

Sebagai

SID_LCadm, hentikan SAP HANA:>HDB stop

Sebagai root atau

SID_LCadm, buka fileglobal.iniuntuk mengedit:>vi /hana/shared/SID/global/hdb/custom/config/global.iniTambahkan definisi berikut ke file

global.ini:SLES untuk SAP 15 SP5 atau yang lebih lama

[ha_dr_provider_SAPHanaSR] provider = SAPHanaSR path = /usr/share/SAPHanaSR/ execution_order = 1 [ha_dr_provider_suschksrv] provider = susChkSrv path = /usr/share/SAPHanaSR/ execution_order = 3 action_on_lost = stop [trace] ha_dr_saphanasr = info

SLES untuk SAP 15 SP6 atau yang lebih baru

[ha_dr_provider_susHanaSR] provider = susHanaSR path = /usr/share/SAPHanaSR-angi execution_order = 1 [ha_dr_provider_suschksrv] provider = susChkSrv path = /usr/share/SAPHanaSR-angi execution_order = 3 action_on_lost = stop [ha_dr_provider_susTkOver] provider = susTkOver path = /usr/share/SAPHanaSR-angi execution_order = 1 sustkover_timeout = 30 [trace] ha_dr_sushanasr = info ha_dr_suschksrv = info ha_dr_sustkover = info

Sebagai root, buat file konfigurasi kustom di direktori

/etc/sudoers.ddengan menjalankan perintah berikut. File konfigurasi baru ini memungkinkan penggunaSID_LCadmmengakses atribut node cluster saat metode hooksrConnectionChanged()dipanggil.>visudo -f /etc/sudoers.d/SAPHanaSRDi file

/etc/sudoers.d/SAPHanaSR, tambahkan teks berikut:SLES untuk SAP 15 SP5 atau yang lebih lama

Ganti kode berikut:

SITE_A: nama situs server SAP HANA utamaSITE_B: nama situs server SAP HANA sekunderSID_LC: SID, yang ditentukan menggunakan huruf kecil

crm_mon -A1 | grep sitesebagai pengguna root, di server utama SAP HANA atau server sekunder.Cmnd_Alias SOK_SITEA = /usr/sbin/crm_attribute -n hana_SID_LC_site_srHook_SITE_A -v SOK -t crm_config -s SAPHanaSR Cmnd_Alias SFAIL_SITEA = /usr/sbin/crm_attribute -n hana_SID_LC_site_srHook_SITE_A -v SFAIL -t crm_config -s SAPHanaSR Cmnd_Alias SOK_SITEB = /usr/sbin/crm_attribute -n hana_SID_LC_site_srHook_SITE_B -v SOK -t crm_config -s SAPHanaSR Cmnd_Alias SFAIL_SITEB = /usr/sbin/crm_attribute -n hana_SID_LC_site_srHook_SITE_B -v SFAIL -t crm_config -s SAPHanaSR SID_LCadm ALL=(ALL) NOPASSWD: SOK_SITEA, SFAIL_SITEA, SOK_SITEB, SFAIL_SITEB

SLES untuk SAP 15 SP6 atau yang lebih baru

Ganti kode berikut:

SITE_A: nama situs server SAP HANA utamaSITE_B: nama situs server SAP HANA sekunderSID_LC: SID, yang ditentukan menggunakan huruf kecil

crm_mon -A1 | grep sitesebagai pengguna root, di server utama SAP HANA atau server sekunder.Cmnd_Alias SOK_SITEA = /usr/sbin/crm_attribute -n hana_SID_LC_site_srHook_SITE_A -v SOK -t crm_config -s SAPHanaSR Cmnd_Alias SFAIL_SITEA = /usr/sbin/crm_attribute -n hana_SID_LC_site_srHook_SITE_A -v SFAIL -t crm_config -s SAPHanaSR Cmnd_Alias SOK_SITEB = /usr/sbin/crm_attribute -n hana_SID_LC_site_srHook_SITE_B -v SOK -t crm_config -s SAPHanaSR Cmnd_Alias SFAIL_SITEB = /usr/sbin/crm_attribute -n hana_SID_LC_site_srHook_SITE_B -v SFAIL -t crm_config -s SAPHanaSR Cmnd_Alias HOOK_HELPER = /usr/bin/SAPHanaSR-hookHelper --sid=SID --case=* SID_LCadm ALL=(ALL) NOPASSWD: SOK_SITEA, SFAIL_SITEA, SOK_SITEB, SFAIL_SITEB

Di file

/etc/sudoersAnda, pastikan teks berikut disertakan:Untuk SLES untuk SAP 15 SP3 atau yang lebih baru:

@includedir /etc/sudoers.d

Untuk versi hingga SLES untuk SAP 15 SP2:

#includedir /etc/sudoers.d

Perhatikan bahwa

#dalam teks ini adalah bagian dari sintaksis dan bukan berarti baris tersebut merupakan komentar.

Sebagai

SID_LCadm, mulai SAP HANA:>HDB startSetelah menyelesaikan konfigurasi cluster untuk SAP HANA, Anda dapat memverifikasi bahwa hook berfungsi dengan benar selama pengujian failover seperti yang dijelaskan dalam Memecahkan masalah hook python SAPHanaSR dan pengambilalihan cluster HA membutuhkan waktu terlalu lama saat kegagalan server indeks HANA.

Mengonfigurasi dukungan failover Cloud Load Balancing

Layanan Load Balancer Jaringan passthrough internal dengan dukungan failover mengarahkan traffic ke host aktif di cluster SAP HANA berdasarkan layanan health check.

Mencadangkan alamat IP untuk IP virtual

Alamat IP virtual (VIP), yang terkadang disebut sebagai alamat IP mengambang, mengikuti sistem SAP HANA yang aktif. Load balancer mengarahkan traffic yang dikirim ke VIP ke VM yang saat ini menghosting sistem SAP HANA yang aktif.

Buka Cloud Shell:

Cadangkan alamat IP untuk IP virtual. Ini adalah alamat IP yang digunakan aplikasi untuk mengakses SAP HANA. Jika Anda mengabaikan flag

--addresses, alamat IP dalam subnet tersebut akan dipilih untuk Anda:$gcloud compute addresses create VIP_NAME \ --region CLUSTER_REGION --subnet CLUSTER_SUBNET \ --addresses VIP_ADDRESSUntuk mengetahui informasi selengkapnya tentang pemesanan IP statis, lihat Memesan alamat IP internal statis.

Konfirmasi reservasi alamat IP:

$gcloud compute addresses describe VIP_NAME \ --region CLUSTER_REGIONAnda akan melihat output yang mirip dengan contoh berikut ini:

address: 10.0.0.19 addressType: INTERNAL creationTimestamp: '2020-05-20T14:19:03.109-07:00' description: '' id: '8961491304398200872' kind: compute#address name: vip-for-hana-ha networkTier: PREMIUM purpose: GCE_ENDPOINT region: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1 selfLink: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1/addresses/vip-for-hana-ha status: RESERVED subnetwork: https://www.googleapis.com/compute/v1/projects/example-project-123456/regions/us-central1/subnetworks/example-subnet-us-central1

Membuat grup instance untuk VM host

Di Cloud Shell, buat dua grup instance tidak terkelola dan tetapkan VM host master utama ke salah satunya dan VM host master sekunder ke VM lainnya:

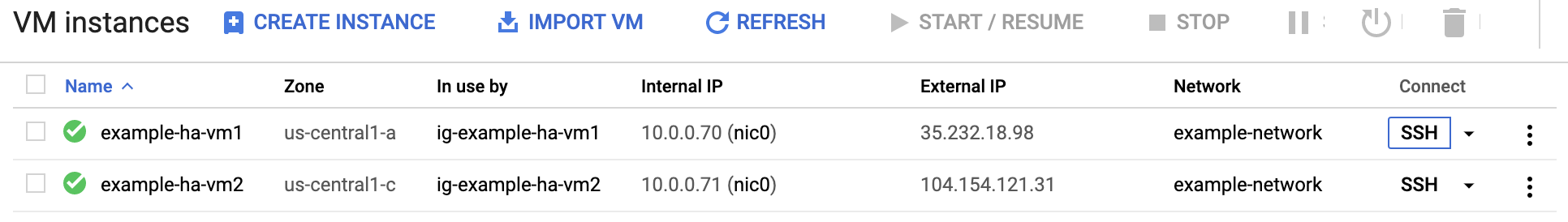

$gcloud compute instance-groups unmanaged create PRIMARY_IG_NAME \ --zone=PRIMARY_ZONE$gcloud compute instance-groups unmanaged add-instances PRIMARY_IG_NAME \ --zone=PRIMARY_ZONE \ --instances=PRIMARY_HOST_NAME$gcloud compute instance-groups unmanaged create SECONDARY_IG_NAME \ --zone=SECONDARY_ZONE$gcloud compute instance-groups unmanaged add-instances SECONDARY_IG_NAME \ --zone=SECONDARY_ZONE \ --instances=SECONDARY_HOST_NAMEKonfirmasi pembuatan grup instance:

$gcloud compute instance-groups unmanaged listAnda akan melihat output yang mirip dengan contoh berikut ini:

NAME ZONE NETWORK NETWORK_PROJECT MANAGED INSTANCES hana-ha-ig-1 us-central1-a example-network example-project-123456 No 1 hana-ha-ig-2 us-central1-c example-network example-project-123456 No 1

Membuat health check Compute Engine

Di Cloud Shell, buat health check. Untuk port yang digunakan oleh health check, pilih port yang berada dalam rentang pribadi, 49152-65535, agar tidak bentrok dengan layanan lain. Nilai interval pemeriksaan dan waktu tunggu sedikit lebih panjang daripada nilai default sehingga dapat meningkatkan toleransi failover selama peristiwa migrasi langsung Compute Engine. Anda dapat menyesuaikan nilainya, jika perlu:

$gcloud compute health-checks create tcp HEALTH_CHECK_NAME --port=HEALTHCHECK_PORT_NUM \ --proxy-header=NONE --check-interval=10 --timeout=10 --unhealthy-threshold=2 \ --healthy-threshold=2Konfirmasi pembuatan health check:

$gcloud compute health-checks describe HEALTH_CHECK_NAMEAnda akan melihat output yang mirip dengan contoh berikut ini:

checkIntervalSec: 10 creationTimestamp: '2020-05-20T21:03:06.924-07:00' healthyThreshold: 2 id: '4963070308818371477' kind: compute#healthCheck name: hana-health-check selfLink: https://www.googleapis.com/compute/v1/projects/example-project-123456/global/healthChecks/hana-health-check tcpHealthCheck: port: 60000 portSpecification: USE_FIXED_PORT proxyHeader: NONE timeoutSec: 10 type: TCP unhealthyThreshold: 2

Membuat aturan firewall untuk health check

Tentukan aturan firewall untuk port dalam rentang pribadi yang mengizinkan akses ke VM host Anda dari rentang IP yang digunakan oleh health check Compute Engine, 35.191.0.0/16 dan 130.211.0.0/22. Untuk mengetahui informasi selengkapnya, lihat Membuat aturan firewall untuk health check.

Jika belum ada, tambahkan tag jaringan ke VM host Anda. Tag jaringan ini digunakan oleh aturan firewall untuk health check.

$gcloud compute instances add-tags PRIMARY_HOST_NAME \ --tags NETWORK_TAGS \ --zone PRIMARY_ZONE$gcloud compute instances add-tags SECONDARY_HOST_NAME \ --tags NETWORK_TAGS \ --zone SECONDARY_ZONEJika belum ada, buat aturan firewall untuk mengizinkan health check:

$gcloud compute firewall-rules create RULE_NAME \ --network NETWORK_NAME \ --action ALLOW \ --direction INGRESS \ --source-ranges 35.191.0.0/16,130.211.0.0/22 \ --target-tags NETWORK_TAGS \ --rules tcp:HLTH_CHK_PORT_NUMContoh:

gcloud compute firewall-rules create fw-allow-health-checks \ --network example-network \ --action ALLOW \ --direction INGRESS \ --source-ranges 35.191.0.0/16,130.211.0.0/22 \ --target-tags cluster-ntwk-tag \ --rules tcp:60000

Mengonfigurasi load balancer dan grup failover

Buat layanan backend load balancer:

$gcloud compute backend-services create BACKEND_SERVICE_NAME \ --load-balancing-scheme internal \ --health-checks HEALTH_CHECK_NAME \ --no-connection-drain-on-failover \ --drop-traffic-if-unhealthy \ --failover-ratio 1.0 \ --region CLUSTER_REGION \ --global-health-checksTambahkan grup instance utama ke layanan backend:

$gcloud compute backend-services add-backend BACKEND_SERVICE_NAME \ --instance-group PRIMARY_IG_NAME \ --instance-group-zone PRIMARY_ZONE \ --region CLUSTER_REGIONTambahkan grup instance failover sekunder ke layanan backend:

$gcloud compute backend-services add-backend BACKEND_SERVICE_NAME \ --instance-group SECONDARY_IG_NAME \ --instance-group-zone SECONDARY_ZONE \ --failover \ --region CLUSTER_REGIONMembuat aturan penerusan. Untuk alamat IP, tentukan alamat IP yang Anda reservasi untuk VIP. Jika Anda perlu mengakses sistem SAP HANA dari luar region yang ditentukan di bawah, sertakan flag

--allow-global-accessdalam definisi:$gcloud compute forwarding-rules create RULE_NAME \ --load-balancing-scheme internal \ --address VIP_ADDRESS \ --subnet CLUSTER_SUBNET \ --region CLUSTER_REGION \ --backend-service BACKEND_SERVICE_NAME \ --ports ALLUntuk mengetahui informasi selengkapnya tentang akses lintas region ke sistem ketersediaan tinggi SAP HANA, lihat Load Balancing TCP/UDP Internal.

Menguji konfigurasi load balancer

Meskipun grup backend instance Anda tidak akan dianggap berfungsi dengan baik hingga nanti, Anda dapat menguji konfigurasi load balancer dengan menyiapkan pemroses untuk merespons health check. Setelah menyiapkan pemroses, jika load balancer dikonfigurasi dengan benar, status grup backend instance akan berubah menjadi berfungsi dengan baik.

Bagian berikut menyajikan berbagai metode yang dapat Anda gunakan untuk menguji konfigurasi.

Menguji load balancer dengan utilitas socat

Anda dapat menggunakan utilitas socat untuk memproses sementara port health check. Anda tetap harus menginstal utilitas socat, karena

Anda akan menggunakannya nanti saat mengonfigurasi resource cluster.

Pada kedua VM host sebagai root, instal utilitas

socat:#zypper install -y socatMulai proses

socatuntuk memproses selama 60 detik di port health check:#timeout 60s socat - TCP-LISTEN:HLTH_CHK_PORT_NUM,forkDi Cloud Shell, setelah menunggu beberapa detik hingga health check mendeteksi pemroses, periksa kondisi grup backend instance Anda:

$gcloud compute backend-services get-health BACKEND_SERVICE_NAME \ --region CLUSTER_REGIONAnda akan melihat output yang mirip dengan berikut ini:

--- backend: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-a/instanceGroups/hana-ha-ig-1 status: healthStatus: ‐ healthState: HEALTHY instance: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-a/instances/hana-ha-vm-1 ipAddress: 10.0.0.35 port: 80 kind: compute#backendServiceGroupHealth --- backend: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instanceGroups/hana-ha-ig-2 status: healthStatus: ‐ healthState: HEALTHY instance: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instances/hana-ha-vm-2 ipAddress: 10.0.0.34 port: 80 kind: compute#backendServiceGroupHealth

Menguji load balancer menggunakan port 22

Jika port 22 terbuka untuk koneksi SSH pada VM host, Anda dapat mengedit sementara health checker agar menggunakan port 22, yang memiliki pemroses untuk merespons health checker.

Agar dapat menggunakan port 22 untuk sementara, ikuti langkah-langkah berikut:

Klik health check di konsol:

Klik Edit.

Di kolom Port, ubah nomor port menjadi 22.

Klik Save dan tunggu satu atau dua menit.

Di Cloud Shell, periksa kondisi grup backend instance Anda:

$gcloud compute backend-services get-health BACKEND_SERVICE_NAME \ --region CLUSTER_REGIONAnda akan melihat output yang mirip dengan berikut ini:

--- backend: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-a/instanceGroups/hana-ha-ig-1 status: healthStatus: ‐ healthState: HEALTHY instance: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-a/instances/hana-ha-vm-1 ipAddress: 10.0.0.35 port: 80 kind: compute#backendServiceGroupHealth --- backend: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instanceGroups/hana-ha-ig-2 status: healthStatus: ‐ healthState: HEALTHY instance: https://www.googleapis.com/compute/v1/projects/example-project-123456/zones/us-central1-c/instances/hana-ha-vm-2 ipAddress: 10.0.0.34 port: 80 kind: compute#backendServiceGroupHealth

Setelah selesai, ubah nomor port health check kembali ke nomor port asli.

Menyiapkan Pacemaker

Prosedur berikut mengonfigurasi implementasi SUSE cluster Pacemaker di VM Compute Engine untuk SAP HANA.

Untuk informasi selengkapnya tentang cara mengonfigurasi cluster ketersediaan tinggi di SLES, lihat dokumentasi Ekstensi Ketersediaan Tinggi SUSE Linux Enterprise untuk versi SLES Anda.

Membuat file konfigurasi Corosync

Buat file konfigurasi Corosync di host utama:

Buat file berikut:

vi /etc/corosync/corosync.conf

Pada file

corosync.confdi host utama, tambahkan konfigurasi berikut, yang mengganti teks variabel miring dengan nilai Anda:totem { version: 2 secauth: off crypto_hash: sha1 crypto_cipher: aes256 cluster_name: hacluster clear_node_high_bit: yes token: 20000 token_retransmits_before_loss_const: 10 join: 60 max_messages: 20 transport: udpu interface { ringnumber: 0 Bindnetaddr: static-ip-of-hdb-on-this-host mcastport: 5405 ttl: 1 } } logging { fileline: off to_stderr: no to_logfile: no logfile: /var/log/cluster/corosync.log to_syslog: yes debug: off timestamp: on logger_subsys { subsys: QUORUM debug: off } } nodelist { node { ring0_addr: this-host-name nodeid: 1 } node { ring0_addr: other-host-name nodeid: 2 } } quorum { provider: corosync_votequorum expected_votes: 2 two_node: 1 }

Buat file konfigurasi Corosync di host sekunder dengan mengulangi langkah-langkah yang sama dengan yang Anda gunakan untuk host utama. Kecuali untuk IP statis HDB pada properti

Bindnetaddrdan urutan nama host dalamnodelist, nilai properti file konfigurasi sama untuk setiap host.

Menginisialisasi cluster

Pada host utama sebagai root:

Ubah sandi untuk pengguna

hacluster:#passwd haclusterLakukan inisialisasi cluster:

#corosync-keygen#crm cluster init --yes ssh#crm cluster init -y csync2Mulai Pacemaker di host utama:

#systemctl enable pacemaker#systemctl start pacemaker

Pada host sekunder sebagai root:

Ubah sandi untuk pengguna

hacluster:#passwd haclusterGabungkan host sekunder ke cluster yang diinisialisasi pada host utama:

#crm cluster join --yes ssh#crm cluster join -y -c primary-host-name csync2Mulai Pacemaker di host sekunder:

#systemctl enable pacemaker#systemctl start pacemaker

Di salah satu host sebagai root, pastikan cluster menunjukkan kedua node:

#crm_mon -sAnda akan melihat output yang mirip dengan berikut ini:

CLUSTER OK: 2 nodes online, 0 resources configured

Menyiapkan pemagaran

Anda dapat menyiapkan pemagaran dengan menentukan resource cluster dengan agen fence untuk setiap VM host.

Untuk memastikan urutan peristiwa yang benar setelah tindakan pemagaran, Anda juga mengonfigurasi sistem operasi untuk menunda mulai ulang Corosync setelah VM diberi pagar. Anda juga perlu menyesuaikan waktu tunggu Pacemaker untuk memulai ulang guna memperhitungkan penundaan.

Membuat resource perangkat pagar

Pada host utama sebagai root, buat resource pagar:

#crm configure primitive STONITH-"primary-host-name" stonith:fence_gce \ op monitor interval="300s" timeout="120s" \ op start interval="0" timeout="60s" \ params port="primary-host-name" zone="primary-zone" project="project_id" \ pcmk_reboot_timeout=300 pcmk_monitor_retries=4 pcmk_delay_max=30#crm configure primitive STONITH-"secondary-host-name" stonith:fence_gce \ op monitor interval="300s" timeout="120s" \ op start interval="0" timeout="60s" \ params port="secondary-host-name" zone="secondary-zone" project="project_id" \ pcmk_reboot_timeout=300 pcmk_monitor_retries=4Tetapkan lokasi setiap perangkat pagar:

#crm configure location LOC_STONITH_"primary-host-name" \ STONITH-"primary-host-name" -inf: "primary-host-name"#crm configure location LOC_STONITH_"secondary-host-name" \ STONITH-"secondary-host-name" -inf: "secondary-host-name"

Mengonfigurasi cluster

Untuk mengonfigurasi cluster, tentukan properti cluster umum dan resource primitif cluster.

Mengaktifkan mode pemeliharaan

Pada salah satu host sebagai root, tempatkan cluster dalam mode pemeliharaan:

#crm configure property maintenance-mode="true"

Mengonfigurasi properti cluster umum

Pada host utama, tetapkan properti cluster umum:

#crm configure property stonith-timeout="300s"#crm configure property stonith-enabled="true"#crm configure rsc_defaults resource-stickiness="1000"#crm configure rsc_defaults migration-threshold="5000"#crm configure op_defaults timeout="600"

Menetapkan penundaan untuk memulai ulang Corosync

Pada kedua host sebagai root, buat file drop-in

systemdyang menunda startup Corosync untuk memastikan urutan peristiwa yang tepat setelah VM dengan pagar dimulai ulang:systemctl edit corosync.service

Tambahkan baris berikut ke file:

[Service] ExecStartPre=/bin/sleep 60

Simpan file dan keluar dari editor.

Muat ulang konfigurasi pengelola sistem.

systemctl daemon-reload

Pastikan bahwa file drop-in telah dibuat:

service corosync status

Anda semestinya akan melihat baris untuk file drop-in, seperti yang ditunjukkan pada contoh berikut:

● corosync.service - Corosync Cluster Engine Loaded: loaded (/usr/lib/systemd/system/corosync.service; disabled; vendor preset: disabled) Drop-In: /etc/systemd/system/corosync.service.d └─override.conf Active: active (running) since Tue 2021-07-20 23:45:52 UTC; 2 days ago

Membuat resource IP cluster lokal untuk alamat VIP

Untuk mengonfigurasi alamat VIP di sistem operasi, buat resource IP cluster lokal untuk alamat VIP yang Anda cadangkan sebelumnya:

# crm configure primitive rsc_vip_int-primary IPaddr2 \

params ip=vip-address cidr_netmask=32 nic="eth0" op monitor interval=3600s timeout=60sMenyiapkan layanan health check bantuan

Load balancer menggunakan pemroses pada port health check setiap host untuk menentukan tempat instance utama cluster SAP HANA berjalan.

Untuk mengelola pemroses di cluster, Anda harus membuat resource untuk pemroses.

Petunjuk ini menggunakan utilitas socat sebagai pemroses.

Pada kedua host sebagai root, instal

socat utility:#zypper in -y socatPada host utama, buat resource untuk layanan health check bantuan:

#crm configure primitive rsc_healthcheck-primary anything \ params binfile="/usr/bin/socat" \ cmdline_options="-U TCP-LISTEN:healthcheck-port-num,backlog=10,fork,reuseaddr /dev/null" \ op monitor timeout=20s interval=10s \ op_params depth=0

Mengelompokkan resource VIP dan resource layanan health check bantuan

Kelompokkan resource VIP dan resource layanan health check bantuan:

# crm configure group g-primary rsc_vip_int-primary rsc_healthcheck-primary meta resource-stickiness=0Membuat resource primitif SAPHanaTopology

Anda menentukan resource primitif SAPHanaTopology dalam file konfigurasi sementara, yang kemudian diupload ke Corosync.

Pada host utama sebagai root:

Buat file konfigurasi sementara untuk parameter konfigurasi

SAPHanaTopology:#vi /tmp/cluster.tmpSalin dan tempel definisi resource SAPHanaTopology ke dalam file

/tmp/cluster.tmp:SLES untuk SAP 15 SP5 atau yang lebih lama

primitive rsc_SAPHanaTopology_SID_HDBinst_num ocf:suse:SAPHanaTopology \ operations \$id="rsc_sap2_SID_HDBinst_num-operations" \ op monitor interval="10" timeout="600" \ op start interval="0" timeout="600" \ op stop interval="0" timeout="300" \ params SID="SID" InstanceNumber="inst_num" clone cln_SAPHanaTopology_SID_HDBinst_num rsc_SAPHanaTopology_SID_HDBinst_num \ meta clone-node-max="1" target-role="Started" interleave="true"

SLES untuk SAP 15 SP6 atau yang lebih baru

primitive rsc_SAPHanaTopology_SID_HDBinst_num ocf:suse:SAPHanaTopology \ operations \$id="rsc_sap2_SID_HDBinst_num-operations" \ op monitor interval="10" timeout="600" \ op start interval="0" timeout="600" \ op stop interval="0" timeout="300" \ params SID="SID" InstanceNumber="inst_num" clone cln_SAPHanaTopology_SID_HDBinst_num rsc_SAPHanaTopology_SID_HDBinst_num \ meta clone-node-max="1" interleave="true"

Edit file

/tmp/cluster.tmpuntuk mengganti teks variabel dengan SID dan nomor instance untuk sistem SAP HANA Anda.Pada resource utama sebagai root, muat konten file

/tmp/cluster.tmpke Corosync:crm configure load update /tmp/cluster.tmp

Membuat resource primitif SAPHana atau SAPHanaController

Anda menentukan resource menggunakan metode yang sama dengan yang

Anda gunakan untuk resource SAPHanaTopology: dalam file konfigurasi sementara, yang kemudian Anda upload ke Corosync.

Ganti file konfigurasi sementara:

#rm /tmp/cluster.tmp#vi /tmp/cluster.tmpSalin dan tempel definisi resource ke dalam file

/tmp/cluster.tmp:SLES untuk SAP 15 SP5 atau yang lebih lama

primitive rsc_SAPHana_SID_HDBinst_num ocf:suse:SAPHana \ operations \$id="rsc_sap_SID_HDBinst_num-operations" \ op start interval="0" timeout="3600" \ op stop interval="0" timeout="3600" \ op promote interval="0" timeout="3600" \ op demote interval="0" timeout="3600" \ op monitor interval="60" role="Master" timeout="700" \ op monitor interval="61" role="Slave" timeout="700" \ params SID="SID" InstanceNumber="inst_num" PREFER_SITE_TAKEOVER="true" DUPLICATE_PRIMARY_TIMEOUT="7200" AUTOMATED_REGISTER="true" ms msl_SAPHana_SID_HDBinst_num rsc_SAPHana_SID_HDBinst_num \ meta notify="true" clone-max="2" clone-node-max="1" \ target-role="Started" interleave="true" colocation col_saphana_ip_SID_HDBinst_num 4000: g-primary:Started \ msl_SAPHana_SID_HDBinst_num:Master order ord_SAPHana_SID_HDBinst_num Optional: cln_SAPHanaTopology_SID_HDBinst_num \ msl_SAPHana_SID_HDBinst_num

SLES untuk SAP 15 SP6 atau yang lebih baru

primitive rsc_SAPHana_SID_HDBinst_num ocf:suse:SAPHanaController \ operations \$id="rsc_sap_SID_HDBinst_num-operations" \ op start interval="0" timeout="3600" \ op stop interval="0" timeout="3600" \ op promote interval="0" timeout="3600" \ op demote interval="0" timeout="3600" \ op monitor interval="60" role="Promoted" timeout="700" \ op monitor interval="61" role="Unpromoted" timeout="700" \ params SID="SID" InstanceNumber="inst_num" PREFER_SITE_TAKEOVER="true" \ DUPLICATE_PRIMARY_TIMEOUT="7200" AUTOMATED_REGISTER="true" clone mst_SAPHana_SID_HDBinst_num rsc_SAPHana_SID_HDBinst_num \ meta clone-node-max="1" interleave="true" promotable="true" colocation col_saphana_ip_SID_HDBinst_num 4000: g-primary:Started \ mst_SAPHana_SID_HDBinst_num:Promoted order ord_SAPHana_SID_HDBinst_num Optional: cln_SAPHanaTopology_SID_HDBinst_num \ mst_SAPHana_SID_HDBinst_num

Untuk cluster SAP HANA HA multi-tingkat, jika Anda menggunakan versi yang lebih lama dari SAP HANA 2.0 SP03, tetapkan

AUTOMATED_REGISTERkefalse. Hal ini mencegah instance yang dipulihkan mencoba mendaftar secara mandiri untuk replikasi ke sistem HANA yang telah memiliki target replikasi yang telah dikonfigurasi. Untuk SAP HANA 2.0 SP03 atau yang lebih baru, Anda dapat menetapkanAUTOMATED_REGISTERketrueuntuk konfigurasi SAP HANA yang menggunakan replikasi sistem multitingkat.Untuk informasi tambahan, lihat:

Pada resource utama sebagai root, muat konten file

/tmp/cluster.tmpke Corosync:crm configure load update /tmp/cluster.tmp

Membuat resource primitif SAPHanaFilesystem

Bagian ini hanya berlaku jika Anda menggunakan hook SAPHanaSR-angi. Jika

menggunakan hook SAPHanaSR, Anda dapat melewati bagian ini.

Anda membuat resource SAPHanaFilesystem menggunakan metode yang sama dengan yang

Anda gunakan untuk resource SAPHanaTopology: dalam file konfigurasi sementara,

yang kemudian Anda upload ke Corosync.

Ganti file konfigurasi sementara:

rm /tmp/cluster.tmp vi /tmp/cluster.tmp

Salin dan tempel definisi resource

SAPHanake dalam file/tmp/cluster.tmp:primitive rsc_SAPHanaFileSystem_SID_HDBinst_num ocf:suse:SAPHanaFilesystem \ operations \$id="rsc_sap3_SID_HDBinst_num-operations" \ op monitor interval="10" timeout="600" \ op start interval="0" timeout="600" \ op stop interval="0" timeout="300" \ params SID="SID" InstanceNumber="inst_num" clone cln_SAPHanaFileSystem_SID_HDBinst_num rsc_SAPHanaFileSystem_SID_HDBinst_num \ meta clone-node-max="1 interleave="true"

Mengonfirmasi replikasi sistem SAP HANA aktif

Pada host utama, sebagai

SID_LCadm, login ke terminal interaktif database SAP HANA:>hdbsql -u system -p "system-password" -i inst_numDi terminal interaktif, periksa status replikasi:

=>select distinct REPLICATION_STATUS from SYS.M_SERVICE_REPLICATIONREPLICATION_STATUSharus"ACTIVE".

Atau, Anda dapat memeriksa status replikasi dengan menjalankan skrip

python berikut sebagai SID_LCadm:

# python $DIR_INSTANCE/exe/python_support/systemReplicationStatus.pyMengaktifkan cluster

Pada host utama sebagai root, keluarkan cluster dari mode pemeliharaan:

#crm configure property maintenance-mode="false"Jika Anda menerima perintah yang meminta Anda untuk menghapus "pemeliharaan", masukkan

y.Tunggu 15 detik, lalu periksa status cluster pada host utama:

#crm statusContoh berikut menunjukkan status cluster yang aktif dan dikonfigurasi dengan benar:

SLES untuk SAP 15 SP5 atau yang lebih lama

Stack: corosync Current DC: hana-ha-vm-1 (version 2.0.1+20190417.13d370ca9-3.9.1-2.0.1+20190417.13d370ca9) - partition with quorum Last updated: Sun Jun 7 00:36:56 2020 Last change: Sun Jun 7 00:36:53 2020 by root via crm_attribute on hana-ha-vm-1 2 nodes configured 8 resources configured Online: [ hana-ha-vm-1 hana-ha-vm-2 ] Full list of resources: STONITH-hana-ha-vm-1 (stonith:fence_gce): Started hana-ha-vm-2 STONITH-hana-ha-vm-2 (stonith:fence_gce): Started hana-ha-vm-1 Clone Set: cln_SAPHanaTopology_HA1_HDB22 [rsc_SAPHanaTopology_HA1_HDB22] Started: [ hana-ha-vm-1 hana-ha-vm-2 ] Resource Group: g-primary rsc_vip_int-primary (ocf::heartbeat:IPaddr2): Started hana-ha-vm-1 rsc_healthcheck-primary (ocf::heartbeat:anything): Started hana-ha-vm-1 Clone Set: msl_SAPHana_HA1_HDB22 [rsc_SAPHana_HA1_HDB22] (promotable) Masters: [ hana-ha-vm-1 ] Slaves: [ hana-ha-vm-2 ]SLES untuk SAP 15 SP6 atau yang lebih baru

Stack: corosync Current DC: hana-ha-vm-1 (version 2.1.7+20231219.0f7f88312-150600.6.3.1-2.1.7+20231219.0f7f88312) - partition with quorum Last updated: Tue Oct 15 03:26:11 2024 Last change: Tue Oct 15 03:26:08 2024 by root via via crm_attribute on hana-ha-vm-1 2 nodes configured 10 resources configured Online: [ hana-ha-vm-1 hana-ha-vm-2 ] Full list of resources: STONITH-hana-ha-vm-1 (stonith:fence_gce): Started hana-ha-vm-2 STONITH-hana-ha-vm-2 (stonith:fence_gce): Started hana-ha-vm-1 Resource Group: g-primary rsc_vip_int-primary (ocf::heartbeat:IPaddr2): Started hana-ha-vm-1 rsc_healthcheck-primary (ocf::heartbeat:anything): Started hana-ha-vm-1 Clone Set: cln_SAPHanaTopology_HA1_HDB22 [rsc_SAPHanaTopology_HA1_HDB22] Started: [ hana-ha-vm-1 hana-ha-vm-2 ] Clone Set: cln_SAPHanaFileSystem_HA1_HDB22 [rsc_SAPHanaFilesystem_HA1_HDB22] Started: [ hana-ha-vm-1 hana-ha-vm-2 ] Clone Set: mst_SAPHana_HA1_HDB22 [rsc_SAPHana_HA1_HDB22] (promotable) Masters: [ hana-ha-vm-1 ] Slaves: [ hana-ha-vm-2 ]

Menguji failover

Uji cluster Anda dengan menyimulasikan kegagalan pada host utama. Gunakan sistem pengujian atau jalankan pengujian pada sistem produksi Anda sebelum sistem dirilis untuk digunakan.

Cadangkan sistem sebelum pengujian.

Anda dapat menyimulasikan kegagalan dengan berbagai cara, termasuk:

HDB stopHDB killreboot(di node aktif)ip link set eth0 downuntuk instance dengan satu antarmuka jaringaniptables ... DROPuntuk instance dengan beberapa antarmuka jaringanecho c > /proc/sysrq-trigger

Petunjuk ini menggunakan ip link set eth0 down atau iptables untuk menyimulasikan gangguan jaringan antara dua host Anda dalam cluster. Gunakan perintah ip link

pada instance dengan satu antarmuka jaringan dan gunakan perintah iptables

pada instance dengan satu atau beberapa antarmuka jaringan. Pengujian ini memvalidasi

failover serta fencing. Jika instance Anda memiliki beberapa antarmuka jaringan yang ditentukan, Anda dapat menggunakan perintah iptables di host sekunder untuk menghentikan traffic masuk dan keluar berdasarkan IP yang digunakan oleh host utama untuk komunikasi cluster, sehingga menyimulasikan hilangnya koneksi jaringan ke host utama.

Pada host yang aktif, sebagai root, buat antarmuka jaringan menjadi offline:

#ip link set eth0 downAtau, jika beberapa antarmuka jaringan aktif, gunakan

iptablesdi host sekunder:#iptables -A INPUT -s PRIMARY_CLUSTER_IP -j DROP; iptables -A OUTPUT -d PRIMARY_CLUSTER_IP -j DROPHubungkan kembali ke host menggunakan SSH dan ubah ke pengguna root.

Masukkan

crm statusuntuk mengonfirmasi bahwa host utama kini aktif di VM yang sebelumnya berisi host sekunder. Mulai ulang otomatis diaktifkan dalam cluster, sehingga host yang dihentikan akan memulai ulang dan mengambil peran host sekunder, seperti yang ditunjukkan dalam contoh berikut.SLES untuk SAP 15 SP5 atau yang lebih lama