Neste guia, você verá como usar o Cloud Deployment Manager para implantar um sistema de escalonamento horizontal do SAP HANA que inclui a solução de recuperação de falhas de failover automático do host do SAP HANA. O uso do Deployment Manager permite a implantação de um sistema que atenda aos requisitos de suporte da SAP e a adoção das práticas recomendadas da SAP e do Compute Engine.

O sistema SAP HANA resultante inclui um host mestre, até 15 hosts workers e até 3 hosts em espera, todos em uma única zona do Compute Engine.

O sistema também inclui o

gerenciador de armazenamentoGoogle Cloud para nós de espera do SAP HANA (gerenciador de armazenamento do SAP HANA), que

gerencia a transferência de dispositivos de armazenamento para o nó de espera durante um failover.

O gerenciador de armazenamento para SAP HANA está instalado no volume /shared do SAP HANA.

Para informações sobre o gerenciador de armazenamento do SAP HANA e as permissões necessárias do IAM,

consulte O gerenciador de armazenamento do SAP HANA.

Se for necessário implantar o SAP HANA em um cluster de alta disponibilidade do Linux, use um dos guias a seguir:

- O Guia de configuração do cluster de alta disponibilidade do Deployment Manager: SAP HANA

- Guia de configuração de cluster de alta disponibilidade para SAP HANA no RHEL

- O Guia de configuração de cluster de alta disponibilidade para SAP HANA no SLES

Este guia é para usuários avançados do SAP HANA familiarizados com as configurações de escalonamento horizontal da SAP que incluem hosts em espera para alta disponibilidade e sistemas de arquivos de rede.

Pré-requisitos

Antes de criar o sistema de escalonamento horizontal de alta disponibilidade do SAP HANA, certifique-se de que os seguintes pré-requisitos sejam atendidos:

- Você leu o Guia de planejamento do SAP HANA e o Guia de planejamento de alta disponibilidade do SAP HANA.

- Você ou sua organização têm uma conta do Google Cloud e criaram um projeto para a implantação do SAP HANA. Para saber informações sobre como criar Google Cloud contas e projetos, consulte Como configurar sua Conta do Google no Guia de implantação do SAP HANA.

- Se você precisar que a carga de trabalho da SAP seja executada em conformidade com residência de dados, controle de acesso, equipes de suporte ou requisitos regulatórios, crie a pasta do Assured Workloads necessária. Para mais informações, consulte Controles soberanos e de conformidade para a SAP no Google Cloud.

- A mídia de instalação do SAP HANA está armazenada em um bucket do Cloud Storage disponível no projeto e na região de implantação. Para informações sobre como carregar a mídia de instalação do SAP HANA em um bucket do Cloud Storage, consulte Como criar um bucket do Cloud Storage, no guia de implantação do SAP HANA.

- Você tem uma solução de NFS, como a

Filestore gerenciada, para compartilhar os volumes

/hana/sharede/hanabackupdo SAP HANA entre os hosts no sistema de escalonamento horizontal do SAP HANA. Especifique os pontos de montagem dos servidores NFS no arquivo de configuração do Deployment Manager antes de implantar o sistema. Para implantar servidores NFS do Filestore, veja Como criar instâncias. A comunicação precisa ser permitida entre todas as VMs na sub-rede do SAP HANA que hospedam um nó de escalonamento horizontal do SAP HANA.

Se o login do SO estiver ativado nos metadados do projeto, você precisará desativar o login do SO temporariamente até que a implantação seja concluída. Para fins de implantação, este procedimento configura chaves SSH em metadados de instâncias. Quando o login do SO é ativado, as configurações de chave SSH baseadas em metadados são desativadas e a implantação falha. Após a conclusão da implantação, ative o login do SO novamente.

Veja mais informações em:

Criar uma rede

Por motivos de segurança, crie uma nova rede. Para controlar quem tem acesso a ela, adicione regras de firewall ou use outro método de controle de acesso.

Caso o projeto tenha uma rede VPC padrão, não a use. Em vez disso, crie sua própria rede VPC para que as únicas regras de firewall aplicadas sejam aquelas criadas explicitamente por você.

Durante a implantação, as instâncias do Compute Engine geralmente exigem acesso à Internet para fazer o download do agente do Google Cloudpara SAP. Se você estiver usando uma das imagens do Linux certificadas pela SAP disponíveis em Google Cloud, a instância de computação também precisará de acesso à Internet para registrar a licença e acessar repositórios de fornecedores do sistema operacional. Uma configuração com um gateway NAT e tags de rede da VM é compatível com esse acesso, mesmo que as instâncias de computação de destino não tenham IPs externos.

Para configurar a rede:

Console

- No Google Cloud console, acesse a página Redes VPC.

- Clique em Criar rede VPC.

- Digite um Nome para a rede.

O nome precisa seguir a convenção de nomenclatura. As redes VPC usam a convenção de nomenclatura do Compute Engine.

- Em Modo de criação da sub-rede, escolha Custom.

- Na seção Nova sub-rede, especifique os parâmetros de configuração a seguir para uma sub-rede:

- Insira um Nome para a sub-rede.

- Em Região, selecione a região do Compute Engine em que você quer criar a sub-rede.

- Em Tipo de pilha de IP, selecione IPv4 (pilha única) e insira um intervalo

de endereços IP no

formato CIDR. ,

como

10.1.0.0/24.Esse é o intervalo principal de IPv4 da sub-rede. Se você planeja adicionar mais de uma sub-rede, atribua intervalos IP CIDR não sobrepostos para cada sub-rede na rede. Observe que cada sub-rede e os respectivos intervalos IP internos são mapeados para uma única região.

- Clique em Concluído.

- Para adicionar mais sub-redes, clique em Adicionar sub-rede e repita as etapas anteriores. É possível adicionar mais sub-redes à rede depois de criá-la.

- Clique em Criar.

gcloud

- Acesse o Cloud Shell.

- Para criar uma nova rede no modo de sub-redes personalizadas, execute:

gcloud compute networks create NETWORK_NAME --subnet-mode custom

Substitua

NETWORK_NAMEpelo nome da nova rede. O nome precisa seguir a convenção de nomenclatura. As redes VPC usam a convenção de nomenclatura do Compute Engine.Especifique

--subnet-mode custompara evitar o uso do modo automático padrão, que cria automaticamente uma sub-rede em cada região do Compute Engine. Para mais informações, consulte Modo de criação da sub-rede. - Crie uma sub-rede e especifique a região e o intervalo de IP:

gcloud compute networks subnets create SUBNETWORK_NAME \ --network NETWORK_NAME --region REGION --range RANGESubstitua:

SUBNETWORK_NAME: o nome da nova sub-rede.NETWORK_NAME: o nome da rede que você criou na etapa anterior;REGION: a região em que você quer a sub-rede;RANGE: o intervalo de endereços IP, especificado no formato CIDR. Por exemplo,10.1.0.0/24Se você planeja adicionar mais de uma sub-rede, atribua intervalos IP CIDR não sobrepostos para cada sub-rede na rede. Observe que cada sub-rede e os respectivos intervalos IP internos são mapeados para uma única região.

- Se quiser, repita o passo anterior e adicione mais sub-redes.

Como configurar um gateway NAT

Se você precisar criar uma ou mais VMs sem endereços IP públicos, será necessário usar a conversão de endereços de rede (NAT) para permitir que as VMs acessem a Internet. Use o Cloud NAT, um Google Cloud serviço gerenciado distribuído e definido por software que permite que as VMs enviem pacotes de saída para a Internet e recebam todos os pacotes de resposta de entrada estabelecidos. Se preferir, é possível configurar uma VM separada como um gateway NAT.

Para criar uma instância do Cloud NAT para seu projeto, consulte Como usar o Cloud NAT.

Depois de configurar o Cloud NAT para seu projeto, as instâncias de VM poderão acessar a Internet com segurança sem um endereço IP público.

Como adicionar regras de firewall

Por padrão, uma regra de firewall implícita bloqueia conexões de entrada de fora da rede de nuvem privada virtual (VPC). Para permitir conexões de entrada, configure uma regra de firewall para sua VM. Depois que uma conexão de entrada for estabelecida com uma VM, será permitido o tráfego nas duas direções nessa conexão.

Também é possível criar uma regra de firewall para permitir o acesso externo a portas especificadas

ou para restringir o acesso entre as VMs na mesma rede. Se o tipo de rede VPC default for usado, algumas regras padrão complementares também serão aplicadas, como a regra default-allow-internal, que permite a conectividade entre VMs na mesma rede em todas as portas.

Dependendo da política de TI que for aplicada ao ambiente, pode ser necessário isolar ou então restringir a conectividade com o host do banco de dados, o que pode ser feito criando regras de firewall.

Dependendo do seu cenário, é possível criar regras de firewall para permitir o acesso para estes itens:

- Portas padrão do SAP listadas no TCP/IP de Todos os Produtos SAP.

- Conexões do seu computador ou do ambiente de rede corporativa para a instância de VM do Compute Engine. Se você não tiver certeza do endereço IP a ser usado, fale com o administrador de redes da sua empresa.

- A comunicação entre VMs na sub-rede do SAP HANA, incluindo a comunicação entre nós em um sistema de escalonamento horizontal do SAP HANA ou a comunicação entre o servidor de banco de dados e os servidores de aplicativos em uma arquitetura de três níveis. É possível ativar a comunicação entre as VMs criando uma regra de firewall para permitir o tráfego proveniente da sub-rede.

Para criar uma regra de firewall:

Console

No Google Cloud console, acesse a página Firewall da rede VPC.

Na parte superior da página, clique em Criar regra de firewall.

- No campo Rede, selecione a rede em que a VM está localizada.

- No campo Destinos, especifique os recursos no Google Cloud a que esta regra se aplica. Por exemplo, especifique Todas as instâncias na rede. Ou para limitar a regra a instâncias específicas no Google Cloud, insira tags em Tags de destino especificadas.

- No campo Filtro de origem, selecione uma das opções a seguir:

- Intervalos de IP para permitir tráfego de entrada de endereços IP específicos. Especifique o intervalo de endereços IP no campo Intervalos de IPs de origem.

- Sub-redes para permitir tráfego de entrada de uma determinada sub-rede. Especifique o nome da sub-rede no campo Sub-redes a seguir. É possível usar esta opção para permitir acesso entre as VMs na configuração em três níveis ou de escalonamento horizontal.

- Na seção Protocolos e portas, selecione Portas e protocolos especificados e insira

tcp:PORT_NUMBER.

Clique em Criar para criar a regra de firewall.

gcloud

Crie uma regra de firewall usando o seguinte comando:

$ gcloud compute firewall-rules create FIREWALL_NAME

--direction=INGRESS --priority=1000 \

--network=NETWORK_NAME --action=ALLOW --rules=PROTOCOL:PORT \

--source-ranges IP_RANGE --target-tags=NETWORK_TAGSComo criar um sistema de escalonamento horizontal do SAP HANA com hosts em espera

Nas instruções abaixo, conclua as seguintes ações:

- Criar o sistema SAP HANA invocando o Deployment Manager com um modelo para arquivo de configuração concluído.

- Verificar a implantação.

- Testar os hosts em espera simulando uma falha de host.

Algumas das etapas nas instruções a seguir usam o Cloud Shell para inserir os comandos gcloud. Se você tiver a versão mais recente da Google Cloud CLI

instalada, insira os comandos gcloud em um terminal local.

Definir e criar o sistema SAP HANA

Nas etapas seguintes, faça o download e conclua um modelo de arquivo de configuração do Deployment Manager invocando o Deployment Manager, que implanta VMs, discos permanentes e instâncias do SAP HANA.

Verifique se suas cotas atuais para recursos de projeto, como discos permanentes e CPUs, são suficientes para o sistema SAP HANA que está prestes a ser instalado. Se as cotas não forem suficientes, a implantação falhará. Para ver os requisitos de cotas do SAP HANA, consulte Considerações sobre preços e cotas para SAP HANA.

Abra o Cloud Shell.

Faça o download do modelo de arquivo de configuração

template.yamlpara o sistema de escalonamento horizontal de alta disponibilidade do SAP HANA em seu diretório de trabalho:wget https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_hana_scaleout/template.yaml

Você tem a opção de renomear o arquivo

template.yamlpara identificar a configuração que ele define. Use, por exemplo, um nome de arquivo comohana2sp3rev30-scaleout.yaml.Abra o arquivo

template.yamlno editor de código do Cloud Shell.Para abrir o editor de código, clique no ícone de lápis, no canto superior direito da janela do terminal do Cloud Shell.

No arquivo

template.yaml, atualize os valores de propriedade a seguir substituindo os colchetes e respectivos conteúdos pelos valores da sua instalação. Por exemplo, substitua "[ZONE]" por "us-central1-f".Property Tipo de dados Descrição Tipo String Especifica o local, o tipo e a versão do modelo do Deployment Manager a ser usado durante a implantação.

O arquivo YAML inclui duas especificações

type, uma delas comentada. A especificaçãotypeque está ativa por padrão especifica a versão do modelo comolatest. A especificaçãotypecomentada especifica uma versão de modelo específica com carimbo de data/hora.Se você precisar que todas as suas implantações usem a mesma versão de modelo, use a especificação

typeque inclui o carimbo de data/hora.instanceNameString Nome da instância da VM para o host mestre do SAP HANA. O nome precisa ser especificado em letras minúsculas, números ou hifens. As instâncias de VM para os hosts worker e em espera usam o mesmo nome com um "w" e o número do host anexado ao nome. instanceTypeString O tipo de máquina virtual do Compute Engine em que é necessário executar o SAP HANA. Se você precisar de um tipo de VM personalizado, especifique um tipo de VM predefinido com um número de vCPUs o mais próximo possível do necessário, mesmo que maior. Após a conclusão da implantação, modifique o número de vCPUs e a quantidade de memória.. zoneString Zona em que você está implantando os sistemas SAP HANA a serem executados. Ela precisa estar na região selecionada para sua sub-rede. subnetworkString Nome da sub-rede criado em uma etapa anterior. Se estiver implantando em uma VPC compartilhada, especifique esse valor como [SHAREDVPC_PROJECT]/[SUBNETWORK]. Por exemplo,myproject/network1.linuxImageString Nome da imagem do sistema operacional Linux ou da família de imagens que você está usando com o SAP HANA. Para especificar uma família de imagens, adicione o prefixo family/ao nome da família. Por exemplo,family/rhel-8-1-sap-haoufamily/sles-15-sp2-sap. Para definir uma imagem específica, determine somente o nome da imagem. Para acessar a lista de famílias de imagens disponíveis, consulte a página Imagens no console Google Cloud .linuxImageProjectString O projeto Google Cloud que contém a imagem que você vai usar. Talvez seja seu próprio projeto ou um projeto de imagem Google Cloud . Para uma imagem do Compute Engine, especifique rhel-sap-cloudoususe-sap-cloud. Para encontrar o projeto de imagem do sistema operacional, consulte Detalhes do sistema operacional.sap_hana_deployment_bucketString Nome do bucket do Cloud Storage no projeto que contém os arquivos de instalação do SAP HANA enviados em uma etapa anterior. sap_hana_sidString ID do sistema SAP HANA. É necessário que tenha 3 caracteres alfanuméricos e comece com uma letra. Todas as letras precisam ser maiúsculas. sap_hana_instance_numberInteiro Número da instância do sistema SAP HANA, de 0 a 99. O padrão é 0. sap_hana_sidadm_passwordString Uma senha temporária para o administrador do sistema operacional a ser usada durante a implantação. As senhas precisam ter pelo menos oito caracteres e incluir no mínimo uma letra maiúscula, uma minúscula e um número. sap_hana_system_passwordString Uma senha temporária para o superusuário do banco de dados para ser usada durante a implantação. As senhas precisam ter pelo menos oito caracteres e incluir no mínimo uma letra maiúscula, uma minúscula e um número. sap_hana_worker_nodesInteiro Número necessário de hosts de worker extras do SAP HANA. É possível especificar de 1 a 15 hosts worker. O valor padrão é 1. sap_hana_standby_nodesInteiro Número de hosts em espera do SAP HANA complementares de que você precisa. É possível especificar de 1 a 3 hosts em espera. O valor padrão é 1. sap_hana_shared_nfsString Ponto de montagem do NFS para o volume /hana/shared. Por exemplo,10.151.91.122:/hana_shared_nfs.sap_hana_backup_nfsString Ponto de montagem do NFS para o volume /hanabackup. Por exemplo,10.216.41.122:/hana_backup_nfs.networkTagString Opcional. Uma ou mais tags de rede separadas por vírgula que representam a instância da VM para fins de roteamento ou firewall. Se você especificar publicIP: Noe não inserir uma tag de rede, forneça outro meio de acesso à Internet.nic_typeString Opcional, mas recomendado se disponível para a máquina de destino e a versão do SO. Especifica a interface de rede a ser usada com a instância de VM. É possível especificar o valor GVNICouVIRTIO_NET. Para usar uma NIC virtual do Google (gVNIC), especifique uma imagem do SO compatível com gVNIC como o valor da propriedadelinuxImage. Confira a lista de imagens do SO em Detalhes do sistema operacional.Se você não especificar um valor para essa propriedade, a interface de rede será selecionada automaticamente com base no tipo de máquina especificado para a propriedade

Esse argumento está disponível nas versõesinstanceType.202302060649ou posteriores do modelo do Deployment Manager.publicIPBooleano Opcional. Determina se um endereço IP público é adicionado à instância da VM. O padrão é Yes.sap_hana_double_volume_sizeInteiro Opcional. Dobra o tamanho do volume do HANA. Útil se você quiser implantar várias instâncias do SAP HANA ou uma instância do SAP HANA de recuperação de desastres na mesma VM. Por padrão, o tamanho do volume é calculado automaticamente para ser o tamanho mínimo necessário para seu volume de memória, mas ainda atende aos requisitos de suporte e certificação da SAP. sap_hana_sidadm_uidInteiro Opcional. Modifica o valor padrão do ID do usuário SID_LCadm. O valor padrão é 900. É possível alterá-lo para um valor diferente para maior consistência no cenário da SAP.sap_hana_sapsys_gidInteiro Opcional. Modifica o código do grupo padrão para sapsys. O padrão é 79. sap_deployment_debugBooleano Opcional. Se esse valor estiver definido como Yes, serão gerados registros detalhados da implantação. Não ative essa configuração a menos que um engenheiro de suporte do Google peça para habilitar a depuração.post_deployment_scriptBooleano Opcional. URL ou local de armazenamento de um script para ser executado após a conclusão da implantação. O script precisa estar hospedado em um servidor da Web ou em um bucket do Cloud Storage. Inicie o valor com http:// https:// ou gs://. Note que esse script será executado em todas as VMs criadas pelo modelo. Se você quer apenas executá-lo na instância mestre, precisará adicionar uma verificação na parte superior do script. O exemplo a seguir mostra um arquivo de configuração concluído que implanta um sistema de escalonamento horizontal do SAP HANA com três hosts workers e um host em espera na zona us-central1-f. Cada host está instalado em uma VM n2-highmem-32 em execução em um sistema operacional Linux fornecido por uma imagem pública do Compute Engine. Os volumes NFS são fornecidos pelo Filestore. As senhas temporárias são usadas apenas durante a implantação e o processamento da configuração. A conta de serviço personalizada especificada se tornará a conta de serviço das VMs implantadas.

resources: - name: sap_hana_ha_scaleout type: https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_hana_scaleout/sap_hana_scaleout.py # # By default, this configuration file uses the latest release of the deployment # scripts for SAP on Google Cloud. To fix your deployments to a specific release # of the scripts, comment out the type property above and uncomment the type property below. # # type: https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/YYYYMMDDHHMM/dm-templates/sap_hana_scaleout/sap_hana_scaleout.py # properties: instanceName: hana-scaleout-w-failover instanceType: n2-highmem-32 zone: us-central1-f subnetwork: example-sub-network-sap linuxImage: family/sles-15-sp2-sap linuxImageProject: suse-sap-cloud sap_hana_deployment_bucket: hana2-sp5-rev53 sap_hana_sid: HF0 sap_hana_instance_number: 00 sap_hana_sidadm_password: TempPa55word sap_hana_system_password: TempPa55word sap_hana_worker_nodes: 3 sap_hana_standby_nodes: 1 sap_hana_shared_nfs: 10.74.146.58:/hana_shr sap_hana_backup_nfs: 10.188.249.170:/hana_bup serviceAccount: sap-deploy-example@example-project-123456.Crie as instâncias:

gcloud deployment-manager deployments create [DEPLOYMENT_NAME] --config [TEMPLATE_NAME].yamlO comando acima invoca o Deployment Manager, que configura a infraestrutura Google Cloud e, em seguida, invoca outro script que configura o sistema operacional e instala o SAP HANA.

Enquanto o Deployment Manager tem controle, as mensagens de status são gravadas no Cloud Shell. Depois que o script é invocado, as mensagens de status são gravadas no Logging e podem ser visualizadas no console Google Cloud , conforme descrito em Como verificar os registros do Logging.

O tempo até a conclusão pode variar, mas o processo todo geralmente leva menos de 30 minutos.

Como verificar a implantação

Para verificar a implantação, é necessário verificar os registros de implantação no Cloud Logging e os discos e serviços nas VMs dos hosts primário e worker, exibir o sistema no SAP HANA Studio e testar a tomada de controle por um host em espera.

Verificar os registros

No console Google Cloud , abra o Cloud Logging para monitorar o progresso da instalação e verificar se há erros.

Filtre os registros:

Explorador de registros

Na página Explorador de registros, acesse o painel Consulta.

No menu suspenso Recurso, selecione Global e clique em Adicionar.

Se a opção Global não for exibida, insira a seguinte consulta no editor de consultas:

resource.type="global" "Deployment"Clique em Run query.

Visualizador de registros legado

- Na página Visualizador de registros legado, no menu de seleção básico, selecione Global como o recurso de registros.

Analise os registros filtrados:

- Se

"--- Finished"for exibido, o processamento do Deployment Manager estará concluído e será possível prosseguir para a próxima etapa. Se você vir um erro de cota:

Na página Cotas do IAM e Admin, aumente as cotas que não atendem aos requisitos do SAP HANA listados no Guia de planejamento do SAP HANA.

Na página Implantações do Deployment Manager, exclua a implantação para limpar as VMs e discos permanentes da instalação com falha.

Execute a implantação novamente.

- Se

Conectar-se às VMs para verificar os discos e serviços do SAP HANA

Após a conclusão da implantação, confirme se os discos e os serviços do SAP HANA foram implantados adequadamente, verificando os discos e os serviços do host mestre e de um host worker.

Na página de instâncias de VM do Compute Engine, conecte-se à VM do host mestre e de um host worker clicando no botão SSH na linha de cada uma das duas instâncias de VM.

Ao se conectar ao host worker, certifique-se de não estar se conectando a um host em espera. Eles usam a mesma convenção de nomenclatura dos hosts workers, mas têm o sufixo de host worker com numeração mais alta antes da primeira transferência. Por exemplo, se você tiver três hosts workers e um host em espera, antes da primeira transferência o host em espera terá um sufixo "w4".

Em cada janela de terminal, altere para usuário raiz.

sudo su -

Em cada janela de terminal, exiba o sistema de arquivos de disco.

df -h

No host mestre, o resultado será semelhante ao seguinte:

hana-scaleout-w-failover:~ # df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 8.0K 126G 1% /dev tmpfs 189G 0 189G 0% /dev/shm tmpfs 126G 18M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda3 45G 5.6G 40G 13% / /dev/sda2 20M 2.9M 18M 15% /boot/efi 10.135.35.138:/hana_shr 1007G 50G 906G 6% /hana/shared tmpfs 26G 0 26G 0% /run/user/473 10.197.239.138:/hana_bup 1007G 0 956G 0% /hanabackup tmpfs 26G 0 26G 0% /run/user/900 /dev/mapper/vg_hana-data 709G 7.7G 702G 2% /hana/data/HF0/mnt00001 /dev/mapper/vg_hana-log 125G 5.3G 120G 5% /hana/log/HF0/mnt00001 tmpfs 26G 0 26G 0% /run/user/1003

No host worker, observe que os diretórios

/hana/datae/hana/logtêm montagens diferentes.hana-scaleout-w-failoverw2:~ # df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 8.0K 126G 1% /dev tmpfs 189G 0 189G 0% /dev/shm tmpfs 126G 9.2M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda3 45G 5.6G 40G 13% / /dev/sda2 20M 2.9M 18M 15% /boot/efi tmpfs 26G 0 26G 0% /run/user/0 10.135.35.138:/hana_shr 1007G 50G 906G 6% /hana/shared 10.197.239.138:/hana_bup 1007G 0 956G 0% /hanabackup /dev/mapper/vg_hana-data 709G 821M 708G 1% /hana/data/HF0/mnt00003 /dev/mapper/vg_hana-log 125G 2.2G 123G 2% /hana/log/HF0/mnt00003 tmpfs 26G 0 26G 0% /run/user/1003

Em um host em espera, os diretórios de dados e de registros não são montados até que o host em espera assuma uma falha no host.

hana-scaleout-w-failoverw4:~ # df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 8.0K 126G 1% /dev tmpfs 189G 0 189G 0% /dev/shm tmpfs 126G 18M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda3 45G 5.6G 40G 13% / /dev/sda2 20M 2.9M 18M 15% /boot/efi tmpfs 26G 0 26G 0% /run/user/0 10.135.35.138:/hana_shr 1007G 50G 906G 6% /hana/shared 10.197.239.138:/hana_bup 1007G 0 956G 0% /hanabackup tmpfs 26G 0 26G 0% /run/user/1003

Em cada janela de terminal, altere para usuário do sistema operacional SAP HANA.

su - SID_LCadm

Substitua

SID_LCpelo valor SID especificado no modelo do arquivo de configuração. Todas as letras devem ser minúsculas.Em cada janela de terminal, verifique se os serviços do SAP HANA, como

hdbnameserver,hdbindexservere outros, estão em execução na instância.HDB info

No host mestre, o resultado será semelhante ao do exemplo truncado a seguir:

hf0adm@hana-scaleout-w-failover:/usr/sap/HF0/HDB00> HDB info USER PID PPID %CPU VSZ RSS COMMAND hf0adm 5936 5935 0.7 18540 6776 -sh hf0adm 6011 5936 0.0 14128 3856 \_ /bin/sh /usr/sap/HF0/HDB00/HDB info hf0adm 6043 6011 0.0 34956 3568 \_ ps fx -U hf0adm -o user:8,pid:8,ppid:8,pcpu:5,vsz:10 hf0adm 17950 1 0.0 23052 3168 sapstart pf=/hana/shared/HF0/profile/HF0_HDB00_hana-scaleout hf0adm 17957 17950 0.0 457332 70956 \_ /usr/sap/HF0/HDB00/hana-scaleout-w-failover/trace/hdb.sa hf0adm 17975 17957 1.8 9176656 3432456 \_ hdbnameserver hf0adm 18334 17957 0.4 4672036 229204 \_ hdbcompileserver hf0adm 18337 17957 0.4 4941180 257348 \_ hdbpreprocessor hf0adm 18385 17957 4.5 9854464 4955636 \_ hdbindexserver -port 30003 hf0adm 18388 17957 1.2 7658520 1424708 \_ hdbxsengine -port 30007 hf0adm 18865 17957 0.4 6640732 526104 \_ hdbwebdispatcher hf0adm 14230 1 0.0 568176 32100 /usr/sap/HF0/HDB00/exe/sapstartsrv pf=/hana/shared/HF0/profi hf0adm 10920 1 0.0 710684 51560 hdbrsutil --start --port 30003 --volume 3 --volumesuffix mn hf0adm 10575 1 0.0 710680 51104 hdbrsutil --start --port 30001 --volume 1 --volumesuffix mn hf0adm 10217 1 0.0 72140 7752 /usr/lib/systemd/systemd --user hf0adm 10218 10217 0.0 117084 2624 \_ (sd-pam)

Em um host worker, você verá uma saída semelhante à saída no seguinte exemplo truncado:

hf0adm@hana-scaleout-w-failoverw2:/usr/sap/HF0/HDB00> HDB info USER PID PPID %CPU VSZ RSS COMMAND hf0adm 22136 22135 0.3 18540 6804 -sh hf0adm 22197 22136 0.0 14128 3892 \_ /bin/sh /usr/sap/HF0/HDB00/HDB info hf0adm 22228 22197 100 34956 3528 \_ ps fx -U hf0adm -o user:8,pid:8,ppid:8,pcpu:5,vsz:10 hf0adm 9138 1 0.0 23052 3064 sapstart pf=/hana/shared/HF0/profile/HF0_HDB00_hana-scaleout hf0adm 9145 9138 0.0 457360 70900 \_ /usr/sap/HF0/HDB00/hana-scaleout-w-failoverw2/trace/hdb. hf0adm 9163 9145 0.7 7326228 755772 \_ hdbnameserver hf0adm 9336 9145 0.5 4670756 226972 \_ hdbcompileserver hf0adm 9339 9145 0.6 4942460 259724 \_ hdbpreprocessor hf0adm 9385 9145 2.0 7977460 1666792 \_ hdbindexserver -port 30003 hf0adm 9584 9145 0.5 6642012 528840 \_ hdbwebdispatcher hf0adm 8226 1 0.0 516532 52676 hdbrsutil --start --port 30003 --volume 5 --volumesuffix mn hf0adm 7756 1 0.0 567520 31316 /hana/shared/HF0/HDB00/exe/sapstartsrv pf=/hana/shared/HF0/p

Em um host em espera, você verá uma saída semelhante à saída truncada no seguinte exemplo:

hana-scaleout-w-failoverw4:~ # su - hf0adm hf0adm@hana-scaleout-w-failoverw4:/usr/sap/HF0/HDB00> HDB info USER PID PPID %CPU VSZ RSS COMMAND hf0adm 19926 19925 0.2 18540 6748 -sh hf0adm 19987 19926 0.0 14128 3864 \_ /bin/sh /usr/sap/HF0/HDB00/HDB info hf0adm 20019 19987 0.0 34956 3640 \_ ps fx -U hf0adm -o user:8,pid:8,ppid:8,pcpu:5,vsz:10 hf0adm 8120 1 0.0 23052 3232 sapstart pf=/hana/shared/HF0/profile/HF0_HDB00_hana-scaleout hf0adm 8127 8120 0.0 457348 71348 \_ /usr/sap/HF0/HDB00/hana-scaleout-w-failoverw4/trace/hdb. hf0adm 8145 8127 0.6 7328784 708284 \_ hdbnameserver hf0adm 8280 8127 0.4 4666916 223892 \_ hdbcompileserver hf0adm 8283 8127 0.4 4939904 256740 \_ hdbpreprocessor hf0adm 8328 8127 0.4 6644572 534044 \_ hdbwebdispatcher hf0adm 7374 1 0.0 633568 31520 /hana/shared/HF0/HDB00/exe/sapstartsrv pf=/hana/shared/HF0/p

Se você estiver usando o RHEL for SAP 9.0 ou posterior, verifique se os pacotes

chkconfigecompat-openssl11estão instalados na instância de VM.Para mais informações da SAP, consulte a Nota SAP 3108316 – Red Hat Enterprise Linux 9.x: instalação e configuração .

Conectar-se ao SAP HANA Studio

Conecte-se ao host mestre do SAP HANA do SAP HANA Studio.

É possível se conectar de uma instância do SAP HANA Studio que esteja fora do Google Cloud ou de uma instância no Google Cloud. É necessário ativar o acesso à rede entre as VMs de destino e o SAP HANA Studio.

Para usar o SAP HANA Studio no Google Cloud e permitir o acesso ao sistema SAP HANA, consulte Como instalar o SAP HANA Studio em uma VM do Windows do Compute Engine.

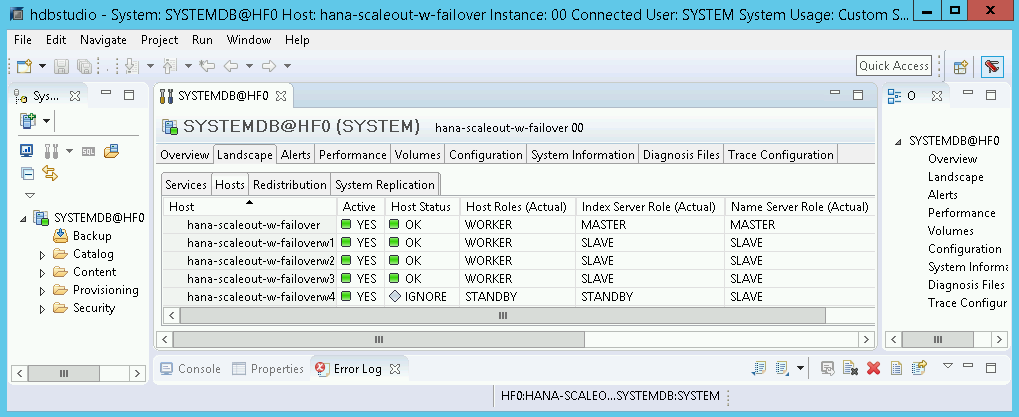

No SAP HANA Studio, clique na guia Landscape no painel de administração padrão do sistema. Será exibida uma mensagem parecida com o seguinte exemplo:

Se algum dos passos de validação mostrar que a instalação falhou:

- Corrija o erro.

- Na página Implantações, exclua a implantação.

- Execute a implantação novamente.

Como realizar um teste de failover

Após a confirmação da implantação bem-sucedida do sistema SAP HANA, teste a função failover.

As instruções a seguir acionam um failover alternando para o usuário do sistema operacional SAP HANA e digitando o comando HDB stop. O comando HDB stop inicia um encerramento otimizado do SAP HANA e desconecta os discos do host, o que permite um failover relativamente rápido.

Para executar um teste de failover:

Conecte-se à VM de um host worker usando SSH. É possível se conectar pela página de instâncias da VM do Compute Engine clicando no botão SSH para cada uma das instâncias ou usando o método SSH que preferir.

Altere para o usuário do sistema operacional SAP HANA. No exemplo a seguir, substitua

SID_LCpelo SID que você definiu para o sistema.su - SID_LCadm

Simule uma falha com a interrupção do SAP HANA:

HDB stop

O comando

HDB stopinicia um desligamento do SAP HANA, que aciona um failover. Durante o failover, os discos são desconectados do host com falha e são reconectados ao host em espera. O host com falha é reiniciado e se torna um host em espera.Após a reinicialização, reconecte-se ao host que assumiu o host com falha usando SSH.

Altere para o usuário raiz.

sudo su -

Exiba o sistema de arquivos de disco das VMs para os hosts mestre e worker.

df -h

Será exibido um código semelhante a este. Os diretórios

/hana/datae/hana/logdo host com falha agora estão montados no host que assumiu o controle.hana-scaleout-w-failoverw4:~ # df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 8.0K 126G 1% /dev tmpfs 189G 0 189G 0% /dev/shm tmpfs 126G 9.2M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda3 45G 5.6G 40G 13% / /dev/sda2 20M 2.9M 18M 15% /boot/efi tmpfs 26G 0 26G 0% /run/user/0 10.74.146.58:/hana_shr 1007G 50G 906G 6% /hana/shared 10.188.249.170:/hana_bup 1007G 0 956G 0% /hanabackup /dev/mapper/vg_hana-data 709G 821M 708G 1% /hana/data/HF0/mnt00003 /dev/mapper/vg_hana-log 125G 2.2G 123G 2% /hana/log/HF0/mnt00003 tmpfs 26G 0 26G 0% /run/user/1003

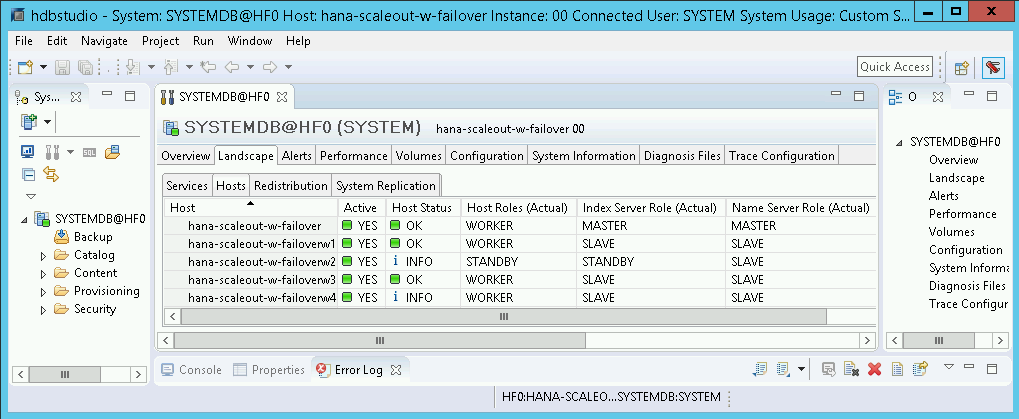

No SAP HANA Studio, abra a visualização Landscape do sistema SAP HANA e confirme se o failover foi bem-sucedido:

- O status dos hosts envolvidos no failover deverá ser

INFO. - A coluna Papel do servidor de índice (real) deve mostrar o host com falha como o novo host em espera.

- O status dos hosts envolvidos no failover deverá ser

Valide a instalação do agente do Google Cloudpara SAP

Depois de implantar uma VM e instalar o sistema SAP, confirme se o agente doGoogle Cloudpara SAP está funcionando corretamente.

Verificar se o agente do Google Cloudpara SAP está em execução

Para verificar se o agente está em execução, siga estas etapas:

Estabeleça uma conexão SSH com a instância do Compute Engine.

Execute este comando:

systemctl status google-cloud-sap-agent

Se o agente estiver funcionando corretamente, a saída conterá

active (running). Por exemplo:google-cloud-sap-agent.service - Google Cloud Agent for SAP Loaded: loaded (/usr/lib/systemd/system/google-cloud-sap-agent.service; enabled; vendor preset: disabled) Active: active (running) since Fri 2022-12-02 07:21:42 UTC; 4 days ago Main PID: 1337673 (google-cloud-sa) Tasks: 9 (limit: 100427) Memory: 22.4 M (max: 1.0G limit: 1.0G) CGroup: /system.slice/google-cloud-sap-agent.service └─1337673 /usr/bin/google-cloud-sap-agent

Se o agente não estiver em execução, reinicie-o.

Verificar se o SAP Host Agent está recebendo métricas

Para verificar se as métricas de infraestrutura são coletadas pelo agente doGoogle Cloudpara SAP e enviadas corretamente ao agente de host da SAP, siga estas etapas:

- No sistema SAP, insira a transação

ST06. No painel de visão geral, verifique a disponibilidade e o conteúdo dos seguintes campos para a configuração completa da infraestrutura de monitoramento da SAP e do Google:

- Provedor de nuvem:

Google Cloud Platform - Acesso ao monitoramento avançado:

TRUE - Detalhes do monitoramento avançado:

ACTIVE

- Provedor de nuvem:

Configurar o monitoramento para o SAP HANA

Como opção, monitore as instâncias do SAP HANA usando o agente doGoogle Cloudpara SAP. A partir da versão 2.0, é possível configurar o agente para coletar as métricas de monitoramento do SAP HANA e enviá-las para o Cloud Monitoring. O Cloud Monitoring permite criar painéis para visualizar essas métricas, configurar alertas com base em limites de métrica e muito mais.

Para mais informações sobre a coleta de métricas de monitoramento do SAP HANA usando o agente doGoogle Cloudpara SAP, consulte Coleta de métricas de monitoramento do SAP HANA.

Ativar a reinicialização rápida do SAP HANA

O Google Cloud recomenda fortemente ativar a reinicialização rápida do SAP HANA para cada instância do SAP HANA, especialmente para instâncias maiores.Google Cloud A reinicialização rápida do SAP HANA reduz os tempos de reinicialização caso o SAP HANA seja encerrado, mas o sistema operacional continua em execução.

Conforme definido pelos scripts de automação fornecidos pelo Google Cloud ,

as configurações do sistema operacional e do kernel já são compatíveis com a reinicialização rápida do SAP HANA.

Você precisa definir o sistema de arquivos tmpfs e configurar o SAP HANA.

Para definir o sistema de arquivos tmpfs e configurar o SAP HANA, siga

as etapas manuais ou use o script de automação fornecido

porGoogle Cloud para ativar a reinicialização rápida do SAP HANA. Para mais informações, veja:

- Etapas manuais: ativar a reinicialização rápida do SAP HANA

- Etapas automatizadas: ativar a reinicialização rápida do SAP HANA

Para receber instruções completas sobre a reinicialização rápida do SAP HANA, consulte a documentação da opção de reinicialização rápida do SAP HANA.

Etapas manuais

Configurar o sistema de arquivos tmpfs

Depois que as VMs do host e os sistemas SAP HANA de base forem implantados, você precisará criar e ativar diretórios para os nós NUMA no sistema de arquivos tmpfs.

Exibir a topologia de NUMA da sua VM

Antes de mapear o sistema de arquivos tmpfs necessário, você precisa saber quantos

nós NUMA sua VM tem. Para exibir os nós NUMA disponíveis em uma

VM do Compute Engine, digite o seguinte comando:

lscpu | grep NUMA

Por exemplo, um tipo de VM m2-ultramem-208 tem quatro nós NUMA,

numerados de 0 a 3, conforme mostrado no exemplo a seguir:

NUMA node(s): 4 NUMA node0 CPU(s): 0-25,104-129 NUMA node1 CPU(s): 26-51,130-155 NUMA node2 CPU(s): 52-77,156-181 NUMA node3 CPU(s): 78-103,182-207

Criar os diretórios de nós NUMA

Crie um diretório para cada nó NUMA na sua VM e defina as permissões.

Por exemplo, para quatro nós NUMA numerados de 0 a 3:

mkdir -pv /hana/tmpfs{0..3}/SID

chown -R SID_LCadm:sapsys /hana/tmpfs*/SID

chmod 777 -R /hana/tmpfs*/SIDMontar os diretórios de nó NUMA em tmpfs

Monte os diretórios do sistema de arquivos tmpfs e especifique uma preferência de nó NUMA para cada um com mpol=prefer:

SID especifica o SID com letras maiúsculas.

mount tmpfsSID0 -t tmpfs -o mpol=prefer:0 /hana/tmpfs0/SID mount tmpfsSID1 -t tmpfs -o mpol=prefer:1 /hana/tmpfs1/SID mount tmpfsSID2 -t tmpfs -o mpol=prefer:2 /hana/tmpfs2/SID mount tmpfsSID3 -t tmpfs -o mpol=prefer:3 /hana/tmpfs3/SID

Atualizar /etc/fstab

Para garantir que os pontos de montagem estejam disponíveis após uma reinicialização do sistema operacional, adicione entradas à tabela do sistema de arquivos, /etc/fstab:

tmpfsSID0 /hana/tmpfs0/SID tmpfs rw,nofail,relatime,mpol=prefer:0 tmpfsSID1 /hana/tmpfs1/SID tmpfs rw,nofail,relatime,mpol=prefer:1 tmpfsSID1 /hana/tmpfs2/SID tmpfs rw,nofail,relatime,mpol=prefer:2 tmpfsSID1 /hana/tmpfs3/SID tmpfs rw,nofail,relatime,mpol=prefer:3

Opcional: defina limites de uso de memória

O sistema de arquivos tmpfs pode aumentar e diminuir dinamicamente.

Para limitar a memória usada pelo sistema de arquivos tmpfs, defina um limite de tamanho para um volume de nó NUMA com a opção size.

Por exemplo:

mount tmpfsSID0 -t tmpfs -o mpol=prefer:0,size=250G /hana/tmpfs0/SID

Também é possível limitar o uso geral da memória tmpfs para todos os nós NUMA de

uma determinada instância do SAP HANA e de um determinado nó do servidor definindo o

parâmetro persistent_memory_global_allocation_limit na seção [memorymanager]

do arquivo global.ini.

Configuração do SAP HANA para reinicialização rápida

Para configurar o SAP HANA para reinicialização rápida, atualize o arquivo global.ini e especifique as tabelas a serem armazenadas na memória permanente.

Atualize a seção [persistence] no arquivo global.ini

Configure a seção [persistence] no arquivo global.ini do SAP HANA para fazer referência aos locais tmpfs. Separe cada local tmpfs com

um ponto e vírgula:

[persistence] basepath_datavolumes = /hana/data basepath_logvolumes = /hana/log basepath_persistent_memory_volumes = /hana/tmpfs0/SID;/hana/tmpfs1/SID;/hana/tmpfs2/SID;/hana/tmpfs3/SID

O exemplo anterior especifica quatro volumes de memória para quatro nós NUMA,

que correspondem a m2-ultramem-208. Se você estivesse executando no m2-ultramem-416, seria necessário configurar oito volumes de memória (0..7).

Reinicie o SAP HANA depois de modificar o arquivo global.ini.

O SAP HANA agora pode usar o local tmpfs como espaço de memória permanente.

Especificar as tabelas a serem armazenadas na memória permanente

Especifique tabelas ou partições específicas de coluna para armazenar na memória permanente.

Por exemplo, para ativar a memória permanente de uma tabela atual, execute a consulta SQL:

ALTER TABLE exampletable persistent memory ON immediate CASCADE

Para alterar o padrão de novas tabelas, adicione o parâmetro table_default no arquivo indexserver.ini. Por exemplo:

[persistent_memory] table_default = ON

Para mais informações sobre como controlar colunas, tabelas e quais visualizações de monitoramento fornecem informações detalhadas, consulte Memória permanente do SAP HANA.

Etapas automatizadas

O script de automação que Google Cloud fornece para ativar

a Reinicialização rápida do SAP HANA

faz mudanças nos diretórios /hana/tmpfs*, /etc/fstab e

na configuração do SAP HANA. Ao executar o script, talvez seja necessário executar

etapas adicionais, dependendo se essa é a implantação inicial do seu

sistema SAP HANA ou se você está redimensionando sua máquina para um tamanho de NUMA diferente.

Para a implantação inicial do seu sistema SAP HANA ou redimensionar a máquina para aumentar o número de nós NUMA, verifique se o SAP HANA está em execução durante a execução do script de automação que Google Cloud fornece para permitir a reinicialização rápida do SAP HANA.

Ao redimensionar a máquina para diminuir o número de nós NUMA, verifique se o SAP HANA é interrompido durante a execução do script de automação que Google Cloud fornece para ativar a reinicialização rápida do SAP HANA. Depois que o script for executado, você precisará atualizar manualmente a configuração do SAP HANA para concluir a configuração de reinício rápido do SAP HANA. Para mais informações, consulte Configuração do SAP HANA para reinicialização rápida.

Para ativar o reinício rápido do SAP HANA, siga estas etapas:

Estabeleça uma conexão SSH com sua VM do host.

Mudar para raiz:

sudo su -

Faça o download do script

sap_lib_hdbfr.sh:wget https://storage.googleapis.com/cloudsapdeploy/terraform/latest/terraform/lib/sap_lib_hdbfr.sh

Torne o arquivo executável:

chmod +x sap_lib_hdbfr.sh

Verifique se o script não tem erros:

vi sap_lib_hdbfr.sh ./sap_lib_hdbfr.sh -help

Se o comando retornar um erro, entre em contato com o Cloud Customer Care. Para mais informações sobre como entrar em contato com o atendimento ao cliente, consulte Como receber suporte para a SAP no Google Cloud.

Execute o script depois de substituir o ID do sistema (SID) do SAP HANA e a senha do usuário SYSTEM do banco de dados do SAP HANA. Para fornecer a senha com segurança, recomendamos que você use uma chave secreta no Gerenciador de secrets.

Execute o script usando o nome de um secret no Secret Manager. Esse secret precisa existir no projeto Google Cloud que contém a instância de VM do host.

sudo ./sap_lib_hdbfr.sh -h 'SID' -s SECRET_NAME

Substitua:

SID: especifique o SID com letras maiúsculas. Por exemplo,AHA.SECRET_NAME: especifique o nome do secret que corresponde à senha do usuário do SYSTEM do banco de dados do SAP HANA. Esse secret precisa existir no projeto Google Cloud que contém a instância de VM do host.

Outra opção é executar o script com uma senha de texto simples. Depois que a reinicialização rápida do SAP HANA estiver ativada, altere sua senha. Não é recomendável usar uma senha de texto simples, porque ela seria registrada no histórico de linha de comando da VM.

sudo ./sap_lib_hdbfr.sh -h 'SID' -p 'PASSWORD'

Substitua:

SID: especifique o SID com letras maiúsculas. Por exemplo,AHA.PASSWORD: especifique a senha do usuário do SYSTEM do banco de dados SAP HANA.

Para uma execução inicial bem-sucedida, você verá uma saída semelhante a esta:

INFO - Script is running in standalone mode

ls: cannot access '/hana/tmpfs*': No such file or directory

INFO - Setting up HANA Fast Restart for system 'TST/00'.

INFO - Number of NUMA nodes is 2

INFO - Number of directories /hana/tmpfs* is 0

INFO - HANA version 2.57

INFO - No directories /hana/tmpfs* exist. Assuming initial setup.

INFO - Creating 2 directories /hana/tmpfs* and mounting them

INFO - Adding /hana/tmpfs* entries to /etc/fstab. Copy is in /etc/fstab.20220625_030839

INFO - Updating the HANA configuration.

INFO - Running command: select * from dummy

DUMMY

"X"

1 row selected (overall time 4124 usec; server time 130 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('global.ini', 'SYSTEM') SET ('persistence', 'basepath_persistent_memory_volumes') = '/hana/tmpfs0/TST;/hana/tmpfs1/TST;'

0 rows affected (overall time 3570 usec; server time 2239 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('global.ini', 'SYSTEM') SET ('persistent_memory', 'table_unload_action') = 'retain';

0 rows affected (overall time 4308 usec; server time 2441 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('indexserver.ini', 'SYSTEM') SET ('persistent_memory', 'table_default') = 'ON';

0 rows affected (overall time 3422 usec; server time 2152 usec)

Como se conectar ao SAP HANA

Observe que, como essas instruções não usam um IP externo para o SAP HANA, só será possível se conectar às instâncias do SAP HANA por meio da instância bastion usando SSH ou por meio do Windows server usando o SAP HANA Studio.

Para se conectar ao SAP HANA por meio da instância bastion, conecte-se ao bastion host e depois às instâncias do SAP HANA usando um cliente SSH de sua escolha.

Para conectar o banco de dados SAP HANA por meio do SAP HANA Studio, use um cliente de área de trabalho remota para se conectar à instância do Windows Server. Após a conexão, instale o SAP HANA Studio (em inglês) manualmente e acesse o banco de dados SAP HANA.

Como realizar tarefas de pós-implantação

Antes de usar sua instância do SAP HANA, recomendamos que você realize as etapas de pós-implantação a seguir. Para saber mais informações, consulte o Guia de instalação e atualização do SAP HANA.

Altere as senhas temporárias do superusuário do sistema SAP HANA e do superusuário do banco de dados.

Atualize o software SAP HANA com os patches mais recentes.

Instale todos os componentes extras, como o Application Function Libraries (AFL) ou o Smart Data Access (SDA).

Se estiver fazendo upgrade de um sistema SAP HANA atual, carregue os dados do sistema atual usando procedimentos de backup e restauração padrão ou usando a replicação do sistema SAP HANA.

Configure e faça o backup do novo banco de dados do SAP HANA. Para mais informações, consulte o guia de operações do SAP HANA.

A seguir

- Para mais informações sobre administração e monitoramento de VMs, consulte o Guia de operações do SAP HANA.