이 가이드에서는 Cloud Deployment Manager를 사용하여 SAP HANA 호스트 자동 장애 조치 장애 복구 솔루션이 포함된 SAP HANA 수평 확장 시스템을 배포하는 방법을 보여줍니다. Deployment Manager를 사용하면 SAP 지원 요구사항을 충족하고 SAP 권장사항과 Compute Engine 권장사항을 모두 준수하는 시스템을 배포할 수 있습니다.

그러면 SAP HANA 시스템에는 마스터 호스트, 작업자 호스트(최대 15개), 대기 호스트(최대 3개) 모두 단일 Compute Engine 영역에 포함됩니다.

또한 시스템에는 SAP HANA 대기 노드용Google Cloud 스토리지 관리자(SAP HANA용 스토리지 관리자)가 포함되며 이 스토리지 관리자는 장애 조치 중에 스토리지 기기에서 대기 노드로의 전송을 관리합니다.

SAP HANA용 스토리지 관리자는 SAP HANA /shared 볼륨에 설치됩니다.

SAP HANA용 스토리지 관리자 및 필요한 IAM 권한에 대한 자세한 내용은 SAP HANA용 스토리지 관리자를 참조하세요.

SAP HANA를 Linux 고가용성 클러스터에 배포해야 하는 경우 다음 가이드 중 하나를 사용하세요.

- Deployment Manager: SAP HANA HA 클러스터 구성 가이드

- RHEL 기반 SAP HANA용 HA 클러스터 구성 가이드

- SLES 기반 SAP HANA용 HA 클러스터 구성 가이드

이 가이드는 고가용성을 위한 대기 호스트가 포함된 SAP 수평 확장 구성과 네트워크 파일 시스템에 대해 잘 알고 있는 SAP HANA 고급 사용자를 위한 것입니다.

기본 요건

SAP HANA 고가용성 수평 확장 시스템을 만들기 전에 다음 기본 요건을 충족해야 합니다.

- SAP HANA 계획 가이드와 SAP HANA 고가용성 계획 가이드를 읽어야 합니다.

- 사용자 또는 사용자의 조직에 Google Cloud 계정이 있어야 하고 SAP HANA 배포를 위한 프로젝트를 만들어야 합니다.Google Cloud 계정 및 프로젝트를 만드는 방법에 대한 자세한 내용은 SAP HANA 배포 가이드의 Google 계정 설정을 참조하세요.

- 데이터 상주, 액세스 제어, 지원 담당자 또는 규제 요건에 따라 SAP 워크로드를 실행해야 하는 경우 필요한 Assured Workloads 폴더를 만들어야 합니다. 자세한 내용은 Google Cloud기반 SAP의 규정 준수 및 주권 제어를 참조하세요.

- SAP HANA 설치 미디어가 배포 프로젝트 및 리전에서 사용할 수 있는 Cloud Storage 버킷에 저장되어 있어야 합니다. SAP HANA 설치 미디어를 Cloud Storage 버킷에 업로드하는 방법에 대한 자세한 내용은 SAP HANA 배포 가이드의 Cloud Storage 버킷 만들기를 참조하세요.

- 수평 확장 SAP HANA 시스템의 호스트 간에 SAP HANA

/hana/shared및/hanabackup볼륨을 공유할 수 있는 관리형 Filestore 솔루션과 같은 NFS 솔루션이 있습니다. 시스템을 배포하기 전에 Deployment Manager 구성 파일에서 NFS 서버의 마운트 지점을 지정해야 합니다. Filestore NFS 서버를 배포하려면 인스턴스 만들기를 참조하세요. SAP HANA 수평 확장 노드를 호스팅하는 SAP HANA 서브네트워크의 모든 VM 간에 통신이 허용되어야 합니다.

프로젝트 메타데이터에 OS 로그인이 사용 설정되면 배포가 완료될 때까지 OS 로그인을 일시적으로 중지해야 합니다. 이 절차는 배포 목적으로 인스턴스 메타데이터에 SSH 키를 구성합니다. OS 로그인이 사용 설정되면 메타데이터 기반 SSH 키 구성이 사용 중지되고 이 배포가 실패합니다. 배포가 완료되면 OS 로그인을 다시 사용 설정할 수 있습니다.

자세한 내용은 다음을 참고하세요.

네트워크 만들기

보안 문제로 새 네트워크를 만들어야 합니다. 방화벽 규칙을 추가하거나 다른 액세스 제어 방법을 사용하여 액세스 권한이 있는 사용자를 제어할 수 있습니다.

프로젝트에 기본 VPC 네트워크가 있으면 사용하지 마세요. 명시적으로 직접 만든 방화벽 규칙만 적용되도록 VPC 네트워크를 직접 만드시기 바랍니다.

배포 중에 Compute Engine 인스턴스는 일반적으로 SAP용 Google Cloud에이전트를 다운로드하기 위해 인터넷에 액세스할 수 있어야 합니다. Google Cloud에서 제공하는 SAP 인증 Linux 이미지 중 하나를 사용하는 경우 컴퓨팅 인스턴스도 라이선스를 등록하고 OS 공급업체 저장소에 액세스하기 위해 인터넷에 액세스할 수 있어야 합니다. NAT 게이트웨이 및 VM 네트워크 태그가 있는 구성은 대상 컴퓨팅 인스턴스에 외부 IP가 없더라도 이러한 액세스를 지원합니다.

네트워킹을 설정하는 방법은 다음과 같습니다.

콘솔

- Google Cloud 콘솔에서 VPC 네트워크 페이지로 이동합니다.

- VPC 네트워크 만들기를 클릭합니다.

- 네트워크의 이름을 입력합니다.

이름은 이름 지정 규칙을 준수해야 합니다. VPC 네트워크는 Compute Engine 이름 지정 규칙을 사용합니다.

- 서브넷 생성 모드에서 커스텀을 선택합니다.

- 새 서브넷 섹션에서 서브넷에 다음 구성 매개변수를 지정합니다.

- 서브넷 이름을 입력합니다.

- 리전에서 서브넷을 만들 Compute Engine 리전을 선택합니다.

- IP 스택 유형에서 IPv4(단일 스택)를 선택한 다음 CIDR 형식의 IP 주소 범위(예:

10.1.0.0/24)를 입력합니다.이 범위는 서브넷의 기본 IPv4 범위입니다. 서브네트워크를 한 개 넘게 추가하려는 경우 네트워크의 각 서브네트워크에 서로 겹치지 않는 CIDR IP 범위를 할당하세요. 각 서브네트워크 및 내부 IP 범위는 단일 리전에 매핑됩니다.

- 완료를 클릭합니다.

- 서브넷을 추가하려면 서브넷 추가를 클릭하고 이전 단계를 반복합니다. 네트워크를 만든 후에 네트워크에 서브넷을 더 추가할 수 있습니다.

- 만들기를 클릭합니다.

gcloud

- Cloud Shell로 이동합니다.

- 커스텀 서브네트워크 모드에서 새 네트워크를 만들려면 다음을 실행합니다.

gcloud compute networks create NETWORK_NAME --subnet-mode custom

NETWORK_NAME을 새 네트워크 이름으로 바꿉니다. 이름은 이름 지정 규칙을 준수해야 합니다. VPC 네트워크는 Compute Engine 이름 지정 규칙을 사용합니다.각 Compute Engine 리전에 서브넷을 자동으로 만드는 기본 자동 모드를 사용하지 않으려면

--subnet-mode custom을 지정합니다. 자세한 내용은 서브넷 생성 모드를 참조하세요. - 서브네트워크를 만들고 리전 및 IP 범위를 지정합니다.

gcloud compute networks subnets create SUBNETWORK_NAME \ --network NETWORK_NAME --region REGION --range RANGE다음을 바꿉니다.

SUBNETWORK_NAME: 새 서브네트워크의 이름입니다.NETWORK_NAME: 이전 단계에서 만든 네트워크의 이름입니다.REGION: 서브네트워크가 위치할 리전입니다.RANGE: CIDR 형식으로 지정된 IP 주소 범위(예:10.1.0.0/24)입니다.서브네트워크를 한 개 넘게 추가하려는 경우 네트워크의 각 서브네트워크에 서로 겹치지 않는 CIDR IP 범위를 할당하세요. 각 서브네트워크 및 내부 IP 범위는 단일 리전에 매핑됩니다.

- 필요한 경우 이전 단계를 반복하고 서브네트워크를 추가합니다.

NAT 게이트웨이 설정

공개 IP 주소가 없는 VM을 하나 이상 만들어야 하는 경우 네트워크 주소 변환(NAT)을 사용하여 VM이 인터넷에 액세스하도록 사용 설정해야 합니다. VM에서 아웃바운드 패킷을 인터넷에 보내고 그에 따라 설정된 인바운드 응답 패킷을 받을 수 있게 하는 Google Cloud 분산 소프트웨어 정의 관리형 서비스인 Cloud NAT를 사용합니다. 또는 별도의 VM을 NAT 게이트웨이로 설정할 수 있습니다.

프로젝트에 Cloud NAT 인스턴스를 만들려면 Cloud NAT 사용을 참조하세요.

프로젝트에 Cloud NAT를 구성하면 VM 인스턴스가 공개 IP 주소 없이 인터넷에 안전하게 액세스할 수 있습니다.

방화벽 규칙 추가

묵시적인 방화벽 규칙은 Virtual Private Cloud(VPC) 네트워크 외부에서 들어오는 연결을 차단하는 것이 기본 설정되어 있습니다. 들어오는 연결을 허용하려면 VM에 방화벽 규칙을 설정합니다. VM에 들어오는 연결이 설정되면 이 연결을 통한 양방향 트래픽이 허용됩니다.

또한 동일한 네트워크에서 지정된 포트에 대한 외부 액세스를 허용하거나 VM 간 액세스를 제한하는 방화벽 규칙을 만들 수 있습니다. default VPC 네트워크 유형이 사용되는 경우 모든 포트에서 동일한 네트워크에 있는 VM 간의 연결을 허용하는 default-allow-internal 규칙과 같은 일부 기본 규칙도 추가로 적용됩니다.

사용자 환경에 적용 가능한 IT 정책 마다 다를 수 있지만, 방화벽 규칙 생성을 통해 데이터베이스 호스에 대한 연결을 격리하거나 제한해야 할 수도 있습니다.

시나리오에 따라 다음에 대한 액세스를 허용하는 방화벽 규칙을 만들 수 있습니다.

- 모든 SAP 제품의 TCP/IP에 나열된 기본 SAP 포트

- 사용자 컴퓨터 또는 기업 네트워크 환경에서 Compute Engine VM 인스턴스에 연결. 사용할 IP 주소를 모르는 경우 회사의 네트워크 관리자에게 문의하세요.

- SAP HANA 수평 확장 시스템의 노드 간 통신 또는 3계층 아키텍처의 데이터베이스 서버와 애플리케이션 서버 간의 통신을 비롯한 SAP HANA 서브네트워크의 VM 간 통신. 서브네트워크의 트래픽을 허용하는 방화벽 규칙을 만들어 VM 간 통신을 사용 설정할 수 있습니다.

방화벽 규칙을 만들려면 다음 안내를 따르세요.

콘솔

Google Cloud 콘솔에서 VPC 네트워크 방화벽 페이지로 이동합니다.

페이지 상단에서 방화벽 규칙 만들기를 클릭합니다.

- 네트워크 필드에서 VM이 위치하는 네트워크를 선택합니다.

- 대상 필드에서 이 규칙이 적용되는 Google Cloud의 리소스를 지정합니다. 예를 들어 네트워크의 모든 인스턴스를 지정합니다. 또는 규칙을 Google Cloud의 특정 인스턴스로 제한하려면 지정된 대상 태그에 태그를 입력합니다.

- 소스 필터 필드에서 다음 중 하나를 선택합니다.

- 특정 IP 주소에서 들어오는 트래픽을 허용하려면 IP 범위를 선택합니다. 소스 IP 범위 필드에 IP 주소 범위를 지정합니다.

- 특정 서브네트워크에서 들어오는 트래픽을 허용하려면 서브넷을 선택합니다. 다음 서브넷 필드에 서브네트워크 이름을 지정합니다. 이 옵션을 사용하면 3계층 또는 수평 확장 구성의 VM 간에 액세스를 허용할 수 있습니다.

- 프로토콜 및 포트 섹션에서 지정된 프로토콜 및 포트를 선택하고

tcp:PORT_NUMBER를 입력합니다.

만들기를 클릭하여 방화벽 규칙을 만듭니다.

gcloud

다음 명령어를 사용하여 방화벽 규칙을 만듭니다.

$ gcloud compute firewall-rules create FIREWALL_NAME

--direction=INGRESS --priority=1000 \

--network=NETWORK_NAME --action=ALLOW --rules=PROTOCOL:PORT \

--source-ranges IP_RANGE --target-tags=NETWORK_TAGS대기 호스트로 SAP HANA 수평 확장 시스템 만들기

다음 안내에서는 다음 작업을 수행합니다.

- 작성할 구성 파일 템플릿이 있는 Deployment Manager를 호출하여 SAP HANA 시스템을 만듭니다.

- 배포를 확인합니다.

- 호스트 오류를 시뮬레이션하여 대기 호스트를 테스트합니다.

다음 안내의 일부 단계에서는 Cloud Shell을 사용하여 gcloud 명령어를 입력합니다. 최신 버전의 Google Cloud CLI가 설치되어 있으면 대신 로컬 터미널에서 gcloud 명령어를 입력할 수 있습니다.

SAP HANA 시스템 정의 및 만들기

다음 단계에서 Deployment Manager 구성 파일 템플릿을 다운로드하여 작성하고 Deployment Manager를 호출합니다. 이는 VM, 영구 디스크, SAP HANA 인스턴스를 배포합니다.

영구 디스크, CPU 등 프로젝트 리소스의 현재 할당량이 설치하려는 SAP HANA 시스템에 충분한지 확인합니다. 할당량이 충분하지 않은 경우 배포가 실패합니다. SAP HANA 할당량 요구사항은 SAP HANA의 가격 책정 및 할당량 고려사항을 참조하세요.

Cloud Shell을 엽니다.

SAP HANA 고가용성 수평 확장 시스템의

template.yaml구성 파일 템플릿을 작업 디렉터리에 다운로드합니다.wget https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_hana_scaleout/template.yaml

필요한 경우

template.yaml파일의 이름을 변경하여 정의하는 구성을 식별합니다. 예를 들어hana2sp3rev30-scaleout.yaml과 같은 파일 이름을 사용할 수 있습니다.Cloud Shell 코드 편집기에서

template.yaml파일을 엽니다.Cloud Shell 코드 편집기를 열려면 Cloud Shell 터미널 창 오른쪽 상단의 연필 아이콘을 클릭합니다.

template.yaml파일에서 대괄호로 묶인 콘텐츠를 설치에 해당하는 값으로 바꿔 다음 속성 값을 업데이트합니다. 예를 들어 '[ZONE]'을 'us-central1-f'로 바꿀 수 있습니다.속성 데이터 유형 설명 유형 문자열 배포 중에 사용할 Deployment Manager 템플릿의 위치, 유형, 버전을 지정합니다.

YAML 파일에는 두 가지의

type사양이 포함되어 있으며 그 중 하나는 주석 처리되어 있습니다. 기본적으로 활성화되는type사양은 템플릿 버전을latest으로 지정합니다. 주석 처리된type사양은 타임스탬프가 있는 특정 템플릿 버전을 지정합니다.모든 배포에서 동일한 템플릿 버전을 사용하려면 타임스탬프가 포함된

type사양을 사용하세요.instanceName문자열 SAP HANA 마스터 호스트의 VM 인스턴스 이름입니다. 이름은 소문자, 숫자, 하이픈으로 지정해야 합니다. 작업자 및 대기 호스트의 VM 인스턴스는 'w'가 있는 동일한 이름을 사용하고 이름에 호스트 번호가 추가됩니다. instanceType문자열 SAP HANA를 실행하는 데 필요한 Compute Engine 가상 머신의 유형입니다. 커스텀 VM 유형이 필요한 경우 사전 정의된 VM 유형을 필요한 수(더 큼)에 가장 가까운 vCPU 수로 지정합니다. 배포가 완료되면 vCPU 수와 메모리 양을 수정합니다. zone문자열 실행할 SAP HANA 시스템을 배포하려는 영역입니다. 서브넷에 선택한 리전에 있어야 합니다. subnetwork문자열 이전 단계에서 만든 서브네트워크 이름입니다. 공유 VPC에 배포하는 경우 이 값을 [SHAREDVPC_PROJECT]/[SUBNETWORK]로 지정합니다. 예를 들면myproject/network1입니다.linuxImage문자열 SAP HANA와 함께 사용할 Linux 운영체제 이미지나 이미지 계열의 이름입니다. 이미지 계열을 지정하려면 계열 이름에 프리픽스 family/를 추가합니다. 예를 들면family/rhel-8-1-sap-ha또는family/sles-15-sp2-sap입니다. 특정 이미지를 지정하려면 이미지 이름만 지정합니다. 사용 가능한 이미지 계열 목록은 Google Cloud 콘솔의 이미지 페이지를 참조하세요.linuxImageProject문자열 사용하려는 이미지가 포함된 Google Cloud 프로젝트입니다. 이 프로젝트는 자체 프로젝트이거나 Google Cloud 이미지 프로젝트일 수 있습니다. Compute Engine 이미지의 경우 rhel-sap-cloud또는suse-sap-cloud를 지정합니다. 운영체제의 이미지 프로젝트를 찾으려면 운영체제 세부정보를 참조하세요.sap_hana_deployment_bucket문자열 이전 단계에서 업로드한 SAP HANA 설치 파일이 포함된 프로젝트의 Cloud Storage 버킷 이름입니다. sap_hana_sid문자열 SAP HANA 시스템 ID입니다. ID는 3자리 영숫자 문자로 구성되고 문자로 시작해야 합니다. 모든 문자는 대문자여야 합니다. sap_hana_instance_number정수 SAP HANA 시스템의 인스턴스 번호입니다(0~99). 기본값은 0입니다. sap_hana_sidadm_password문자열 배포 중에 사용할 운영체제 관리자의 임시 비밀번호입니다. 비밀번호는 8자 이상이어야 하며 최소 대문자 1개, 소문자 1개, 숫자 1개를 포함해야 합니다. sap_hana_system_password문자열 배포 중에 사용할 수 있는 데이터베이스 수퍼유저의 임시 비밀번호입니다. 비밀번호는 8자 이상이어야 하며 최소 대문자 1개, 소문자 1개, 숫자 1개를 포함해야 합니다. sap_hana_worker_nodes정수 필요한 추가 SAP HANA 작업자 호스트의 번호입니다. 작업자 호스트를 1~15개 지정할 수 있습니다. 기본값은 1입니다. sap_hana_standby_nodes정수 필요한 추가 SAP HANA 대기 호스트의 번호입니다. 대기 호스트를 1~3개 지정할 수 있습니다. 기본값은 1입니다. sap_hana_shared_nfs문자열 /hana/shared볼륨의 NFS 마운트 지점입니다. 예를 들면10.151.91.122:/hana_shared_nfs입니다.sap_hana_backup_nfs문자열 /hanabackup볼륨의 NFS 마운트 지점입니다. 예를 들면10.216.41.122:/hana_backup_nfs입니다.networkTag문자열 선택사항입니다. 방화벽 또는 라우팅 목적으로 VM 인스턴스를 나타내는 쉼표로 구분된 하나 이상의 네트워크 태그입니다. publicIP: No를 지정하고 네트워크 태그를 지정하지 않으면 다른 인터넷 액세스 방법을 제공해야 합니다.nic_type문자열 선택사항이지만 가능한 경우 대상 머신 및 OS 버전에 권장됩니다. VM 인스턴스에 사용할 네트워크 인터페이스를 지정합니다. GVNIC또는VIRTIO_NET값을 지정할 수 있습니다. Google 가상 NIC(gVNIC)를 사용하려면linuxImage속성의 값으로 gVNIC를 지원하는 OS 이미지를 지정해야 합니다. OS 이미지 목록은 운영체제 세부정보를 참조하세요.이 속성 값을 지정하지 않으면

Deployment Manager 템플릿 버전instanceType속성에 지정하는 머신 유형에 따라 네트워크 인터페이스가 자동으로 선택됩니다.202302060649이상에서 이 인수를 사용할 수 있습니다.publicIPBoolean 선택사항입니다. 공개 IP 주소를 VM 인스턴스에 추가할지 여부를 결정합니다. 기본값은 Yes입니다.sap_hana_double_volume_size정수 선택사항입니다. HANA 볼륨 크기를 두 배로 늘립니다. 동일한 VM에 여러 SAP HANA 인스턴스 또는 재해 복구 SAP HANA 인스턴스를 배포하려는 경우에 유용합니다. 기본적으로 볼륨 크기는 SAP 인증 및 지원 요구사항을 계속 충족하면서 메모리 사용 공간에 필요한 최소 크기로 자동 계산됩니다. sap_hana_sidadm_uid정수 선택사항입니다. SID_LCadm사용자 ID의 기본값을 재정의합니다. 기본값은 900입니다. SAP 환경 내에서 일관성을 위해 다른 값으로 변경할 수 있습니다.sap_hana_sapsys_gid정수 선택사항입니다. sapsys의 기본 그룹 ID를 재정의합니다. 기본값은 79입니다. sap_deployment_debugBoolean 선택사항입니다. 이 값이 Yes로 설정된 경우 배포 시 상세 배포 로그가 생성됩니다. Google 지원 엔지니어가 디버깅을 사용 설정하도록 요청하지 않는 한 이 설정을 사용하지 마세요.post_deployment_scriptBoolean 선택사항입니다. 배포가 완료된 후 실행할 스크립트의 URL 또는 스토리지 위치입니다. 스크립트는 웹 서버 또는 Cloud Storage 버킷에서 호스팅되어야 합니다. 값이 http://, https:// 또는 gs://로 시작됩니다. 이 스크립트는 템플릿이 만드는 모든 VM에서 실행됩니다. 마스터 인스턴스에서만 실행하려면 스크립트 상단에 검사를 추가해야 합니다. 다음 예시에서는 us-central1-f 영역에 3개의 작업자 호스트와 1개의 대기 호스트가 있는 SAP HANA 수평 확장 시스템을 배포하는 완료된 구성 파일을 보여줍니다. 각 호스트는 Compute Engine 공개 이미지에서 제공하는 Linux 운영체제가 실행되는 n2-highmem-32 VM에 설치됩니다. Filestore에서 NFS 볼륨을 제공합니다. 임시 비밀번호는 배포 및 구성 처리 중에만 사용됩니다. 지정된 커스텀 서비스 계정은 배포된 VM의 서비스 계정이 됩니다.

resources: - name: sap_hana_ha_scaleout type: https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/latest/dm-templates/sap_hana_scaleout/sap_hana_scaleout.py # # By default, this configuration file uses the latest release of the deployment # scripts for SAP on Google Cloud. To fix your deployments to a specific release # of the scripts, comment out the type property above and uncomment the type property below. # # type: https://storage.googleapis.com/cloudsapdeploy/deploymentmanager/YYYYMMDDHHMM/dm-templates/sap_hana_scaleout/sap_hana_scaleout.py # properties: instanceName: hana-scaleout-w-failover instanceType: n2-highmem-32 zone: us-central1-f subnetwork: example-sub-network-sap linuxImage: family/sles-15-sp2-sap linuxImageProject: suse-sap-cloud sap_hana_deployment_bucket: hana2-sp5-rev53 sap_hana_sid: HF0 sap_hana_instance_number: 00 sap_hana_sidadm_password: TempPa55word sap_hana_system_password: TempPa55word sap_hana_worker_nodes: 3 sap_hana_standby_nodes: 1 sap_hana_shared_nfs: 10.74.146.58:/hana_shr sap_hana_backup_nfs: 10.188.249.170:/hana_bup serviceAccount: sap-deploy-example@example-project-123456.다음을 실행하여 인스턴스를 만듭니다.

gcloud deployment-manager deployments create [DEPLOYMENT_NAME] --config [TEMPLATE_NAME].yaml위 명령어는 Deployment Manager를 호출하여 Google Cloud 인프라를 설정한 후 운영체제를 구성하고 SAP HANA를 설치하는 다른 스크립트를 호출합니다.

Deployment Manager에는 제어 기능이 있지만 상태 메시지는 Cloud Shell에 기록됩니다. 스크립트가 호출되면 상태 메시지는 Logging에 기록되고 Logging 로그 확인의 설명대로 Google Cloud 콘솔에서 이 메시지를 볼 수 있습니다.

완료 시간은 다를 수 있지만 일반적으로 전체 프로세스가 완료되는 데 30분 미만이 걸립니다.

배포 확인

배포를 확인하려면 Cloud Logging에서 배포 로그를 확인하고, 기본 호스트와 작업자 호스트의 VM에서 디스크와 서비스를 확인하고, SAP HANA Studio에 시스템을 표시하고, 대기 호스트의 인계 작업을 테스트합니다.

로그 확인

Google Cloud 콘솔에서 Cloud Logging을 열어 설치 진행 상태를 모니터링하고 오류를 확인합니다.

로그를 필터링합니다.

로그 탐색기

로그 탐색기 페이지에서 쿼리 창으로 이동합니다.

리소스 드롭다운 메뉴에서 전역을 선택한 후 추가를 클릭합니다.

전역 옵션이 표시되지 않으면 쿼리 편집기에 다음 쿼리를 입력합니다.

resource.type="global" "Deployment"쿼리 실행을 클릭합니다.

기존 로그 뷰어

- 기존 로그 뷰어 페이지의 기본 선택기 메뉴에서 전역을 로깅 리소스로 선택합니다.

필터링된 로그를 분석합니다.

"--- Finished"가 표시되면 배포 처리가 완료된 것이므로 다음 단계를 진행할 수 있습니다.할당량 오류가 표시되면 다음을 수행합니다.

IAM 및 관리자 할당량 페이지에서 SAP HANA 계획 가이드에 나와 있는 SAP HANA 요구사항을 충족하지 않는 할당량을 늘립니다.

배포 관리자 배포 페이지에서 배포를 삭제하여 설치를 실패한 VM과 영구 디스크를 삭제합니다.

배포를 다시 실행합니다.

VM에 연결하여 디스크 및 SAP HANA 서비스 확인

배포가 완료되면 마스터 호스트와 한 작업자 호스트의 디스크와 서비스를 확인하여 디스크와 SAP HANA 서비스가 제대로 배포되었는지 확인합니다.

Compute Engine VM 인스턴스 페이지에서 마스터 호스트의 VM 인스턴스와 한 작업자 호스트의 VM 인스턴스의 행에 있는 SSH 버튼을 클릭하여 두 VM을 연결합니다.

작업자 호스트에 연결할 때 대기 호스트에 연결되지 않도록 해야 합니다. 대기 호스트는 작업자 호스트와 동일한 이름 지정 규칙을 사용하지만 첫 인계 작업 전에 가장 높은 번호가 지정된 작업자-호스트 서픽스를 포함합니다. 예를 들어 3개의 작업자 호스트와 1개의 대기 호스트가 있는 경우, 첫 인계 작업 전에 대기 호스트의 서픽스가 'w4'입니다.

각 터미널 창에서 루트 사용자로 전환합니다.

sudo su -

각 터미널 창에서 디스크 파일 시스템을 표시합니다.

df -h

마스터 호스트에 다음과 비슷한 출력이 표시됩니다.

hana-scaleout-w-failover:~ # df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 8.0K 126G 1% /dev tmpfs 189G 0 189G 0% /dev/shm tmpfs 126G 18M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda3 45G 5.6G 40G 13% / /dev/sda2 20M 2.9M 18M 15% /boot/efi 10.135.35.138:/hana_shr 1007G 50G 906G 6% /hana/shared tmpfs 26G 0 26G 0% /run/user/473 10.197.239.138:/hana_bup 1007G 0 956G 0% /hanabackup tmpfs 26G 0 26G 0% /run/user/900 /dev/mapper/vg_hana-data 709G 7.7G 702G 2% /hana/data/HF0/mnt00001 /dev/mapper/vg_hana-log 125G 5.3G 120G 5% /hana/log/HF0/mnt00001 tmpfs 26G 0 26G 0% /run/user/1003

작업자 호스트에서

/hana/data디렉터리와/hana/log디렉터리의 마운트는 다릅니다.hana-scaleout-w-failoverw2:~ # df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 8.0K 126G 1% /dev tmpfs 189G 0 189G 0% /dev/shm tmpfs 126G 9.2M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda3 45G 5.6G 40G 13% / /dev/sda2 20M 2.9M 18M 15% /boot/efi tmpfs 26G 0 26G 0% /run/user/0 10.135.35.138:/hana_shr 1007G 50G 906G 6% /hana/shared 10.197.239.138:/hana_bup 1007G 0 956G 0% /hanabackup /dev/mapper/vg_hana-data 709G 821M 708G 1% /hana/data/HF0/mnt00003 /dev/mapper/vg_hana-log 125G 2.2G 123G 2% /hana/log/HF0/mnt00003 tmpfs 26G 0 26G 0% /run/user/1003

대기 호스트에서 데이터 디렉터리와 로그 디렉터리는 대기 호스트가 오류가 발생한 호스트를 인계할 때까지 마운트되지 않습니다.

hana-scaleout-w-failoverw4:~ # df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 8.0K 126G 1% /dev tmpfs 189G 0 189G 0% /dev/shm tmpfs 126G 18M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda3 45G 5.6G 40G 13% / /dev/sda2 20M 2.9M 18M 15% /boot/efi tmpfs 26G 0 26G 0% /run/user/0 10.135.35.138:/hana_shr 1007G 50G 906G 6% /hana/shared 10.197.239.138:/hana_bup 1007G 0 956G 0% /hanabackup tmpfs 26G 0 26G 0% /run/user/1003

각 터미널 창에서 SAP HANA 운영체제 사용자로 변경합니다.

su - SID_LCadm

SID_LC를 구성 파일 템플릿에서 지정한 SID 값으로 바꿉니다. 모든 문자에 소문자를 사용합니다.각 터미널 창에서

hdbnameserver,hdbindexserver등의 SAP HANA 서비스가 인스턴스에서 실행 중인지 확인합니다.HDB info

마스터 호스트에서 다음과 같이 잘린 예시의 출력과 비슷한 출력이 표시됩니다.

hf0adm@hana-scaleout-w-failover:/usr/sap/HF0/HDB00> HDB info USER PID PPID %CPU VSZ RSS COMMAND hf0adm 5936 5935 0.7 18540 6776 -sh hf0adm 6011 5936 0.0 14128 3856 \_ /bin/sh /usr/sap/HF0/HDB00/HDB info hf0adm 6043 6011 0.0 34956 3568 \_ ps fx -U hf0adm -o user:8,pid:8,ppid:8,pcpu:5,vsz:10 hf0adm 17950 1 0.0 23052 3168 sapstart pf=/hana/shared/HF0/profile/HF0_HDB00_hana-scaleout hf0adm 17957 17950 0.0 457332 70956 \_ /usr/sap/HF0/HDB00/hana-scaleout-w-failover/trace/hdb.sa hf0adm 17975 17957 1.8 9176656 3432456 \_ hdbnameserver hf0adm 18334 17957 0.4 4672036 229204 \_ hdbcompileserver hf0adm 18337 17957 0.4 4941180 257348 \_ hdbpreprocessor hf0adm 18385 17957 4.5 9854464 4955636 \_ hdbindexserver -port 30003 hf0adm 18388 17957 1.2 7658520 1424708 \_ hdbxsengine -port 30007 hf0adm 18865 17957 0.4 6640732 526104 \_ hdbwebdispatcher hf0adm 14230 1 0.0 568176 32100 /usr/sap/HF0/HDB00/exe/sapstartsrv pf=/hana/shared/HF0/profi hf0adm 10920 1 0.0 710684 51560 hdbrsutil --start --port 30003 --volume 3 --volumesuffix mn hf0adm 10575 1 0.0 710680 51104 hdbrsutil --start --port 30001 --volume 1 --volumesuffix mn hf0adm 10217 1 0.0 72140 7752 /usr/lib/systemd/systemd --user hf0adm 10218 10217 0.0 117084 2624 \_ (sd-pam)

작업자 호스트에서 다음과 같이 잘린 예시의 출력과 유사한 출력이 표시됩니다.

hf0adm@hana-scaleout-w-failoverw2:/usr/sap/HF0/HDB00> HDB info USER PID PPID %CPU VSZ RSS COMMAND hf0adm 22136 22135 0.3 18540 6804 -sh hf0adm 22197 22136 0.0 14128 3892 \_ /bin/sh /usr/sap/HF0/HDB00/HDB info hf0adm 22228 22197 100 34956 3528 \_ ps fx -U hf0adm -o user:8,pid:8,ppid:8,pcpu:5,vsz:10 hf0adm 9138 1 0.0 23052 3064 sapstart pf=/hana/shared/HF0/profile/HF0_HDB00_hana-scaleout hf0adm 9145 9138 0.0 457360 70900 \_ /usr/sap/HF0/HDB00/hana-scaleout-w-failoverw2/trace/hdb. hf0adm 9163 9145 0.7 7326228 755772 \_ hdbnameserver hf0adm 9336 9145 0.5 4670756 226972 \_ hdbcompileserver hf0adm 9339 9145 0.6 4942460 259724 \_ hdbpreprocessor hf0adm 9385 9145 2.0 7977460 1666792 \_ hdbindexserver -port 30003 hf0adm 9584 9145 0.5 6642012 528840 \_ hdbwebdispatcher hf0adm 8226 1 0.0 516532 52676 hdbrsutil --start --port 30003 --volume 5 --volumesuffix mn hf0adm 7756 1 0.0 567520 31316 /hana/shared/HF0/HDB00/exe/sapstartsrv pf=/hana/shared/HF0/p

대기 호스트에서 다음과 같이 잘린 예시의 출력과 비슷한 출력이 표시됩니다.

hana-scaleout-w-failoverw4:~ # su - hf0adm hf0adm@hana-scaleout-w-failoverw4:/usr/sap/HF0/HDB00> HDB info USER PID PPID %CPU VSZ RSS COMMAND hf0adm 19926 19925 0.2 18540 6748 -sh hf0adm 19987 19926 0.0 14128 3864 \_ /bin/sh /usr/sap/HF0/HDB00/HDB info hf0adm 20019 19987 0.0 34956 3640 \_ ps fx -U hf0adm -o user:8,pid:8,ppid:8,pcpu:5,vsz:10 hf0adm 8120 1 0.0 23052 3232 sapstart pf=/hana/shared/HF0/profile/HF0_HDB00_hana-scaleout hf0adm 8127 8120 0.0 457348 71348 \_ /usr/sap/HF0/HDB00/hana-scaleout-w-failoverw4/trace/hdb. hf0adm 8145 8127 0.6 7328784 708284 \_ hdbnameserver hf0adm 8280 8127 0.4 4666916 223892 \_ hdbcompileserver hf0adm 8283 8127 0.4 4939904 256740 \_ hdbpreprocessor hf0adm 8328 8127 0.4 6644572 534044 \_ hdbwebdispatcher hf0adm 7374 1 0.0 633568 31520 /hana/shared/HF0/HDB00/exe/sapstartsrv pf=/hana/shared/HF0/p

RHEL for SAP 9.0 이상을 사용하는 경우

chkconfig및compat-openssl11패키지가 VM 인스턴스에 설치되어 있는지 확인합니다.SAP의 자세한 내용은 SAP Note 3108316 - Red Hat Enterprise Linux 9.x: Installation and Configuration을 참조하세요.

SAP HANA Studio 연결

SAP HANA Studio에서 마스터 SAP HANA 호스트에 연결합니다.

Google Cloud 외부의 SAP HANA Studio 인스턴스 또는 Google Cloud의 인스턴스에서 연결할 수 있습니다. 대상 VM과 SAP HANA Studio 간에 네트워크 액세스를 사용 설정해야 할 수도 있습니다.

Google Cloud 에서 SAP HANA Studio를 사용하고 SAP HANA 시스템에 대한 액세스를 사용 설정하려면 Compute Engine Windows VM에 SAP HANA Studio 설치를 참조하세요.

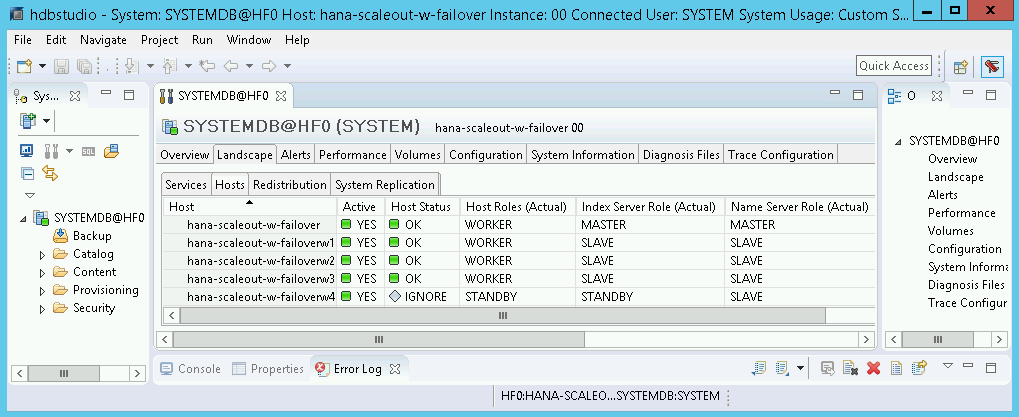

SAP HANA Studio의 기본 시스템 관리 패널에서 가로 모드 탭을 클릭합니다. 다음 예와 비슷한 화면이 표시됩니다.

검증 단계에서 설치에 실패한 단계를 하나라도 발견한 경우 다음을 수행합니다.

- 오류를 수정합니다.

- Deployments(배포) 페이지에서 배포를 삭제합니다.

- 배포를 다시 실행합니다.

장애 조치 테스트 수행

SAP HANA 시스템이 성공적으로 배포되었는지 확인한 다음 장애 조치 기능을 테스트합니다.

다음 안내는 SAP HANA 운영체제 사용자로 전환하고 HDB stop 명령어를 입력하여 장애 조치를 트리거합니다. HDB stop 명령어는 SAP HANA의 단계적 종료를 시작하고 호스트에서 디스크를 분리하므로 상대적으로 빠른 장애 조치가 사용 설정됩니다.

장애 조치 테스트를 수행하려면 다음 안내를 따르세요.

SSH를 사용하여 작업자 호스트의 VM에 연결합니다. 각 VM 인스턴스의 SSH 버튼을 클릭하여 Compute Engine VM 인스턴스 페이지에서 연결하거나 선호하는 SSH 방법을 사용할 수 있습니다.

SAP HANA 운영체제 사용자로 변경합니다. 다음 예시에서

SID_LC를 시스템에 정의한 SID로 바꿉니다.su - SID_LCadm

SAP HANA를 중지하여 오류를 시뮬레이션합니다.

HDB stop

HDB stop명령어는 SAP HANA 종료를 시작하여 장애 조치를 트리거합니다. 장애 조치 동안 디스크가 오류가 발생한 호스트에서 분리되고 대기 호스트에 다시 연결됩니다. 오류가 발생한 호스트는 다시 시작되어 대기 호스트가 됩니다.인계 작업이 완료될 때까지 기다린 후에 SSH를 사용하여 장애가 발생한 호스트를 대신할 호스트에 다시 연결합니다.

루트 사용자로 변경합니다.

sudo su -

마스터 및 작업자 호스트에 대한 VM의 디스크 파일 시스템을 표시합니다.

df -h

다음과 비슷한 출력이 표시됩니다. 이제 오류가 발생한 호스트의

/hana/data디렉터리와/hana/log디렉터리가 인계할 호스트에 마운트됩니다.hana-scaleout-w-failoverw4:~ # df -h Filesystem Size Used Avail Use% Mounted on devtmpfs 126G 8.0K 126G 1% /dev tmpfs 189G 0 189G 0% /dev/shm tmpfs 126G 9.2M 126G 1% /run tmpfs 126G 0 126G 0% /sys/fs/cgroup /dev/sda3 45G 5.6G 40G 13% / /dev/sda2 20M 2.9M 18M 15% /boot/efi tmpfs 26G 0 26G 0% /run/user/0 10.74.146.58:/hana_shr 1007G 50G 906G 6% /hana/shared 10.188.249.170:/hana_bup 1007G 0 956G 0% /hanabackup /dev/mapper/vg_hana-data 709G 821M 708G 1% /hana/data/HF0/mnt00003 /dev/mapper/vg_hana-log 125G 2.2G 123G 2% /hana/log/HF0/mnt00003 tmpfs 26G 0 26G 0% /run/user/1003

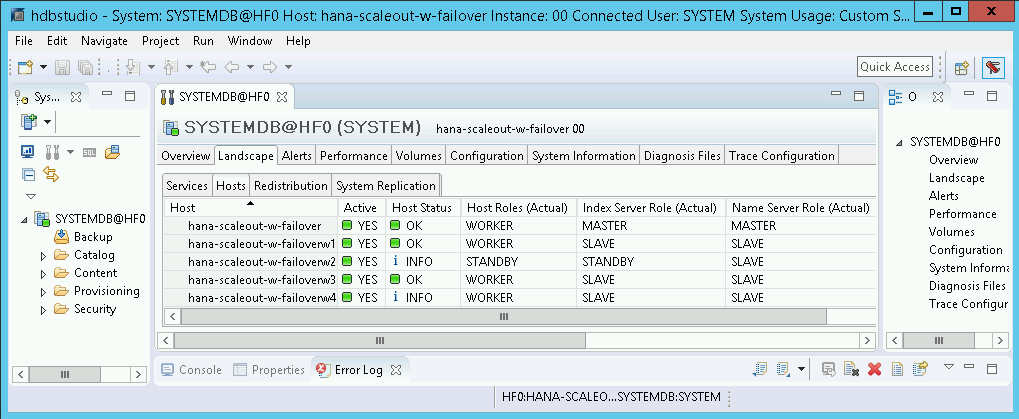

SAP HANA Studio에서 SAP HANA 시스템의 가로 모드 뷰를 열어서 장애 조치가 성공했는지 확인합니다.

- 장애 조치와 관련된 호스트의 상태는

INFO여야 합니다. - 인덱스 서버 역할(실제) 열은 장애가 발생한 호스트를 새로운 대기 호스트로 표시해야 합니다.

- 장애 조치와 관련된 호스트의 상태는

SAP용 Google Cloud에이전트 설치 검증

VM을 배포하고 SAP 시스템을 설치했으면 SAP용Google Cloud에이전트가 올바르게 작동하는지 확인합니다.

SAP용 Google Cloud에이전트가 실행 중인지 확인

에이전트가 실행 중인지 확인하려면 다음 단계를 따릅니다.

Compute Engine 인스턴스와 SSH 연결을 설정합니다.

다음 명령어를 실행합니다.

systemctl status google-cloud-sap-agent

에이전트가 올바르게 작동하는 경우 출력에

active (running)이 포함됩니다. 예를 들면 다음과 같습니다.google-cloud-sap-agent.service - Google Cloud Agent for SAP Loaded: loaded (/usr/lib/systemd/system/google-cloud-sap-agent.service; enabled; vendor preset: disabled) Active: active (running) since Fri 2022-12-02 07:21:42 UTC; 4 days ago Main PID: 1337673 (google-cloud-sa) Tasks: 9 (limit: 100427) Memory: 22.4 M (max: 1.0G limit: 1.0G) CGroup: /system.slice/google-cloud-sap-agent.service └─1337673 /usr/bin/google-cloud-sap-agent

에이전트가 실행되고 있지 않으면 에이전트를 다시 시작합니다.

SAP 호스트 에이전트가 측정항목을 수신하는지 확인

SAP용Google Cloud에이전트에서 인프라 측정항목을 수집하고 SAP 호스트 에이전트로 올바르게 전송하는지 확인하려면 다음 단계를 수행합니다.

- SAP 시스템에서

ST06트랜잭션을 입력합니다. 개요 창에서 다음 필드의 가용성과 콘텐츠를 확인하여 SAP 및 Google 모니터링 인프라의 엔드 투 엔드 설정이 올바른지 확인합니다.

- 클라우드 제공업체:

Google Cloud Platform - 향상된 모니터링 액세스:

TRUE - 향상된 모니터링 세부정보:

ACTIVE

- 클라우드 제공업체:

SAP HANA 모니터링 설정

원하는 경우 SAP용Google Cloud에이전트를 사용하여 SAP HANA 인스턴스를 모니터링할 수 있습니다. 버전 2.0부터는 에이전트에서 SAP HANA 모니터링 측정항목을 수집하고 Cloud Monitoring으로 전송하도록 구성할 수 있습니다. Cloud Monitoring을 사용하면 대시보드를 만들어 이러한 측정항목을 시각화하고 측정항목 기준점을 기반으로 알림을 설정할 수 있습니다.

SAP용Google Cloud에이전트를 사용하여 SAP HANA 모니터링 측정항목 수집에 대한 자세한 내용은 SAP HANA 모니터링 측정항목 수집을 참조하세요.

SAP HANA 빠른 다시 시작 사용 설정

특히 큰 인스턴스의 경우Google Cloud 는 SAP HANA의 각 인스턴스에 SAP HANA 빠른 다시 시작을 사용 설정하는 것을 강력히 권장합니다. SAP HANA 빠른 다시 시작은 SAP HANA가 종료되지만 운영체제는 계속 실행되는 경우 다시 시작하는 시간을 줄입니다.

Google Cloud 에서 제공하는 자동화 스크립트에서 구성한 대로 운영체제와 커널 설정에서는 이미 SAP HANA 빠른 재시작을 지원합니다.

tmpfs 파일 시스템을 정의하고 SAP HANA를 구성해야 합니다.

tmpfs 파일 시스템을 정의하고 SAP HANA를 구성하려면 수동 단계를 수행하거나Google Cloud 에서 제공하는 자동화 스크립트를 사용하여 SAP HANA 빠른 다시 시작을 사용 설정하면 됩니다. 자세한 내용은 다음을 참조하세요.

SAP HANA 빠른 다시 시작 옵션에 대한 전체 안내는 SAP HANA 빠른 다시 시작 옵션 문서를 참조하세요.

수동 단계

tmpfs 파일 시스템 구성

호스트 VM 및 기본 SAP HANA 시스템이 성공적으로 배포되면 tmpfs 파일 시스템에 NUMA 노드의 디렉터리를 만들고 마운트해야 합니다.

VM의 NUMA 토폴로지 표시

필요한 tmpfs 파일 시스템을 매핑하려면 먼저 VM에 있는 NUMA 노드 수를 알아야 합니다. Compute Engine VM에 사용 가능한 NUMA 노드를 표시하려면 다음 명령어를 입력합니다.

lscpu | grep NUMA

예를 들어 m2-ultramem-208 VM 유형에는 다음 예시와 같이 0~3으로 번호가 지정된 4개의 NUMA 노드가 있습니다.

NUMA node(s): 4 NUMA node0 CPU(s): 0-25,104-129 NUMA node1 CPU(s): 26-51,130-155 NUMA node2 CPU(s): 52-77,156-181 NUMA node3 CPU(s): 78-103,182-207

NUMA 노드 디렉터리 만들기

VM에서 각 NUMA 노드의 디렉터리를 만들고 권한을 설정합니다.

예를 들어 0~3으로 번호가 지정된 4개의 NUMA 노드는 다음과 같습니다.

mkdir -pv /hana/tmpfs{0..3}/SID

chown -R SID_LCadm:sapsys /hana/tmpfs*/SID

chmod 777 -R /hana/tmpfs*/SIDNUMA 노드 디렉터리를 tmpfs에 마운트

tmpfs 파일 시스템 디렉터리를 마운트하고 각각에 대해 mpol=prefer로 NUMA 노드 기본 설정을 지정합니다.

SID: SID를 대문자로 지정합니다.

mount tmpfsSID0 -t tmpfs -o mpol=prefer:0 /hana/tmpfs0/SID mount tmpfsSID1 -t tmpfs -o mpol=prefer:1 /hana/tmpfs1/SID mount tmpfsSID2 -t tmpfs -o mpol=prefer:2 /hana/tmpfs2/SID mount tmpfsSID3 -t tmpfs -o mpol=prefer:3 /hana/tmpfs3/SID

/etc/fstab 업데이트

운영체제 재부팅 후 마운트 지점을 사용할 수 있도록 하려면 파일 시스템 테이블 /etc/fstab에 항목을 추가합니다.

tmpfsSID0 /hana/tmpfs0/SID tmpfs rw,nofail,relatime,mpol=prefer:0 tmpfsSID1 /hana/tmpfs1/SID tmpfs rw,nofail,relatime,mpol=prefer:1 tmpfsSID1 /hana/tmpfs2/SID tmpfs rw,nofail,relatime,mpol=prefer:2 tmpfsSID1 /hana/tmpfs3/SID tmpfs rw,nofail,relatime,mpol=prefer:3

선택사항: 메모리 사용량 한도 설정

tmpfs 파일 시스템은 동적으로 확장 및 축소할 수 있습니다.

tmpfs 파일 시스템에서 사용하는 메모리를 제한하려면 size 옵션을 사용하여 NUMA 노드 볼륨의 크기 제한을 설정하면 됩니다.

예를 들면 다음과 같습니다.

mount tmpfsSID0 -t tmpfs -o mpol=prefer:0,size=250G /hana/tmpfs0/SID

global.ini 파일의 [memorymanager] 섹션에서 persistent_memory_global_allocation_limit 파라미터를 설정하여 특정 SAP HANA 인스턴스 및 지정된 서버 노드의 모든 NUMA 노드에 대한 전체 tmpfs 메모리 사용량을 제한할 수도 있습니다.

빠른 다시 시작을 위한 SAP HANA 구성

빠른 다시 시작을 위해 SAP HANA를 구성하려면 global.ini 파일을 업데이트하고 영구 메모리에 저장할 테이블을 지정합니다.

global.ini 파일에서 [persistence] 섹션 업데이트

SAP HANA global.ini 파일에서 tmpfs 섹션을 참조하도록 [persistence] 섹션을 구성합니다. 각 tmpfs 위치를 세미콜론으로 구분합니다.

[persistence] basepath_datavolumes = /hana/data basepath_logvolumes = /hana/log basepath_persistent_memory_volumes = /hana/tmpfs0/SID;/hana/tmpfs1/SID;/hana/tmpfs2/SID;/hana/tmpfs3/SID

앞의 예시는 m2-ultramem-208에 해당하는 4개의 NUMA 노드에 메모리 볼륨 4개를 지정합니다. m2-ultramem-416에서 실행 중인 경우 메모리 볼륨 8개(0~7)를 구성해야 합니다.

global.ini 파일을 수정한 후 SAP HANA를 다시 시작합니다.

이제 SAP HANA에서 tmpfs 위치를 영구 메모리 공간으로 사용할 수 있습니다.

영구 메모리에 저장할 테이블 지정

영구 메모리에 저장할 특정 열 테이블 또는 파티션을 지정합니다.

예를 들어 기존 테이블에 영구 메모리를 사용 설정하려면 SQL 쿼리를 실행합니다.

ALTER TABLE exampletable persistent memory ON immediate CASCADE

새 테이블의 기본값을 변경하려면 indexserver.ini 파일에 table_default 파라미터를 추가합니다. 예를 들면 다음과 같습니다.

[persistent_memory] table_default = ON

열, 테이블 제어 방법 및 자세한 정보를 제공하는 모니터링 뷰에 대한 자세한 내용은 SAP HANA 영구 메모리를 참조하세요.

자동 단계

SAP HANA 빠른 다시 시작을 사용 설정하도록 Google Cloud 에서 제공하는 자동화 스크립트는 /hana/tmpfs* 디렉터리, /etc/fstab 파일, SAP HANA 구성을 변경합니다. 스크립트를 실행할 때 SAP HANA 시스템의 초기 배포인지 여부 또는 머신 크기를 다른 NUMA 크기로 조절하는지 여부에 따라 추가 단계를 수행해야 할 수 있습니다.

SAP HANA 시스템을 처음 배포하거나 머신 크기를 조절하여 NUMA 노드 수를 늘리려면 SAP HANA 빠른 다시 시작을 사용 설정하도록 Google Cloud에서 제공하는 자동화 스크립트를 실행하는 동안 SAP HANA가 실행 중인지 확인합니다.

NUMA 노드 수가 줄어들도록 머신 크기를 조절하는 경우 SAP HANA 빠른 다시 시작을 사용 설정하도록 Google Cloud 에서 제공하는 자동화 스크립트를 실행하는 동안 SAP HANA가 중지되었는지 확인합니다. 스크립트가 실행된 후 SAP HANA 구성을 수동으로 업데이트하여 SAP HANA 빠른 다시 시작 설정을 완료해야 합니다. 자세한 내용은 빠른 다시 시작을 위한 SAP HANA 구성을 참조하세요.

SAP HANA 빠른 다시 시작을 사용 설정하려면 다음 단계를 수행합니다.

호스트 VM과의 SSH 연결을 설정합니다.

루트로 전환하기:

sudo su -

sap_lib_hdbfr.sh스크립트 다운로드:wget https://storage.googleapis.com/cloudsapdeploy/terraform/latest/terraform/lib/sap_lib_hdbfr.sh

파일을 실행 가능하게 만듭니다.

chmod +x sap_lib_hdbfr.sh

스크립트에 오류가 없는지 확인합니다.

vi sap_lib_hdbfr.sh ./sap_lib_hdbfr.sh -help

명령어에서 오류를 반환하면 Cloud Customer Care팀에 문의하세요. Cloud Customer Care 문의 정보는 Google Cloud기반 SAP 지원 받기를 참조하세요.

SAP HANA 데이터베이스의 SYSTEM 사용자에 대한 SAP HANA 시스템 ID(SID)와 비밀번호를 바꾼 후 스크립트를 실행합니다. 비밀번호를 안전하게 제공하려면 Secret Manager에서 보안 비밀을 사용하는 것이 좋습니다.

Secret Manager에서 보안 비밀 이름을 사용하여 스크립트를 실행합니다. 이 보안 비밀은 호스트 VM 인스턴스가 포함된 Google Cloud 프로젝트에 있어야 합니다.

sudo ./sap_lib_hdbfr.sh -h 'SID' -s SECRET_NAME

다음을 바꿉니다.

SID: 대문자로 SID를 지정합니다. 예를 들면AHA입니다.SECRET_NAME: SAP HANA 데이터베이스의 SYSTEM 사용자에 대한 비밀번호에 해당하는 보안 비밀의 이름을 지정합니다. 이 보안 비밀은 호스트 VM 인스턴스가 포함된 Google Cloud 프로젝트에 있어야 합니다.

또는 일반 텍스트 비밀번호를 사용하여 스크립트를 실행할 수 있습니다. SAP HANA 빠른 다시 시작을 사용 설정한 후에 비밀번호를 변경해야 합니다. VM의 명령줄 기록에 비밀번호가 기록되므로 일반 텍스트 비밀번호를 사용하지 않는 것이 좋습니다.

sudo ./sap_lib_hdbfr.sh -h 'SID' -p 'PASSWORD'

다음을 바꿉니다.

SID: 대문자로 SID를 지정합니다. 예를 들면AHA입니다.PASSWORD: SAP HANA 데이터베이스의 SYSTEM 사용자에 대한 비밀번호를 지정합니다.

초기 실행이 성공하면 다음과 비슷한 출력이 표시됩니다.

INFO - Script is running in standalone mode

ls: cannot access '/hana/tmpfs*': No such file or directory

INFO - Setting up HANA Fast Restart for system 'TST/00'.

INFO - Number of NUMA nodes is 2

INFO - Number of directories /hana/tmpfs* is 0

INFO - HANA version 2.57

INFO - No directories /hana/tmpfs* exist. Assuming initial setup.

INFO - Creating 2 directories /hana/tmpfs* and mounting them

INFO - Adding /hana/tmpfs* entries to /etc/fstab. Copy is in /etc/fstab.20220625_030839

INFO - Updating the HANA configuration.

INFO - Running command: select * from dummy

DUMMY

"X"

1 row selected (overall time 4124 usec; server time 130 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('global.ini', 'SYSTEM') SET ('persistence', 'basepath_persistent_memory_volumes') = '/hana/tmpfs0/TST;/hana/tmpfs1/TST;'

0 rows affected (overall time 3570 usec; server time 2239 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('global.ini', 'SYSTEM') SET ('persistent_memory', 'table_unload_action') = 'retain';

0 rows affected (overall time 4308 usec; server time 2441 usec)

INFO - Running command: ALTER SYSTEM ALTER CONFIGURATION ('indexserver.ini', 'SYSTEM') SET ('persistent_memory', 'table_default') = 'ON';

0 rows affected (overall time 3422 usec; server time 2152 usec)

SAP HANA에 연결

이 안내에서는 SAP HANA에 외부 IP를 사용하지 않으므로 SSH를 사용하는 배스천 인스턴스를 통해 또는 SAP HANA Studio를 사용하는 Windows 서버를 통해 SAP HANA 인스턴스에 연결할 수 있습니다.

배스천 인스턴스를 통해 SAP HANA에 연결하려면 원하는 SSH 클라이언트를 사용하여 배스천 호스트에 연결한 다음 SAP HANA 인스턴스에 연결합니다.

SAP HANA Studio를 통해 SAP HANA 데이터베이스에 연결하려면 원격 데스크톱 클라이언트를 사용하여 Windows Server 인스턴스에 연결합니다. 연결 후 수동으로 SAP HANA Studio를 설치하고 SAP HANA 데이터베이스에 액세스합니다.

배포 후 작업 수행

SAP HANA 인스턴스를 사용하기 전에 다음과 같은 배포 후 단계를 수행하는 것이 좋습니다. 자세한 내용은 SAP HANA 설치 및 업데이트 가이드를 참조하세요.

SAP HANA 시스템 관리자와 데이터베이스 수퍼유저의 임시 비밀번호를 변경합니다.

SAP HANA 소프트웨어를 최신 패치로 업데이트합니다.

Application Function Libraries(AFL) 또는 Smart Data Access(SDA)와 같은 추가 구성요소를 설치합니다.

기존 SAP HANA 시스템을 업그레이드하는 경우 표준 백업 및 복원 절차를 사용하거나 SAP HANA 시스템 복제를 사용하여 기존 시스템에서 데이터를 로드합니다.

새로운 SAP HANA 데이터베이스를 구성 및 백업합니다. 자세한 내용은 SAP HANA 운영 가이드를 참조하세요.

다음 단계

- VM 관리 및 모니터링에 대한 자세한 내용은 SAP HANA 작업 가이드를 참조하세요.