En esta guía de planificación, se proporciona a los administradores de SAP y Google Cloud la información que necesitan para planificar la replicación de los datos de SAP en BigQuery a través de la versión 2.9 (la más reciente) de BigQuery Connector para SAP con SAP LT Replication Server.

En esta guía, se abarcan los siguientes temas:

- Requisitos de software

- Seguridad

- Redes

- Planificación del rendimiento

- Opciones de asignación de tablas y campos

- Ciclo de vida de la asistencia

Si deseas obtener información sobre los aceleradores de soluciones para el modelado de datos de SAP en BigQuery, consulta Google Cloud Cortex Framework.

Requisitos de software

En esta sección, se describen los requisitos de software para BigQuery Connector para SAP.

Puedes instalar BigQuery Connector para SAP en SAP LT Replication Server en Google Cloud, en entornos locales o en nubes públicas, como AWS, Azure, etcétera.

Requisitos de versiones de software de SAP

Las versiones requeridas de SAP LT Replication Server y los sistemas de origen de SAP difieren según si instalas SAP LT Replication Server en su propio servidor en una arquitectura independiente o dentro del sistema de aplicaciones de origen ABAP en una arquitectura incorporada.

Los requisitos del software de SAP también son diferentes según el sistema de SAP que uses como fuente de datos: SAP S/4HANA o SAP ECC.

Para ver las versiones de software de SAP con las que Google Cloud admite BigQuery Connector para SAP, selecciona la pestaña que corresponda a tu sistema de origen de SAP:

S/4HANA

| Arquitectura de instalación | Sistema | Versiones compatibles | Complemento de la interfaz de usuario (IU) |

|---|---|---|---|

| Independiente | Sistema de origen |

|

Asegúrate de que el complemento de IU sea la versión más reciente compatible con tu versión de SAP NetWeaver, según lo recomienda SAP. /UI2/CL_JSON: PL12 o versión posterior. Para obtener información sobre la versión mínima requerida del complemento de IU, consulta la sección "Paquete de asistencia" en la Nota de SAP 22798102 - correcciones /UI2/CL_JSON - PL12. Para obtener información sobre la compatibilidad del complemento de IU con SAP NetWeaver, consulta los siguientes vínculos:

|

| SAP LT Replication Server |

|

||

| Incorporado | Sistema de origen |

|

ECC

| Arquitectura de instalación | Sistema | Versiones compatibles | Complemento de la interfaz de usuario (IU) |

|---|---|---|---|

| Independiente | Sistema de origen |

|

Asegúrate de que el complemento de IU sea la versión más reciente compatible con tu versión de SAP NetWeaver, según lo recomienda SAP. /UI2/CL_JSON: PL12 o versión posterior. Para obtener información sobre la versión mínima requerida del complemento de IU, consulta la sección "Paquete de asistencia" en la Nota de SAP 22798102 - correcciones /UI2/CL_JSON - PL12. Para obtener información sobre la compatibilidad del complemento de IU con SAP NetWeaver, consulta los siguientes vínculos:

|

| SAP LT Replication Server |

|

||

| Incorporado | Sistema de origen |

|

Requisitos del sistema operativo

BigQuery Connector para SAP es compatible con cualquier sistema operativo compatible con SAP LT Replication Server.

Para obtener información sobre los sistemas operativos que admite SAP LT Replication Server, consulta Matriz de disponibilidad del producto de SAP.

Requisito de la cuenta de Facturación de Cloud

Aunque BigQuery Connector para SAP se ofrece sin costo en este momento, necesitas una cuenta de Facturación de Cloud para recibir el paquete de instalación.

Escalabilidad

En volúmenes muy grandes, como miles de millones de registros de datos con millones de deltas, BigQuery Connector para SAP usa funciones de escalamiento y de partición de SAP LT Replication Server para paralelizar la extracción de datos a gran escala. Para obtener más información, consulta la Guía de tamaño de tu versión de SAP LT Replication Server en el Portal de ayuda de SAP.

En el lado de Google Cloud , según tu ruta de replicación, BigQuery Connector para SAP usa diferentes servicios de Google Cloud para escalar la carga de datos:

- Para la replicación de CDC a través de Pub/Sub, BigQuery Connector para SAP usa la API de Pub/Sub y la API de Storage Write.

- Para la replicación de datos de transmisión, BigQuery Connector para SAP usa la API de transmisión de BigQuery.

Fuentes de replicación compatibles

BigQuery Connector para SAP admite la mayoría de los sistemas de origen de aplicaciones y bases de datos de uso común compatibles con SAP LT Replication Server.

Fuentes compatibles de aplicaciones de SAP

Puedes replicar datos de las fuentes de la aplicación de SAP que admite SAP LT Replication Server. BigQuery Connector para SAP admite las principales versiones de aplicaciones empresariales en mantenimiento como fuentes de datos, así como aplicaciones heredadas más antiguas. Algunas de las aplicaciones de SAP compatibles son las siguientes:

- SAP Business Suite 7

- S/4HANA

- Aplicaciones SAP que se ejecutan en SAP NetWeaver

Para replicar datos de SAP Business Warehouse, SAP recomienda no usar SAP LT Replication Server. Para obtener más información de SAP, consulta la Nota SAP 2525755.

Las aplicaciones SAP Cloud, como S/4HANA Cloud, SAP Ariba, SAP SuccessFactors y otras no son compatibles.

Fuentes de datos compatibles

Solo puedes replicar tablas transparentes o de clúster.

BigQuery Connector para SAP no admite las vistas de SAP Core Data Services (CDS) de replicación.

En la herramienta de diseño de la información, BigQuery es compatible a partir de SAP BusinessObjects Business Intelligence 4.3 como fuente de datos. Puedes consultar datos almacenados en BigQuery desde las herramientas de informes de SAP BusinessObjects, como SAP BusinessObjects Web Intelligence y SAP Crystal Reporting para Enterprise, entre otras.

Para obtener más información sobre la nota de SAP 2750723: Asistencia de Google BigQuery en productos de la plataforma SAP BI, verifica la compatibilidad.

Seguridad

Cuando implementas la seguridad para la replicación de datos de SAP LT Replication Server a BigQuery, debes implementar controles de seguridad en SAP LT Replication Server, el sistema operativo host de SAP LT Replication Server y enGoogle Cloud.

Para la comunicación entre BigQuery Connector para SAP y BigQuery, BigQuery Connector para SAP usa la comunicación HTTPS de extremo a extremo y SSL.

Seguridad de SAP

Para controlar quién puede configurar y trabajar con BigQuery Connector para SAP en SAP LT Replication Server, usa la autorización estándar basada en roles de SAP.

BigQuery Connector para SAP proporciona el objeto de autorización ZGOOG_MTID como parte de la instalación del transporte.

Para configurar y ejecutar trabajos de replicación de datos que usan BigQuery Connector para SAP, puedes definir un rol que tenga acceso de administrador dentro de SAP LT Replication Server, como se describe en Crea roles y autorizaciones de SAP para BigQuery Connector para SAP.

Por ejemplo, puedes definir un rol llamado ZGOOGLE_BIGQUERY_ADMIN que tenga todas las autorizaciones de SAP y las autorizaciones ZGOOG_MTID necesarias para configurar y operar la replicación de datos en BigQuery a través de BigQuery Connector para SAP

Para obtener más información de SAP sobre los roles y la autorización, consulta la Guía de seguridad de la versión de SAP LT Replication Server en el Portal de ayuda de SAP.

Google Cloud seguridad

La implementación de la seguridad en Google Cloud para BigQuery Connector para SAP puede incluir los siguientes controles de seguridad:

- Permisos, roles, cuentas de servicio y claves de la administración de identidades y accesos (IAM).

- Controles de BigQuery que se establecen a nivel del conjunto de datos o de la tabla.

- Controles del servicio de nube privada virtual (VPC) para servicios basados en API, como BigQuery.

- Extremos de Private Service Connect que permiten el consumo privado de servicios, como BigQuery, en redes de VPC.

Google Cloud Identity and Access Management

Para la autenticación y autorización de BigQuery Connector para SAP, necesitas una cuenta de servicio de IAM en el proyecto deGoogle Cloud que contiene tu conjunto de datos de BigQuery.

Para obtener autorización para interactuar con los recursos de Google Cloud , debes otorgar roles a la cuenta de servicio que contiene permisos para interactuar con los servicios de BigQuery y Pub/Sub.

Para la replicación de datos de transmisión (solo inserción), los permisos que BigQuery Connector para SAP necesita para acceder a BigQuery se encuentran en los siguientes roles de IAM:

Para la replicación de captura de datos de cambio (CDC), los permisos que BigQuery Connector para SAP necesita para acceder a Pub/Sub y BigQuery se encuentran en los siguientes roles de IAM:

Si SAP LT Replication Server se ejecuta en una VM de Compute Engine, también debes otorgar la función de creador de tokens de cuenta de servicio a la cuenta de servicio de la VM del host.

Si SAP LT Replication Server se ejecuta de forma local o en otra plataforma en la nube, además de crear una cuenta de servicio, debes crear una clave de cuenta de servicio para BigQuery Connector para SAP. Tu administrador de SAP instala la clave en el host de SAP LT Replication Server. Cuando BigQuery Connector para SAP se conecta a Pub/Sub o BigQuery, SAP LT Replication Server usa la clave de la cuenta de servicio para autenticarse conGoogle Cloud.

No se requiere una clave de cuenta de servicio cuando SAP LT Replication Server se ejecuta en Google Cloud.

Para obtener más información sobre IAM, las cuentas de servicio, los roles y los permisos, consulta los siguientes documentos:

- Cuentas de servicio

- Autentícate como cuenta de servicio

- Recomendaciones para las cuentas de servicio

- Introducción a la autenticación de la API de BigQuery

Controles de acceso a tablas y conjuntos de datos de BigQuery

Además de los controles de IAM, también puedes controlar el acceso a través de BigQuery. En BigQuery Connector para SAP, puedes establecer controles de acceso en conjuntos de datos y tablas.

Para obtener más información, consulte:

Controles del servicio de VPC

En Google Cloud, las reglas de firewall de VPC no son aplicables a las interacciones basadas en API con BigQuery. En su lugar, puedes usar los Controles del servicio de nube privada virtual (VPC) para restringir el tráfico.

Si tu carga de trabajo de SAP se ejecuta en Google Cloud, puedes implementar controles de servicios de VPC si defines perímetros de servicio. Para obtener más información, consulta Perímetros de servicio.

Si tu carga de trabajo de SAP no se ejecuta en Google Cloud, puedes implementar controles de servicios de VPC como parte de la configuración del Acceso privado a Google para hosts locales.

Si deseas obtener más información sobre la seguridad de la red de BigQuery, consulta Seguridad de red.

Extremos de Private Service Connect

Si deseas configurar extremos en tu red de VPC que permitan el consumo privado de servicios administrados por Google, como BigQuery, puedes usar Private Service Connect.

Private Service Connect te permite crear extremos privados que usan direcciones IP internas de un rango de CIDR de VPC para acceder a los servicios y las APIs de Google. También puedes usar Private Service Connect para crear un nombre de DNS privado personalizado para la API de transmisión de BigQuery. Para obtener más información, consulta Private Service Connect.

Para BigQuery Connector para SAP que se ejecuta en un host fuera deGoogle Cloud, no se admite Private Service Connect.

Más información sobre la Google Cloud seguridad

Para obtener más información sobre las cuentas de seguridad, los roles y los permisos, consulta los siguientes documentos:

- Cuentas de servicio

- Crea y habilita cuentas de servicio para instancias

- Descripción general de la seguridad y administración de datos

- Autenticación y autorización de BigQuery

Herramientas de redes

Cuando planifiques la ruta de acceso de la red para la replicación en BigQuery, ten en cuenta los siguientes puntos:

- Ancho de banda

- La latencia y su impacto en el consumo de recursos en el host de SAP LT Replication Server

- El volumen de datos y su impacto en cualquier carga de red existente

- Si tu carga de trabajo de SAP no se ejecuta en Google Cloud, qué tipo de conexión usar: Cloud Interconnect o Cloud VPN

Conectando a Google Cloud

Si tus sistemas SAP no se ejecutan en Google Cloud y aún no tienes una conexión de tus sistemas SAP a Google Cloud, debes establecer una conexión y configurar el acceso privado a las APIs de Google Cloud .

Puedes establecer una conexión con Google Cloud a través de Cloud Interconnect o Cloud VPN.

Por lo general, Cloud Interconnect proporciona un mayor ancho de banda, una latencia más baja y una contención de red menor que Cloud VPN. En trabajos de replicación sensibles al rendimiento y de gran volumen, Google Cloudrecomienda Cloud Interconnect para BigQuery Connector para SAP.

Con Cloud VPN, tus datos de replicación viajan a través de la Internet pública, por lo que la contención de red es menos predecible y las latencias suelen ser más altas.

Sin importar la opción de conexión que elijas, debes revisar todo el tráfico que esperas que admita la conexión. Determina si la conexión tiene suficiente ancho de banda y velocidad de red para admitir los trabajos de replicación y cualquier otra carga de trabajo sin afectar de manera negativa.

Las conexiones lentas pueden aumentar el consumo de recursos en el servidor de origen de SAP y el host de SAP LT Replication Server a través de la extensión del tiempo que les lleva a los trabajos de recursos completarse, lo que mantiene los recursos necesarios para la replicación vinculada por períodos más largos.

Para obtener más información sobre tus opciones de conexión, consulta lo siguiente:

- Conectando a Google Cloud

- Descripción general de Cloud Interconnect

- Descripción general de Cloud VPN

Para usar un servidor proxy para enviar las solicitudes HTTP a Google Cloud, te recomendamos que uses destinos RFC definidos en la transacción SM59.

Destinos de RFC

Los archivos de transporte de BigQuery Connector para SAP contienen los siguientes destinos de RFC de muestra en la transacción SM59. Estos destinos de RFC son conexiones HTTP a servidores externos (tipo G) y se conectan al extremo de API pública del servicio correspondiente.

| Nombre de destino de RFC de muestra | Host del destino (extremo de API) | Notas |

|---|---|---|

GOOG_BIGQUERY |

https://bigquery.googleapis.com |

Este destino de RFC se orienta a la API de BigQuery. |

GOOG_PUBSUB |

https://pubsub.googleapis.com |

Este destino de RFC se orienta a la API de Pub/Sub. |

GOOG_IAMCREDENTIALS |

https://iamcredentials.googleapis.com |

Este destino de RFC se orienta a la API de IAM. |

GOOG_OAUTH2_TOKEN |

https://googleapis.com/oauth2 |

Este destino de RFC se orienta al extremo de Google Cloud para la autenticación basada en OAuth 2.0. Debes usarlo para las cargas de trabajo de SAP que se ejecutan fuera de Google Cloud y solo cuando deseas autenticarte en Google Cloud a través del token web JSON (JWT). |

El uso de destinos de RFC para conectarse a Google Cloud ofrece las siguientes ventajas:

Si usas un servidor proxy en tu entorno de SAP y deseas usar el mismo para enviar las solicitudes HTTP a Google Cloud, puedes configurar el servidor proxy en el destino de RFC.

Si deseas habilitar el acceso a las APIs y los servicios de Google Cloud a través de extremos de Private Service Connect, puedes crear esos extremos en tu proyecto deGoogle Cloud y, luego, especificarlos en tus destinos de RFC.

Puedes usar la compresión HTTP, queGoogle Cloud recomienda para las replicaciones entre regiones, en las que el sistema de origen SAP y el conjunto de datos de BigQuery se colocan en diferentes regiones de Compute Engine.

Si quieres usar destinos RFC para conectarte a las APIs o los servicios de Google Cloud , debes crear entradas en la tabla /GOOG/SERVIC_MAP que asignen los destinos RFC a la tabla /GOOG/CLIENT_KEY. Para conocer los pasos de configuración, consulta la guía de instalación y configuración de BigQuery Connector para SAP para tu situación.

Compresión HTTP

Cuando usas destinos de RFC para configurar la conexión entre BigQuery Connector para SAP y las APIs de Google Cloud , puedes usar la opción Compresión para comprimir el cuerpo de la solicitud HTTP. La compresión HTTP solo está disponible cuando configuras tus destinos de RFC para que usen HTTP 1.1.

Antes de habilitar la compresión HTTP en tu entorno de producción, analiza los parámetros de perfil que afectan la compresión HTTP en un entorno de pruebas. Para obtener más información desde SAP, consulta la Nota 1037677 de SAP: la compresión HTTP solo comprime ciertos documentos.

Ancho de banda

Asegúrate de que la conexión de red entre SAP LT Replication Server yGoogle Cloud tenga suficiente ancho de banda para admitir el volumen de datos a la velocidad que necesitas.

Las conexiones de red más lentas aumentan la latencia de la replicación de datos, lo que aumenta los recursos que la replicación usa en el sistema SAP de origen.

Para instalaciones productivas, Google Cloud recomienda una conexión de Cloud Interconnect. También puedes usar Cloud VPN.

Latencia

Para reducir la latencia sobre la conexión de red, crea tu conjunto de datos de destino de BigQuery lo más cercano posible al sistema SAP LT Replication Server y al sistema fuente de SAP. Si el sistema SAP de origen se ejecuta en Google Cloud, crea el conjunto de datos de BigQuery en la misma región Google Cloud que el sistema SAP de origen.

Prueba la latencia antes de migrar la instalación a un entorno de producción.

Para obtener más información sobre el rendimiento de la red, consulta Rendimiento de la conexión de red.

Controles de acceso a la red

Puedes implementar controles de acceso a la red en ambos lados de la conexión entre SAP LT Replication Server y Google Cloud.

Google Cloud Controles de acceso a la red

BigQuery Connector para SAP se comunica con BigQuery a través de un extremo de API, que no está sujeto a las reglas de firewall de VPC Google Cloud.

En su lugar, usa Controles del servicio de VPC para restringir el tráfico.

Si deseas obtener más información sobre la seguridad de la red de BigQuery, consulta Seguridad de red.

Controles de acceso a la red del host de SAP LT Replication Server

En el host de SAP LT Replication Server, debes asegurarte de que los firewalls o proxies permitan el tráfico de salida desde el servidor a los extremos de las APIs de BigQuery y Pub/Sub. Específicamente, asegúrate de que tu servidor de replicación de SAP LT pueda acceder a las siguientes Google Cloud APIs:

https://bigquery.googleapis.comhttps://pubsub.googleapis.comhttps://iamcredentials.googleapis.com

Si deseas usar extremos de Private Service Connect para acceder a las APIs de BigQuery y Pub/Sub, debes configurar los extremos de Private Service Connect en la tabla /GOOG/SERVIC_MAP.

Planificación del rendimiento

El rendimiento de las cargas iniciales y los trabajos de replicación entre SAP LT Replication Server y BigQuery se ve afectado por varios factores en diferentes puntos de la ruta de replicación.

Sin embargo, ciertos factores básicos, como la distancia entre SAP LT Replication Server y tu conjunto de datos de BigQuery o el ancho de banda de tu conexión a Google Cloud, tienen un mayor impacto en el rendimiento que la mayoría de los demás factores.

Prácticas recomendadas para el rendimiento general

Para obtener el mejor rendimiento, incorpora las siguientes recomendaciones en la configuración de SAP LT Replication Server:

- Ejecuta tu carga de trabajo de SAP, incluido el sistema de origen SAP y SAP LT Replication Server, en Google Cloud.

- Si tu carga de trabajo de SAP está en Google Cloud, crea tu conjunto de datos de BigQuery en la misma región que tu carga de trabajo de SAP.

- Si no puedes ejecutar tu carga de trabajo de SAP en Google Cloud, haz lo siguiente:

- Crea tu conjunto de datos de BigQuery en la región Google Cloudmás cercana a tu carga de trabajo de SAP.

- Conéctate a Google Cloud a través de Cloud Interconnect.

- Para evitar la contención de recursos, usa hosts dedicados independientes para el sistema de origen SAP y SAP LT Replication Server.

- Ajusta el tamaño del sistema SAP LT Replication Server de forma óptima para tu carga de trabajo según la Guía de tamaño de la versión de SAP LT Replication Server en el Portal de ayuda de SAP.

- Usa la siguiente configuración de replicación de SAP LT Replication Server:

- Objetos Job paralelos.

- Lectura de Tipo 1, si es posible. Para obtener más información, consulta El rendimiento y la configuración avanzada de la replicación de LTRS.

- Configura BigQuery Connector para SAP con lo siguiente:

- Compresión de registro predeterminada.

- Default chunk size.

- Cuando asignes campos a tu tabla de BigQuery, evita los nombres personalizados, si es posible.

Para obtener más información, consulte:

- Consideraciones sobre el rendimiento de SAP LT Replication Server

- Rendimiento de la conexión de red

- Transmisión de datos

- Compresión de registros

Características adicionales que pueden afectar el rendimiento

Muchas características de la configuración y los datos pueden afectar el rendimiento. Es posible que no puedas modificar algunas de estas características. Estas características incluyen lo siguiente:

- En el servidor de origen:

- La cantidad de CPU.

- La cantidad de memoria.

- La base de datos que se usa, como SAP HANA, SAP ASE, IBM Db2 o alguna otra.

- La cantidad de columnas en la tabla fuente.

- La cantidad de datos que contiene cada registro.

- Los metadatos de la tabla, como la longitud de los nombres de campo.

- La cantidad de procesos de trabajo de diálogo.

- En SAP LT Replication Server, haz lo siguiente:

- La cantidad de CPU.

- La cantidad de memoria.

- Otras cargas de trabajo en las que el host podría estar en ejecución.

- Cuadro de diálogo de SAP y procesos de trabajo en segundo plano.

- El tipo de arquitectura de instalación de SAP LT Replication Server. Para obtener más información, consulta Instalación independiente (recomendado) o incorporada de SAP LT Replication Server.

- La cantidad de trabajos en segundo plano que se ejecutan en el sistema SAP LT Replication Server

- La cantidad de trabajos en segundo plano que se asignan a la transferencia masiva en la pestaña Administración de la transacción

LTRC. - La configuración de rendimiento de la transacción

LTRS, incluidos Tipo de lectura y Tamaño de la parte.

- En la configuración de la replicación de BigQuery (transacción

/GOOG/SLT_SETTINGS):- Si se especifican o no nombres personalizados para los campos de destino. El procesamiento de los nombres de campo de BigQuery de destino puede tener un ligero impacto en el rendimiento.

- Si la compresión de registro está habilitada.

- Tamaño del fragmento, que puede afectar la cantidad total de solicitudes HTTP enviadas.

Consideraciones sobre el rendimiento de SAP LT Replication Server

En las siguientes secciones, se analizan las opciones de rendimiento relacionadas con la configuración de SAP LT Replication Server.

Rendimiento y arquitectura de instalación de SAP LT Replication Server

Una arquitectura independiente, en la que SAP LT Replication Server se instala en su propio servidor dedicado, suele proporcionar un mejor rendimiento que una arquitectura incorporada, en la que SAP LT Replication Server se instala en el mismo servidor que el sistema de origen.

En una arquitectura incorporada, SAP LT Replication Server debe compartir los recursos del servidor con el sistema de origen SAP.

Incluso con una arquitectura independiente, la CPU y la memoria del host, así como cualquier otra carga de trabajo que pueda ejecutarse en el servidor, pueden afectar el rendimiento de una instancia de SAP LT Replication Server.

El rendimiento y la configuración avanzada de la replicación de LTRS

El rendimiento de las cargas iniciales y la replicación se ven afectados por la configuración que especificas para la tabla de origen en la transacción LTRS en Configuración de replicación avanzada.

Si deseas obtener orientación sobre el ajuste del rendimiento, en especial para optimizar las cargas iniciales o la replicación de alto volumen, consulta la Guía de optimización del rendimiento de SAP LT Replication Server en el Portal de ayuda de SAP. .

Google Cloud recomienda las siguientes especificaciones en la sección Configuración avanzada de la replicación > Rendimiento general de la transacción LTRS:

Para cargas iniciales desde la mayoría de los tipos de tablas, especifica 1 Cálculo de rango como Tipo de lectura. En el caso de las tablas que son demasiado grandes para el Cálculo del rango de 1 rango, especifica el Tipo de lectura 5.

En el caso de las replicaciones, en Configuración activa:

- Para las replicaciones más rápidas, especifica Rangos automáticos.

- Para obtener replicaciones más confiables, especifica Sin rangos.

En la siguiente tabla, se sugiere una configuración para algunas situaciones comunes.

| Tipo de tabla | Tipo de lectura recomendado |

|---|---|

| Transparente (pequeña a mediana) | Lectura de tipo 1: cálculo de rangos |

| Transparente (grande) | Solo si la lectura del tipo 1 no funciona, lee el tipo 5: cálculo del rango |

| Tabla del clúster | Lectura tipo 4: cola de remitentes |

Rendimiento de la conexión de red

El ancho de banda y la latencia de la conexión entre el sistema SAP LT Replication Server y Google Cloud pueden afectar el rendimiento general de la replicación en BigQuery.

El impacto afecta no solo la velocidad de replicación, sino también la cantidad de recursos que consume SAP LT Replication Server y el sistema de origen, ya que tarda más en recibir la confirmación de la replicación desde BigQuery. SAP LT Replication Server y el sistema de origen contienen los recursos del host.

Si tu carga de trabajo de SAP se ejecuta de forma local o en otro proveedor de servicios en la nube,Google Cloud recomienda usar una conexión de Cloud Interconnect, que proporciona alto ancho de banda y baja latencia sin tener que competir con el tráfico en la Internet pública.

Puedes usar Cloud VPN para conectarte a Google Cloud y BigQuery, pero, con una conexión de VPN, tus replicaciones deben competir con el tráfico general de Internet.

Si tu carga de trabajo de SAP se ejecuta en Google Cloud, Google Cloudrecomienda ubicar SAP LT Replication Server y tu conjunto de datos de BigQuery en la misma región. Si SAP LT Replication Server y BigQuery están en regiones diferentes, la latencia suele ser más alta y el rendimiento suele ser peor. Si deseas obtener más información para elegir una región, consulta Elige una región y una zona.

Transmisión de datos

Por lo general, deseas enviar la mayor cantidad de datos posible en cada solicitud HTTP para reducir la cantidad general de solicitudes HTTP y la sobrecarga de procesamiento relacionada.

Sin embargo, en algunos casos, es posible que debas reducir la cantidad de datos enviados, ya sea debido al tamaño de los registros de una tabla en particular o porque alcanzas un límite de cuota o cualquier otro límite en Pub/Sub o BigQuery.

Puedes controlar la cantidad de datos que se envían en cada solicitud de las siguientes maneras:

- Ajusta la cantidad de datos (el tamaño de la parte) que SAP LT Replication Server envía a BigQuery Connector para SAP.

- Ajusta la cantidad de datos (el tamaño del fragmento) que BigQuery Connector para SAP envía a BigQuery.

- Ajusta las cuotas para las inserciones de transmisión en tu proyecto de BigQuery.

Ajusta la cantidad de datos que envía SAP LT Replication Server

SAP LT Replication Server envía registros del sistema de origen a BigQuery Connector para SAP en porciones. Cada parte se maneja como un trabajo de carga o replicación independiente que consume recursos del servidor hasta que se completa.

Por lo general, si aumentas el tamaño de la parte de SAP LT Replication Server, disminuirás la cantidad de procesos de SAP LT Replication Server, así como la sobrecarga asociada a ellos.

Tamaño de la porción y tamaño del fragmento

El tamaño de las porciones de SAP LT Replication Server se expresa en bytes o como un producto de bytes y registros. El tamaño de los fragmentos de BigQuery Connector para SAP se calcula según la cantidad de registros que pueden contener. El tamaño en bytes de un fragmento cambia según varios factores, incluida la cantidad de campos en los registros y la cantidad de datos que contiene cada registro.

Si el tamaño de la parte de SAP LT Replication Server es mayor que el conector de BigQuery para el tamaño de fragmento de SAP, BigQuery Connector para SAP envía varios fragmentos para cada parte hasta que se envíen todos los registros de la parte.

Si el tamaño de la parte es más pequeño que el tamaño del fragmento, BigQuery Connector para SAP envía solo un fragmento por parte. Cada fragmento contiene solo la cantidad de registros enviados en cada parte, sin importar el tamaño del fragmento configurado en BigQuery Connector para SAP.

Lo ideal es que el tamaño de la parte en SAP LT Replication Server permita que BigQuery Connector para SAP cree los fragmentos más grandes posibles sin exceder el límite de Pub/Sub o BigQuery en la cantidad de bytes de cada solicitud HTTP.

Si deseas obtener más orientación sobre cómo especificar un tamaño de fragmento, consulta Tamaño de fragmentación en BigQuery Connector para SAP.

Tamaño de la parte en SAP LT Replication Server

Para cambiar el tamaño de la parte predeterminada que usa SAP LT Replication Server, ejecuta la transacción LTRS y ajusta el valor en el campo Tamaño del paquete en Configuración avanzada de la replicación en Opciones de rendimiento.

Para obtener más información, consulta la Guía de optimización del rendimiento de SAP LT Replication Server en el Portal de ayuda de SAP.

Tamaño de fragmento en BigQuery Connector para SAP

BigQuery Connector para SAP envía datos a BigQuery como fragmentos de registros.

Para la replicación de CDC a través de Pub/Sub, te recomendamos que uses el tamaño de fragmento predeterminado con BigQuery Connector para SAP, que es de 1,000 registros. Esta es la cantidad máxima de registros que permite Pub/Sub.

Para la replicación de datos de transmisión, te recomendamos que uses el tamaño de fragmento predeterminado con BigQuery Connector para SAP, que es de 10,000 registros. Sin embargo, si los registros de una tabla de origen contienen muy pocos campos o los campos contienen valores de datos de tamaño muy pequeño, puedes usar un tamaño de fragmento más grande hasta el tamaño máximo de fragmento que permite BigQuery, que es 50,000 registros.

Si la cantidad de registros en un fragmento determinado se resuelve en un tamaño de bytes que supera el límite permitido en el tamaño de bytes para las solicitudes HTTP, es posible que recibas un error quotaExceeded o un error invalid.

Esto puede suceder si los registros en una tabla de origen contienen muchos campos o los campos contienen muchos datos.

Si obtienes un error relacionado con el tamaño del fragmento, intenta reducir el tamaño del fragmento que se especifica en la configuración de transferencia masiva para esa tabla. De manera alternativa, puedes habilitar el tamaño de fragmento dinámico para que esa tabla ajuste automáticamente el tamaño de fragmento. Para obtener más información, consulta Tamaño de fragmento dinámico.

Si no habilitaste el tamaño de fragmento dinámico, las tablas de origen de SAP, como MSEG, ACDOCA y MATDOC, que pueden tener registros grandes con muchos campos por registro, es posible que debas especificar un tamaño de fragmento más bajo.

Para especificar el tamaño de un fragmento, ejecuta la transacción /GOOG/SLT_SETTINGS. El tamaño del fragmento se especifica en el campo Tamaño del fragmento, en la pantalla de atributos de la tabla.

Si deseas obtener más información para especificar un tamaño de fragmento, consulta los siguientes vínculos:

- Para la replicación de CDC a través de Pub/Sub, consulta Especifica la creación de tablas y otros atributos generales.

- Para la replicación de datos de transmisión, consulta Especifica la creación de tablas y otros atributos generales.

Para obtener más información sobre los mensajes de error de BigQuery, consulta Mensajes de error.

Sobrecarga de procesamiento asociada con el envío de porciones

Cada porción que se envía activa las siguientes acciones, y cada una de las cuales genera cierta sobrecarga de procesamiento o consumo de recursos:

- Una colección de registros modificados en la tabla de registro en el sistema de origen se envía a SAP LT Replication Server en una sola porción. Los registros modificados aún no se borran de la tabla de registro.

- SAP LT Replication Server solicita un nuevo token de acceso de Google Cloud.

- BigQuery Connector para SAP envía una solicitud HTTP a Google Cloudpara verificar la estructura de la tabla de destino.

- BigQuery Connector para SAP envía los registros a Google Clouden tantos fragmentos como sean necesarios para enviar todos los registros que recibió en la porción única. Cada fragmento se envía en una solicitud HTTP separada.

- Google Cloud procesa cada fragmento que recibe.

- En un fragmento, se muestra un código de estado HTTP

OKa SAP LT Replication Server. - Después de que Google Cloud recibe todos los registros, SAP LT Replication Server borra los registros enviados de la tabla de registro, lo que libera los recursos en el sistema de origen.

Si deseas obtener más información sobre las partes y la configuración de SAP LT Replication Server para el rendimiento, consulta la Guía de optimización del rendimiento de SAP LT Replication Server en el Portal de ayuda de SAP.

Cuotas de BigQuery

Las cuotas de la API de BigQuery que están vigentes para tu proyecto limitan la cantidad de datos que puedes transmitir a BigQuery con el tiempo y en cualquier solicitud HTTP.

Por ejemplo, BigQuery establece límites en métricas como las siguientes:

- Los bytes por segundo por proyecto que puedes enviar.

- La cantidad máxima de registros o filas que puedes enviar en una sola solicitud HTTP.

- El tamaño máximo de una solicitud HTTP que puedes enviar.

Para las inserciones de transmisión, BigQuery corrige el tamaño de las solicitudes HTTP a 10 MB y la cantidad de registros que puedes enviar en una sola solicitud HTTP a 50,000.

En la mayoría de los casos, puedes cambiar las cuotas, pero no los límites.

Puedes ver y editar las cuotas vigentes para tu proyecto en la consola deGoogle Cloud en la página Cuotas.

Si deseas obtener más información sobre las cuotas y los límites de BigQuery para las inserciones de transmisión, consulta lo siguiente:

Cuotas de Pub/Sub

Las cuotas de la API de Pub/Sub que están vigentes para tu proyecto limitan la cantidad de datos que puedes transmitir a BigQuery con el tiempo y en cualquier solicitud HTTP.

Por ejemplo, Pub/Sub establece límites en métricas como las siguientes:

- Los bytes por segundo por proyecto que puedes enviar.

- La cantidad máxima de registros o filas que puedes enviar en una sola solicitud HTTP.

- El tamaño máximo de una solicitud HTTP que puedes enviar.

En el caso de los datos de CDC, Pub/Sub fija el tamaño de las solicitudes HTTP en 10 MB y la cantidad de registros que puedes enviar en una sola solicitud HTTP en 1,000.

En la mayoría de los casos, puedes cambiar las cuotas, pero no los límites.

Puedes ver y editar las cuotas vigentes para tu proyecto en la consola deGoogle Cloud en la página Cuotas.

Para obtener más información sobre las cuotas y los límites de recursos de Pub/Sub, consulta los siguientes recursos:

Compresión de registros

Para la replicación de CDC a través de Pub/Sub, no se admite la función de compresión de registros.

Para la replicación de datos de transmisión, de forma predeterminada, BigQuery Connector para SAP mejora el rendimiento de la replicación a través de la compresión de los registros que envía a BigQuery. A partir de la versión 2.8 y posteriores de BigQuery Connector para SAP, la opción de compresión de registros está disponible a nivel de la tabla y del campo.

Cuando la compresión de registros está habilitada a nivel de la tabla (que es el parámetro de configuración predeterminado), BigQuery Connector para SAP omite todos los campos que están vacíos en el registro de origen de los registros que se envían a BigQuery. Cuando el registro se inserta en BigQuery, los campos que se omitieron de los datos enviados se inicializan con null en la tabla de destino en BigQuery.

Sin embargo, si necesitas replicar algunos campos vacíos con sus valores iniciales en BigQuery y seguir usando la compresión de registros a nivel de la tabla, puedes cambiar el parámetro de configuración de compresión de registros para esos campos específicos. Esto significa que los valores vacíos en los campos especificados no se omiten de los datos enviados y conservan cualquier valor con el que se inicialicen en la tabla de origen.

Puedes controlar el comportamiento de la compresión de registros con el parámetro de configuración Enviar marca sin comprimir disponible a nivel de la tabla y del campo. En la siguiente tabla, se resume el comportamiento de la compresión de registros:

| Enviar marca sin comprimir a nivel de la tabla | Enviar marca sin comprimir a nivel del campo | Comportamiento de la compresión de registros |

|---|---|---|

| Sí | No | Todos los campos se envían sin comprimir. |

| Sí | Sí | Todos los campos se envían sin comprimir. |

| No | Sí | Solo los campos seleccionados a nivel del campo se envían sin comprimir. |

| No | No | Todos los campos se envían comprimidos. |

Cuando los datos sin comprimir se envían para la replicación, excepto por los campos de fecha y de marca de tiempo, los campos vacíos conservan cualquier valor con el que se hayan inicializado en la tabla de origen. El valor inicializado para los campos de fecha y marca de tiempo recibe los siguientes valores:

- Valor de inicialización del campo de fecha:

DATE 1970-01-01 - Valor de inicialización del campo de marca de tiempo:

TIMESTAMP 1970-01-01 00:00:00 UTC

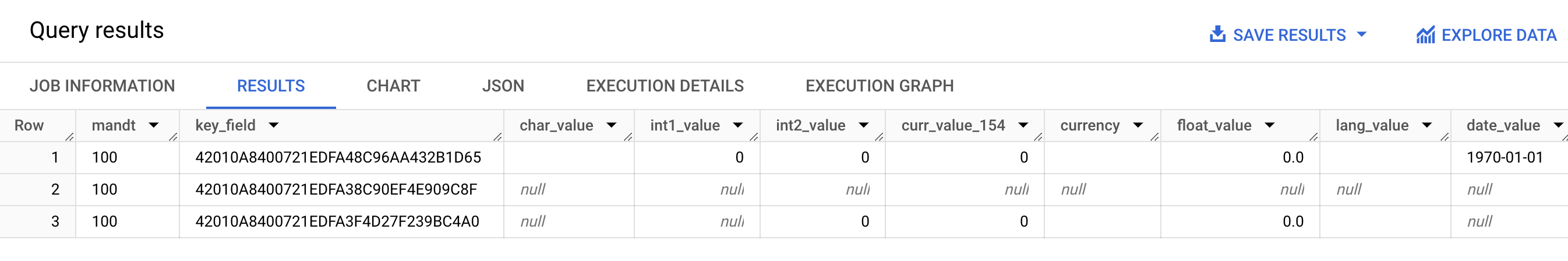

En la siguiente captura de pantalla, se muestra un ejemplo del comportamiento de compresión de registros:

- Fila 1: Todos los campos están sin comprimir. La marca de envío sin comprimir se selecciona a nivel de la tabla.

- Fila 2: Todos los campos están comprimidos. La marca de envío sin comprimir está desactivada a nivel de la tabla.

- Fila 3: Los siguientes campos no están comprimidos:

int2_value,curr_value_154,currency,float_valueylang_value. En estos campos, se selecciona Enviar marca sin comprimir a nivel del campo.

Para obtener un mejor rendimiento, no inhabilite la compresión de registros seleccionando Enviar marca sin comprimir a nivel de la tabla. Puede tener un impacto negativo en el rendimiento de la replicación. Si necesitas enviar datos sin comprimir solo para campos específicos, selecciona Enviar marca sin comprimir para esos campos específicos a nivel del campo. Para obtener más información sobre cómo la compresión de registros afecta tus datos que se transfieren de SAP LT Replication Server a BigQuery, consulta Comprende la función de compresión de BigQuery Connector para SAP.

Opciones de configuración de la replicación de BigQuery

Cuando configuras la replicación con BigQuery Connector para SAP, usas varias transacciones SAP diferentes, incluida una transacción personalizada que proporciona Google Cloud:

SM30: Define las propiedades para conectarse a Google Cloud, que se almacenan como un registro en la tabla de configuración personalizada/GOOG/CLIENT_KEY. De forma opcional, cuando usas destinos de RFC para conectarte a las APIs y los servicios deGoogle Cloud , algunas propiedades de conexión se almacenan en la tabla de configuración personalizada/GOOG/SERVIC_MAP.LTRC: Define la aplicación de replicación BigQuery Connector para SAP y el ID de transferencia masiva, entre otras propiedades.SM59: Define los destinos de RFC que permiten conectarse a las APIs y los servicios de Google Cloud, como BigQuery y la IAM./GOOG/SLT_SETTINGS: define las propiedades de la tabla, los campos y el conjunto de datos de BigQuery de destino. Cuando ingresas/GOOG/SLT_SETTINGSen SAP LT Replication Server, debes agregar/npara escapar la barra diagonal inicial en el nombre de la transacción.

Idiomas admitidos

BigQuery Connector para SAP solo admite parámetros de configuración de replicación en inglés. Cuando configures la replicación a través de las transacciones de SAP y la transacción personalizada que proporciona Google Cloud, usa inglés como tu idioma de inicio de sesión en la pantalla de inicio de sesión de SAP.

Sin embargo, BigQuery Connector para SAP admite la ejecución de trabajos en segundo plano que se ejecutan en SAP LT Replication Server en todos los idiomas compatibles con SAP SLT.

Cualquier mensaje de error que puedas encontrar cuando trabajes con BigQuery Connector para SAP se genera en inglés, sin importar el idioma de ejecución del trabajo en segundo plano.

Propiedades de la tabla de destino

Cuando configuras la replicación en SAP LT Replication Server a través de la ejecución de la transacción /GOOG/SLT_SETTINGS, puedes especificar la configuración que se aplica cuando BigQuery Connector para SAP crea la tabla de destino en BigQuery.

Por ejemplo, puedes especificar las siguientes propiedades en una tabla de BigQuery de destino:

- Nombre de la tabla

- La opción predeterminada para asignar nombres a los campos

- Campos adicionales para capturar los cambios en los registros y habilitar las consultas de recuento de registros

- Partición de tablas

Opciones predeterminadas para asignar nombres a los campos

Puedes configurar BigQuery Connector para SAP para crear los nombres para los campos en la tabla de BigQuery de destino a partir de los nombres de los campos de origen o las etiquetas y descripciones de los campos de origen. Las etiquetas y las descripciones suelen ser más informativas sobre el contenido del campo.

De forma predeterminada, BigQuery Connector para SAP usa los nombres de los campos de origen.

Puedes cambiar el valor predeterminado si especificas la marca Nombres personalizados cuando especificas los atributos de creación de tablas en la configuración de transferencia masiva de la transacción /GOOG/SLT_SETTINGS. Esta especificación se almacena en la tabla de configuración /GOOG/BQ_MASTR.

Cuando se crean los nombres, BigQuery Connector para SAP los modifica para que se ajusten a la convención de nombres de BigQuery.

Antes de crear una tabla, puedes editar los nombres de los campos en la pantalla de asignación de campos de la transacción /GOOG/SLT_SETTINGS.

Cuando los Nombres personalizados se especifican, los nombres que BigQuery Connector para SAP usará cuando cree la tabla de destino. Se mostrarán en la columna Nombre del campo externo de la pantalla de asignación de campos.

BigQuery Connector para SAP crea los nombres en la columna Nombre de campo externo de la etiqueta del campo medio de cada campo de origen. Si no se especifica una etiqueta de campo medio en la definición del campo de origen, se usa la descripción corta del campo. Si tampoco se especifica la descripción corta, se usa la etiqueta especificada más corta. Si no se especifica nada, se usa el nombre del campo de origen.

Si deseas obtener más información para personalizar los nombres de campos de destino, consulta Personaliza los nombres de campos de destino.

Captura los cambios de registros y habilita los recuentos de registros

Para capturar el tipo de cambio en la tabla de origen que activó la replicación y poder consultar recuentos de registros en la tabla de BigQuery en comparación con SAP LT Replication Server o recuentos de registros en la tabla de origen, especifica la opción Marcas de campos adicionales en la transacción /GOOG/SLT_SETTINGS cuando configuras la replicación.

Cuando se especifica la opción Marca de campos adicionales, se agregan las siguientes columnas al esquema de la tabla de BigQuery de destino:

| Nombre del campo | Tipo de datos | Descripción |

|---|---|---|

operation_flag

|

STRING

|

Identifica el tipo de cambio en la tabla de origen que activó la carga o la replicación del registro en BigQuery.

Para contar los registros que se insertaron en el modo de replicación, consulta los registros que tienen un valor de

Para contar los registros que se insertaron en el modo de carga inicial, consulta los registros que tienen un valor de |

is_deleted

|

BOOLEAN

|

Cuando es true, indica que el registro de origen se borró de la tabla de origen.

Para contar solo los registros de una tabla de BigQuery que no se borraron de la tabla de origen, usa el campo |

recordstamp

|

TIMESTAMP

|

La hora en la que SAP LT Replication Server envió el registro a BigQuery. Para contar la cantidad de registros únicos en una tabla de BigQuery, consulta solo la instancia más reciente de cada registro insertado. Para ver una consulta de ejemplo, visita Consulta el recuento total de registros en una tabla de BigQuery. |

La configuración actual de la opción Marca de campos adicionales se almacena en la tabla de configuración /GOOG/BQ_MASTR.

Para obtener información sobre cómo especificar la marca de campos adicionales, consulta lo siguiente:

- Para la replicación de CDC a través de Pub/Sub, consulta Especifica la creación de tablas y otros atributos generales.

- Para la replicación de datos de transmisión, consulta Especifica la creación de tablas y otros atributos generales.

Partición de tablas

Puedes crear tablas de BigQuery particionadas a través de un campo de marca de tiempo en la tabla de origen, lo que crea una tabla particionada por columnas de unidad de tiempo, o por la hora en la que los registros se insertan en BigQuery, lo que crea una tabla particionada por tiempo de transferencia.

Para habilitar la partición, especifica un tipo de partición en el campo Partition Type en /GOOG/BQ_TABLE cuando configures las propiedades de replicación.

Los tipos de particiones que puedes especificar ajustan el nivel de detalle de la partición por hora, día, mes o año.

Para usar una marca de tiempo de la tabla de origen para la partición de columnas de unidad de tiempo, especifica el nombre del campo de origen en el campo Partition Field.

Si deseas usar un tiempo de inserción de BigQuery para la partición en tiempo de transferencia, puedes dejar Campo de partición en blanco. BigQuery Connector para SAP crea un campo en la tabla de destino para almacenar el tiempo de inserción.

Propiedades del campo de destino

De forma predeterminada, BigQuery Connector para SAP usa los nombres de campo y los tipos de datos en la tabla de origen de SAP como los nombres de campo y los tipos de datos en BigQuery de destino.

De forma opcional, antes de crear la tabla de destino, puedes personalizar los nombres de los campos o cambiar el tipo de datos de BigQuery.

Personaliza los nombres de los campos de destino

Antes de crear una tabla, puedes personalizar los nombres de los campos de destino.

Si es necesario, BigQuery Connector para SAP modifica los nombres personalizados que especifiques para cumplir con la convención de nombres de BigQuery.

Cuando configuras la replicación, puedes ver los nombres de campos en la pantalla de asignación de campos de la transacción /GOOG/SLT_SETTINGS. BigQuery Connector para SAP almacena la configuración en la tabla de configuración /GOOG/BQ_FIELD.

Antes de crear una tabla, puedes especificar un nombre de campo personalizado si editas el nombre generado en la columna Nombre de campo temporal de la pantalla de asignación de campos. Si borras un valor y dejas el campo Nombre de campo temporal en blanco, BigQuery Connector para SAP usa el nombre del campo de origen para el nombre de ese campo de destino.

Después de realizar las modificaciones en Nombre de campo temporal, cuando haces clic en Guardar, BigQuery Connector para SAP valida el valor, aplica las convenciones de nombres de BigQuery según sea necesario y guarda los cambios. Puedes validar un valor sin guardarlo si presionas Intro.

Si deseas obtener información para configurar el método de nombres predeterminado para los campos de destino, consulta Opciones de nombres predeterminados para campos.

Usa una hoja de cálculo o un archivo de texto para editar el mapa de campos de BigQuery

Antes de crear una tabla de BigQuery de destino, puedes guardar de forma opcional los tipos de datos, los nombres y las descripciones predeterminados de los campos de destino en una hoja de cálculo o un archivo de texto para que los ingenieros o administradores de datos de BigQuery puedan editar los valores con facilidad sin requerir acceso a SAP LT Replication Server.

Después de editar los valores, debes convertir el archivo y su contenido al formato de valores separados por comas (CSV). Luego, puedes aplicar las actualizaciones a la configuración de la transferencia masiva si subes el archivo CSV a través de la transacción personalizada /GOOG/SLT_SETTINGS.

El proceso para editar el mapa de campos de BigQuery con un archivo CSV incluye los siguientes pasos:

- Crea una hoja de cálculo o un archivo de texto de las asignaciones de campo predeterminadas.

- Edite los valores.

- Convierte la hoja de cálculo o el archivo de texto al formato CSV.

- Sube el archivo CSV.

Para obtener instrucciones detalladas para cada uno de estos pasos, consulta Edita el mapa de campos de BigQuery en un archivo CSV.

Convención de nombres de BigQuery para campos

La convención de nombres de BigQuery solo usa letras minúsculas, números y guiones bajos.

BigQuery Connector para SAP aplica las convenciones de nombres de BigQuery a cualquier valor de entrada que se use para el nombre de un campo de destino.

Por ejemplo, si ingresas FIELD-@#!*123 como un nombre de campo personalizado, BigQuery Connector para SAP cambia el nombre a field_123.

Si deseas obtener más información sobre la convención de nombres de BigQuery para los campos, consulta Nombres de columnas.

Asignación de tipos de datos

De forma predeterminada, BigQuery Connector para SAP asigna tipos de datos a los campos de BigQuery de destino según la categoría de tipo SAP o el tipo de datos SAP del campo SAP de origen.

Para la replicación de CDC a través de Pub/Sub, el proceso incluye un paso intermedio en la asignación de tipos de datos:

BigQuery Connector para SAP a Pub/Sub: Cuando BigQuery Connector para SAP envía datos a un tema de Pub/Sub, los tipos de datos de SAP se convierten inicialmente en tipos de datos de Avro de Pub/Sub.

De Pub/Sub a BigQuery: Luego, los datos con formato Avro de Pub/Sub se transmiten a BigQuery con una suscripción a BigQuery. En este punto, Pub/Sub asigna los tipos de datos finales de BigQuery.

Para garantizar un flujo de datos fluido y una interpretación precisa, los tipos de datos Avro de Pub/Sub y los tipos de datos finales de BigQuery deben ser compatibles. Para obtener información sobre la compatibilidad del esquema entre un tema de Pub/Sub y una tabla de BigQuery, consulta Compatibilidad del esquema.

Cuando configuras la replicación, puedes ver los tipos de datos en la pantalla de asignación de campos de la transacción /GOOG/SLT_SETTINGS. BigQuery Connector para SAP almacena la configuración en la tabla de configuración /GOOG/BQ_FIELD.

Antes de crear una tabla, puedes cambiar la especificación predeterminada del tipo de datos a un tipo de datos de BigQuery y un tipo de datos de Avro de Pub/Sub diferentes.

Tipos de datos que requieren un control especial

Varios tipos de datos de SAP requieren un control especial para que se representen con precisión en la tabla de BigQuery de destino.

Tú mismo debes controlar algunos de estos tipos de datos. BigQuery Connector para SAP se encarga de otros por ti.

Booleanos

Para los booleanos, SAP usa el tipo de datos CHAR, que, de forma predeterminada, BigQuery Connector para SAP se asigna al tipo de datos STRING en la tabla de BigQuery de destino.

En consecuencia, para los valores booleanos, cuando configuras la replicación a través de la transacción /GOOG/SLT_SETTINGS, debes cambiar la asignación predeterminada del tipo de datos para los campos booleanos de STRING a BOOLEAN en la pantalla de asignación de campos.

Marcas de tiempo

Para las marcas de tiempo, SAP usa los tipos de datos P (decimal empaquetado) o DEC (decimal), que de forma predeterminada, BigQuery Connector para SAP se asigna a NUMERIC en la tabla de BigQuery de destino.

En consecuencia, para las marcas de tiempo, cuando configuras la replicación a través de la transacción /GOOG/SLT_SETTINGS, debes cambiar la asignación predeterminada del tipo de datos de los campos de marca de tiempo de NUMERIC a TIMESTAMP o TIMESTAMP (LONG) en la pantalla de asignación de campos.

Categoría de tipo SAP X

La categoría de tipo SAP X es un hexadecimal y se representa a través de los tipos de datos SAP RAW, RAWSTRING o LRAW. De forma predeterminada, BigQuery Connector para SAP asigna estos tipos de datos a STRING en la tabla de origen de BigQuery.

Si necesitas un campo de origen con la categoría de tipo SAP X para asignar BYTES, debes cambiar la asignación del tipo de datos predeterminada del campo en la pantalla de asignación de campos de la transacción /GOOG/SLT_SETTINGS.

La categoría de tipo SAP X a veces se usa en SAP para representar números enteros.

En este caso, BigQuery Connector para SAP comprueba el tipo de datos del campo de origen de uno de los tipos de datos SAP para números enteros, INT1, INT2,INT4, INT8 y asigna el tipo de datos INTEGER en la tabla de BigQuery de destino.

Categoría de tipo SAP y

La categoría de tipo SAP y es una string de bytes y se representa a través de los tipos de datos SAP RAW, RAWSTRING o LRAW. De forma predeterminada, BigQuery Connector para SAP asigna estos tipos de datos a STRING en la tabla de origen de BigQuery.

Si necesitas un campo de origen con la categoría de tipo SAP y para asignar BYTES, debes cambiar la asignación del tipo de datos predeterminada del campo en la pantalla de asignación de campos de la transacción /GOOG/SLT_SETTINGS.

Tipo de datos SAP LRAW

BigQuery Connector para SAP almacena los tipos de datos LRAW en BigQuery como cadenas codificadas en Base64.

Si usas la replicación de CDC a través de Pub/Sub, el conector convierte los campos LRAW en codificación UTF-8 antes de enviarlos a Pub/Sub. A pesar de esta conversión, el conector sigue almacenando los datos como Base64 en BigQuery.

La conversión UTF-8 del conector de un valor de campo LRAW solo considera los bytes iniciales que indica su columna de longitud precedente. Esto se ajusta a los estándares de SAP, en los que el campo de longitud anterior (un tipo INT2 o INT4) define la longitud válida del contenido LRAW.

Asignación de tipos de datos predeterminada

En la siguiente tabla, se muestra la conversión de tipo de datos predeterminada de BigQuery Connector para SAP:

| Categoría de tipo SAP | Tipo de datos SAP | Tipo de datos de BigQuery | Tipo de datos Avro de Pub/Sub | Notas |

|---|---|---|---|---|

b (número entero de 1 byte)s (número entero de 2 bytes)I (número entero de 4 bytes)8 (número entero de 8 bytes)

|

INT1INT2INT4INT8

|

INTEGER |

INT |

|

F (número de punto flotante)

|

FLTP

|

FLOAT |

FLOAT |

|

P (empaquetado)

|

CURRDECQUAN

|

NUMERIC |

DOUBLE |

De forma predeterminada, categoría de tipo SAP P se asigna al tipo de datos NUMERIC de BigQuery y se convierte en un número en el formato externo. |

a (número flotante decimal, 16 lugares)

|

DECFLOAT16 |

NUMERIC |

DOUBLE |

|

e (número flotante decimal, 16 lugares)

|

DECFLOAT34 |

NUMERIC |

DOUBLE |

|

N (numérica) |

NUMC |

STRING |

STRING |

|

X (hexadecimal)y (string de bytes)

|

RAWRAWSTRINGLRAW

|

STRING |

STRING |

Si la categoría de tipo SAP es X, pero el nombre del tipo de datos abarca el patrón 'INT*' (INT1, INT2, INT4), se reemplaza un elemento de datos de origen por uno nuevo TYPINT8 con TYPEKIND '8', que se asigna al tipo de datos de BigQuery INTEGER. |

C (carácter)g (string de caracteres)? (csequence)& (clike)

|

CHARSTRING |

STRING |

STRING |

|

D (fecha) |

DATS |

DATE |

STRING |

|

T (hora) |

TIMS |

TIME |

STRING |

Licencias

BigQuery Connector para SAP está disponible como “Software” en virtud del acuerdo que rige el uso de la Google Cloud Plataforma, incluidas las Condiciones Específicas del Servicio disponibles en https://cloud.google.com/terms/service-terms. Sin limitar la generalidad de los términos anteriores, no puedes modificar ni distribuir BigQuery Connector para SAP sin un permiso escrito explícito de Google.

Por el momento, el software de BigQuery Connector para SAP se ofrece sin costo. Para mayor claridad, el uso de otros “Software” y “Servicios” en el acuerdo que rige el uso de la Plataforma de Google Cloud , como BigQuery, Pub/Sub, la API de Pub/Sub, la API de Storage Write y la API de transmisión de BigQuery, puede generar un costo.

BigQuery Connector para SAP no incluye ninguna licencia para el software de SAP, incluido, entre otros, SAP LT Replication Server. Debes obtener una licencia adecuada para el software de SAP por separado.

Ciclo de vida de la asistencia

Google Cloud admite y mantiene la versión principal más reciente de BigQuery Connector para SAP durante un período de al menos 12 meses después de la publicación de un aviso de baja en la Página de notas de la versión de SAP en Google Cloud, la versión principal anterior.

¿Qué sigue?

Si deseas obtener información para instalar BigQuery Connector para SAP, consulta Instala BigQuery Connector para SAP.