Questo documento spiega come utilizzare Google Kubernetes Engine (GKE) per eseguire il deployment di un framework di test di carico distribuito che utilizza più container per creare traffico per una semplice API basata su REST. Questo documento esegue test di carico su un'applicazione web di cui è stato eseguito il deployment in App Engine che espone endpoint in stile REST per rispondere alle richieste POST HTTP in entrata.

Puoi utilizzare lo stesso pattern per creare framework di test di carico per una serie di scenari e applicazioni, come sistemi di messaggistica, sistemi di gestione degli stream di dati e sistemi di database.

Obiettivi

- Definisci le variabili di ambiente per controllare la configurazione del deployment.

- Creare un cluster GKE.

- Esegui test di carico.

- Se vuoi, aumenta il numero di utenti o estendi il pattern ad altri casi d'uso.

Costi

In questo documento utilizzi i seguenti componenti fatturabili di Google Cloud:

- App Engine

- Artifact Registry

- Cloud Build

- Cloud Storage

- Google Kubernetes Engine

Per generare una stima dei costi in base all'utilizzo previsto,

utilizza il Calcolatore prezzi.

Prima di iniziare

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

Enable the App Engine, Artifact Registry, Cloud Build, Compute Engine, Resource Manager, Google Kubernetes Engine, and Identity and Access Management APIs.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

Enable the App Engine, Artifact Registry, Cloud Build, Compute Engine, Resource Manager, Google Kubernetes Engine, and Identity and Access Management APIs.

-

Grant roles to your user account. Run the following command once for each of the following IAM roles:

roles/serviceusage.serviceUsageAdmin, roles/container.admin, roles/appengine.appAdmin, roles/appengine.appCreator, roles/artifactregistry.admin, roles/resourcemanager.projectIamAdmin, roles/compute.instanceAdmin.v1, roles/iam.serviceAccountUser, roles/cloudbuild.builds.builder, roles/iam.serviceAccountAdmingcloud projects add-iam-policy-binding PROJECT_ID --member="user:USER_IDENTIFIER" --role=ROLE

- Replace

PROJECT_IDwith your project ID. -

Replace

USER_IDENTIFIERwith the identifier for your user account. For example,user:myemail@example.com. - Replace

ROLEwith each individual role.

- Replace

- L'immagine container Docker di Locust.

- Il meccanismo di orchestrazione e gestione dei container.

- Esegui il deployment di un test di carico principale, denominato master da Locust.

- Esegui il deployment di un gruppo di worker per i test di carico. Con questi worker per i test di carico, puoi creare una quantità significativa di traffico a scopo di test.

8089per l'interfaccia web5557e5558per comunicare con i lavoratoriApri Cloud Shell:

Esegui tutti i comandi di terminale in questo documento da Cloud Shell.

Imposta le variabili di ambiente che richiedono la personalizzazione:

export GKE_CLUSTER=GKE_CLUSTER export AR_REPO=AR_REPO export REGION=REGION export ZONE=ZONE export SAMPLE_APP_LOCATION=SAMPLE_APP_LOCATION

Sostituisci quanto segue:

GKE_CLUSTER: il nome del tuo cluster GKE.AR_REPO: il nome del repository Artifact RegistryREGION: la regione in cui verranno creati il cluster GKE e il repository Artifact RegistryZONE: la zona della tua regione in cui verrà creata l'istanza Compute EngineSAMPLE_APP_LOCATION: la località(regionale) in cui verrà eseguito il deployment dell'applicazione App Engine di esempio

I comandi dovrebbero essere simili all'esempio seguente:

export GKE_CLUSTER=gke-lt-cluster export AR_REPO=dist-lt-repo export REGION=us-central1 export ZONE=us-central1-b export SAMPLE_APP_LOCATION=us-central

Imposta le seguenti variabili di ambiente aggiuntive:

export GKE_NODE_TYPE=e2-standard-4 export GKE_SCOPE="https://www.googleapis.com/auth/cloud-platform" export PROJECT=$(gcloud config get-value project) export SAMPLE_APP_TARGET=${PROJECT}.appspot.comImposta la zona predefinita in modo da non dover specificare questi valori nei comandi successivi:

gcloud config set compute/zone ${ZONE}Crea un account di servizio con le autorizzazioni minime richieste dal cluster:

gcloud iam service-accounts create dist-lt-svc-acc gcloud projects add-iam-policy-binding ${PROJECT} --member=serviceAccount:dist-lt-svc-acc@${PROJECT}.iam.gserviceaccount.com --role=roles/artifactregistry.reader gcloud projects add-iam-policy-binding ${PROJECT} --member=serviceAccount:dist-lt-svc-acc@${PROJECT}.iam.gserviceaccount.com --role=roles/container.nodeServiceAccountCrea il cluster GKE:

gcloud container clusters create ${GKE_CLUSTER} \ --service-account=dist-lt-svc-acc@${PROJECT}.iam.gserviceaccount.com \ --region ${REGION} \ --machine-type ${GKE_NODE_TYPE} \ --enable-autoscaling \ --num-nodes 3 \ --min-nodes 3 \ --max-nodes 10 \ --scopes "${GKE_SCOPE}"Connettiti al cluster GKE:

gcloud container clusters get-credentials ${GKE_CLUSTER} \ --region ${REGION} \ --project ${PROJECT}Clona il repository di esempio da GitHub:

git clone https://github.com/GoogleCloudPlatform/distributed-load-testing-using-kubernetes

Cambia la directory di lavoro impostandola sul repository clonato:

cd distributed-load-testing-using-kubernetes

Crea un repository Artifact Registry:

gcloud artifacts repositories create ${AR_REPO} \ --repository-format=docker \ --location=${REGION} \ --description="Distributed load testing with GKE and Locust"

Crea l'immagine container e archiviala nel tuo repository Artifact Registry:

export LOCUST_IMAGE_NAME=locust-tasks export LOCUST_IMAGE_TAG=latest gcloud builds submit \ --tag ${REGION}-docker.pkg.dev/${PROJECT}/${AR_REPO}/${LOCUST_IMAGE_NAME}:${LOCUST_IMAGE_TAG} \ docker-imageL'immagine Docker di Locust inclusa incorpora un'attività di test che chiama gli endpoint

/logine/metricsnell'applicazione di esempio. In questo insieme di attività di test di esempio, il rispettivo rapporto tra le richieste inviate a questi due endpoint sarà1su999.Verifica che l'immagine Docker sia nel repository Artifact Registry:

gcloud artifacts docker images list ${REGION}-docker.pkg.dev/${PROJECT}/${AR_REPO} | \ grep ${LOCUST_IMAGE_NAME}L'output è simile al seguente:

Listing items under project

PROJECT, locationREGION, repositoryAR_REPOREGION-docker.pkg.dev/PROJECT/AR_REPO/locust-tasks sha256:796d4be067eae7c82d41824791289045789182958913e57c0ef40e8d5ddcf283 2022-04-13T01:55:02 2022-04-13T01:55:02Crea ed esegui il deployment di sample-webapp come App Engine:

gcloud app create --region=${SAMPLE_APP_LOCATION} gcloud app deploy sample-webapp/app.yaml \ --project=${PROJECT}Quando richiesto, digita

yper procedere con il deployment.L'output è simile al seguente:

File upload done. Updating service [default]...done. Setting traffic split for service [default]...done. Deployed service [default] to [https://

PROJECT.appspot.com]L'applicazione App Engine di esempio implementa gli endpoint

/logine/metrics:Sostituisci i valori variabile di ambiente per i parametri di immagine, progetto e host di destinazione nei file

locust-master-controller.yamlelocust-worker-controller.yamle crea i deployment di Locust master e worker:envsubst < kubernetes-config/locust-master-controller.yaml.tpl | kubectl apply -f - envsubst < kubernetes-config/locust-worker-controller.yaml.tpl | kubectl apply -f - envsubst < kubernetes-config/locust-master-service.yaml.tpl | kubectl apply -f -

Verifica i deployment di Locust:

kubectl get pods -o wide

L'output è simile al seguente:

NAME READY STATUS RESTARTS AGE IP NODE locust-master-87f8ffd56-pxmsk 1/1 Running 0 1m 10.32.2.6 gke-gke-load-test-default-pool-96a3f394 locust-worker-58879b475c-279q9 1/1 Running 0 1m 10.32.1.5 gke-gke-load-test-default-pool-96a3f394 locust-worker-58879b475c-9frbw 1/1 Running 0 1m 10.32.2.8 gke-gke-load-test-default-pool-96a3f394 locust-worker-58879b475c-dppmz 1/1 Running 0 1m 10.32.2.7 gke-gke-load-test-default-pool-96a3f394 locust-worker-58879b475c-g8tzf 1/1 Running 0 1m 10.32.0.11 gke-gke-load-test-default-pool-96a3f394 locust-worker-58879b475c-qcscq 1/1 Running 0 1m 10.32.1.4 gke-gke-load-test-default-pool-96a3f394Verifica i servizi:

kubectl get services

L'output è simile al seguente:

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kubernetes ClusterIP 10.87.240.1 <none> 443/TCP 12m locust-master ClusterIP 10.87.245.22 <none> 5557/TCP,5558/TCP 1m locust-master-web LoadBalancer 10.87.246.225 <pending> 8089:31454/TCP 1mEsegui un loop di monitoraggio mentre viene eseguito il provisioning dell'indirizzo IP interno del bilanciatore del carico di rete passthrough interno (indirizzo IP esterno GKE) per il servizio dell'applicazione web master Locust:

kubectl get svc locust-master-web --watch

Premi

Ctrl+Cper uscire dal loop di visualizzazione dopo aver eseguito il provisioning di un indirizzo EXTERNAL-IP.Prendi nota dell'indirizzo IP del bilanciatore del carico interno del servizio host web:

export INTERNAL_LB_IP=$(kubectl get svc locust-master-web \ -o jsonpath="{.status.loadBalancer.ingress[0].ip}") && \ echo $INTERNAL_LB_IPA seconda della configurazione di rete, puoi collegarti all'applicazione web Locust tramite l'indirizzo IP di cui è stato eseguito il provisioning in due modi:

Routing di rete. Se la tua rete è configurata per consentire il routing dalla tua workstation alla rete VPC del progetto, puoi accedere direttamente all'indirizzo IP del bilanciatore del carico di rete passthrough interno dalla tua workstation.

Proxy e tunnel SSH. Se non esiste una route di rete tra la tua workstation e la tua rete VPC, puoi indirizzare il traffico all'indirizzo IP del bilanciatore del carico di rete passthrough interno creando un'istanza Compute Engine con un proxy

nginxe un tunnel SSH tra la workstation e l'istanza.

Imposta una variabile di ambiente con il nome dell'istanza.

export PROXY_VM=locust-nginx-proxy

Avvia un'istanza con un container Docker

ngnixconfigurato per eseguire il proxy della porta dell'applicazione web Locust8089sul bilanciatore del carico di rete passthrough interno:gcloud compute instances create-with-container ${PROXY_VM} \ --zone ${ZONE} \ --container-image gcr.io/cloud-marketplace/google/nginx1:latest \ --container-mount-host-path=host-path=/tmp/server.conf,mount-path=/etc/nginx/conf.d/default.conf \ --metadata=startup-script="#! /bin/bash cat <<EOF > /tmp/server.conf server { listen 8089; location / { proxy_pass http://${INTERNAL_LB_IP}:8089; } } EOF"Apri un tunnel SSH da Cloud Shell all'istanza proxy:

gcloud compute ssh --zone ${ZONE} ${PROXY_VM} \ -- -N -L 8089:localhost:8089Fai clic sull'icona Anteprima web (

) e seleziona Cambia porta dalle opzioni elencate.

Nella finestra di dialogo Cambia porta di anteprima, inserisci 8089 nel campo Numero porta e seleziona Cambia e visualizza anteprima.

A breve si aprirà una scheda del browser con l'interfaccia web di Locust.

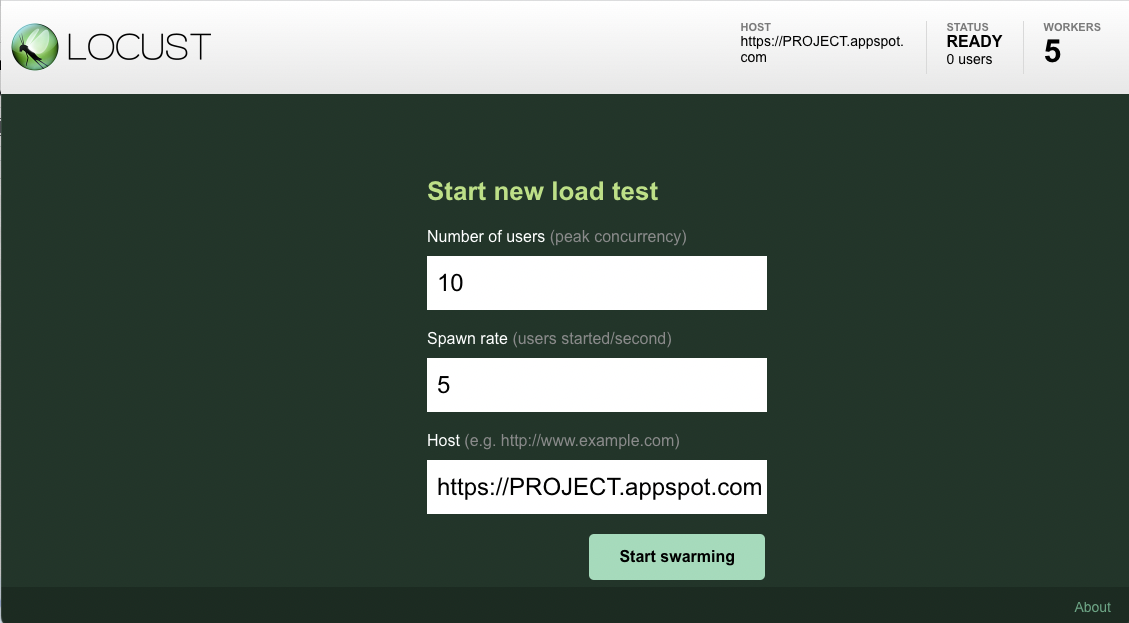

Dopo aver aperto il frontend di Locust nel browser, viene visualizzata una finestra di dialogo che può essere utilizzata per avviare un nuovo test di carico.

Specifica il numero totale di utenti (concurrency massima) come

10e la frequenza di generazione (utenti avviati/secondo) come5utenti per secondo.Fai clic su Avvia swarming per iniziare la simulazione.

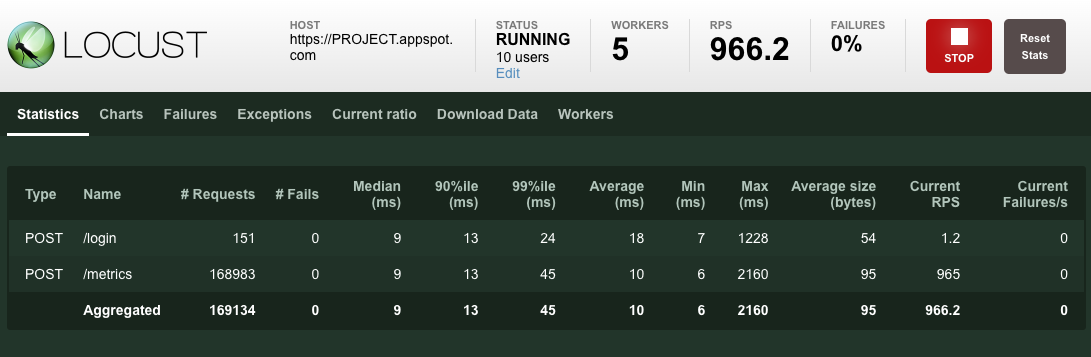

Dopo l'inizio delle richieste, le statistiche iniziano ad aggregarsi per le metriche di simulazione, come il numero di richieste e richieste al secondo, come mostrato nell'immagine seguente:

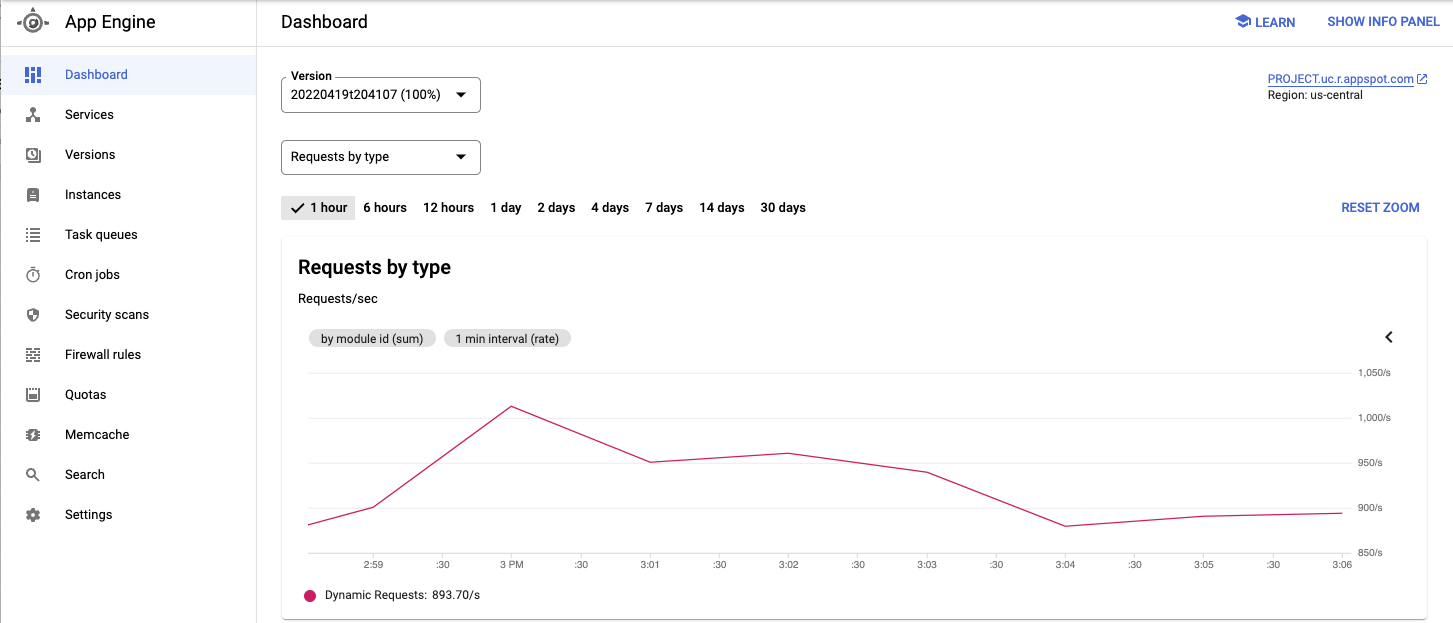

Visualizza il servizio di cui è stato eseguito il deployment e altre metriche dalla consoleGoogle Cloud .

Dopo aver osservato il comportamento dell'applicazione in test, fai clic su Interrompi per terminare il test.

Scala il pool di pod di worker Locust a 20.

kubectl scale deployment/locust-worker --replicas=20

Il deployment e l'avvio dei nuovi pod richiedono alcuni minuti.

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

- Creazione di applicazioni web scalabili e resilienti.

- Esamina la documentazione di GKE per maggiori dettagli.

- Prova i tutorial su GKE.

- Per altre architetture di riferimento, diagrammi e best practice, visita il Centro architetture di Google Cloud.

Al termine delle attività descritte in questo documento, puoi evitare la fatturazione continua eliminando le risorse che hai creato. Per ulteriori informazioni, consulta la sezione Pulizia.

Carico di lavoro di esempio

Il seguente diagramma mostra un esempio di carico di lavoro in cui le richieste passano dal client all'applicazione.

Per modellare questa interazione, puoi utilizzare Locust, un

strumento di test di carico distribuito basato su Python che può distribuire

le richieste su più percorsi target. Ad esempio, Locust può distribuire

le richieste ai percorsi target /login e /metrics. Il carico di lavoro viene modellato come insieme di

attività

in Locust.

Architettura

Questa architettura prevede due componenti principali:

L'immagine container Docker di Locust contiene il software Locust. Il file Dockerfile, che ottieni quando cloni il repository GitHub che accompagna questo documento, utilizza un'immagine di base Python e include script per avviare il servizio Locust ed eseguire le attività. Per approssimare i clienti reali, ogni attività Locust viene ponderata. Ad esempio, la registrazione avviene una volta ogni mille richieste totali dei clienti.

GKE fornisce l'orchestrazione e la gestione dei container. Con GKE, puoi specificare il numero di nodi contenitore che costituiscono la base del tuo framework di test di carico. Puoi anche organizzare i tuoi worker di test di carico in pod e specificare quanti pod vuoi che GKE continui a eseguire.

Per eseguire il deployment delle attività di test di carico:

Il seguente diagramma mostra l'architettura che dimostra i test di carico utilizzando un'applicazione di esempio. Il pod principale fornisce l'interfaccia web utilizzata per eseguire e monitorare i test di carico. I pod worker generano il traffico delle richieste REST per l'applicazione in fase di test e inviano le metriche al master.

Informazioni sul master dei test di carico

Il master Locust è il punto di contatto per l'esecuzione delle attività di test di carico. La configurazione principale di Locust specifica diversi elementi, tra cui le porte predefinite utilizzate dal contenitore:

Queste informazioni vengono utilizzate in seguito per configurare i worker Locust.

Esegui il deployment di un servizio per assicurarti che le porte necessarie siano accessibili agli altri pod all'interno del cluster tramite hostname:port. Queste porte possono essere anche richiamate tramite un nome descrittivo.

Questo servizio consente ai worker Locust di rilevare e comunicare facilmente e in modo affidabile con il master, anche se il master non funziona e viene sostituito da un nuovo pod dal deployment.

Viene implementato un secondo servizio con l'annotazione necessaria per creare un bilanciatore del carico di rete passthrough interno che rende accessibile il servizio dell'applicazione web Locust ai client esterni al cluster che utilizzano la stessa rete VPC e si trovano nella stessa Google Cloud regione del cluster.

Dopo aver eseguito il deployment del master Locust, puoi aprire l'interfaccia web utilizzando l'indirizzo IP interno di cui è stato eseguito il provisioning dal bilanciatore del carico di rete passthrough interno. Dopo aver eseguito il deployment dei worker Locust, puoi avviare la simulazione e esaminare le statistiche aggregate tramite l'interfaccia web di Locust.

Informazioni sui worker per i test di carico

I worker Locust eseguono le attività di test di carico. Utilizzi un singolo deployment per creare più pod. I pod sono distribuiti nel cluster Kubernetes. Ogni pod utilizza le variabili di ambiente per controllare le informazioni di configurazione, ad esempio il nome host del sistema in test e il nome host del master Locust.

Il seguente diagramma mostra la relazione tra il master Locust e i worker Locust.

Inizializzare le variabili comuni

Devi definire diverse variabili che controllano dove vengono implementati gli elementi dell'infrastruttura.

Crea un cluster GKE

Configura l'ambiente

Crea l'immagine container

Esegui il deployment dell'applicazione di esempio

Esegui il deployment dei pod Locust master e worker

Connettiti al frontend web di Locust

Utilizza l'interfaccia web principale di Locust per eseguire le attività di test di carico sul sistema in test.

Routing di rete

Se esiste una route per il traffico di rete tra la tua workstation e la rete VPC del tuoGoogle Cloud progetto, apri il browser e poi l'interfaccia web Locust master. Per aprire l'interfaccia di Locust, vai al seguente URL:

http://INTERNAL_LB_IP:8089

Sostituisci INTERNAL_LB_IP con l'URL e l'indirizzo IP che hai annotato nel passaggio precedente.

Proxy e tunnel SSH

Esegui un test di carico di base sull'applicazione di esempio

Aumentare il numero di utenti (facoltativo)

Se vuoi testare un aumento del carico sull'applicazione, puoi aggiungere utenti simulati. Prima di poter aggiungere utenti simulati, devi assicurarti che siano disponibili risorse sufficienti per supportare l'aumento del carico. Con Google Cloud, puoi aggiungere pod worker Locust al deployment senza eseguire nuovamente il deployment dei pod esistenti, a condizione che tu disponga delle risorse VM sottostanti per supportare un numero maggiore di pod. Il cluster GKE iniziale inizia con 3 nodi e può eseguire la scalabilità automatica fino a 10 nodi.

Se viene visualizzato un errore Pod Unschedulable, devi aggiungere altri nodi al cluster. Per maggiori dettagli, consulta la sezione Modificare le dimensioni di un cluster GKE.

Dopo l'avvio dei pod, torna all'interfaccia web principale di Locust e riavvia il test di carico.

Espandi il pattern

Per estendere questo pattern, puoi creare nuove attività Locust o persino passare a un diverso framework di test di carico.

Puoi personalizzare le metriche raccolte. Ad esempio, potresti voler misurare le richieste al secondo, monitorare la latenza di risposta con l'aumento del carico o controllare i tassi di errore di risposta e i tipi di errori.

Per informazioni, consulta la documentazione di Cloud Monitoring.

Esegui la pulizia

Per evitare che al tuo account Google Cloud vengano addebitati costi relativi alle risorse utilizzate in questo documento, elimina il progetto che contiene le risorse oppure mantieni il progetto ed elimina le singole risorse.

Elimina il progetto

Elimina il cluster GKE

Se non vuoi eliminare l'intero progetto, esegui il seguente comando per eliminare il cluster GKE:

gcloud container clusters delete ${GKE_CLUSTER} --region ${REGION}