Pub/Sub

Sie können Ereignisse für das Streaming in BigQuery, Data Lakes oder operative Datenbanken aufnehmen.

Neukunden erhalten ein Guthaben im Wert von 300 $, das sie für Pub/Sub ausgeben können. Alle Kunden erhalten bis zu 10 GB für die Aufnahme oder Zustellung von Nachrichten pro Monat, die nicht mit dem Guthaben verrechnet werden.

Stellen Sie eine beispielhafte Data-Warehouse-Lösung bereit, um Daten mit BigQuery und Looker Studio zu untersuchen, zu analysieren und zu visualisieren. Außerdem können Sie mithilfe von generativer KI die Ergebnisse der Analyse zusammenfassen.

Managementfreies, sicheres, skalierbares Nachrichten- oder Warteschlangensystem

In der Reihenfolge und in beliebiger Reihenfolge mit mindestens einmal Nachrichten-Zustellen mit Pull- und Push-Modus

Sichere Daten dank detaillierter Zugriffssteuerung und durchgehender Verschlüsselung

Vorteile

Hochverfügbarkeit ganz einfach

Synchrone zonenübergreifende Nachrichtenreplizierung und Eingangstracking jeder Nachricht sorgen für die zuverlässige Übermittlung bei jedem Umfang.

Keine Planung – alles ist automatisch

Dank der automatischen Skalierung und Bereitstellung ohne Partitionen müssen Sie sich keine Gedanken um die Planung machen. Die Arbeitslasten sind sofort bereit für die Produktion.

Einfache, offene Basis für Echtzeitdatensysteme

Eine schnelle und zuverlässige Möglichkeit, beliebige Volumen kleiner Datasets zu speichern; ein Einstiegspunkt für Echtzeit- und Batchpipelines, die BigQuery, Data Lakes und Betriebsdatenbanken speisen. Verwenden Sie dies mit ETL-/ELT-Pipelines in Dataflow.

Wichtige Features

Wichtige Features

Streamanalysen und Connectors

Die native Einbindung in Dataflow ermöglicht die zuverlässige, genau einmalige Verarbeitung und Einbindung von Ereignisstreams in Java, Python und SQL.

Skalierbare Zustellung nach Reihenfolge

Optionales Sortieren pro Schlüssel vereinfacht die zustandsorientierte Anwendungslogik ohne Einschränkung der horizontalen Skalierung. Dafür müssen keine Partitionen verwaltet werden.

Vereinfachte Streamingaufnahme mit nativen Integrationen

Mit unseren nativen Abos können Sie Streamingdaten aus Pub/Sub direkt in BigQuery oder Cloud Storage aufnehmen.

Kunden

Von Kunden lernen, die Pub/Sub nutzen

Das ist neu

Das ist neu

Melden Sie sich für die Google Cloud-Newsletter an – so erhalten Sie regelmäßig Produktupdates, Veranstaltungsinformationen, Sonderangebote und mehr.

Dokumentation

Dokumentation

Anwendungsfälle

Anwendungsfälle

Streamanalysen

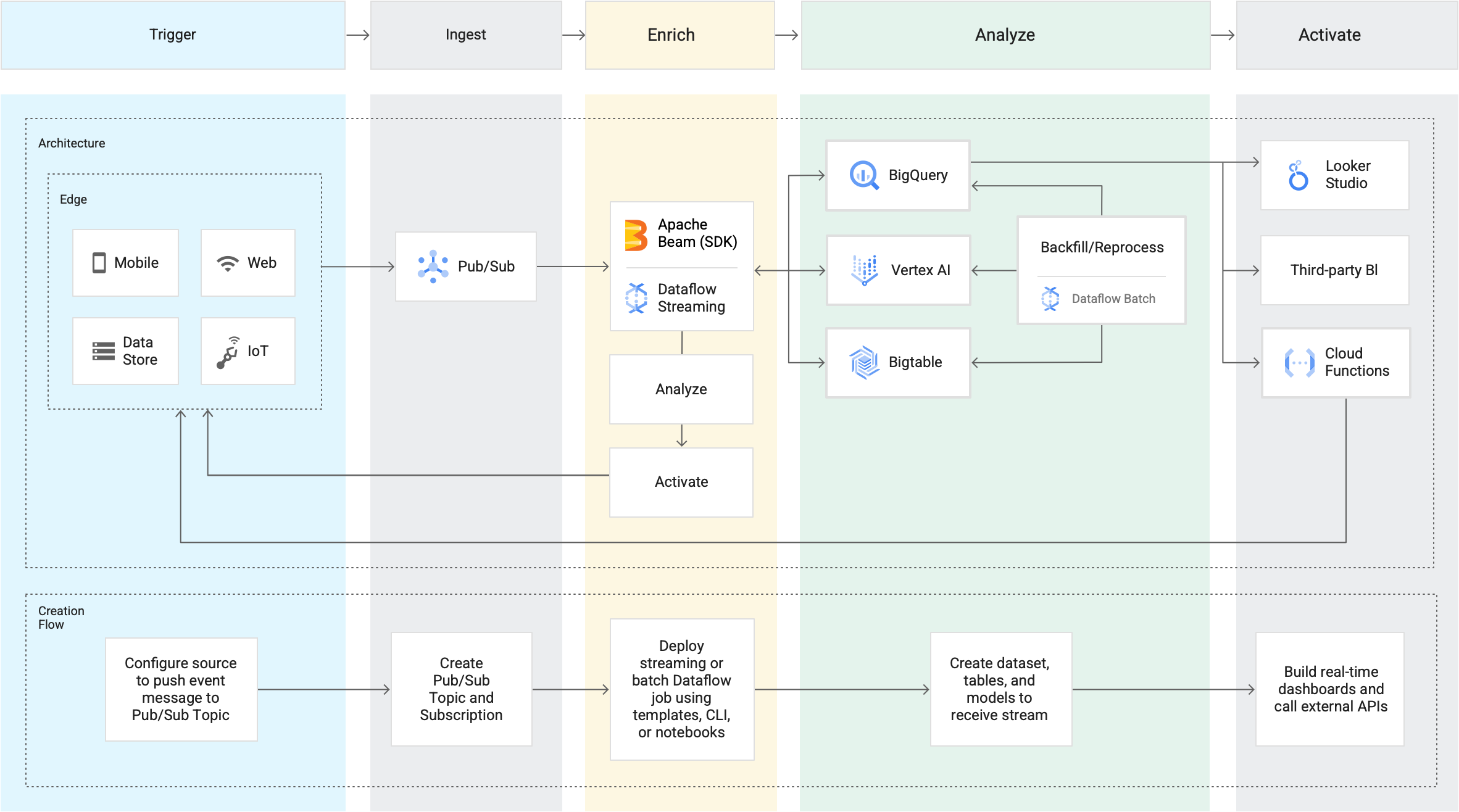

Mit Streamanalysen von Google Cloud sind Daten sofort nach ihrer Generierung besser organisiert, nutzbar und zugänglich. Unsere Streaming-Lösung beruht auf Pub/Sub, Dataflow und BigQuery und stellt die Ressourcen für die Aufnahme, Verarbeitung und Analyse schwankender Echtzeitdatenmengen bereit. Dadurch werden die geschäftliche Datenauswertung und Erstellung von Statistiken in Echtzeit möglich. Diese abstrahierte Bereitstellung reduziert die Komplexität und macht Streamanalysen sowohl für Datenanalysten als auch für Data Engineers zugänglich.

Asynchrone Einbindung von Mikrodiensten

Pub/Sub fungiert als Messaging-Middleware für die Einbindung herkömmlicher Dienste oder als einfaches Kommunikationsmedium für moderne Mikrodienste. Über Push-Abos werden Ereignisse an serverlose Webhooks in Cloud Functions, App Engine oder Cloud Run bzw. an benutzerdefinierte Umgebungen in Google Kubernetes Engine oder Compute Engine gesendet. Eine Pull-Zustellung mit geringer Latenz wird für den Fall angeboten, dass die Bereitstellung von Webhooks nicht möglich ist oder Streams mit hohem Durchsatz effizient verarbeitet werden sollen.

Alle Features

Alle Features

| Mindestens einmalige Übermittlung | Synchrone zonenübergreifende Nachrichtenreplizierung und Eingangstracking jeder Nachricht sorgen für mindestens einmalige Übermittlung bei jedem Umfang. |

| Offen | Offene APIs und Clientbibliotheken in sieben Sprachen unterstützen cloudübergreifende und hybride Bereitstellungen. |

| Genau einmalige Verarbeitung | Dataflow unterstützt die zuverlässige, genau einmalige Verarbeitung von Pub/Sub-Streams. |

| Keine Bereitstellung – alles ist automatisch | Pub/Sub enthält keine Shards oder Partitionen. Sie legen einfach Ihre Kontingente fest und veröffentlichen und nutzen die Angebote. |

| Compliance und Sicherheit | Pub/Sub ist mit HIPAA kompatibel und bietet präzise Zugriffssteuerung sowie Ende-zu-Ende-Verschlüsselung. |

| Cloudnative Integrationen | Sie können die Vorteile der Verknüpfung mit verschiedenen Diensten wie Cloud Storage, Gmail-Aktualisierungsereignissen und Cloud Functions für serverloses, ereignisgestütztes Computing nutzen. |

| Drittanbieter- und OSS-Integrationen | Pub/Sub bietet Drittanbietereinbindungen in Splunk und Datadog für Logs sowie in Striim und Informatica für die Dateneinbindung. Darüber hinaus sind OSS-Integrationen über Confluent Cloud für Apache Kafka sowie über Knative Eventing für Kubernetes-basierte, serverlose Arbeitslasten verfügbar. |

| Suchen und wiederholen | Sie können den Rückstand auf jeden Zeitpunkt oder einen Snapshot zurücksetzen, um die Nachrichten noch einmal zu verarbeiten. Veraltete Daten können durch Vorspulen verworfen werden. |

| Themen für unzustellbare Nachrichten | Nachrichten, die von Abonnentenanwendungen nicht verarbeitet werden können, werden zur Offlineuntersuchung und zum Debuggen an diese Themen weitergeleitet. So können andere Nachrichten ohne Verzögerung verarbeitet werden. |

| Filtern | Pub/Sub kann Nachrichten anhand von Attributen filtern, um die Datenmenge für die Abonnenten zu reduzieren. |

Preise

Preise

Die Preise für Pub/Sub hängen vom monatlichen Datenvolumen ab. Die ersten 10 GB an Daten im Monat sind kostenlos.

Monatliches Datenvolumen1 | Preis pro TB2 |

|---|---|

Erste 10 GB | 0,00 $ |

Mehr als 10 GB | 40,00 $ |

1 Detaillierte Preisinformationen finden Sie in der Preisübersicht.

2TB bezieht sich auf ein Tebibyte bzw. 240 Byte.

Wenn Sie in einer anderen Währung als US-Dollar bezahlen, gelten die unter Cloud Platform SKUs für Ihre Währung angegebenen Preise.

Gleich loslegen

Profitieren Sie von einem Guthaben über 300 $, um Google Cloud und mehr als 20 „Immer kostenlos“ Produkte kennenzulernen.

Benötigen Sie Hilfe beim Einstieg?

Vertrieb kontaktierenMit einem zertifizierten Partner arbeiten

Partner findenMehr ansehen

Alle Produkte ansehen