本指南可帮助您了解、部署和使用 Analytics Lakehouse 快速起步解决方案。该解决方案演示了如何通过创建分析湖仓一体来统一数据湖和数据仓库,以使用统一的数据栈来存储、处理、分析和激活数据。

构建分析湖仓一体的常见用例包括:

- 遥测数据与报告数据的大规模分析。

- 统一结构化和非结构化数据分析。

- 为数据仓库提供实时分析功能。

本文档适用于一些具有数据分析背景并使用数据库或数据湖执行分析的开发者。本文假定您熟悉基本的云概念,但不一定熟悉Google Cloud。拥有 Terraform 经验会很有帮助。

目标

- 了解如何设置分析湖仓一体。

- 使用通用治理层保护分析湖仓一体。

- 根据数据构建信息中心以执行数据分析。

- 创建机器学习模型以预测一段时间内的数据值。

使用的产品

此解决方案使用以下 Google Cloud 产品:

- BigQuery:伸缩能力极强的全托管式数据仓库,内置有机器学习功能。

- Dataproc:用于大规模数据湖现代化改造、ETL 和安全数据科学的全托管式服务。

- Looker Studio:自助式商业智能平台,可帮助您创建和共享数据洞见。

- Dataplex Universal Catalog:大规模集中发现、管理、监控和治理数据。

- Cloud Storage:一种企业级服务,为各种数据类型提供费用低廉、不受限制的对象存储。可从Google Cloud 内部和外部访问数据,并以地理位置冗余方式复制数据。

- BigLake:BigLake 是一种统一数据仓库和数据湖的存储引擎,它支持 BigQuery 和开源框架(如 Spark),具有精细的访问权限控制。

以下 Google Cloud 产品用于暂存解决方案中首次使用的数据:

- Workflows:一个全托管式编排平台,该平台按指定顺序以工作流的形式执行服务。Workflows 可以组合各种服务,包括 Cloud Run 或 Cloud Run functions 上托管的自定义服务、Google Cloud 服务(如 BigQuery)以及任何基于 HTTP 的 API。

架构

此解决方案部署的示例湖仓一体架构会分析电子商务数据集,以了解零售商在一段时间内的业绩。下图展示了该解决方案部署的 Google Cloud 资源的架构。

解决方案流程

该架构表示用于在分析湖仓一体架构中填充和转换数据的常见数据流动:

- 数据位于 Cloud Storage 存储桶中。

- 在 Dataplex Universal Catalog 中创建数据湖。存储桶中的数据会整理为数据湖中的实体或表的形式。

- 数据湖中的表可直接以 BigLake 表的形式在 BigQuery 中提供。

- 使用 Dataproc 或 BigQuery 以及使用 Apache Iceberg 等开放文件格式的数据转换。

- 可以使用政策标记和行访问权限政策来保护数据。

- 机器学习技术可以应用于这些表。

- 根据数据创建信息中心,以使用 Looker Studio 执行更多分析。

费用

如需估算分析湖仓一体解决方案使用的 Google Cloud 资源的费用,请参阅 Google Cloud 价格计算器中预先计算的估算值。

使用估算值作为起点来计算部署费用。您可以修改估算值,以反映您计划对解决方案中使用的资源进行的任何配置更改。

系统会基于某些因素(包括以下因素)做出预先计算的估算:

- 部署资源的 Google Cloud 位置。

- 资源的使用时间。

准备工作

如需部署此解决方案,您首先需要一个 Google Cloud 项目和一些 IAM 权限。

创建或选择一个 Google Cloud 项目

部署解决方案时,您需要选择部署资源的 Google Cloud 项目。您可以创建一个新项目或使用现有项目进行部署。

如果您要创建新项目,请在开始部署之前执行此操作。使用新项目有助于避免与先前预配的资源(例如用于生产工作负载的资源)发生冲突。

如需创建项目,请完成以下步骤:

-

Ensure that you have the Project Creator IAM role

(

roles/resourcemanager.projectCreator). Learn how to grant roles. -

In the Google Cloud console, go to the project selector page.

-

Click Create project.

-

Name your project. Make a note of your generated project ID.

-

Edit the other fields as needed.

-

Click Create.

获取所需的 IAM 权限

如需开始部署过程,您需要下表中列出的 Identity and Access Management (IAM) 权限。

如果您为此解决方案创建了新项目,则您在该项目中拥有 roles/owner 基本角色,并拥有所有必要的权限。如果您没有 roles/owner 角色,请让管理员授予您这些权限(或包含这些权限的角色)。

| 所需的 IAM 权限 | 包含所需权限的预定义角色 |

|---|---|

|

Service Usage Admin ( roles/serviceusage.serviceUsageAdmin) |

|

Service Account Admin ( roles/iam.serviceAccountAdmin) |

|

Project IAM Admin ( roles/resourcemanager.projectIamAdmin) |

config.deployments.createconfig.deployments.list |

Cloud Infrastructure Manager Admin ( roles/config.admin) |

iam.serviceAccount.actAs |

Service Account User ( roles/iam.serviceAccountUser) |

关于临时服务账号权限

如果您通过控制台启动部署过程,则 Google 会创建一个服务账号,用于代表您部署解决方案(以及稍后删除部署)。系统会临时为此服务账号分配某些 IAM 权限;也就是说,在解决方案部署和删除操作完成后,会自动撤消这些权限。Google 建议您在删除部署后删除服务账号,如本指南后面部分所述。

查看分配给服务账号的角色

此处列出了这些角色,以防Google Cloud 项目或组织的管理员需要此信息。

roles/biglake.adminroles/bigquery.adminroles/compute.adminroles/datalineage.viewerroles/dataplex.adminroles/dataproc.adminroles/iam.serviceAccountAdminroles/iam.serviceAccountUserroles/resourcemanager.projectIamAdminroles/servicenetworking.serviceAgentroles/serviceusage.serviceUsageViewerroles/vpcaccess.adminroles/storage.adminroles/workflows.admin

部署解决方案

本部分将引导您完成解决方案部署过程。

为了减少您部署此解决方案所需的工作量,GitHub 中提供了 Terraform 配置。Terraform 配置定义了解决方案需要的所有Google Cloud 资源。

您可以使用以下任一方法来部署解决方案:

通过控制台:如果您要试用采用默认配置的解决方案并了解其工作原理,请使用此方法。Cloud Build 会部署此解决方案需要的所有资源。如果您不再需要部署的解决方案,可以通过控制台将其删除。您在部署解决方案后创建的任何资源都可能需要单独删除。

如需使用此部署方法,请按照通过控制台进行部署中的说明操作。

使用 Terraform CLI:如果您要自定义解决方案,或者要使用基础架构即代码 (IaC) 方法自动预配和管理资源,请使用此方法。从 GitHub 下载 Terraform 配置,根据需要选择性地自定义代码,然后使用 Terraform CLI 部署解决方案。部署解决方案后,您可以继续使用 Terraform 来管理解决方案。

如需使用此部署方法,请按照使用 Terraform CLI 进行部署中的说明操作。

通过控制台进行部署

完成以下步骤以部署预配置的解决方案。

在 Google Cloud 快速起步解决方案目录中,前往 Analytics Lakehouse 解决方案。

查看页面上提供的信息,例如解决方案的预计费用和预计部署时间。

准备好开始部署解决方案后,请点击部署。

此时会显示分步配置窗格。

完成配置窗格中的步骤。

请记下您输入的部署名称。在稍后删除部署时需要此名称。

点击部署后,系统会显示解决方案部署页面。此页面的状态字段显示正在部署。

等待解决方案部署。

如果部署失败,状态字段将显示失败。您可以使用 Cloud Build 日志来诊断错误。如需了解详情,请参阅通过控制台部署时出错。

部署完成后,状态字段将更改为已部署。

如需查看和使用解决方案,请返回控制台中的解决方案部署页面。

- 点击 操作菜单。

- 选择查看 Looker Studio 信息中心,以打开基于使用该解决方案转换的示例数据构建的信息中心。

- 选择打开 BigQuery 编辑器,使用解决方案中的示例数据运行查询和构建机器学习 (ML) 模型。

- 选择查看 Colab 以在笔记本环境中运行查询。

如果您不再需要此解决方案,可以将部署删除,以免继续为 Google Cloud 资源计费。如需了解详情,请参阅删除部署。

使用 Terraform CLI 进行部署

本部分介绍如何使用 Terraform CLI 自定义解决方案或自动预配和管理解决方案。使用 Terraform CLI 部署的解决方案不会显示在 Google Cloud 控制台的解决方案部署页面中。

设置 Terraform 客户端

您可以在 Cloud Shell 或本地主机上运行 Terraform。本指南介绍如何在 Cloud Shell 中运行 Terraform,其中预安装了 Terraform 并将其配置为向 Google Cloud进行身份验证。

GitHub 代码库中提供了此解决方案的 Terraform 代码。

将 GitHub 代码库克隆到 Cloud Shell。

系统会显示一条提示,要求您确认将 GitHub 代码库下载到 Cloud Shell。

点击确认。

Cloud Shell 会在单独的浏览器标签页中启动,而 Terraform 代码会下载到 Cloud Shell 环境的

$HOME/cloudshell_open目录中。在 Cloud Shell 中,检查当前工作目录是否为

$HOME/cloudshell_open/terraform-google-analytics-lakehouse/。这是包含此解决方案的 Terraform 配置文件的目录。如果您需要切换到该目录,请运行以下命令:cd $HOME/cloudshell_open/terraform-google-analytics-lakehouse/通过运行以下命令来初始化 Terraform:

terraform init等待系统显示以下消息:

Terraform has been successfully initialized!

配置 Terraform 变量

您下载的 Terraform 代码包含可用于根据需要自定义部署的变量。例如,您可以指定 Google Cloud 项目以及要在其中部署解决方案的区域。

确保当前工作目录为

$HOME/cloudshell_open/terraform-google-analytics-lakehouse/。如果不是,请转到该目录。在同一目录中,创建一个名为

terraform.tfvars的文本文件。在

terraform.tfvars文件中,复制以下代码段,并为所需的变量设置值。- 按照代码段中作为注释提供的说明进行操作。

- 此代码段仅包含您必须为其设置值的变量。Terraform 配置包括具有默认值的其他变量。如需查看所有变量和默认值,请参阅

$HOME/cloudshell_open/terraform-google-analytics-lakehouse/目录中提供的variables.tf文件。 - 确保您在

terraform.tfvars文件中设置的每个值都与variables.tf文件中声明的变量类型匹配。例如,如果为variables.tf文件中的变量定义的类型为bool,则必须将true或false指定为该变量在terraform.tfvars文件中的值。

# This is an example of the terraform.tfvars file. # The values in this file must match the variable types declared in variables.tf. # The values in this file override any defaults in variables.tf. # ID of the project in which you want to deploy the solution project_id = "PROJECT_ID" # Google Cloud region where you want to deploy the solution # Example: us-central1 region = "REGION" # Whether or not to enable underlying apis in this solution. # Example: true enable_apis = true # Whether or not to protect Cloud Storage and BigQuery resources from deletion when solution is modified or changed. # Example: false force_destroy = false

验证并查看 Terraform 配置

确保当前工作目录为

$HOME/cloudshell_open/terraform-google-analytics-lakehouse/。如果不是,请转到该目录。验证 Terraform 配置没有错误:

terraform validate如果该命令返回任何错误,请在配置中进行所需的更正,然后再次运行

terraform validate命令。重复此步骤,直到命令返回以下消息:Success! The configuration is valid.查看配置中定义的资源:

terraform plan如果您未按照上文所述创建

terraform.tfvars文件,则 Terraform 会提示您为没有默认值的变量输入值。输入必需的值。terraform plan命令的输出是在应用配置时 Terraform 预配的资源列表。如果要进行任何更改,请修改配置,然后再次运行

terraform validate和terraform plan命令。

预配资源

如果 Terraform 配置中不需要进一步更改,请部署资源。

确保当前工作目录为

$HOME/cloudshell_open/terraform-google-analytics-lakehouse/。如果不是,请转到该目录。应用 Terraform 配置:

terraform apply如果您未按照上文所述创建

terraform.tfvars文件,则 Terraform 会提示您为没有默认值的变量输入值。输入必需的值。Terraform 会显示将创建的资源列表。

当系统提示您执行操作时,请输入

yes。Terraform 展示一些显示部署进度的消息。

如果无法完成部署,则 Terraform 会显示导致失败的错误。查看错误消息,并更新配置以修复错误。然后,再次运行

terraform apply命令。如需有关排查 Terraform 错误的帮助,请参阅使用 Terraform CLI 部署解决方案时出错。创建完所有资源后,Terraform 会显示以下消息:

Apply complete!Terraform 输出还列出了您需要的以下其他信息:

- 已部署的信息中心的 Looker Studio 网址。

- 用于打开 BigQuery 编辑器以进行部分示例查询的链接。

- 打开 Colab 教程的链接。

以下示例展示了输出内容:

lookerstudio_report_url = "https://lookerstudio.google.com/reporting/create?c.reportId=79675b4f-9ed8-4ee4-bb35-709b8fd5306a&ds.ds0.datasourceName=vw_ecommerce&ds.ds0.projectId=${var.project_id}&ds.ds0.type=TABLE&ds.ds0.datasetId=gcp_lakehouse_ds&ds.ds0.tableId=view_ecommerce" bigquery_editor_url = "https://console.cloud.google.com/bigquery?project=my-cloud-project&ws=!1m5!1m4!6m3!1smy-cloud-project!2sds_edw!3ssp_sample_queries" lakehouse_colab_url = "https://colab.research.google.com/github/GoogleCloudPlatform/terraform-google-analytics-lakehouse/blob/main/assets/ipynb/exploratory-analysis.ipynb"如需查看和使用信息中心并在 BigQuery 中运行查询,请复制上一步中的输出网址,并在新的浏览器标签页中打开该网址。

信息中心、笔记本和 BigQuery 编辑器将在新标签页中打开。

如果您不再需要此解决方案,可以将部署删除,以免继续为 Google Cloud 资源计费。如需了解详情,请参阅删除部署。

自定义解决方案

本部分提供的信息可供 Terraform 开发者修改分析湖仓一体解决方案,以满足其自己的技术和业务要求。仅当您使用 Terraform CLI 部署解决方案时,本部分中的指导才具有相关性。

在了解了解决方案如何使用示例数据后,建议使用您自己的数据。如需使用您自己的数据,请将其放在名为 edw-raw-hash 的 Cloud Storage 存储桶中。该哈希值是部署期间生成的 8 个字符的随机字符集。您可以通过以下方式更改 Terraform 代码:

- 数据集 ID。更改 Terraform 代码,以便代码在创建 BigQuery 数据集时,会使用您要用于数据的数据集 ID。

- 架构。更改 Terraform 代码,使其创建要用于存储数据的 BigQuery 表 ID。这包括外部表架构,以便 BigQuery 可以从 Cloud Storage 读取数据。

- 可用区。根据您的业务需求创建数据湖区域(通常有两层或三层分区,取决于数据质量和使用情况)。

- Looker 信息中心。更改用于创建 Looker 信息中心的 Terraform 代码,以便信息中心反映您正在使用的数据。

- PySpark 作业。更改 Terraform 代码以使用 Dataproc 执行 PySpark 作业。

以下是常见的分析数据湖仓一体对象,显示了 main.tf 中的 Terraform 示例代码。

-

BigQuery 数据集:数据库对象分组和存储所采用的架构。

resource "google_bigquery_dataset" "ds_edw" { project = module.project-services.project_id dataset_id = "DATASET_PHYSICAL_ID" friendly_name = "DATASET_LOGICAL_NAME" description = "DATASET_DESCRIPTION" location = "REGION" labels = var.labels delete_contents_on_destroy = var.force_destroy } -

BigQuery 表:一种数据库对象,用于表示存储在 BigQuery 中的数据或表示存储在 Cloud Storage 中的数据架构。

resource "google_bigquery_table" "tbl_edw_taxi" { dataset_id = google_bigquery_dataset.ds_edw.dataset_id table_id = "TABLE_NAME" project = module.project-services.project_id deletion_protection = var.deletion_protection ... } -

BigQuery 存储过程:一种数据库对象,用于表示在调用时要执行的一个或多个 SQL 语句。该过程可以是将数据从一个表转换到另一个表,也可以是将数据从外部表加载到标准表。

resource "google_bigquery_routine" "sp_sample_translation_queries" { project = module.project-services.project_id dataset_id = google_bigquery_dataset.ds_edw.dataset_id routine_id = "sp_sample_translation_queries" routine_type = "PROCEDURE" language = "SQL" definition_body = templatefile("${path.module}/assets/sql/sp_sample_translation_queries.sql", { project_id = module.project-services.project_id }) } -

Cloud Workflows 工作流:Workflows 工作流表示要按特定顺序执行的步骤组合。这可用于设置数据或执行数据转换以及其他执行步骤。

resource "google_workflows_workflow" "copy_data" { name = "copy_data" project = module.project-services.project_id region = var.region description = "Copies data and performs project setup" service_account = google_service_account.workflows_sa.email source_contents = templatefile("${path.module}/src/yaml/copy-data.yaml", { public_data_bucket = var.public_data_bucket, textocr_images_bucket = google_storage_bucket.textocr_images_bucket.name, ga4_images_bucket = google_storage_bucket.ga4_images_bucket.name, tables_bucket = google_storage_bucket.tables_bucket.name, dataplex_bucket = google_storage_bucket.dataplex_bucket.name, images_zone_name = google_dataplex_zone.gcp_primary_raw.name, tables_zone_name = google_dataplex_zone.gcp_primary_staging.name, lake_name = google_dataplex_lake.gcp_primary.name }) }

如需自定义解决方案,请在 Cloud Shell 中完成以下步骤:

验证当前工作目录是否为

$HOME/cloudshell_open/terraform-google-analytics-lakehouse。如果不是,请转到该目录:cd $HOME/cloudshell_open/terraform-google-analytics-lakehouse打开

main.tf并进行所需更改。如需详细了解此类自定义对可靠性、安全性、性能、费用和操作的影响,请参阅设计建议。

预配资源。

设计建议

本部分就如何使用 Analytics Lakehouse 解决方案来开发符合安全性、可靠性、费用和性能要求的架构提供了相关建议。

在开始扩缩湖仓一体解决方案时,您可以通过多种方式来提高查询性能并减少总支出。这些方法包括更改数据的物理存储方式、修改 SQL 查询以及更改使用不同技术执行查询的方式。如需详细了解优化 Spark 工作负载的方法,请参阅适用于生产环境的 Dataproc 最佳做法。

请注意以下几点:

- 在进行任何设计更改之前,请评估费用影响并考虑与其他功能的潜在权衡。您可以使用Google Cloud 价格计算器评估设计更改的费用影响。

- 要在解决方案中实现设计更改,您需要具备 Terraform 编码方面的专业知识,以及解决方案中使用的 Google Cloud 服务的高级知识。

- 如果您修改了 Google 提供的 Terraform 配置,然后遇到错误,请在 GitHub 中创建问题。GitHub 问题会尽量得到查看,且不适用于一般使用问题。

- 如需详细了解如何在 Google Cloud中设计和设置生产级环境,请参阅 Google Cloud中的着陆区设计和 Google Cloud 设置核对清单。

删除解决方案部署

如果不再需要解决方案部署,为避免继续为创建的资源计费,请删除部署。

通过控制台删除部署

如果您通过控制台部署了解决方案,请按以下流程操作。

在 Google Cloud 控制台中,前往解决方案部署页面。

选择您要删除的部署所在的项目。

找到您要删除的部署。

在部署对应的行中,点击 操作,然后选择删除。

您可能需要向下滚动才能看到该行中的操作。

输入部署的名称,然后点击确认。

状态字段显示正在删除。

如果删除失败,请参阅删除部署时出错中的问题排查指南。

如果您不再需要用于此解决方案的 Google Cloud 项目,则可以删除该项目。如需了解详情,请参阅可选:删除项目。

使用 Terraform CLI 删除部署

如果您使用 Terraform CLI 部署了解决方案,请按照以下步骤操作。

在 Cloud Shell 中,确保当前工作目录为

$HOME/cloudshell_open/terraform-google-analytics-lakehouse/。如果不是,请转到该目录。移除 Terraform 预配的资源:

terraform destroyTerraform 会显示将被销毁的资源列表。

当系统提示您执行操作时,请输入

yes。Terraform 会显示显示进度的消息。删除所有资源后,Terraform 将显示以下消息:

Destroy complete!如果删除失败,请参阅删除部署时出错中的问题排查指南。

如果您不再需要用于此解决方案的 Google Cloud 项目,则可以删除该项目。如需了解详情,请参阅可选:删除项目。

可选:删除项目

如果您在新 Google Cloud 项目中部署了解决方案,但不再需要该项目,请完成以下步骤来将其删除:

- 在 Google Cloud 控制台中,前往管理资源页面。

- 在项目列表中,选择要删除的项目,然后点击删除。

- 在提示符处,输入项目 ID,然后点击关停。

如果您决定保留项目,请删除为此解决方案创建的服务账号,如下一部分所述。

可选:删除服务账号

如果删除了用于解决方案的项目,请跳过此部分。

如本指南前面部分所述,当您部署解决方案时,系统代表您创建了一个服务账号。系统为服务账号临时分配了某些 IAM 权限;也就是说,在解决方案的部署和删除操作完成后,系统会自动撤消这些权限,但不会删除服务账号。Google 建议您删除此服务账号。

如果您通过 Google Cloud 控制台部署了解决方案,请进入解决方案部署页面。(如果您已进入该页面,请刷新浏览器。)系统会在后台触发进程来删除服务账号。无需进一步操作。

如果您使用 Terraform CLI 部署了解决方案,请完成以下步骤:

在 Google Cloud 控制台中,打开服务账号页面。

选择您用于解决方案的项目。

选择要删除的服务账号。

为解决方案创建的服务账号的电子邮件 ID 采用以下格式:

goog-sc-DEPLOYMENT_NAME-NNN@PROJECT_ID.iam.gserviceaccount.com电子邮件 ID 包含以下值:

- DEPLOYMENT_NAME:部署的名称。

- NNN:随机 3 位数。

- PROJECT_ID:部署了解决方案的项目的 ID。

点击删除。

排查错误

可以诊断和解决错误的操作取决于部署方法和错误的复杂程度。

通过控制台部署解决方案时发生错误

如果您使用控制台时部署失败,请执行以下操作:

转到解决方案部署页面。

如果部署失败,状态字段将显示失败。

查看导致失败的错误的详细信息:

在部署对应的行中,点击 操作。

您可能需要向下滚动才能看到该行中的操作。

选择查看 Cloud Build 日志。

查看 Cloud Build 日志,并采取适当的措施来解决导致失败的问题。

使用 Terraform CLI 部署解决方案时发生错误

如果在使用 Terraform 时部署失败,terraform

apply 命令的输出将包含错误消息,您可以查看这些错误消息以诊断问题。

以下部分中的示例显示了您在使用 Terraform 时可能会遇到的部署错误。

“API 未启用”错误

如果您创建了一个项目,然后立即尝试在新项目中部署此解决方案,则部署可能会失败,并显示如下错误:

Error: Error creating Network: googleapi: Error 403: Compute Engine API has not

been used in project PROJECT_ID before or it is disabled. Enable it by visiting

https://console.developers.google.com/apis/api/compute.googleapis.com/overview?project=PROJECT_ID

then retry. If you enabled this API recently, wait a few minutes for the action

to propagate to our systems and retry.

如果发生此错误,请等待几分钟,然后再次运行 terraform apply 命令。

“无法分配请求的地址”错误

运行 terraform apply 命令时,可能会发生 cannot assign requested address 错误,并显示如下消息:

Error: Error creating service account:

Post "https://iam.googleapis.com/v1/projects/PROJECT_ID/serviceAccounts:

dial tcp [2001:db8:ffff:ffff::5f]:443:

connect: cannot assign requested address

如果发生此错误,请再次运行 terraform apply 命令。

访问 BigQuery 或 Looker Studio 中的数据时出错

在 Terraform 预配步骤之后有一个将数据加载到环境的预配步骤。如果您在将数据加载到 Looker Studio 信息中心时遇到错误,或者在开始探索 BigQuery 时没有对象,请等待几分钟,然后重试。

删除部署时出错

在某些情况下,尝试删除部署可能会失败:

- 通过控制台部署解决方案后,如果您更改此解决方案预配的任何资源,然后尝试删除部署,则删除操作可能会失败。解决方案部署页面上的状态字段会显示失败,并且 Cloud Build 日志会显示错误原因。

- 使用 Terraform CLI 部署解决方案后,如果您使用非 Terraform 界面(例如控制台)更改任何资源,然后尝试删除部署,则删除操作可能会失败。

terraform destroy命令输出中的消息会显示错误的原因。

查看错误日志和消息,找出并删除导致错误的资源,然后再次尝试删除部署。

如果基于控制台的部署未删除,并且您无法使用 Cloud Build 日志诊断错误,则可以使用 Terraform CLI 删除该部署,如下一部分所述。

使用 Terraform CLI 删除基于控制台的部署

本部分介绍在尝试通过控制台删除基于控制台的部署出错时如何删除该部署。在此方法中,您可以下载要删除的部署的 Terraform 配置,然后使用 Terraform CLI 删除部署。

确定部署的 Terraform 代码、日志和其他数据的存储区域。此区域可能与您在部署解决方案时选择的区域不同。

在 Google Cloud 控制台中,前往解决方案部署页面。

选择您要删除的部署所在的项目。

在部署列表中,找到要删除的部署所在的行。

点击 查看所有行内容。

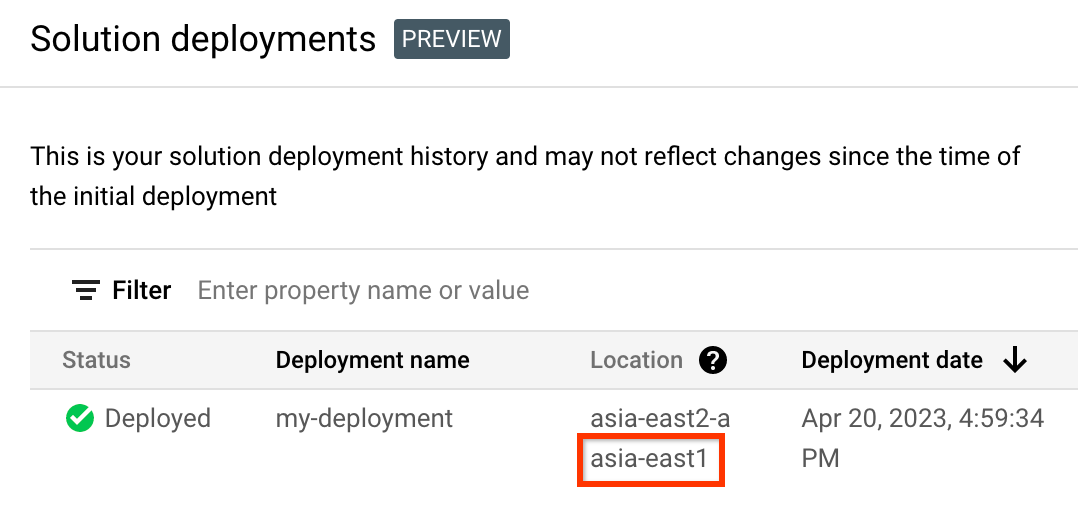

在位置列中,记下第二个位置,如以下示例中突出显示部分所示:

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

为要删除的部署的项目 ID、区域和名称创建环境变量:

export REGION="REGION" export PROJECT_ID="PROJECT_ID" export DEPLOYMENT_NAME="DEPLOYMENT_NAME"在这些命令中,替换以下内容:

- REGION:您先前在此过程中记下的位置。

- PROJECT_ID:您在其中部署解决方案的项目的 ID。

- DEPLOYMENT_NAME:您要删除的部署的名称。

获取您要删除的最新修订版本部署的 ID:

export REVISION_ID=$(curl \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://config.googleapis.com/v1alpha2/projects/${PROJECT_ID}/locations/${REGION}/deployments/${DEPLOYMENT_NAME}" \ | jq .latestRevision -r) echo $REVISION_ID输出类似于以下内容:

projects/PROJECT_ID/locations/REGION/deployments/DEPLOYMENT_NAME/revisions/r-0获取该部署的 Terraform 配置的 Cloud Storage 位置:

export CONTENT_PATH=$(curl \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://config.googleapis.com/v1alpha2/${REVISION_ID}" \ | jq .applyResults.content -r) echo $CONTENT_PATH以下是此命令的输出示例:

gs://PROJECT_ID-REGION-blueprint-config/DEPLOYMENT_NAME/r-0/apply_results/content将 Terraform 配置从 Cloud Storage 下载到 Cloud Shell:

gcloud storage cp $CONTENT_PATH $HOME --recursive cd $HOME/content/等到系统显示

Operation completed消息,如以下示例所示:Operation completed over 45 objects/268.5 KiB初始化 Terraform:

terraform init等待系统显示以下消息:

Terraform has been successfully initialized!移除已部署的资源:

terraform destroyTerraform 会显示将被销毁的资源列表。

如果显示的警告与未声明变量有关,请忽略这些警告。

当系统提示您执行操作时,请输入

yes。Terraform 会显示显示进度的消息。删除所有资源后,Terraform 将显示以下消息:

Destroy complete!删除部署工件:

curl -X DELETE \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://config.googleapis.com/v1alpha2/projects/${PROJECT_ID}/locations/${REGION}/deployments/${DEPLOYMENT_NAME}?force=true&delete_policy=abandon"等待几秒钟,然后验证部署工件是否已删除:

curl -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://config.googleapis.com/v1alpha2/projects/${PROJECT_ID}/locations/${REGION}/deployments/${DEPLOYMENT_NAME}" \ | jq .error.message如果输出显示

null,请等待几秒钟,然后再次运行该命令。删除部署工件后,系统会显示一条如以下示例所示的消息:

Resource 'projects/PROJECT_ID/locations/REGION/deployments/DEPLOYMENT_NAME' was not found- 对于文档、控制台教程或解决方案,请使用页面上的发送反馈按钮。

- 对于未经修改的 Terraform 代码,请在 GitHub 代码库中创建问题。 GitHub 问题会尽量得到查看,且不适用于一般使用问题。

- 如有关于解决方案中所使用产品的问题,请与 Cloud Customer Care 联系。

- 使用 Dataplex Universal Catalog 创建数据湖

- 为 Apache Iceberg 创建 BigLake 外部表

- 在 Google Cloud上使用 Apache Spark

- 了解 BigQuery

提交反馈

快速起步解决方案仅供参考,并非官方支持的产品。Google 可能会在不事先通知的情况下更改或移除解决方案。

如需排查错误,请查看 Cloud Build 日志和 Terraform 输出。

如需提交反馈,请执行以下操作: