Google Kubernetes Engine (GKE)

Le service Kubernetes entièrement automatisé le plus évolutif

Mettez vos conteneurs en mode Autopilot et exécutez de façon sécurisée vos charges de travail d'entreprise à grande échelle, quel que soit votre niveau d'expertise sur Kubernetes.

Bénéficiez d'un cluster zonal ou Autopilot gratuit par mois. Les nouveaux clients bénéficient de 300 $ de crédits pour essayer GKE et d'autres produits Google Cloud.

Fonctionnalités

Vitesse accrue, risque réduit et coût total de possession (TCO) moindre

Éditions flexibles

L'édition GKE Standard offre une gestion entièrement automatisée du cycle de vie des clusters, l'autoscaling des pods et des clusters, la visibilité des coûts et l'optimisation automatisée des coûts d'infrastructure. Elle inclut tous les avantages existants de GKE, et propose les modes de fonctionnement Autopilot et Standard. GKE Enterprise, la nouvelle édition Premium de GKE, offre tous les avantages mentionnés précédemment, ainsi que des fonctionnalités de gestion, de gouvernance, de sécurité et de configuration pour plusieurs équipes et clusters, le tout pilotable via une console unifiée, et enfin un maillage de services intégré.

Expérience Kubernetes sans serveur avec Autopilot

Surveillance automatisée de la sécurité et de la conformité

La fonctionnalité de détection des menaces GKE est fournie par Security Command Center (SCC) et identifie en temps quasi réel les menaces qui affectent vos clusters GKE en surveillant en permanence les journaux d'audit GKE.

La conformité avec GKE offre des insights en temps réel simplifiés, des rapports automatisés et la liberté d'innover de manière sécurisée sur Google Cloud.

Autoscaling des pods et des clusters

GKE implémente l'API Kubernetes complète, l'autoscaling quadridirectionnel, les canaux de publication, la compatibilité multicluster et le scaling à la hausse jusqu'à 15 000 nœuds. L'autoscaling horizontal des pods peut être basé sur l'utilisation du processeur ou sur des métriques personnalisées. L'autoscaling des clusters fonctionne par pool de nœuds. L'autoscaling vertical des pods analyse en continu l'utilisation de la mémoire et des processeurs des pods, et ajuste automatiquement les demandes de ressources mémoire et de processeurs en conséquence.

Mise en réseau et sécurité natives pour les conteneurs

Applications et modèles Kubernetes intégrés

Compatibilité avec les GPU et TPU

Gestion de plusieurs équipes avec les niveaux d'accès d'équipes de parc

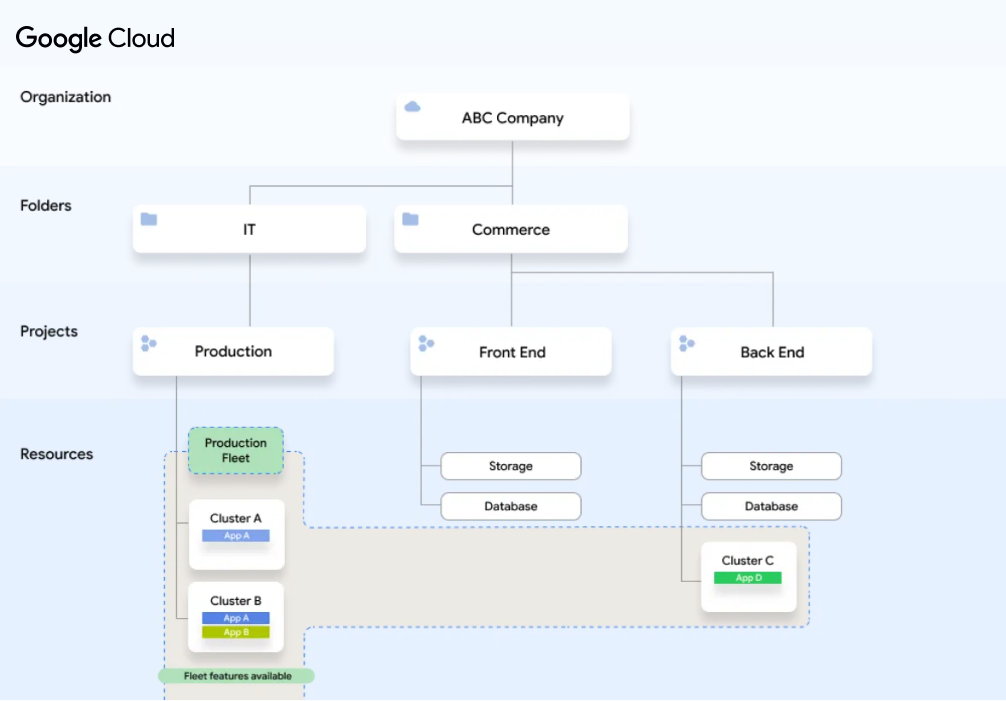

Gestion multicluster avec les parcs

Sauvegarde pour GKE

Compatibilité multicloud avec la portabilité des charges de travail

Compatibilité hybride

Maillage de services géré

GitOps géré

Gestion de l'authentification et des accès

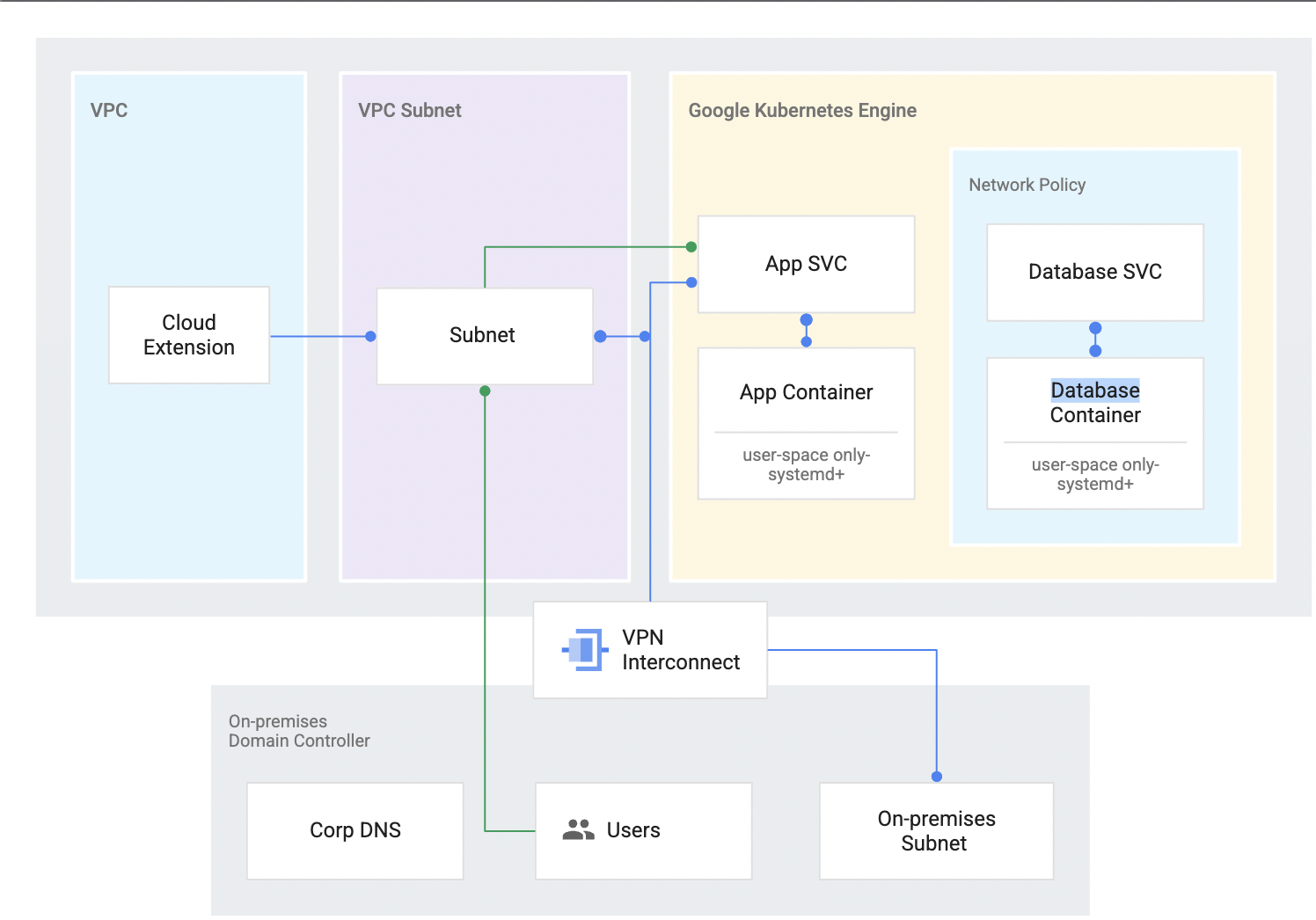

Réseau hybride

Réservez une plage d'adresses IP pour votre cluster afin que ses adresses IP coexistent avec celles de votre réseau privé via Google Cloud VPN.

Sécurité et conformité

Surveillance et journalisation intégrées

Options de cluster

Autoscaling

Mise à niveau automatique

Réparation automatique

Limites de ressources

Isolement du conteneur

Prise en charge des applications avec état

Compatibilité avec les images Docker

OS spécialement conçu pour les conteneurs

Registre de conteneurs privés

Compilations rapides et cohérentes

Tableau de bord intégré

VM Spot

Compatibilité avec les disques persistants

Compatibilité avec le SSD local

Équilibrage de charge global

Compatibilité avec Linux et Windows

Conteneurs sans serveur

Mesure de l'utilisation

Canaux de publication

Sécurité sur la chaîne d'approvisionnement logicielle

Facturation à la seconde

Fonctionnement

Un cluster GKE comporte un plan de contrôle et des machines appelés "nœuds". Les nœuds exécutent les services nécessaires aux conteneurs qui constituent vos charges de travail. Le plan de contrôle décide ensuite de ce qui s'exécute sur ces nœuds : il gère entre autres la planification et le scaling. Le mode Autopilot prend en charge cette complexité. Il vous suffit de déployer et d'exécuter vos applications.

Un cluster GKE comporte un plan de contrôle et des machines appelés "nœuds". Les nœuds exécutent les services nécessaires aux conteneurs qui constituent vos charges de travail. Le plan de contrôle décide ensuite de ce qui s'exécute sur ces nœuds : il gère entre autres la planification et le scaling. Le mode Autopilot prend en charge cette complexité. Il vous suffit de déployer et d'exécuter vos applications.

Utilisations courantes

Gérer une infrastructure multicluster

Simplifier les déploiements multicluster avec les parcs

Trouver le bon partenaire pour gérer une infrastructure multicluster

Tutoriels, guides de démarrage rapide et ateliers

Simplifier les déploiements multicluster avec les parcs

Partenaires et intégrations

Trouver le bon partenaire pour gérer une infrastructure multicluster

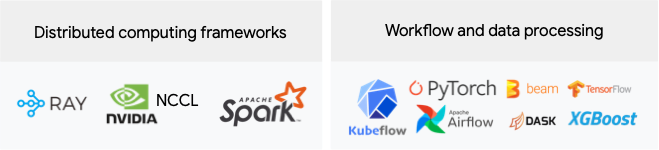

Exécuter de façon sécurisée des charges de travail d'IA optimisées

Exécuter des charges de travail d'IA optimisées avec l'orchestration de plates-formes

Une plate-forme de ML et d'IA robuste offre les éléments suivants : (i) orchestration d'infrastructure compatible avec les GPU pour l'entraînement et l'inférence des charges de travail à grande échelle, (ii) intégration flexible avec des frameworks de calcul et de traitement des données distribués, et (iii) possibilité pour plusieurs équipes d'utiliser la même infrastructure dans l'optique d'optimiser l'utilisation des ressources.

Des GPU partagés dans GKE aident à trouver des neutrinos

Tutoriels, guides de démarrage rapide et ateliers

Exécuter des charges de travail d'IA optimisées avec l'orchestration de plates-formes

Une plate-forme de ML et d'IA robuste offre les éléments suivants : (i) orchestration d'infrastructure compatible avec les GPU pour l'entraînement et l'inférence des charges de travail à grande échelle, (ii) intégration flexible avec des frameworks de calcul et de traitement des données distribués, et (iii) possibilité pour plusieurs équipes d'utiliser la même infrastructure dans l'optique d'optimiser l'utilisation des ressources.

Ressources de formation

Des GPU partagés dans GKE aident à trouver des neutrinos

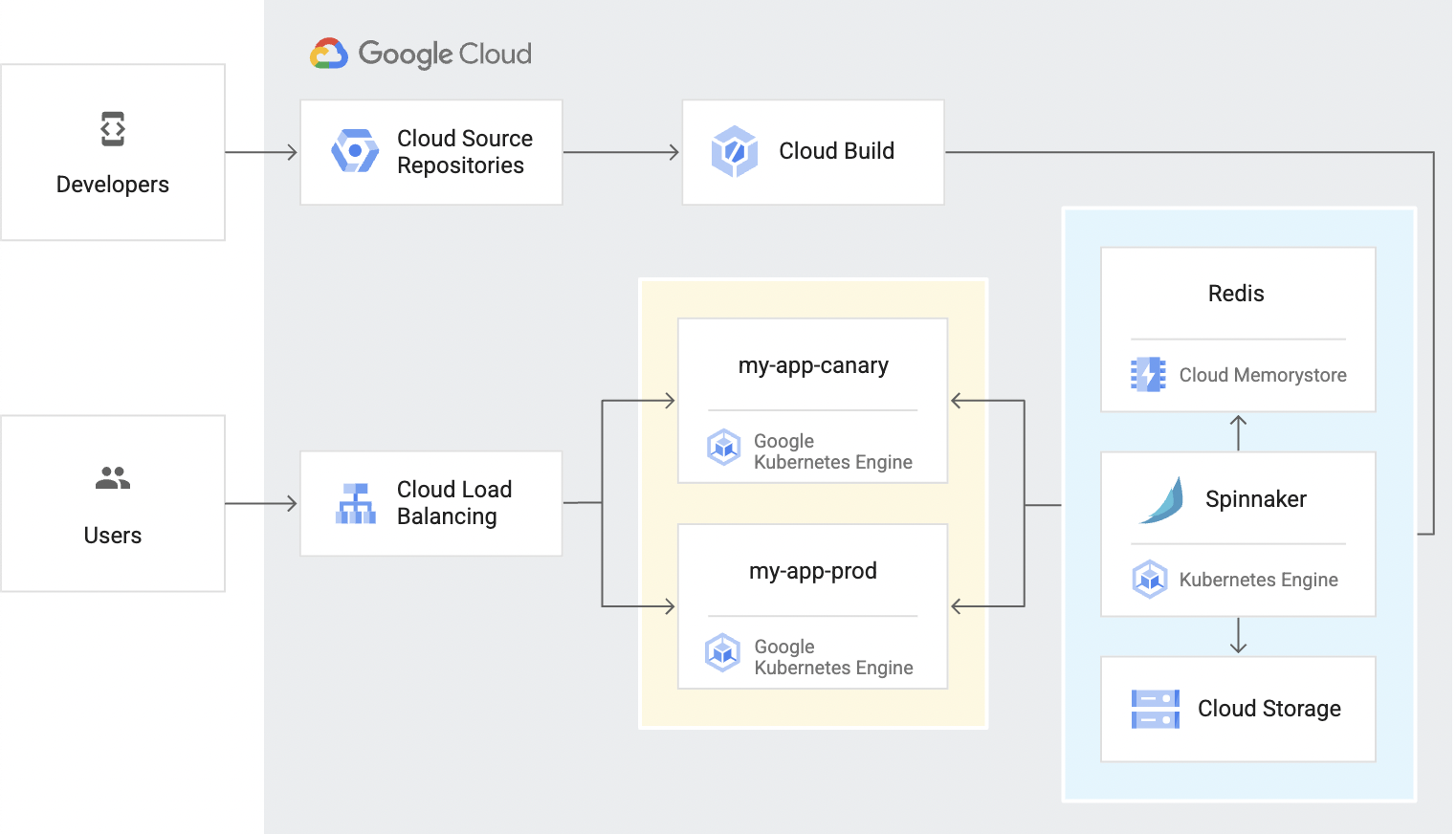

Intégration et livraison continues

Créer un pipeline de livraison continue

Tutoriels, guides de démarrage rapide et ateliers

Créer un pipeline de livraison continue

Déployer et exécuter des applications

Déployer une application Web conteneurisée

Trouver le bon partenaire pour déployer et exécuter votre solution

Current déploie et exécute ses applications sur GKE

Tutoriels, guides de démarrage rapide et ateliers

Déployer une application Web conteneurisée

Partenaires et intégrations

Trouver le bon partenaire pour déployer et exécuter votre solution

Ressources de formation

Current déploie et exécute ses applications sur GKE

Migrer des charges de travail

Migrer une application à deux niveaux vers GKE

Partenaires et services de migration

Tutoriels, guides de démarrage rapide et ateliers

Migrer une application à deux niveaux vers GKE

Partenaires et intégrations

Partenaires et services de migration

Tarification

| Fonctionnement des tarifs de GKE | Une fois les crédits gratuits utilisés, le coût total est basé sur l'édition, le mode de fonctionnement du cluster, les frais de gestion du cluster et les frais de transfert de données entrant applicables. | |

|---|---|---|

| Service | Description | Prix (USD) |

Version gratuite | La version gratuite de GKE fournit 74,40 $ de crédits mensuels par compte de facturation, appliqués aux clusters zonaux et Autopilot. | Gratuit |

Kubernetes | Édition Enterprise Inclut toutes les fonctionnalités de l'édition Standard, mais également les opérations inter-équipes, la gestion multicluster et l'accès en libre-service, des fonctionnalités avancées de sécurité, de maillage de services et de configuration, ainsi qu'une console unifiée. | 0,0083 $ par vCPU et par heure |

Édition Standard Inclut la gestion entièrement automatisée du cycle de vie des clusters, l'autoscaling des pods et des clusters, la visibilité des coûts et l'optimisation automatisée des coûts d'infrastructure. | 0,10 $ par cluster et par heure | |

Calcul | Mode Autopilot : ressources de processeur, de mémoire et de calcul provisionnées pour vos pods. Mode Standard : chaque instance vous est facturée selon les tarifs de Compute Engine. | Consultez les tarifs de Compute Engine. |

Apprenez-en davantage sur les tarifs de GKE. Afficher le détail des tarifs

Fonctionnement des tarifs de GKE

Une fois les crédits gratuits utilisés, le coût total est basé sur l'édition, le mode de fonctionnement du cluster, les frais de gestion du cluster et les frais de transfert de données entrant applicables.

La version gratuite de GKE fournit 74,40 $ de crédits mensuels par compte de facturation, appliqués aux clusters zonaux et Autopilot.

Gratuit

Édition Enterprise

Inclut toutes les fonctionnalités de l'édition Standard, mais également les opérations inter-équipes, la gestion multicluster et l'accès en libre-service, des fonctionnalités avancées de sécurité, de maillage de services et de configuration, ainsi qu'une console unifiée.

0,0083 $

par vCPU et par heure

Édition Standard

Inclut la gestion entièrement automatisée du cycle de vie des clusters, l'autoscaling des pods et des clusters, la visibilité des coûts et l'optimisation automatisée des coûts d'infrastructure.

0,10 $

par cluster et par heure

Mode Autopilot : ressources de processeur, de mémoire et de calcul provisionnées pour vos pods.

Mode Standard : chaque instance vous est facturée selon les tarifs de Compute Engine.

Consultez les tarifs de Compute Engine.

Apprenez-en davantage sur les tarifs de GKE. Afficher le détail des tarifs