Dataflow

即時 data intelligence

充分發揮即時資料的潛能。Dataflow 是簡單易用且可擴充的全代管串流平台,能協助您加快即時決策速度,並提供更優質的客戶體驗。

新客戶可以獲得價值 $300 美元的免費抵免額,盡情體驗 Dataflow。

功能

使用串流 AI 和機器學習技術,即時支援生成式 AI 模型

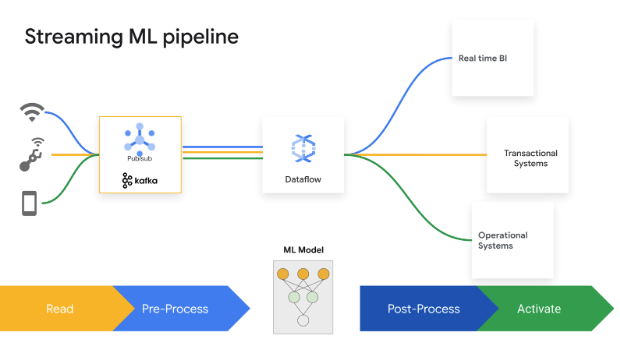

即時資料可為 AI/機器學習模型提供最新資訊,提高預測準確率。Dataflow ML 能簡化完整的機器學習 pipeline 部署與管理作業。我們提供現成可用的模式,方便您取得個人化建議、詐欺偵測、威脅防範等功能。運用 Vertex AI、Gemini 模型和 Gemma 模型建構串流 AI、執行遠端推論,並透過 MLTransform 簡化資料處理作業。運用 Dataflow GPU 和最適資源配置功能,提升 MLOps 和機器學習工作效率。

實現企業規模的進階串流用途

Dataflow 是一項全代管服務,透過開放原始碼 Apache Beam SDK 實現企業規模的進階串流用途,且提供豐富多元的功能,適用於各種狀態與時間、轉換和 I/O 連接器。Dataflow 可擴充為每項工作 4,000 個 worker,且會定期處理數 PB 的資料。它還具備自動調度資源功能,可讓批次與串流 pipeline 達到最佳資源使用率。

運用範本和筆記本,縮短創造價值的時間

Dataflow 提供方便您輕鬆上手的工具。Dataflow 範本是預先設計的串流和批次處理藍圖,經過最佳化調整,能提高 CDC 和 BigQuery 資料整合效率。您可以透過 Vertex AI 筆記本,從零開始以疊代的方式建構採用最新數據資料學架構的 pipeline,然後使用 Dataflow 執行器加以部署。Dataflow 工作建構工具提供視覺化的使用者介面,可讓您在 Google Cloud 控制台中建構及執行 Dataflow pipeline,完全不需要編寫程式碼。

運用智慧型診斷和監控工具節省時間

Dataflow 提供全方位的診斷與監控工具。進度落後項目偵測功能會自動找出效能瓶頸,而資料取樣功能則可讓您觀測各個 pipeline 步驟的資料。Dataflow 深入分析結果會提供工作改善建議。Dataflow UI 提供豐富的監控工具,包括工作圖表、執行作業詳細資料、指標、自動調度資源資訊主頁和記錄。另外,Dataflow 也提供工作費用監控 UI,方便您估算費用。

內建管理與安全防護機制

Dataflow 透過多種方式協助您保護資料:利用 Confidential VM 支援功能加密使用中的資料;客戶自行管理的加密金鑰 (CMEK);VPC Service Controls 整合功能;以及關閉公開 IP。Dataflow 稽核記錄功能可讓貴組織掌握 Dataflow 的使用情形,有助於找出「誰在什麼時間、什麼地方做了什麼」,以便加強管理。

常見用途

即時分析

加入串流資料,以便進行即時分析及建立作業 pipeline

加入串流資料,以便進行即時分析及建立作業 pipeline

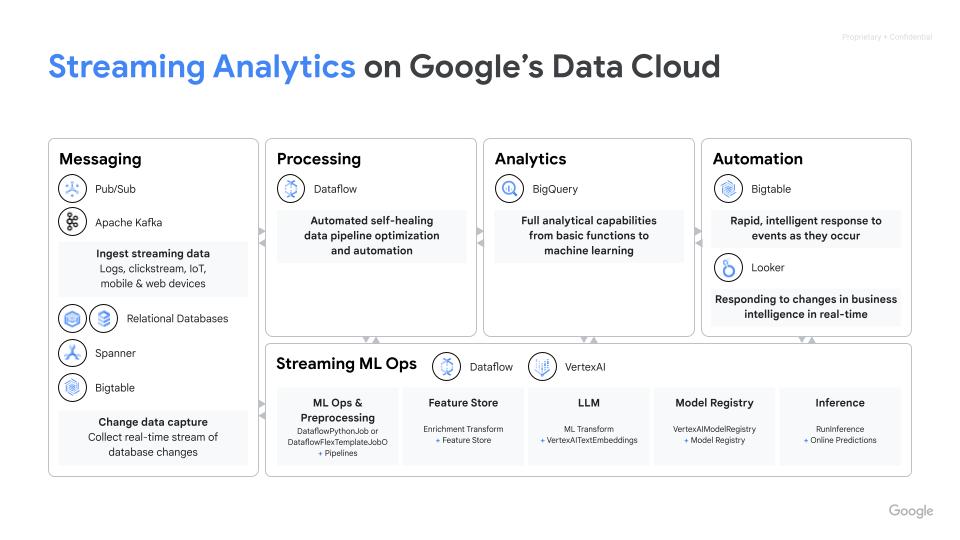

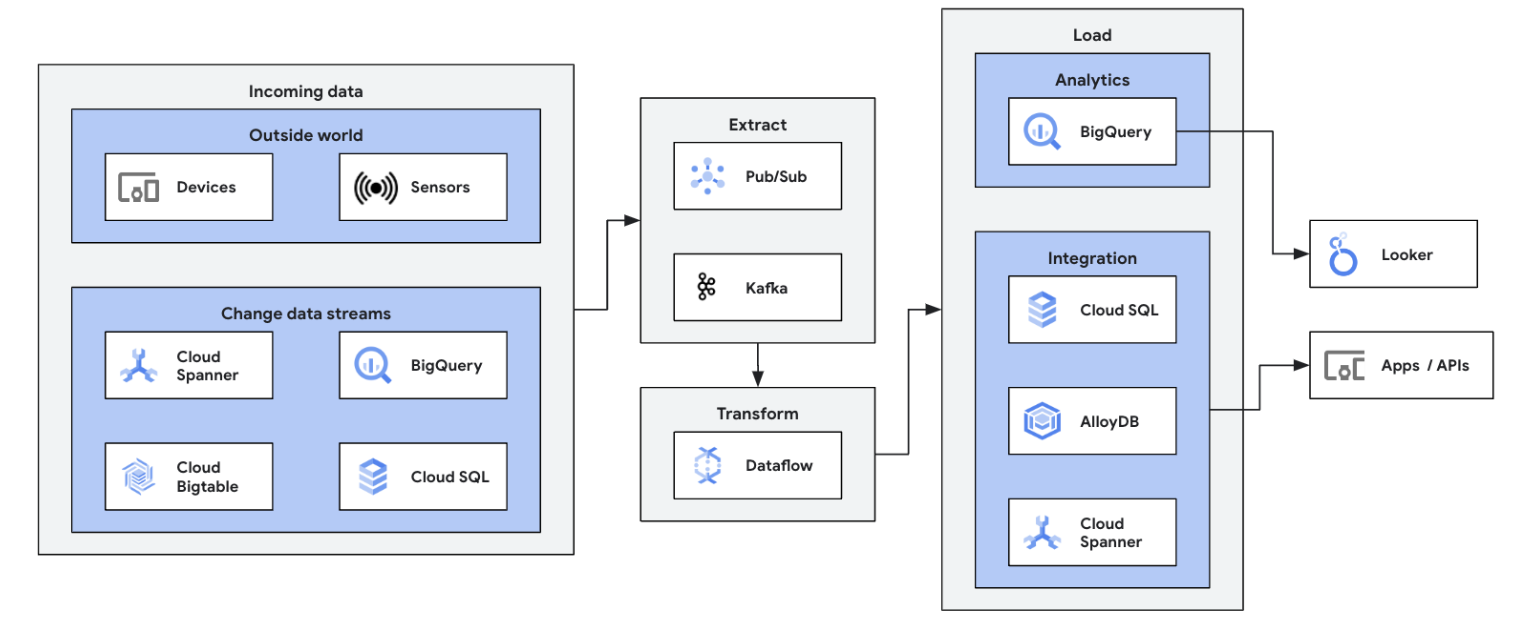

將串流資料來源 (Pub/Sub、Kafka、CDC 事件、使用者點擊流、記錄和感應器資料) 整合至 BigQuery、Google Cloud Storage data lake、Spanner、Bigtable、SQL 儲存庫、Splunk、Datadog 等,即可開始串流資料。探索各種經過最佳化的 Dataflow 範本,只要按幾下滑鼠,就能輕鬆設定 pipeline,不必編寫程式碼。利用整合式 UDF 建構工具,將自訂邏輯新增至範本工作,或是運用 Beam 轉換和 I/O 連接器生態系統的完整功能,從頭開始建立自訂 ETL pipeline。Dataflow 也常用於將 BigQuery 中經過 ETL 處理的資料反向調回 OLTP 儲存庫,以便快速查詢及為使用者提供服務。這是 Dataflow 將串流資料寫入多個儲存位置的常見模式。

展開您的第一項 Dataflow 工作,並參加 Dataflow 基礎的自助課程。

教學課程、快速入門導覽課程和研究室

加入串流資料,以便進行即時分析及建立作業 pipeline

加入串流資料,以便進行即時分析及建立作業 pipeline

將串流資料來源 (Pub/Sub、Kafka、CDC 事件、使用者點擊流、記錄和感應器資料) 整合至 BigQuery、Google Cloud Storage data lake、Spanner、Bigtable、SQL 儲存庫、Splunk、Datadog 等,即可開始串流資料。探索各種經過最佳化的 Dataflow 範本,只要按幾下滑鼠,就能輕鬆設定 pipeline,不必編寫程式碼。利用整合式 UDF 建構工具,將自訂邏輯新增至範本工作,或是運用 Beam 轉換和 I/O 連接器生態系統的完整功能,從頭開始建立自訂 ETL pipeline。Dataflow 也常用於將 BigQuery 中經過 ETL 處理的資料反向調回 OLTP 儲存庫,以便快速查詢及為使用者提供服務。這是 Dataflow 將串流資料寫入多個儲存位置的常見模式。

展開您的第一項 Dataflow 工作,並參加 Dataflow 基礎的自助課程。

即時 ETL 與資料整合

運用即時資料翻新資料平台

運用即時資料翻新資料平台

即時執行 ETL 和整合程序,並立即寫入資料,可讓您快速分析與制定決策。Dataflow 提供無伺服器架構和串流功能,非常適合用於建構即時 ETL pipeline。Dataflow 能自動調度資源,可確保維持一定的效率和規模彈性,而它對於各種資料來源和目的地的支援也簡化了整合作業。

歡迎參加這個 Google Cloud Skills Boost 課程,運用 Dataflow 批次處理功能建構基礎。

教學課程、快速入門導覽課程和研究室

運用即時資料翻新資料平台

運用即時資料翻新資料平台

即時執行 ETL 和整合程序,並立即寫入資料,可讓您快速分析與制定決策。Dataflow 提供無伺服器架構和串流功能,非常適合用於建構即時 ETL pipeline。Dataflow 能自動調度資源,可確保維持一定的效率和規模彈性,而它對於各種資料來源和目的地的支援也簡化了整合作業。

歡迎參加這個 Google Cloud Skills Boost 課程,運用 Dataflow 批次處理功能建構基礎。

即時機器學習和生成式 AI

運用串流機器學習/AI 功能即時採取行動

運用串流機器學習/AI 功能即時採取行動

即時做出決策有助於提升業務價值。Dataflow 串流 AI 和 Dataflow ML 可讓客戶實作低延遲預測和推論、即時個人化、威脅偵測、詐欺防範,以及其他多種極需即時情報的用途。使用 MLTransform 預先處理資料,即可專心轉換資料,不必費心編寫複雜的程式碼或管理基礎程式庫。您也可以使用 RunInference 對生成式 AI 模型進行預測。

教學課程、快速入門導覽課程和研究室

運用串流機器學習/AI 功能即時採取行動

運用串流機器學習/AI 功能即時採取行動

即時做出決策有助於提升業務價值。Dataflow 串流 AI 和 Dataflow ML 可讓客戶實作低延遲預測和推論、即時個人化、威脅偵測、詐欺防範,以及其他多種極需即時情報的用途。使用 MLTransform 預先處理資料,即可專心轉換資料,不必費心編寫複雜的程式碼或管理基礎程式庫。您也可以使用 RunInference 對生成式 AI 模型進行預測。

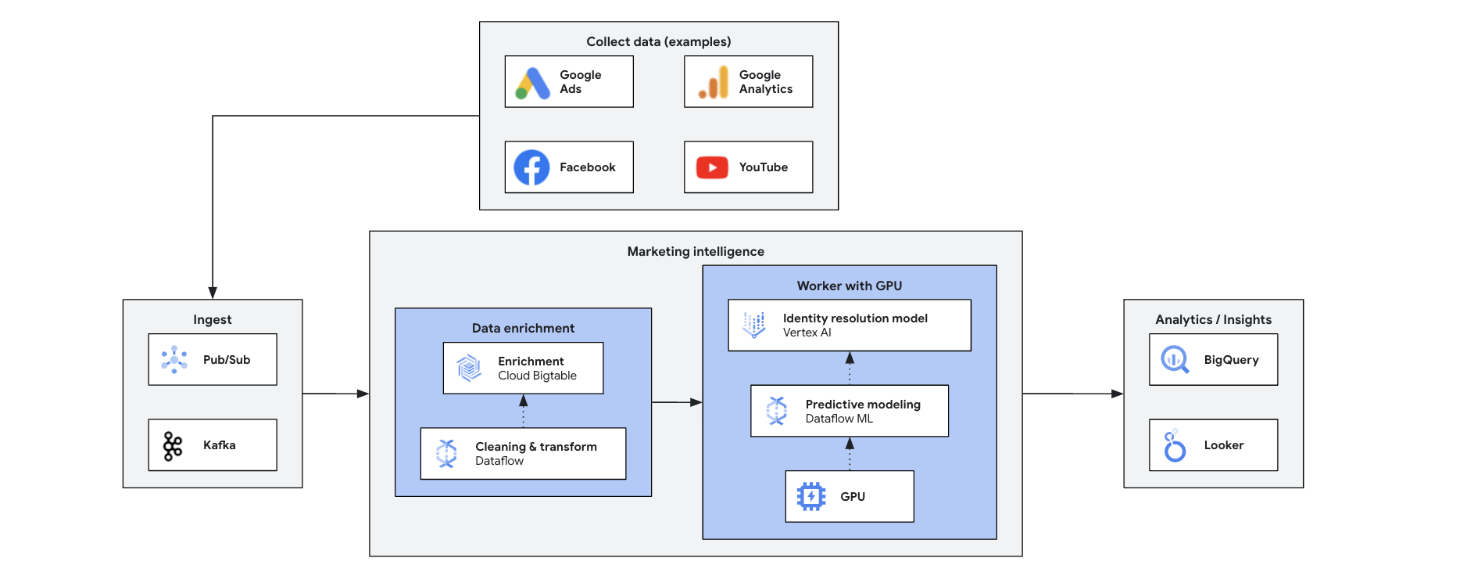

行銷情報

運用即時深入分析資訊改變行銷方式

運用即時深入分析資訊改變行銷方式

即時行銷情報功能會分析當前市場、客戶和競爭對手的資料,方便您迅速做出明智的決策,並靈活因應趨勢、行為和競爭操作,進而改變行銷方式。Meet 具備以下優點:

- 提供個人化內容,即時展開全通路行銷

- 透過個人化互動改善客戶關係管理

- 以靈活的方式進行行銷組合最佳化

- 動態區隔使用者

- 運用競爭情報,保持領先地位

- 主動在社群媒體上進行危機管理

教學課程、快速入門導覽課程和研究室

運用即時深入分析資訊改變行銷方式

運用即時深入分析資訊改變行銷方式

即時行銷情報功能會分析當前市場、客戶和競爭對手的資料,方便您迅速做出明智的決策,並靈活因應趨勢、行為和競爭操作,進而改變行銷方式。Meet 具備以下優點:

- 提供個人化內容,即時展開全通路行銷

- 透過個人化互動改善客戶關係管理

- 以靈活的方式進行行銷組合最佳化

- 動態區隔使用者

- 運用競爭情報,保持領先地位

- 主動在社群媒體上進行危機管理

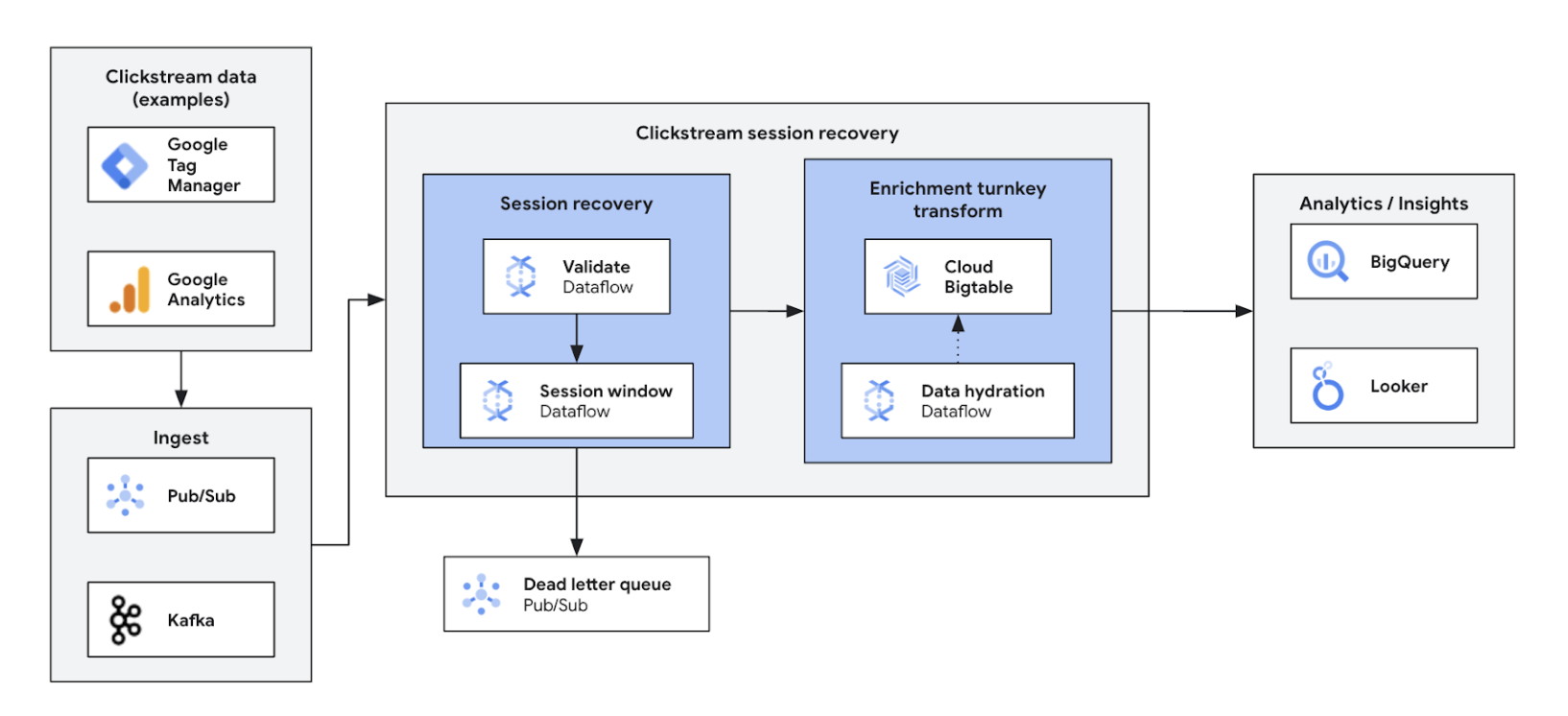

點擊流分析

改善及提供個人化的網頁和應用程式體驗

改善及提供個人化的網頁和應用程式體驗

透過即時點擊流分析,企業能即時分析使用者在網站和應用程式上的互動情形,據以展開即時的個人化作業、A/B 測試和漏斗最佳化,進而提高參與度、加快產品開發速度、減少客戶流失,並提升產品支援服務。企業最終可透過動態定價和個人化推薦,提供絕佳的使用者體驗並帶動業務成長。

教學課程、快速入門導覽課程和研究室

改善及提供個人化的網頁和應用程式體驗

改善及提供個人化的網頁和應用程式體驗

透過即時點擊流分析,企業能即時分析使用者在網站和應用程式上的互動情形,據以展開即時的個人化作業、A/B 測試和漏斗最佳化,進而提高參與度、加快產品開發速度、減少客戶流失,並提升產品支援服務。企業最終可透過動態定價和個人化推薦,提供絕佳的使用者體驗並帶動業務成長。

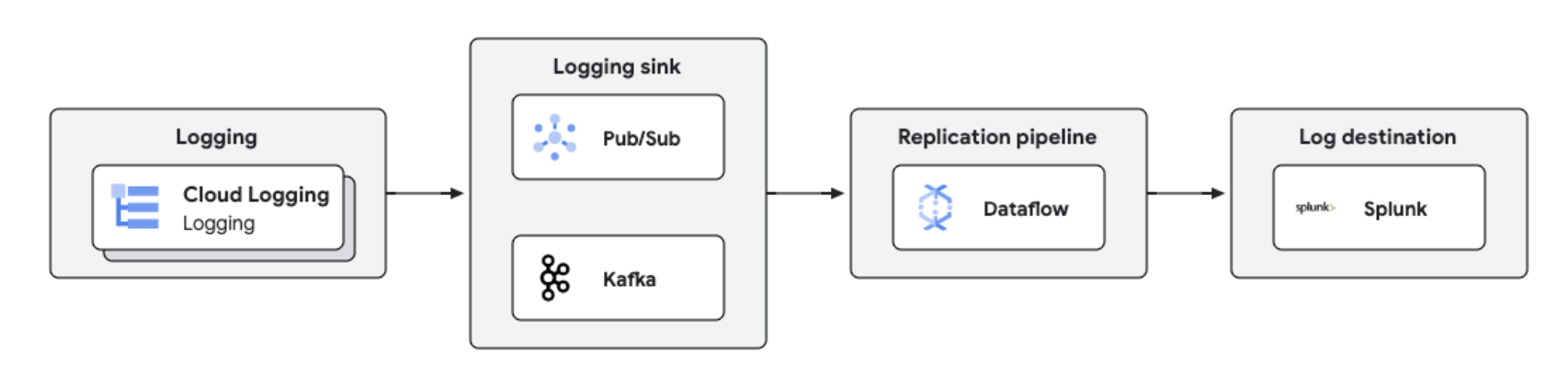

即時複製記錄並進行數據分析

集中化記錄管理與數據分析

集中化記錄管理與數據分析

您可以使用 Dataflow 將 Google Cloud 記錄複製到 Splunk 等第三方平台,以便近乎即時地處理及分析記錄。這項解決方案提供集中化記錄管理、法規遵循、稽核和數據分析功能,同時降低成本並提升效能。

教學課程、快速入門導覽課程和研究室

集中化記錄管理與數據分析

集中化記錄管理與數據分析

您可以使用 Dataflow 將 Google Cloud 記錄複製到 Splunk 等第三方平台,以便近乎即時地處理及分析記錄。這項解決方案提供集中化記錄管理、法規遵循、稽核和數據分析功能,同時降低成本並提升效能。

定價

| Dataflow 的定價方式 | 探索 Dataflow 的計費和資源模式。 | |

|---|---|---|

| 服務與用途 | 說明 | 定價 |

Dataflow 運算資源 | 詳情請參閱詳細的定價頁面 | |

其他 Dataflow 資源 | 詳情請參閱詳細的定價頁面 | |

Dataflow 承諾使用折扣 (CUD) | 視承諾期而定,Dataflow CUD 提供兩種等級的折扣:

| 進一步瞭解 Dataflow CUD |

進一步瞭解 Dataflow 定價。查看所有定價詳細資料。

Dataflow 的定價方式

探索 Dataflow 的計費和資源模式。

Dataflow 承諾使用折扣 (CUD)

視承諾期而定,Dataflow CUD 提供兩種等級的折扣:

- 一年期的 CUD 提供以量計價費率的 20% 折扣優惠

- 三年期的 CUD 提供以量計價費率的 40% 折扣優惠

進一步瞭解 Dataflow CUD

進一步瞭解 Dataflow 定價。查看所有定價詳細資料。

企業案例

瞭解頂尖客戶選用 Dataflow 的理由

ANZ Bank Google Cloud SRE 產品負責人 Namitha Vijaya Kumar

「Dataflow 能協助我們執行批次處理程序和即時資料處理作業,進而確保企業 data lake 能維持資料的即時性。如此一來,便可幫助下游使用資料進行分析/制定決策,並向零售客戶傳送即時通知。」

Dataflow 的優點

簡化機器學習串流作業

提供統包式功能,將串流導入 AI/機器學習:適用於推論的 RunInference、可用於模型訓練預先處理作業的 MLTransform、用於查詢特徵儲存庫的 Enrichment 及動態 GPU 支援,這些功能皆可減少手動作業,只會耗用有限的 GPU 資源,不會浪費任何支出。

運用強大的工具實現最佳成本效益

Dataflow 會自動進行最佳化調整,大幅改善效能和資源使用情況,藉此提供符合成本效益的串流服務。它可以輕鬆調度資源來處理各種工作負載,而且還具備 AI 輔助自我修復功能。強大的工具可協助您完成作業與理解內容。

開放、可攜、可擴充

Dataflow 專為開放原始碼 Apache Beam 打造,提供整合式批次和串流支援功能,可在雲端、on-premises 環境之間轉移工作負載,或將工作負載移至邊緣裝置。

合作夥伴與整合功能

Dataflow 合作夥伴

Google Cloud 合作夥伴開發了 Dataflow 整合機制,能夠提供強大的處理功能,協助您快速輕鬆地執行各種規模的資料處理工作。查看所有合作夥伴,立即展開串流之旅。