In dieser Anleitung registrieren Sie einen Vertex AI-Endpunkt als Remote-Modell in BigQuery. Anschließend verwenden Sie die Funktion ML.PREDICT, um Vorhersagen mit dem Remote-Modell zu treffen.

Sie können Remote-Modelle verwenden, wenn ein Modell für den Import in BigQuery zu groß ist. Sie sind auch nützlich, wenn Sie eine einzelne Inferenz für Online-, Batch- und Mikro-Batch-Anwendungsfälle verwenden möchten.

Modell in Vertex AI Model Registry importieren

In dieser Anleitung verwenden Sie ein vortrainiertes TensorFlow-Modell, das in Cloud Storage unter gs://cloud-samples-data/bigquery/ml/remote_model_tutorial/ verfügbar ist. Der Cloud Storage-Bucket befindet sich am multiregionalen Standort US.

Das Modell ist ein TensorFlow-Modell mit dem Namen saved_model.pb. Es handelt sich um ein benutzerdefiniertes Modell zur Sentimentanalyse, das durch Feinabstimmung eines BERT-Modells mit IMDb-Filmrezensionen im Nur-Text-Format erstellt wurde. Das Modell verwendet Texteingaben aus den Filmrezensionen und gibt Sentimentwerte zwischen 0 und 1 zurück. Wenn Sie das Modell in die Modellregistrierung importieren, verwenden Sie einen vordefinierten TensorFlow-Container.

So importieren Sie das Modell:

Rufen Sie in der Google Cloud Console die Seite Vertex AI Model Registry auf.

Klicken Sie auf Importieren.

Gehen Sie für Schritt 1: Name und Region so vor:

Wählen Sie Als neues Modell importieren aus.

Geben Sie für Name

bert_sentimentein.Geben Sie unter Beschreibung

BQML tutorial modelein.Wählen Sie bei Region die Option

us-central1aus. Sie müssen eine Region in den USA auswählen, da sich der Cloud Storage-Bucket am multiregionalen StandortUSbefindet.Klicken Sie auf Weiter.

Gehen Sie für Schritt 2: Modelleinstellungen so vor:

Wählen Sie Modellartefakte in einen neuen vordefinierten Container importieren aus.

Gehen Sie im Bereich Vordefinierte Containereinstellungen folgendermaßen vor:

Wählen Sie für Modell-Framework die Option TensorFlow aus.

Wählen Sie für Modell-Framework-Version die Option 2.15 aus.

Wählen Sie für Beschleunigertyp die Option GPU aus.

Geben Sie für Speicherort des Modellartefakts

gs://cloud-samples-data/bigquery/ml/remote_model_tutorial/ein.Übernehmen Sie für alle verbleibenden Optionen die Standardwerte und klicken Sie auf Importieren.

Wenn der Import abgeschlossen ist, wird das Modell auf der Seite Model Registry angezeigt.

Modell in einem Vertex AI-Endpunkt bereitstellen

Führen Sie die folgenden Schritte aus, um das Modell an einem Endpunkt bereitzustellen.

Rufen Sie in der Google Cloud Console die Seite Vertex AI Model Registry auf.

Klicken Sie in der Spalte Name auf

bert_sentiment.Klicken Sie auf den Tab Bereitstellen und Testen.

Klicken Sie auf In Endpunkt bereitstellen.

Führen Sie für Schritt 1, Endpunkt definieren, die folgenden Schritte aus:

Klicken Sie auf Neuen Endpunkt erstellen.

Geben Sie unter Endpunktname

bert sentiment endpointein.Behalten Sie die verbleibenden Standardwerte bei und klicken Sie auf Weiter.

Gehen Sie für Schritt 2, Modelleinstellungen, so vor:

Geben Sie im Abschnitt Compute-Einstellungen für Mindestanzahl von Computing-Knoten den Wert

1ein. Dies ist die Anzahl der Knoten, die für das Modell verfügbar sein müssen.Wählen Sie im Bereich Erweiterte Skalierungsoptionen für Maschinentyp die Option Standard (n1-standard-2) aus. Da Sie beim Importieren des Modells GPU als Beschleunigertyp ausgewählt haben, werden der Beschleunigertyp und die Anzahl der Beschleuniger automatisch festgelegt, nachdem Sie den Maschinentyp ausgewählt haben.

Behalten Sie die verbleibenden Standardwerte bei und klicken Sie auf Bereitstellen.

Wenn das Modell am Endpunkt bereitgestellt wird, ändert sich der Status in

Active.Kopieren Sie die numerische Endpunkt-ID in der Spalte ID und den Wert in der Spalte Region. Sie benötigen sie später.

Dataset erstellen

Erstellen Sie ein BigQuery-Dataset zum Speichern Ihres ML-Modells.

Console

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Klicken Sie im Bereich Explorer auf den Namen Ihres Projekts.

Klicken Sie auf Aktionen ansehen > Dataset erstellen.

Führen Sie auf der Seite Dataset erstellen die folgenden Schritte aus:

Geben Sie unter Dataset-ID

bqml_tutorialein.Wählen Sie als Standorttyp die Option Mehrere Regionen und dann USA (mehrere Regionen in den USA) aus.

Übernehmen Sie die verbleibenden Standardeinstellungen unverändert und klicken Sie auf Dataset erstellen.

bq

Wenn Sie ein neues Dataset erstellen möchten, verwenden Sie den Befehl bq mk mit dem Flag --location. Eine vollständige Liste der möglichen Parameter finden Sie in der bq mk --dataset-Befehlsreferenz.

Erstellen Sie ein Dataset mit dem Namen

bqml_tutorial, wobei der Datenspeicherort aufUSund die Beschreibung aufBigQuery ML tutorial datasetfestgelegt ist:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Anstelle des Flags

--datasetverwendet der Befehl die verkürzte Form-d. Wenn Sie-dund--datasetauslassen, wird standardmäßig ein Dataset erstellt.Prüfen Sie, ob das Dataset erstellt wurde:

bq ls

API

Rufen Sie die Methode datasets.insert mit einer definierten Dataset-Ressource auf.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

BigQuery DataFrames

Bevor Sie dieses Beispiel ausprobieren, folgen Sie den Schritten zur Einrichtung von BigQuery DataFrames in der BigQuery-Kurzanleitung: BigQuery DataFrames verwenden. Weitere Informationen finden Sie in der Referenzdokumentation zu BigQuery DataFrames.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter ADC für eine lokale Entwicklungsumgebung einrichten.

BigQuery-Cloud-Ressourcenverbindung erstellen

Sie benötigen eine Cloud-Ressourcenverbindung, um eine Verbindung zu einem Vertex AI-Endpunkt herzustellen.

Console

Rufen Sie die Seite BigQuery auf.

Klicken Sie im linken Bereich auf Explorer:

Wenn Sie den linken Bereich nicht sehen, klicken Sie auf Linken Bereich maximieren, um ihn zu öffnen.

Klicken Sie im Bereich Explorer auf Daten hinzufügen.

Das Dialogfeld Daten hinzufügen wird geöffnet.

Wählen Sie im Bereich Filtern nach im Abschnitt Datenquellentyp die Option Datenbanken aus.

Alternativ können Sie im Feld Nach Datenquellen suchen

Vertex AIeingeben.Klicken Sie im Abschnitt Empfohlene Datenquellen auf Vertex AI.

Klicken Sie auf die Lösungsübersichtskarte Vertex AI-Modelle: BigQuery Federation.

Wählen Sie in der Liste Verbindungstyp die Option Vertex AI-Remote-Modelle, Remote-Funktionen und BigLake (Cloud Resource) aus.

Geben Sie im Feld Verbindungs-ID

bqml_tutorialein.Prüfen Sie, ob Mehrere Regionen – USA ausgewählt ist.

Klicken Sie auf Verbindung erstellen.

Klicken Sie unten im Fenster auf Zur Verbindung. Alternativ können Sie im Bereich Explorer auf Verbindungen und dann auf

us.bqml_tutorialklicken.Kopieren Sie im Bereich Verbindungsinformationen die Dienstkonto-ID. Sie benötigen diese ID, wenn Sie Berechtigungen für die Verbindung konfigurieren. Wenn Sie eine Verbindungsressource erstellen, erstellt BigQuery ein eindeutiges Systemdienstkonto und ordnet es der Verbindung zu.

bq

Verbindung herstellen:

bq mk --connection --location=US --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE bqml_tutorial

Ersetzen Sie

PROJECT_IDdurch IhreGoogle Cloud Projekt-ID. Der Parameter--project_idüberschreibt das Standardprojekt.Wenn Sie eine Verbindungsressource herstellen, erstellt BigQuery ein eindeutiges Systemdienstkonto und ordnet es der Verbindung zu.

Fehlerbehebung:Wird der folgende Verbindungsfehler angezeigt, aktualisieren Sie das Google Cloud SDK:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Rufen Sie die Dienstkonto-ID ab und kopieren Sie sie zur Verwendung in einem späteren Schritt:

bq show --connection PROJECT_ID.us.bqml_tutorial

Die Ausgabe sieht etwa so aus:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Verbindungszugriff einrichten

Weisen Sie dem Dienstkonto der Cloud-Ressourcenverbindung die Rolle „Vertex AI User“ zu. Sie müssen diese Rolle in demselben Projekt gewähren, in dem Sie den Endpunkt des Remote-Modells erstellt haben.

So weisen Sie die Rolle zu:

Zur Seite IAM & Verwaltung.

Klicken Sie auf Zugriff gewähren.

Geben Sie im Feld Neue Hauptkonten die Dienstkonto-ID der Cloud-Ressourcenverbindung ein, die Sie zuvor kopiert haben.

Wählen Sie im Feld Rolle auswählen die Option Vertex AI und dann Vertex AI-Nutzer aus.

Klicken Sie auf Speichern.

BigQuery ML-Remote-Modell erstellen

Sie erstellen ein BigQuery ML-Remote-Modell mit der Anweisung CREATE MODEL und der Klausel REMOTE WITH CONNECTION. Weitere Informationen zur CREATE MODEL-Anweisung finden Sie unter CREATE MODEL-Anweisung für Remote-Modelle über benutzerdefinierte Modelle.

Sie erstellen Ihr Modell am multiregionalen Standort US. In einem multiregionalen BigQuery-Dataset (US, EU) können Sie nur ein Remote-Modell erstellen, das eine Verbindung zu einem Endpunkt herstellt, der in einer Region innerhalb desselben multiregionalen Standorts (US, EU) bereitgestellt wird.

Wenn Sie das Remote-Modell erstellen, benötigen Sie die Endpunkt-ID, die beim Bereitstellen des Modells in Vertex AI generiert wurde. Außerdem müssen die Namen und Typen der Ein- und Ausgabefelder genau mit der Ein- und Ausgabe des Vertex AI-Modells übereinstimmen. In diesem Beispiel ist die Eingabe ein Text STRING und die Ausgabe ein ARRAY vom Typ FLOAT64.

Console

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Klicken Sie unter Neu erstellen auf SQL-Abfrage.

Geben Sie im Abfrageeditor diese

CREATE MODEL-Anweisung ein und klicken Sie dann auf Ausführen:CREATE OR REPLACE MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment` INPUT (text STRING) OUTPUT(scores ARRAY<FLOAT64>) REMOTE WITH CONNECTION `PROJECT_ID.us.bqml_tutorial` OPTIONS(ENDPOINT = 'https://us-central1-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/endpoints/ENDPOINT_ID')

Ersetzen Sie Folgendes:

- PROJECT_ID ist der Name Ihres Projekts.

- ENDPOINT_ID: die Endpunkt-ID, die Sie zuvor kopiert haben.

Wenn der Vorgang abgeschlossen ist, wird eine Meldung wie

Successfully created model named bert_sentimentangezeigt.Ihr neues Modell wird im Bereich Ressourcen angezeigt. Modelle sind am Modellsymbol

zu erkennen.

zu erkennen.Wenn Sie das neue Modell im Feld Ressourcen auswählen, werden Informationen zum Modell unter dem Abfrageeditor angezeigt.

bq

Erstellen Sie das Remote-Modell mit der folgenden

CREATE MODEL-Anweisung:bq query --use_legacy_sql=false \ "CREATE OR REPLACE MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment` INPUT (text STRING) OUTPUT(scores ARRAY<FLOAT64>) REMOTE WITH CONNECTION `PROJECT_ID.us.bqml_tutorial` OPTIONS(ENDPOINT = 'https://us-central1-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/endpoints/ENDPOINT_ID')"

Ersetzen Sie Folgendes:

- PROJECT_ID ist der Name Ihres Projekts.

- ENDPOINT_ID: die Endpunkt-ID, die Sie zuvor kopiert haben.

Nachdem Sie das Modell erstellt haben, prüfen Sie, ob es im Dataset angezeigt wird:

bq ls -m bqml_tutorial

Die Ausgabe sieht etwa so aus:

Id Model Type Labels Creation Time ---------------- ------------ -------- ----------------- bert_sentiment 28 Jan 17:39:43

Vorhersagen mit ML.PREDICT abrufen

Mit der Funktion ML.PREDICT können Sie Stimmungsanalysen aus dem Remote-Modell abrufen. Die Eingabe ist eine Textspalte (review) mit Rezensionen von Filmen aus der Tabelle bigquery-public-data.imdb.reviews.

In diesem Beispiel werden 10.000 Datensätze ausgewählt und für die Vorhersage gesendet. Das Remote-Modell verwendet für Anfragen standardmäßig eine Batchgröße von 128.

Console

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Klicken Sie im Bereich Neu erstellen auf SQL-Abfrage.

Geben Sie im Abfrageeditor diese Abfrage ein, in der die Funktion

ML.PREDICTverwendet wird, und klicken Sie dann auf Ausführen.SELECT * FROM ML.PREDICT ( MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment`, ( SELECT review as text FROM `bigquery-public-data.imdb.reviews` LIMIT 10000 ) )

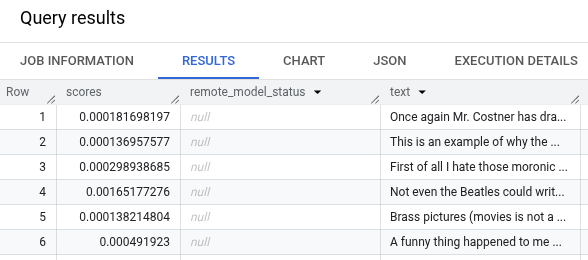

Die Abfrageergebnisse sollten in etwa so aussehen:

bq

Geben Sie den folgenden Befehl ein, um die Abfrage mit ML.PREDICT auszuführen.

bq query --use_legacy_sql=false \ 'SELECT * FROM ML.PREDICT ( MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment`, ( SELECT review as text FROM `bigquery-public-data.imdb.reviews` LIMIT 10000 ) )'