Höhere Netzwerkbandbreiten können die Leistung Ihrer GPU-Instanzen verbessern, um verteilte Arbeitslasten zu unterstützen, die in Compute Engine ausgeführt werden.

Für Instanzen mit angehängten GPUs in Compute Engine ist folgende maximale Netzwerkbandbreite verfügbar:

- Bei beschleunigungsoptimierten A4X-Instanzen können Sie je nach Maschinentyp eine maximale Netzwerkbandbreite von bis zu 2.000 Gbit/s erhalten.

- Für beschleunigungsoptimierte A4- und A3-Instanzen können Sie je nach Maschinentyp eine maximale Netzwerkbandbreite von bis zu 3.600 Gbit/s erhalten.

- Bei beschleunigungsoptimierten G4-Instanzen können Sie je nach Maschinentyp eine maximale Netzwerkbandbreite von bis zu 400 Gbit/s erhalten.

- Bei beschleunigungsoptimierten A2- und G2-Instanzen können Sie je nach Maschinentyp eine maximale Netzwerkbandbreite von bis zu 100 Gbit/s erhalten.

- Für N1-Instanzen für allgemeine Zwecke, an die P100- und P4-GPUs angeschlossen sind, steht eine maximale Netzwerkbandbreite von 32 Gbit/s zur Verfügung. Dies entspricht der maximalen Rate, die für N1-Instanzen verfügbar ist, denen keine GPUs zugeordnet sind. Weitere Informationen zu Netzwerkbandbreiten finden Sie unter maximale Rate ausgehender Daten.

- Bei N1-Instanzen für allgemeine Zwecke, an die T4- und V100-GPUs angeschlossen sind, können Sie basierend auf der Kombination aus GPU und Anzahl der vCPUs eine maximale Netzwerkbandbreite von bis zu 100 Gbit/s erhalten.

Netzwerkbandbreite und NIC-Anordnung prüfen

Im folgenden Abschnitt finden Sie Informationen zur Netzwerkanordnung und Bandbreitengeschwindigkeit für jeden GPU-Maschinentyp.

A4X-Maschinentypen

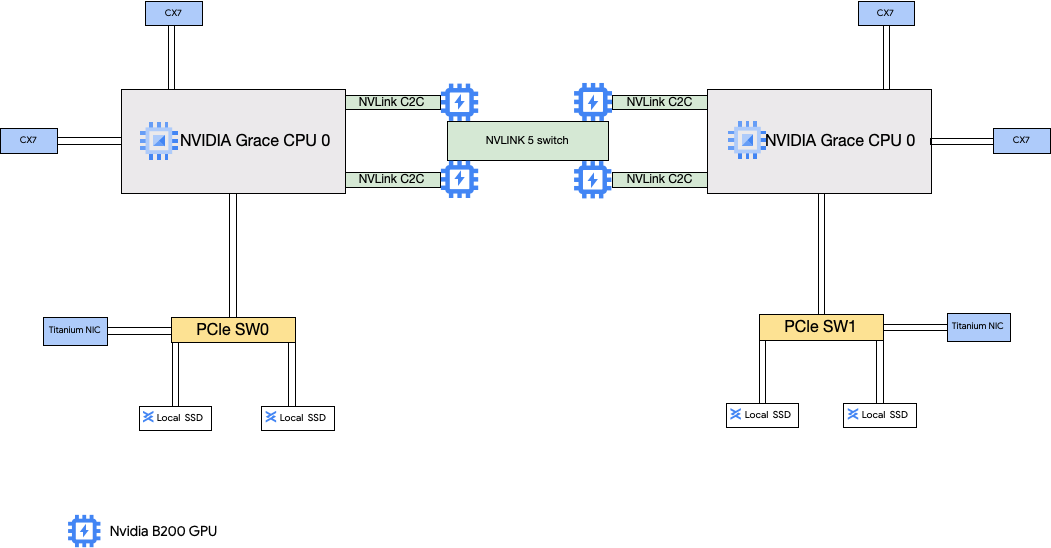

An die A4X-Maschinentypen sind NVIDIA GB200-Superchips angehängt. Diese Superchips haben NVIDIA B200-GPUs.

Dieser Maschinentyp hat vier NVIDIA ConnectX-7-Netzwerkkarten (NICs) und zwei Titanium-NICs. Die vier CX-7-NICs bieten eine Gesamtzahl von 1.600 Gbit/s an Netzwerkbandbreite. Diese CX-7-NICs sind ausschließlich für die GPU-zu-GPU-Kommunikation mit hoher Bandbreite vorgesehen und können nicht für andere Netzwerkanforderungen wie den öffentlichen Internetzugriff verwendet werden. Die beiden Titanium-NICs sind Smart-NICs, die zusätzliche 400 Gbit/s Netzwerkbandbreite für allgemeine Netzwerkanforderungen bieten. Zusammen bieten die Netzwerkkarten eine maximale Gesamtbandbreite von 2.000 Gbit/s für diese Maschinen.

A4X ist eine Exascale-Plattform, die auf der Rack-Scale-Architektur NVIDIA GB200 NVL72 basiert. Sie führt die NVIDIA Grace Hopper-Superchip-Architektur ein, die NVIDIA Hopper-GPUs und NVIDIA Grace-CPUs mit hoher Bandbreite über NVIDIA NVLink Chip-to-Chip (C2C) verbindet.

Die A4X-Netzwerkarchitektur verwendet ein schienenorientiertes Design. Das ist eine Topologie, bei der die entsprechende Netzwerkkarte einer Compute Engine-Instanz mit der Netzwerkkarte einer anderen verbunden ist. Die vier CX-7-NICs auf jeder Instanz sind physisch in einer 4-Way-Rail-Aligned-Netzwerktopologie isoliert, sodass A4X in Gruppen von 72 GPUs auf Tausende von GPUs in einem einzelnen nicht blockierenden Cluster skaliert werden kann. Dieser hardwareintegrierte Ansatz bietet eine vorhersehbare Leistung mit niedriger Latenz, die für große, verteilte Arbeitslasten unerlässlich ist.

Wenn Sie diese mehreren NICs verwenden möchten, müssen Sie drei VPC-Netzwerke (Virtual Private Cloud) erstellen:

- 2 VPC-Netzwerke: Jede gVNIC muss an ein anderes VPC-Netzwerk angehängt werden.

- 1 VPC-Netzwerk mit dem RDMA-Netzwerkprofil: Alle vier CX-7-NICs verwenden dasselbe VPC-Netzwerk.

Informationen zum Einrichten dieser Netzwerke finden Sie in der AI Hypercomputer-Dokumentation unter VPC-Netzwerke erstellen.

| Angehängte NVIDIA GB200 Grace Blackwell-Superchips | |||||||

|---|---|---|---|---|---|---|---|

| Maschinentyp | vCPU-Anzahl1 | Instanzarbeitsspeicher (GB) | Verbundene lokale SSD (GiB) | Anzahl der physischen Netzwerkkarten | Maximale Netzwerkbandbreite (Gbit/s)2 | GPU-Anzahl | GPU-Arbeitsspeicher3 (GB HBM3e) |

a4x-highgpu-4g |

140 | 884 | 12.000 | 6 | 2.000 | 4 | 720 |

1 Eine vCPU ist als einzelner Hardware-Hyper-Thread auf einer der verfügbaren CPU-Plattformen implementiert.

2 Die maximale Bandbreite für ausgehenden Traffic darf die angegebene Zahl nicht überschreiten. Die tatsächliche Bandbreite für ausgehenden Traffic hängt von der Ziel-IP-Adresse und anderen Faktoren ab.

Weitere Informationen zur Netzwerkbandbreite finden Sie unter Netzwerkbandbreite.

3 GPU-Arbeitsspeicher ist der Speicher auf einem GPU-Gerät, der zum temporären Speichern von Daten verwendet werden kann. Es ist vom Arbeitsspeicher der Instanz getrennt und wurde speziell für die höheren Bandbreitenanforderungen grafikintensiver Arbeitslasten entwickelt.

A4- und A3-Ultra-Maschinentypen

An die A4-Maschinentypen sind NVIDIA B200-GPUs angehängt und an die A3 Ultra-Maschinentypen NVIDIA H200-GPUs.

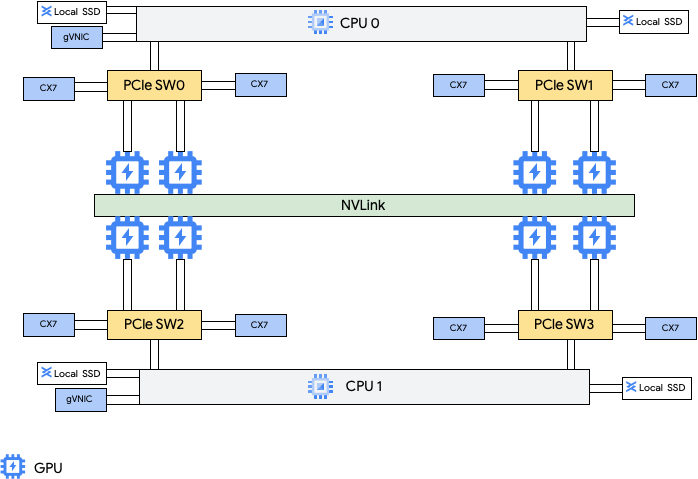

Diese Maschinentypen bieten acht NVIDIA ConnectX-7-Netzwerkkarten (CX-7) und zwei virtuelle Google-NICs (gVNIC). Die acht CX-7-NICs bieten eine Gesamtnetzwerkbandbreite von 3.200 Gbit/s. Diese NICs sind ausschließlich für die GPU-zu-GPU-Kommunikation mit hoher Bandbreite vorgesehen und können nicht für andere Netzwerkanforderungen wie den öffentlichen Internetzugriff verwendet werden. Wie im folgenden Diagramm dargestellt, ist jede CX-7-NIC auf eine GPU ausgerichtet, um den nicht einheitlichen Arbeitsspeicherzugriff (Non-Uniform Memory Access, NUMA) zu optimieren. Alle acht GPUs können über die All-to-All-NVLink-Brücke, die sie verbindet, schnell miteinander kommunizieren. Die beiden anderen gVNIC-Netzwerkkarten sind Smart-NICs, die zusätzliche 400 Gbit/s Netzwerkbandbreite für allgemeine Netzwerkanforderungen bieten. Zusammen bieten die Netzwerkkarten eine maximale Netzwerkbandbreite von 3.600 Gbit/s für diese Maschinen.

Wenn Sie diese mehreren NICs verwenden möchten, müssen Sie drei VPC-Netzwerke (Virtual Private Cloud) erstellen:

- 2 reguläre VPC-Netzwerke: Jede gVNIC muss an ein anderes VPC-Netzwerk angehängt werden.

- 1 RoCE-VPC-Netzwerk: Alle acht CX-7-NICs verwenden dasselbe RoCE-VPC-Netzwerk.

Informationen zum Einrichten dieser Netzwerke finden Sie in der AI Hypercomputer-Dokumentation unter VPC-Netzwerke erstellen.

A4-VMs

| Angehängte NVIDIA B200 Blackwell-GPUs | |||||||

|---|---|---|---|---|---|---|---|

| Maschinentyp | vCPU-Anzahl1 | Instanzarbeitsspeicher (GB) | Verbundene lokale SSD (GiB) | Anzahl der physischen Netzwerkkarten | Maximale Netzwerkbandbreite (Gbit/s)2 | GPU-Anzahl | GPU-Arbeitsspeicher3 (GB HBM3e) |

a4-highgpu-8g |

224 | 3.968 | 12.000 | 10 | 3.600 | 8 | 1.440 |

1 Eine vCPU ist als einzelner Hardware-Hyper-Thread auf einer der verfügbaren CPU-Plattformen implementiert.

2 Die maximale Bandbreite für ausgehenden Traffic darf die angegebene Zahl nicht überschreiten. Die tatsächliche Bandbreite für ausgehenden Traffic hängt von der Ziel-IP-Adresse und anderen Faktoren ab.

Weitere Informationen zur Netzwerkbandbreite finden Sie unter Netzwerkbandbreite.

3 GPU-Arbeitsspeicher ist der Speicher auf einem GPU-Gerät, der zum temporären Speichern von Daten verwendet werden kann. Es ist vom Arbeitsspeicher der Instanz getrennt und wurde speziell für die höheren Bandbreitenanforderungen grafikintensiver Arbeitslasten entwickelt.

A3-Ultra-VMs

| Angehängte NVIDIA H200-GPUs | |||||||

|---|---|---|---|---|---|---|---|

| Maschinentyp | vCPU-Anzahl1 | Instanzarbeitsspeicher (GB) | Verbundene lokale SSD (GiB) | Anzahl der physischen Netzwerkkarten | Maximale Netzwerkbandbreite (Gbit/s)2 | GPU-Anzahl | GPU-Arbeitsspeicher3 (GB HBM3e) |

a3-ultragpu-8g |

224 | 2.952 | 12.000 | 10 | 3.600 | 8 | 1128 |

1 Eine vCPU ist als einzelner Hardware-Hyper-Thread auf einer der verfügbaren CPU-Plattformen implementiert.

2 Die maximale Bandbreite für ausgehenden Traffic darf die angegebene Zahl nicht überschreiten. Die tatsächliche Bandbreite für ausgehenden Traffic hängt von der Ziel-IP-Adresse und anderen Faktoren ab.

Weitere Informationen zur Netzwerkbandbreite finden Sie unter Netzwerkbandbreite.

3 GPU-Arbeitsspeicher ist der Speicher auf einem GPU-Gerät, der zum temporären Speichern von Daten verwendet werden kann. Es ist vom Arbeitsspeicher der Instanz getrennt und wurde speziell für die höheren Bandbreitenanforderungen grafikintensiver Arbeitslasten entwickelt.

A3 Mega-, High- und Edge-Maschinentypen

An diese Maschinentypen sind H100-GPUs angehängt. Jeder dieser Maschinentypen hat eine feste GPU-Anzahl, eine Anzahl von vCPUs und eine vorgegebene Speichergröße.

- A3-VMs mit einer einzelnen NIC: Für A3-VMs mit 1 bis 4 angehängten GPUs ist nur eine einzelne physische Netzwerkschnittstellenkarte (NIC) verfügbar.

- A3-VMs mit mehreren NICs: Für A3-VMs mit 8 angehängten GPUs sind mehrere physische NICs verfügbar. Bei diesen A3-Maschinentypen sind die NICs auf einem Peripheral Component Interconnect Express-Bus (PCIe) so angeordnet:

- Für den Maschinentyp „A3 Mega“ ist eine NIC-Anordnung von 8+1 verfügbar. Bei dieser Anordnung teilen sich 8 NICs denselben PCIe-Bus und 1 NIC befindet sich auf einem separaten PCIe-Bus.

- Für den Maschinentyp „A3 High“ ist eine NIC-Anordnung von 4+1 verfügbar. Bei dieser Anordnung teilen sich 4 NICs denselben PCIe-Bus und eine NIC befindet sich auf einem separaten PCIe-Bus.

- Für den Maschinentyp „A3 Edge“ ist eine NIC-Anordnung von 4+1 verfügbar. Bei dieser Anordnung teilen sich 4 NICs denselben PCIe-Bus und eine NIC befindet sich auf einem separaten PCIe-Bus. Diese fünf NICs bieten eine Gesamtnetzwerkbandbreite von 400 Gbit/s für jede VM.

NICs, die denselben PCIe-Bus verwenden, haben eine uneinheitliche Ausrichtung des Arbeitsspeicherzugriffs (NUMA) von einer NIC pro zwei NVIDIA H100-GPUs. Diese NICs sind ideal für die dedizierte GPU-zu-GPU-Kommunikation mit hoher Bandbreite. Die physische NIC, die sich auf einem separaten PCIe-Bus befindet, ist ideal für andere Netzwerkanforderungen. Eine Anleitung zum Einrichten von Netzwerken für A3 High- und A3 Edge-VMs finden Sie unter MTU-Netzwerke im Jumbo Frame einrichten.

A3 Mega

| Angehängte NVIDIA H100-GPUs | |||||||

|---|---|---|---|---|---|---|---|

| Maschinentyp | vCPU-Anzahl1 | Instanzarbeitsspeicher (GB) | Verbundene lokale SSD (GiB) | Anzahl der physischen Netzwerkkarten | Maximale Netzwerkbandbreite (Gbit/s)2 | GPU-Anzahl | GPU-Arbeitsspeicher3 (GB HBM3) |

a3-megagpu-8g |

208 | 1.872 | 6.000 | 9 | 1.800 | 8 | 640 |

A3 High

| Angehängte NVIDIA H100-GPUs | |||||||

|---|---|---|---|---|---|---|---|

| Maschinentyp | vCPU-Anzahl1 | Instanzarbeitsspeicher (GB) | Verbundene lokale SSD (GiB) | Anzahl der physischen Netzwerkkarten | Maximale Netzwerkbandbreite (Gbit/s)2 | GPU-Anzahl | GPU-Arbeitsspeicher3 (GB HBM3) |

a3-highgpu-1g |

26 | 234 | 750 | 1 | 25 | 1 | 80 |

a3-highgpu-2g |

52 | 468 | 1.500 | 1 | 50 | 2 | 160 |

a3-highgpu-4g |

104 | 936 | 3.000 | 1 | 100 | 4 | 320 |

a3-highgpu-8g |

208 | 1.872 | 6.000 | 5 | 1.000 | 8 | 640 |

A3 Edge

| Angehängte NVIDIA H100-GPUs | |||||||

|---|---|---|---|---|---|---|---|

| Maschinentyp | vCPU-Anzahl1 | Instanzarbeitsspeicher (GB) | Verbundene lokale SSD (GiB) | Anzahl der physischen Netzwerkkarten | Maximale Netzwerkbandbreite (Gbit/s)2 | GPU-Anzahl | GPU-Arbeitsspeicher3 (GB HBM3) |

a3-edgegpu-8g |

208 | 1.872 | 6.000 | 5 |

|

8 | 640 |

1 Eine vCPU ist als einzelner Hardware-Hyper-Thread auf einer der verfügbaren CPU-Plattformen implementiert.

2 Die maximale Bandbreite für ausgehenden Traffic darf die angegebene Zahl nicht überschreiten. Die tatsächliche Bandbreite für ausgehenden Traffic hängt von der Ziel-IP-Adresse und anderen Faktoren ab.

Weitere Informationen zur Netzwerkbandbreite finden Sie unter Netzwerkbandbreite.

3 GPU-Arbeitsspeicher ist der Speicher auf einem GPU-Gerät, der zum temporären Speichern von Daten verwendet werden kann. Es ist vom Arbeitsspeicher der Instanz getrennt und wurde speziell für die höheren Bandbreitenanforderungen grafikintensiver Arbeitslasten entwickelt.

A2-Maschinentypen

Jeder A2-Maschinentyp hat eine feste Anzahl von angehängten NVIDIA A100-GPUs mit 40 GB oder NVIDIA A100-GPUs mit 80 GB. Jeder Maschinentyp hat außerdem eine feste Anzahl an vCPUs und eine feste Arbeitsspeichergröße.

A2-Maschinenserien sind in zwei Typen verfügbar:

- A2 Ultra: Bei diesen Maschinentypen sind A100-GPUs mit 80 GB und eine lokale SSD angehängt.

- A2 Standard: An diese Maschinentypen sind A100-GPUs mit 40 GB angehängt.

A2-Ultra

| Angehängte NVIDIA A100-GPUs mit 80 GB | ||||||

|---|---|---|---|---|---|---|

| Maschinentyp | vCPU-Anzahl1 | Instanzarbeitsspeicher (GB) | Verbundene lokale SSD (GiB) | Maximale Netzwerkbandbreite (Gbit/s)2 | GPU-Anzahl | GPU-Arbeitsspeicher3 (GB HBM2e) |

a2-ultragpu-1g |

12 | 170 | 375 | 24 | 1 | 80 |

a2-ultragpu-2g |

24 | 340 | 750 | 32 | 2 | 160 |

a2-ultragpu-4g |

48 | 680 | 1.500 | 50 | 4 | 320 |

a2-ultragpu-8g |

96 | 1.360 | 3.000 | 100 | 8 | 640 |

A2-Standard

| Angehängte NVIDIA A100-GPUs mit 40 GB | ||||||

|---|---|---|---|---|---|---|

| Maschinentyp | vCPU-Anzahl1 | Instanzarbeitsspeicher (GB) | Unterstützung lokaler SSDs | Maximale Netzwerkbandbreite (Gbit/s)2 | GPU-Anzahl | GPU-Arbeitsspeicher3 (GB HBM2) |

a2-highgpu-1g |

12 | 85 | Ja | 24 | 1 | 40 |

a2-highgpu-2g |

24 | 170 | Ja | 32 | 2 | 80 |

a2-highgpu-4g |

48 | 340 | Ja | 50 | 4 | 160 |

a2-highgpu-8g |

96 | 680 | Ja | 100 | 8 | 320 |

a2-megagpu-16g |

96 | 1.360 | Ja | 100 | 16 | 640 |

1 Eine vCPU ist als einzelner Hardware-Hyper-Thread auf einer der verfügbaren CPU-Plattformen implementiert.

2 Die maximale Bandbreite für ausgehenden Traffic darf die angegebene Zahl nicht überschreiten. Die tatsächliche Bandbreite für ausgehenden Traffic hängt von der Ziel-IP-Adresse und anderen Faktoren ab.

Weitere Informationen zur Netzwerkbandbreite finden Sie unter Netzwerkbandbreite.

3 GPU-Arbeitsspeicher ist der Speicher auf einem GPU-Gerät, der zum temporären Speichern von Daten verwendet werden kann. Es ist vom Arbeitsspeicher der Instanz getrennt und wurde speziell für die höheren Bandbreitenanforderungen grafikintensiver Arbeitslasten entwickelt.

G4-Maschinentypen

Beschleunigungsoptimierte G4-Maschinentypen

verwenden

NVIDIA RTX PRO 6000 Blackwell Server Edition-GPUs (nvidia-rtx-pro-6000)

und eignen sich für NVIDIA Omniverse-Simulationsarbeitslasten, grafikintensive Anwendungen, Videotranscodierung und virtuelle Desktops. G4-Maschinentypen bieten im Vergleich zu Maschinentypen der A-Serie auch eine kostengünstige Lösung für die Durchführung von Single-Host-Inferenz und Modelloptimierung.

| Angehängte NVIDIA RTX PRO 6000-GPUs | |||||||

|---|---|---|---|---|---|---|---|

| Maschinentyp | vCPU-Anzahl1 | Instanzarbeitsspeicher (GB) | Maximal unterstützte Titanium-SSD (GiB)2 | Anzahl der physischen Netzwerkkarten | Maximale Netzwerkbandbreite (Gbit/s)3 | GPU-Anzahl | GPU-Arbeitsspeicher4 (GB GDDR7) |

g4-standard-48 |

48 | 180 | 1.500 | 1 | 50 | 1 | 96 |

g4-standard-96 |

96 | 360 | 3.000 | 1 | 100 | 2 | 192 |

g4-standard-192 |

192 | 720 | 6.000 | 1 | 200 | 4 | 384 |

g4-standard-384 |

384 | 1.440 | 12.000 | 2 | 400 | 8 | 768 |

1 Eine vCPU ist als einzelner Hardware-Hyper-Thread auf einer der verfügbaren CPU-Plattformen implementiert.

2 Sie können Titanium-SSD-Laufwerke hinzufügen, wenn Sie eine G4-Instanz erstellen. Informationen zur Anzahl der Laufwerke, die Sie anhängen können, finden Sie unter Maschinentypen, bei denen Sie eine bestimmte Anzahl von lokalen SSD-Laufwerken auswählen müssen.

3 Die maximale Bandbreite für ausgehenden Traffic darf die angegebene Zahl nicht überschreiten. Die tatsächliche Bandbreite für ausgehenden Traffic hängt von der Ziel-IP-Adresse und anderen Faktoren ab.

Siehe Netzwerkbandbreite.

4 GPU-Arbeitsspeicher ist der Speicher auf einem GPU-Gerät, der zum temporären Speichern von Daten verwendet werden kann. Es ist vom Arbeitsspeicher der Instanz getrennt und wurde speziell für die höheren Bandbreitenanforderungen grafikintensiver Arbeitslasten entwickelt.

G2-Maschinentypen

An beschleunigungsoptimierte G2-Maschinentypen sind NVIDIA L4-GPUs angehängt. Sie sind ideal für kostenoptimierte Inferenz-, grafikintensive und Hochleistungs-Computing-Arbeitslasten.

Jeder G2-Maschinentyp hat auch einen Standardarbeitsspeicher und einen benutzerdefinierten Arbeitsspeicherbereich. Der benutzerdefinierte Arbeitsspeicherbereich definiert die Größe des Arbeitsspeichers, den Sie Ihrer Instanz für jeden Maschinentyp zuweisen können. Sie können auch beim Erstellen einer G2-Instanz lokale SSD-Laufwerke hinzufügen. Informationen zur Anzahl der Laufwerke, die Sie anhängen können, finden Sie unter Maschinentypen, bei denen Sie eine bestimmte Anzahl von lokalen SSD-Laufwerken auswählen müssen.

Um die höheren Netzwerkbandbreitenraten (50 Gbit/s oder höher) für die meisten GPU-Instanzen zu erhalten, wird die Verwendung von Google Virtual NIC (gVNIC) empfohlen. Weitere Informationen zum Erstellen von GPU-Instanzen, die gVNIC verwenden, finden Sie unter GPU-Instanzen mit höheren Bandbreiten erstellen.

| Angehängte NVIDIA L4-GPUs | |||||||

|---|---|---|---|---|---|---|---|

| Maschinentyp | vCPU-Anzahl1 | Standard-Instanzarbeitsspeicher (GB) | Benutzerdefinierter Instanzarbeitsspeicherbereich (GB) | Maximal unterstützte lokale SSD (GiB) | Maximale Netzwerkbandbreite (Gbit/s)2 | GPU-Anzahl | GPU-Arbeitsspeicher3 (GB GDDR6) |

g2-standard-4 |

4 | 16 | 16 bis 32 | 375 | 10 | 1 | 24 |

g2-standard-8 |

8 | 32 | 32 bis 54 | 375 | 16 | 1 | 24 |

g2-standard-12 |

12 | 48 | 48 bis 54 | 375 | 16 | 1 | 24 |

g2-standard-16 |

16 | 64 | 54 bis 64 | 375 | 32 | 1 | 24 |

g2-standard-24 |

24 | 96 | 96 bis 108 | 750 | 32 | 2 | 48 |

g2-standard-32 |

32 | 128 | 96 bis 128 | 375 | 32 | 1 | 24 |

g2-standard-48 |

48 | 192 | 192 bis 216 | 1.500 | 50 | 4 | 96 |

g2-standard-96 |

96 | 384 | 384 bis 432 | 3.000 | 100 | 8 | 192 |

1 Eine vCPU ist als einzelner Hardware-Hyper-Thread auf einer der verfügbaren CPU-Plattformen implementiert.

2 Die maximale Bandbreite für ausgehenden Traffic darf die angegebene Zahl nicht überschreiten. Die tatsächliche Bandbreite für ausgehenden Traffic hängt von der Ziel-IP-Adresse und anderen Faktoren ab.

Weitere Informationen zur Netzwerkbandbreite finden Sie unter Netzwerkbandbreite.

3 GPU-Arbeitsspeicher ist der Speicher auf einem GPU-Gerät, der zum temporären Speichern von Daten verwendet werden kann. Es ist vom Arbeitsspeicher der Instanz getrennt und wurde speziell für die höheren Bandbreitenanforderungen grafikintensiver Arbeitslasten entwickelt.

N1-Maschinentypen mit GPU

Bei N1-Instanzen für allgemeine Zwecke, an die T4- und V100-GPUs angeschlossen sind, können Sie basierend auf der Kombination aus GPU und Anzahl der vCPUs eine maximale Netzwerkbandbreite von bis zu 100 Gbit/s erhalten. Informationen zu allen anderen N1-GPU-Instanzen finden Sie unter Übersicht.

Lesen Sie den folgenden Abschnitt, um die maximale Netzwerkbandbreite zu berechnen, die für Ihre T4- und V100-Instanzen basierend auf dem GPU-Modell, der vCPU und der GPU-Anzahl verfügbar ist.

Weniger als 5 vCPUs

Für T4- und V100-Instanzen mit maximal 5 vCPUs steht eine maximale Netzwerkbandbreite von 10 Gbit/s zur Verfügung.

Mehr als 5 vCPUs

Bei T4- und V100-Instanzen mit mehr als 5 vCPUs wird die maximale Netzwerkbandbreite anhand der Anzahl der vCPUs und GPUs für diese VM berechnet.

Um die höheren Netzwerkbandbreitenraten (50 Gbit/s oder höher) für die meisten GPU-Instanzen zu erhalten, wird die Verwendung von Google Virtual NIC (gVNIC) empfohlen. Weitere Informationen zum Erstellen von GPU-Instanzen, die gVNIC verwenden, finden Sie unter GPU-Instanzen mit höheren Bandbreiten erstellen.

| GPU-Modell | Anzahl der GPUs | Berechnung der maximalen Netzwerkbandbreite |

|---|---|---|

| NVIDIA V100 | 1 | min(vcpu_count * 2, 32) |

| 2 | min(vcpu_count * 2, 32) |

|

| 4 | min(vcpu_count * 2, 50) |

|

| 8 | min(vcpu_count * 2, 100) |

|

| NVIDIA T4 | 1 | min(vcpu_count * 2, 32) |

| 2 | min(vcpu_count * 2, 50) |

|

| 4 | min(vcpu_count * 2, 100) |

MTU-Einstellungen und GPU-Maschinentypen

Um die Netzwerkbandbreite zu maximieren, legen Sie für Ihre VPC-Netzwerke einen höheren MTU-Wert (Maximum Transmission Unit) fest. Höhere MTU-Werte erhöhen die Paketgröße und reduzieren den Paketheader-Overhead, wodurch der Nutzlastdatendurchsatz erhöht wird.

Für GPU-Maschinentypen empfehlen wir die folgenden MTU-Einstellungen für Ihre VPC-Netzwerke.

| GPU-Maschinentyp | Empfohlene MTU (in Byte) | |

|---|---|---|

| VPC-Netzwerk | VPC-Netzwerk mit RDMA-Profilen | |

|

8896 | 8896 |

|

8244 | – |

|

8896 | – |

Beachten Sie beim Festlegen des MTU-Werts Folgendes:

- 8.192 Zeichen entsprechen zwei 4‑KB-Seiten.

- 8244 wird in A3 Mega-, A3 High- und A3 Edge-VMs für GPU-NICs empfohlen, für die die Header-Aufteilung aktiviert ist.

- Verwenden Sie den Wert 8896, sofern in der Tabelle nichts anderes angegeben ist.

GPU-Maschinen mit hoher Bandbreite erstellen

Wenn Sie GPU-Instanzen mit höherer Netzwerkbandbreite erstellen möchten, verwenden Sie je nach Maschinentyp eine der folgenden Methoden:

Informationen zum Erstellen von A2-, G2- und N1-Instanzen, die höhere Netzwerkbandbreiten verwenden, finden Sie unter Höhere Netzwerkbandbreite für A2-, G2- und N1-Instanzen verwenden. Zum Testen oder Prüfen der Bandbreitengeschwindigkeit für diese Maschinen können Sie den Benchmarking-Test verwenden. Weitere Informationen finden Sie unter Netzwerkbandbreite prüfen.

Informationen zum Erstellen von A3 Mega-Instanzen mit höherer Netzwerkbandbreite finden Sie unter A3 Mega-Slurm-Cluster für ML-Training bereitstellen. Zum Testen oder Prüfen der Bandbreitengeschwindigkeit für diese Maschinen können Sie einen Benchmarking-Test durchführen. Folgen Sie dazu der Anleitung unter Netzwerkbandbreite prüfen.

Informationen zu A3-High- und A3-Edge-Instanzen, die höhere Netzwerkbandbreiten verwenden, finden Sie unter A3-VM mit aktiviertem GPUDirect-TCPX erstellen. Zum Testen oder Prüfen der Bandbreitengeschwindigkeit für diese Maschinen können Sie den Benchmarking-Test verwenden. Weitere Informationen finden Sie unter Netzwerkbandbreite prüfen.

Für andere beschleunigungsoptimierte Maschinentypen ist keine Aktion erforderlich, um eine höhere Netzwerkbandbreite zu nutzen. Beim Erstellen einer Instanz wird bereits eine hohe Netzwerkbandbreite verwendet. Informationen zum Erstellen von Instanzen für andere beschleunigungsoptimierte Maschinentypen finden Sie unter VM mit angehängten GPUs erstellen.

Nächste Schritte

- Weitere Informationen zu GPU-Plattformen

- Instanzen mit angehängten GPUs erstellen

- Weitere Informationen

- GPU-Preisübersicht