Le unità SSD locali sono progettate per casi d'uso in cui è necessario spazio di archiviazione temporaneo, come le cache o uno spazio di elaborazione temporaneo. Le unità SSD locali si trovano sulla macchina fisica su cui è in esecuzione la VM, pertanto è possibile crearle solo in fase di creazione della VM. Non è possibile usare le unità SSD come dispositivi di avvio.

Nella serie di macchine di terza generazione, al momento della creazione di una VM viene aggiunta una quantità predefinita di dischi SSD locali. Il solo modo per aggiungere spazio di archiviazione SSD locale a queste VM è il seguente:

- Per le serie C3 e C3D, lo spazio di archiviazione SSD locale è disponibile solo su alcuni tipi di macchine, ad esempio

c3-standard-88-lssd. - Per le serie Z3, A3 e A2 Ultra, tutti i tipi di macchine sono dotate di spazio di archiviazione SSD locale.

Per la serie M3 e i tipi di macchine di prima e seconda generazione, è necessario specificare i dischi SSD locali in fase di creazione della VM.

Dopo aver creato un disco SSD locale, per poterlo utilizzare è necessario prima formattare e montare il dispositivo.

Per informazioni sulla quantità di spazio di archiviazione su SSD locale disponibile con i vari tipi di macchine e sul numero di dischi SSD locali collegabili a una VM, vedi Scegli un numero valido di dischi SSD locali.

Prima di iniziare

- Controlla quali sono le limitazioni degli SSD locali prima di utilizzarli.

- Esamina gli scenari di persistenza dei dati dei dischi SSD locali.

- Se aggiungi SSD locali a istanze di macchine virtuali (VM) con GPU collegate, consulta Disponibilità delle unità SSD locali per regioni e zone GPU.

-

Se non l'hai ancora fatto, configura l'autenticazione.

L'autenticazione è il processo mediante il quale la tua identità viene verificata per l'accesso a servizi e API di Google Cloud .

Per eseguire codice o esempi da un ambiente di sviluppo locale, puoi autenticarti su Compute Engine selezionando una delle seguenti opzioni:

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

gcloud

-

After installing the Google Cloud CLI, initialize it by running the following command:

gcloud initIf you're using an external identity provider (IdP), you must first sign in to the gcloud CLI with your federated identity.

- Set a default region and zone.

-

Install the Google Cloud CLI.

-

If you're using an external identity provider (IdP), you must first sign in to the gcloud CLI with your federated identity.

-

To initialize the gcloud CLI, run the following command:

gcloud init -

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

-

Install the Google Cloud CLI.

-

If you're using an external identity provider (IdP), you must first sign in to the gcloud CLI with your federated identity.

-

To initialize the gcloud CLI, run the following command:

gcloud init -

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

-

Install the Google Cloud CLI.

-

If you're using an external identity provider (IdP), you must first sign in to the gcloud CLI with your federated identity.

-

To initialize the gcloud CLI, run the following command:

gcloud init -

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

-

Install the Google Cloud CLI.

-

If you're using an external identity provider (IdP), you must first sign in to the gcloud CLI with your federated identity.

-

To initialize the gcloud CLI, run the following command:

gcloud init -

If you're using a local shell, then create local authentication credentials for your user account:

gcloud auth application-default login

You don't need to do this if you're using Cloud Shell.

If an authentication error is returned, and you are using an external identity provider (IdP), confirm that you have signed in to the gcloud CLI with your federated identity.

Vai alla pagina Crea un'istanza.

Specifica il nome, la regione e la zona della VM. Puoi anche aggiungere tag o etichette.

Nella sezione Configurazione macchina, scegli la famiglia di macchine che contiene il tipo di macchina di destinazione.

Seleziona una serie dall'elenco Serie, quindi scegli il tipo di macchina.

- Per le serie di macchine di terza generazione C3 e C3D, scegli un tipo di macchina il cui nome termina con

-lssd. - Per le serie Z3, A3 e A2 Ultra, ogni tipo di macchina include già spazio di archiviazione SSD locale.

- Per le serie di macchine M3 o di prima e seconda generazione, dopo aver selezionato il tipo di macchina, procedi nel seguente modo:

- Espandi la sezione Opzioni avanzate.

- Espandi Dischi, fai clic su Aggiungi SSD locale e segui questi passaggi:

- Nella pagina Configura SSD locale, scegli il tipo di interfaccia del disco.

- Seleziona il numero di dischi dall'elenco Capacità disco.

- Fai clic su Salva.

- Per le serie di macchine di terza generazione C3 e C3D, scegli un tipo di macchina il cui nome termina con

Continua con il processo di creazione della VM.

Dopo aver creato la VM con i dischi SSD locali, devi formattare e montare ogni dispositivo per poterli utilizzare.

Per le serie di macchine ultra Z3, A3 e A2, per creare una VM con dischi SSD locali collegati, crea una VM che utilizzi uno dei tipi di macchine disponibili per quella serie, seguendo le istruzioni per creare un'istanza.

Per la serie di macchine C3 o C3D, per creare una VM con dischi SSD locali collegati, segui le istruzioni per creare un'istanza, ma specifica un tipo di istanza che includa i dischi SSD locali (

-lssd).Ad esempio, puoi creare una VM C3 con due partizioni SSD locali che utilizzino l'interfaccia del disco NVMe come segue:

gcloud compute instances create example-c3-instance \ --zone ZONE \ --machine-type c3-standard-8-lssd \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

Per le serie di macchine M3 e di prima e seconda generazione, per creare una VM con dischi SSD locali collegati, segui le istruzioni per creare un'istanza, ma utilizza il flag

--local-ssdper creare e collegare un disco SSD locale. Per creare più dischi SSD locali, aggiungi altri flag--local-ssd. Facoltativamente, puoi anche impostare i valori dell'interfaccia e il nome del dispositivo per ogni flag--local-ssd.Ad esempio, puoi creare una VM M3 con quattro dischi SSD locali e specificare il tipo di interfaccia del disco come segue:

gcloud compute instances create VM_NAME \ --machine-type m3-ultramem-64 \ --zone ZONE \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE,device-name=DEVICE-NAME \ --local-ssd interface=INTERFACE_TYPE \ --image-project IMAGE_PROJECT \ --image-family IMAGE_FAMILY

- VM_NAME: il nome della nuova VM

- ZONE: la zona in cui creare la VM. Questo flag è facoltativo se hai configurato la proprietà

compute/zonedi gcloud CLI o la variabile di ambienteCLOUDSDK_COMPUTE_ZONE. - INTERFACE_TYPE: il tipo di interfaccia del disco che vuoi utilizzare per il dispositivo SSD locale. Specifica

nvmese crei una VM M3 o se l'immagine disco di avvio contiene driver NVMe ottimizzati. Specificascsiper le altre immagini. - (Facoltativo) DEVICE-NAME: un nome del disco da utilizzare nel link simbolico (symlink) del sistema operativo guest.

- IMAGE_FAMILY: una delle famiglie di immagini disponibili che vuoi installare sul disco di avvio.

- IMAGE_PROJECT: il progetto di immagini a cui appartiene la famiglia di immagini.

- Nella console Google Cloud , vai alla pagina Istanze VM.

- Fai clic su Crea istanza.

- Specifica i parametri che ti interessano.

- Nella parte superiore o inferiore della pagina, fai clic su Codice equivalente e quindi sulla scheda Terraform per visualizzare il codice Terraform.

- Nelle serie di macchine Ultra Z3, A3 e A2, per creare una VM con dischi SSD locali collegati, crea una VM che utilizzi uno dei tipi di macchine disponibili per quella serie.

Nelle serie di macchine C3 o C3D, per creare una VM con dischi SSD locali collegati, specifica un tipo di istanza che contenga dischi SSD locali (

-lssd).Di seguito è riportato un payload di richiesta di esempio, che crea una VM C3 con disco di avvio Ubuntu e due dischi SSD locali:

{ "machineType":"zones/us-central1-c/machineTypes/c3-standard-8-lssd", "name":"c3-with-local-ssd", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true } ], "networkInterfaces":[ { "network":"global/networks/default" } ] }Nelle serie di macchine M3 e di prima e seconda generazione, per creare una VM con dischi SSD locali collegati, puoi aggiungere i dispositivi SSD locali in fase di creazione della VM, utilizzando la proprietà

initializeParams. Devi specificare anche le seguenti proprietà:diskType: impostato su SSD localeautoDelete: impostato su truetype: impostato suSCRATCH

Non è possibile utilizzare le seguenti proprietà con i dispositivi SSD locali:

diskName- Proprietà

sourceImage diskSizeGb

Di seguito è riportato un payload di richiesta di esempio, che crea una VM M3 con disco di avvio Ubuntu e quattro dischi SSD locali:

{ "machineType":"zones/us-central1-f/machineTypes/m3-ultramem-64", "name":"local-ssd-instance", "disks":[ { "type":"PERSISTENT", "initializeParams":{ "sourceImage":"projects/ubuntu-os-cloud/global/images/family/ubuntu-2204-lts" }, "boot":true }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, { "type":"SCRATCH", "initializeParams":{ "diskType":"zones/us-central1-f/diskTypes/local-ssd" }, "autoDelete":true, "interface": "NVME" }, ], "networkInterfaces":[ { "network":"global/networks/default" } ] }Vai alla pagina Istanze VM.

Fai clic sul pulsante SSH accanto all'istanza a cui è collegata la nuova unità SSD locale. Il browser apre una connessione terminale all'istanza.

Nel terminale, utilizza il comando

findper identificare l'unità SSD locale che vuoi montare.$ find /dev/ | grep google-local-nvme-ssdLe unità SSD locali in modalità SCSI hanno nomi standard come

google-local-ssd-0. Le unità SSD locali in modalità NVMe hanno nomi comegoogle-local-nvme-ssd-0, come si vede nel seguente output:$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-0

Formatta l'unità SSD locale con un file system ext4. Questo comando elimina tutti i dati esistenti sull'unità SSD locale.

$ sudo mkfs.ext4 -F /dev/disk/by-id/[SSD_NAME]Sostituisci

[SSD_NAME]con l'ID dell'unità SSD locale che vuoi formattare. Ad esempio, specificagoogle-local-nvme-ssd-0per formattare la prima SSD locale NVMe nell'istanza.Utilizza il comando

mkdirper creare una directory in cui montare il dispositivo.$ sudo mkdir -p /mnt/disks/[MNT_DIR]Sostituisci

[MNT_DIR]con il percorso della directory in cui vuoi montare il disco SSD locale.Monta l'unità SSD locale nella VM.

$ sudo mount /dev/disk/by-id/[SSD_NAME] /mnt/disks/[MNT_DIR]Sostituisci i seguenti valori:

[SSD_NAME]: l'ID dell'unità SSD locale che vuoi montare.[MNT_DIR]: la directory in cui vuoi montare l'unità SSD locale.

Configura l'accesso in lettura e scrittura al dispositivo. Per questo esempio, concedi l'accesso in scrittura al dispositivo per tutti gli utenti.

$ sudo chmod a+w /mnt/disks/[MNT_DIR]Sostituisci

[MNT_DIR]con la directory in cui hai montato l'unità SSD locale.Crea la voce

/etc/fstab. Utilizza il comandoblkidper trovare l'UUID del file system sul dispositivo e modifica il file/etc/fstabin modo che includa l'UUID con le opzioni di montaggio. Puoi completare questo passaggio con un solo comando.Ad esempio, per un'unità SSD locale in modalità NVMe, usa il seguente comando:

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-nvme-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabPer un'unità SSD locale in una modalità non NVMe, come SCSI, usa il seguente comando:

$ echo UUID=`sudo blkid -s UUID -o value /dev/disk/by-id/google-local-ssd-0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabSostituisci

[MNT_DIR]con la directory in cui hai montato l'unità SSD locale.Usa il comando

catper verificare che le voci/etc/fstabsiano corrette:$ cat /etc/fstabEffettua la connessione all'istanza tramite RDP. Per questo esempio, vai alla pagina Istanze VM e fai clic sul pulsante RDP accanto all'istanza con le unità SSD locali collegate. Dopo che hai inserito il nome utente e la password, si apre una finestra con l'interfaccia desktop del server.

Fai clic con il tasto destro del mouse sul pulsante di avvio di Windows e seleziona Gestione disco.

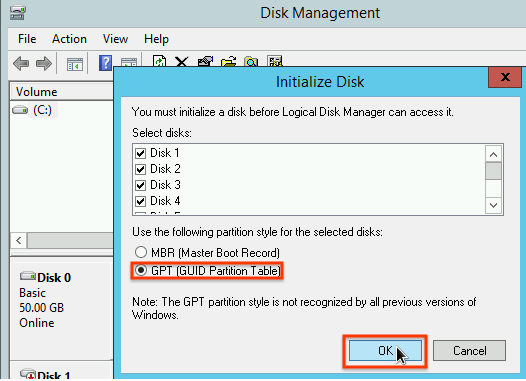

Se non hai mai inizializzato l'unità SSD locale, lo strumento chiederà di selezionare uno schema di partizione per le nuove partizioni. Seleziona GPT e fai clic su Ok.

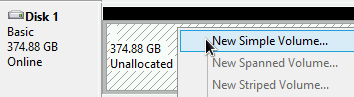

Dopo l'inizializzazione dell'unità SSD locale, fai clic con il tasto destro del mouse sullo spazio su disco non allocato e seleziona Nuovo volume semplice.

Segui le istruzioni nella procedura guidata Nuovo volume semplice per configurare il nuovo volume. Puoi utilizzare qualsiasi formato di partizione; tuttavia, ai fini di questo esempio, seleziona

NTFS. Seleziona anche Esegui una formattazione rapida per velocizzare la procedura di formattazione.

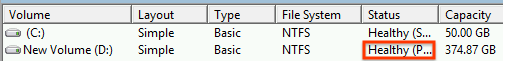

Al termine della procedura guidata e della formattazione del volume, verifica che la nuova unità SSD locale abbia lo stato

Healthy.

Vai alla pagina Istanze VM.

Fai clic sul pulsante SSH accanto all'istanza a cui è collegata la nuova unità SSD locale. Il browser apre una connessione terminale all'istanza.

Nel terminale, installa lo strumento

mdadm. Il processo di installazione dimdadminclude un prompt all'utente che interrompe gli script, pertanto esegui manualmente il processo.Debian e Ubuntu:

$ sudo apt update && sudo apt install mdadm --no-install-recommendsCentOS e RHEL:

$ sudo yum install mdadm -ySLES e openSUSE:

$ sudo zypper install -y mdadmUtilizza il comando

findper identificare tutte le unità SSD locali che vuoi montare insieme.In questo esempio, l'istanza comprende otto partizioni SSD locali in modalità NVMe:

$ find /dev/ | grep google-local-nvme-ssd /dev/disk/by-id/google-local-nvme-ssd-7 /dev/disk/by-id/google-local-nvme-ssd-6 /dev/disk/by-id/google-local-nvme-ssd-5 /dev/disk/by-id/google-local-nvme-ssd-4 /dev/disk/by-id/google-local-nvme-ssd-3 /dev/disk/by-id/google-local-nvme-ssd-2 /dev/disk/by-id/google-local-nvme-ssd-1 /dev/disk/by-id/google-local-nvme-ssd-0

findnon garantisce un ordinamento preciso. I dispositivi possono essere elencati in un altro ordine, ma il numero di righe di output deve corrispondere al numero previsto di partizioni dell'unità SSD. Le unità SSD locali in modalità SCSI hanno nomi standard comegoogle-local-ssd. Le unità SSD locali in modalità NVMe hanno nomi comegoogle-local-nvme-ssd.Utilizza

mdadmper combinare più dispositivi SSD locali in un unico array denominato/dev/md0. In questo esempio sono stati combinati otto dispositivi SSD locali in modalità NVMe. Per i dispositivi SSD locali in modalità SCSI, specifica i nomi ricevuti con il comandofind:$ sudo mdadm --create /dev/md0 --level=0 --raid-devices=8 \ /dev/disk/by-id/google-local-nvme-ssd-0 \ /dev/disk/by-id/google-local-nvme-ssd-1 \ /dev/disk/by-id/google-local-nvme-ssd-2 \ /dev/disk/by-id/google-local-nvme-ssd-3 \ /dev/disk/by-id/google-local-nvme-ssd-4 \ /dev/disk/by-id/google-local-nvme-ssd-5 \ /dev/disk/by-id/google-local-nvme-ssd-6 \ /dev/disk/by-id/google-local-nvme-ssd-7 mdadm: Defaulting to version 1.2 metadata mdadm: array /dev/md0 started.

Puoi verificare i dettagli dell'array con

mdadm --detail. L'aggiunta del flag--prefer=by-idelenca i dispositivi che utilizzano i percorsi/dev/disk/by-id.sudo mdadm --detail --prefer=by-id /dev/md0

L'output dovrebbe essere simile a questo per ogni dispositivo dell'array.

... Number Major Minor RaidDevice State 0 259 0 0 active sync /dev/disk/by-id/google-local-nvme-ssd-0 ...Formatta l'array

/dev/md0completo con un file system ext4.$ sudo mkfs.ext4 -F /dev/md0Crea una directory in cui montare

/dev/md0. Per questo esempio crea la directory/mnt/disks/ssd-array:$ sudo mkdir -p /mnt/disks/[MNT_DIR]Sostituisci

[MNT_DIR]con la directory in cui hai montato l'array SSD locale.Monta l'array

/dev/md0nella directory/mnt/disks/ssd-array:$ sudo mount /dev/md0 /mnt/disks/[MNT_DIR]Sostituisci

[MNT_DIR]con la directory in cui hai montato l'array SSD locale.Configura l'accesso in lettura e scrittura al dispositivo. Per questo esempio, concedi l'accesso in scrittura al dispositivo per tutti gli utenti.

$ sudo chmod a+w /mnt/disks/[MNT_DIR]Sostituisci

[MNT_DIR]con la directory in cui hai montato l'array SSD locale.Crea la voce

/etc/fstab. Utilizza il comandoblkidper trovare l'UUID del file system sul dispositivo e modifica il file/etc/fstabin modo che includa l'UUID con le opzioni di montaggio. Specifica l'opzionenofailper consentire l'avvio del sistema anche se l'unità SSD locale non è disponibile. Puoi completare questo passaggio con un unico comando. Ad esempio:$ echo UUID=`sudo blkid -s UUID -o value /dev/md0` /mnt/disks/[MNT_DIR] ext4 discard,defaults,nofail 0 2 | sudo tee -a /etc/fstabSostituisci

[MNT_DIR]con la directory in cui hai montato l'array SSD locale.Se nel file

/etc/fstabutilizzi un nome dispositivo come/dev/md0anziché l'UUID, devi modificare il file/etc/mdadm/mdadm.confper assicurarti che l'array venga riassemblato automaticamente all'avvio. A questo scopo, segui questi due passaggi:- Assicurati che l'array di dischi venga scansionato e ricomposto automaticamente all'avvio.

$ sudo mdadm --detail --scan | sudo tee -a /etc/mdadm/mdadm.conf - Aggiorna

initramfsin modo che l'array sia disponibile durante il processo di fase iniziale di avvio.$ sudo update-initramfs -u

- Assicurati che l'array di dischi venga scansionato e ricomposto automaticamente all'avvio.

Usa il comando

catper verificare che le voci/etc/fstabsiano corrette:$ cat /etc/fstabEffettua la connessione all'istanza tramite RDP. Per questo esempio, vai alla pagina Istanze VM e fai clic sul pulsante RDP accanto all'istanza con le unità SSD locali collegate. Dopo che hai inserito il nome utente e la password, si apre una finestra con l'interfaccia desktop del server.

Fai clic con il tasto destro del mouse sul pulsante di avvio di Windows e seleziona Gestione disco.

Se non hai mai inizializzato le unità SSD locali, lo strumento chiederà di selezionare uno schema di partizione per le nuove partizioni. Seleziona GPT e fai clic su Ok.

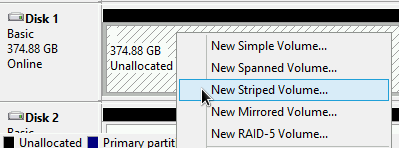

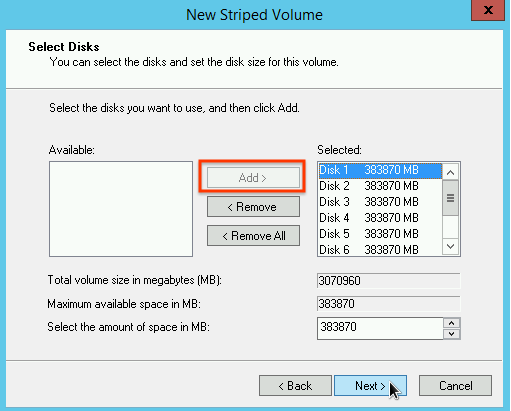

Dopo l'inizializzazione dell'unità SSD locale, fai clic con il tasto destro del mouse sullo spazio su disco non allocato e seleziona Nuovo volume con striping.

Seleziona le partizioni dell'unità SSD locale che vuoi includere nell'array con striping. Per questo esempio, seleziona tutte le partizioni per combinarle in un unico dispositivo SSD locale.

Segui le istruzioni nella procedura guidata Nuovo volume con striping per configurare il nuovo volume. Puoi utilizzare qualsiasi formato di partizione; tuttavia, ai fini di questo esempio, seleziona

NTFS. Seleziona anche Esegui una formattazione rapida per velocizzare la procedura di formattazione.

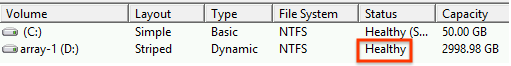

Al termine della procedura guidata e della formattazione del volume, verifica che la nuova unità SSD locale abbia lo stato

Healthy.

- Scopri di più sui nomi dei dispositivi per la tua VM.

- Scopri come eseguire il benchmarking delle prestazioni per i dischi SSD locali

Terraform

Per utilizzare gli esempi di Terraform in questa pagina in un ambiente di sviluppo locale, installa e inizializza gcloud CLI, quindi configura le Credenziali predefinite dell'applicazione con le tue credenziali utente.

Per ulteriori informazioni, vedi Set up authentication for a local development environment.

Vai

Per utilizzare gli esempi di Go questa pagina in un ambiente di sviluppo locale, installa e inizializza gcloud CLI, quindi configura le Credenziali predefinite dell'applicazione con le tue credenziali utente.

Per ulteriori informazioni, vedi Set up authentication for a local development environment.

Java

Per utilizzare gli esempi di Java questa pagina in un ambiente di sviluppo locale, installa e inizializza gcloud CLI, quindi configura le Credenziali predefinite dell'applicazione con le tue credenziali utente.

Per ulteriori informazioni, vedi Set up authentication for a local development environment.

Python

Per utilizzare gli esempi di Python questa pagina in un ambiente di sviluppo locale, installa e inizializza gcloud CLI, quindi configura le Credenziali predefinite dell'applicazione con le tue credenziali utente.

Per ulteriori informazioni, vedi Set up authentication for a local development environment.

REST

Per utilizzare gli esempi di API REST in questa pagina in un ambiente di sviluppo locale, utilizzi le credenziali che fornisci a gcloud CLI.

After installing the Google Cloud CLI, initialize it by running the following command:

gcloud initIf you're using an external identity provider (IdP), you must first sign in to the gcloud CLI with your federated identity.

Per saperne di più, consulta la sezione Autenticarsi per l'utilizzo di REST nella documentazione sull'autenticazione di Google Cloud .

Crea una VM con un'unità SSD locale

Puoi creare una VM con spazio di archiviazione su disco SSD locale utilizzando Google Cloud console, gcloud CLI o l'API Compute Engine.

Console

gcloud

Sostituisci i seguenti valori:

Se necessario, puoi collegare le unità SSD locali a una VM di prima o seconda generazione utilizzando una combinazione di

nvmeescsiper partizioni diverse. Le prestazioni del dispositivonvmedipendono dall'immagine del disco di avvio dell'istanza. Le VM di terza generazione supportano solo l'interfaccia del disco NVMe.Dopo aver creato una VM con disco SSD locale, per poterla utilizzare devi prima formattare e montare ogni dispositivo.

Terraform

Per creare una VM con dischi SSD locali collegati, puoi utilizzare la risorsa

google_compute_instance.Per scoprire come applicare o rimuovere una configurazione Terraform, consulta Comandi Terraform di base.

Per generare il codice Terraform, puoi utilizzare il componente Codice equivalente nella console Google Cloud .Go

Go

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella sezione Utilizzo delle librerie client della Guida rapida di Compute Engine. Per ulteriori informazioni, consulta la documentazione di riferimento dell'API Go di Compute Engine.

Per effettuare l'autenticazione in Compute Engine, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Java

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella sezione Utilizzo delle librerie client della Guida rapida di Compute Engine. Per ulteriori informazioni, consulta la documentazione di riferimento dell'API Java di Compute Engine.

Per effettuare l'autenticazione in Compute Engine, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

Python

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella sezione Utilizzo delle librerie client della Guida rapida di Compute Engine. Per ulteriori informazioni, consulta la documentazione di riferimento dell'API Python di Compute Engine.

Per effettuare l'autenticazione in Compute Engine, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, vedi Configura l'autenticazione per un ambiente di sviluppo locale.

REST

Utilizza

instances.insert methodper creare una VM da una famiglia di immagini o da una versione specifica di un'immagine sistema operativo.Dopo aver creato un disco SSD locale, devi formattare e montare ogni dispositivo per poterlo utilizzare.

Per ulteriori informazioni sulla creazione di un'istanza con REST, vedi l'API Compute Engine.

Formatta e monta un dispositivo SSD locale

Puoi formattare e montare i dischi SSD locali singolarmente oppure combinare più dischi SSD locali in un unico volume logico.

Formatta e monta singole partizioni SSD locali

Il modo più semplice per collegare le unità SSD locali all'istanza è formattare e montare ogni dispositivo con una singola partizione. In alternativa, puoi combinare più partizioni in un unico volume logico.

Istanze Linux

Formatta e monta la nuova unità SSD locale sull'istanza Linux. Puoi utilizzare il formato e la configurazione della partizione che preferisci. Per questo esempio, crea una singola partizione

ext4.Facoltativamente, puoi aggiungere l'unità SSD locale al file

/etc/fstab, in modo che il dispositivo sia montato di nuovo automaticamente al riavvio dell'istanza. Con questa impostazione, in caso di arresto dell'istanza, i dati sull'unità SSD locale non vengono conservati. Per informazioni dettagliate, vedi Persistenza dei dati nell'unità SSD locale.Quando specifichi la voce di file

/etc/fstab, assicurati di includere l'opzionenofail, in modo che l'istanza possa continuare ad avviarsi anche se l'unità SSD locale non è presente. Ad esempio, se acquisisci uno snapshot del disco di avvio e crei una nuova istanza senza collegare alcun disco SSD locale, l'istanza può continuare il processo di avvio, invece di essere messa in pausa indefinitamente.Se crei uno snapshot dal disco di avvio di questa istanza e lo usi per creare un'istanza separata senza SSD locali, modifica il file

/etc/fstabe rimuovi la voce relativa a questa unità SSD locale. Anche se è attiva l'opzionenofail, mantieni il file/etc/fstabsincronizzato con le partizioni collegate all'istanza e rimuovi le voci prima di creare lo snapshot del disco di avvio.Istanze Windows

Usa lo strumento di gestione del disco di Windows per formattare e montare un'unità SSD locale su un'istanza Windows.

Ecco fatto. Ora puoi scrivere file sull'unità SSD locale.

Formatta e monta più partizioni SSD locali in un unico volume logico

A differenza delle unità SSD permanenti, le SSD locali hanno una capacità fissa di 375 GB per ogni dispositivo collegato all'istanza. Se vuoi combinare più partizioni SSD locali in un unico volume logico, devi definire autonomamente la gestione del volume nelle partizioni.

Istanze Linux

Usa

mdadmper creare un array RAID 0. In questo esempio, l'array è formattato con un unico file systemext4, ma puoi applicare qualsiasi file system preferisci.Facoltativamente, puoi aggiungere l'unità SSD locale al file

/etc/fstab, in modo che il dispositivo sia montato di nuovo automaticamente al riavvio dell'istanza. Con questa impostazione, in caso di arresto dell'istanza, i dati sull'unità SSD locale non vengono conservati. Per informazioni dettagliate, consulta la sezione Persistenza dei dati nell'unità SSD locale.Quando specifichi la voce di file

/etc/fstab, assicurati di includere l'opzionenofail, in modo che l'istanza possa continuare ad avviarsi anche se l'unità SSD locale non è presente. Ad esempio, se acquisisci uno snapshot del disco di avvio e crei una nuova istanza senza alcuna unità SSD locale collegata, l'istanza può continuare il processo di avvio, invece di essere messa in pausa indefinitamente.Se crei uno snapshot dal disco di avvio di questa istanza e lo usi per creare un'istanza separata senza SSD locali, modifica il file

/etc/fstabe rimuovi la voce relativa a questo array SSD locale. Anche se è attiva l'opzionenofail, mantieni il file/etc/fstabsincronizzato con le partizioni collegate all'istanza e rimuovi le voci prima di creare lo snapshot del disco di avvio.Istanze Windows

Usa lo strumento di gestione del disco di Windows per formattare e montare un array SSD locale su un'istanza Windows.

Ora puoi scrivere file sull'unità SSD locale.

Passaggi successivi

Salvo quando diversamente specificato, i contenuti di questa pagina sono concessi in base alla licenza Creative Commons Attribution 4.0, mentre gli esempi di codice sono concessi in base alla licenza Apache 2.0. Per ulteriori dettagli, consulta le norme del sito di Google Developers. Java è un marchio registrato di Oracle e/o delle sue consociate.

Ultimo aggiornamento 2025-07-15 UTC.

-