En este instructivo, aprenderás a usar un modelo de serie temporal univariable ARIMA_PLUS para predecir el valor futuro de una columna determinada en función de los valores históricos de esa columna.

En este instructivo, se prevé una sola serie temporal. Los valores previstos se calculan una vez para cada punto temporal en los datos de entrada.

En este instructivo, se usan datos de la tabla de muestra bigquery-public-data.google_analytics_sample.ga_sessions pública. Esta tabla contiene datos ofuscados de comercio electrónico de Google Merchandise Store.

Objetivos

En este instructivo, se te guiará para que completes las siguientes tareas:

- Crear un modelo de series temporales para prever el tráfico del sitio con la declaración

CREATE MODEL - Evalúa la información del modelo de promedio móvil integrado autorregresivo (ARIMA) con la función

ML.ARIMA_EVALUATE. - Inspecciona los coeficientes del modelo con la función

ML.ARIMA_COEFFICIENTS. - Recuperar la información del tráfico previsto del sitio del modelo con la función

ML.FORECAST - Recuperar componentes de las series temporales, como la estacionalidad y la tendencia, con la función

ML.EXPLAIN_FORECASTPuedes inspeccionar estos componentes de series temporales para explicar los valores previstos.

Costos

En este instructivo, se usan los siguientes componentes facturables de Google Cloud:

- BigQuery

- BigQuery ML

Para obtener más información sobre los costos de BigQuery, consulta la página de precios de BigQuery.

Para obtener más información sobre los costos de BigQuery ML, consulta los precios de BigQuery ML.

Antes de comenzar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

- BigQuery se habilita automáticamente en proyectos nuevos.

Para activar BigQuery en un proyecto existente, ve a

Enable the BigQuery API.

Para crear el conjunto de datos, necesitas el permiso

bigquery.datasets.createde IAM.Para crear el modelo, necesitas los siguientes permisos:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateData

Para ejecutar inferencias, necesitas los siguientes permisos:

bigquery.models.getDatabigquery.jobs.create

Permisos necesarios

Para obtener más información sobre los roles y permisos de IAM en BigQuery, consulta Introducción a IAM.

Crea un conjunto de datos

Crea un conjunto de datos de BigQuery para almacenar tu modelo de AA.

Console

En la consola de Google Cloud , ve a la página BigQuery.

En el panel Explorador, haz clic en el nombre de tu proyecto.

Haz clic en Ver acciones > Crear conjunto de datos.

En la página Crear conjunto de datos, haz lo siguiente:

En ID del conjunto de datos, ingresa

bqml_tutorial.En Tipo de ubicación, selecciona Multirregión y, luego, EE.UU. (varias regiones en Estados Unidos).

Deja la configuración predeterminada restante como está y haz clic en Crear conjunto de datos.

bq

Para crear un conjunto de datos nuevo, usa el comando bq mk con la marca --location. Para obtener una lista completa de los parámetros posibles, consulta la

referencia del

comando bq mk --dataset.

Crea un conjunto de datos llamado

bqml_tutorialcon la ubicación de los datos establecida enUSy una descripción deBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

En lugar de usar la marca

--dataset, el comando usa el acceso directo-d. Si omites-dy--dataset, el comando crea un conjunto de datos de manera predeterminada.Confirma que se haya creado el conjunto de datos:

bq ls

API

Llama al método datasets.insert con un recurso de conjunto de datos definido.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

Permite trabajar con BigQuery DataFrames.

Antes de probar este ejemplo, sigue las instrucciones de configuración de BigQuery DataFrames en la guía de inicio rápido de BigQuery con BigQuery DataFrames. Para obtener más información, consulta la documentación de referencia de BigQuery DataFrames.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura ADC para un entorno de desarrollo local.

Visualiza los datos de entrada

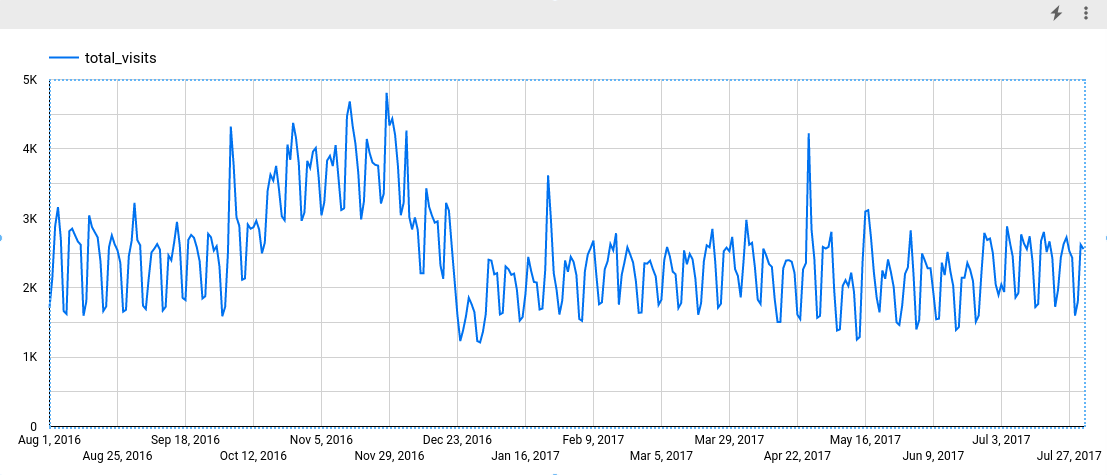

Antes de crear el modelo, puedes visualizar de forma opcional tus datos de series temporales de entrada para tener una idea de la distribución. Puedes hacerlo mediante Looker Studio.

Sigue estos pasos para visualizar los datos de series temporales:

SQL

En la siguiente consulta de GoogleSQL, la instrucción SELECT analiza la columna date de la tabla de entrada al tipo TIMESTAMP y le cambia el nombre a parsed_date, y usa la cláusula SUM(...) y la cláusula GROUP BY date para crear un valor de totals.visits diario.

En la consola de Google Cloud , ve a la página BigQuery.

En el editor de consultas, pega la siguiente consulta y haz clic en Ejecutar:

SELECT PARSE_TIMESTAMP("%Y%m%d", date) AS parsed_date, SUM(totals.visits) AS total_visits FROM `bigquery-public-data.google_analytics_sample.ga_sessions_*` GROUP BY date;

Cuando se complete la consulta, haz clic en Explorar datos > Explorar con Looker Studio. Looker Studio se abre en una pestaña nueva. Completa los siguientes pasos en la pestaña nueva.

En Looker Studio, haz clic en Insertar > Gráfico de serie temporal.

En el panel Gráfico, elige la pestaña Configuración.

En la sección Métrica, agrega el campo total_visits y quita la métrica predeterminada Conteo de registros. El gráfico resultante es similar al siguiente:

Si observas el gráfico, puedes ver que la serie temporal de entrada tiene un patrón estacional semanal.

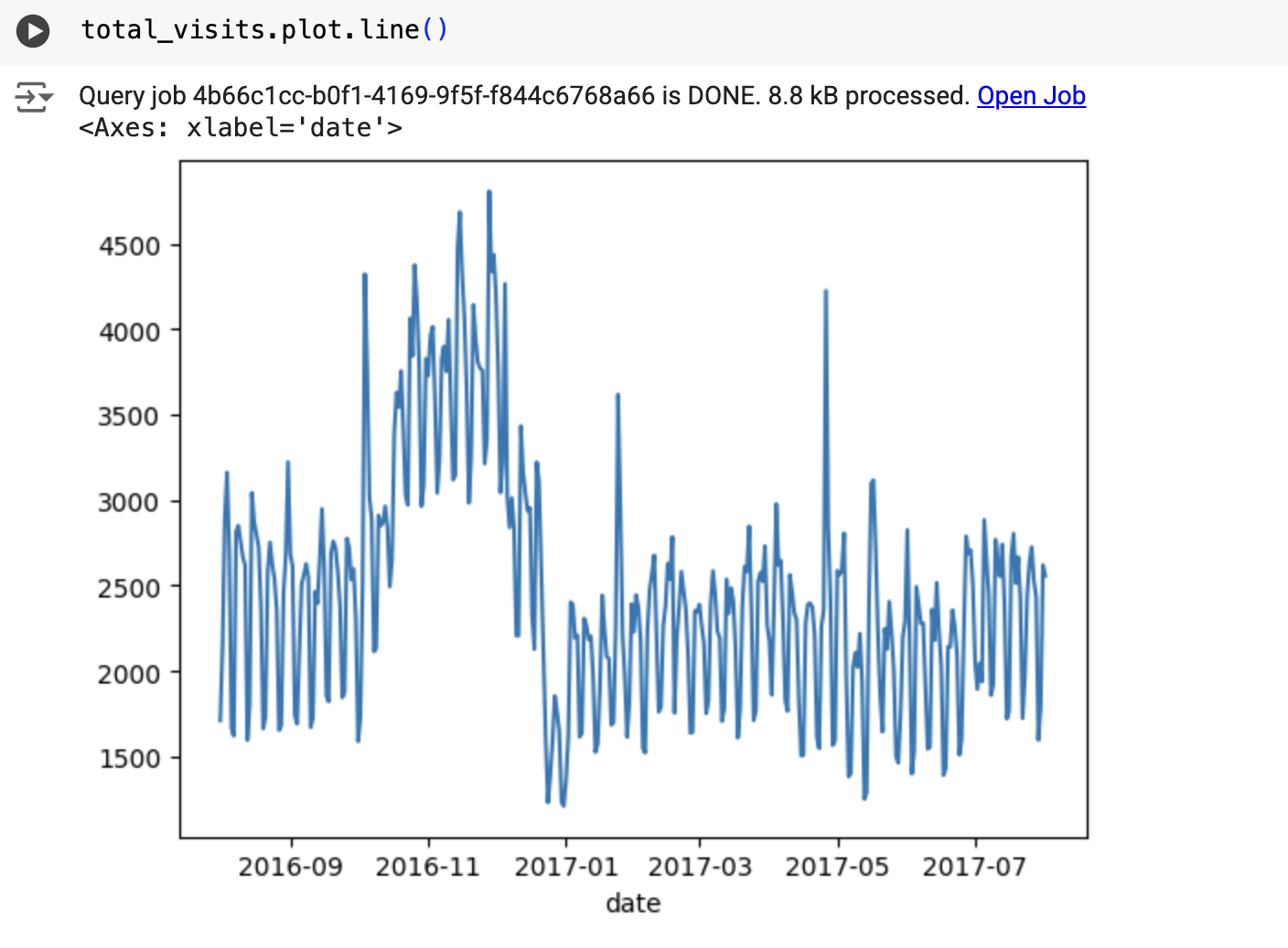

Permite trabajar con BigQuery DataFrames.

Antes de probar este ejemplo, sigue las instrucciones de configuración de BigQuery DataFrames en la guía de inicio rápido de BigQuery con BigQuery DataFrames. Para obtener más información, consulta la documentación de referencia de BigQuery DataFrames.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura ADC para un entorno de desarrollo local.

El resultado es similar al siguiente:

Crea el modelo de serie temporal

Crea un modelo de serie temporal para predecir las visitas totales al sitio, representadas por la columna totals.visits, y entrénalo con los datos de Google Analytics 360.

SQL

En la siguiente consulta, la cláusula OPTIONS(model_type='ARIMA_PLUS', time_series_timestamp_col='date', ...) indica que creas un modelo de serie temporal basado en ARIMA. La opción auto_arima de la sentencia CREATE MODEL se establece de forma predeterminada en TRUE, por lo que el algoritmo auto.ARIMA ajusta automáticamente los hiperparámetros en el modelo. El algoritmo se adapta a decenas de modelos candidatos y elige el mejor, que es el que tiene el criterio de información Akaike (AIC) más bajo.

La opción data_frequency de las sentencias CREATE MODEL se establece de forma predeterminada en AUTO_FREQUENCY, por lo que el proceso de entrenamiento infiere automáticamente la frecuencia de datos de la serie temporal de entrada. La opción decompose_time_series de la instrucción CREATE MODEL se establece de forma predeterminada en TRUE, de modo que se muestre información sobre los datos de series temporales cuando evalúes el modelo en el siguiente paso.

Sigue estos pasos para crear el modelo:

En la consola de Google Cloud , ve a la página BigQuery.

En el editor de consultas, pega la siguiente consulta y haz clic en Ejecutar:

CREATE OR REPLACE MODEL `bqml_tutorial.ga_arima_model` OPTIONS (model_type = 'ARIMA_PLUS', time_series_timestamp_col = 'parsed_date', time_series_data_col = 'total_visits', auto_arima = TRUE, data_frequency = 'AUTO_FREQUENCY', decompose_time_series = TRUE ) AS SELECT PARSE_TIMESTAMP("%Y%m%d", date) AS parsed_date, SUM(totals.visits) AS total_visits FROM `bigquery-public-data.google_analytics_sample.ga_sessions_*` GROUP BY date;

La consulta tarda alrededor de 4 segundos en completarse, después de eso, el modelo

ga_arima_modelaparece en el panel Explorador. Debido a que en la consulta se usa una declaraciónCREATE MODELpara crear un modelo, no se muestran los resultados.

Permite trabajar con BigQuery DataFrames.

Antes de probar este ejemplo, sigue las instrucciones de configuración de BigQuery DataFrames en la guía de inicio rápido de BigQuery con BigQuery DataFrames. Para obtener más información, consulta la documentación de referencia de BigQuery DataFrames.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura ADC para un entorno de desarrollo local.

Evalúa los modelos candidatos

SQL

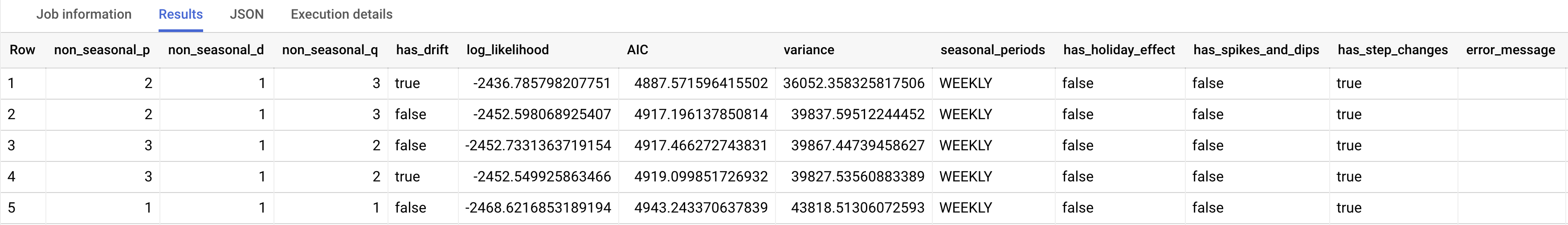

Evalúa los modelos de series temporales con la función ML.ARIMA_EVALUATE. La función ML.ARIMA_EVALUATE te muestra las métricas de evaluación de todos los modelos candidatos que se evaluaron durante el proceso de ajuste automático de hiperparámetros.

Sigue estos pasos para evaluar el modelo:

En la consola de Google Cloud , ve a la página BigQuery.

En el editor de consultas, pega la siguiente consulta y haz clic en Ejecutar:

SELECT * FROM ML.ARIMA_EVALUATE(MODEL `bqml_tutorial.ga_arima_model`);

Los resultados debería ser similar al siguiente:

Permite trabajar con BigQuery DataFrames.

Antes de probar este ejemplo, sigue las instrucciones de configuración de BigQuery DataFrames en la guía de inicio rápido de BigQuery con BigQuery DataFrames. Para obtener más información, consulta la documentación de referencia de BigQuery DataFrames.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura ADC para un entorno de desarrollo local.

Las columnas de salida non_seasonal_p, non_seasonal_d, non_seasonal_q y has_drift definen un modelo ARIMA en la canalización de entrenamiento. Las columnas de salida log_likelihood, AIC y variance son relevantes para el proceso de ajuste del modelo ARIMA.

El algoritmo auto.ARIMA usa la prueba de KPSS para determinar el mejor valor de non_seasonal_d, que en este caso es 1. Cuando non_seasonal_d es 1, el algoritmo auto.ARIMA entrena 42 modelos ARIMA candidatos diferentes en paralelo.

En este ejemplo, los 42 modelos candidatos son válidos, por lo que el resultado contiene 42 filas, una para cada modelo ARIMA candidato. En los casos en los que algunos de los modelos no son válidos, se excluyen del resultado. Estos modelos candidatos se devuelven en orden ascendente según el AIC. El modelo de la primera fila tiene el AIC más bajo y se considera el mejor modelo. El mejor modelo se guarda como el modelo final y se usa cuando llamas a funciones como ML.FORECAST en el modelo.

La columna seasonal_periods contiene información sobre el patrón estacional identificado en los datos de series temporales. No tiene nada que ver con el modelado ARIMA, por lo tanto, tiene el mismo valor en todas las filas de salida. Informa un patrón semanal, que coincide con los resultados que viste si elegiste visualizar los datos de entrada.

Las columnas has_holiday_effect, has_spikes_and_dips y has_step_changes solo se propagan cuando decompose_time_series=TRUE. Estas columnas también reflejan información sobre los datos de la serie temporal de entrada y no están relacionadas con el modelado ARIMA. Estas columnas también tienen los mismos valores en todas las filas de salida.

La columna error_message muestra los errores que se produjeron durante el proceso de ajuste auto.ARIMA. Un motivo posible de los errores es que las columnas non_seasonal_p, non_seasonal_d, non_seasonal_q y has_drift seleccionadas no pueden estabilizar la serie temporal. Para recuperar el mensaje de error de todos los modelos candidatos, configura la opción show_all_candidate_models en TRUE cuando crees el modelo.

Para obtener más información sobre las columnas de salida, consulta la función ML.ARIMA_EVALUATE.

Inspecciona los coeficientes del modelo

SQL

Inspecciona los coeficientes del modelo de series temporales con la función ML.ARIMA_COEFFICIENTS.

Sigue estos pasos para recuperar los coeficientes del modelo:

En la consola de Google Cloud , ve a la página BigQuery.

En el editor de consultas, pega la siguiente consulta y haz clic en Ejecutar:

SELECT * FROM ML.ARIMA_COEFFICIENTS(MODEL `bqml_tutorial.ga_arima_model`);

La columna de salida ar_coefficients muestra los coeficientes del modelo de la parte autorregresiva (AR) del modelo ARIMA. De manera similar, la columna de salida ma_coefficients muestra los coeficientes del modelo de la parte de promedio móvil (MA) del modelo ARIMA. Ambas columnas contienen valores de array, cuyas longitudes son iguales a non_seasonal_p y non_seasonal_q, respectivamente. En el resultado de la función ML.ARIMA_EVALUATE, viste que el mejor modelo tiene un valor de non_seasonal_p de 2 y un valor de non_seasonal_q de 3. Por lo tanto, en el resultado ML.ARIMA_COEFFICIENTS, el valor de ar_coefficients es un array de 2 elementos y el valor de ma_coefficients es un array de 3 elementos. El valor intercept_or_drift es el término constante en el modelo ARIMA.

Para obtener más información sobre las columnas de salida, consulta la función ML.ARIMA_COEFFICIENTS.

Permite trabajar con BigQuery DataFrames.

Inspecciona los coeficientes del modelo de series temporales con la función coef_.

Antes de probar este ejemplo, sigue las instrucciones de configuración de BigQuery DataFrames en la guía de inicio rápido de BigQuery con BigQuery DataFrames. Para obtener más información, consulta la documentación de referencia de BigQuery DataFrames.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura ADC para un entorno de desarrollo local.

La columna de salida ar_coefficients muestra los coeficientes del modelo de la parte autorregresiva (AR) del modelo ARIMA. De manera similar, la columna de salida ma_coefficients muestra los coeficientes del modelo de la parte de promedio móvil (MA) del modelo ARIMA. Ambas columnas contienen valores de array, cuyas longitudes son iguales a non_seasonal_p y non_seasonal_q, respectivamente.

Usa el modelo para predecir datos

SQL

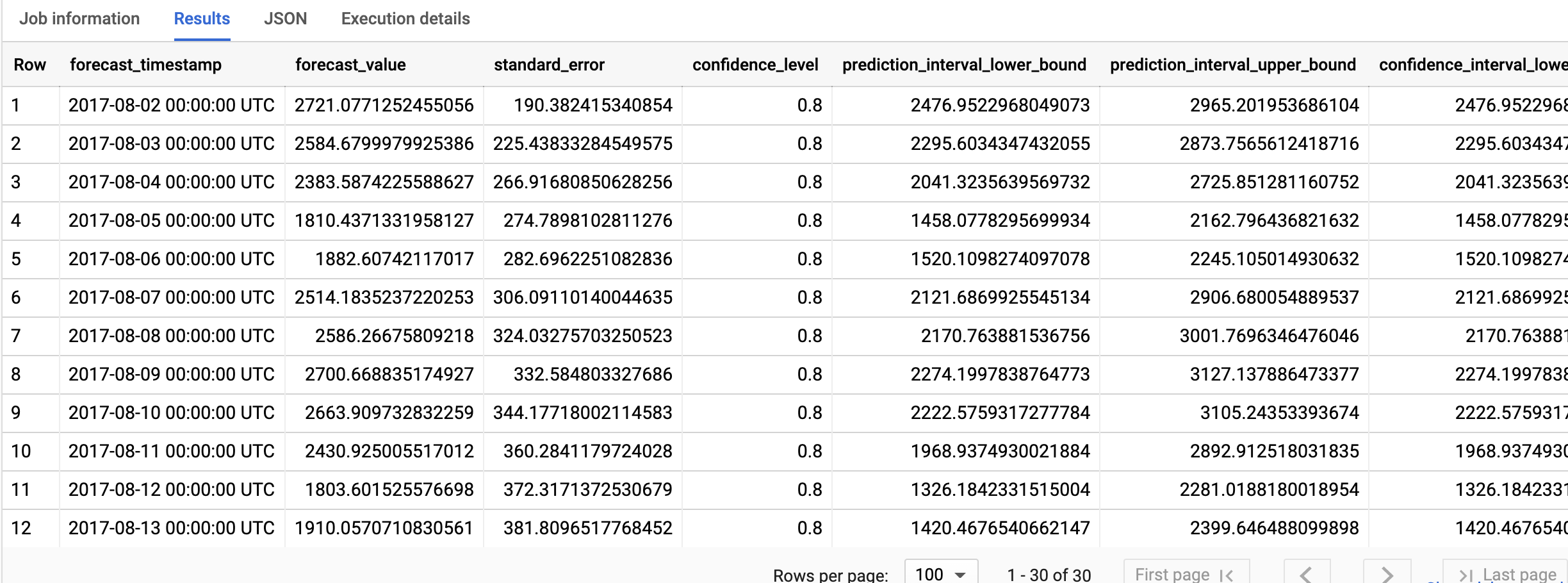

Prevé valores de series temporales futuras con la función ML.FORECAST.

En la siguiente consulta de GoogleSQL, la cláusula STRUCT(30 AS horizon, 0.8 AS confidence_level) indica que la consulta prevé 30 puntos futuros y genera un intervalo de predicción con un nivel de confianza del 80%.

Sigue estos pasos para predecir datos con el modelo:

En la consola de Google Cloud , ve a la página BigQuery.

En el editor de consultas, pega la siguiente consulta y haz clic en Ejecutar:

SELECT * FROM ML.FORECAST(MODEL `bqml_tutorial.ga_arima_model`, STRUCT(30 AS horizon, 0.8 AS confidence_level));

Los resultados debería ser similar al siguiente:

Permite trabajar con BigQuery DataFrames.

Prevé valores de series temporales futuras con la función predict.

Antes de probar este ejemplo, sigue las instrucciones de configuración de BigQuery DataFrames en la guía de inicio rápido de BigQuery con BigQuery DataFrames. Para obtener más información, consulta la documentación de referencia de BigQuery DataFrames.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura ADC para un entorno de desarrollo local.

Las filas de salida se ordenan cronológicamente según el valor de la columna forecast_timestamp. En la previsión de series temporales, el intervalo de predicción, representado por los valores de las columnas prediction_interval_lower_bound y prediction_interval_upper_bound, es tan importante como el valor de la columna forecast_value. El valor de forecast_value es el punto medio del intervalo de predicción. El intervalo de predicción depende de los valores de las columnas standard_error y confidence_level.

Para obtener más información sobre las columnas de salida, consulta la función ML.FORECAST.

Explica los resultados de la previsión

SQL

Puedes obtener métricas de interpretabilidad además de los datos de previsión con la función ML.EXPLAIN_FORECAST. La función ML.EXPLAIN_FORECAST prevé valores de series temporales futuras y también muestra todos los componentes separados de la serie temporal.

Al igual que la función ML.FORECAST, la cláusula STRUCT(30 AS horizon, 0.8 AS confidence_level) que se usa en la función ML.EXPLAIN_FORECAST indica que la consulta prevé 30 puntos temporales futuros y genera un intervalo de predicción con una confianza del 80%.

Sigue estos pasos para explicar los resultados del modelo:

En la consola de Google Cloud , ve a la página BigQuery.

En el editor de consultas, pega la siguiente consulta y haz clic en Ejecutar:

SELECT * FROM ML.EXPLAIN_FORECAST(MODEL `bqml_tutorial.ga_arima_model`, STRUCT(30 AS horizon, 0.8 AS confidence_level));

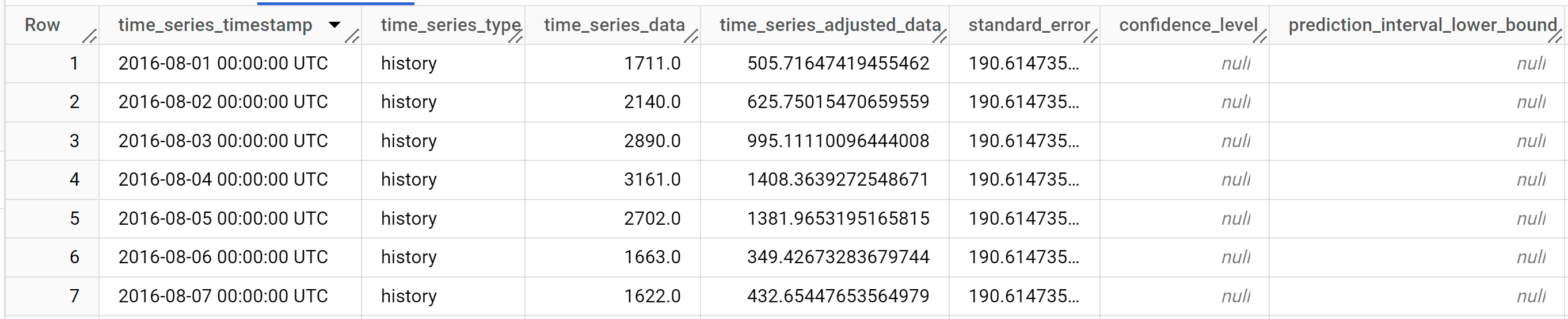

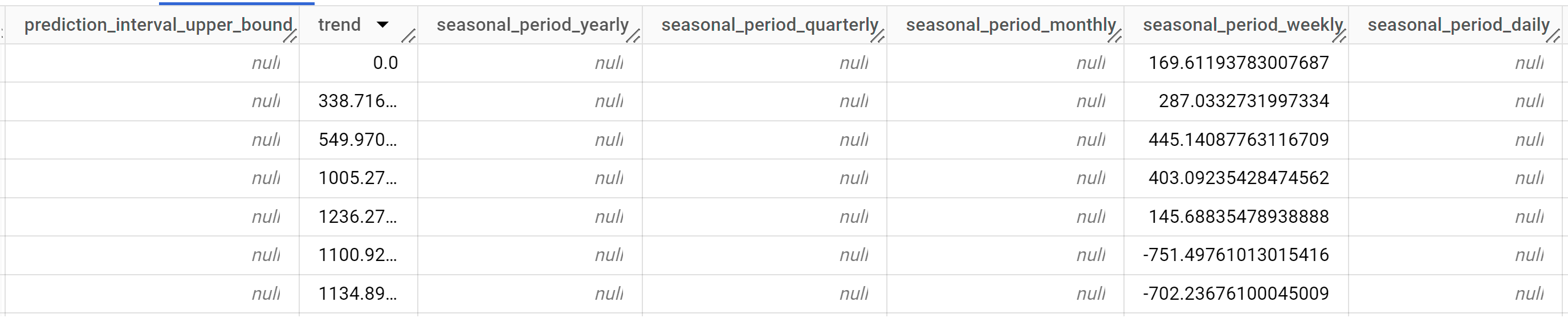

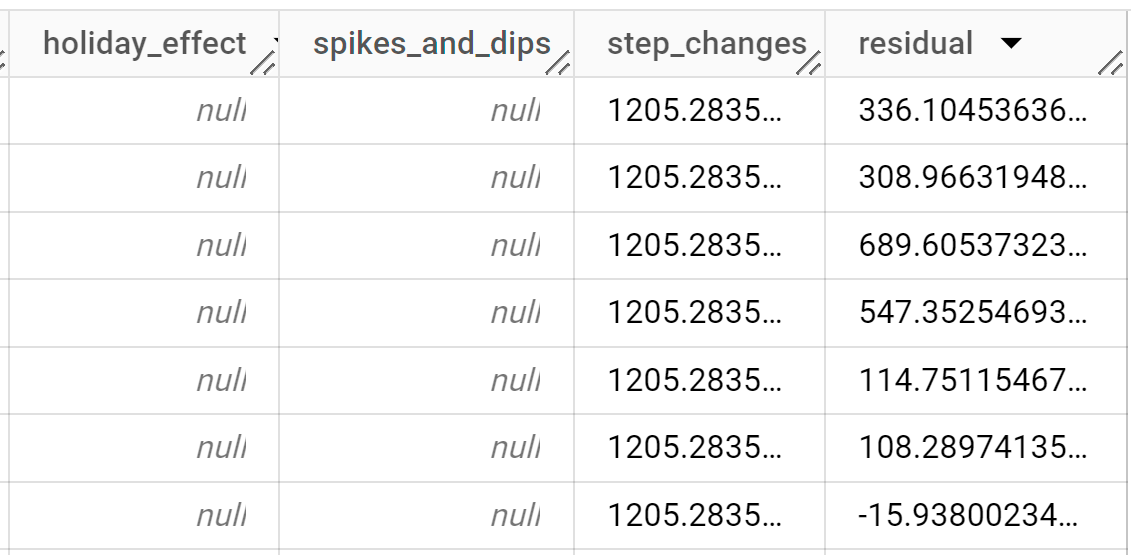

Los resultados debería ser similar al siguiente:

Las filas de salida se ordenan cronológicamente según el valor de la columna

time_series_timestamp.Para obtener más información sobre las columnas de salida, consulta la función

ML.EXPLAIN_FORECAST.

Permite trabajar con BigQuery DataFrames.

Puedes obtener métricas de interpretabilidad además de los datos de previsión con la función predict_explain. La función predict_explain prevé valores de series temporales futuras y también muestra todos los componentes separados de la serie temporal.

Al igual que la función predict, la cláusula horizon=30, confidence_level=0.8 que se usa en la función predict_explain indica que la consulta prevé 30 puntos temporales futuros y genera un intervalo de predicción con una confianza del 80%.

Antes de probar este ejemplo, sigue las instrucciones de configuración de BigQuery DataFrames en la guía de inicio rápido de BigQuery con BigQuery DataFrames. Para obtener más información, consulta la documentación de referencia de BigQuery DataFrames.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura ADC para un entorno de desarrollo local.

Si deseas visualizar los resultados, puedes usar Looker Studio como se describe en la sección Visualiza los datos de entrada para crear un gráfico con las siguientes columnas como métricas:

time_series_dataprediction_interval_lower_boundprediction_interval_upper_boundtrendseasonal_period_weeklystep_changes

Limpia

Para evitar que se apliquen cargos a tu cuenta de Google Cloud por los recursos usados en este instructivo, borra el proyecto que contiene los recursos o conserva el proyecto y borra los recursos individuales.

- Puedes borrar el proyecto que creaste.

- De lo contrario, puedes mantener el proyecto y borrar el conjunto de datos.

Borra tu conjunto de datos

Borrar tu proyecto quita todos sus conjuntos de datos y tablas. Si prefieres volver a usar el proyecto, puedes borrar el conjunto de datos que creaste en este instructivo:

Si es necesario, abre la página de BigQuery en la consola deGoogle Cloud .

En el panel de navegación, haz clic en el conjunto de datos bqml_tutorial que creaste.

Haz clic en Borrar conjunto de datos en el lado derecho de la ventana. Esta acción borra el conjunto de datos, la tabla y todos los datos.

En el cuadro de diálogo Borrar conjunto de datos, ingresa el nombre del conjunto de datos (

bqml_tutorial) y, luego, haz clic en Borrar para confirmar el comando de borrado.

Borra tu proyecto

Para borrar el proyecto, haz lo siguiente:

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

¿Qué sigue?

- Aprende a prever una sola serie temporal con un modelo multivariable

- Obtén más información para prever varias series temporales con un modelo univariable

- Obtén más información para escalar un modelo univariado cuando se prevén varias series temporales en muchas filas.

- Aprende a predecir jerárquicamente varias series temporales con un modelo univariable

- Para obtener una descripción general de BigQuery ML, consulta Introducción a la IA y el aprendizaje automático en BigQuery.