Neste tutorial, você importa modelos do TensorFlow para um conjunto de dados do BigQuery ML. Em seguida, use uma consulta SQL para fazer previsões com base nos modelos importados.

crie um conjunto de dados

Crie um conjunto de dados do BigQuery para armazenar seu modelo de ML.

Console

No console do Google Cloud , acesse a página BigQuery.

No painel Explorer, clique no nome do seu projeto.

Clique em Ver ações > Criar conjunto de dados.

Na página Criar conjunto de dados, faça o seguinte:

Para o código do conjunto de dados, insira

bqml_tutorial.Em Tipo de local, selecione Multirregião e EUA (várias regiões nos Estados Unidos).

Mantenha as configurações padrão restantes e clique em Criar conjunto de dados.

bq

Para criar um novo conjunto de dados, utilize o

comando bq mk

com a sinalização --location. Para obter uma lista completa de parâmetros, consulte a

referência

comando bq mk --dataset.

Crie um conjunto de dados chamado

bqml_tutorialcom o local dos dados definido comoUSe uma descrição deBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Em vez de usar a flag

--dataset, o comando usa o atalho-d. Se você omitir-de--dataset, o comando vai criar um conjunto de dados por padrão.Confirme se o conjunto de dados foi criado:

bq ls

API

Chame o método datasets.insert com um recurso de conjunto de dados definido.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

BigQuery DataFrames

Antes de testar esta amostra, siga as instruções de configuração dos BigQuery DataFrames no Guia de início rápido do BigQuery: como usar os BigQuery DataFrames. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para autenticar no BigQuery, configure o Application Default Credentials. Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local.

Importar um modelo do TensorFlow

As etapas a seguir mostram como importar um modelo do Cloud Storage.

O caminho para o modelo é

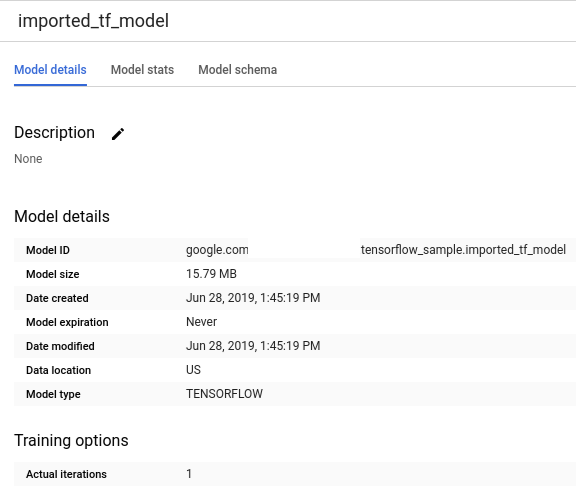

gs://cloud-training-demos/txtclass/export/exporter/1549825580/*. O nome do modelo importado é imported_tf_model.

O URI do Cloud Storage termina em um caractere curinga (*). Esse caractere indica que o BigQuery ML precisa importar todos os recursos associados ao modelo.

O modelo importado é um classificador de texto do TensorFlow que prevê qual site publicou um determinado título de artigo.

Para importar o modelo do TensorFlow para seu conjunto de dados, siga estas etapas.

Console

No console do Google Cloud , acesse a página BigQuery.

Em Criar, clique em Consulta SQL.

No editor de consultas, insira esta instrução

CREATE MODELe clique em Executar.CREATE OR REPLACE MODEL `bqml_tutorial.imported_tf_model` OPTIONS (MODEL_TYPE='TENSORFLOW', MODEL_PATH='gs://cloud-training-demos/txtclass/export/exporter/1549825580/*')

Quando a operação for concluída, você vai receber uma mensagem como

Successfully created model named imported_tf_model.Seu novo modelo vai aparecer no painel Recursos. Os modelos são indicados pelo ícone:

.

.Se você selecionar o novo modelo no painel Recursos, as informações sobre o modelo serão exibidas abaixo do Editor de consultas.

bq

Importe o modelo do TensorFlow do Cloud Storage inserindo a seguinte instrução

CREATE MODEL.bq query --use_legacy_sql=false \ "CREATE OR REPLACE MODEL `bqml_tutorial.imported_tf_model` OPTIONS (MODEL_TYPE='TENSORFLOW', MODEL_PATH='gs://cloud-training-demos/txtclass/export/exporter/1549825580/*')"

Depois de importar o modelo, verifique se ele aparece no conjunto de dados.

bq ls -m bqml_tutorial

O resultado será assim:

tableId Type ------------------- ------- imported_tf_model MODEL

API

Insira um novo job e preencha a propriedade jobs#configuration.query no corpo da solicitação.

{ "query": "CREATE MODEL `PROJECT_ID:bqml_tutorial.imported_tf_model` OPTIONS(MODEL_TYPE='TENSORFLOW' MODEL_PATH='gs://cloud-training-demos/txtclass/export/exporter/1549825580/*')" }

Substitua PROJECT_ID pelo nome do projeto e do conjunto de dados.

BigQuery DataFrames

Antes de testar esta amostra, siga as instruções de configuração dos BigQuery DataFrames no Guia de início rápido do BigQuery: como usar os BigQuery DataFrames. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para autenticar no BigQuery, configure o Application Default Credentials. Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local.

Importe o modelo usando o objeto TensorFlowModel.

Para mais informações sobre como importar modelos do TensorFlow no BigQuery ML, incluindo requisitos de formato e armazenamento, consulte a instrução CREATE MODEL para importar modelos do TensorFlow.

Fazer previsões com o modelo importado do TensorFlow

Depois de importar o modelo do TensorFlow, use a

função ML.PREDICT

para fazer previsões com o modelo.

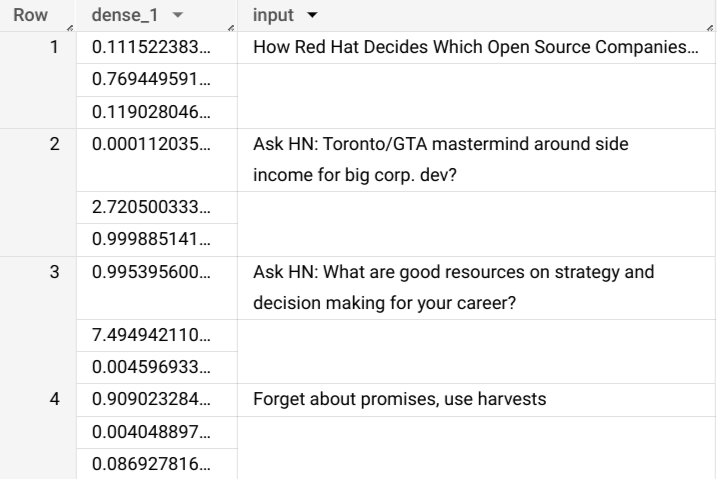

A consulta a seguir usa imported_tf_model para fazer previsões com dados de entrada da tabela full no conjunto de dados público hacker_news. Na consulta, a função serving_input_fn do modelo do TensorFlow especifica que o modelo espera uma única string de entrada chamada input. A subconsulta atribui o alias input à coluna title na instrução SELECT da subconsulta.

Para fazer previsões com o modelo importado do TensorFlow, siga estas etapas.

Console

No console do Google Cloud , acesse a página BigQuery.

Em Criar nova, clique em Consulta SQL.

No editor de consultas, insira esta consulta que usa a função

ML.PREDICT.SELECT * FROM ML.PREDICT(MODEL `bqml_tutorial.imported_tf_model`, ( SELECT title AS input FROM bigquery-public-data.hacker_news.full ) )

Os resultados da consulta vão ficar assim:

bq

Digite este comando para executar a consulta que usa ML.PREDICT.

bq query \ --use_legacy_sql=false \ 'SELECT * FROM ML.PREDICT( MODEL `bqml_tutorial.imported_tf_model`, (SELECT title AS input FROM `bigquery-public-data.hacker_news.full`))'

Os resultados devem ficar assim:

+------------------------------------------------------------------------+----------------------------------------------------------------------------------+ | dense_1 | input | +------------------------------------------------------------------------+----------------------------------------------------------------------------------+ | ["0.6251608729362488","0.2989124357700348","0.07592673599720001"] | How Red Hat Decides Which Open Source Companies t... | | ["0.014276246540248394","0.972910463809967","0.01281337533146143"] | Ask HN: Toronto/GTA mastermind around side income for big corp. dev? | | ["0.9821603298187256","1.8601855117594823E-5","0.01782100833952427"] | Ask HN: What are good resources on strategy and decision making for your career? | | ["0.8611106276512146","0.06648492068052292","0.07240450382232666"] | Forget about promises, use harvests | +------------------------------------------------------------------------+----------------------------------------------------------------------------------+

API

Insira um novo job e preencha a propriedade jobs#configuration.query como no corpo da solicitação. Substitua project_id pelo nome do projeto.

{ "query": "SELECT * FROM ML.PREDICT(MODEL `project_id.bqml_tutorial.imported_tf_model`, (SELECT * FROM input_data))" }

BigQuery DataFrames

Antes de testar esta amostra, siga as instruções de configuração dos BigQuery DataFrames no Guia de início rápido do BigQuery: como usar os BigQuery DataFrames. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para autenticar no BigQuery, configure o Application Default Credentials. Para mais informações, consulte Configurar o ADC para um ambiente de desenvolvimento local.

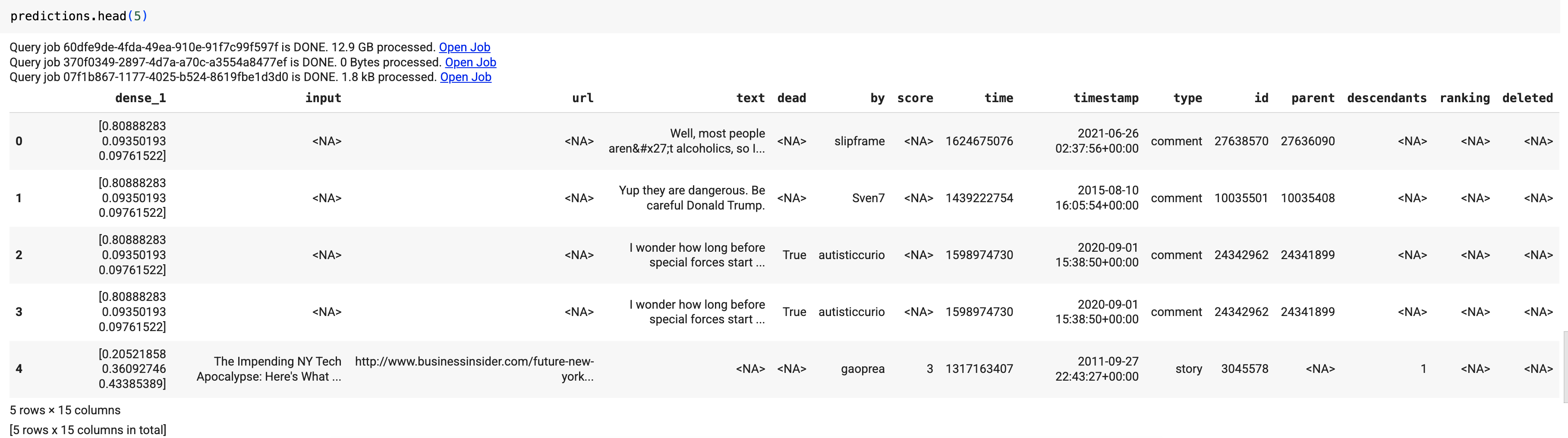

Use a função predict para executar o modelo do TensorFlow:

Os resultados devem ficar assim:

Nos resultados da consulta, a coluna dense_1 contém uma matriz de valores de probabilidade, e a coluna input contém os valores de string correspondentes da tabela de entrada. Cada valor de elemento da matriz representa a probabilidade de que a string de entrada correspondente seja um título de artigo de uma publicação específica.