Caricare i dati di Cloud Storage in BigQuery

Puoi caricare i dati da Cloud Storage a BigQuery utilizzando il connettore BigQuery Data Transfer Service per Cloud Storage. Con BigQuery Data Transfer Service, puoi pianificare job di trasferimento ricorrenti che aggiungono i dati più recenti da Cloud Storage a BigQuery.

Prima di iniziare

Prima di creare un trasferimento di dati Cloud Storage, procedi nel seguente modo:

- Verifica di aver completato tutte le azioni richieste in Attivazione di BigQuery Data Transfer Service.

- Recupera l'URI Cloud Storage.

- Crea un set di dati BigQuery per archiviare i dati.

- Crea la tabella di destinazione per il trasferimento dei dati e specifica la definizione dello schema.

- Se prevedi di specificare una chiave di crittografia gestita dal cliente (CMEK), assicurati che il tuo account di servizio disponga delle autorizzazioni per criptare e decriptare e di disporre dell'ID risorsa chiave Cloud KMS necessario per utilizzare CMEK. Per informazioni su come funziona la CMEK con BigQuery Data Transfer Service, vedi Specifica la chiave di crittografia con i trasferimenti.

Limitazioni

I trasferimenti di dati ricorrenti da Cloud Storage a BigQuery sono soggetti alle seguenti limitazioni:

- Tutti i file che corrispondono ai pattern definiti da un carattere jolly o dai parametri di runtime per il trasferimento dei dati devono condividere lo stesso schema definito per la tabella di destinazione, altrimenti il trasferimento non andrà a buon fine. Anche le modifiche allo schema della tabella tra le esecuzioni causano l'errore del trasferimento.

- Poiché è possibile creare versioni degli oggetti Cloud Storage, è importante notare che gli oggetti Cloud Storage archiviati non sono supportati per i trasferimenti di dati BigQuery. Gli oggetti devono essere pubblicati per essere trasferiti.

- A differenza dei caricamenti individuali di dati da Cloud Storage a BigQuery, per i trasferimenti di dati continui devi creare la tabella di destinazione prima di configurare il trasferimento. Per i file CSV e JSON, devi anche definire in anticipo lo schema della tabella. BigQuery non può creare la tabella nell'ambito del processo di trasferimento dei dati ricorrente.

- i trasferimenti di dati da Cloud Storage impostano il parametro Preferenza di scrittura su

APPENDper impostazione predefinita. In questa modalità, un file non modificato può essere caricato in BigQuery una sola volta. Se la proprietàlast modification timedel file viene aggiornata, il file verrà ricaricato. BigQuery Data Transfer Service non garantisce che tutti i file vengano trasferiti o trasferiti una sola volta se i file Cloud Storage vengono modificati durante un trasferimento di dati. Quando carichi i dati in BigQuery da un bucket Cloud Storage, sono previste le seguenti limitazioni:

BigQuery non garantisce la coerenza dei dati per le origini dati esterne. Le modifiche ai dati sottostanti durante l'esecuzione di una query possono comportare un comportamento imprevisto.

BigQuery non supporta il controllo delle versioni degli oggetti Cloud Storage. Se includi un numero di generazione nell'URI Cloud Storage, il job di caricamento non va a buon fine.

A seconda del formato dei dati di origine di Cloud Storage, potrebbero essere presenti limitazioni aggiuntive. Per ulteriori informazioni, vedi:

Il bucket Cloud Storage deve trovarsi in una località compatibile con la regione o la multiregione del set di dati di destinazione in BigQuery. Questo è noto come colocation. Per maggiori dettagli, consulta Località dei dati del servizio di trasferimento di Cloud Storage.

Intervalli minimi

- I file di origine vengono selezionati immediatamente per il trasferimento dei dati, senza un'età minima del file.

- L'intervallo di tempo minimo tra i trasferimenti di dati ricorrenti è di 15 minuti. L'intervallo predefinito per un trasferimento di dati ricorrente è di 24 ore.

- Puoi configurare un trasferimento basato sugli eventi per pianificare automaticamente i trasferimenti di dati a intervalli più brevi.

Autorizzazioni obbligatorie

Quando carichi i dati in BigQuery, hai bisogno di autorizzazioni che ti consentano di caricare i dati in tabelle e partizioni BigQuery nuove o esistenti. Se carichi i dati da Cloud Storage, devi anche accedere al bucket che contiene i tuoi dati. Assicurati di disporre delle seguenti autorizzazioni necessarie:

BigQuery: assicurati che la persona o il account di servizio che crea il trasferimento dei dati disponga delle seguenti autorizzazioni in BigQuery:

bigquery.transfers.updateautorizzazioni per creare il trasferimento di dati- Autorizzazioni

bigquery.datasets.getebigquery.datasets.updatesul set di dati di destinazione

Il ruolo IAM predefinito

bigquery.admininclude le autorizzazionibigquery.transfers.update,bigquery.datasets.updateebigquery.datasets.get. Per saperne di più sui ruoli IAM in BigQuery Data Transfer Service, consulta Controllo dell'accesso.Cloud Storage: sono richieste le autorizzazioni

storage.objects.getsul singolo bucket o su un livello superiore. Se utilizzi un carattere jolly URI, devi disporre anche delle autorizzazionistorage.objects.list. Se vuoi eliminare i file di origine dopo ogni trasferimento riuscito, devi disporre anche delle autorizzazionistorage.objects.delete. Il ruolo IAM predefinitostorage.objectAdmininclude tutte queste autorizzazioni.

Configurare un trasferimento Cloud Storage

Per creare un trasferimento di dati Cloud Storage in BigQuery Data Transfer Service:

Console

Vai alla pagina Trasferimenti di dati nella console Google Cloud .

Fai clic su Crea trasferimento.

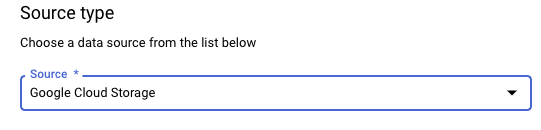

Nella sezione Tipo di origine, per Origine, scegli Google Cloud Storage.

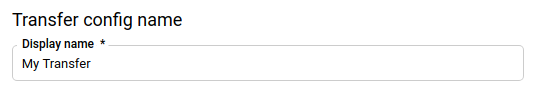

Nella sezione Nome configurazione di trasferimento, per Nome visualizzato, inserisci un nome per il trasferimento di dati, ad esempio

My Transfer. Il nome del trasferimento può essere qualsiasi valore che ti consenta di identificare il trasferimento se devi modificarlo in un secondo momento.

Nella sezione Opzioni di pianificazione, seleziona una Frequenza di ripetizione:

Se selezioni Ore, Giorni, Settimane o Mesi, devi anche specificare una frequenza. Puoi anche selezionare Personalizzata per specificare una frequenza di ripetizione personalizzata. Puoi selezionare Inizia ora o Inizia all'ora impostata e fornire una data di inizio e un'ora di esecuzione.

Se selezioni On demand, questo trasferimento di dati viene eseguito quando attivi manualmente il trasferimento.

Se selezioni Basata su eventi, devi anche specificare una sottoscrizione Pub/Sub. Scegli il nome dell'abbonamento o fai clic su Crea una sottoscrizione. Questa opzione abilita un trasferimento basato su eventi che attiva le esecuzioni del trasferimento quando gli eventi arrivano alla sottoscrizione Pub/Sub.

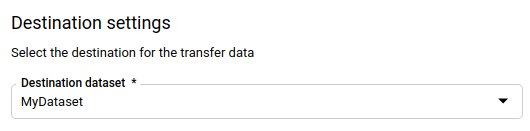

Nella sezione Impostazioni destinazione, per Set di dati di destinazione, scegli il set di dati che hai creato per archiviare i dati.

Nella sezione Dettagli origine dati:

- In Tabella di destinazione, inserisci il nome della tabella di destinazione. La tabella di destinazione deve rispettare le regole di denominazione delle tabelle. I nomi delle tabelle di destinazione supportano anche i parametri.

- In URI Cloud Storage, inserisci l'URI Cloud Storage. I caratteri jolly e i parametri sono supportati. Se l'URI non corrisponde a nessun file, nella tabella di destinazione non viene sovrascritto alcun dato.

In Preferenza di scrittura, scegli:

- AGGIUNGI per aggiungere in modo incrementale i nuovi dati alla tabella di destinazione esistente. AGGIUNGI è il valore predefinito per Preferenza di scrittura.

- ESEGUI IL MIRRORING per sovrascrivere i dati nella tabella di destinazione durante ogni esecuzione del trasferimento di dati.

Per saperne di più su come BigQuery Data Transfer Service importa i dati utilizzando AGGIUNGI o ESEGUI IL MIRRORING, consulta Importazione dati per i trasferimenti di Cloud Storage. Per ulteriori informazioni sul campo

writeDisposition, vediJobConfigurationLoad.In Elimina file di origine dopo il trasferimento, seleziona la casella se vuoi eliminare i file di origine dopo ogni trasferimento di dati riuscito. I job di eliminazione si basano sul "best effort". I job di eliminazione non vengono riprovati se il primo tentativo di eliminazione dei file di origine non riesce.

Nella sezione Opzioni di trasferimento:

- In Tutti i formati:

- In Numero di errori consentiti, inserisci il numero massimo di record non validi che BigQuery può ignorare durante l'esecuzione del job. Se il numero di record non validi supera questo valore, nel risultato del job viene restituito un errore

invalide il job riesce. Il valore predefinito è0. - (Facoltativo) In Tipi di target decimali, inserisci un elenco separato da virgole dei possibili tipi di dati SQL in cui potrebbero essere convertiti i valori decimali di origine. Il tipo di dati SQL selezionato per la conversione dipende dalle seguenti condizioni:

- Il tipo di dati selezionato per la conversione sarà il primo nel seguente elenco che supporta la precisione e la scalabilità dei dati di origine, nel seguente ordine:

NUMERIC,BIGNUMERICeSTRING. - Se nessuno dei tipi di dati elencati supporta la precisione e la scalabilità, viene selezionato il tipo di dati che supporta l'intervallo più ampio nell'elenco specificato. Se un valore supera l'intervallo supportato durante la lettura dei dati di origine, viene generato un errore.

- Il tipo di dati

STRINGsupporta tutti i valori di precisione e scalabilità. - Se questo campo viene lasciato vuoto, il tipo di dato predefinito sarà

NUMERIC,STRINGper ORC eNUMERICper gli altri formati file. - Questo campo non può contenere tipi di dati duplicati.

- L'ordine dei tipi di dati elencati in questo campo viene ignorato.

- Il tipo di dati selezionato per la conversione sarà il primo nel seguente elenco che supporta la precisione e la scalabilità dei dati di origine, nel seguente ordine:

- In Numero di errori consentiti, inserisci il numero massimo di record non validi che BigQuery può ignorare durante l'esecuzione del job. Se il numero di record non validi supera questo valore, nel risultato del job viene restituito un errore

- In JSON, CSV, per Ignora valori sconosciuti, seleziona la casella se vuoi che il trasferimento di dati elimini i dati che non corrispondono allo schema della tabella di destinazione.

- In AVRO, per Utilizza tipi logici Avro, seleziona la casella se vuoi che il trasferimento di dati converta i tipi logici Avro nei tipi di dati BigQuery corrispondenti. Il comportamento predefinito è ignorare l'attributo

logicalTypeper la maggior parte dei tipi e utilizzare il tipo Avro sottostante. In CSV:

- Per Delimitatore di campo, inserisci il carattere che separa i campi. Il valore predefinito è una virgola.

- Per Virgolette, inserisci il carattere utilizzato per citare le sezioni di dati in un file CSV. Il valore predefinito sono le virgolette doppie (

"). - Per Righe di intestazione da saltare, inserisci il numero di righe di intestazione dei file di origine se non vuoi importarle. Il valore predefinito è

0. - Per Consenti caratteri di fine riga con virgolette, seleziona la casella se vuoi consentire i caratteri di fine riga all'interno dei campi tra virgolette.

- Per Consenti righe incomplete, seleziona la casella se vuoi consentire il trasferimento di dati delle righe con colonne

NULLABLEmancanti.

Per ulteriori informazioni, vedi le opzioni solo per CSV.

- In Tutti i formati:

Nel menu Service account, seleziona un service account tra quelli associati al tuo progetto Google Cloud . Puoi associare un account di servizio al trasferimento di dati anziché utilizzare le tue credenziali utente. Per ulteriori informazioni sull'utilizzo dei service account con i trasferimenti di dati, consulta Utilizza i service account.

- Se hai eseguito l'accesso con un'identità federata, è necessario un service account per creare un trasferimento di dati. Se hai eseguito l'accesso con un Account Google, il service account per il trasferimento è facoltativo.

- Il service account deve avere le autorizzazioni richieste sia per BigQuery che per Cloud Storage.

(Facoltativo) Nella sezione Opzioni di notifica:

- Fai clic sul pulsante di attivazione/disattivazione per abilitare le notifiche via email. Quando attivi questa opzione, il proprietario della configurazione del trasferimento di dati riceve una notifica via email quando l'esecuzione di un trasferimento non riesce.

- In Seleziona un argomento Pub/Sub, scegli il nome dell'argomento o fai clic su Crea un argomento. Questa opzione configura l'esecuzione delle notifiche di Pub/Sub in relazione al trasferimento.

(Facoltativo) Nella sezione Opzioni avanzate, se utilizzi le CMEK, seleziona Chiave gestita dal cliente. Viene visualizzato un elenco di CMEK disponibili tra cui scegliere. Per informazioni su come funzionano le CMEK con BigQuery Data Transfer Service, vedi Specifica la chiave di crittografia con i trasferimenti.

Fai clic su Salva.

bq

Inserisci il comando bq mk e fornisci il flag di creazione del trasferimento: --transfer_config. Sono necessari anche i seguenti flag:

--data_source--display_name--target_dataset--params

Flag facoltativi:

--destination_kms_key: specifica l'ID risorsa chiave per la chiave Cloud KMS se utilizzi una chiave di crittografia gestita dal cliente (CMEK) per questo trasferimento di dati. Per informazioni su come funzionano le CMEK con BigQuery Data Transfer Service, vedi Specifica la chiave di crittografia con i trasferimenti.--service_account_name: specifica un account di servizio da utilizzare per l'autenticazione del trasferimento di Cloud Storage anziché il tuo account utente.

bq mk \ --transfer_config \ --project_id=PROJECT_ID \ --data_source=DATA_SOURCE \ --display_name=NAME \ --target_dataset=DATASET \ --destination_kms_key="DESTINATION_KEY" \ --params='PARAMETERS' \ --service_account_name=SERVICE_ACCOUNT_NAME

Dove:

- PROJECT_ID è l'ID progetto. Se

--project_idnon viene fornito per specificare un progetto particolare, viene utilizzato il progetto predefinito. - DATA_SOURCE è l'origine dati, ad esempio

google_cloud_storage. - NAME è il nome visualizzato per la configurazione del trasferimento di dati. Il nome del trasferimento può essere qualsiasi valore che ti consenta di identificare il trasferimento se devi modificarlo in un secondo momento.

- DATASET è il set di dati di destinazione per la configurazione del trasferimento.

- DESTINATION_KEY: l'ID risorsa chiave Cloud KMS, ad esempio

projects/project_name/locations/us/keyRings/key_ring_name/cryptoKeys/key_name. - PARAMETERS contiene i parametri per la configurazione del trasferimento

creata in formato JSON. Ad esempio:

--params='{"param":"param_value"}'.destination_table_name_template: il nome della tabella BigQuery di destinazione.data_path_template: l'URI Cloud Storage che contiene i file da trasferire. I caratteri jolly e i parametri sono supportati.write_disposition: determina se i file corrispondenti vengono aggiunti alla tabella di destinazione o rispecchiati completamente. I valori supportati sonoAPPENDoMIRROR. Per informazioni su come BigQuery Data Transfer Service aggiunge o esegue il mirroring dei dati nei trasferimenti di Cloud Storage, consulta Importazione dati per i trasferimenti di Cloud Storage.file_format: il formato dei file che vuoi trasferire. Il formato può essereCSV,JSON,AVRO,PARQUEToORC. Il valore predefinito èCSV.max_bad_records: per qualsiasi valore difile_format, il numero massimo di record errati che possono essere ignorati. Il valore predefinito è0.decimal_target_types: per qualsiasi valorefile_format, un elenco separato da virgole dei possibili tipi di dati SQL in cui potrebbero essere convertiti i valori decimali di origine. Se questo campo non viene fornito, il tipo di dato predefinito sarà"NUMERIC,STRING"perORCe"NUMERIC"per gli altri formati file.ignore_unknown_values: per qualsiasi valorefile_format, impostaTRUEper accettare le righe che contengono valori che non corrispondono allo schema. Per ulteriori informazioni, vedi i dettagli del campoignoreUnknownvaluesnella tabella di riferimentoJobConfigurationLoad.use_avro_logical_types: per i valoriAVROfile_format, impostaTRUEper interpretare i tipi logici nei tipi corrispondenti (ad esempioTIMESTAMP), anziché utilizzare solo i tipi non elaborati (ad esempioINTEGER).parquet_enum_as_string: per i valoriPARQUETfile_format, impostaTRUEper dedurre il tipo logicoPARQUETENUMcomeSTRINGanziché il valore predefinitoBYTES.parquet_enable_list_inference: per i valoriPARQUETfile_format, impostaTRUEper utilizzare l'inferenza dello schema specificamente per il tipo logicoPARQUETLIST.reference_file_schema_uri: un percorso URI a un file di riferimento con lo schema del lettore.field_delimiter: per i valoriCSVfile_format, un carattere che separa i campi. Il valore predefinito è una virgola.quote: per i valoriCSVfile_format, un carattere utilizzato per citare le sezioni di dati in un file CSV. Il valore predefinito sono le virgolette doppie (").skip_leading_rows: per i valoriCSVfile_format, indica il numero di righe di intestazione iniziali che non vuoi importare. Il valore predefinito è 0.allow_quoted_newlines: per i valoriCSVfile_format, impostaTRUEper consentire i ritorni a capo nei campi tra virgolette.allow_jagged_rows: per i valoriCSVfile_format, impostaTRUEper accettare le righe che non hanno le colonne finali facoltative. I valori mancanti vengono compilati conNULL.preserve_ascii_control_characters: per i valoriCSVfile_format, impostaTRUEper conservare eventuali caratteri di controllo ASCII incorporati.encoding: specifica il tipo di codificaCSV. I valori supportati sonoUTF8,ISO_8859_1,UTF16BE,UTF16LE,UTF32BEeUTF32LE.delete_source_files: impostato suTRUEper eliminare i file di origine dopo ogni trasferimento riuscito. I job di eliminazione non vengono riprovati se il primo tentativo di eliminazione del file di origine non riesce. Il valore predefinito èFALSE.

- SERVICE_ACCOUNT_NAME è il nome del account di servizio utilizzato per

autenticare il trasferimento. Il account di servizio deve

essere di proprietà dello stesso

project_idutilizzato per creare il trasferimento e deve disporre di tutte le autorizzazioni richieste.

Ad esempio, il seguente comando crea un trasferimento di dati Cloud Storage denominato My Transfer utilizzando un valore data_path_template di gs://mybucket/myfile/*.csv, il set di dati di destinazione mydataset e file_format

CSV. Questo esempio include valori non predefiniti per i parametri facoltativi

associati a CSV file_format.

Il trasferimento dei dati viene creato nel progetto predefinito:

bq mk --transfer_config \

--target_dataset=mydataset \

--project_id=myProject \

--display_name='My Transfer' \

--destination_kms_key=projects/myproject/locations/mylocation/keyRings/myRing/cryptoKeys/myKey \

--params='{"data_path_template":"gs://mybucket/myfile/*.csv",

"destination_table_name_template":"MyTable",

"file_format":"CSV",

"max_bad_records":"1",

"ignore_unknown_values":"true",

"field_delimiter":"|",

"quote":";",

"skip_leading_rows":"1",

"allow_quoted_newlines":"true",

"allow_jagged_rows":"false",

"delete_source_files":"true"}' \

--data_source=google_cloud_storage \

--service_account_name=abcdef-test-sa@abcdef-test.iam.gserviceaccount.com projects/862514376110/locations/us/transferConfigs/ 5dd12f26-0000-262f-bc38-089e0820fe38

Dopo aver eseguito il comando, ricevi un messaggio simile al seguente:

[URL omitted] Please copy and paste the above URL into your web browser and

follow the instructions to retrieve an authentication code.

Segui le istruzioni e incolla il codice di autenticazione nella riga di comando.

API

Utilizza il metodo projects.locations.transferConfigs.create e fornisci un'istanza della risorsa TransferConfig.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Specificare la chiave di crittografia con i trasferimenti

Puoi specificare le chiavi di crittografia gestite dal cliente (CMEK) per criptare i dati per un'esecuzione del trasferimento. Puoi utilizzare una chiave CMEK per supportare i trasferimenti da Cloud Storage.Quando specifichi una CMEK con un trasferimento, BigQuery Data Transfer Service la applica a qualsiasi cache su disco intermedia dei dati importati, in modo che l'intero flusso di lavoro di trasferimento dei dati sia conforme alla CMEK.

Non puoi aggiornare un trasferimento esistente per aggiungere una chiave CMEK se il trasferimento non è stato originariamente creato con una chiave CMEK. Ad esempio, non puoi modificare una tabella di destinazione che originariamente era criptata per impostazione predefinita in modo che ora sia criptata con CMEK. Al contrario, non puoi modificare una tabella di destinazione criptata con CMEK in modo che abbia un tipo di crittografia diverso.

Puoi aggiornare una chiave CMEK per un trasferimento se la configurazione del trasferimento è stata originariamente creata con una crittografia CMEK. Quando aggiorni una CMEK per una configurazione di trasferimento, BigQuery Data Transfer Service la propaga alle tabelle di destinazione alla successiva esecuzione del trasferimento, durante la quale BigQuery Data Transfer Service sostituisce le CMEK obsolete con la nuova CMEK. Per ulteriori informazioni, vedi Aggiornare un trasferimento.

Puoi anche utilizzare le chiavi predefinite del progetto. Quando specifichi una chiave predefinita del progetto con un trasferimento, BigQuery Data Transfer Service utilizza la chiave predefinita del progetto come chiave predefinita per qualsiasi nuova configurazione di trasferimento.

Attivare manualmente un trasferimento

Oltre ai trasferimenti di dati pianificati automaticamente da Cloud Storage, puoi attivare manualmente un trasferimento per caricare file di dati aggiuntivi.

Se la configurazione del trasferimento è parametrizzata in fase di runtime, dovrai specificare un intervallo di date per cui verranno avviati trasferimenti aggiuntivi.

Per attivare un trasferimento di dati:

Console

Vai alla pagina BigQuery nella console Google Cloud .

Fai clic su Trasferimenti di dati.

Seleziona il trasferimento dei dati dall'elenco.

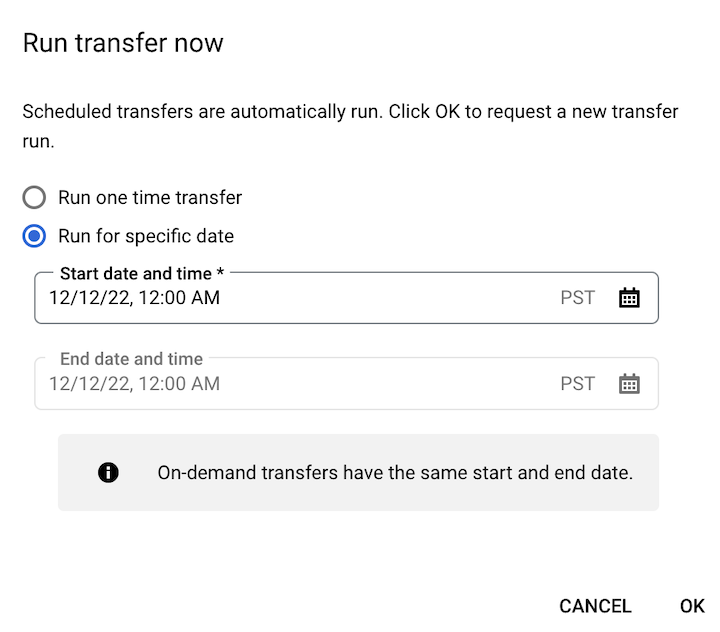

Fai clic su Esegui trasferimento ora o Pianifica backfill (per le configurazioni di trasferimento con parametri di runtime).

Se hai fatto clic su Esegui trasferimento ora, seleziona Esegui trasferimento una sola volta o Esegui per una data specifica, a seconda dei casi. Se hai selezionato Esegui per una data specifica, seleziona una data e un'ora specifiche:

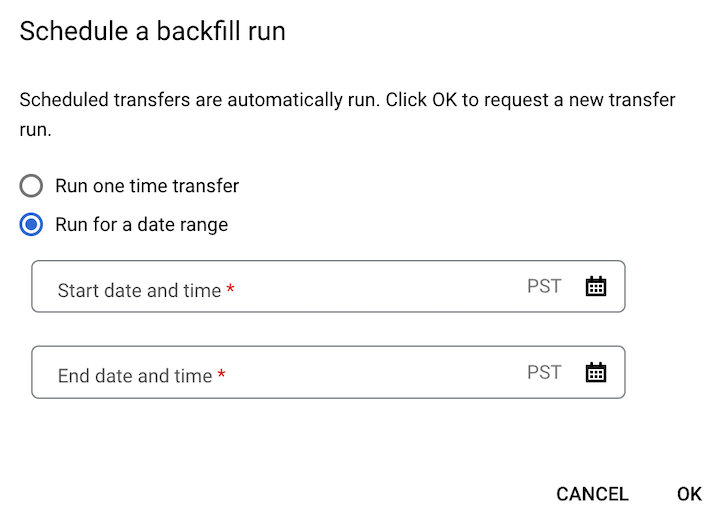

Se hai fatto clic su Pianifica backfill, seleziona Esegui trasferimento una tantum o Esegui per un intervallo di date, a seconda dei casi. Se hai selezionato Esegui per un intervallo di date, seleziona una data e un'ora di inizio e di fine:

Fai clic su Ok.

bq

Inserisci il comando bq mk

e fornisci il flag --transfer_run. Puoi utilizzare il flag --run_time

oppure i flag --start_time e --end_time.

bq mk \ --transfer_run \ --start_time='START_TIME' \ --end_time='END_TIME' \ RESOURCE_NAME

bq mk \ --transfer_run \ --run_time='RUN_TIME' \ RESOURCE_NAME

Dove:

START_TIME e END_TIME sono timestamp che terminano con

Zo contengono un offset del fuso orario valido. Ad esempio:2017-08-19T12:11:35.00Z2017-05-25T00:00:00+00:00

RUN_TIME è un timestamp che specifica l'ora in cui pianificare l'esecuzione del trasferimento di dati. Se vuoi eseguire un trasferimento una tantum per l'ora corrente, puoi utilizzare il flag

--run_time.RESOURCE_NAME è il nome risorsa del trasferimento (chiamato anche configurazione di trasferimento), ad esempio

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7. Se non conosci il nome della risorsa del trasferimento, esegui il comandobq ls --transfer_config --transfer_location=LOCATIONper trovare il nome della risorsa.

API

Utilizza il metodo projects.locations.transferConfigs.startManualRuns e fornisci la risorsa di configurazione del trasferimento utilizzando il parametro parent.

Passaggi successivi

- Scopri di più sui parametri di runtime nei trasferimenti dei report Cloud Storage.

- Scopri di più su BigQuery Data Transfer Service.