Cloud Storage 외부 테이블 만들기

BigQuery는 다음 형식의 Cloud Storage 데이터 쿼리를 지원합니다.

- 쉼표로 구분된 값(CSV)

- JSON(줄바꿈으로 구분)

- Avro

- ORC

- Parquet

- Datastore 내보내기

- Firestore 내보내기

BigQuery는 다음 저장소 등급의 Cloud Storage 데이터 쿼리를 지원합니다.

- Standard

- Nearline

- Coldline

- Archive

Cloud Storage 외부 테이블을 쿼리하려면 외부 테이블과 Cloud Storage 파일 모두에 대한 권한이 있어야 합니다. 가능한 경우 BigLake 테이블을 사용하는 것이 좋습니다. BigLake 테이블은 액세스 위임을 제공하므로 Cloud Storage 데이터를 쿼리하는 데 BigLake 테이블에 대한 권한만 필요합니다.

Cloud Storage에 저장된 데이터를 쿼리할 때는 데이터 세트와 Cloud Storage 버킷의 위치를 고려해야 합니다.

시작하기 전에

사용자에게 이 문서의 각 작업을 수행하는 데 필요한 권한을 부여하는 Identity and Access Management(IAM) 역할을 부여합니다. 태스크를 수행하는 데 필요한 권한(있는 경우)이 태스크의 '필요한 권한' 섹션에 나열됩니다.

필요한 역할

외부 테이블을 만들려면 bigquery.tables.create BigQuery Identity and Access Management(IAM) 권한이 필요합니다.

다음과 같이 사전 정의된 각 Identity and Access Management 역할에 이 권한이 포함되어 있습니다.

- BigQuery 데이터 편집자(

roles/bigquery.dataEditor) - BigQuery 데이터 소유자(

roles/bigquery.dataOwner) - BigQuery 관리자(

roles/bigquery.admin)

또한 데이터가 포함된 Cloud Storage 버킷에 액세스하려면 다음 권한이 필요합니다.

storage.buckets.getstorage.objects.getstorage.objects.list(URI 와일드 카드를 사용하는 경우 필수)

Cloud Storage 스토리지 관리자(roles/storage.admin)는 사전 정의된 Identity and Access Management 역할에 이러한 권한이 포함되어 있습니다.

이러한 역할의 주 구성원이 아닌 경우 관리자에게 액세스 권한을 부여하거나 외부 테이블을 만들도록 요청하세요.

BigQuery의 Identity and Access Management 역할 및 권한에 대한 자세한 내용은 사전 정의된 역할 및 권한을 참조하세요.

Compute Engine 인스턴스의 액세스 범위

Compute Engine 인스턴스에서 Cloud Storage 소스에 연결된 외부 테이블을 쿼리해야 하는 경우 인스턴스에 최소한 Cloud Storage 읽기 전용 액세스 범위(https://www.googleapis.com/auth/devstorage.read_only)가 있어야 합니다.

범위는 Cloud Storage를 포함한 Google Cloud제품에 대한 Compute Engine 인스턴스의 액세스를 제어합니다. 인스턴스에서 실행되는 애플리케이션은 인스턴스에 연결된 서비스 계정을 사용하여 Google Cloud API를 호출합니다.

기본 Compute Engine 서비스 계정으로 실행되도록 Compute Engine 인스턴스를 설정하면 인스턴스에 기본적으로 https://www.googleapis.com/auth/devstorage.read_only 범위를 포함한 여러 기본 범위가 부여됩니다.

대신 커스텀 서비스 계정으로 인스턴스를 설정하는 경우 인스턴스에 https://www.googleapis.com/auth/devstorage.read_only 범위를 명시적으로 부여해야 합니다.

Compute Engine 인스턴스에 범위를 적용하는 방법은 인스턴스의 서비스 계정 및 액세스 범위 변경을 참조하세요. Compute Engine 서비스 계정에 대한 자세한 내용은 서비스 계정을 참조하세요.

파티션을 나누지 않은 데이터의 외부 테이블 만들기

다음 방법으로 외부 데이터 소스에 연결된 영구 테이블을 만들 수 있습니다.

- Google Cloud 콘솔 사용

bq mk명령어 사용tables.insertAPI 메서드를 사용할 때ExternalDataConfiguration생성CREATE EXTERNAL TABLE데이터 정의 언어(DDL) 문을 실행합니다.- 클라이언트 라이브러리 사용

다음 옵션 중 하나를 선택합니다.

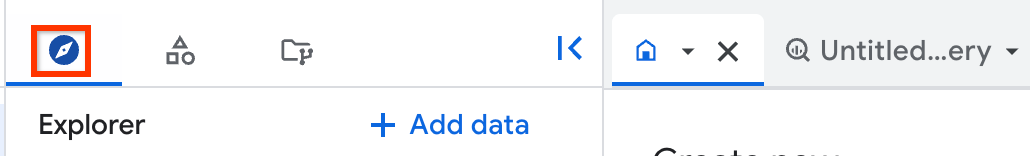

콘솔

BigQuery 페이지로 이동합니다.

왼쪽 창에서 탐색기를 클릭합니다.

왼쪽 창이 표시되지 않으면 왼쪽 창 펼치기를 클릭하여 창을 엽니다.

탐색기 창에서 프로젝트를 펼치고 데이터 세트를 클릭한 다음 데이터 세트를 선택합니다.

작업 옵션을 펼치고 테이블 만들기를 클릭합니다.

소스 섹션에서 다음 세부정보를 지정합니다.

다음 항목으로 테이블 만들기에서 Google Cloud Storage를 선택합니다.

GCS 버킷에서 파일 선택 또는 URI 패턴을 사용에서 사용할 버킷과 파일을 찾아보거나

gs://bucket_name/[folder_name/]file_name형식으로 경로를 입력합니다.Google Cloud 콘솔에서는 URI를 여러 개 지정할 수 없지만 별표(

*) 와일드 카드 문자 하나를 지정하여 여러 파일을 선택할 수 있습니다. 예를 들면gs://mybucket/file_name*입니다. 자세한 내용은 Cloud Storage URI의 와일드 카드 지원을 참조하세요.Cloud Storage 버킷은 만들려는 테이블이 포함된 데이터 세트와 같은 위치에 있어야 합니다.

파일 형식에 파일과 일치하는 형식을 선택합니다.

대상 섹션에서 다음 세부정보를 지정합니다.

프로젝트에서 테이블을 만들 프로젝트를 선택합니다.

데이터 세트에서 테이블을 만들 데이터 세트를 선택합니다.

테이블에 만들려는 테이블의 이름을 입력합니다.

테이블 유형에서 외부 테이블을 선택합니다.

스키마 섹션에서 스키마 자동 감지를 사용 설정하거나 소스 파일이 있는 경우 스키마를 수동으로 지정할 수 있습니다. 소스 파일이 없으면 스키마를 수동으로 지정해야 합니다.

스키마 자동 감지를 사용 설정하려면 자동 감지 옵션을 선택합니다.

스키마를 수동으로 지정하려면 자동 감지 옵션을 선택 해제한 상태로 둡니다. 텍스트로 편집을 사용 설정하고 테이블 스키마를 JSON 배열로 입력합니다.

스키마와 일치하지 않는 추가 열 값이 있는 행을 무시하려면 고급 옵션 섹션을 펼치고 알 수 없는 값을 선택합니다.

테이블 만들기를 클릭합니다.

영구 테이블이 생성된 후에는 기본 BigQuery 테이블인 것처럼 이 테이블에 대해 쿼리를 실행할 수 있습니다. 쿼리가 완료되면 CSV 또는 JSON 파일로 결과를 내보내거나, 테이블로 저장하거나, Google 스프레드시트에 저장할 수 있습니다.

SQL

CREATE EXTERNAL TABLE DDL 문을 실행하여 영구 외부 테이블을 만들 수 있습니다.

스키마를 명시적으로 지정하거나 스키마 자동 감지를 사용하여 외부 데이터에서 스키마를 추론할 수 있습니다.

Google Cloud 콘솔에서 BigQuery 페이지로 이동합니다.

쿼리 편집기에서 다음 문을 입력합니다.

CREATE EXTERNAL TABLE `PROJECT_ID.DATASET.EXTERNAL_TABLE_NAME` OPTIONS ( format ="TABLE_FORMAT", uris = ['BUCKET_PATH'[,...]] );

다음을 바꿉니다.

PROJECT_ID: 테이블을 만들 프로젝트의 이름(예:myproject)DATASET: 테이블을 만들 BigQuery 데이터 세트의 이름(예:mydataset)EXTERNAL_TABLE_NAME: 만들려는 테이블의 이름(예:mytable)TABLE_FORMAT: 만들려는 테이블의 형식(예:PARQUET)BUCKET_PATH: 외부 테이블의 데이터가 포함된 Cloud Storage 버킷 경로(['gs://bucket_name/[folder_name/]file_name']형식)경로에 별표(

*) 와일드 카드 문자 하나를 지정하여 버킷에서 여러 개의 파일을 선택할 수 있습니다. 예를 들면['gs://mybucket/file_name*']입니다. 자세한 내용은 Cloud Storage URI의 와일드 카드 지원을 참조하세요.여러 경로를 제공하여

uris옵션에 대해 여러 버킷을 지정할 수 있습니다.다음 예시에서는 유효한

uris값을 보여줍니다.['gs://bucket/path1/myfile.csv']['gs://bucket/path1/*.csv']['gs://bucket/path1/*', 'gs://bucket/path2/file00*']

여러 파일을 대상으로 하는

uris값을 지정하는 경우 해당하는 모든 파일은 호환되는 스키마를 공유해야 합니다.BigQuery에서 Cloud Storage URI를 사용하는 방법에 대한 자세한 내용은 Cloud Storage 리소스 경로를 참조하세요.

실행을 클릭합니다.

쿼리를 실행하는 방법에 대한 자세한 내용은 대화형 쿼리 실행을 참조하세요.

예시

다음 예시에서는 스키마 자동 감지를 사용하여 Cloud Storage에 저장된 CSV 파일에 연결되는 sales라는 외부 테이블을 만듭니다.

CREATE OR REPLACE EXTERNAL TABLE mydataset.sales OPTIONS ( format = 'CSV', uris = ['gs://mybucket/sales.csv']);

다음 예시에서는 스키마를 명시적으로 지정하고 CSV 파일의 첫 번째 행을 건너뜁니다.

CREATE OR REPLACE EXTERNAL TABLE mydataset.sales ( Region STRING, Quarter STRING, Total_Sales INT64 ) OPTIONS ( format = 'CSV', uris = ['gs://mybucket/sales.csv'], skip_leading_rows = 1);

bq

외부 테이블을 만들려면 bq mk 명령어를 --external_table_definition 플래그와 함께 실행합니다. 이 플래그에는 테이블 정의 파일 경로 또는 인라인 테이블 정의가 포함됩니다.

옵션 1: 테이블 정의 파일

bq mkdef 명령어를 사용하여 테이블 정의 파일을 만든 후 다음과 같이 bq mk 명령어에 파일 경로를 전달합니다.

bq mkdef --source_format=SOURCE_FORMAT \ BUCKET_PATH > DEFINITION_FILE bq mk --table \ --external_table_definition=DEFINITION_FILE \ DATASET_NAME.TABLE_NAME \ SCHEMA

다음을 바꿉니다.

SOURCE_FORMAT: 외부 데이터 소스의 형식. 예를 들면CSV입니다.BUCKET_PATH: 테이블의 데이터가 포함된 Cloud Storage 버킷 경로(gs://bucket_name/[folder_name/]file_pattern형식)file_pattern에 별표(*) 와일드 카드 문자 하나를 지정하여 버킷에서 여러 개의 파일을 선택할 수 있습니다. 예를 들면gs://mybucket/file00*.parquet입니다. 자세한 내용은 Cloud Storage URI의 와일드 카드 지원을 참조하세요.여러 경로를 제공하여

uris옵션에 대해 여러 버킷을 지정할 수 있습니다.다음 예시에서는 유효한

uris값을 보여줍니다.gs://bucket/path1/myfile.csvgs://bucket/path1/*.parquetgs://bucket/path1/file1*,gs://bucket1/path1/*

여러 파일을 대상으로 하는

uris값을 지정하는 경우 해당하는 모든 파일은 호환되는 스키마를 공유해야 합니다.BigQuery에서 Cloud Storage URI를 사용하는 방법에 대한 자세한 내용은 Cloud Storage 리소스 경로를 참조하세요.

DEFINITION_FILE: 로컬 머신에 있는 테이블 정의 파일의 경로입니다.DATASET_NAME: 테이블이 포함된 데이터 세트의 이름입니다.TABLE_NAME: 생성할 테이블의 이름SCHEMA: JSON 스키마 파일 경로를 지정하거나field:data_type,field:data_type,...형식으로 스키마를 지정합니다.

예를 들면 다음과 같습니다.

bq mkdef --source_format=CSV gs://mybucket/sales.csv > mytable_def

bq mk --table --external_table_definition=mytable_def \

mydataset.mytable \

Region:STRING,Quarter:STRING,Total_sales:INTEGER

스키마 자동 감지를 사용하려면 mkdef 명령어에서 --autodetect=true 플래그를 설정하고 스키마를 생략합니다.

bq mkdef --source_format=CSV --autodetect=true \

gs://mybucket/sales.csv > mytable_def

bq mk --table --external_table_definition=mytable_def \

mydataset.mytable

옵션 2: 인라인 테이블 정의

테이블 정의 파일을 만드는 대신 테이블 정의를 bq mk 명령어에 직접 전달할 수 있습니다.

bq mk --table \ --external_table_definition=@SOURCE_FORMAT=BUCKET_PATH \ DATASET_NAME.TABLE_NAME \ SCHEMA

다음을 바꿉니다.

SOURCE_FORMAT: 외부 데이터 소스의 형식예를 들면

CSV입니다.BUCKET_PATH: 테이블의 데이터가 포함된 Cloud Storage 버킷 경로(gs://bucket_name/[folder_name/]file_pattern형식)file_pattern에 별표(*) 와일드 카드 문자 하나를 지정하여 버킷에서 여러 개의 파일을 선택할 수 있습니다. 예를 들면gs://mybucket/file00*.parquet입니다. 자세한 내용은 Cloud Storage URI의 와일드 카드 지원을 참조하세요.여러 경로를 제공하여

uris옵션에 대해 여러 버킷을 지정할 수 있습니다.다음 예시에서는 유효한

uris값을 보여줍니다.gs://bucket/path1/myfile.csvgs://bucket/path1/*.parquetgs://bucket/path1/file1*,gs://bucket1/path1/*

여러 파일을 대상으로 하는

uris값을 지정하는 경우 해당하는 모든 파일은 호환되는 스키마를 공유해야 합니다.BigQuery에서 Cloud Storage URI를 사용하는 방법에 대한 자세한 내용은 Cloud Storage 리소스 경로를 참조하세요.

DATASET_NAME: 테이블이 포함된 데이터 세트의 이름TABLE_NAME: 생성할 테이블의 이름SCHEMA: JSON 스키마 파일 경로를 지정하거나field:data_type,field:data_type,...형식으로 스키마를 지정합니다. 스키마 자동 감지를 사용하려면 이 인수를 생략하세요.

예를 들면 다음과 같습니다.

bq mkdef --source_format=CSV gs://mybucket/sales.csv > mytable_def

bq mk --table --external_table_definition=mytable_def \

mydataset.mytable \

Region:STRING,Quarter:STRING,Total_sales:INTEGER

API

tables.insert API 메서드를 호출하여, 전달한 Table 리소스에 ExternalDataConfiguration을 생성합니다.

schema 속성을 지정하거나 autodetect 속성을 true로 설정하여 지원되는 데이터 소스에 스키마 자동 감지를 사용 설정합니다.

자바

이 샘플을 사용해 보기 전에 BigQuery 빠른 시작: 클라이언트 라이브러리 사용의 Java 설정 안내를 따르세요. 자세한 내용은 BigQuery Java API 참고 문서를 확인하세요.

BigQuery에 인증하려면 애플리케이션 기본 사용자 인증 정보를 설정합니다. 자세한 내용은 클라이언트 라이브러리의 인증 설정을 참조하세요.

Node.js

이 샘플을 사용해 보기 전에 BigQuery 빠른 시작: 클라이언트 라이브러리 사용의 Node.js 설정 안내를 따르세요. 자세한 내용은 BigQuery Node.js API 참고 문서를 확인하세요.

BigQuery에 인증하려면 애플리케이션 기본 사용자 인증 정보를 설정합니다. 자세한 내용은 클라이언트 라이브러리의 인증 설정을 참조하세요.

Python

이 샘플을 사용해 보기 전에 BigQuery 빠른 시작: 클라이언트 라이브러리 사용의 Python 설정 안내를 따르세요. 자세한 내용은 BigQuery Python API 참고 문서를 확인하세요.

BigQuery에 인증하려면 애플리케이션 기본 사용자 인증 정보를 설정합니다. 자세한 내용은 클라이언트 라이브러리의 인증 설정을 참조하세요.

파티션을 나눈 데이터의 외부 테이블 만들기

Cloud Storage에 있는 Hive 파티션을 나눈 데이터용 외부 테이블을 만들 수 있습니다. 외부에서 파티션을 나눈 테이블을 만든 후에는 파티션 키를 변경할 수 없습니다. 파티션을 변경하려면 테이블을 다시 만들어야 합니다.

파티션을 나눈 Hive 데이터의 외부 테이블을 만들려면 다음 옵션 중 하나를 선택합니다.

콘솔

Google Cloud 콘솔에서 BigQuery로 이동합니다.

- 왼쪽 창에서 탐색기를 클릭합니다.

- 탐색기 창에서 프로젝트를 펼치고 데이터 세트를 클릭한 다음 데이터 세트를 선택합니다.

- 작업을 클릭한 다음 테이블 만들기를 클릭합니다. 그러면 테이블 만들기 창이 열립니다.

- 소스 섹션에서 다음 세부정보를 지정합니다.

- 다음 항목으로 테이블 만들기에서 Google Cloud Storage를 선택합니다.

- Cloud Storage 버킷에서 파일 선택에 와일드 카드를 사용하여 Cloud Storage 폴더 경로를 입력합니다.

예를 들면

my_bucket/my_files*입니다. Cloud Storage 버킷은 생성, 추가 또는 덮어쓰려는 테이블이 포함된 데이터 세트와 동일한 위치에 있어야 합니다. - 파일 형식 목록에서 파일 유형을 선택합니다.

- 소스 데이터 파티션 나누기 체크박스를 선택한 후 소스 URI 프리픽스 선택에 대해 Cloud Storage URI 프리픽스를 입력합니다. 예를 들면

gs://my_bucket/my_files입니다. - 파티션 추론 모드 섹션에서 다음 옵션 중 하나를 선택합니다.

- 유형을 자동으로 추론: 파티션 스키마 감지 모드를

AUTO로 설정합니다. - 모든 열은 문자열: 파티션 스키마 감지 모드를

STRINGS로 설정합니다. - 직접 제공하여 파티션 스키마 감지 모드를

CUSTOM으로 설정하고 파티션 키의 스키마 정보를 직접 입력합니다. 자세한 내용은 커스텀 파티션 키 스키마 제공을 참조하세요.

- 유형을 자동으로 추론: 파티션 스키마 감지 모드를

- 선택사항: 이 테이블의 모든 쿼리에 파티션 필터가 필요하면 파티션 필터 필요 체크박스를 선택합니다. 파티션 필터를 필수항목으로 설정하면 비용을 줄이고 성능을 높일 수 있습니다. 자세한 내용은 쿼리에서 파티션 키에 조건자 필터 필요를 참조하세요.

- 대상 섹션에서 다음 세부정보를 지정합니다.

- 프로젝트에서 테이블을 만들 프로젝트를 선택합니다.

- 데이터 세트에서 테이블을 만들 데이터 세트를 선택합니다.

- 테이블에 만들 테이블의 이름을 입력합니다.

- 테이블 유형에서 외부 테이블을 선택합니다.

- 스키마 섹션에 스키마 정의를 입력합니다.

- 스키마의 자동 감지를 사용 설정하려면 자동 감지를 선택합니다.

- 스키마와 일치하지 않는 추가 열 값이 있는 행을 무시하려면 고급 옵션 섹션을 펼치고 알 수 없는 값을 선택합니다.

- 테이블 만들기를 클릭합니다.

SQL

CREATE EXTERNAL TABLE DDL 문을 사용합니다.

다음 예시에서는 Hive 파티션 키의 자동 감지를 사용합니다.

CREATE EXTERNAL TABLE `PROJECT_ID.DATASET.EXTERNAL_TABLE_NAME` WITH PARTITION COLUMNS OPTIONS ( format = 'SOURCE_FORMAT', uris = ['GCS_URIS'], hive_partition_uri_prefix = 'GCS_URI_SHARED_PREFIX', require_hive_partition_filter = BOOLEAN);

다음을 바꿉니다.

SOURCE_FORMAT: 외부 데이터 소스 형식(예:PARQUET)GCS_URIS: 와일드 카드 형식을 사용하는 Cloud Storage 폴더의 경로GCS_URI_SHARED_PREFIX: 와일드 카드가 없는 소스 URI 프리픽스BOOLEAN: 쿼리 시 조건자 필터를 요구할지 여부. 이 플래그는 선택사항입니다. 기본값은false입니다.

다음 예시에서는 커스텀 Hive 파티션 키와 유형을 WITH PARTITION COLUMNS 절에 나열하여 사용합니다.

CREATE EXTERNAL TABLE `PROJECT_ID.DATASET.EXTERNAL_TABLE_NAME` WITH PARTITION COLUMNS (PARTITION_COLUMN_LIST) OPTIONS ( format = 'SOURCE_FORMAT', uris = ['GCS_URIS'], hive_partition_uri_prefix = 'GCS_URI_SHARED_PREFIX', require_hive_partition_filter = BOOLEAN);

다음을 바꿉니다.

PARTITION_COLUMN_LIST: Cloud Storage 폴더 경로에서 다음 형식으로 같은 순서를 따르는 열 목록

KEY1 TYPE1, KEY2 TYPE2

다음 예시에서는 외부에서 파티션을 나눈 테이블을 만듭니다. 스키마 자동 감지를 사용하여 파일 스키마와 파티션을 나눈 하이브 레이아웃을 모두 감지합니다. 외부 경로가 gs://bucket/path/field_1=first/field_2=1/data.parquet이면 파티션 열은 field_1(STRING) 및 field_2(INT64)로 감지됩니다.

CREATE EXTERNAL TABLE dataset.AutoHivePartitionedTable WITH PARTITION COLUMNS OPTIONS ( uris = ['gs://bucket/path/*'], format = 'PARQUET', hive_partition_uri_prefix = 'gs://bucket/path', require_hive_partition_filter = false);

다음 예시에서는 파티션 열을 명시적으로 지정하여 외부에서 파티션을 나눈 테이블을 만듭니다. 이 예시에서는 외부 파일 경로의 패턴이 gs://bucket/path/field_1=first/field_2=1/data.parquet라고 가정합니다.

CREATE EXTERNAL TABLE dataset.CustomHivePartitionedTable WITH PARTITION COLUMNS ( field_1 STRING, -- column order must match the external path field_2 INT64) OPTIONS ( uris = ['gs://bucket/path/*'], format = 'PARQUET', hive_partition_uri_prefix = 'gs://bucket/path', require_hive_partition_filter = false);

bq

먼저 bq mkdef 명령어를 사용하여 테이블 정의 파일을 만듭니다.

bq mkdef \ --source_format=SOURCE_FORMAT \ --hive_partitioning_mode=PARTITIONING_MODE \ --hive_partitioning_source_uri_prefix=GCS_URI_SHARED_PREFIX \ --require_hive_partition_filter=BOOLEAN \ GCS_URIS > DEFINITION_FILE

다음을 바꿉니다.

SOURCE_FORMAT: 외부 데이터 소스의 형식. 예를 들면CSV입니다.PARTITIONING_MODE: Hive 파티션 나누기 모드. 다음 값 중 하나를 사용합니다.AUTO: 키 이름과 유형을 자동으로 감지STRINGS: 키 이름을 문자열로 자동으로 변환CUSTOM: 소스 URI 프리픽스의 키 스키마를 인코딩

GCS_URI_SHARED_PREFIX: 소스 URI 프리픽스BOOLEAN: 쿼리 시 조건자 필터를 요구할지 여부를 지정합니다. 이 플래그는 선택사항입니다. 기본값은false입니다.GCS_URIS: 와일드 카드 형식을 사용하는 Cloud Storage 폴더의 경로DEFINITION_FILE: 로컬 머신에 있는 테이블 정의 파일의 경로

PARTITIONING_MODE가 CUSTOM이면 다음 형식을 사용하여 소스 URI 프리픽스에 파티션 키 스키마를 포함합니다.

--hive_partitioning_source_uri_prefix=GCS_URI_SHARED_PREFIX/{KEY1:TYPE1}/{KEY2:TYPE2}/...

테이블 정의 파일을 만든 후 bq mk 명령어를 사용하여 외부 테이블을 만듭니다.

bq mk --external_table_definition=DEFINITION_FILE \ DATASET_NAME.TABLE_NAME \ SCHEMA

다음을 바꿉니다.

DEFINITION_FILE: 테이블 정의 파일의 경로DATASET_NAME: 테이블이 포함된 데이터 세트의 이름TABLE_NAME: 생성할 테이블의 이름SCHEMA: JSON 스키마 파일 경로를 지정하거나field:data_type,field:data_type,...형식으로 스키마를 지정합니다. 스키마 자동 감지를 사용하려면 이 인수를 생략하세요.

예시

다음 예시에서는 AUTO Hive 파티션 나누기 모드를 사용합니다.

bq mkdef --source_format=CSV \

--hive_partitioning_mode=AUTO \

--hive_partitioning_source_uri_prefix=gs://myBucket/myTable \

gs://myBucket/myTable/* > mytable_def

bq mk --external_table_definition=mytable_def \

mydataset.mytable \

Region:STRING,Quarter:STRING,Total_sales:INTEGER

다음 예시에서는 STRING Hive 파티션 나누기 모드를 사용합니다.

bq mkdef --source_format=CSV \

--hive_partitioning_mode=STRING \

--hive_partitioning_source_uri_prefix=gs://myBucket/myTable \

gs://myBucket/myTable/* > mytable_def

bq mk --external_table_definition=mytable_def \

mydataset.mytable \

Region:STRING,Quarter:STRING,Total_sales:INTEGER

다음 예시에서는 CUSTOM Hive 파티션 나누기 모드를 사용합니다.

bq mkdef --source_format=CSV \

--hive_partitioning_mode=CUSTOM \

--hive_partitioning_source_uri_prefix=gs://myBucket/myTable/{dt:DATE}/{val:STRING} \

gs://myBucket/myTable/* > mytable_def

bq mk --external_table_definition=mytable_def \

mydataset.mytable \

Region:STRING,Quarter:STRING,Total_sales:INTEGER

API

BigQuery API를 사용하여 Hive 파티션 나누기를 설정하려면 테이블 정의 파일을 만들 때 ExternalDataConfiguration 객체에 hivePartitioningOptions 객체를 포함합니다.

hivePartitioningOptions.mode 필드를 CUSTOM로 설정한 경우, hivePartitioningOptions.sourceUriPrefix 필드에 파티션 키 스키마를 인코딩해야 합니다(예: gs://BUCKET/PATH_TO_TABLE/{KEY1:TYPE1}/{KEY2:TYPE2}/...).

쿼리 시 조건자 필터를 사용하도록 하려면 hivePartitioningOptions.requirePartitionFilter 필드를 true로 설정합니다.

자바

이 샘플을 사용해 보기 전에 BigQuery 빠른 시작: 클라이언트 라이브러리 사용의 Java 설정 안내를 따르세요. 자세한 내용은 BigQuery Java API 참고 문서를 확인하세요.

BigQuery에 인증하려면 애플리케이션 기본 사용자 인증 정보를 설정합니다. 자세한 내용은 클라이언트 라이브러리의 인증 설정을 참조하세요.

외부 테이블 쿼리

자세한 내용은 외부 테이블에서 Cloud Storage 데이터 쿼리를 참조하세요.

외부 테이블을 BigLake로 업그레이드

외부 테이블을 연결에 연결하여 Cloud Storage에 따라 테이블을 BigLake 테이블로 업그레이드할 수 있습니다. BigLake 테이블에서 메타데이터 캐싱을 사용하려면 이에 대한 설정을 동시에 지정할 수 있습니다. 소스 형식 및 소스 URI와 같은 테이블 세부정보를 가져오려면 테이블 정보 가져오기를 참조하세요.

외부 테이블을 BigLake 테이블로 업데이트하려면 다음 옵션 중 하나를 선택합니다.

SQL

CREATE OR REPLACE EXTERNAL TABLE DDL 문을 사용하여 테이블을 업데이트합니다.

Google Cloud 콘솔에서 BigQuery 페이지로 이동합니다.

쿼리 편집기에서 다음 문을 입력합니다.

CREATE OR REPLACE EXTERNAL TABLE `PROJECT_ID.DATASET.EXTERNAL_TABLE_NAME` WITH CONNECTION {`REGION.CONNECTION_ID` | DEFAULT} OPTIONS( format ="TABLE_FORMAT", uris = ['BUCKET_PATH'], max_staleness = STALENESS_INTERVAL, metadata_cache_mode = 'CACHE_MODE' );

다음을 바꿉니다.

PROJECT_ID: 테이블이 포함된 프로젝트 이름DATASET: 테이블이 포함된 데이터 세트의 이름EXTERNAL_TABLE_NAME: 테이블의 이름REGION: 연결이 포함된 리전CONNECTION_ID: 사용할 연결의 이름기본 연결을 사용하려면

REGION.CONNECTION_ID가 포함된 연결 문자열 대신DEFAULT를 지정합니다.TABLE_FORMAT: 테이블에 사용되는 형식테이블을 업데이트할 때는 이를 변경할 수 없습니다.

BUCKET_PATH: 외부 테이블의 데이터가 포함된 Cloud Storage 버킷 경로(['gs://bucket_name/[folder_name/]file_name']형식)경로에 별표(

*) 와일드 카드 문자 하나를 지정하여 버킷에서 여러 개의 파일을 선택할 수 있습니다. 예를 들면['gs://mybucket/file_name*']입니다. 자세한 내용은 Cloud Storage URI의 와일드 카드 지원을 참조하세요.여러 경로를 제공하여

uris옵션에 대해 여러 버킷을 지정할 수 있습니다.다음 예시에서는 유효한

uris값을 보여줍니다.['gs://bucket/path1/myfile.csv']['gs://bucket/path1/*.csv']['gs://bucket/path1/*', 'gs://bucket/path2/file00*']

여러 파일을 대상으로 하는

uris값을 지정하는 경우 해당하는 모든 파일은 호환되는 스키마를 공유해야 합니다.BigQuery에서 Cloud Storage URI를 사용하는 방법에 대한 자세한 내용은 Cloud Storage 리소스 경로를 참조하세요.

STALENESS_INTERVAL: 캐시된 메타데이터가 테이블에 대한 작업에서 사용되는지 여부와 작업이 사용하기 위해 캐시된 메타데이터가 작업에서 사용되려면 얼마나 최신이어야 하는지를 지정합니다.메타데이터 캐싱 고려사항에 대한 자세한 내용은 성능을 위한 메타데이터 캐싱을 참조하세요.

메타데이터 캐싱을 사용 중지하려면 0을 지정합니다. 이 값이 기본값입니다.

메타데이터 캐싱을 사용 설정하려면 30분에서 7일 사이의 간격 리터럴 값을 지정합니다. 예를 들어 4시간 비활성 간격의 경우

INTERVAL 4 HOUR를 지정합니다. 이 값을 사용하면 지난 4시간 이내에 새로고침된 경우 테이블에 대한 작업이 캐시된 메타데이터를 사용합니다. 캐시된 메타데이터가 이보다 오래된 경우 작업이 대신 Cloud Storage에서 메타데이터를 검색합니다.CACHE_MODE: 메타데이터 캐시를 자동 또는 수동으로 새로고침할지 지정합니다.메타데이터 캐싱 고려사항에 대한 자세한 내용은 성능을 위한 메타데이터 캐싱을 참조하세요.

시스템 정의 간격(일반적으로 30~60분)으로 메타데이터 캐시를 새로고침하려면

AUTOMATIC으로 설정합니다.지정한 일정에 따라 메타데이터 캐시를 새로고침하려면

MANUAL로 설정합니다. 이 경우BQ.REFRESH_EXTERNAL_METADATA_CACHE시스템 프로시져를 호출하여 캐시를 새로고침할 수 있습니다.STALENESS_INTERVAL이 0보다 큰 값으로 설정된 경우CACHE_MODE를 설정해야 합니다.

실행을 클릭합니다.

쿼리를 실행하는 방법에 대한 자세한 내용은 대화형 쿼리 실행을 참조하세요.

bq

bq mkdef 및 bq update 명령어를 사용하여 테이블을 업데이트합니다.

변경할 테이블의 측면을 설명하는 외부 테이블 정의를 생성합니다.

bq mkdef --connection_id=PROJECT_ID.REGION.CONNECTION_ID \ --source_format=TABLE_FORMAT \ --metadata_cache_mode=CACHE_MODE \ "BUCKET_PATH" > /tmp/DEFINITION_FILE

다음을 바꿉니다.

PROJECT_ID: 연결이 포함된 프로젝트 이름REGION: 연결이 포함된 리전CONNECTION_ID: 사용할 연결의 이름TABLE_FORMAT: 테이블에 사용되는 형식. 테이블을 업데이트할 때는 이를 변경할 수 없습니다.CACHE_MODE: 메타데이터 캐시를 자동 또는 수동으로 새로고침할지 지정합니다. 메타데이터 캐싱 고려사항에 대한 자세한 내용은 성능을 위한 메타데이터 캐싱을 참조하세요.시스템 정의 간격(일반적으로 30~60분)으로 메타데이터 캐시를 새로고침하려면

AUTOMATIC으로 설정합니다.지정한 일정에 따라 메타데이터 캐시를 새로고침하려면

MANUAL로 설정합니다. 이 경우BQ.REFRESH_EXTERNAL_METADATA_CACHE시스템 프로시저를 호출하여 캐시를 새로고침할 수 있습니다.STALENESS_INTERVAL이 0보다 큰 값으로 설정된 경우CACHE_MODE를 설정해야 합니다.BUCKET_PATH: 외부 테이블의 데이터가 포함된 Cloud Storage 버킷 경로(gs://bucket_name/[folder_name/]file_name형식)경로에 별표(

*) 와일드카드 문자 하나를 지정하여 버킷에서 선택한 파일을 제한할 수 있습니다. 예를 들면gs://mybucket/file_name*입니다. 자세한 내용은 Cloud Storage URI의 와일드 카드 지원을 참조하세요.여러 경로를 제공하여

uris옵션에 대해 여러 버킷을 지정할 수 있습니다.다음 예시에서는 유효한

uris값을 보여줍니다.gs://bucket/path1/myfile.csvgs://bucket/path1/*.csvgs://bucket/path1/*,gs://bucket/path2/file00*

여러 파일을 대상으로 하는

uris값을 지정하는 경우 해당하는 모든 파일은 호환되는 스키마를 공유해야 합니다.BigQuery에서 Cloud Storage URI를 사용하는 방법에 대한 자세한 내용은 Cloud Storage 리소스 경로를 참조하세요.

DEFINITION_FILE: 만들려는 테이블 정의 파일의 이름

새 외부 테이블 정의를 사용하여 테이블을 업데이트합니다.

bq update --max_staleness=STALENESS_INTERVAL \ --external_table_definition=/tmp/DEFINITION_FILE \ PROJECT_ID:DATASET.EXTERNAL_TABLE_NAME

다음을 바꿉니다.

STALENESS_INTERVAL: 캐시된 메타데이터가 테이블에 대한 작업에서 사용되는지 여부와 작업이 사용하기 위해 캐시된 메타데이터가 작업에서 사용되려면 얼마나 최신이어야 하는지를 지정합니다. 메타데이터 캐싱 고려사항에 대한 자세한 내용은 성능을 위한 메타데이터 캐싱을 참조하세요.메타데이터 캐싱을 사용 중지하려면 0을 지정합니다. 이 값이 기본값입니다.

메타데이터 캐싱을 사용 설정하려면

INTERVAL데이터 유형 문서에 설명된Y-M D H:M:S형식을 사용하여 30분에서 7일 사이의 간격 값을 지정합니다. 예를 들어 4시간 비활성 간격의 경우0-0 0 4:0:0을 지정합니다. 이 값을 사용하면 지난 4시간 이내에 새로고침된 경우 테이블에 대한 작업이 캐시된 메타데이터를 사용합니다. 캐시된 메타데이터가 이보다 오래된 경우 작업이 대신 Cloud Storage에서 메타데이터를 검색합니다.DEFINITION_FILE: 만들거나 업데이트한 테이블 정의 파일의 이름PROJECT_ID: 테이블이 포함된 프로젝트 이름DATASET: 테이블이 포함된 데이터 세트의 이름EXTERNAL_TABLE_NAME: 테이블의 이름

Cloud Storage 리소스 경로

Cloud Storage 데이터 소스를 기반으로 외부 테이블을 만들 때는 데이터 경로를 제공해야 합니다.

Cloud Storage 리소스 경로에는 버킷 이름과 객체(파일 이름)가 포함됩니다. 예를 들어 Cloud Storage 버킷 이름이 mybucket이고 데이터 파일 이름이 myfile.csv라면 리소스 경로는 gs://mybucket/myfile.csv가 됩니다.

BigQuery는 처음 이중 슬래시 다음에 슬래시 여러 개가 연속으로 포함된 Cloud Storage 리소스 경로를 지원하지 않습니다.

Cloud Storage 객체 이름에는 연속된 슬래시('/') 문자 여러 개가 포함될 수 있습니다. 하지만 BigQuery는 연속된 슬래시 여러 개를 단일 슬래시로 변환합니다. 예를 들어 gs://bucket/my//object//name 리소스 경로는 Cloud Storage에서는 유효하지만 BigQuery에서는 작동하지 않습니다.

Cloud Storage 리소스 경로를 검색하려면 다음 안내를 따르세요.

Cloud Storage 콘솔을 엽니다.

소스 데이터가 포함된 객체(파일) 위치로 이동합니다.

객체의 이름을 클릭합니다.

객체 세부정보 페이지가 열립니다.

gsutil URI 필드에 제공된 값(

gs://로 시작)을 복사합니다.

Cloud Storage URI의 와일드 카드 지원

데이터가 여러 개의 파일로 분리되어 있는 경우 별표(*) 와일드 카드를 사용하여 여러 파일을 선택할 수 있습니다. 별표 와일드 카드를 사용하려면 다음 규칙을 따라야 합니다.

- 와일드 카드는 객체 이름 중간이나 끝에 입력할 수 있습니다.

- 별표 여러 개를 사용하는 것은 지원되지 않습니다. 예를 들어

gs://mybucket/fed-*/temp/*.csv경로는 유효하지 않습니다. - 버킷 이름에 별표를 사용하는 것은 지원되지 않습니다.

예를 들면 다음과 같습니다.

다음 예시에서는 프리픽스

gs://mybucket/fed-samples/fed-sample로 시작하는 모든 폴더의 모든 파일을 선택하는 방법을 보여줍니다.gs://mybucket/fed-samples/fed-sample*다음 예시에서는

fed-samples라는 폴더와fed-samples의 모든 하위 폴더에 있는.csv확장자가 있는 파일만 선택하는 방법을 보여줍니다.gs://mybucket/fed-samples/*.csv다음 예시에서는

fed-samples라는 폴더에 있는 이름 지정 패턴이fed-sample*.csv인 파일을 선택하는 방법을 보여줍니다. 이 예시에서는fed-samples하위 폴더에 있는 파일을 선택하지 않습니다.gs://mybucket/fed-samples/fed-sample*.csv

bq 명령줄 도구를 사용할 때 일부 플랫폼에서 별표를 이스케이프 처리해야 할 수도 있습니다.

Datastore 또는 Firestore 내보내기에 연결된 외부 테이블을 만들 때는 별표 와일드 카드를 사용할 수 없습니다.

가격 책정

BigQuery 요청에는 다음과 같은 Cloud Storage 검색 및 데이터 전송 요금이 적용됩니다.

- Nearline, Coldline, Archive 스토리지 클래스 검색 요금은 기존 가격 책정 문서 및 검색 SKU에 따라 청구됩니다.

- 한 위치의 BigQuery 작업이 다른 위치의 Cloud Storage 버킷에 저장된 데이터를 읽을 때 리전 간 네트워크 데이터 전송 요금이 청구됩니다. 이 요금은 다음 SKU로 처리됩니다.

- Google Cloud 대륙 1과 대륙 2 간의 스토리지 데이터 전송 예를 들어

us-central1에서europe-west1로 데이터를 전송하는 경우 북미와 유럽 간Google Cloud 스토리지 데이터 전송을 참고하세요. - 네트워크 데이터 전송 Google Cloud 대륙 내 리전 간 예를 들어

us-east4에서US로 데이터를 전송하는 경우 북미 내 네트워크 데이터 전송 Google Cloud 리전 간을 참고하세요.

- Google Cloud 대륙 1과 대륙 2 간의 스토리지 데이터 전송 예를 들어

제한사항

외부 테이블에 적용되는 제한사항에 대한 자세한 내용은 외부 테이블 제한사항을 참조하세요.

다음 단계

- 외부 테이블 알아보기

- BigLake 테이블 알아보기