Dalam tutorial ini, Anda akan mengimpor model TensorFlow ke set data BigQuery ML. Kemudian, Anda menggunakan kueri SQL untuk membuat prediksi dari model yang diimpor.

Membuat set data

Buat set data BigQuery untuk menyimpan model ML Anda.

Konsol

Di konsol Google Cloud , buka halaman BigQuery.

Di panel Explorer, klik nama project Anda.

Klik View actions > Create dataset.

Di halaman Create dataset, lakukan hal berikut:

Untuk Dataset ID, masukkan

bqml_tutorial.Untuk Location type, pilih Multi-region, lalu pilih US (multiple regions in United States).

Jangan ubah setelan default yang tersisa, lalu klik Create dataset.

bq

Untuk membuat set data baru, gunakan perintah bq mk dengan flag --location. Untuk daftar lengkap kemungkinan parameter, lihat referensi

perintah bq mk --dataset.

Buat set data bernama

bqml_tutorialdengan lokasi data yang ditetapkan keUSdan deskripsiBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Perintah ini menggunakan pintasan

-d, bukan flag--dataset. Jika Anda menghapus-ddan--dataset, perintah defaultnya adalah membuat set data.Pastikan set data telah dibuat:

bq ls

API

Panggil metode datasets.insert dengan resource set data yang ditentukan.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

BigQuery DataFrames

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan BigQuery DataFrames di Panduan memulai BigQuery menggunakan BigQuery DataFrames. Untuk mengetahui informasi selengkapnya, lihat dokumentasi referensi BigQuery DataFrames.

Untuk melakukan autentikasi ke BigQuery, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Mengimpor model TensorFlow

Langkah-langkah berikut menunjukkan cara mengimpor model dari Cloud Storage.

Jalur ke model adalah

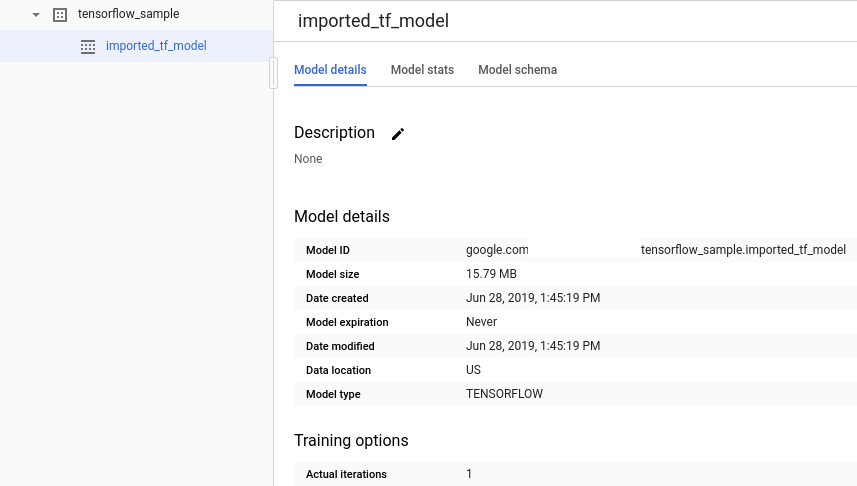

gs://cloud-training-demos/txtclass/export/exporter/1549825580/*. Nama model yang diimpor adalah imported_tf_model.

Perhatikan bahwa URI Cloud Storage diakhiri dengan karakter pengganti (*).

Karakter ini menunjukkan bahwa BigQuery ML harus mengimpor aset apa pun yang terkait dengan model tersebut.

Model yang diimpor adalah model pengklasifikasi teks TensorFlow yang memprediksi situs yang memublikasikan judul artikel tertentu.

Untuk mengimpor model TensorFlow ke set data, ikuti langkah-langkah berikut.

Konsol

Di konsol Google Cloud , buka halaman BigQuery.

Untuk Buat baru, klik Kueri SQL.

Di editor kueri, masukkan pernyataan

CREATE MODELini, lalu klik Jalankan.CREATE OR REPLACE MODEL `bqml_tutorial.imported_tf_model` OPTIONS (MODEL_TYPE='TENSORFLOW', MODEL_PATH='gs://cloud-training-demos/txtclass/export/exporter/1549825580/*')

Setelah operasi selesai, Anda akan melihat pesan seperti

Successfully created model named imported_tf_model.Model baru Anda akan muncul di panel Resources. Model ditunjukkan dengan ikon model:

.

.Jika Anda memilih model baru di panel Resources, informasi tentang model akan muncul di bawah Query editor.

bq

Impor model TensorFlow dari Cloud Storage dengan memasukkan pernyataan

CREATE MODELberikut.bq query --use_legacy_sql=false \ "CREATE OR REPLACE MODEL `bqml_tutorial.imported_tf_model` OPTIONS (MODEL_TYPE='TENSORFLOW', MODEL_PATH='gs://cloud-training-demos/txtclass/export/exporter/1549825580/*')"

Setelah mengimpor model, verifikasi bahwa model muncul di set data.

bq ls -m bqml_tutorial

Outputnya mirip dengan hal berikut ini:

tableId Type ------------------- ------- imported_tf_model MODEL

API

Masukkan tugas baru dan isi properti jobs#configuration.query di isi permintaan.

{ "query": "CREATE MODEL `PROJECT_ID:bqml_tutorial.imported_tf_model` OPTIONS(MODEL_TYPE='TENSORFLOW' MODEL_PATH='gs://cloud-training-demos/txtclass/export/exporter/1549825580/*')" }

Ganti PROJECT_ID dengan nama project dan set data Anda.

BigQuery DataFrames

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan BigQuery DataFrames di Panduan memulai BigQuery menggunakan BigQuery DataFrames. Untuk mengetahui informasi selengkapnya, lihat dokumentasi referensi BigQuery DataFrames.

Untuk melakukan autentikasi ke BigQuery, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Impor model menggunakan objek TensorFlowModel.

Untuk mengetahui informasi selengkapnya tentang cara mengimpor model TensorFlow ke BigQuery ML, termasuk persyaratan format dan penyimpanan, lihat pernyataan CREATE MODEL untuk mengimpor model TensorFlow.

Membuat prediksi dengan model TensorFlow yang diimpor

Setelah mengimpor model TensorFlow, Anda menggunakan

fungsi ML.PREDICT

untuk membuat prediksi dengan model.

Kueri berikut menggunakan imported_tf_model untuk membuat prediksi menggunakan data

input dari tabel full dalam set data publik hacker_news. Dalam kueri, fungsi serving_input_fn model TensorFlow menentukan bahwa model mengharapkan string input tunggal bernama input. Subkueri menetapkan

alias input ke kolom title dalam pernyataan SELECT subkueri.

Untuk membuat prediksi dengan model TensorFlow yang diimpor, ikuti langkah-langkah berikut.

Konsol

Di konsol Google Cloud , buka halaman BigQuery.

Di bagian Buat baru, klik Kueri SQL.

Di editor kueri, masukkan kueri ini yang menggunakan fungsi

ML.PREDICT.SELECT * FROM ML.PREDICT(MODEL `bqml_tutorial.imported_tf_model`, ( SELECT title AS input FROM bigquery-public-data.hacker_news.full ) )

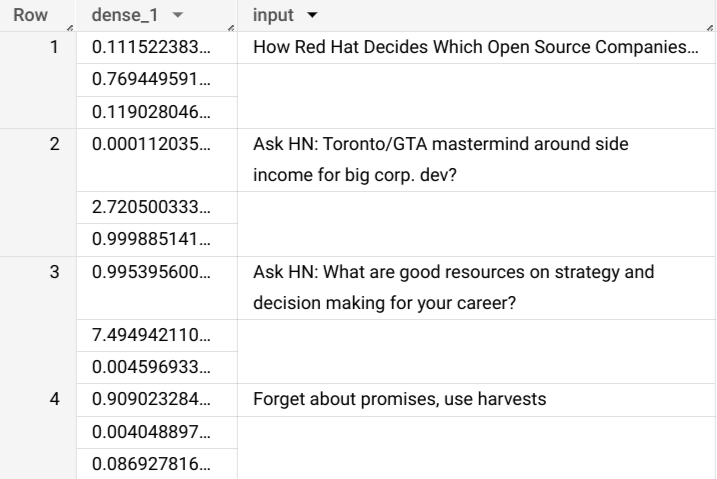

Hasil kueri akan terlihat seperti ini:

bq

Masukkan perintah ini untuk menjalankan kueri yang menggunakan ML.PREDICT.

bq query \ --use_legacy_sql=false \ 'SELECT * FROM ML.PREDICT( MODEL `bqml_tutorial.imported_tf_model`, (SELECT title AS input FROM `bigquery-public-data.hacker_news.full`))'

Hasilnya akan terlihat seperti ini:

+------------------------------------------------------------------------+----------------------------------------------------------------------------------+ | dense_1 | input | +------------------------------------------------------------------------+----------------------------------------------------------------------------------+ | ["0.6251608729362488","0.2989124357700348","0.07592673599720001"] | How Red Hat Decides Which Open Source Companies t... | | ["0.014276246540248394","0.972910463809967","0.01281337533146143"] | Ask HN: Toronto/GTA mastermind around side income for big corp. dev? | | ["0.9821603298187256","1.8601855117594823E-5","0.01782100833952427"] | Ask HN: What are good resources on strategy and decision making for your career? | | ["0.8611106276512146","0.06648492068052292","0.07240450382232666"] | Forget about promises, use harvests | +------------------------------------------------------------------------+----------------------------------------------------------------------------------+

API

Masukkan tugas baru dan isi properti jobs#configuration.query seperti pada isi permintaan. Ganti project_id dengan nama project Anda.

{ "query": "SELECT * FROM ML.PREDICT(MODEL `project_id.bqml_tutorial.imported_tf_model`, (SELECT * FROM input_data))" }

BigQuery DataFrames

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan BigQuery DataFrames di Panduan memulai BigQuery menggunakan BigQuery DataFrames. Untuk mengetahui informasi selengkapnya, lihat dokumentasi referensi BigQuery DataFrames.

Untuk melakukan autentikasi ke BigQuery, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

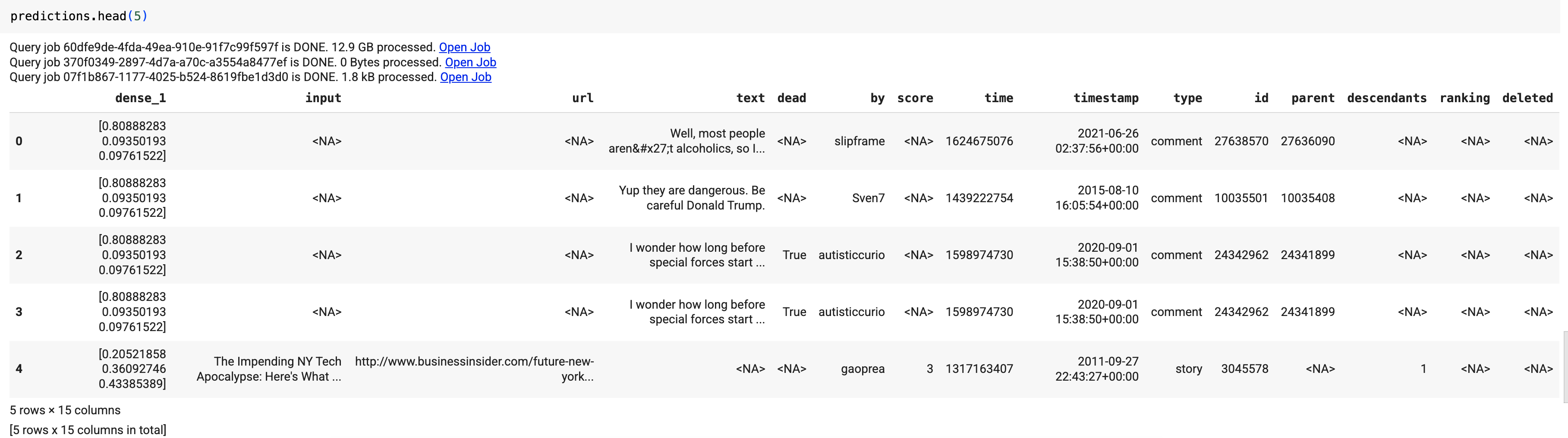

Gunakan fungsi predict untuk menjalankan model TensorFlow:

Hasilnya akan terlihat seperti ini:

Dalam hasil kueri, kolom dense_1 berisi array nilai probabilitas, dan kolom input berisi nilai string yang sesuai dari tabel input. Setiap nilai elemen array mewakili

probabilitas bahwa string input yang sesuai adalah judul artikel

dari publikasi tertentu.