Menggunakan plugin BigQuery JupyterLab

Untuk meminta masukan atau dukungan terkait fitur ini, kirim email ke bigquery-ide-plugin@google.com.

Dokumen ini menunjukkan cara menginstal dan menggunakan plugin BigQuery JupyterLab untuk melakukan hal berikut:

- Jelajahi data BigQuery Anda.

- Gunakan BigQuery DataFrames API.

- Deploy notebook BigQuery DataFrames ke Cloud Composer.

Plugin BigQuery JupyterLab mencakup semua fungsi plugin Dataproc JupyterLab, seperti membuat template runtime Dataproc Serverless, meluncurkan dan mengelola notebook, mengembangkan dengan Apache Spark, men-deploy kode, dan mengelola resource.

Menginstal plugin BigQuery JupyterLab

Untuk menginstal dan menggunakan plugin BigQuery JupyterLab, ikuti langkah-langkah berikut:

Di terminal lokal, periksa untuk memastikan Anda telah menginstal Python 3.8 atau yang lebih baru di sistem Anda:

python3 --versionDi terminal lokal Anda, lakukan inisialisasi gcloud CLI:

gcloud initInstal Pipenv, alat lingkungan virtual Python:

pip3 install pipenvBuat lingkungan virtual baru:

pipenv shellInstal JupyterLab di lingkungan virtual baru:

pipenv install jupyterlabInstal plugin BigQuery JupyterLab:

pipenv install bigquery-jupyter-pluginJika versi JupyterLab yang Anda instal lebih lama dari 4.0.0, aktifkan ekstensi plugin:

jupyter server extension enable bigquery_jupyter_pluginLuncurkan JupyterLab:

jupyter labJupyterLab akan terbuka di browser Anda.

Memperbarui setelan project dan region

Secara default, sesi Anda berjalan di project dan region yang Anda tetapkan saat menjalankan gcloud init. Untuk mengubah setelan project dan region untuk sesi Anda, lakukan hal berikut:

- Di menu JupyterLab, klik Settings > Google BigQuery Settings.

Anda harus memulai ulang plugin agar perubahan diterapkan.

Jelajahi data

Untuk menggunakan data BigQuery di JupyterLab, lakukan hal berikut:

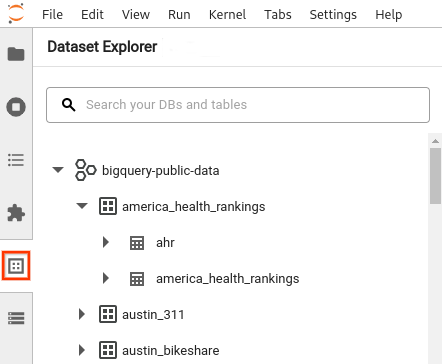

- Di sidebar JupyterLab, buka panel Dataset Explorer: klik ikon

dataset.

dataset. Untuk meluaskan project, di panel Dataset Explorer, klik panah perluasan di samping nama project.

Panel Dataset Explorer menampilkan semua set data dalam project yang berada di region BigQuery yang Anda konfigurasi untuk sesi tersebut. Anda dapat berinteraksi dengan project dan set data dengan berbagai cara:

- Untuk melihat informasi tentang set data, klik nama set data.

- Untuk menampilkan semua tabel dalam set data, klik panah peluas di samping set data.

- Untuk melihat informasi tentang tabel, klik nama tabel.

- Untuk mengubah project atau region BigQuery, perbarui setelan Anda.

Menjalankan notebook

Untuk membuat kueri data BigQuery dari JupyterLab, lakukan hal berikut:

- Untuk membuka halaman peluncur, klik File > New Launcher.

- Di bagian BigQuery Notebooks, klik kartu BigQuery DataFrames. Notebook baru akan terbuka dan menunjukkan cara memulai BigQuery DataFrames.

Notebook BigQuery DataFrames mendukung pengembangan Python di kernel Python lokal. Operasi BigQuery DataFrames dieksekusi dari jarak jauh di BigQuery, tetapi kode lainnya dieksekusi secara lokal di komputer Anda. Saat operasi dijalankan di BigQuery, ID tugas kueri dan link ke tugas akan muncul di bawah sel kode.

- Untuk melihat tugas di konsol Google Cloud , klik Open Job.

Men-deploy notebook BigQuery DataFrames

Anda dapat men-deploy notebook BigQuery DataFrames ke Cloud Composer dengan menggunakan template runtime Dataproc Serverless. Anda harus menggunakan versi runtime 2.1 atau yang lebih baru.

- Di notebook JupyterLab Anda, klik calendar_monthJob Scheduler.

- Untuk Nama tugas, masukkan nama unik untuk tugas Anda.

- Untuk Environment, masukkan nama lingkungan Cloud Composer tempat Anda ingin men-deploy tugas.

- Jika notebook Anda diparameterkan, tambahkan parameter.

- Masukkan nama Template runtime serverless.

- Untuk menangani kegagalan eksekusi notebook, masukkan bilangan bulat untuk Jumlah percobaan ulang dan nilai (dalam menit) untuk Penundaan percobaan ulang.

Pilih notifikasi eksekusi yang akan dikirim, lalu masukkan penerima.

Notifikasi dikirim menggunakan konfigurasi SMTP Airflow.

Pilih jadwal untuk notebook.

Klik Buat.

Jika berhasil dijadwalkan, notebook Anda akan muncul dalam daftar tugas terjadwal di lingkungan Cloud Composer yang Anda pilih.

Langkah berikutnya

- Coba panduan memulai BigQuery DataFrames.

- Pelajari lebih lanjut BigQuery DataFrames Python API.

- Gunakan JupyterLab untuk sesi notebook dan batch serverless dengan Dataproc.