Generative KI – Übersicht

In diesem Dokument werden die von BigQuery ML unterstützten Funktionen für generative künstliche Intelligenz (KI) beschrieben. Mit diesen Features können Sie KI-Aufgaben in BigQuery ML mithilfe von vortrainierten Modellen von Vertex AI ausführen. Zu den unterstützten Aufgaben gehören folgende:

Wenn Sie auf ein Vertex AI-Modell zugreifen, um eine dieser Funktionen auszuführen, erstellen Sie in BigQuery ML ein Remote-Modell, das den Endpunkt des Vertex AI-Modells darstellt. Nachdem Sie ein Remote-Modell für das Vertex AI-Modell erstellt haben, das Sie verwenden möchten, können Sie die Funktionalität dieses Modells nutzen. Dazu führen Sie eine BigQuery ML-Funktion für das Remote-Modell aus.

Mit diesem Ansatz können Sie die Funktionen dieser Vertex AI-Modelle in SQL-Abfragen verwenden, um BigQuery-Daten zu analysieren.

Workflow

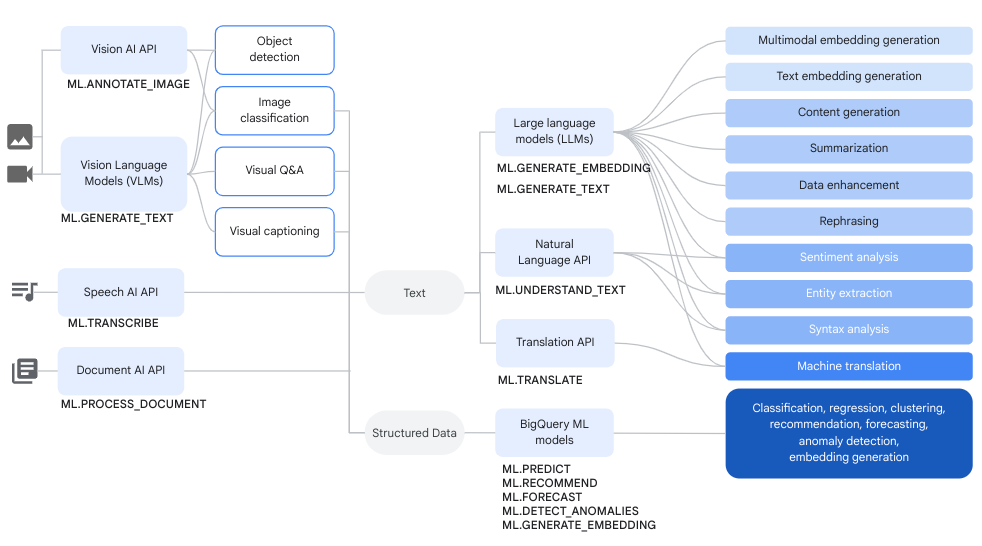

Sie können Remote-Modelle über Vertex AI-Modelle und Remote-Modelle über Cloud AI-Dienste zusammen mit BigQuery ML-Funktionen zum Ausführen komplexer Datenanalyse- und generativer KI-Aufgaben verwenden.

Das folgende Diagramm zeigt einige typische Workflows, in denen Sie diese Funktionen zusammen verwenden können:

Textgenerierung

Die Textgenerierung ist eine Form der generativen KI, bei der Text entweder auf Grundlage eines Prompts oder einer Datenanalyse generiert wird. Sie können Text sowohl mit Text- als auch mit multimodalen Daten generieren.

Typische Anwendungsfälle für die Textgenerierung:

- Erstellung von Creative-Inhalten

- Code wird generiert.

- Chat- oder E-Mail-Antworten generieren

- Brainstorming, z. B. Vorschläge für zukünftige Produkte oder Dienstleistungen.

- Personalisierung von Inhalten, z. B. Produktvorschläge

- Daten werden klassifiziert, indem Inhalten ein oder mehrere Labels zugewiesen werden, um sie in Kategorien zu sortieren.

- Identifizieren Sie die wichtigsten in den Inhalten ausgedrückten Sentiments.

- Die wichtigsten Ideen oder Eindrücke zusammenfassen, die durch die Inhalte vermittelt werden.

- Identifizieren einer oder mehrerer wichtiger Entitäten in Text- oder visuellen Daten.

- Übersetzung von Text- oder Audiodaten in eine andere Sprache.

- Generiert Text, der mit dem gesprochenen Inhalt in Audiodaten übereinstimmt.

- Untertitel für visuelle Daten oder Antworten auf Fragen zu visuellen Daten

Die Datenanreicherung ist ein gängiger nächster Schritt nach der Textgenerierung. Dabei werden die Erkenntnisse aus der ersten Analyse durch die Kombination mit zusätzlichen Daten erweitert. So können Sie beispielsweise Bilder von Haushaltsgegenständen analysieren, um Text für eine design_type-Spalte zu generieren, sodass der SKU der Haushaltsgegenstände eine Beschreibung wie mid-century modern oder farmhouse zugeordnet ist.

Unterstützte Modelle

Für generative KI-Aufgaben können Sie in BigQuery ML Remote-Modelle verwenden, um auf Modelle zu verweisen, die in Vertex AI bereitgestellt oder gehostet werden. Sie können die folgenden Arten von Remote-Modellen erstellen:

Remote-Modelle über eines der folgenden vortrainierten Vertex AI-Modelle:

Wenn Sie Feedback geben oder Support für die Modelle in der Vorabversion anfordern möchten, senden Sie eine E-Mail an bqml-feedback@google.com.

Modelle zur Textgenerierung verwenden

Nachdem Sie ein Remote-Modell erstellt haben, können Sie über die Funktion ML.GENERATE_TEXT mit diesem Modell interagieren.

- Bei Remote-Modellen, die auf den Gemini 1.5- oder 2.0-Modellen basieren, können Sie die

ML.GENERATE_TEXT-Funktion zum Analysieren von Text, Bildern, Audio, Video oder von PDF-Inhalten aus einer Objekttabelle mit einem Prompt nutzen, den Sie als Funktionsargument angeben. Alternativ können Sie Text aus einem Prompt generieren, den Sie in einer Abfrage oder einer Spalte in einer Standardtabelle angeben. - Bei Remote-Modellen, die auf dem

gemini-1.0-pro-vision-Modell basieren, können Sie dieML.GENERATE_TEXT-Funktion zum Analysieren von Bild- oder Videoinhalten aus einer Objekttabelle durch einen Prompt nutzen, den Sie als Funktionsargument angeben. - Bei allen anderen Arten von Remote-Modellen können Sie die

ML.GENERATE_TEXT-Funktion mit einem Prompt verwenden, den Sie in einer Abfrage oder einer Spalte in einer Standardtabelle angeben.

Sie können Fundierung und Sicherheitsattribute verwenden, wenn Sie Gemini-Modelle mit der Funktion ML.GENERATE_TEXT verwenden, wenn Sie eine Standardtabelle als Eingabe verwenden. Mit der Fundierung kann das Gemini-Modell zusätzliche Informationen aus dem Internet verwenden, um spezifischere und faktischere Antworten zu generieren. Mit Sicherheitsattributen kann das Gemini-Modell die zurückgegebenen Antworten anhand der von Ihnen angegebenen Attribute filtern.

Wenn Sie ein Remote-Modell erstellen, das auf eines der folgenden Modelle verweist, können Sie optional gleichzeitig die überwachte Abstimmung konfigurieren:

gemini-1.5-pro-002gemini-1.5-flash-002gemini-1.0-pro-002(Vorschau)

Alle Inferenzen treten in Vertex AI auf. Die Ergebnisse werden in BigQuery gespeichert.

Mit den folgenden Themen können Sie die Textgenerierung in BigQuery ML ausprobieren:

- Text mit einem Gemini-Modell und der Funktion

ML.GENERATE_TEXTgenerieren - Bilder mit einem Gemini-Vision-Modell analysieren

- Generieren Sie Text mithilfe der Funktion

ML.GENERATE_TEXTund Ihren Daten. - Modell mit Ihren Daten optimieren

- Text mit einem

text-bison-Modell und der FunktionML.GENERATE_TEXTgenerieren

Einbettung

Einbettungen sind hochdimensionale numerische Vektoren, die eine bestimmte Entität darstellen, z. B. einen Text oder eine Audiodatei. Durch das Generieren von Einbettungen können Sie die Semantik Ihrer Daten so erfassen, dass sich die Daten leichter analysieren und vergleichen lassen.

Typische Anwendungsfälle für die Generierung von Einbettungen:

- Mithilfe von Retrieval-Augmented Generation (RAG) Modellantworten auf Nutzeranfragen durch Verweisen auf zusätzliche Daten aus einer vertrauenswürdigen Quelle ergänzen. RAG bietet eine bessere Faktenrichtigkeit und Antwortkonsistenz sowie Zugriff auf Daten, die aktueller sind als die Trainingsdaten des Modells.

- Multimodale Suche Beispielsweise kann Text als Eingabe für die Bildsuche verwendet werden.

- Semantische Suche, um ähnliche Elemente für Empfehlungen, Substitution und Datensatzdeduplizierung zu finden

- Erstellen von Einbettungen für ein K-Means-Modell zum Clustering.

Unterstützte Modelle

Die folgenden Modelle werden unterstützt:

- Für Texteinbettungen können Sie die Vertex AI-Modelle

text-embeddingundtext-multilingual-embeddingverwenden. - Für multimodale Einbettungen, die Text, Bilder und Videos in denselben semantischen Bereich einbetten können, können Sie das Vertex AI-Modell

multimodalembeddingverwenden. - Zum Erstellen von Einbettungen für strukturierte Daten aus unabhängigen und identisch verteilten Zufallsvariablen (IID) können Sie ein BigQuery ML-Modell für die Hauptkomponentenanalyse (PCA) oder ein Autoencoder-Modell verwenden.

- Um Einbettungen für Nutzer- oder Artikeldaten zu erstellen, können Sie ein BigQuery ML-Modell zur Matrixfaktorisierung verwenden.

Für eine kleinere, schlanke Texteinbettung sollten Sie ein vortrainiertes TensorFlow-Modell verwenden, z. B. NNLM, SWIVEL oder BERT.

Modelle zur Generierung von Einbettungen verwenden

Nachdem Sie das Modell erstellt haben, können Sie über die Funktion ML.GENERATE_EMBEDDING mit diesem Modell interagieren. ML.GENERATE_EMBEDDING funktioniert für alle unterstützten Modelltypen mit Daten in Standardtabellen. Bei multimodalen Einbettungsmodellen funktioniert ML.GENERATE_EMBEDDING auch mit visuellen Inhalten in Objekttabellen.

Bei Remote-Modellen erfolgt die gesamte Inferenz in Vertex AI. Bei anderen Modelltypen erfolgt die gesamte Inferenz in BigQuery. Die Ergebnisse werden in BigQuery gespeichert.

Mit den folgenden Themen können Sie die Textgenerierung in BigQuery ML ausprobieren:

- Text-Embeddings mit der Funktion

ML.GENERATE_EMBEDDINGgenerieren - Bild-Embeddings mit der Funktion

ML.GENERATE_EMBEDDINGgenerieren - Video-Embeddings mit der Funktion

ML.GENERATE_EMBEDDINGgenerieren - Multimodale Einbettungen generieren und suchen

- Semantische Suche und Retrieval Augmented Generation durchführen

Preise

Ihnen werden die Rechenressourcen in Rechnung gestellt, die Sie zum Ausführen von Abfragen für Modelle verwenden. Remote-Modelle führen Aufrufe an Vertex AI-Modelle aus. Daher fallen für Abfragen an Remote-Modelle auch Gebühren von Vertex AI an.

Weitere Informationen finden Sie unter BigQuery ML-Preise.

Nächste Schritte

- Weitere Informationen zum Ausführen von Inferenzen für Modelle von maschinellem Lernen finden Sie unter Modellinferenz – Übersicht.