Text über ein Text-Bison-Modell und die Funktion ML.GENERATE_TEXT generieren

In dieser Anleitung erfahren Sie, wie Sie ein Remote-Modell erstellen, das auf dem text-bison@002-LLM (Large Language Model, großes Sprachmodell) basiert. Verwenden Sie dieses Modell zusammen mit der ML.GENERATE_TEXT-Funktion, um verschieden Aufgaben im Bereich der Textgenerierung auszuführen. In dieser Anleitung wird die öffentliche Tabelle bigquery-public-data.imdb.reviews verwendet.

Erforderliche Berechtigungen

- Zum Erstellen des Datasets benötigen Sie die IAM (Identity and Access Management)-Berechtigung

bigquery.datasets.create. Zum Erstellen der Verbindungsressource benötigen Sie die folgenden IAM-Berechtigungen:

bigquery.connections.createbigquery.connections.get

Zum Erteilen von Berechtigungen für das Dienstkonto der Verbindung benötigen Sie die folgende Berechtigung:

resourcemanager.projects.setIamPolicy

Zum Erstellen des Modells benötigen Sie die folgenden Berechtigungen:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.connections.delegate

Zum Ausführen von Inferenzen benötigen Sie die folgenden Berechtigungen:

bigquery.models.getDatabigquery.jobs.create

Kosten

In diesem Dokument verwenden Sie die folgenden kostenpflichtigen Komponenten von Google Cloud:

- BigQuery ML: You incur costs for the data that you process in BigQuery.

- Vertex AI: You incur costs for calls to the Vertex AI service that's represented by the remote model.

Mit dem Preisrechner können Sie eine Kostenschätzung für Ihre voraussichtliche Nutzung vornehmen.

Weitere Informationen zu den Preisen von BigQuery finden Sie unter BigQuery: Preise in der BigQuery-Dokumentation.

Weitere Informationen zu den Preisen für Vertex AI finden Sie auf der Seite Vertex AI: Preise.

Hinweise

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Make sure that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection, and Vertex AI APIs.

Dataset erstellen

Erstellen Sie ein BigQuery-Dataset, um Ihr ML-Modell zu speichern.

Console

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Klicken Sie im Bereich Explorer auf den Namen Ihres Projekts.

Klicken Sie auf Aktionen ansehen > Dataset erstellen.

Führen Sie auf der Seite Dataset erstellen die folgenden Schritte aus:

Geben Sie unter Dataset-ID

bqml_tutorialein.Wählen Sie als Standorttyp die Option Mehrere Regionen und dann USA (mehrere Regionen in den USA) aus.

Übernehmen Sie die verbleibenden Standardeinstellungen unverändert und klicken Sie auf Dataset erstellen.

bq

Wenn Sie ein neues Dataset erstellen möchten, verwenden Sie den Befehl bq mk mit dem Flag --location. Eine vollständige Liste der möglichen Parameter finden Sie in der bq mk --dataset-Befehlsreferenz.

Erstellen Sie ein Dataset mit dem Namen

bqml_tutorial, dessen Speicherort aufUSfestgelegt ist und das die BeschreibungBigQuery ML tutorial datasethat:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Anstelle des Flags

--datasetverwendet der Befehl die verkürzte Form-d. Wenn Sie-dund--datasetauslassen, wird standardmäßig ein Dataset erstellt.Prüfen Sie, ob das Dataset erstellt wurde:

bq ls

API

Rufen Sie die Methode datasets.insert mit einer definierten Dataset-Ressource auf.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

Verbindung herstellen

Erstellen Sie eine Cloud-Ressourcenverbindung und rufen Sie das Dienstkonto der Verbindung ab. Erstellen Sie die Verbindung in demselben Standort wie dem des von Ihnen im vorherigen Schritt erstellten Datasets.

Wählen Sie eine der folgenden Optionen aus:

Console

Rufen Sie die Seite BigQuery auf.

Klicken Sie im Bereich Explorer auf Daten hinzufügen.

Das Dialogfeld Daten hinzufügen wird geöffnet.

Wählen Sie im Bereich Filtern nach im Abschnitt Datenquellentyp die Option Datenbanken aus.

Alternativ können Sie im Feld Nach Datenquellen suchen den Wert

Vertex AIeingeben.Klicken Sie im Abschnitt Empfohlene Datenquellen auf Vertex AI.

Klicken Sie auf die Lösungskarte Vertex AI-Modelle: BigQuery-Verknüpfung.

Wählen Sie in der Liste Verbindungstyp die Option Vertex AI-Remote-Modelle, Remote-Funktionen und BigLake (Cloud-Ressource) aus.

Geben Sie im Feld Verbindungs-ID einen Namen für die Verbindung ein.

Klicken Sie auf Verbindung erstellen.

Klicken Sie auf Zur Verbindung.

Kopieren Sie im Bereich Verbindungsinformationen die Dienstkonto-ID zur Verwendung in einem späteren Schritt.

bq

Erstellen Sie in einer Befehlszeilenumgebung eine Verbindung:

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

Der Parameter

--project_idüberschreibt das Standardprojekt.Ersetzen Sie dabei Folgendes:

REGION: Ihre VerbindungsregionPROJECT_ID: Ihre Google Cloud-Projekt-IDCONNECTION_ID: eine ID für Ihre Verbindung

Wenn Sie eine Verbindungsressource herstellen, erstellt BigQuery ein eindeutiges Systemdienstkonto und ordnet es der Verbindung zu.

Fehlerbehebung:Wird der folgende Verbindungsfehler angezeigt, aktualisieren Sie das Google Cloud SDK:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Rufen Sie die Dienstkonto-ID ab und kopieren Sie sie zur Verwendung in einem späteren Schritt:

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

Die Ausgabe sieht in etwa so aus:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Terraform

Verwenden Sie die Ressource google_bigquery_connection:

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Im folgenden Beispiel wird eine Cloud-Ressourcenverbindung mit dem Namen my_cloud_resource_connection in der Region US erstellt:

Führen Sie die Schritte in den folgenden Abschnitten aus, um Ihre Terraform-Konfiguration auf ein Google Cloud-Projekt anzuwenden.

Cloud Shell vorbereiten

- Rufen Sie Cloud Shell auf.

-

Legen Sie das Google Cloud-Standardprojekt fest, auf das Sie Ihre Terraform-Konfigurationen anwenden möchten.

Sie müssen diesen Befehl nur einmal pro Projekt und in jedem beliebigen Verzeichnis ausführen.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Umgebungsvariablen werden überschrieben, wenn Sie in der Terraform-Konfigurationsdatei explizite Werte festlegen.

Verzeichnis vorbereiten

Jede Terraform-Konfigurationsdatei muss ein eigenes Verzeichnis haben (auch als Stammmodul bezeichnet).

-

Erstellen Sie in Cloud Shell ein Verzeichnis und eine neue Datei in diesem Verzeichnis. Der Dateiname muss die Erweiterung

.tfhaben, z. B.main.tf. In dieser Anleitung wird die Datei alsmain.tfbezeichnet.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Wenn Sie einer Anleitung folgen, können Sie den Beispielcode in jedem Abschnitt oder Schritt kopieren.

Kopieren Sie den Beispielcode in das neu erstellte

main.tf.Kopieren Sie optional den Code aus GitHub. Dies wird empfohlen, wenn das Terraform-Snippet Teil einer End-to-End-Lösung ist.

- Prüfen und ändern Sie die Beispielparameter, die auf Ihre Umgebung angewendet werden sollen.

- Speichern Sie die Änderungen.

-

Initialisieren Sie Terraform. Dies ist nur einmal für jedes Verzeichnis erforderlich.

terraform init

Fügen Sie optional die Option

-upgradeein, um die neueste Google-Anbieterversion zu verwenden:terraform init -upgrade

Änderungen anwenden

-

Prüfen Sie die Konfiguration und prüfen Sie, ob die Ressourcen, die Terraform erstellen oder aktualisieren wird, Ihren Erwartungen entsprechen:

terraform plan

Korrigieren Sie die Konfiguration nach Bedarf.

-

Wenden Sie die Terraform-Konfiguration an. Führen Sie dazu den folgenden Befehl aus und geben Sie

yesan der Eingabeaufforderung ein:terraform apply

Warten Sie, bis Terraform die Meldung „Apply complete“ anzeigt.

- Öffnen Sie Ihr Google Cloud-Projekt, um die Ergebnisse aufzurufen. Rufen Sie in der Google Cloud Console Ihre Ressourcen in der Benutzeroberfläche auf, um sicherzustellen, dass Terraform sie erstellt oder aktualisiert hat.

Dem Dienstkonto der Verbindung Berechtigungen gewähren

Weisen Sie dem Dienstkonto der Verbindung die Rolle „Vertex AI-Nutzer“ zu. Sie müssen diese Rolle in dem Projekt gewähren, das Sie im Abschnitt Vorbereitung erstellt oder ausgewählt haben. Die Zuweisung der Rolle in einem anderen Projekt führt zu dem Fehler bqcx-1234567890-xxxx@gcp-sa-bigquery-condel.iam.gserviceaccount.com does not have the permission to access resource.

So weisen Sie die Rolle zu:

Zur Seite IAM & Verwaltung.

Klicken Sie auf Zugriff gewähren.

Geben Sie im Feld Neue Hauptkonten die Dienstkonto-ID ein, die Sie zuvor kopiert haben.

Wählen Sie im Feld Rolle auswählen die Option Vertex AI und dann Vertex AI-Nutzerrolle aus.

Klicken Sie auf Speichern.

Remote-Modell erstellen

Erstellen Sie ein Remote-Modell, das ein gehostetes Vertex AI-LLM (Large Language Model) darstellt:

SQL

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor folgende Abfrage aus:

CREATE OR REPLACE MODEL `bqml_tutorial.llm_model` REMOTE WITH CONNECTION `LOCATION.CONNECTION_ID` OPTIONS (ENDPOINT = 'text-bison@002');

Ersetzen Sie Folgendes:

LOCATION: Standort der VerbindungCONNECTION_ID: ID Ihrer BigQuery-VerbindungWenn Sie sich Verbindungsdetails in der Google Cloud Console ansehen, ist dies der Wert im letzten Abschnitt der voll qualifizierten Verbindungs-ID, der unter Verbindungs-ID angezeigt wird, z. B.

projects/myproject/locations/connection_location/connections/myconnection.

Die Abfrage dauert mehrere Sekunden. Anschließend wird das Modell

llm_modelimbqml_tutorial-Dataset des Bereichs Explorer angezeigt. Da die Abfrage eineCREATE MODEL-Anweisung zum Erstellen eines Modells verwendet, gibt es keine Abfrageergebnisse.

BigQuery DataFrames

Bevor Sie dieses Beispiel ausprobieren, folgen Sie den Schritten zur Einrichtung von BigQuery DataFrames in der BigQuery-Kurzanleitung: BigQuery DataFrames verwenden. Weitere Informationen finden Sie in der Referenzdokumentation zu BigQuery DataFrames.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter ADC für eine lokale Entwicklungsumgebung einrichten.

Keyword-Extraktion ausführen

Führen Sie mithilfe des Remote-Modells und der ML.GENERATE_TEXT-Funktion die Keyword-Extraktion für IMDB-Filmrezensionen durch:

SQL

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Geben Sie im Abfrageeditor folgende Anweisung ein, um eine Schlüsselwortextraktion für fünf Filmrezensionen durchzuführen:

SELECT ml_generate_text_result['predictions'][0]['content'] AS generated_text, ml_generate_text_result['predictions'][0]['safetyAttributes'] AS safety_attributes, * EXCEPT (ml_generate_text_result) FROM ML.GENERATE_TEXT( MODEL `bqml_tutorial.llm_model`, ( SELECT CONCAT('Extract the key words from the text below: ', review) AS prompt, * FROM `bigquery-public-data.imdb.reviews` LIMIT 5 ), STRUCT( 0.2 AS temperature, 100 AS max_output_tokens));

Die Ausgabe sieht in etwa so aus, wobei nicht generierte Spalten aus Gründen der Übersichtlichkeit weggelassen wurden:

+----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+ | generated_text | safety_attributes | ml_generate_text_status | prompt | ... | +----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+ | " Keywords:\n- British Airways\n- | {"blocked":false,"categories": | | Extract the key words from | | | acting\n- story\n- kid\n- switch off" | ["Death, Harm & Tragedy","Derogatory", | | the text below: I had to | | | | "Finance","Health","Insult", | | see this on the British | | | | "Profanity","Religion & Belief", | | Airways plane. It was | | | | "Sexual","Toxic"] | | terribly bad acting and | | | | "safetyRatings":[{"category": | | a dumb story. Not even | | | | "Dangerous Content","probabilityScore"... | | a kid would enjoy this... | | +----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+ | " - Family movie\n- ITV station\n- THE | {"blocked":false,"categories": | | Extract the key words from | | | REAL HOWARD SPITZ\n- Roald Dahl\n- | ["Death, Harm & Tragedy","Derogatory", | | the text below: This is | | | DOCTOR WHO\n- Pulp fiction\n- Child | "Health","Illicit Drugs","Insult", | | a family movie that was | | | abuse\n- KINDERGARTEN COP\n- PC\n- | "Legal","Profanity","Public Safety", | | broadcast on my local | | | Children's author\n- Vadim Jean\n- | "Sexual","Toxic","Violent"], | | ITV station at 1.00 am a | | | Haphazard\n- Kelsey Grammar\n- | "safetyRatings":[{"category": | | couple of nights ago. | | | Dead pan\n- Ridiculous camera angles" | "Dangerous Content","probabilityScore"... | | This might be a strange... | | +----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+Die Ergebnisse enthalten die folgenden Spalten:

generated_text: generierter Text.safety_attributes: Sicherheitsattribute sowie Informationen dazu, ob der Inhalt aufgrund einer der blockierenden Kategorien blockiert wird. Weitere Informationen zu den Sicherheitsattributen finden Sie unter Vertex PaLM API.ml_generate_text_status: API-Antwortstatus für die entsprechende Zeile. Wenn der Vorgang erfolgreich war, ist dieser Wert leer.prompt: Eingabeaufforderung für die Sentimentanalyse.- Alle Spalten aus der

bigquery-public-data.imdb.reviews-Tabelle.

Optional: Anstatt das von der Funktion zurückgegebene JSON-Dokument manuell zu parsen, wie im vorherigen Schritt, verwenden Sie das

flatten_json_output-Argument, um den generierten Text und die Sicherheitsattribute in separaten Spalten zurückzugeben.Führen Sie im Abfrageeditor folgende Abfrage aus:

SELECT * FROM ML.GENERATE_TEXT( MODEL `bqml_tutorial.llm_model`, ( SELECT CONCAT('Extract the key words from the text below: ', review) AS prompt, * FROM `bigquery-public-data.imdb.reviews` LIMIT 5 ), STRUCT( 0.2 AS temperature, 100 AS max_output_tokens, TRUE AS flatten_json_output));

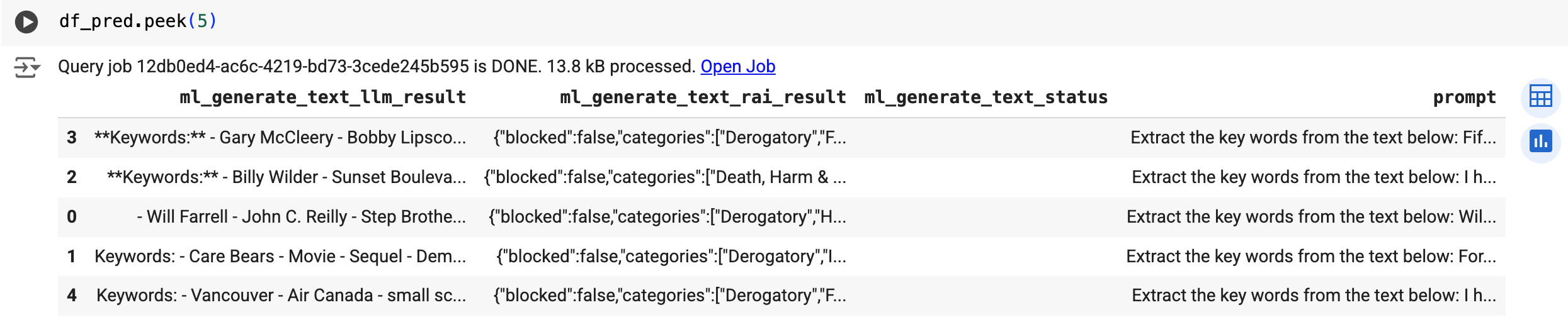

Die Ausgabe sieht in etwa so aus, wobei nicht generierte Spalten aus Gründen der Übersichtlichkeit weggelassen wurden:

+----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+ | ml_generate_text_llm_result | ml_generate_text_rai_result | ml_generate_text_status | prompt | ... | +----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+ | Keywords: | {"blocked":false,"categories": | | Extract the key words from | | | - British Airways | ["Death, Harm & Tragedy","Derogatory", | | the text below: I had to | | | - acting | "Finance","Health","Insult", | | see this on the British | | | - story | "Profanity","Religion & Belief", | | Airways plane. It was | | | - kid | "Sexual","Toxic"] | | terribly bad acting and | | | - switch off | "safetyRatings":[{"category": | | a dumb story. Not even | | | | "Dangerous Content","probabilityScore"... | | a kid would enjoy this... | | +----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+ | - Family movie | {"blocked":false,"categories": | | Extract the key words from | | | - ITV station | ["Death, Harm & Tragedy","Derogatory", | | the text below: This is | | | - THE REAL HOWARD SPITZ | "Health","Illicit Drugs","Insult", | | a family movie that was | | | - Roald Dahl | "Legal","Profanity","Public Safety", | | broadcast on my local | | | - DOCTOR WHO | "Sexual","Toxic","Violent"], | | ITV station at 1.00 am a | | | - Pulp Fiction | "safetyRatings":[{"category": | | couple of nights ago. | | | - ... | "Dangerous Content","probabilityScore"... | | This might be a strange... | | +----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+Die Ergebnisse enthalten die folgenden Spalten:

ml_generate_text_llm_result: generierter Text.ml_generate_text_rai_result: Sicherheitsattribute sowie Informationen dazu, ob der Inhalt aufgrund einer der blockierenden Kategorien blockiert wird. Weitere Informationen zu den Sicherheitsattributen finden Sie unter Vertex PaLM API.ml_generate_text_status: API-Antwortstatus für die entsprechende Zeile. Wenn der Vorgang erfolgreich war, ist dieser Wert leer.prompt: Eingabeaufforderung für die Keyword-Extraktion.- Alle Spalten aus der

bigquery-public-data.imdb.reviews-Tabelle.

BigQuery DataFrames

Bevor Sie dieses Beispiel ausprobieren, folgen Sie den Schritten zur Einrichtung von BigQuery DataFrames in der BigQuery-Kurzanleitung: BigQuery DataFrames verwenden. Weitere Informationen finden Sie in der Referenzdokumentation zu BigQuery DataFrames.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter ADC für eine lokale Entwicklungsumgebung einrichten.

Verwenden Sie die Funktion predict, um das Remote-Modell auszuführen:

Das Ergebnis sieht etwa so aus:

Kurzanleitung: Eine Sentimentanalyse durchführen

Mit dem Remote-Modell und der ML.GENERATE_TEXT-Funktion können Sie eine Sentimentanalyse für IMDB-Filmrezensionen durchführen:

SQL

Öffnen Sie in der Google Cloud Console die Seite BigQuery.

Führen Sie im Abfrageeditor die folgende Anweisung aus, um eine Stimmungsanalyse für fünf Filmrezensionen durchzuführen:

SELECT ml_generate_text_result['predictions'][0]['content'] AS generated_text, ml_generate_text_result['predictions'][0]['safetyAttributes'] AS safety_attributes, * EXCEPT (ml_generate_text_result) FROM ML.GENERATE_TEXT( MODEL `bqml_tutorial.llm_model`, ( SELECT CONCAT( 'perform sentiment analysis on the following text, return one the following categories: positive, negative: ', review) AS prompt, * FROM `bigquery-public-data.imdb.reviews` LIMIT 5 ), STRUCT( 0.2 AS temperature, 100 AS max_output_tokens));

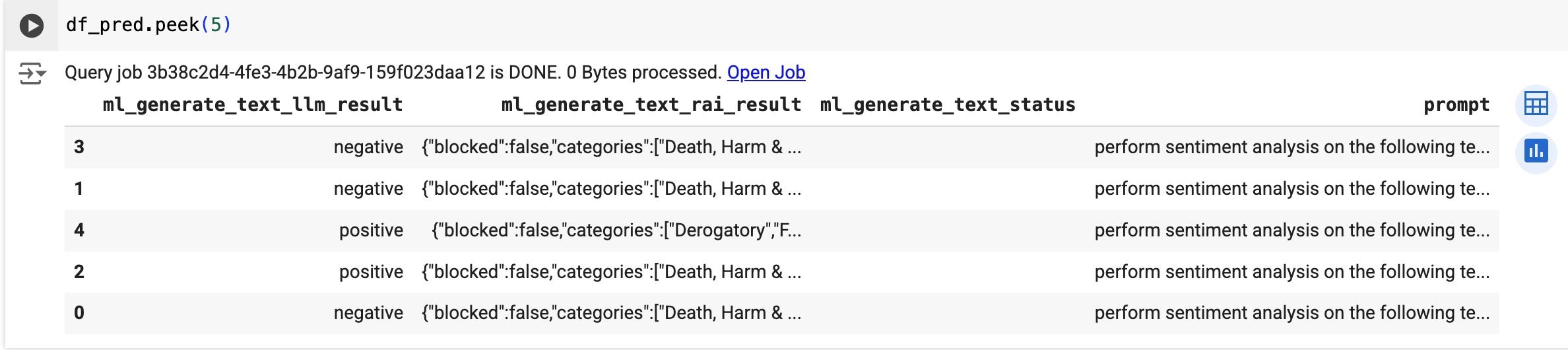

Die Ausgabe sieht in etwa so aus, wobei nicht generierte Spalten aus Gründen der Übersichtlichkeit weggelassen wurden:

+----------------+---------------------------------------------+-------------------------+----------------------------+-----+ | generated_text | safety_attributes | ml_generate_text_status | prompt | ... | +----------------+---------------------------------------------+-------------------------+----------------------------+-----+ | "negative" | {"blocked":false,"categories": | | perform sentiment analysis | | | | ["Death, Harm & Tragedy","Derogatory", | | on the following text, | | | | "Finance","Health","Insult", | | return one the following | | | | "Profanity","Religion & Belief", | | categories: positive, | | | | "Sexual","Toxic"] | | negative: I had to see | | | | "safetyRatings":[{"category": | | this on the British | | | | "Dangerous Content","probabilityScore"... | | Airways plane. It was... | | +----------------+---------------------------------------------+-------------------------+----------------------------+-----+ | "negative" | {"blocked":false,"categories": | | perform sentiment analysis | | | | ["Death, Harm & Tragedy","Derogatory", | | on the following text, | | | | "Health","Illicit Drugs","Insult", | | return one the following | | | | "Legal","Profanity","Public Safety", | | categories: positive, | | | | "Sexual","Toxic","Violent"], | | negative: This is a family | | | | "safetyRatings":[{"category": | | movie that was broadcast | | | | "Dangerous Content","probabilityScore"... | | on my local ITV station... | | +----------------+---------------------------------------------+-------------------------+----------------------------+-----+Die Ergebnisse enthalten die Spalten, die auch unter Keyword-Extraktion ausführen dokumentiert sind.

BigQuery DataFrames

Bevor Sie dieses Beispiel ausprobieren, folgen Sie den Schritten zur Einrichtung von BigQuery DataFrames in der BigQuery-Kurzanleitung: BigQuery DataFrames verwenden. Weitere Informationen finden Sie in der Referenzdokumentation zu BigQuery DataFrames.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter ADC für eine lokale Entwicklungsumgebung einrichten.

Verwenden Sie die Funktion predict, um das Remote-Modell auszuführen:

Das Ergebnis sieht etwa so aus:

Bereinigen

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.