Este tutorial ensina a usar um

ARIMA_PLUS modelo de série temporal univariada para prever o valor futuro de uma determinada coluna com base nos valores do histórico dessa coluna.

Este tutorial faz previsões para várias séries cronológicas. Os valores previstos são calculados para cada ponto temporal, para cada valor numa ou mais colunas especificadas. Por exemplo, se quiser prever o tempo e especificar uma coluna com dados de cidades, os dados previstos vão conter previsões para todos os pontos temporais da cidade A, seguidas dos valores previstos para todos os pontos temporais da cidade B e assim sucessivamente.

Este tutorial usa dados da tabela pública

bigquery-public-data.new_york.citibike_trips. Esta tabela contém informações sobre viagens de Citi Bike na cidade de Nova Iorque.

Antes de ler este tutorial, recomendamos vivamente que leia o artigo Preveja uma única série cronológica com um modelo univariado.

Crie um conjunto de dados

Crie um conjunto de dados do BigQuery para armazenar o seu modelo de ML.

Consola

Na Google Cloud consola, aceda à página BigQuery.

No painel Explorador, clique no nome do projeto.

Clique em Ver ações > Criar conjunto de dados

Na página Criar conjunto de dados, faça o seguinte:

Para o ID do conjunto de dados, introduza

bqml_tutorial.Em Tipo de localização, selecione Várias regiões e, de seguida, selecione EUA (várias regiões nos Estados Unidos).

Deixe as restantes predefinições como estão e clique em Criar conjunto de dados.

bq

Para criar um novo conjunto de dados, use o comando

bq mk

com a flag --location. Para uma lista completa de parâmetros possíveis, consulte a referência do comando bq mk --dataset.

Crie um conjunto de dados com o nome

bqml_tutorialcom a localização dos dados definida comoUSe uma descrição deBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Em vez de usar a flag

--dataset, o comando usa o atalho-d. Se omitir-de--dataset, o comando cria um conjunto de dados por predefinição.Confirme que o conjunto de dados foi criado:

bq ls

API

Chame o método datasets.insert

com um recurso de conjunto de dados definido.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

DataFrames do BigQuery

Antes de experimentar este exemplo, siga as instruções de configuração dos DataFrames do BigQuery no início rápido do BigQuery com os DataFrames do BigQuery. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para se autenticar no BigQuery, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure o ADC para um ambiente de desenvolvimento local.

Visualize os dados de entrada

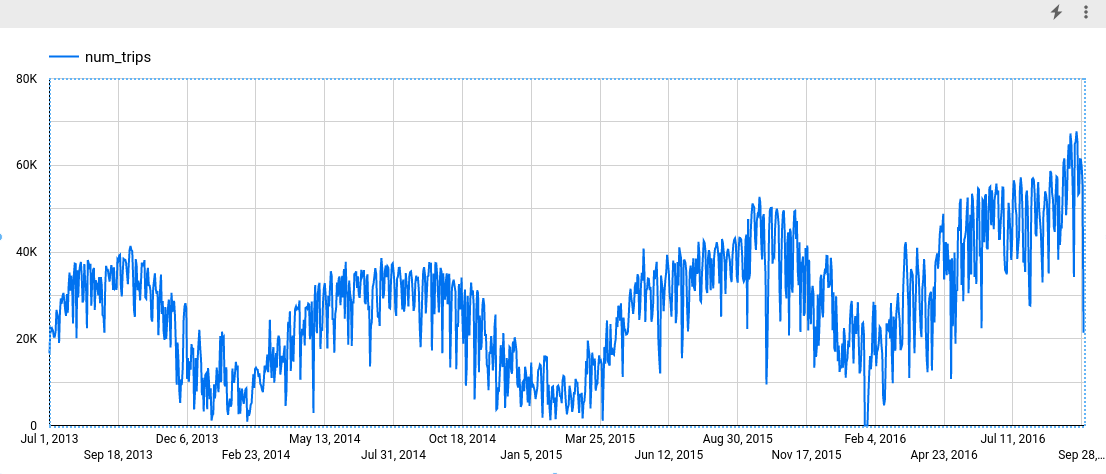

Antes de criar o modelo, pode visualizar opcionalmente os dados de séries cronológicas de entrada para ter uma ideia da distribuição. Pode fazê-lo através do Looker Studio.

SQL

A declaração SELECT da seguinte consulta usa a função EXTRACT para extrair as informações de data da coluna starttime. A consulta usa a cláusula COUNT(*) para obter o número total diário de viagens de Citi Bike.

Siga estes passos para visualizar os dados de séries cronológicas:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

SELECT EXTRACT(DATE from starttime) AS date, COUNT(*) AS num_trips FROM `bigquery-public-data.new_york.citibike_trips` GROUP BY date;

Quando a consulta estiver concluída, clique em Explorar dados > Explorar com o Looker Studio. O Looker Studio é aberto num novo separador. Conclua os seguintes passos no novo separador.

No Looker Studio, clique em Inserir > Gráfico de intervalos temporais.

No painel Gráfico, escolha o separador Configuração.

Na secção Métrica, adicione o campo num_trips e remova a métrica predefinida Contagem de registos. O gráfico resultante tem um aspeto semelhante ao seguinte:

DataFrames do BigQuery

Antes de experimentar este exemplo, siga as instruções de configuração dos DataFrames do BigQuery no início rápido do BigQuery com os DataFrames do BigQuery. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para se autenticar no BigQuery, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure o ADC para um ambiente de desenvolvimento local.

Crie o modelo de séries cronológicas

Quer prever o número de viagens de bicicleta para cada estação do Citi Bike, o que requer muitos modelos de intervalos temporais; um para cada estação do Citi Bike incluída nos dados de entrada. Pode criar vários modelos para o fazer, mas pode ser um processo tedioso e demorado, especialmente quando tem um grande número de séries cronológicas. Em alternativa, pode usar uma única consulta para criar e ajustar um conjunto de modelos de séries cronológicas de modo a prever várias séries cronológicas em simultâneo.

SQL

Na consulta seguinte, a cláusula

OPTIONS(model_type='ARIMA_PLUS', time_series_timestamp_col='date', ...)

indica que está a criar um modelo de série cronológica baseado em

ARIMA. Usa a opção time_series_id_col da declaração CREATE MODEL para especificar uma ou mais colunas nos dados de entrada para as quais quer obter previsões, neste caso, a estação de Citi Bike, conforme representado pela coluna start_station_name. Usa a cláusula WHERE para limitar as estações de início àquelas que têm Central Park nos respetivos nomes. A opção auto_arima_max_order da declaração CREATE MODEL controla o espaço de pesquisa para o ajuste de hiperparâmetros no algoritmo auto.ARIMA. A opção

decompose_time_series

da declaração CREATE MODEL tem como predefinição TRUE, para que as informações sobre os dados da série cronológica sejam devolvidas quando avaliar o modelo no passo seguinte.

Siga estes passos para criar o modelo:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

CREATE OR REPLACE MODEL `bqml_tutorial.nyc_citibike_arima_model_group` OPTIONS (model_type = 'ARIMA_PLUS', time_series_timestamp_col = 'date', time_series_data_col = 'num_trips', time_series_id_col = 'start_station_name', auto_arima_max_order = 5 ) AS SELECT start_station_name, EXTRACT(DATE from starttime) AS date, COUNT(*) AS num_trips FROM `bigquery-public-data.new_york.citibike_trips` WHERE start_station_name LIKE '%Central Park%' GROUP BY start_station_name, date;

A consulta demora aproximadamente 24 segundos a ser concluída. Depois, pode aceder ao modelo

nyc_citibike_arima_model_group. Uma vez que a consulta usa uma declaraçãoCREATE MODEL, não vê os resultados da consulta.

Esta consulta cria doze modelos de séries cronológicas, um para cada uma das doze estações de início da Citi Bike nos dados de entrada. O custo de tempo, aproximadamente 24 segundos, é apenas 1,4 vezes superior ao da criação de um único modelo de série cronológica devido ao paralelismo. No entanto, se remover a cláusula WHERE ... LIKE ..., haveria mais de 600 séries cronológicas para prever e não seriam previstas completamente em paralelo devido às limitações de capacidade de slots. Nesse caso, a consulta demoraria aproximadamente 15 minutos a

concluir. Para reduzir o tempo de execução da consulta com o compromisso de uma potencial ligeira diminuição na qualidade do modelo, pode diminuir o valor de auto_arima_max_order.

Isto reduz o espaço de pesquisa do ajuste de hiperparâmetros no algoritmo.auto.ARIMA Para mais informações, consulte

Large-scale time series forecasting best practices.

DataFrames do BigQuery

No fragmento seguinte, está a criar um modelo de série cronológica baseado em ARIMA.

Antes de experimentar este exemplo, siga as instruções de configuração dos DataFrames do BigQuery no início rápido do BigQuery com os DataFrames do BigQuery. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para se autenticar no BigQuery, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure o ADC para um ambiente de desenvolvimento local.

Isto cria doze modelos de séries cronológicas, um para cada uma das doze estações de início da Citi Bike nos dados de entrada. O custo de tempo, aproximadamente 24 segundos, é apenas 1,4 vezes superior ao da criação de um único modelo de série cronológica devido ao paralelismo.

Avalie o modelo

SQL

Avalie o modelo de séries cronológicas através da função ML.ARIMA_EVALUATE. A função ML.ARIMA_EVALUATE mostra as métricas de avaliação que foram geradas para o modelo durante o processo de ajuste automático de hiperparâmetros.

Siga estes passos para avaliar o modelo:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

SELECT * FROM ML.ARIMA_EVALUATE(MODEL `bqml_tutorial.nyc_citibike_arima_model_group`);

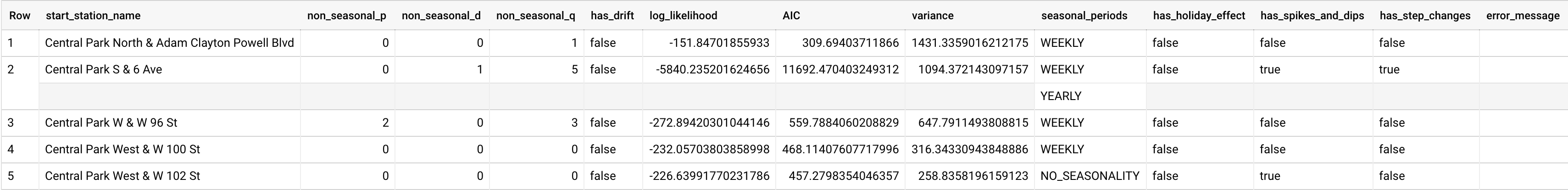

Os resultados devem ter o seguinte aspeto:

Embora o

auto.ARIMAavalie dezenas de modelos ARIMA candidatos para cada série cronológica, oML.ARIMA_EVALUATE, por predefinição, apenas produz as informações do melhor modelo para tornar a tabela de resultados compacta. Para ver todos os modelos candidatos, pode definir oshow_all_candidate_modelargumento da funçãoML.ARIMA_EVALUATEcomoTRUE.

DataFrames do BigQuery

Antes de experimentar este exemplo, siga as instruções de configuração dos DataFrames do BigQuery no início rápido do BigQuery com os DataFrames do BigQuery. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para se autenticar no BigQuery, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure o ADC para um ambiente de desenvolvimento local.

A coluna start_station_name identifica a coluna de dados de entrada para a qual foram criadas séries cronológicas. Esta é a coluna que especificou com a opção time_series_id_col quando criou o modelo.

As colunas de saída non_seasonal_p, non_seasonal_d, non_seasonal_q e has_drift

definem um modelo ARIMA no pipeline de preparação. As colunas de saída log_likelihood, AIC e variance são relevantes para o processo de ajuste do modelo ARIMA.O processo de ajuste determina o melhor modelo ARIMA através do algoritmo auto.ARIMA, um para cada série cronológica.

O algoritmo auto.ARIMA usa o

teste KPSS para determinar o melhor valor

para non_seasonal_d, que, neste caso, é 1. Quando non_seasonal_d é 1,

o algoritmo auto.ARIMA prepara 42 modelos ARIMA candidatos diferentes em paralelo.

Neste exemplo, todos os 42 modelos candidatos são válidos, pelo que a saída contém 42 linhas, uma para cada modelo ARIMA candidato. Nos casos em que alguns dos modelos não são válidos, são excluídos da saída. Estes modelos candidatos são devolvidos por ordem ascendente de AIC. O modelo na primeira linha tem o AIC mais baixo e é considerado o melhor modelo. Este melhor modelo é guardado como o modelo final e é usado quando prevê dados, avalia o modelo e inspeciona os coeficientes do modelo, conforme mostrado nos passos seguintes.

A coluna seasonal_periods contém informações sobre o padrão sazonal identificado nos dados de séries cronológicas. Cada série cronológica pode ter padrões sazonais diferentes. Por exemplo, a partir da figura, pode ver que uma série cronológica tem um padrão anual, enquanto outras não têm.

As colunas has_holiday_effect, has_spikes_and_dips e has_step_changes

só são preenchidas quando decompose_time_series=TRUE. Estas colunas também refletem

informações sobre os dados de séries cronológicas de entrada e não estão relacionadas com a modelagem ARIMA. Estas colunas também têm os mesmos valores em todas as linhas de saída.

Inspecione os coeficientes do modelo

SQL

Inspeccione os coeficientes do modelo de séries cronológicas através da função ML.ARIMA_COEFFICIENTS.

Siga estes passos para obter os coeficientes do modelo:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

SELECT * FROM ML.ARIMA_COEFFICIENTS(MODEL `bqml_tutorial.nyc_citibike_arima_model_group`);

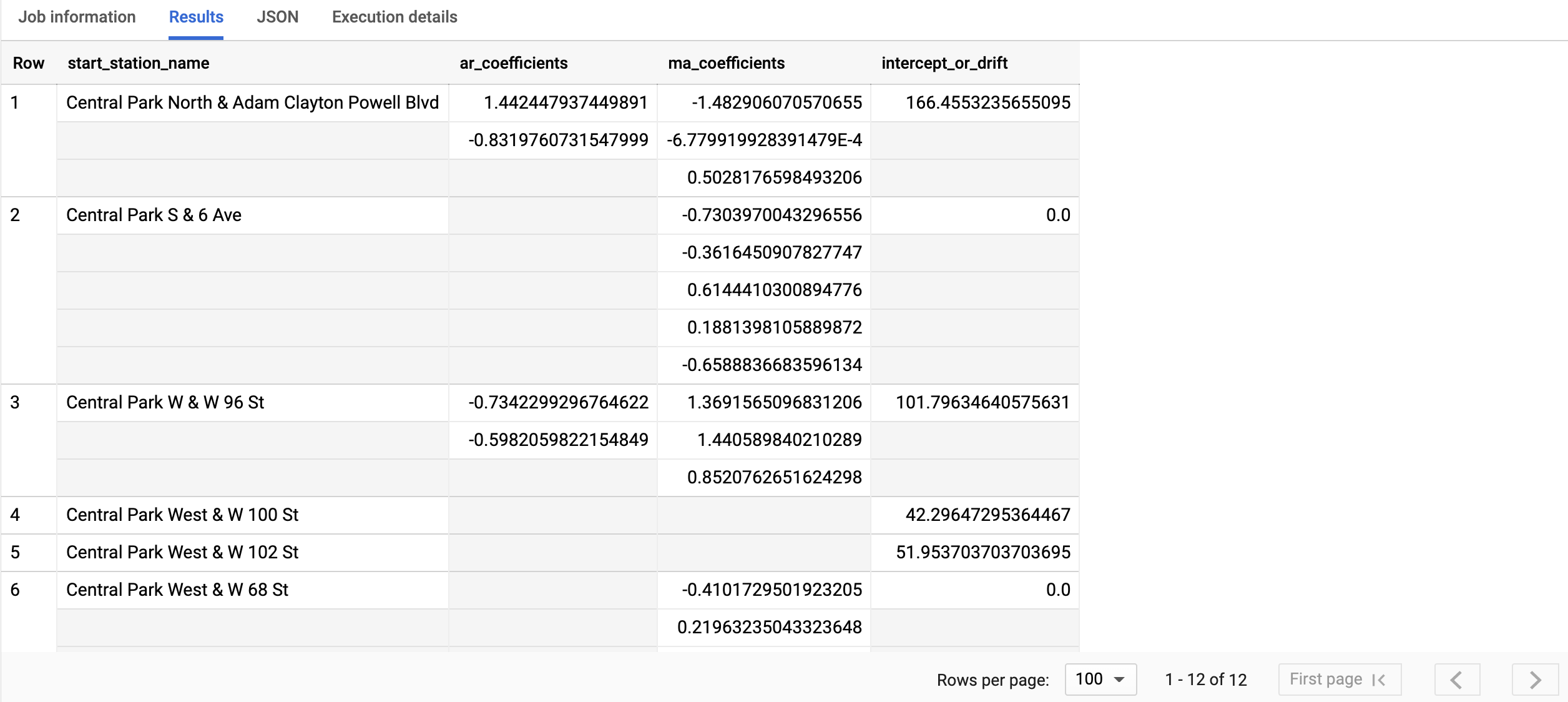

A consulta demora menos de um segundo a concluir. Os resultados devem ser semelhantes aos seguintes:

Para mais informações sobre as colunas de saída, consulte a função

ML.ARIMA_COEFFICIENTS.

DataFrames do BigQuery

Inspeccione os coeficientes do modelo de séries cronológicas através da função coef_.

Antes de experimentar este exemplo, siga as instruções de configuração dos DataFrames do BigQuery no início rápido do BigQuery com os DataFrames do BigQuery. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para se autenticar no BigQuery, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure o ADC para um ambiente de desenvolvimento local.

A coluna start_station_name identifica a coluna de dados de entrada para a qual foram criadas séries cronológicas. Esta é a coluna que especificou na opção time_series_id_col quando criou o modelo.

A coluna de saída ar_coefficients mostra os coeficientes do modelo da parte autorregressiva (AR) do modelo ARIMA. Da mesma forma, a coluna ma_coefficientsoutput mostra os coeficientes do modelo da parte de média móvel (MA) do modelo ARIMA. Ambas as colunas contêm valores de matriz, cujos comprimentos são iguais a non_seasonal_p e non_seasonal_q, respetivamente. O valor intercept_or_drift é o termo constante no modelo ARIMA.

Use o modelo para prever dados

SQL

Preveja valores de séries cronológicas futuras através da função ML.FORECAST.

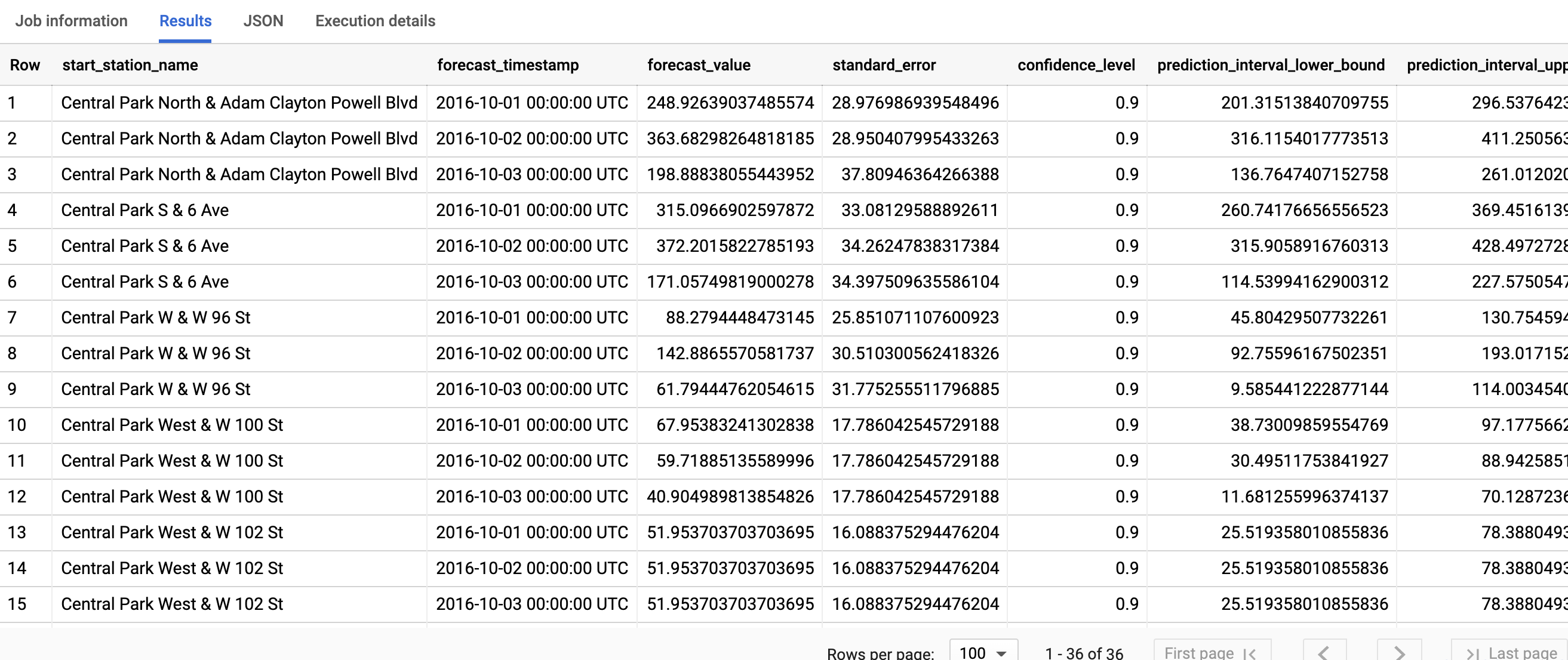

Na consulta GoogleSQL seguinte, a cláusula STRUCT(3 AS horizon, 0.9 AS confidence_level) indica que a consulta prevê 3 pontos temporais futuros e gera um intervalo de previsão com um nível de confiança de 90%.

Siga estes passos para prever dados com o modelo:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

SELECT * FROM ML.FORECAST(MODEL `bqml_tutorial.nyc_citibike_arima_model_group`, STRUCT(3 AS horizon, 0.9 AS confidence_level))

Clique em Executar.

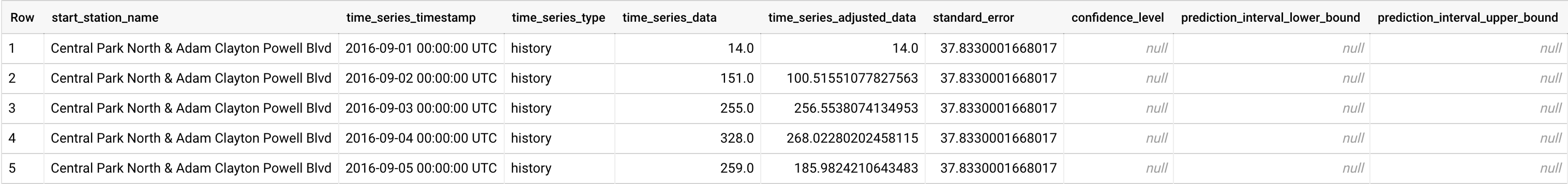

A consulta demora menos de um segundo a concluir. Os resultados devem ter o seguinte aspeto:

Para mais informações sobre as colunas de saída, consulte a função

ML.FORECAST.

DataFrames do BigQuery

Preveja valores de séries cronológicas futuras através da função predict.

Antes de experimentar este exemplo, siga as instruções de configuração dos DataFrames do BigQuery no início rápido do BigQuery com os DataFrames do BigQuery. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para se autenticar no BigQuery, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure o ADC para um ambiente de desenvolvimento local.

A primeira coluna, start_station_name, anota os intervalos temporais em função dos quais cada modelo de intervalos temporais é ajustado. Cada start_station_name tem três linhas de resultados previstos, conforme especificado pelo valor de horizon.

Para cada start_station_name, as linhas de saída estão por ordem cronológica do valor da coluna forecast_timestamp. Na previsão de séries cronológicas, o intervalo de previsão, representado pelos valores das colunas prediction_interval_lower_bound e prediction_interval_upper_bound, é tão importante quanto o valor da coluna forecast_value. O valor forecast_value é o ponto médio

do intervalo de previsão. O intervalo de previsão depende dos valores das colunas standard_error e confidence_level.

Explicar os resultados da previsão

SQL

Pode obter métricas de explicabilidade, além dos dados de previsão, usando a função ML.EXPLAIN_FORECAST. A função ML.EXPLAIN_FORECAST prevê

valores de séries cronológicas futuras e também devolve todos os componentes separados das

séries cronológicas. Se quiser apenas devolver dados de previsão, use a função ML.FORECAST

em alternativa, conforme mostrado em

Use o modelo para prever dados.

A cláusula STRUCT(3 AS horizon, 0.9 AS confidence_level) usada na função ML.EXPLAIN_FORECAST indica que a consulta prevê 3 pontos no tempo futuros e gera um intervalo de previsão com 90% de confiança.

Siga estes passos para explicar os resultados do modelo:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

SELECT * FROM ML.EXPLAIN_FORECAST(MODEL `bqml_tutorial.nyc_citibike_arima_model_group`, STRUCT(3 AS horizon, 0.9 AS confidence_level));

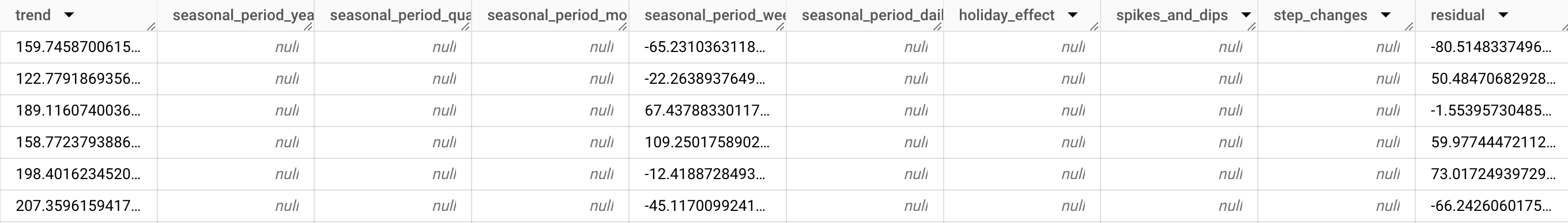

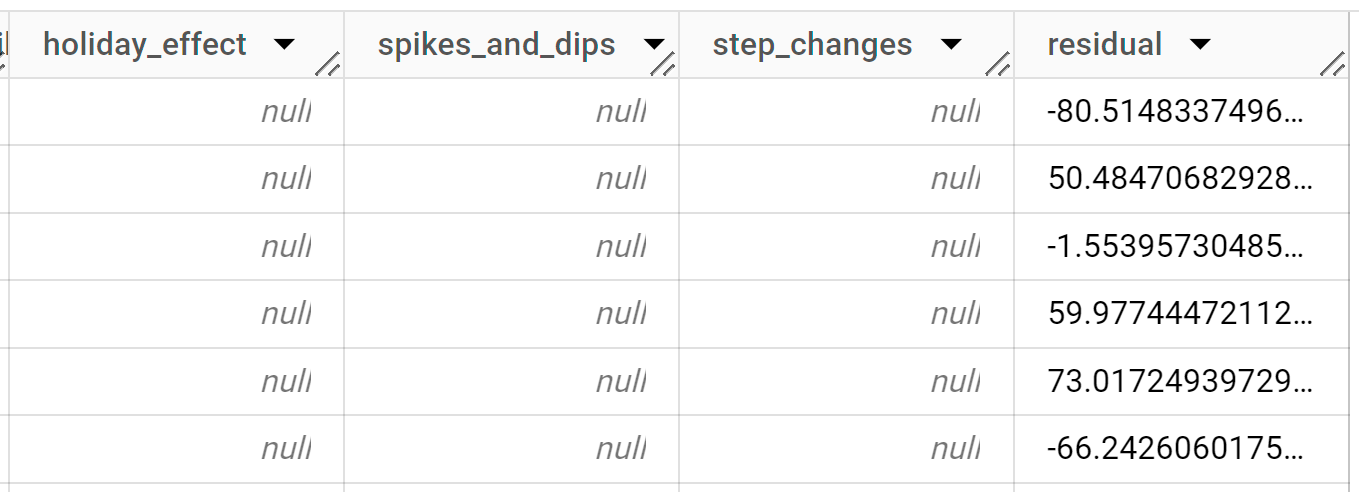

A consulta demora menos de um segundo a concluir. Os resultados devem ter o seguinte aspeto:

As primeiras milhares de linhas devolvidas são todas dados do histórico. Tem de deslocar a página pelos resultados para ver os dados de previsão.

As linhas de saída são ordenadas primeiro por

start_station_namee, em seguida, cronologicamente pelo valor da colunatime_series_timestamp. Na previsão de séries cronológicas, o intervalo de previsão, representado pelos valores das colunasprediction_interval_lower_boundeprediction_interval_upper_bound, é tão importante quanto o valor da colunaforecast_value. O valorforecast_valueé o ponto médio do intervalo de previsão. O intervalo de previsão depende dos valores das colunasstandard_erroreconfidence_level.Para mais informações sobre as colunas de saída, consulte

ML.EXPLAIN_FORECAST.

DataFrames do BigQuery

Pode obter métricas de explicabilidade, além dos dados de previsão, usando a função predict_explain. A função predict_explain prevê

valores de séries cronológicas futuras e também devolve todos os componentes separados das

séries cronológicas. Se quiser apenas devolver dados de previsão, use a função predict

em alternativa, conforme mostrado em

Use o modelo para prever dados.

A cláusula horizon=3, confidence_level=0.9 usada na função predict_explain indica que a consulta prevê 3 pontos no tempo futuros e gera um intervalo de previsão com 90% de confiança.

Antes de experimentar este exemplo, siga as instruções de configuração dos DataFrames do BigQuery no início rápido do BigQuery com os DataFrames do BigQuery. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para se autenticar no BigQuery, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure o ADC para um ambiente de desenvolvimento local.

As linhas de saída são ordenadas primeiro por time_series_timestamp e, em seguida, cronologicamente pelo valor da coluna start_station_name. Na previsão de séries cronológicas, o intervalo de previsão, representado pelos valores das colunas prediction_interval_lower_bound e prediction_interval_upper_bound, é tão importante quanto o valor da coluna forecast_value. O valor forecast_value é o ponto médio

do intervalo de previsão. O intervalo de previsão depende dos valores das colunas standard_error e confidence_level.