Ejecutar una consulta

En este documento se explica cómo ejecutar una consulta en BigQuery y saber cuántos datos procesará la consulta antes de ejecutarla mediante una prueba.

Tipos de consultas

Puedes consultar datos de BigQuery con uno de los siguientes tipos de trabajo de consulta:

Trabajos de consulta interactiva. De forma predeterminada, BigQuery ejecuta las consultas como tareas de consulta interactivas, que están diseñadas para empezar a ejecutarse lo antes posible.

Consultas por lotes. Las consultas por lotes tienen una prioridad inferior a las consultas interactivas. Cuando un proyecto o una reserva utiliza todos los recursos de computación disponibles, es más probable que las consultas por lotes se pongan en cola y permanezcan en ella. Una vez que se inicia una consulta por lotes, se ejecuta igual que una consulta interactiva. Para obtener más información, consulta el artículo sobre colas de consultas.

Trabajos de consulta continua. Con estas tareas, la consulta se ejecuta de forma continua, lo que te permite analizar los datos entrantes en BigQuery en tiempo real y, a continuación, escribir los resultados en una tabla de BigQuery o exportarlos a Bigtable o Pub/Sub. Puedes usar esta función para llevar a cabo tareas urgentes, como crear estadísticas y actuar en consecuencia de inmediato, aplicar inferencias de aprendizaje automático (ML) en tiempo real y crear flujos de datos basados en eventos.

Puedes ejecutar trabajos de consulta con los siguientes métodos:

- Redacta y ejecuta una consulta en la Google Cloud consola.

- Ejecuta el comando

bq queryen la herramienta de línea de comandos bq. - Llama mediante programación al método

jobs.queryojobs.inserten la API REST de BigQuery. - Usa las bibliotecas de cliente de BigQuery.

BigQuery guarda los resultados de las consultas en una tabla temporal (opción predeterminada) o en una tabla permanente. Cuando especifica una tabla permanente como tabla de destino de los resultados, puede elegir si quiere añadir datos a una tabla que ya tenga o sobrescribirla, o bien crear una tabla con un nombre único.

Roles obligatorios

Para obtener los permisos que necesitas para ejecutar un trabajo de consulta, pide a tu administrador que te conceda los siguientes roles de gestión de identidades y accesos:

-

Usuario de tareas de BigQuery (

roles/bigquery.jobUser) en el proyecto. -

Lector de datos de BigQuery (

roles/bigquery.dataViewer) en todas las tablas y vistas a las que hace referencia tu consulta. Para consultar vistas, también necesitas este rol en todas las tablas y vistas subyacentes. Si usa vistas autorizadas o conjuntos de datos autorizados, no necesita tener acceso a los datos de origen subyacentes.

Para obtener más información sobre cómo conceder roles, consulta el artículo Gestionar el acceso a proyectos, carpetas y organizaciones.

Estos roles predefinidos contienen los permisos necesarios para ejecutar una tarea de consulta. Para ver los permisos exactos que se necesitan, despliega la sección Permisos necesarios:

Permisos obligatorios

Para ejecutar una tarea de consulta, se necesitan los siguientes permisos:

-

bigquery.jobs.createen el proyecto desde el que se ejecuta la consulta, independientemente de dónde se almacenen los datos. -

bigquery.tables.getDataen todas las tablas y vistas a las que hace referencia tu consulta. Para consultar vistas, también necesitas este permiso en todas las tablas y vistas subyacentes. Si usa vistas autorizadas o conjuntos de datos autorizados, no necesita acceder a los datos de origen subyacentes.

También puedes obtener estos permisos con roles personalizados u otros roles predefinidos.

Solución de problemas

Access Denied: Project [project_id]: User does not have bigquery.jobs.create

permission in project [project_id].

Este error se produce cuando una entidad de seguridad no tiene permiso para crear trabajos de consulta en el proyecto.

Solución: Un administrador debe concederte el permiso bigquery.jobs.create

en el proyecto que estás consultando. Este permiso es obligatorio, además de cualquier otro permiso necesario para acceder a los datos consultados.

Para obtener más información sobre los permisos de BigQuery, consulta Control de acceso con gestión de identidades y accesos.

Ejecutar una consulta interactiva

Para ejecutar una consulta interactiva, selecciona una de las siguientes opciones:

Consola

Ve a la página BigQuery.

Haz clic en Consulta de SQL.

En el editor de consultas, introduce una consulta de GoogleSQL válida.

Por ejemplo, consulta el conjunto de datos público de BigQuery

usa_namespara determinar los nombres más comunes en Estados Unidos entre los años 1910 y 2013:SELECT name, gender, SUM(number) AS total FROM `bigquery-public-data.usa_names.usa_1910_2013` GROUP BY name, gender ORDER BY total DESC LIMIT 10;También puedes usar el panel Referencia para crear nuevas consultas.

Opcional: Para mostrar automáticamente sugerencias de código al escribir una consulta, haz clic en Más y, a continuación, selecciona Autocompletar SQL. Si no necesitas sugerencias de autocompletar, desmarca Autocompletar SQL. También se desactivarán las sugerencias de Autocompletar del nombre del proyecto.

Opcional: Para seleccionar ajustes de consulta adicionales, haz clic en Más y, a continuación, en Ajustes de consulta.

Haz clic en Ejecutar.

Si no especificas una tabla de destino, la tarea de consulta escribe el resultado en una tabla temporal (caché).

Ahora puedes consultar los resultados de la consulta en la pestaña Resultados del panel Resultados de la consulta.

Opcional: Para ordenar los resultados de la consulta por columna, haz clic en Abrir menú de ordenación junto al nombre de la columna y selecciona un orden. Si el número de bytes estimados procesados para la ordenación es superior a cero, se muestra en la parte superior del menú.

Opcional: Para ver una visualización de los resultados de tu consulta, ve a la pestaña Visualización. Puedes ampliar o reducir el gráfico, descargarlo como archivo PNG o activar o desactivar la visibilidad de la leyenda.

En el panel Configuración de la visualización, puede cambiar el tipo de visualización y configurar las medidas y las dimensiones de la visualización. Los campos de este panel se rellenan automáticamente con la configuración inicial inferida del esquema de la tabla de destino de la consulta. La configuración se conserva entre las siguientes ejecuciones de consultas en el mismo editor de consultas.

En las visualizaciones Líneas, Barras y De dispersión, las dimensiones admitidas son los tipos de datos

INT64,FLOAT64,NUMERIC,BIGNUMERIC,TIMESTAMP,DATE,DATETIME,TIMEySTRING, mientras que las medidas admitidas son los tipos de datosINT64,FLOAT64,NUMERICyBIGNUMERIC.Si los resultados de tu consulta incluyen el tipo

GEOGRAPHY, Mapa es el tipo de visualización predeterminado, que te permite visualizar los resultados en un mapa interactivo.Opcional: En la pestaña JSON, puedes consultar los resultados de la consulta en formato JSON, donde la clave es el nombre de la columna y el valor es el resultado de esa columna.

bq

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Usa el comando

bq query. En el siguiente ejemplo, la marca--use_legacy_sql=falsete permite usar la sintaxis de GoogleSQL.bq query \ --use_legacy_sql=false \ 'QUERY'

Sustituye QUERY por una consulta de GoogleSQL válida. Por ejemplo, consulta el conjunto de datos público de BigQuery

usa_namespara determinar los nombres más comunes en Estados Unidos entre 1910 y 2013:bq query \ --use_legacy_sql=false \ 'SELECT name, gender, SUM(number) AS total FROM `bigquery-public-data.usa_names.usa_1910_2013` GROUP BY name, gender ORDER BY total DESC LIMIT 10;'La tarea de consulta escribe el resultado en una tabla temporal (caché).

También puede especificar la tabla de destino y la ubicación de los resultados de la consulta. Para escribir los resultados en una tabla, incluye la marca adecuada para añadir (

--append_table=true) o sobrescribir (--replace=true) la tabla.bq query \ --location=LOCATION \ --destination_table=TABLE \ --use_legacy_sql=false \ 'QUERY'

Haz los cambios siguientes:

LOCATION: la región o multirregión de la tabla de destino. Por ejemplo,

US.En este ejemplo, el conjunto de datos

usa_namesse almacena en la ubicación multirregional de EE. UU. Si especificas una tabla de destino para esta consulta, el conjunto de datos que contenga la tabla de destino también debe estar en la multirregión de EE. UU. No puedes consultar un conjunto de datos de una ubicación y escribir los resultados en una tabla de otra ubicación.Puedes definir un valor predeterminado para la ubicación mediante el archivo.bigqueryrc.

TABLE: un nombre para la tabla de destino (por ejemplo,)

myDataset.myTableSi la tabla de destino es nueva, BigQuery la crea cuando ejecutas la consulta. Sin embargo, debes especificar un conjunto de datos.

Si la tabla no está en tu proyecto actual, añade el ID del proyecto con el formatoGoogle Cloud

PROJECT_ID:DATASET.TABLE(por ejemplo,myProject:myDataset.myTable). Si no se especifica--destination_table, se genera una tarea de consulta que escribe el resultado en una tabla temporal.

API

Para ejecutar una consulta mediante la API, inserta un nuevo trabajo y rellena la propiedad de configuración del trabajo query. También puedes especificar tu ubicación en la propiedad location de la sección jobReference del recurso Job.

Consulta los resultados llamando al getQueryResults.

Encuesta hasta jobComplete es igual a true. Comprueba si hay errores y advertencias en la lista errors.

C#

Antes de probar este ejemplo, sigue las C#instrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API C# de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Go

Antes de probar este ejemplo, sigue las Goinstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Go de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Java

Antes de probar este ejemplo, sigue las Javainstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Java de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Para ejecutar una consulta con un proxy, consulta Configurar un proxy.

Node.js

Antes de probar este ejemplo, sigue las Node.jsinstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Node.js de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

PHP

Antes de probar este ejemplo, sigue las PHPinstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API PHP de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Python

Antes de probar este ejemplo, sigue las Pythoninstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Python de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Ruby

Antes de probar este ejemplo, sigue las Rubyinstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Ruby de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Ejecutar una consulta por lotes

Para ejecutar una consulta por lotes, selecciona una de las siguientes opciones:

Consola

Ve a la página BigQuery.

Haz clic en Consulta de SQL.

En el editor de consultas, introduce una consulta de GoogleSQL válida.

Por ejemplo, consulta el conjunto de datos público de BigQuery

usa_namespara determinar los nombres más comunes en Estados Unidos entre los años 1910 y 2013:SELECT name, gender, SUM(number) AS total FROM `bigquery-public-data.usa_names.usa_1910_2013` GROUP BY name, gender ORDER BY total DESC LIMIT 10;Haz clic en Más y, a continuación, en Configuración de la consulta.

En la sección Gestión de recursos, selecciona Lote.

Opcional: Ajusta la configuración de la consulta.

Haz clic en Guardar.

Haz clic en Ejecutar.

Si no especificas una tabla de destino, la tarea de consulta escribe el resultado en una tabla temporal (caché).

bq

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Usa el comando

bq queryy especifica la marca--batch. En el siguiente ejemplo, la marca--use_legacy_sql=falsele permite usar la sintaxis de GoogleSQL.bq query \ --batch \ --use_legacy_sql=false \ 'QUERY'

Sustituye QUERY por una consulta de GoogleSQL válida. Por ejemplo, consulta el conjunto de datos público de BigQuery

usa_namespara determinar los nombres más comunes en Estados Unidos entre 1910 y 2013:bq query \ --batch \ --use_legacy_sql=false \ 'SELECT name, gender, SUM(number) AS total FROM `bigquery-public-data.usa_names.usa_1910_2013` GROUP BY name, gender ORDER BY total DESC LIMIT 10;'La tarea de consulta escribe el resultado en una tabla temporal (caché).

También puede especificar la tabla de destino y la ubicación de los resultados de la consulta. Para escribir los resultados en una tabla, incluye la marca adecuada para añadir (

--append_table=true) o sobrescribir (--replace=true) la tabla.bq query \ --batch \ --location=LOCATION \ --destination_table=TABLE \ --use_legacy_sql=false \ 'QUERY'

Haz los cambios siguientes:

LOCATION: la región o multirregión de la tabla de destino. Por ejemplo,

US.En este ejemplo, el conjunto de datos

usa_namesse almacena en la ubicación multirregional de EE. UU. Si especificas una tabla de destino para esta consulta, el conjunto de datos que contenga la tabla de destino también debe estar en la multirregión de EE. UU. No puedes consultar un conjunto de datos de una ubicación y escribir los resultados en una tabla de otra ubicación.Puedes definir un valor predeterminado para la ubicación mediante el archivo.bigqueryrc.

TABLE: un nombre para la tabla de destino (por ejemplo,)

myDataset.myTableSi la tabla de destino es nueva, BigQuery la crea cuando ejecutas la consulta. Sin embargo, debes especificar un conjunto de datos.

Si la tabla no está en tu proyecto actual, añade el ID del proyecto con el formatoGoogle Cloud

PROJECT_ID:DATASET.TABLE(por ejemplo,myProject:myDataset.myTable). Si no se especifica--destination_table, se genera una tarea de consulta que escribe el resultado en una tabla temporal.

API

Para ejecutar una consulta mediante la API, inserta un nuevo trabajo y rellena la propiedad de configuración del trabajo query. También puedes especificar tu ubicación en la propiedad location de la sección jobReference del recurso Job.

Cuando rellenes las propiedades de la tarea de consulta, incluye la propiedad configuration.query.priority y asigna el valor BATCH.

Consulta los resultados llamando al getQueryResults.

Encuesta hasta jobComplete es igual a true. Comprueba si hay errores y advertencias en la lista errors.

Go

Antes de probar este ejemplo, sigue las Goinstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Go de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Java

Para ejecutar una consulta por lotes, define la prioridad de la consulta como QueryJobConfiguration.Priority.BATCH al crear una QueryJobConfiguration.

Antes de probar este ejemplo, sigue las Javainstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Java de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Node.js

Antes de probar este ejemplo, sigue las Node.jsinstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Node.js de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Python

Antes de probar este ejemplo, sigue las Pythoninstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Python de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Ejecutar una consulta continua

Para ejecutar un trabajo de consulta continua, se necesita una configuración adicional. Para obtener más información, consulta el artículo Crear consultas continuas.

Usar el panel Referencia

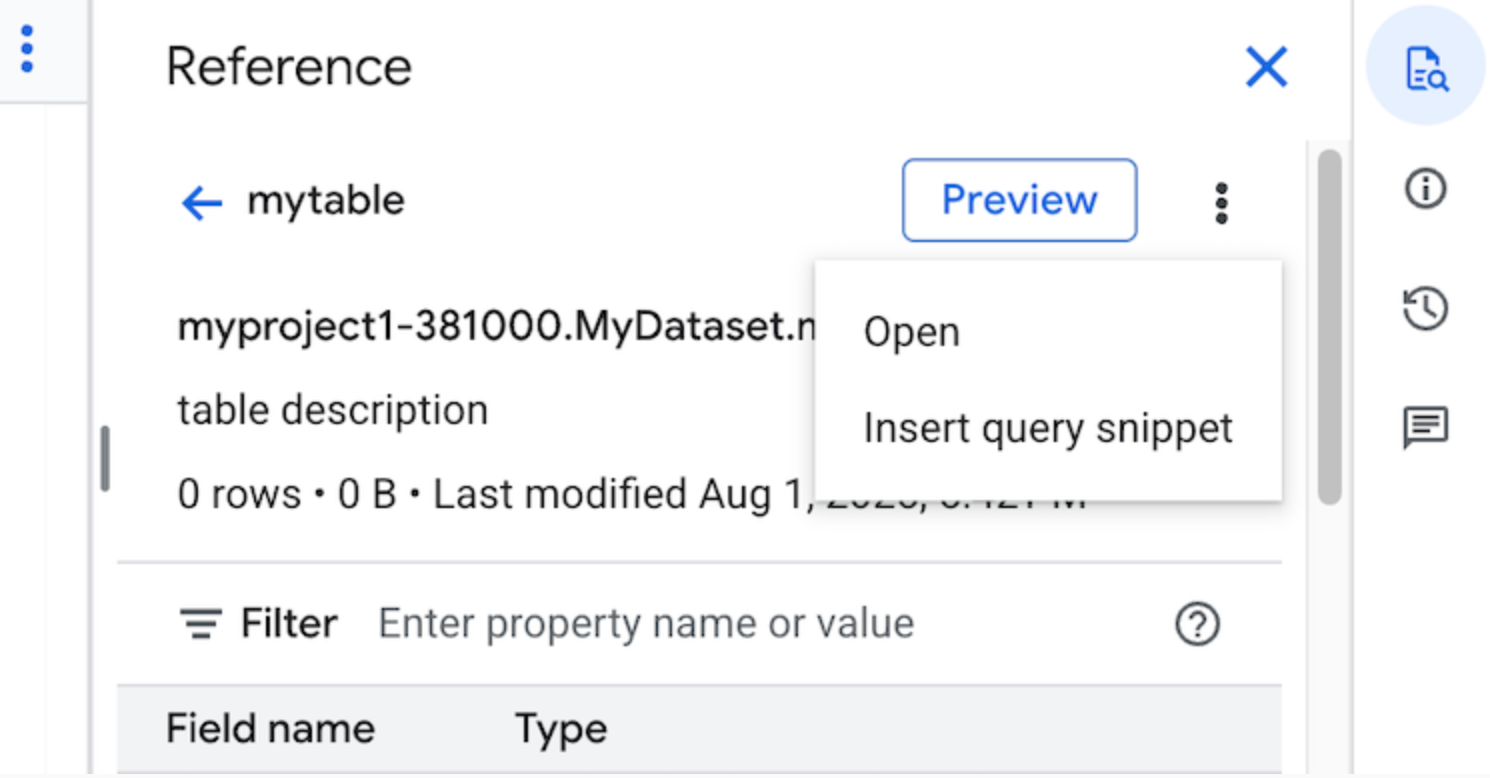

En el editor de consultas, el panel Referencia muestra de forma dinámica información contextual sobre tablas, copias de seguridad, vistas y vistas materializadas. El panel te permite ver una vista previa de los detalles del esquema de estos recursos o abrirlos en una pestaña nueva. También puedes usar el panel Referencia para crear consultas o editar las que ya tengas insertando fragmentos de consulta o nombres de campos.

Para crear una consulta con el panel Referencia, sigue estos pasos:

En la Google Cloud consola, ve a la página BigQuery.

Haz clic en Consulta de SQL.

Haz clic en quick_reference_all Referencia.

Haz clic en una tabla o vista reciente o destacada. También puedes usar la barra de búsqueda para encontrar tablas y vistas.

Haz clic en Ver acciones y, a continuación, en Insertar fragmento de consulta.

Opcional: Puedes obtener una vista previa de los detalles del esquema de la tabla o la vista, o bien abrirlos en una pestaña nueva.

Ahora puedes editar la consulta manualmente o insertar nombres de campo directamente en ella. Para insertar un nombre de campo, coloca el cursor en el editor de consultas donde quieras insertarlo y haz clic en el nombre de campo del panel Referencia.

Configuración de consultas

Cuando ejecutas una consulta, puedes especificar los siguientes ajustes:

Una tabla de destino para los resultados de la consulta.

La prioridad del trabajo.

Indica si se deben usar los resultados de la consulta almacenados en caché.

Tiempo de espera del trabajo en milisegundos.

Indica si se debe usar el modo de sesión.

El tipo de cifrado que se va a usar.

Número máximo de bytes facturados por la consulta.

El dialecto de SQL que se va a usar.

La ubicación en la que se ejecutará la consulta. La consulta debe ejecutarse en la misma ubicación que las tablas a las que haga referencia.

La reserva para ejecutar la consulta (Vista previa).

Modo de creación de tareas opcional

El modo de creación de trabajos opcional puede mejorar la latencia general de las consultas que se ejecutan durante un breve periodo, como las de los paneles de control o las cargas de trabajo de exploración de datos. Este modo ejecuta la consulta y devuelve los resultados insertados para las instrucciones SELECT sin necesidad de usar jobs.getQueryResults para obtener los resultados. Las consultas que usan el modo de creación de trabajos opcional no crean un trabajo cuando se ejecutan, a menos que BigQuery determine que es necesario crear un trabajo para completar la consulta.

Para habilitar el modo de creación de tareas opcional, asigna el valor JOB_CREATION_OPTIONAL al campo jobCreationMode de la instancia QueryRequest en el cuerpo de la solicitud jobs.query.

Si el valor de este campo es JOB_CREATION_OPTIONAL, BigQuery determina si la consulta puede usar el modo de creación de trabajos opcional. Si es así, BigQuery ejecuta la consulta y devuelve todos los resultados en el campo rows de la respuesta. Como no se crea ningún trabajo para esta consulta, BigQuery no devuelve ningún jobReference en el cuerpo de la respuesta. En su lugar, devuelve un campo queryId que puedes usar para obtener estadísticas sobre la consulta mediante la INFORMATION_SCHEMA.JOBSvista. Como no se ha creado ningún trabajo, no hay ningún jobReference que se pueda transferir a las APIs jobs.get y jobs.getQueryResults para buscar estas consultas.

Si BigQuery determina que se necesita una tarea para completar la consulta, se devuelve un jobReference. Puedes inspeccionar el campo job_creation_reason

en la vista INFORMATION_SCHEMA.JOBSpara determinar

el motivo por el que se ha creado una tarea para la consulta. En este caso, debes usar jobs.getQueryResults para obtener los resultados cuando se complete la consulta.

Si usa el valor JOB_CREATION_OPTIONAL, es posible que el campo jobReference no esté presente en la respuesta. Comprueba si el campo existe antes de acceder a él.

Cuando se especifica JOB_CREATION_OPTIONAL en consultas de varias instrucciones (secuencias de comandos), BigQuery puede optimizar el proceso de ejecución. Como parte de esta optimización, BigQuery puede determinar que puede completar la secuencia de comandos creando menos recursos de tareas que el número de instrucciones individuales, e incluso puede ejecutar toda la secuencia de comandos sin crear ninguna tarea.

Esta optimización depende de la evaluación que haga BigQuery de la secuencia de comandos, por lo que puede que no se aplique en todos los casos. El sistema automatiza por completo la optimización. No se requieren controles ni acciones por parte del usuario.

Para ejecutar una consulta con el modo de creación de trabajo opcional, selecciona una de las siguientes opciones:

Consola

Ve a la página BigQuery.

Haz clic en Consulta de SQL.

En el editor de consultas, introduce una consulta de GoogleSQL válida.

Por ejemplo, consulta el conjunto de datos público de BigQuery

usa_namespara determinar los nombres más comunes en Estados Unidos entre los años 1910 y 2013:SELECT name, gender, SUM(number) AS total FROM `bigquery-public-data.usa_names.usa_1910_2013` GROUP BY name, gender ORDER BY total DESC LIMIT 10;Haz clic en Más y, a continuación, elige el modo de consulta Creación de tareas opcional. Para confirmar esta opción, haz clic en Confirmar.

Haz clic en Ejecutar.

bq

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Usa el comando

bq queryy especifica la marca--job_creation_mode=JOB_CREATION_OPTIONAL. En el siguiente ejemplo, la marca--use_legacy_sql=falsele permite usar la sintaxis de GoogleSQL.bq query \ --rpc=true \ --use_legacy_sql=false \ --job_creation_mode=JOB_CREATION_OPTIONAL \ --location=LOCATION \ 'QUERY'

Sustituye QUERY por una consulta de GoogleSQL válida y LOCATION por una región válida en la que se encuentre el conjunto de datos. Por ejemplo, consulta el conjunto de datos público de BigQuery

usa_namespara determinar los nombres más comunes en Estados Unidos entre 1910 y 2013:bq query \ --rpc=true \ --use_legacy_sql=false \ --job_creation_mode=JOB_CREATION_OPTIONAL \ --location=us \ 'SELECT name, gender, SUM(number) AS total FROM `bigquery-public-data.usa_names.usa_1910_2013` GROUP BY name, gender ORDER BY total DESC LIMIT 10;'El trabajo de consulta devuelve la salida insertada en la respuesta.

API

Para ejecutar una consulta en el modo de creación de tareas opcional mediante la API, ejecuta una consulta de forma síncrona y rellena la propiedad QueryRequest. Incluye la propiedad jobCreationMode y asigna el valor JOB_CREATION_OPTIONAL.

Comprueba la respuesta. Si jobComplete es igual a true y jobReference está vacío, consulta los resultados del campo rows. También puedes obtener el queryId de la respuesta.

Si jobReference está presente, puedes consultar jobCreationReason para saber por qué BigQuery ha creado un trabajo. Consulta los resultados llamando al getQueryResults.

Encuesta hasta jobComplete es igual a true. Comprueba si hay errores y advertencias en la lista errors.

Java

Versión disponible: 2.51.0 y posteriores

Antes de probar este ejemplo, sigue las Javainstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Java de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Para ejecutar una consulta con un proxy, consulta Configurar un proxy.

Python

Versión disponible: 3.34.0 y posteriores

Antes de probar este ejemplo, sigue las Pythoninstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Python de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Node

Versión disponible: 8.1.0 y versiones posteriores

Antes de probar este ejemplo, sigue las Node.jsinstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Node.js de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Go

Versión disponible: 1.69.0 y versiones posteriores

Antes de probar este ejemplo, sigue las Goinstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Go de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Controlador JDBC

Versión disponible: JDBC v1.6.1 y versiones posteriores

Requiere definir JobCreationMode=2 en la cadena de conexión.

jdbc:bigquery://https://www.googleapis.com/bigquery/v2:443;JobCreationMode=2;Location=US;

Controlador ODBC

Versión disponible: ODBC 3.0.7.1016 y versiones posteriores

Requiere definir JobCreationMode=2 en el archivo .ini.

[ODBC Data Sources] Sample DSN=Simba Google BigQuery ODBC Connector 64-bit [Sample DSN] JobCreationMode=2

Cuotas

Para obtener información sobre las cuotas de las consultas interactivas y por lotes, consulta Tareas de consulta.

Monitorizar consultas

Puedes obtener información sobre las consultas mientras se ejecutan mediante el explorador de trabajos o consultando la vista INFORMATION_SCHEMA.JOBS_BY_PROJECT.

Ejecución de prueba

Una prueba en BigQuery proporciona la siguiente información:

- Estimación de los cargos en el modo bajo demanda

- validación de tu consulta

- Bytes aproximados procesados por tu consulta en el modo de capacidad

Las pruebas no usan ranuras de consulta y no se te cobra por realizarlas. Puedes usar la estimación devuelta por una prueba para calcular los costes de las consultas en la calculadora de precios.

Realizar una prueba de funcionamiento

Para hacer una prueba de funcionamiento, sigue estos pasos:

Consola

Ve a la página de BigQuery.

Escribe tu consulta en el editor de consultas.

Si la consulta es válida, aparecerá automáticamente una marca de verificación junto con la cantidad de datos que procesará la consulta. Si la consulta no es válida, aparecerá un signo de exclamación junto con un mensaje de error.

bq

Introduce una consulta como la siguiente con la marca --dry_run.

bq query \ --use_legacy_sql=false \ --dry_run \ 'SELECT COUNTRY, AIRPORT, IATA FROM `project_id`.dataset.airports LIMIT 1000'

Si la consulta es válida, el comando genera la siguiente respuesta:

Query successfully validated. Assuming the tables are not modified, running this query will process 10918 bytes of data.

API

Para hacer una prueba con la API, envía una tarea de consulta con el valor true en el campo dryRun del tipo JobConfiguration.

Go

Antes de probar este ejemplo, sigue las Goinstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Go de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Java

Antes de probar este ejemplo, sigue las Javainstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Java de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Node.js

Antes de probar este ejemplo, sigue las Node.jsinstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Node.js de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

PHP

Antes de probar este ejemplo, sigue las PHPinstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API PHP de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Python

Asigna el valor True a la propiedad QueryJobConfig.dry_run.

Client.query()

siempre devuelve un QueryJob

completado cuando se proporciona una configuración de consulta de prueba.

Antes de probar este ejemplo, sigue las Pythoninstrucciones de configuración de la guía de inicio rápido de BigQuery con bibliotecas de cliente. Para obtener más información, consulta la documentación de referencia de la API Python de BigQuery.

Para autenticarte en BigQuery, configura las credenciales predeterminadas de la aplicación. Para obtener más información, consulta el artículo Configurar la autenticación para bibliotecas de cliente.

Siguientes pasos

- Consulta cómo gestionar trabajos de consulta.

- Consulta cómo ver el historial de consultas.

- Consulta cómo guardar y compartir consultas.

- Más información sobre las colas de consultas

- Consulta cómo escribir resultados de consultas.