Gestione dei dati delle tabelle

Questo documento descrive come gestire i dati delle tabelle in BigQuery. Puoi lavorare con i dati delle tabelle BigQuery nei seguenti modi:

- Carica i dati in una tabella

- Aggiungere o sovrascrivere i dati della tabella

- Sfogliare (o visualizzare l'anteprima) i dati della tabella

- Esegui query sui dati della tabella

- Modifica i dati della tabella utilizzando DML (Data Manipulation Language)

- Copia i dati della tabella

- Esportare i dati delle tabelle

Per informazioni sulla gestione degli schemi delle tabelle, vedi Modifica degli schemi delle tabelle.

Prima di iniziare

Concedi ruoli che forniscono le autorizzazioni necessarie agli utenti che devono eseguire ogni attività descritta in questo documento. Le autorizzazioni richieste (se presenti) per eseguire un'attività sono elencate nella sezione "Autorizzazioni richieste" dell'attività.

Caricamento di dati in una tabella

Puoi caricare i dati quando crei una tabella oppure puoi creare una tabella vuota e caricare i dati in un secondo momento. Quando carichi i dati, puoi utilizzare il rilevamento automatico dello schema per i formati di dati supportati oppure puoi specificare lo schema.

Per ulteriori informazioni sul caricamento dei dati, consulta la documentazione relativa al formato e alla posizione dei dati di origine:

Per ulteriori informazioni sul caricamento dei dati da Cloud Storage, consulta:

Per ulteriori informazioni sul caricamento dei dati da un'origine locale, consulta Caricamento dei dati da file locali.

Aggiunta e sovrascrittura dei dati della tabella

Puoi sovrascrivere i dati della tabella utilizzando un'operazione di caricamento o query. Puoi aggiungere dati aggiuntivi a una tabella esistente eseguendo un'operazione di caricamento e aggiunta o aggiungendo i risultati della query alla tabella.

Per ulteriori informazioni sull'aggiunta o la sovrascrittura di una tabella durante il caricamento dei dati, consulta la documentazione relativa al formato dei dati di origine:

- Aggiungere o sovrascrivere una tabella con dati Avro

- Aggiungere o sovrascrivere una tabella con dati CSV

- Aggiunta o sovrascrittura di una tabella con dati JSON

- Aggiungere o sovrascrivere una tabella con dati Parquet

- Aggiungere o sovrascrivere una tabella con dati ORC

- Aggiungere o sovrascrivere una tabella con i dati Datastore

Per aggiungere o sovrascrivere una tabella utilizzando i risultati della query, specifica una tabella di destinazione e imposta la disposizione di scrittura su:

- Aggiungi alla tabella: aggiunge i risultati della query a una tabella esistente.

- Sovrascrivi tabella: sovrascrive una tabella esistente con lo stesso nome utilizzando i risultati della query.

Puoi utilizzare la seguente query per aggiungere record da una tabella a un'altra:

INSERT INTO <projectID>.<datasetID>.<table1> ( <column2>, <column3>) (SELECT * FROM <projectID>.<datasetID>.<table2>)

Per ulteriori informazioni sull'utilizzo dei risultati delle query per aggiungere o sovrascrivere dati, vedi Scrivere i risultati delle query.

Esplorare i dati della tabella

Puoi sfogliare o leggere i dati della tabella in base a:

- Utilizzo della console Google Cloud

- Utilizzo del comando

bq headdello strumento a riga di comando bq - Chiamata del metodo API

tabledata.list - Utilizzo delle librerie client

Autorizzazioni obbligatorie

Per leggere i dati di tabelle e partizioni, devi disporre dell'autorizzazione Identity and Access Management (IAM) bigquery.tables.getData.

Ognuno dei seguenti ruoli IAM predefiniti include le autorizzazioni necessarie per sfogliare i dati di tabelle e partizioni:

roles/bigquery.dataViewerroles/bigquery.dataEditorroles/bigquery.dataOwnerroles/bigquery.admin

Se disponi dell'autorizzazione bigquery.datasets.create, puoi sfogliare i dati nelle tabelle e nelle partizioni dei set di dati che crei.

Per saperne di più sui ruoli e sulle autorizzazioni IAM in BigQuery, consulta Ruoli e autorizzazioni predefiniti.

Esplorare i dati della tabella

Per sfogliare i dati della tabella:

Console

Nella console Google Cloud , apri la pagina BigQuery.

Nel riquadro Spazio di esplorazione, espandi il progetto e seleziona un set di dati.

Fai clic su una tabella nell'elenco.

Fai clic su Dettagli e prendi nota del valore in Numero di righe. Potresti aver bisogno di questo valore per controllare il punto di partenza dei risultati utilizzando lo strumento a riga di comando o l'API bq.

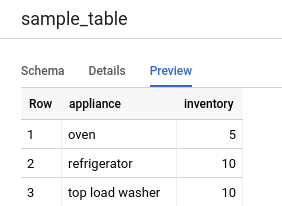

Fai clic su Anteprima. Viene visualizzato un set di dati di esempio.

Riga di comando

Esegui il comando bq head con il flag --max_rows per elencare tutte le colonne in

un determinato numero di righe della tabella. Se --max_rows non è specificato, il valore predefinito

è 100.

Per sfogliare un sottoinsieme di colonne nella tabella (incluse le colonne nidificate e ripetute), utilizza il flag --selected_fields e inserisci le colonne come elenco separato da virgole.

Per specificare il numero di righe da saltare prima di visualizzare i dati della tabella, utilizza il flag

--start_row=integer (o la scorciatoia -s). Il valore predefinito è 0. Puoi recuperare il numero di righe in una tabella utilizzando

il comando bq show per recuperare le informazioni sulla tabella.

Se la tabella che stai sfogliando si trova in un progetto diverso da quello predefinito,

aggiungi l'ID progetto al comando nel seguente formato:

project_id:dataset.table.

bq head \ --max_rows integer1 \ --start_row integer2 \ --selected_fields "columns" \ project_id:dataset.table

Dove:

- integer1 è il numero di righe da visualizzare.

- integer2 è il numero di righe da saltare prima di visualizzare i dati.

- columns è un elenco di colonne separate da virgole.

- project_id è l'ID progetto.

- dataset è il nome del set di dati contenente la tabella.

- table è il nome della tabella da sfogliare.

Esempi:

Inserisci il seguente comando per elencare tutte le colonne nelle prime 10 righe di

mydataset.mytable. mydataset si trova nel tuo progetto predefinito.

bq head --max_rows=10 mydataset.mytable

Inserisci il seguente comando per elencare tutte le colonne nelle prime 100 righe di

mydataset.mytable. mydataset si trova in myotherproject, non nel tuo progetto

predefinito.

bq head myotherproject:mydataset.mytable

Inserisci il seguente comando per visualizzare solo field1 e field2 in

mydataset.mytable. Il comando utilizza il flag --start_row per passare alla riga 100.

mydataset.mytable si trova nel tuo progetto predefinito.

bq head --start_row 100 --selected_fields "field1,field2" mydataset.mytable

Poiché il comando bq head non crea un job di query, i comandi bq head non vengono visualizzati nella cronologia delle query e non ti vengono addebitati.

API

Sfoglia i dati di una tabella chiamando tabledata.list.

Specifica il nome della tabella nel parametro tableId.

Configura questi parametri facoltativi per controllare l'output:

maxResults: il numero massimo di risultati da restituireselectedFields: elenco separato da virgole delle colonne da restituire. Se non specificato, vengono restituite tutte le colonne.startIndex: indice in base zero della riga iniziale da leggere

I valori vengono restituiti racchiusi in un oggetto JSON che devi analizzare, come descritto

nella documentazione di riferimento tabledata.list.

C#

Prima di provare questo esempio, segui le istruzioni di configurazione di C# nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery C#.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Go

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Go.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Le librerie client di Cloud per Go eseguono automaticamente la paginazione per impostazione predefinita, quindi non devi implementarla manualmente, ad esempio:

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Node.js.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Le librerie client Cloud per Node.js eseguono automaticamente la paginazione per impostazione predefinita, quindi non è necessario implementarla manualmente, ad esempio:

PHP

Prima di provare questo esempio, segui le istruzioni di configurazione di PHP nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery PHP.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

L'impaginazione avviene automaticamente nelle librerie client di Cloud per PHP

utilizzando la funzione generatore rows, che recupera la pagina successiva di

risultati durante l'iterazione.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Ruby

Prima di provare questo esempio, segui le istruzioni di configurazione di Ruby nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Ruby.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

L'impaginazione avviene automaticamente nelle librerie client di Cloud per Ruby

utilizzando Table#data e Data#next.

Esecuzione di query sui dati della tabella

Puoi eseguire query sui dati BigQuery utilizzando uno dei seguenti tipi di job di query:

Job di query interattive. Per impostazione predefinita, BigQuery esegue le query come job di query interattive, che devono iniziare l'esecuzione il più rapidamente possibile.

Job di query batch. Le query batch hanno una priorità inferiore rispetto alle query interattive. Quando un progetto o una prenotazione utilizza tutte le risorse di calcolo disponibili, è più probabile che le query batch vengano messe in coda e rimangano in coda. Dopo l'avvio di una query batch, questa viene eseguita come una query interattiva. Per ulteriori informazioni, consulta la sezione Code di query.

Job di query continui. Con questi job, la query viene eseguita continuamente, consentendoti di analizzare i dati in entrata in BigQuery in tempo reale e quindi scrivere i risultati in una tabella BigQuery o esportarli in Bigtable o Pub/Sub. Puoi utilizzare questa funzionalità per eseguire attività sensibili al tempo, come creare e agire immediatamente in base agli approfondimenti, applicare l'inferenza di machine learning (ML) in tempo reale e creare pipeline di dati basate su eventi.

Puoi eseguire job di query utilizzando i seguenti metodi:

- Componi ed esegui una query nella consoleGoogle Cloud .

- Esegui il comando

bq querynello strumento a riga di comando bq. - Chiama in modo programmatico il metodo

jobs.queryojobs.insertnell'API REST di BigQuery. - Utilizza le librerie client di BigQuery.

Per ulteriori informazioni sull'esecuzione di query sulle tabelle BigQuery, consulta Introduzione all'esecuzione di query sui dati di BigQuery.

Oltre a eseguire query sui dati archiviati nelle tabelle BigQuery, puoi eseguire query sui dati archiviati esternamente. Per saperne di più, consulta Introduzione alle origini dati esterne.

Modifica dei dati delle tabelle

Puoi modificare i dati in una tabella utilizzando le istruzioni DML (Data Manipulation Language) in SQL. Le istruzioni DML consentono di aggiornare, unire, inserire ed eliminare righe nelle tabelle. Per esempi e riferimenti alla sintassi di ogni tipo di istruzione DML, consulta Istruzioni Data Manipulation Language in GoogleSQL.

Il dialetto SQL precedente non supporta le istruzioni DML. Per aggiornare o eliminare i dati utilizzandoSQL precedentey, devi eliminare la tabella e poi ricrearla con nuovi dati. In alternativa, puoi scrivere una query che modifichi i dati e scriva i risultati della query in una nuova tabella di destinazione.

Copia dei dati della tabella

Puoi copiare una tabella:

- Utilizzo della console Google Cloud

- Utilizzo del comando

bq cpdello strumento a riga di comando bq - Chiamare il metodo API

jobs.inserte configurare un job di copia - Utilizzo delle librerie client

Per ulteriori informazioni sulla copia delle tabelle, vedi Copiare una tabella.

Esportazione dei dati delle tabelle

Puoi esportare i dati della tabella in un bucket Cloud Storage in formato CSV, JSON, Avro o Parquet (anteprima). L'esportazione nel tuo computer locale non è supportata. Tuttavia, puoi scaricare e salvare i risultati delle query utilizzando la console Google Cloud .

Per ulteriori informazioni, vedi Esportare i dati delle tabelle.

Sicurezza delle tabelle

Per controllare l'accesso alle tabelle in BigQuery, vedi Controllare l'accesso alle risorse con IAM.

Passaggi successivi

- Per ulteriori informazioni sul caricamento dei dati, vedi Introduzione al caricamento dei dati.

- Per ulteriori informazioni sull'esecuzione di query sui dati, consulta Introduzione all'esecuzione di query sui dati di BigQuery.

- Per ulteriori informazioni sulla modifica degli schemi delle tabelle, vedi Modifica degli schemi delle tabelle.

- Per ulteriori informazioni sulla creazione e l'utilizzo delle tabelle, vedi Creazione e utilizzo delle tabelle.

- Per saperne di più sulla gestione delle tabelle, consulta Gestire le tabelle.