Neste tutorial, importa modelos do TensorFlow para um conjunto de dados do BigQuery ML. Em seguida, usa uma consulta SQL para fazer previsões a partir dos modelos importados.

Crie um conjunto de dados

Crie um conjunto de dados do BigQuery para armazenar o seu modelo de ML.

Consola

Na Google Cloud consola, aceda à página BigQuery.

No painel Explorador, clique no nome do projeto.

Clique em Ver ações > Criar conjunto de dados

Na página Criar conjunto de dados, faça o seguinte:

Para o ID do conjunto de dados, introduza

bqml_tutorial.Em Tipo de localização, selecione Várias regiões e, de seguida, selecione EUA (várias regiões nos Estados Unidos).

Deixe as restantes predefinições como estão e clique em Criar conjunto de dados.

bq

Para criar um novo conjunto de dados, use o comando

bq mk

com a flag --location. Para uma lista completa de parâmetros possíveis, consulte a referência do comando bq mk --dataset.

Crie um conjunto de dados com o nome

bqml_tutorialcom a localização dos dados definida comoUSe uma descrição deBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Em vez de usar a flag

--dataset, o comando usa o atalho-d. Se omitir-de--dataset, o comando cria um conjunto de dados por predefinição.Confirme que o conjunto de dados foi criado:

bq ls

API

Chame o método datasets.insert

com um recurso de conjunto de dados definido.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

DataFrames do BigQuery

Antes de experimentar este exemplo, siga as instruções de configuração dos DataFrames do BigQuery no início rápido do BigQuery com os DataFrames do BigQuery. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para se autenticar no BigQuery, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure o ADC para um ambiente de desenvolvimento local.

Importe um modelo do TensorFlow

Os passos seguintes mostram como importar um modelo do Cloud Storage.

O caminho para o modelo é

gs://cloud-training-demos/txtclass/export/exporter/1549825580/*. O nome do modelo importado é imported_tf_model.

Tenha em atenção que o URI do Cloud Storage termina num caráter universal (*).

Este caráter indica que o BigQuery ML deve importar todos os recursos

associados ao modelo.

O modelo importado é um modelo de classificador de texto do TensorFlow que prevê que Website publicou um determinado título de artigo.

Para importar o modelo do TensorFlow para o conjunto de dados, siga estes passos.

Consola

Na Google Cloud consola, aceda à página BigQuery.

Para Criar novo, clique em Consulta SQL.

No editor de consultas, introduza esta declaração

CREATE MODELe, de seguida, clique em Executar.CREATE OR REPLACE MODEL `bqml_tutorial.imported_tf_model` OPTIONS (MODEL_TYPE='TENSORFLOW', MODEL_PATH='gs://cloud-training-demos/txtclass/export/exporter/1549825580/*')

Quando a operação estiver concluída, deve ver uma mensagem como

Successfully created model named imported_tf_model.O novo modelo é apresentado no painel Recursos. Os modelos são indicados pelo ícone de modelo:

.

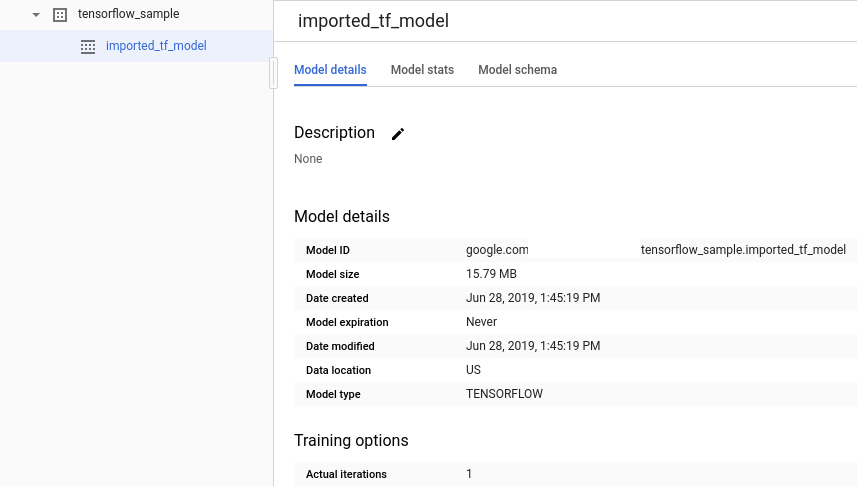

.Se selecionar o novo modelo no painel Recursos, as informações sobre o modelo aparecem abaixo do Editor de consultas.

bq

Importe o modelo do TensorFlow do Cloud Storage introduzindo a seguinte declaração

CREATE MODEL.bq query --use_legacy_sql=false \ "CREATE OR REPLACE MODEL `bqml_tutorial.imported_tf_model` OPTIONS (MODEL_TYPE='TENSORFLOW', MODEL_PATH='gs://cloud-training-demos/txtclass/export/exporter/1549825580/*')"

Depois de importar o modelo, verifique se este é apresentado no conjunto de dados.

bq ls -m bqml_tutorial

O resultado é semelhante ao seguinte:

tableId Type ------------------- ------- imported_tf_model MODEL

API

Insira uma nova tarefa e preencha a propriedade jobs#configuration.query no corpo do pedido.

{ "query": "CREATE MODEL `PROJECT_ID:bqml_tutorial.imported_tf_model` OPTIONS(MODEL_TYPE='TENSORFLOW' MODEL_PATH='gs://cloud-training-demos/txtclass/export/exporter/1549825580/*')" }

Substitua PROJECT_ID pelo nome do seu projeto e conjunto de dados.

DataFrames do BigQuery

Antes de experimentar este exemplo, siga as instruções de configuração dos DataFrames do BigQuery no início rápido do BigQuery com os DataFrames do BigQuery. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para se autenticar no BigQuery, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure o ADC para um ambiente de desenvolvimento local.

Importe o modelo através do objeto TensorFlowModel.

Para mais informações sobre a importação de modelos do TensorFlow para o BigQuery ML, incluindo os requisitos de formato e armazenamento, consulte a declaração CREATE MODEL para importar modelos do TensorFlow.

Faça previsões com o modelo do TensorFlow importado

Depois de importar o modelo do TensorFlow, usa a

ML.PREDICT função

para fazer previsões com o modelo.

A consulta seguinte usa imported_tf_model para fazer previsões com dados de entrada da tabela full no conjunto de dados público hacker_news. Na consulta, a função serving_input_fn do modelo do TensorFlow especifica que o modelo espera uma única string de entrada denominada input. A subconsulta atribui o alias input à coluna title na declaração SELECT da subconsulta.

Para fazer previsões com o modelo do TensorFlow importado, siga estes passos.

Consola

Na Google Cloud consola, aceda à página BigQuery.

Em Criar novo, clique em Consulta SQL.

No editor de consultas, introduza esta consulta que usa a função

ML.PREDICT.SELECT * FROM ML.PREDICT(MODEL `bqml_tutorial.imported_tf_model`, ( SELECT title AS input FROM bigquery-public-data.hacker_news.full ) )

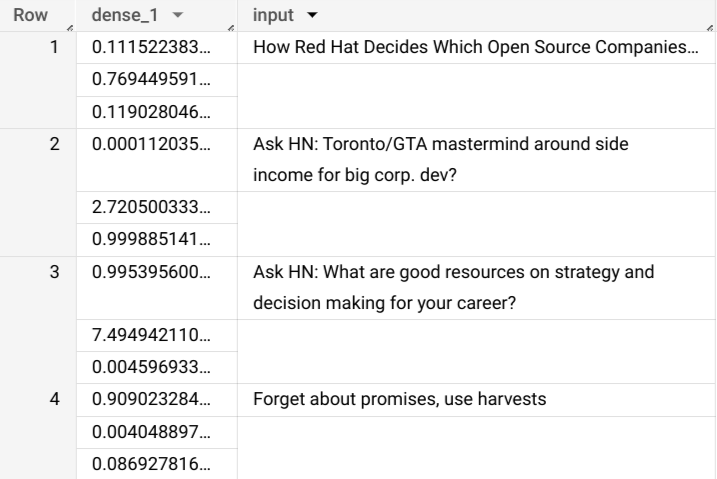

Os resultados da consulta devem ter o seguinte aspeto:

bq

Introduza este comando para executar a consulta que usa ML.PREDICT.

bq query \ --use_legacy_sql=false \ 'SELECT * FROM ML.PREDICT( MODEL `bqml_tutorial.imported_tf_model`, (SELECT title AS input FROM `bigquery-public-data.hacker_news.full`))'

Os resultados devem ter o seguinte aspeto:

+------------------------------------------------------------------------+----------------------------------------------------------------------------------+ | dense_1 | input | +------------------------------------------------------------------------+----------------------------------------------------------------------------------+ | ["0.6251608729362488","0.2989124357700348","0.07592673599720001"] | How Red Hat Decides Which Open Source Companies t... | | ["0.014276246540248394","0.972910463809967","0.01281337533146143"] | Ask HN: Toronto/GTA mastermind around side income for big corp. dev? | | ["0.9821603298187256","1.8601855117594823E-5","0.01782100833952427"] | Ask HN: What are good resources on strategy and decision making for your career? | | ["0.8611106276512146","0.06648492068052292","0.07240450382232666"] | Forget about promises, use harvests | +------------------------------------------------------------------------+----------------------------------------------------------------------------------+

API

Insira um novo emprego e preencha a propriedade jobs#configuration.query, como no corpo do pedido. Substitua project_id pelo nome do seu projeto.

{ "query": "SELECT * FROM ML.PREDICT(MODEL `project_id.bqml_tutorial.imported_tf_model`, (SELECT * FROM input_data))" }

DataFrames do BigQuery

Antes de experimentar este exemplo, siga as instruções de configuração dos DataFrames do BigQuery no início rápido do BigQuery com os DataFrames do BigQuery. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para se autenticar no BigQuery, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure o ADC para um ambiente de desenvolvimento local.

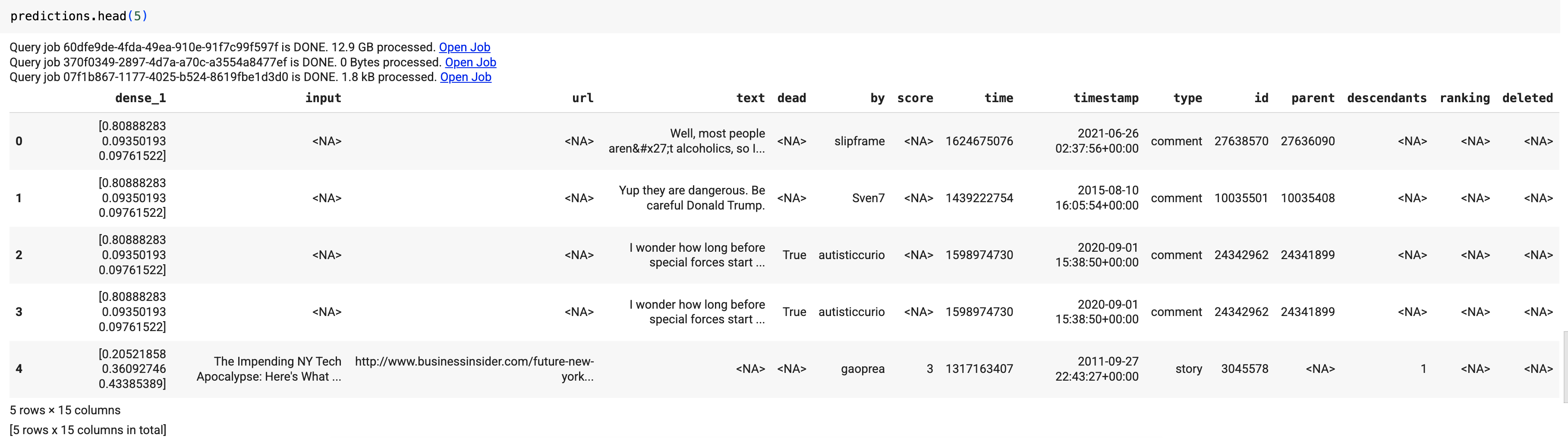

Use a função predict para executar o modelo do TensorFlow:

Os resultados devem ter o seguinte aspeto:

Nos resultados da consulta, a coluna dense_1 contém uma matriz de valores de probabilidade e a coluna input contém os valores de string correspondentes da tabela de entrada. Cada valor do elemento da matriz representa a probabilidade de a string de entrada correspondente ser o título de um artigo de uma publicação específica.