Panoramica dell'AI generativa

Questo documento descrive le funzionalità di intelligenza artificiale (AI) generativa supportate da BigQuery ML. Queste funzionalità ti consentono di eseguire attività di AI in BigQuery ML utilizzando modelli Vertex AI preaddestrati e modelli BigQuery ML integrati.

Le attività supportate includono:

- Generare testo

- Generare dati strutturati

- Generare valori di un tipo specifico per riga

- Generare incorporamenti

- Previsione di serie temporali

Per accedere a un modello Vertex AI per eseguire una di queste funzioni, crea un modello remoto in BigQuery ML che rappresenti l'endpoint del modello Vertex AI. Dopo aver creato un modello remoto sul modello Vertex AI che vuoi utilizzare, accedi alle funzionalità del modello eseguendo una funzione BigQuery ML sul modello remoto.

Questo approccio ti consente di utilizzare le funzionalità di questi modelli Vertex AI nelle query SQL per analizzare i dati BigQuery.

Flusso di lavoro

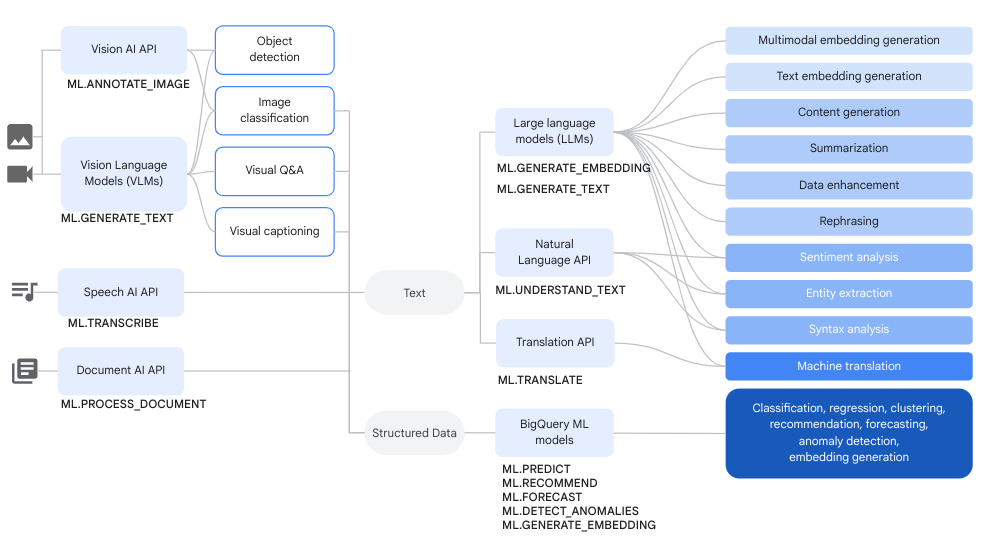

Puoi utilizzare modelli remoti su modelli Vertex AI e modelli remoti su servizi Cloud AI insieme alle funzioni BigQuery ML per eseguire analisi dei dati complesse e attività di AI generativa.

Il seguente diagramma mostra alcuni flussi di lavoro tipici in cui potresti utilizzare queste funzionalità insieme:

Genera testo

La generazione di testo è una forma di AI generativa in cui il testo viene generato in base a un prompt o all'analisi dei dati. Puoi eseguire la generazione di testo utilizzando dati testuali e multimodali.

Ecco alcuni casi d'uso comuni per la generazione di testo:

- Generazione di contenuti creativi.

- Generazione del codice in corso.

- Generazione di risposte via chat o email.

- Brainstorming, ad esempio suggerendo strade per prodotti o servizi futuri.

- Personalizzazione dei contenuti, ad esempio suggerimenti sui prodotti.

- Classificare i dati applicando una o più etichette ai contenuti per ordinarli in categorie.

- Identificare i sentimenti chiave espressi nei contenuti.

- Riassumere le idee o le impressioni chiave trasmesse dai contenuti.

- Identificare una o più entità importanti in dati di testo o visivi.

- Traduzione dei contenuti di dati di testo o audio in un'altra lingua.

- Generare un testo che corrisponda ai contenuti verbali dei dati audio.

- Aggiungere sottotitoli codificati o eseguire domande e risposte sui dati visivi.

L'arricchimento dei dati è un passaggio successivo comune dopo la generazione di testo, in cui arricchisci

gli approfondimenti dell'analisi iniziale combinandoli con dati aggiuntivi. Ad esempio, potresti analizzare le immagini di arredamento per la casa per generare testo per una colonna design_type, in modo che lo SKU dell'arredamento abbia una descrizione associata, ad esempio mid-century modern o farmhouse.

Modelli supportati

Per eseguire attività di IA generativa, puoi utilizzare modelli remoti in BigQuery ML per fare riferimento a modelli di cui è stato eseguito il deployment o ospitati in Vertex AI. Puoi creare i seguenti tipi di modelli remoti:

- Modelli remoti su uno qualsiasi dei modelli Gemini disponibili a livello generale o in anteprima.

Modelli remoti rispetto ai seguenti modelli di partner:

Utilizzo di modelli di generazione del testo

Dopo aver creato un modello remoto, puoi utilizzare la

funzione ML.GENERATE_TEXT

per interagire con il modello:

Per i modelli remoti basati sui modelli Gemini, puoi:

Utilizza la funzione

ML.GENERATE_TEXTper generare testo da un prompt che specifichi in una query o estrai da una colonna di una tabella standard. Quando specifichi il prompt in una query, puoi fare riferimento ai seguenti tipi di colonne della tabella nel prompt:STRINGcolonne per fornire dati di testo.STRUCTcolonne che utilizzano il formatoObjectRefper fornire dati non strutturati. Devi utilizzare la funzioneOBJ.GET_ACCESS_URLall'interno del prompt per convertire i valoriObjectRefin valoriObjectRefRuntime.

Utilizza la funzione

ML.GENERATE_TEXTper analizzare contenuti di testo, immagini, audio, video o PDF da una tabella di oggetti con un prompt che fornisci come argomento della funzione.

Per tutti gli altri tipi di modelli remoti, puoi utilizzare la funzione

ML.GENERATE_TEXTcon un prompt che fornisci in una query o da una colonna di una tabella standard.

Utilizza i seguenti argomenti per provare la generazione di testo in BigQuery ML:

- Genera testo utilizzando un modello Gemini e la funzione

ML.GENERATE_TEXT. - Genera testo utilizzando un modello Gemma e la funzione

ML.GENERATE_TEXT. - Analizzare le immagini con un modello Gemini.

- Genera testo utilizzando la funzione

ML.GENERATE_TEXTcon i tuoi dati. - Ottimizzare un modello utilizzando i tuoi dati.

Attributi di messa a terra e sicurezza

Puoi utilizzare

grounding

e

attributi di sicurezza

quando utilizzi i modelli Gemini con la funzione ML.GENERATE_TEXT,

a condizione che utilizzi una tabella standard per l'input. La fondatezza consente al modello Gemini di utilizzare informazioni aggiuntive da internet per generare risposte più specifiche e oggettive. Gli attributi di sicurezza consentono al

modello Gemini di filtrare le risposte restituite in base agli

attributi specificati.

Ottimizzazione supervisionata

Quando crei un modello remoto che fa riferimento a uno dei seguenti modelli, puoi scegliere facoltativamente di configurare la messa a punto supervisionata contemporaneamente:

gemini-2.0-flash-001gemini-2.0-flash-lite-001gemini-1.5-pro-002gemini-1.5-flash-002

Tutta l'inferenza avviene in Vertex AI. I risultati vengono archiviati in BigQuery.

Vertex AI Provisioned Throughput

Per i modelli Gemini supportati, puoi utilizzare Vertex AI Provisioned Throughput con la funzione ML.GENERATE_TEXT per fornire un throughput elevato e coerente per le richieste. Per ulteriori informazioni, consulta Utilizzare il throughput riservato di Vertex AI.

Generare dati strutturati

La generazione di dati strutturati è molto simile alla generazione di testo, tranne per il fatto che puoi anche formattare la risposta del modello specificando uno schema SQL.

Per generare dati strutturati, crea un modello remoto su uno dei modelli Gemini

disponibili a livello generale

o

in anteprima. A questo punto puoi utilizzare la funzione

AI.GENERATE_TABLE

per interagire con il modello. Per provare a creare dati strutturati, vedi

Generare dati strutturati utilizzando la funzione AI.GENERATE_TABLE.

Puoi specificare

attributi di sicurezza

quando utilizzi i modelli Gemini con la funzione AI.GENERATE_TABLE

per filtrare le risposte del modello.

Generare valori di un tipo specifico per riga

Puoi utilizzare le funzioni di AI generativa scalare con i modelli Gemini per

analizzare i dati nelle tabelle standard BigQuery. I dati includono sia

dati di testo sia dati non strutturati provenienti da

colonne che contengono valori ObjectRef.

Per ogni riga della tabella, queste funzioni generano un output contenente un

tipo specifico.

Sono disponibili le seguenti funzioni di AI:

AI.GENERATE, che genera un valoreSTRINGAI.GENERATE_BOOLAI.GENERATE_DOUBLEAI.GENERATE_INT

Quando utilizzi la funzione AI.GENERATE con i modelli Gemini supportati, puoi utilizzare Vertex AI Provisioned Throughput per fornire una velocità effettiva elevata e coerente per le richieste. Per ulteriori informazioni, consulta Utilizzare il throughput riservato di Vertex AI.

Generare incorporamenti

Un incorporamento è un vettore numerico ad alta dimensione che rappresenta una determinata entità, ad esempio un testo o un file audio. La generazione di incorporamenti ti consente di acquisire la semantica dei dati in modo da semplificare il ragionamento e il confronto dei dati.

Di seguito sono riportati alcuni casi d'uso comuni per la generazione di incorporamenti:

- Utilizzo della Retrieval-Augmented Generation (RAG) per ampliare le risposte del modello alle query degli utenti facendo riferimento a dati aggiuntivi provenienti da una fonte attendibile. La RAG offre una migliore accuratezza fattuale e coerenza delle risposte e fornisce anche l'accesso a dati più recenti rispetto a quelli di addestramento del modello.

- Esecuzione della ricerca multimodale. Ad esempio, l'utilizzo dell'input di testo per cercare immagini.

- Eseguire la ricerca semantica per trovare elementi simili per suggerimenti, sostituzione e deduplicazione dei record.

- Creazione di incorporamenti da utilizzare con un modello K-means per il clustering.

Modelli supportati

Sono supportati i seguenti modelli:

Per creare incorporamenti di testo, puoi utilizzare i seguenti modelli Vertex AI:

gemini-embedding-001(anteprima)text-embeddingtext-multilingual-embedding- Modelli aperti supportati (anteprima)

Per creare incorporamenti multimodali, che possono incorporare testo, immagini e video nello stesso spazio semantico, puoi utilizzare il modello

multimodalembeddingdi Vertex AI.Per creare incorporamenti per dati strutturati variabili casuali indipendenti e identicamente distribuite (IID), puoi utilizzare un modello di analisi delle componenti principali (PCA) BigQuery ML o un modello autoencoder.

Per creare incorporamenti per i dati di utenti o elementi, puoi utilizzare un modello di fattorizzazione matriciale di BigQuery ML.

Per un incorporamento di testo più piccolo e leggero, prova a utilizzare un modello TensorFlow preaddestrato, come NNLM, SWIVEL o BERT.

Utilizzo di modelli di generazione di embedding

Dopo aver creato il modello, puoi utilizzare la

funzione ML.GENERATE_EMBEDDING

per interagire con esso. Per tutti i tipi di modelli supportati, ML.GENERATE_EMBEDDING

funziona con i dati strutturati nelle

tabelle standard. Per i modelli di incorporamento multimodale, ML.GENERATE_EMBEDDING funziona anche con i contenuti visivi delle colonne delle tabelle standard che contengono valori ObjectRef o delle tabelle degli oggetti.

Per i modelli remoti, tutta l'inferenza avviene in Vertex AI. Per gli altri tipi di modelli, tutta l'inferenza avviene in BigQuery. I risultati vengono memorizzati in BigQuery.

Utilizza i seguenti argomenti per provare la generazione di testo in BigQuery ML:

- Generare incorporamenti di testo utilizzando la funzione

ML.GENERATE_EMBEDDING - Generare incorporamenti di immagini utilizzando la funzione

ML.GENERATE_EMBEDDING - Generare incorporamenti video utilizzando la funzione

ML.GENERATE_EMBEDDING - Generare e cercare embedding multimodali

- Eseguire la ricerca semantica e la generazione aumentata dal recupero

Previsione

La previsione è una tecnica che consente di analizzare i dati storici delle serie temporali per fare una previsione informata sulle tendenze future. Puoi utilizzare il modello di serie temporali TimesFM

(anteprima) integrato di BigQuery ML per eseguire previsioni senza dover creare un modello personalizzato. Il modello TimesFM integrato funziona con la

funzione AI.FORECAST

per generare previsioni in base ai tuoi dati.

Località

Le località supportate per i modelli di generazione ed embedding di testo variano in base al tipo e alla versione del modello che utilizzi. Per ulteriori informazioni, consulta Località. A differenza di altri modelli di AI generativa, il supporto della località non si applica al modello di serie temporali TimesFM integrato. Il modello TimesFM è disponibile in tutte le regioni supportate da BigQuery.

Prezzi

Ti vengono addebitate le risorse di calcolo che utilizzi per eseguire query sui modelli. I modelli remoti effettuano chiamate ai modelli Vertex AI, pertanto le query sui modelli remoti comportano anche addebiti da Vertex AI.

Per ulteriori informazioni, vedi Prezzi di BigQuery ML.

Passaggi successivi

- Per un'introduzione all'AI e al ML in BigQuery, consulta Introduzione all'AI e al ML in BigQuery.

- Per saperne di più sull'esecuzione dell'inferenza sui modelli di machine learning, consulta Panoramica dell'inferenza del modello.