Ottimizzare un modello utilizzando i tuoi dati

Questo documento mostra come creare un modello remoto BigQuery ML che fa riferimento a un modello Vertex AI e poi come configurare il modello per eseguire l'ottimizzazione supervisionata. Il modello Vertex AI deve essere uno dei seguenti:

gemini-2.0-flash-001gemini-2.0-flash-lite-001gemini-1.5-pro-002gemini-1.5-flash-002

Dopo aver creato il modello remoto, utilizza la

funzione ML.EVALUATE

per valutare il modello e verificare che le sue prestazioni siano adatte al tuo caso

d'uso. Puoi quindi utilizzare il modello insieme alla

funzione ML.GENERATE_TEXT

per analizzare il testo in una tabella BigQuery.

Per ulteriori informazioni, consulta Ottimizzazione supervisionata del modello dell'API Gemini di Vertex AI.

Ruoli obbligatori

Per creare e valutare un modello ottimizzato, devi disporre dei seguenti ruoli IAM (Identity and Access Management):

- Crea e utilizza set di dati, tabelle e modelli BigQuery:

Editor dati BigQuery (

roles/bigquery.dataEditor) nel tuo progetto. Crea, delega e utilizza le connessioni BigQuery: Amministratore connessioni BigQuery (

roles/bigquery.connectionsAdmin) nel tuo progetto.Se non hai configurato una connessione predefinita, puoi crearne e impostarne una durante l'esecuzione dell'istruzione

CREATE MODEL. Per farlo, devi disporre del ruolo Amministratore BigQuery (roles/bigquery.admin) nel tuo progetto. Per saperne di più, vedi Configurare la connessione predefinita.Concedi le autorizzazioni al account di servizio della connessione: Amministratore IAM progetto (

roles/resourcemanager.projectIamAdmin) sul progetto che contiene l'endpoint Vertex AI. Questo è il progetto attuale per i modelli remoti che crei specificando il nome del modello come endpoint. Questo è il progetto identificato nell'URL per i modelli remoti che crei specificando un URL come endpoint.Crea job BigQuery: Utente job BigQuery (

roles/bigquery.jobUser) nel tuo progetto.

Questi ruoli predefiniti contengono le autorizzazioni necessarie per eseguire le attività descritte in questo documento. Per vedere quali sono esattamente le autorizzazioni richieste, espandi la sezione Autorizzazioni obbligatorie:

Autorizzazioni obbligatorie

- Crea un set di dati:

bigquery.datasets.create - Crea, delega e utilizza una connessione:

bigquery.connections.* - Imposta le autorizzazioni dell'account di servizio:

resourcemanager.projects.getIamPolicyeresourcemanager.projects.setIamPolicy - Crea un modello ed esegui l'inferenza:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.models.updateMetadata

Potresti anche ottenere queste autorizzazioni con ruoli personalizzati o altri ruoli predefiniti.

Prima di iniziare

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection,Vertex AI, and Compute Engine APIs.

Crea un set di dati

Crea un set di dati BigQuery che contenga le tue risorse:

Console

Nella console Google Cloud , vai alla pagina BigQuery.

Nel riquadro Explorer, fai clic sul nome del progetto.

Fai clic su Visualizza azioni > Crea set di dati.

Nella pagina Crea set di dati:

In ID set di dati, digita un nome per il set di dati.

Per Tipo di località, seleziona una località per il set di dati.

Fai clic su Crea set di dati.

bq

Per creare un nuovo set di dati, utilizza il comando

bq mkcon il flag--location:bq --location=LOCATION mk -d DATASET_ID

Sostituisci quanto segue:

LOCATION: la posizione del set di dati.DATASET_IDè l'ID del set di dati che stai creando.

Verifica che il set di dati sia stato creato:

bq ls

Crea una connessione

Puoi saltare questo passaggio se hai configurato una connessione predefinita o se disponi del ruolo Amministratore BigQuery.

Crea una connessione a una risorsa Cloud da utilizzare per il modello remoto e recupera il account di servizio della connessione. Crea la connessione nella stessa posizione del set di dati creato nel passaggio precedente.

Seleziona una delle seguenti opzioni:

Console

Vai alla pagina BigQuery.

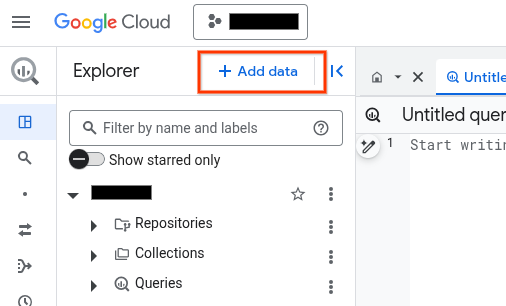

Nel riquadro Explorer, fai clic su Aggiungi dati:

Si apre la finestra di dialogo Aggiungi dati.

Nel riquadro Filtra per, nella sezione Tipo di origine dati, seleziona Applicazioni aziendali.

In alternativa, nel campo Cerca origini dati, puoi inserire

Vertex AI.Nella sezione Origini dati in evidenza, fai clic su Vertex AI.

Fai clic sulla scheda della soluzione Vertex AI Models: BigQuery Federation.

Nell'elenco Tipo di connessione, seleziona Modelli remoti di Vertex AI, funzioni remote e BigLake (risorsa Cloud).

Nel campo ID connessione, inserisci un nome per la connessione.

Fai clic su Crea connessione.

Fai clic su Vai alla connessione.

Nel riquadro Informazioni sulla connessione, copia l'ID del account di servizio da utilizzare in un passaggio successivo.

bq

In un ambiente a riga di comando, crea una connessione:

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

Il parametro

--project_idsostituisce il progetto predefinito.Sostituisci quanto segue:

REGION: la tua regione di connessionePROJECT_ID: il tuo ID progetto Google CloudCONNECTION_ID: un ID per la tua connessione

Quando crei una risorsa di connessione, BigQuery crea un account di serviziot di sistema univoco e lo associa alla connessione.

Risoluzione dei problemi: se viene visualizzato il seguente errore di connessione, aggiorna Google Cloud SDK:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Recupera e copia l'ID account di servizio da utilizzare in un passaggio successivo:

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

L'output è simile al seguente:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Terraform

Utilizza la risorsa

google_bigquery_connection.

Per eseguire l'autenticazione in BigQuery, configura le credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

L'esempio seguente crea una connessione di risorsa Cloud denominata

my_cloud_resource_connection nella regione US:

Per applicare la configurazione di Terraform in un progetto Google Cloud , completa i passaggi nelle sezioni seguenti.

Prepara Cloud Shell

- Avvia Cloud Shell.

-

Imposta il progetto Google Cloud predefinito in cui vuoi applicare le configurazioni Terraform.

Devi eseguire questo comando una sola volta per progetto e puoi eseguirlo in qualsiasi directory.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Le variabili di ambiente vengono sostituite se imposti valori espliciti nel file di configurazione Terraform.

Prepara la directory

Ogni file di configurazione di Terraform deve avere la propria directory (chiamata anche modulo radice).

-

In Cloud Shell, crea una directory e un nuovo file al suo interno. Il nome file deve avere l'estensione

.tf, ad esempiomain.tf. In questo tutorial, il file viene denominatomain.tf.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Se stai seguendo un tutorial, puoi copiare il codice campione in ogni sezione o passaggio.

Copia il codice campione nel

main.tfappena creato.(Facoltativo) Copia il codice da GitHub. Questa operazione è consigliata quando lo snippet Terraform fa parte di una soluzione end-to-end.

- Rivedi e modifica i parametri di esempio da applicare al tuo ambiente.

- Salva le modifiche.

-

Inizializza Terraform. Devi effettuare questa operazione una sola volta per directory.

terraform init

(Facoltativo) Per utilizzare l'ultima versione del provider Google, includi l'opzione

-upgrade:terraform init -upgrade

Applica le modifiche

-

Rivedi la configurazione e verifica che le risorse che Terraform creerà o

aggiornerà corrispondano alle tue aspettative:

terraform plan

Apporta le correzioni necessarie alla configurazione.

-

Applica la configurazione di Terraform eseguendo il comando seguente e inserendo

yesal prompt:terraform apply

Attendi che Terraform visualizzi il messaggio "Apply complete!".

- Apri il tuo Google Cloud progetto per visualizzare i risultati. Nella console Google Cloud , vai alle risorse nell'interfaccia utente per assicurarti che Terraform le abbia create o aggiornate.

Concedi l'accesso al account di servizio della connessione

Concedi al account di servizio della connessione il ruolo Agente di servizio Vertex AI.

Se prevedi di specificare l'endpoint come URL quando crei il modello remoto,

ad esempio endpoint = 'https://us-central1-aiplatform.googleapis.com/v1/projects/myproject/locations/us-central1/publishers/google/models/gemini-2.0-flash',

concedi questo ruolo nello stesso progetto specificato nell'URL.

Se prevedi di specificare l'endpoint utilizzando il nome del modello quando crei

il modello remoto, ad esempio endpoint = 'gemini-2.0-flash', concedi questo ruolo

nello stesso progetto in cui prevedi di creare il modello remoto.

La concessione del ruolo in un progetto diverso genera l'errore

bqcx-1234567890-wxyz@gcp-sa-bigquery-condel.iam.gserviceaccount.com does not have the permission to access resource.

Per concedere il ruolo, segui questi passaggi:

Console

Vai alla pagina IAM e amministrazione.

Fai clic su Concedi l'accesso.

In Nuove entità, inserisci l'ID account di servizio che hai copiato in precedenza.

Fai clic su Seleziona un ruolo.

In Filtro, digita

Vertex AI Service Agente seleziona il ruolo.Fai clic su Salva.

gcloud

Utilizza il

comando gcloud projects add-iam-policy-binding:

gcloud projects add-iam-policy-binding 'PROJECT_NUMBER' --member='serviceAccount:MEMBER' --role='roles/aiplatform.serviceAgent' --condition=None

Sostituisci quanto segue:

PROJECT_NUMBER: il numero di progetto.MEMBER: l'ID account di servizio che hai copiato in precedenza.

Il account di servizio associato alla tua connessione è un'istanza di Agente di servizio di delega della connessione BigQuery, quindi è possibile assegnargli un ruolo di service agent.

Crea un modello con l'ottimizzazione supervisionata

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, esegui la seguente query per creare un modello remoto:

CREATE OR REPLACE MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME` REMOTE WITH CONNECTION {DEFAULT | `PROJECT_ID.REGION.CONNECTION_ID`} OPTIONS ( ENDPOINT = 'ENDPOINT', MAX_ITERATIONS = MAX_ITERATIONS, LEARNING_RATE_MULTIPLIER = LEARNING_RATE_MULTIPLIER, DATA_SPLIT_METHOD = 'DATA_SPLIT_METHOD', DATA_SPLIT_EVAL_FRACTION = DATA_SPLIT_EVAL_FRACTION, DATA_SPLIT_COL = 'DATA_SPLIT_COL', EVALUATION_TASK = 'EVALUATION_TASK', PROMPT_COL = 'INPUT_PROMPT_COL', INPUT_LABEL_COLS = INPUT_LABEL_COLS) AS SELECT PROMPT_COLUMN, LABEL_COLUMN FROM `TABLE_PROJECT_ID.TABLE_DATASET.TABLE_NAME`;

Sostituisci quanto segue:

PROJECT_ID: l'ID progetto del progetto in cui creare il modello.DATASET_ID: l'ID del set di dati che deve contenere il modello. Questo set di dati deve trovarsi in una regione Vertex AI supportata.MODEL_NAME: il nome del modello.REGION: la regione utilizzata dalla connessione.CONNECTION_ID: l'ID della tua connessione BigQuery. Questa connessione deve trovarsi nella stessa posizione del set di dati che stai utilizzando.Quando visualizzi i dettagli della connessione nella console Google Cloud , questo è il valore dell'ultima sezione dell'ID connessione completo visualizzato in ID connessione, ad esempio

projects/myproject/locations/connection_location/connections/myconnection.ENDPOINT: un valoreSTRINGche specifica il nome del modello da utilizzare.MAX_ITERATIONS: un valoreINT64che specifica il numero di passaggi da eseguire per la regolazione supervisionata. Il valore diMAX_ITERATIONSdeve essere compreso tra1e∞.I modelli Gemini vengono addestrati utilizzando le epoche anziché i passaggi, quindi BigQuery ML converte il valore

MAX_ITERATIONSin epoche. Il valore predefinito diMAX_ITERATIONSè il numero di righe nei dati di input, che equivale a un'epoca. Per utilizzare più epoche, specifica un multiplo del numero di righe nei dati di addestramento. Ad esempio, se hai 100 righe di dati di input e vuoi utilizzare due epoche, specifica200per il valore dell'argomento. Se fornisci un valore che non è un multiplo del numero di righe nei dati di input, BigQuery ML esegue l'arrotondamento per eccesso all'epoca più vicina. Ad esempio, se hai 100 righe di dati di input e specifichi101per il valoreMAX_ITERATIONS, l'addestramento viene eseguito con due epoche.Per ulteriori informazioni sui parametri utilizzati per ottimizzare i modelli Gemini, vedi Crea un job di ottimizzazione.

DATA_SPLIT_METHOD: un valoreSTRINGche specifica il metodo utilizzato per dividere i dati di input in set di addestramento e valutazione. Le opzioni valide sono le seguenti:AUTO_SPLIT: BigQuery ML divide automaticamente i dati. Il modo in cui i dati vengono suddivisi varia a seconda del numero di righe nella tabella di input. Questo è il valore predefinito.RANDOM: i dati vengono randomizzati prima di essere suddivisi in set. Per personalizzare la suddivisione dei dati, puoi utilizzare questa opzione con l'opzioneDATA_SPLIT_EVAL_FRACTION.CUSTOM: i dati vengono suddivisi utilizzando la colonna fornita nell'opzioneDATA_SPLIT_COL. Il valoreDATA_SPLIT_COLdeve essere il nome di una colonna di tipoBOOL. Le righe con un valore diTRUEoNULLvengono utilizzate come dati di valutazione, mentre le righe con un valore diFALSEvengono utilizzate come dati di addestramento.SEQ: suddivide i dati utilizzando la colonna fornita nell'opzioneDATA_SPLIT_COL. Il valore diDATA_SPLIT_COLdeve essere il nome di una colonna di uno dei seguenti tipi:NUMERICBIGNUMERICSTRINGTIMESTAMP

I dati vengono ordinati dal più piccolo al più grande in base alla colonna specificata.

Le prime n righe vengono utilizzate come dati di valutazione, dove n è il valore specificato per

DATA_SPLIT_EVAL_FRACTION. Le righe rimanenti vengono utilizzate come dati di addestramento.NO_SPLIT: nessuna suddivisione dei dati; tutti i dati di input vengono utilizzati come dati di addestramento.

Per saperne di più su queste opzioni di suddivisione dei dati, vedi

DATA_SPLIT_METHOD.DATA_SPLIT_EVAL_FRACTION: un valoreFLOAT64che specifica la frazione dei dati da utilizzare come dati di valutazione durante l'ottimizzazione supervisionata. Deve essere un valore compreso nell'intervallo[0, 1.0]. Il valore predefinito è0.2.Utilizza questa opzione quando specifichi

RANDOMoSEQcome valore per l'opzioneDATA_SPLIT_METHOD. Per personalizzare la suddivisione dei dati, puoi utilizzare l'opzioneDATA_SPLIT_METHODcon l'opzioneDATA_SPLIT_EVAL_FRACTION.DATA_SPLIT_COL: un valoreSTRINGche specifica il nome della colonna da utilizzare per ordinare i dati di input nel set di addestramento o di valutazione. Utilizza quando specifichiCUSTOMoSEQcome valore per l'opzioneDATA_SPLIT_METHOD.EVALUATION_TASK: un valoreSTRINGche specifica il tipo di attività per cui vuoi ottimizzare il modello. Le opzioni valide sono:TEXT_GENERATIONCLASSIFICATIONSUMMARIZATIONQUESTION_ANSWERINGUNSPECIFIED

Il valore predefinito è

UNSPECIFIED.INPUT_PROMPT_COL: un valoreSTRINGche contiene il nome della colonna del prompt nella tabella dei dati di addestramento da utilizzare per eseguire l'ottimizzazione supervisionata. Il valore predefinito èprompt.INPUT_LABEL_COLS: un valoreARRAY<<STRING>che contiene il nome della colonna dell'etichetta nella tabella dei dati di addestramento da utilizzare nell'ottimizzazione supervisionata. Puoi specificare un solo elemento nell'array. Il valore predefinito è un array vuoto. In questo modolabeldiventa il valore predefinito dell'argomentoLABEL_COLUMN.PROMPT_COLUMN: la colonna della tabella dei dati di addestramento che contiene il prompt per valutare i contenuti della colonnaLABEL_COLUMN. Questa colonna deve essere di tipoSTRINGo deve essere convertita inSTRING. Se specifichi un valore per l'opzioneINPUT_PROMPT_COL, devi specificare lo stesso valore perPROMPT_COLUMN. In caso contrario, questo valore deve essereprompt. Se la tabella non ha una colonnaprompt, utilizza un alias per specificare una colonna della tabella esistente. Ad esempio,AS SELECT hint AS prompt, label FROM mydataset.mytable.LABEL_COLUMN: la colonna della tabella dei dati di addestramento che contiene gli esempi con cui addestrare il modello. Questa colonna deve essere di tipoSTRINGo deve essere convertita inSTRING. Se specifichi un valore per l'opzioneINPUT_LABEL_COLS, devi specificare lo stesso valore perLABEL_COLUMN. In caso contrario, questo valore deve esserelabel. Se la tabella non ha una colonnalabel, utilizza un alias per specificare una colonna della tabella esistente. Ad esempio,AS SELECT prompt, feature AS label FROM mydataset.mytable.TABLE_PROJECT_ID: l'ID progetto del progetto che contiene la tabella dei dati di addestramento.TABLE_DATASET: il nome del dataset contenente la tabella dei dati di addestramento.TABLE_NAME: il nome della tabella che contiene i dati da utilizzare per addestrare il modello.

Valuta il modello ottimizzato

Nella console Google Cloud , vai alla pagina BigQuery.

Nell'editor di query, esegui la seguente query per valutare il modello ottimizzato:

SELECT * FROM ML.EVALUATE( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, TABLE `TABLE_PROJECT_ID.TABLE_DATASET.TABLE_NAME`, STRUCT('TASK_TYPE' AS task_type, TOKENS AS max_output_tokens, TEMPERATURE AS temperature, TOP_K AS top_k, TOP_P AS top_p));

Sostituisci quanto segue:

PROJECT_ID: l'ID progetto del progetto che contiene il modello.DATASET_ID: l'ID del set di dati che contiene il modello.MODEL_NAME: il nome del modello.TABLE_PROJECT_ID: l'ID progetto del progetto che contiene la tabella dei dati di valutazione.TABLE_DATASET: il nome del set di dati che contiene la tabella dei dati di valutazione.TABLE_NAME: il nome della tabella che contiene i dati di valutazione.La tabella deve avere una colonna il cui nome corrisponda al nome della colonna del prompt fornito durante l'addestramento del modello. Puoi fornire questo valore utilizzando l'opzione

prompt_coldurante l'addestramento del modello. Seprompt_colnon è specificato, viene utilizzata la colonna denominatapromptnei dati di addestramento. Viene restituito un errore se non è presente una colonna denominataprompt.La tabella deve avere una colonna il cui nome corrisponda al nome della colonna delle etichette fornito durante l'addestramento del modello. Puoi fornire questo valore utilizzando l'opzione

input_label_colsdurante l'addestramento del modello. Seinput_label_colsnon è specificato, viene utilizzata la colonna denominatalabelnei dati di addestramento. Viene restituito un errore se non è presente una colonna denominatalabel.TASK_TYPE: un valoreSTRINGche specifica il tipo di attività per cui vuoi valutare il modello. Le opzioni valide sono:TEXT_GENERATIONCLASSIFICATIONSUMMARIZATIONQUESTION_ANSWERINGUNSPECIFIED

TOKENS: un valoreINT64che imposta il numero massimo di token che possono essere generati nella risposta. Questo valore deve essere compreso nell'intervallo[1,1024]. Specifica un valore più basso per risposte più brevi e un valore più alto per risposte più lunghe. Il valore predefinito è128.TEMPERATURE: un valoreFLOAT64nell'intervallo[0.0,1.0]che controlla il grado di casualità nella selezione dei token. Il valore predefinito è0.I valori più bassi per

temperaturesono ideali per i prompt che richiedono risposte più deterministiche e meno aperte o creative, mentre i valori più alti pertemperaturepossono portare a risultati più diversificati o creativi. Un valore di0pertemperatureè deterministico, il che significa che viene sempre selezionata la risposta con la probabilità più alta.TOP_K: un valoreINT64nell'intervallo[1,40]che determina il pool iniziale di token che il modello prende in considerazione per la selezione. Specifica un valore più basso per risposte meno casuali e un valore più alto per risposte più casuali. Il valore predefinito è40.TOP_P: un valoreFLOAT64nell'intervallo[0.0,1.0]aiuta a determinare quali token del pool determinato daTOP_Kvengono selezionati. Specifica un valore più basso per risposte meno casuali e un valore più alto per risposte più casuali. Il valore predefinito è0.95.

Genera testo

Genera testo con la

funzione ML.GENERATE_TEXT:

Colonna Prompt

Genera testo utilizzando una colonna della tabella per fornire il prompt.

SELECT * FROM ML.GENERATE_TEXT( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, TABLE PROJECT_ID.DATASET_ID.TABLE_NAME, STRUCT(TOKENS AS max_output_tokens, TEMPERATURE AS temperature, TOP_P AS top_p, FLATTEN_JSON AS flatten_json_output, STOP_SEQUENCES AS stop_sequences) );

Sostituisci quanto segue:

PROJECT_ID: il tuo ID progetto.DATASET_ID: l'ID del set di dati che contiene il modello.MODEL_NAME: il nome del modello.TABLE_NAME: il nome della tabella che contiene il prompt. Questa tabella deve avere una colonna il cui nome corrisponda al nome della colonna delle funzionalità nel modello ottimizzato. Il nome della colonna delle funzionalità nel modello può essere impostato utilizzando l'opzionePROMPT_COLdurante la creazione del modello. In caso contrario, il nome della colonna della funzionalità nel modello èpromptper impostazione predefinita oppure puoi utilizzare un alias per utilizzare una colonna con un nome diverso.TOKENS: un valoreINT64che imposta il numero massimo di token che possono essere generati nella risposta. Questo valore deve essere compreso nell'intervallo[1,8192]. Specifica un valore più basso per risposte più brevi e un valore più alto per risposte più lunghe. Il valore predefinito è128.TEMPERATURE: un valoreFLOAT64nell'intervallo[0.0,1.0]che controlla il grado di casualità nella selezione dei token. Il valore predefinito è0.I valori più bassi per

temperaturesono ideali per i prompt che richiedono risposte più deterministiche e meno aperte o creative, mentre i valori più alti pertemperaturepossono portare a risultati più diversificati o creativi. Un valore di0pertemperatureè deterministico, il che significa che viene sempre selezionata la risposta con la probabilità più alta.TOP_P: un valoreFLOAT64nell'intervallo[0.0,1.0]aiuta a determinare la probabilità dei token selezionati. Specifica un valore più basso per risposte meno casuali e un valore più alto per risposte più casuali. Il valore predefinito è0.95.FLATTEN_JSON: un valoreBOOLche determina se restituire il testo generato e gli attributi di sicurezza in colonne separate. Il valore predefinito èFALSE.STOP_SEQUENCES: un valoreARRAY<STRING>che rimuove le stringhe specificate se sono incluse nelle risposte del modello. Le stringhe vengono confrontate esattamente, comprese le maiuscole. Il valore predefinito è un array vuoto.GROUND_WITH_GOOGLE_SEARCH: un valoreBOOLche determina se il modello Vertex AI utilizza Grounding con la Ricerca Google durante la generazione delle risposte. La fondatezza consente al modello di utilizzare informazioni aggiuntive da internet durante la generazione di una risposta, in modo da rendere le risposte del modello più specifiche e basate su fatti. Quando siaflatten_json_outputsia questo campo sono impostati suTrue, nei risultati viene inclusa una colonnaml_generate_text_grounding_resultaggiuntiva, che fornisce le fonti utilizzate dal modello per raccogliere informazioni aggiuntive. Il valore predefinito èFALSE.SAFETY_SETTINGS: un valoreARRAY<STRUCT<STRING AS category, STRING AS threshold>>che configura le soglie di sicurezza dei contenuti per filtrare le risposte. Il primo elemento della struct specifica una categoria di danni, mentre il secondo elemento specifica una soglia di blocco corrispondente. Il modello filtra i contenuti che violano queste impostazioni. Puoi specificare ogni categoria una sola volta. Ad esempio, non puoi specificare siaSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_MEDIUM_AND_ABOVE' AS threshold)cheSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_ONLY_HIGH' AS threshold). Se non è presente un'impostazione di sicurezza per una determinata categoria, viene utilizzata l'impostazione di sicurezzaBLOCK_MEDIUM_AND_ABOVE.Le categorie supportate sono le seguenti:

HARM_CATEGORY_HATE_SPEECHHARM_CATEGORY_DANGEROUS_CONTENTHARM_CATEGORY_HARASSMENTHARM_CATEGORY_SEXUALLY_EXPLICIT

Le soglie supportate sono le seguenti:

BLOCK_NONE(accesso limitato)BLOCK_LOW_AND_ABOVEBLOCK_MEDIUM_AND_ABOVE(valore predefinito)BLOCK_ONLY_HIGHHARM_BLOCK_THRESHOLD_UNSPECIFIED

Per ulteriori informazioni, consulta la definizione di categoria di sicurezza e soglia di blocco.

REQUEST_TYPE: un valoreSTRINGche specifica il tipo di richiesta di inferenza da inviare al modello Gemini. Il tipo di richiesta determina la quota utilizzata dalla richiesta. I valori validi sono:DEDICATED: la funzioneML.GENERATE_TEXTutilizza solo la quota di throughput riservato. La funzioneML.GENERATE_TEXTrestituisce l'erroreProvisioned throughput is not purchased or is not activese la quota di throughput con provisioning non è disponibile.SHARED: la funzioneML.GENERATE_TEXTutilizza solo la quota condivisa dinamica (DSQ), anche se hai acquistato una quota di throughput di cui è stato eseguito il provisioning.UNSPECIFIED: La funzioneML.GENERATE_TEXTutilizza la quota nel seguente modo:- Se non hai acquistato la quota di throughput di cui è stato eseguito il provisioning,

la funzione

ML.GENERATE_TEXTutilizza la quota DSQ. - Se hai acquistato una quota di throughput di cui è stato eseguito il provisioning,

la funzione

ML.GENERATE_TEXTutilizza prima la quota di throughput di cui è stato eseguito il provisioning. Se le richieste superano la quota di throughput di cui è stato eseguito il provisioning, il traffico in eccesso utilizza la quota DSQ.

- Se non hai acquistato la quota di throughput di cui è stato eseguito il provisioning,

la funzione

Il valore predefinito è

UNSPECIFIED.Per ulteriori informazioni, consulta la sezione Utilizzare il throughput riservato di Vertex AI.

L'esempio seguente mostra una richiesta con queste caratteristiche:

- Utilizza la colonna

promptdella tabellapromptsper il prompt. - Restituisce una risposta breve e moderatamente probabile.

- Restituisce il testo generato e gli attributi di sicurezza in colonne separate.

SELECT * FROM ML.GENERATE_TEXT( MODEL `mydataset.mymodel`, TABLE mydataset.prompts, STRUCT( 0.4 AS temperature, 100 AS max_output_tokens, 0.5 AS top_p, TRUE AS flatten_json_output));

Query prompt

Genera testo utilizzando una query per fornire il prompt.

SELECT * FROM ML.GENERATE_TEXT( MODEL `PROJECT_ID.DATASET_ID.MODEL_NAME`, (PROMPT_QUERY), STRUCT(TOKENS AS max_output_tokens, TEMPERATURE AS temperature, TOP_P AS top_p, FLATTEN_JSON AS flatten_json_output, STOP_SEQUENCES AS stop_sequences) );

Sostituisci quanto segue:

PROJECT_ID: il tuo ID progetto.DATASET_ID: l'ID del set di dati che contiene il modello.MODEL_NAME: il nome del modello.PROMPT_QUERY: una query che fornisce i dati del prompt.TOKENS: un valoreINT64che imposta il numero massimo di token che possono essere generati nella risposta. Questo valore deve essere compreso nell'intervallo[1,8192]. Specifica un valore più basso per risposte più brevi e un valore più alto per risposte più lunghe. Il valore predefinito è128.TEMPERATURE: un valoreFLOAT64nell'intervallo[0.0,1.0]che controlla il grado di casualità nella selezione dei token. Il valore predefinito è0.I valori più bassi per

temperaturesono ideali per i prompt che richiedono risposte più deterministiche e meno aperte o creative, mentre i valori più alti pertemperaturepossono portare a risultati più diversificati o creativi. Un valore di0pertemperatureè deterministico, il che significa che viene sempre selezionata la risposta con la probabilità più alta.TOP_P: un valoreFLOAT64nell'intervallo[0.0,1.0]aiuta a determinare la probabilità dei token selezionati. Specifica un valore più basso per risposte meno casuali e un valore più alto per risposte più casuali. Il valore predefinito è0.95.FLATTEN_JSON: un valoreBOOLche determina se restituire il testo generato e gli attributi di sicurezza in colonne separate. Il valore predefinito èFALSE.STOP_SEQUENCES: un valoreARRAY<STRING>che rimuove le stringhe specificate se sono incluse nelle risposte del modello. Le stringhe vengono confrontate esattamente, comprese le maiuscole. Il valore predefinito è un array vuoto.GROUND_WITH_GOOGLE_SEARCH: un valoreBOOLche determina se il modello Vertex AI utilizza Grounding con la Ricerca Google durante la generazione delle risposte. La fondatezza consente al modello di utilizzare informazioni aggiuntive da internet durante la generazione di una risposta, in modo da rendere le risposte del modello più specifiche e basate su fatti. Quando siaflatten_json_outputsia questo campo sono impostati suTrue, nei risultati viene inclusa una colonnaml_generate_text_grounding_resultaggiuntiva, che fornisce le fonti utilizzate dal modello per raccogliere informazioni aggiuntive. Il valore predefinito èFALSE.SAFETY_SETTINGS: un valoreARRAY<STRUCT<STRING AS category, STRING AS threshold>>che configura le soglie di sicurezza dei contenuti per filtrare le risposte. Il primo elemento della struct specifica una categoria di danni, mentre il secondo elemento specifica una soglia di blocco corrispondente. Il modello filtra i contenuti che violano queste impostazioni. Puoi specificare ogni categoria una sola volta. Ad esempio, non puoi specificare siaSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_MEDIUM_AND_ABOVE' AS threshold)cheSTRUCT('HARM_CATEGORY_DANGEROUS_CONTENT' AS category, 'BLOCK_ONLY_HIGH' AS threshold). Se non è presente un'impostazione di sicurezza per una determinata categoria, viene utilizzata l'impostazione di sicurezzaBLOCK_MEDIUM_AND_ABOVE.Le categorie supportate sono le seguenti:

HARM_CATEGORY_HATE_SPEECHHARM_CATEGORY_DANGEROUS_CONTENTHARM_CATEGORY_HARASSMENTHARM_CATEGORY_SEXUALLY_EXPLICIT

Le soglie supportate sono le seguenti:

BLOCK_NONE(accesso limitato)BLOCK_LOW_AND_ABOVEBLOCK_MEDIUM_AND_ABOVE(valore predefinito)BLOCK_ONLY_HIGHHARM_BLOCK_THRESHOLD_UNSPECIFIED

Per ulteriori informazioni, consulta la definizione di categoria di sicurezza e soglia di blocco.

REQUEST_TYPE: un valoreSTRINGche specifica il tipo di richiesta di inferenza da inviare al modello Gemini. Il tipo di richiesta determina la quota utilizzata dalla richiesta. I valori validi sono:DEDICATED: la funzioneML.GENERATE_TEXTutilizza solo la quota di throughput riservato. La funzioneML.GENERATE_TEXTrestituisce l'erroreProvisioned throughput is not purchased or is not activese la quota di throughput con provisioning non è disponibile.SHARED: la funzioneML.GENERATE_TEXTutilizza solo la quota condivisa dinamica (DSQ), anche se hai acquistato una quota di throughput di cui è stato eseguito il provisioning.UNSPECIFIED: La funzioneML.GENERATE_TEXTutilizza la quota nel seguente modo:- Se non hai acquistato la quota di throughput di cui è stato eseguito il provisioning,

la funzione

ML.GENERATE_TEXTutilizza la quota DSQ. - Se hai acquistato una quota di throughput di cui è stato eseguito il provisioning,

la funzione

ML.GENERATE_TEXTutilizza prima la quota di throughput di cui è stato eseguito il provisioning. Se le richieste superano la quota di throughput di cui è stato eseguito il provisioning, il traffico in eccesso utilizza la quota DSQ.

- Se non hai acquistato la quota di throughput di cui è stato eseguito il provisioning,

la funzione

Il valore predefinito è

UNSPECIFIED.Per ulteriori informazioni, consulta la sezione Utilizzare il throughput riservato di Vertex AI.

Esempio 1

L'esempio seguente mostra una richiesta con queste caratteristiche:

- Richiede un riepilogo del testo nella colonna

bodydella tabellaarticles. - Restituisce una risposta moderatamente lunga e più probabile.

- Restituisce il testo generato e gli attributi di sicurezza in colonne separate.

SELECT * FROM ML.GENERATE_TEXT( MODEL `mydataset.mymodel`, ( SELECT CONCAT('Summarize this text', body) AS prompt FROM mydataset.articles ), STRUCT( 0.2 AS temperature, 650 AS max_output_tokens, 0.2 AS top_p, TRUE AS flatten_json_output));

Esempio 2

L'esempio seguente mostra una richiesta con queste caratteristiche:

- Utilizza una query per creare i dati del prompt concatenando stringhe che forniscono prefissi del prompt con le colonne della tabella.

- Restituisce una risposta breve e moderatamente probabile.

- Non restituisce il testo generato e gli attributi di sicurezza in colonne separate.

SELECT * FROM ML.GENERATE_TEXT( MODEL `mydataset.mytuned_model`, ( SELECT CONCAT(question, 'Text:', description, 'Category') AS prompt FROM mydataset.input_table ), STRUCT( 0.4 AS temperature, 100 AS max_output_tokens, 0.5 AS top_p, FALSE AS flatten_json_output));