Dalam tutorial ini, Anda akan mendaftarkan endpoint Vertex AI sebagai model jarak jauh di BigQuery. Kemudian, Anda menggunakan fungsi ML.PREDICT untuk membuat

prediksi menggunakan model jarak jauh.

Anda dapat menggunakan model jarak jauh saat model terlalu besar untuk diimpor ke BigQuery. Model ini juga berguna saat Anda ingin memiliki satu titik inferensi untuk kasus penggunaan online, batch, dan batch mikro.

Mengimpor model ke Vertex AI Model Registry

Dalam tutorial ini, Anda menggunakan model TensorFlow terlatih yang tersedia di Cloud Storage di gs://cloud-samples-data/bigquery/ml/remote_model_tutorial/. Bucket Cloud Storage berada di lokasi multi-region US.

Model ini adalah model TensorFlow yang bernama saved_model.pb. Model ini adalah model analisis sentimen yang disesuaikan yang dibuat dengan menyelaraskan model BERT dengan ulasan film IMDB teks biasa. Model ini menggunakan input teks dari ulasan film dan mengembalikan skor sentimen antara nol dan satu. Saat mengimpor

model ke Model Registry, Anda menggunakan container TensorFlow

bawaan.

Ikuti langkah-langkah berikut untuk mengimpor model.

Di konsol Google Cloud , buka halaman Model Registry Vertex AI.

Klik Import.

Untuk Langkah satu: Nama dan region, lakukan hal berikut:

Pilih Import as new model.

Untuk Name, masukkan

bert_sentiment.Untuk Description, masukkan

BQML tutorial model.Untuk Region, pilih

us-central1. Anda harus memilih region berbasis AS karena bucket Cloud Storage berada di lokasiUSmulti-region.Klik Lanjutkan.

Untuk Langkah kedua: Setelan model, lakukan hal berikut:

Pilih Import model artifacts into a new prebuilt container.

Di bagian Prebuilt container settings, lakukan hal berikut:

Untuk Model framework, pilih TensorFlow.

Untuk Versi framework model, pilih 2.15.

Untuk Jenis akselerator, pilih GPU.

Untuk Lokasi artefak model, masukkan

gs://cloud-samples-data/bigquery/ml/remote_model_tutorial/.Biarkan nilai default untuk semua opsi yang tersisa, lalu klik Impor.

Setelah impor selesai, model Anda akan muncul di halaman Model Registry.

Men-deploy model ke endpoint Vertex AI

Ikuti langkah-langkah berikut untuk men-deploy model ke endpoint.

Di konsol Google Cloud , buka halaman Model Registry Vertex AI.

Di kolom Nama, klik

bert_sentiment.Klik tab Deploy & Test.

Klik Deploy to endpoint.

Untuk langkah pertama, Tentukan endpoint Anda, lakukan hal berikut:

Klik Buat endpoint baru.

Untuk Endpoint name, masukkan

bert sentiment endpoint.Biarkan nilai default yang tersisa, lalu klik Lanjutkan.

Untuk langkah kedua, Setelan model, lakukan hal berikut:

Di bagian Setelan komputasi, untuk Jumlah minimum node komputasi, masukkan

1. Ini adalah jumlah node yang harus selalu tersedia untuk model.Di bagian Advanced scaling options, untuk Machine type, pilih Standard (n1-standard-2). Karena Anda memilih GPU sebagai jenis akselerator saat mengimpor model, setelah Anda memilih jenis mesin, jenis akselerator dan jumlah akselerator akan ditetapkan secara otomatis.

Biarkan nilai default yang tersisa, lalu klik Deploy.

Saat model di-deploy ke endpoint, status akan berubah menjadi

Active.Salin ID endpoint numerik di kolom ID dan nilai di kolom Region. Anda akan membutuhkannya nanti.

Membuat set data

Buat set data BigQuery untuk menyimpan model ML Anda.

Konsol

Di konsol Google Cloud , buka halaman BigQuery.

Di panel Explorer, klik nama project Anda.

Klik View actions > Create dataset.

Di halaman Create dataset, lakukan hal berikut:

Untuk Dataset ID, masukkan

bqml_tutorial.Untuk Location type, pilih Multi-region, lalu pilih US (multiple regions in United States).

Jangan ubah setelan default yang tersisa, lalu klik Create dataset.

bq

Untuk membuat set data baru, gunakan perintah bq mk dengan flag --location. Untuk daftar lengkap kemungkinan parameter, lihat referensi

perintah bq mk --dataset.

Buat set data bernama

bqml_tutorialdengan lokasi data yang ditetapkan keUSdan deskripsiBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Perintah ini menggunakan pintasan

-d, bukan flag--dataset. Jika Anda menghapus-ddan--dataset, perintah defaultnya adalah membuat set data.Pastikan set data telah dibuat:

bq ls

API

Panggil metode datasets.insert dengan resource set data yang ditentukan.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

BigQuery DataFrames

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan BigQuery DataFrames di Panduan memulai BigQuery menggunakan BigQuery DataFrames. Untuk mengetahui informasi selengkapnya, lihat dokumentasi referensi BigQuery DataFrames.

Untuk melakukan autentikasi ke BigQuery, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Membuat koneksi resource BigQuery Cloud

Anda harus memiliki koneksi resource Cloud untuk terhubung ke endpoint Vertex AI.

Konsol

Buka halaman BigQuery.

Di panel kiri, klik Explorer:

Jika Anda tidak melihat panel kiri, klik Luaskan panel kiri untuk membuka panel.

Di panel Penjelajah, klik Tambahkan data.

Dialog Tambahkan data akan terbuka.

Di panel Filter Menurut, di bagian Jenis Sumber Data, pilih Database.

Atau, di kolom Telusuri sumber data, Anda dapat memasukkan

Vertex AI.Di bagian Sumber data unggulan, klik Vertex AI.

Klik kartu solusi Vertex AI Models: BigQuery Federation.

Dalam daftar Connection type, pilih Vertex AI remote models, remote functions and BigLake (Cloud Resource).

Di kolom Connection ID, masukkan

bqml_tutorial.Pastikan Multi-region—US dipilih.

Klik Create connection.

Di bagian bawah jendela, klik Buka koneksi. Atau, di panel Explorer, klik Connections, lalu klik

us.bqml_tutorial.Di panel Connection info, salin ID akun Layanan. Anda memerlukan ID ini saat mengonfigurasi izin untuk koneksi. Saat Anda membuat resource koneksi, BigQuery akan membuat akun layanan sistem unik dan mengaitkannya dengan koneksi.

bq

Buat koneksi:

bq mk --connection --location=US --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE bqml_tutorial

Ganti

PROJECT_IDdengan Google Cloud project ID Anda. Parameter--project_idakan menggantikan project default.Saat Anda membuat resource koneksi, BigQuery akan membuat akun layanan sistem unik dan mengaitkannya dengan koneksi.

Pemecahan masalah: Jika Anda mendapatkan error koneksi berikut, update Google Cloud SDK:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Ambil dan salin ID akun layanan untuk digunakan pada langkah berikutnya:

bq show --connection PROJECT_ID.us.bqml_tutorial

Outputnya mirip dengan hal berikut ini:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel.iam.gserviceaccount.com"}

Menyiapkan akses koneksi

Berikan peran Vertex AI User ke akun layanan koneksi resource Cloud. Anda harus memberikan peran ini di project yang sama tempat Anda membuat endpoint model jarak jauh.

Untuk memberikan peran, ikuti langkah-langkah berikut:

Buka halaman IAM & Admin.

Klik Berikan Akses.

Di kolom New principals, masukkan ID akun layanan koneksi resource Cloud yang Anda salin sebelumnya.

Di kolom Pilih peran, pilih Vertex AI, lalu pilih Pengguna Vertex AI.

Klik Simpan.

Membuat model jarak jauh BigQuery ML

Anda membuat model jarak jauh BigQuery ML menggunakan pernyataan CREATE MODEL dengan klausa REMOTE WITH CONNECTION. Untuk mengetahui informasi selengkapnya tentang

pernyataan CREATE MODEL, lihat Pernyataan CREATE MODEL untuk model jarak jauh

melalui model kustom.

Anda membuat model di lokasi multi-region US. Dalam set data multi-region BigQuery (US, EU), Anda hanya dapat membuat model jarak jauh yang terhubung ke endpoint yang di-deploy di region dalam lokasi multi-region yang sama (US, EU).

Saat membuat model jarak jauh, Anda memerlukan ID endpoint yang dihasilkan

saat Anda men-deploy model ke Vertex AI. Selain itu, nama dan jenis kolom input dan output harus sama persis dengan input dan output model Vertex AI. Dalam contoh ini, inputnya adalah teks STRING, dan

outputnya adalah ARRAY berjenis FLOAT64.

Konsol

Di konsol Google Cloud , buka halaman BigQuery.

Untuk Buat baru, klik Kueri SQL.

Di editor kueri, masukkan pernyataan

CREATE MODELini, lalu klik Jalankan:CREATE OR REPLACE MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment` INPUT (text STRING) OUTPUT(scores ARRAY<FLOAT64>) REMOTE WITH CONNECTION `PROJECT_ID.us.bqml_tutorial` OPTIONS(ENDPOINT = 'https://us-central1-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/endpoints/ENDPOINT_ID')

Ganti kode berikut:

- PROJECT_ID: nama project Anda.

- ENDPOINT_ID: ID endpoint yang Anda salin sebelumnya.

Setelah operasi selesai, Anda akan melihat pesan yang mirip dengan

Successfully created model named bert_sentiment.Model baru Anda akan muncul di panel Resources. Model ditunjukkan dengan ikon model:

.

.Jika Anda memilih model baru di panel Resources, informasi tentang model akan muncul di bawah Query editor.

bq

Buat model jarak jauh dengan memasukkan pernyataan

CREATE MODELberikut:bq query --use_legacy_sql=false \ "CREATE OR REPLACE MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment` INPUT (text STRING) OUTPUT(scores ARRAY<FLOAT64>) REMOTE WITH CONNECTION `PROJECT_ID.us.bqml_tutorial` OPTIONS(ENDPOINT = 'https://us-central1-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/endpoints/ENDPOINT_ID')"

Ganti kode berikut:

- PROJECT_ID: nama project Anda.

- ENDPOINT_ID: ID endpoint yang Anda salin sebelumnya.

Setelah membuat model, verifikasi bahwa model muncul di set data:

bq ls -m bqml_tutorial

Outputnya mirip dengan hal berikut ini:

Id Model Type Labels Creation Time ---------------- ------------ -------- ----------------- bert_sentiment 28 Jan 17:39:43

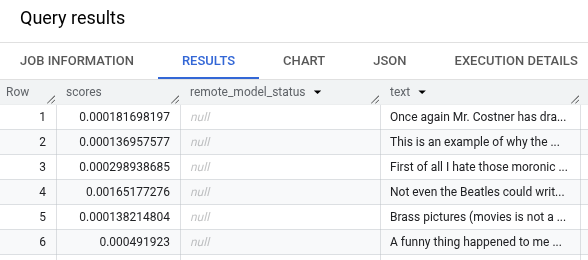

Mendapatkan prediksi menggunakan ML.PREDICT

Anda menggunakan fungsi ML.PREDICT untuk mendapatkan prediksi sentimen dari model

jarak jauh. Inputnya adalah kolom teks (review) yang berisi ulasan film

dari tabel bigquery-public-data.imdb.reviews.

Dalam contoh ini, 10.000 data dipilih dan dikirim untuk prediksi. Model jarak jauh ditetapkan secara default ke ukuran batch 128 instance untuk permintaan.

Konsol

Di konsol Google Cloud , buka halaman BigQuery.

Di bagian Buat baru, klik Kueri SQL.

Di editor kueri, masukkan kueri ini yang menggunakan fungsi

ML.PREDICT, lalu klik Run.SELECT * FROM ML.PREDICT ( MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment`, ( SELECT review as text FROM `bigquery-public-data.imdb.reviews` LIMIT 10000 ) )

Hasil kueri akan terlihat seperti berikut:

bq

Masukkan perintah ini untuk menjalankan kueri yang menggunakan ML.PREDICT.

bq query --use_legacy_sql=false \ 'SELECT * FROM ML.PREDICT ( MODEL `PROJECT_ID.bqml_tutorial.bert_sentiment`, ( SELECT review as text FROM `bigquery-public-data.imdb.reviews` LIMIT 10000 ) )'