Puoi utilizzare l'SDK Vertex AI per Python per visualizzare i dati delle esecuzioni di Vertex AI Experiments e confrontare le esecuzioni.

La console Google Cloud fornisce una visualizzazione dei dati associati a queste corse.

Recuperare i dati delle esecuzioni dell'esperimento

Questi esempi riguardano l'ottenimento di metriche di esecuzione, parametri di esecuzione, metriche delle serie temporali di runtime, artefatti e metriche di classificazione per una determinata esecuzione dell'esperimento.

Metriche di riepilogo

Python

run_name: specifica il nome dell'esecuzione appropriato per questa sessione.experiment: il nome o l'istanza di questo esperimento. Puoi trovare l'elenco degli esperimenti nella console Google Cloud selezionando Esperimenti nel menu di navigazione della sezione.project: . Puoi trovarli nella pagina Benvenuto della console Google Cloud .location: consulta l'elenco delle località disponibili.

Parametri

Python

run_name: specifica il nome dell'esecuzione appropriato per questa sessione.experiment: il nome o l'istanza di questo esperimento. Puoi trovare l'elenco degli esperimenti nella console Google Cloud selezionando Esperimenti nel menu di navigazione della sezione.project: . Puoi trovarli nella pagina Benvenuto della console Google Cloud .location: consulta l'elenco delle località disponibili.

Metriche delle serie temporali

Python

run_name: specifica il nome dell'esecuzione appropriato per questa sessione.experiment: il nome o l'istanza di questo esperimento. Puoi trovare l'elenco degli esperimenti nella console Google Cloud selezionando Esperimenti nel menu di navigazione della sezione.project: . Puoi trovarli nella pagina Benvenuto della console Google Cloud .location: consulta l'elenco delle località disponibili.

Artefatti

Python

run_name: specifica il nome dell'esecuzione appropriato per questa sessione.experiment: il nome o l'istanza di questo esperimento. Puoi trovare l'elenco degli esperimenti nella console Google Cloud selezionando Esperimenti nel menu di navigazione della sezione.project: . Puoi trovarli nella pagina Benvenuto della console Google Cloud .location: consulta l'elenco delle località disponibili.

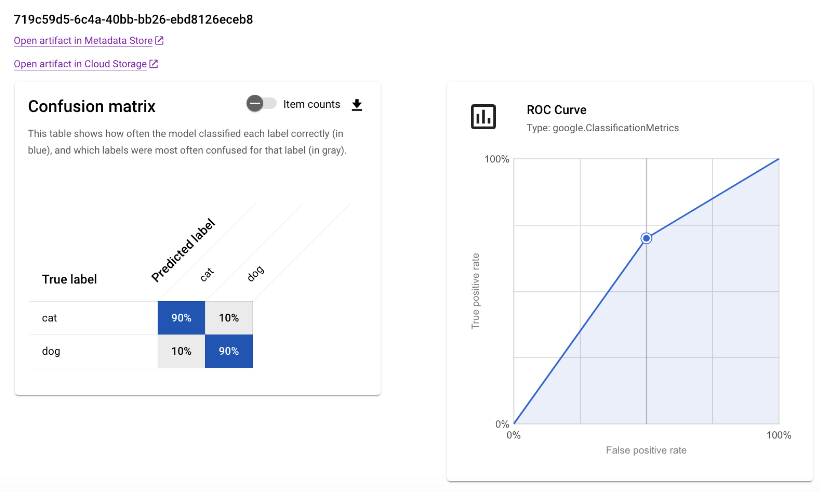

Metriche di classificazione

Python

run_name: specifica il nome dell'esecuzione appropriato per questa sessione.experiment: il nome o l'istanza di questo esperimento. Puoi trovare l'elenco degli esperimenti nella console Google Cloud selezionando Esperimenti nel menu di navigazione della sezione.project: . Puoi trovarli nella pagina Benvenuto della console Google Cloud .location: consulta l'elenco delle località disponibili.

Confronta esecuzioni

Utilizzando l'SDK Vertex AI per Python, puoi recuperare i dati associati al tuo esperimento. I dati delle esecuzioni dell'esperimento vengono restituiti in un DataFrame.

Confronta esecuzioni

I dati delle esecuzioni dell'esperimento vengono restituiti in un DataFrame.

Python

experiment_name: fornisci un nome per l'esperimento. Puoi trovare l'elenco degli esperimenti nella console Google Cloud selezionando Esperimenti nella barra di navigazione della sezione.project: . Puoi trovare questi ID nella pagina Benvenuto della console Google Cloud .location: consulta l'elenco delle località disponibili.

ConsoleGoogle Cloud

Utilizza la console Google Cloud per visualizzare i dettagli delle esecuzioni dell'esperimento e confrontarle tra loro.

Visualizzare i dati di esecuzione dell'esperimento

- Nella console Google Cloud , vai alla pagina Esperimenti.

Vai a Esperimenti.

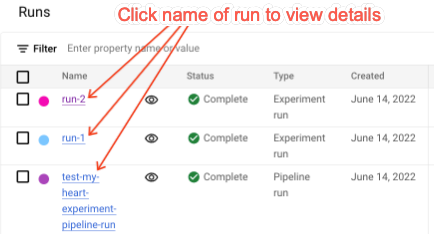

Viene visualizzato un elenco di esperimenti associati a un progetto. - Seleziona l'esperimento contenente l'esecuzione che vuoi controllare.

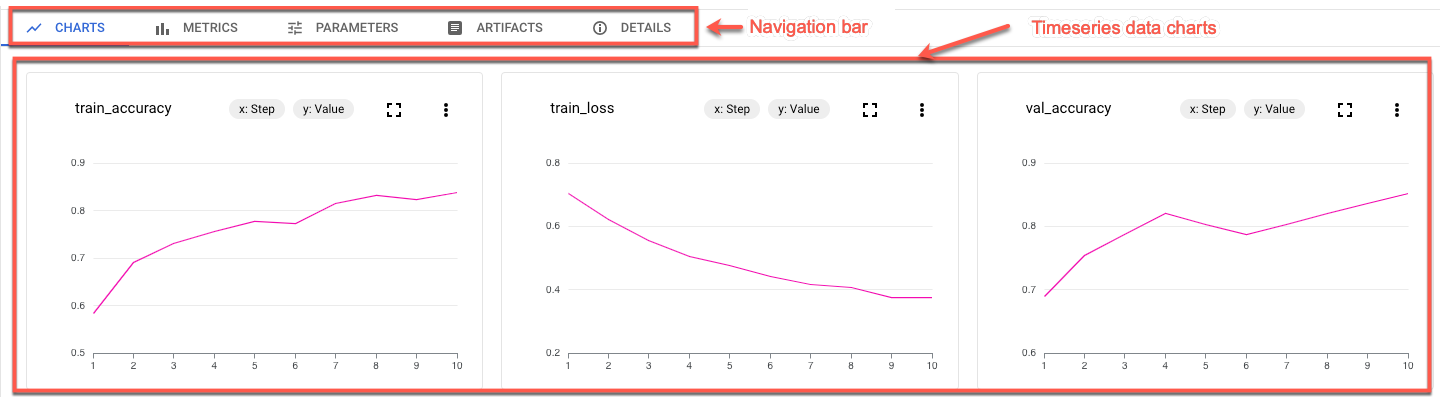

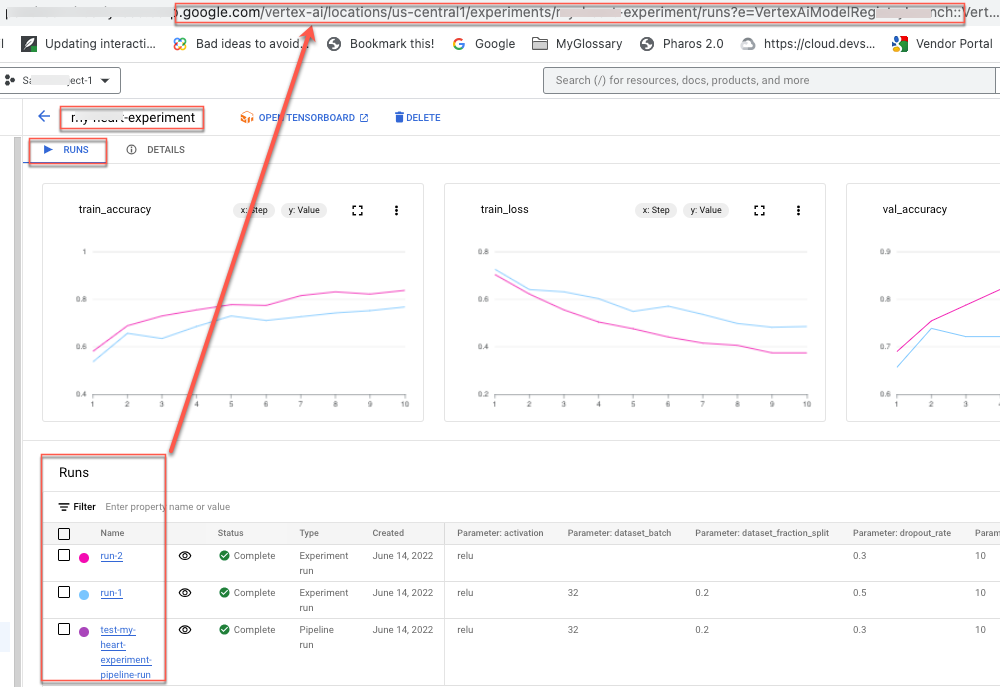

Viene visualizzato un elenco di corse, grafici di dati delle serie temporali e una tabella di dati di metriche e parametri. Nota che in questo caso sono selezionate tre corse, ma nei grafici dei dati delle serie temporali vengono visualizzate solo due linee. Non è presente una terza linea perché la terza esecuzione dell'esperimento non dispone di dati delle serie temporali da visualizzare.

- Fai clic sul nome dell'esecuzione per passare alla relativa pagina dei dettagli.

Vengono visualizzati la barra di navigazione e i grafici delle serie temporali.

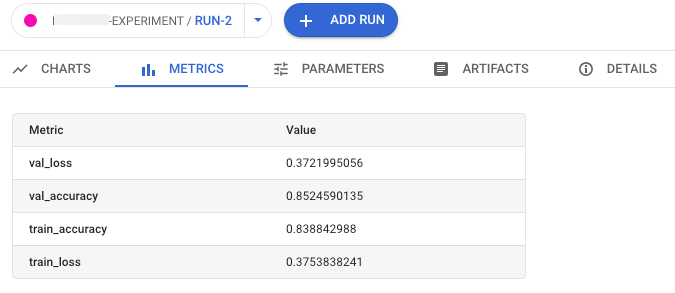

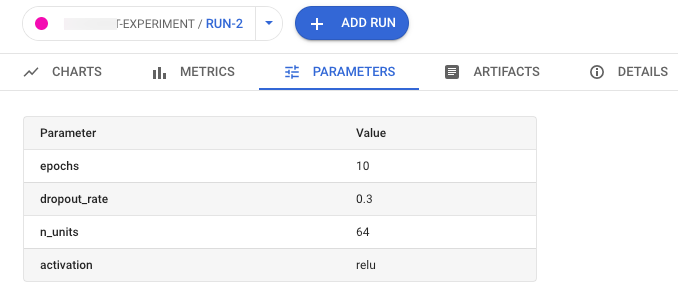

- Per visualizzare metriche, parametri, artefatti e dettagli dell'esecuzione selezionata,

fai clic sui rispettivi pulsanti nella barra di navigazione.

- Metriche

- Parametri

- Artefatti

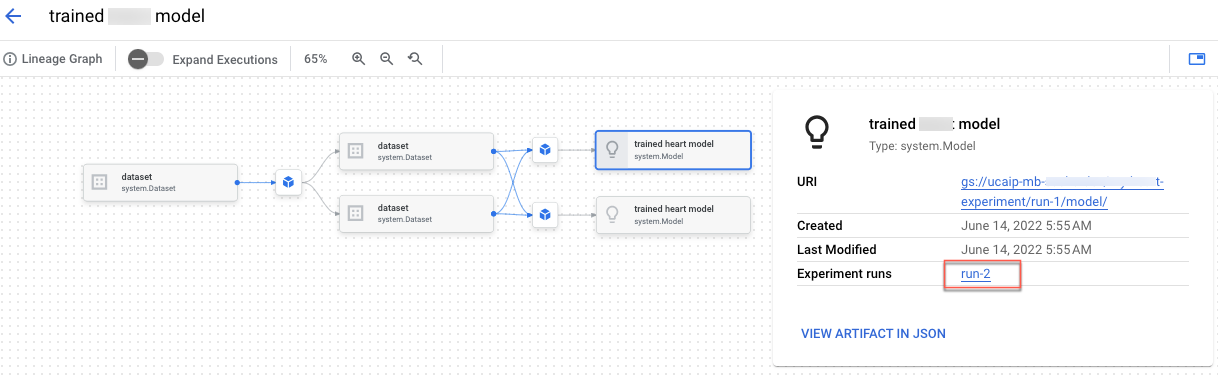

Per visualizzare la derivazione dell'artefatto, fai clic sul link Apri l'artefatto nell'archivio metadati. Viene visualizzato il grafico di derivazione associato all'esecuzione.

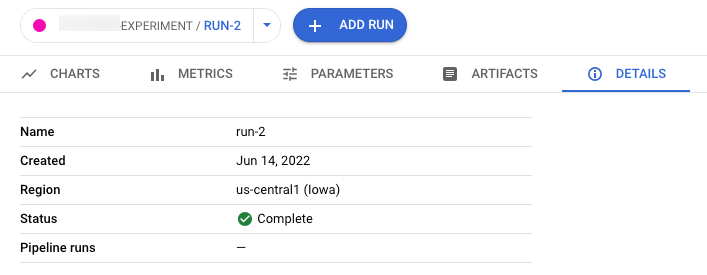

- Dettagli

- Metriche

Per condividere i dati con altri, utilizza gli URL associati alle visualizzazioni. Ad esempio, condividi l'elenco delle esecuzioni dell'esperimento associate a un esperimento:

Confrontare le esecuzioni degli esperimenti

Puoi selezionare le esecuzioni da confrontare sia all'interno di un esperimento sia tra esperimenti diversi.

- Nella console Google Cloud , vai alla pagina Esperimenti.

Vai a Esperimenti.

Viene visualizzato un elenco di esperimenti. - Seleziona l'esperimento contenente le esecuzioni che vuoi confrontare. Viene visualizzato un elenco di esecuzioni.

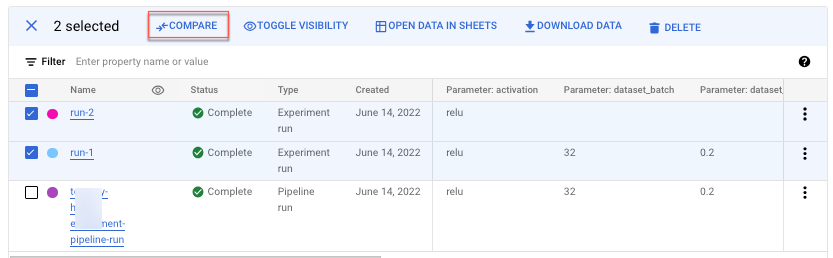

- Seleziona le esecuzioni dell'esperimento che vuoi confrontare. Fai clic su Confronta.

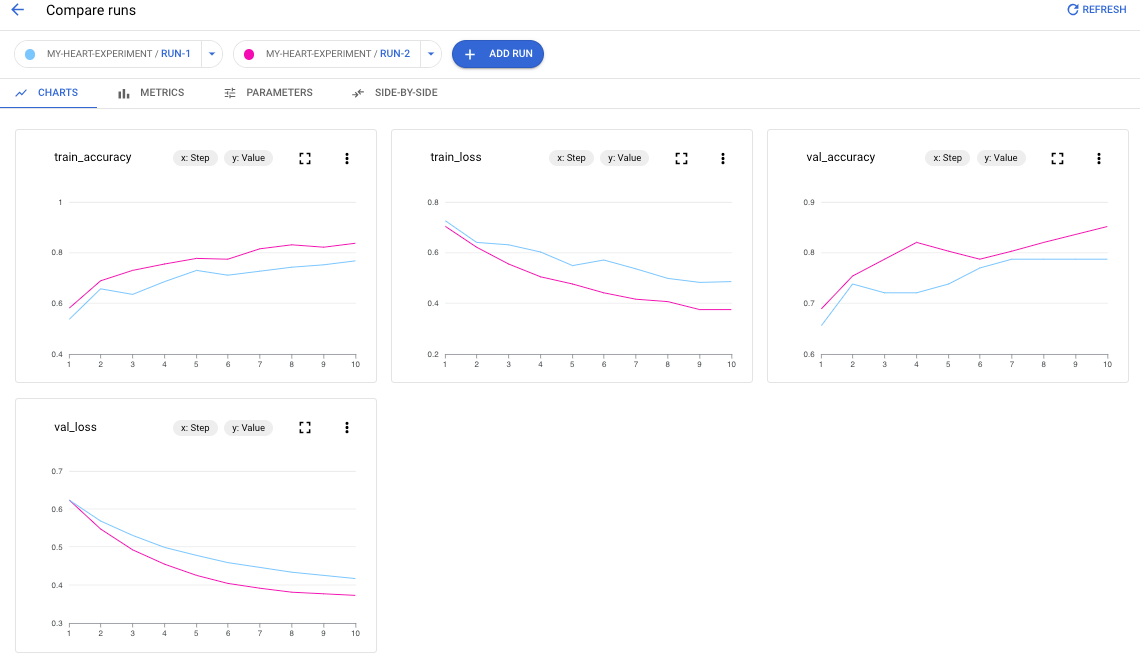

Per impostazione predefinita, i grafici vengono visualizzati confrontando le metriche delle serie temporali delle esecuzioni dell'esperimento selezionate.

- Per aggiungere altre esecuzioni da qualsiasi esperimento nel progetto, fai clic su Aggiungi esecuzione.

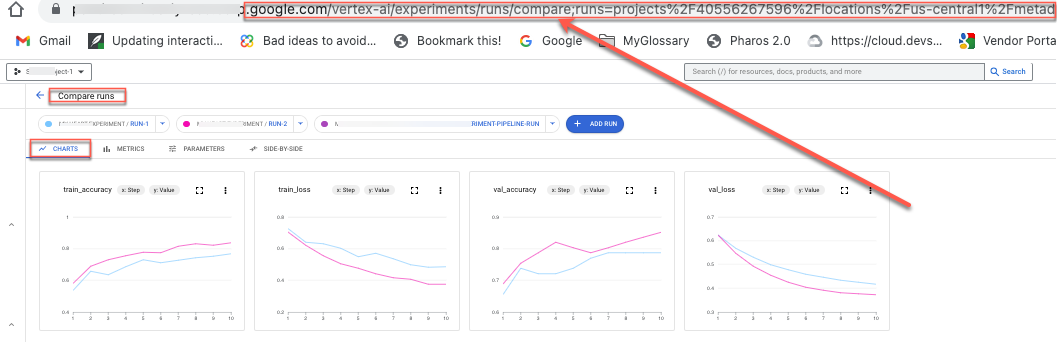

Per condividere i dati con altri, utilizza gli URL associati alle visualizzazioni. Ad esempio, condividi la visualizzazione del confronto dei dati delle metriche delle serie temporali:

Consulta Creare e gestire le esecuzioni di esperimenti per scoprire come aggiornare lo stato di un'esecuzione.