Vous pouvez créer un cluster de basculement à l'aide de Windows Server sur Google Cloud Platform (GCP). Plusieurs serveurs collaborent afin de fournir une haute disponibilité (HD) à vos applications Windows. Si un nœud de cluster est défaillant, un autre nœud peut prendre en charge l'exécution du logiciel. Vous pouvez configurer le basculement pour qu'il se produise automatiquement (ce qui correspond à la configuration habituelle) ou vous pouvez le déclencher manuellement.

Ce tutoriel part du principe que vous connaissez la fonctionnalité de clustering de basculement, Active Directory (AD) et l'administration de Windows Server.

Pour un bref aperçu de la mise en réseau dans GCP, consultez l'article GCP pour les experts en centre de données : Mise en réseau.

Architecture

Ce tutoriel vous explique comment créer un exemple de cluster de basculement sur Compute Engine. L'exemple de système contient les deux serveurs suivants :

- Une instance de VM Compute Engine principale exécutant Windows Server 2016 dans la zone

a. - Une seconde instance, configurée pour correspondre à l'instance principale dans la zone

b.

De plus, vous déployez un contrôleur de domaine AD qui, dans le cadre de ce tutoriel, remplit les fonctions suivantes :

- fournit un domaine Windows ;

- résout des noms d'hôte sur des adresses IP ;

- héberge le témoin de partage de fichiers agissant comme un troisième "vote" afin d'atteindre le quorum requis pour le cluster.

Vous pouvez créer le contrôleur de domaine dans n'importe quelle zone. Ce tutoriel utilise la zone c.

Dans un système de production, vous pouvez héberger le témoin de partage de fichiers à un autre endroit. Vous n'avez pas besoin de système AD distinct pour ne prendre en charge que votre cluster de basculement. Consultez la section Étapes suivantes pour obtenir des liens vers des articles relatifs à l'utilisation d'AD dans GCP.

Les deux serveurs que vous utiliserez pour déployer le cluster de basculement sont situés dans des zones différentes afin de garantir que chaque serveur se trouve sur une machine physique différente et de vous assurer une protection dans le cas improbable d'une défaillance de zone.

Le graphique suivant décrit l'architecture que vous allez déployer en suivant ce tutoriel.

Options d'espace de stockage partagé

Ce tutoriel ne couvre pas la configuration d'un serveur de fichiers pour l'espace de stockage partagé à haute disponibilité.

Google Cloud accepte plusieurs solutions d'espace de stockage partagé que vous pouvez utiliser avec le clustering de basculement Windows Server, parmi lesquelles :

Pour en savoir plus sur les autres solutions d'espace de stockage partagé possibles, consultez les pages suivantes :

Comprendre le routage réseau

Si le cluster bascule, les requêtes doivent être envoyées au nouveau nœud actif. La technologie de clustering gère normalement le routage en utilisant le protocole de résolution d'adresse (ARP), qui associe les adresses IP aux adresses MAC. Dans GCP, le cloud privé virtuel (VPC) utilise un réseau défini par logiciel qui n'utilise pas d'adresses MAC. Cela signifie que les modifications diffusées à l'aide de l'ARP n'affectent pas du tout le routage. Pour que le routage fonctionne, le cluster nécessite une aide logicielle émanant de l'équilibreur de charge interne.

En général, l'équilibrage de charge interne répartit le trafic réseau entrant sur plusieurs instances backend internes à votre VPC, afin de partager la charge entre elles. Pour le clustering de basculement, nous vous recommandons d'utiliser l'équilibrage de charge interne pour router tout le trafic vers une seule instance : le nœud de cluster actuellement actif. Voici comment l'équilibrage de charge interne détecte le nœud approprié :

- Chaque instance de VM exécute une instance de l'agent Compute Engine compatible avec la fonctionnalité de clustering de basculement Windows. L'agent assure le suivi des adresses IP pour l'instance de VM.

- L'interface de l'équilibreur de charge fournit l'adresse IP pour le trafic entrant vers l'application.

- Le backend de l'équilibreur de charge réalise une vérification de l'état. Le processus de vérification de l'état pingue l'agent de façon périodique sur chaque nœud du cluster, en utilisant l'adresse IP fixe de l'instance de VM via un port particulier. Le port par défaut est 59998.

- La vérification de l'état inclut l'adresse IP de l'application en tant que charge utile dans la requête.

- L'agent compare l'adresse IP dans la requête à la liste des adresses IP de la VM hôte. Si l'agent trouve une correspondance, il renvoie une valeur de 1. Sinon, il renvoie une valeur de 0.

- Si la vérification de l'état d'une VM aboutit, l'équilibreur de charge la marque comme étant saine. À tout moment, une seule VM peut voir la vérification de son état aboutir. En effet, une seule VM possède l'adresse IP de la charge de travail.

Que se passe-t-il pendant un basculement ?

Lorsqu'un basculement se produit dans le cluster, les modifications suivantes sont appliquées :

- La fonctionnalité de clustering de basculement Windows modifie le statut du nœud actif pour indiquer qu'il est défaillant.

- Cette même fonctionnalité déplace ensuite toutes les ressources et tous les rôles de cluster du nœud défaillant vers le nœud le plus approprié, tel que défini par le quorum. Cette action inclut le déplacement des adresses IP associées.

- Le clustering de basculement diffuse les paquets ARP pour indiquer aux routeurs réseau matériels que les adresses IP ont été déplacées. Dans ce scénario, le réseau GCP ignore ces paquets.

- Une fois le déplacement effectué, l'agent Compute Engine de la VM associée au nœud défaillant renvoie une valeur de 0 au lieu de 1 à la vérification de l'état de la VM. La réponse est modifiée car la VM n'héberge plus l'adresse IP indiquée dans la requête.

- L'agent Compute Engine de la VM associée au nouveau nœud actif modifie également sa réponse à la vérification de l'état, en renvoyant une valeur de 1 au lieu de 0.

- L'équilibreur de charge interne interrompt le routage du trafic vers le nœud défaillant et le dirige vers le nœud nouvellement actif.

Pour aller plus loin

Maintenant que vous avez examiné certains concepts, voici quelques détails à noter concernant le graphique représentant l'architecture :

- L'agent Compute Engine de la VM nommée

wsfc-2renvoie à la vérification de l'état une valeur de 1, indiquant qu'il s'agit du nœud de cluster actif. Pourwsfc-1, la valeur renvoyée est 0. - L'équilibreur de charge redirige les requêtes vers

wsfc-2, comme l'indique la flèche. - L'équilibreur de charge et

wsfc-2disposent tous deux de l'adresse IP10.0.0.9. Pour l'équilibreur de charge, il s'agit de l'adresse IP frontend spécifiée. Pour la VM, il s'agit de l'adresse IP de l'application. Le cluster de basculement définit cette adresse IP sur le nœud actuellement actif. - Le cluster de basculement et

wsfc-2disposent tous deux de l'adresse IP10.0.0.8. La VM dispose de cette adresse IP, car elle héberge actuellement les ressources du cluster.

Conseils pour suivre ce tutoriel

Ce tutoriel comporte de nombreuses étapes. Vous serez parfois invité à suivre les étapes décrites dans des documents externes, tels que la documentation Microsoft. Vous trouverez dans ce tutoriel des notes détaillant la réalisation de ces étapes externes.

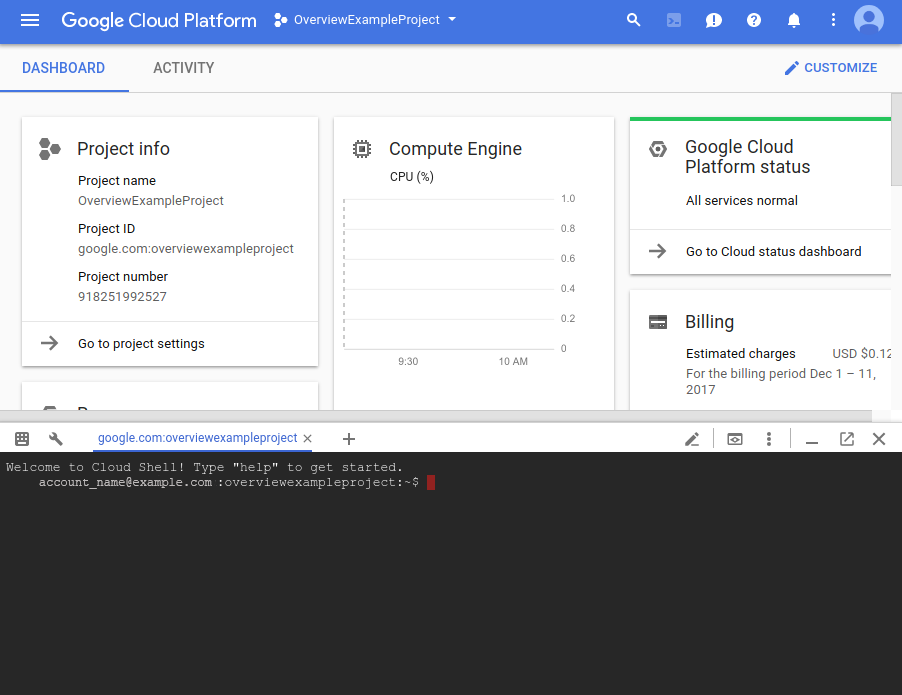

Ce tutoriel utilise Cloud Shell dans la console Google Cloud . Bien qu'il soit possible de configurer le clustering de basculement via l'interface utilisateur de la console Google Cloud ou la gcloud CLI, ce tutoriel utilise principalement Cloud Shell pour vous faciliter la tâche. Cette approche vous permettra de le terminer plus rapidement. Certaines étapes nécessiteront, lorsque cela sera plus pertinent, l'utilisation de la console Google Cloud au lieu de Cloud Shell.

Il est recommandé de prendre des instantanés de vos disques persistants Compute Engine tout au long du processus. Si un problème survient, vous pourrez ainsi utiliser un instantané pour éviter de tout recommencer depuis le début. Dans ce tutoriel, des suggestions s'afficheront pour vous indiquer les bons moments pour prendre des instantanés.

Si vous découvrez que certaines étapes ne fonctionnent pas comme prévu, vous trouverez peut-être des instructions pour résoudre le problème dans la section que vous parcourez. Si aucune instruction n'est disponible, reportez-vous à la section Dépannage.

Objectifs

- Créer un réseau.

- Installer Windows Server 2016 sur deux VM Compute Engine.

- Installer et configurer Active Directory sur une troisième instance dans Windows Server.

- Configurer le cluster de basculement, y compris un témoin de partage de fichiers pour le quorum et un rôle pour la charge de travail.

- Configurer l'équilibreur de charge interne.

- Tester l'opération de basculement pour vérifier que le cluster fonctionne

Prérequis

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Compute Engine API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Compute Engine API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. - Démarrez une instance dans Cloud Shell.

Accéder à Cloud Shell

Créer le réseau

Votre cluster nécessite un réseau personnalisé. Utilisez le système VPC pour créer un réseau et un sous-réseau personnalisés en exécutant des commandes gcloud dans Cloud Shell.

Créez le réseau à l'aide de la commande suivante :

gcloud compute networks create wsfcnet --subnet-mode customLe nom du réseau que vous avez créé est

wsfcnet.Créez un sous-réseau à l'aide de la commande suivante, en remplaçant

[YOUR_REGION]par une région GCP à proximité :gcloud compute networks subnets create wsfcnetsub1 --network wsfcnet --region [YOUR_REGION] --range 10.0.0.0/16Le nom du sous-réseau que vous avez créé est

wsfcnetsub1.

Notez que la plage CIDR pour les adresses IP dans ce sous-réseau est 10.0.0.0/16. Il s'agit d'un exemple de plage utilisée dans le cadre de ce tutoriel. Dans les systèmes de production, vous devrez collaborer avec vos administrateurs réseau pour attribuer les plages d'adresses IP adaptées à vos systèmes.

Créer des règles de pare-feu

Par défaut, votre réseau est fermé au trafic externe. Vous devez ouvrir des ports dans le pare-feu pour activer les connexions à distance aux serveurs. Utilisez les commandes gcloud dans Cloud Shell pour créer ces règles.

Pour ce tutoriel, ouvrez le port 3389 sur le réseau principal pour activer les connexions RDP. Dans la commande suivante, remplacez

[YOUR_IPv4_ADDRESS]par l'adresse IP de l'ordinateur utilisé pour vous connecter aux instances de votre VM. Dans un système de production, vous pouvez fournir une plage d'adresses IP ou une série d'adresses.gcloud compute firewall-rules create allow-rdp --network wsfcnet --allow tcp:3389 --source-ranges [YOUR_IPv4_ADDRESS]Sur le sous-réseau, autorisez tous les protocoles sur tous les ports pour permettre aux serveurs de communiquer entre eux. Dans un système de production, vous devrez envisager de n'ouvrir que certains ports, selon vos besoins.

gcloud compute firewall-rules create allow-all-subnet --network wsfcnet --allow all --source-ranges 10.0.0.0/16Notez que la valeur de

source-rangescorrespond à la plage d'adressage CIDR que vous avez utilisée pour créer le sous-réseau.Affichez vos règles de pare-feu à l'aide de la commande suivante :

gcloud compute firewall-rules listUn résultat semblable aux lignes suivantes doit s'afficher :

NAME NETWORK DIRECTION PRIORITY ALLOW DENY DISABLED allow-all-subnet wsfcnet INGRESS 1000 all False allow-rdp wsfcnet INGRESS 1000 tcp:3389 False

Activer le clustering de basculement dans Compute Engine

Pour activer le clustering de basculement dans l'agent Compute Engine, vous devez ajouter l'indicateur enable-wsfc=true à vos définitions de VM en le spécifiant en tant que métadonnées personnalisées pour la VM ou en créant un fichier de configuration sur chaque VM, comme décrit dans la documentation de Compute Engine.

Ce tutoriel définit l'indicateur en tant que métadonnées personnalisées au moment de la création des VM, comme décrit dans la section suivante. Il s'appuie également sur le comportement par défaut pour wsfc-addrs et wsfc-agent-port, vous n'avez donc pas besoin de définir ces valeurs.

Créer les serveurs

Créez ensuite les trois serveurs. Exécutez la commande gcloud dans Cloud Shell.

Créer le premier serveur de nœud de cluster

Créez une instance Compute Engine. Pour la configurer, procédez comme suit :

- Nommez l'instance

wsfc-1. - Définissez l'indicateur

--zonesur une zone appropriée proche de vous. Par exemple,us-central1-a. - Définissez l'indicateur

--machine-typesurn1-standard-2.. - Définissez l'indicateur

--image-projectsurwindows-cloud. - Définissez l'indicateur

--image-familysurwindows-2016. - Définissez l'indicateur

--scopessurhttps://www.googleapis.com/auth/compute. - Définissez l'indicateur

--can-ip-forwardpour activer le transfert IP. - Définissez l'indicateur

--private-network-ipsur10.0.0.4. - Définissez le réseau sur

wsfcnetet le sous-réseau surwsfcnetsub1. - Utilisez le paramètre

--metadatapour définirenable-wsfc=true.

Exécutez la commande suivante, en remplaçant [YOUR_ZONE_1] par le nom de votre première zone :

gcloud compute instances create wsfc-1 --zone [YOUR_ZONE_1] --machine-type n1-standard-2 --image-project windows-cloud --image-family windows-2016 --scopes https://www.googleapis.com/auth/compute --can-ip-forward --private-network-ip 10.0.0.4 --network wsfcnet --subnet wsfcnetsub1 --metadata enable-wsfc=true

Créer le deuxième serveur de nœud de cluster

Pour le deuxième serveur, suivez les mêmes étapes que précédemment, sauf pour les éléments suivants :

- Définissez le nom de l'instance sur

wsfc-2. - Définissez l'indicateur

--zonesur une zone différente de celle que vous avez utilisée pour le premier serveur. Par exemple,us-central1-b. - Définissez l'indicateur

--private-network-ipsur10.0.0.5.

Remplacez [YOUR_ZONE_2] par le nom de la deuxième zone :

gcloud compute instances create wsfc-2 --zone [YOUR_ZONE_2] --machine-type n1-standard-2 --image-project windows-cloud --image-family windows-2016 --scopes https://www.googleapis.com/auth/compute --can-ip-forward --private-network-ip 10.0.0.5 --network wsfcnet --subnet wsfcnetsub1 --metadata enable-wsfc=true

Créer le troisième serveur pour Active Directory

Pour le contrôleur de domaine, suivez les mêmes étapes que précédemment, sauf pour les éléments suivants :

- Définissez le nom de l'instance sur

wsfc-dc. - Définissez l'indicateur

--zonesur une zone différente de celles que vous avez utilisées pour les autres serveurs. Par exemple,us-central1-c. - Définissez l'indicateur

--private-network-ipsur10.0.0.6. - Omettez

--metadata enable-wsfc=true.

Remplacez [YOUR_ZONE_3] par le nom de votre zone :

gcloud compute instances create wsfc-dc --zone [YOUR_ZONE_3] --machine-type n1-standard-2 --image-project windows-cloud --image-family windows-2016 --scopes https://www.googleapis.com/auth/compute --can-ip-forward --private-network-ip 10.0.0.6 --network wsfcnet --subnet wsfcnetsub1

Afficher vos instances

Vous pouvez afficher les détails des instances que vous avez créées, en exécutant la commande suivante :

gcloud compute instances list

Un résultat semblable aux lignes suivantes s'affichera :

NAME ZONE MACHINE_TYPE PREEMPTIBLE INTERNAL_IP EXTERNAL_IP STATUS wsfc-1 us-central1-a n1-standard-2 10.0.0.4 35.203.131.133 RUNNING wsfc-2 us-central1-b n1-standard-2 10.0.0.5 35.203.130.194 RUNNING wsfc-dc us-central1-c n1-standard-2 10.0.0.6 35.197.27.2 RUNNING

Se connecter aux VM

Pour vous connecter à une VM sous Windows, vous devez d'abord générer un mot de passe pour celle-ci. Vous pouvez ensuite vous y connecter à l'aide du protocole RDP.

Générer des mots de passe

Dans la console Google Cloud , accédez à la page Instances de VM.

Cliquez sur le nom de l'instance de VM pour laquelle vous avez besoin d'un nouveau mot de passe.

Sur la page d'informations de l'instance, cliquez sur le bouton Définir un mot de passe Windows. Un mot de passe est alors généré. Copiez le mot de passe et stockez-le dans un emplacement sécurisé.

Se connecter via le protocole RDP

La documentation de Compute Engine fournit de plus amples informations sur la procédure de connexion à vos instances de VM Windows via le protocole RDP. Au choix, vous pouvez :

- Utiliser un client existant.

- ajouter à votre navigateur un plug-in Chrome pour le protocole RDP, puis vous connecter via la consoleGoogle Cloud .

Chaque fois que ce tutoriel vous demande de vous connecter à une instance Windows, utilisez votre connexion RDP préférée.

Configurer la mise en réseau Windows

Les adresses IP internes que vous avez attribuées lors de la création des VM sont statiques. Pour vous assurer que Windows considère les adresses IP comme statiques, vous devez les ajouter, ainsi que les adresses IP de la passerelle par défaut et du serveur DNS, à la configuration de mise en réseau de Windows Server.

Utilisez le protocole RDP pour vous connecter à wsfc-1, wsfc-2 et wsfc-dc, puis répétez les étapes suivantes pour chaque instance :

- Dans le volet de gauche du Gestionnaire de serveur, sélectionnez Serveur local.

- Dans l'entrée Ethernet du volet Propriétés, cliquez sur Adresse IPv4 attribuée par DHCP, compatible IPv6.

- Faites un clic droit sur Ethernet, puis sélectionnez Propriétés.

- Double-cliquez sur Protocole Internet Version 4 (TCP/IPv4).

- Sélectionnez Utiliser l'adresse IP suivante.

Saisissez l'adresse IP interne que vous avez attribuée à la VM lors de sa création.

- Pour

wsfc-1, saisissez "10.0.0.4". - Pour

wsfc-2, saisissez "10.0.0.5". - Pour

wsfc-dc, saisissez "10.0.0.6".

- Pour

Pour Masque de sous-réseau, saisissez "255.255.0.0".

Pour Passerelle par défaut, saisissez

10.0.0.1, l'adresse IP automatiquement réservée à la passerelle par défaut lors de la création du sous-réseauwsfcnetsub1.L'adresse IP de la passerelle par défaut est toujours la deuxième adresse de la plage d'adresses IP principale d'un sous-réseau. Consultez la section Adresses inutilisables dans les plages de sous-réseaux IPv4.

Pour

wsfc-1etwsfc-2uniquement :Cliquez sur Utiliser l'adresse de serveur DNS suivante.

Pour Serveur DNS préféré, saisissez "10.0.0.6".

Fermez toutes les boîtes de dialogue.

Vous perdez alors la connexion RDP, car ces modifications réinitialisent la carte réseau virtuelle de l'instance de VM.

Fermez la session RDP, puis reconnectez-vous à l'instance. Si une des boîtes de dialogue de l'étape précédente est toujours ouverte, fermez-la.

Dans la section sur les propriétés du serveur local, vérifiez que le paramètre Ethernet correspond à l'adresse IP du serveur local (

10.0.0.4,10.0.0.5,ou10.0.0.6). Si ce n'est pas le cas, ouvrez à nouveau la boîte de dialogue Protocole Internet Version 4 (TCP/IPv4), puis modifiez le paramètre.

Nous vous proposons à présent de prendre des instantanés de wsfc-1 et wsfc-2.

Configurer Active Directory

Configurez à présent le contrôleur de domaine.

- Utilisez le protocole RDP pour vous connecter au serveur nommé

wsfc-dc. - À l'aide de l'application de bureau "Gestion de l'ordinateur Windows", définissez un mot de passe pour le compte administrateur local.

- Activez le compte administrateur local.

Pour configurer le contrôleur de domaine, suivez la procédure décrite dans les instructions Microsoft, dont le lien est indiqué après les remarques supplémentaires ci-dessous. Vous pouvez utiliser les valeurs par défaut pour la plupart des paramètres.

- Cochez la case pour le rôle "Serveur DNS". Cette étape n'est pas spécifiée dans les instructions.

- Cochez la case Redémarrer automatiquement le serveur de destination, si nécessaire.

- Définissez le serveur de fichiers comme contrôleur de domaine.

- Lors de l'étape Ajouter une nouvelle forêt, nommez votre domaine "WSFC.TEST".

- Définissez le nom de domaine NetBIOS sur "WSFC" (valeur par défaut).

Nous vous proposons à présent de prendre des instantanés de wsfc-dc.

Créer le compte utilisateur du domaine

Le redémarrage de wsfc-dc peut prendre un certain temps. Avant de relier des serveurs au domaine, utilisez le protocole RDP pour vous connecter à wsfc-dc, afin de vérifier que le contrôleur de domaine est bien en cours d'exécution.

Vous devez créer un profil d'utilisateur du domaine disposant de droits d'administrateur pour les serveurs de cluster. Procédez comme suit :

- Dans le contrôleur de domaine

wsfc-dc, cliquez sur Démarrer, puis saisissez dsa pour rechercher et ouvrir l'application "Utilisateurs et ordinateurs Active Directory". - Faites un clic droit sur WSFC.TEST, placez votre souris sur Nouveau, puis cliquez sur Utilisateur.

- Dans les champs Nom complet et Nom d'ouverture de session de l'utilisateur, saisissez

cluster-admin. - Cliquez sur Suivant.

- Saisissez un mot de passe pour l'utilisateur et confirmez-le. Sélectionnez les options souhaitées relatives au mot de passe dans la boîte de dialogue. Par exemple, vous pouvez choisir que le mot de passe défini n'expire jamais.

- Confirmez les paramètres, puis cliquez sur Terminer.

Attribuez à

cluster-adminle rôle d'administrateur danswsfc-dc:- Effectuez un clic droit sur

cluster-admin, puis sélectionnez Ajouter à un groupe. - Saisissez Administrateurs, puis cliquez sur OK.

- Effectuez un clic droit sur

Ce tutoriel utilise WSFC.TEST\cluster-admin comme compte administrateur à chaque endroit où ce type de compte est nécessaire. Dans un système de production, suivez vos mesures de sécurité habituelles relatives à l'attribution des comptes et des autorisations. Pour en savoir plus, consultez l'article Overview of Active Directory accounts needed by a failover cluster.

Relier les serveurs au domaine

Ajoutez les deux serveurs de nœuds de cluster au domaine WSFC.TEST. Pour ce faire, réalisez les étapes suivantes pour chaque serveur de nœud de cluster (wsfc-1 et wsfc-2) :

- Dans Gestionnaire de serveur > Serveur local, cliquez sur GROUPE DE TRAVAIL dans le volet Propriétés.

- Cliquez sur Modifier.

- Sélectionnez Domaine, puis saisissez "WSFC.TEST".

- Cliquez sur OK.

- Indiquez les identifiants nécessaires pour relier

WSFC.TEST\cluster-adminau domaine. - Cliquez sur OK.

- Fermez les boîtes de dialogue, puis suivez les instructions qui s'affichent pour redémarrer le serveur.

Dans Gestionnaire de serveur, attribuez à

cluster-adminle rôle d'administrateur danswsfc-1etwsfc-2. Vous pouvez également gérer les droits d'administrateur à l'aide d'une stratégie de groupe.- Dans le menu Outils, sélectionnez Gestion de l'ordinateur > Utilisateurs et groupes locaux > Groupes > Administrateurs, puis cliquez sur Ajouter.

- Saisissez "cluster-admin", puis cliquez sur Vérifier les noms.

- Cliquez sur OK.

Nous vous proposons à présent de prendre des instantanés des trois VM.

Configurer le clustering de basculement

Réserver une adresse IP au cluster dans Compute Engine

Lorsque vous créez le cluster de basculement, vous attribuez une adresse IP pour créer un point d'accès administratif. Dans un environnement de production, vous pouvez utiliser une adresse IP d'un sous-réseau distinct. Cependant, dans le cadre de ce tutoriel, vous réservez une adresse IP du sous-réseau que vous avez déjà créé. La réservation de l'adresse IP évite les conflits avec d'autres attributions d'adresses IP.

Ouvrez un terminal sur une VM hôte ou ouvrez Cloud Shell.

Réservez une adresse IP. Pour ce tutoriel, utilisez

10.0.0.8:gcloud compute addresses create cluster-access-point --region [YOUR_REGION] --subnet wsfcnetsub1 --addresses 10.0.0.8

Pour confirmer la réservation de l'adresse IP :

gcloud compute addresses list

Créer le cluster

Pour créer et configurer le cluster de basculement, procédez comme suit :

- Connectez-vous à

wsfc-1etwsfc-2à l'aide du protocole RDP. Suivez la procédure décrite dans les instructions Microsoft, dont le lien est indiqué après les remarques supplémentaires ci-dessous :

- Installez la fonctionnalité de clustering de basculement sur

wsfc-1etwsfc-2. N'installez pas cette fonctionnalité surwsfc-dc. - Exécutez l'application "Gestionnaire du cluster de basculement" en tant qu'utilisateur de domaine

WSFC.TEST\cluster-admin. Sinon, vous pourriez rencontrer des problèmes d'autorisation. Il est judicieux de toujours exécuter le gestionnaire de cluster de basculement de cette manière ou de vous connecter à un serveur en tant quecluster-adminpour vous assurer que vous disposez des autorisations requises. - Ajoutez

wsfc-1etwsfc-2au cluster en tant que nœuds. Pour valider la configuration, procédez comme suit :

- Sur la page Options de test, sélectionnez Exécuter uniquement les tests que je sélectionne , puis cliquez sur Suivant.

Sur la page Sélection des tests, effacez le contenu de l'option Stockage. En effet, cette option échoue au moment de s'exécuter sur Compute Engine, de la même façon que sur des serveurs physiques autonomes.

Voici des problèmes courants que vous pouvez rencontrer lors de la validation de cluster :

- Une seule interface réseau entre les instances dupliquées : vous pouvez ignorer cette erreur, car elle ne s'applique pas à une configuration basée sur le cloud.

- Les mises à jour Windows sont différentes sur les deux instances dupliquées : si vous avez configuré vos instances Windows pour autoriser les mises à jour automatiques, les mises à jour de l'un des nœuds peuvent avoir été appliquées, alors que celles de l'autre n'ont pas encore été téléchargées. Vous devez conserver la même configuration pour les serveurs.

- Redémarrage en attente : vous avez apporté des modifications à l'un des serveurs. Pour les appliquer, le redémarrage du serveur concerné est donc nécessaire. N'ignorez pas cette erreur.

- Les serveurs n'ont pas tous le même rôle de domaine : vous pouvez ignorer cette erreur.

- Les serveurs ne se situent pas tous dans la même unité organisationnelle (UO) : Ce tutoriel n'utilise pas du tout d'unité organisationnelle. Cependant, dans un système de production, vous devrez envisager de placer votre cluster dans sa propre unité organisationnelle. Les instructions Microsoft décrivent les bonnes pratiques à adopter dans ce contexte.

- Des pilotes non signés ont été trouvés : vous pouvez ignorer cette erreur.

Sur la page Résumé, vous pouvez sélectionner Créer le cluster maintenant en utilisant les nœuds validés pour poursuivre la création du cluster. Ainsi, vous n'aurez pas à fermer et ouvrir à nouveau l'assistant de configuration.

Dans l'assistant "Création d'un cluster", sur la page Point d'accès :

- Nommez votre cluster "testcluster".

- Dans le champ Adresse, saisissez l'adresse IP que vous avez réservée précédemment (

10.0.0.8).

- Installez la fonctionnalité de clustering de basculement sur

Attribuer le rôle d'administrateur du cluster

En attribuant à un compte de domaine le rôle d'administrateur du cluster, vous pouvez réaliser plusieurs actions sur le cluster à partir d'outils tels que Windows PowerShell. Pour attribuer au compte de domaine cluster-admin le rôle d'administrateur de cluster, procédez comme suit :

- Sur le nœud de cluster qui héberge ses ressources, dans l'application "Gestionnaire du cluster de basculement", sélectionnez votre cluster dans le volet gauche, puis cliquez sur Propriétés dans le volet droit.

- Sélectionnez l'onglet Autorisations du cluster.

- Cliquez sur Ajouter, puis ajoutez

cluster-admin. - Après avoir sélectionné

cluster-admindans la liste Noms de groupes ou d'utilisateurs, sélectionnez Contrôle total dans le volet Autorisations. - Cliquez sur Appliquer, puis sur OK.

Nous vous proposons à présent de prendre des instantanés.

Créer le témoin de partage de fichiers

Vous avez à présent un cluster de basculement à deux nœuds, mais celui-ci utilise un mécanisme de vote pour choisir le nœud qui doit être actif. Pour atteindre le quorum fixé, vous pouvez ajouter un témoin de partage de fichiers.

Ce tutoriel ajoute simplement un dossier partagé au serveur du contrôleur de domaine. Si ce serveur passait en mode hors connexion au moment où l'un des nœuds du cluster redémarre, l'ensemble du cluster pourrait cesser de fonctionner, car le serveur restant ne peut pas voter seul. Dans le cadre de ce tutoriel, les fonctionnalités de l'infrastructure de GCP, telles que la migration à chaud et le redémarrage automatique, sont considérées comme suffisamment fiables pour maintenir le dossier partagé actif.

Si vous souhaitez créer un témoin de partage de fichiers avec une haute disponibilité plus importante, vous disposez des options suivantes :

- Utilisez un cluster des serveurs Windows pour partager les fichiers à l'aide des espaces de stockage direct. Cette fonctionnalité de Windows Server 2016 propose un partage à disponibilité élevée pour le témoin du quorum. Par exemple, vous pouvez créer un cluster pour votre contrôleur de domaine Active Directory afin de fournir des services de domaine à disponibilité élevée et le témoin de partage de fichiers en même temps.

- Utilisez un logiciel de réplication de données, tel que SIOS Datakeeper, avec le clustering de basculement Windows Server pour la réplication synchrone ou asynchrone.

Pour créer le partage de fichiers pour le témoin, procédez comme suit :

- Connectez-vous à

wsfc-dc. Ce serveur héberge le partage de fichiers. - Dans l'explorateur de fichiers, accédez au lecteur

C. - Dans la barre de titre, cliquez sur le bouton Nouveau dossier.

- Nommez le nouveau dossier

shares. - Double-cliquez sur le dossier

sharespour l'ouvrir. - Ajoutez un nouveau dossier et nommez-le

clusterwitness-testcluster.

Configurer le partage pour le témoin de partage de fichiers

Vous devez définir des autorisations sur le dossier du témoin de partage de fichiers pour permettre au cluster de l'utiliser.

- Dans l'explorateur de fichiers, faites un clic droit sur le dossier

clusterwitness-testcluster, puis sélectionnez Propriétés. - Sous l'onglet Partage, cliquez sur Partage avancé.

- Cochez la case Partager ce dossier.

- Cliquez sur Autorisations, puis sur Ajouter.

- Cliquez sur Types d'objets, sélectionnez Ordinateurs, puis cliquez sur OK.

- Ajoutez le compte d'ordinateur

testcluster$. - Attribuez les autorisations Contrôle total à

testcluster$. - Cliquez sur Appliquer, puis fermez toutes les boîtes de dialogue.

Ajouter le témoin de partage de fichiers au cluster de basculement

Configurez à présent le cluster de basculement pour utiliser le témoin de partage de fichiers en tant que vote du quorum. Pour ce faire, procédez comme suit :

- Sur l'ordinateur qui héberge les ressources du cluster (

wsfc-1), ouvrez l'application "Gestionnaire du cluster de basculement". - Dans le volet gauche, effectuez un clic droit sur le nom du cluster (testcluster.WSFC.TEST), passez votre souris sur Autres actions, puis cliquez sur Configurer les paramètres du quorum du cluster.

- Dans le panneau Sélectionner l'option de configuration du quorum, choisissez Sélectionner le témoin de quorum.

- Dans le panneau Sélectionner le témoin de quorum, choisissez Configurer un témoin de partage de fichiers.

- Dans le champ Chemin d'accès au partage de fichiers, saisissez le chemin d'accès au dossier partagé, tel que

\\wsfc-dc\clusterwitness-testcluster. - Confirmez les paramètres, puis cliquez sur Terminer.

Tester le cluster de basculement

Votre cluster de basculement Windows Server devrait maintenant fonctionner. Vous pouvez tester le cluster manuellement, en déplaçant ses ressources entre vos instances. Vous n'avez pas encore fini la procédure, mais le moment est bien choisi pour vérifier que tout ce que vous avez réalisé jusqu'à présent fonctionne correctement.

- Sur

wsfc-1, notez le nom du serveur hôte actuel dans l'application "Gestionnaire du cluster de basculement". - Exécutez Windows PowerShell en tant que

cluster-admin. Dans PowerShell, exécutez la commande suivante pour modifier le serveur hôte actuel :

Move-ClusterGroup -Name "Cluster Group"

Vous devriez voir la modification du nom du serveur hôte actuel apparaître pour l'autre VM.

Si ce n'est pas le cas, relisez les précédentes étapes pour voir si vous n'avez pas oublié quelque chose. Le problème le plus fréquemment rencontré est une règle de pare-feu manquante qui bloque l'accès au réseau. Pour en savoir plus sur les différents problèmes à vérifier, consultez la section Dépannage.

Si la modification du nom apparaît, vous pouvez alors passer à la configuration de l'équilibreur de charge interne, nécessaire pour acheminer le trafic réseau vers le serveur hôte actuel du cluster.

Nous vous proposons à présent de prendre des instantanés.

Ajouter un rôle au cluster de basculement

Dans la fonctionnalité de clustering de basculement Windows, les rôles hébergent des charges de travail en cluster. Vous pouvez utiliser un rôle pour indiquer l'adresse IP utilisée par votre application dans le cluster. Dans le cadre de ce tutoriel, vous ajoutez un rôle pour la charge de travail de test, qui est le serveur Web IIS (Internet Information Services), et vous attribuez une adresse IP à ce rôle.

Réserver une adresse IP au rôle dans Compute Engine

Pour éviter les conflits d'adressage IP au sein de votre sous-réseau dans Compute Engine, réservez l'adresse IP au rôle.

Ouvrez un terminal sur une VM hôte ou ouvrez Cloud Shell.

Réservez une adresse IP. Pour ce tutoriel, utilisez

10.0.0.9:gcloud compute addresses create load-balancer-ip --region [YOUR_REGION] --subnet wsfcnetsub1 --addresses 10.0.0.9

Pour confirmer la réservation de l'adresse IP :

gcloud compute addresses list

Ajouter le rôle

Procédez comme suit :

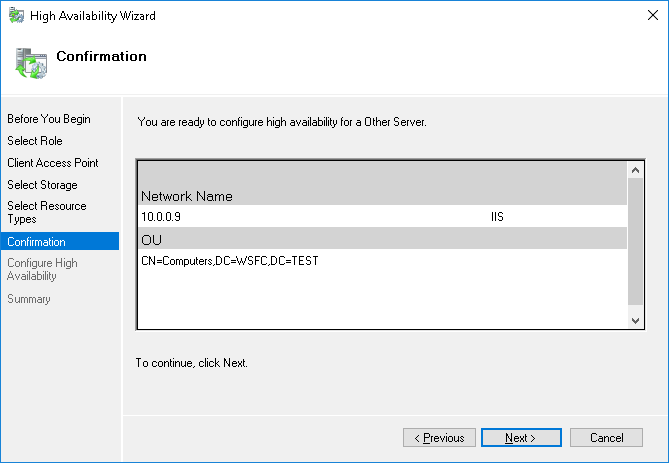

- Dans l'application "Gestionnaire du cluster de basculement", dans le volet Actions, sélectionnez Configurer un rôle.

- Sur la page Sélectionner un rôle, sélectionnez Autre serveur.

- Sur la page Point d'accès client, saisissez le nom

IIS. - Définissez l'adresse sur

10.0.0.9. - Ignorez les étapes Sélectionner le stockage et Sélectionner les types de ressources.

- Confirmez les paramètres, puis cliquez sur Terminer.

Créer l'équilibreur de charge interne

Créez et configurez l'équilibreur de charge interne, nécessaire pour acheminer le trafic réseau vers le nœud hôte actif du cluster. Vous allez utiliser la consoleGoogle Cloud , car l'interface utilisateur vous offre un bon aperçu de l'organisation de l'équilibrage de charge interne.

Vous allez également créer un groupe d'instances Compute Engine pour chaque zone du cluster, que l'équilibreur de charge utilise pour gérer les nœuds de cluster.

Créer les groupes d'instances

Créez un groupe d'instances dans chaque zone contenant un nœud de cluster, puis ajoutez chaque nœud au groupe d'instances de sa zone.

N'ajoutez pas le contrôleur de domaine wsfc-dc à un groupe d'instances.

Créez un groupe d'instances pour chaque zone du cluster, en remplaçant

[ZONE_1]par le nom de votre première zone et[ZONE_2]par le nom de votre deuxième zone :gcloud compute instance-groups unmanaged create wsfc-group-1 --zone=[ZONE_1]

gcloud compute instance-groups unmanaged create wsfc-group-2 --zone=[ZONE_2]

Ajoutez le serveur de chaque zone au groupe d'instances de cette zone :

gcloud compute instance-groups unmanaged add-instances wsfc-group-1 --instances wsfc-1 --zone [ZONE_1]

gcloud compute instance-groups unmanaged add-instances wsfc-group-2 --instances wsfc-2 --zone [ZONE_2]

Confirmez que vos groupes d'instances ont été créés et que chaque groupe contient une instance :

gcloud compute instance-groups unmanaged list

NAME ZONE NETWORK NETWORK_PROJECT MANAGED INSTANCES wsfc-group-1 us-central1-a wsfcnet exampleproject No 1 wsfc-group-2 us-central1-b wsfcnet exampleproject No 1

Créer l'équilibreur de charge

Démarrer la configuration

Dans la console Google Cloud , accédez à la page Équilibrage de charge.

- Cliquez sur Créer un équilibreur de charge.

- Sous Type d'équilibreur de charge, sélectionnez Équilibreur de charge réseau (TCP/UDP/SSL), puis cliquez sur Suivant.

- Pour Proxy ou passthrough, sélectionnez Équilibreur de charge passthrough, puis cliquez sur Suivant.

- Pour Public ou interne, sélectionnez Interne, puis cliquez sur Suivant.

- Cliquez sur Configurer.

Configuration de base

- Dans le champ Nom, saisissez "wsfc-lb".

- Sélectionnez votre région actuelle.

- Sélectionnez

wsfcnetpour Réseau.

Configurer le backend

Rappelez-vous que l'équilibreur de charge interne de GCP utilise, de façon périodique, une fonctionnalité de vérification de l'état pour déterminer le nœud actif. Le processus de vérification de l'état pingue l'agent hôte du cluster Compute Engine en cours d'exécution sur le nœud de cluster actif. La charge utile de la vérification de l'état correspond à l'adresse IP de l'application, représentée par le rôle en cluster. L'agent renvoie une valeur de 1 si le nœud est actif, ou de 0 s'il est inactif.

- Cliquez sur Configuration du backend.

- Sous Backends, ajoutez chaque groupe d'instances que vous avez créé. Pour ce faire, sélectionnez son nom, puis cliquez sur OK.

Créez une vérification d'état.

- Dans le champ Nom, saisissez "wsfc-hc".

- Pour Protocole, conservez le paramètre TCP par défaut, puis remplacez le contenu du champ Port par "59998" pour les réponses de l'agent hôte du cluster.

- Dans le champ Requête, saisissez "10.0.0.9".

- Dans le champ Réponse, saisissez "1".

- Dans le champ Intervalle entre deux tests, saisissez "2".

- Dans le champ Délai avant expiration, saisissez "1".

- Cliquez sur Enregistrer et continuer.

Configurer l'interface

La configuration de l'interface crée une règle de transfert qui définit la manière dont l'équilibreur de charge gère les requêtes entrantes. Pour simplifier ce tutoriel, vous allez tester le système en exécutant des requêtes entre les VM du sous-réseau.

Dans votre système de production, vous souhaiterez probablement ouvrir le système au trafic externe, tel que le trafic Internet. Pour ce faire, vous pourrez créer un hôte bastion qui accepte le trafic externe et le transmet à votre réseau interne. L'utilisation d'un hôte bastion n'est pas traitée dans ce tutoriel.

- Dans le volet central, cliquez sur Configuration de l'interface.

- Dans le champ Nom, saisissez "wsfc-lb-fe".

- Sélectionnez votre sous-réseau (

wsfcnetsub1). - Dans le champ Adresse IP interne, sélectionnez load-balancer-ip (10.0.0.9). Il s'agit de la même adresse IP que celle que vous avez définie pour le rôle.

- Dans le champ Ports, saisissez "80".

- Cliquez sur OK.

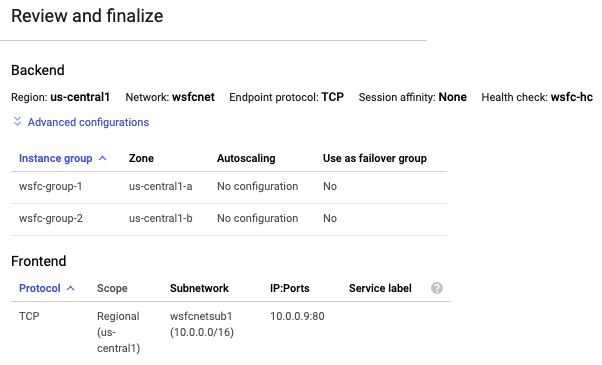

Vérifier et finaliser

- Dans le volet central, cliquez sur Vérification et finalisation pour afficher un résumé des paramètres de l'équilibreur de charge interne. Le résumé s'affiche dans le volet de droite.

Cliquez sur Créer. La création de l'équilibreur de charge peut prendre quelques instants.

Créer des règles de pare-feu pour la vérification de l'état

Vous avez peut-être noté que la console Google Cloud vous a averti que le système de vérification d'état nécessitait une règle de pare-feu pour que les vérifications d'état puissent atteindre leurs cibles. Dans cette section, vous allez définir cette règle de pare-feu.

Dans la console Google Cloud , accédez à Cloud Shell.

Exécutez la commande suivante pour créer la règle de pare-feu :

gcloud compute firewall-rules create allow-health-check --network wsfcnet --source-ranges 130.211.0.0/22,35.191.0.0/16 --allow tcp:59998

Ouvrir le pare-feu Windows

Sur chaque nœud de cluster (wsfc-1 et wsfc-2), créez une règle de pare-feu dans le pare-feu Windows pour permettre à l'équilibreur de charge d'accéder à chaque système Windows.

Ouvrez l'application "Pare-feu Windows avec fonctions avancées de sécurité".

Dans le volet de navigation de gauche, sélectionnez Règles de trafic entrant.

Dans le volet de navigation de droite, sélectionnez Nouvelle règle.

Dans le panneau Type de règle, sélectionnez Personnalisée comme type de règle, puis cliquez sur Suivant.

Dans le panneau Programme, acceptez la valeur par défaut et cliquez sur Suivant.

Dans le panneau Protocole et ports :

- Dans le champ Type de protocole, sélectionnez TCP.

- Dans le champ Port local, sélectionnez Ports spécifiques et saisissez

59998.

Dans le panneau Champ d'application, sous À quelles adresses IP distantes cette règle s'applique-t-elle ? :

- Sélectionnez Ces adresses IP.

Ajoutez chacune des adresses IP suivantes au champ Cette adresse IP ou ce sous-réseau en cliquant sur Ajouter :

130.211.0.0/2235.191.0.0/16

Cliquez sur Suivant.

Dans le panneau Action, acceptez Autoriser la connexion, puis cliquez sur Suivant.

Dans le panneau Profil, acceptez les valeurs par défaut, puis cliquez sur Suivant.

Spécifiez un nom pour la règle de pare-feu, puis cliquez sur Terminer.

Valider l'équilibreur de charge

Une fois votre équilibreur de charge interne en cours d'exécution, vous pouvez inspecter son état pour vérifier qu'il peut trouver une instance saine, puis tester à nouveau le basculement.

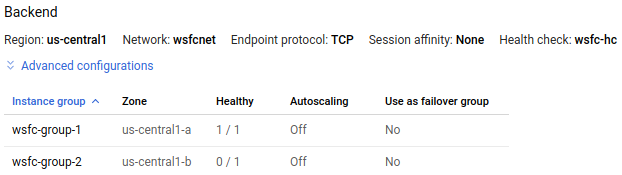

Dans la console Google Cloud , accédez à la page Équilibrage de charge.

Cliquez sur le nom de l'équilibreur de charge (

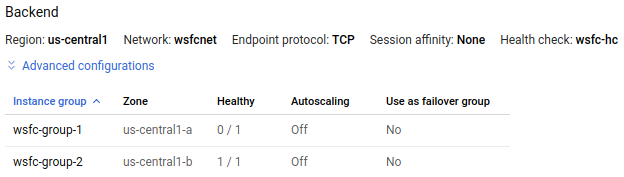

wsfc-lb).Dans la section Backend du résumé, les groupes d'instances doivent être répertoriés.

Dans l'image suivante de la page de détails de l'équilibreur de charge

wsfc-lb, le groupe d'instanceswsfc-group-1contient le nœud actif, comme indiqué par 1 / 1 dans la colonne Opérationnel. Le groupe d'instanceswsfc-group-2contient le nœud inactif, comme indiqué par 0 / 1.

Si les deux groupes d'instances affichent 0 / 1, il est possible que la synchronisation de l'équilibreur de charge avec les nœuds soit toujours en cours. Parfois, vous devez effectuer au moins une action de basculement pour que l'équilibreur de charge trouve l'adresse IP.

Dans l'application "Gestionnaire du cluster de basculement", développez le nom du cluster et cliquez sur Rôles. Dans la colonne Nœud propriétaire, notez le nom du serveur pour le rôle IIS.

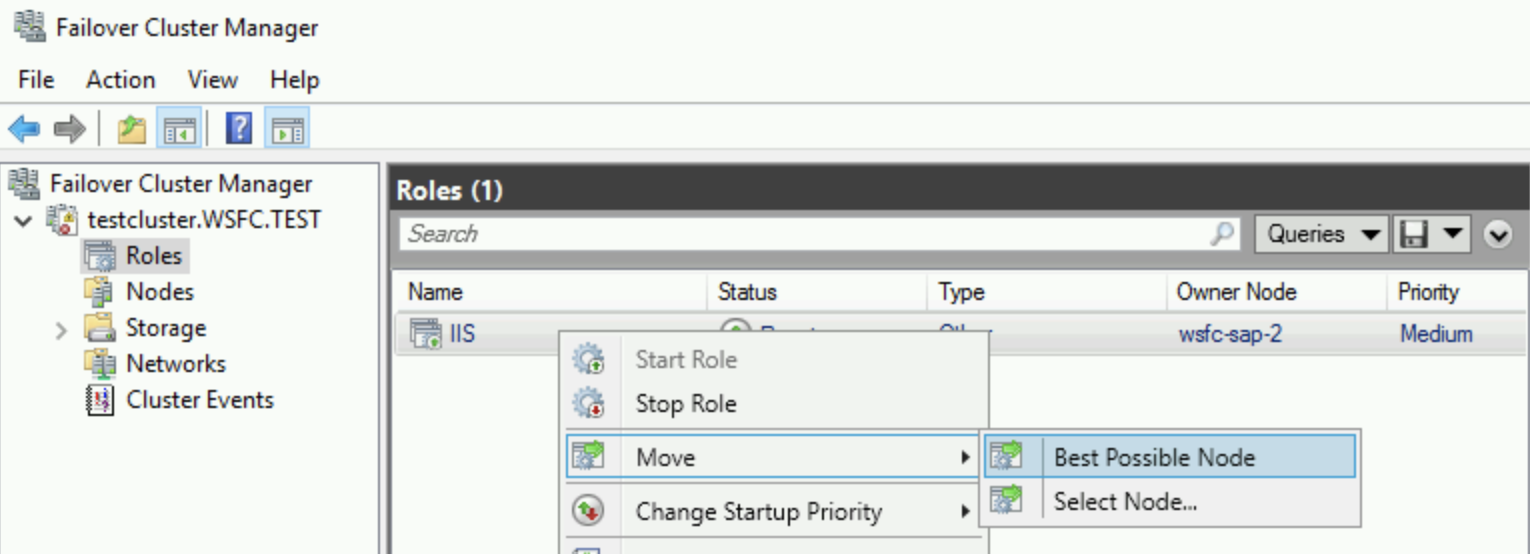

Démarrez un basculement en effectuant un clic droit sur le rôle IIS, puis en sélectionnant Déplacer > Meilleur nœud possible. Cette action déplace le rôle vers l'autre nœud, comme indiqué dans la colonne Nœud propriétaire.

Patientez jusqu'à ce que le champ État indique En cours d'exécution.

Revenez à la page Détails de l'équilibreur de charge, cliquez sur Actualiser, et vérifiez que les valeurs 1 / 1 et 0 / 1 dans la colonne Healthy (Opérationnel) ont interverti les groupes d'instances.

gcloud compute backend-services get-health wsfc-lb --region=[REGION]

La sortie ressemble à ceci :

backend: https://compute.googleapis.com/compute/v1/projects/exampleproject/zones/us-central1-a/instanceGroups/wsfc-group-1

status:

healthStatus:

- healthState: HEALTHY

instance: https://compute.googleapis.com/compute/v1/projects/exampleproject/zones/us-central1-a/instances/wsfc-1

ipAddress: 10.0.0.4

port: 80

kind: compute#backendServiceGroupHealth

---

backend: https://compute.googleapis.com/compute/v1/projects/exampleproject/zones/us-central1-b/instanceGroups/wsfc-group-2

status:

healthStatus:

- healthState: UNHEALTHY

instance: https://compute.googleapis.com/compute/v1/projects/exampleproject/zones/us-central1-b/instances/wsfc-2

ipAddress: 10.0.0.5

port: 80

kind: compute#backendServiceGroupHealthInstaller votre application

Maintenant que vous avez un cluster, vous pouvez configurer votre application sur chaque nœud, pour qu'elle s'exécute dans un environnement en cluster.

Dans le cadre de ce tutoriel, vous devrez configurer un élément prouvant que le cluster fonctionne réellement avec l'équilibreur de charge interne. Configurez IIS sur chaque VM pour publier une page Web simple.

Vous ne configurez pas IIS pour la HD (haute disponibilité) dans le cluster. Vous devez créer des instances IIS distinctes qui publient chacune une page Web différente. Après un basculement, le serveur Web publie son propre contenu et non du contenu partagé.

Configurer votre application ou IIS pour la HD sort du champ d'application de ce tutoriel.

Configurer IIS

Sur chaque nœud de cluster, installez IIS.

- Sur la page Sélectionner des services de rôle, assurez-vous que Document par défaut est sélectionné sous Fonctionnalités HTTP communes.

- Sur la page Confirmation, cochez la case autorisant le redémarrage automatique du serveur de destination.

Vérifiez le fonctionnement de chaque serveur Web.

- Utilisez le protocole RDP pour vous connecter à la VM nommée

wsfc-dc. - Dans le Gestionnaire de serveur, cliquez sur Serveur local dans le volet de navigation situé dans la partie gauche de la fenêtre.

- Dans la section Propriétés située en haut de l'écran, désactivez Configuration de sécurité renforcée d'Internet Explorer.

- Ouvrez Internet Explorer.

Accédez à l'adresse IP de chaque serveur :

http://10.0.0.4/

http://10.0.0.5/

- Utilisez le protocole RDP pour vous connecter à la VM nommée

Pour chaque cas, la page Accueil, page Web par défaut d'IIS, s'affiche.

Modifier les pages Web par défaut

En modifiant chaque page Web par défaut, vous pourrez facilement identifier le serveur qui publie chaque page.

- Utilisez le protocole RDP pour vous connecter à la VM nommée

wsfc-1. - Exécutez l'application "Bloc-notes" en tant qu'administrateur.

- Ouvrez

C:\inetpub\wwwroot\iisstart.htmdans "Bloc-notes". N'oubliez pas de sélectionner l'option Tous les fichiers, pour ne pas afficher uniquement les fichiers texte. Dans l'élément

<title>, remplacez le texte par le nom du serveur actuel. Exemple :<title>wsfc-1</title>Enregistrez le fichier HTML.

Répétez ces étapes pour

wsfc-2, en définissant l'élément<title>surwsfc-2.

Désormais, lorsque vous affichez une page Web publiée par l'un de ces serveurs, le nom du serveur apparaît en tant que titre dans l'onglet Internet Explorer.

Tester le basculement

- Utilisez le protocole RDP pour vous connecter à la VM nommée

wsfc-dc. - Ouvrez Internet Explorer.

Accédez à l'adresse IP du rôle d'équilibreur de charge :

http://10.0.0.9/La page Accueil s'affiche avec le nom du serveur actuel en tant que titre de l'onglet.

Arrêtez le serveur actuel pour simuler une défaillance. Pour ce faire, dans Cloud Shell, exécutez la commande suivante, en remplaçant

[INSTANCE_NAME]par le nom du serveur actuel que vous avez vu à l'étape précédente, tel quewsfc-1:gcloud compute instances stop [INSTANCE_NAME] --zone=[ACTIVE_ZONE]Basculez sur votre connexion RDP pour

wsfc-dc.La détection de l'équilibreur de charge et le réacheminement du trafic peuvent prendre quelques instants.

Après environ 30 secondes, actualisez la page dans Internet Explorer.

Vous devriez à présent voir s'afficher le nom du nouveau nœud actif en tant que titre de l'onglet. Par exemple, si vous avez commencé avec

wsfc-1actif, vous devriez maintenant voir s'afficherwsfc-2en tant que titre. Si vous ne constatez pas immédiatement la modification ou si une erreur indiquant que la page est introuvable s'affiche, actualisez le navigateur.

Félicitations ! Vous disposez à présent d'un cluster de basculement Windows Server 2016 actif qui s'exécute sur GCP.

Dépannage

Voici quelques problèmes fréquemment rencontrés et les solutions proposées que vous pouvez consulter si certaines étapes ne fonctionnent pas.

Blocages du processus de vérification de l'état causés par les règles de pare-feu GCP

Si la vérification de l'état ne fonctionne pas, vérifiez que vous disposez bien d'une règle de pare-feu autorisant le trafic entrant à partir des adresses IP utilisées par le système de vérification de l'état : 130.211.0.0/22 et 35.191.0.0/16.

Blocages du processus de vérification de l'état causés par le pare-feu Windows

Dans le pare-feu Windows, vérifiez que le port 59998 est bien ouvert sur chaque nœud de cluster. Consultez la section Ouvrir le pare-feu Windows.

Nœuds en cluster utilisant le protocole DHCP

Il est important que chaque VM du cluster dispose d'une adresse IP statique. Si une VM est configurée pour utiliser DHCP sous Windows, modifiez les paramètres réseau dans Windows pour que l'adresse IPv4 corresponde à l'adresse IP de la VM indiquée dans la console Google Cloud . Définissez également l'adresse IP de la passerelle pour qu'elle corresponde à l'adresse de la passerelle du sous-réseau dans le réseau VPC de GCP.

Tags réseau de GCP dans les règles de pare-feu

Si vous utilisez des tags réseau dans vos règles de pare-feu, vérifiez qu'ils sont correctement définis sur chaque instance de VM. Ce tutoriel n'utilise pas de tags. Toutefois, si vous les définissez dans un autre cadre, ils doivent être utilisés de manière cohérente.