ネットワーク帯域幅が大きいほど、GPU インスタンスのパフォーマンスが向上し、Compute Engine で実行される分散ワークロードをサポートできます。

Compute Engine で GPU が接続されたインスタンスで使用可能な最大ネットワーク帯域幅は次のとおりです。

- A3 アクセラレータ最適化インスタンスの場合、最大 3,600 Gbps の最大ネットワーク帯域幅を使用できます。

- A2 および G2 アクセラレータ最適化インスタンスでは、マシンタイプに応じて最大 100 Gbps の最大ネットワーク帯域幅を使用できます。

- P100、P4 GPU が接続された N1 汎用インスタンスの場合、32 Gbps の最大ネットワーク帯域幅を使用できます。これは、GPU が接続されていない N1 インスタンスで使用できる最大レートと類似しています。ネットワーク帯域幅についての詳細は、下り(外向き)最大データ通信速度を参照してください。

- T4 および V100 GPU が接続された N1 汎用インスタンスの場合、GPU と vCPU 数の組み合わせに基づいて、最大 100 Gbps の最大ネットワーク帯域幅を使用できます。

ネットワーク帯域幅と NIC の配置を確認する

次のセクションでは、各 GPU マシンタイプのネットワークの手配と帯域幅速度を確認します。

A3 Ultra マシンタイプ

A3 Ultra マシンタイプには H200 GPU がアタッチされており、A3 マシンシリーズで最も高いネットワーク パフォーマンスを提供します。

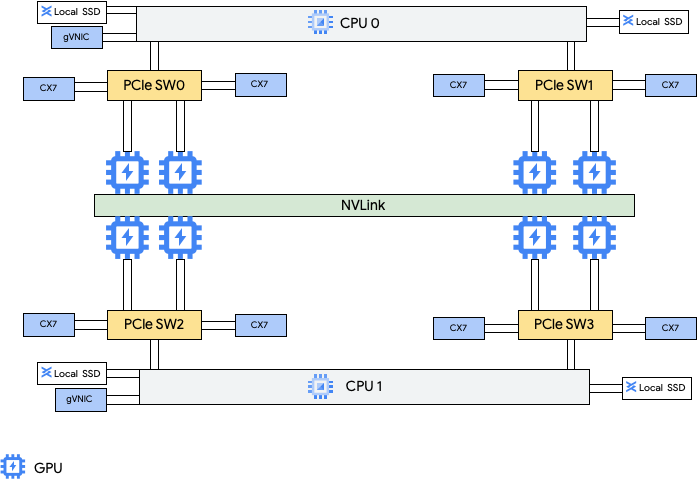

このマシンタイプには、8 つの NVIDIA ConnectX-7(CX7)ネットワーク インターフェース カード(NIC)と 2 つの Google Virtual NIC(gVNIC)が用意されています。8 つの CX7 NIC は、合計 3,200 Gbps のネットワーク帯域幅を提供します。これらの NIC は、高帯域幅の GPU 間通信専用であり、パブリック インターネット アクセスなどの他のネットワーキングのニーズには使用できません。次の図に示すように、各 CX7 NIC は 1 つの NVIDIA H200 141 GB GPU と協調し、不均一メモリアクセス(NUMA)を最適化します。8 つの GPU はすべて、それらを接続するオールツーオール NVLink ブリッジを使用して相互に高速に通信できます。他の 2 つの gVNIC ネットワーク インターフェース カードはスマート NIC で、汎用ネットワーキング要件に 400 Gbps のネットワーク帯域幅を追加し、これらのマシンに合計 3,600 Gbps の最大ネットワーク帯域幅を提供します。

これらの複数の NIC を使用するには、次のように 3 つの Virtual Private Cloud ネットワークを作成する必要があります。

- 2 つの Virtual Private Cloud ネットワーク: 各 gVNIC に独自の VPC ネットワークがあります

- RDMA 用の 1 つの Virtual Private Cloud ネットワーク: 8 つの CX7 NIC すべてが同じ VPC ネットワークを共有します。

これらのネットワークを設定するには、AI Hypercomputer のドキュメントの VPC ネットワークを作成するをご覧ください。

| マシンタイプ | GPU 数 | GPU メモリ* (GB HBM3e) |

vCPU 数† | VM メモリ(GB) | アタッチされたローカル SSD(GiB) | 物理 NIC の数 | 最大ネットワーク帯域幅(Gbps)‡ |

|---|---|---|---|---|---|---|---|

a3-ultragpu-8g |

8 | 1128 | 224 | 2,952 | 12,000 | 10 | 3,600 |

*GPU メモリは GPU デバイスのメモリで、データの一時的な保存に使用できます。これは VM のメモリとは別に存在し、グラフィックを多用するワークロードでの帯域幅の高い需要に対応するように設計されています。

†vCPU は、利用可能な CPU プラットフォームのいずれかで単一のハードウェア ハイパースレッドとして実装されます。

‡ 最大下り(外向き)帯域幅は許容数を超えることはできません。実際の下り(外向き)帯域幅は、宛先 IP アドレスやその他の要因によって異なります。ネットワーク帯域幅をご覧ください。

A3 Mega、High、Edge マシンタイプ

これらのマシンタイプには、H100 80 GB GPU がアタッチされています。これらのマシンタイプには、固定の GPU 数、vCPU 数、メモリサイズが設定されています。

- 単一 NIC A3 VM: 1~4 個の GPU がアタッチされている A3 VM では、単一の物理ネットワーク インターフェース カード(NIC)のみを使用できます。

- マルチ NIC A3 VM: 8 個の GPU がアタッチされている A3 VM では、複数の物理 NIC を使用できます。これらの A3 マシンタイプでは、NIC が Peripheral Component Interconnect Express(PCIe)バス上で次のように配置されます。

- A3 Mega マシンタイプ: NIC を 8+1 で配置できます。この構成では、8 つの NIC が同じ PCIe バスを共有し、1 つの NIC が別の PCIe バス上に配置されます。

- A3 High マシンタイプ: NIC を 4+1 で配置できます。この構成では、4 つの NIC が同じ PCIe バスを共有し、1 つの NIC が別の PCIe バス上に配置されます。

- マシンタイプが A3 Edge マシンタイプの場合: NIC を 4+1 で配置できます。この構成では、4 つの NIC が同じ PCIe バスを共有し、1 つの NIC が別の PCIe バス上に配置されます。これらの 5 つの NIC は、VM ごとに合計 400 Gbps のネットワーク帯域幅を提供します。

同じ PCIe バスを共有する NIC のそれぞれに対し、2 つの NVIDIA H100 80 GB GPU の不均一メモリアクセス(NUMA)アライメントが使用されます。これらの NIC は、専用の高帯域幅 GPU 間通信に最適です。他のネットワーク要件には、別の PCIe バス上にある物理 NIC で適切に対応できます。A3 High VM と A3 Edge VM のネットワーキングを設定する方法については、ジャンボ フレーム MTU ネットワークを設定するをご覧ください。

A3 Mega

| マシンタイプ | GPU 数 | GPU メモリ* (GB HBM3) |

vCPU 数† | VM メモリ(GB) | アタッチされたローカル SSD(GiB) | 物理 NIC の数 | 最大ネットワーク帯域幅(Gbps)‡ |

|---|---|---|---|---|---|---|---|

a3-megagpu-8g |

8 | 640 | 208 | 1,872 | 6,000 | 9 | 1,800 |

A3 High

| マシンタイプ | GPU 数 | GPU メモリ* (GB HBM3) |

vCPU 数† | VM メモリ(GB) | アタッチされたローカル SSD(GiB) | 物理 NIC の数 | 最大ネットワーク帯域幅(Gbps)‡ |

|---|---|---|---|---|---|---|---|

a3-highgpu-1g |

1 | 80 | 26 | 234 | 750 | 1 | 25 |

a3-highgpu-2g |

2 | 160 | 52 | 468 | 1,500 | 1 | 50 |

a3-highgpu-4g |

4 | 320 | 104 | 936 | 3,000 | 1 | 100 |

a3-highgpu-8g |

8 | 640 | 208 | 1,872 | 6,000 | 5 | 1,000 |

A3 Edge

| マシンタイプ | GPU 数 | GPU メモリ* (GB HBM3) |

vCPU 数† | VM メモリ(GB) | アタッチされたローカル SSD(GiB) | 物理 NIC の数 | 最大ネットワーク帯域幅(Gbps)‡ |

|---|---|---|---|---|---|---|---|

a3-edgegpu-8g |

8 | 640 | 208 | 1,872 | 6,000 | 5 |

|

*GPU メモリは GPU デバイスのメモリで、データの一時的な保存に使用できます。これは VM のメモリとは別に存在し、グラフィックを多用するワークロードでの帯域幅の高い需要に対応するように設計されています。

†vCPU は、利用可能な CPU プラットフォームのいずれかで単一のハードウェア ハイパースレッドとして実装されます。

‡ 最大下り(外向き)帯域幅は許容数を超えることはできません。実際の下り(外向き)帯域幅は、宛先 IP アドレスやその他の要因によって異なります。ネットワーク帯域幅をご覧ください。

A2 マシンタイプ

各 A2 マシンタイプには、一定数の NVIDIA A100 40 GB または NVIDIA A100 80 GB GPU が接続されています。各マシンタイプには、一定の数の vCPU と一定のサイズのメモリも搭載されます。

A2 マシンシリーズは次の 2 つのタイプで用意されています。

- A2 Ultra: A100 80 GB GPU とローカル SSD ディスクがアタッチされるマシンタイプです。

- A2 Standard: A100 40 GB GPU がアタッチされるマシンタイプです。

A2 Ultra

| マシンタイプ | GPU 数 | GPU メモリ* (GB HBM3) |

vCPU 数† | VM メモリ(GB) | アタッチされたローカル SSD(GiB) | 最大ネットワーク帯域幅(Gbps)‡ |

|---|---|---|---|---|---|---|

a2-ultragpu-1g |

1 | 80 | 12 | 170 | 375 | 24 |

a2-ultragpu-2g |

2 | 160 | 24 | 340 | 750 | 32 |

a2-ultragpu-4g |

4 | 320 | 48 | 680 | 1,500 | 50 |

a2-ultragpu-8g |

8 | 640 | 96 | 1,360 | 3,000 | 100 |

A2 標準

| マシンタイプ | GPU 数 | GPU メモリ* (GB HBM3) |

vCPU 数† | VM メモリ(GB) | アタッチされたローカル SSD(GiB) | 最大ネットワーク帯域幅(Gbps)‡ |

|---|---|---|---|---|---|---|

a2-highgpu-1g |

1 | 40 | 12 | 85 | はい | 24 |

a2-highgpu-2g |

2 | 80 | 24 | 170 | はい | 32 |

a2-highgpu-4g |

4 | 160 | 48 | 340 | はい | 50 |

a2-highgpu-8g |

8 | 320 | 96 | 680 | はい | 100 |

a2-megagpu-16g |

16 | 640 | 96 | 1,360 | はい | 100 |

*GPU メモリは GPU デバイスのメモリで、データの一時的な保存に使用できます。これは VM のメモリとは別に存在し、グラフィックを多用するワークロードでの帯域幅の高い需要に対応するように設計されています。

†vCPU は、利用可能な CPU プラットフォームのいずれかで単一のハードウェア ハイパースレッドとして実装されます。

‡ 最大下り(外向き)帯域幅は許容数を超えることはできません。実際の下り(外向き)帯域幅は、宛先 IP アドレスやその他の要因によって異なります。ネットワーク帯域幅をご覧ください。

G2 マシンタイプ

各 G2 マシンタイプには、固定数の NVIDIA L4 GPU と vCPU がアタッチされます。各 G2 マシンタイプにはデフォルトのメモリとカスタムメモリ範囲もあります。カスタムメモリ範囲はマシンタイプごとに VM に割り当てることができるメモリの量を定義します。カスタムメモリは VM の作成時に指定できます。

ほとんどの GPU インスタンスに高いネットワーク帯域幅レート(50 Gbps 以上)を適用するには、Google Virtual NIC(gVNIC)の使用をおすすめします。gVNIC を使用する GPU インスタンスの作成の詳細については、高い帯域幅を使用する GPU インスタスの作成をご覧ください。

| マシンタイプ | GPU 数 | GPU メモリ*(GB GDDR6) | vCPU 数† | デフォルトの VM メモリ(GB) | カスタム VM メモリ範囲(GB) | サポート対象の最大ローカル SSD(GiB) | 最大ネットワーク帯域幅(Gbps)‡ |

|---|---|---|---|---|---|---|---|

g2-standard-4 |

1 | 24 | 4 | 16 | 16~32 | 375 | 10 |

g2-standard-8 |

1 | 24 | 8 | 32 | 32~54 | 375 | 16 |

g2-standard-12 |

1 | 24 | 12 | 48 | 48~54 | 375 | 16 |

g2-standard-16 |

1 | 24 | 16 | 64 | 54~64 | 375 | 32 |

g2-standard-24 |

2 | 48 | 24 | 96 | 96~108 | 750 | 32 |

g2-standard-32 |

1 | 24 | 32 | 128 | 96~128 | 375 | 32 |

g2-standard-48 |

4 | 96 | 48 | 192 | 192~216 | 1,500 | 50 |

g2-standard-96 |

8 | 192 | 96 | 384 | 384~432 | 3,000 | 100 |

*GPU メモリは GPU デバイスのメモリで、データの一時的な保存に使用できます。これは VM のメモリとは別に存在し、グラフィックを多用するワークロードでの帯域幅の高い需要に対応するように設計されています。

†vCPU は、利用可能な CPU プラットフォームのいずれかで単一のハードウェア ハイパースレッドとして実装されます。

‡ 最大下り(外向き)帯域幅は許容数を超えることはできません。実際の下り(外向き)帯域幅は、宛先 IP アドレスやその他の要因によって異なります。ネットワーク帯域幅をご覧ください。

N1 + GPU マシンタイプ

T4 および V100 GPU が接続された N1 汎用インスタンスの場合、GPU と vCPU 数の組み合わせに基づいて、最大 100 Gbps の最大ネットワーク帯域幅を使用できます。他のすべての N1 GPU インスタンスについては、概要をご覧ください。

GPU モデル、vCPU、GPU 数に基づいて、T4 VM と V100 インスタンスで使用可能な最大ネットワーク帯域幅を計算するには、次のセクションを確認してください。

vCPU が 5 個以下の場合

vCPU が 5 個以下の T4 および V100 インスタンスの場合、最大 10 Gbps のネットワーク帯域幅を使用できます。

vCPU が 5 個より多い場合

vCPU が 5 個より多い T4 インスタンスおよび V100 VM の場合、最大ネットワーク帯域幅はその VM の vCPU と GPU 数に基づいて計算されます。

ほとんどの GPU インスタンスに高いネットワーク帯域幅レート(50 Gbps 以上)を適用するには、Google Virtual NIC(gVNIC)の使用をおすすめします。gVNIC を使用する GPU インスタンスの作成の詳細については、高い帯域幅を使用する GPU インスタスの作成をご覧ください。

| GPU モデル | GPU の数 | 最大ネットワーク帯域幅の計算 |

|---|---|---|

| NVIDIA V100 | 1 | min(vcpu_count * 2, 32) |

| 2 | min(vcpu_count * 2, 32) |

|

| 4 | min(vcpu_count * 2, 50) |

|

| 8 | min(vcpu_count * 2, 100) |

|

| NVIDIA T4 | 1 | min(vcpu_count * 2, 32) |

| 2 | min(vcpu_count * 2, 50) |

|

| 4 | min(vcpu_count * 2, 100) |

高帯域幅マシンを作成する

- 高いネットワーク帯域幅を使用する A2、G2、N1 インスタンスを作成するには、高いネットワーク帯域幅を使用するをご覧ください。これらのマシンの帯域幅速度をテストまたは検証するには、ベンチマーク テストを使用します。詳細については、ネットワーク帯域幅の確認をご覧ください。

- A3 以降のインスタンスに高帯域幅のインスタンスを構成するには、以下を確認してください。

- A3 Ultra インスタンスについては、AI Hypercomputer のドキュメントの A3 Ultra インスタンスを作成するをご覧ください。

- A3 Mega インスタンスの場合は、ML トレーニング用に A3 Mega Slurm クラスタをデプロイするをご覧ください。

- A3 High インスタンスの場合は、GPUDirect-TCPX を有効にして A3 VM を作成するをご覧ください。

次のステップ

- GPU プラットフォームの詳細を学習する。

- GPU が接続されたインスタンスを作成する方法を学習する。

- 詳しくは、より高いネットワーク帯域幅を使用するをご覧ください。

- GPU の料金について学習する。