Gestisci trasferimenti

Questo documento mostra come gestire le configurazioni di trasferimento dei dati esistenti.

Puoi anche attivare manualmente un trasferimento esistente, noto anche come avvio di un'esecuzione di backfill.

Visualizzare i trasferimenti

Visualizza le configurazioni di trasferimento esistenti visualizzando le informazioni su ogni trasferimento, elencando tutti i trasferimenti esistenti e visualizzando la cronologia o i messaggi di log delle esecuzioni dei trasferimenti.

Ruoli obbligatori

Per ottenere le autorizzazioni necessarie per visualizzare i dettagli del trasferimento, chiedi all'amministratore di concederti il ruolo IAM Utente BigQuery (roles/bigquery.user) nel progetto.

Per saperne di più sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.

Potresti anche riuscire a ottenere le autorizzazioni richieste tramite i ruoli personalizzati o altri ruoli predefiniti.

Inoltre, per visualizzare i messaggi di log tramite la console Google Cloud , devi disporre delle autorizzazioni per visualizzare i dati di Cloud Logging. Il ruolo Visualizzatore log

(roles/logging.viewer) ti consente di accedere in sola lettura a tutte le funzionalità di

Logging. Per saperne di più sui ruoli e sulle autorizzazioni di Identity and Access Management (IAM)

che si applicano ai dati dei log cloud, consulta la guida al controllo dell'accesso di Cloud Logging.

Per saperne di più sui ruoli IAM in BigQuery Data Transfer Service, consulta Controllo dell'accesso.

Visualizzare i dettagli del trasferimento

Dopo aver creato un trasferimento, puoi ottenere informazioni sulla sua configurazione. La configurazione include i valori forniti durante la creazione del trasferimento, nonché altre informazioni importanti, come i nomi delle risorse.

Per ottenere informazioni su una configurazione di trasferimento:

Console

Vai alla pagina Trasferimenti di dati.

Seleziona il trasferimento di cui vuoi visualizzare i dettagli.

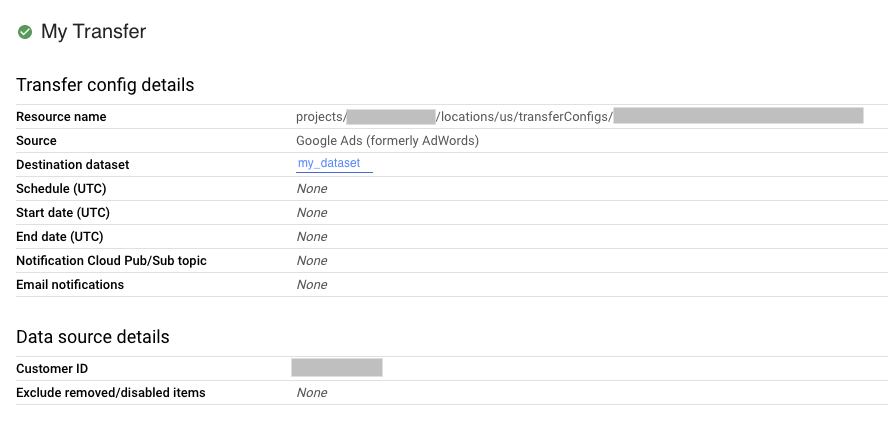

Per visualizzare la configurazione del trasferimento e i dettagli dell'origine dati, fai clic su Configurazione nella pagina Dettagli trasferimento. L'esempio seguente mostra le proprietà di configurazione per un trasferimento Google Ads:

bq

Inserisci il comando bq show e fornisci il nome della risorsa della configurazione di trasferimento. Il flag --format può essere utilizzato per controllare il formato di output.

bq show \

--format=prettyjson \

--transfer_config resource_name

Sostituisci resource_name con il nome della risorsa di trasferimento (detta anche configurazione di trasferimento). Se non conosci

il nome risorsa del trasferimento, trovalo con:

bq ls --transfer_config --transfer_location=location.

Ad esempio, inserisci il seguente comando per visualizzare la configurazione del trasferimento

per

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7.

bq show \

--format=prettyjson \

--transfer_config projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

API

Utilizza il metodo projects.locations.transferConfigs.get e fornisci la configurazione del trasferimento utilizzando il parametro name.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Elenca configurazioni di trasferimento

Per elencare tutte le configurazioni di trasferimento esistenti in un progetto:

Console

Nella console Google Cloud , vai alla pagina Trasferimenti dati.

Se nel progetto sono presenti configurazioni di trasferimento, nell'elenco dei trasferimenti di dati viene visualizzato un elenco delle configurazioni di trasferimento.

bq

Per elencare tutte le configurazioni di trasferimento per un progetto in base alla località, inserisci il comando bq ls e fornisci i flag --transfer_location e --transfer_config. Puoi anche fornire il flag --project_id per specificare un progetto

particolare. Se --project_id non è specificato, viene utilizzato il progetto predefinito.

Il flag --format può essere utilizzato per controllare il formato di output.

Per elencare le configurazioni di trasferimento per origini dati specifiche, fornisci il

flag --filter.

Per visualizzare un determinato numero di configurazioni di trasferimento in formato paginato, fornisci il flag --max_results per specificare il numero di trasferimenti. Il comando restituisce un token di pagina che fornisci utilizzando il flag --page_token per visualizzare le successive n configurazioni. Se --max_results viene omesso, verranno restituite 1000 configurazioni e --max_results non accetterà valori superiori a 1000. Se il tuo progetto

ha più di 1000 configurazioni, utilizza --max_results e --page_token per

scorrere tutte le configurazioni.

bq ls \ --transfer_config \ --transfer_location=location \ --project_id=project_id \ --max_results=integer \ --filter=dataSourceIds:data_sources

Sostituisci quanto segue:

locationè la posizione delle configurazioni di trasferimento. La posizione viene specificata quando crei un trasferimento.project_idè l'ID progetto.integerè il numero di risultati da mostrare per pagina.data_sourcesè uno o più dei seguenti valori:amazon_s3- Trasferimento dati Amazon S3azure_blob_storage- Trasferimento di dati di Azure Blob Storagedcm_dt- Trasferimento dei dati di Campaign Managergoogle_cloud_storage- Trasferimento dei dati di Cloud Storagecross_region_copy- Copia del set di datidfp_dt- Trasferimento dei dati di Google Ad Managerdisplayvideo- Trasferimento dei dati di Display & Video 360google_ads- Trasferimento dei dati di Google Adsmerchant_center- Trasferimento dei dati di Google Merchant Centermysql- Trasferimento di dati MySQLplay- Trasferimento dei dati di Google Playscheduled_query- Trasferimento dei dati delle query programmatesearch_ads- Trasferimento dati di Search Ads 360youtube_channel- Trasferimento dei dati del canale YouTubeyoutube_content_owner- Trasferimento dei dati del proprietario dei contenuti YouTuberedshift- Migrazione di Amazon Redshifton_premises- Migrazione Teradata

Esempi:

Inserisci questo comando per visualizzare tutte le configurazioni di trasferimento negli

Stati Uniti per il tuo progetto predefinito. L'output viene controllato utilizzando il flag --format.

bq ls \

--format=prettyjson \

--transfer_config \

--transfer_location=us

Inserisci questo comando per visualizzare tutte le configurazioni di trasferimento negli Stati Uniti per l'ID progetto myproject.

bq ls \

--transfer_config \

--transfer_location=us \

--project_id=myproject

Inserisci il seguente comando per elencare le tre configurazioni di trasferimento più recenti.

bq ls \

--transfer_config \

--transfer_location=us \

--project_id=myproject \

--max_results=3

Il comando restituisce un token della pagina successiva. Copia il token di pagina e inseriscilo nel comando bq ls per visualizzare i tre risultati successivi.

bq ls \

--transfer_config \

--transfer_location=us \

--project_id=myproject \

--max_results=3 \

--page_token=AB1CdEfg_hIJKL

Inserisci il comando seguente per elencare le configurazioni di trasferimento di Ads e Campaign Manager per l'ID progetto myproject.

bq ls \

--transfer_config \

--transfer_location=us \

--project_id=myproject \

--filter=dataSourceIds:dcm_dt,google_ads

API

Utilizza il metodo projects.locations.transferConfigs.list e fornisci l'ID progetto utilizzando il parametro parent.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Visualizzare la cronologia delle esecuzioni dei trasferimenti

Man mano che vengono eseguiti i trasferimenti pianificati, viene mantenuta una cronologia delle esecuzioni per ogni configurazione di trasferimento, incluse le esecuzioni riuscite e quelle non riuscite. I trasferimenti più vecchi di 90 giorni vengono eliminati automaticamente dalla cronologia dei trasferimenti.

Per visualizzare la cronologia delle esecuzioni per una configurazione di trasferimento:

Console

Nella console Google Cloud , vai alla pagina Trasferimenti dati.

Fai clic sul trasferimento nell'elenco dei trasferimenti di dati.

Verrà visualizzata la pagina CRONOLOGIA ESECUZIONI per il trasferimento selezionato.

bq

Per elencare le esecuzioni del trasferimento per una determinata configurazione di trasferimento, inserisci il comando bq

ls e fornisci il flag --transfer_run. Puoi anche fornire il flag

--project_id per specificare un progetto particolare. Se resource_name

non contiene informazioni sul progetto, viene utilizzato il valore --project_id. Se

--project_id non è specificato, viene utilizzato il progetto predefinito. Il flag --format

può essere utilizzato per controllare il formato di output.

Per visualizzare un determinato numero di esecuzioni del trasferimento, fornisci il flag --max_results. Il comando restituisce un token di pagina che fornisci utilizzando il flag --page_token per visualizzare le successive n configurazioni.

Per elencare le esecuzioni del trasferimento in base allo stato di esecuzione, fornisci il flag --filter.

bq ls \ --transfer_run \ --max_results=integer \ --transfer_location=location \ --project_id=project_id \ --filter=states:state, ... \ resource_name

Sostituisci quanto segue:

integerè il numero di risultati da restituire.locationè la posizione delle configurazioni di trasferimento. La posizione viene specificata quando crei un trasferimento.project_idè l'ID progetto.state, ...è uno dei seguenti o un elenco separato da virgole:SUCCEEDEDFAILEDPENDINGRUNNINGCANCELLED

resource_nameè il nome della risorsa del trasferimento (detta anche configurazione del trasferimento). Se non conosci il nome della risorsa del trasferimento, trovalo con:bq ls --transfer_config --transfer_location=location.

Esempi:

Inserisci il comando seguente per visualizzare le tre esecuzioni più recenti per la

configurazione del trasferimento

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7.

L'output viene controllato utilizzando il flag --format.

bq ls \

--format=prettyjson \

--transfer_run \

--max_results=3 \

--transfer_location=us \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

Il comando restituisce un token della pagina successiva. Copia il token di pagina e inseriscilo nel comando bq ls per visualizzare i tre risultati successivi.

bq ls \

--format=prettyjson \

--transfer_run \

--max_results=3 \

--page_token=AB1CdEfg_hIJKL \

--transfer_location=us \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

Inserisci il seguente comando per visualizzare tutte le esecuzioni non riuscite per la

configurazione del trasferimento

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7.

bq ls \

--format=prettyjson \

--transfer_run \

--filter=states:FAILED \

--transfer_location=us \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

API

Utilizza il metodo projects.locations.transferConfigs.runs.list e specifica l'ID progetto utilizzando il parametro parent.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Visualizzare i dettagli dell'esecuzione del trasferimento e i messaggi di log

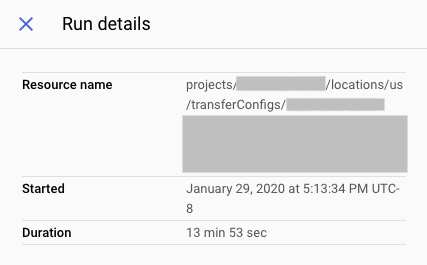

Quando un'esecuzione del trasferimento viene visualizzata nella cronologia delle esecuzioni, puoi visualizzare i dettagli dell'esecuzione, inclusi messaggi di log, avvisi ed errori, il nome dell'esecuzione e l'ora di inizio e fine.

Per visualizzare i dettagli dell'esecuzione del trasferimento:

Console

Nella console Google Cloud , vai alla pagina Trasferimenti dati.

Fai clic sul trasferimento nell'elenco dei trasferimenti di dati.

Verrà visualizzata la pagina CRONOLOGIA ESECUZIONI per il trasferimento selezionato.

Fai clic su una singola esecuzione del trasferimento e si aprirà il riquadro Dettagli esecuzione per l'esecuzione del trasferimento.

Nei Dettagli esecuzione, prendi nota di eventuali messaggi di errore. Queste informazioni sono necessarie se contatti l'assistenza clienti Google Cloud. I dettagli dell'esecuzione includono anche messaggi di log e avvisi.

bq

Per visualizzare i dettagli dell'esecuzione del trasferimento, inserisci il comando bq show e fornisci il nome dell'esecuzione del trasferimento utilizzando il flag --transfer_run. Il flag --format

può essere utilizzato per controllare il formato di output.

bq show \ --format=prettyjson \ --transfer_run run_name

Sostituisci run_name con il nome dell'esecuzione del trasferimento.

Puoi recuperare il nome dell'esecuzione utilizzando il comando bq ls.

Esempio:

Inserisci questo comando per visualizzare i dettagli dell'esecuzione del trasferimento

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g.

bq show \

--format=prettyjson \

--transfer_run \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g

Per visualizzare i messaggi di log di trasferimento per un'esecuzione del trasferimento, inserisci il comando bq ls

con il flag --transfer_log. Puoi filtrare i messaggi di log per tipo utilizzando

il flag --message_type.

Per visualizzare un determinato numero di messaggi di log, fornisci il flag --max_results. Il comando restituisce un token di pagina che fornisci utilizzando il flag --page_token per visualizzare i successivi n messaggi.

bq ls \ --transfer_log \ --max_results=integer \ --message_type=messageTypes:message_type \ run_name

Sostituisci quanto segue:

integerè il numero di messaggi di log da restituire.message_typeè il tipo di messaggio di log da visualizzare (un singolo valore o un elenco separato da virgole):INFOWARNINGERROR

run_nameè il nome dell'esecuzione del trasferimento. Puoi recuperare il nome dell'esecuzione utilizzando il comandobq ls.

Esempi:

Inserisci il seguente comando per visualizzare i primi due messaggi di log per l'esecuzione

del trasferimento

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g.

bq ls \

--transfer_log \

--max_results=2 \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g

Il comando restituisce un token della pagina successiva. Copia il token di pagina e inseriscilo nel comando bq ls per visualizzare i due risultati successivi.

bq ls \

--transfer_log \

--max_results=2 \

--page_token=AB1CdEfg_hIJKL \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g

Inserisci il seguente comando per visualizzare solo i messaggi di errore per l'esecuzione del trasferimento

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g.

bq ls \

--transfer_log \

--message_type=messageTypes:ERROR \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g

API

Utilizza il metodo projects.transferConfigs.runs.transferLogs.list e fornisci il nome dell'esecuzione del trasferimento utilizzando il parametro parent.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Modificare i trasferimenti

Puoi modificare i trasferimenti esistenti modificando le informazioni sulla configurazione del trasferimento, aggiornando le credenziali di un utente associate a una configurazione del trasferimento e disattivando o eliminando un trasferimento.

Ruoli obbligatori

Per ottenere le autorizzazioni necessarie per modificare i trasferimenti, chiedi all'amministratore di concederti il ruolo IAM BigQuery Admin (roles/bigquery.admin) nel progetto.

Per saperne di più sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.

Potresti anche riuscire a ottenere le autorizzazioni richieste tramite i ruoli personalizzati o altri ruoli predefiniti.

Aggiorna un trasferimento

Dopo aver creato una configurazione del trasferimento, puoi modificare i seguenti campi:

- Set di dati di destinazione

- Nome visualizzato

- Uno qualsiasi dei parametri specificati per il tipo di trasferimento specifico

- Impostazioni di notifica per la corsa

- Service account

Non puoi modificare l'origine di un trasferimento una volta creato.

Per aggiornare un trasferimento:

Console

Nella console Google Cloud , vai alla pagina Trasferimenti dati.

Fai clic sul trasferimento nell'elenco dei trasferimenti di dati.

Fai clic su MODIFICA per aggiornare la configurazione del trasferimento.

bq

Inserisci il

comando bq update,

fornisci il nome della risorsa della configurazione del trasferimento utilizzando il

flag --transfer_config e fornisci i flag --display_name, --params,

--refresh_window_days, --schedule o --target_dataset. Puoi

fornire facoltativamente un flag --destination_kms_key per le query pianificate

o i trasferimenti Cloud Storage.

bq update \ --display_name='NAME' \ --params='PARAMETERS' \ --refresh_window_days=INTEGER \ --schedule='SCHEDULE' --target_dataset=DATASET_ID \ --destination_kms_key="DESTINATION_KEY" \ --transfer_config \ --service_account_name=SERVICE_ACCOUNT \ RESOURCE_NAME

Sostituisci quanto segue:

NAME: il nome visualizzato per la configurazione del trasferimento.PARAMETERS: i parametri per la configurazione del trasferimento in formato JSON. Ad esempio:--params='{"param1":"param_value1"}'. Per informazioni sui parametri supportati, consulta la guida al trasferimento per la tua origine dati.INTEGER: un valore compreso tra 0 e 30. Per informazioni sull'impostazione della finestra di aggiornamento, consulta la documentazione relativa al tipo di trasferimento.SCHEDULE: una pianificazione ricorrente, ad esempio--schedule="every 3 hours". Per una descrizione della sintassi dischedule, vedi Formattazione dischedule.- DATASET_ID: il set di dati di destinazione per la configurazione del trasferimento.

- DESTINATION_KEY: l'ID risorsa chiave Cloud KMS

—ad esempio,

projects/project_name/locations/us/keyRings/key_ring_name/cryptoKeys/key_name. CMEK è disponibile solo per i trasferimenti di query pianificate o Cloud Storage. - SERVICE_ACCOUNT: specifica un account di servizio da utilizzare per questo trasferimento.

- RESOURCE_NAME: il nome della risorsa del trasferimento (chiamata anche configurazione di trasferimento). Se non conosci il nome della risorsa del trasferimento, trovalo con:

bq ls --transfer_config --transfer_location=location.

Esempi:

Il seguente comando aggiorna il nome visualizzato, il set di dati di destinazione,

la finestra di aggiornamento e i parametri per il trasferimento di Google Ads

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7:

bq update \ --display_name='My changed transfer' \ --params='{"customer_id":"123-123-5678"}' \ --refresh_window_days=3 \ --target_dataset=mydataset2 \ --transfer_config \ projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

Il seguente comando aggiorna i parametri e la pianificazione per il trasferimento di query pianificato

projects/myproject/locations/us/transferConfigs/5678z567-5678-5z67-5yx9-56zy3c866vw9:

bq update \ --params='{"destination_table_name_template":"test", "write_disposition":"APPEND"}' \ --schedule="every 24 hours" \ --transfer_config \ projects/myproject/locations/us/transferConfigs/5678z567-5678-5z67-5yx9-56zy3c866vw9

API

Utilizza il metodo projects.transferConfigs.patch e fornisci il nome risorsa del trasferimento utilizzando il parametro transferConfig.name. Se non conosci il nome della risorsa del trasferimento, trovalo con:

bq ls --transfer_config --transfer_location=location.

Puoi anche chiamare il seguente metodo e fornire l'ID progetto utilizzando il parametro

parent per elencare tutti i trasferimenti:

projects.locations.transferConfigs.list.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Aggiorna credenziali

Un trasferimento utilizza le credenziali dell'utente che lo ha creato. Se devi modificare l'utente collegato a una configurazione di trasferimento, puoi aggiornare le credenziali del trasferimento. Questa opzione è utile se l'utente che ha creato il trasferimento non fa più parte della tua organizzazione.

Per aggiornare le credenziali per un trasferimento:

Console

Nella Google Cloud console, accedi come utente a cui vuoi trasferire la proprietà.

Vai alla pagina Trasferimenti di dati.

Fai clic sul trasferimento nell'elenco dei trasferimenti di dati.

Fai clic sul menu ALTRO e poi seleziona Aggiorna credenziali.

Fai clic su Consenti per concedere a BigQuery Data Transfer Service l'autorizzazione a visualizzare i dati dei report e ad accedere e gestire i dati in BigQuery.

bq

Inserisci il comando bq update, fornisci il nome della risorsa della configurazione di trasferimento utilizzando il flag --transfer_config e specifica il flag --update_credentials.

bq update \ --update_credentials=boolean \ --transfer_config \ resource_name

Sostituisci quanto segue:

booleanè un valore booleano che indica se le credenziali devono essere aggiornate per la configurazione del trasferimento.resource_nameè il nome della risorsa del trasferimento (detta anche configurazione di trasferimento). Se non conosci il nome della risorsa del trasferimento, trovalo con:bq ls --transfer_config --transfer_location=location.

Esempi:

Inserisci il seguente comando per aggiornare le credenziali per il trasferimento di Google Ads

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7.

bq update \

--update_credentials=true \

--transfer_config \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

API

Utilizza il metodo projects.transferConfigs.patch e fornisci i parametri authorizationCode e updateMask.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Disattivare un trasferimento

Quando disattivi un trasferimento, disabled viene aggiunto al nome del trasferimento. Quando il trasferimento è disattivato, non vengono pianificate nuove esecuzioni di trasferimento e non sono consentiti nuovi backfill. Tutte le esecuzioni del trasferimento in corso vengono completate.

La disattivazione di un trasferimento non rimuove i dati già trasferiti a BigQuery. I dati trasferiti in precedenza comportano costi di archiviazione standard di BigQuery finché non elimini il set di dati o elimini le tabelle.

Per disattivare un trasferimento:

Console

Nella console Google Cloud , vai alla pagina BigQuery.

Fai clic su Trasferimenti.

Nella pagina Trasferimenti, fai clic sul trasferimento nell'elenco che vuoi disattivare.

Fai clic su DISATTIVA. Per riattivare il trasferimento, fai clic su ATTIVA.

bq

La disattivazione di un trasferimento non è supportata dalla CLI.

API

Utilizza il metodo projects.locations.transferConfigs.patch e imposta disabled su true nella risorsa projects.locations.transferConfig.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Per riattivare il trasferimento:

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Eliminare un trasferimento

Quando un trasferimento viene eliminato, non vengono pianificate nuove esecuzioni di trasferimento. Tutte le esecuzioni del trasferimento in corso vengono interrotte.

L'eliminazione di un trasferimento non rimuove i dati già trasferiti a BigQuery. I dati trasferiti in precedenza comportano costi di archiviazione standard di BigQuery finché non elimini il set di dati o elimini le tabelle.

Per eliminare un trasferimento:

Console

Nella console Google Cloud , vai alla pagina BigQuery.

Fai clic su Trasferimenti.

Nella pagina Trasferimenti, fai clic sul trasferimento nell'elenco che vuoi eliminare.

Fai clic su ELIMINA. Come misura di sicurezza, dovrai digitare la parola "elimina" in una casella per confermare la tua intenzione.

bq

Inserisci il comando bq rm e fornisci il nome della risorsa della configurazione di trasferimento. Puoi utilizzare il flag -f per eliminare una configurazione di trasferimento senza

richiedere la conferma.

bq rm \

-f \

--transfer_config \

resource_name

Dove:

- resource_name è il nome della risorsa del trasferimento, noto anche come configurazione di trasferimento. Se non conosci il nome della risorsa

del trasferimento, esegui il comando

bq ls --transfer_config --transfer_location=locationper elencare tutti i trasferimenti.

Ad esempio, inserisci il seguente comando per eliminare la configurazione del trasferimento

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7.

bq rm \

--transfer_config \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

API

Utilizza il metodo projects.locations.transferConfigs.delete e fornisci la risorsa che stai eliminando utilizzando il parametro name.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Attivare manualmente un trasferimento

Puoi attivare manualmente un trasferimento, chiamato anche esecuzione di backfill, per caricare file di dati aggiuntivi al di fuori dei trasferimenti pianificati automaticamente. Con le origini dati che supportano i parametri di runtime, puoi anche attivare manualmente un trasferimento specificando una data o un intervallo di tempo da cui caricare i dati storici.

Puoi avviare manualmente i backfill dati in qualsiasi momento. Oltre ai limiti delle origini, BigQuery Data Transfer Service supporta un massimo di 180 giorni per richiesta di backfill. Le richieste di backfill simultanee non sono supportate.

Per informazioni sulla quantità di dati disponibili per il backfill, consulta la guida al trasferimento per l'origine dati.

Ruoli obbligatori

Per ottenere le autorizzazioni necessarie per modificare i trasferimenti, chiedi all'amministratore di concederti il ruolo IAM BigQuery Admin (roles/bigquery.admin) nel progetto.

Per saperne di più sulla concessione dei ruoli, consulta Gestisci l'accesso a progetti, cartelle e organizzazioni.

Potresti anche riuscire a ottenere le autorizzazioni richieste tramite i ruoli personalizzati o altri ruoli predefiniti.

Attivare manualmente un trasferimento o un backfill

Puoi attivare manualmente un trasferimento o un backfill con i seguenti metodi:

- Seleziona l'esecuzione del trasferimento utilizzando la console Google Cloud , quindi fai clic su Esegui trasferimento ora o Pianifica riempimento.

- Utilizza il comando

bq mk –transfer runutilizzando lo strumento a riga di comandobq - Chiama il metodo API

projects.locations.transferConfigs.startManualRuns method

Per istruzioni dettagliate su ciascun metodo, seleziona la scheda corrispondente:

Console

Nella console Google Cloud , vai alla pagina Trasferimenti dati.

Seleziona il trasferimento dall'elenco.

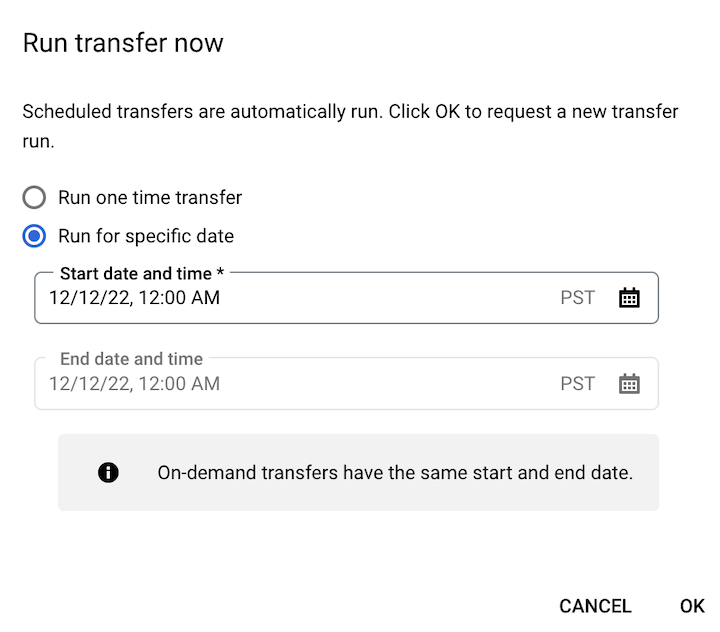

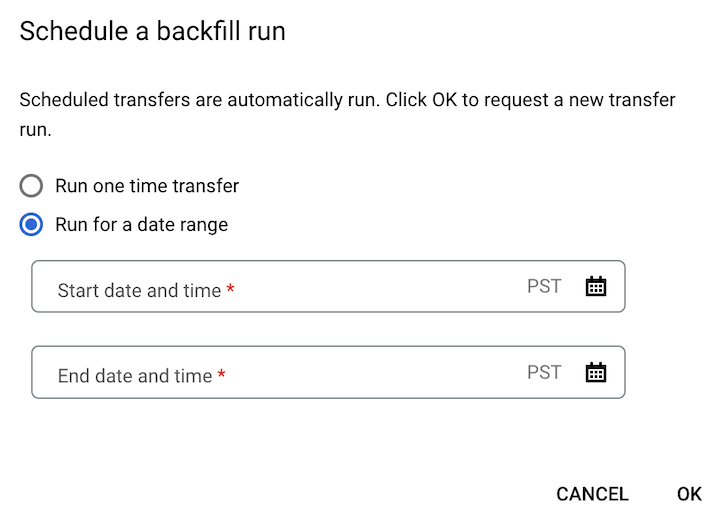

Fai clic su Esegui trasferimento ora o Pianifica riempimento. È disponibile una sola opzione a seconda del tipo di configurazione del trasferimento.

Se hai fatto clic su Esegui trasferimento ora, seleziona Esegui trasferimento una sola volta o Esegui per una data specifica, a seconda dei casi. Se hai selezionato Esegui per una data specifica, seleziona una data e un'ora specifiche:

Se hai fatto clic su Pianifica riempimento, seleziona Esegui trasferimento una tantum o Esegui per un intervallo di date, a seconda dei casi. Se hai selezionato Esegui per un intervallo di date, seleziona una data e un'ora di inizio e di fine:

Fai clic su OK.

bq

Per avviare manualmente un'esecuzione del trasferimento, inserisci il comando bq mk con il flag

--transfer_run:

bq mk \ --transfer_run \ --run_time='RUN_TIME' \ RESOURCE_NAME

Sostituisci quanto segue:

RUN_TIMEè un timestamp che specifica la data di un trasferimento precedente. Utilizza timestamp che terminano con Z o che contengono un offset del fuso orario valido, ad esempio2022-08-19T12:11:35.00Zo2022-05-25T00:00:00+00:00.- Se il trasferimento non ha un parametro di runtime o vuoi semplicemente attivare un trasferimento ora senza specificare un trasferimento precedente, inserisci l'ora corrente in questo campo.

RESOURCE_NAMEè il nome della risorsa elencato nella configurazione del trasferimento, ad esempioprojects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7.- Per trovare il nome della risorsa di una configurazione di trasferimento, consulta la sezione Recuperare i dettagli del trasferimento.

- Il nome della risorsa utilizza il formato Nome della risorsa relativa.

Per avviare manualmente un'esecuzione del trasferimento per un intervallo di date, inserisci il comando bq mk con il

flag --transfer_run insieme a un intervallo di date:

bq mk \ --transfer_run \ --start_time='START_TIME' \ --end_time='END_TIME' \ RESOURCE_NAME

Sostituisci quanto segue:

START_TIMEeEND_TIMEsono timestamp che terminano con Z o contengono un offset del fuso orario valido. Questi valori specificano l'intervallo di tempo contenente le esecuzioni di trasferimento precedenti che vuoi riempire da cui iniziare, ad esempio2022-08-19T12:11:35.00Zo2022-05-25T00:00:00+00:00RESOURCE_NAMEè il nome della risorsa elencato nella configurazione del trasferimento, ad esempioprojects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7- Per trovare il nome della risorsa di una configurazione di trasferimento, consulta la sezione Recuperare i dettagli del trasferimento.

- Il nome della risorsa utilizza il formato Nome della risorsa relativa.

API

Per avviare manualmente un'esecuzione del trasferimento, utilizza il metodo

projects.locations.transferConfigs.startManualRuns

e fornisci il nome della risorsa di configurazione del trasferimento utilizzando il parametro

parent. Per trovare il nome della risorsa di una configurazione di trasferimento, consulta Recuperare i dettagli del trasferimento.

"requestedRunTime": "RUN_TIME"

Sostituisci quanto segue:

RUN_TIMEè un timestamp che specifica la data di un trasferimento precedente. Utilizza timestamp che terminano con Z o che contengono un offset del fuso orario valido, ad esempio2022-08-19T12:11:35.00Zo2022-05-25T00:00:00+00:00.- Se il trasferimento non ha un parametro di runtime o vuoi semplicemente attivare un trasferimento ora senza specificare un trasferimento precedente, inserisci l'ora corrente in questo campo.

Per avviare manualmente un'esecuzione del trasferimento per un intervallo di date, fornisci un intervallo di date:

"requestedTimeRange": { "startTime": "START_TIME", "endTime": "END_TIME" }

Sostituisci quanto segue:

START_TIMEeEND_TIMEsono timestamp che terminano con Z o contengono un offset del fuso orario valido. Questi valori specificano l'intervallo di tempo contenente le esecuzioni di trasferimento precedenti che vuoi riempire da cui iniziare, ad esempio2022-08-19T12:11:35.00Zo2022-05-25T00:00:00+00:00

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Java.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di BigQuery per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API BigQuery Python.

Per eseguire l'autenticazione in BigQuery, configura le Credenziali predefinite dell'applicazione. Per saperne di più, vedi Configurare l'autenticazione per le librerie client.

Logging e monitoraggio

BigQuery Data Transfer Service esporta log e metriche in Cloud Monitoring e Cloud Logging, che forniscono visibilità sui trasferimenti. Puoi utilizzare Monitoring per configurare dashboard per monitorare i trasferimenti, valutare le prestazioni di esecuzione dei trasferimenti e visualizzare i messaggi di errore per risolvere i problemi relativi agli errori di trasferimento. Puoi utilizzare Logging per visualizzare i log relativi a un'esecuzione del trasferimento o a una configurazione del trasferimento.

Puoi anche visualizzare gli audit log disponibili per BigQuery Data Transfer Service per l'attività di trasferimento e i log di accesso ai dati.