Trabalhe com dados de intervalos temporais

Este documento descreve como usar funções SQL para suportar a análise de séries cronológicas.

Introdução

Uma série cronológica é uma sequência de pontos de dados, cada um dos quais consiste num tempo e num valor associado a esse tempo. Normalmente, uma série cronológica também tem um identificador que atribui um nome exclusivo à série cronológica.

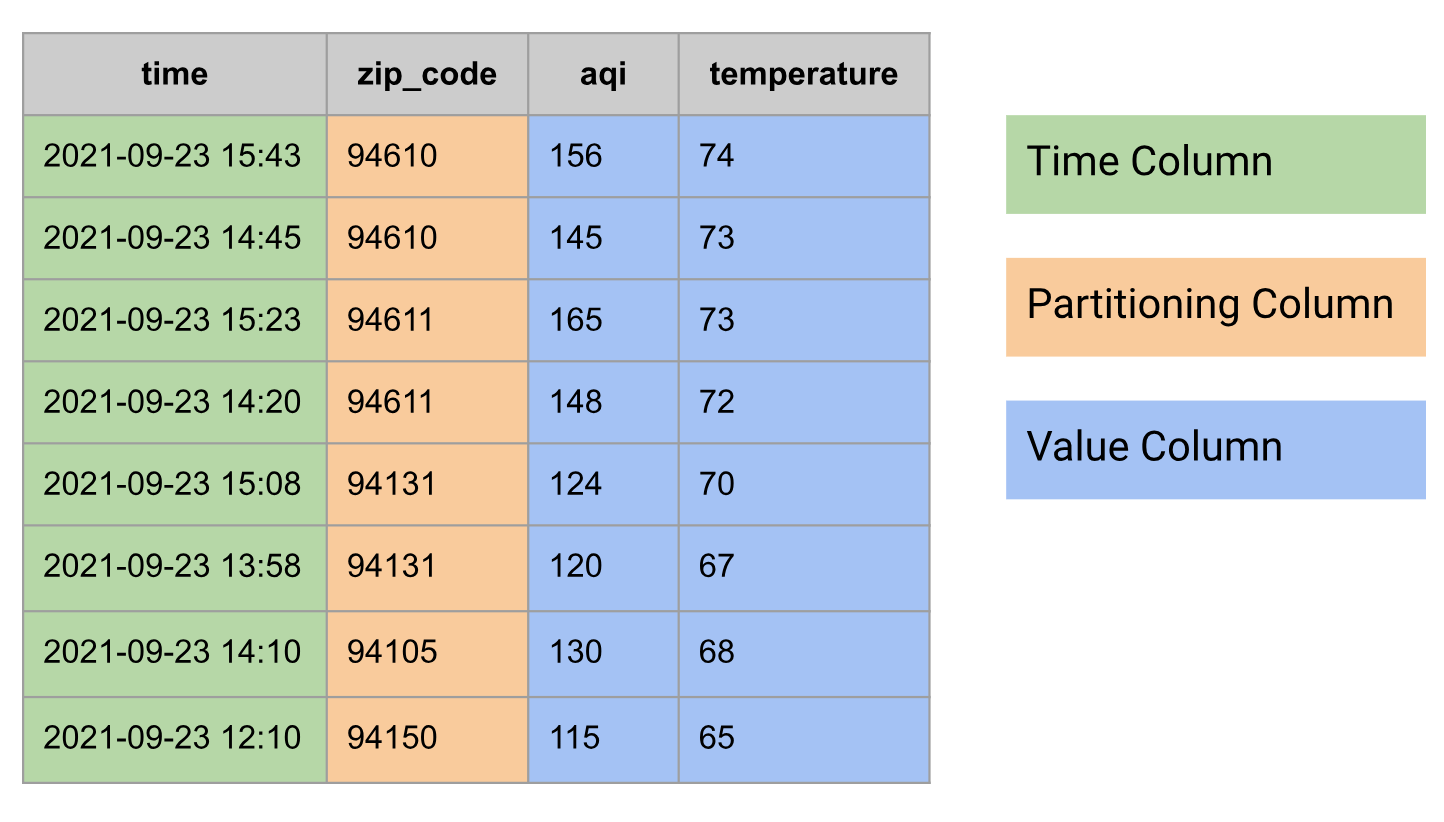

Nas bases de dados relacionais, uma série cronológica é modelada como uma tabela com os seguintes grupos de colunas:

- Coluna Hora

- Pode ter colunas de partição, por exemplo, código postal

- Uma ou mais colunas de valores ou um tipo

STRUCTque combine vários valores, por exemplo, temperatura e IQA

Segue-se um exemplo de dados de séries cronológicas modelados como uma tabela:

Agregue uma série temporal

Na análise de séries temporais, a agregação de tempo é uma agregação realizada ao longo do eixo temporal.

Pode fazer a agregação de tempo no BigQuery com a ajuda das funções de agrupamento por tempo (TIMESTAMP_BUCKET, DATE_BUCKET e DATETIME_BUCKET).

As funções de agrupamento por tempo mapeiam os valores de tempo de entrada para o grupo a que pertencem.

Normalmente, a agregação de tempo é realizada para combinar vários pontos de dados num período de tempo num único ponto de dados, usando uma função de agregação, como AVG, MIN, MAX, COUNT ou SUM. Por exemplo, latência média de pedidos de 15 minutos, temperaturas mínimas e máximas diárias e número diário de viagens de táxi.

Para as consultas nesta secção, crie uma tabela denominada

mydataset.environmental_data_hourly:

CREATE OR REPLACE TABLE mydataset.environmental_data_hourly AS

SELECT * FROM UNNEST(

ARRAY<STRUCT<zip_code INT64, time TIMESTAMP, aqi INT64, temperature INT64>>[

STRUCT(60606, TIMESTAMP '2020-09-08 00:30:51', 22, 66),

STRUCT(60606, TIMESTAMP '2020-09-08 01:32:10', 23, 63),

STRUCT(60606, TIMESTAMP '2020-09-08 02:30:35', 22, 60),

STRUCT(60606, TIMESTAMP '2020-09-08 03:29:39', 21, 58),

STRUCT(60606, TIMESTAMP '2020-09-08 04:33:05', 21, 59),

STRUCT(60606, TIMESTAMP '2020-09-08 05:32:01', 21, 57),

STRUCT(60606, TIMESTAMP '2020-09-08 06:31:14', 22, 56),

STRUCT(60606, TIMESTAMP '2020-09-08 07:31:06', 28, 55),

STRUCT(60606, TIMESTAMP '2020-09-08 08:29:59', 30, 55),

STRUCT(60606, TIMESTAMP '2020-09-08 09:29:34', 31, 55),

STRUCT(60606, TIMESTAMP '2020-09-08 10:31:24', 38, 56),

STRUCT(60606, TIMESTAMP '2020-09-08 11:31:24', 38, 56),

STRUCT(60606, TIMESTAMP '2020-09-08 12:32:38', 38, 57),

STRUCT(60606, TIMESTAMP '2020-09-08 13:29:59', 38, 56),

STRUCT(60606, TIMESTAMP '2020-09-08 14:31:22', 43, 59),

STRUCT(60606, TIMESTAMP '2020-09-08 15:31:38', 42, 63),

STRUCT(60606, TIMESTAMP '2020-09-08 16:34:22', 43, 65),

STRUCT(60606, TIMESTAMP '2020-09-08 17:33:23', 42, 68),

STRUCT(60606, TIMESTAMP '2020-09-08 18:28:47', 36, 69),

STRUCT(60606, TIMESTAMP '2020-09-08 19:30:28', 34, 67),

STRUCT(60606, TIMESTAMP '2020-09-08 20:30:53', 29, 67),

STRUCT(60606, TIMESTAMP '2020-09-08 21:32:28', 27, 67),

STRUCT(60606, TIMESTAMP '2020-09-08 22:31:45', 25, 65),

STRUCT(60606, TIMESTAMP '2020-09-08 23:31:02', 22, 63),

STRUCT(94105, TIMESTAMP '2020-09-08 00:07:11', 60, 74),

STRUCT(94105, TIMESTAMP '2020-09-08 01:07:24', 61, 73),

STRUCT(94105, TIMESTAMP '2020-09-08 02:08:07', 60, 71),

STRUCT(94105, TIMESTAMP '2020-09-08 03:11:05', 69, 69),

STRUCT(94105, TIMESTAMP '2020-09-08 04:07:26', 72, 67),

STRUCT(94105, TIMESTAMP '2020-09-08 05:08:11', 70, 66),

STRUCT(94105, TIMESTAMP '2020-09-08 06:07:30', 68, 65),

STRUCT(94105, TIMESTAMP '2020-09-08 07:07:10', 77, 64),

STRUCT(94105, TIMESTAMP '2020-09-08 08:06:35', 81, 64),

STRUCT(94105, TIMESTAMP '2020-09-08 09:10:18', 82, 63),

STRUCT(94105, TIMESTAMP '2020-09-08 10:08:10', 107, 62),

STRUCT(94105, TIMESTAMP '2020-09-08 11:08:01', 115, 62),

STRUCT(94105, TIMESTAMP '2020-09-08 12:07:39', 120, 62),

STRUCT(94105, TIMESTAMP '2020-09-08 13:06:03', 125, 61),

STRUCT(94105, TIMESTAMP '2020-09-08 14:08:37', 129, 62),

STRUCT(94105, TIMESTAMP '2020-09-08 15:09:19', 150, 62),

STRUCT(94105, TIMESTAMP '2020-09-08 16:06:39', 151, 62),

STRUCT(94105, TIMESTAMP '2020-09-08 17:08:01', 155, 63),

STRUCT(94105, TIMESTAMP '2020-09-08 18:09:23', 154, 64),

STRUCT(94105, TIMESTAMP '2020-09-08 19:08:43', 151, 67),

STRUCT(94105, TIMESTAMP '2020-09-08 20:07:19', 150, 69),

STRUCT(94105, TIMESTAMP '2020-09-08 21:07:37', 148, 72),

STRUCT(94105, TIMESTAMP '2020-09-08 22:08:01', 143, 76),

STRUCT(94105, TIMESTAMP '2020-09-08 23:08:41', 137, 75)

]);

Uma observação interessante sobre os dados anteriores é que as medições são feitas em períodos de tempo arbitrários, conhecidos como séries cronológicas não alinhadas. A agregação é uma das formas através das quais uma série cronológica pode ser alinhada.

Obtenha uma média de 3 horas

A consulta seguinte calcula um índice de qualidade do ar (IQA) médio de 3 horas e a temperatura para cada código postal. A função TIMESTAMP_BUCKET executa a agregação de tempo atribuindo cada valor de tempo a um dia específico.

SELECT

TIMESTAMP_BUCKET(time, INTERVAL 3 HOUR) AS time,

zip_code,

CAST(AVG(aqi) AS INT64) AS aqi,

CAST(AVG(temperature) AS INT64) AS temperature

FROM mydataset.environmental_data_hourly

GROUP BY zip_code, time

ORDER BY zip_code, time;

/*---------------------+----------+-----+-------------+

| time | zip_code | aqi | temperature |

+---------------------+----------+-----+-------------+

| 2020-09-08 00:00:00 | 60606 | 22 | 63 |

| 2020-09-08 03:00:00 | 60606 | 21 | 58 |

| 2020-09-08 06:00:00 | 60606 | 27 | 55 |

| 2020-09-08 09:00:00 | 60606 | 36 | 56 |

| 2020-09-08 12:00:00 | 60606 | 40 | 57 |

| 2020-09-08 15:00:00 | 60606 | 42 | 65 |

| 2020-09-08 18:00:00 | 60606 | 33 | 68 |

| 2020-09-08 21:00:00 | 60606 | 25 | 65 |

| 2020-09-08 00:00:00 | 94105 | 60 | 73 |

| 2020-09-08 03:00:00 | 94105 | 70 | 67 |

| 2020-09-08 06:00:00 | 94105 | 75 | 64 |

| 2020-09-08 09:00:00 | 94105 | 101 | 62 |

| 2020-09-08 12:00:00 | 94105 | 125 | 62 |

| 2020-09-08 15:00:00 | 94105 | 152 | 62 |

| 2020-09-08 18:00:00 | 94105 | 152 | 67 |

| 2020-09-08 21:00:00 | 94105 | 143 | 74 |

+---------------------+----------+-----+-------------*/

Obtenha um valor mínimo e máximo de 3 horas

Na consulta seguinte, calcula as temperaturas mínimas e máximas de 3 horas para cada código postal:

SELECT

TIMESTAMP_BUCKET(time, INTERVAL 3 HOUR) AS time,

zip_code,

MIN(temperature) AS temperature_min,

MAX(temperature) AS temperature_max,

FROM mydataset.environmental_data_hourly

GROUP BY zip_code, time

ORDER BY zip_code, time;

/*---------------------+----------+-----------------+-----------------+

| time | zip_code | temperature_min | temperature_max |

+---------------------+----------+-----------------+-----------------+

| 2020-09-08 00:00:00 | 60606 | 60 | 66 |

| 2020-09-08 03:00:00 | 60606 | 57 | 59 |

| 2020-09-08 06:00:00 | 60606 | 55 | 56 |

| 2020-09-08 09:00:00 | 60606 | 55 | 56 |

| 2020-09-08 12:00:00 | 60606 | 56 | 59 |

| 2020-09-08 15:00:00 | 60606 | 63 | 68 |

| 2020-09-08 18:00:00 | 60606 | 67 | 69 |

| 2020-09-08 21:00:00 | 60606 | 63 | 67 |

| 2020-09-08 00:00:00 | 94105 | 71 | 74 |

| 2020-09-08 03:00:00 | 94105 | 66 | 69 |

| 2020-09-08 06:00:00 | 94105 | 64 | 65 |

| 2020-09-08 09:00:00 | 94105 | 62 | 63 |

| 2020-09-08 12:00:00 | 94105 | 61 | 62 |

| 2020-09-08 15:00:00 | 94105 | 62 | 63 |

| 2020-09-08 18:00:00 | 94105 | 64 | 69 |

| 2020-09-08 21:00:00 | 94105 | 72 | 76 |

+---------------------+----------+-----------------+-----------------*/

Obtenha uma média de 3 horas com o alinhamento personalizado

Quando faz a agregação de séries cronológicas, usa um alinhamento específico para as janelas de séries cronológicas, implícita ou explicitamente. As consultas anteriores usavam o alinhamento implícito, que produzia intervalos que começavam em horas como 00:00:00, 03:00:00 e 06:00:00. Para definir explicitamente este alinhamento na função TIMESTAMP_BUCKET, transmita um argumento opcional que especifique a origem.

Na consulta seguinte, a origem é definida como 2020-01-01 02:00:00. Esta opção altera

o alinhamento e produz grupos que começam em horas como 02:00:00,

05:00:00 e 08:00:00:

SELECT

TIMESTAMP_BUCKET(time, INTERVAL 3 HOUR, TIMESTAMP '2020-01-01 02:00:00') AS time,

zip_code,

CAST(AVG(aqi) AS INT64) AS aqi,

CAST(AVG(temperature) AS INT64) AS temperature

FROM mydataset.environmental_data_hourly

GROUP BY zip_code, time

ORDER BY zip_code, time;

/*---------------------+----------+-----+-------------+

| time | zip_code | aqi | temperature |

+---------------------+----------+-----+-------------+

| 2020-09-07 23:00:00 | 60606 | 23 | 65 |

| 2020-09-08 02:00:00 | 60606 | 21 | 59 |

| 2020-09-08 05:00:00 | 60606 | 24 | 56 |

| 2020-09-08 08:00:00 | 60606 | 33 | 55 |

| 2020-09-08 11:00:00 | 60606 | 38 | 56 |

| 2020-09-08 14:00:00 | 60606 | 43 | 62 |

| 2020-09-08 17:00:00 | 60606 | 37 | 68 |

| 2020-09-08 20:00:00 | 60606 | 27 | 66 |

| 2020-09-08 23:00:00 | 60606 | 22 | 63 |

| 2020-09-07 23:00:00 | 94105 | 61 | 74 |

| 2020-09-08 02:00:00 | 94105 | 67 | 69 |

| 2020-09-08 05:00:00 | 94105 | 72 | 65 |

| 2020-09-08 08:00:00 | 94105 | 90 | 63 |

| 2020-09-08 11:00:00 | 94105 | 120 | 62 |

| 2020-09-08 14:00:00 | 94105 | 143 | 62 |

| 2020-09-08 17:00:00 | 94105 | 153 | 65 |

| 2020-09-08 20:00:00 | 94105 | 147 | 72 |

| 2020-09-08 23:00:00 | 94105 | 137 | 75 |

+---------------------+----------+-----+-------------*/

Agregue uma série temporal com preenchimento de lacunas

Por vezes, depois de agregar uma série cronológica, os dados podem ter lacunas que precisam de ser preenchidas com alguns valores para análise ou apresentação adicionais dos dados.

A técnica usada para preencher essas lacunas chama-se preenchimento de lacunas. No BigQuery, pode usar a função de tabela GAP_FILL para preencher lacunas nos dados de séries cronológicas, usando um dos métodos de preenchimento de lacunas fornecidos:

- NULL, também conhecido como constante

- LOCF, last observation carried forward

- Linear, interpolação linear entre os dois pontos de dados adjacentes

Para as consultas nesta secção, crie uma tabela denominada

mydataset.environmental_data_hourly_with_gaps, que se baseia nos dados usados

na secção anterior, mas com lacunas. Em cenários do mundo real, os dados podem ter pontos de dados em falta devido a uma avaria de curto prazo da estação meteorológica.

CREATE OR REPLACE TABLE mydataset.environmental_data_hourly_with_gaps AS

SELECT * FROM UNNEST(

ARRAY<STRUCT<zip_code INT64, time TIMESTAMP, aqi INT64, temperature INT64>>[

STRUCT(60606, TIMESTAMP '2020-09-08 00:30:51', 22, 66),

STRUCT(60606, TIMESTAMP '2020-09-08 01:32:10', 23, 63),

STRUCT(60606, TIMESTAMP '2020-09-08 02:30:35', 22, 60),

STRUCT(60606, TIMESTAMP '2020-09-08 03:29:39', 21, 58),

STRUCT(60606, TIMESTAMP '2020-09-08 04:33:05', 21, 59),

STRUCT(60606, TIMESTAMP '2020-09-08 05:32:01', 21, 57),

STRUCT(60606, TIMESTAMP '2020-09-08 06:31:14', 22, 56),

STRUCT(60606, TIMESTAMP '2020-09-08 07:31:06', 28, 55),

STRUCT(60606, TIMESTAMP '2020-09-08 08:29:59', 30, 55),

STRUCT(60606, TIMESTAMP '2020-09-08 09:29:34', 31, 55),

STRUCT(60606, TIMESTAMP '2020-09-08 10:31:24', 38, 56),

STRUCT(60606, TIMESTAMP '2020-09-08 11:31:24', 38, 56),

-- No data points between hours 12 and 15.

STRUCT(60606, TIMESTAMP '2020-09-08 16:34:22', 43, 65),

STRUCT(60606, TIMESTAMP '2020-09-08 17:33:23', 42, 68),

STRUCT(60606, TIMESTAMP '2020-09-08 18:28:47', 36, 69),

STRUCT(60606, TIMESTAMP '2020-09-08 19:30:28', 34, 67),

STRUCT(60606, TIMESTAMP '2020-09-08 20:30:53', 29, 67),

STRUCT(60606, TIMESTAMP '2020-09-08 21:32:28', 27, 67),

STRUCT(60606, TIMESTAMP '2020-09-08 22:31:45', 25, 65),

STRUCT(60606, TIMESTAMP '2020-09-08 23:31:02', 22, 63),

STRUCT(94105, TIMESTAMP '2020-09-08 00:07:11', 60, 74),

STRUCT(94105, TIMESTAMP '2020-09-08 01:07:24', 61, 73),

STRUCT(94105, TIMESTAMP '2020-09-08 02:08:07', 60, 71),

STRUCT(94105, TIMESTAMP '2020-09-08 03:11:05', 69, 69),

STRUCT(94105, TIMESTAMP '2020-09-08 04:07:26', 72, 67),

STRUCT(94105, TIMESTAMP '2020-09-08 05:08:11', 70, 66),

STRUCT(94105, TIMESTAMP '2020-09-08 06:07:30', 68, 65),

STRUCT(94105, TIMESTAMP '2020-09-08 07:07:10', 77, 64),

STRUCT(94105, TIMESTAMP '2020-09-08 08:06:35', 81, 64),

STRUCT(94105, TIMESTAMP '2020-09-08 09:10:18', 82, 63),

STRUCT(94105, TIMESTAMP '2020-09-08 10:08:10', 107, 62),

STRUCT(94105, TIMESTAMP '2020-09-08 11:08:01', 115, 62),

STRUCT(94105, TIMESTAMP '2020-09-08 12:07:39', 120, 62),

STRUCT(94105, TIMESTAMP '2020-09-08 13:06:03', 125, 61),

STRUCT(94105, TIMESTAMP '2020-09-08 14:08:37', 129, 62),

-- No data points between hours 15 and 18.

STRUCT(94105, TIMESTAMP '2020-09-08 19:08:43', 151, 67),

STRUCT(94105, TIMESTAMP '2020-09-08 20:07:19', 150, 69),

STRUCT(94105, TIMESTAMP '2020-09-08 21:07:37', 148, 72),

STRUCT(94105, TIMESTAMP '2020-09-08 22:08:01', 143, 76),

STRUCT(94105, TIMESTAMP '2020-09-08 23:08:41', 137, 75)

]);

Obter uma média de 3 horas (inclui lacunas)

A consulta seguinte calcula a temperatura e o IQA médios de 3 horas para cada código postal:

SELECT

TIMESTAMP_BUCKET(time, INTERVAL 3 HOUR) AS time,

zip_code,

CAST(AVG(aqi) AS INT64) AS aqi,

CAST(AVG(temperature) AS INT64) AS temperature

FROM mydataset.environmental_data_hourly_with_gaps

GROUP BY zip_code, time

ORDER BY zip_code, time;

/*---------------------+----------+-----+-------------+

| time | zip_code | aqi | temperature |

+---------------------+----------+-----+-------------+

| 2020-09-08 00:00:00 | 60606 | 22 | 63 |

| 2020-09-08 03:00:00 | 60606 | 21 | 58 |

| 2020-09-08 06:00:00 | 60606 | 27 | 55 |

| 2020-09-08 09:00:00 | 60606 | 36 | 56 |

| 2020-09-08 15:00:00 | 60606 | 43 | 67 |

| 2020-09-08 18:00:00 | 60606 | 33 | 68 |

| 2020-09-08 21:00:00 | 60606 | 25 | 65 |

| 2020-09-08 00:00:00 | 94105 | 60 | 73 |

| 2020-09-08 03:00:00 | 94105 | 70 | 67 |

| 2020-09-08 06:00:00 | 94105 | 75 | 64 |

| 2020-09-08 09:00:00 | 94105 | 101 | 62 |

| 2020-09-08 12:00:00 | 94105 | 125 | 62 |

| 2020-09-08 18:00:00 | 94105 | 151 | 68 |

| 2020-09-08 21:00:00 | 94105 | 143 | 74 |

+---------------------+----------+-----+-------------*/

Repare como o resultado tem lacunas em determinados intervalos de tempo. Por exemplo, a série cronológica para o código postal 60606 não tem um ponto de dados em 2020-09-08 12:00:00 e a série cronológica para o código postal 94105 não tem um ponto de dados em 2020-09-08 15:00:00.

Obter uma média de 3 horas (preencher lacunas)

Use a consulta da secção anterior e adicione a função GAP_FILL para preencher as lacunas:

WITH aggregated_3_hr AS (

SELECT

TIMESTAMP_BUCKET(time, INTERVAL 3 HOUR) AS time,

zip_code,

CAST(AVG(aqi) AS INT64) AS aqi,

CAST(AVG(temperature) AS INT64) AS temperature

FROM mydataset.environmental_data_hourly_with_gaps

GROUP BY zip_code, time)

SELECT *

FROM GAP_FILL(

TABLE aggregated_3_hr,

ts_column => 'time',

bucket_width => INTERVAL 3 HOUR,

partitioning_columns => ['zip_code']

)

ORDER BY zip_code, time;

/*---------------------+----------+------+-------------+

| time | zip_code | aqi | temperature |

+---------------------+----------+------+-------------+

| 2020-09-08 00:00:00 | 60606 | 22 | 63 |

| 2020-09-08 03:00:00 | 60606 | 21 | 58 |

| 2020-09-08 06:00:00 | 60606 | 27 | 55 |

| 2020-09-08 09:00:00 | 60606 | 36 | 56 |

| 2020-09-08 12:00:00 | 60606 | NULL | NULL |

| 2020-09-08 15:00:00 | 60606 | 43 | 67 |

| 2020-09-08 18:00:00 | 60606 | 33 | 68 |

| 2020-09-08 21:00:00 | 60606 | 25 | 65 |

| 2020-09-08 00:00:00 | 94105 | 60 | 73 |

| 2020-09-08 03:00:00 | 94105 | 70 | 67 |

| 2020-09-08 06:00:00 | 94105 | 75 | 64 |

| 2020-09-08 09:00:00 | 94105 | 101 | 62 |

| 2020-09-08 12:00:00 | 94105 | 125 | 62 |

| 2020-09-08 15:00:00 | 94105 | NULL | NULL |

| 2020-09-08 18:00:00 | 94105 | 151 | 68 |

| 2020-09-08 21:00:00 | 94105 | 143 | 74 |

+---------------------+----------+------+-------------*/

A tabela de saída contém agora uma linha em falta em 2020-09-08 12:00:00 para o código postal 60606 e em 2020-09-08 15:00:00 para o código postal 94105, com NULL

valores nas colunas de métricas correspondentes. Uma vez que não especificou nenhum método de preenchimento de lacunas, GAP_FILL usou o método de preenchimento de lacunas predefinido, NULL.

Preencha as lacunas com o preenchimento de lacunas linear e LOCF

Na consulta seguinte, a função GAP_FILL é usada com o método de preenchimento de lacunas LOCF para a coluna aqi e a interpolação linear para a coluna temperature:

WITH aggregated_3_hr AS (

SELECT

TIMESTAMP_BUCKET(time, INTERVAL 3 HOUR) AS time,

zip_code,

CAST(AVG(aqi) AS INT64) AS aqi,

CAST(AVG(temperature) AS INT64) AS temperature

FROM mydataset.environmental_data_hourly_with_gaps

GROUP BY zip_code, time)

SELECT *

FROM GAP_FILL(

TABLE aggregated_3_hr,

ts_column => 'time',

bucket_width => INTERVAL 3 HOUR,

partitioning_columns => ['zip_code'],

value_columns => [

('aqi', 'locf'),

('temperature', 'linear')

]

)

ORDER BY zip_code, time;

/*---------------------+----------+-----+-------------+

| time | zip_code | aqi | temperature |

+---------------------+----------+-----+-------------+

| 2020-09-08 00:00:00 | 60606 | 22 | 63 |

| 2020-09-08 03:00:00 | 60606 | 21 | 58 |

| 2020-09-08 06:00:00 | 60606 | 27 | 55 |

| 2020-09-08 09:00:00 | 60606 | 36 | 56 |

| 2020-09-08 12:00:00 | 60606 | 36 | 62 |

| 2020-09-08 15:00:00 | 60606 | 43 | 67 |

| 2020-09-08 18:00:00 | 60606 | 33 | 68 |

| 2020-09-08 21:00:00 | 60606 | 25 | 65 |

| 2020-09-08 00:00:00 | 94105 | 60 | 73 |

| 2020-09-08 03:00:00 | 94105 | 70 | 67 |

| 2020-09-08 06:00:00 | 94105 | 75 | 64 |

| 2020-09-08 09:00:00 | 94105 | 101 | 62 |

| 2020-09-08 12:00:00 | 94105 | 125 | 62 |

| 2020-09-08 15:00:00 | 94105 | 125 | 65 |

| 2020-09-08 18:00:00 | 94105 | 151 | 68 |

| 2020-09-08 21:00:00 | 94105 | 143 | 74 |

+---------------------+----------+-----+-------------*/

Nesta consulta, a primeira linha com lacunas preenchidas tem o valor aqi, que é retirado do ponto de dados anterior desta série cronológica (código postal 60606) em 2020-09-08 09:00:00.36 O valor temperature de 62 é o resultado da interpolação linear entre os pontos de dados 2020-09-08 09:00:00 e 2020-09-08 15:00:00. A outra linha em falta foi criada de forma semelhante: o valor aqi foi transferido do ponto de dados anterior desta série cronológica (código postal 94105) e o valor da temperatura 65 é o resultado da interpolação linear entre os pontos de dados disponíveis anteriores e seguintes.125

Alinhe uma série temporal com o preenchimento de lacunas

As séries cronológicas podem estar alinhadas ou não alinhadas. Uma série cronológica está alinhada quando os pontos de dados ocorrem apenas a intervalos regulares.

No mundo real, no momento da recolha, as séries cronológicas raramente estão alinhadas e, normalmente, requerem algum processamento adicional para as alinhar.

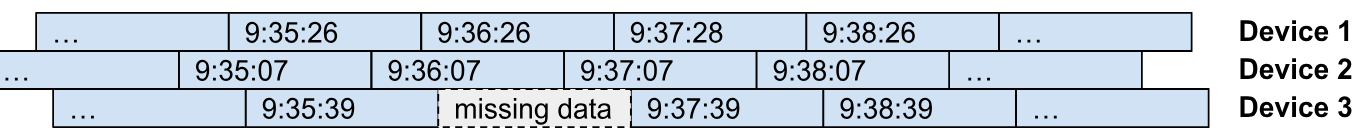

Por exemplo, considere os dispositivos de IoT que enviam as respetivas métricas para um coletor centralizado a cada minuto. Seria irrazoável esperar que os dispositivos enviassem as respetivas métricas exatamente nos mesmos instantes. Normalmente, cada dispositivo envia as respetivas métricas com a mesma frequência (período), mas com um desvio de tempo (alinhamento) diferente. O diagrama seguinte ilustra este exemplo. Pode ver cada dispositivo a enviar os respetivos dados com um intervalo de um minuto, com algumas instâncias de dados em falta (Dispositivo 3 às 9:36:39) e dados atrasados (Dispositivo 1 às 9:37:28).

Pode fazer o alinhamento de séries cronológicas em dados não alinhados, usando a agregação de tempo. Isto é útil se quiser alterar o período de amostragem da série cronológica, como alterar o período de amostragem original de 1 minuto para um período de 15 minutos. Pode alinhar os dados para processamento de séries cronológicas adicional, como juntar os dados de séries cronológicas ou para fins de apresentação (como a criação de gráficos).

Pode usar a função de tabela GAP_FILL com métodos LOCF ou de preenchimento de lacunas lineares para fazer o alinhamento de séries cronológicas. A ideia é usar GAP_FILL com o período de saída e o alinhamento selecionados (controlados pelo argumento de origem opcional). O resultado da operação é uma tabela com séries cronológicas alinhadas, em que os valores de cada ponto de dados são derivados das séries cronológicas de entrada com o método de preenchimento de lacunas usado para essa coluna de valores específica (LOCF ou linear).

Crie uma tabela mydataset.device_data semelhante à ilustração anterior:

CREATE OR REPLACE TABLE mydataset.device_data AS

SELECT * FROM UNNEST(

ARRAY<STRUCT<device_id INT64, time TIMESTAMP, signal INT64, state STRING>>[

STRUCT(2, TIMESTAMP '2023-11-01 09:35:07', 87, 'ACTIVE'),

STRUCT(1, TIMESTAMP '2023-11-01 09:35:26', 82, 'ACTIVE'),

STRUCT(3, TIMESTAMP '2023-11-01 09:35:39', 74, 'INACTIVE'),

STRUCT(2, TIMESTAMP '2023-11-01 09:36:07', 88, 'ACTIVE'),

STRUCT(1, TIMESTAMP '2023-11-01 09:36:26', 82, 'ACTIVE'),

STRUCT(2, TIMESTAMP '2023-11-01 09:37:07', 88, 'ACTIVE'),

STRUCT(1, TIMESTAMP '2023-11-01 09:37:28', 80, 'ACTIVE'),

STRUCT(3, TIMESTAMP '2023-11-01 09:37:39', 77, 'ACTIVE'),

STRUCT(2, TIMESTAMP '2023-11-01 09:38:07', 86, 'ACTIVE'),

STRUCT(1, TIMESTAMP '2023-11-01 09:38:26', 81, 'ACTIVE'),

STRUCT(3, TIMESTAMP '2023-11-01 09:38:39', 77, 'ACTIVE')

]);

Seguem-se os dados reais ordenados pelas colunas time e device_id:

SELECT * FROM mydataset.device_data ORDER BY time, device_id;

/*-----------+---------------------+--------+----------+

| device_id | time | signal | state |

+-----------+---------------------+--------+----------+

| 2 | 2023-11-01 09:35:07 | 87 | ACTIVE |

| 1 | 2023-11-01 09:35:26 | 82 | ACTIVE |

| 3 | 2023-11-01 09:35:39 | 74 | INACTIVE |

| 2 | 2023-11-01 09:36:07 | 88 | ACTIVE |

| 1 | 2023-11-01 09:36:26 | 82 | ACTIVE |

| 2 | 2023-11-01 09:37:07 | 88 | ACTIVE |

| 1 | 2023-11-01 09:37:28 | 80 | ACTIVE |

| 3 | 2023-11-01 09:37:39 | 77 | ACTIVE |

| 2 | 2023-11-01 09:38:07 | 86 | ACTIVE |

| 1 | 2023-11-01 09:38:26 | 81 | ACTIVE |

| 3 | 2023-11-01 09:38:39 | 77 | ACTIVE |

+-----------+---------------------+--------+----------*/

A tabela contém a série cronológica para cada dispositivo com duas colunas de métricas:

signal– Nível do sinal, conforme observado pelo dispositivo no momento da amostragem, representado como um valor inteiro entre0e100.state- estado do dispositivo no momento da amostragem, representado como uma string de formato livre.

Na consulta seguinte, a função GAP_FILL é usada para alinhar a série cronológica em intervalos de 1 minuto. Tenha em atenção como a interpolação linear é usada para calcular os valores da coluna signal e o LOCF para a coluna state. Para estes dados de exemplo, a interpolação linear é uma escolha adequada para calcular os valores de saída.

SELECT *

FROM GAP_FILL(

TABLE mydataset.device_data,

ts_column => 'time',

bucket_width => INTERVAL 1 MINUTE,

partitioning_columns => ['device_id'],

value_columns => [

('signal', 'linear'),

('state', 'locf')

]

)

ORDER BY time, device_id;

/*---------------------+-----------+--------+----------+

| time | device_id | signal | state |

+---------------------+-----------+--------+----------+

| 2023-11-01 09:36:00 | 1 | 82 | ACTIVE |

| 2023-11-01 09:36:00 | 2 | 88 | ACTIVE |

| 2023-11-01 09:36:00 | 3 | 75 | INACTIVE |

| 2023-11-01 09:37:00 | 1 | 81 | ACTIVE |

| 2023-11-01 09:37:00 | 2 | 88 | ACTIVE |

| 2023-11-01 09:37:00 | 3 | 76 | INACTIVE |

| 2023-11-01 09:38:00 | 1 | 81 | ACTIVE |

| 2023-11-01 09:38:00 | 2 | 86 | ACTIVE |

| 2023-11-01 09:38:00 | 3 | 77 | ACTIVE |

+---------------------+-----------+--------+----------*/

A tabela de saída contém uma série cronológica alinhada para cada dispositivo e colunas de valores (signal e state), calculadas através dos métodos de preenchimento de lacunas especificados na chamada de função.

Junte dados de intervalos temporais

Pode juntar dados de séries cronológicas através de uma junção com janelas ou de uma junção AS OF.

Junção com janelas

Por vezes, tem de juntar duas ou mais tabelas com dados de séries cronológicas. Considere as duas tabelas seguintes:

mydataset.sensor_temperatures, contém dados de temperatura comunicados por cada sensor a cada 15 segundos.mydataset.sensor_fuel_rates, contém a taxa de consumo de combustível medida por cada sensor a cada 15 segundos.

Para criar estas tabelas, execute as seguintes consultas:

CREATE OR REPLACE TABLE mydataset.sensor_temperatures AS

SELECT * FROM UNNEST(

ARRAY<STRUCT<sensor_id INT64, ts TIMESTAMP, temp FLOAT64>>[

(1, TIMESTAMP '2020-01-01 12:00:00.063', 37.1),

(1, TIMESTAMP '2020-01-01 12:00:15.024', 37.2),

(1, TIMESTAMP '2020-01-01 12:00:30.032', 37.3),

(2, TIMESTAMP '2020-01-01 12:00:01.001', 38.1),

(2, TIMESTAMP '2020-01-01 12:00:15.082', 38.2),

(2, TIMESTAMP '2020-01-01 12:00:31.009', 38.3)

]);

CREATE OR REPLACE TABLE mydataset.sensor_fuel_rates AS

SELECT * FROM UNNEST(

ARRAY<STRUCT<sensor_id INT64, ts TIMESTAMP, rate FLOAT64>>[

(1, TIMESTAMP '2020-01-01 12:00:11.016', 10.1),

(1, TIMESTAMP '2020-01-01 12:00:26.015', 10.2),

(1, TIMESTAMP '2020-01-01 12:00:41.014', 10.3),

(2, TIMESTAMP '2020-01-01 12:00:08.099', 11.1),

(2, TIMESTAMP '2020-01-01 12:00:23.087', 11.2),

(2, TIMESTAMP '2020-01-01 12:00:38.077', 11.3)

]);

Seguem-se os dados reais das tabelas:

SELECT * FROM mydataset.sensor_temperatures ORDER BY sensor_id, ts;

/*-----------+---------------------+------+

| sensor_id | ts | temp |

+-----------+---------------------+------+

| 1 | 2020-01-01 12:00:00 | 37.1 |

| 1 | 2020-01-01 12:00:15 | 37.2 |

| 1 | 2020-01-01 12:00:30 | 37.3 |

| 2 | 2020-01-01 12:00:01 | 38.1 |

| 2 | 2020-01-01 12:00:15 | 38.2 |

| 2 | 2020-01-01 12:00:31 | 38.3 |

+-----------+---------------------+------*/

SELECT * FROM mydataset.sensor_fuel_rates ORDER BY sensor_id, ts;

/*-----------+---------------------+------+

| sensor_id | ts | rate |

+-----------+---------------------+------+

| 1 | 2020-01-01 12:00:11 | 10.1 |

| 1 | 2020-01-01 12:00:26 | 10.2 |

| 1 | 2020-01-01 12:00:41 | 10.3 |

| 2 | 2020-01-01 12:00:08 | 11.1 |

| 2 | 2020-01-01 12:00:23 | 11.2 |

| 2 | 2020-01-01 12:00:38 | 11.3 |

+-----------+---------------------+------*/

Para verificar a taxa de consumo de combustível à temperatura comunicada por cada sensor, pode juntar as duas séries cronológicas.

Embora os dados nas duas séries cronológicas não estejam alinhados, são amostrados no mesmo intervalo (15 segundos). Por conseguinte, esses dados são uma boa opção para a junção em janelas. Use as funções de agrupamento por tempo para alinhar as datas/horas usadas como chaves de junção.

As consultas seguintes ilustram como cada data/hora pode ser atribuída a intervalos de 15 segundos usando a função TIMESTAMP_BUCKET:

SELECT *, TIMESTAMP_BUCKET(ts, INTERVAL 15 SECOND) ts_window

FROM mydataset.sensor_temperatures

ORDER BY sensor_id, ts;

/*-----------+---------------------+------+---------------------+

| sensor_id | ts | temp | ts_window |

+-----------+---------------------+------+---------------------+

| 1 | 2020-01-01 12:00:00 | 37.1 | 2020-01-01 12:00:00 |

| 1 | 2020-01-01 12:00:15 | 37.2 | 2020-01-01 12:00:15 |

| 1 | 2020-01-01 12:00:30 | 37.3 | 2020-01-01 12:00:30 |

| 2 | 2020-01-01 12:00:01 | 38.1 | 2020-01-01 12:00:00 |

| 2 | 2020-01-01 12:00:15 | 38.2 | 2020-01-01 12:00:15 |

| 2 | 2020-01-01 12:00:31 | 38.3 | 2020-01-01 12:00:30 |

+-----------+---------------------+------+---------------------*/

SELECT *, TIMESTAMP_BUCKET(ts, INTERVAL 15 SECOND) ts_window

FROM mydataset.sensor_fuel_rates

ORDER BY sensor_id, ts;

/*-----------+---------------------+------+---------------------+

| sensor_id | ts | rate | ts_window |

+-----------+---------------------+------+---------------------+

| 1 | 2020-01-01 12:00:11 | 10.1 | 2020-01-01 12:00:00 |

| 1 | 2020-01-01 12:00:26 | 10.2 | 2020-01-01 12:00:15 |

| 1 | 2020-01-01 12:00:41 | 10.3 | 2020-01-01 12:00:30 |

| 2 | 2020-01-01 12:00:08 | 11.1 | 2020-01-01 12:00:00 |

| 2 | 2020-01-01 12:00:23 | 11.2 | 2020-01-01 12:00:15 |

| 2 | 2020-01-01 12:00:38 | 11.3 | 2020-01-01 12:00:30 |

+-----------+---------------------+------+---------------------*/

Pode usar este conceito para juntar os dados da taxa de consumo de combustível com a temperatura comunicada por cada sensor:

SELECT

t1.sensor_id AS sensor_id,

t1.ts AS temp_ts,

t1.temp AS temp,

t2.ts AS rate_ts,

t2.rate AS rate

FROM mydataset.sensor_temperatures t1

LEFT JOIN mydataset.sensor_fuel_rates t2

ON TIMESTAMP_BUCKET(t1.ts, INTERVAL 15 SECOND) =

TIMESTAMP_BUCKET(t2.ts, INTERVAL 15 SECOND)

AND t1.sensor_id = t2.sensor_id

ORDER BY sensor_id, temp_ts;

/*-----------+---------------------+------+---------------------+------+

| sensor_id | temp_ts | temp | rate_ts | rate |

+-----------+---------------------+------+---------------------+------+

| 1 | 2020-01-01 12:00:00 | 37.1 | 2020-01-01 12:00:11 | 10.1 |

| 1 | 2020-01-01 12:00:15 | 37.2 | 2020-01-01 12:00:26 | 10.2 |

| 1 | 2020-01-01 12:00:30 | 37.3 | 2020-01-01 12:00:41 | 10.3 |

| 2 | 2020-01-01 12:00:01 | 38.1 | 2020-01-01 12:00:08 | 11.1 |

| 2 | 2020-01-01 12:00:15 | 38.2 | 2020-01-01 12:00:23 | 11.2 |

| 2 | 2020-01-01 12:00:31 | 38.3 | 2020-01-01 12:00:38 | 11.3 |

+-----------+---------------------+------+---------------------+------*/

AS OF aderir

Para esta secção, use a tabela mydataset.sensor_temperatures e crie uma nova tabela, mydataset.sensor_location.

A tabela mydataset.sensor_temperatures contém dados de temperatura de diferentes sensores, comunicados a cada 15 segundos:

SELECT * FROM mydataset.sensor_temperatures ORDER BY sensor_id, ts;

/*-----------+---------------------+------+

| sensor_id | ts | temp |

+-----------+---------------------+------+

| 1 | 2020-01-01 12:00:00 | 37.1 |

| 1 | 2020-01-01 12:00:15 | 37.2 |

| 1 | 2020-01-01 12:00:30 | 37.3 |

| 2 | 2020-01-01 12:00:45 | 38.1 |

| 2 | 2020-01-01 12:01:01 | 38.2 |

| 2 | 2020-01-01 12:01:15 | 38.3 |

+-----------+---------------------+------*/

Para criar mydataset.sensor_location, execute a seguinte consulta:

CREATE OR REPLACE TABLE mydataset.sensor_locations AS

SELECT * FROM UNNEST(

ARRAY<STRUCT<sensor_id INT64, ts TIMESTAMP, location GEOGRAPHY>>[

(1, TIMESTAMP '2020-01-01 11:59:47.063', ST_GEOGPOINT(-122.022, 37.406)),

(1, TIMESTAMP '2020-01-01 12:00:08.185', ST_GEOGPOINT(-122.021, 37.407)),

(1, TIMESTAMP '2020-01-01 12:00:28.032', ST_GEOGPOINT(-122.020, 37.405)),

(2, TIMESTAMP '2020-01-01 07:28:41.239', ST_GEOGPOINT(-122.390, 37.790))

]);

/*-----------+---------------------+------------------------+

| sensor_id | ts | location |

+-----------+---------------------+------------------------+

| 1 | 2020-01-01 11:59:47 | POINT(-122.022 37.406) |

| 1 | 2020-01-01 12:00:08 | POINT(-122.021 37.407) |

| 1 | 2020-01-01 12:00:28 | POINT(-122.02 37.405) |

| 2 | 2020-01-01 07:28:41 | POINT(-122.39 37.79) |

+-----------+---------------------+------------------------*/

Agora, associe dados de mydataset.sensor_temperatures a dados de

mydataset.sensor_location.

Neste cenário, não pode usar uma junção com janelas, uma vez que os dados de temperatura e a data de localização não são comunicados no mesmo intervalo.

Uma forma de o fazer no BigQuery é transformar os dados de data/hora num intervalo, usando o tipo de dados RANGE. O intervalo representa a validade temporal de uma linha, indicando a hora de início e de fim para a qual a linha é válida.

Use a função de janela LEAD para encontrar o ponto de dados seguinte na série cronológica, relativamente ao ponto de dados atual, que também é o limite final da validade temporal da linha atual. As consultas seguintes demonstram isto, convertendo dados de localização

em intervalos de validade:

WITH locations_ranges AS (

SELECT

sensor_id,

RANGE(ts, LEAD(ts) OVER (PARTITION BY sensor_id ORDER BY ts ASC)) AS ts_range,

location

FROM mydataset.sensor_locations

)

SELECT * FROM locations_ranges ORDER BY sensor_id, ts_range;

/*-----------+--------------------------------------------+------------------------+

| sensor_id | ts_range | location |

+-----------+--------------------------------------------+------------------------+

| 1 | [2020-01-01 11:59:47, 2020-01-01 12:00:08) | POINT(-122.022 37.406) |

| 1 | [2020-01-01 12:00:08, 2020-01-01 12:00:28) | POINT(-122.021 37.407) |

| 1 | [2020-01-01 12:00:28, UNBOUNDED) | POINT(-122.02 37.405) |

| 2 | [2020-01-01 07:28:41, UNBOUNDED) | POINT(-122.39 37.79) |

+-----------+--------------------------------------------+------------------------*/

Agora, pode juntar os dados de temperaturas (à esquerda) com os dados de localização (à direita):

WITH locations_ranges AS (

SELECT

sensor_id,

RANGE(ts, LEAD(ts) OVER (PARTITION BY sensor_id ORDER BY ts ASC)) AS ts_range,

location

FROM mydataset.sensor_locations

)

SELECT

t1.sensor_id AS sensor_id,

t1.ts AS temp_ts,

t1.temp AS temp,

t2.location AS location

FROM mydataset.sensor_temperatures t1

LEFT JOIN locations_ranges t2

ON RANGE_CONTAINS(t2.ts_range, t1.ts)

AND t1.sensor_id = t2.sensor_id

ORDER BY sensor_id, temp_ts;

/*-----------+---------------------+------+------------------------+

| sensor_id | temp_ts | temp | location |

+-----------+---------------------+------+------------------------+

| 1 | 2020-01-01 12:00:00 | 37.1 | POINT(-122.022 37.406) |

| 1 | 2020-01-01 12:00:15 | 37.2 | POINT(-122.021 37.407) |

| 1 | 2020-01-01 12:00:30 | 37.3 | POINT(-122.02 37.405) |

| 2 | 2020-01-01 12:00:01 | 38.1 | POINT(-122.39 37.79) |

| 2 | 2020-01-01 12:00:15 | 38.2 | POINT(-122.39 37.79) |

| 2 | 2020-01-01 12:00:31 | 38.3 | POINT(-122.39 37.79) |

+-----------+---------------------+------+------------------------*/

Combine e divida dados de intervalos

Nesta secção, combine dados de intervalos que tenham intervalos sobrepostos e divida os dados de intervalos em intervalos mais pequenos.

Combine dados de intervalos

As tabelas com valores de intervalo podem ter intervalos sobrepostos. Na seguinte consulta, os intervalos de tempo capturam o estado dos sensores em intervalos de aproximadamente 5 minutos:

CREATE OR REPLACE TABLE mydataset.sensor_metrics AS

SELECT * FROM UNNEST(

ARRAY<STRUCT<sensor_id INT64, duration RANGE<DATETIME>, flow INT64, spins INT64>>[

(1, RANGE<DATETIME> "[2020-01-01 12:00:01, 2020-01-01 12:05:23)", 10, 1),

(1, RANGE<DATETIME> "[2020-01-01 12:05:12, 2020-01-01 12:10:46)", 10, 20),

(1, RANGE<DATETIME> "[2020-01-01 12:10:27, 2020-01-01 12:15:56)", 11, 4),

(1, RANGE<DATETIME> "[2020-01-01 12:16:00, 2020-01-01 12:20:58)", 11, 9),

(1, RANGE<DATETIME> "[2020-01-01 12:20:33, 2020-01-01 12:25:08)", 11, 8),

(2, RANGE<DATETIME> "[2020-01-01 12:00:19, 2020-01-01 12:05:08)", 21, 31),

(2, RANGE<DATETIME> "[2020-01-01 12:05:08, 2020-01-01 12:10:30)", 21, 2),

(2, RANGE<DATETIME> "[2020-01-01 12:10:22, 2020-01-01 12:15:42)", 21, 10)

]);

A consulta seguinte na tabela mostra vários intervalos sobrepostos:

SELECT * FROM mydataset.sensor_metrics;

/*-----------+--------------------------------------------+------+-------+

| sensor_id | duration | flow | spins |

+-----------+--------------------------------------------+------+-------+

| 1 | [2020-01-01 12:00:01, 2020-01-01 12:05:23) | 10 | 1 |

| 1 | [2020-01-01 12:05:12, 2020-01-01 12:10:46) | 10 | 20 |

| 1 | [2020-01-01 12:10:27, 2020-01-01 12:15:56) | 11 | 4 |

| 1 | [2020-01-01 12:16:00, 2020-01-01 12:20:58) | 11 | 9 |

| 1 | [2020-01-01 12:20:33, 2020-01-01 12:25:08) | 11 | 8 |

| 2 | [2020-01-01 12:00:19, 2020-01-01 12:05:08) | 21 | 31 |

| 2 | [2020-01-01 12:05:08, 2020-01-01 12:10:30) | 21 | 2 |

| 2 | [2020-01-01 12:10:22, 2020-01-01 12:15:42) | 21 | 10 |

+-----------+--------------------------------------------+------+-------*/

Para alguns dos intervalos sobrepostos, o valor na coluna flow é o mesmo.

Por exemplo, as linhas 1 e 2 sobrepõem-se e também têm as mesmas leituras de flow. Pode combinar estas duas linhas para reduzir o número de linhas na tabela. Pode

usar a função de tabela RANGE_SESSIONIZE para encontrar intervalos que se sobreponham

a cada linha e fornecer uma coluna session_range adicional que contenha um

intervalo que seja a união de todos os intervalos que se sobrepõem. Para apresentar os intervalos de sessões de cada linha, execute a seguinte consulta:

SELECT sensor_id, session_range, flow

FROM RANGE_SESSIONIZE(

# Input data.

(SELECT sensor_id, duration, flow FROM mydataset.sensor_metrics),

# Range column.

"duration",

# Partitioning columns. Ranges are sessionized only within these partitions.

["sensor_id", "flow"],

# Sessionize mode.

"OVERLAPS")

ORDER BY sensor_id, session_range;

/*-----------+--------------------------------------------+------+

| sensor_id | session_range | flow |

+-----------+--------------------------------------------+------+

| 1 | [2020-01-01 12:00:01, 2020-01-01 12:10:46) | 10 |

| 1 | [2020-01-01 12:00:01, 2020-01-01 12:10:46) | 10 |

| 1 | [2020-01-01 12:10:27, 2020-01-01 12:15:56) | 11 |

| 1 | [2020-01-01 12:16:00, 2020-01-01 12:25:08) | 11 |

| 1 | [2020-01-01 12:16:00, 2020-01-01 12:25:08) | 11 |

| 2 | [2020-01-01 12:00:19, 2020-01-01 12:05:08) | 21 |

| 2 | [2020-01-01 12:05:08, 2020-01-01 12:15:42) | 21 |

| 2 | [2020-01-01 12:05:08, 2020-01-01 12:15:42) | 21 |

+-----------+--------------------------------------------+------*/

Tenha em atenção que, para sensor_id com o valor 2, o limite final da primeira linha tem o mesmo valor de data/hora que o limite inicial da segunda linha. No entanto, uma vez que os limites finais são exclusivos, não se sobrepõem (apenas se encontram) e, por isso, não estavam nos mesmos intervalos de sessões. Se quiser colocar estas duas linhas nos mesmos intervalos de sessões, use o modo MEETS de divisão em sessões.

Para combinar os intervalos, agrupe os resultados por session_range e pelas colunas de partição (sensor_id e flow):

SELECT sensor_id, session_range, flow

FROM RANGE_SESSIONIZE(

(SELECT sensor_id, duration, flow FROM mydataset.sensor_metrics),

"duration",

["sensor_id", "flow"],

"OVERLAPS")

GROUP BY sensor_id, session_range, flow

ORDER BY sensor_id, session_range;

/*-----------+--------------------------------------------+------+

| sensor_id | session_range | flow |

+-----------+--------------------------------------------+------+

| 1 | [2020-01-01 12:00:01, 2020-01-01 12:10:46) | 10 |

| 1 | [2020-01-01 12:10:27, 2020-01-01 12:15:56) | 11 |

| 1 | [2020-01-01 12:16:00, 2020-01-01 12:25:08) | 11 |

| 2 | [2020-01-01 12:00:19, 2020-01-01 12:05:08) | 21 |

| 2 | [2020-01-01 12:05:08, 2020-01-01 12:15:42) | 21 |

+-----------+--------------------------------------------+------*/

Por último, adicione a coluna spins aos dados da sessão agregando-a através de

SUM.

SELECT sensor_id, session_range, flow, SUM(spins) as spins

FROM RANGE_SESSIONIZE(

TABLE mydataset.sensor_metrics,

"duration",

["sensor_id", "flow"],

"OVERLAPS")

GROUP BY sensor_id, session_range, flow

ORDER BY sensor_id, session_range;

/*-----------+--------------------------------------------+------+-------+

| sensor_id | session_range | flow | spins |

+-----------+--------------------------------------------+------+-------+

| 1 | [2020-01-01 12:00:01, 2020-01-01 12:10:46) | 10 | 21 |

| 1 | [2020-01-01 12:10:27, 2020-01-01 12:15:56) | 11 | 4 |

| 1 | [2020-01-01 12:16:00, 2020-01-01 12:25:08) | 11 | 17 |

| 2 | [2020-01-01 12:00:19, 2020-01-01 12:05:08) | 21 | 31 |

| 2 | [2020-01-01 12:05:08, 2020-01-01 12:15:42) | 21 | 12 |

+-----------+--------------------------------------------+------+-------*/

Divida os dados de intervalo

Também pode dividir um intervalo em intervalos mais pequenos. Para este exemplo, use a seguinte tabela com dados de intervalo:

/*-----------+--------------------------+------+-------+

| sensor_id | duration | flow | spins |

+-----------+--------------------------+------+-------+

| 1 | [2020-01-01, 2020-12-31) | 10 | 21 |

| 1 | [2021-01-01, 2021-12-31) | 11 | 4 |

| 2 | [2020-04-15, 2021-04-15) | 21 | 31 |

| 2 | [2021-04-15, 2021-04-15) | 21 | 12 |

+-----------+--------------------------+------+-------*/

Agora, divida os intervalos originais em intervalos de 3 meses:

WITH sensor_data AS (

SELECT * FROM UNNEST(

ARRAY<STRUCT<sensor_id INT64, duration RANGE<DATE>, flow INT64, spins INT64>>[

(1, RANGE<DATE> "[2020-01-01, 2020-12-31)", 10, 21),

(1, RANGE<DATE> "[2021-01-01, 2021-12-31)", 11, 4),

(2, RANGE<DATE> "[2020-04-15, 2021-04-15)", 21, 31),

(2, RANGE<DATE> "[2021-04-15, 2022-04-15)", 21, 12)

])

)

SELECT sensor_id, expanded_range, flow, spins

FROM sensor_data, UNNEST(GENERATE_RANGE_ARRAY(duration, INTERVAL 3 MONTH)) AS expanded_range;

/*-----------+--------------------------+------+-------+

| sensor_id | expanded_range | flow | spins |

+-----------+--------------------------+------+-------+

| 1 | [2020-01-01, 2020-04-01) | 10 | 21 |

| 1 | [2020-04-01, 2020-07-01) | 10 | 21 |

| 1 | [2020-07-01, 2020-10-01) | 10 | 21 |

| 1 | [2020-10-01, 2020-12-31) | 10 | 21 |

| 1 | [2021-01-01, 2021-04-01) | 11 | 4 |

| 1 | [2021-04-01, 2021-07-01) | 11 | 4 |

| 1 | [2021-07-01, 2021-10-01) | 11 | 4 |

| 1 | [2021-10-01, 2021-12-31) | 11 | 4 |

| 2 | [2020-04-15, 2020-07-15) | 21 | 31 |

| 2 | [2020-07-15, 2020-10-15) | 21 | 31 |

| 2 | [2020-10-15, 2021-01-15) | 21 | 31 |

| 2 | [2021-01-15, 2021-04-15) | 21 | 31 |

| 2 | [2021-04-15, 2021-07-15) | 21 | 12 |

| 2 | [2021-07-15, 2021-10-15) | 21 | 12 |

| 2 | [2021-10-15, 2022-01-15) | 21 | 12 |

| 2 | [2022-01-15, 2022-04-15) | 21 | 12 |

+-----------+--------------------------+------+-------*/

Na consulta anterior, cada intervalo original foi dividido em intervalos mais pequenos, com a largura definida como INTERVAL 3 MONTH. No entanto, os intervalos de 3 meses não estão alinhados com uma origem comum. Para alinhar estes intervalos a uma origem comum

2020-01-01, execute a seguinte consulta:

WITH sensor_data AS (

SELECT * FROM UNNEST(

ARRAY<STRUCT<sensor_id INT64, duration RANGE<DATE>, flow INT64, spins INT64>>[

(1, RANGE<DATE> "[2020-01-01, 2020-12-31)", 10, 21),

(1, RANGE<DATE> "[2021-01-01, 2021-12-31)", 11, 4),

(2, RANGE<DATE> "[2020-04-15, 2021-04-15)", 21, 31),

(2, RANGE<DATE> "[2021-04-15, 2022-04-15)", 21, 12)

])

)

SELECT sensor_id, expanded_range, flow, spins

FROM sensor_data

JOIN UNNEST(GENERATE_RANGE_ARRAY(RANGE<DATE> "[2020-01-01, 2022-12-31)", INTERVAL 3 MONTH)) AS expanded_range

ON RANGE_OVERLAPS(duration, expanded_range);

/*-----------+--------------------------+------+-------+

| sensor_id | expanded_range | flow | spins |

+-----------+--------------------------+------+-------+

| 1 | [2020-01-01, 2020-04-01) | 10 | 21 |

| 1 | [2020-04-01, 2020-07-01) | 10 | 21 |

| 1 | [2020-07-01, 2020-10-01) | 10 | 21 |

| 1 | [2020-10-01, 2021-01-01) | 10 | 21 |

| 1 | [2021-01-01, 2021-04-01) | 11 | 4 |

| 1 | [2021-04-01, 2021-07-01) | 11 | 4 |

| 1 | [2021-07-01, 2021-10-01) | 11 | 4 |

| 1 | [2021-10-01, 2022-01-01) | 11 | 4 |

| 2 | [2020-04-01, 2020-07-01) | 21 | 31 |

| 2 | [2020-07-01, 2020-10-01) | 21 | 31 |

| 2 | [2020-10-01, 2021-01-01) | 21 | 31 |

| 2 | [2021-01-01, 2021-04-01) | 21 | 31 |

| 2 | [2021-04-01, 2021-07-01) | 21 | 31 |

| 2 | [2021-04-01, 2021-07-01) | 21 | 12 |

| 2 | [2021-07-01, 2021-10-01) | 21 | 12 |

| 2 | [2021-10-01, 2022-01-01) | 21 | 12 |

| 2 | [2022-01-01, 2022-04-01) | 21 | 12 |

| 2 | [2022-04-01, 2022-07-01) | 21 | 12 |

+-----------+--------------------------+------+-------*/

Na consulta anterior, a linha com o intervalo [2020-04-15, 2021-04-15) é dividida em 5 intervalos, começando pelo intervalo [2020-04-01, 2020-07-01). Tenha em atenção que o limite de início estende-se agora para além do limite de início original, de modo a alinhar-se com a origem comum. Se não quiser que o limite inicial se estenda para além do limite inicial original, pode restringir a condição:JOIN

WITH sensor_data AS (

SELECT * FROM UNNEST(

ARRAY<STRUCT<sensor_id INT64, duration RANGE<DATE>, flow INT64, spins INT64>>[

(1, RANGE<DATE> "[2020-01-01, 2020-12-31)", 10, 21),

(1, RANGE<DATE> "[2021-01-01, 2021-12-31)", 11, 4),

(2, RANGE<DATE> "[2020-04-15, 2021-04-15)", 21, 31),

(2, RANGE<DATE> "[2021-04-15, 2022-04-15)", 21, 12)

])

)

SELECT sensor_id, expanded_range, flow, spins

FROM sensor_data

JOIN UNNEST(GENERATE_RANGE_ARRAY(RANGE<DATE> "[2020-01-01, 2022-12-31)", INTERVAL 3 MONTH)) AS expanded_range

ON RANGE_CONTAINS(duration, RANGE_START(expanded_range));

/*-----------+--------------------------+------+-------+

| sensor_id | expanded_range | flow | spins |

+-----------+--------------------------+------+-------+

| 1 | [2020-01-01, 2020-04-01) | 10 | 21 |

| 1 | [2020-04-01, 2020-07-01) | 10 | 21 |

| 1 | [2020-07-01, 2020-10-01) | 10 | 21 |

| 1 | [2020-10-01, 2021-01-01) | 10 | 21 |

| 1 | [2021-01-01, 2021-04-01) | 11 | 4 |

| 1 | [2021-04-01, 2021-07-01) | 11 | 4 |

| 1 | [2021-07-01, 2021-10-01) | 11 | 4 |

| 1 | [2021-10-01, 2022-01-01) | 11 | 4 |

| 2 | [2020-07-01, 2020-10-01) | 21 | 31 |

| 2 | [2020-10-01, 2021-01-01) | 21 | 31 |

| 2 | [2021-01-01, 2021-04-01) | 21 | 31 |

| 2 | [2021-04-01, 2021-07-01) | 21 | 31 |

| 2 | [2021-07-01, 2021-10-01) | 21 | 12 |

| 2 | [2021-10-01, 2022-01-01) | 21 | 12 |

| 2 | [2022-01-01, 2022-04-01) | 21 | 12 |

| 2 | [2022-04-01, 2022-07-01) | 21 | 12 |

+-----------+--------------------------+------+-------*/

Agora, vê que o intervalo [2020-04-15, 2021-04-15) foi dividido em 4 intervalos, começando pelo intervalo [2020-07-01, 2020-10-01).

Práticas recomendadas para armazenar dados

Ao armazenar dados de séries cronológicas, é importante ter em conta os padrões de consulta usados nas tabelas onde os dados são armazenados. Normalmente, quando consulta dados de séries cronológicas, pode filtrar os dados por um intervalo de tempo específico.

Para otimizar estes padrões de utilização, recomenda-se que armazene dados de séries cronológicas em tabelas particionadas, com dados particionados pela coluna de tempo ou tempo de carregamento. Isto pode melhorar significativamente o desempenho do tempo de consulta dos dados de séries cronológicas, uma vez que permite ao BigQuery remover partições que não contêm dados consultados.

Pode ativar a agrupagem na hora, no intervalo ou numa das colunas de partição para melhorar ainda mais o desempenho do tempo de consulta.