Sensitive Data Protection을 사용하여 BigQuery 데이터 스캔

민감한 정보의 보호와 관리는 먼저 해당 정보가 어디에 있는지 파악하는 것에서 출발합니다. 이 위치를 파악하고 있으면 신용카드 번호, 의료 정보, 주민등록번호, 운전면허증 번호, 주소, 본명, 회사 보안 비밀과 같은 민감한 세부정보가 유출되는 위험을 줄일 수 있습니다. 또한 주기적으로 데이터를 검사하면 규정 준수 요구사항을 충족할 수 있으며 사용에 따라 데이터가 증가하고 변경될 때 권장사항을 따르도록 할 수 있습니다. 규정 준수 요구사항을 충족하려면 Sensitive Data Protection을 사용하여 BigQuery 테이블을 검사하고 민감한 정보를 보호합니다.

BigQuery 데이터를 스캔하는 방법에는 두 가지가 있습니다.

민감한 정보 프로파일링. Sensitive Data Protection은 조직, 폴더 또는 프로젝트 전체에서 BigQuery 데이터에 대한 프로필을 생성할 수 있습니다. 데이터 프로필은 테이블에 대한 측정항목과 메타데이터를 포함하며 민감한 정보와 고위험 데이터를 저장할 위치를 결정하는 데 도움이 됩니다. Sensitive Data Protection은 프로젝트, 테이블, 열 수준에서 이러한 측정항목을 보고합니다. 자세한 내용은 BigQuery 데이터의 데이터 프로필을 참조하세요.

주문형 검사. Sensitive Data Protection은 단일 테이블 또는 열 하위 집합에서 심층적인 검사를 수행하고 발견 항목을 셀 수준으로 보고할 수 있습니다. 이러한 종류의 검사를 사용하면 테이블 셀 내의 신용카드 번호의 정확한 위치와 같은 특정 데이터 유형의 개별 인스턴스를 식별할 수 있습니다.Google Cloud 콘솔의 Sensitive Data Protection 페이지, Google Cloud 콘솔의 BigQuery 페이지 또는 DLP API를 통한 프로그래매틱 방식으로 주문형 검사를 수행할 수 있습니다.

이 페이지에서는 Google Cloud 콘솔의 BigQuery 페이지를 통해 주문형 검사를 수행하는 방법을 설명합니다.

Sensitive Data Protection은 고객이 Google Cloud 민감한 정보를 대규모로 식별하고 보호할 수 있는 완전 관리형 서비스입니다. Sensitive Data Protection은 150개가 넘는 사전 정의된 감지기를 사용하여 패턴, 형식, 체크섬을 식별합니다. Sensitive Data Protection은 또한 고객 데이터를 복제하지 않고 마스킹, 토큰화, 가명처리, 날짜 이동 등 데이터를 익명화할 수 있는 도구 모음도 제공합니다.

Sensitive Data Protection에 대해 자세히 알아보려면 Sensitive Data Protection 문서를 참고하세요.

시작하기 전에

- Sensitive Data Protection 가격 책정 및 Sensitive Data Protection 비용을 제어하는 방법을 숙지합니다.

Sensitive Data Protection 작업을 실행할 수 있도록 Sensitive Data Protection 작업을 만드는 사용자에게 사전 정의된 Sensitive Data Protection IAM 역할 또는 충분한 권한이 부여되어 있는지 확인합니다.

Google Cloud 콘솔을 사용하여 BigQuery 데이터 스캔

BigQuery 데이터를 스캔하려면 테이블을 분석하는 Sensitive Data Protection 작업을 만들어야 합니다. BigQuery Google Cloud 콘솔에서 Sensitive Data Protection으로 스캔 옵션을 사용하여 BigQuery 테이블을 빠르게 스캔할 수 있습니다.

Sensitive Data Protection을 사용하여 BigQuery 테이블을 스캔하려면 다음 안내를 따르세요.

Google Cloud 콘솔에서 BigQuery 페이지로 이동합니다.

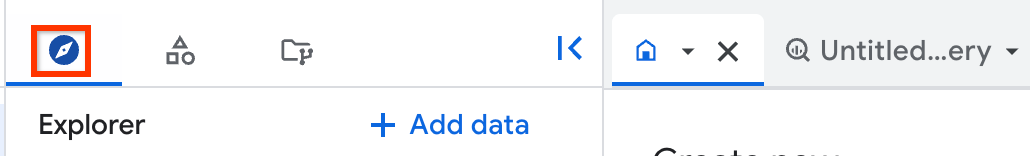

왼쪽 창에서 탐색기를 클릭합니다.

왼쪽 창이 표시되지 않으면 왼쪽 창 펼치기를 클릭하여 창을 엽니다.

탐색기 창에서 프로젝트를 펼치고 데이터 세트를 클릭한 다음 데이터 세트를 클릭합니다.

개요 > 테이블을 클릭한 다음 테이블을 선택합니다.

열기 > Sensitive Data Protection으로 스캔을 클릭합니다. Sensitive Data Protection 작업 생성 페이지가 새 탭에서 열립니다.

1단계: 입력 데이터 선택에서 작업 ID를 입력합니다. 위치 섹션의 값이 자동으로 생성됩니다. 또한 샘플링 섹션은 데이터에 대해 샘플 스캔을 실행하도록 자동으로 구성되지만 필요에 따라 설정을 조정할 수 있습니다.

계속을 클릭합니다.

선택사항: 2단계: 감지 구성에서는

infoTypes라고 하는 찾을 데이터 유형을 구성할 수 있습니다.다음 중 하나를 수행합니다.

- 사전 정의된

infoTypes목록에서 선택하려면 infoType 관리를 클릭합니다. 그런 다음 검색하려는 infoType을 선택합니다. - 기존 검사 템플릿을 사용하려면 템플릿 이름 필드에 템플릿의 전체 리소스 이름을 입력합니다.

infoTypes에 대한 자세한 내용은 Sensitive Data Protection 문서의 InfoTypes 및 infoType 감지기를 참고하세요.- 사전 정의된

계속을 클릭합니다.

선택사항: 3단계: 작업 추가에서는 BigQuery에 저장을 사용 설정하여 Sensitive Data Protection 발견 항목을 BigQuery 테이블에 게시합니다. 발견 항목을 저장하지 않으면 완료된 작업에 발견 항목 수와

infoTypes에 대한 통계만 포함됩니다. BigQuery에 발견 항목을 저장하면 각 발견 항목의 정확한 위치와 신뢰도에 대한 세부정보가 저장됩니다.선택사항: BigQuery에 저장을 사용 설정한 경우 BigQuery에 저장 섹션에서 다음 정보를 입력합니다.

- 프로젝트 ID: 결과가 저장되는 프로젝트 ID입니다.

- 데이터 세트 ID: 결과를 저장하는 데이터 세트의 이름입니다.

- 선택사항: 테이블 ID: 결과를 저장하는 테이블의 이름입니다. 지정된 테이블 ID가 없으면 새 테이블에

dlp_googleapis_date_1234567890과 비슷한 기본 이름이 할당됩니다. 기존 테이블을 지정하면 여기에 발견 항목이 추가됩니다.

감지된 실제 콘텐츠를 포함하려면 인용 포함을 사용 설정합니다.

계속을 클릭합니다.

선택사항: 4단계: 일정에서 시간 범위 지정 또는 주기적인 일정으로 작업을 실행하는 트리거 만들기를 선택하여 시간 범위 또는 일정을 구성합니다.

계속을 클릭합니다.

선택사항: 검토 페이지에서 작업 세부정보를 검사합니다. 필요한 경우 이전 설정을 조정합니다.

만들기를 클릭합니다.

Sensitive Data Protection 작업이 완료되면 작업 세부정보 페이지로 리디렉션되고 이메일로 알림을 받습니다. 작업 세부정보 페이지에서 스캔 결과를 보거나 작업 완료 이메일에서 Sensitive Data Protection 작업 세부정보 페이지 링크를 클릭할 수 있습니다.

Sensitive Data Protection 발견 항목을 BigQuery에 게시한 경우 작업 세부정보 페이지에서 BigQuery에서 발견 항목 보기를 클릭하여 Google Cloud 콘솔에서 테이블을 엽니다. 그런 다음 테이블을 쿼리하고 발견 항목을 분석할 수 있습니다. BigQuery에서 결과를 쿼리하는 방법에 대한 자세한 내용은 Sensitive Data Protection 문서의 BigQuery에서 Sensitive Data Protection 발견 항목 쿼리를 참고하세요.

다음 단계

Sensitive Data Protection을 사용하여 BigQuery 및 기타 스토리지 저장소에서 민감한 정보를 검사하는 방법 자세히 알아보기

조직, 폴더 또는 프로젝트의 데이터 프로파일링 자세히 알아보기

Identity & Security 블로그 게시물 데이터 관리: Sensitive Data Protection을 사용하여 민감한 정보 익명화 및 난독화 읽어보기

Sensitive Data Protection 스캔에서 발견한 민감한 정보를 수정하거나 익명화하려면 다음을 참고하세요.

- 텍스트를 검사하여 민감한 정보 익명화

- Sensitive Data Protection 문서의 민감한 정보 익명화

- GoogleSQL의 AEAD 암호화 개념 - 테이블 내 개별 값 암호화에 대한 자세한 내용

- Cloud KMS 키로 데이터 보호 - Cloud KMS에서 BigQuery 테이블을 암호화하는 자체 암호화 키를 만들고 관리하는 방법에 대한 자세한 내용