使用 BigQuery JupyterLab 插件

如需针对此功能请求反馈或支持,请发送邮件至 bigquery-ide-plugin@google.com。

本文档介绍了如何安装和使用 BigQuery JupyterLab 插件来执行以下操作:

- 探索 BigQuery 数据。

- 使用 BigQuery DataFrames API。

- 将 BigQuery DataFrames 笔记本部署到 Cloud Composer。

BigQuery JupyterLab 插件包含 Dataproc JupyterLab 插件的所有功能,例如创建 Dataproc Serverless 运行时模板、启动和管理笔记本、使用 Apache Spark 进行开发、部署代码以及管理资源。

安装 BigQuery JupyterLab 插件

如需安装和使用 BigQuery JupyterLab 插件,请按照以下步骤操作:

在本地终端中,检查以确保您的系统上安装了 Python 3.8 或更高版本:

python3 --version在本地终端中,初始化 gcloud CLI:

gcloud init安装 Pipenv(一种 Python 虚拟环境工具):

pip3 install pipenv创建新的虚拟环境:

pipenv shell在新虚拟环境中安装 JupyterLab:

pipenv install jupyterlab安装 BigQuery JupyterLab 插件:

pipenv install bigquery-jupyter-plugin如果安装的 JupyterLab 版本低于 4.0.0,则启用插件扩展程序:

jupyter server extension enable bigquery_jupyter_plugin启动 JupyterLab:

jupyter labJupyterLab 会在浏览器中打开。

更新项目和区域设置

默认情况下,您的会话会在您运行 gcloud init 时设置的项目和区域中运行。如需更改会话的项目和区域设置,请执行以下操作:

- 在 JupyterLab 菜单中,依次点击设置 > Google BigQuery 设置。

您必须重启插件,所做的更改才会生效。

探索数据

如需在 JupyterLab 中处理 BigQuery 数据,请执行以下操作:

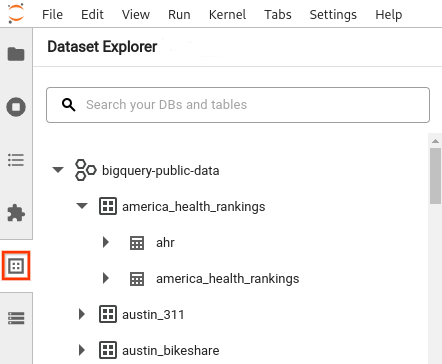

- 在 JupyterLab 边栏中,打开数据集资源管理器窗格:点击

数据集图标。

数据集图标。 如需展开项目,请在数据集资源管理器窗格中点击项目名称旁边的 展开箭头。

数据集资源管理器窗格会显示项目中位于您为会话配置的 BigQuery 区域中的所有数据集。您可以通过多种方式与项目和数据集互动:

- 如需查看数据集的相关信息,请点击相应数据集的名称。

- 要显示数据集中的所有表,请点击数据集旁边的 展开箭头。

- 如需查看表的相关信息,请点击表的名称。

- 如需更改项目或 BigQuery 区域,请更新您的设置。

执行笔记本

如需从 JupyterLab 查询 BigQuery 数据,请执行以下操作:

- 如需打开启动器页面,请依次点击文件 > 新启动器。

- 在 BigQuery 笔记本部分中,点击 BigQuery DataFrames 卡片。系统会打开一个新笔记本,其中介绍了如何开始使用 BigQuery DataFrames。

BigQuery DataFrames 笔记本支持在本地 Python 内核中进行 Python 开发。BigQuery DataFrames 操作在 BigQuery 上远程执行,但其余代码在本地计算机上执行。在 BigQuery 中执行操作时,查询作业 ID 和作业链接会显示在代码单元下方。

- 如需在 Google Cloud 控制台中查看作业,请点击打开作业。

部署 BigQuery DataFrames 笔记本

您可以使用 Dataproc Serverless 运行时模板将 BigQuery DataFrames Notebook 部署到 Cloud Composer。您必须使用运行时版本 2.1 或更高版本。

- 在 JupyterLab 笔记本中,点击 calendar_month作业调度器。

- 对于作业名称,为作业输入一个唯一的名称。

- 在环境部分,输入要部署作业的 Cloud Composer 环境的名称。

- 如果您的笔记本已参数化,请添加参数。

- 输入无服务器运行时模板的名称。

- 如需处理笔记本执行故障,请为重试计数输入一个整数,为重试延迟输入一个值(以分钟为单位)。

选择要发送哪些执行通知,然后输入收件人。

系统会使用 Airflow SMTP 配置发送通知。

为笔记本选择时间表。

点击创建。

成功安排笔记本后,它会显示在所选 Cloud Composer 环境的预定作业列表中。

后续步骤

- 尝试学习 BigQuery DataFrames 快速入门。

- 详细了解 BigQuery DataFrames Python API。

- 使用 JupyterLab 进行 Dataproc 的无服务器批处理和笔记本会话。