Este tutorial ensina como usar um modelo de série temporal multivariada para prever o valor futuro de uma determinada coluna, com base no valor histórico de várias caraterísticas de entrada.

Este tutorial prevê um único intervalo temporal. Os valores previstos são calculados uma vez para cada ponto temporal nos dados de entrada.

Este tutorial usa dados do

bigquery-public-data.epa_historical_air_quality conjunto de dados público. Este conjunto de dados contém informações sobre partículas diárias (PM2.5), temperatura e velocidade do vento recolhidas em várias cidades dos EUA.

Crie um conjunto de dados

Crie um conjunto de dados do BigQuery para armazenar o seu modelo de ML.

Consola

Na Google Cloud consola, aceda à página BigQuery.

No painel Explorador, clique no nome do projeto.

Clique em Ver ações > Criar conjunto de dados

Na página Criar conjunto de dados, faça o seguinte:

Para o ID do conjunto de dados, introduza

bqml_tutorial.Em Tipo de localização, selecione Várias regiões e, de seguida, selecione EUA (várias regiões nos Estados Unidos).

Deixe as restantes predefinições como estão e clique em Criar conjunto de dados.

bq

Para criar um novo conjunto de dados, use o comando

bq mk

com a flag --location. Para uma lista completa de parâmetros possíveis, consulte a referência do comando bq mk --dataset.

Crie um conjunto de dados com o nome

bqml_tutorialcom a localização dos dados definida comoUSe uma descrição deBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Em vez de usar a flag

--dataset, o comando usa o atalho-d. Se omitir-de--dataset, o comando cria um conjunto de dados por predefinição.Confirme que o conjunto de dados foi criado:

bq ls

API

Chame o método datasets.insert

com um recurso de conjunto de dados definido.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

DataFrames do BigQuery

Antes de experimentar este exemplo, siga as instruções de configuração dos DataFrames do BigQuery no início rápido do BigQuery com os DataFrames do BigQuery. Para mais informações, consulte a documentação de referência do BigQuery DataFrames.

Para se autenticar no BigQuery, configure as Credenciais padrão da aplicação. Para mais informações, consulte o artigo Configure o ADC para um ambiente de desenvolvimento local.

Crie uma tabela de dados de entrada

Crie uma tabela de dados que possa usar para preparar e avaliar o modelo. Esta tabela combina colunas de várias tabelas no conjunto de dados bigquery-public-data.epa_historical_air_quality para fornecer dados meteorológicos diários. Também cria as seguintes colunas para usar como variáveis de entrada para o modelo:

date: a data da observaçãopm25o valor médio de PM2,5 para cada diawind_speed: a velocidade média do vento para cada diatemperature: a temperatura mais elevada de cada dia

Na seguinte consulta GoogleSQL, a cláusula FROM bigquery-public-data.epa_historical_air_quality.*_daily_summary indica que está a consultar as tabelas *_daily_summary no conjunto de dados epa_historical_air_quality. Estas tabelas são tabelas particionadas.

Siga estes passos para criar a tabela de dados de entrada:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

CREATE TABLE `bqml_tutorial.seattle_air_quality_daily` AS WITH pm25_daily AS ( SELECT avg(arithmetic_mean) AS pm25, date_local AS date FROM `bigquery-public-data.epa_historical_air_quality.pm25_nonfrm_daily_summary` WHERE city_name = 'Seattle' AND parameter_name = 'Acceptable PM2.5 AQI & Speciation Mass' GROUP BY date_local ), wind_speed_daily AS ( SELECT avg(arithmetic_mean) AS wind_speed, date_local AS date FROM `bigquery-public-data.epa_historical_air_quality.wind_daily_summary` WHERE city_name = 'Seattle' AND parameter_name = 'Wind Speed - Resultant' GROUP BY date_local ), temperature_daily AS ( SELECT avg(first_max_value) AS temperature, date_local AS date FROM `bigquery-public-data.epa_historical_air_quality.temperature_daily_summary` WHERE city_name = 'Seattle' AND parameter_name = 'Outdoor Temperature' GROUP BY date_local ) SELECT pm25_daily.date AS date, pm25, wind_speed, temperature FROM pm25_daily JOIN wind_speed_daily USING (date) JOIN temperature_daily USING (date);

Visualize os dados de entrada

Antes de criar o modelo, pode visualizar opcionalmente os dados de séries cronológicas de entrada para ter uma ideia da distribuição. Pode fazê-lo através do Looker Studio.

Siga estes passos para visualizar os dados de séries cronológicas:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

SELECT * FROM `bqml_tutorial.seattle_air_quality_daily`;

Quando a consulta estiver concluída, clique em Explorar dados > Explorar com o Looker Studio. O Looker Studio é aberto num novo separador. Conclua os seguintes passos no novo separador.

No Looker Studio, clique em Inserir > Gráfico de intervalos temporais.

No painel Gráfico, escolha o separador Configuração.

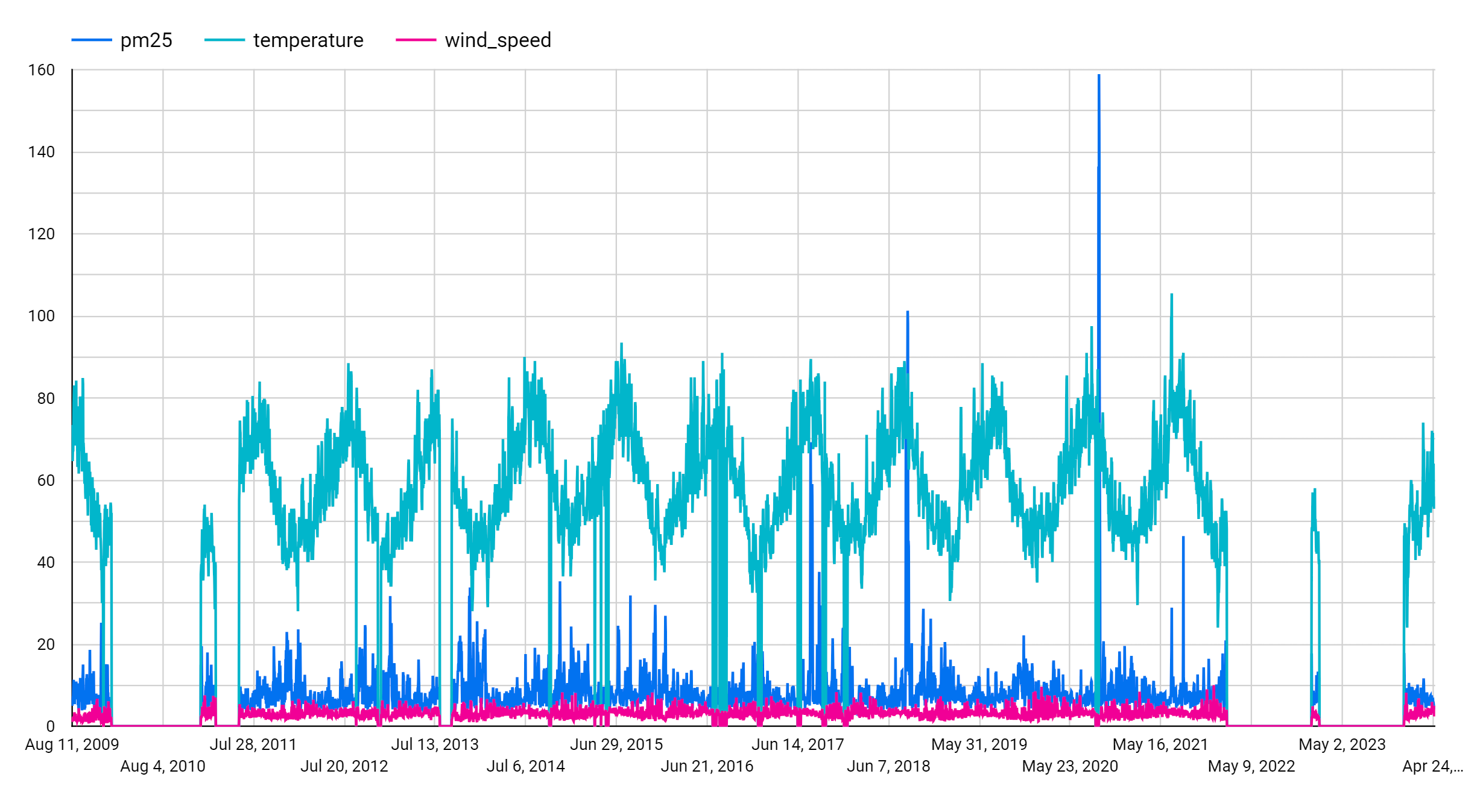

Na secção Métrica, adicione os campos pm25, temperature e wind_speed e remova a métrica Contagem de registos predefinida. O gráfico resultante tem um aspeto semelhante ao seguinte:

Analisando o gráfico, pode ver que a série temporal de entrada tem um padrão sazonal semanal.

Crie o modelo de séries cronológicas

Crie um modelo de séries cronológicas para prever valores de partículas, representados

pela coluna pm25, usando os valores das colunas pm25, wind_speed e temperature

como variáveis de entrada. Prepare o modelo com os dados de qualidade do ar da tabela bqml_tutorial.seattle_air_quality_daily, selecionando os dados recolhidos entre 1 de janeiro de 2012 e 31 de dezembro de 2020.

Na consulta seguinte, a cláusula OPTIONS(model_type='ARIMA_PLUS_XREG',

time_series_timestamp_col='date', ...) indica que está a criar um modelo ARIMA com regressores externos. A opção auto_arima da declaração CREATE MODEL tem como predefinição TRUE, pelo que o algoritmo auto.ARIMA

ajusta automaticamente os hiperparâmetros no modelo. O algoritmo

ajusta dezenas de modelos candidatos e escolhe o melhor modelo, que é o modelo

com o critério de informação de Akaike (AIC) mais baixo.

A opção

data_frequency

das declarações CREATE MODEL tem como predefinição AUTO_FREQUENCY, pelo que o processo de preparação infere automaticamente a frequência dos dados da série cronológica de entrada.

Siga estes passos para criar o modelo:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

CREATE OR REPLACE MODEL `bqml_tutorial.seattle_pm25_xreg_model` OPTIONS ( MODEL_TYPE = 'ARIMA_PLUS_XREG', time_series_timestamp_col = 'date', # Identifies the column that contains time points time_series_data_col = 'pm25') # Identifies the column to forecast AS SELECT date, # The column that contains time points pm25, # The column to forecast temperature, # Temperature input to use in forecasting wind_speed # Wind speed input to use in forecasting FROM `bqml_tutorial.seattle_air_quality_daily` WHERE date BETWEEN DATE('2012-01-01') AND DATE('2020-12-31');

A consulta demora cerca de 20 segundos a ser concluída. Depois, pode aceder ao modelo

seattle_pm25_xreg_model. Uma vez que a consulta usa uma declaraçãoCREATE MODELpara criar um modelo, não vê os resultados da consulta.

Avalie os modelos candidatos

Avalie os modelos de séries cronológicas através da função ML.ARIMA_EVALUATE. A função ML.ARIMA_EVALUATE mostra as métricas de avaliação de todos os modelos candidatos que foram avaliados durante o processo de otimização automática de hiperparâmetros.

Siga estes passos para avaliar o modelo:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

SELECT * FROM ML.ARIMA_EVALUATE(MODEL `bqml_tutorial.seattle_pm25_xreg_model`);

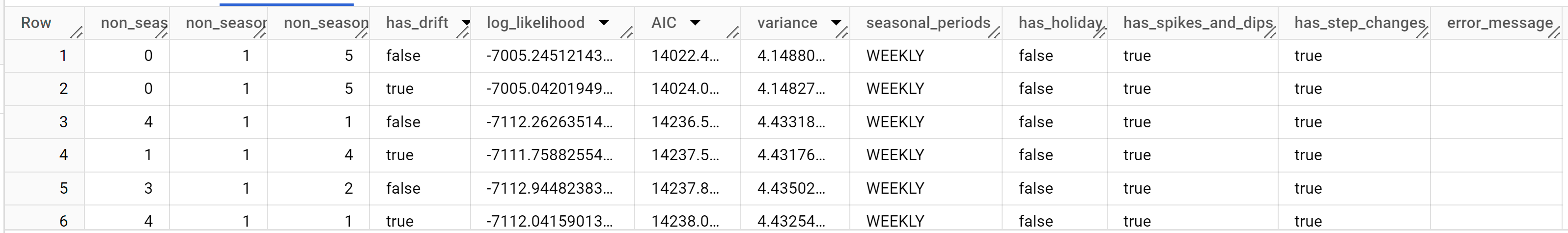

Os resultados devem ter um aspeto semelhante ao seguinte:

As colunas de saída

non_seasonal_p,non_seasonal_d,non_seasonal_qehas_driftdefinem um modelo ARIMA no pipeline de preparação. As colunas de saídalog_likelihood,AICevariancesão relevantes para o processo de ajuste do modelo ARIMA.O algoritmo

auto.ARIMAusa o teste KPSS para determinar o melhor valor paranon_seasonal_d, que, neste caso, é1. Quandonon_seasonal_dé1, o algoritmoauto.ARIMAprepara 42 modelos ARIMA candidatos diferentes em paralelo. Neste exemplo, todos os 42 modelos candidatos são válidos, pelo que a saída contém 42 linhas, uma para cada modelo ARIMA candidato. Nos casos em que alguns dos modelos não são válidos, são excluídos da saída. Estes modelos candidatos são devolvidos por ordem ascendente de AIC. O modelo na primeira linha tem o AIC mais baixo e é considerado o melhor modelo. O melhor modelo é guardado como o modelo final e é usado quando chama funções comoML.FORECASTno modelo.A coluna

seasonal_periodscontém informações sobre o padrão sazonal identificado nos dados de séries cronológicas. Não tem nada a ver com a modelagem ARIMA, pelo que tem o mesmo valor em todas as linhas de saída. Comunica um padrão semanal, o que concorda com os resultados que viu se optou por visualizar os dados de entrada.As colunas

has_holiday_effect,has_spikes_and_dipsehas_step_changesfornecem informações sobre os dados de séries cronológicas de entrada e não estão relacionadas com a modelagem ARIMA. Estas colunas são devolvidas porque o valor da opçãodecompose_time_seriesna declaraçãoCREATE MODELéTRUE. Estas colunas também têm os mesmos valores em todas as linhas de saída.A coluna

error_messagemostra os erros ocorridos durante o processo de ajuste.auto.ARIMAUm dos motivos possíveis para os erros é quando as colunasnon_seasonal_p,non_seasonal_d,non_seasonal_qehas_driftselecionadas não conseguem estabilizar a série cronológica. Para obter a mensagem de erro de todos os modelos candidatos, defina a opçãoshow_all_candidate_modelscomoTRUEquando criar o modelo.Para mais informações sobre as colunas de saída, consulte a função

ML.ARIMA_EVALUATE.

Inspecione os coeficientes do modelo

Inspeccione os coeficientes do modelo de séries cronológicas através da função ML.ARIMA_COEFFICIENTS.

Siga estes passos para obter os coeficientes do modelo:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

SELECT * FROM ML.ARIMA_COEFFICIENTS(MODEL `bqml_tutorial.seattle_pm25_xreg_model`);

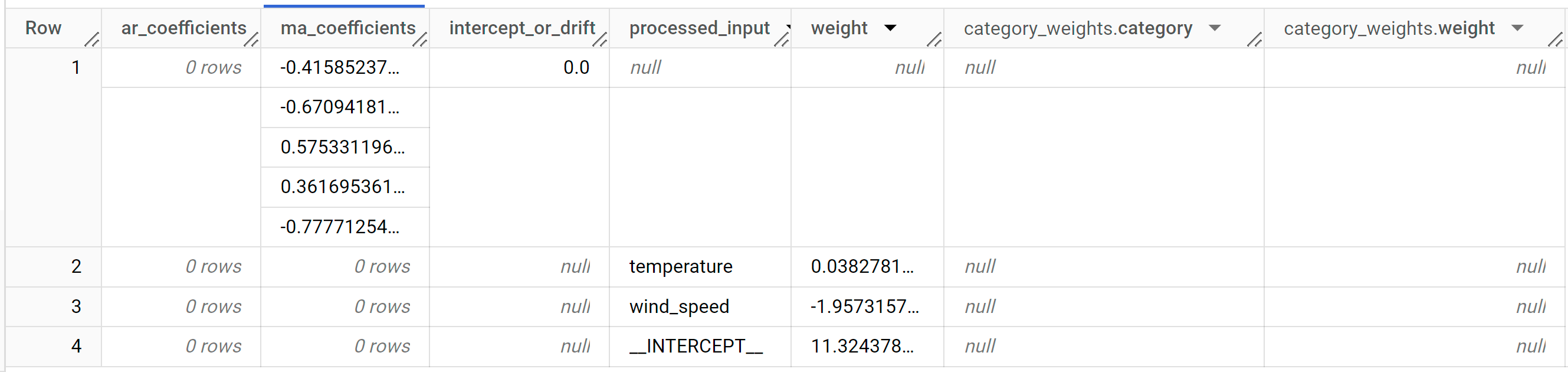

Os resultados devem ter um aspeto semelhante ao seguinte:

A coluna de saída

ar_coefficientsmostra os coeficientes do modelo da parte autorregressiva (AR) do modelo ARIMA. Da mesma forma, a colunama_coefficientsoutput mostra os coeficientes do modelo da parte de média móvel (MA) do modelo ARIMA. Ambas as colunas contêm valores de matriz, cujos comprimentos são iguais anon_seasonal_penon_seasonal_q, respetivamente. No resultado da funçãoML.ARIMA_EVALUATE, viu que o melhor modelo tem um valornon_seasonal_pde0e um valornon_seasonal_qde5. Por conseguinte, na saídaML.ARIMA_COEFFICIENTS, o valorar_coefficientsé uma matriz vazia e o valorma_coefficientsé uma matriz de 5 elementos. O valorintercept_or_drifté o termo constante no modelo ARIMA.As colunas de saída

processed_input,weightecategory_weightsmostram as ponderações de cada funcionalidade e a interceção no modelo de regressão linear. Se a funcionalidade for uma funcionalidade numérica, o peso encontra-se na colunaweight. Se a funcionalidade for uma funcionalidade categórica, o valorcategory_weightsé uma matriz de valores de estrutura, em que cada valor de estrutura contém o nome e o peso de uma determinada categoria.Para mais informações sobre as colunas de saída, consulte a função

ML.ARIMA_COEFFICIENTS.

Use o modelo para prever dados

Preveja valores de séries cronológicas futuras através da função ML.FORECAST.

Na consulta GoogleSQL seguinte, a cláusula STRUCT(30 AS horizon, 0.8 AS confidence_level)indica que a consulta prevê 30 pontos temporais futuros e gera um intervalo de previsão com um nível de confiança de 80%.

Siga estes passos para prever dados com o modelo:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

SELECT * FROM ML.FORECAST( MODEL `bqml_tutorial.seattle_pm25_xreg_model`, STRUCT(30 AS horizon, 0.8 AS confidence_level), ( SELECT date, temperature, wind_speed FROM `bqml_tutorial.seattle_air_quality_daily` WHERE date > DATE('2020-12-31') ));

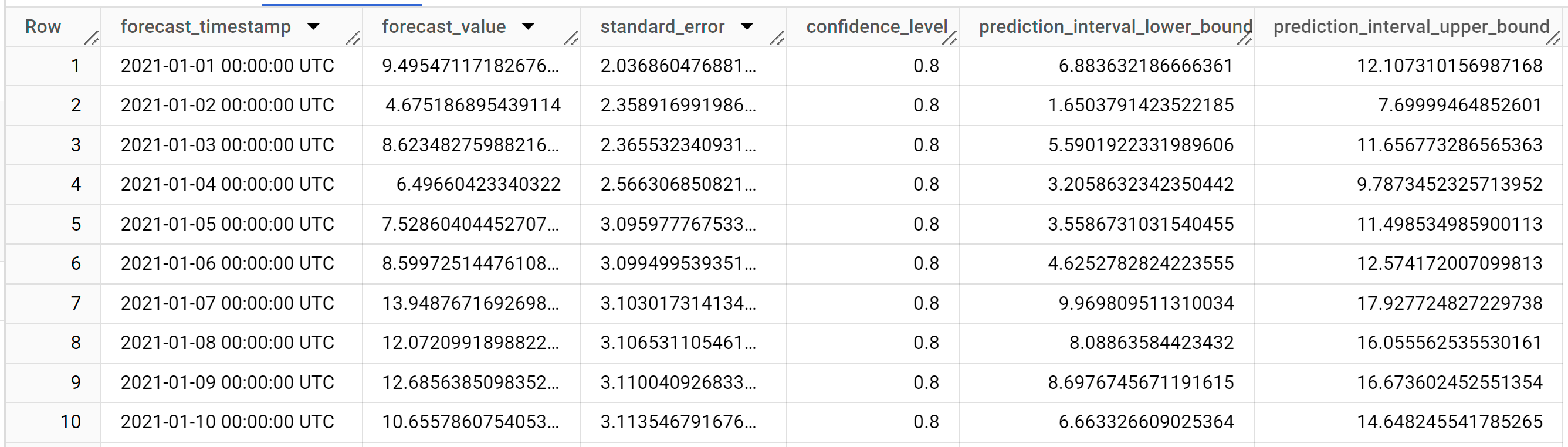

Os resultados devem ter um aspeto semelhante ao seguinte:

As linhas de saída estão por ordem cronológica do valor da coluna

forecast_timestamp. Na previsão de séries cronológicas, o intervalo de previsão, representado pelos valores das colunasprediction_interval_lower_boundeprediction_interval_upper_bound, é tão importante quanto o valor da colunaforecast_value. O valorforecast_valueé o ponto médio do intervalo de previsão. O intervalo de previsão depende dos valores das colunasstandard_erroreconfidence_level.Para mais informações sobre as colunas de saída, consulte a função

ML.FORECAST.

Avalie a precisão da previsão

Avalie a precisão da previsão do modelo através da função ML.EVALUATE.

Na seguinte consulta GoogleSQL, a segunda declaração SELECT fornece os dados com as funcionalidades futuras, que são usados para prever os valores futuros a comparar com os dados reais.

Siga estes passos para avaliar a precisão do modelo:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

SELECT * FROM ML.EVALUATE( MODEL `bqml_tutorial.seattle_pm25_xreg_model`, ( SELECT date, pm25, temperature, wind_speed FROM `bqml_tutorial.seattle_air_quality_daily` WHERE date > DATE('2020-12-31') ), STRUCT( TRUE AS perform_aggregation, 30 AS horizon));

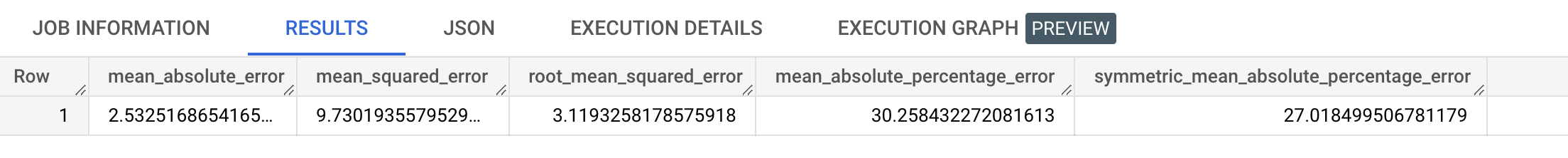

Os resultados devem ser semelhantes aos seguintes:

Para mais informações sobre as colunas de saída, consulte a função

ML.EVALUATE.

Explicar os resultados da previsão

Pode obter métricas de explicabilidade, além dos dados de previsão, usando a função ML.EXPLAIN_FORECAST. A função ML.EXPLAIN_FORECAST prevê

valores de séries cronológicas futuras e também devolve todos os componentes separados das

séries cronológicas.

Semelhante à função ML.FORECAST, a cláusula STRUCT(30 AS horizon, 0.8 AS confidence_level) usada na função ML.EXPLAIN_FORECAST indica que a consulta prevê 30 pontos temporais futuros e gera um intervalo de previsão com 80% de confiança.

Siga estes passos para explicar os resultados do modelo:

Na Google Cloud consola, aceda à página BigQuery.

No editor de consultas, cole a seguinte consulta e clique em Executar:

SELECT * FROM ML.EXPLAIN_FORECAST( MODEL `bqml_tutorial.seattle_pm25_xreg_model`, STRUCT(30 AS horizon, 0.8 AS confidence_level), ( SELECT date, temperature, wind_speed FROM `bqml_tutorial.seattle_air_quality_daily` WHERE date > DATE('2020-12-31') ));

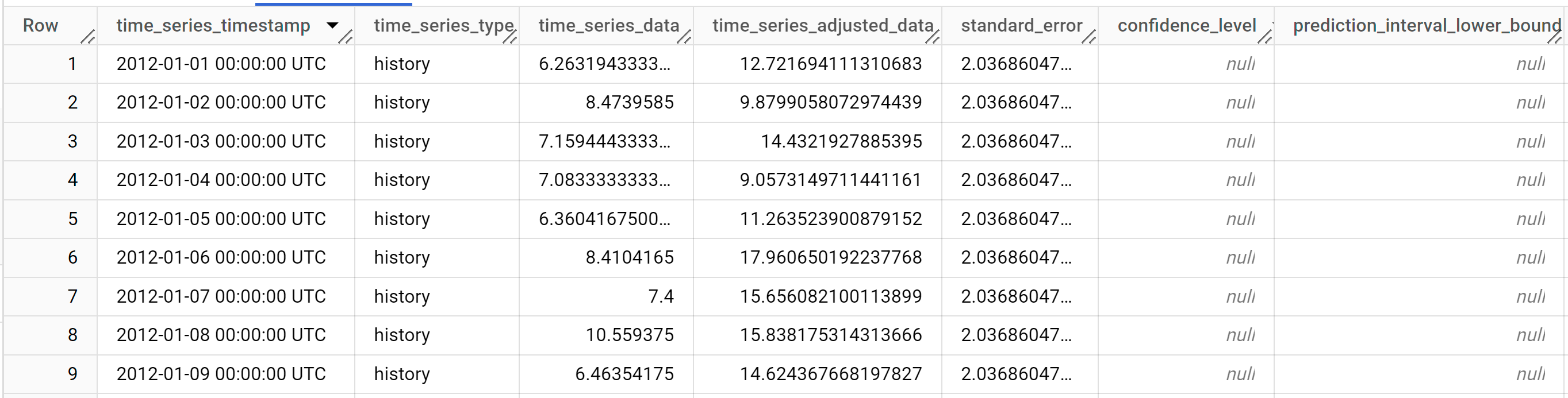

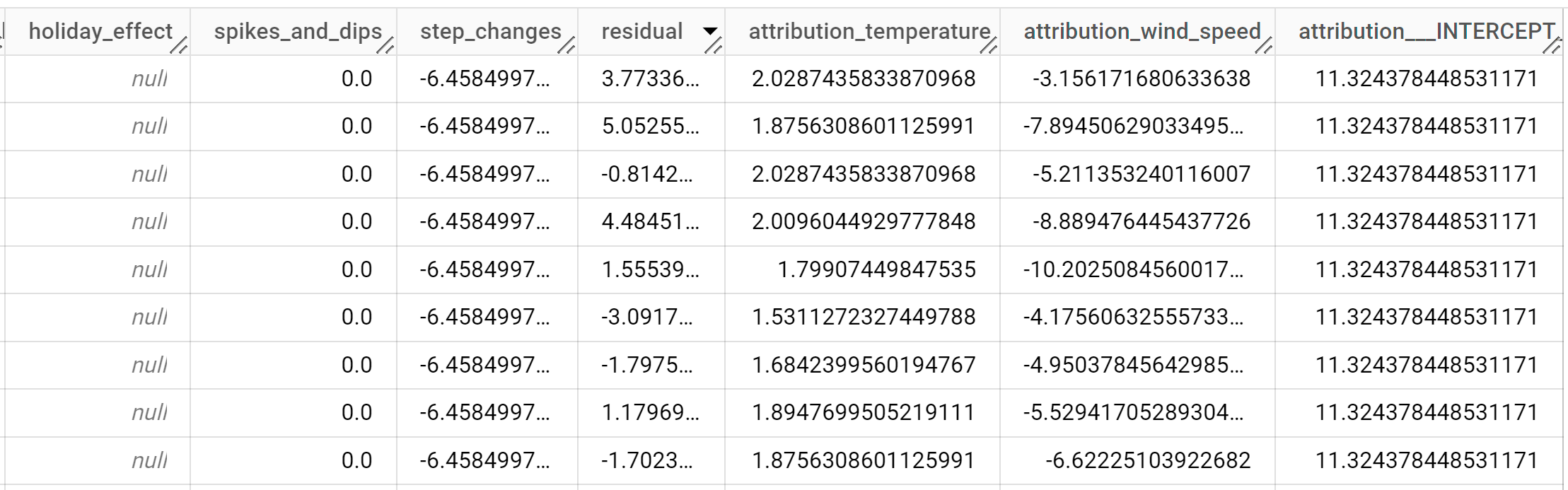

Os resultados devem ter um aspeto semelhante ao seguinte:

As linhas de saída são ordenadas cronologicamente pelo valor da coluna

time_series_timestamp.Para mais informações sobre as colunas de saída, consulte a função

ML.EXPLAIN_FORECAST.